scala

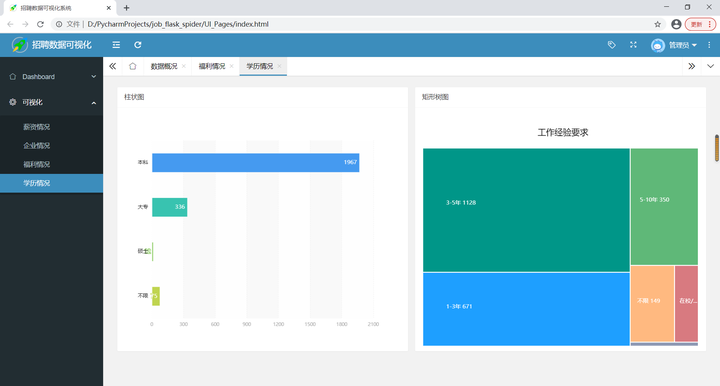

云笔记

职场

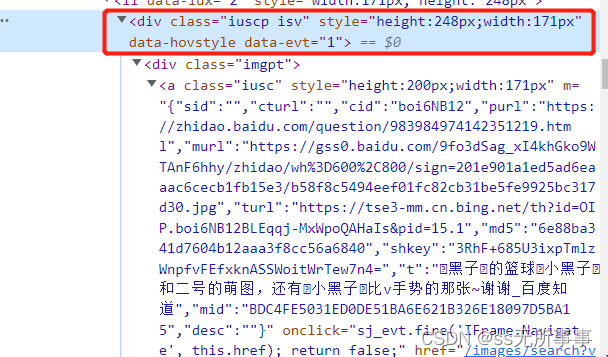

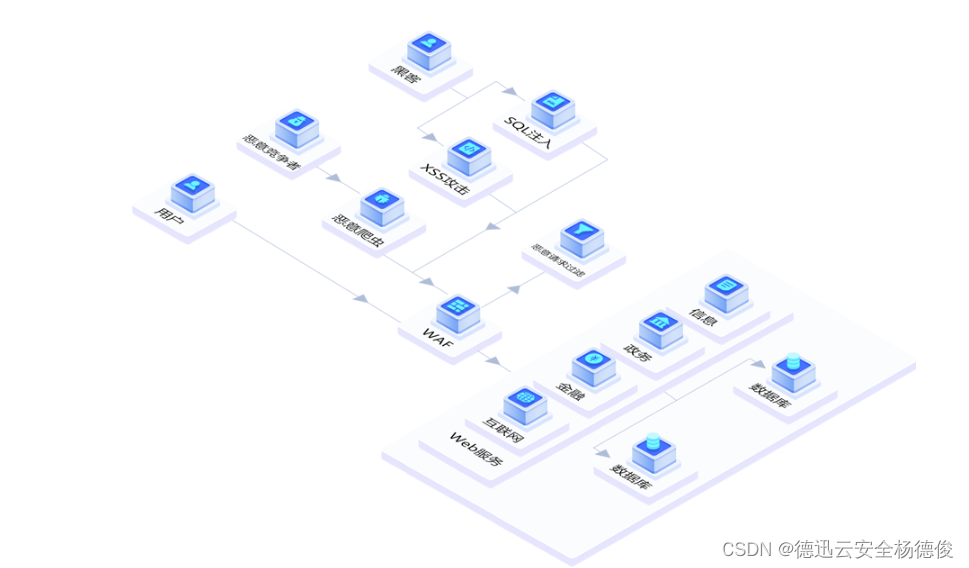

DOM型XSS

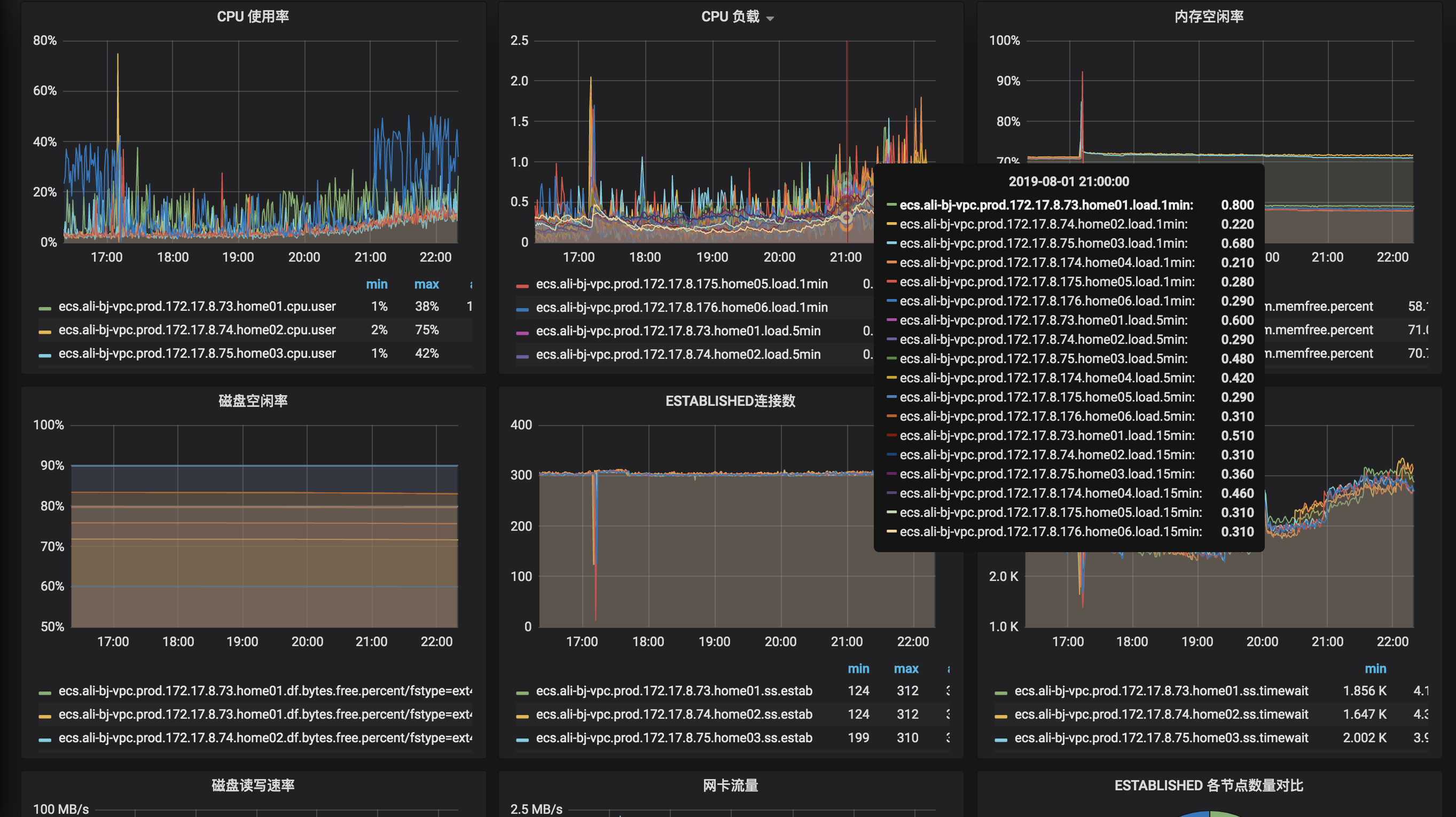

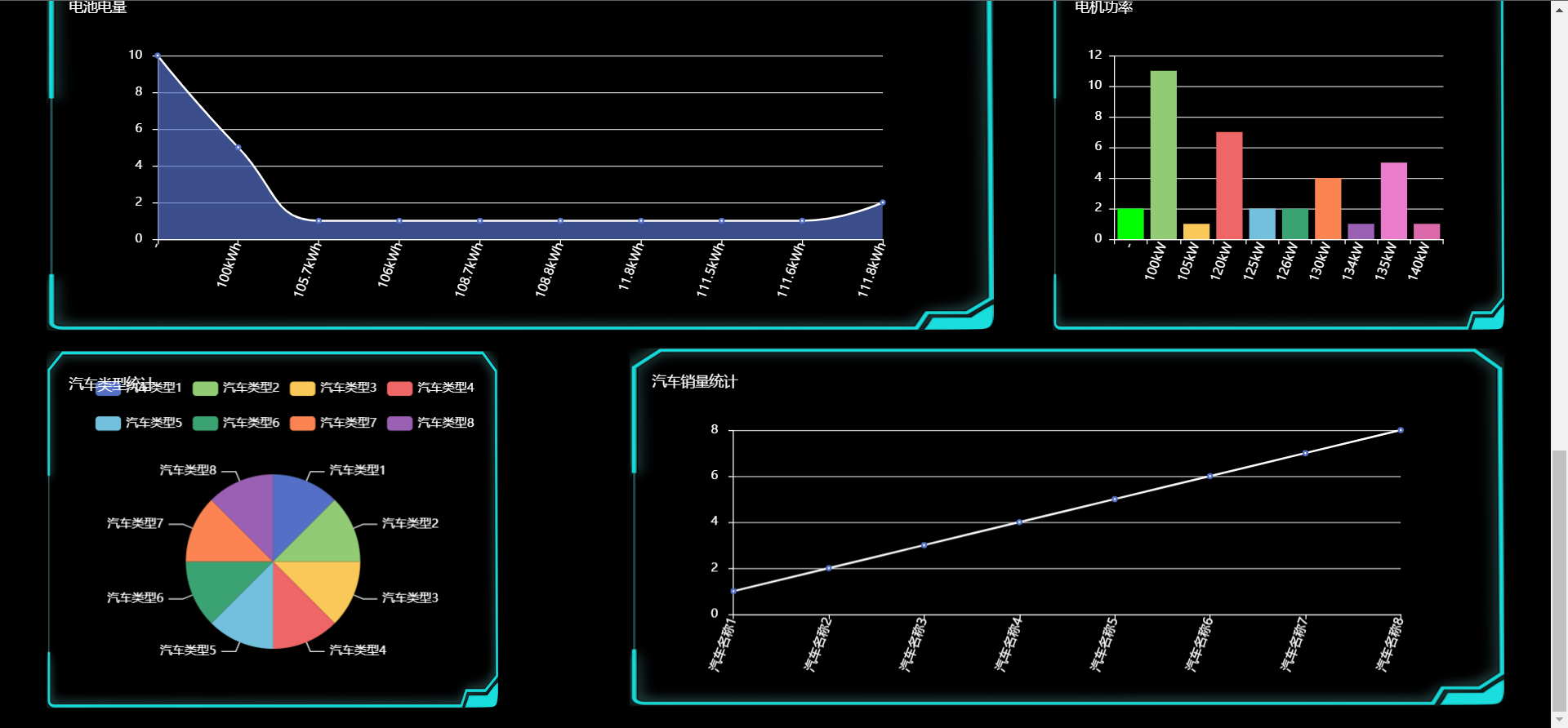

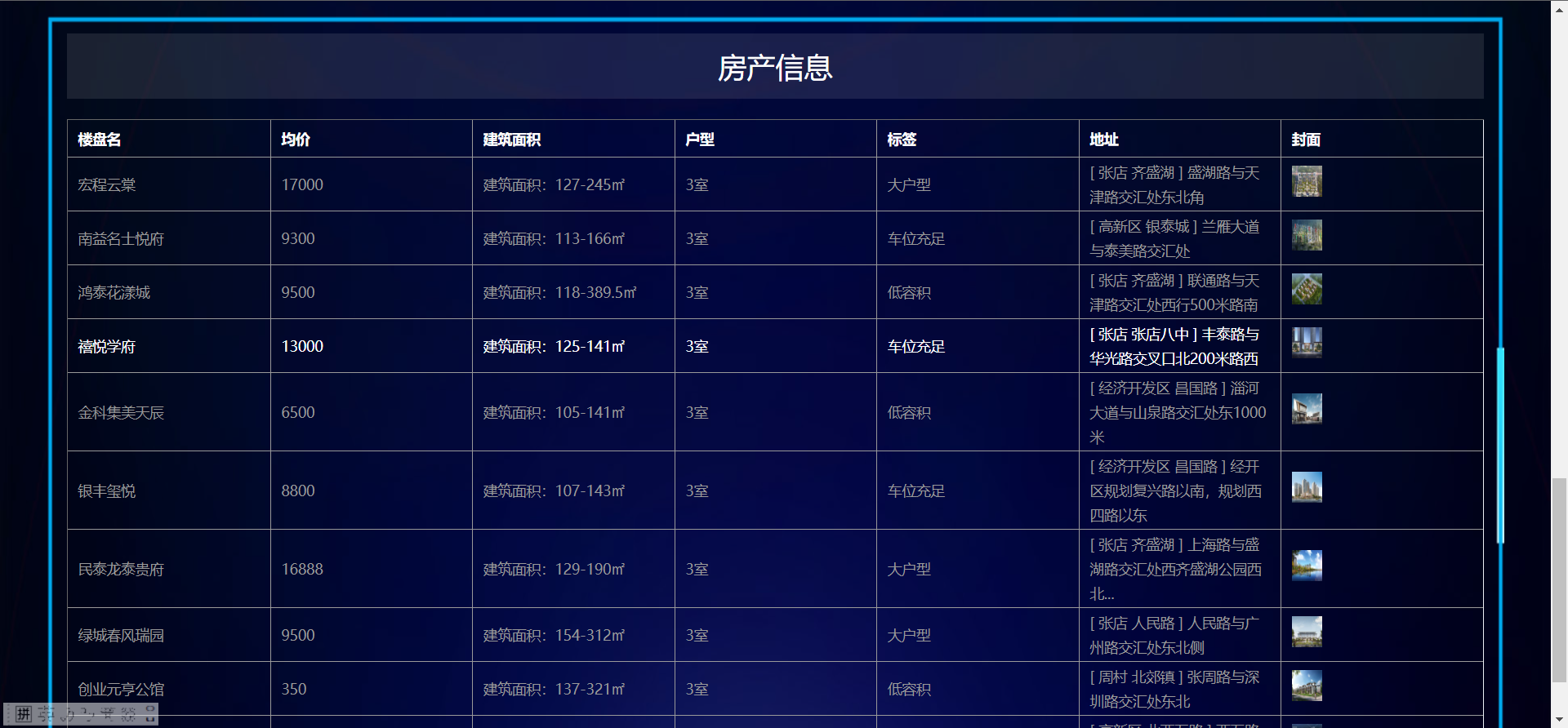

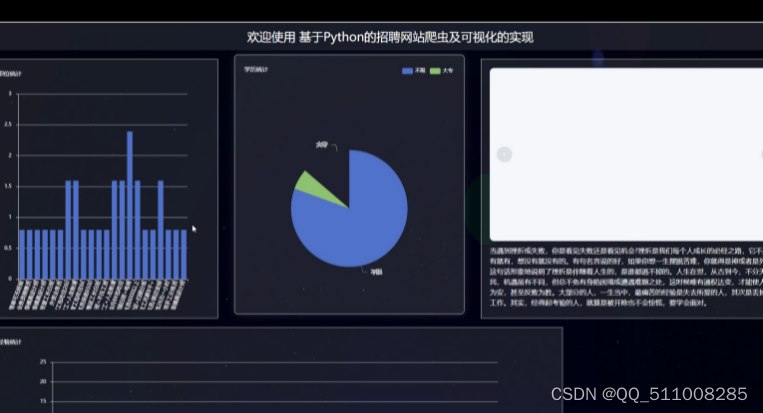

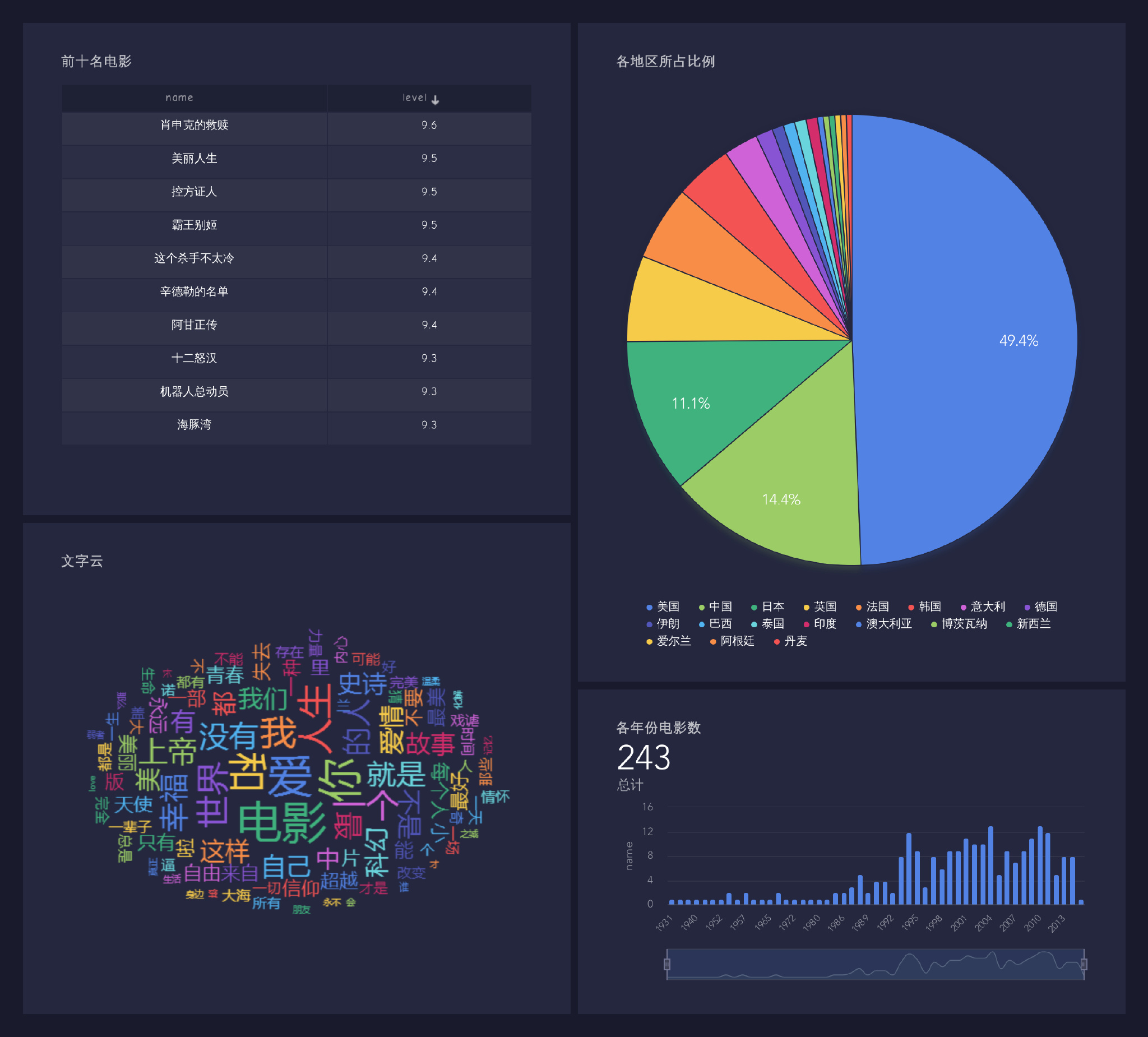

业务大屏

制图综合

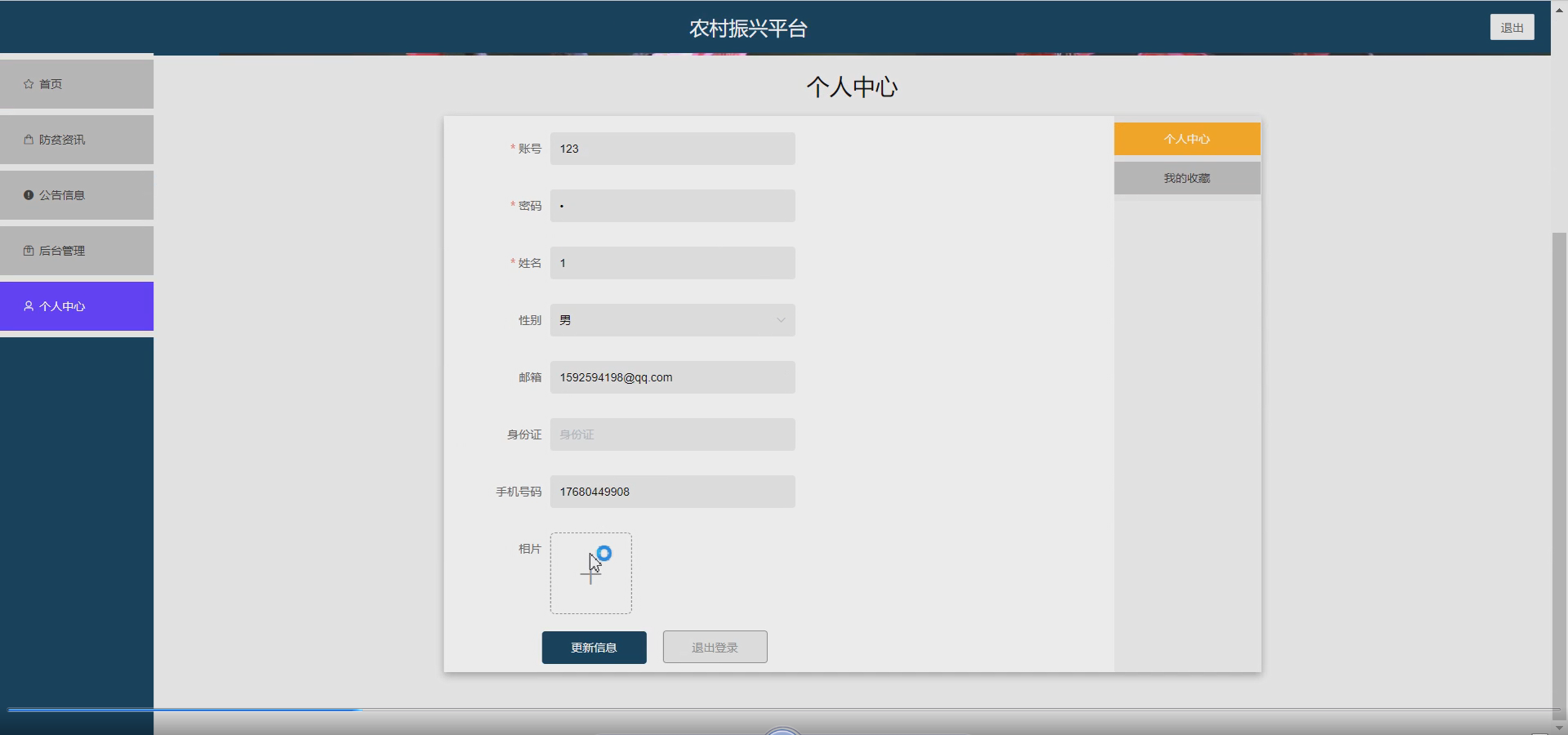

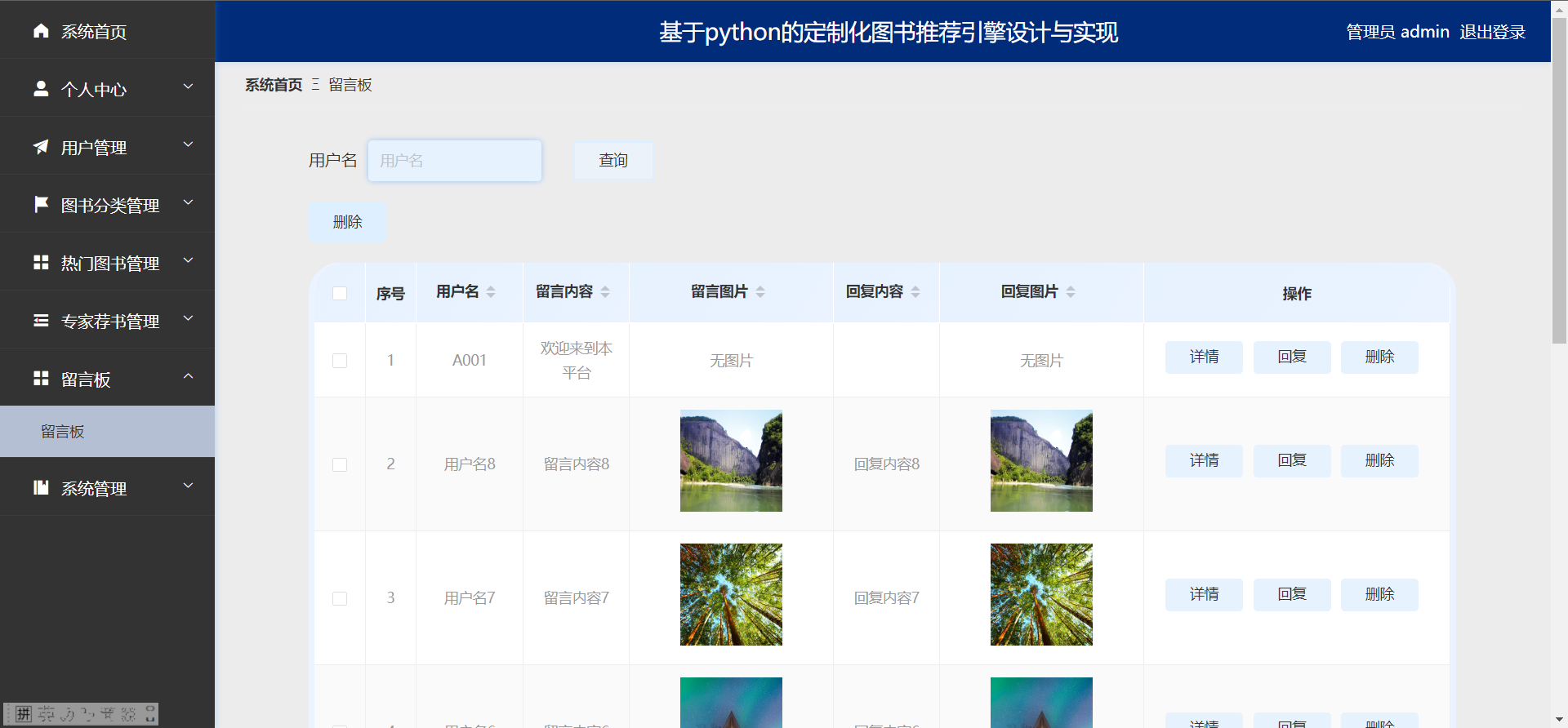

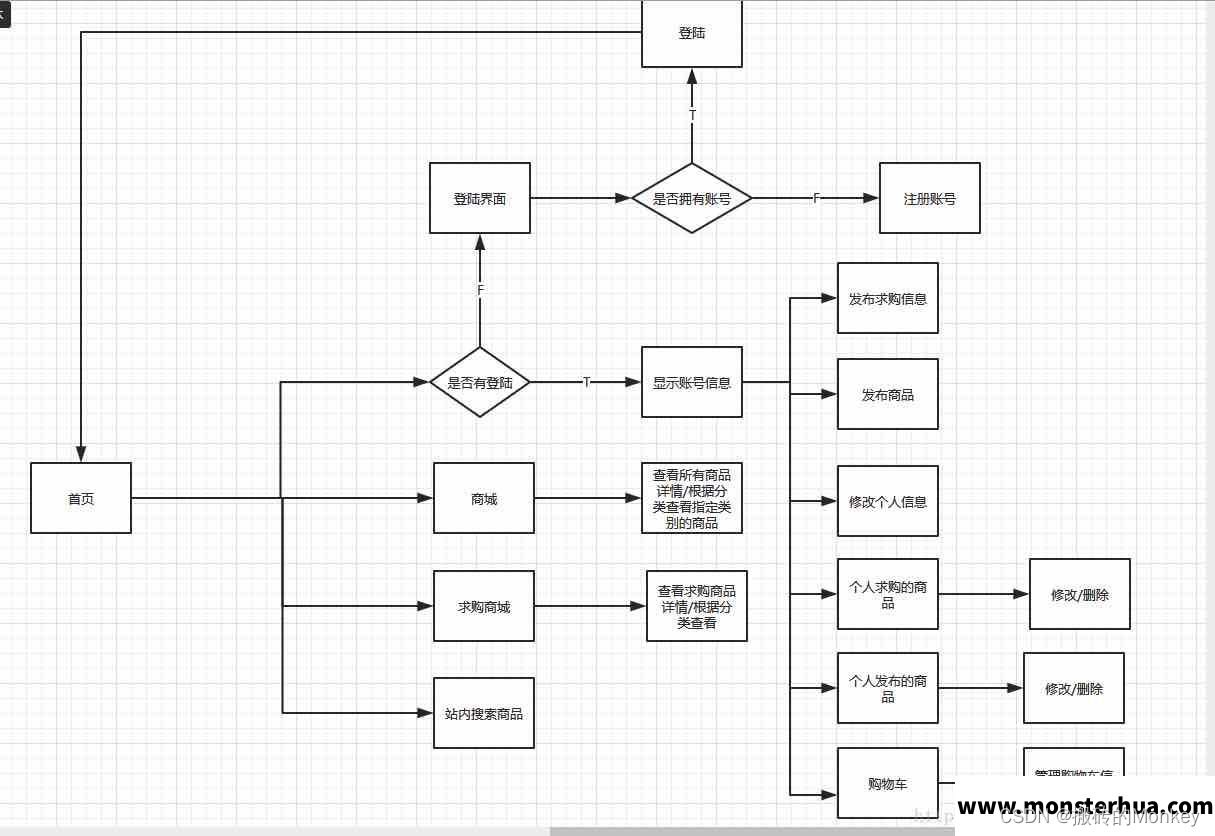

大学生心理健康咨询系统

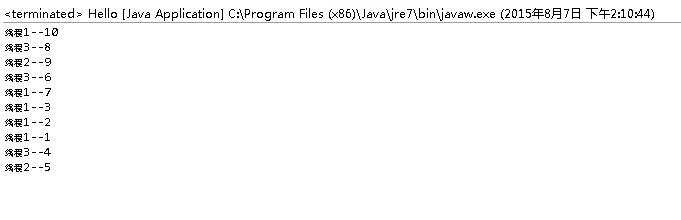

线程池

微信授权功能

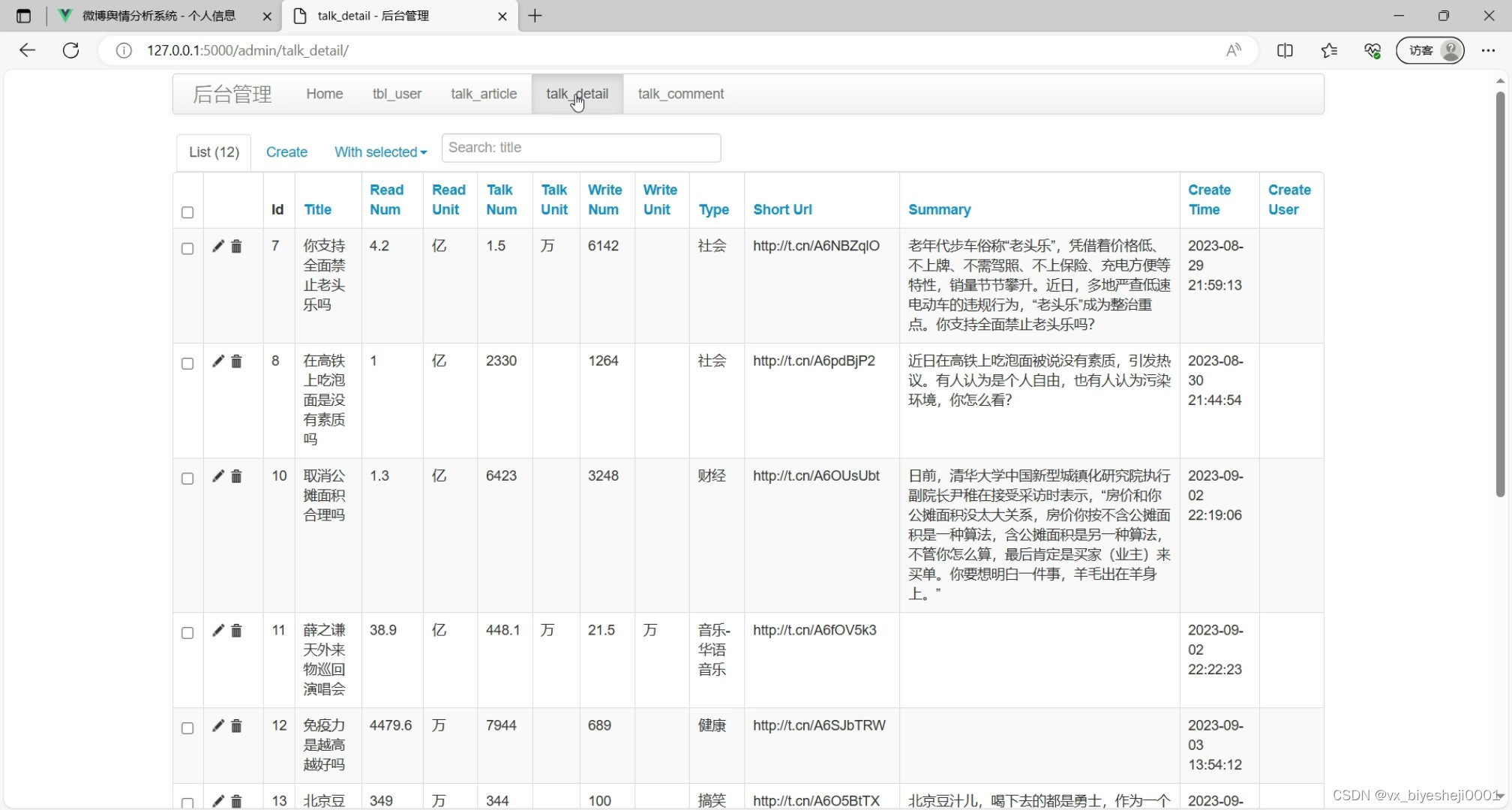

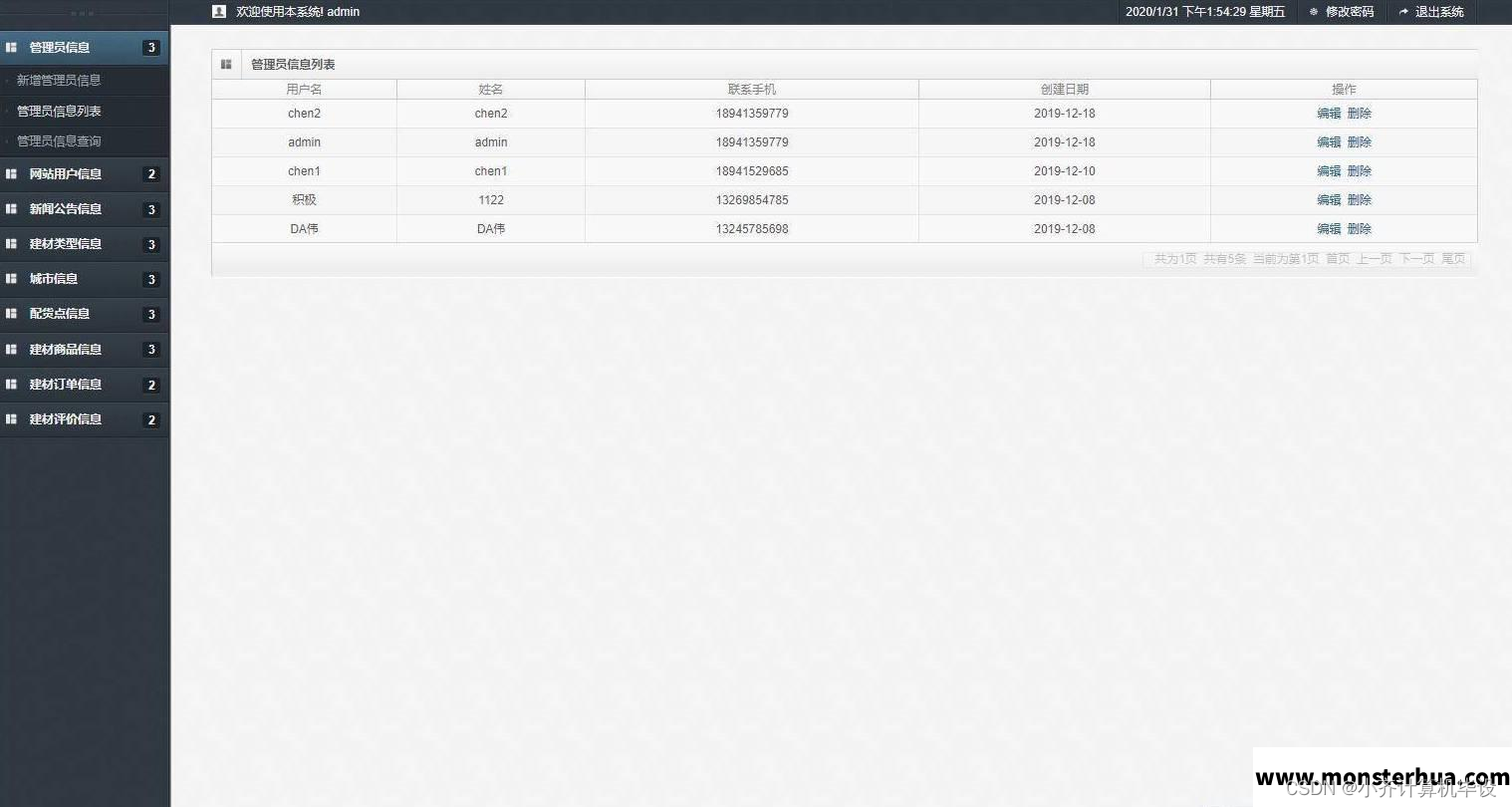

后台开发

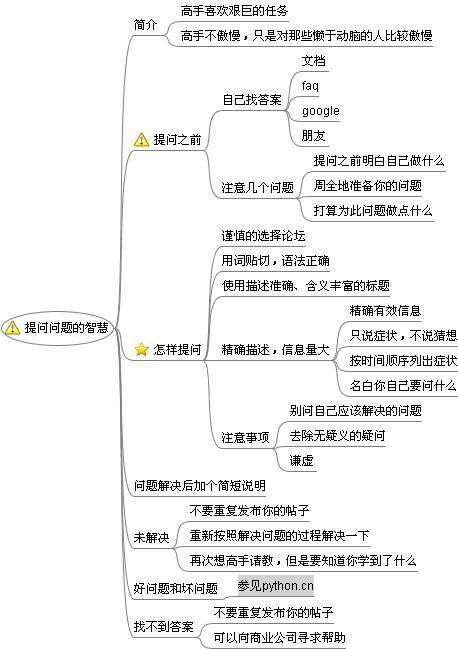

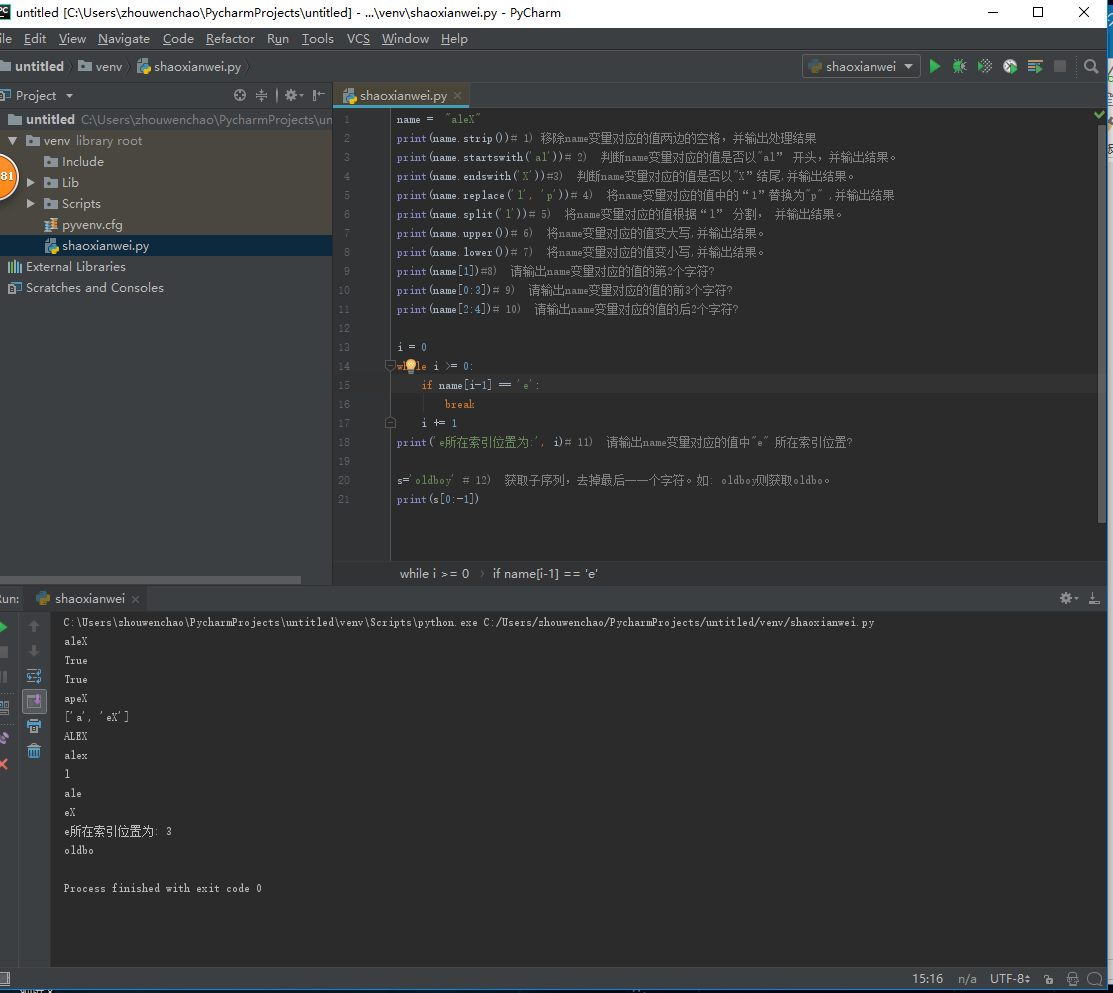

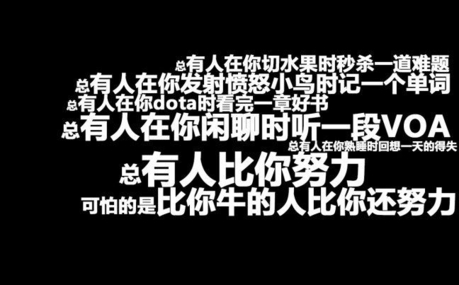

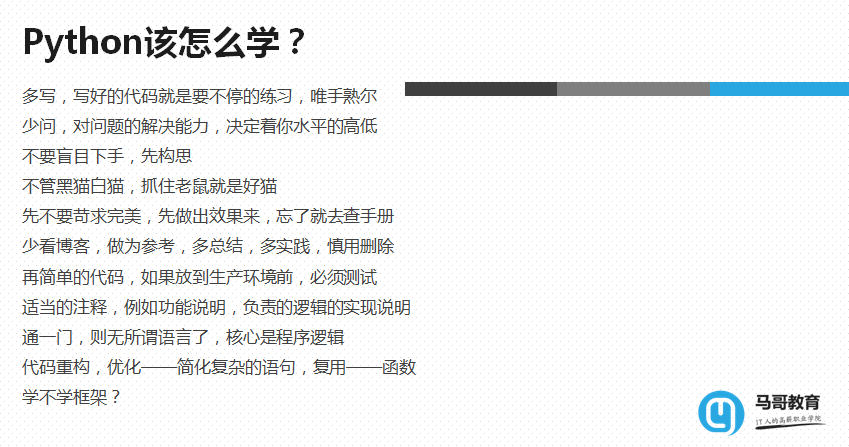

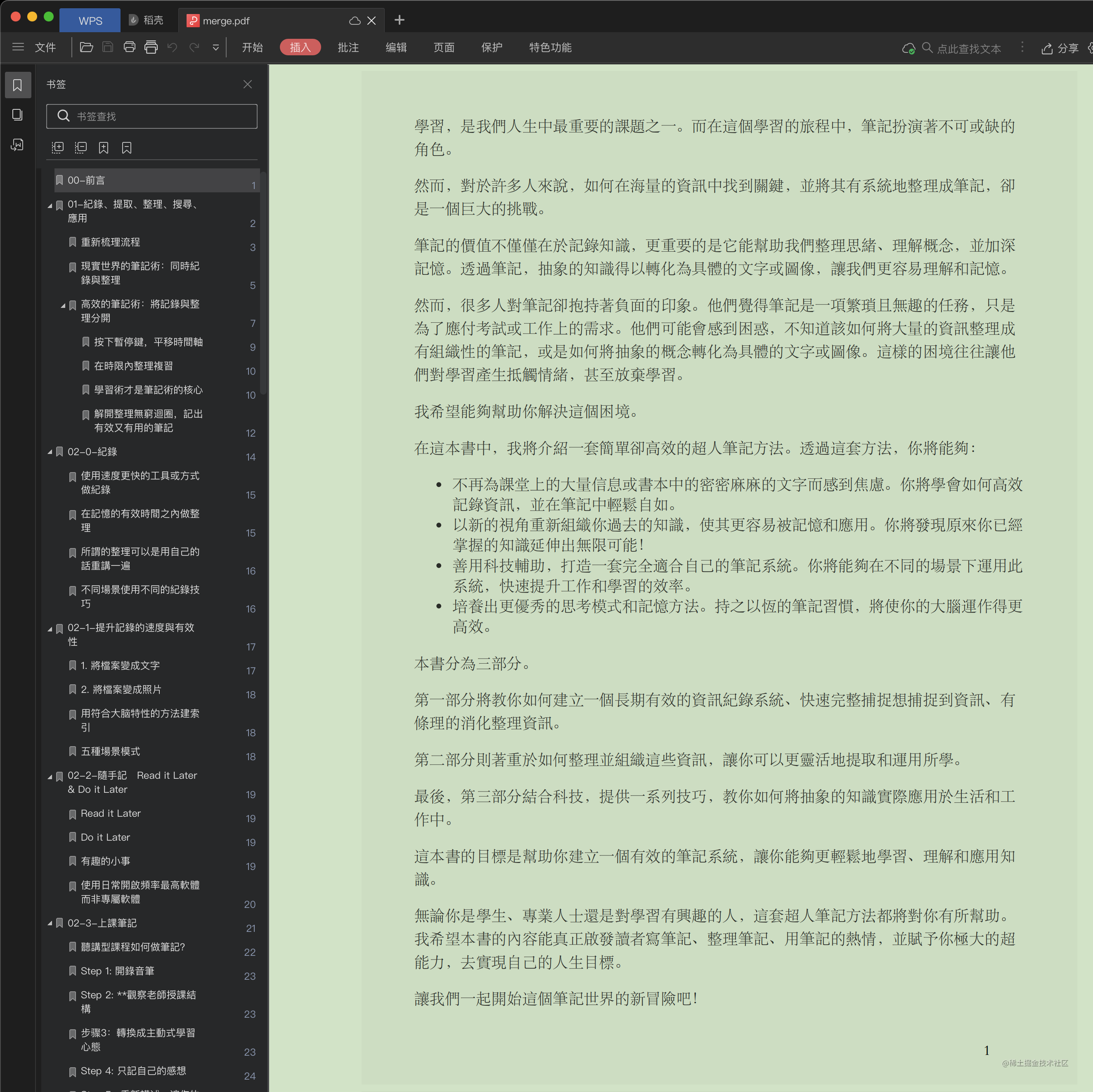

学习方法

四大分析工具

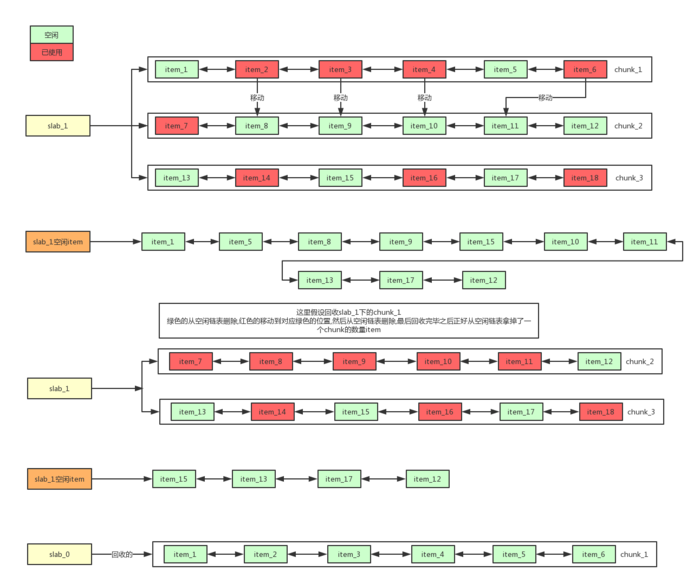

off heap

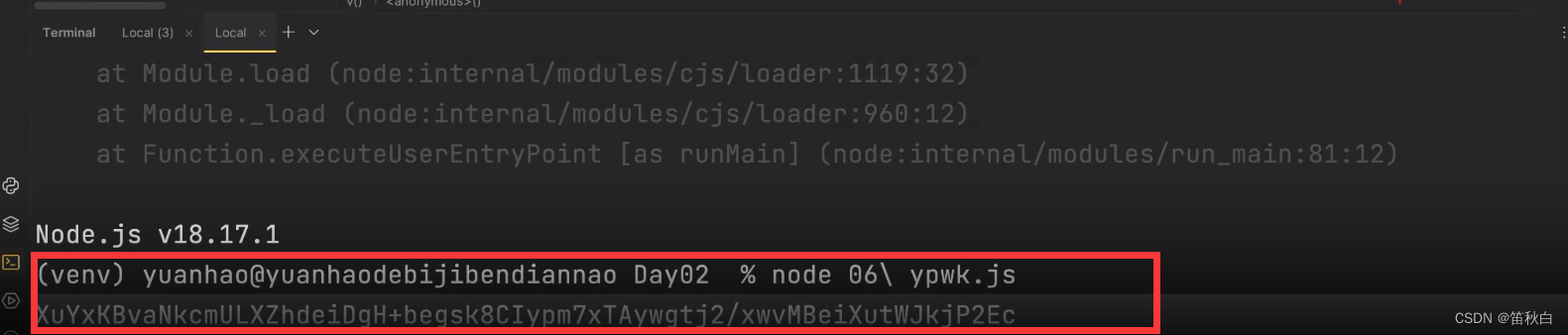

cve-2022-21449

azkaban

征信报告

VMware

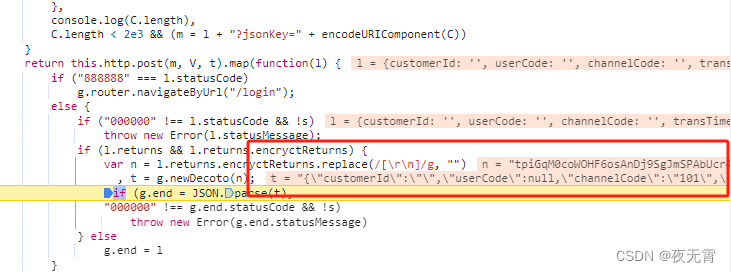

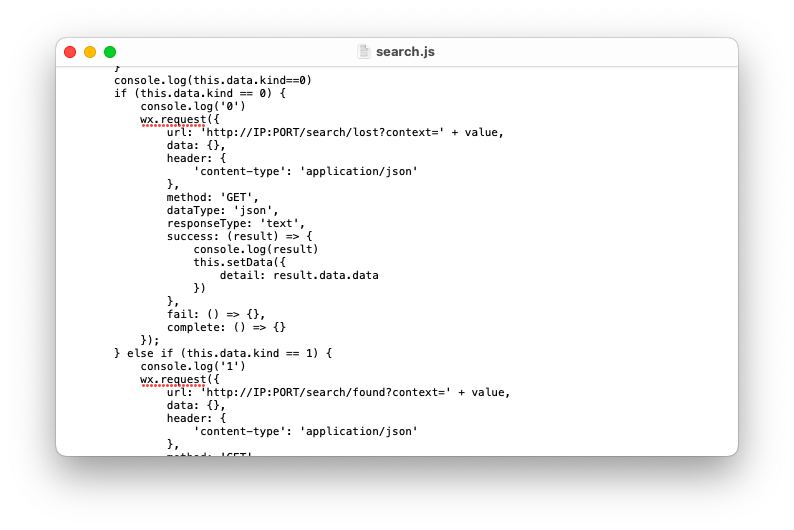

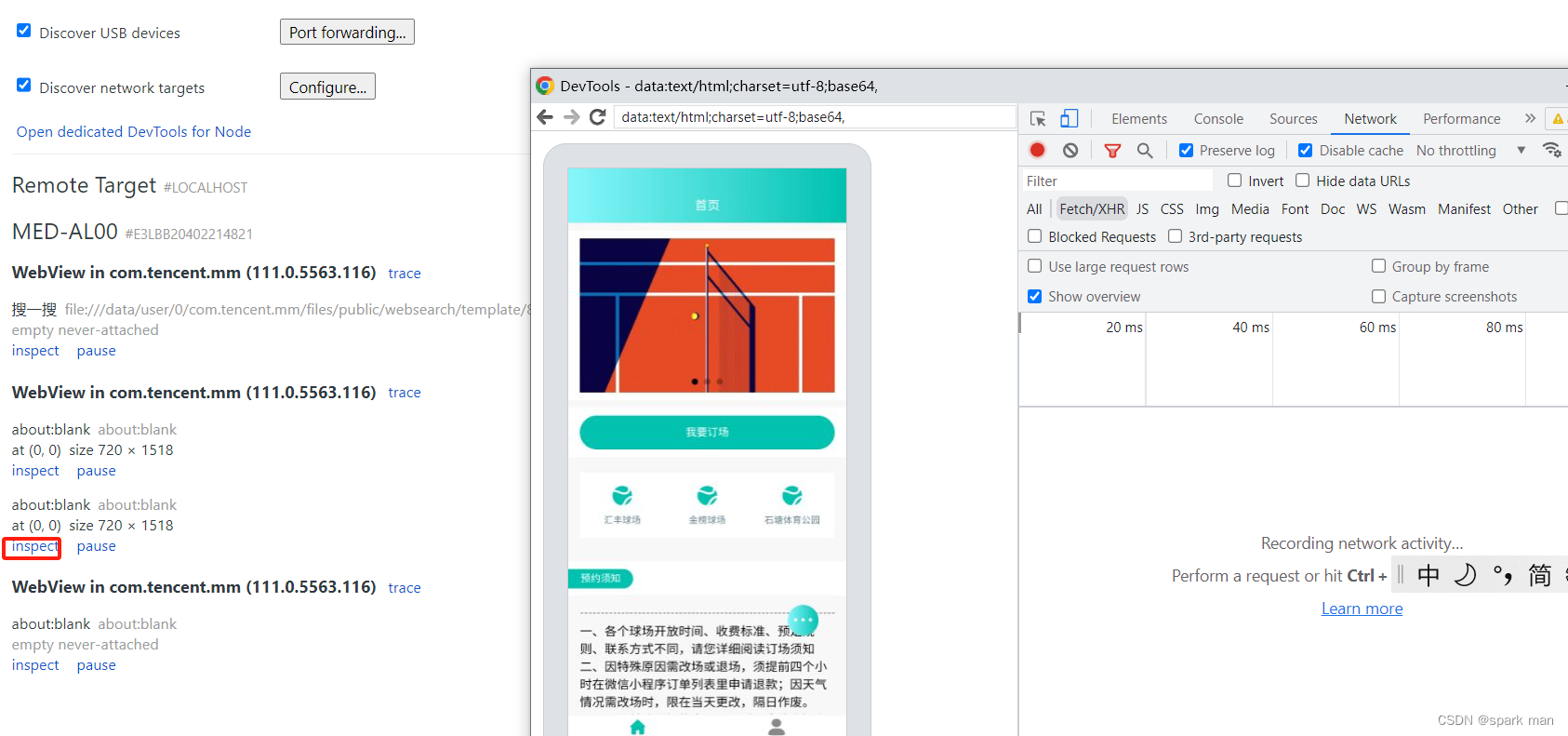

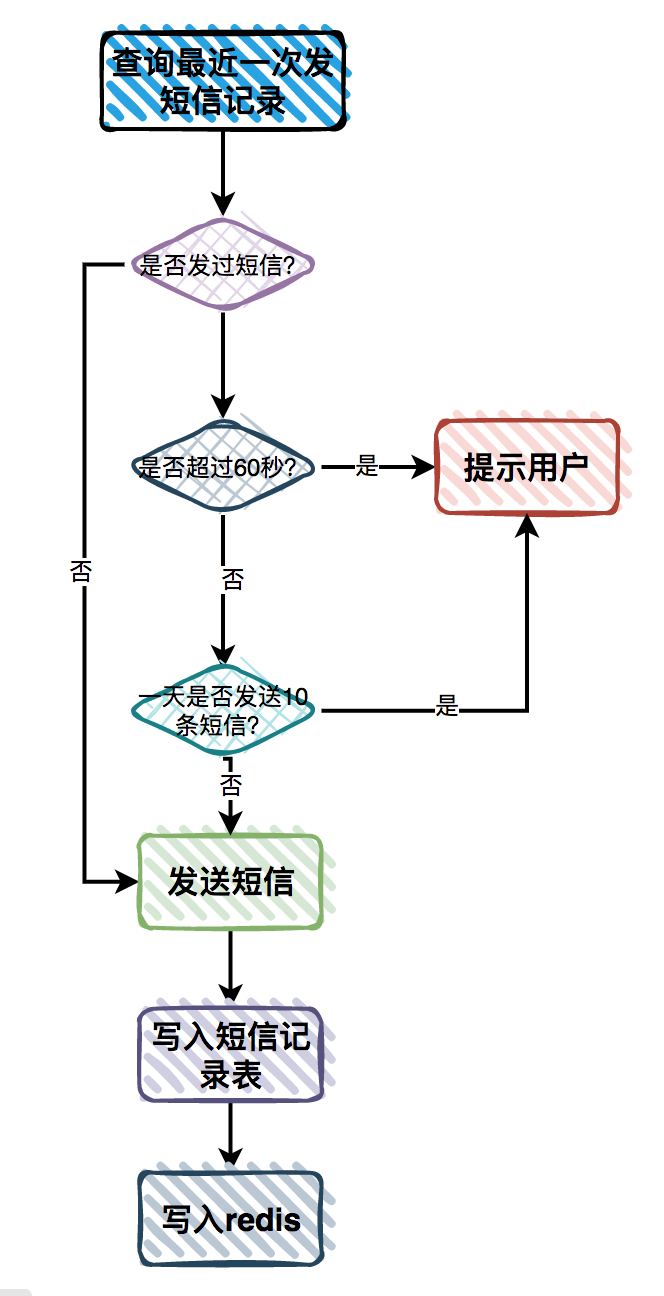

管理微信小程序登录态

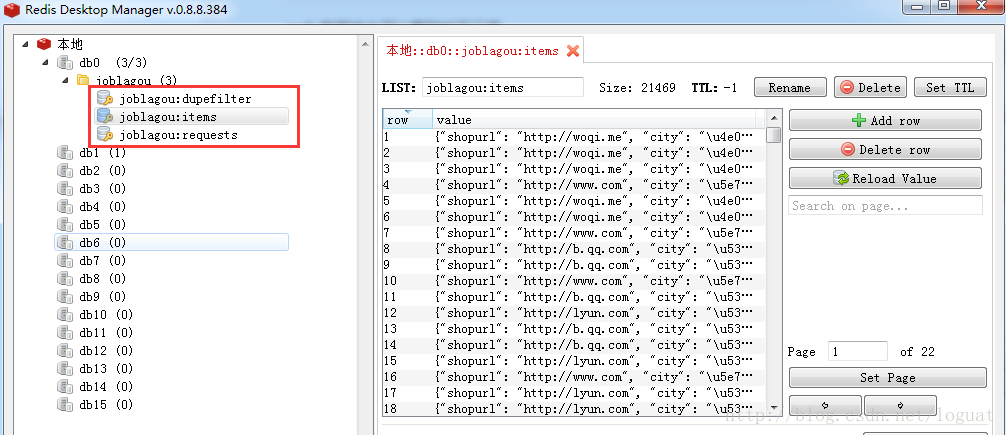

django-redis

Junit常用注解

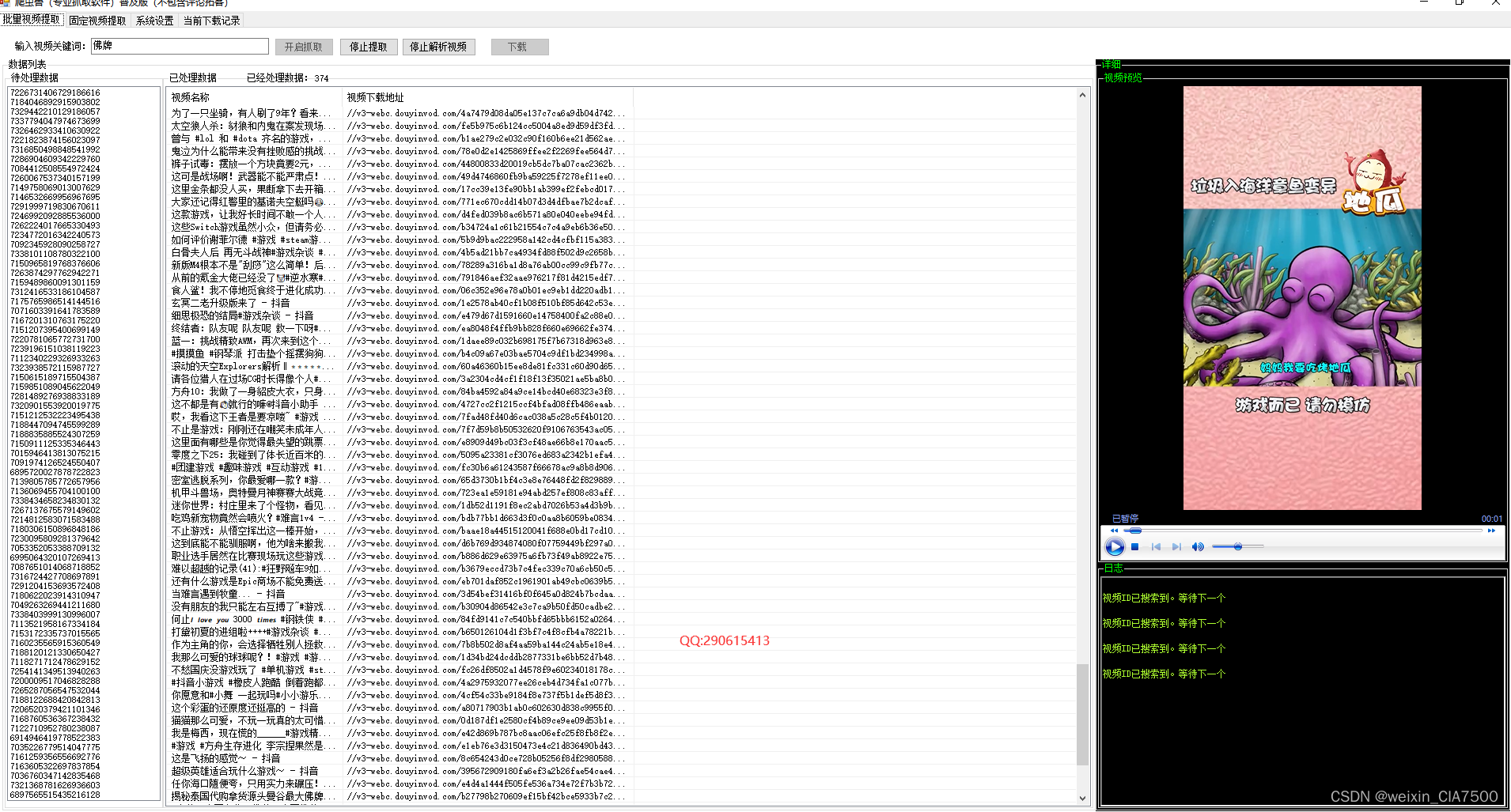

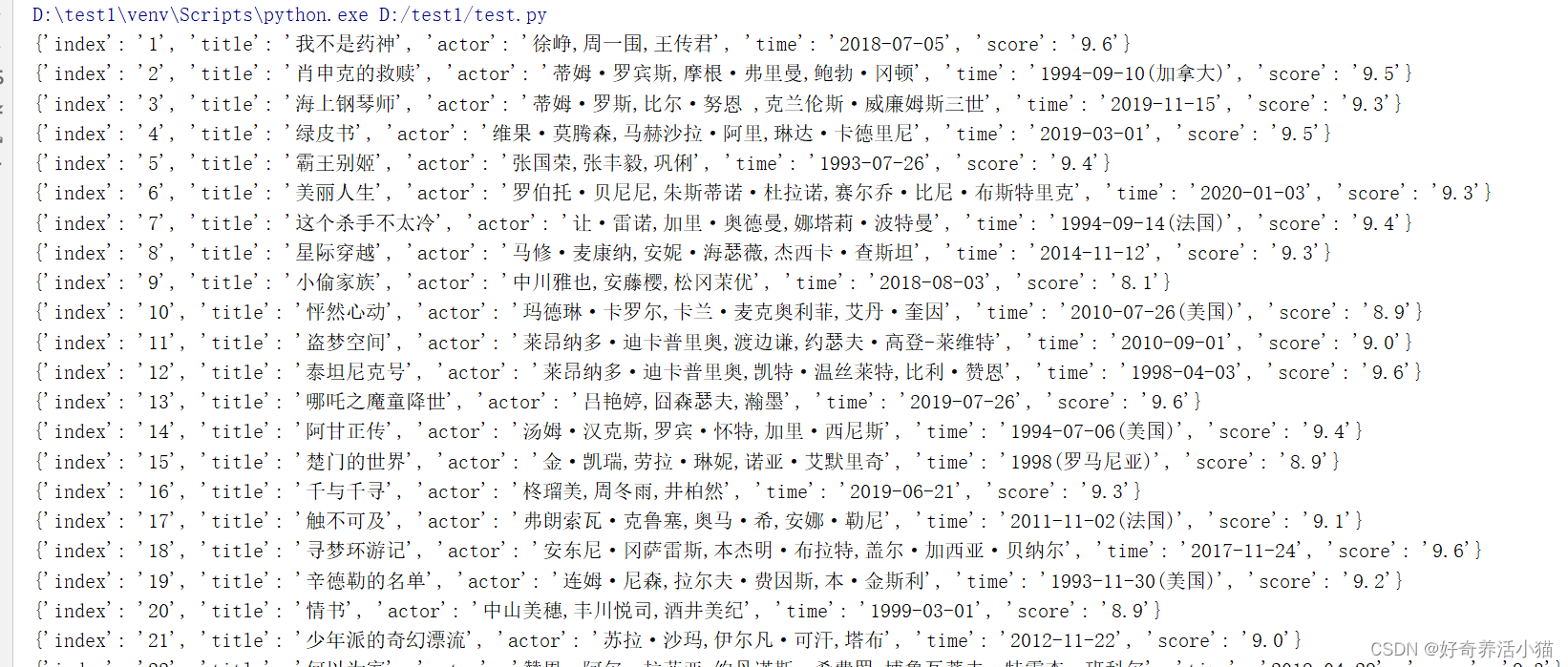

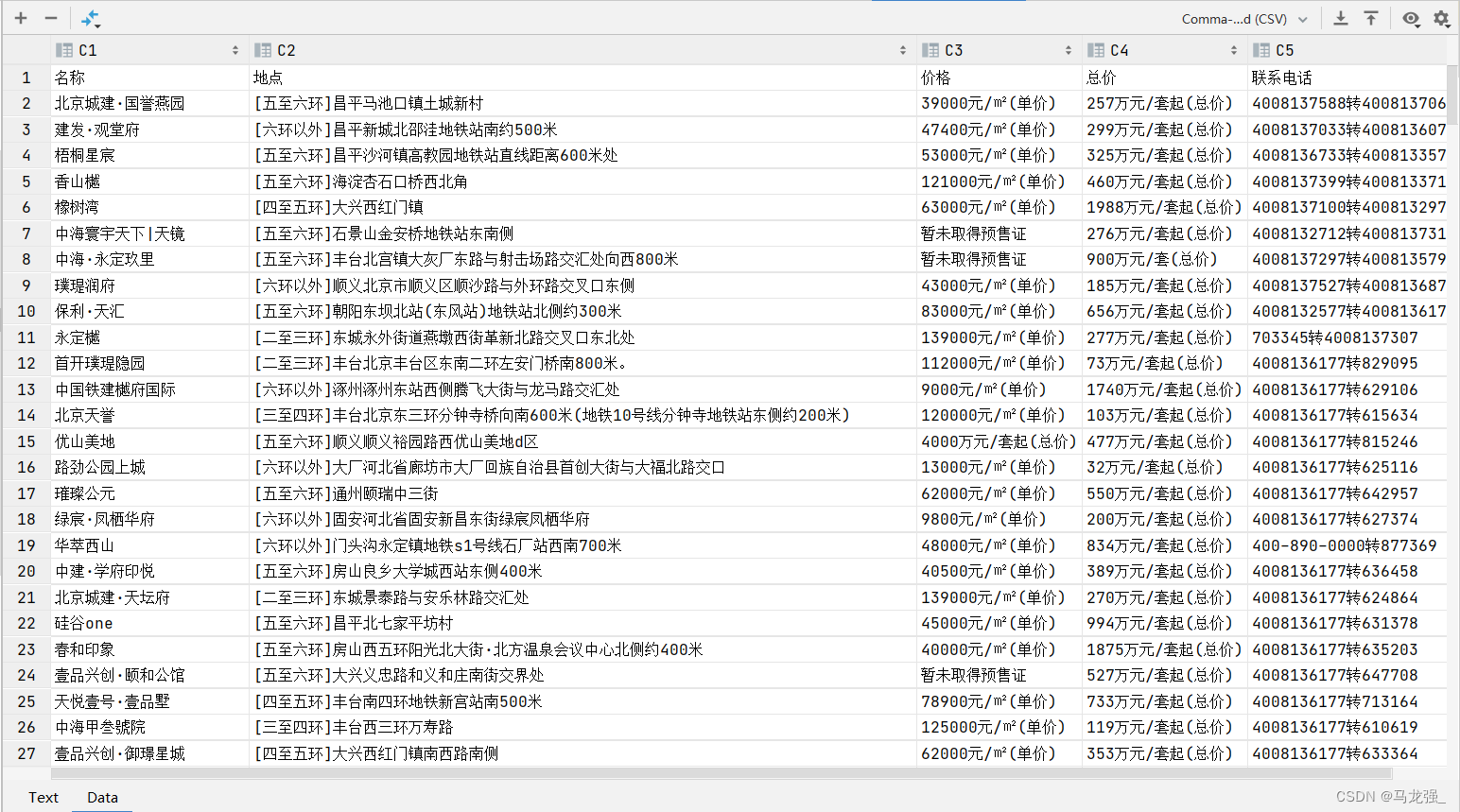

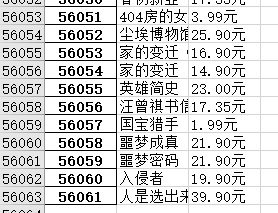

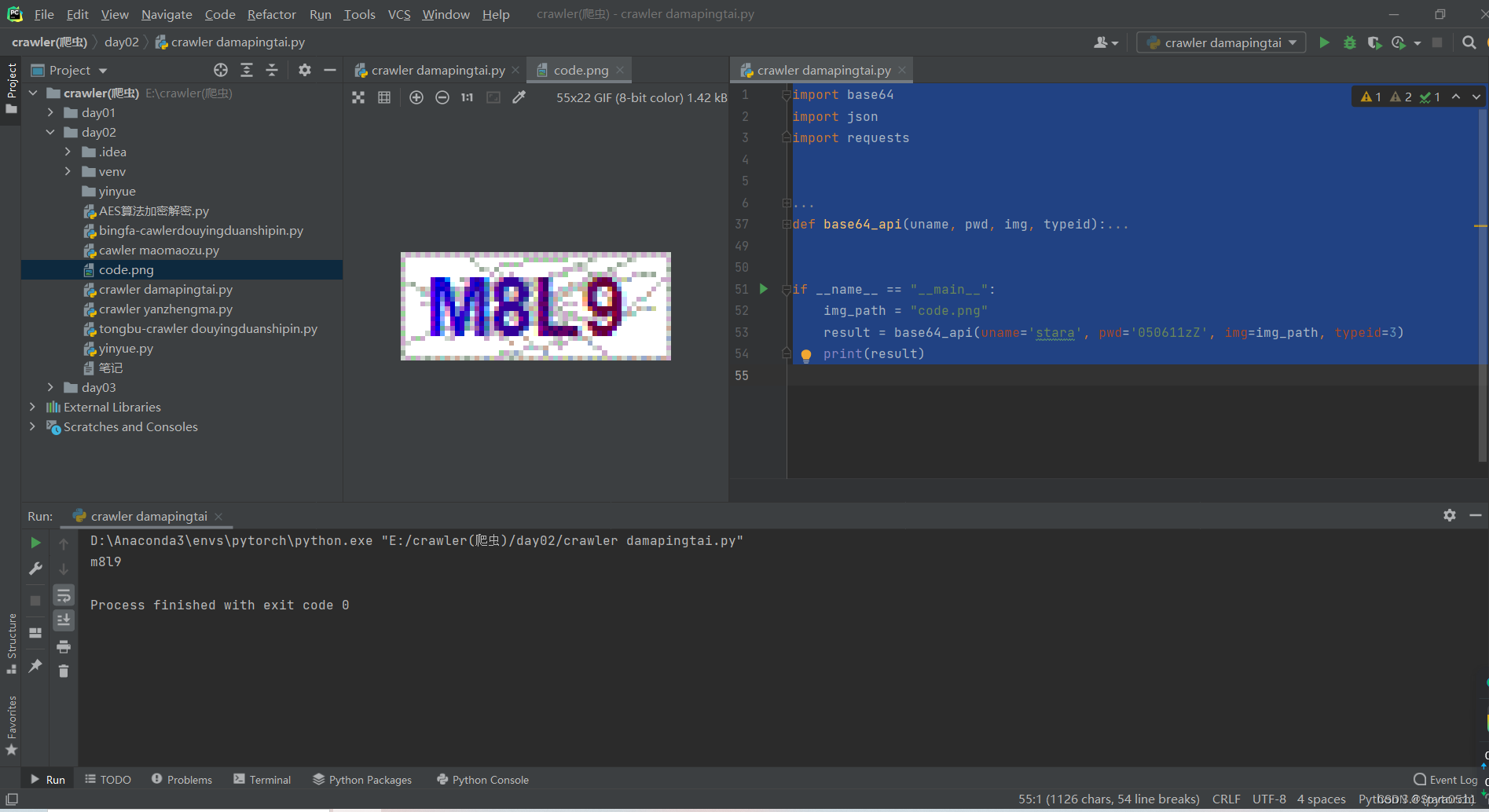

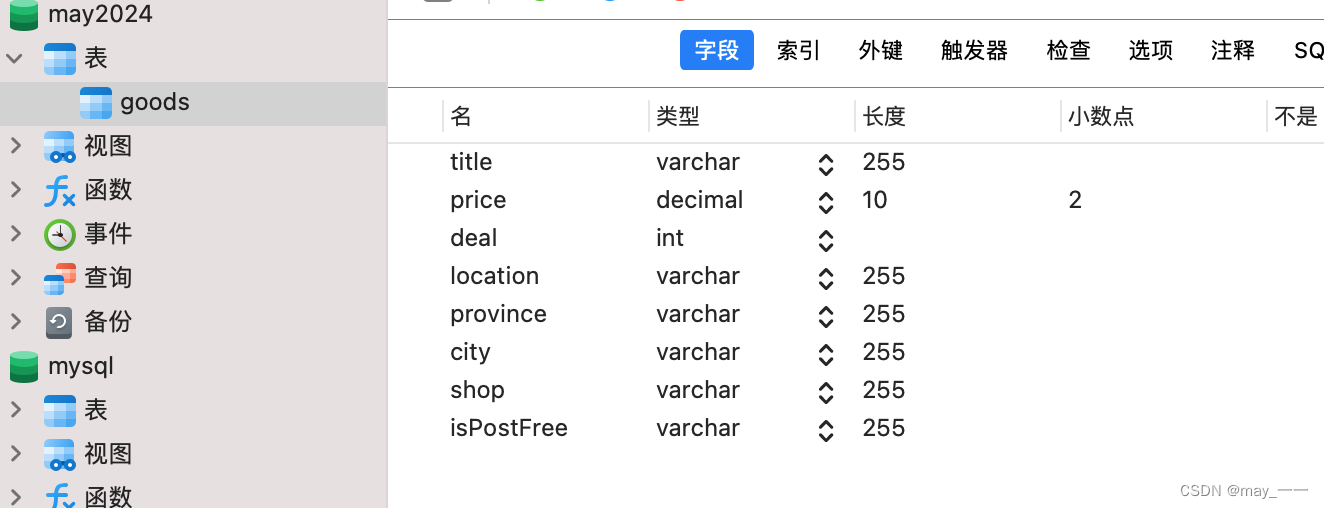

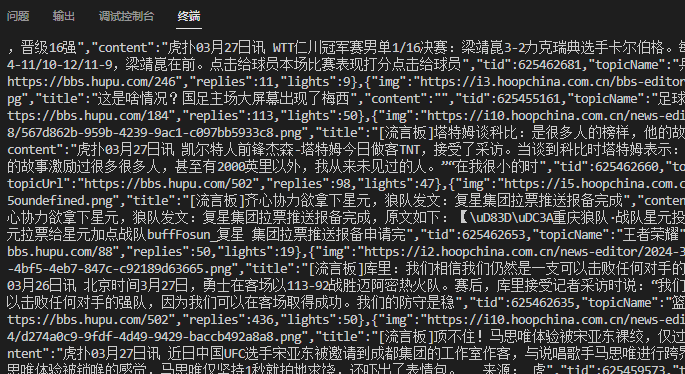

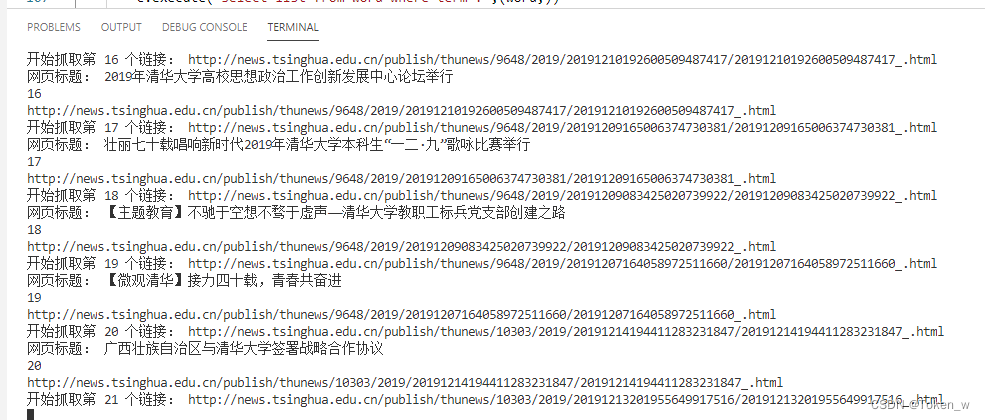

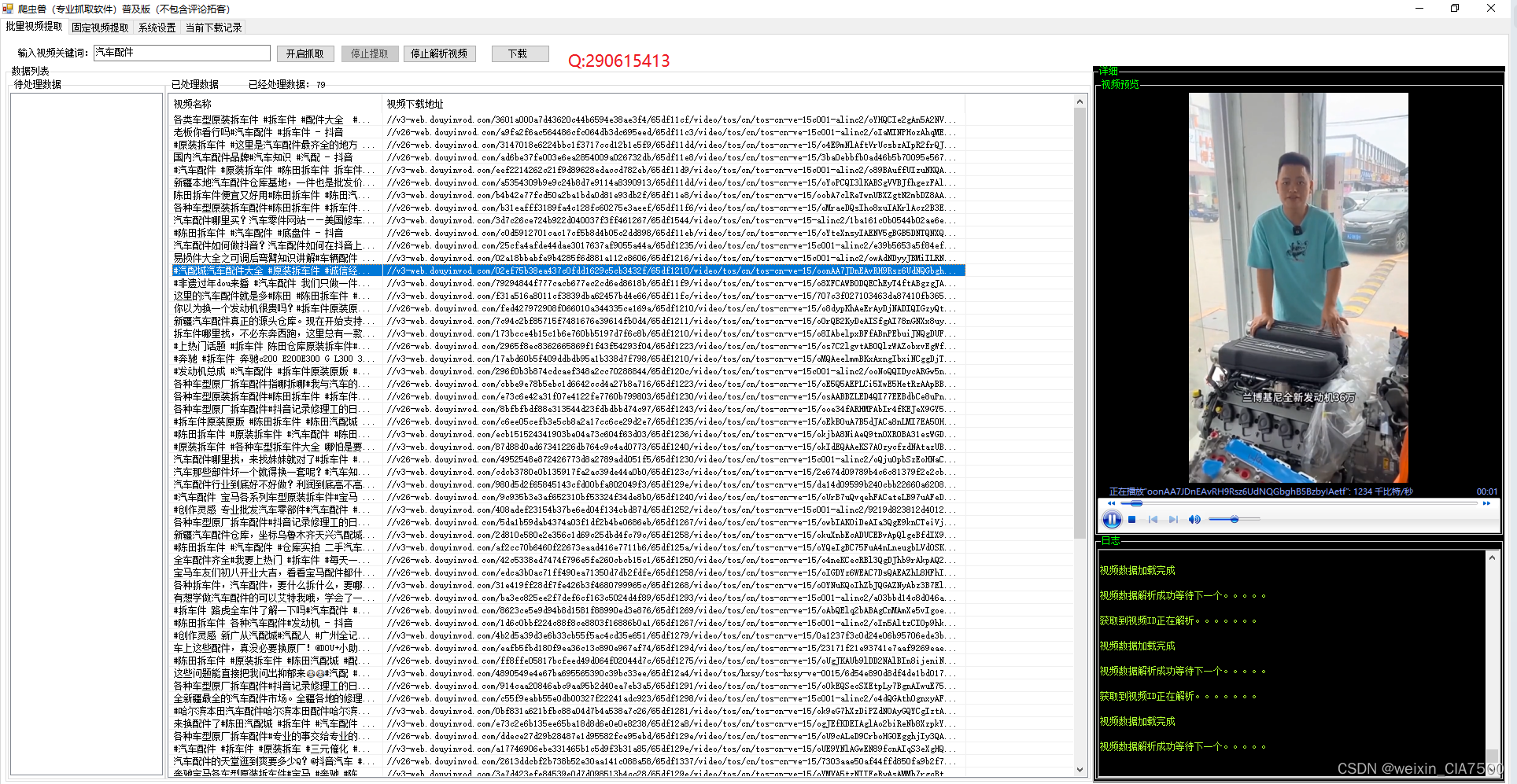

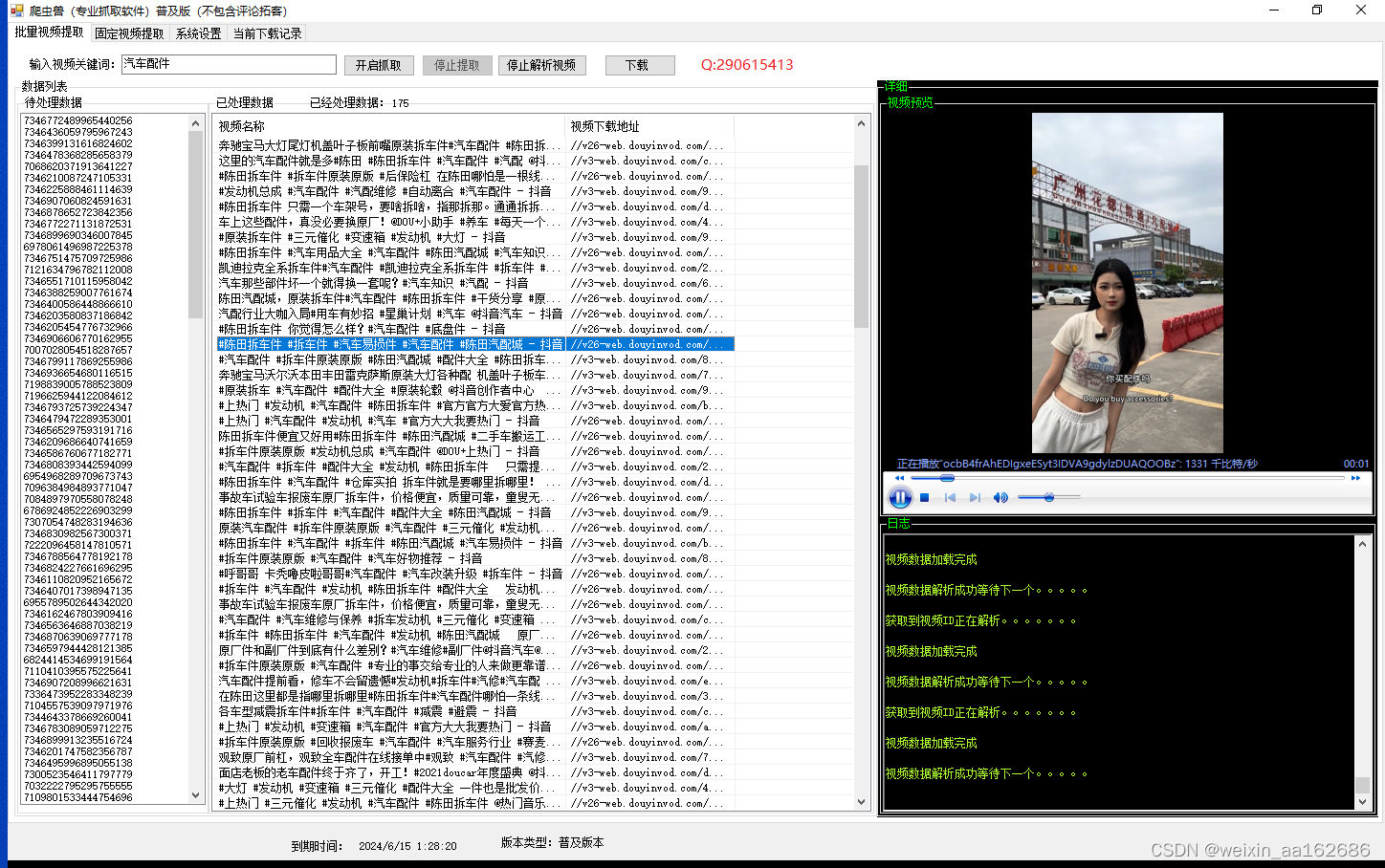

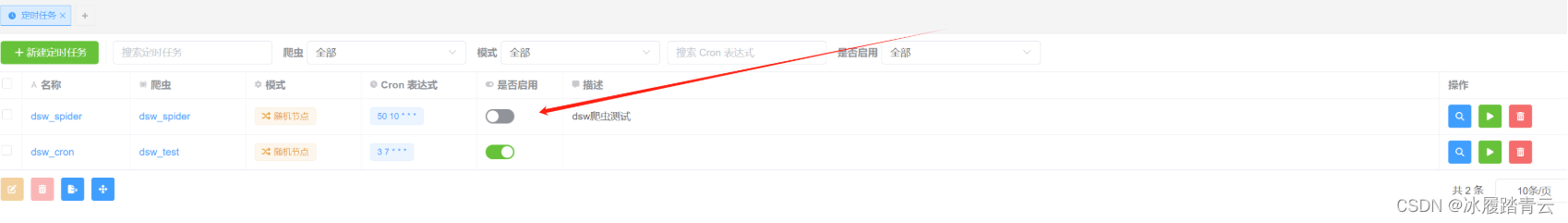

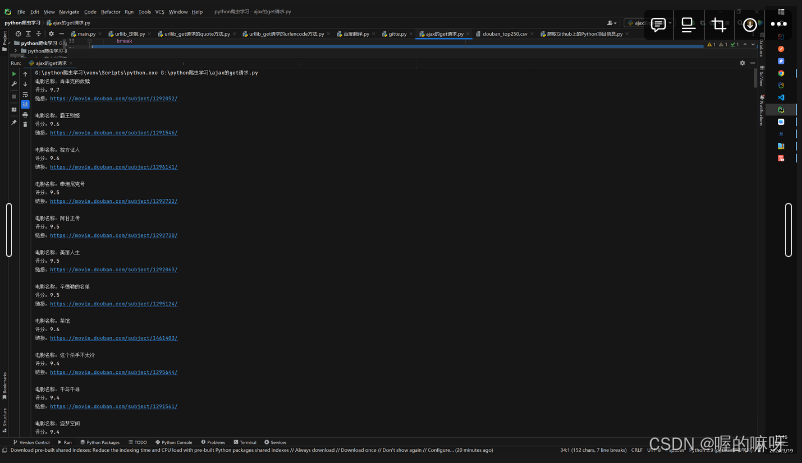

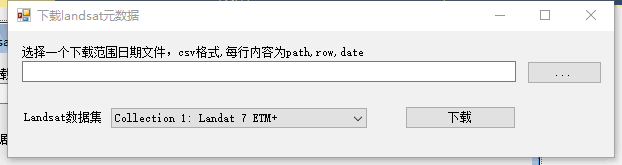

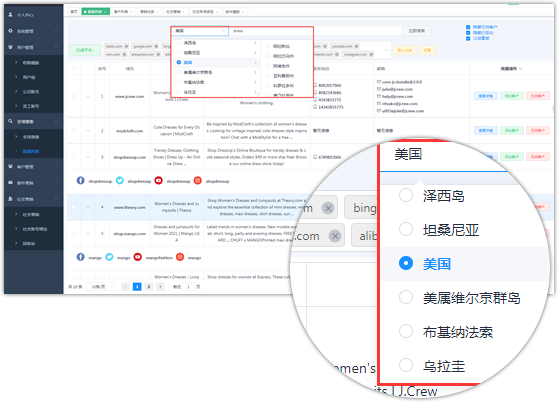

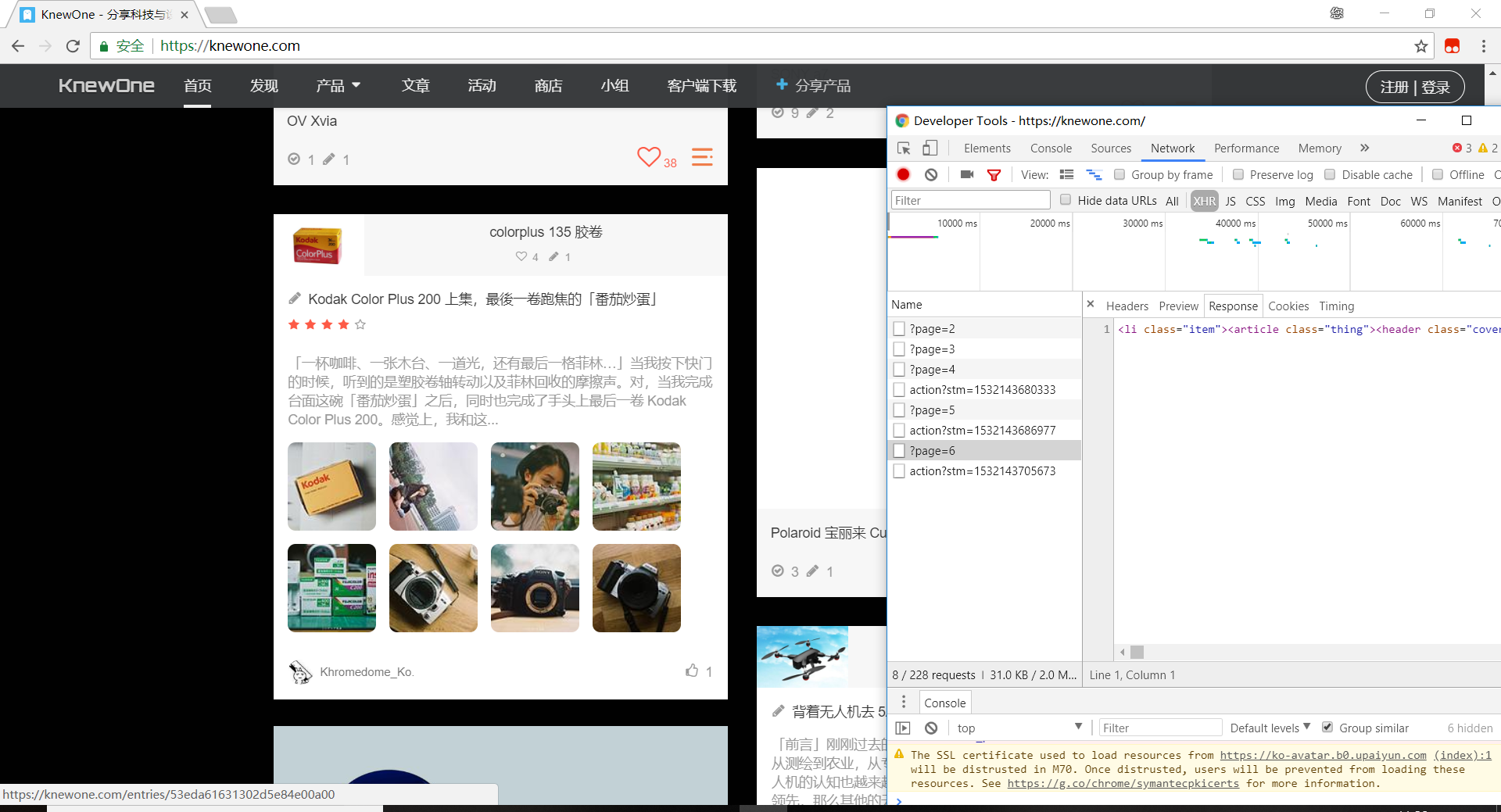

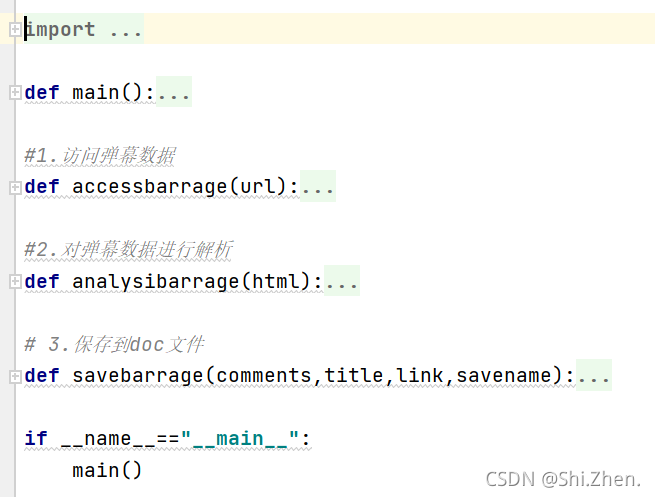

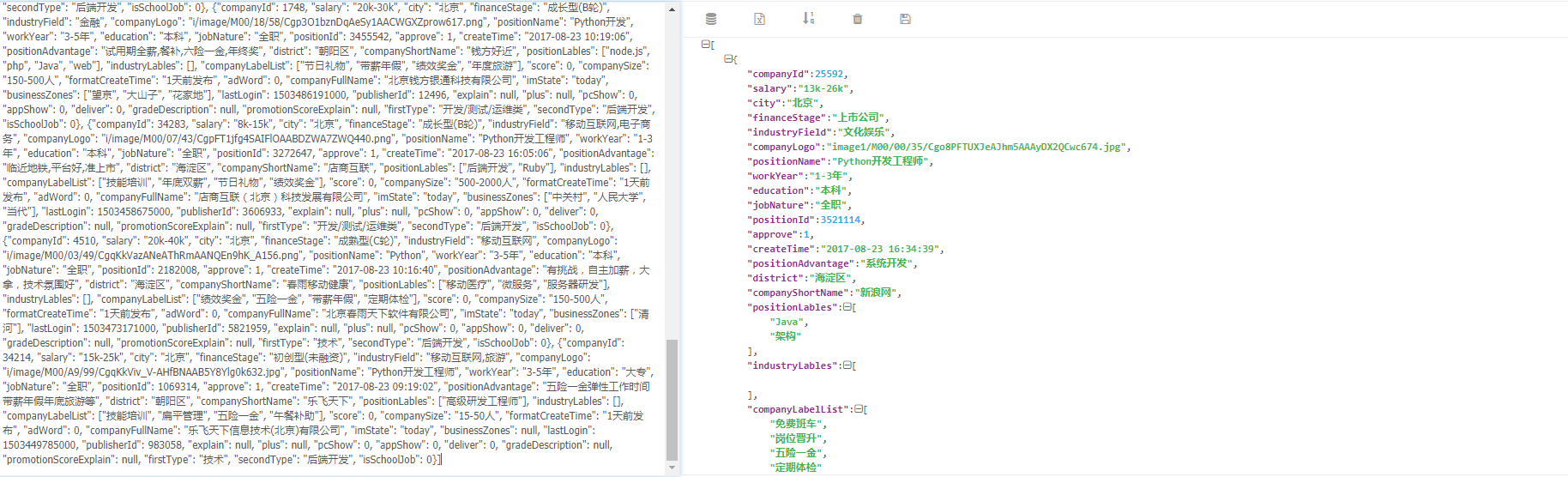

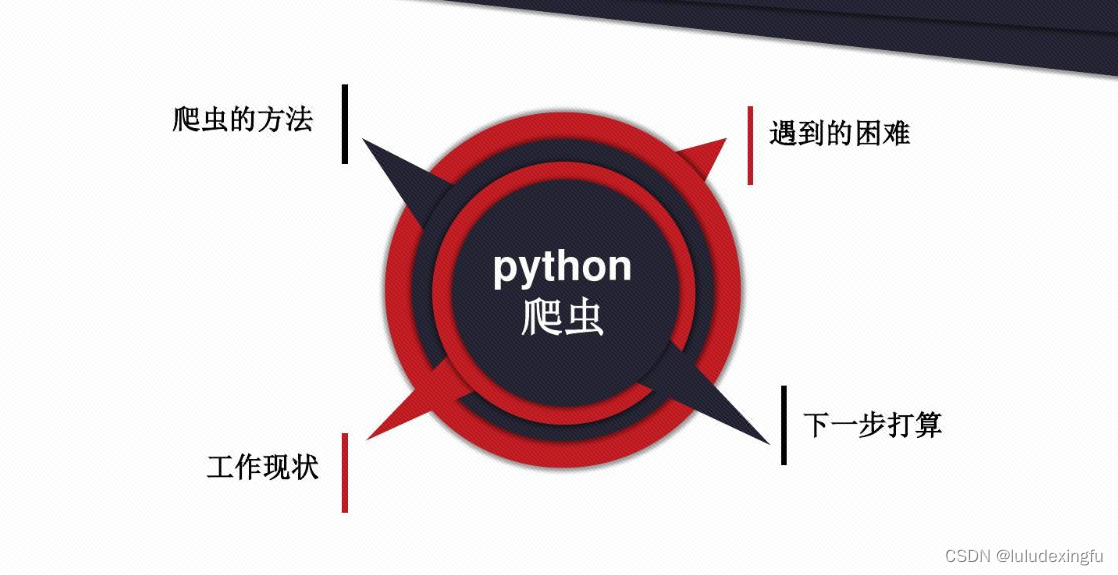

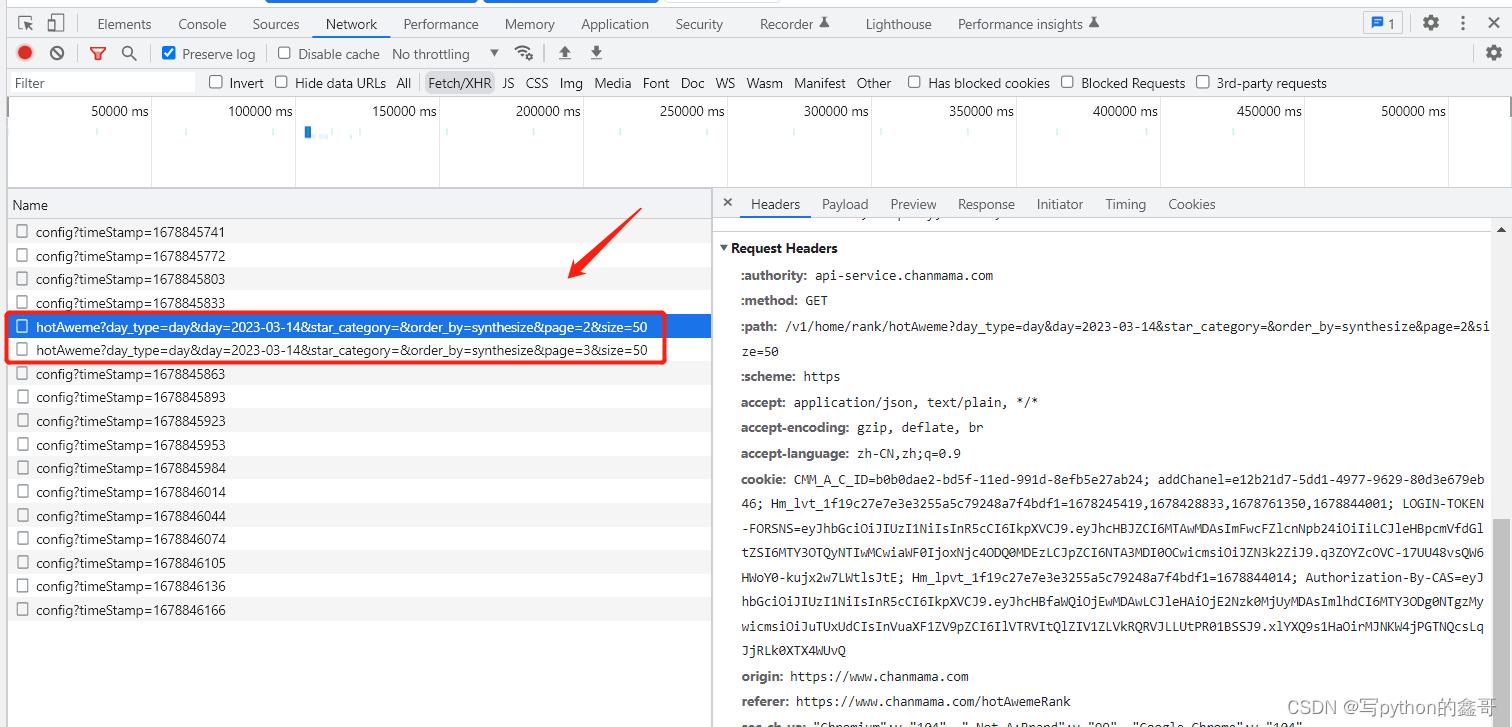

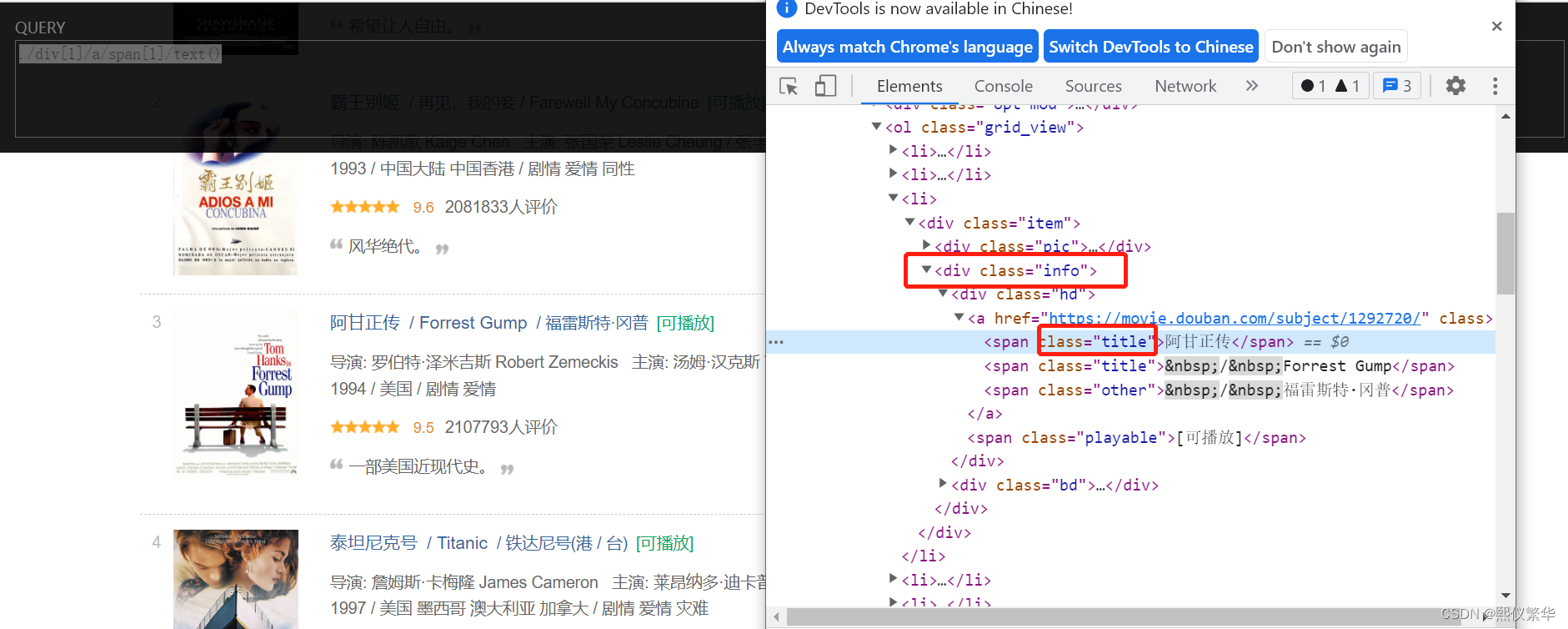

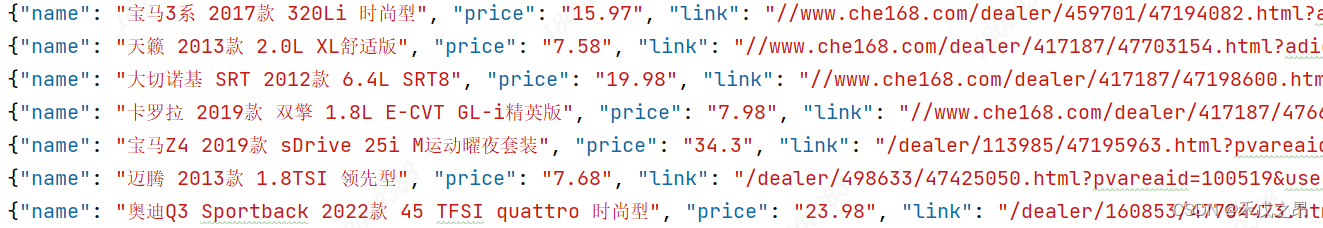

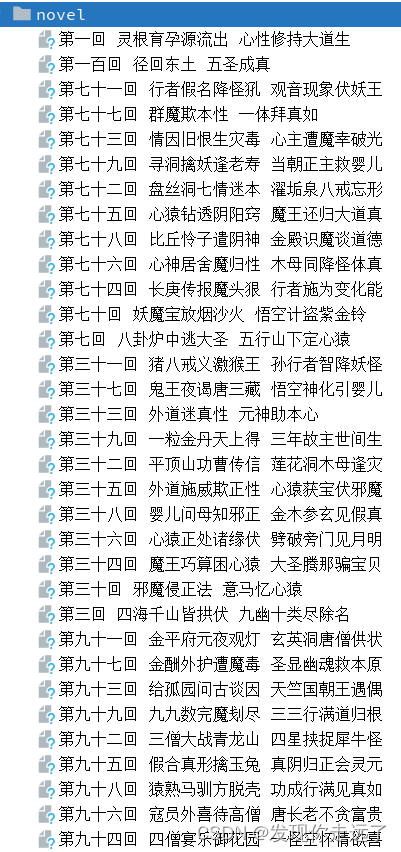

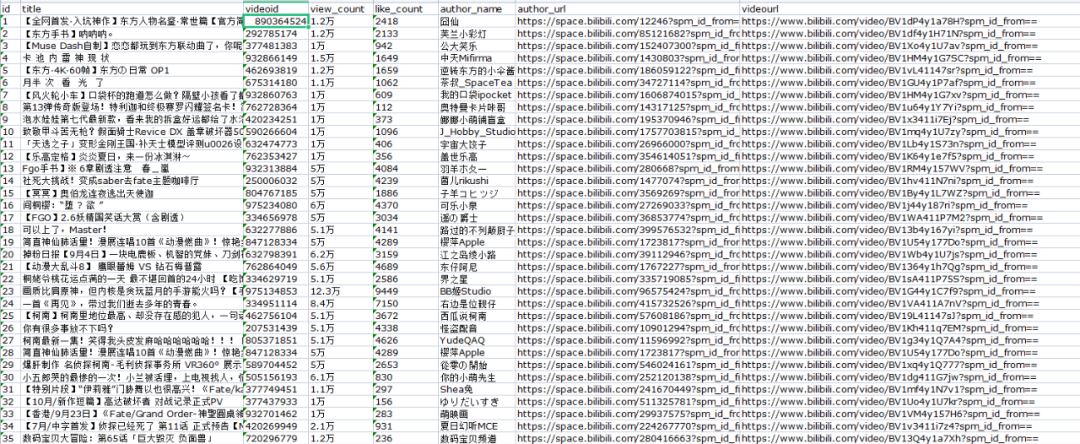

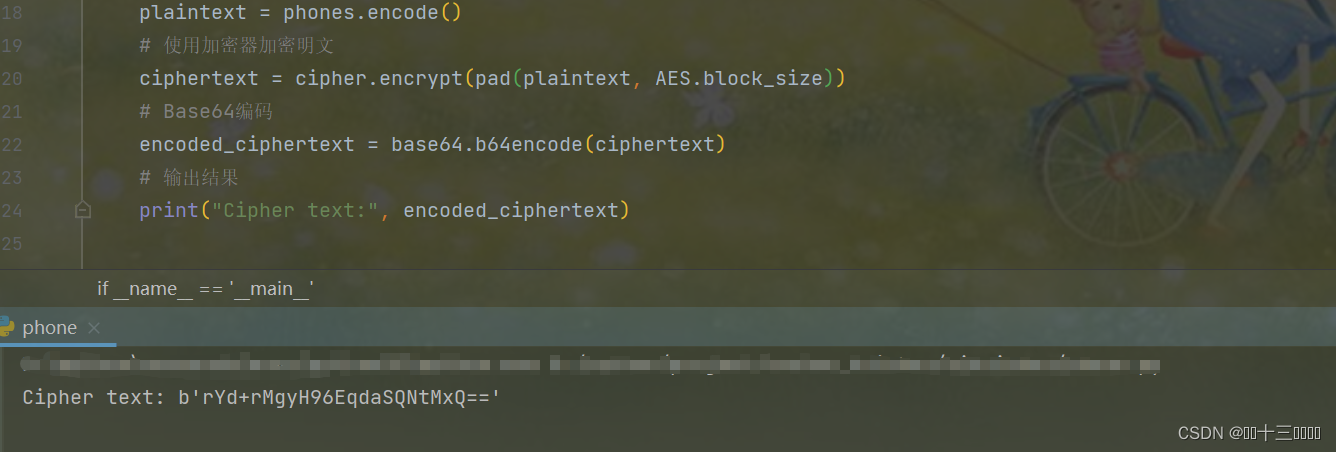

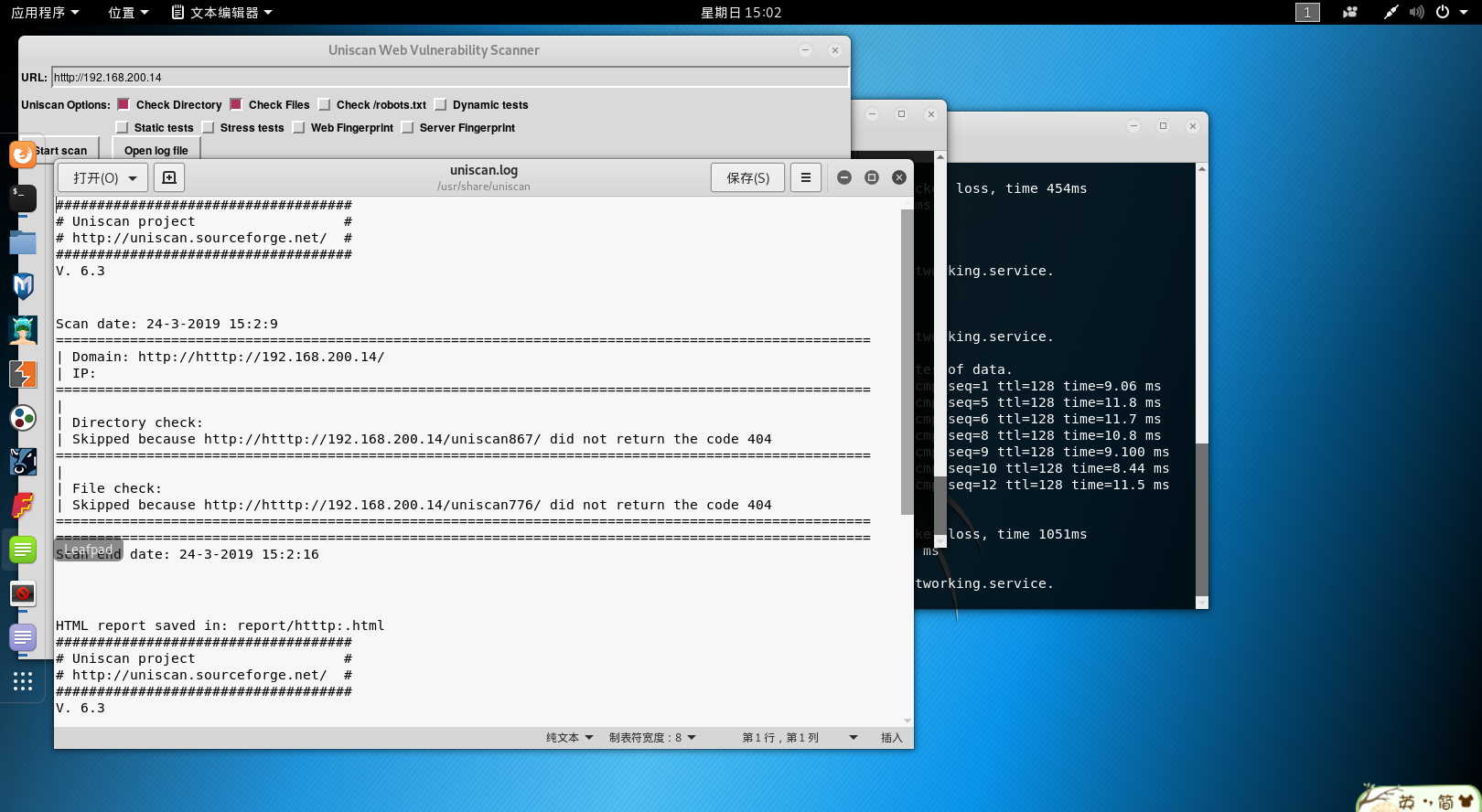

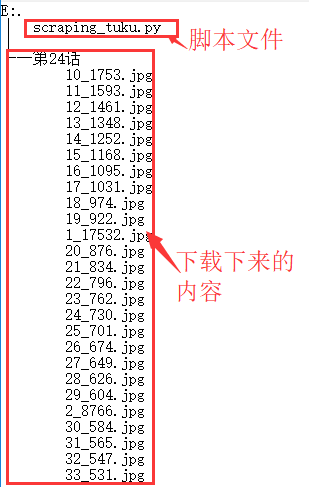

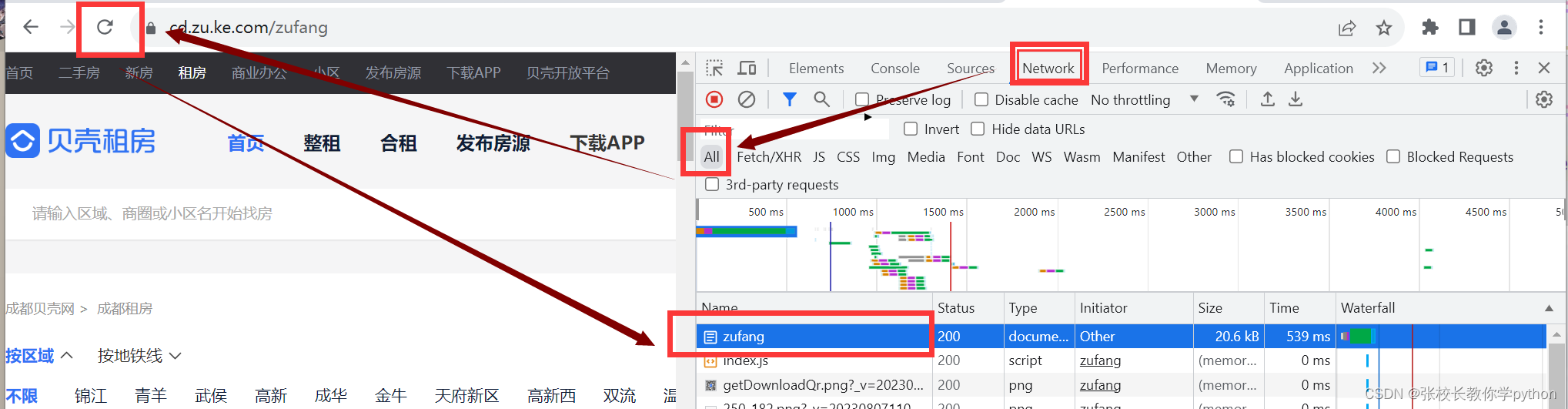

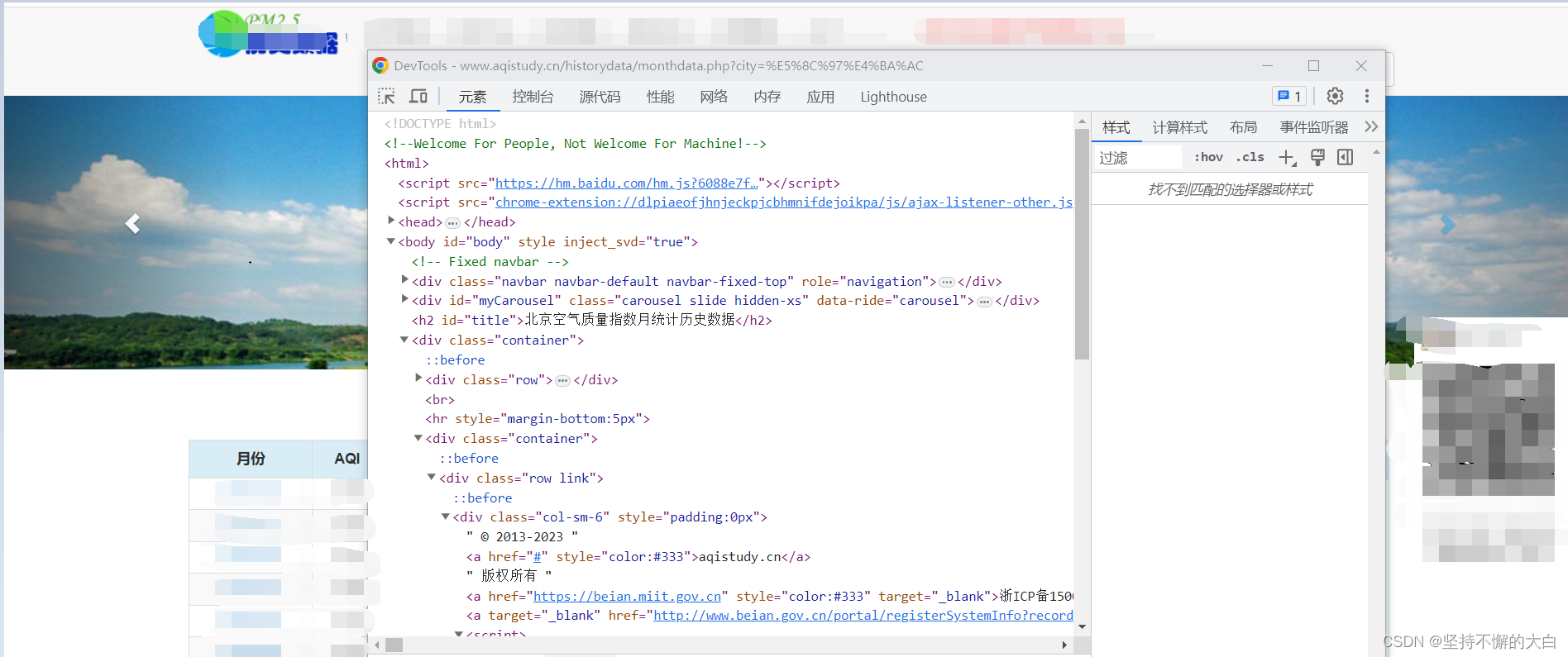

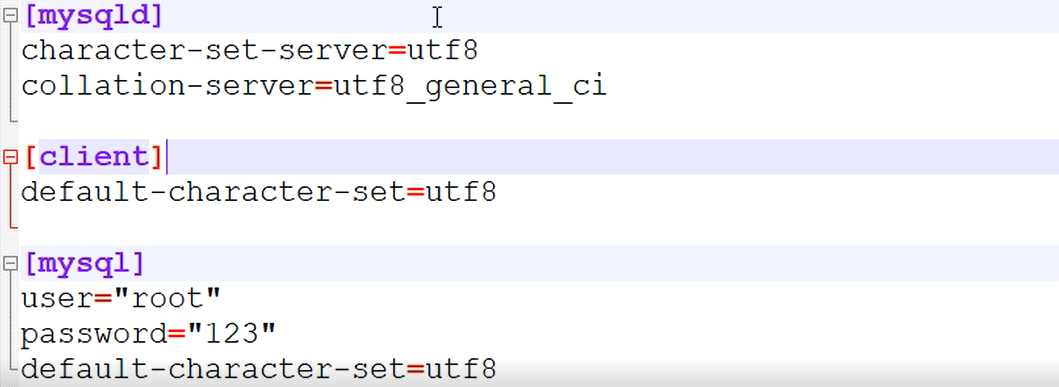

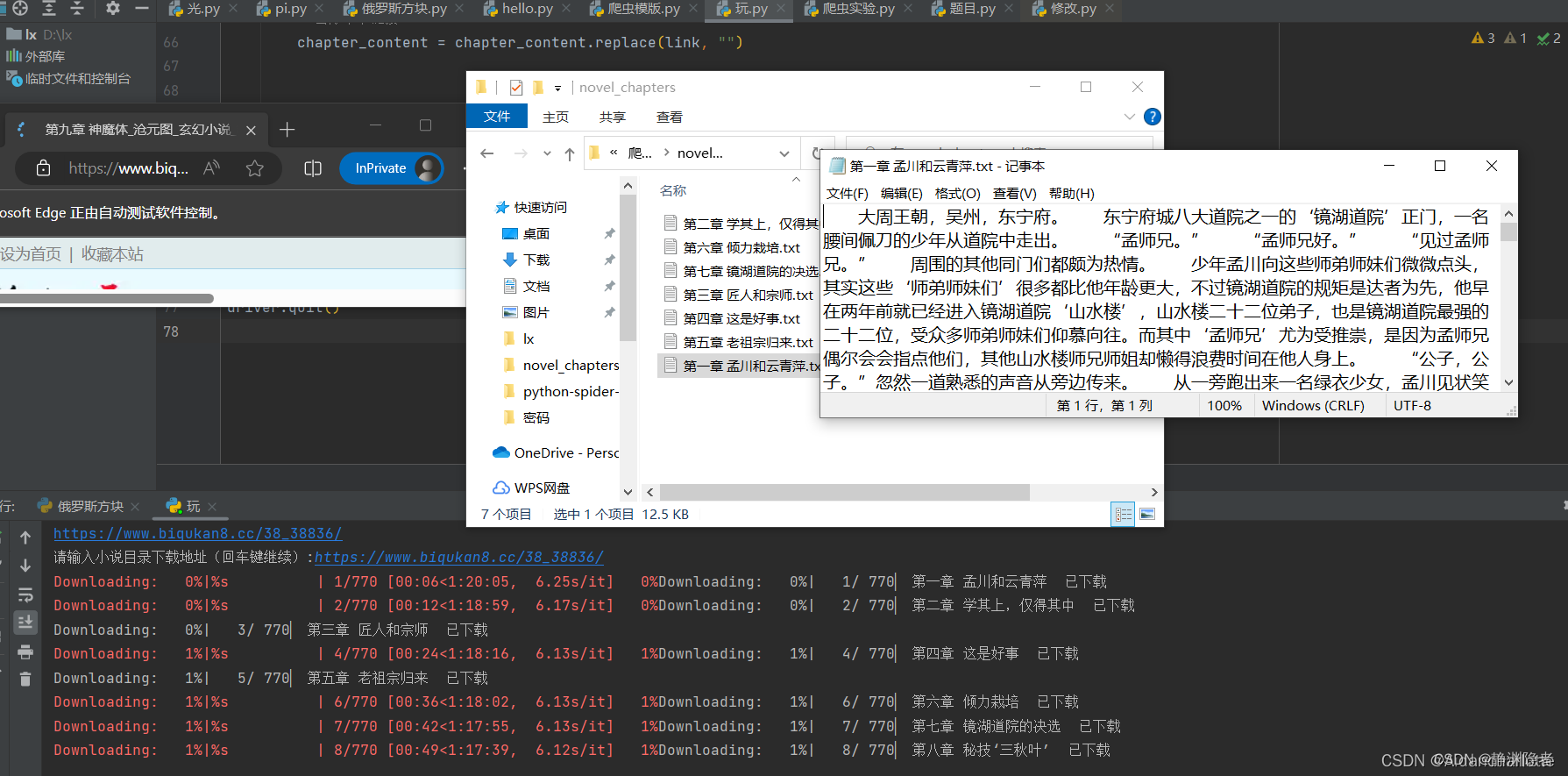

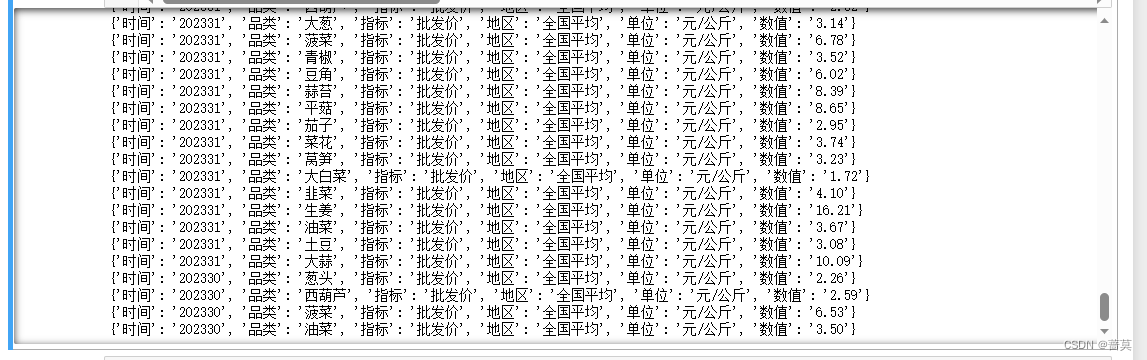

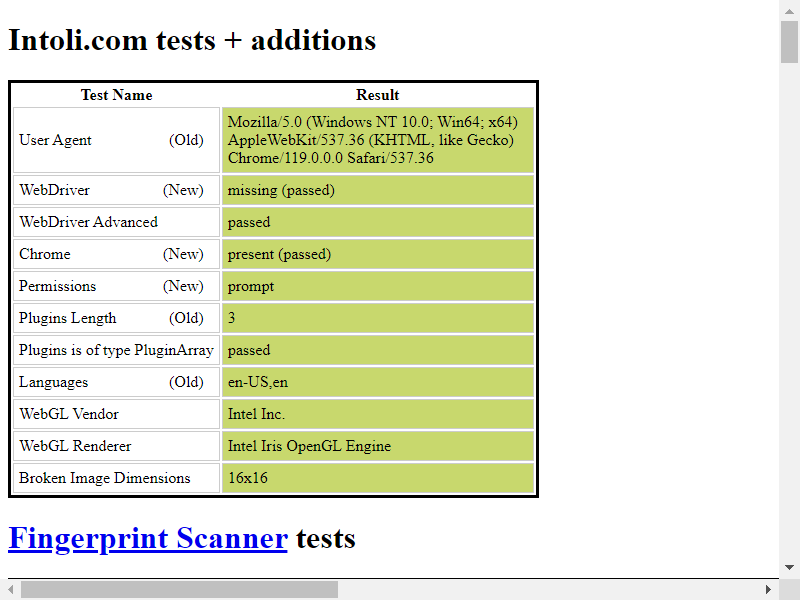

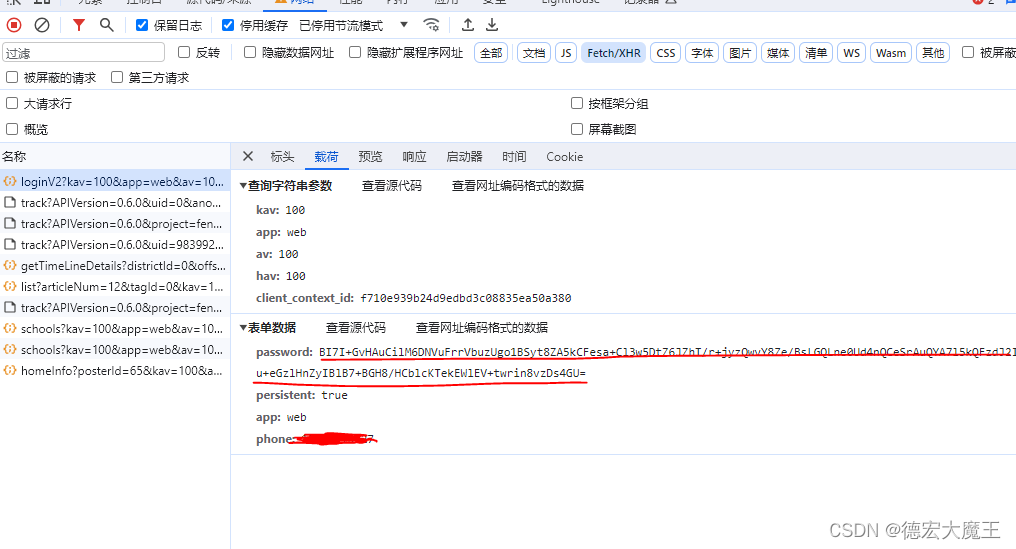

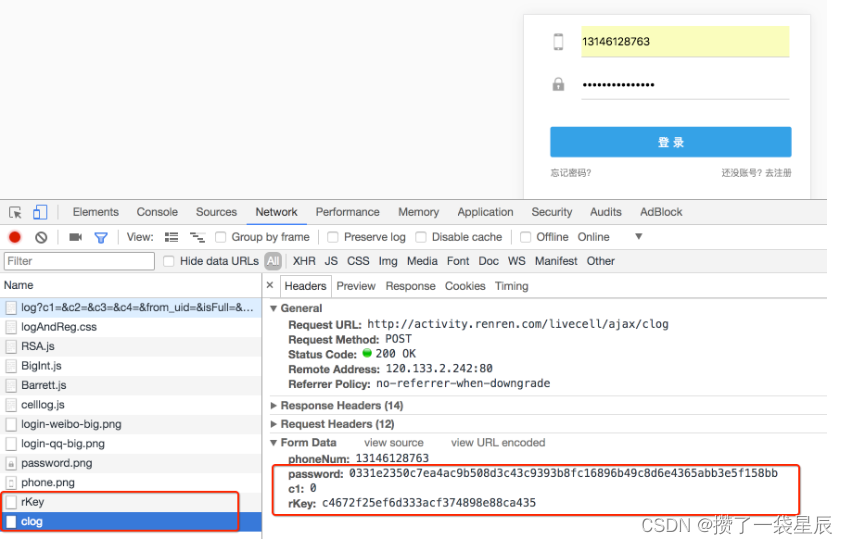

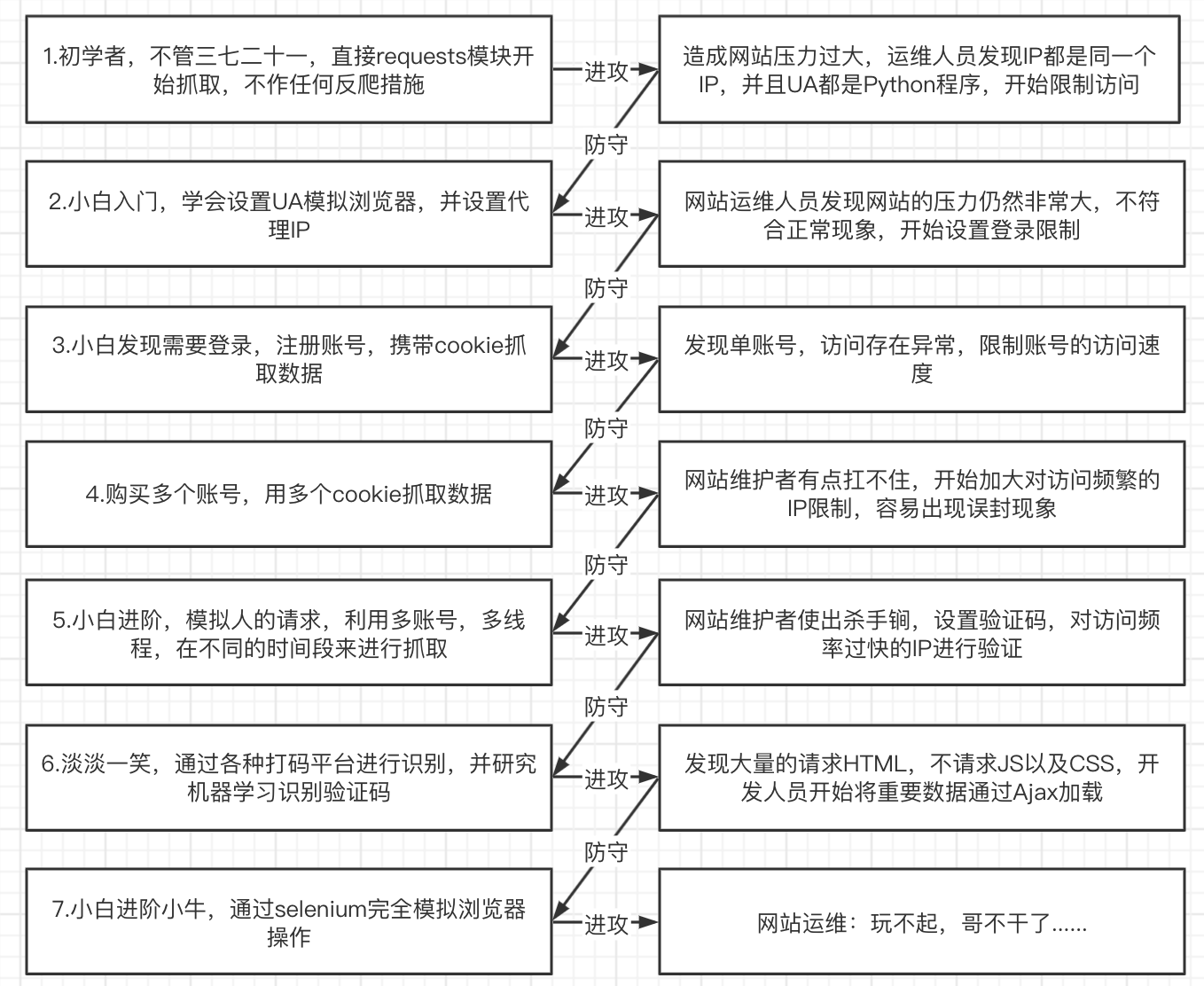

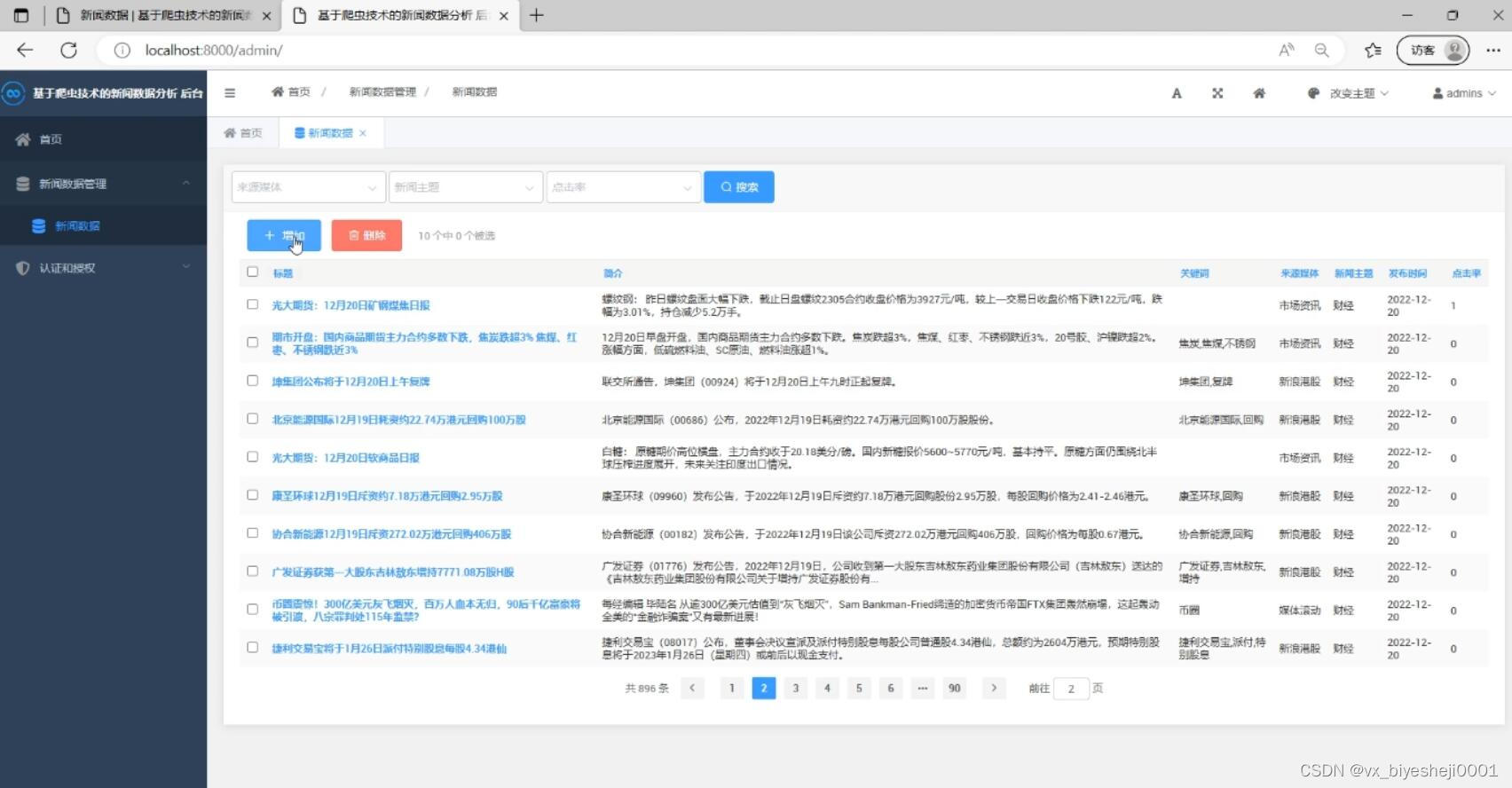

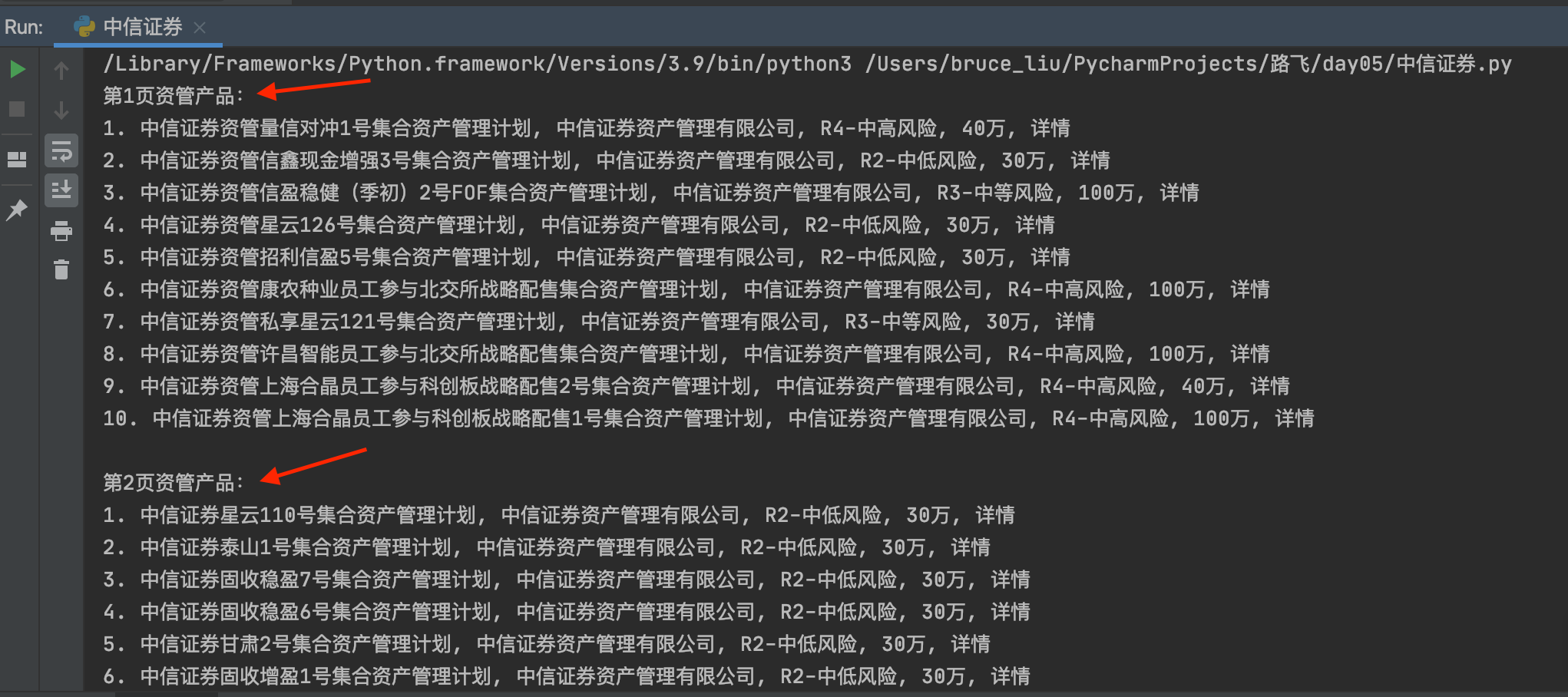

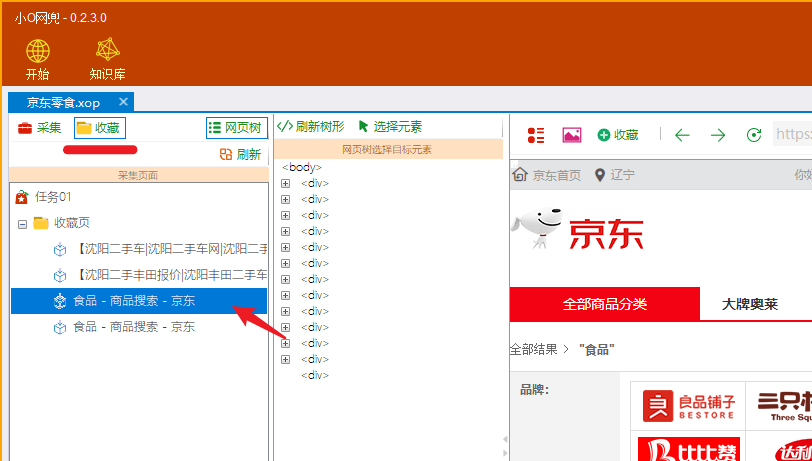

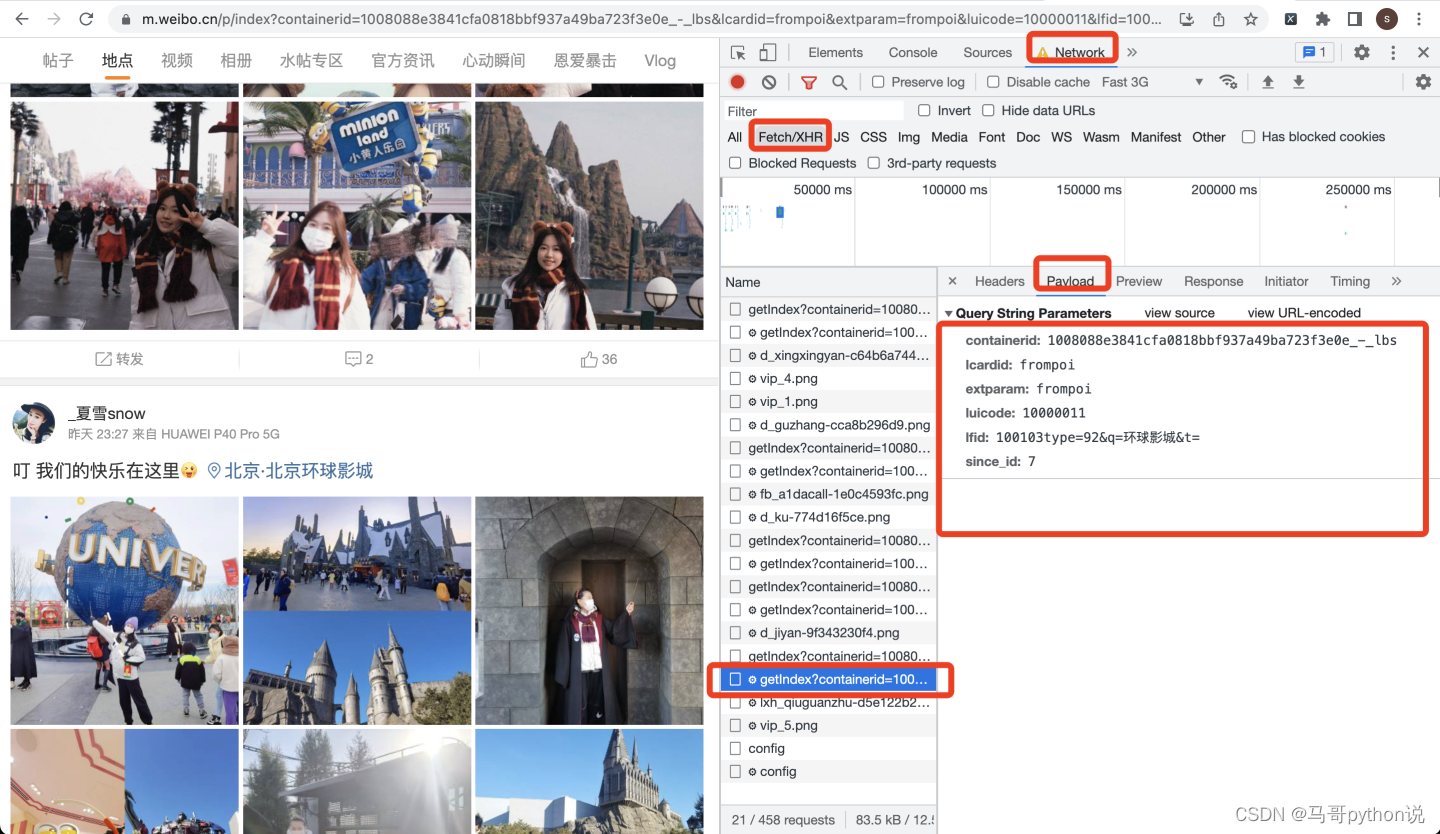

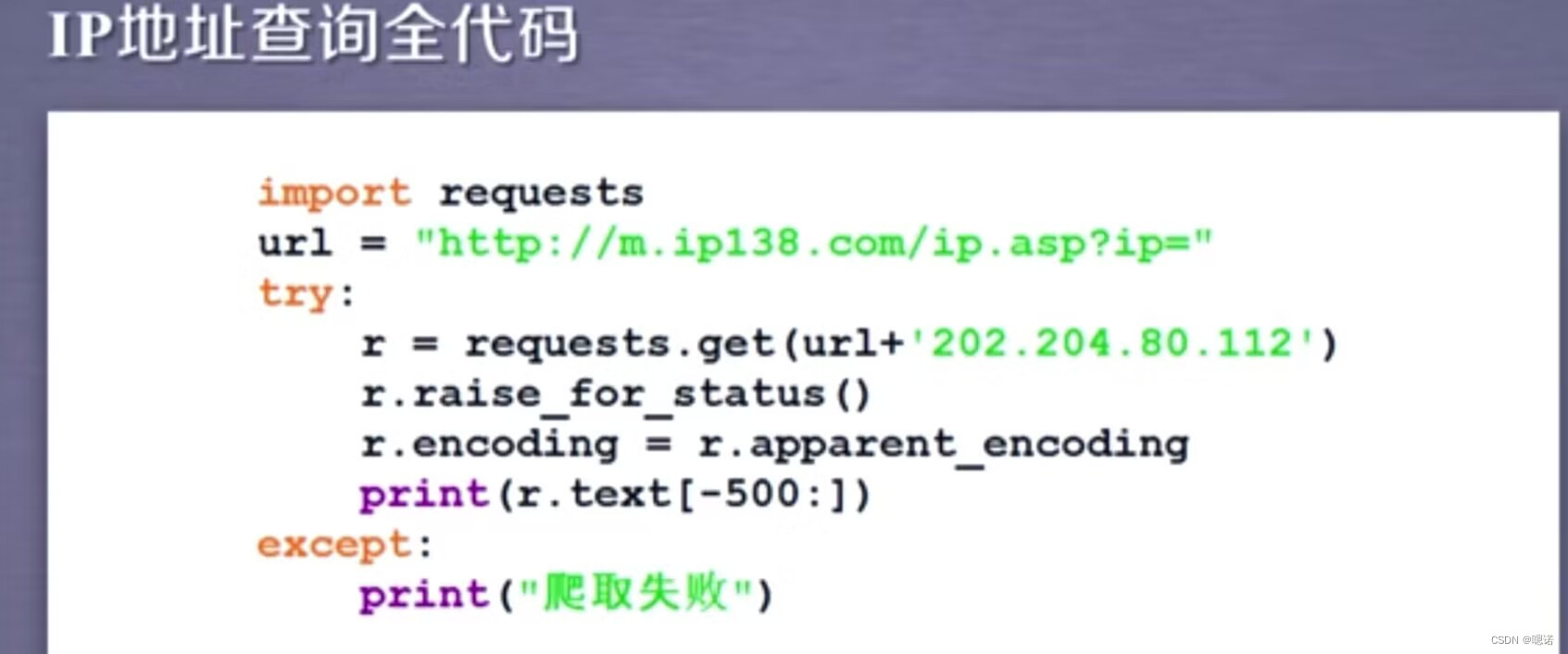

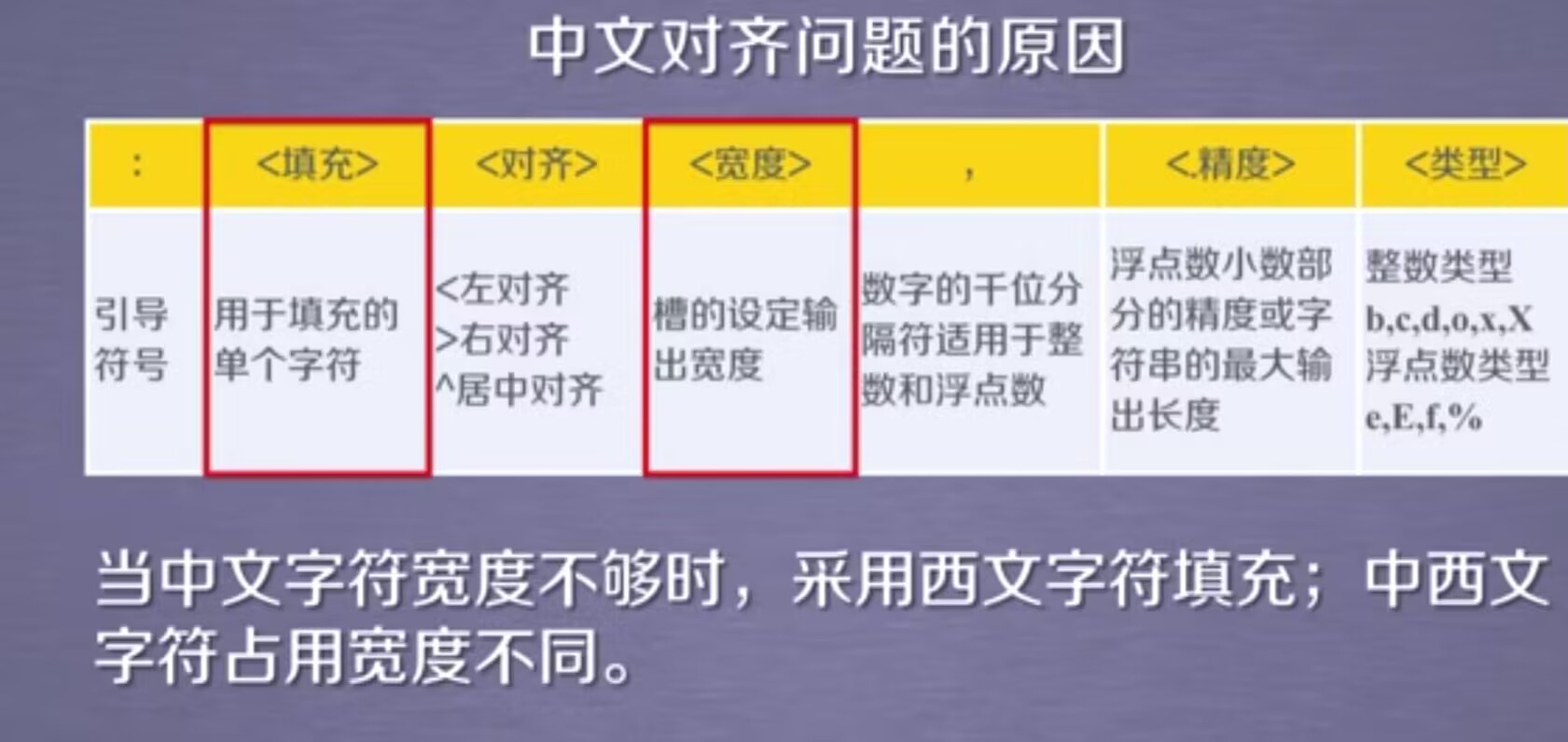

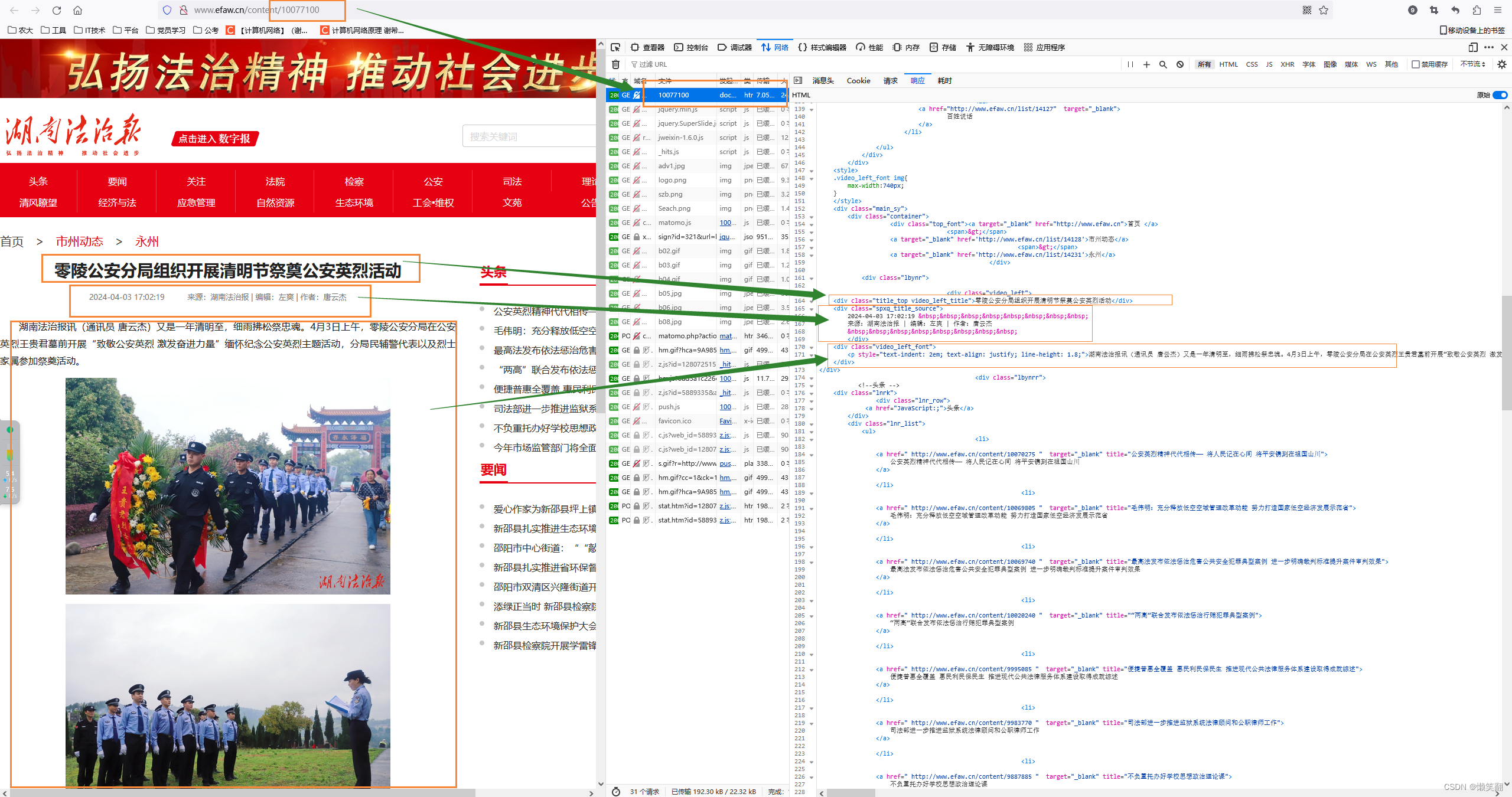

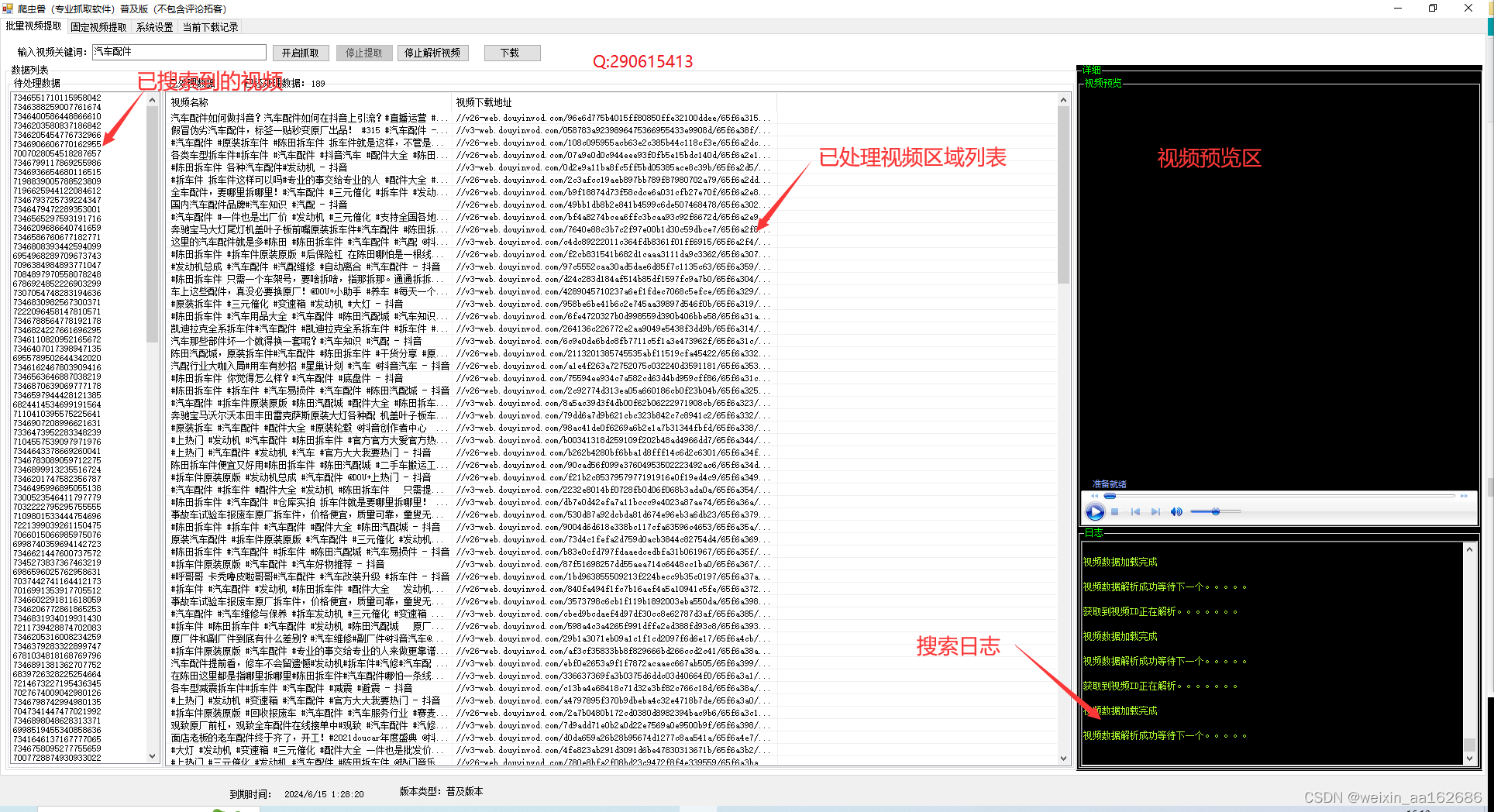

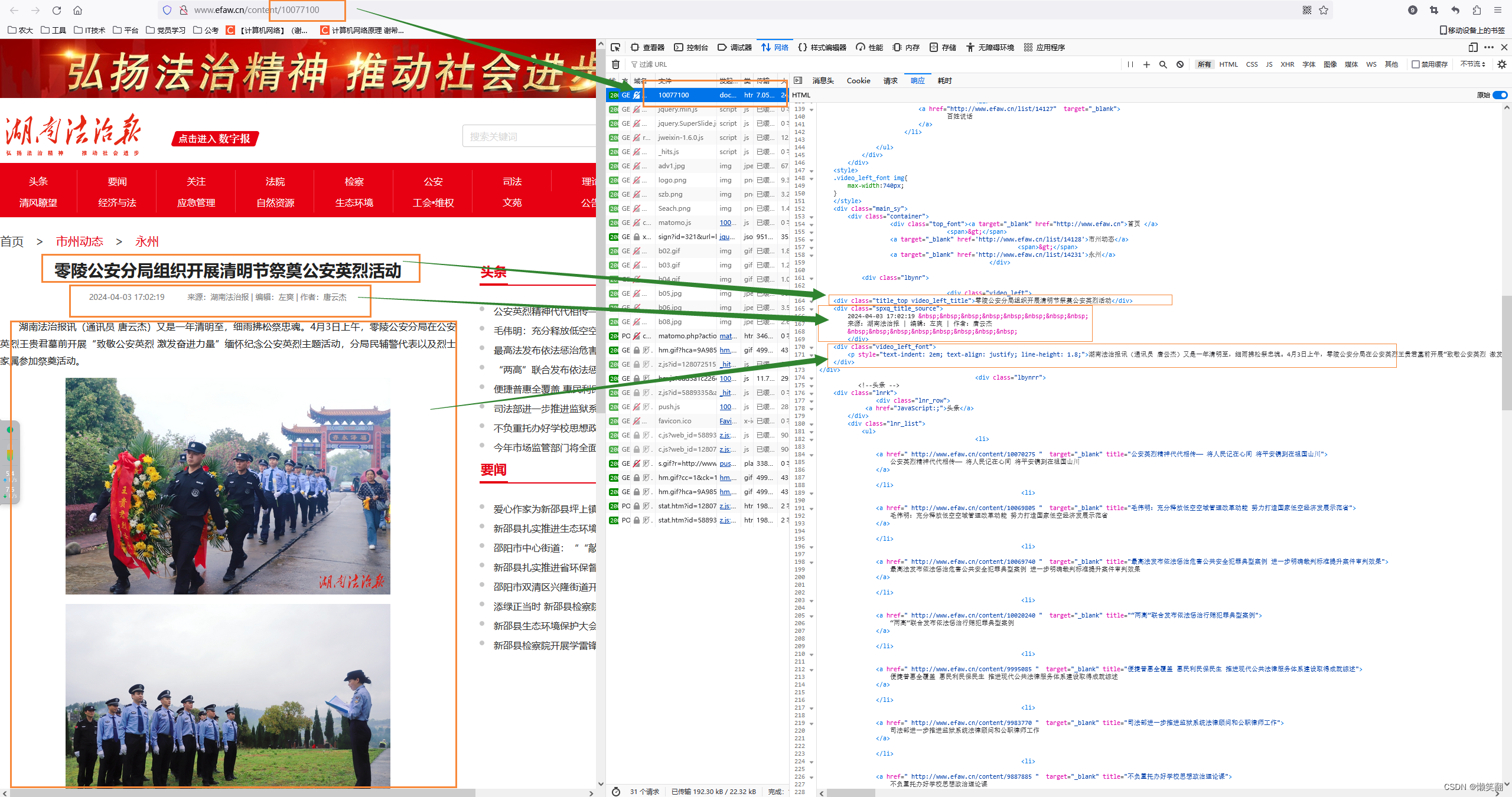

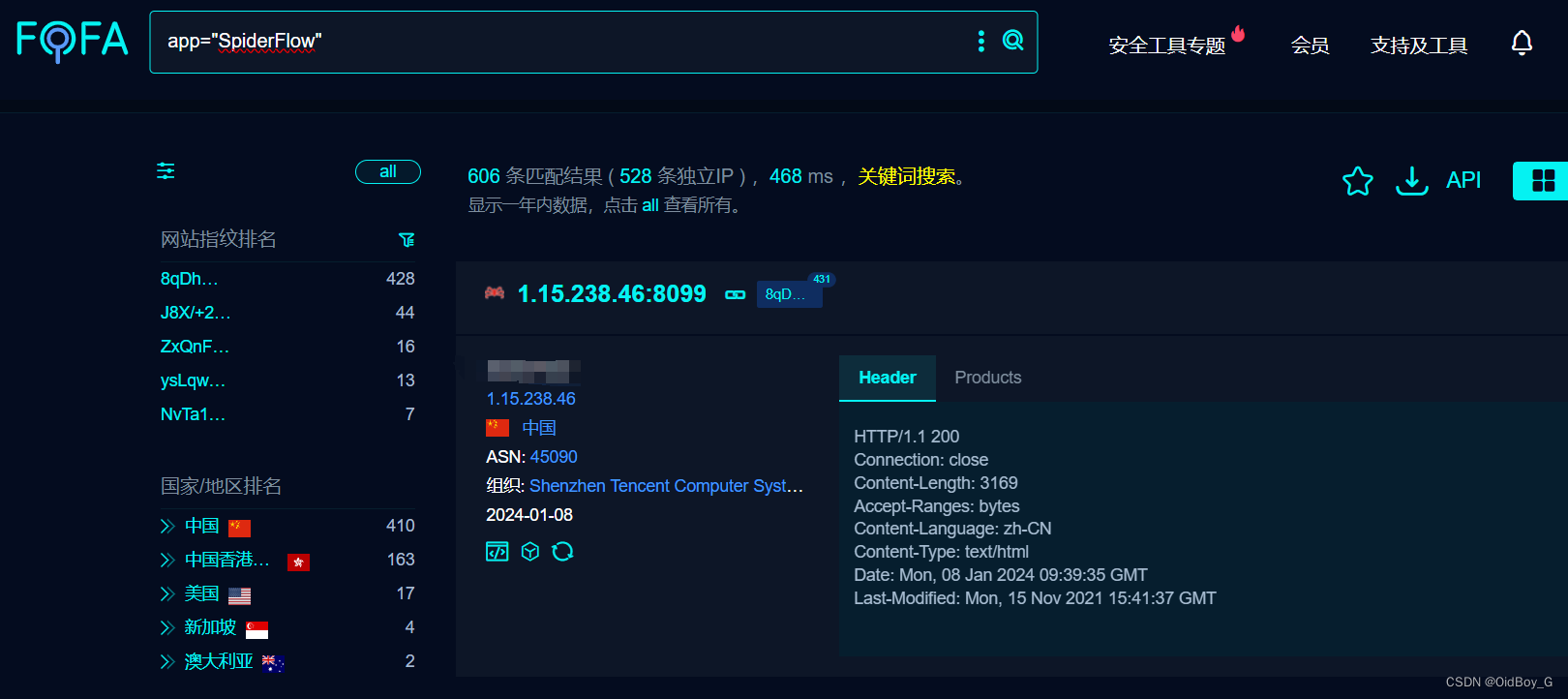

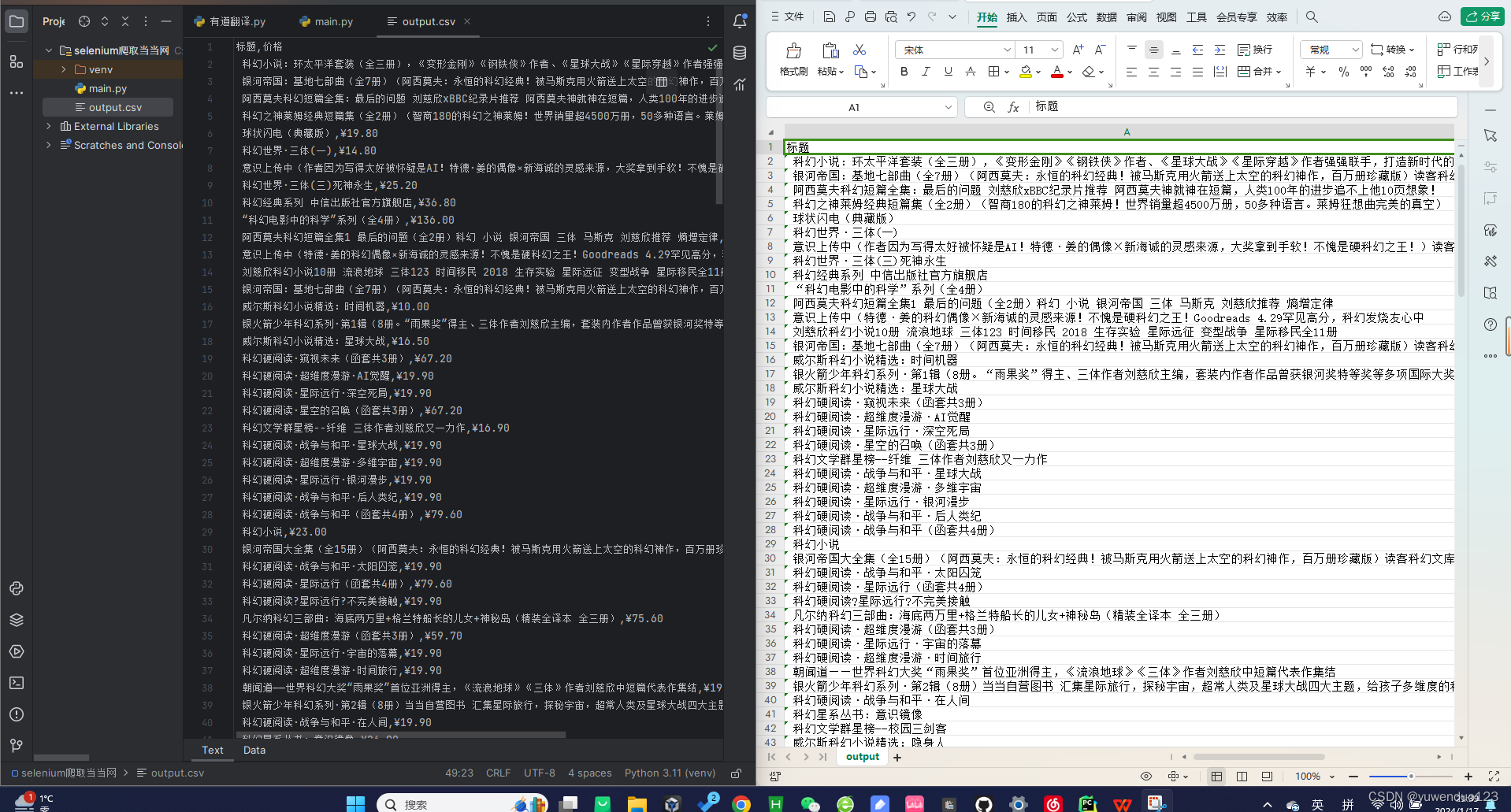

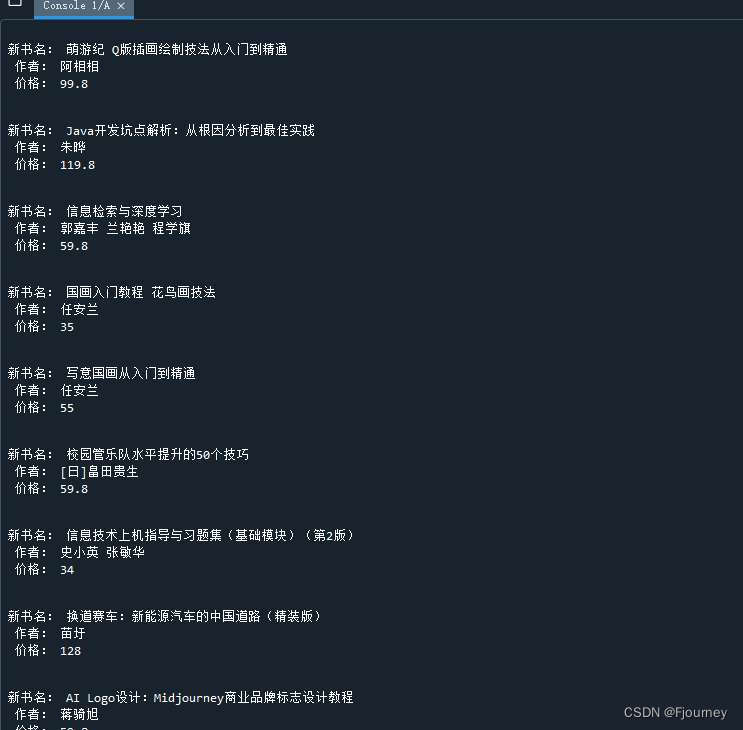

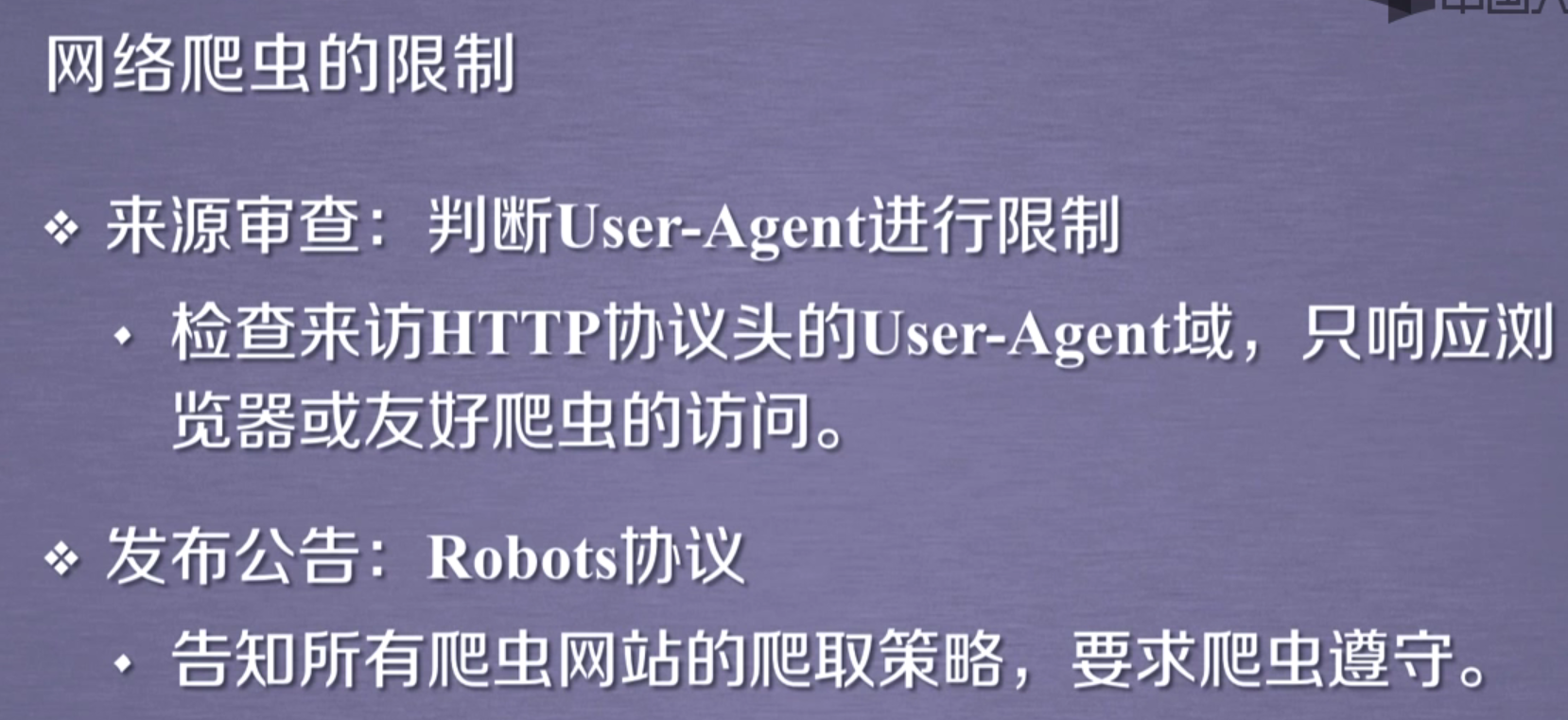

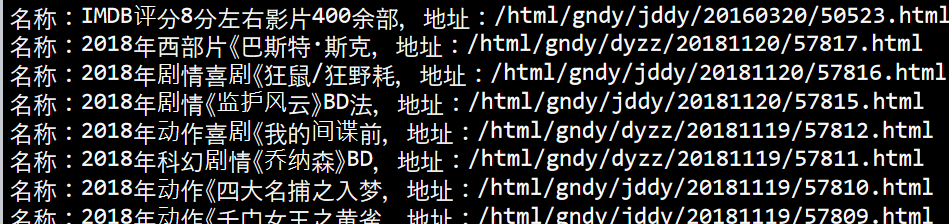

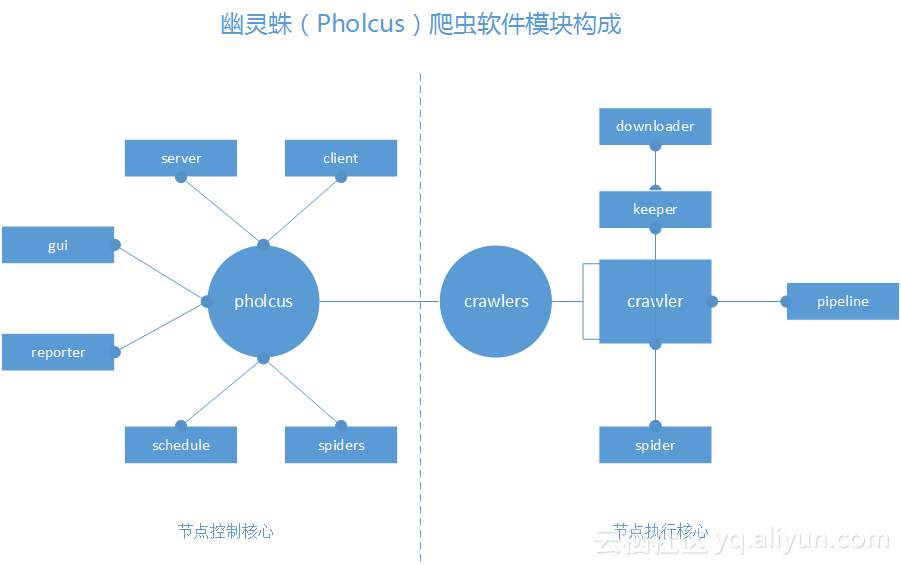

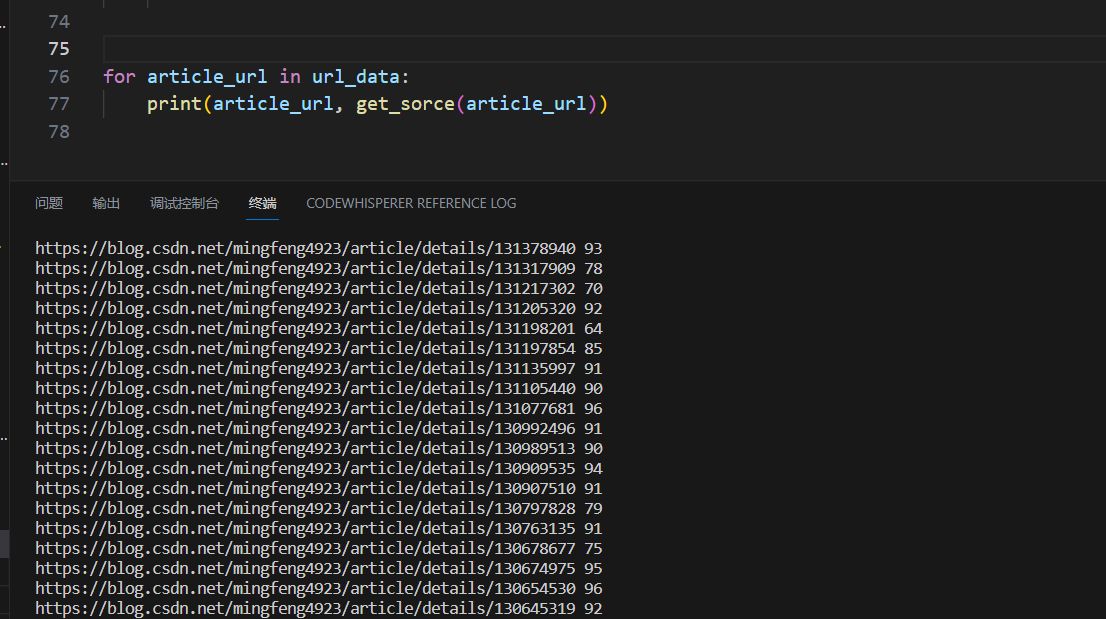

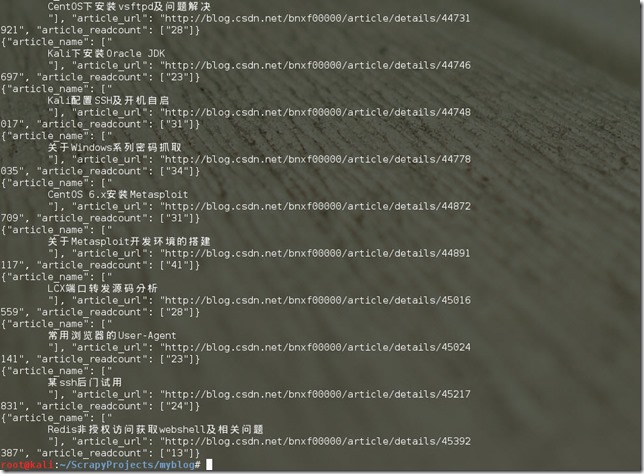

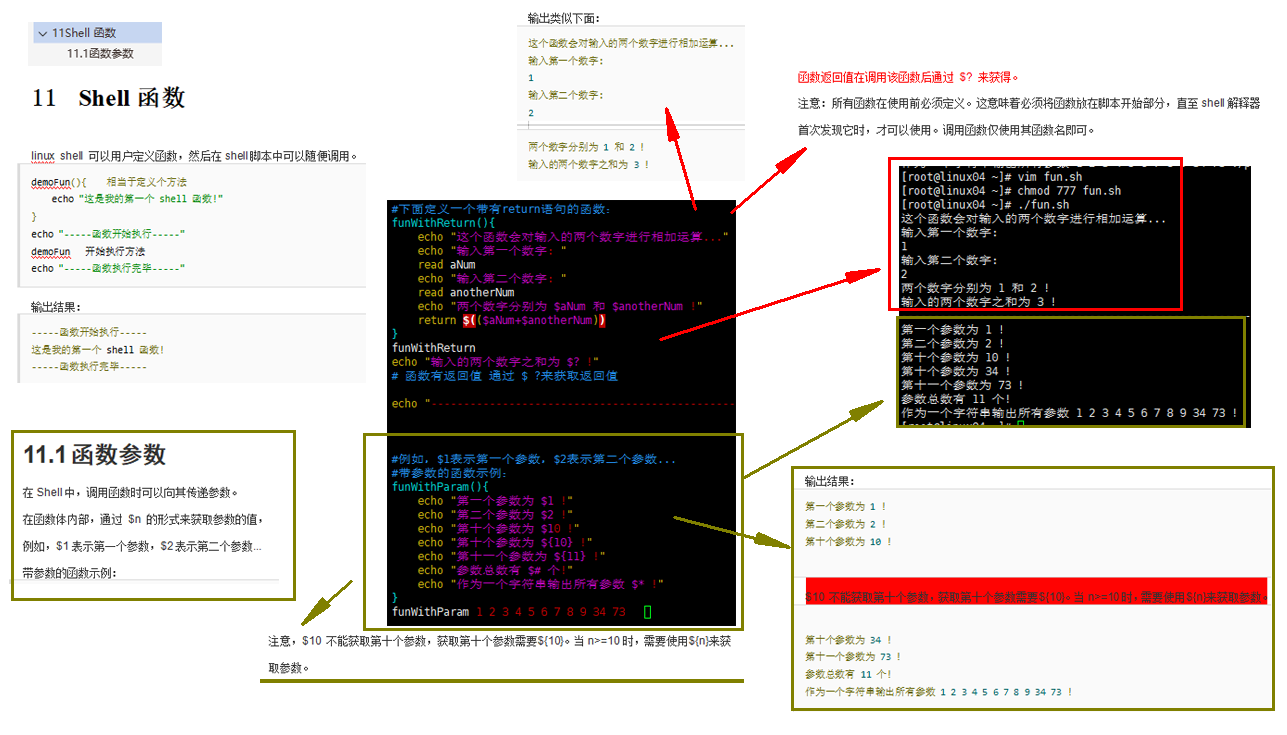

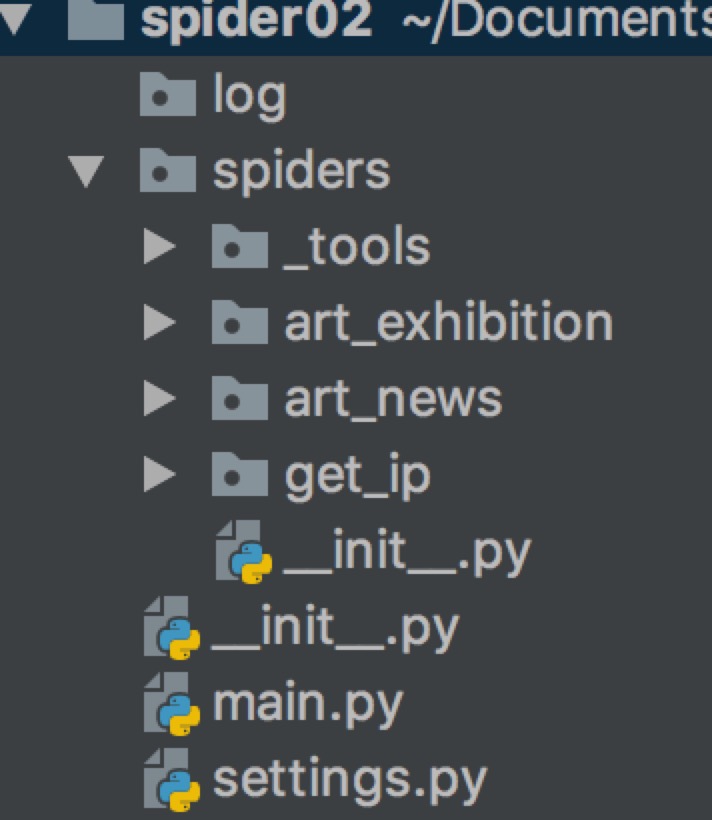

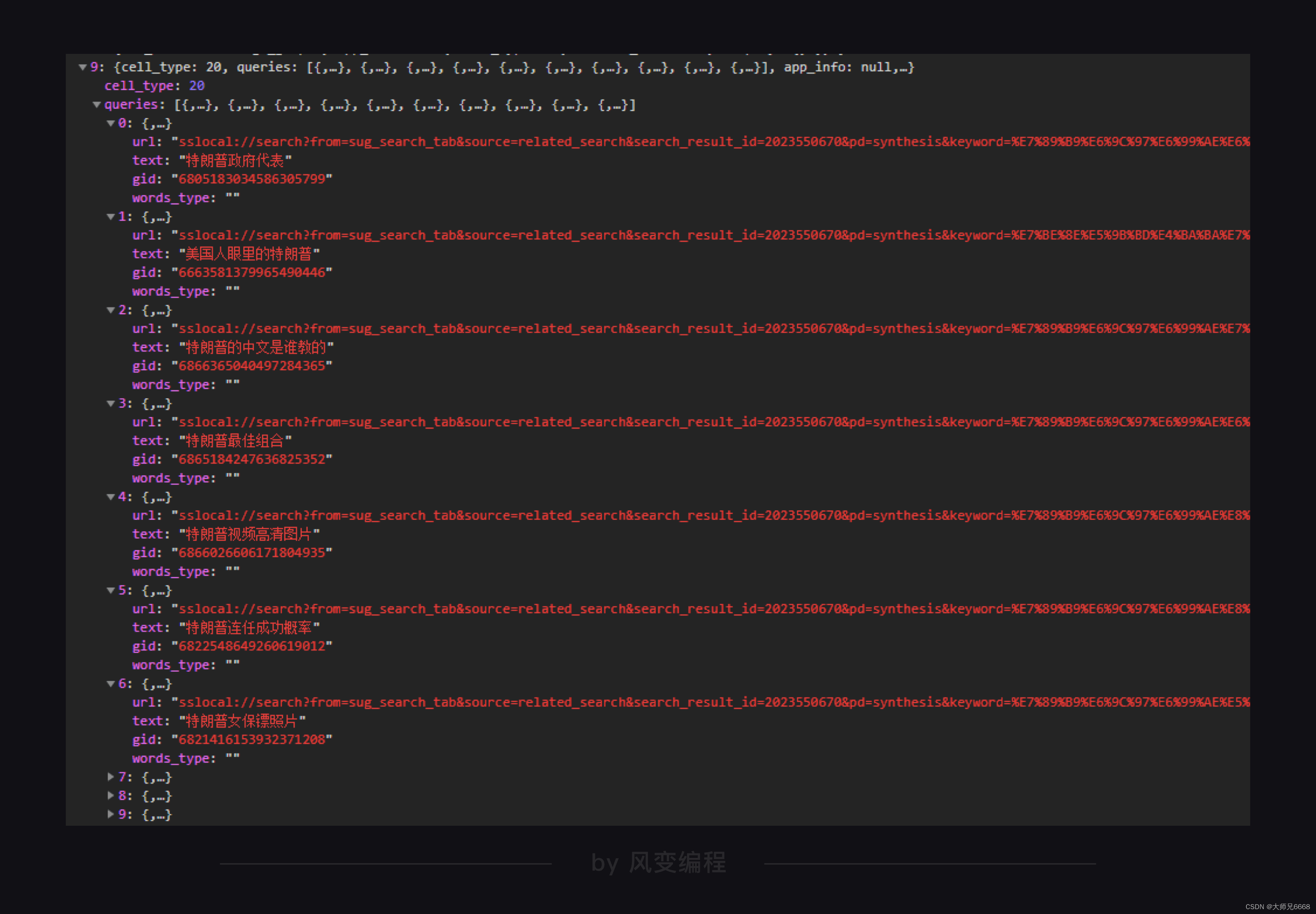

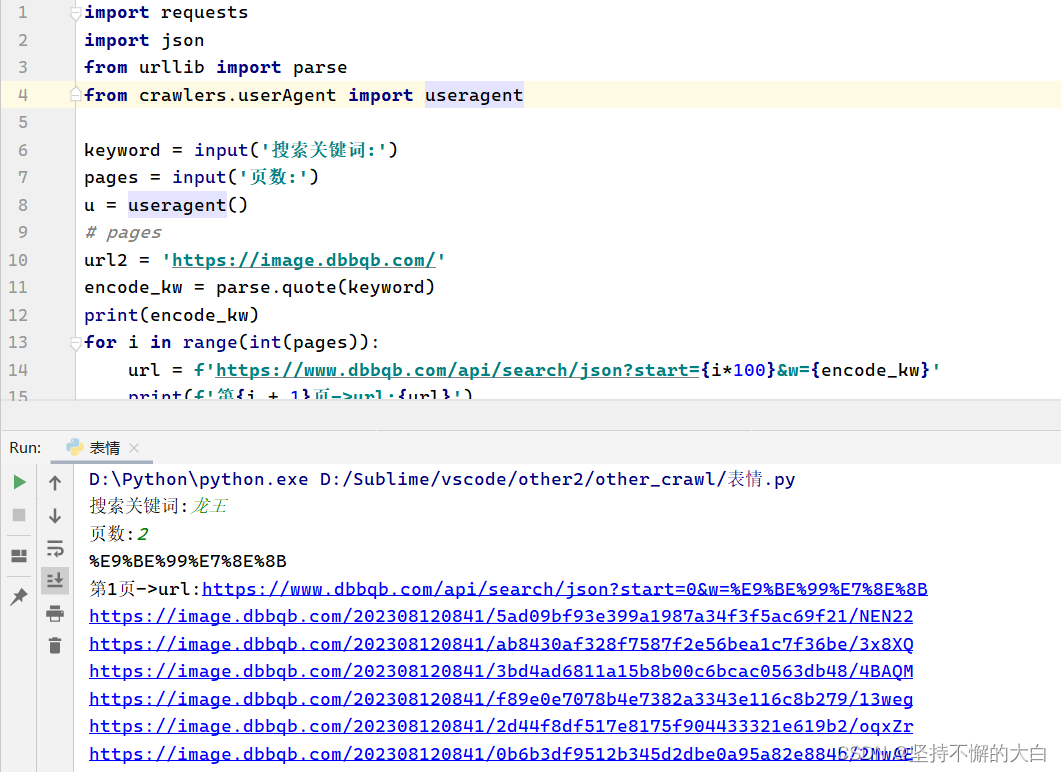

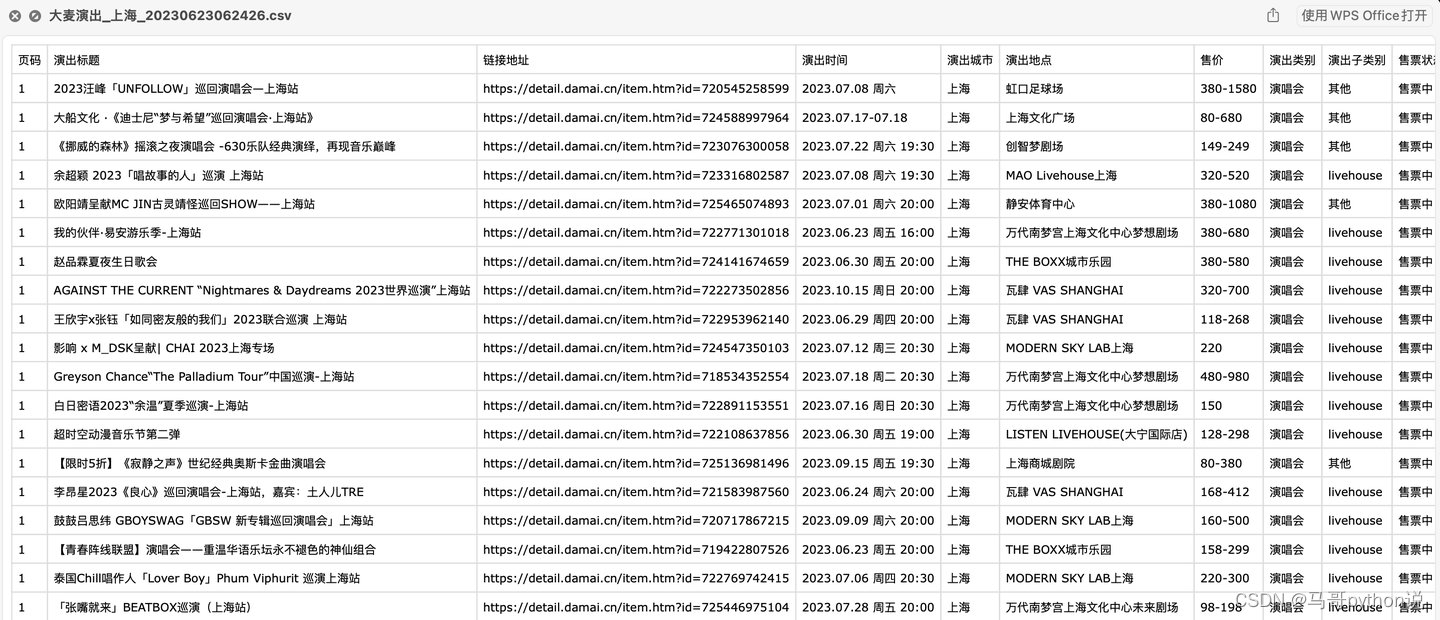

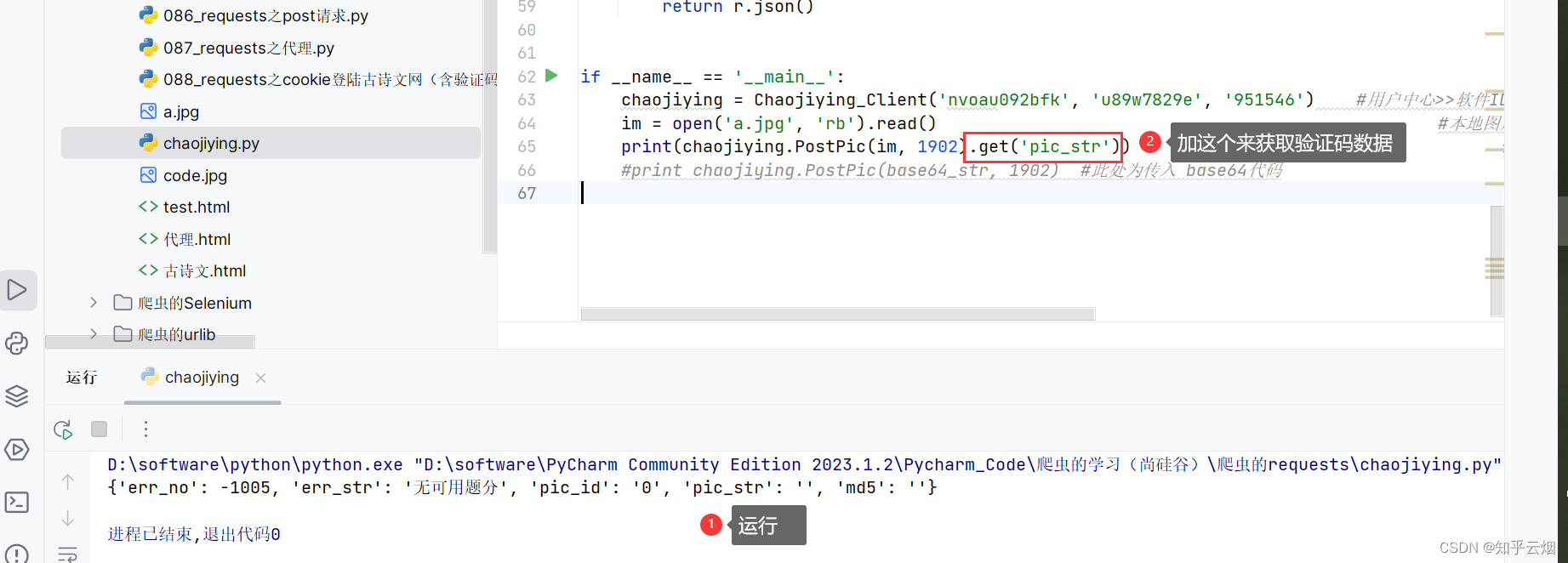

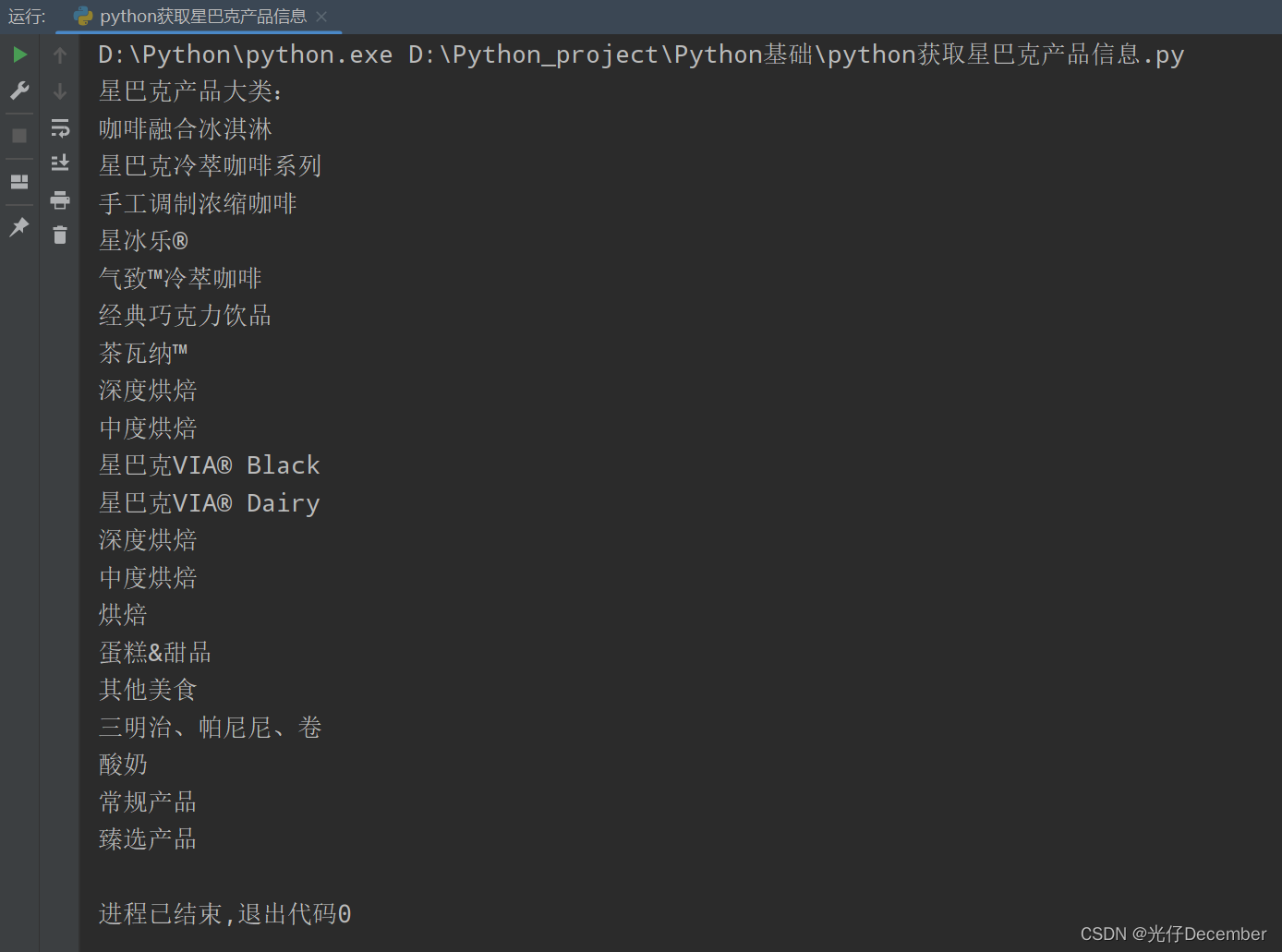

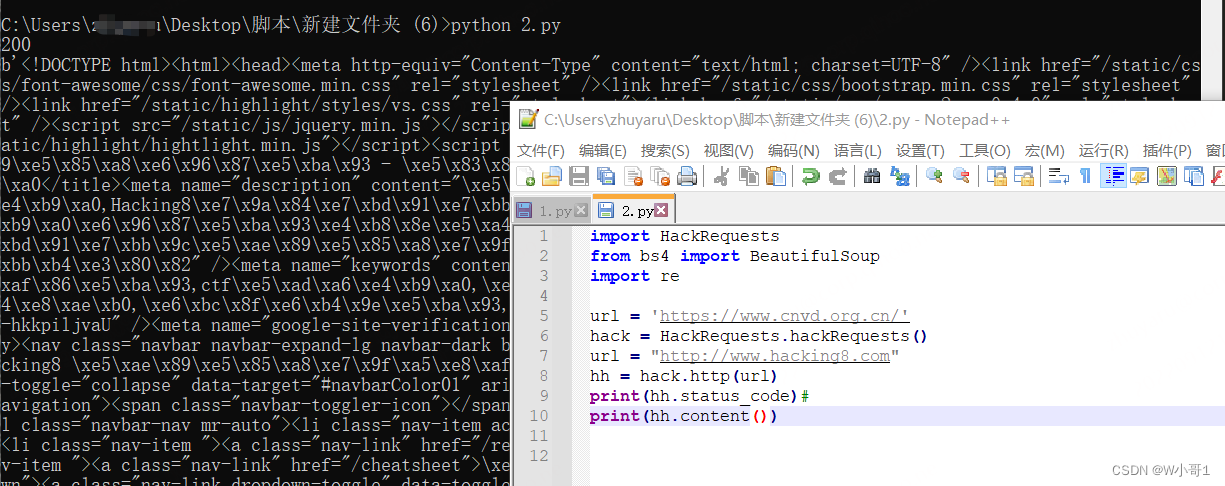

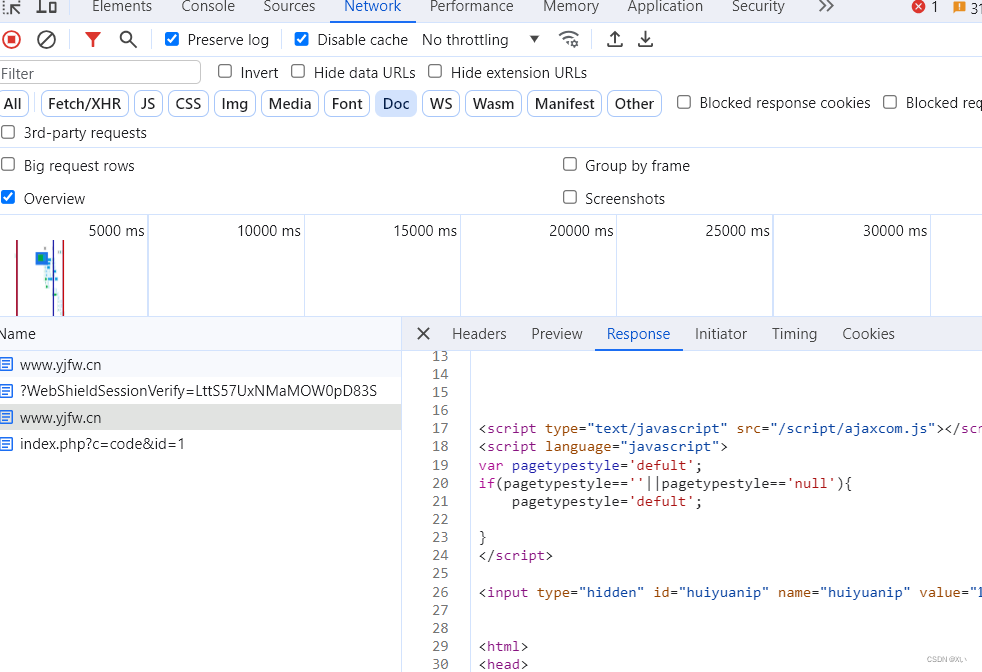

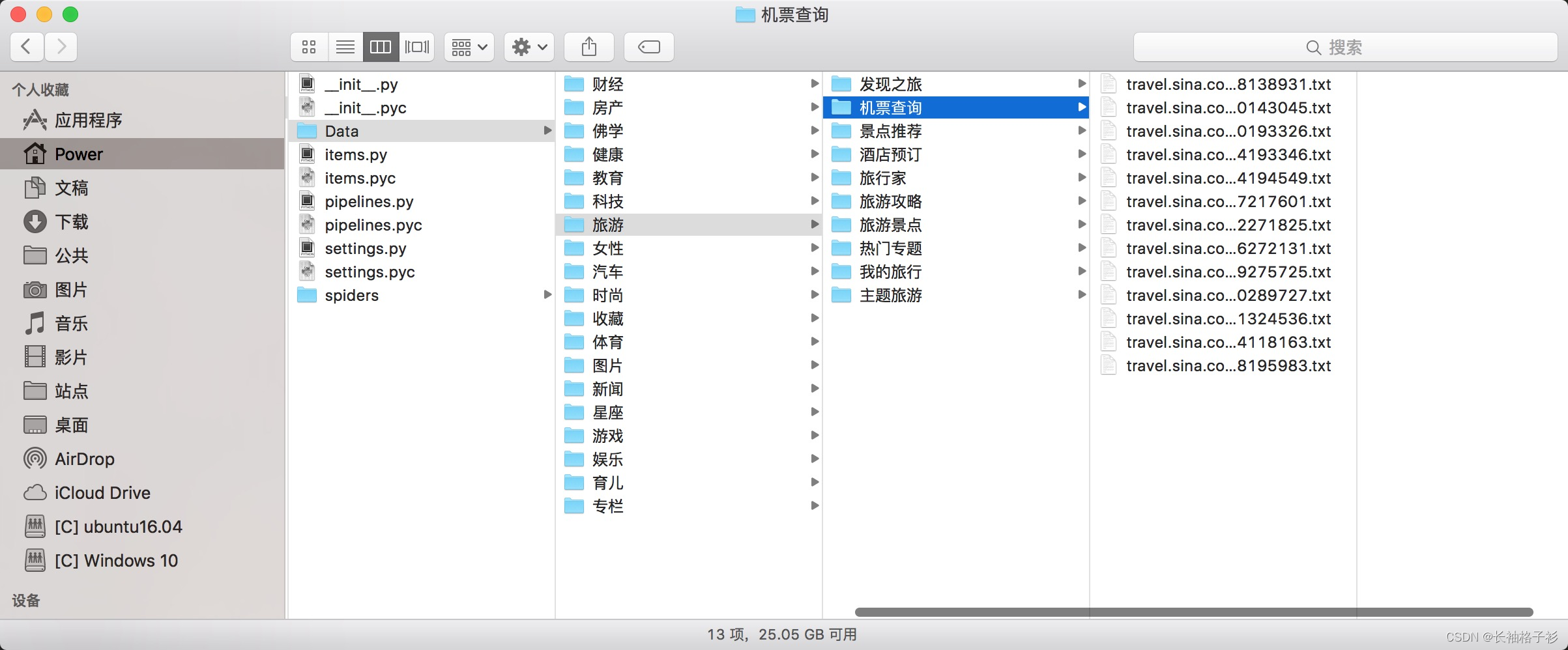

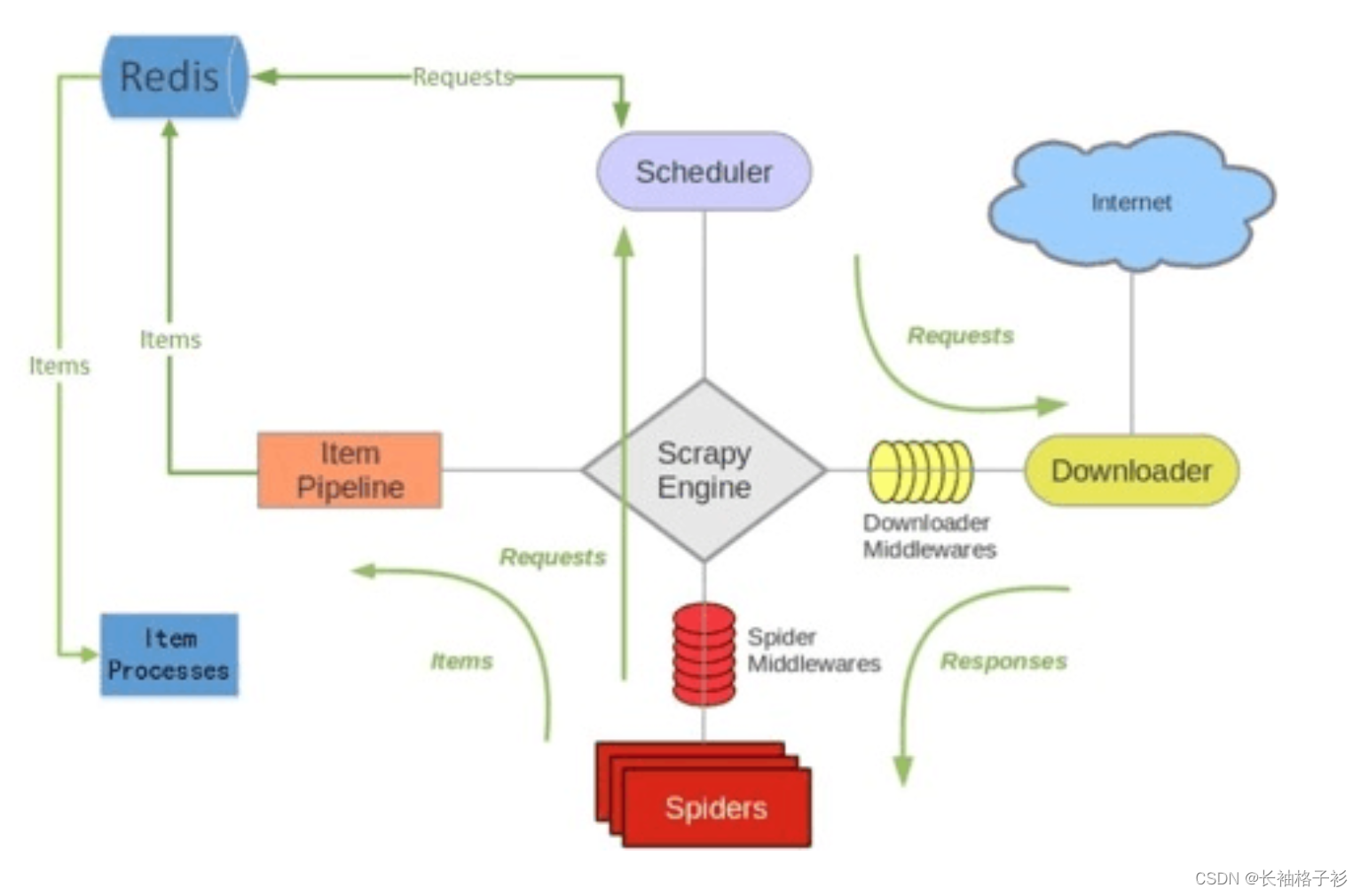

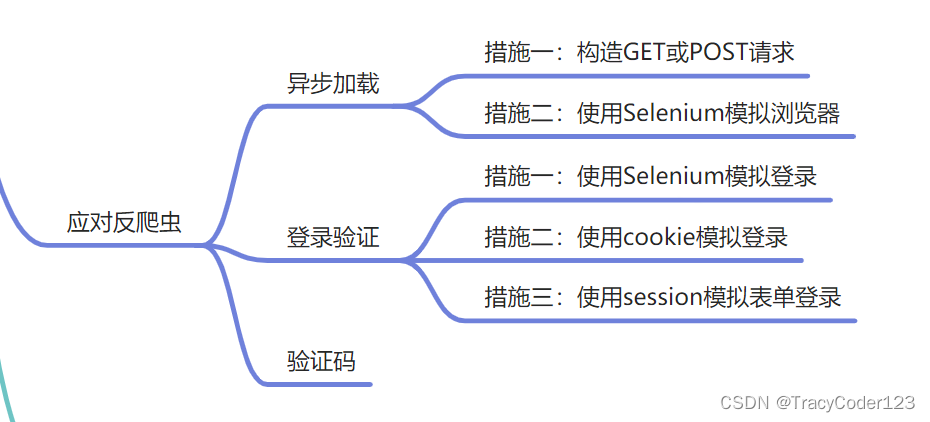

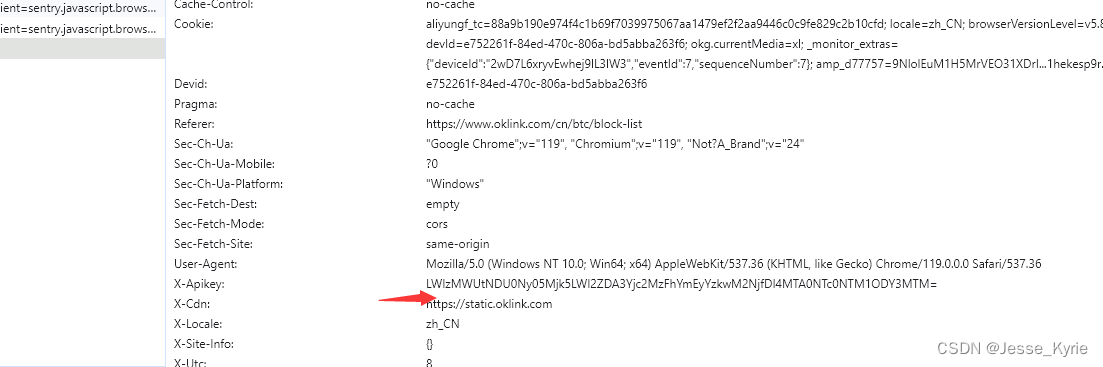

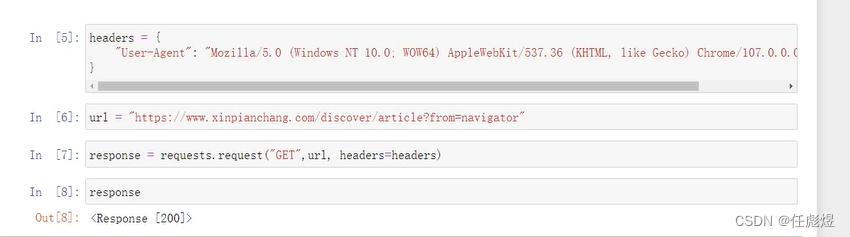

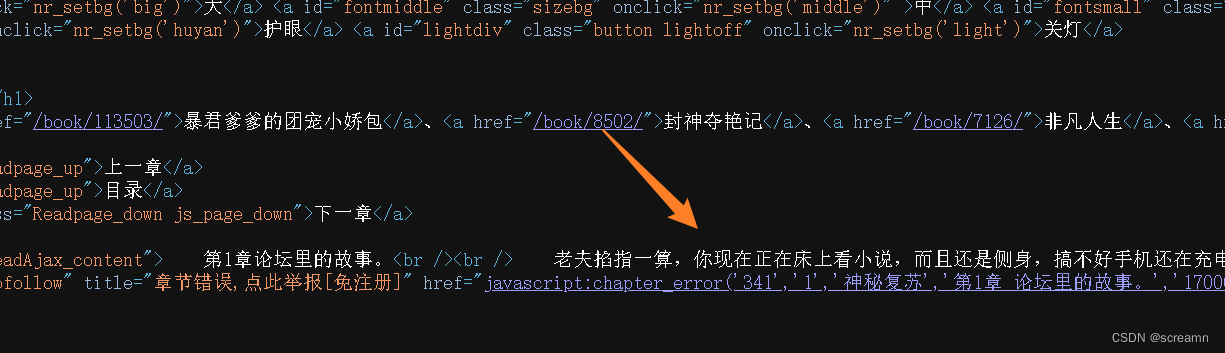

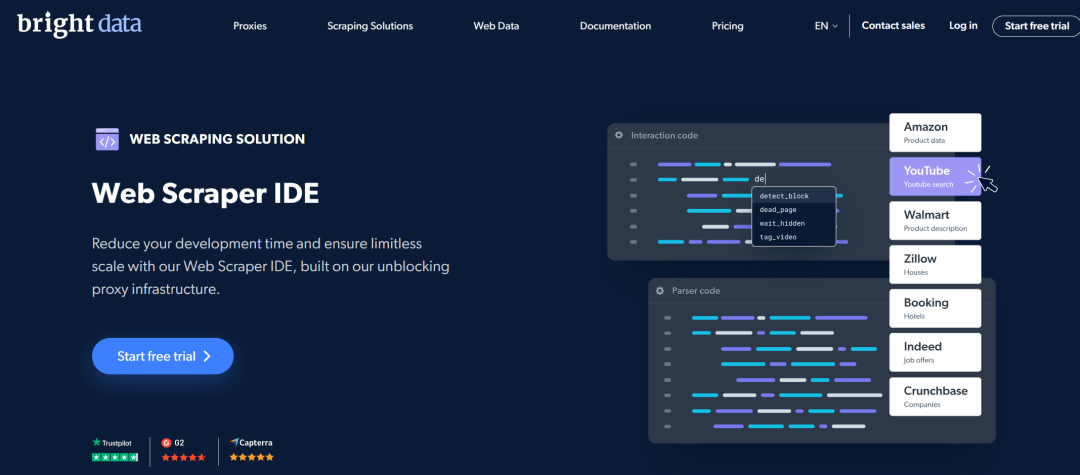

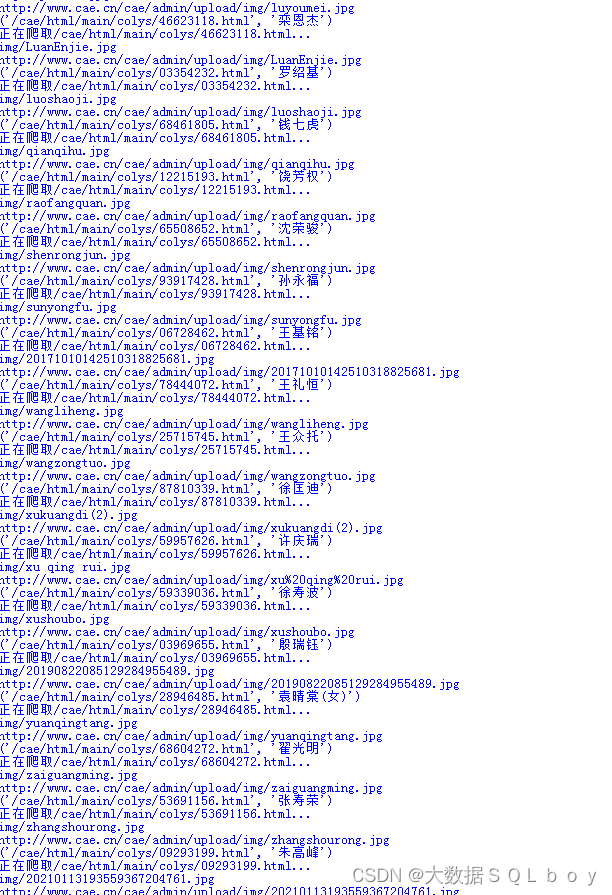

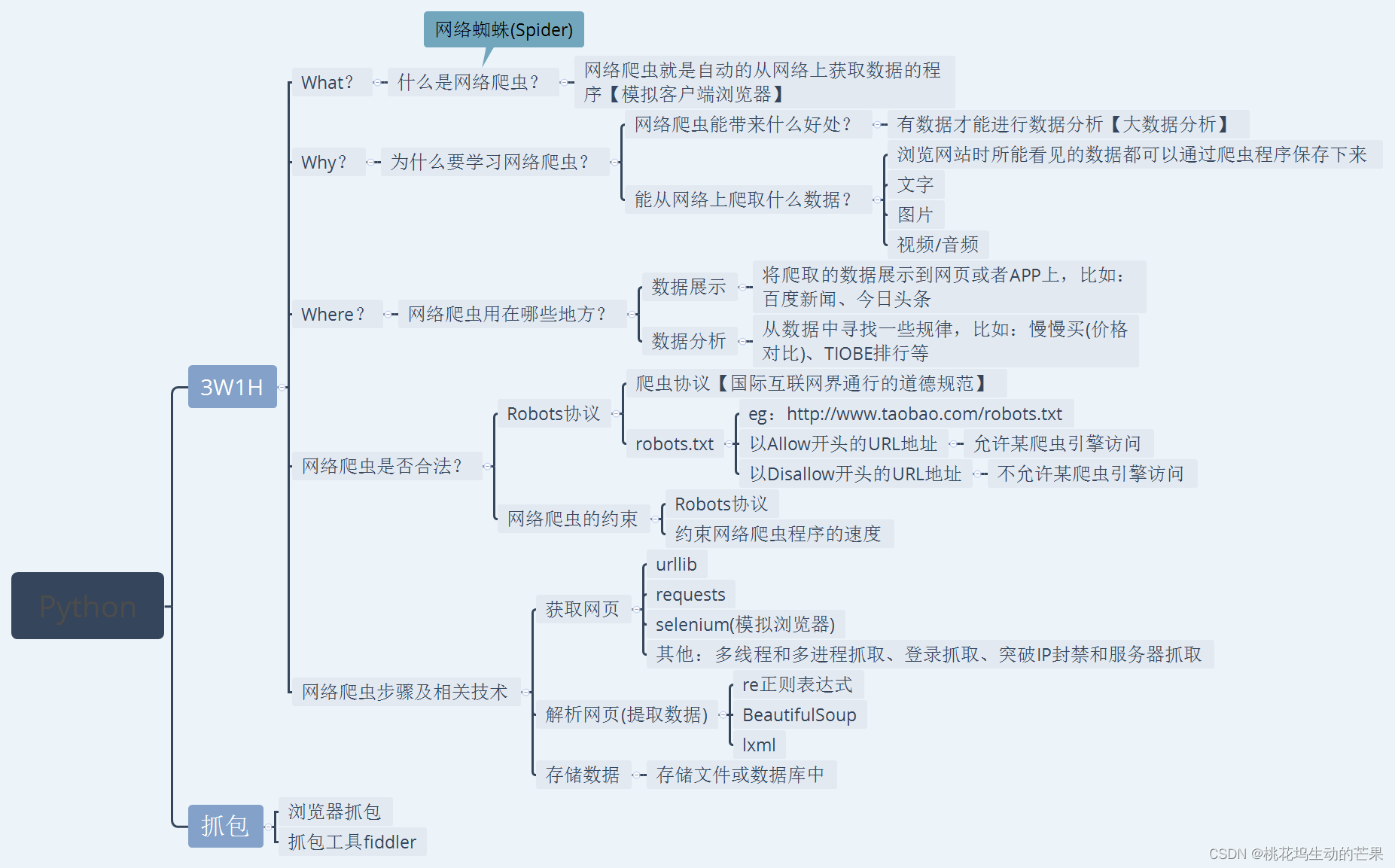

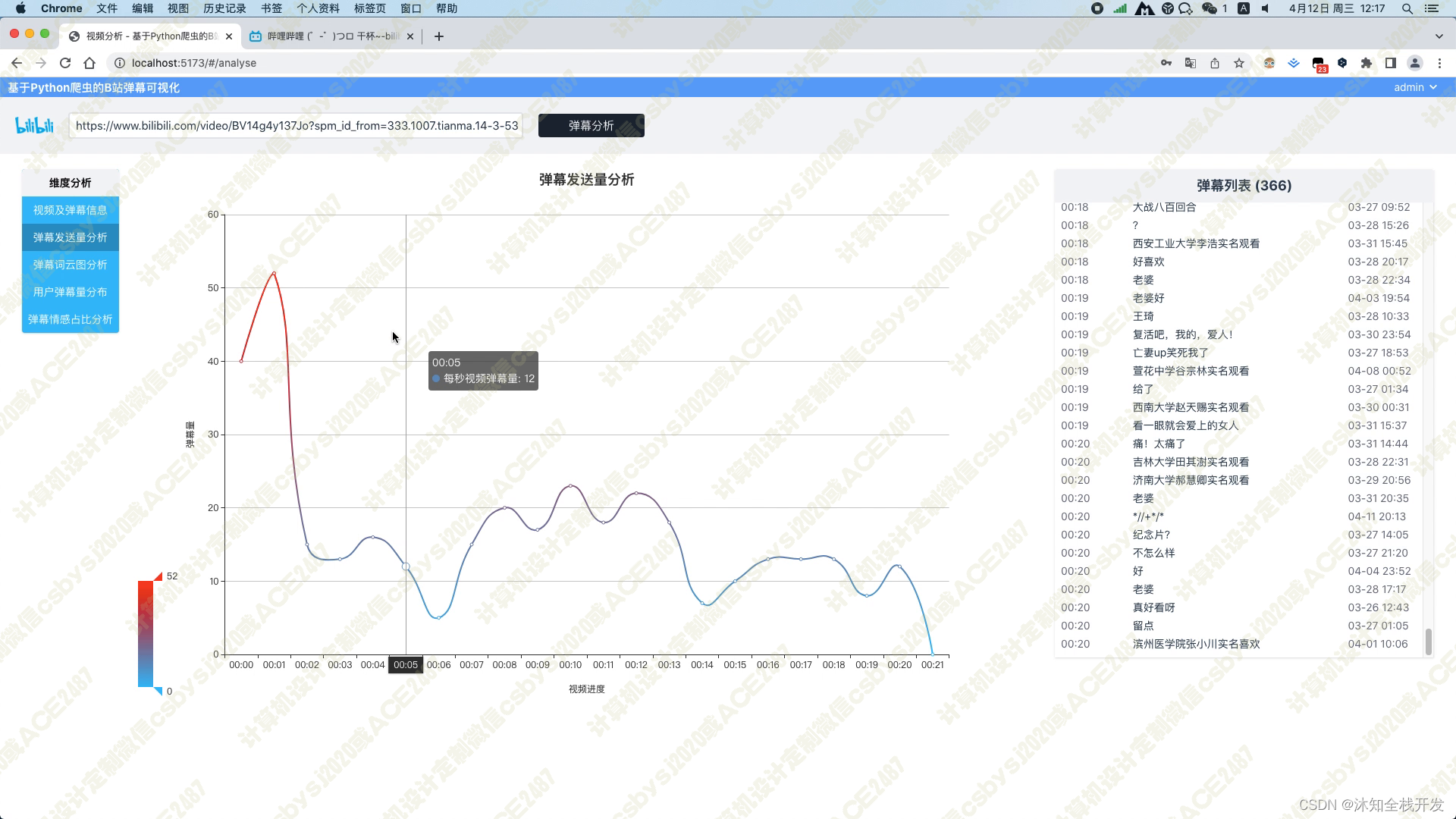

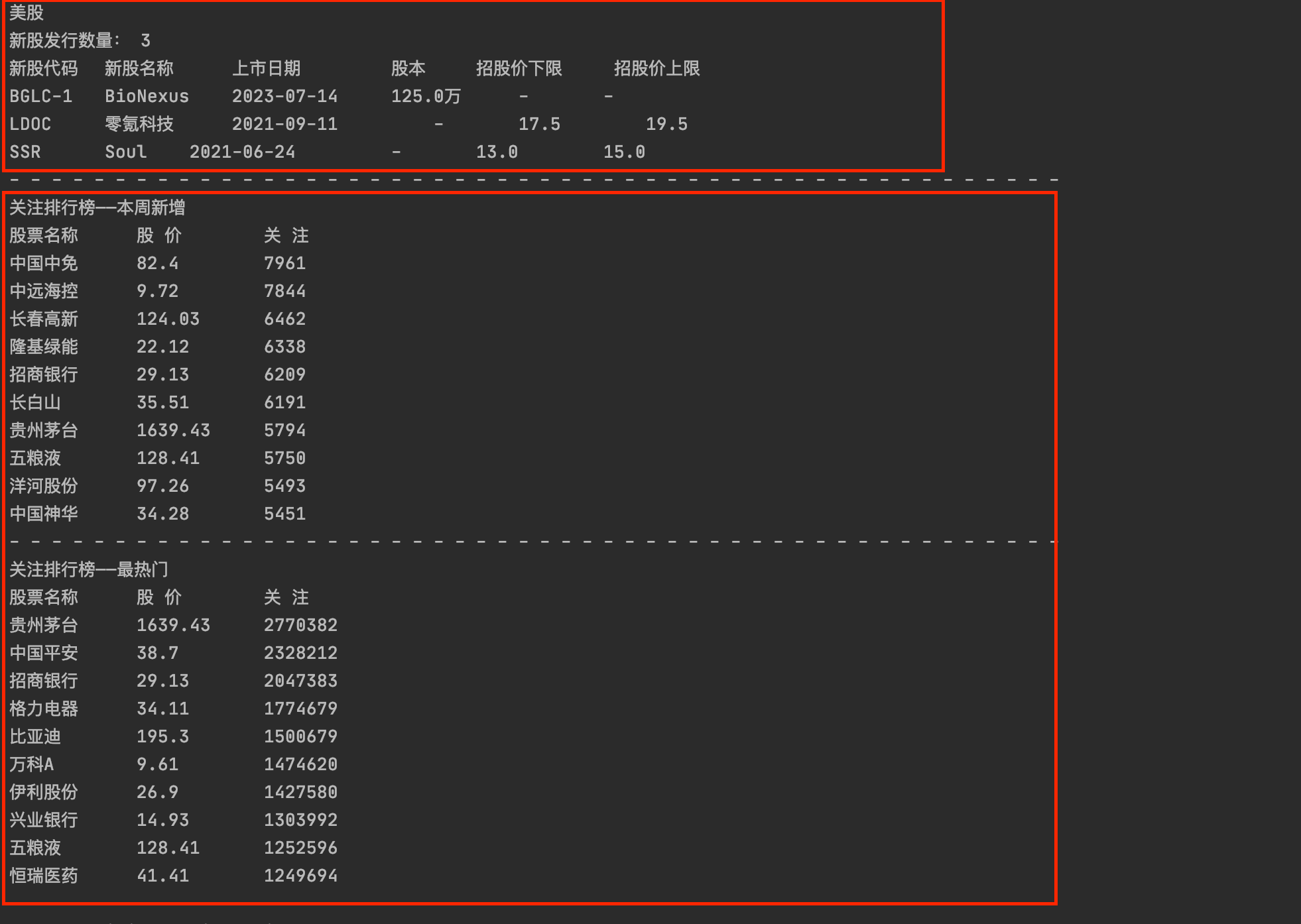

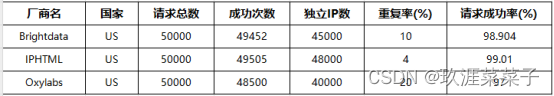

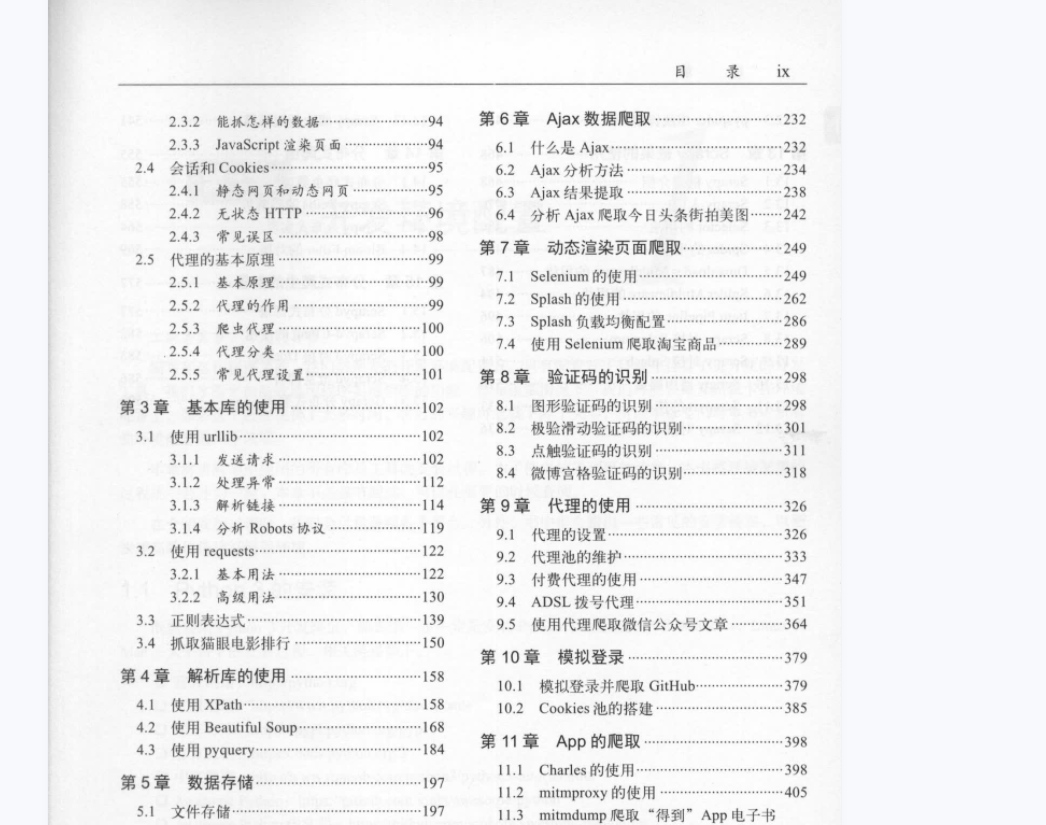

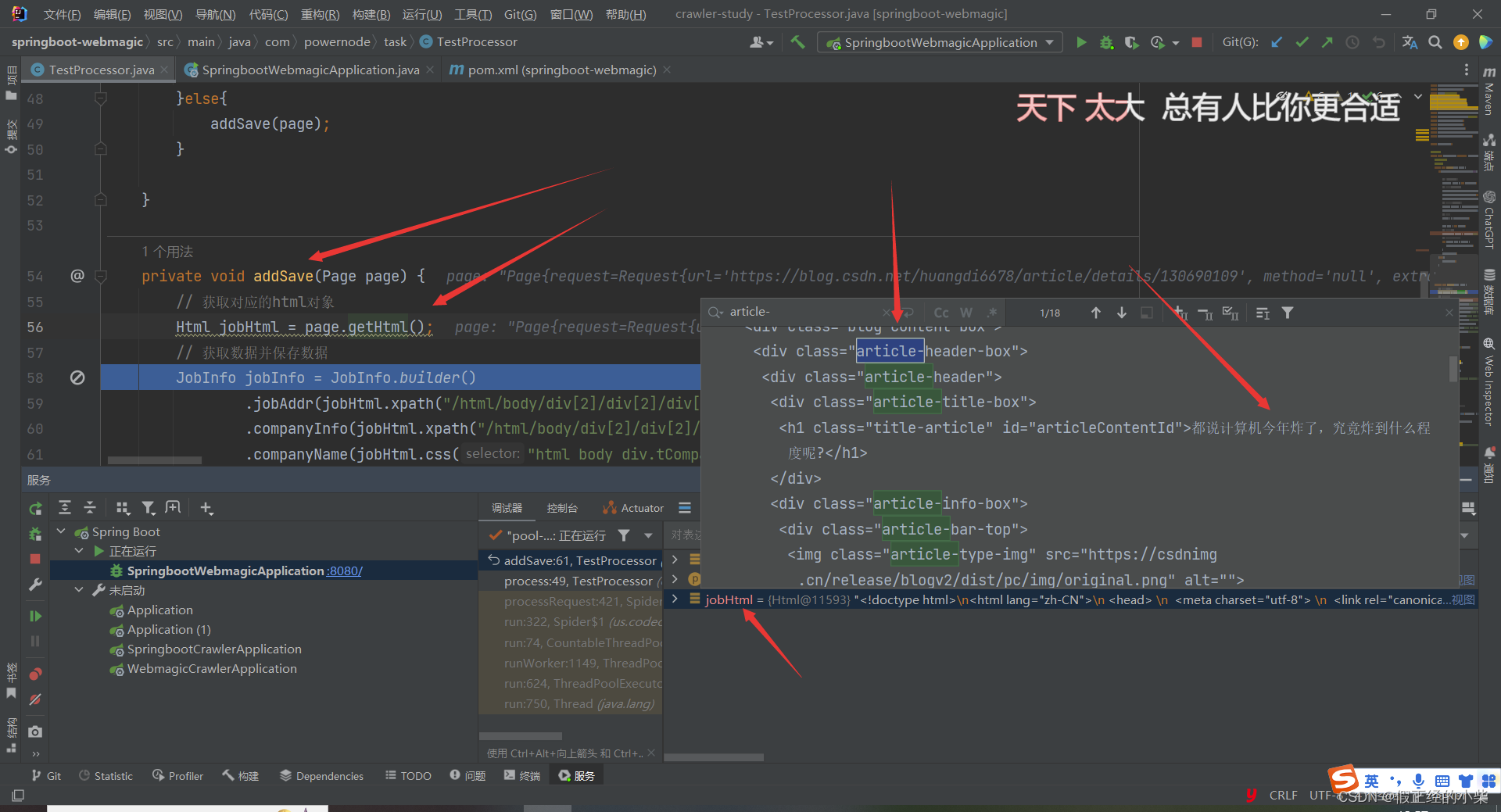

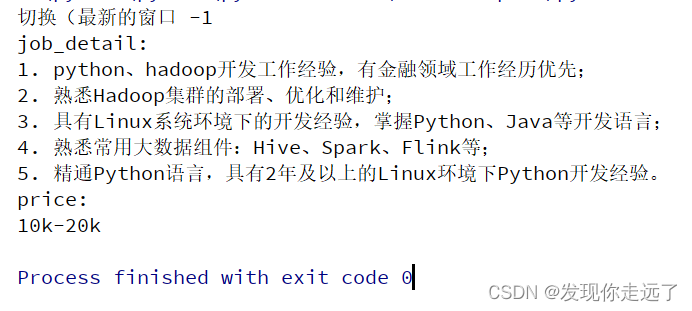

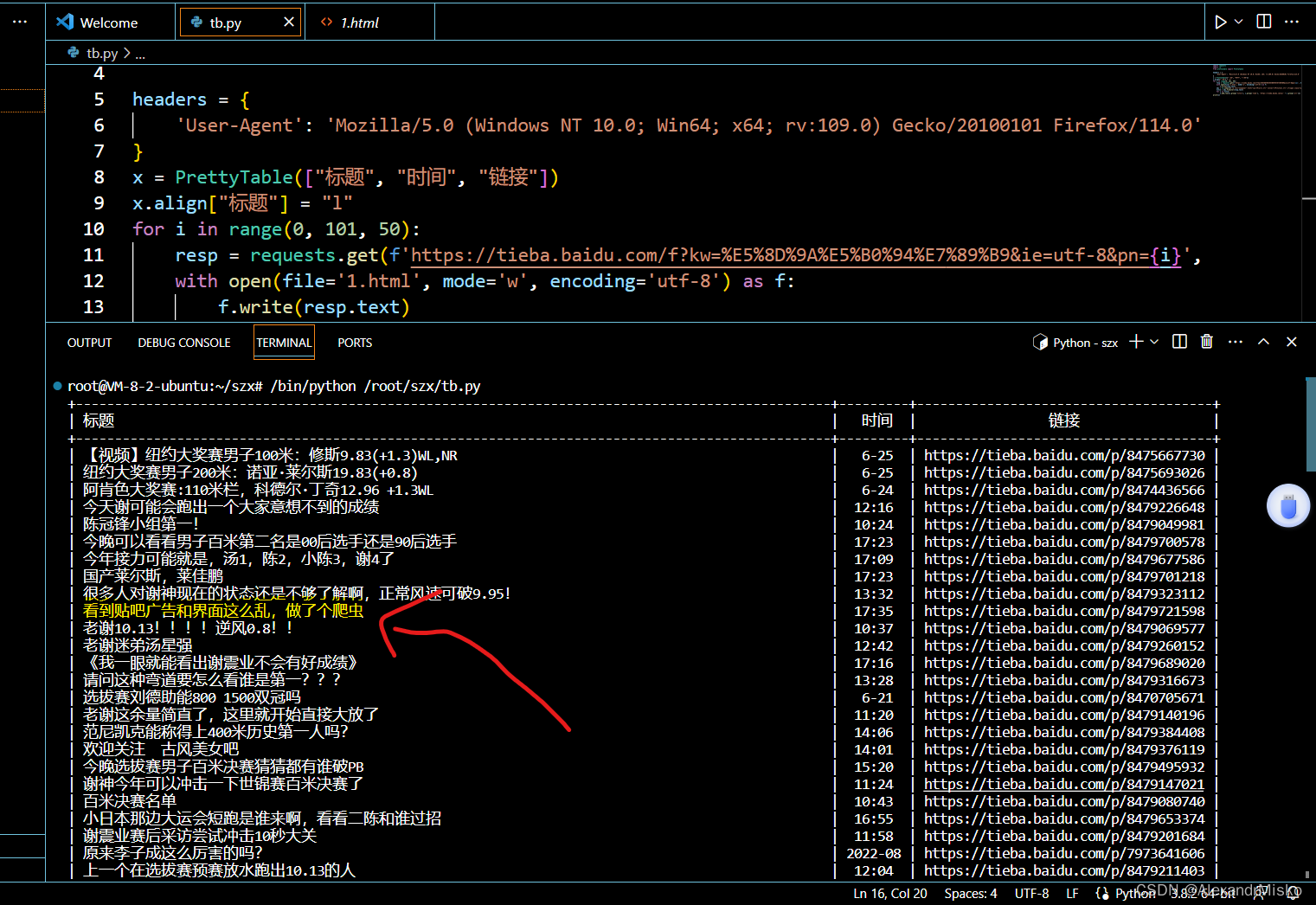

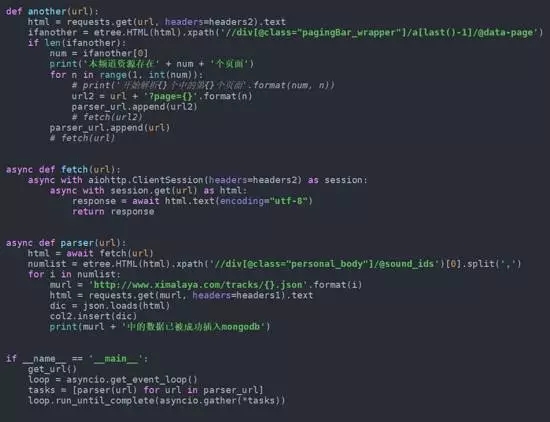

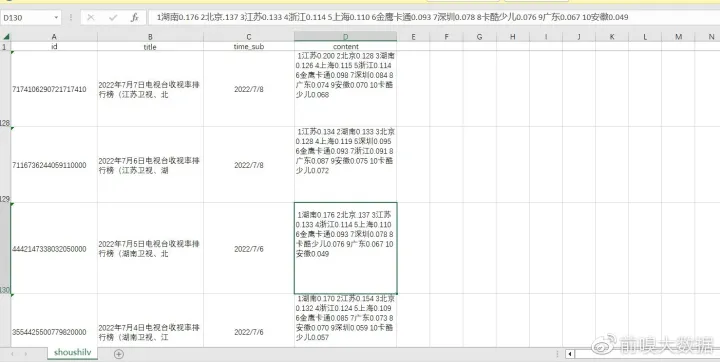

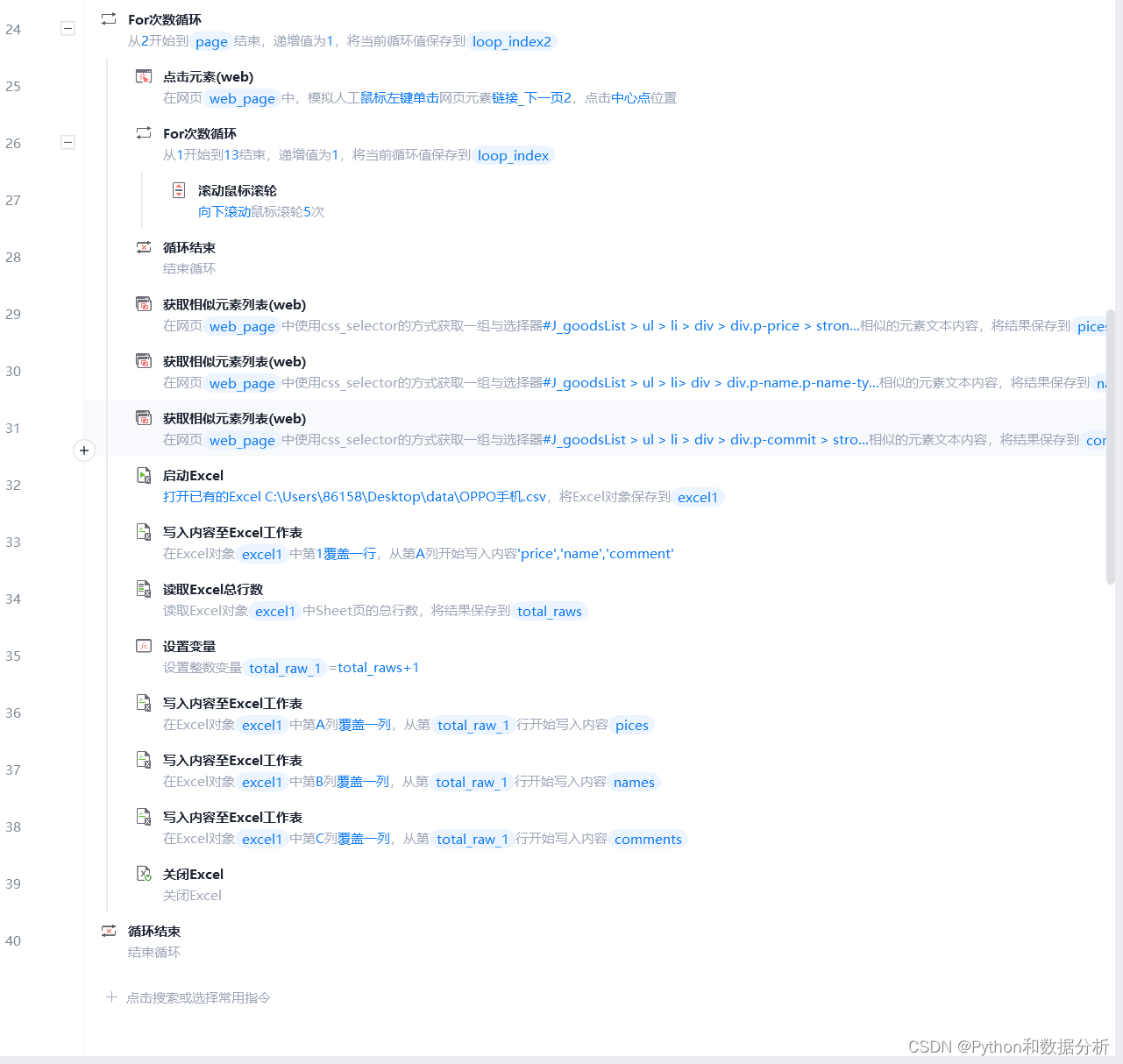

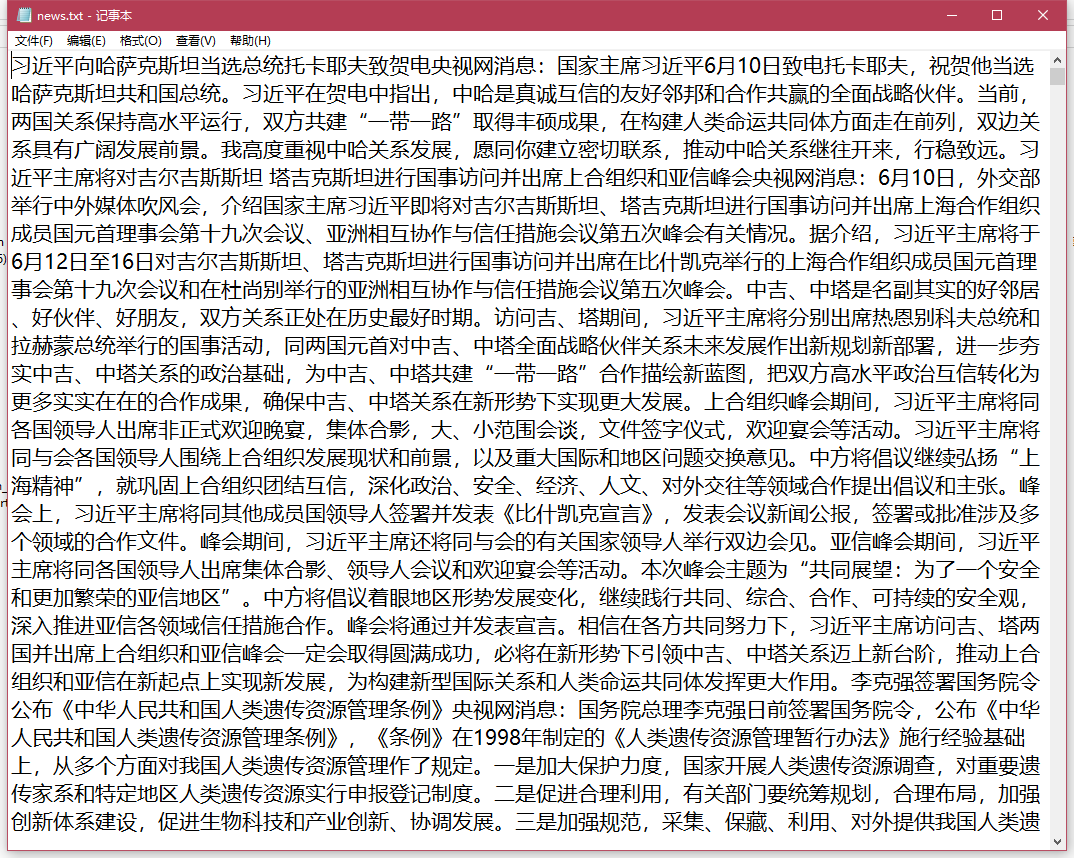

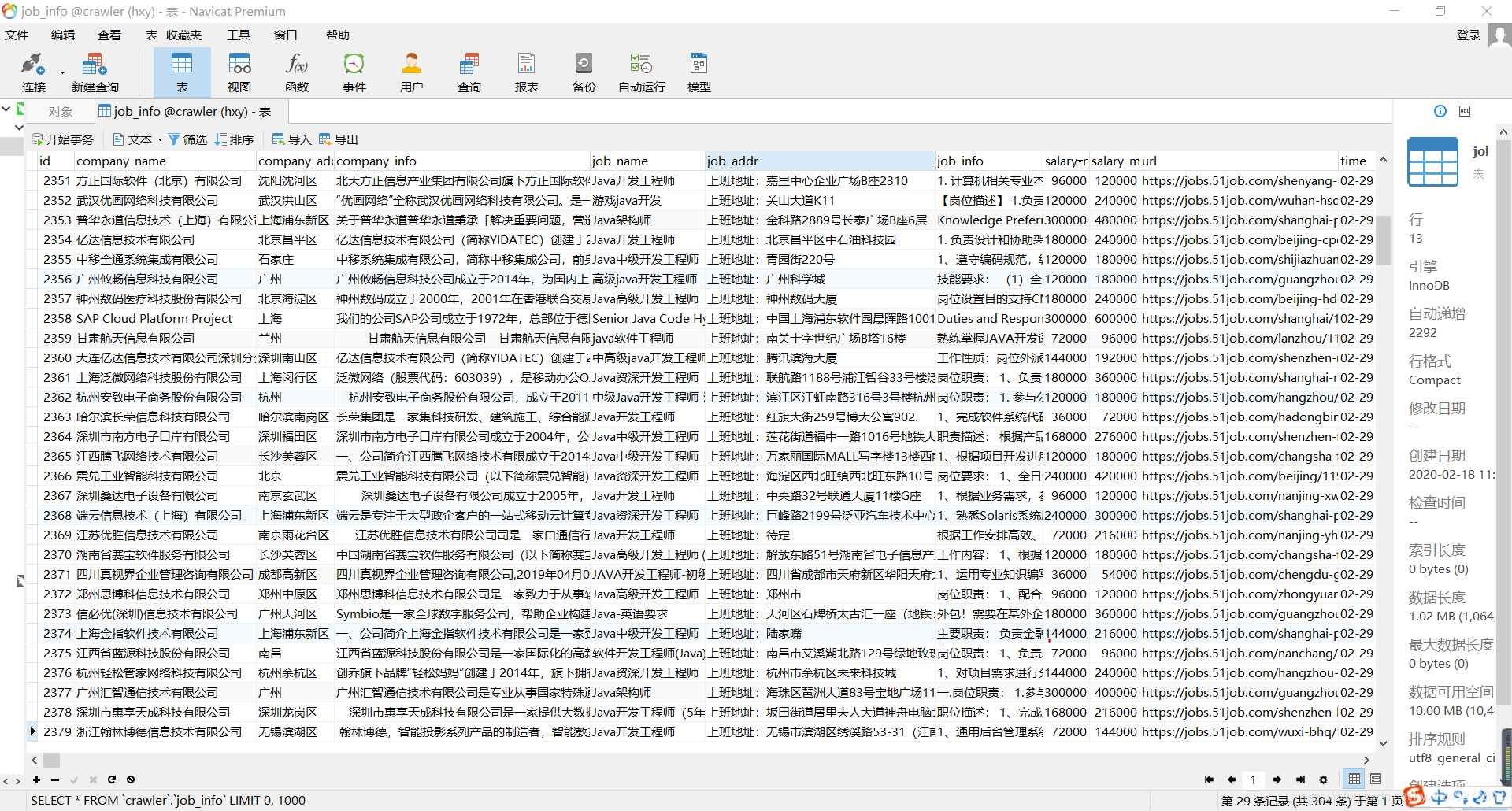

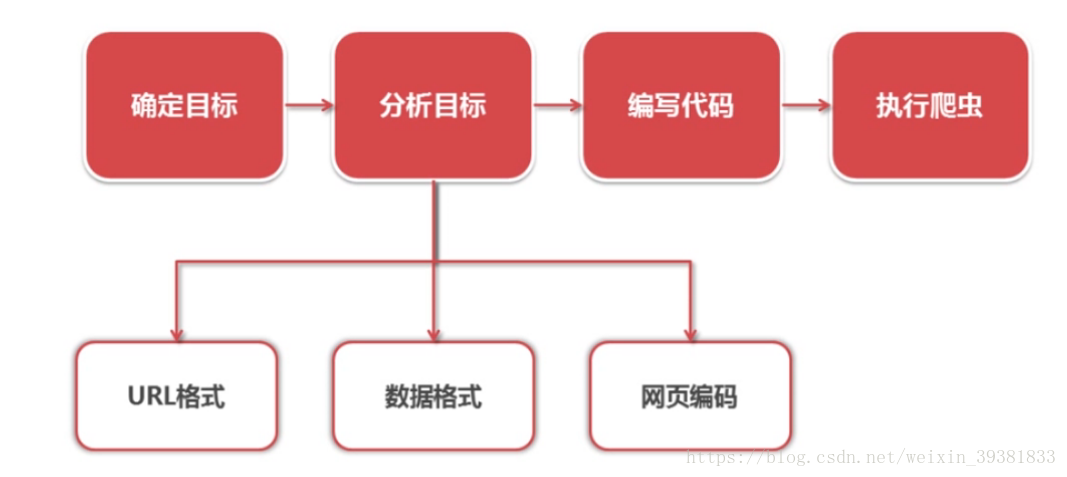

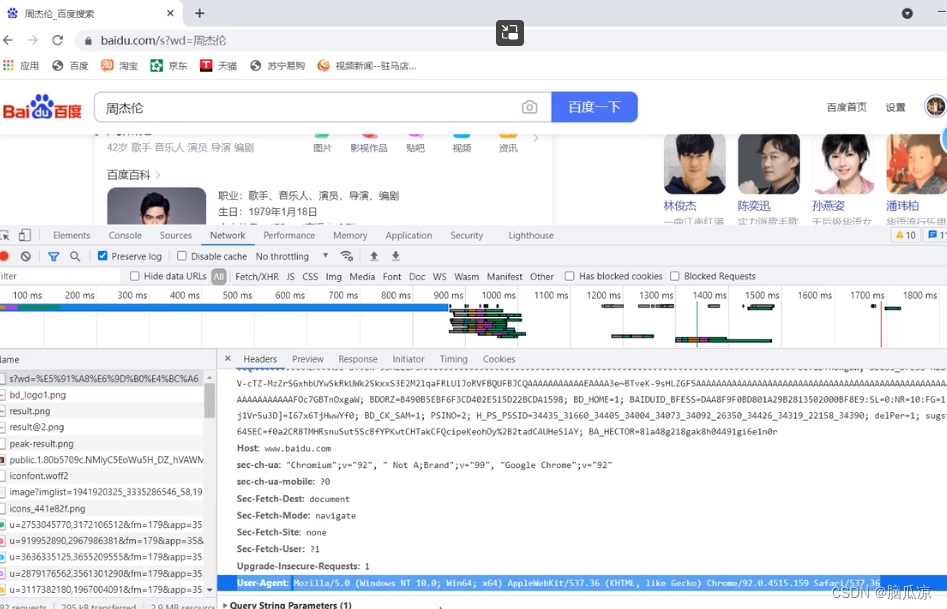

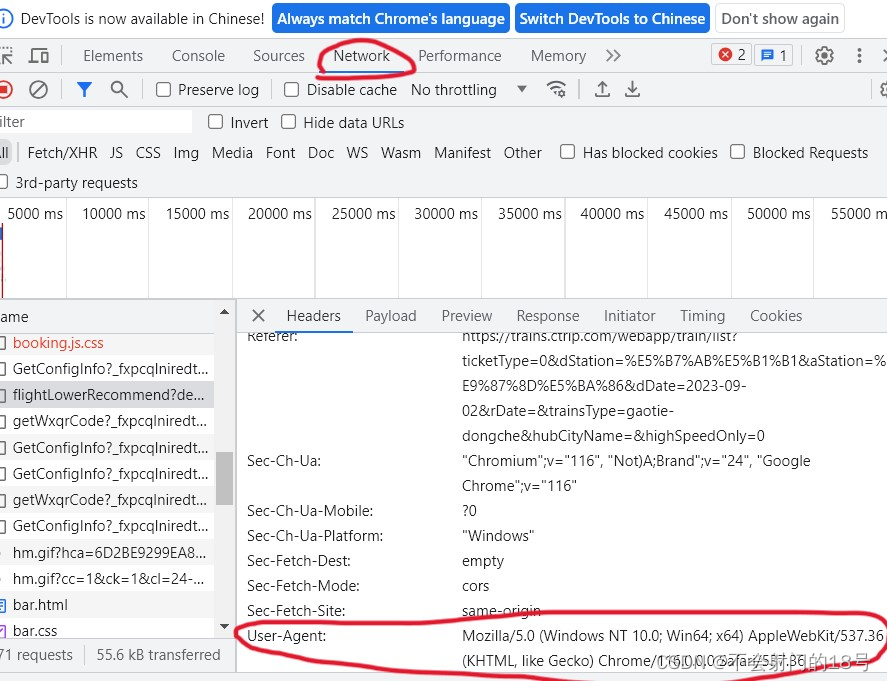

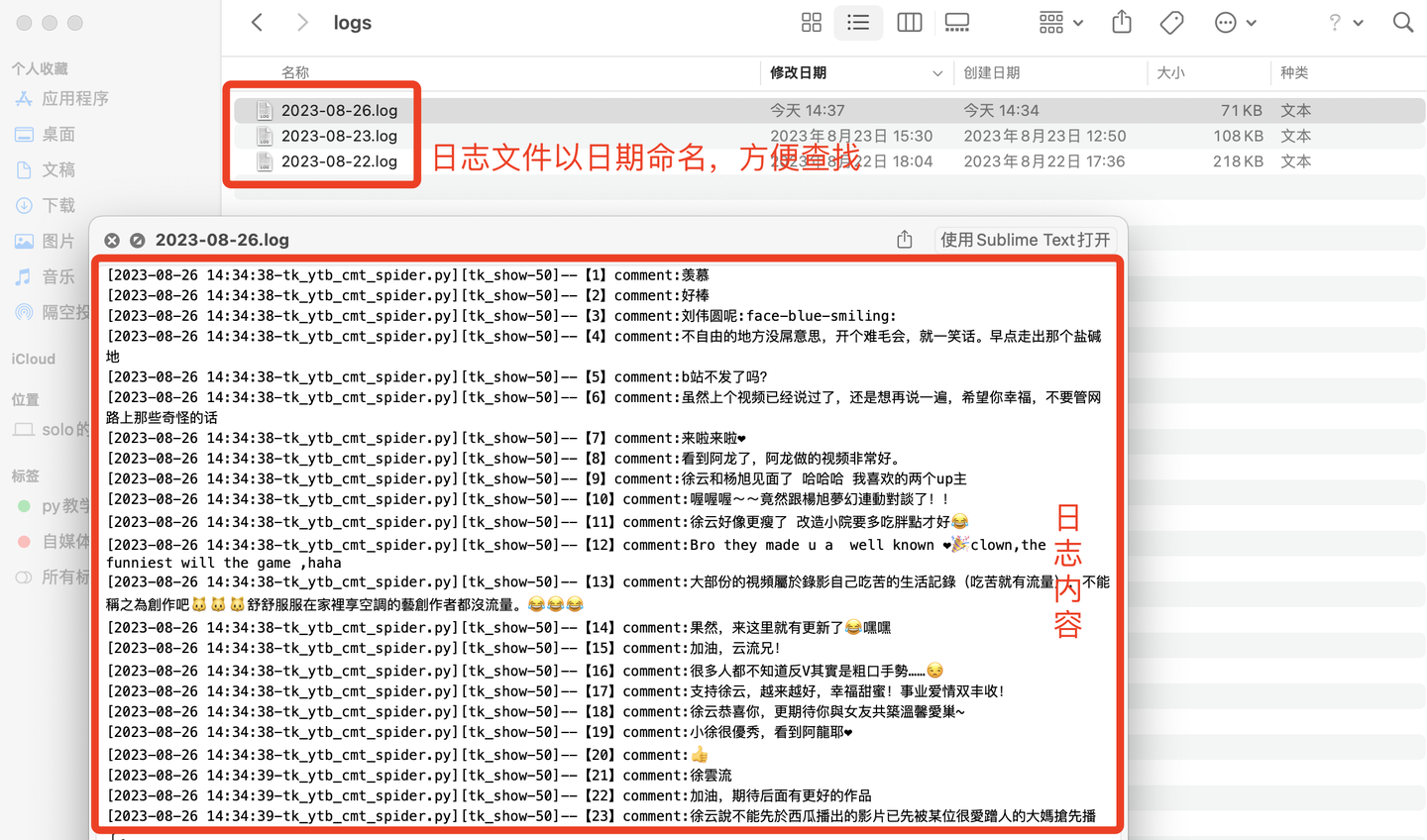

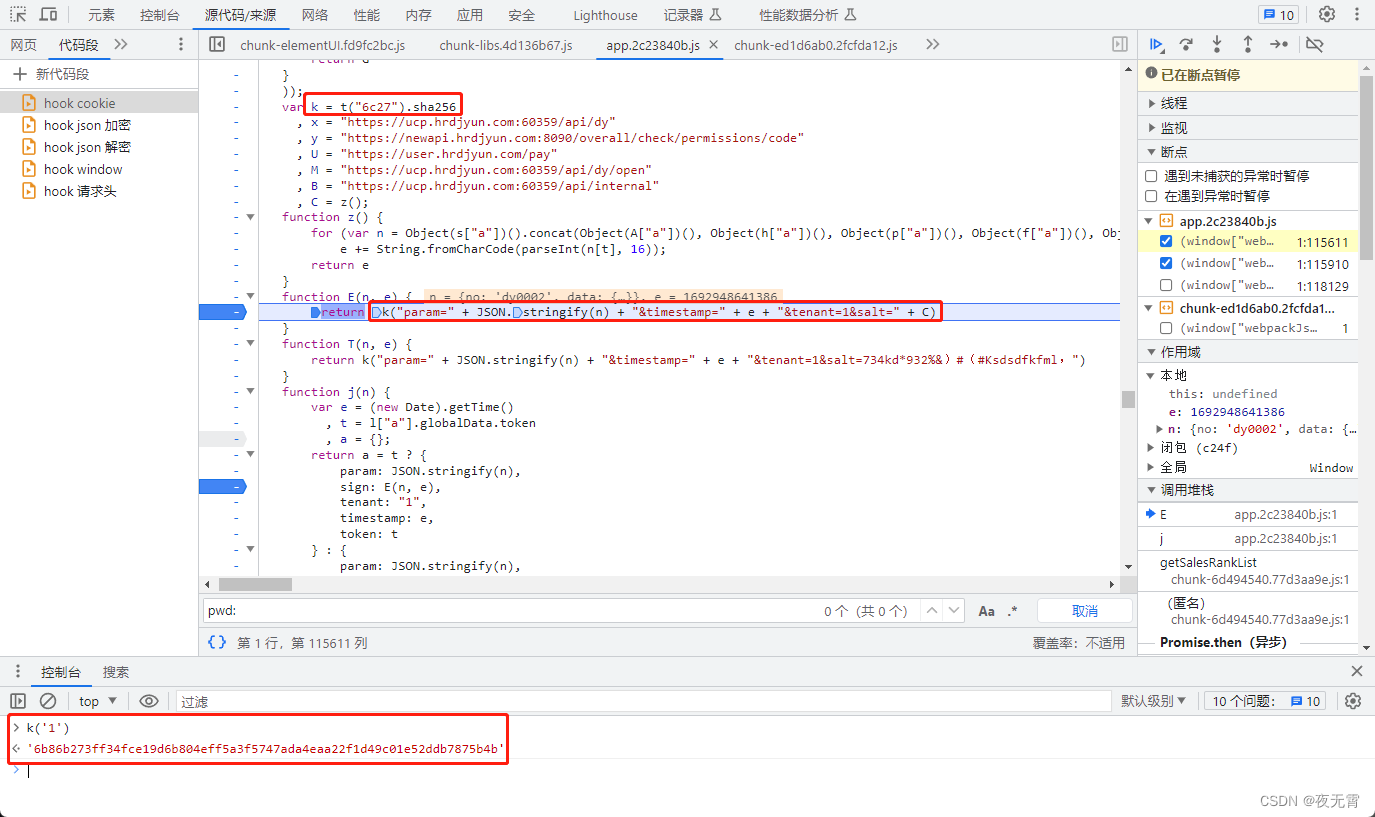

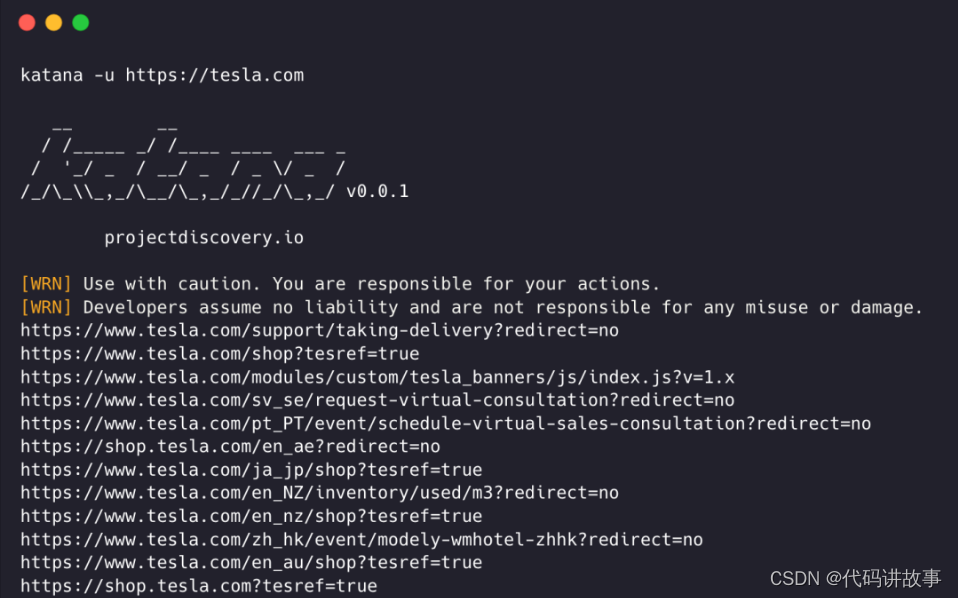

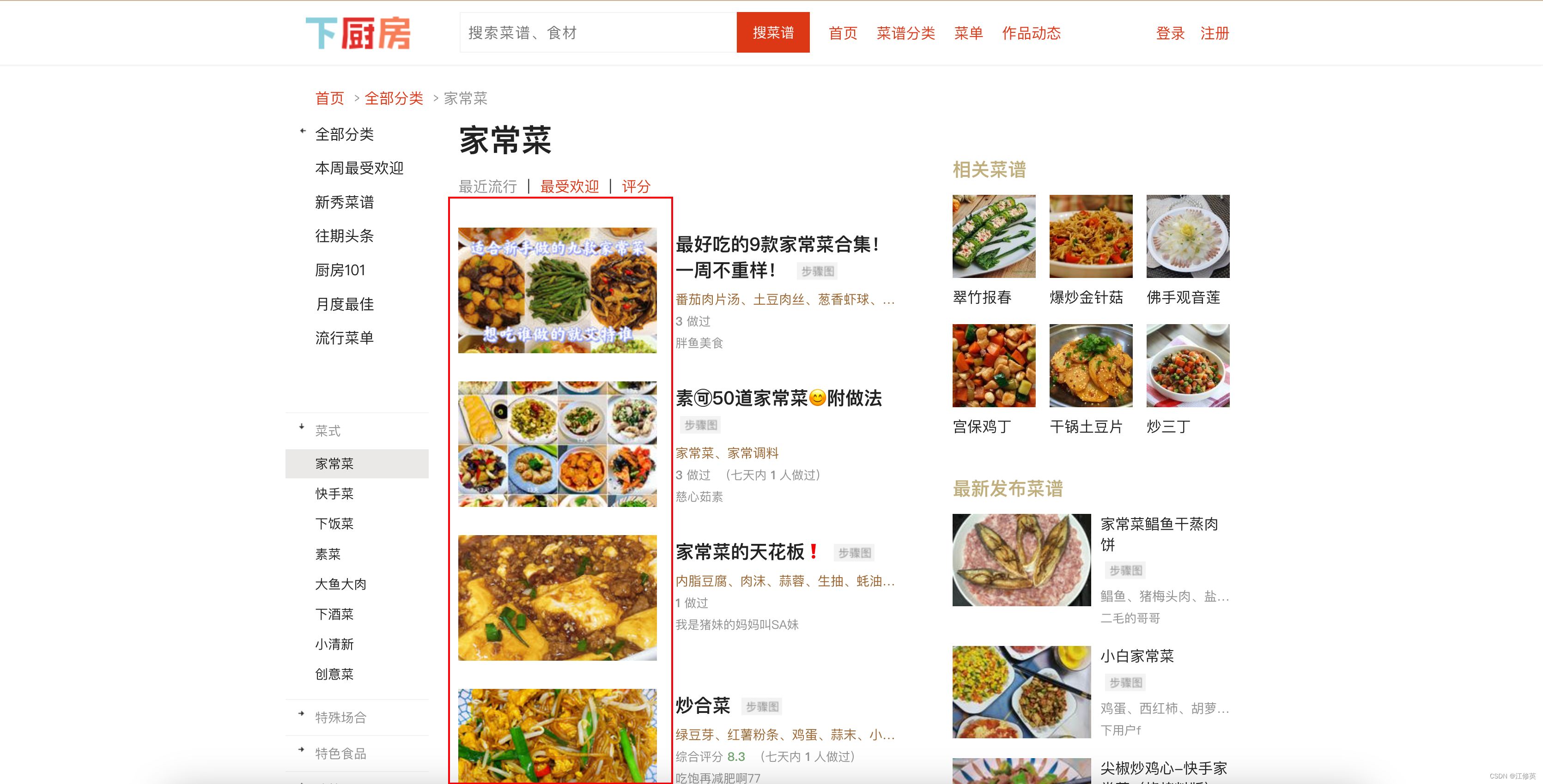

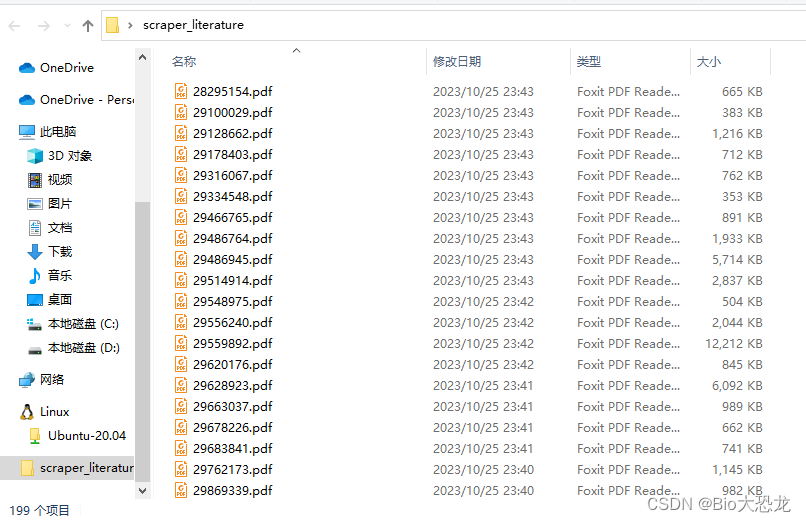

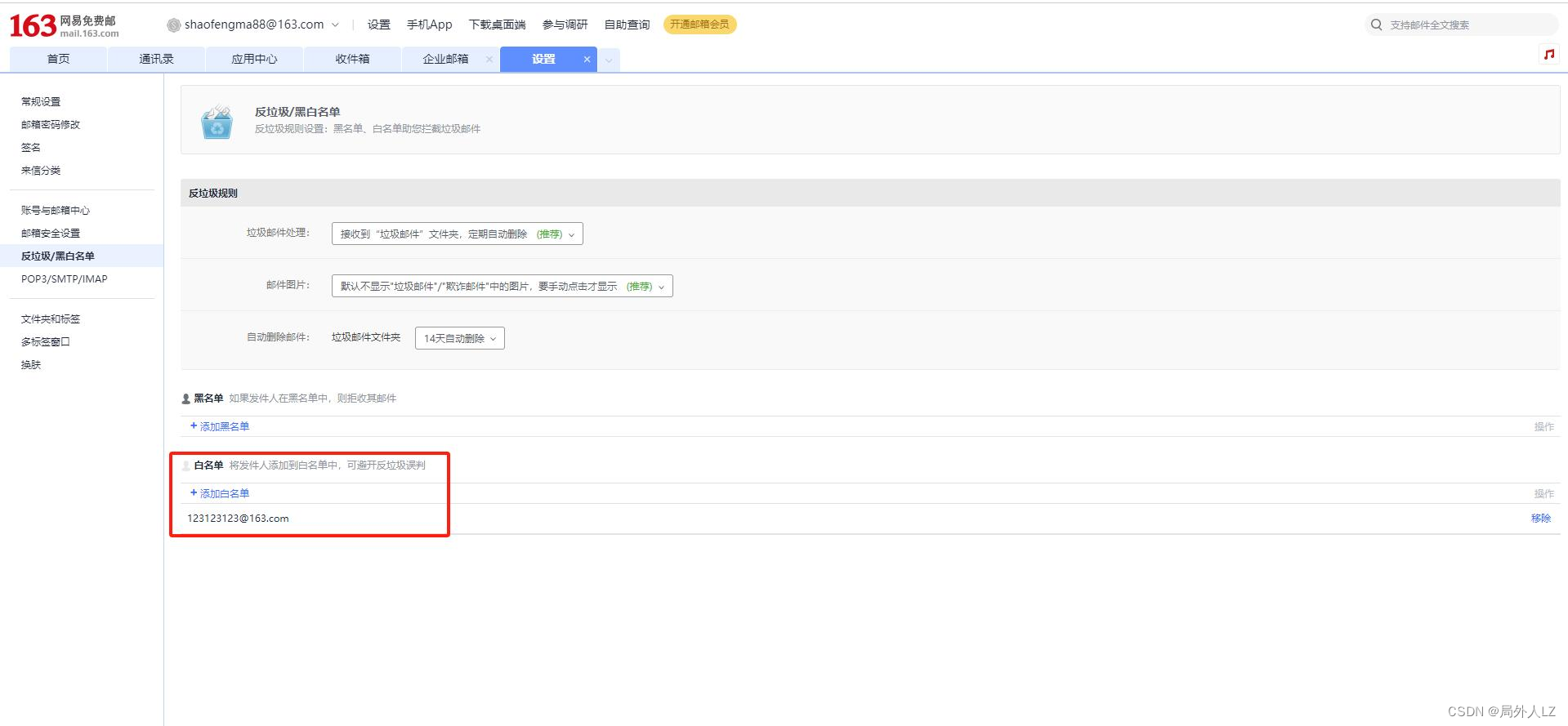

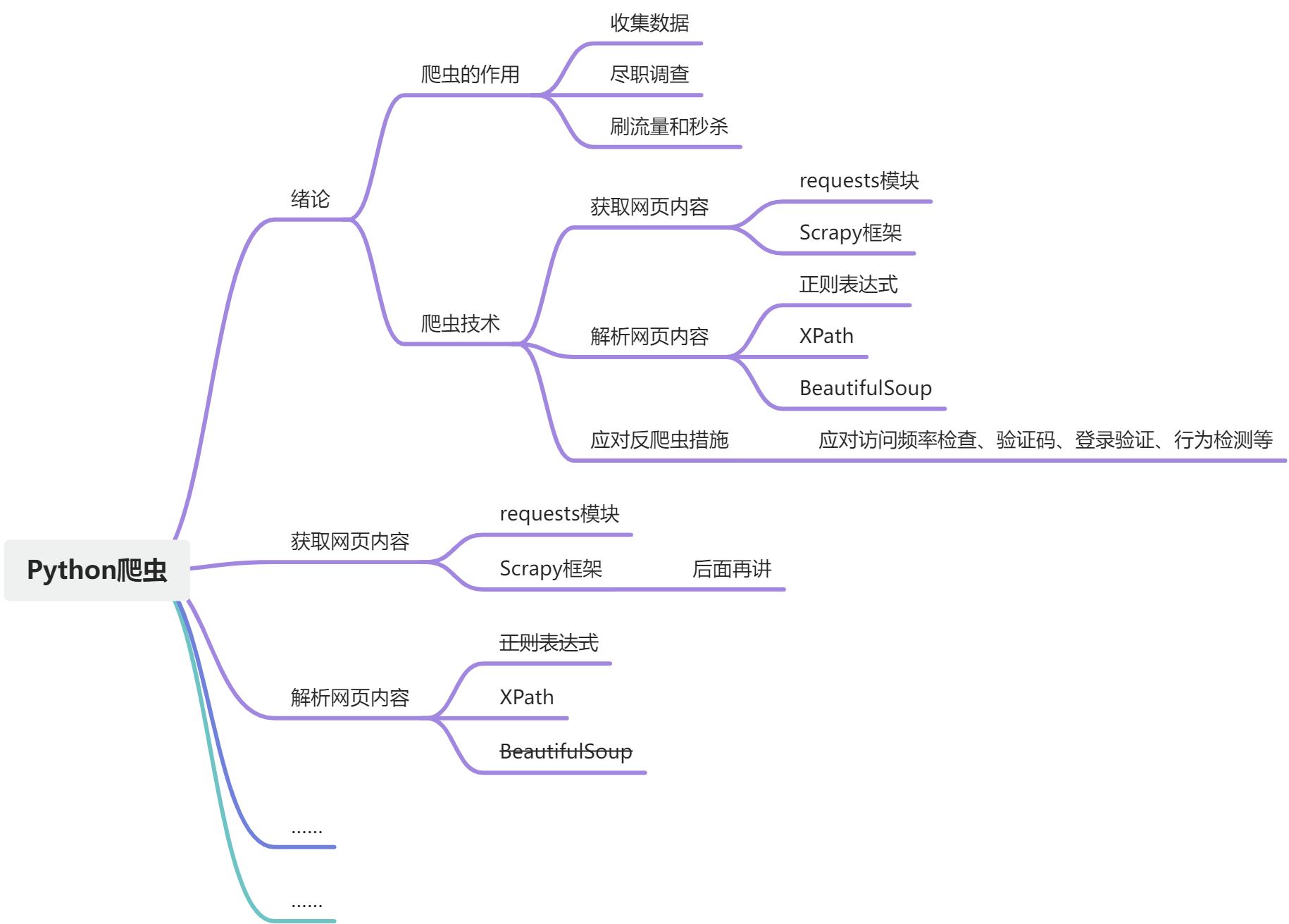

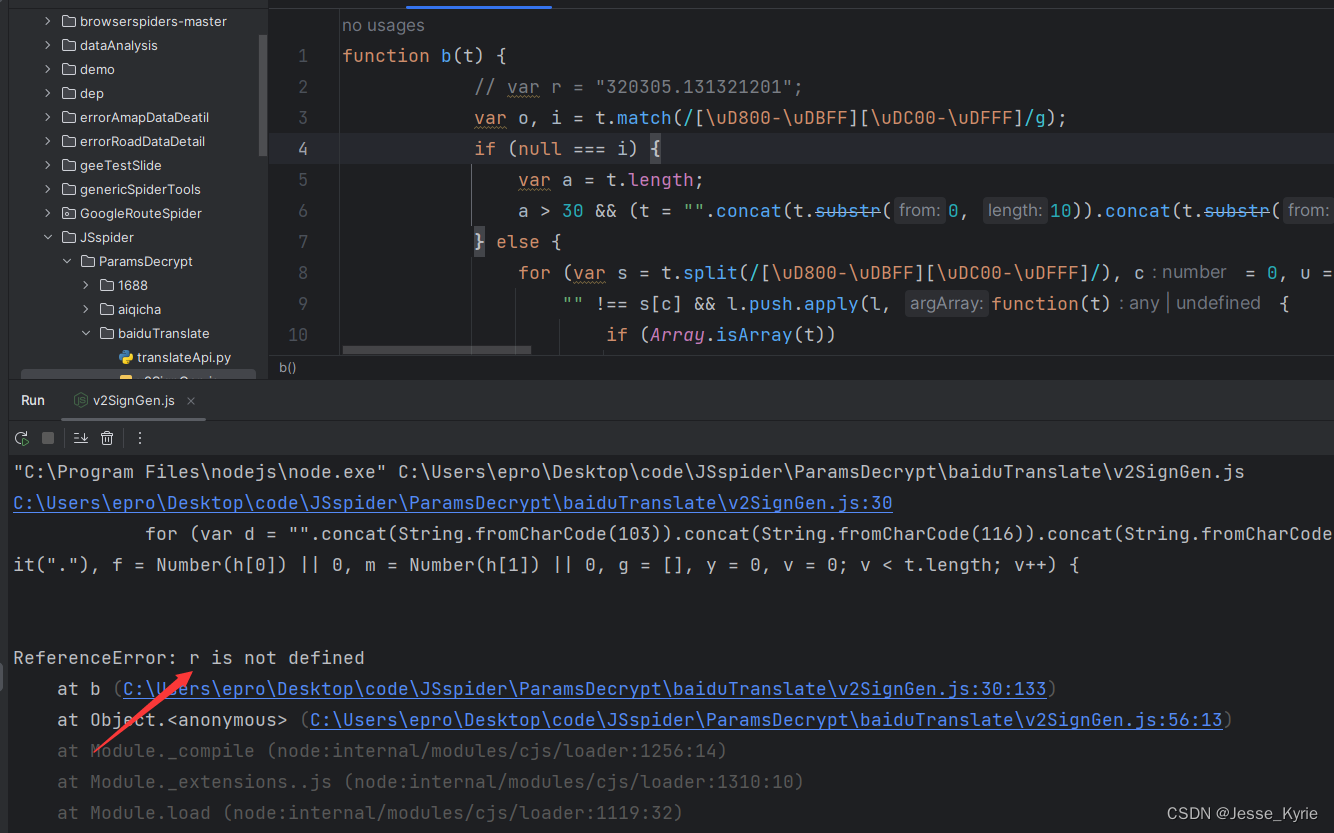

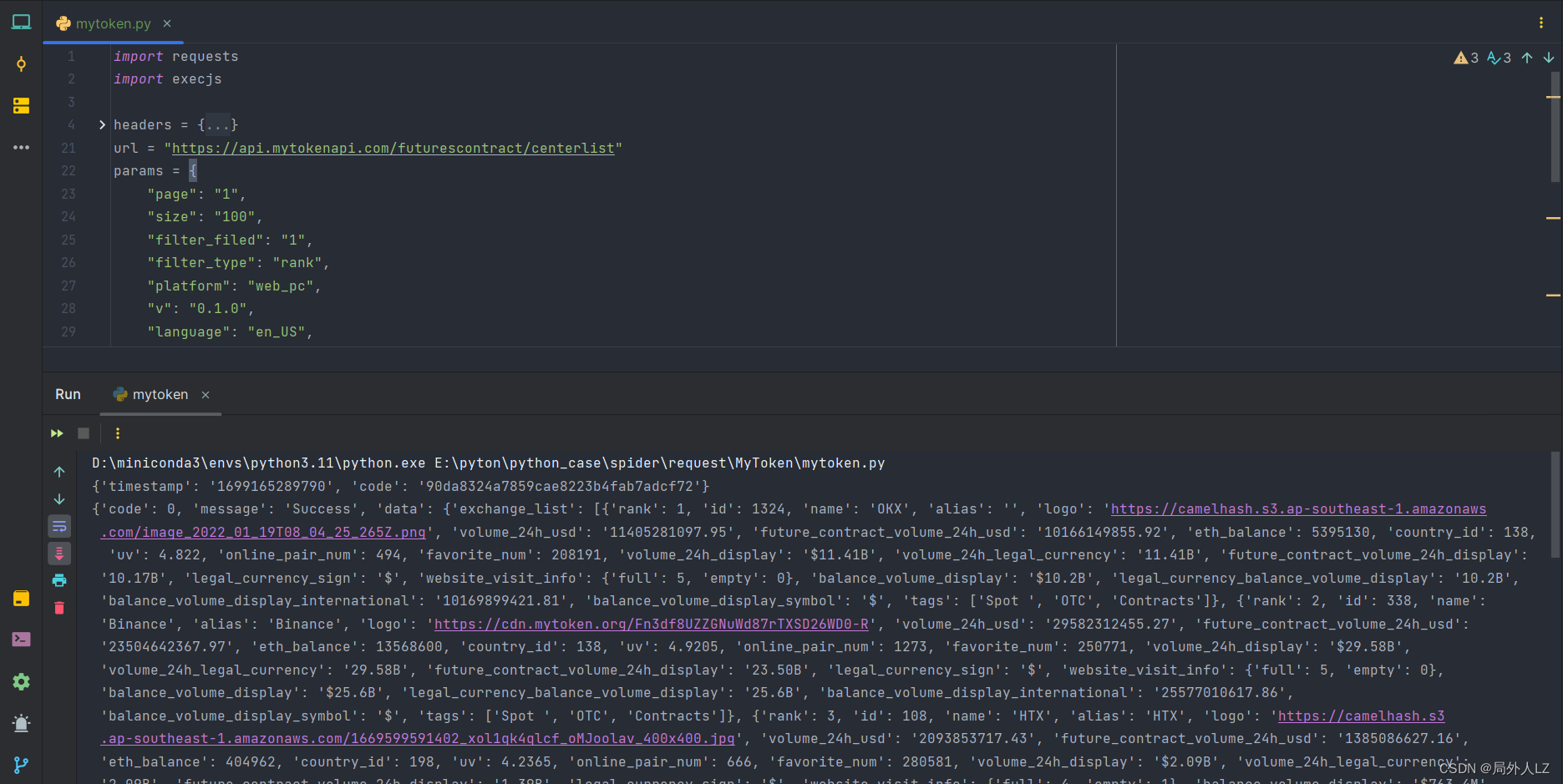

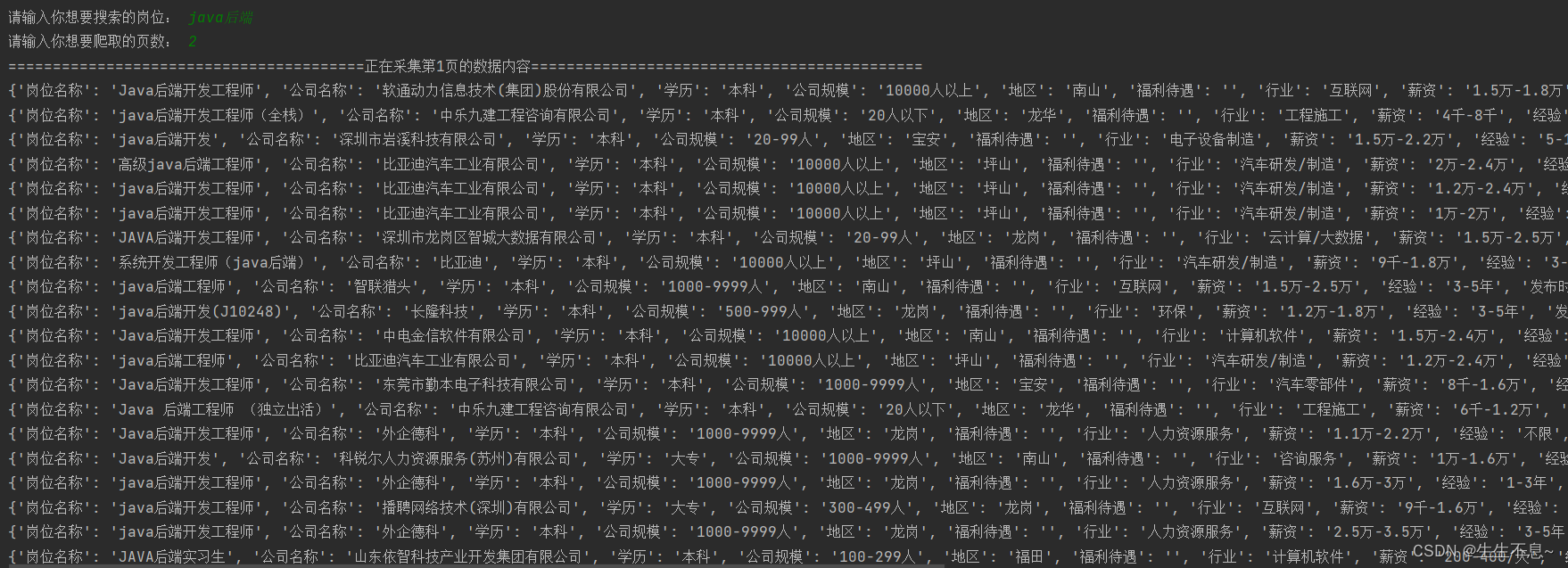

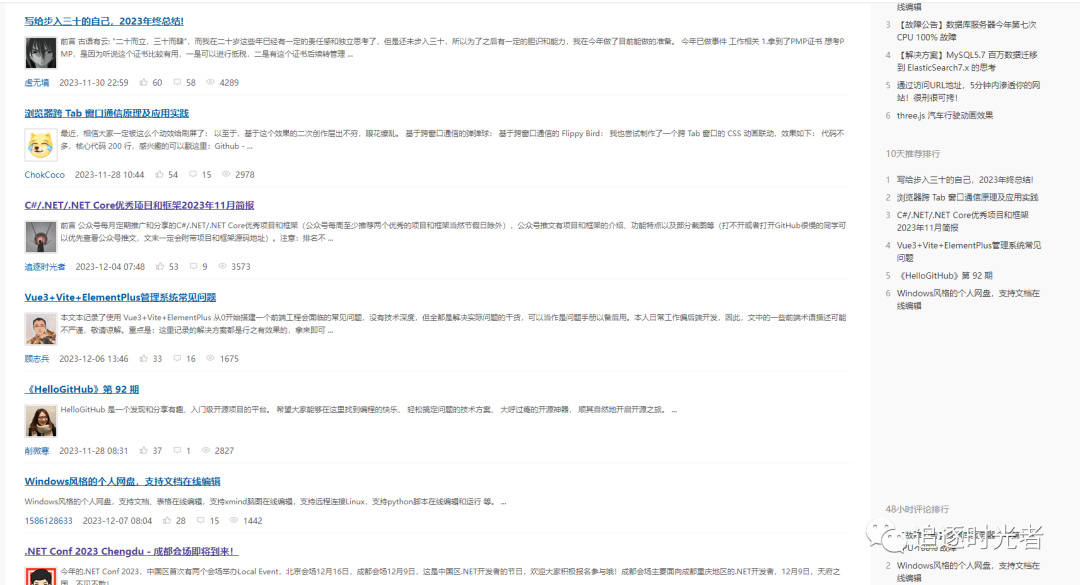

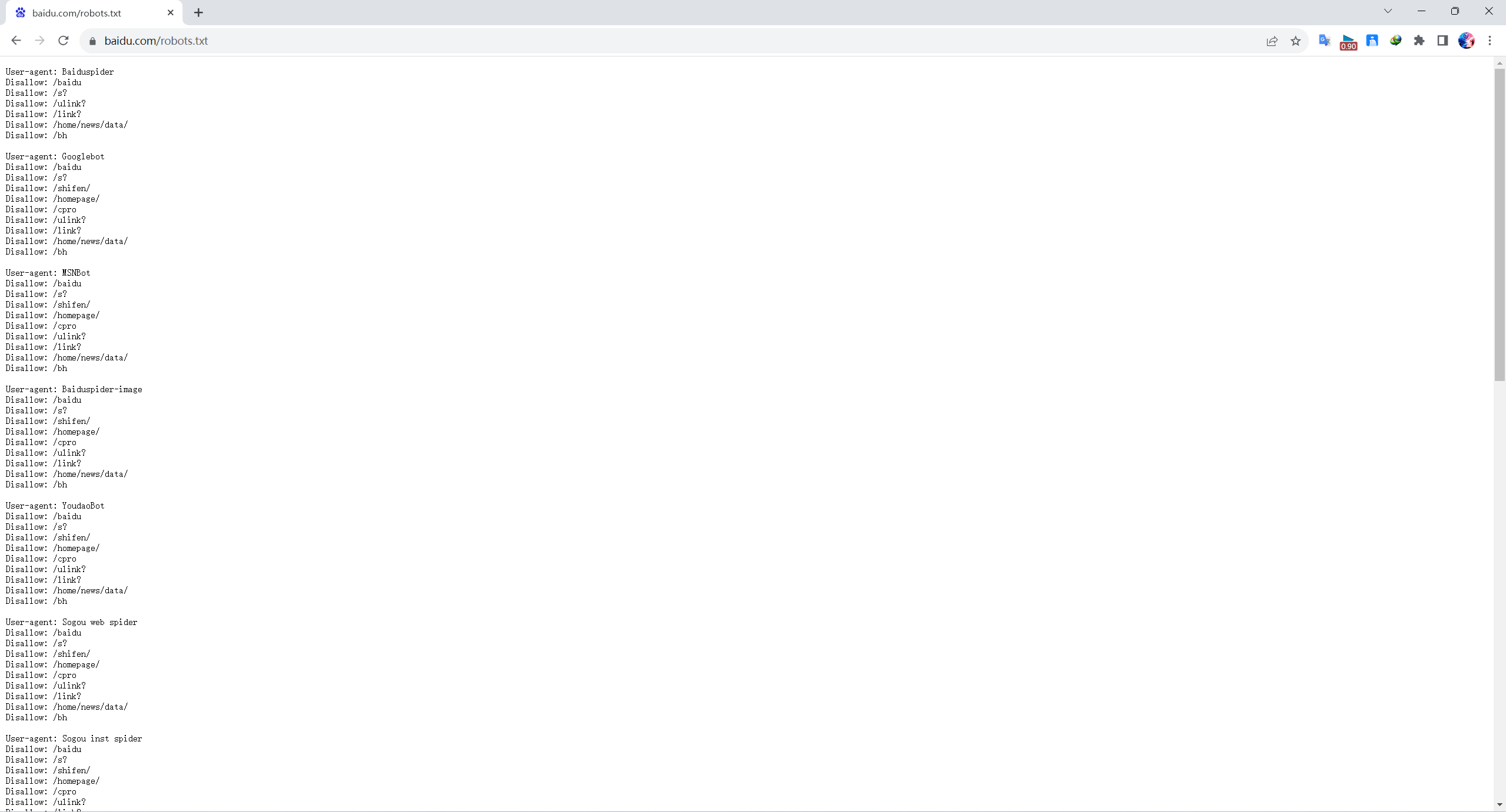

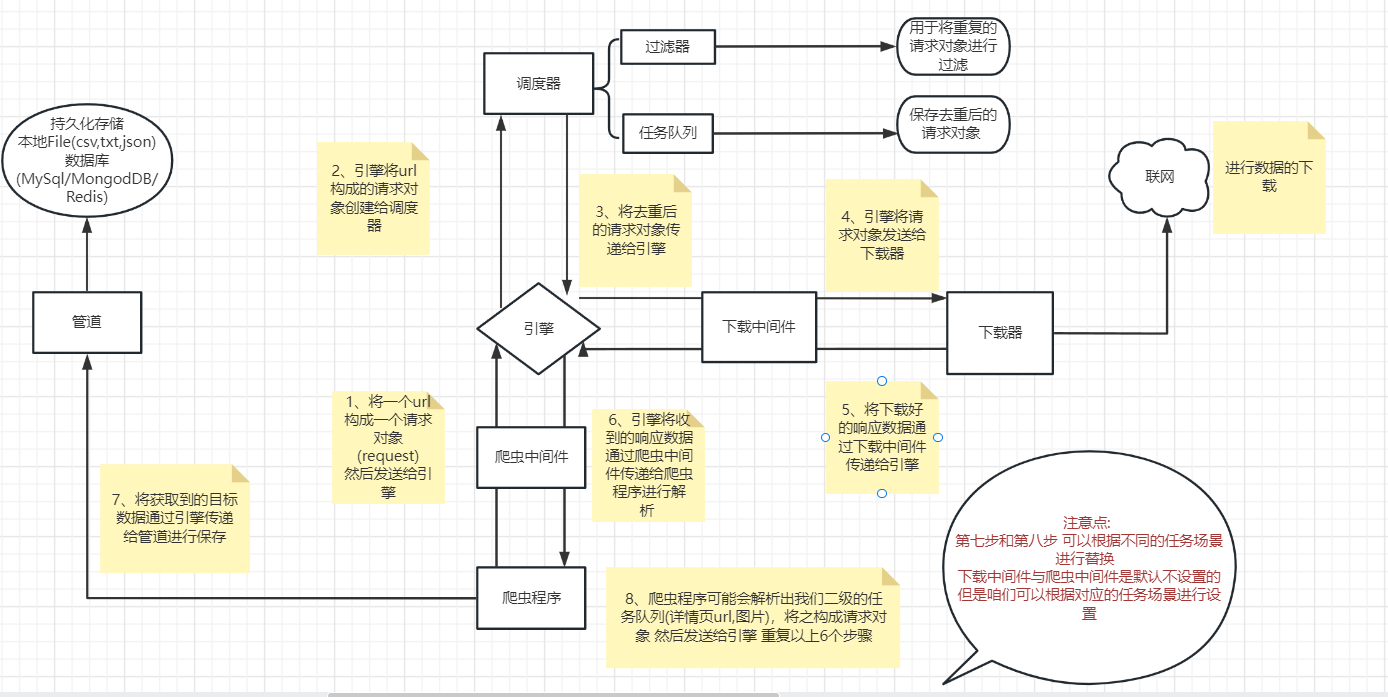

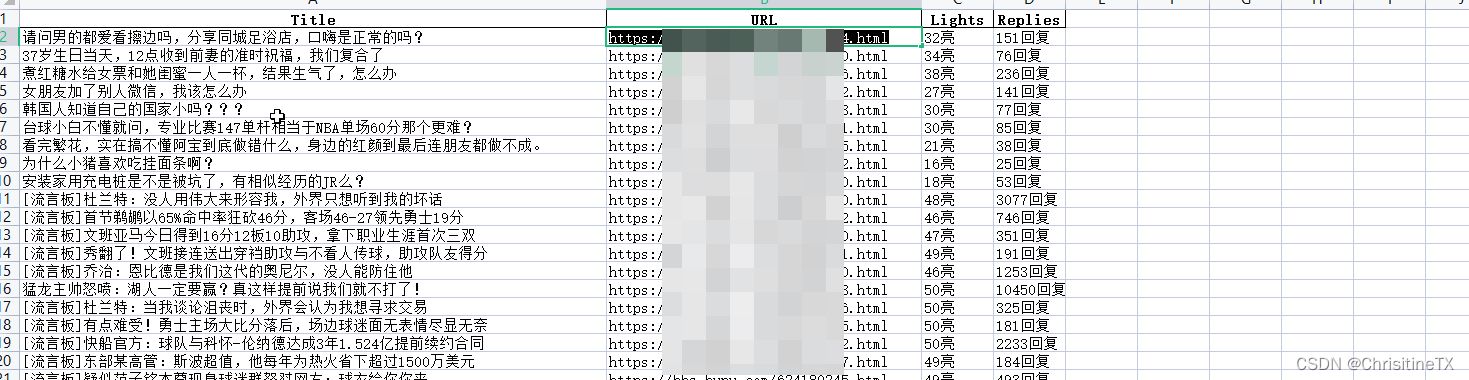

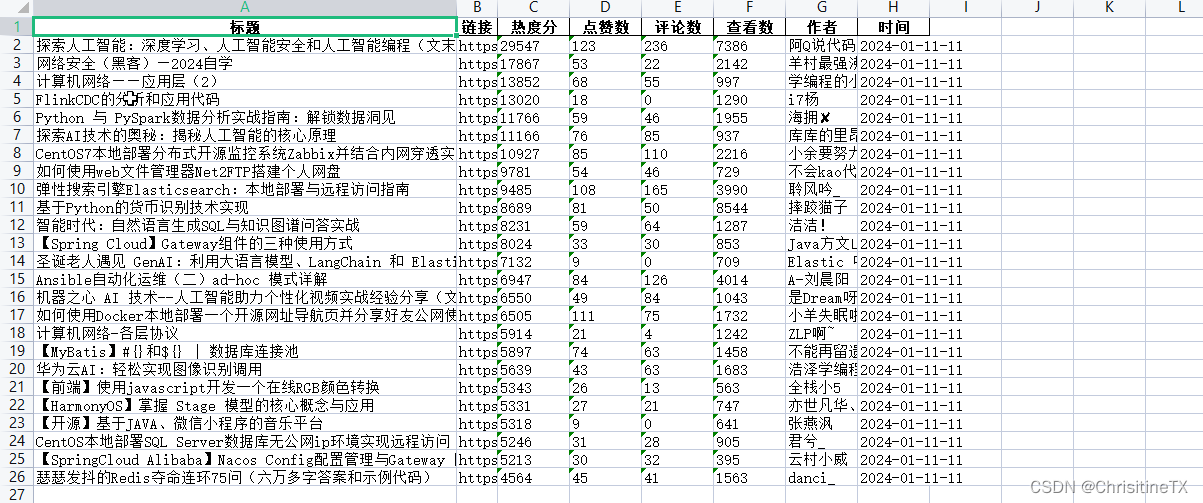

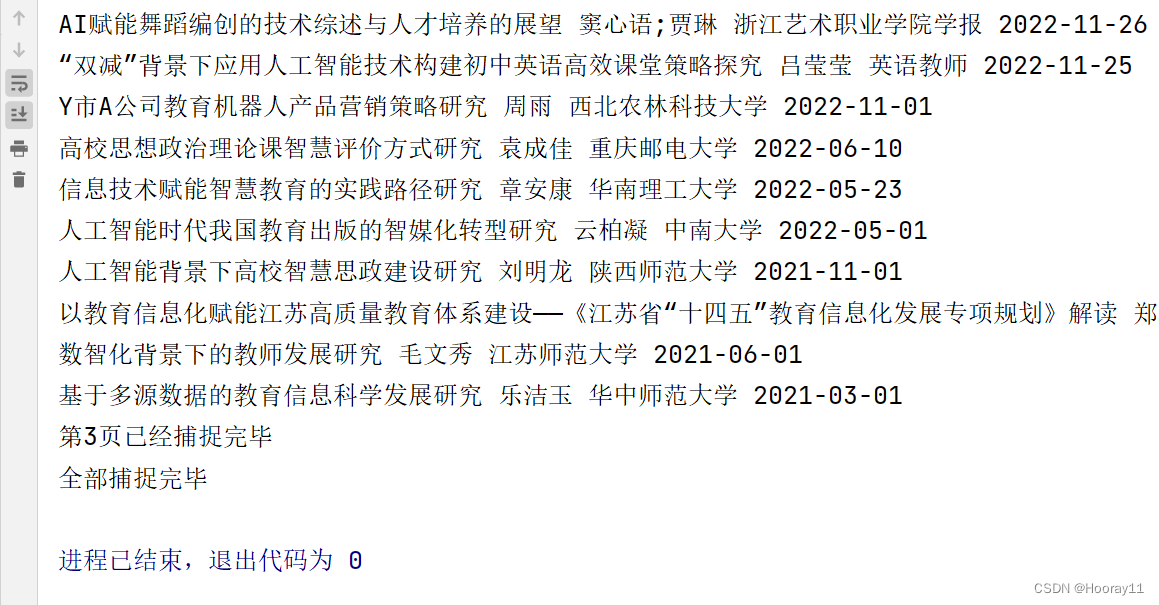

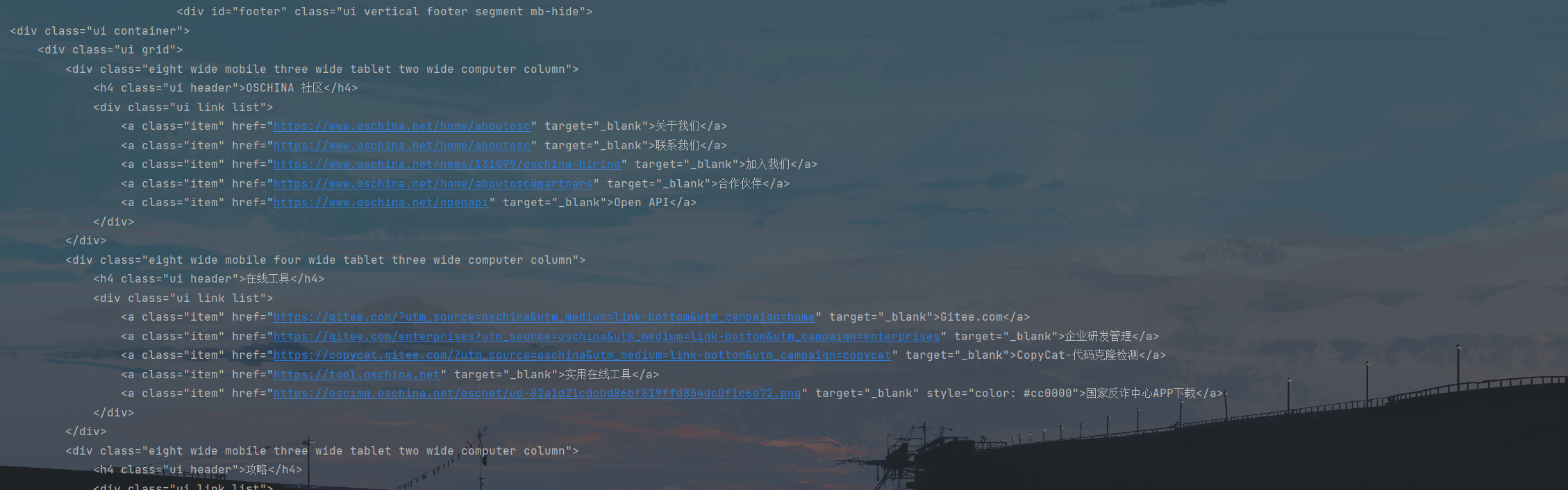

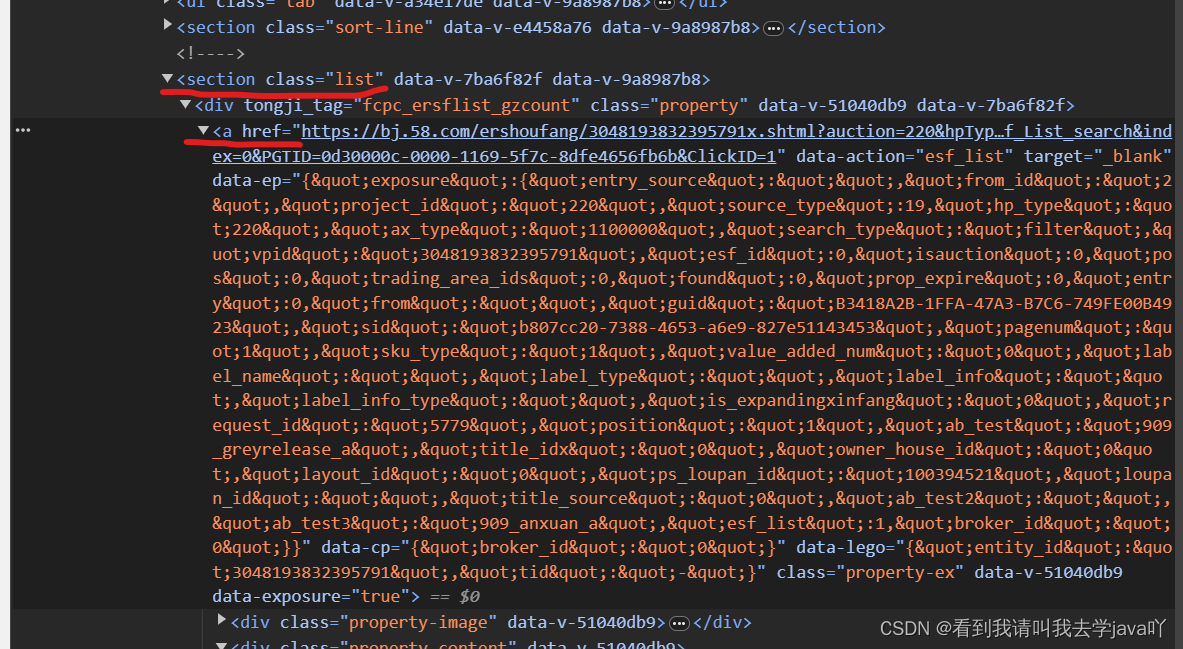

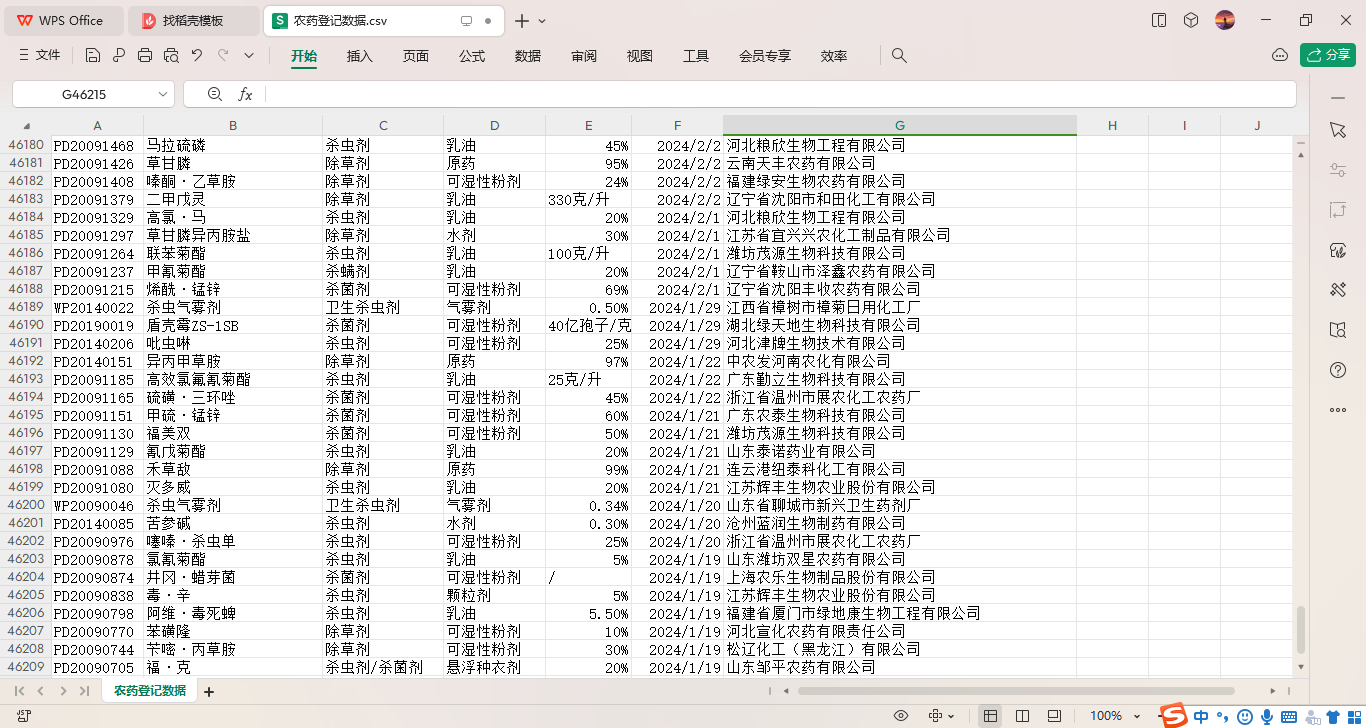

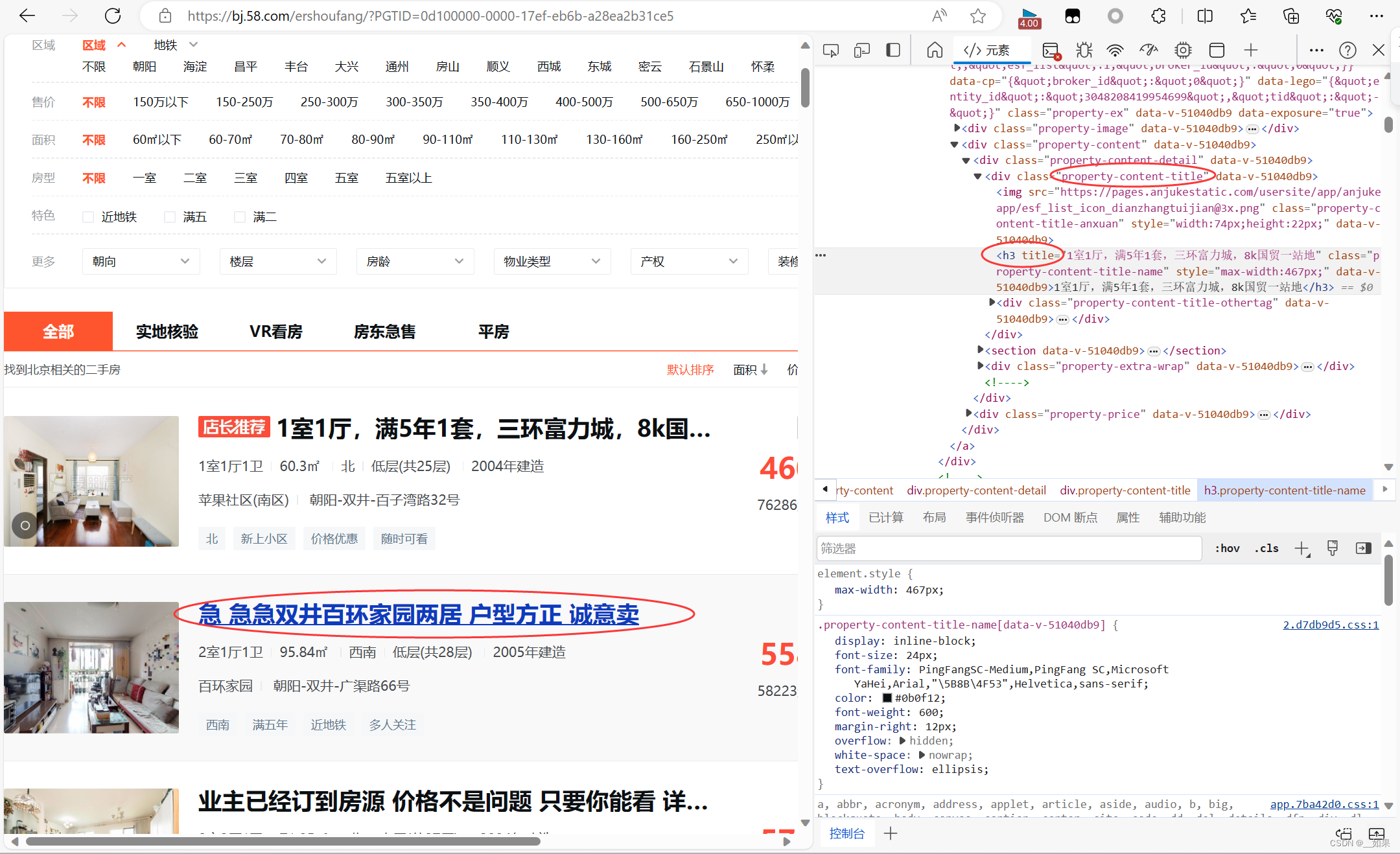

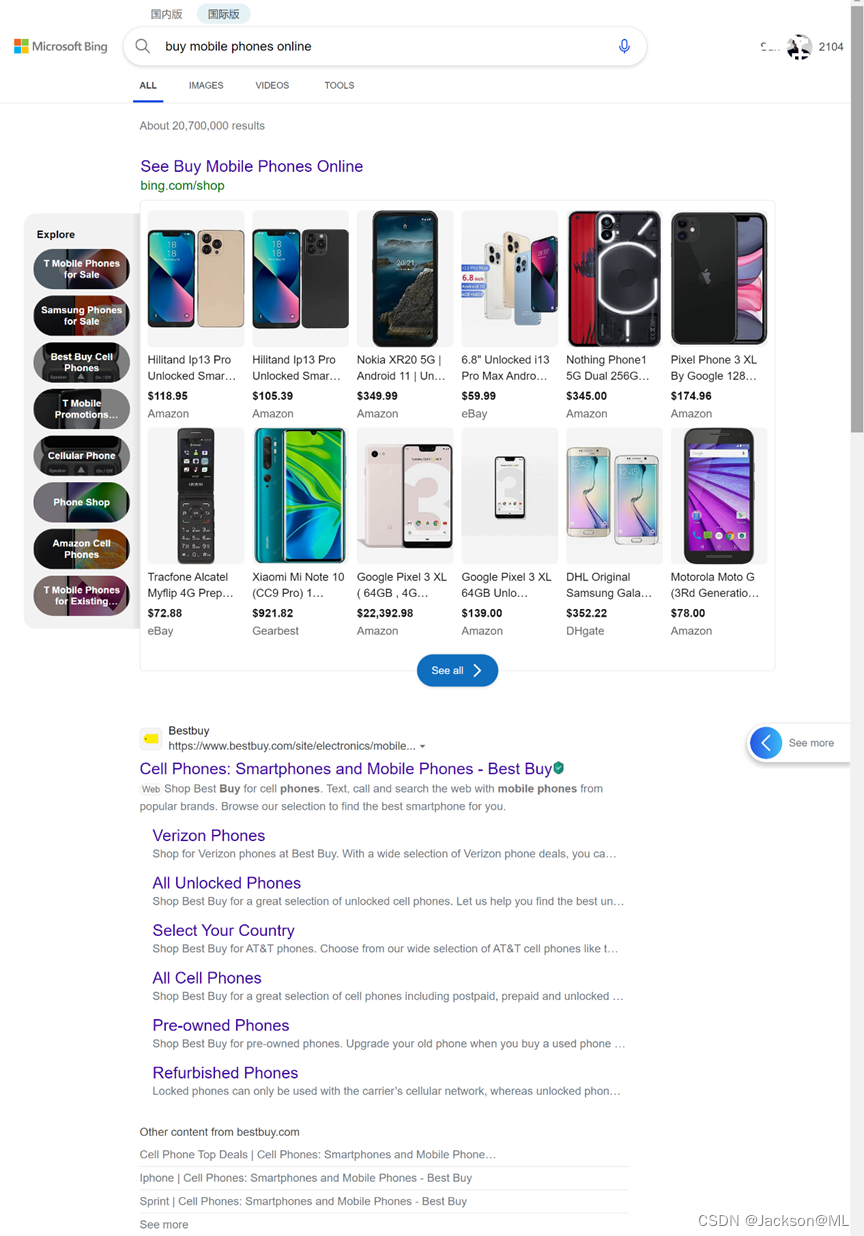

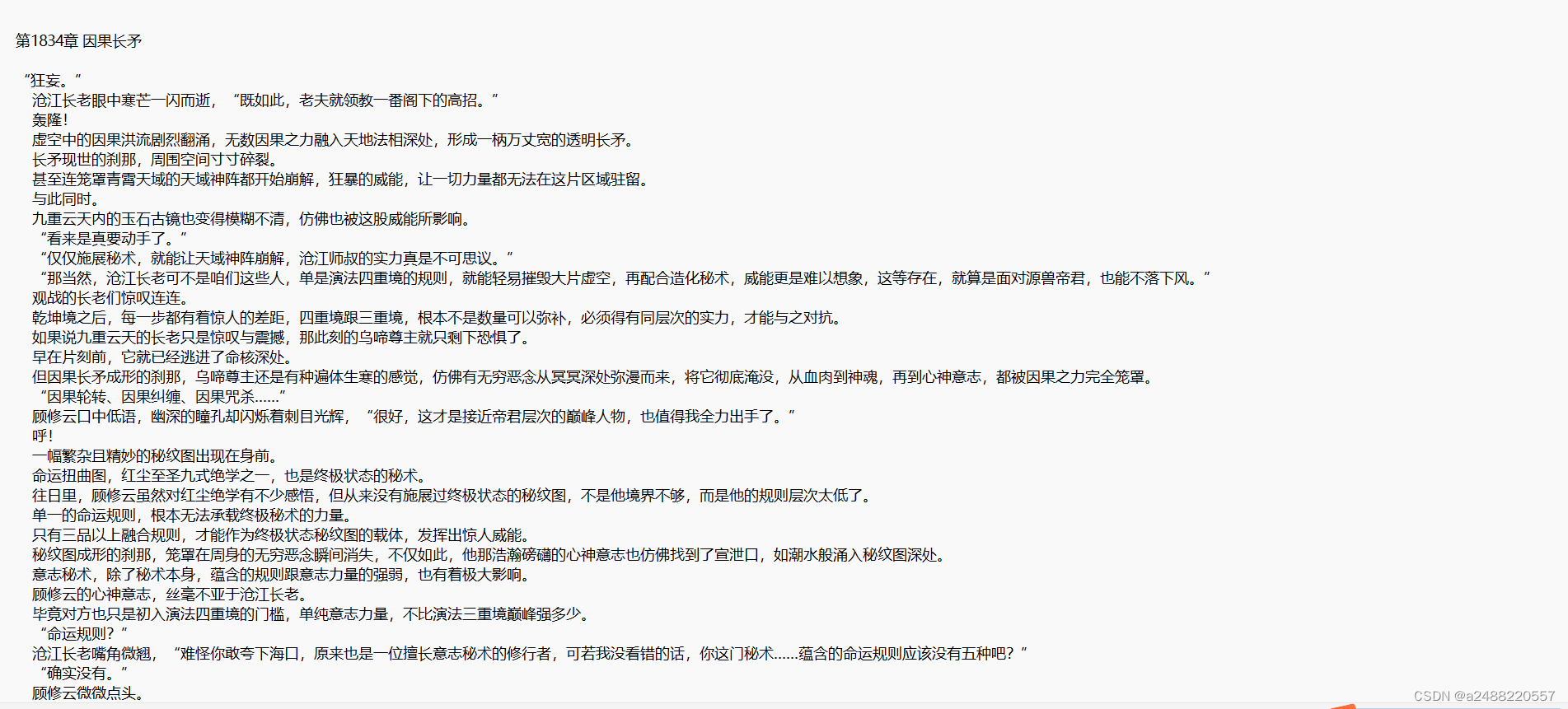

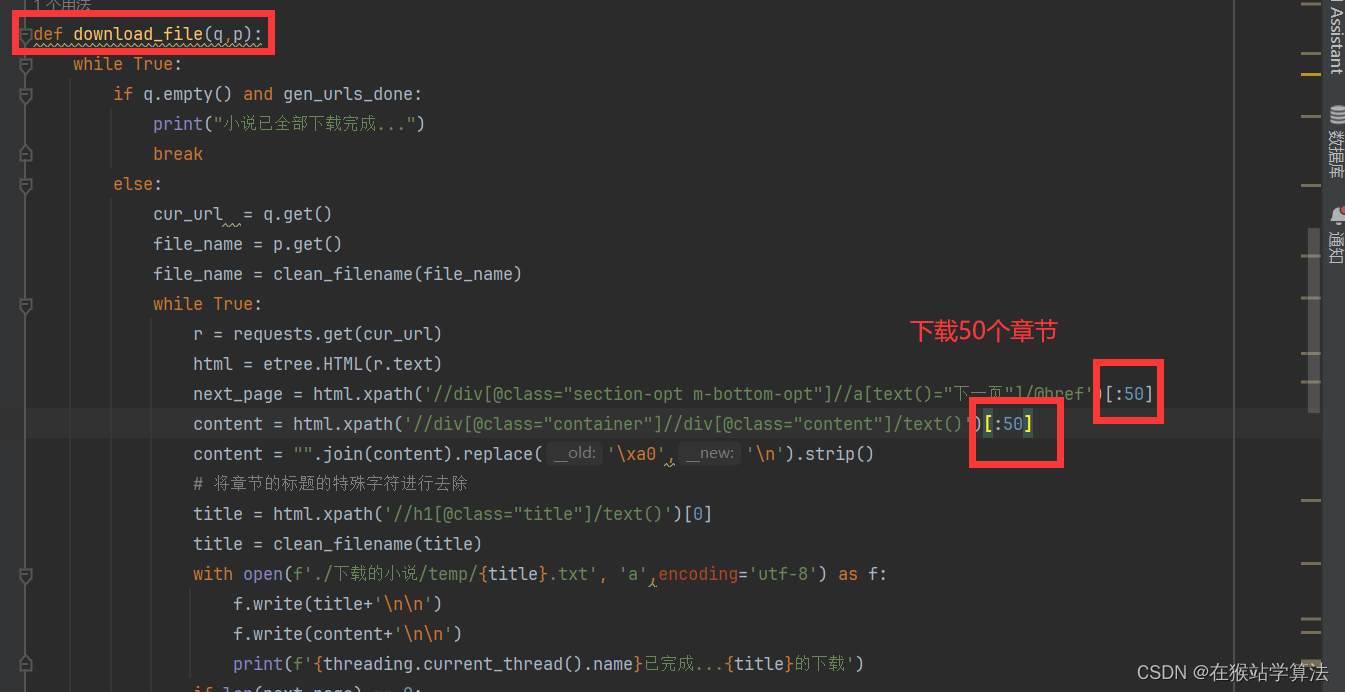

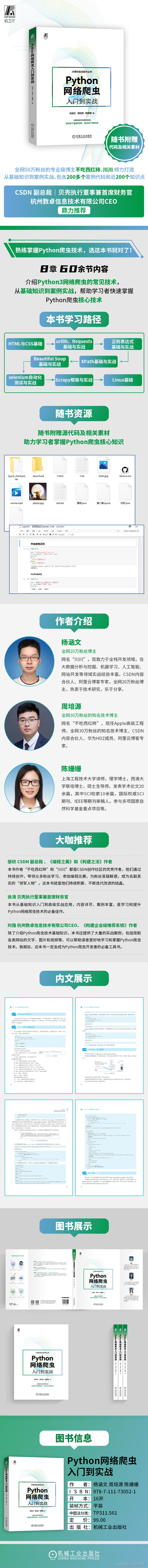

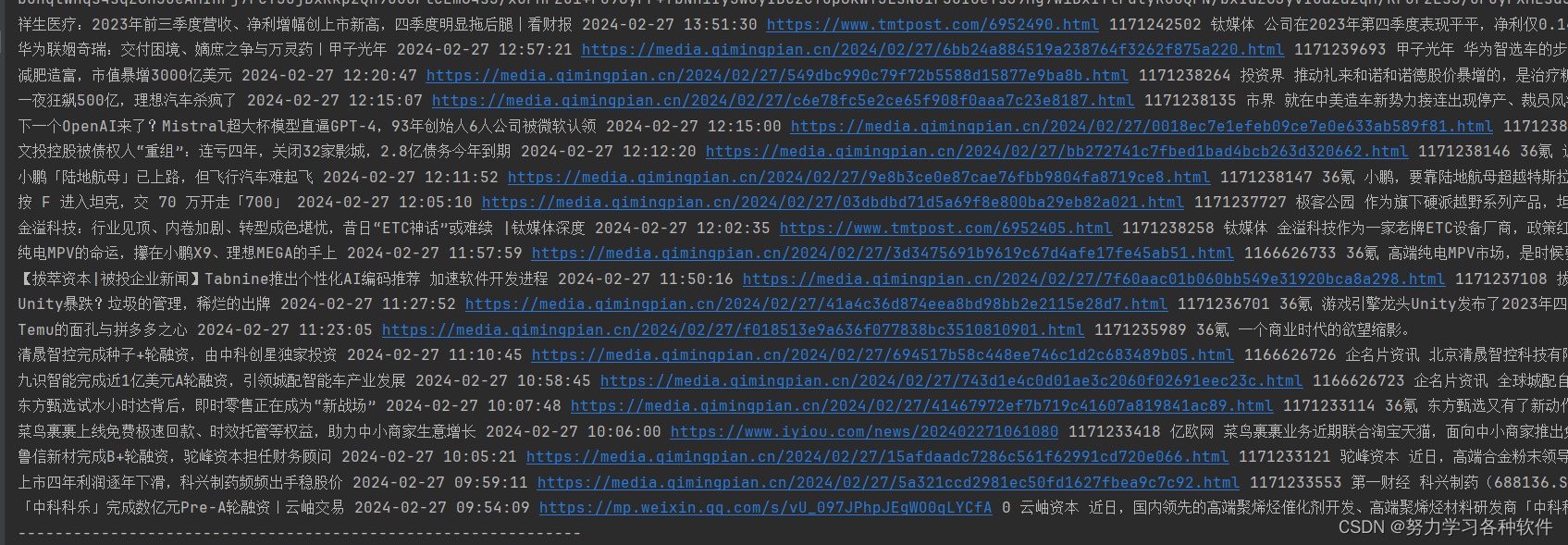

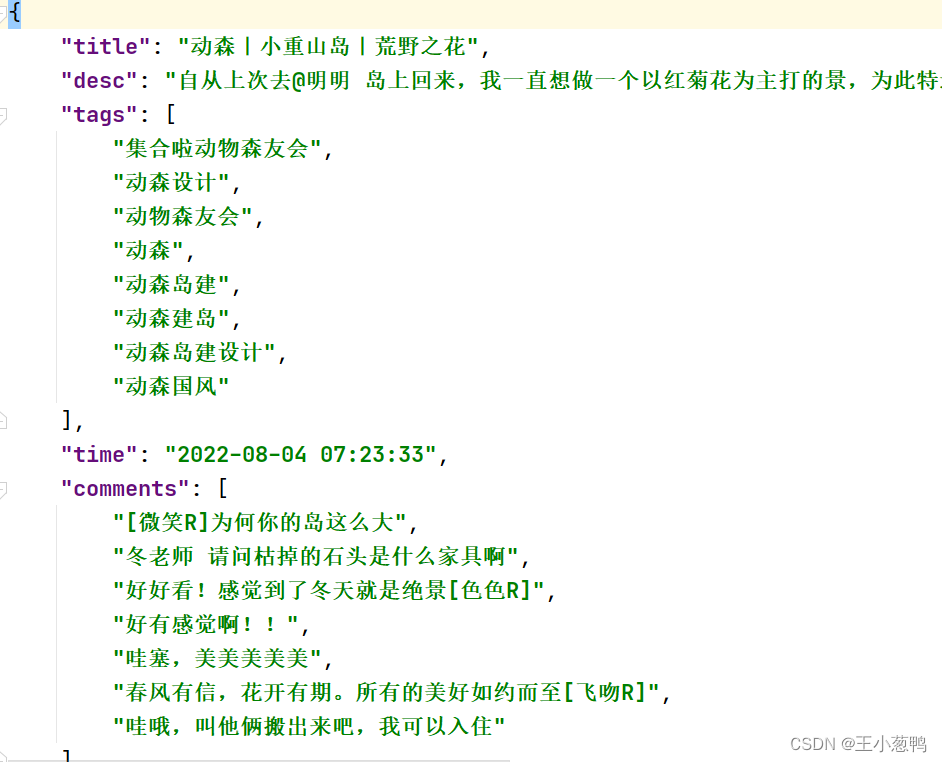

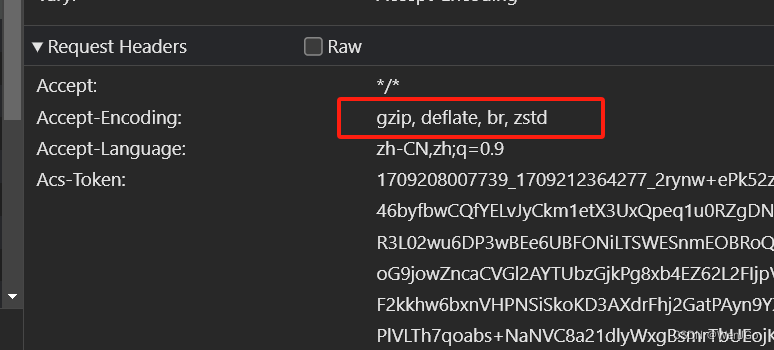

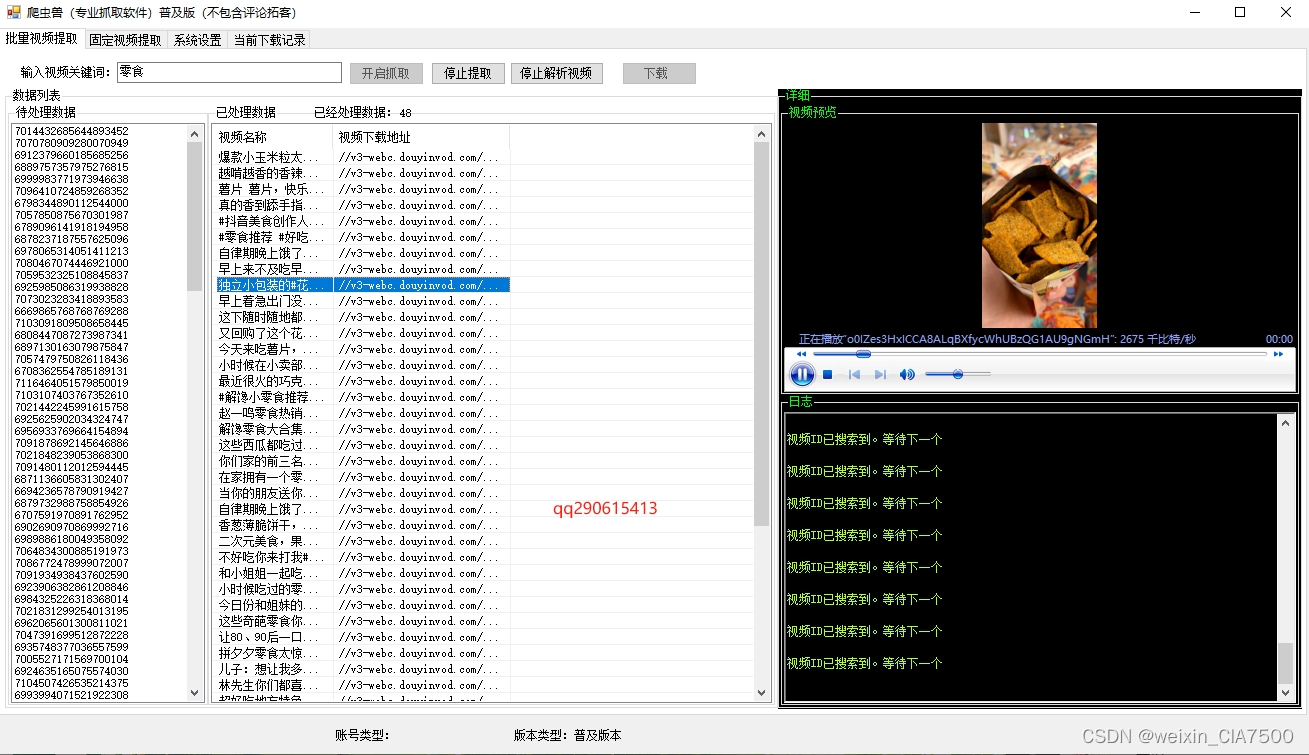

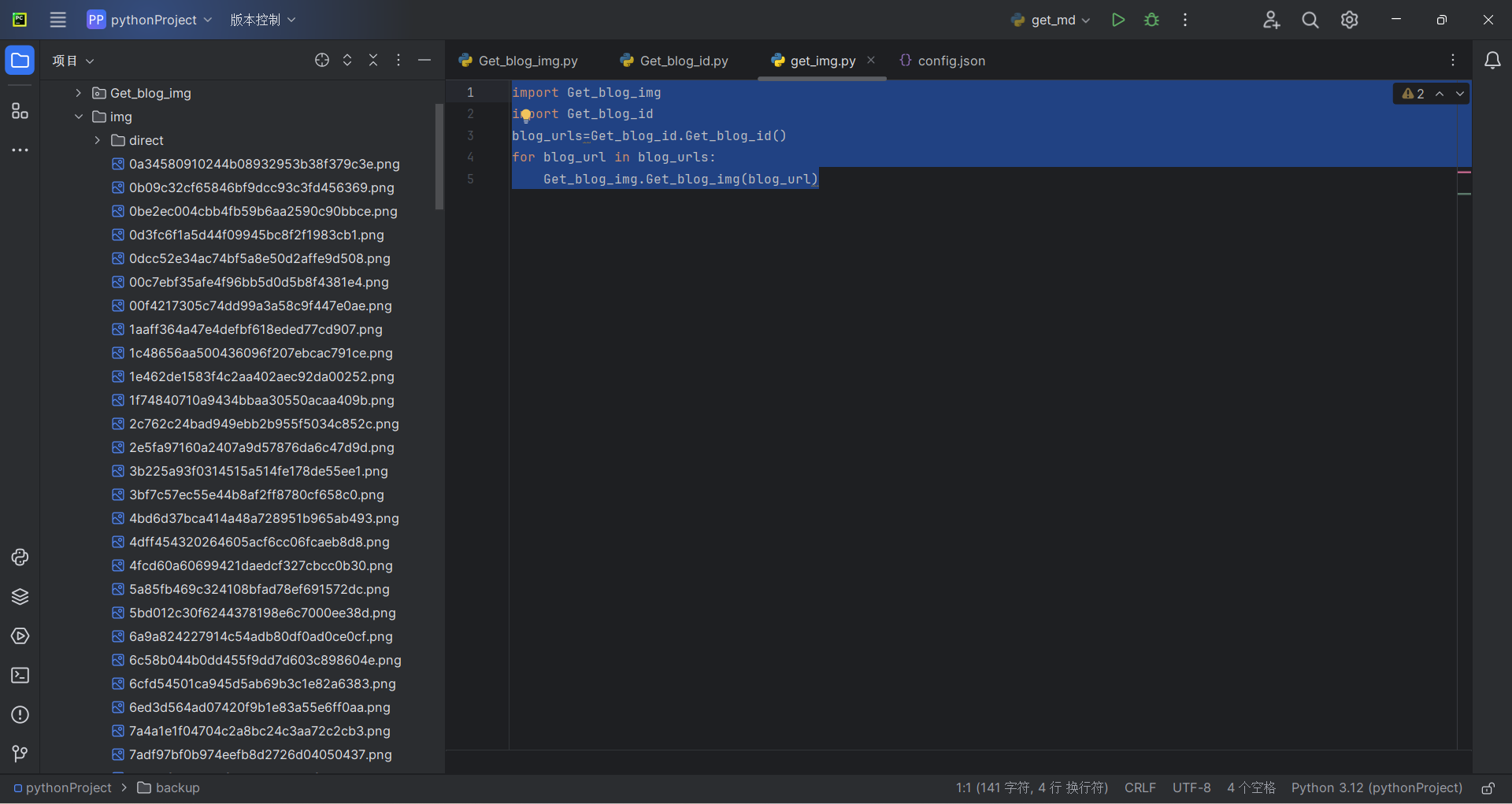

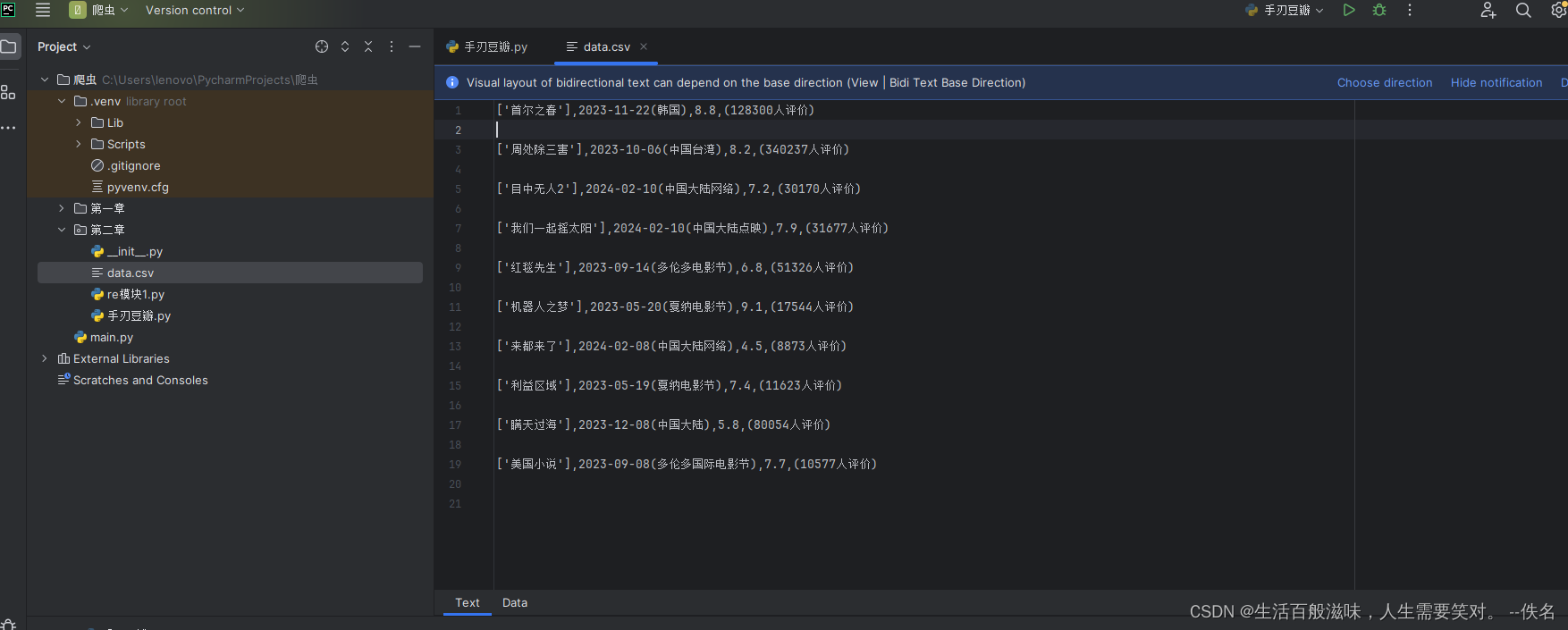

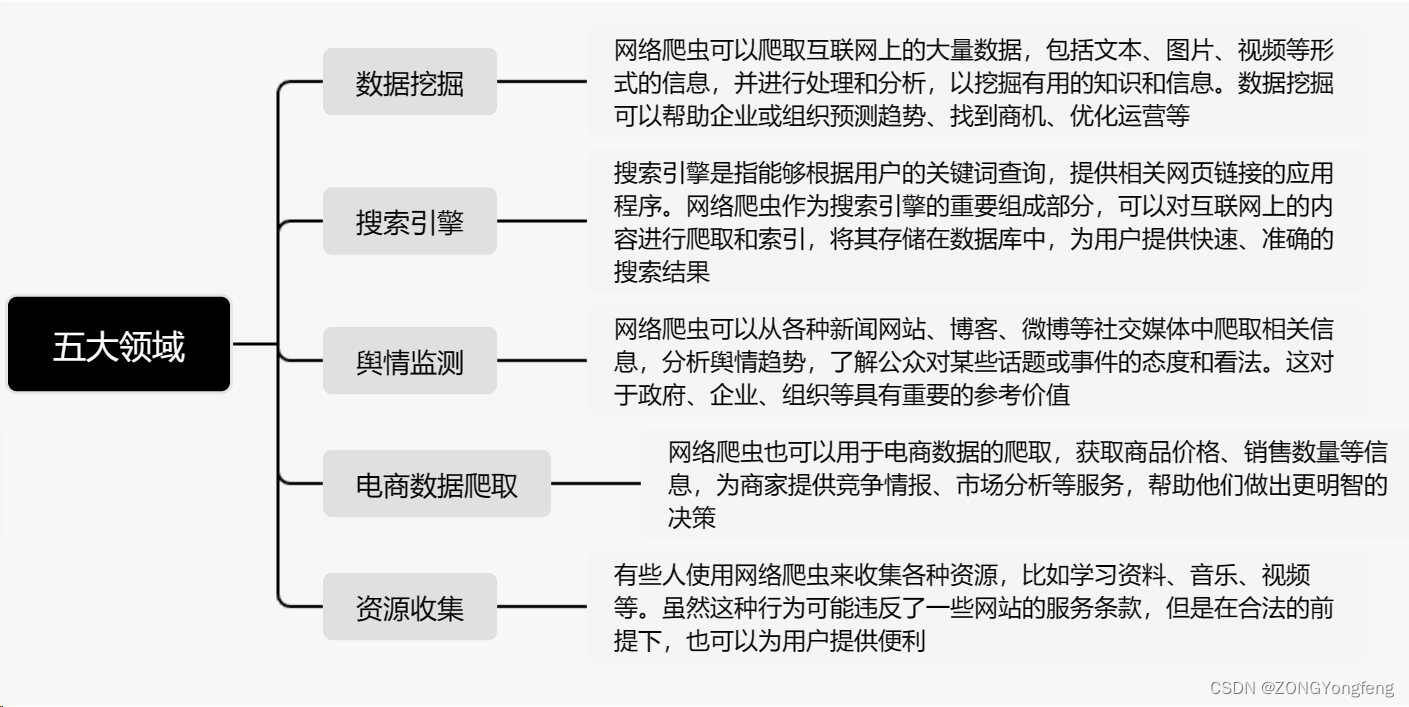

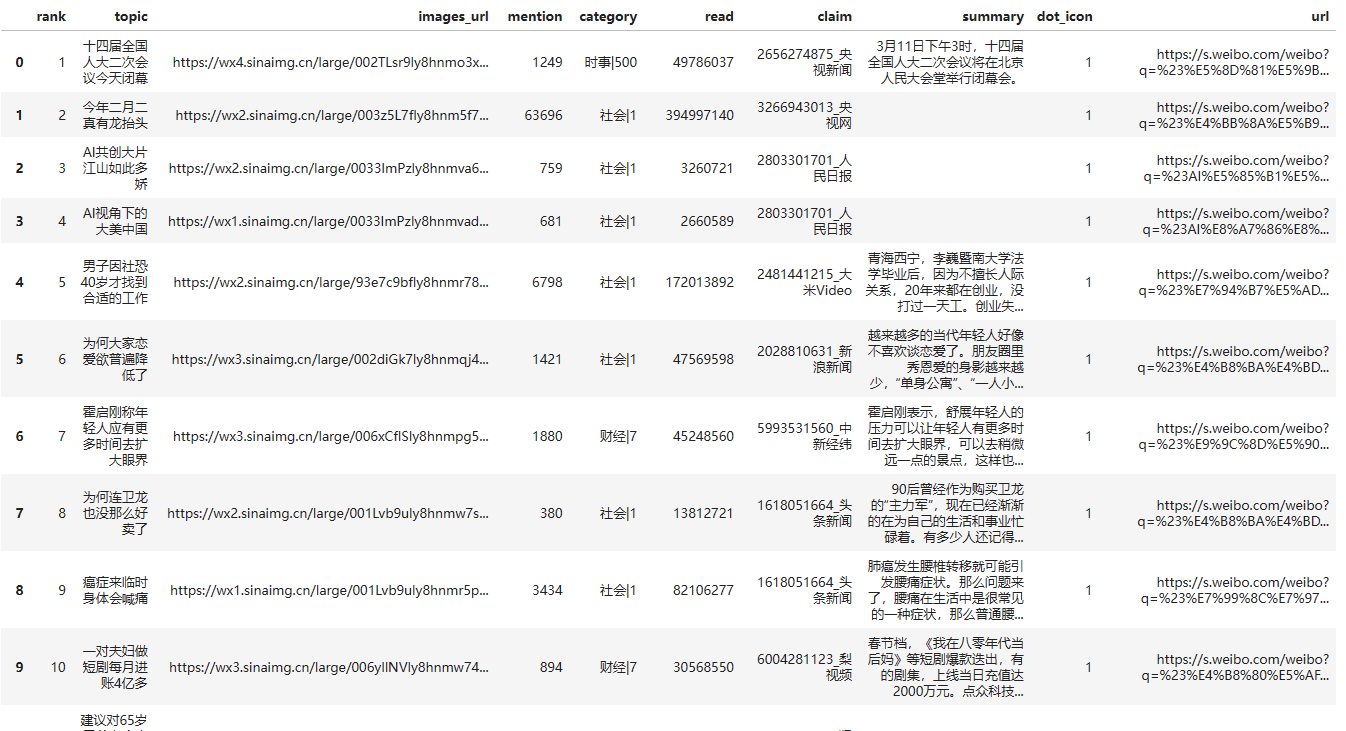

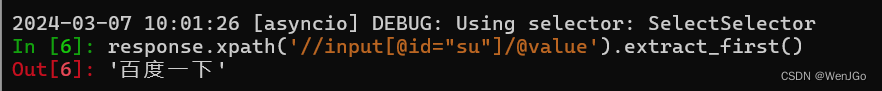

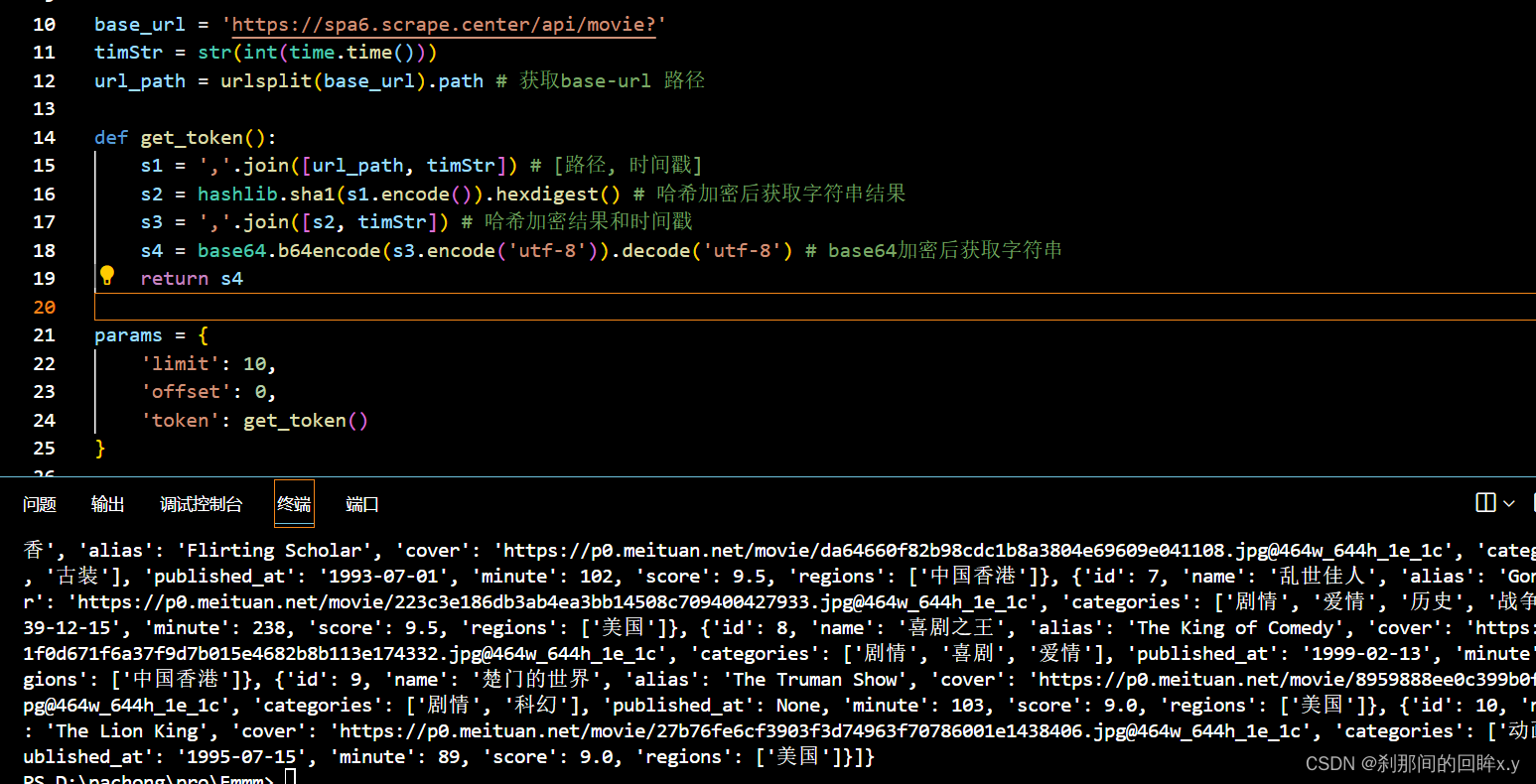

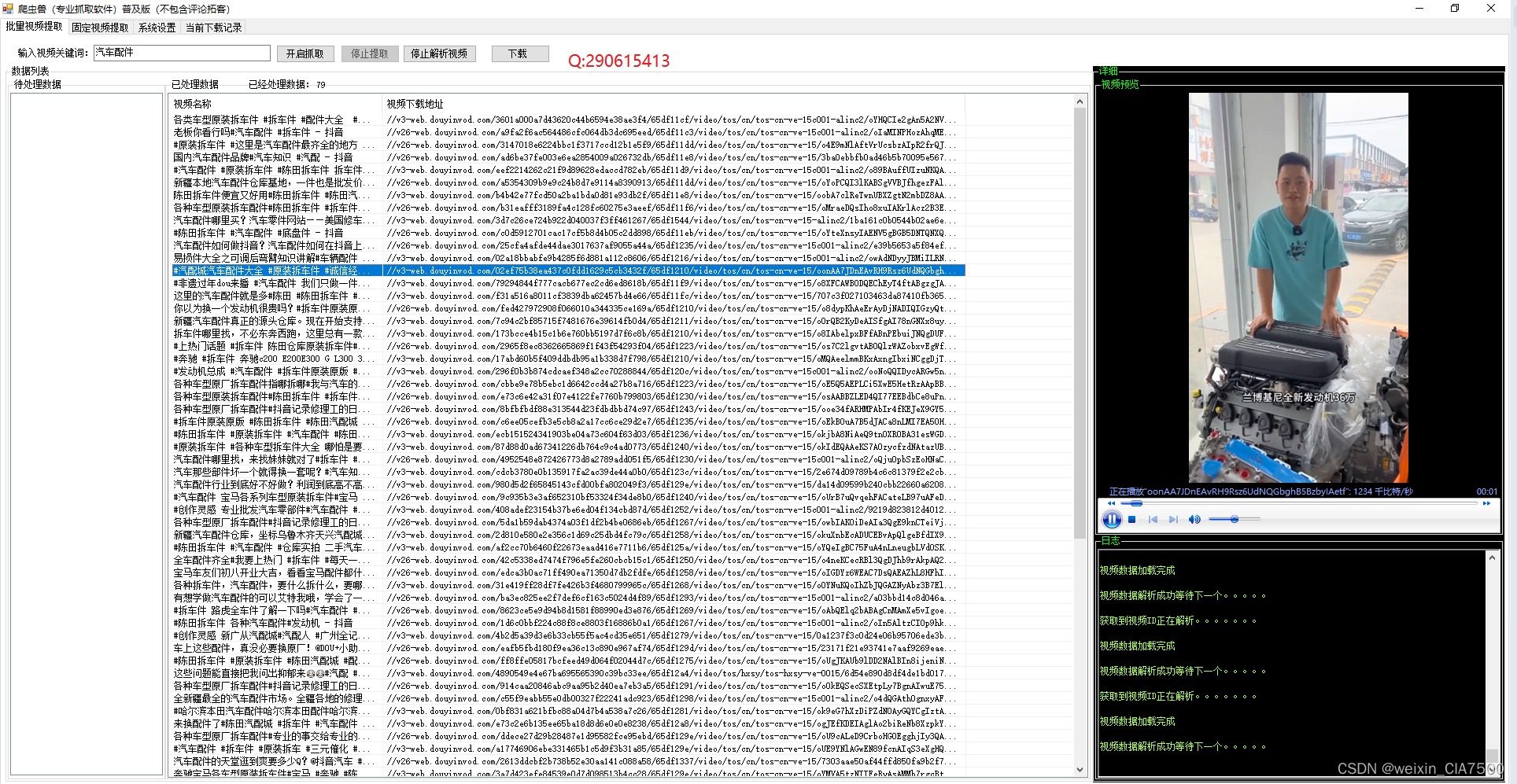

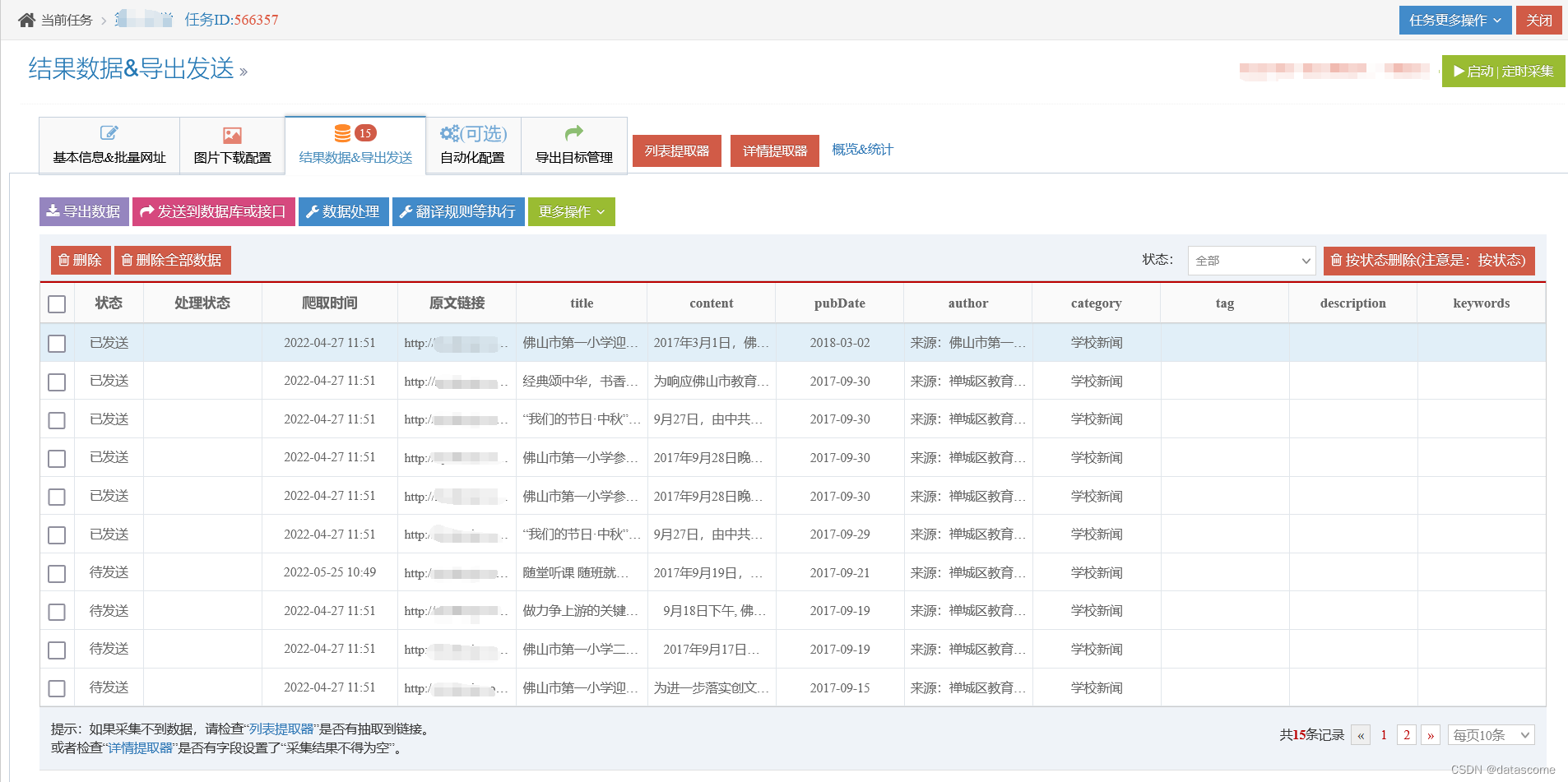

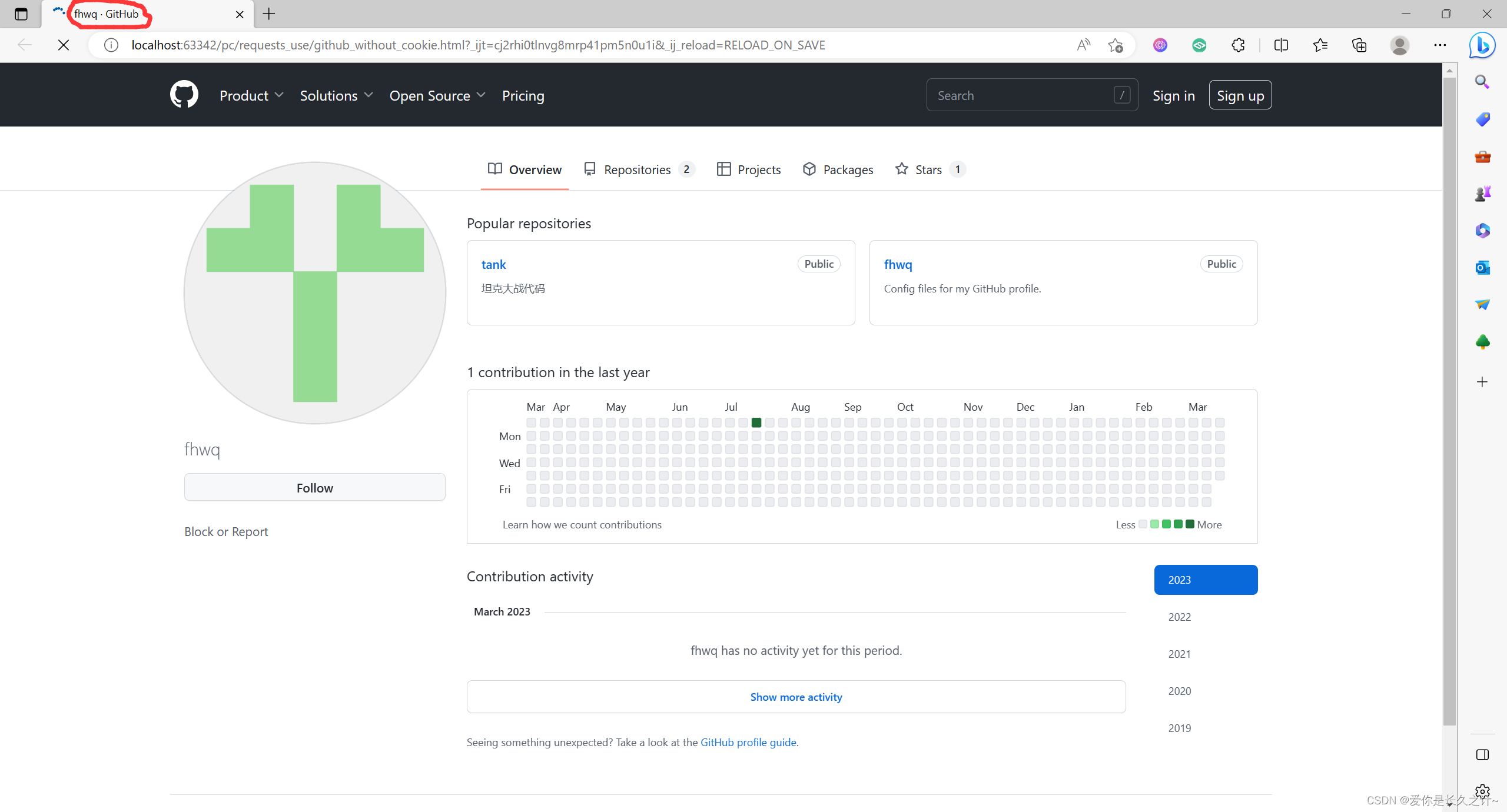

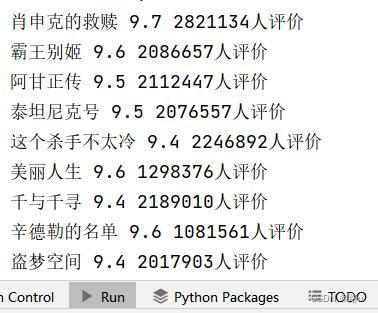

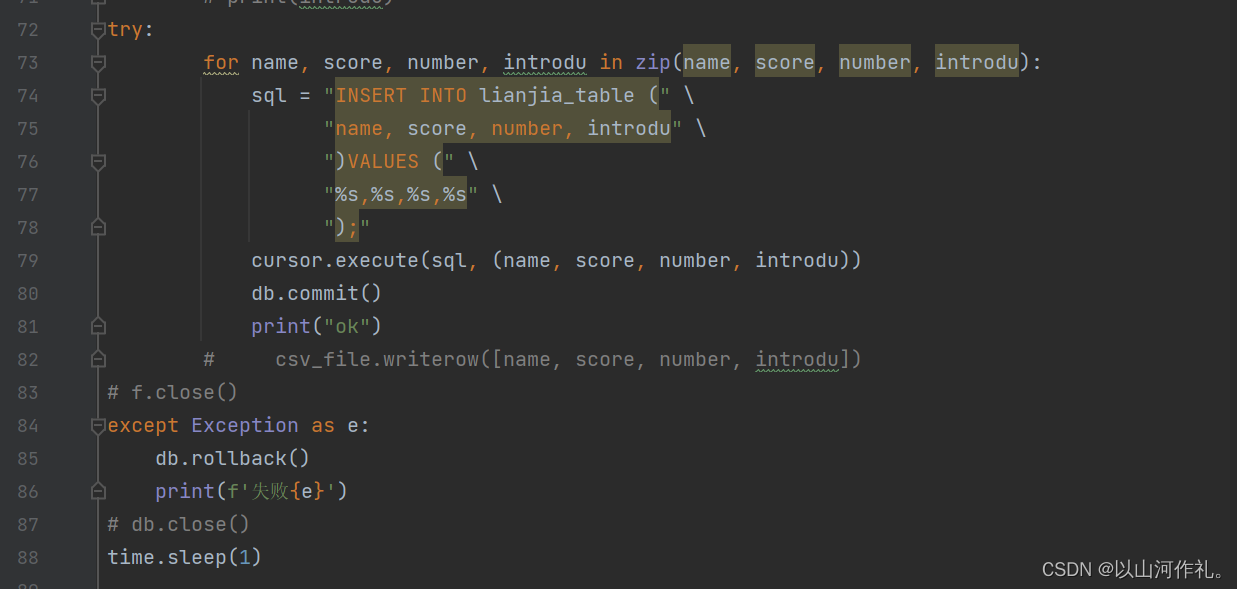

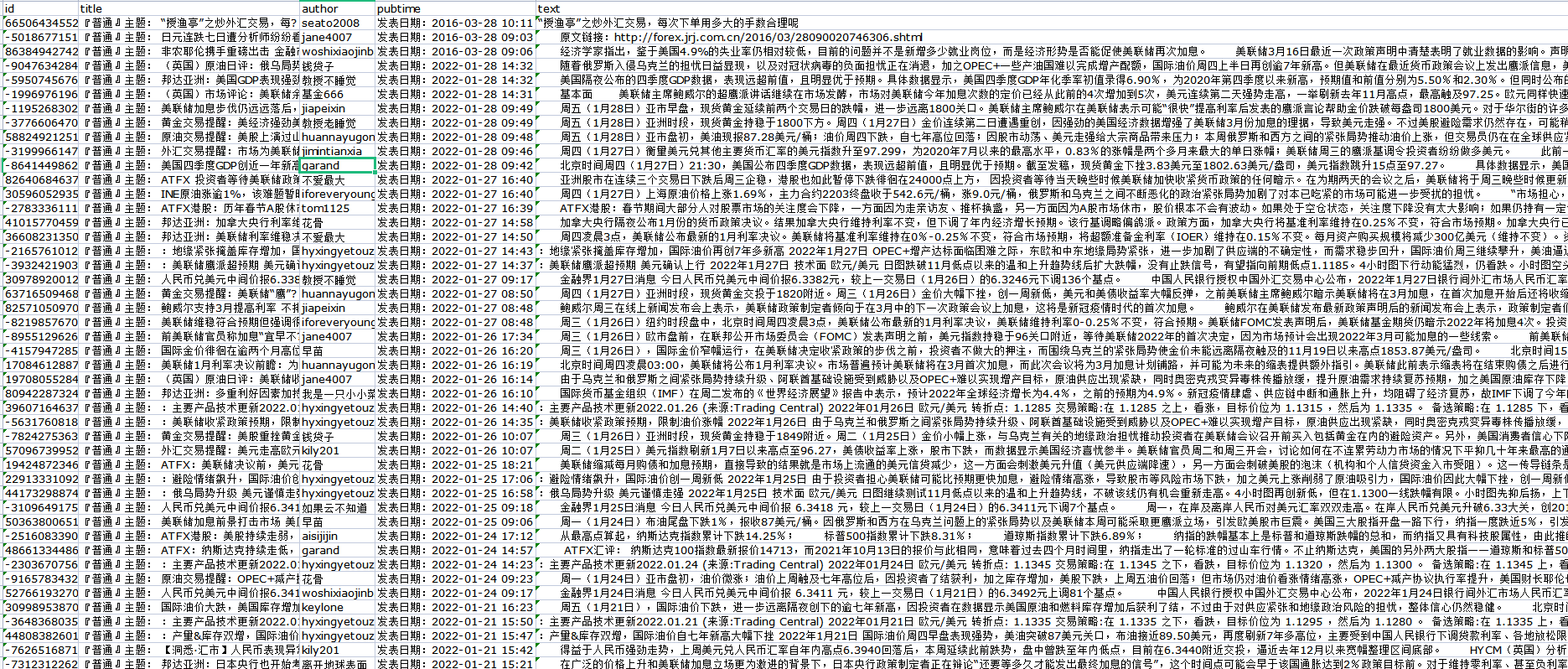

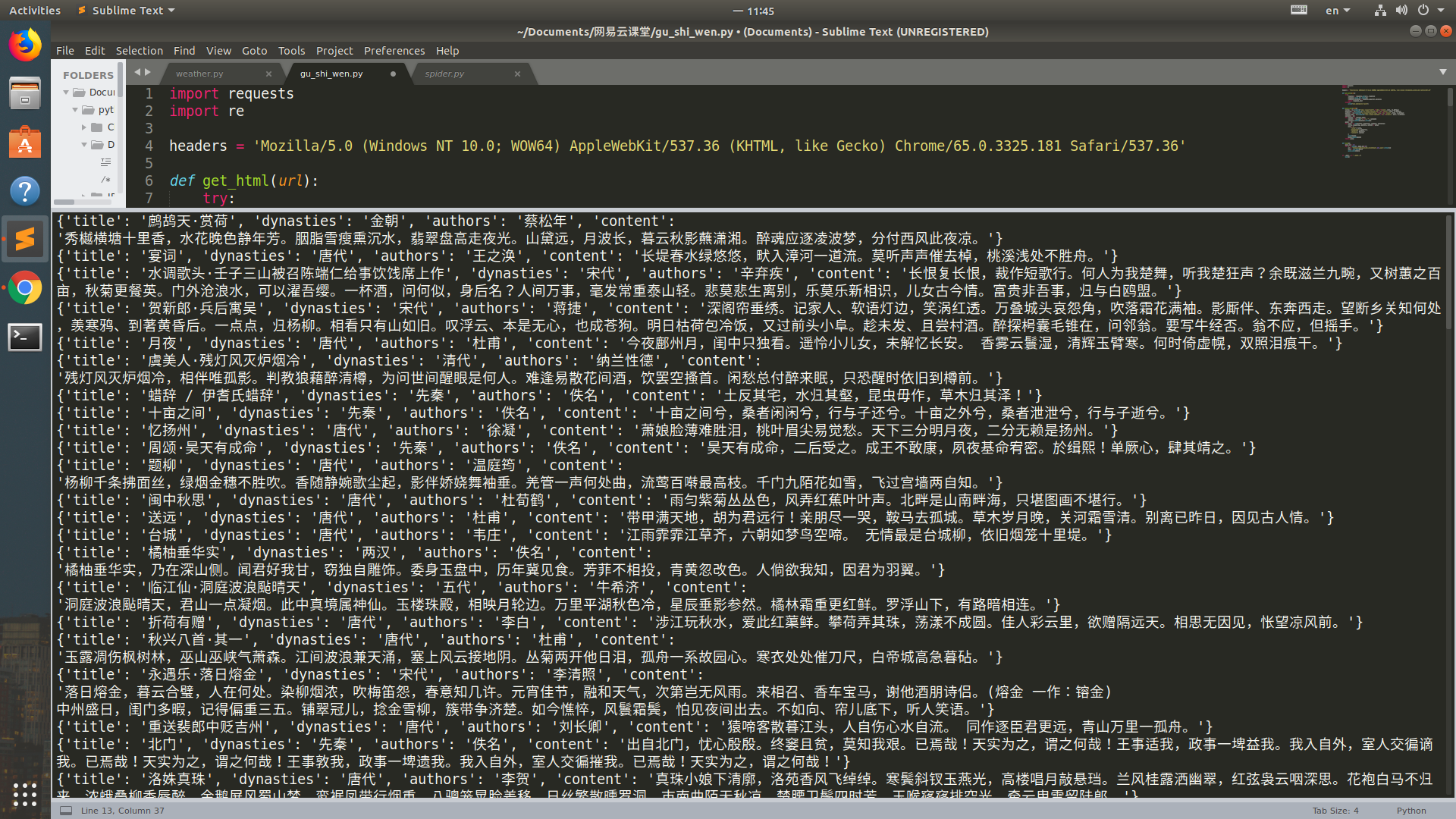

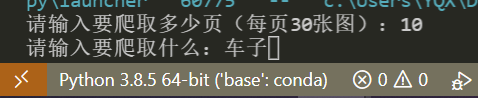

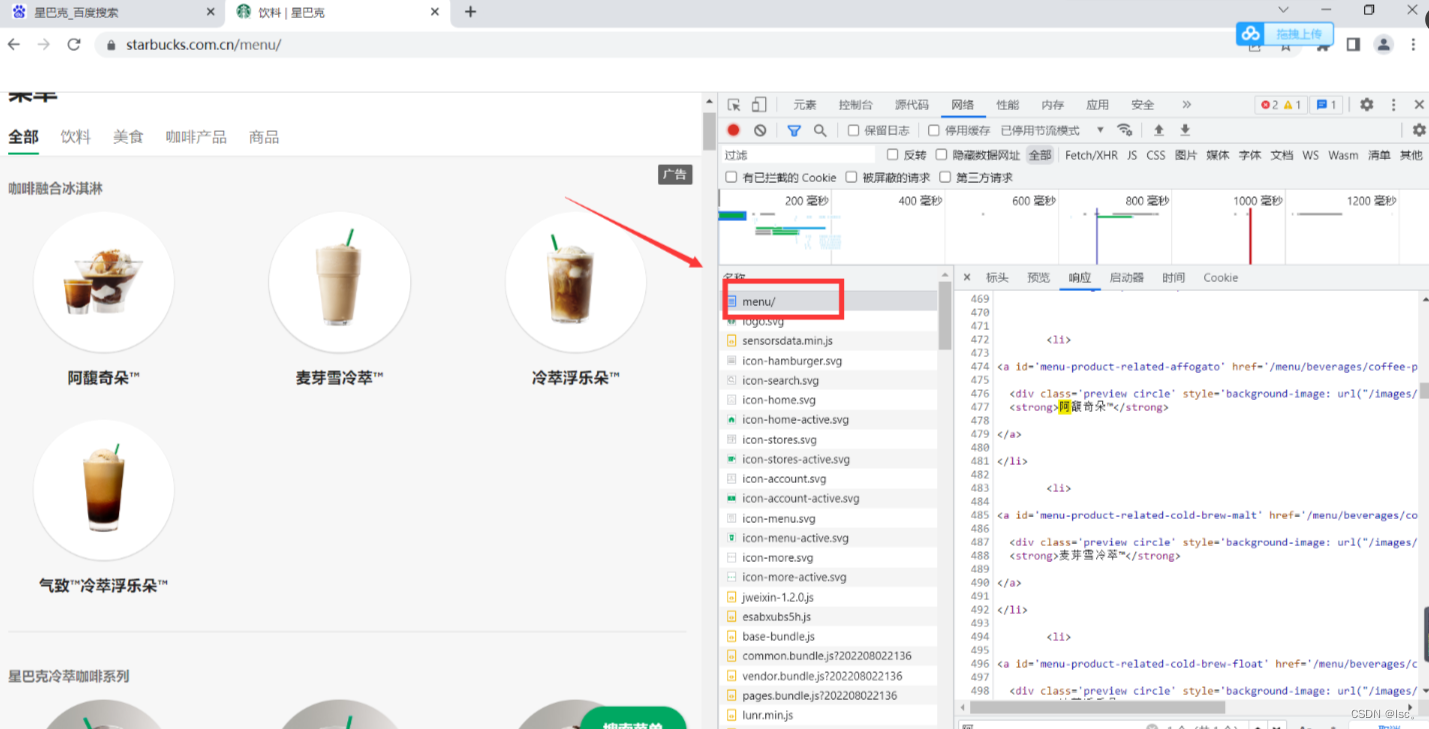

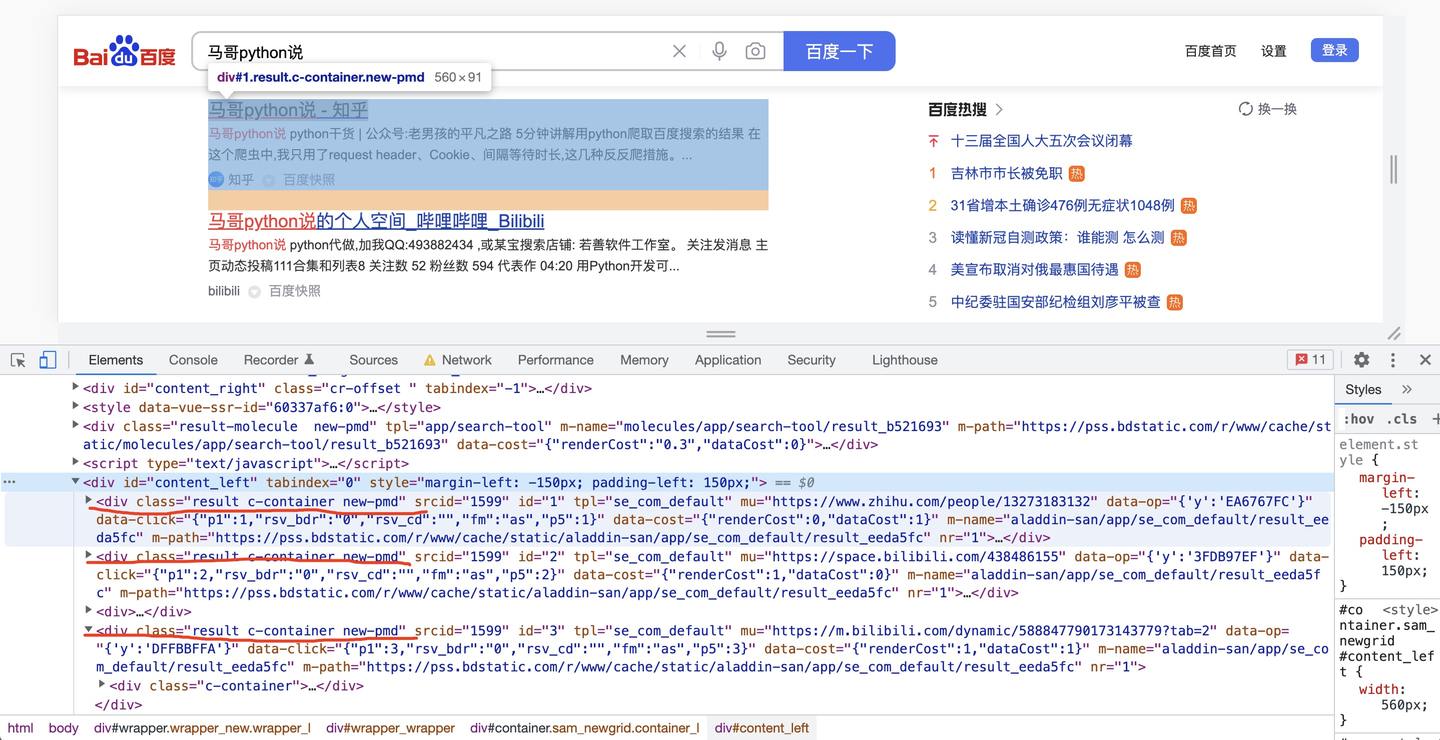

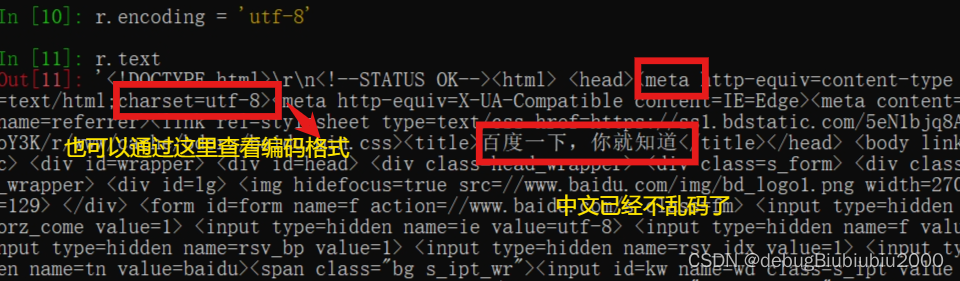

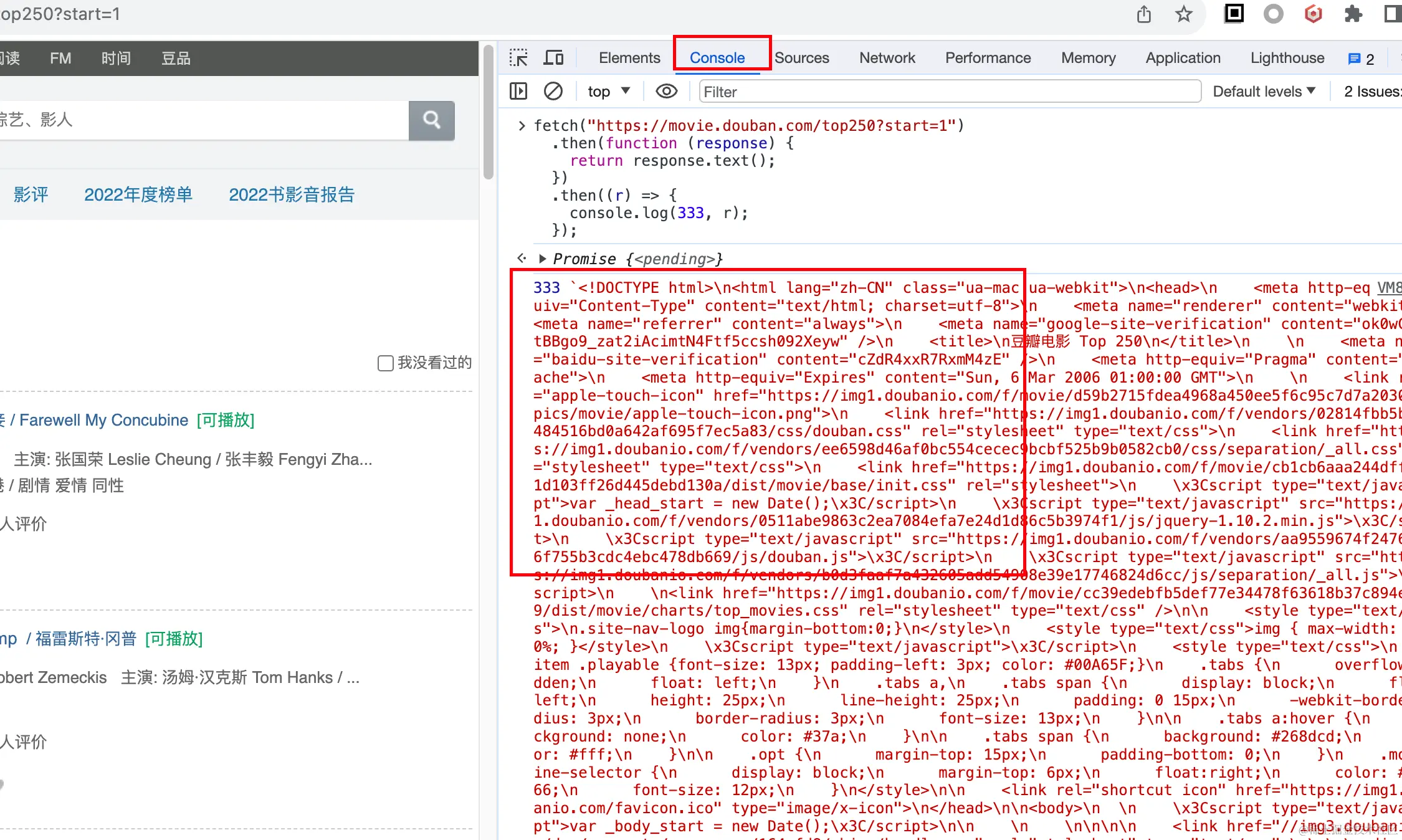

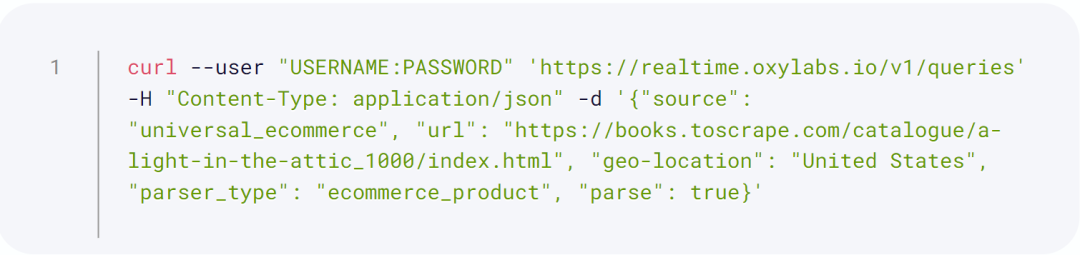

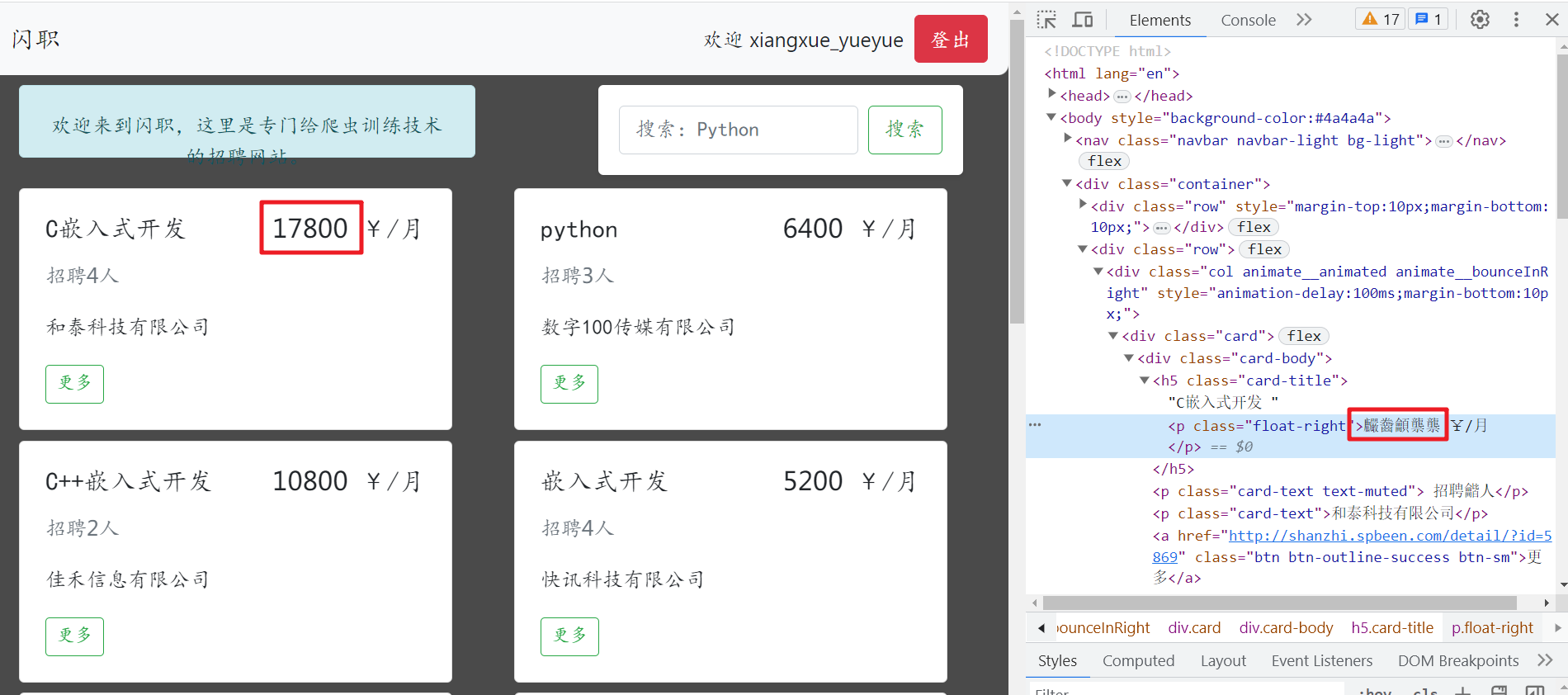

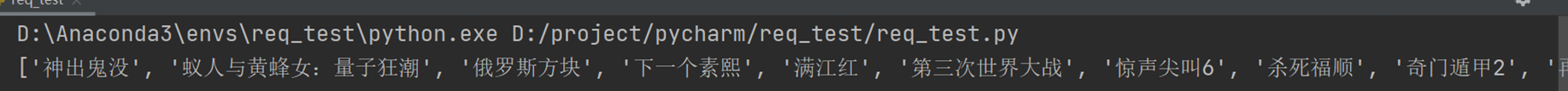

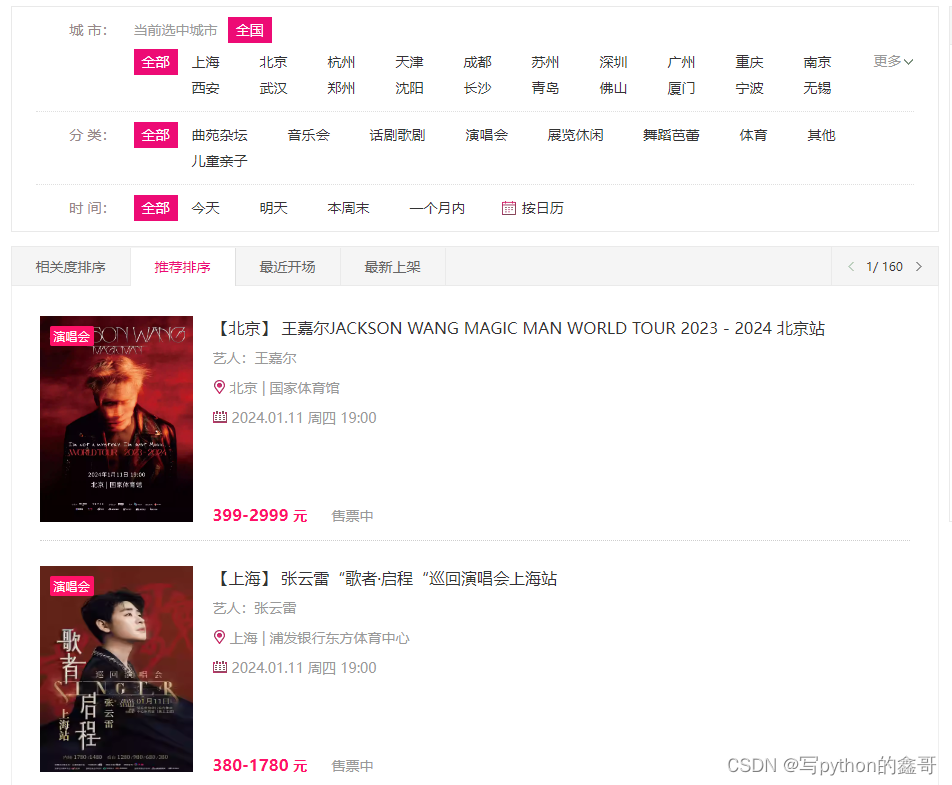

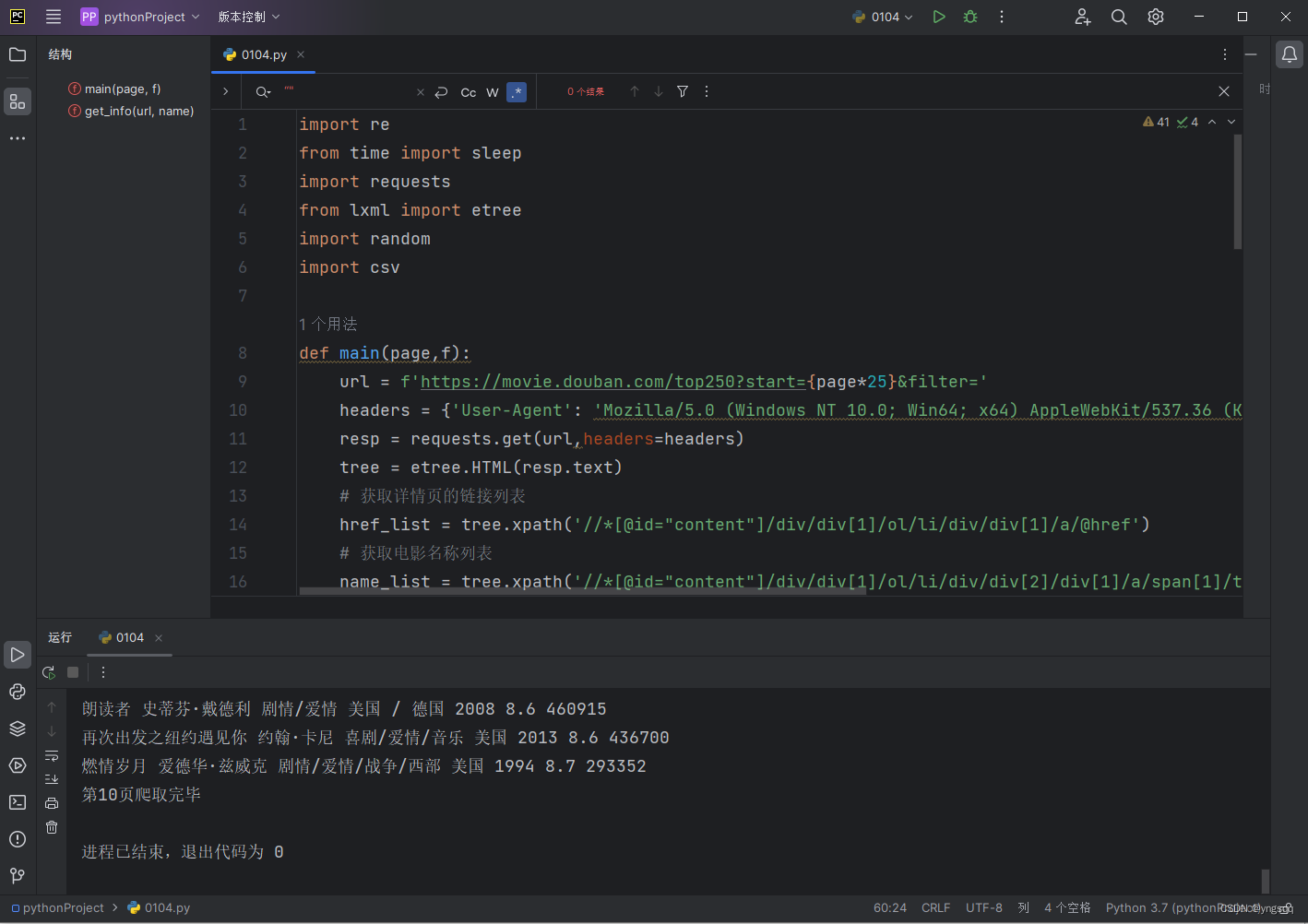

爬虫

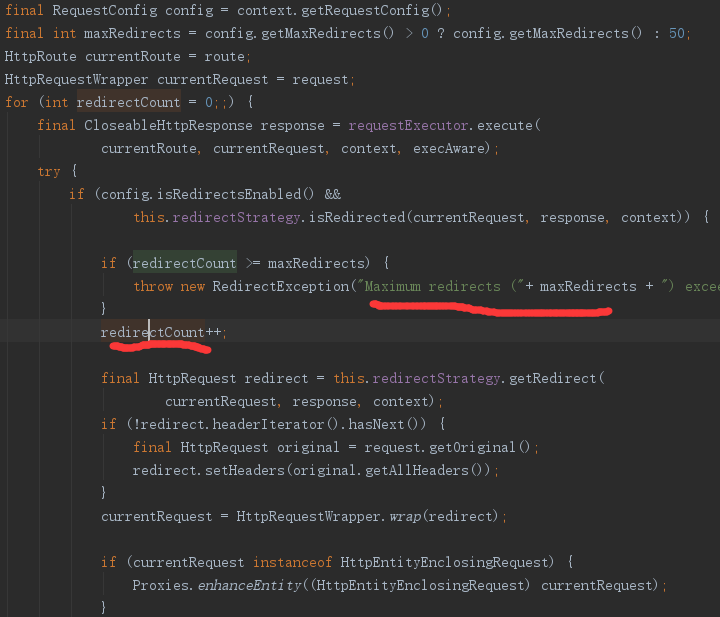

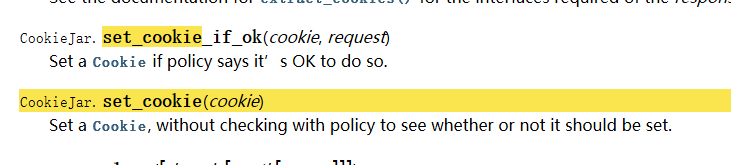

2024/4/11 13:01:00HttpComponents HttpClient 4.3-alpha1 发布

HttpComponents HttpClient 发布了 4.3 的首个 alpha 版本。4.3 是一个新的版本,主要改进内容包括: 支持 Java 7 的 try-with-resources 资源管理,用于连接的释放为 HttpEntity、HttpRequest 和 HttpClient 实例增加更便利的 Builder 类废弃基…

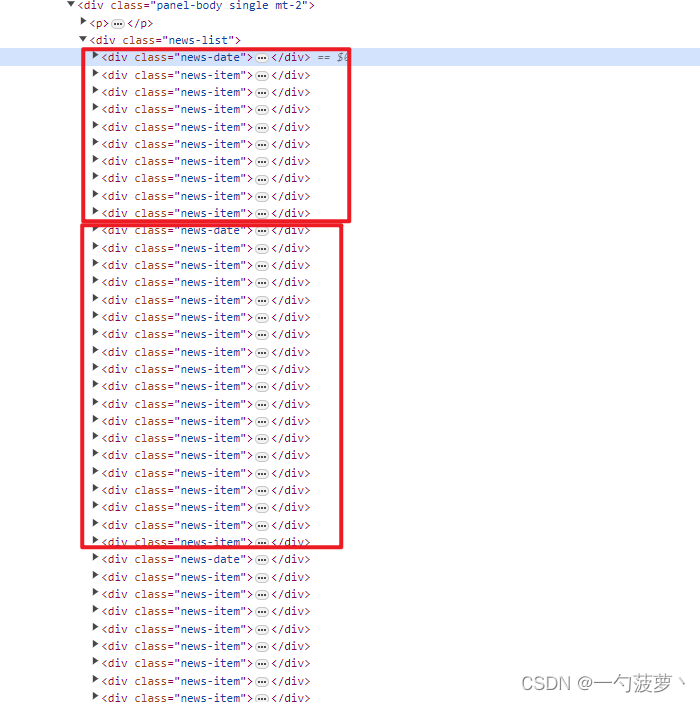

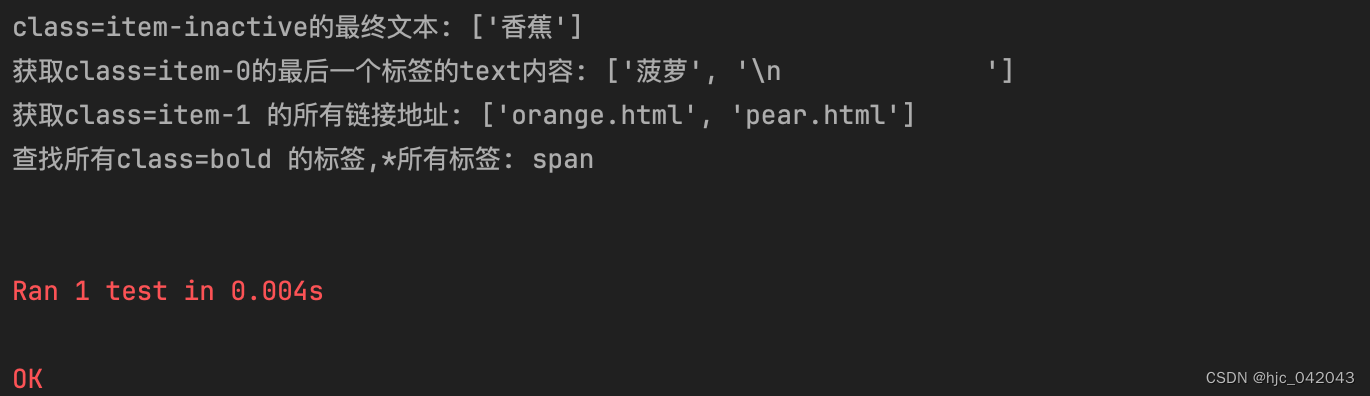

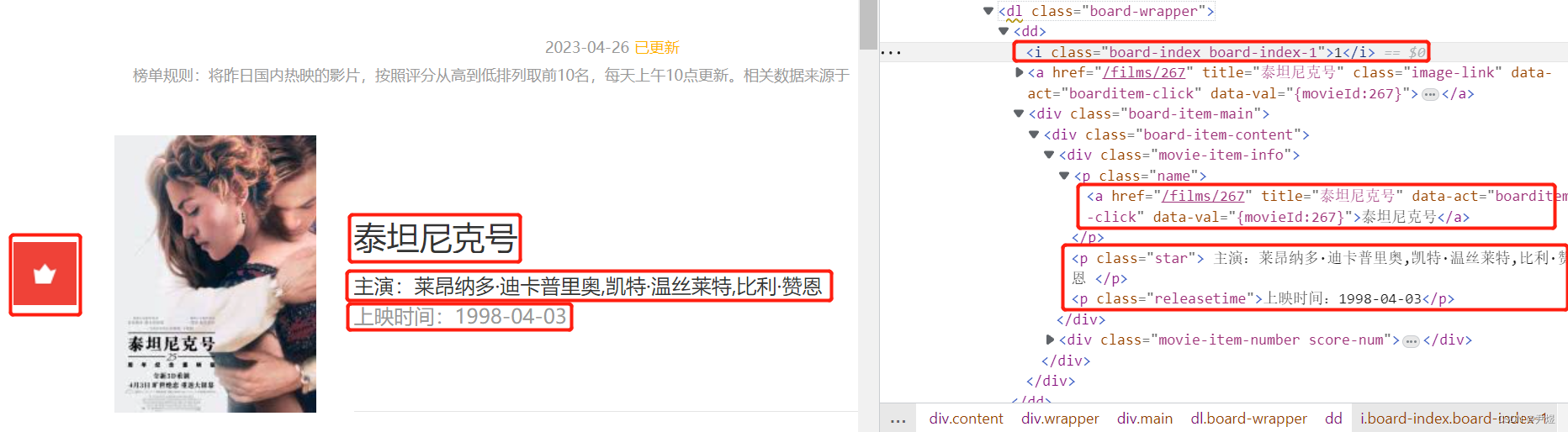

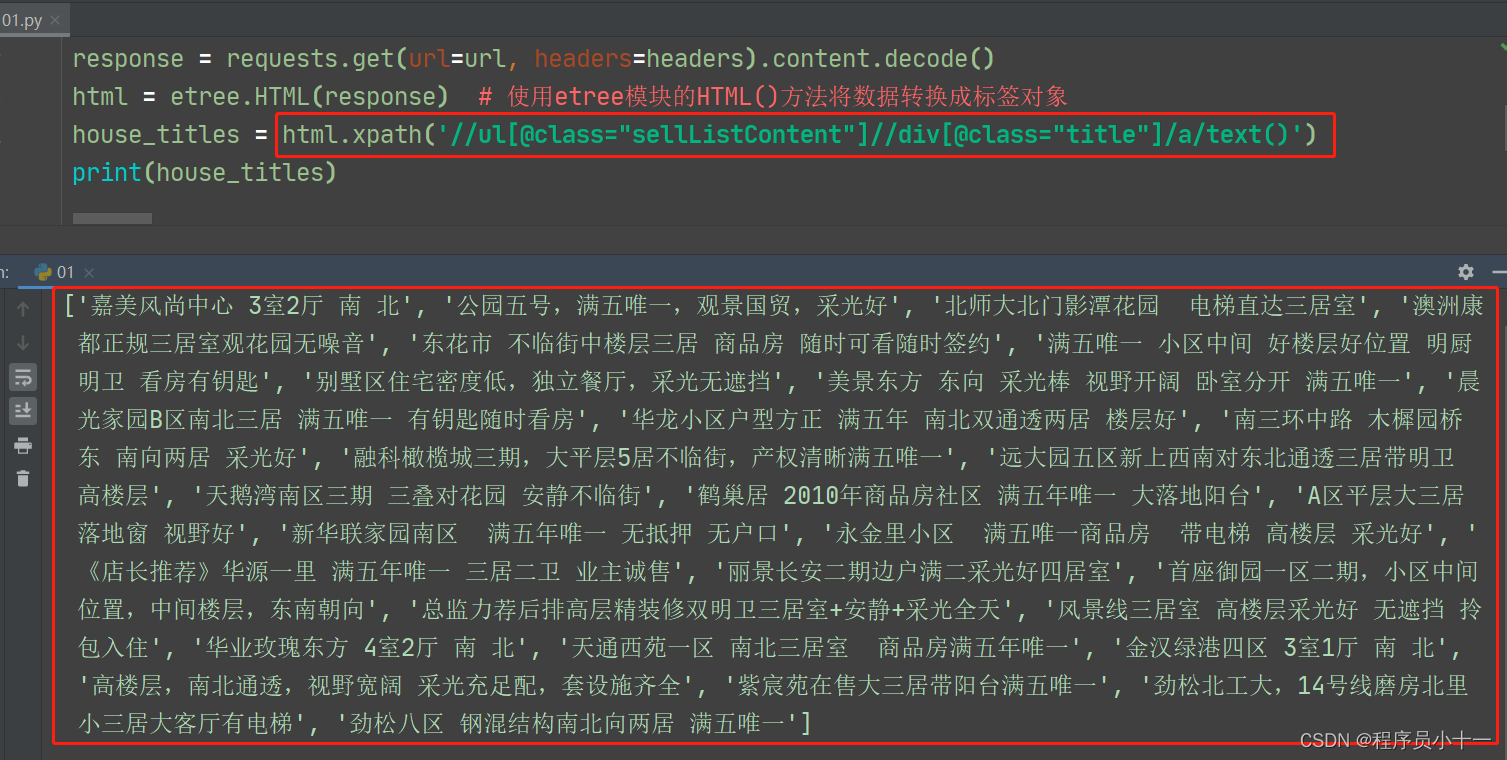

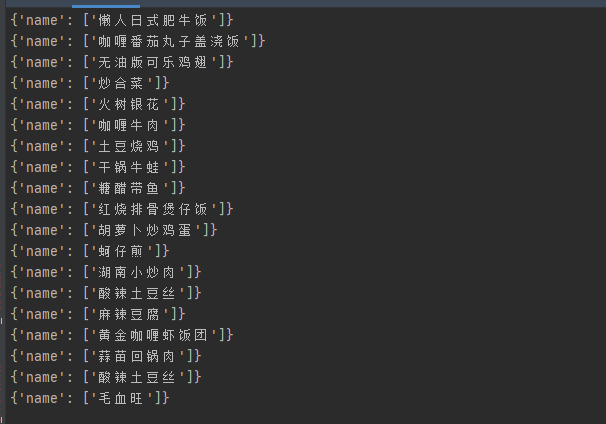

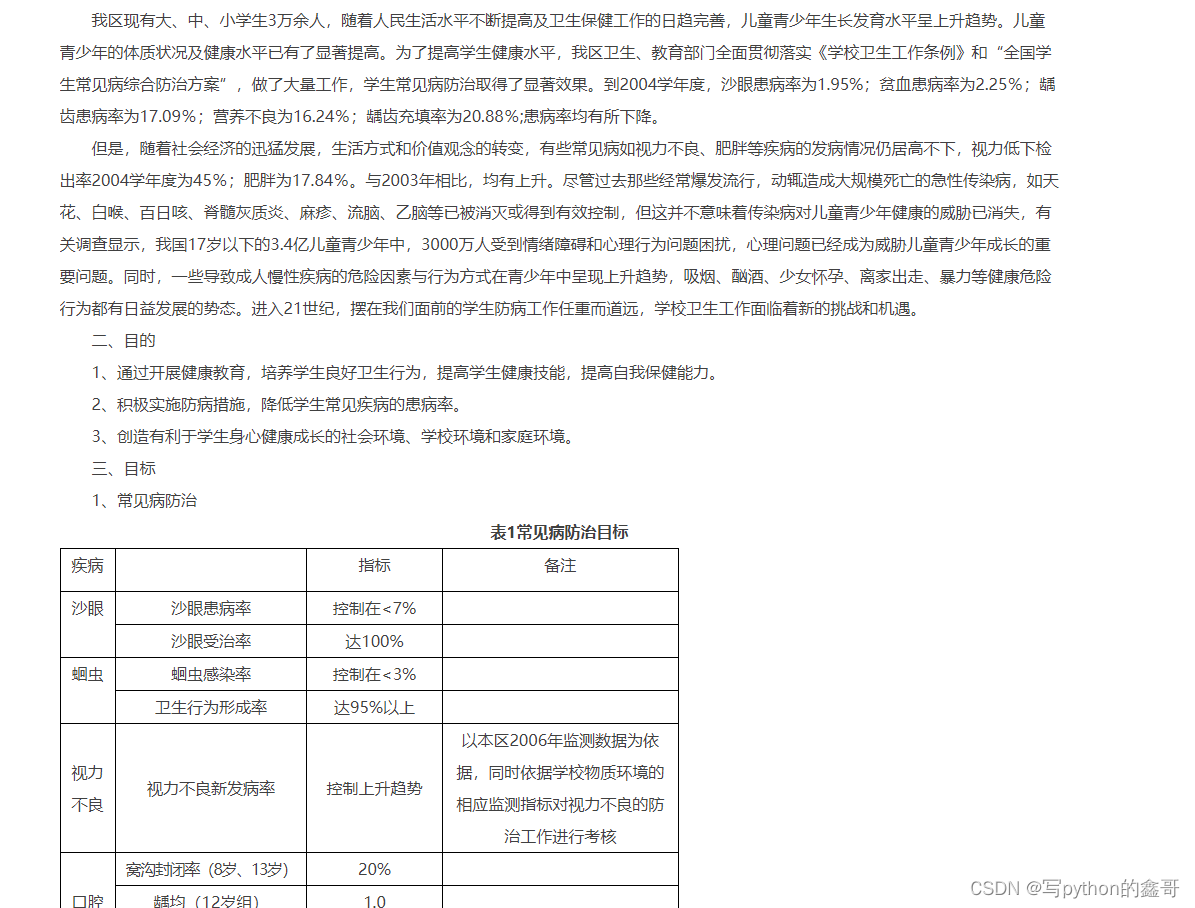

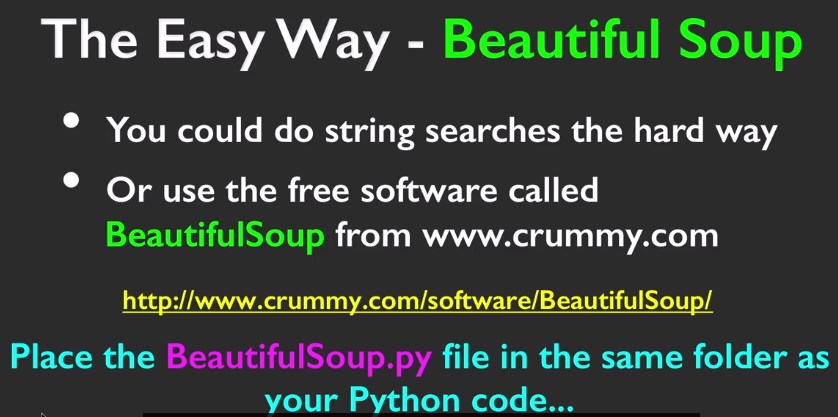

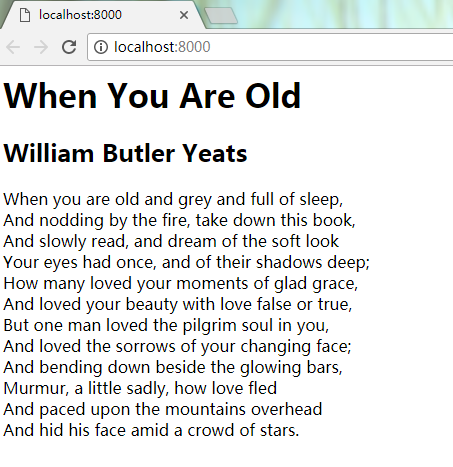

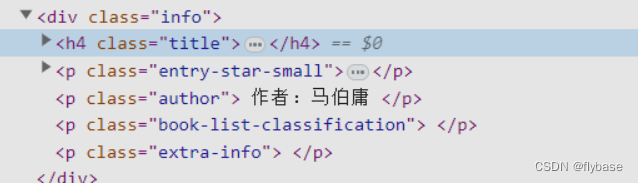

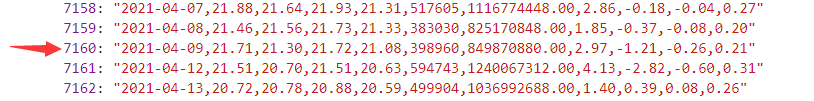

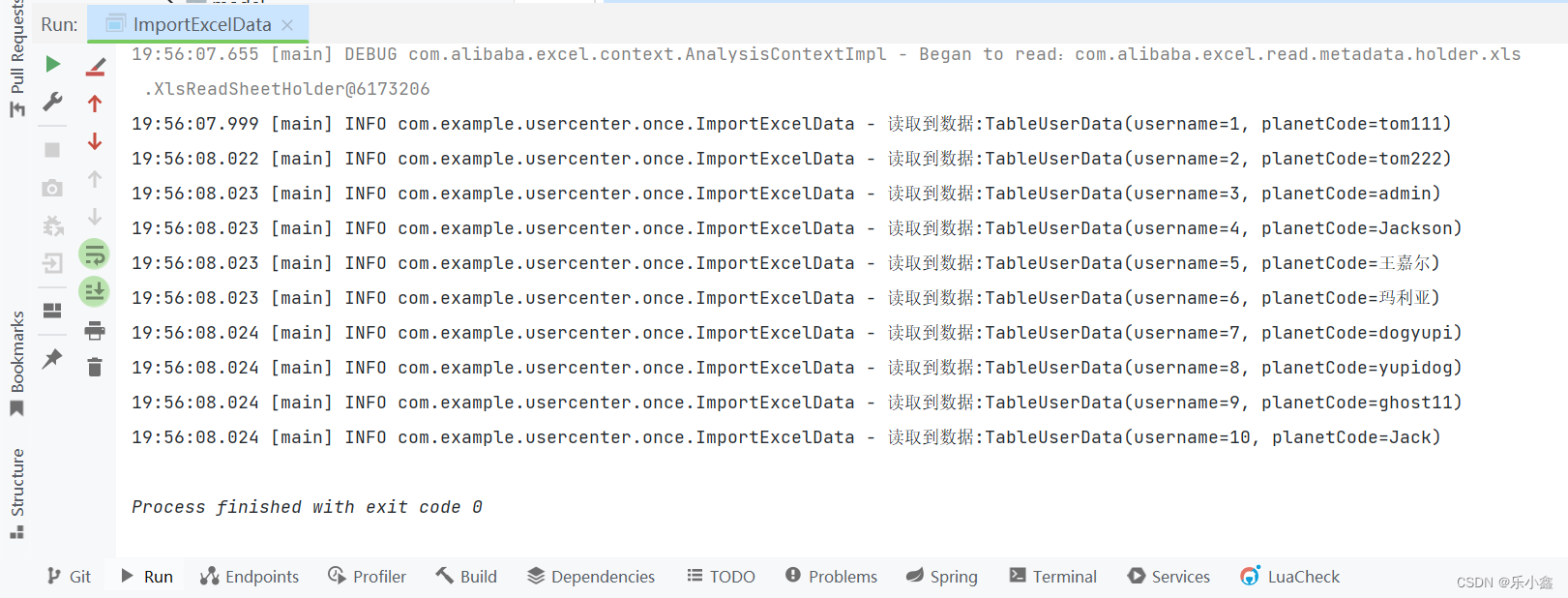

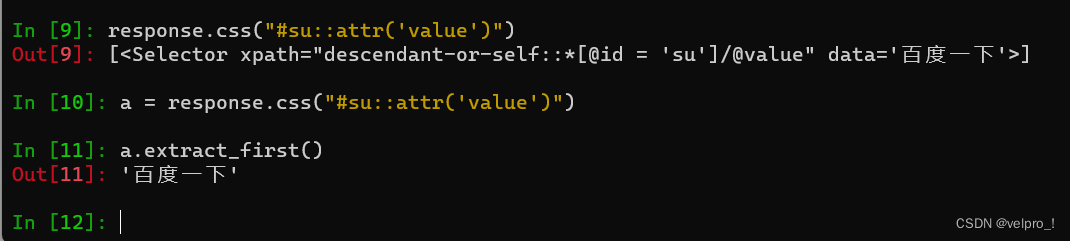

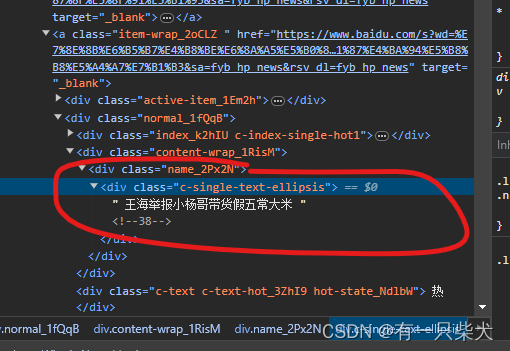

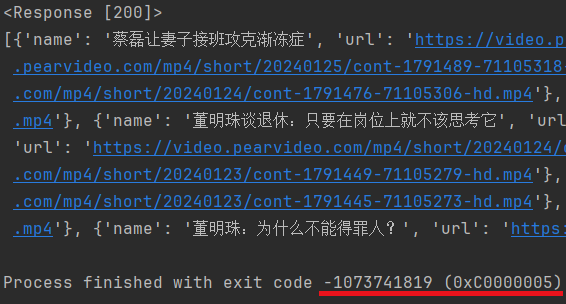

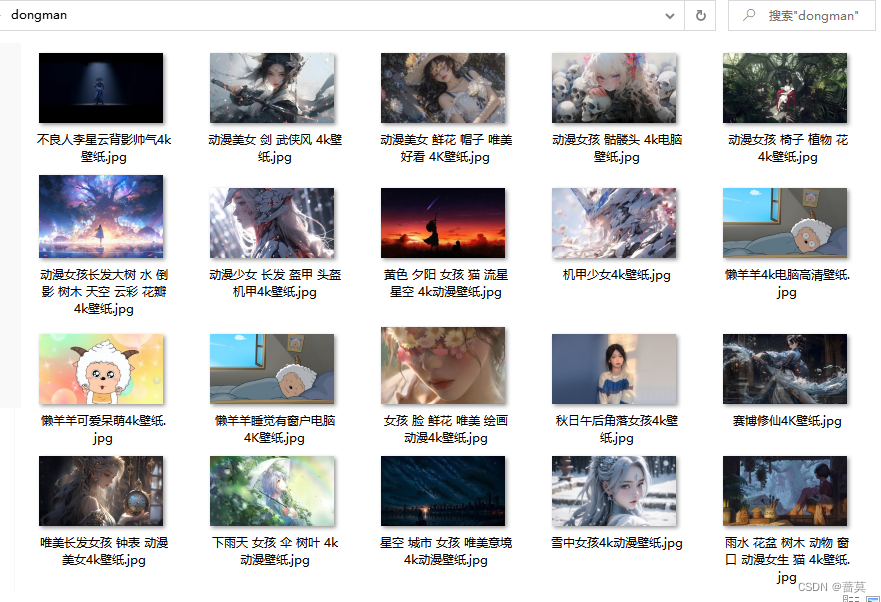

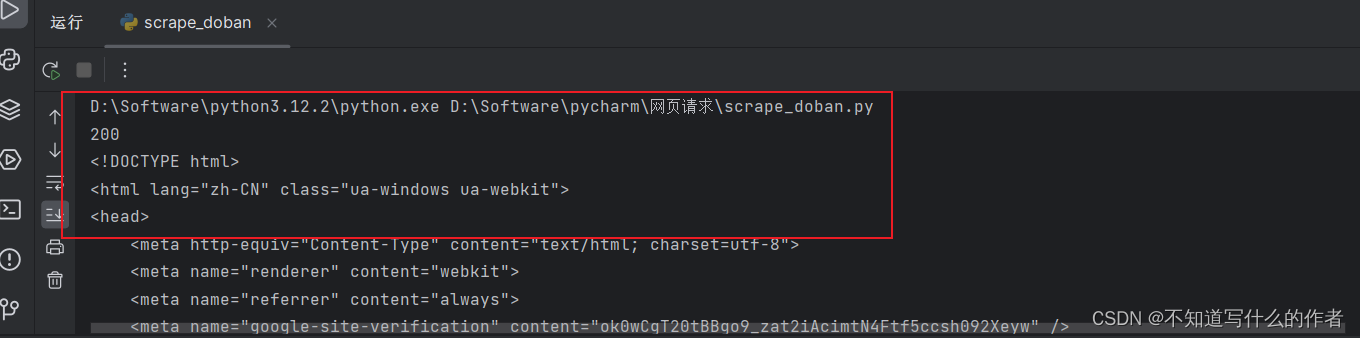

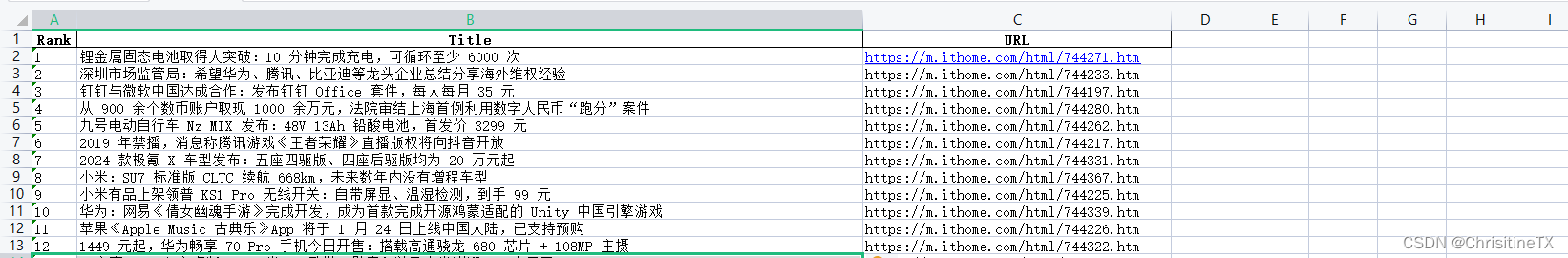

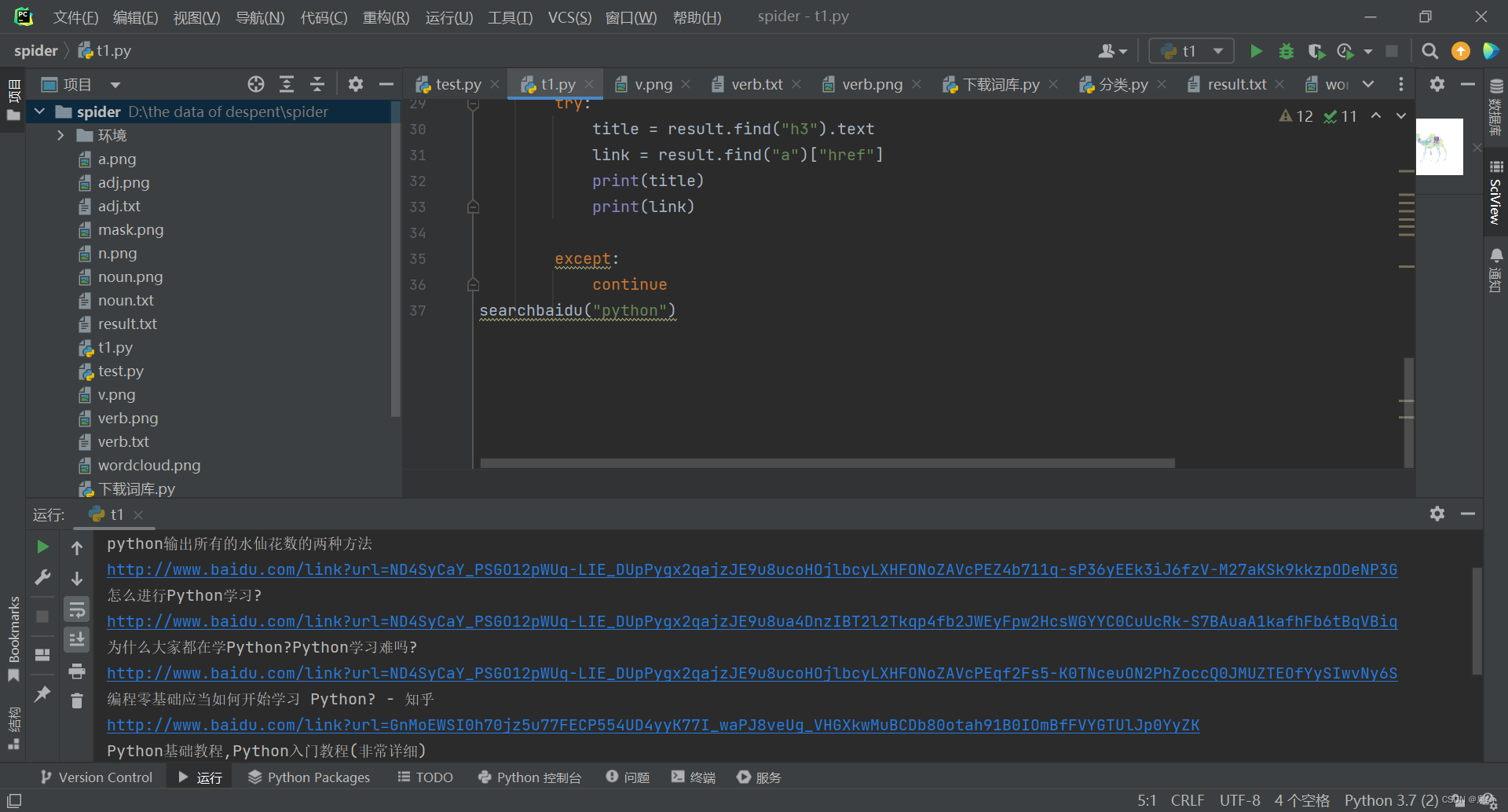

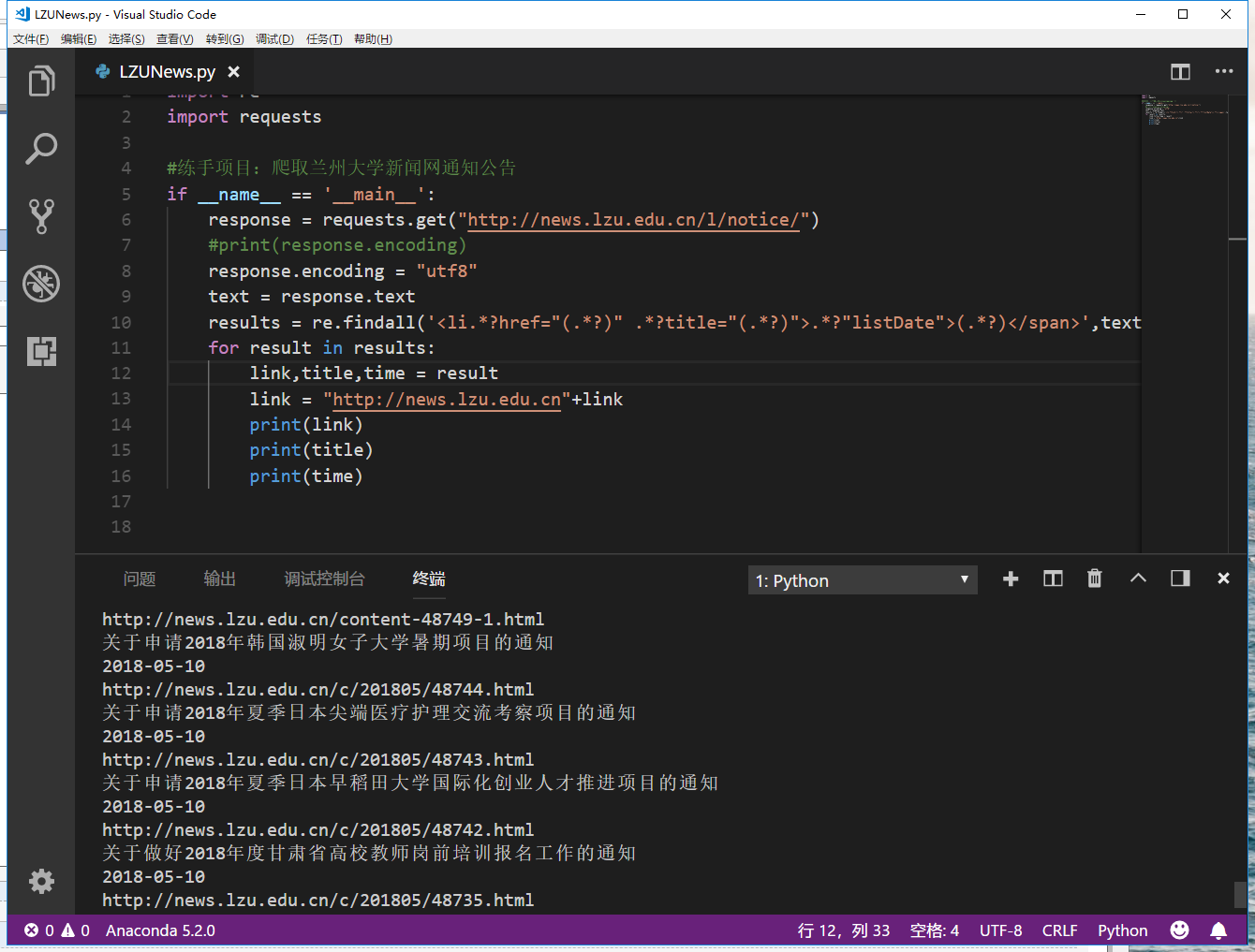

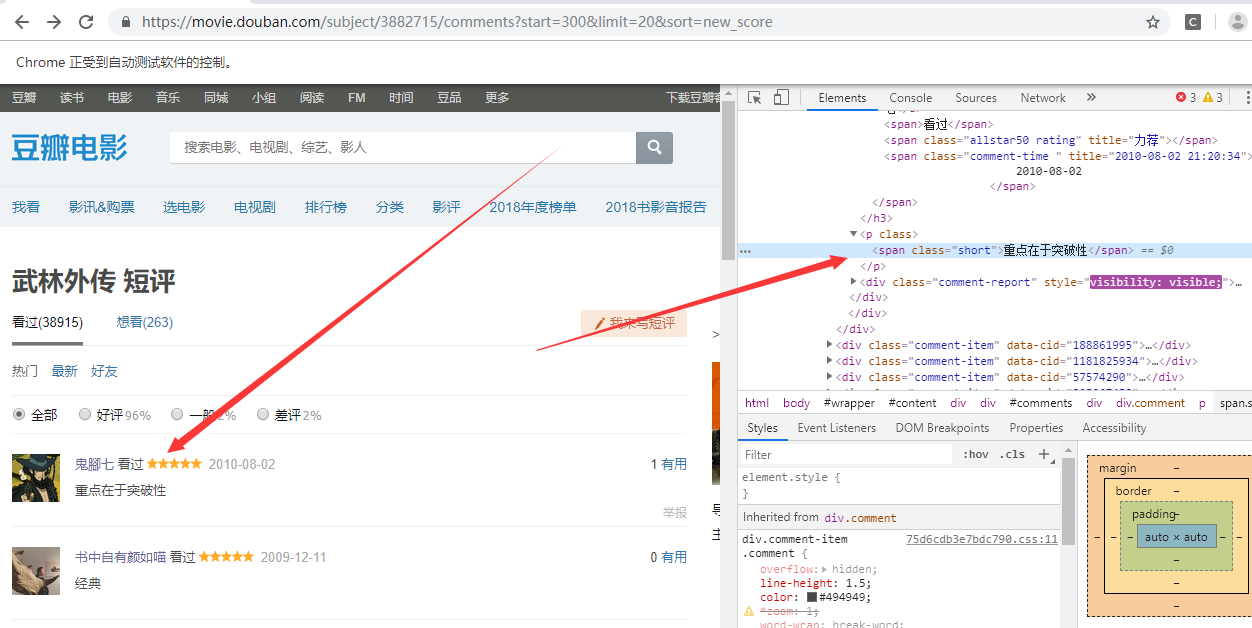

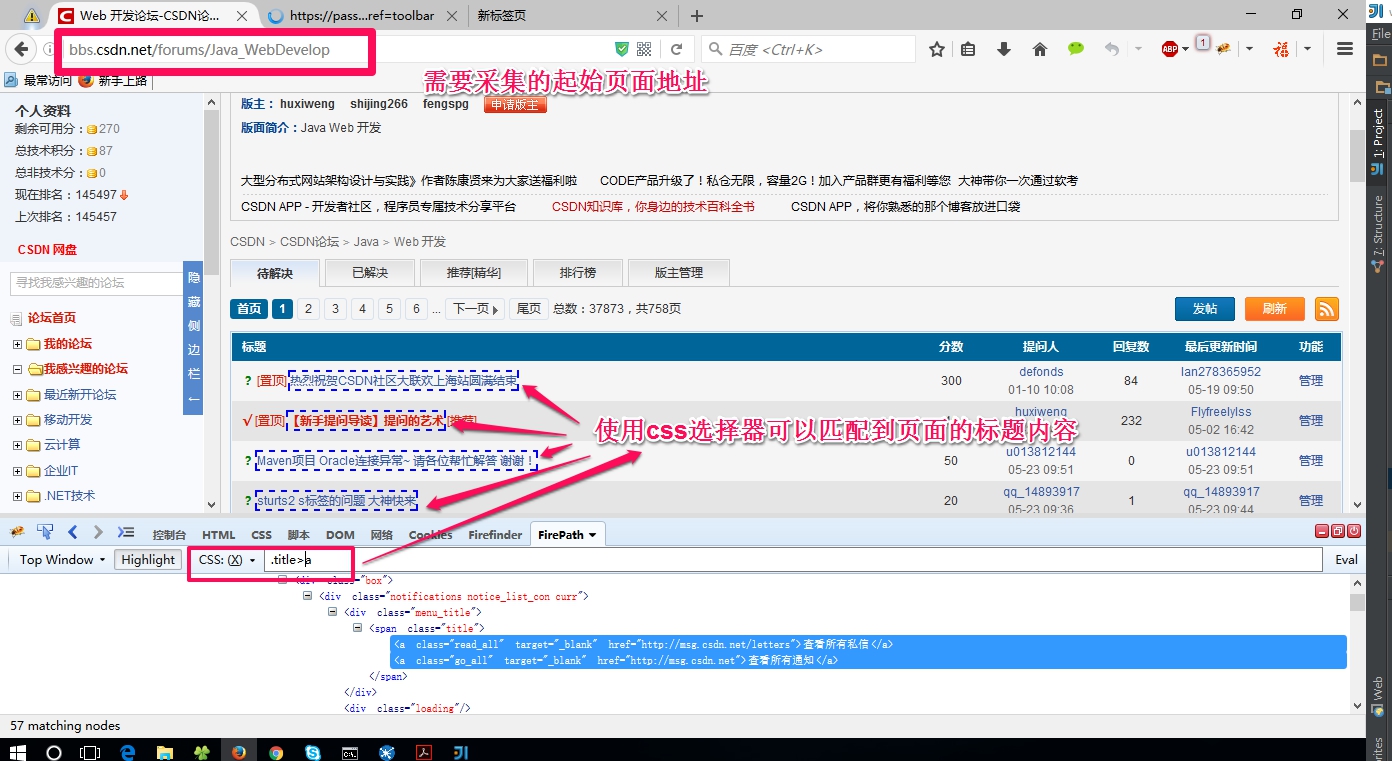

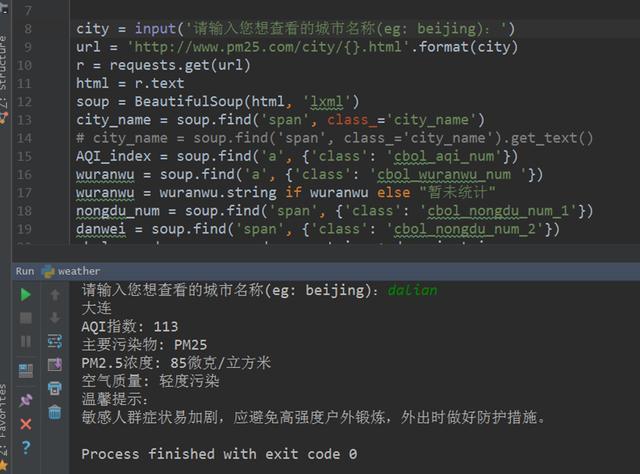

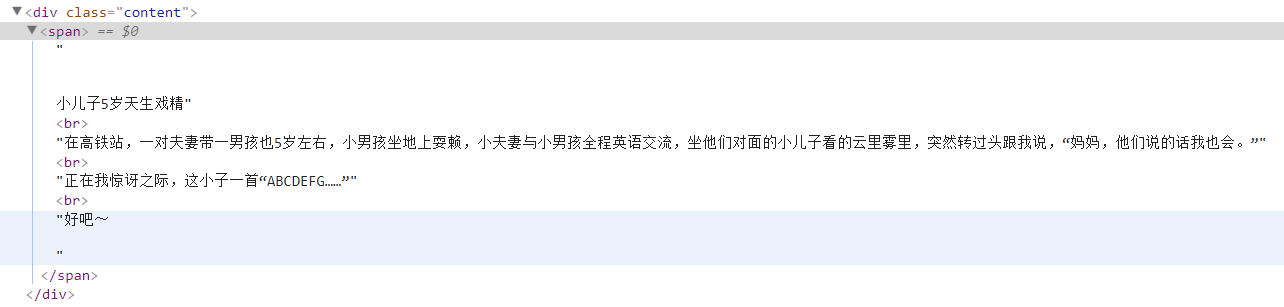

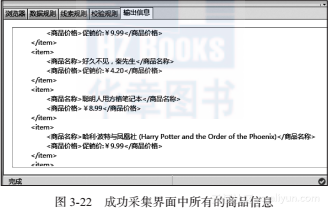

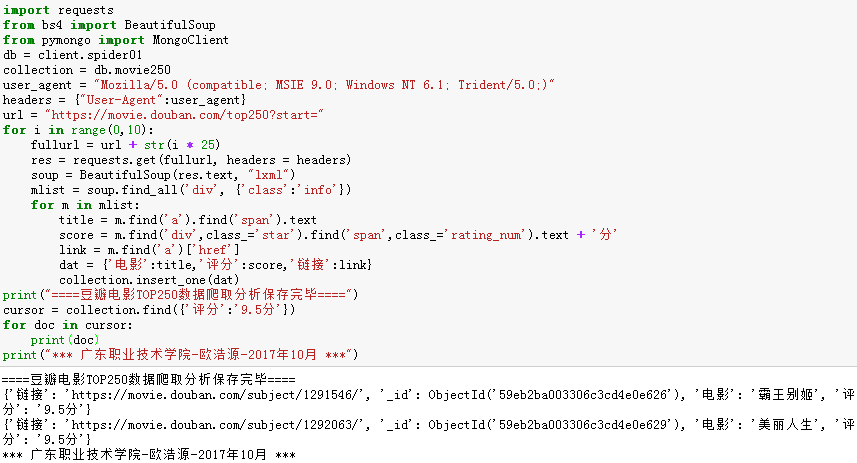

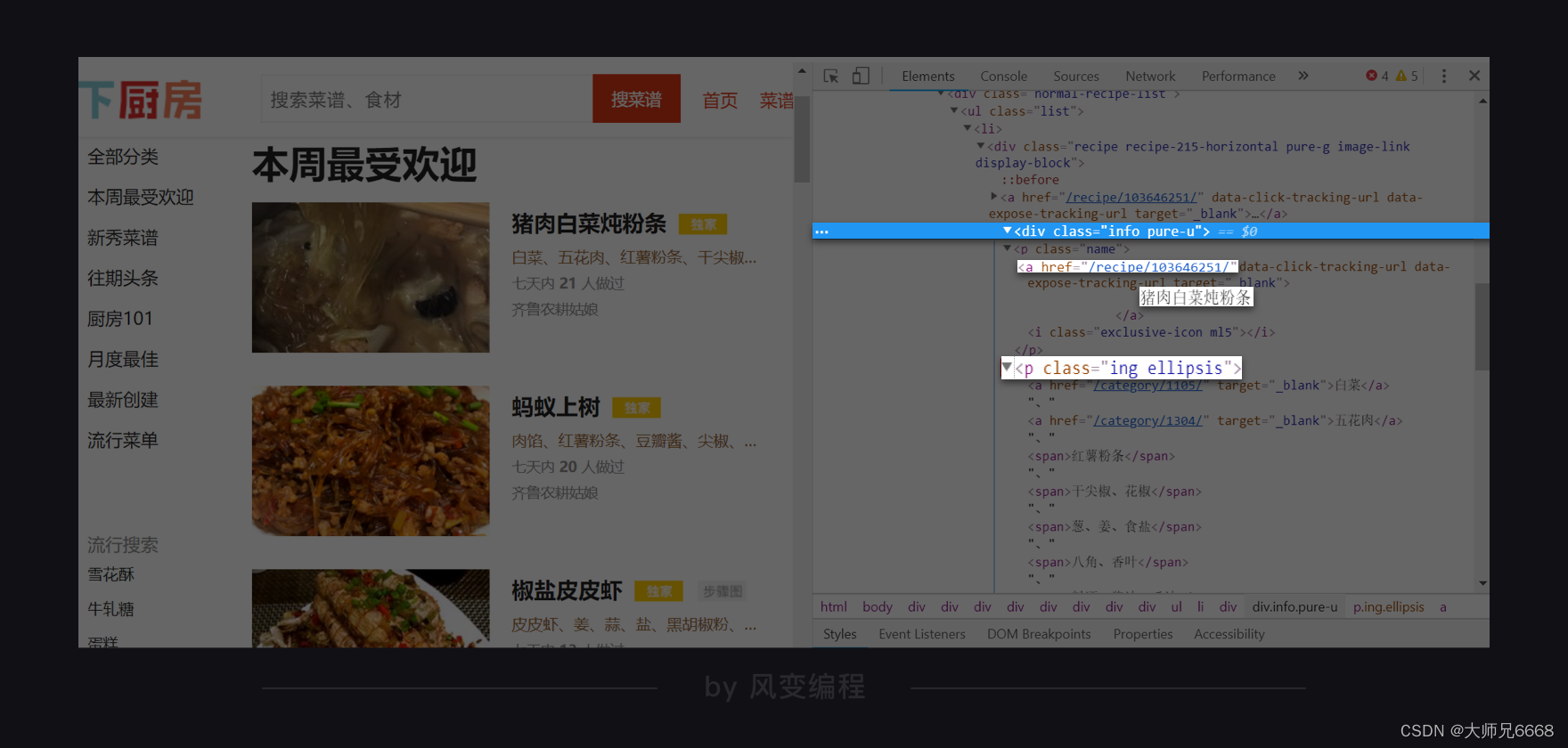

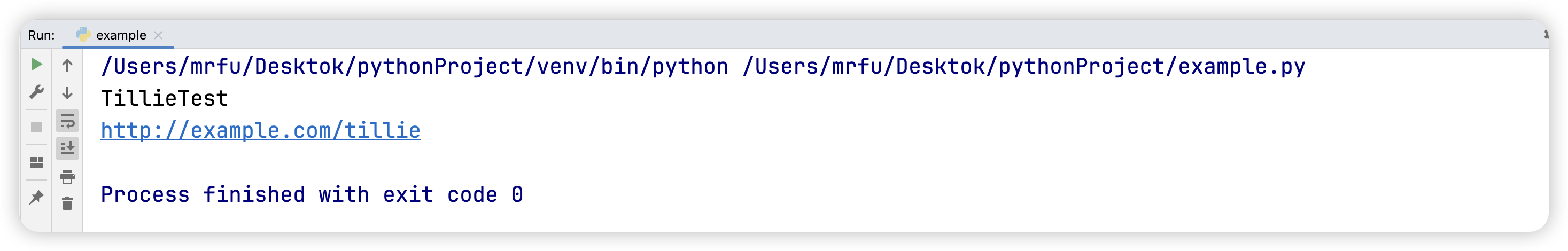

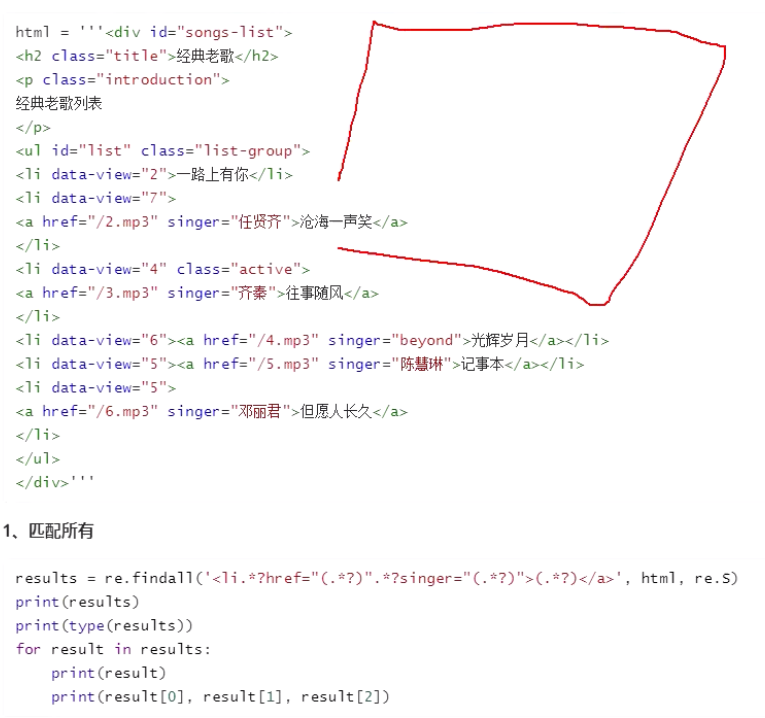

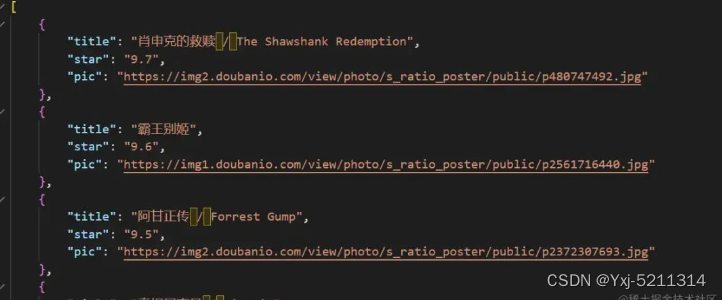

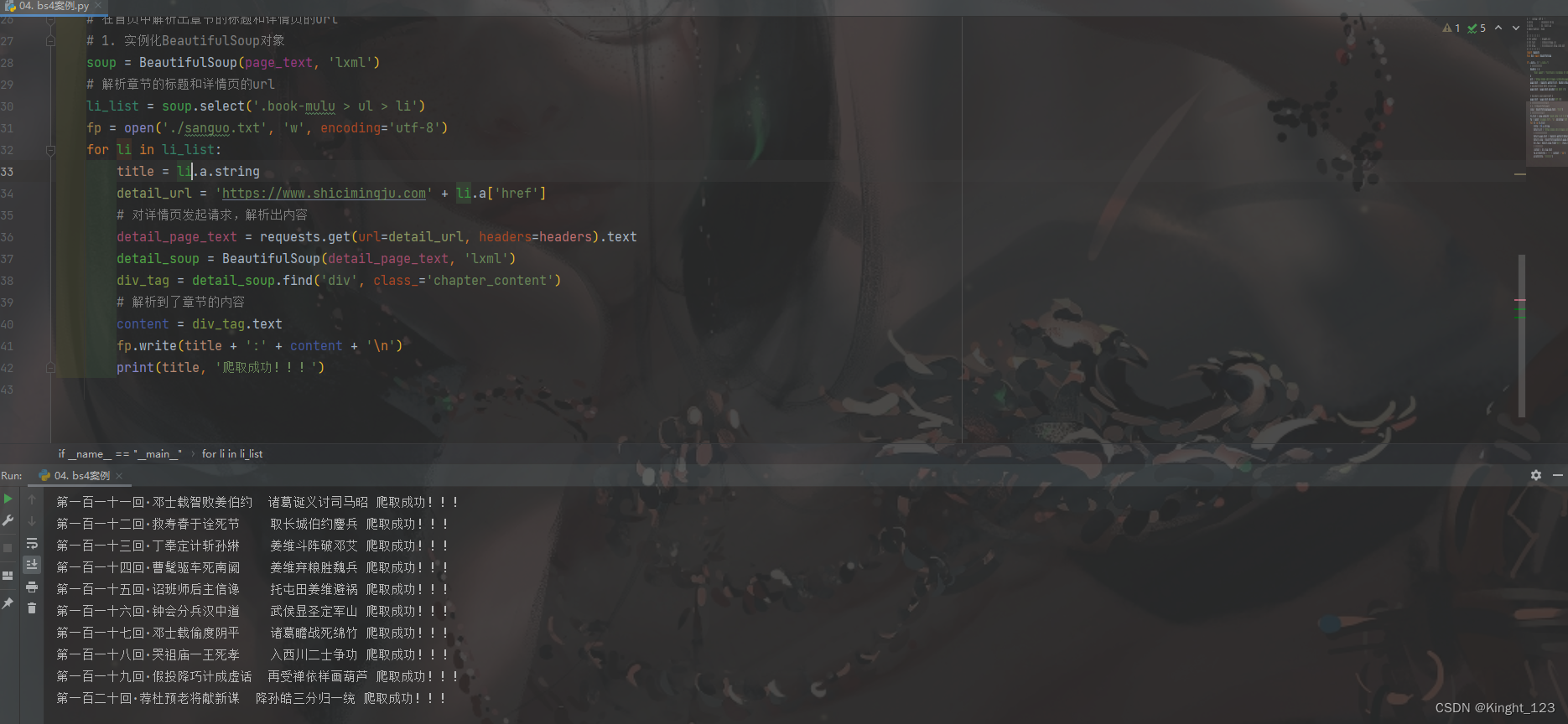

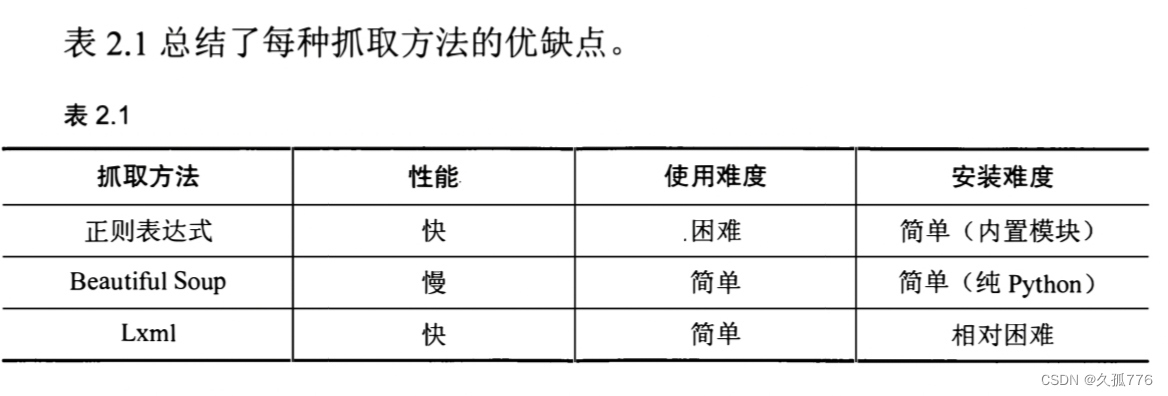

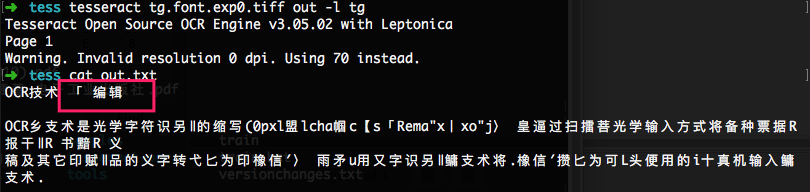

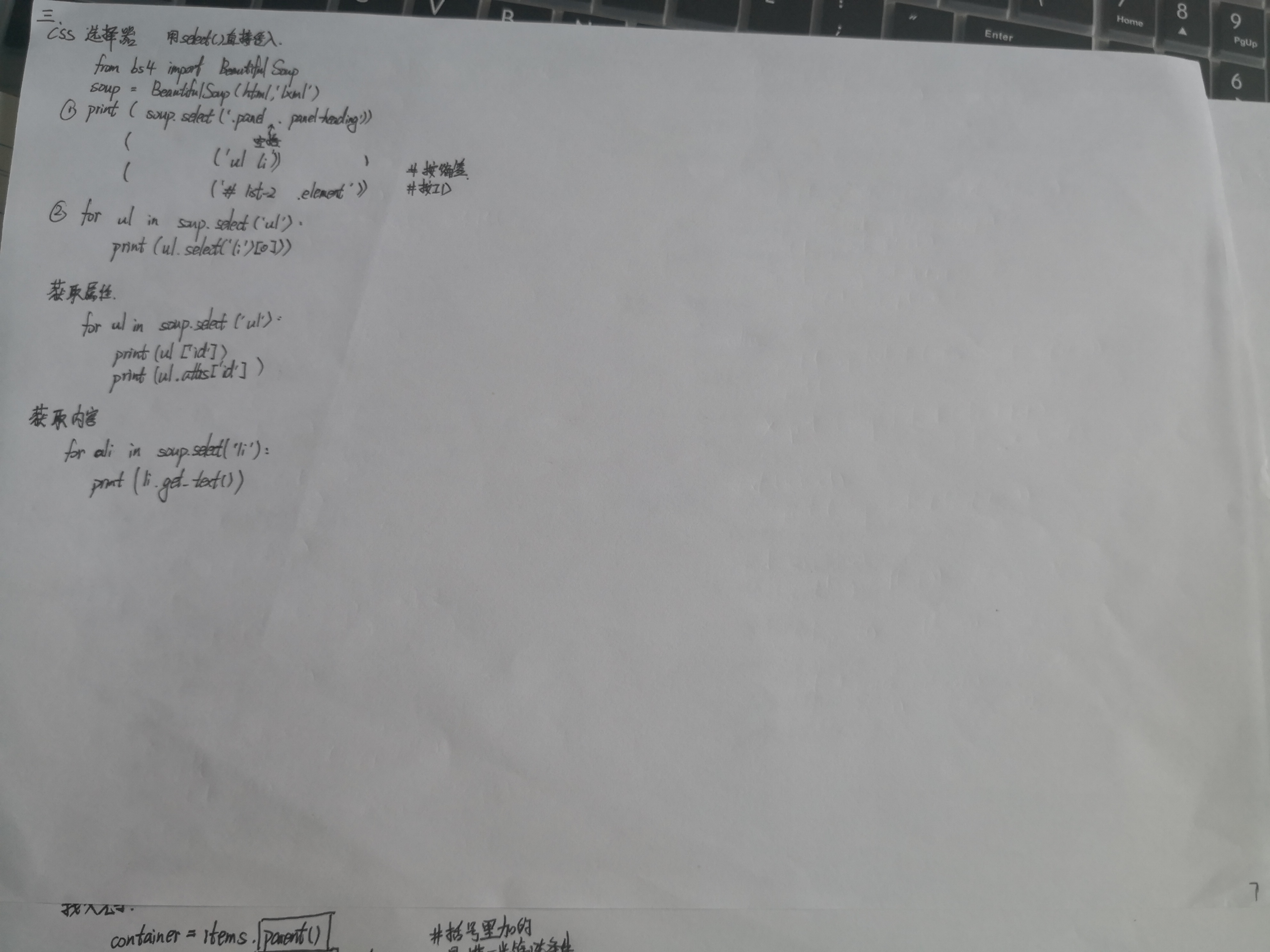

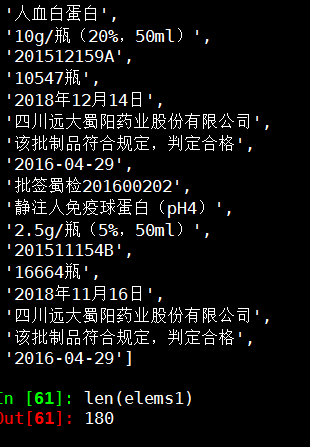

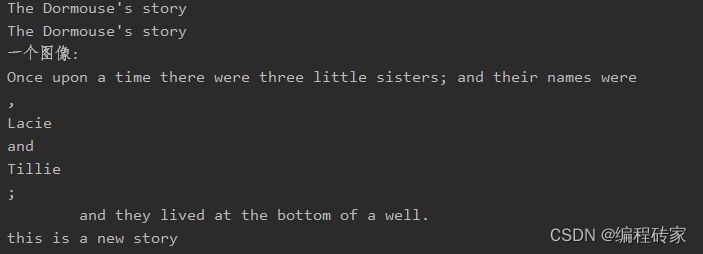

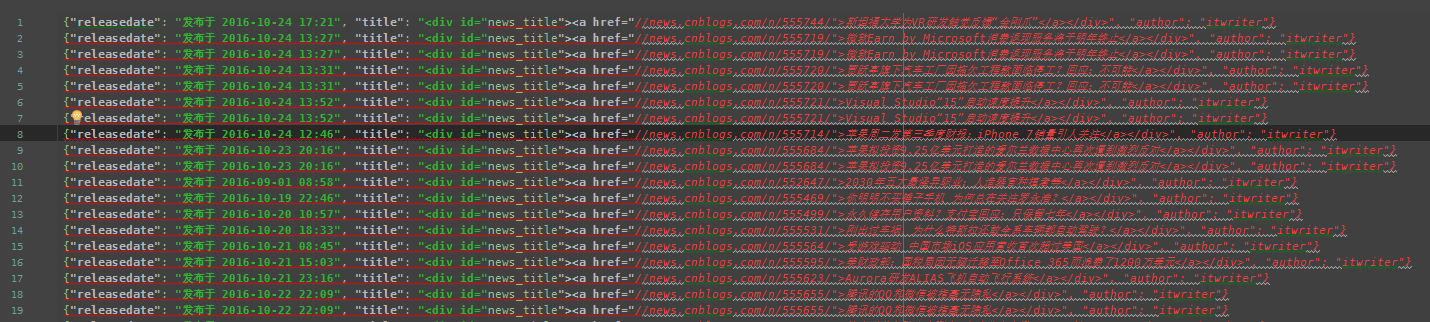

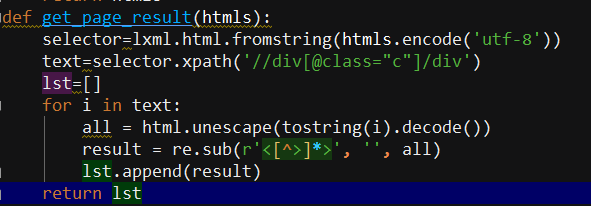

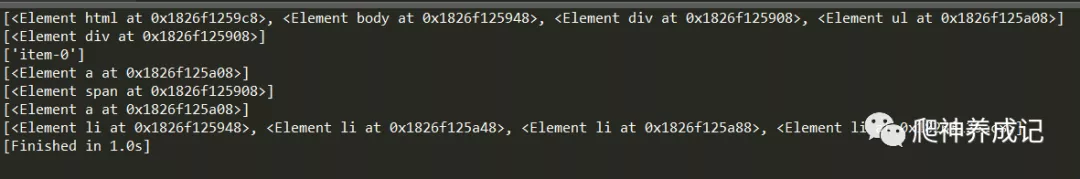

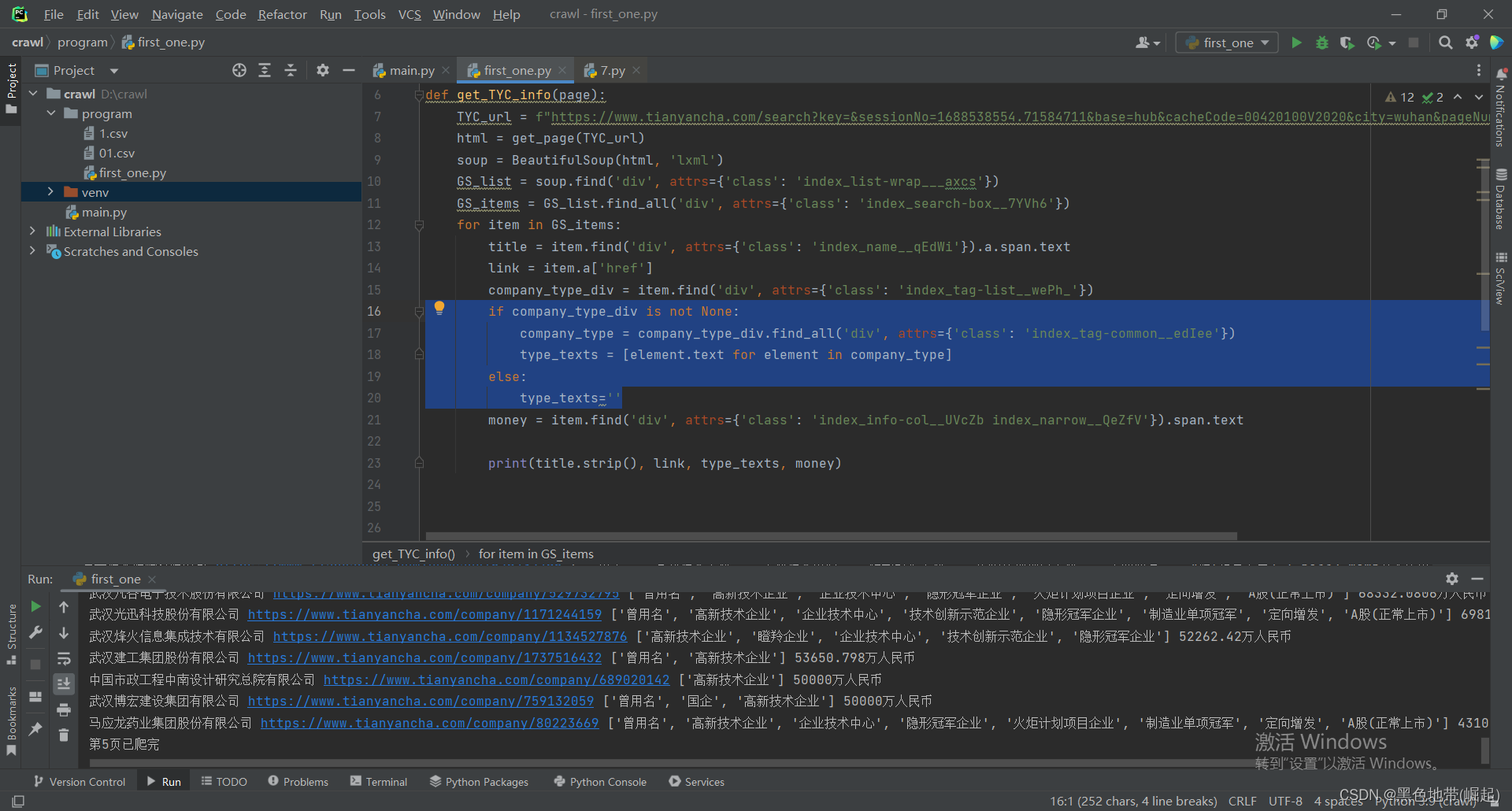

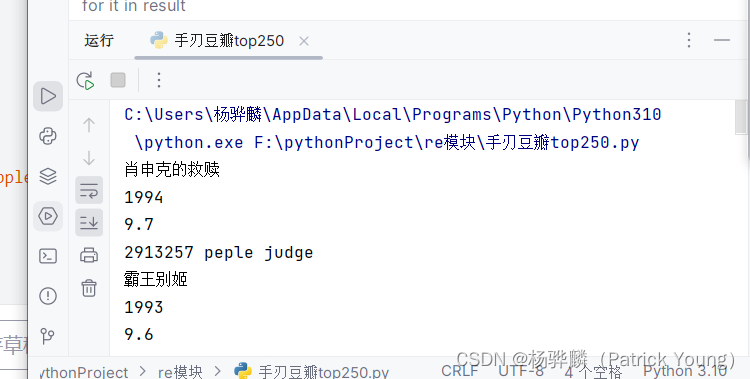

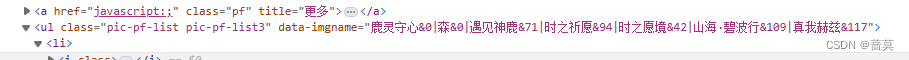

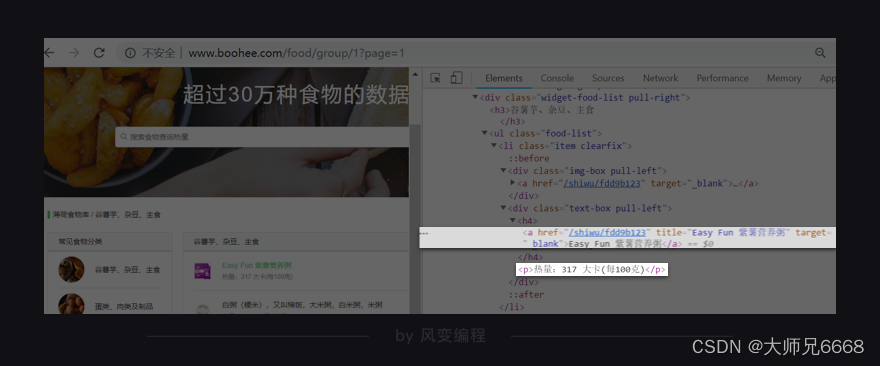

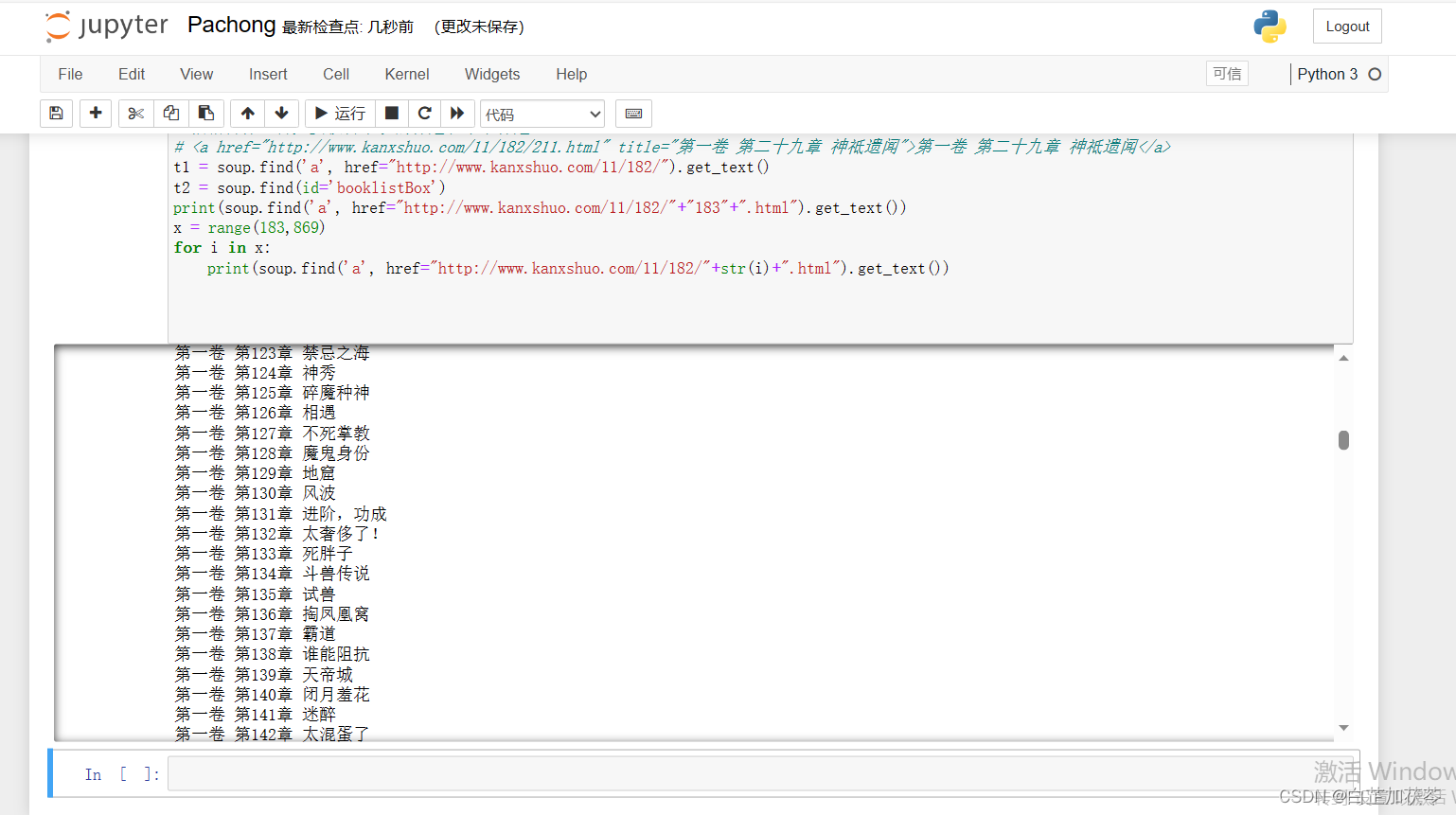

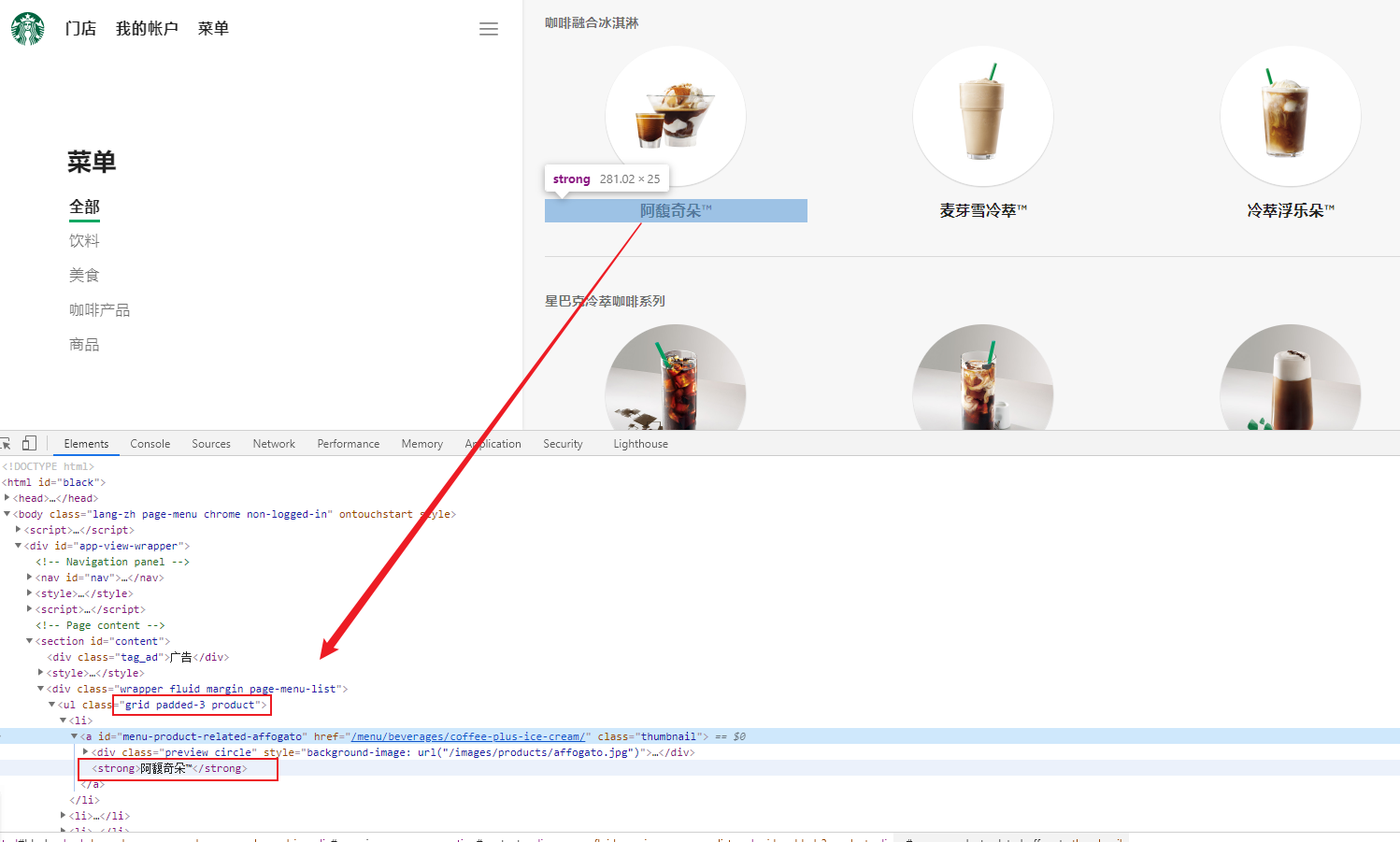

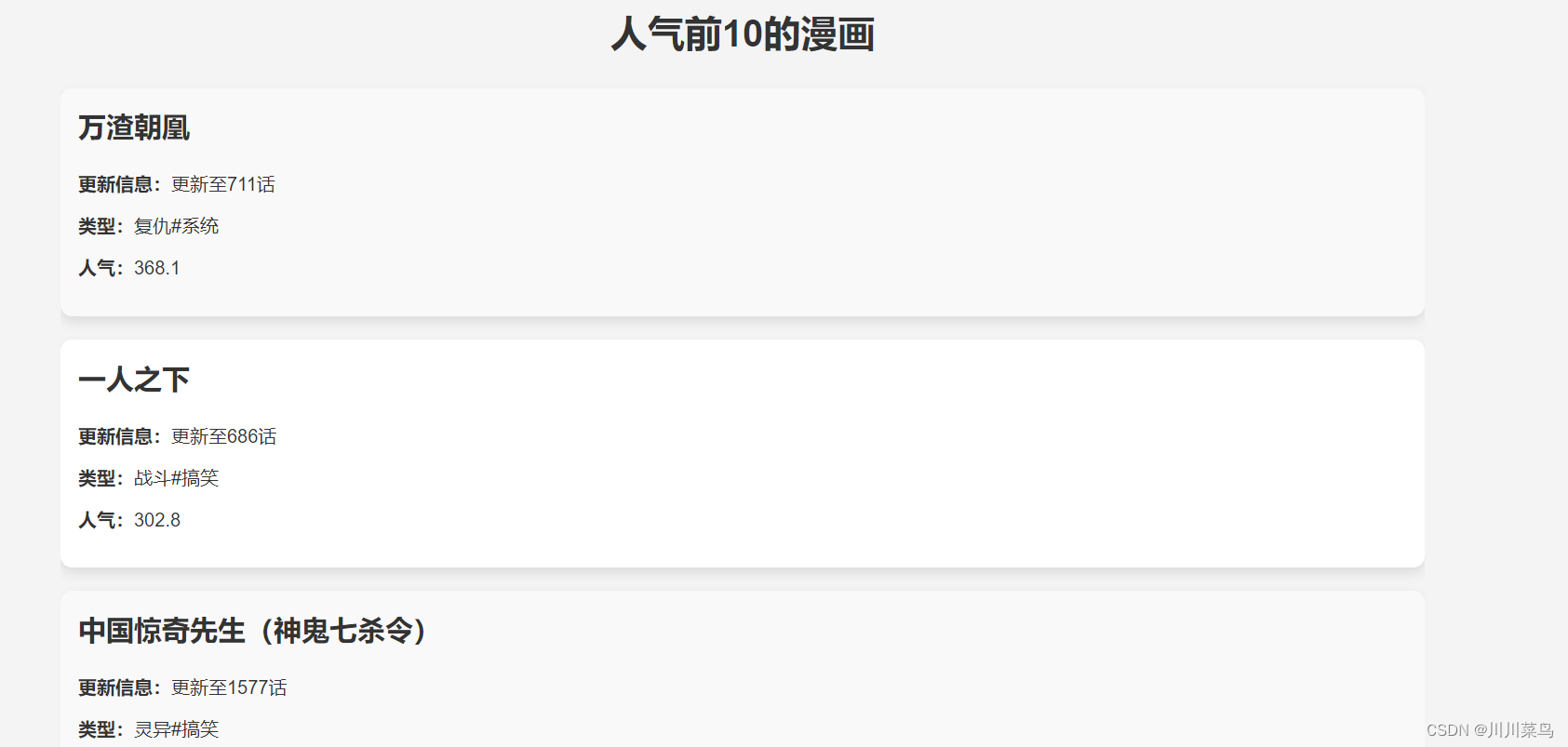

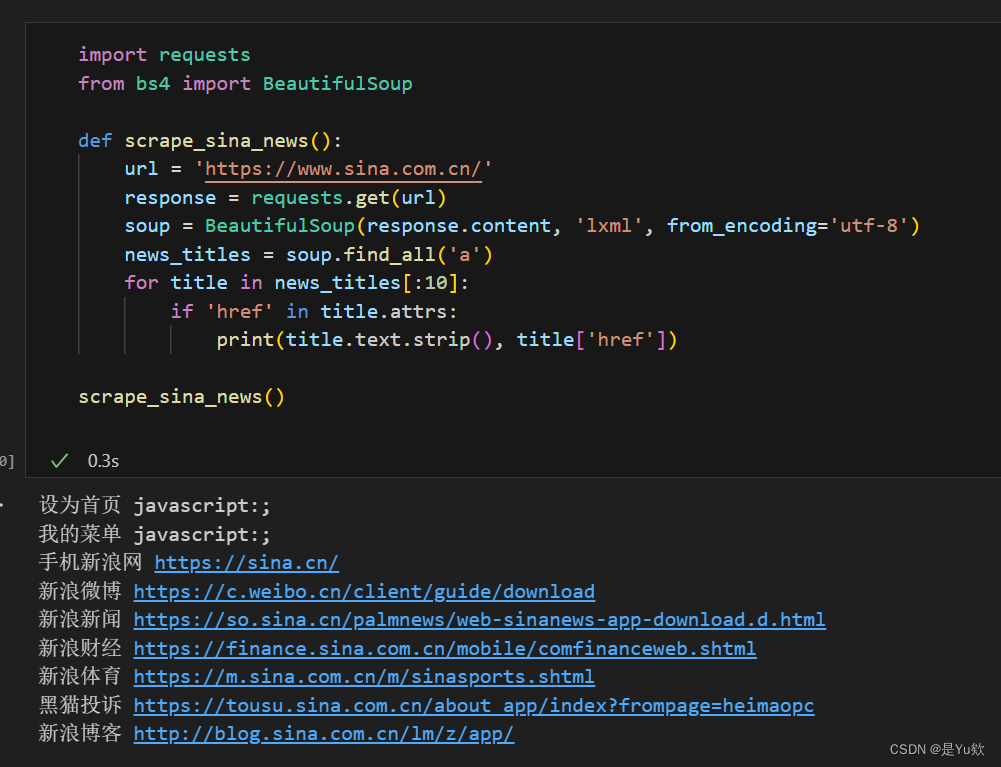

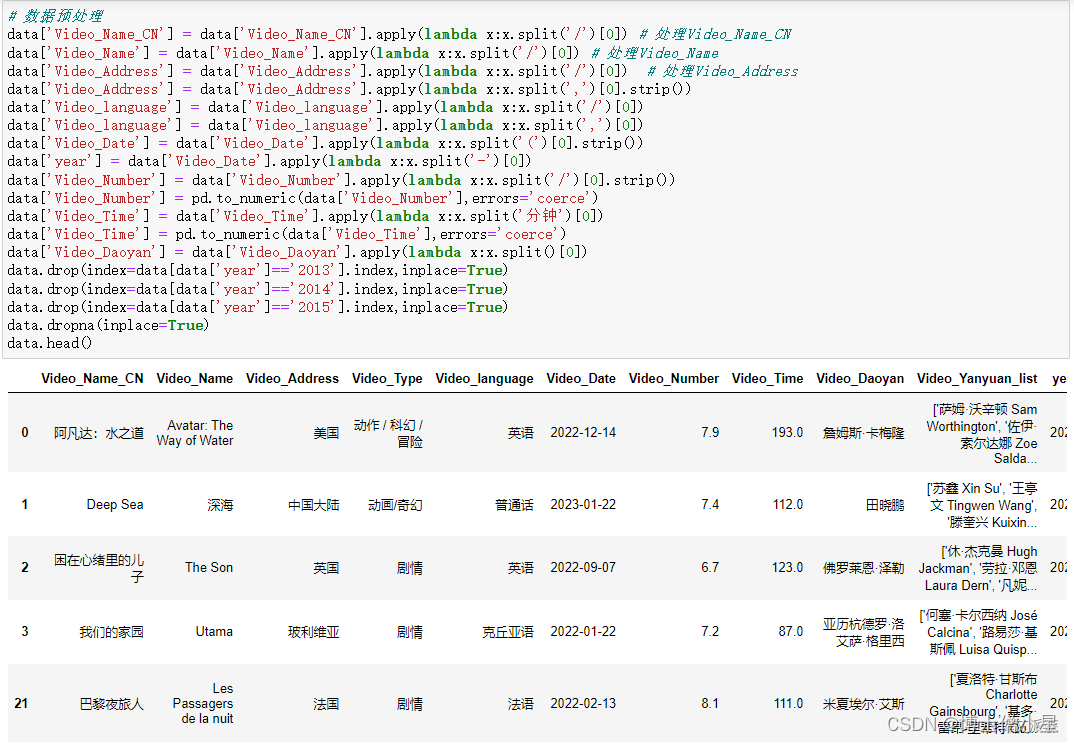

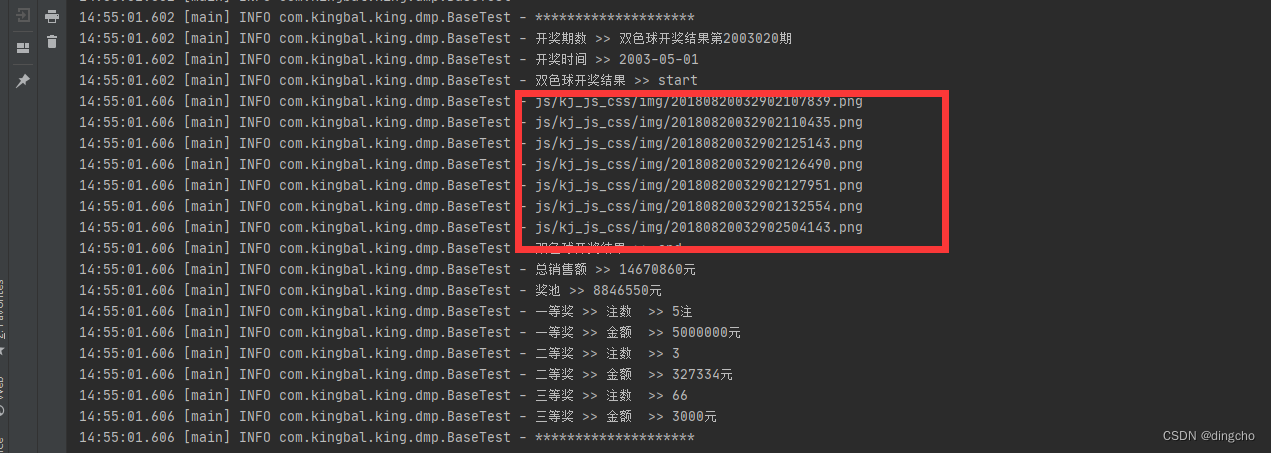

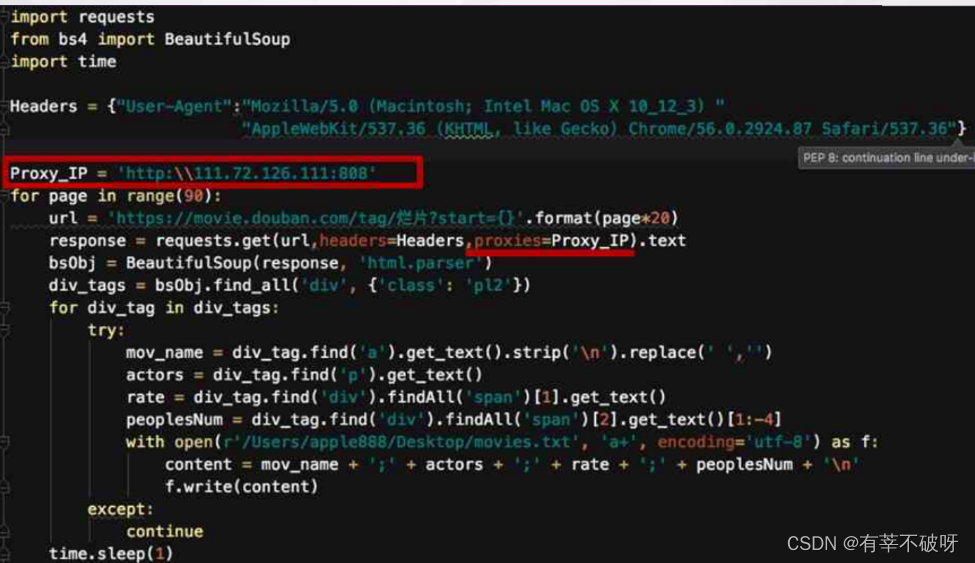

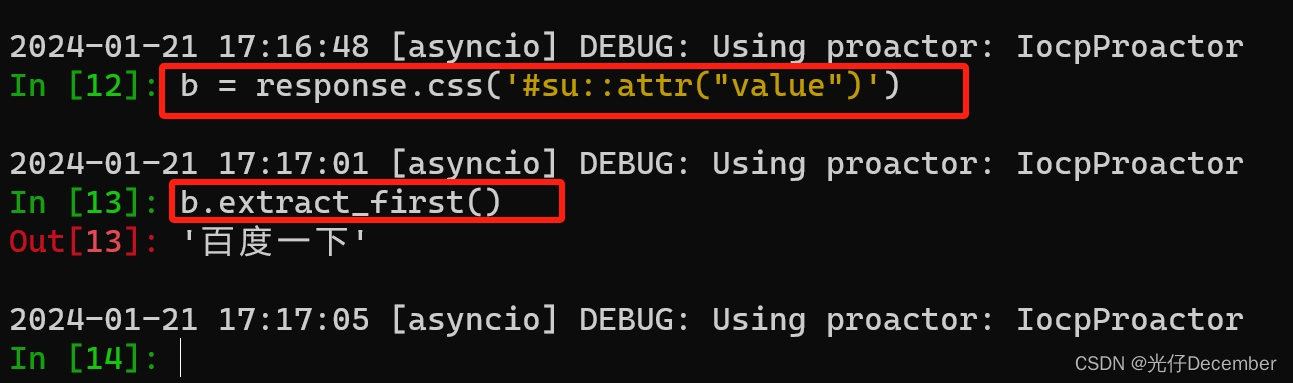

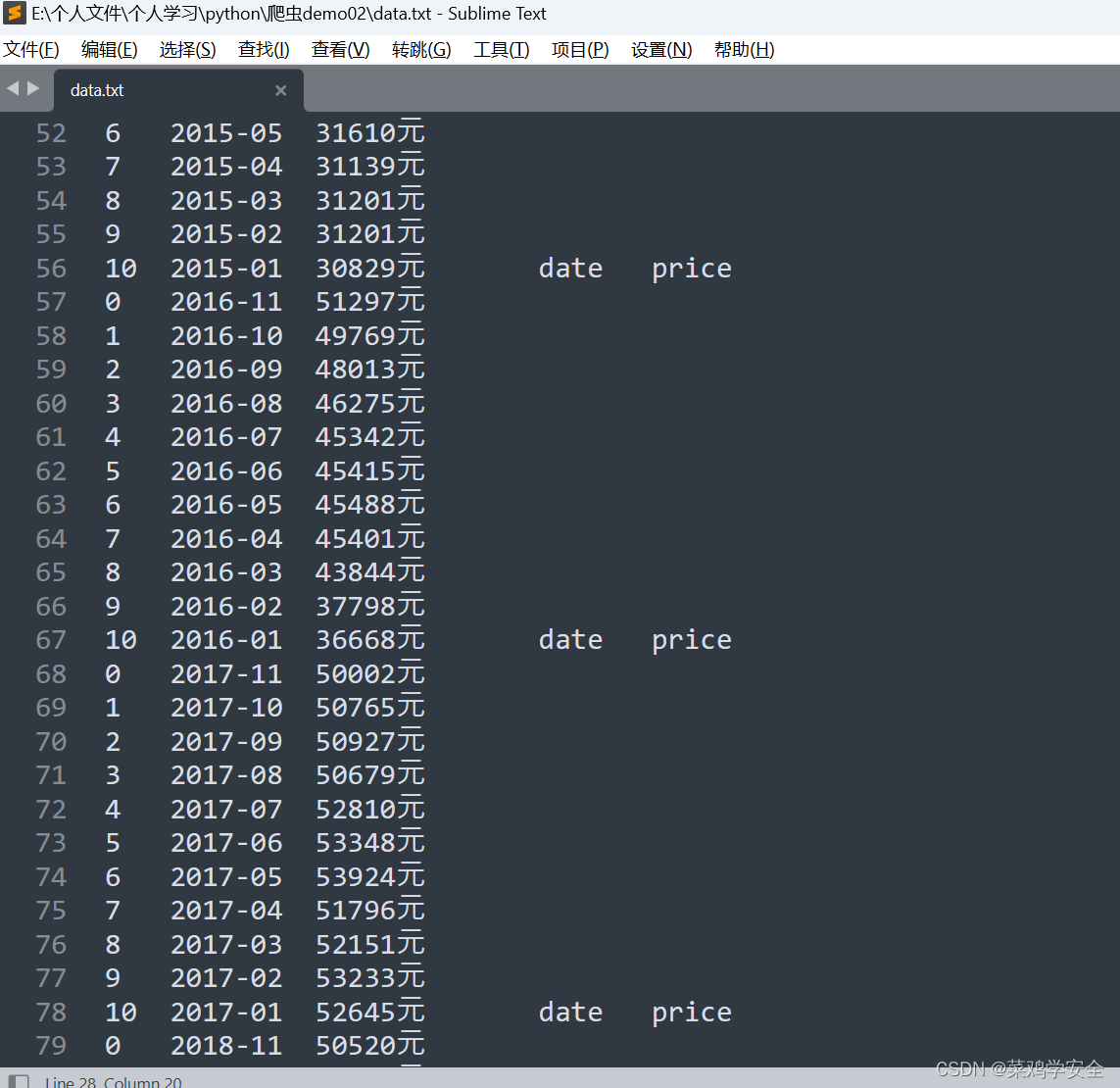

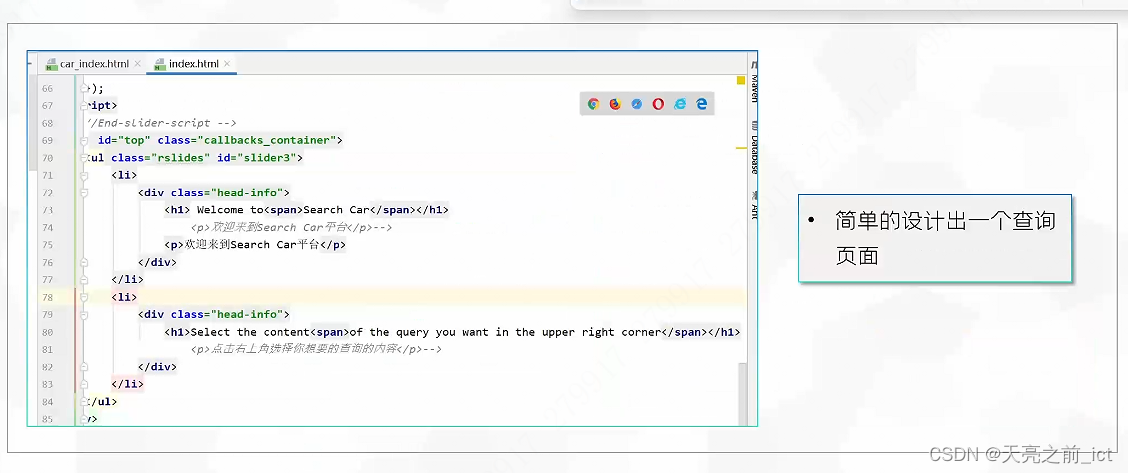

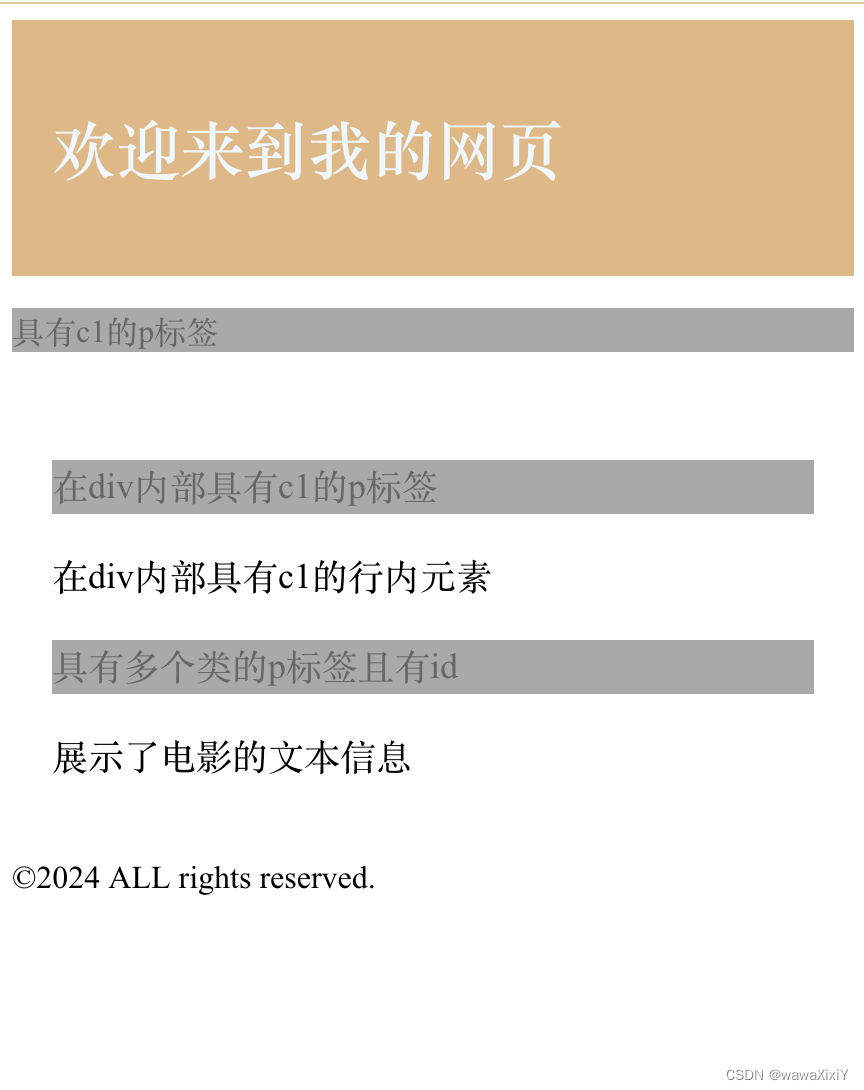

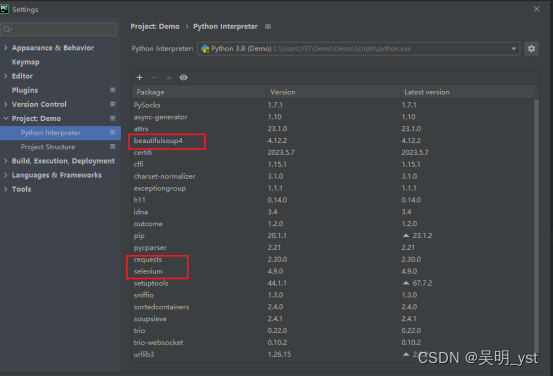

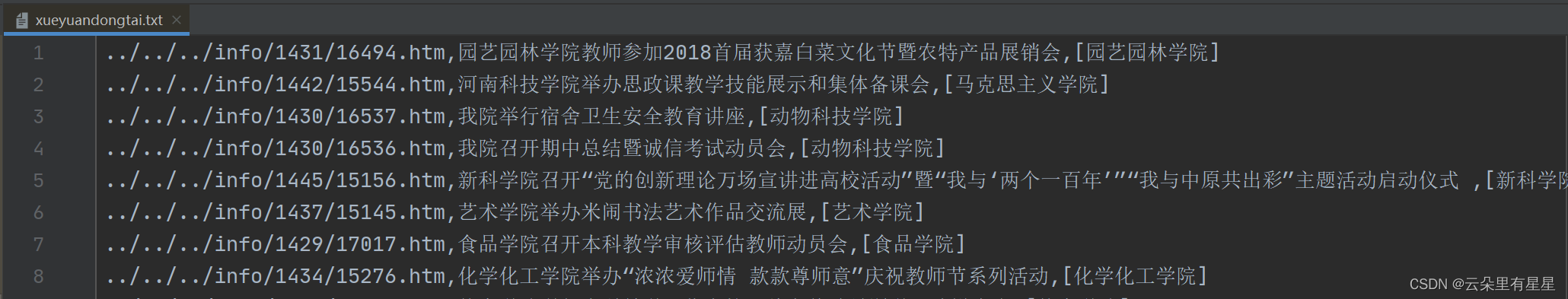

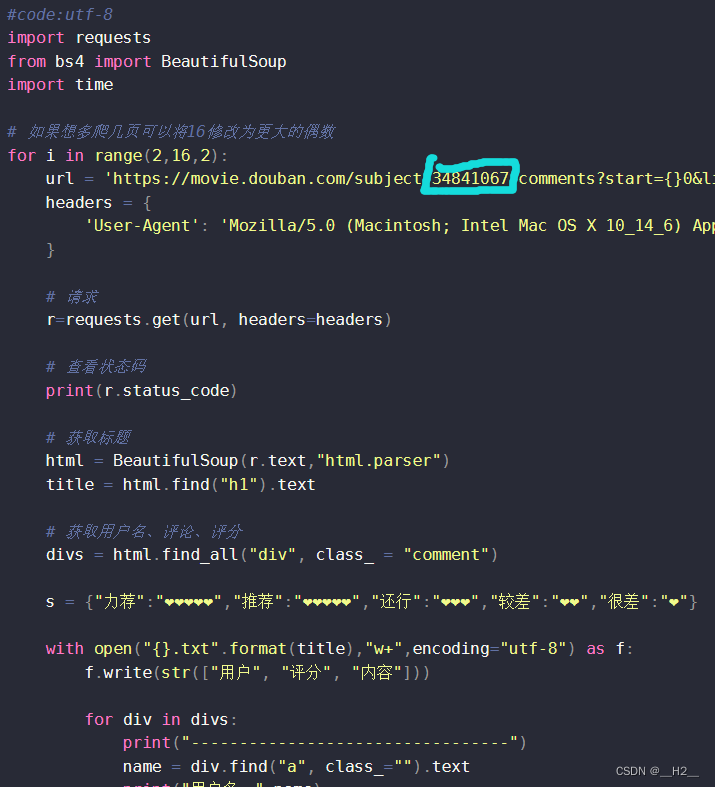

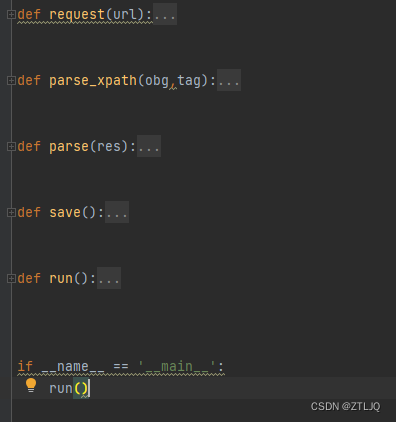

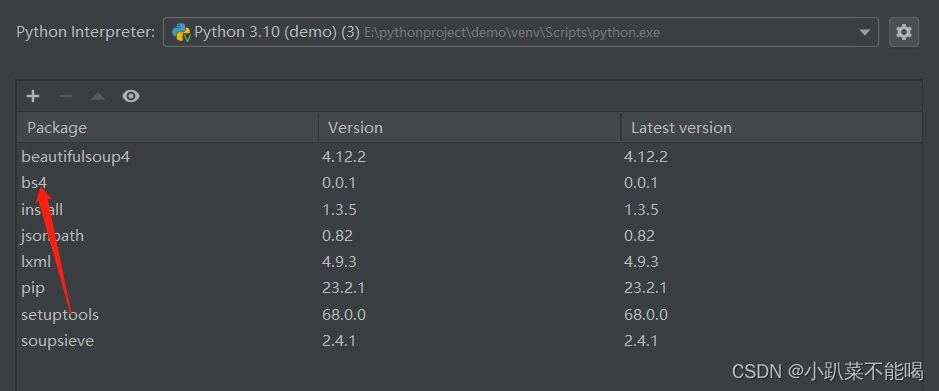

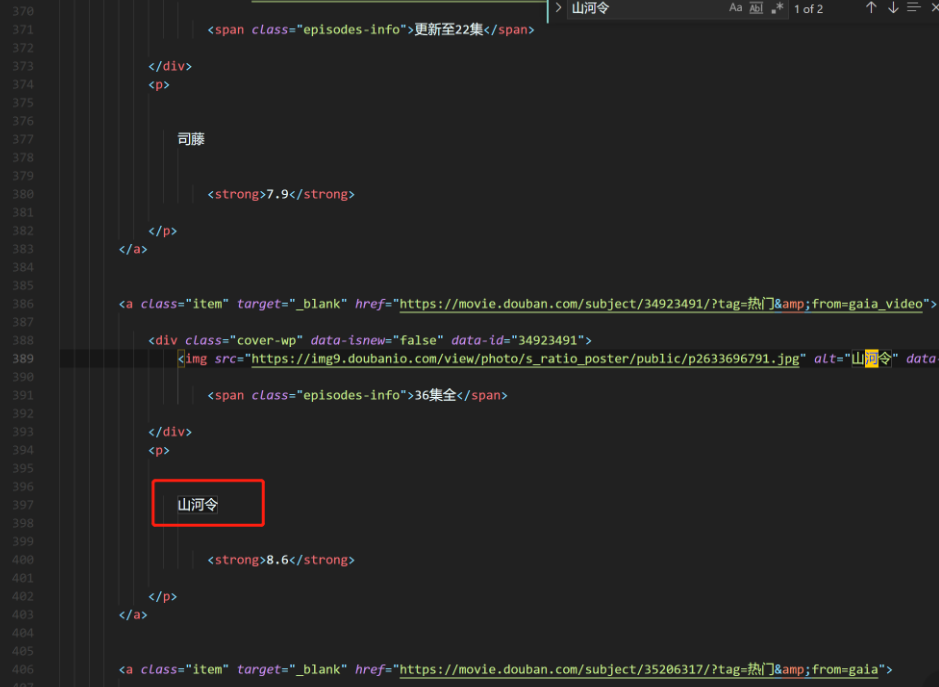

Beautifulsoup解析库使用实际案例

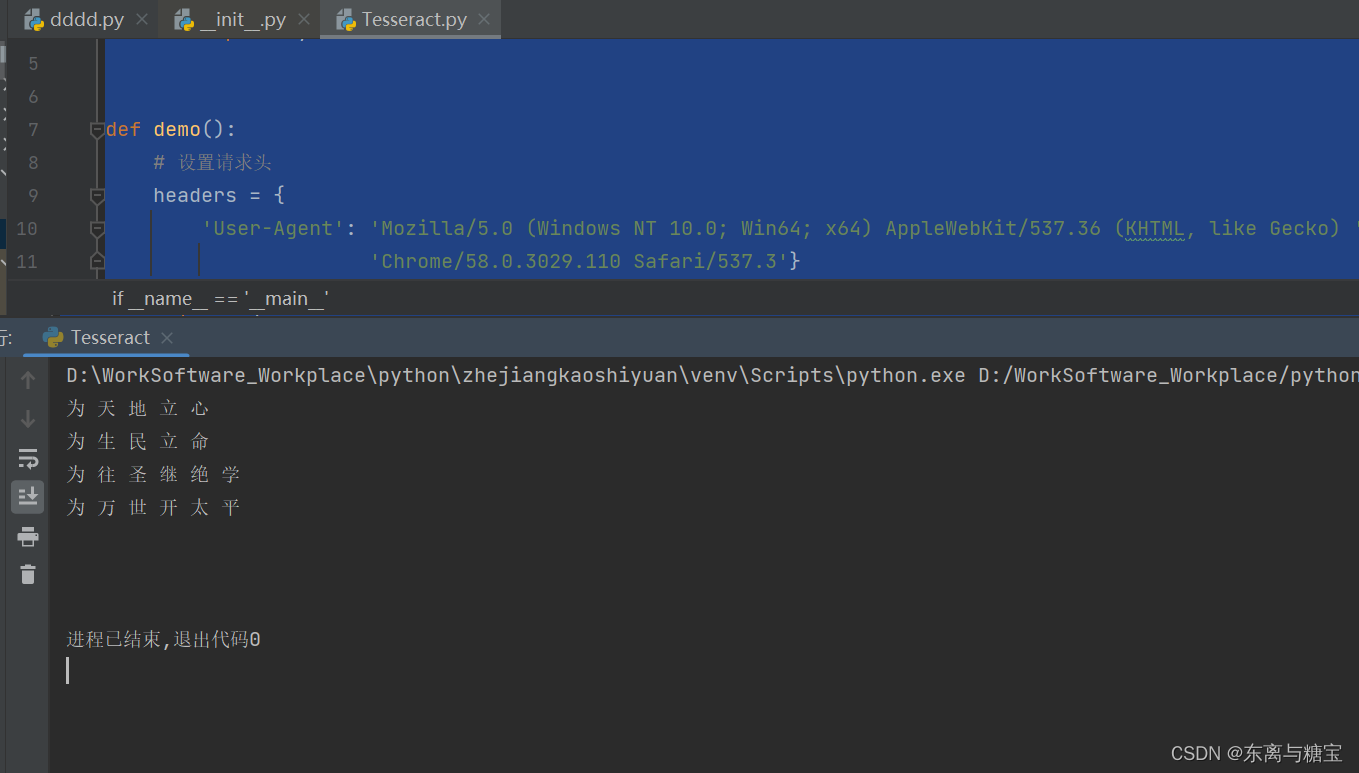

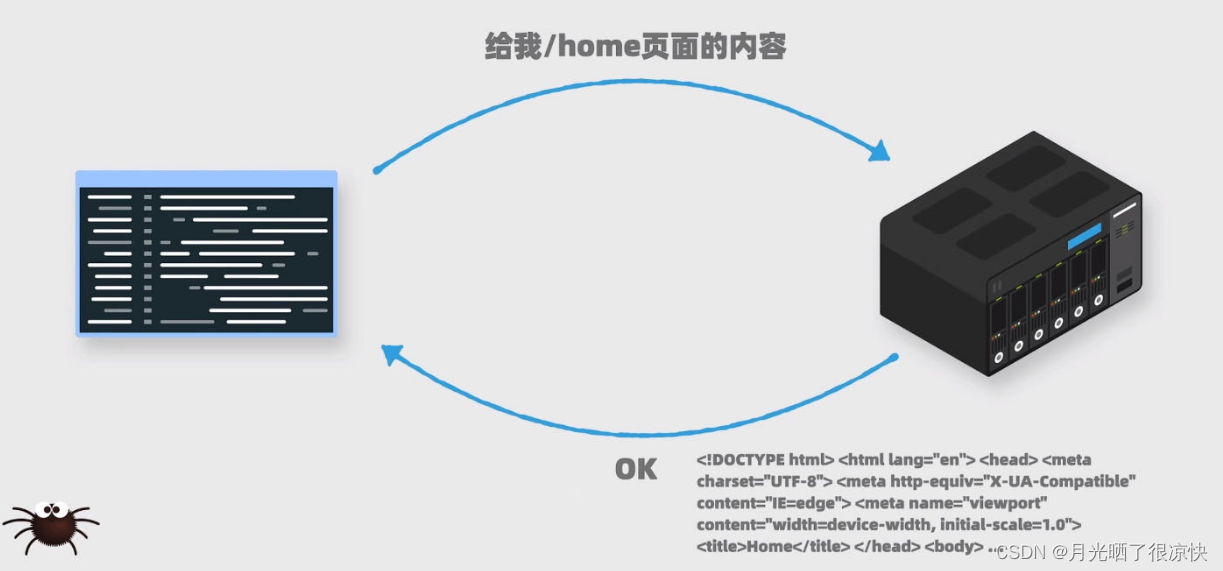

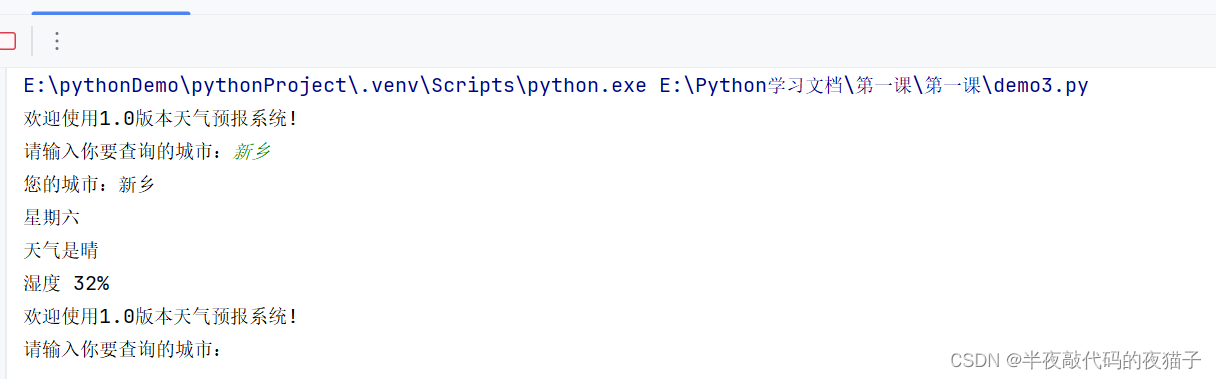

爬虫,是学习Python的一个有用的分支,互联网时代,信息浩瀚如海,如果能够便捷的获取有用的信息,我们便有可能领先一步,而爬虫正是这样的一个工具。之前的的文章中讲到了很多有关爬虫基础知识的使用࿰…

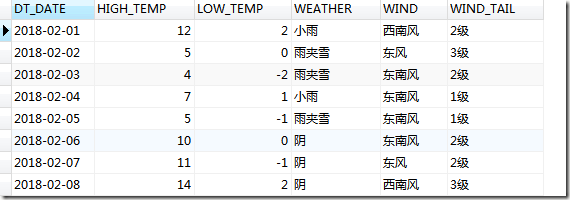

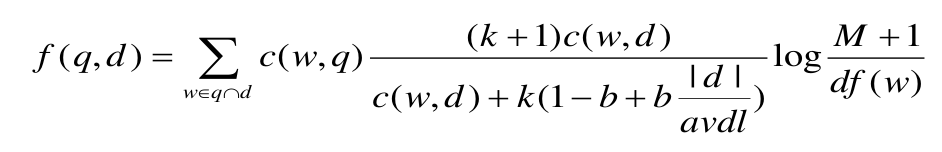

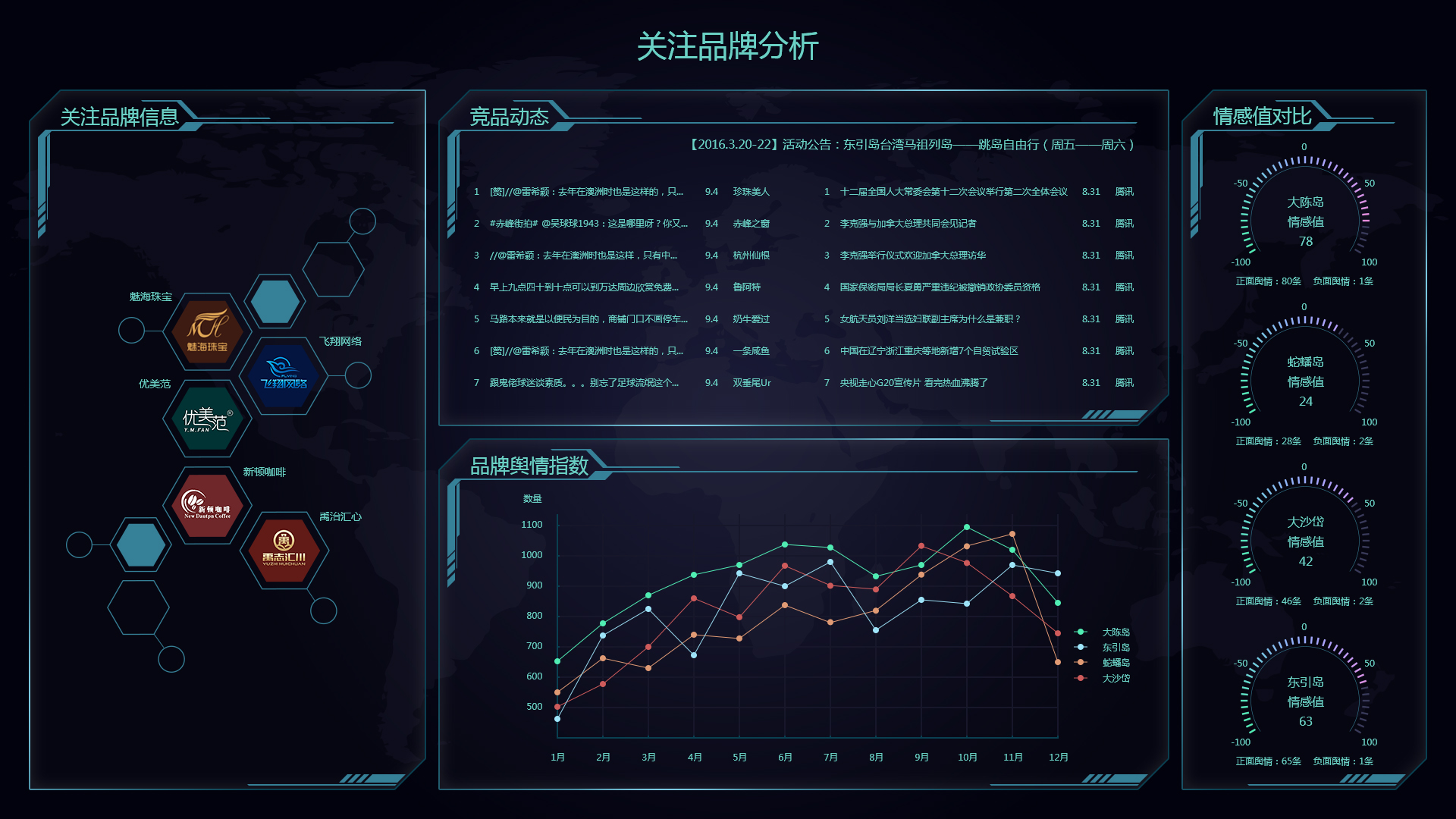

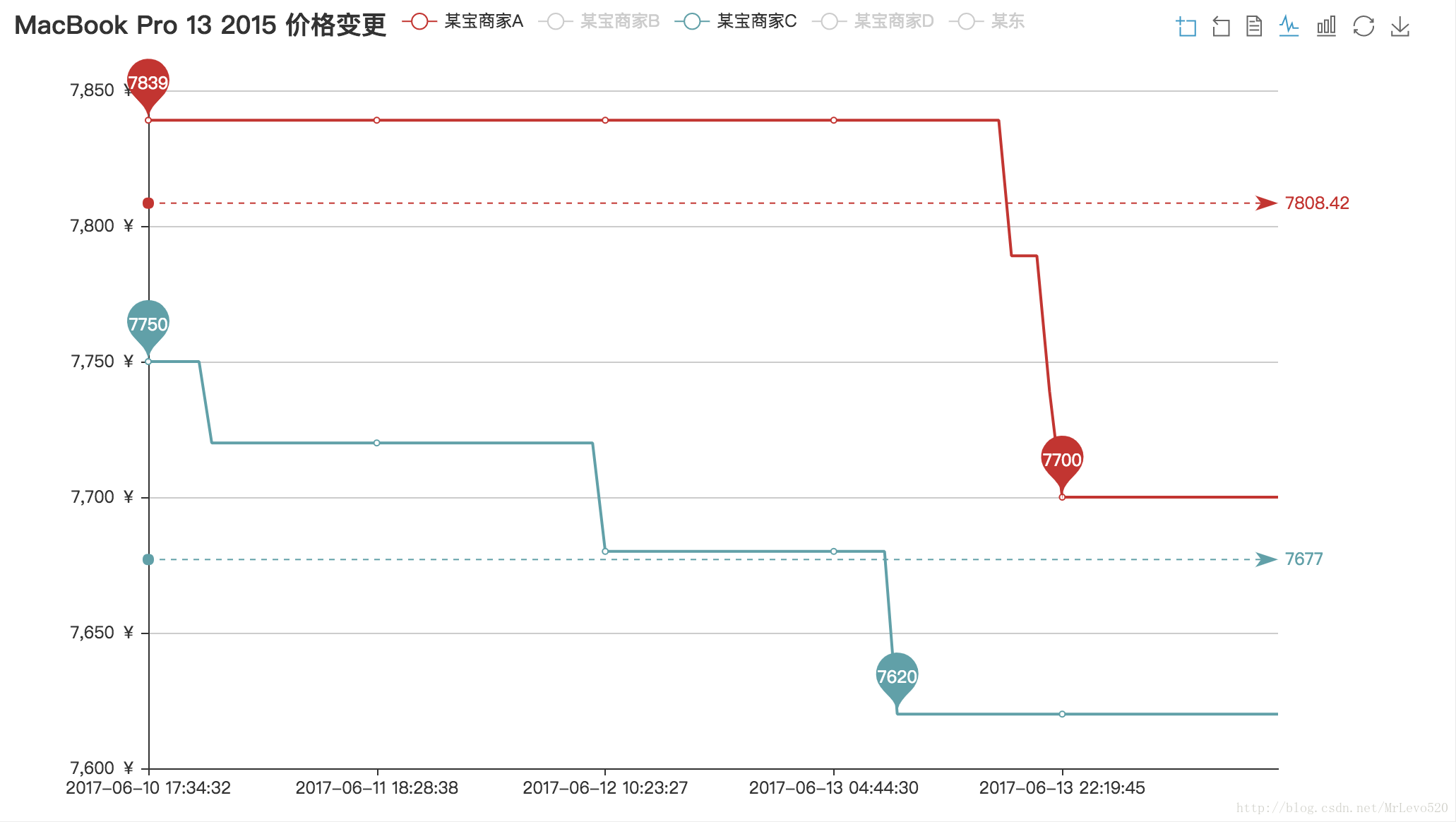

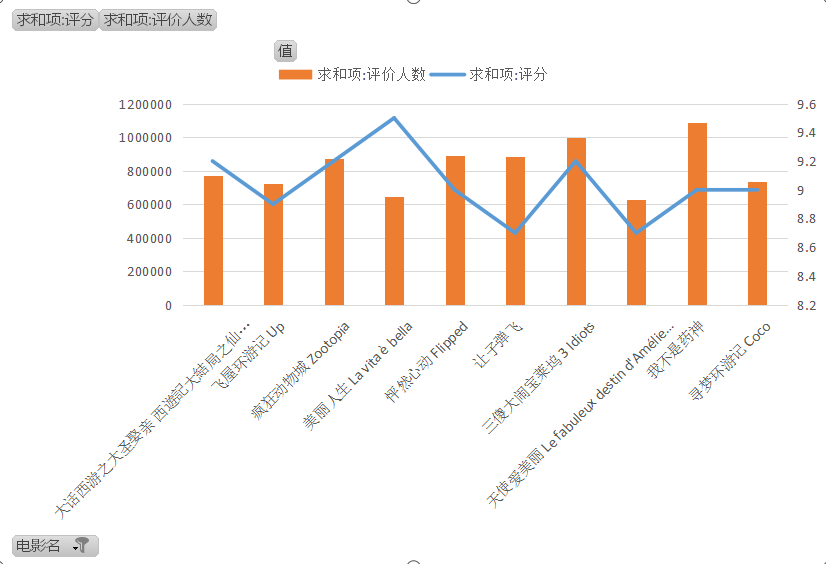

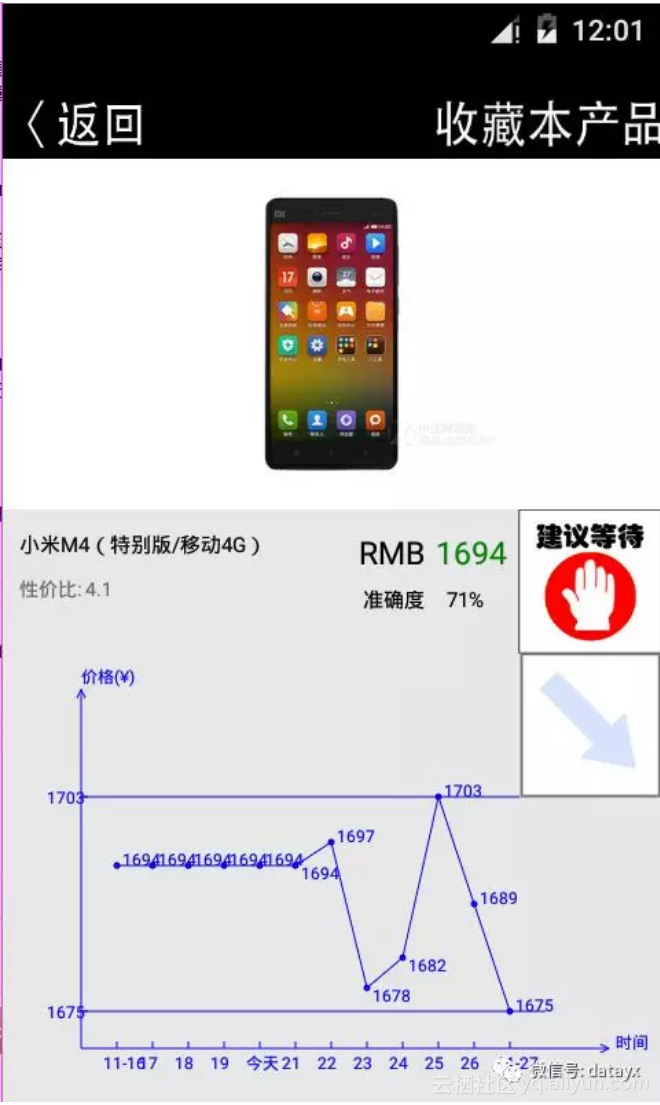

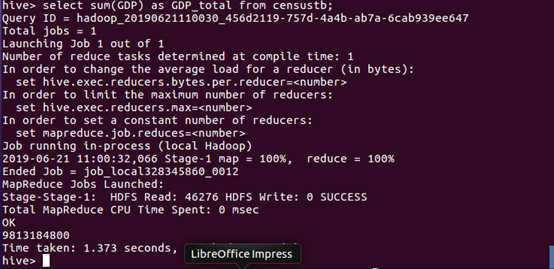

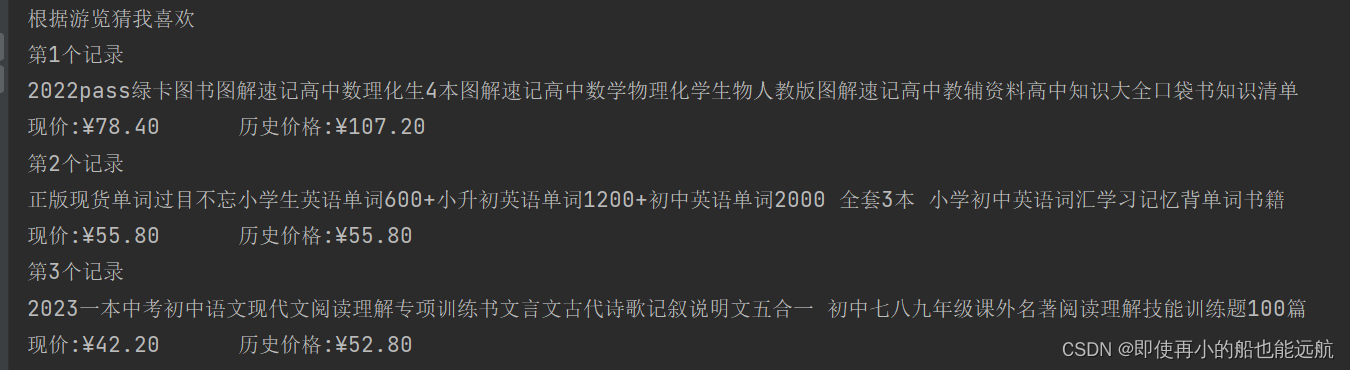

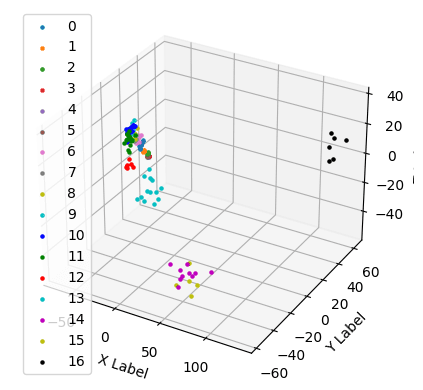

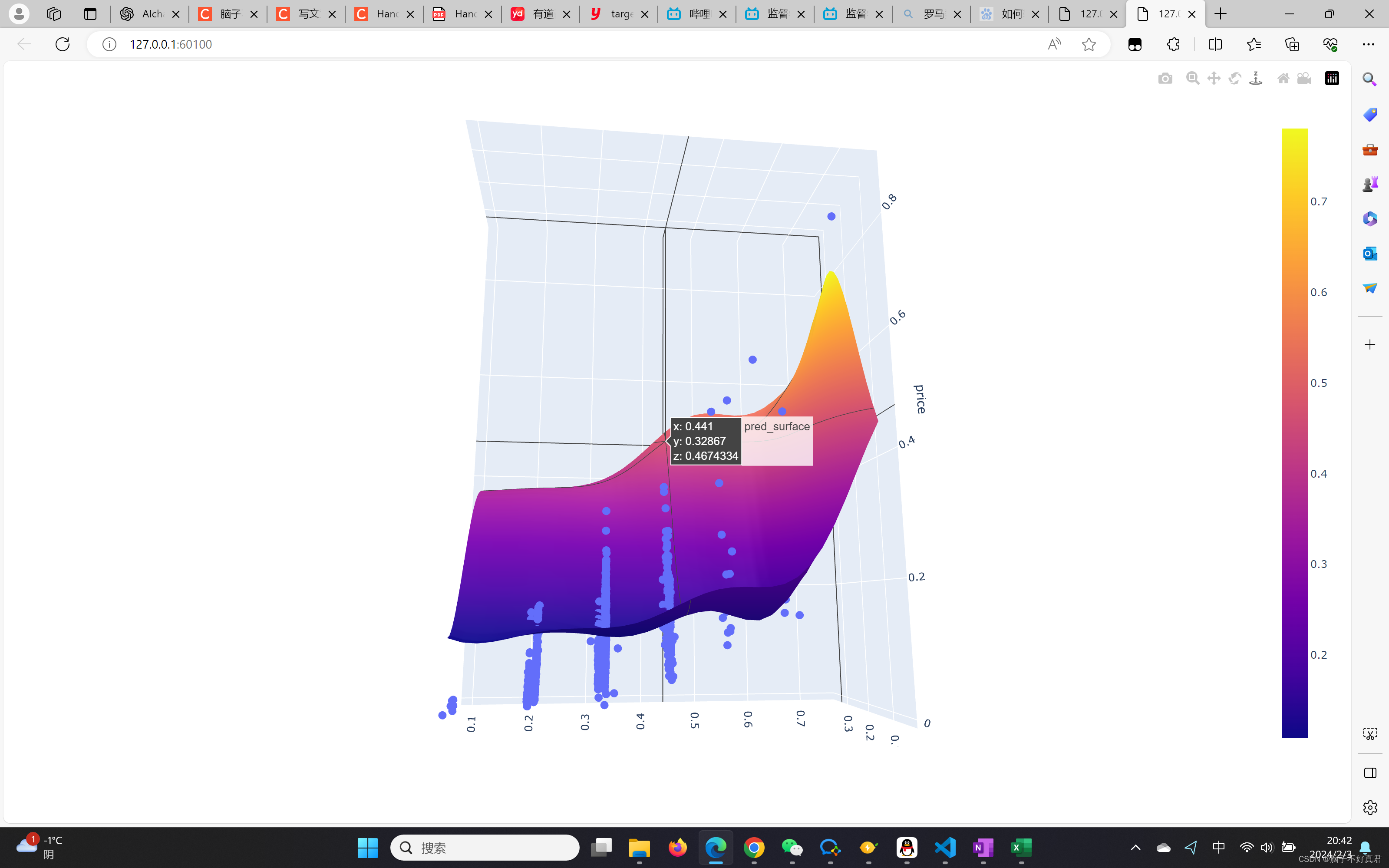

“大数据应用场景”之隔壁老王(连载四)

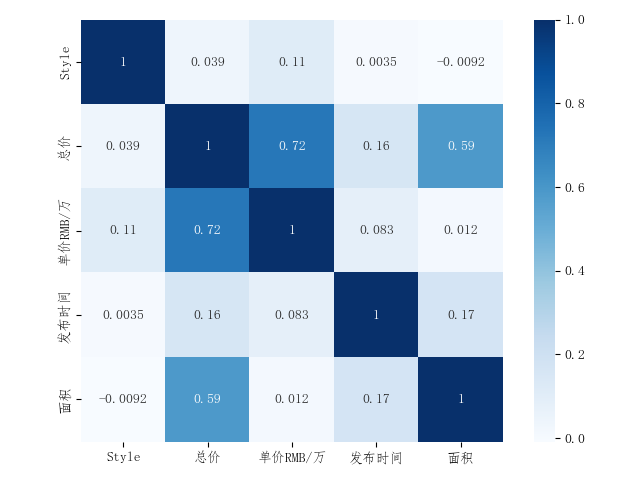

老王上周预测了辣条的销量之后,马上就吩咐了工厂工人,开始制作各种形状的辣条了,什么条状的,块状的,片状等等等。可是等到辣条生产出来之后,是要卖的呀,所以怎么定价又成了老王的一个难题&#…

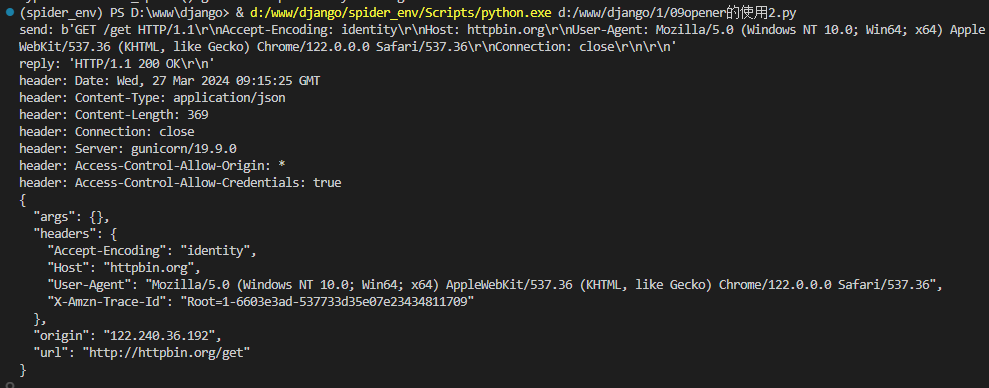

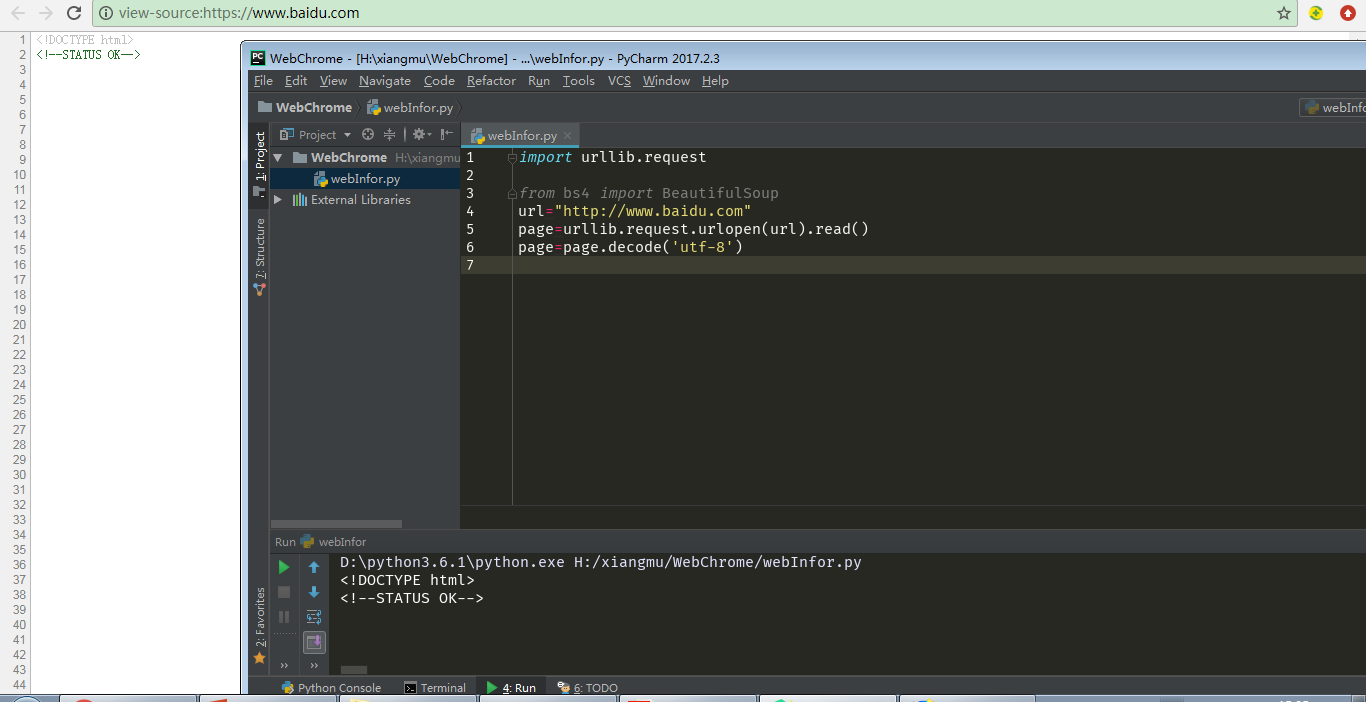

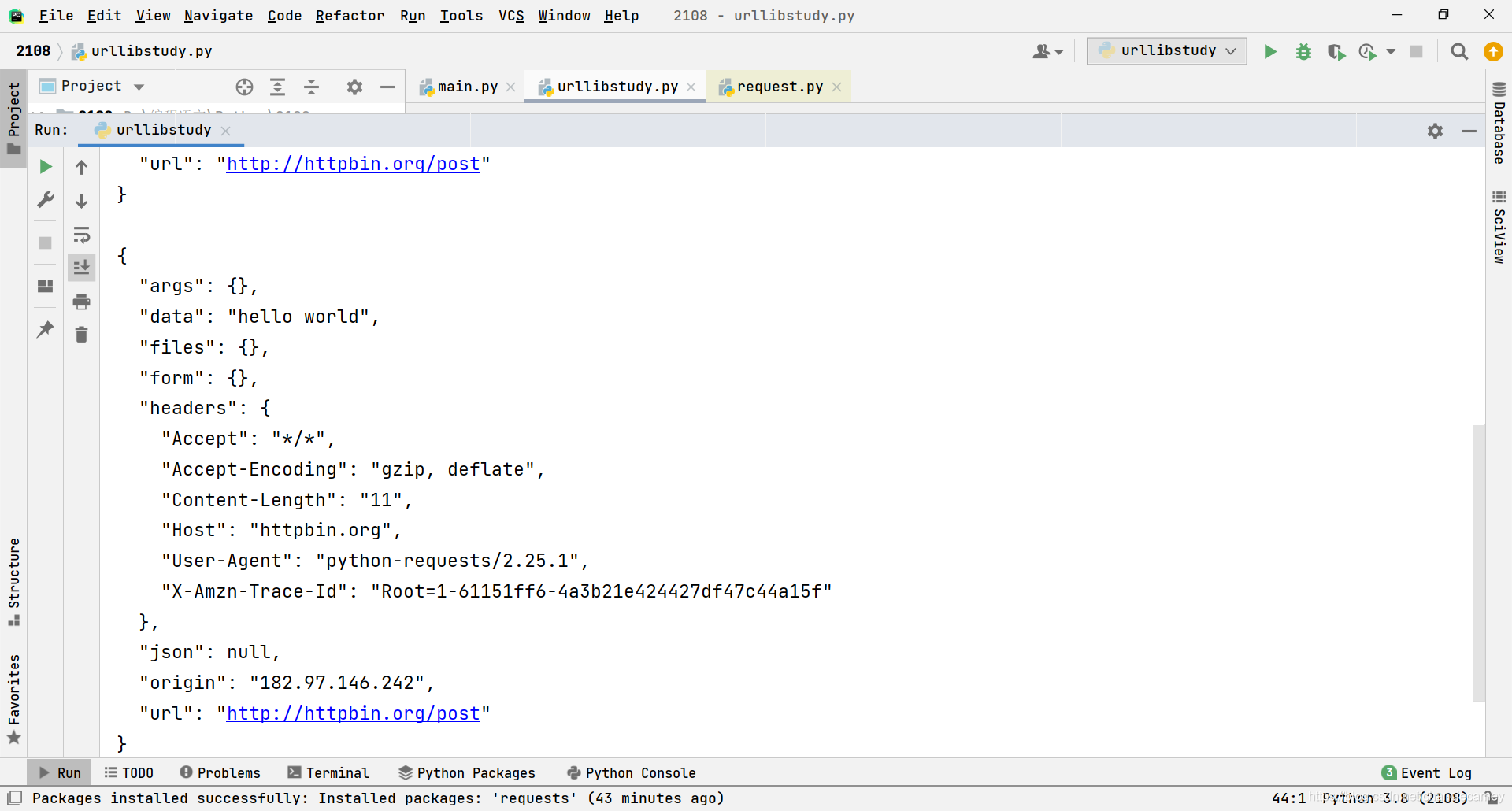

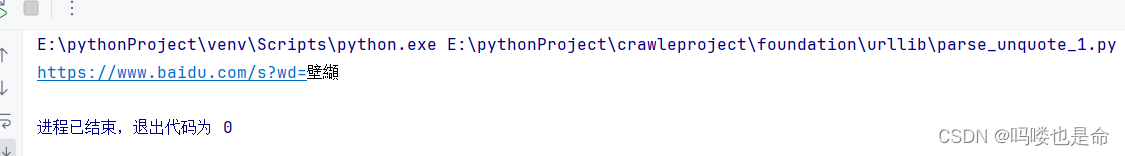

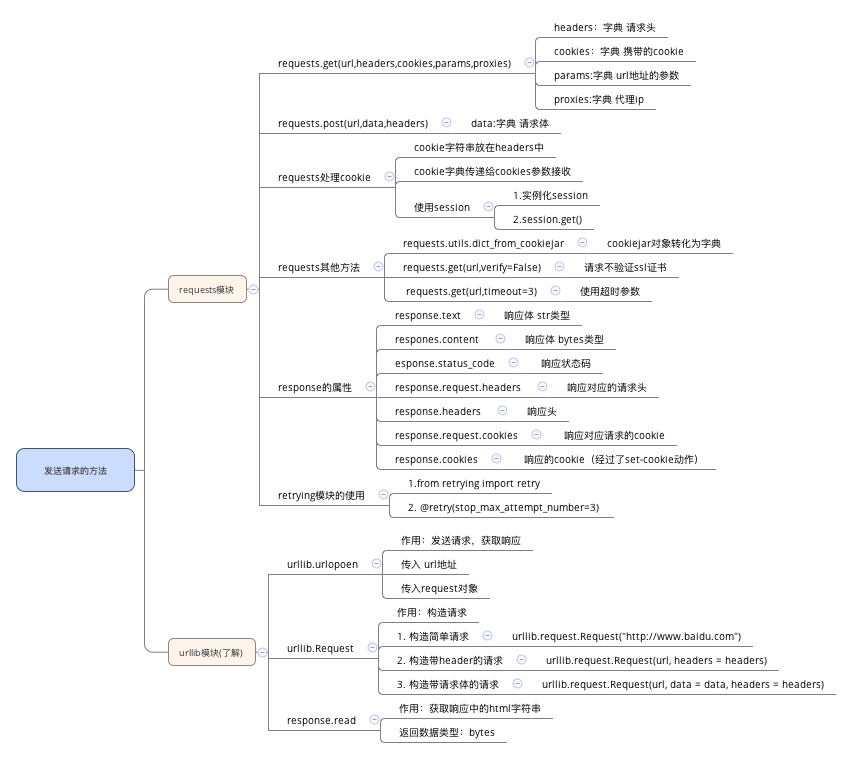

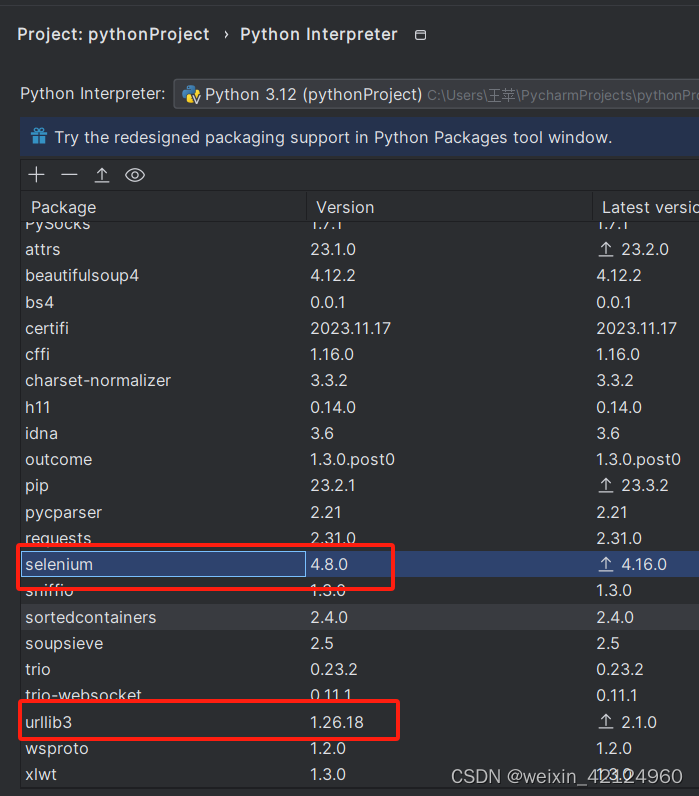

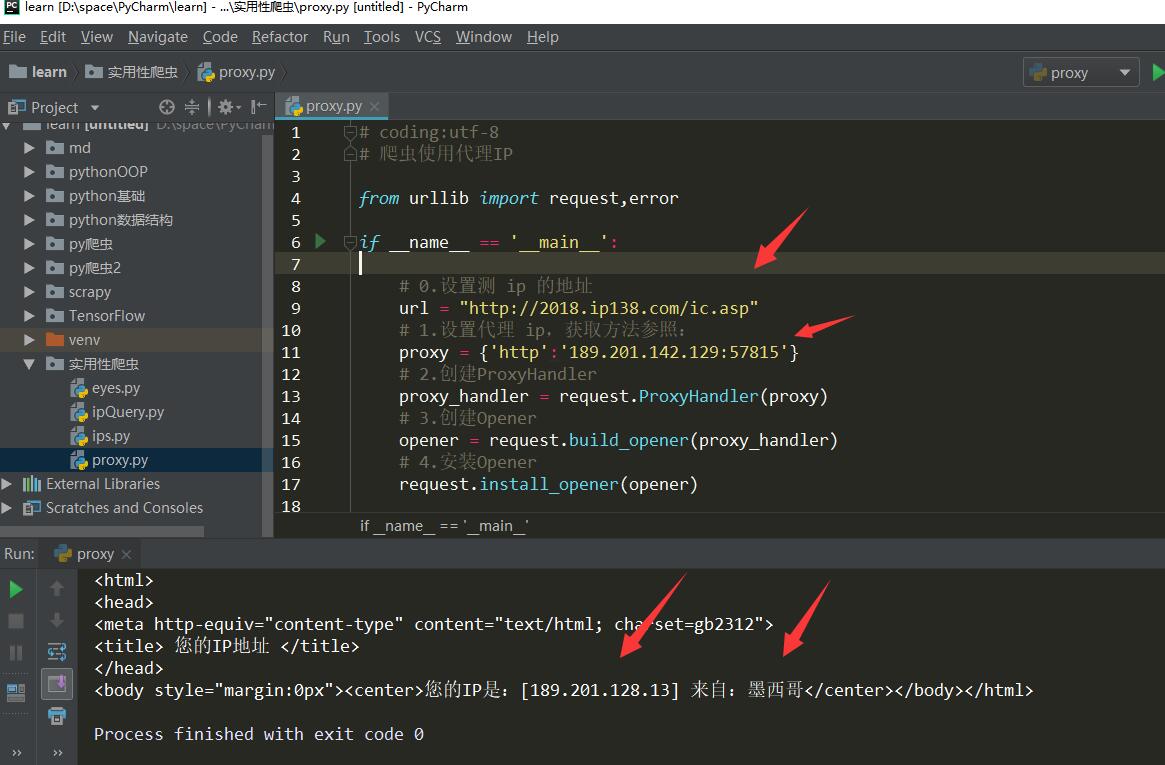

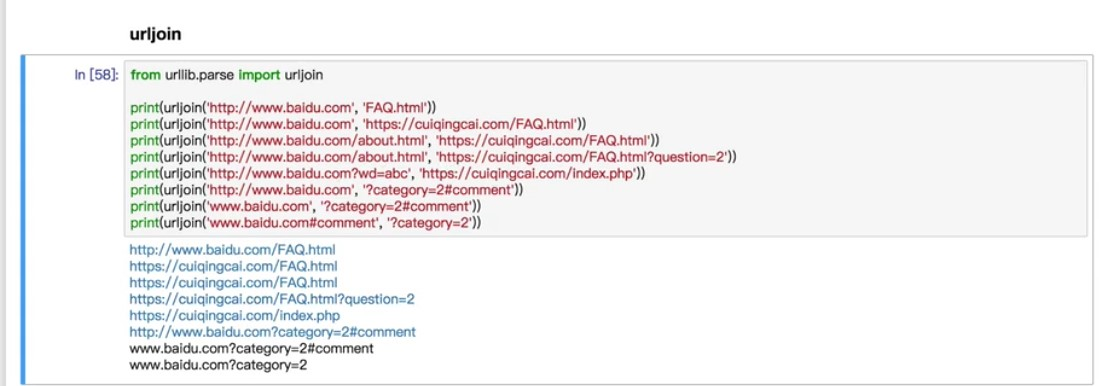

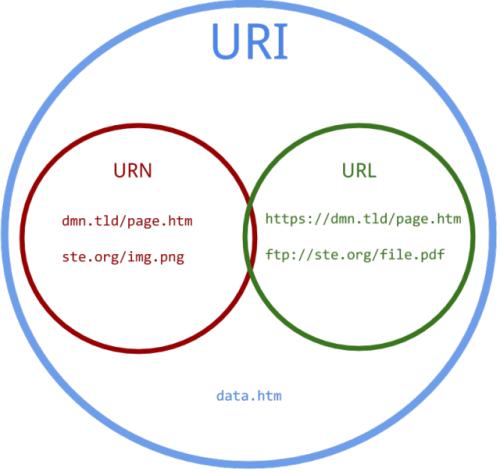

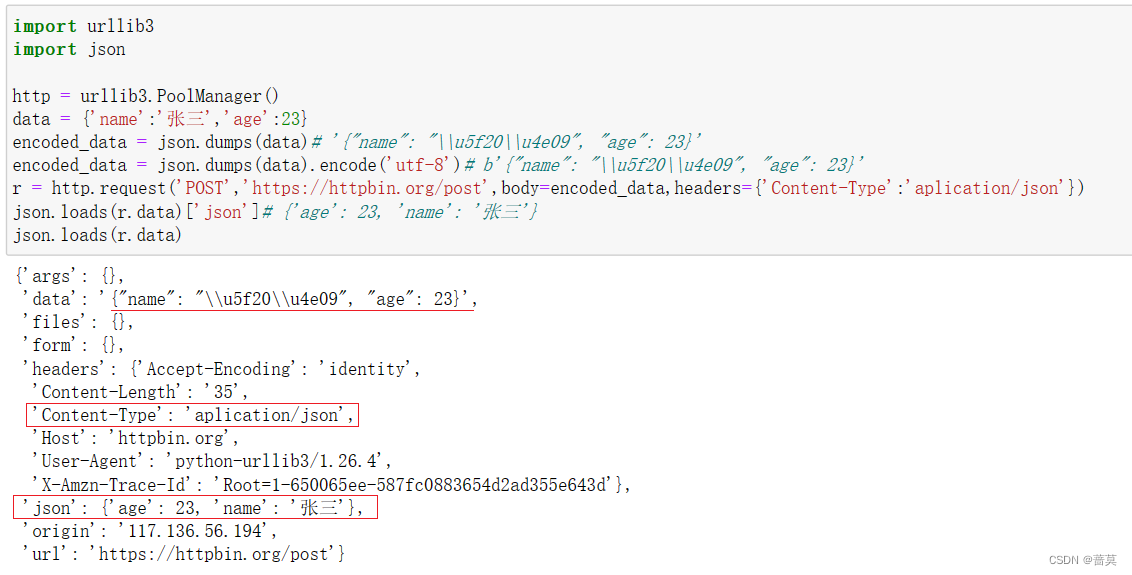

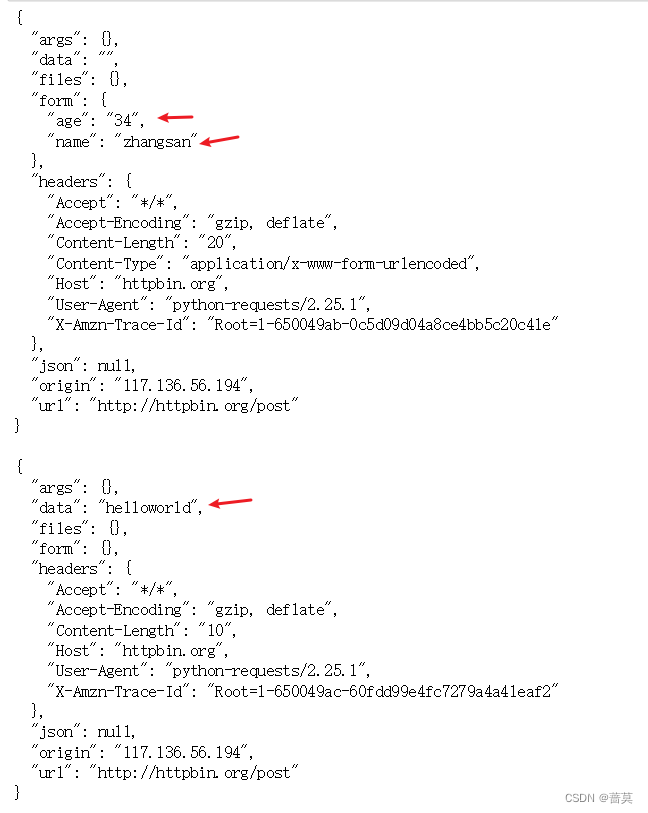

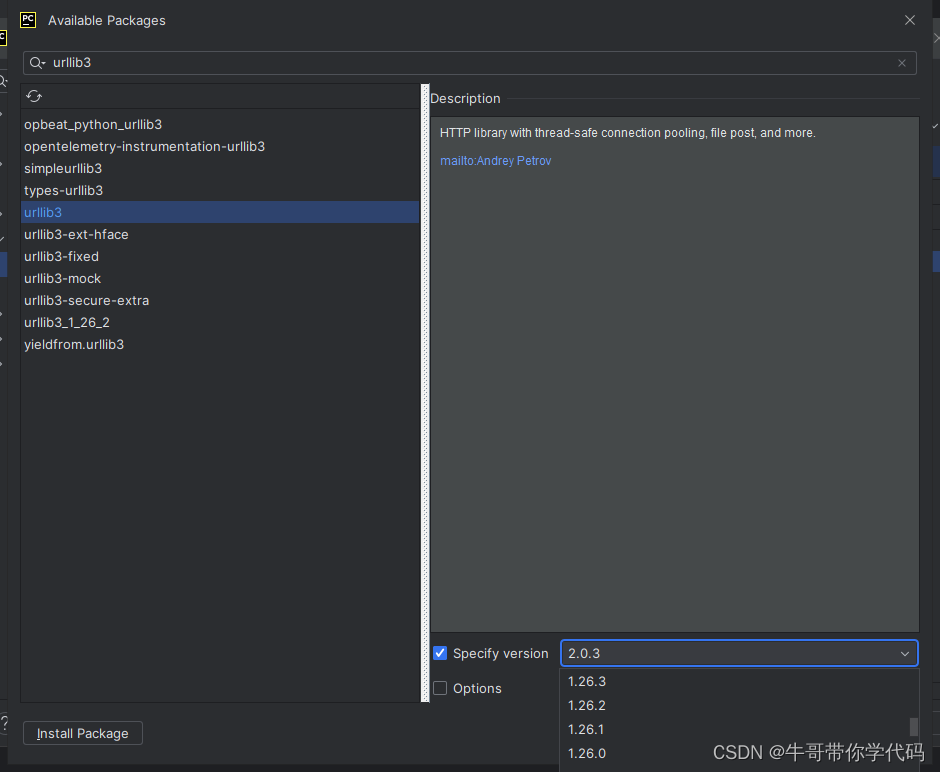

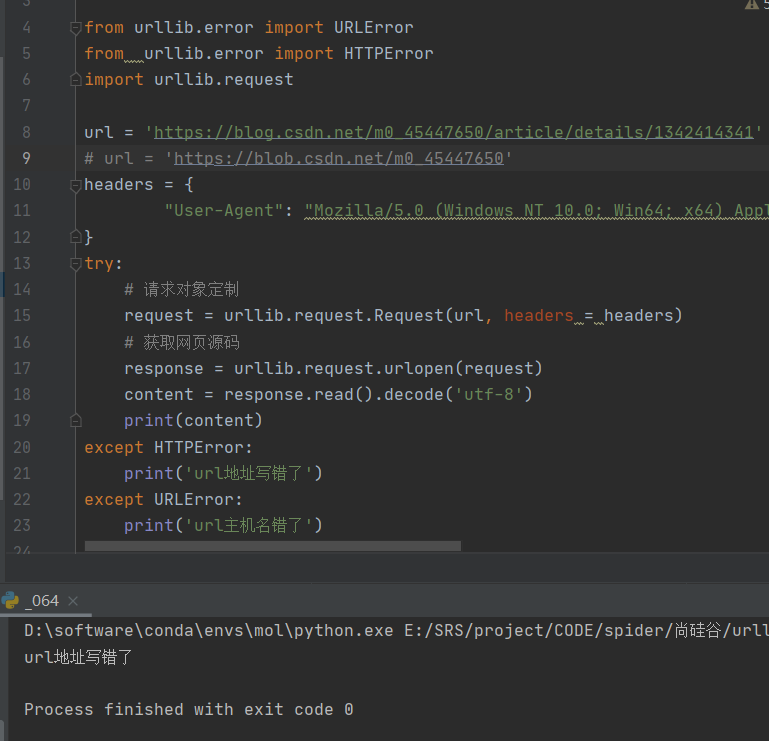

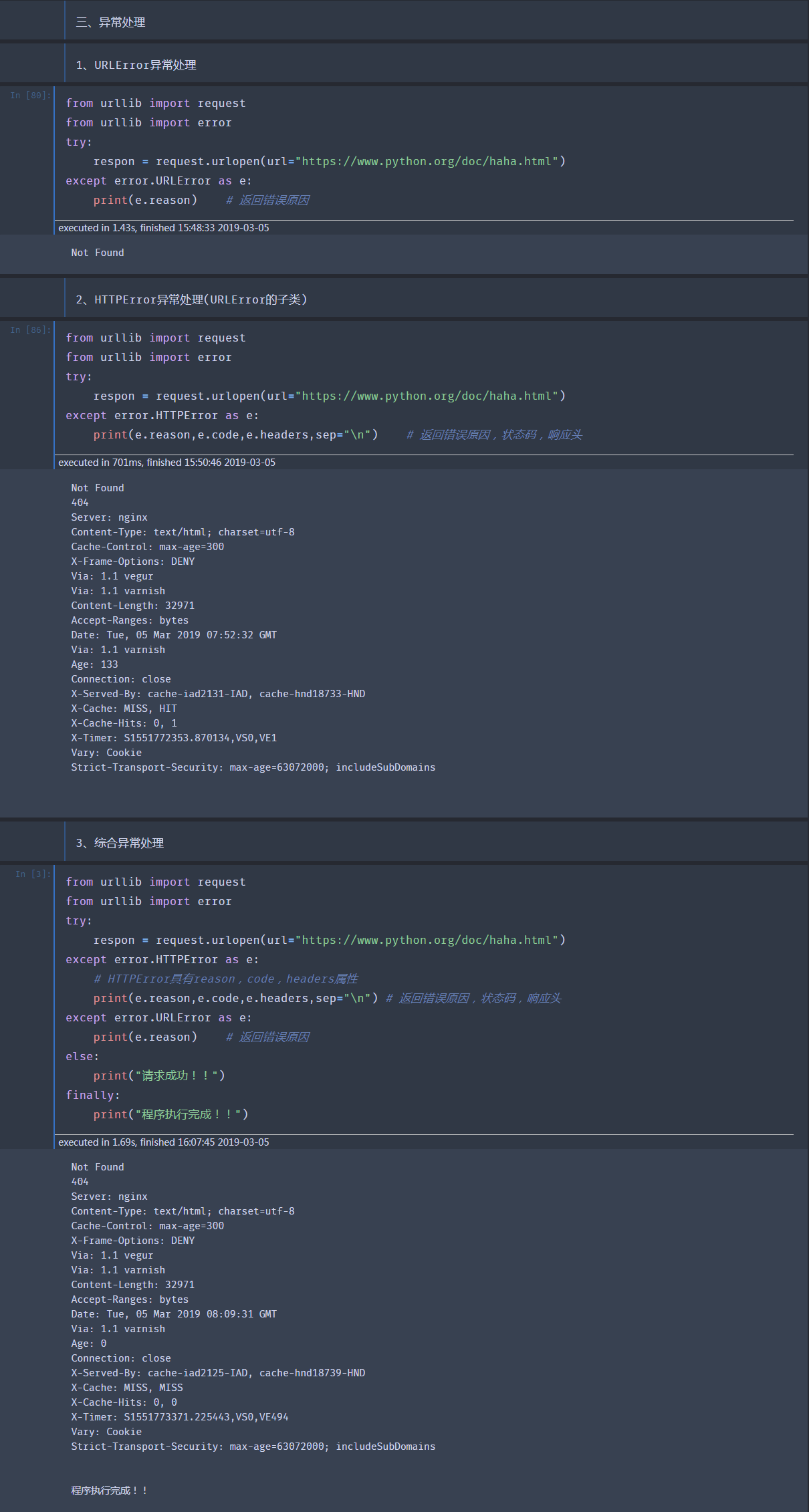

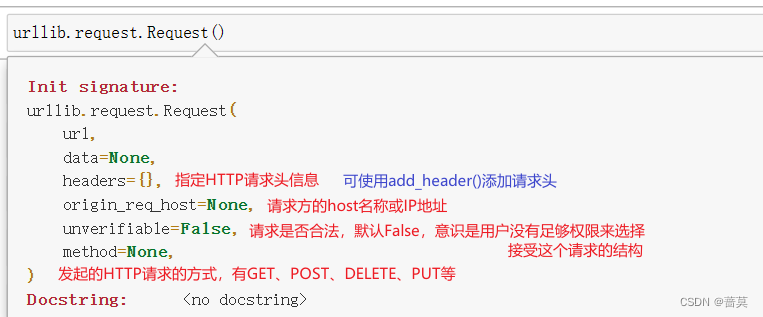

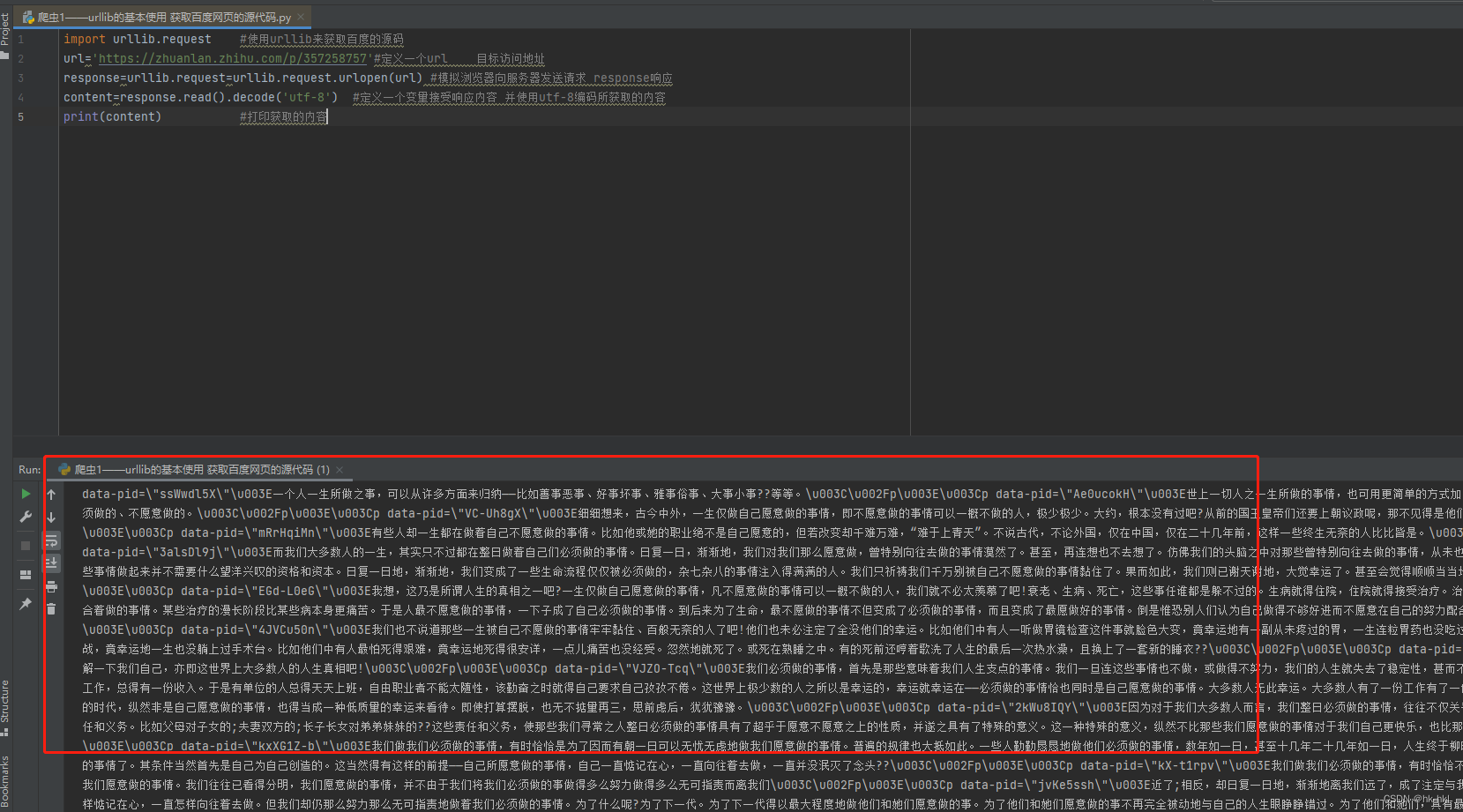

爬虫基础(3)发送请求之urllib库与urllib3库的使用

文章目录一. urllib库与urllib3库的简介(一)什么是Urllib库(二)什么是urllib3库(三)urllib库与urllib3库的关系二. urllib库模块详析(一)发送请求1. urlopen方法2. Request对象3. 高…

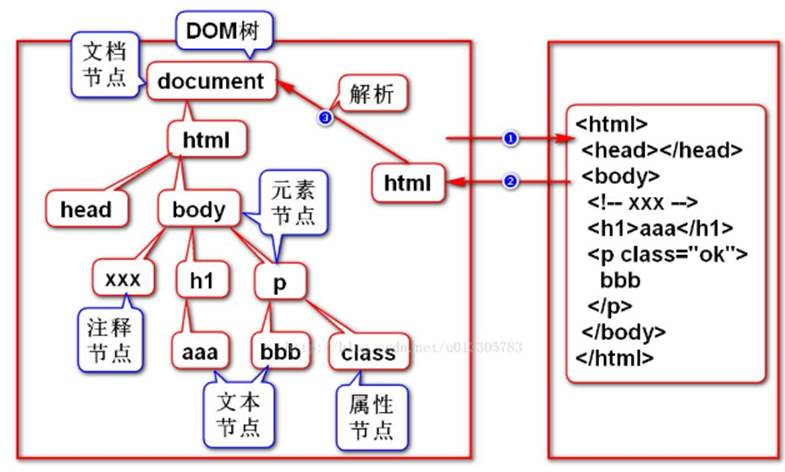

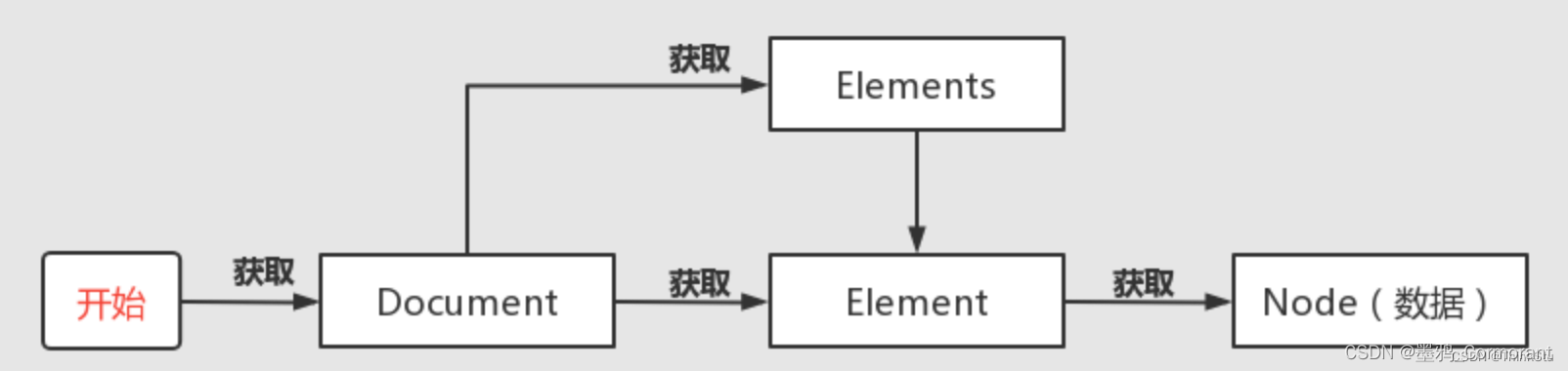

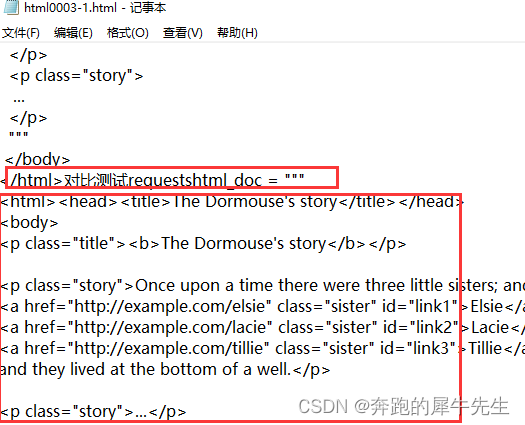

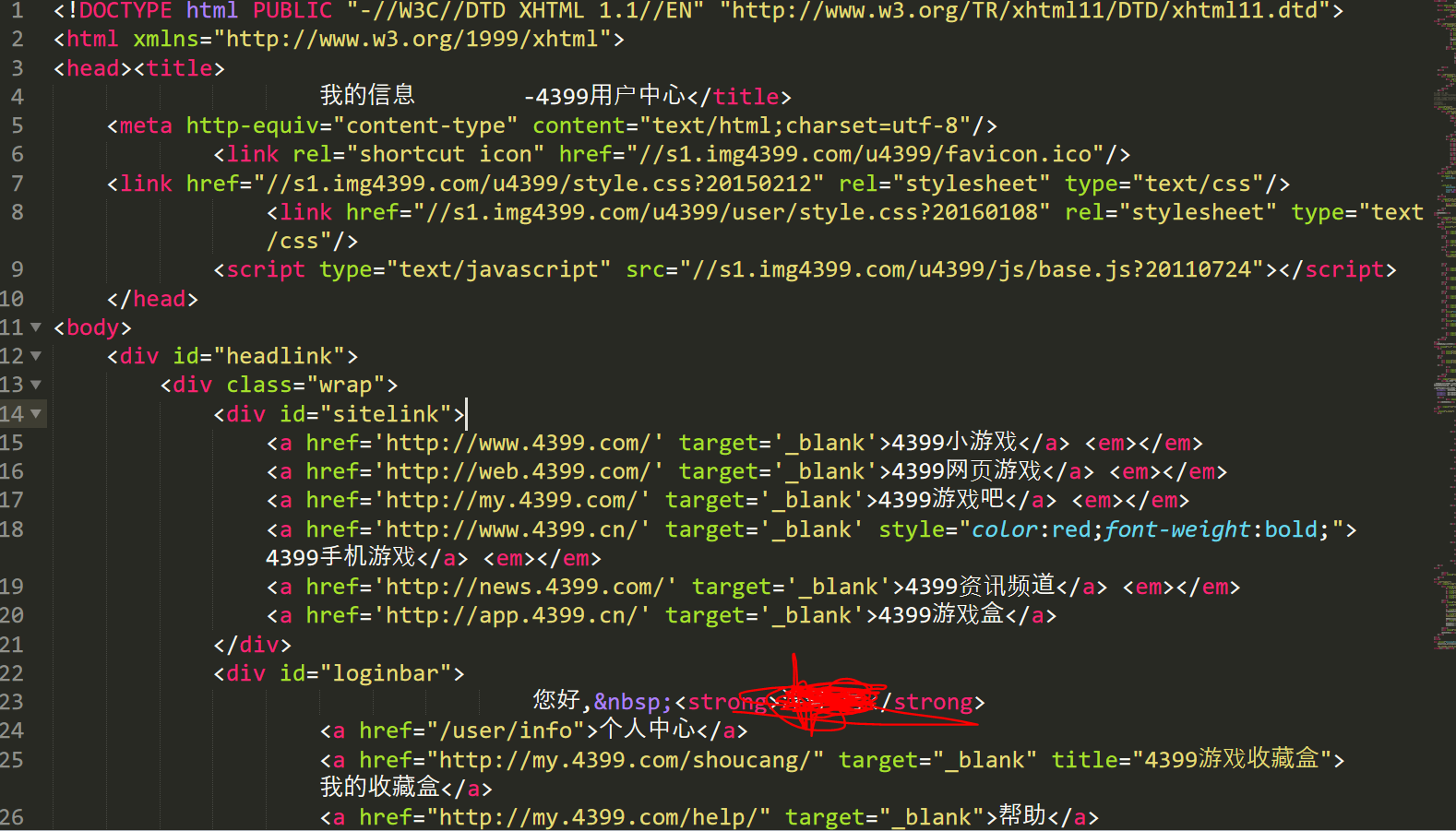

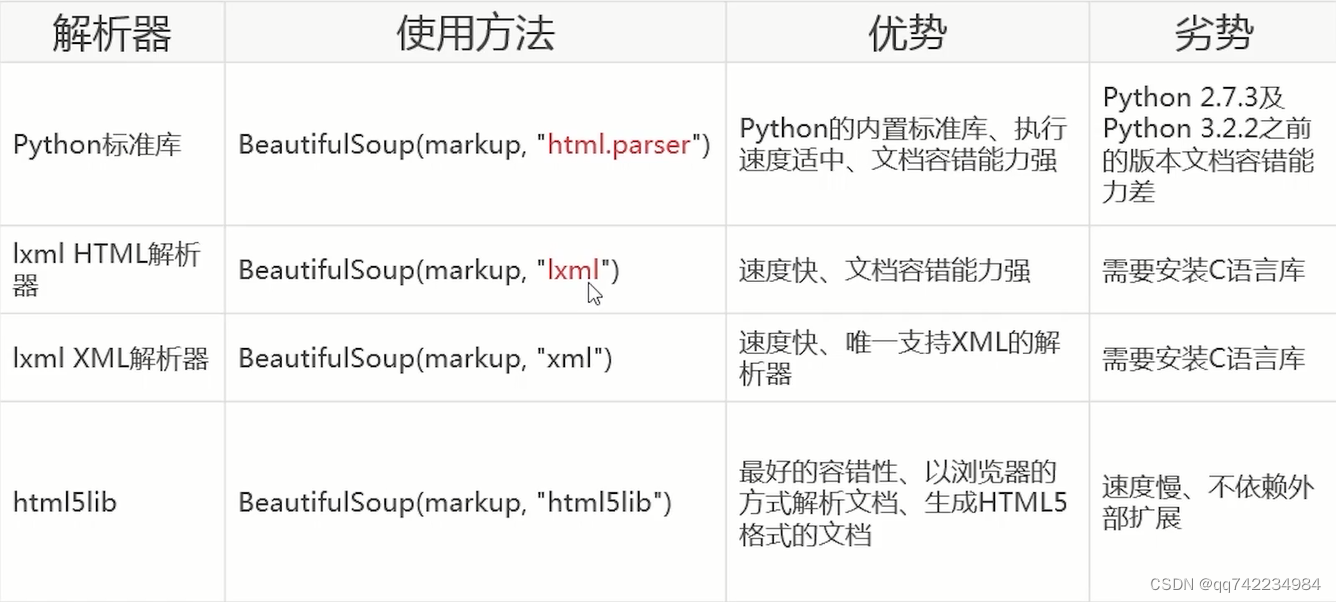

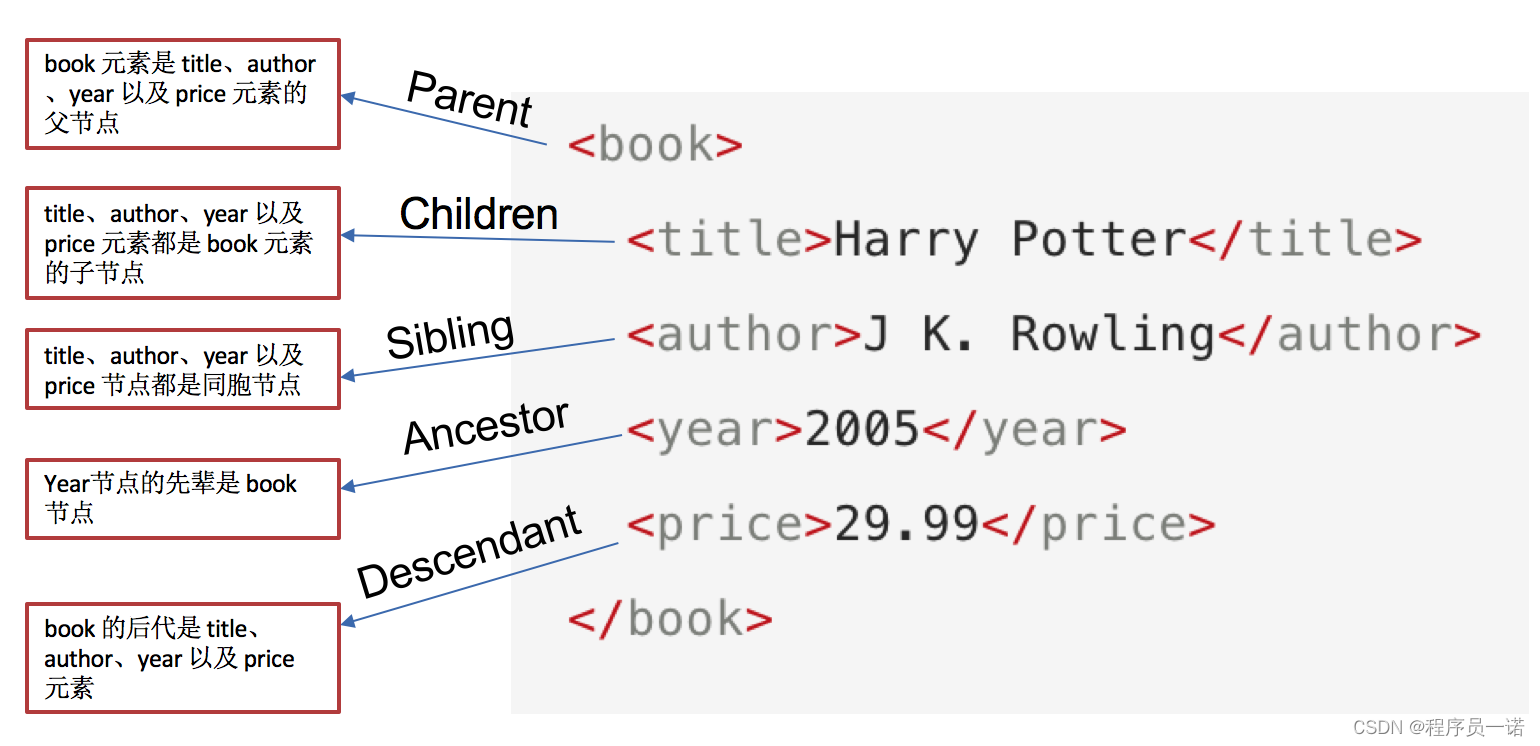

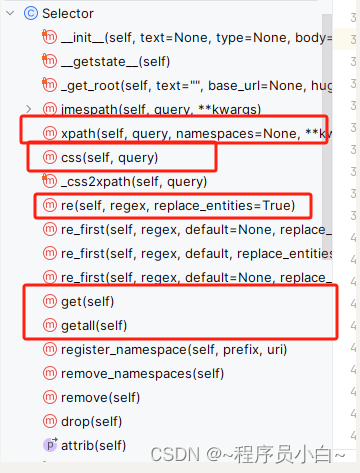

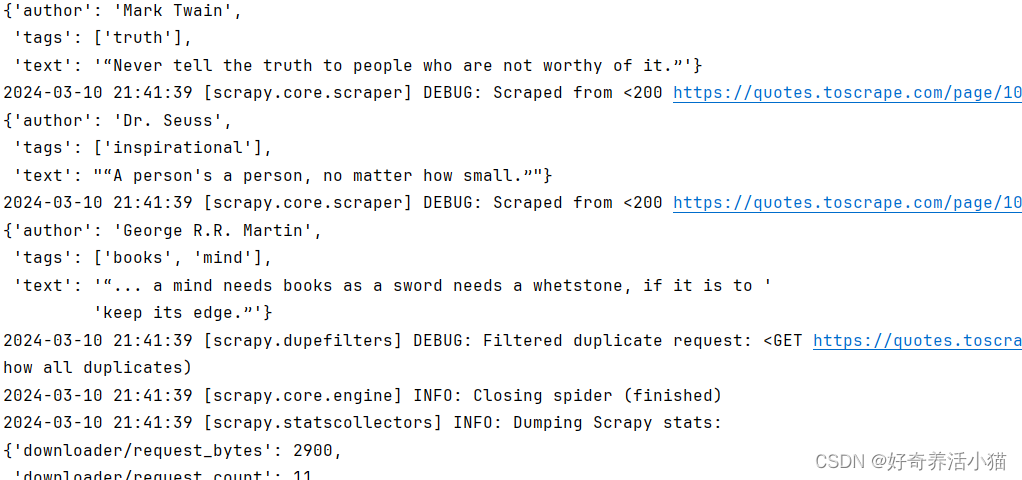

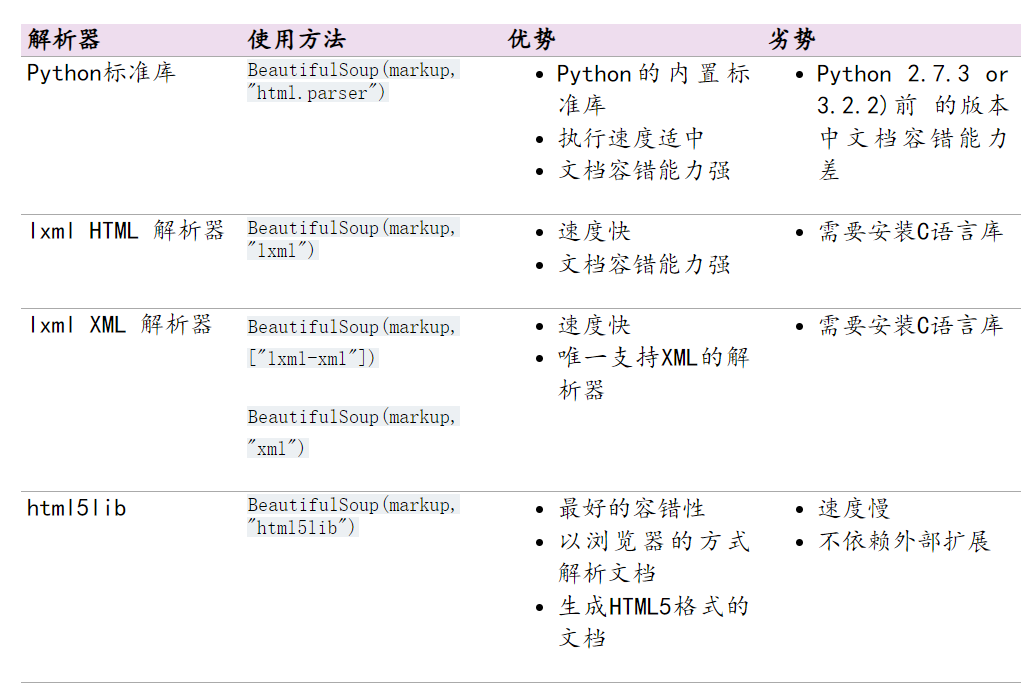

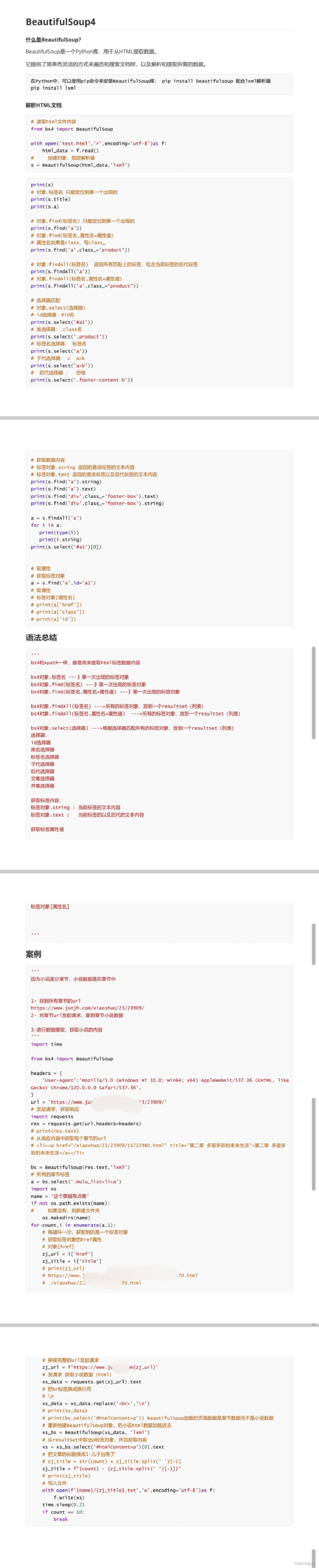

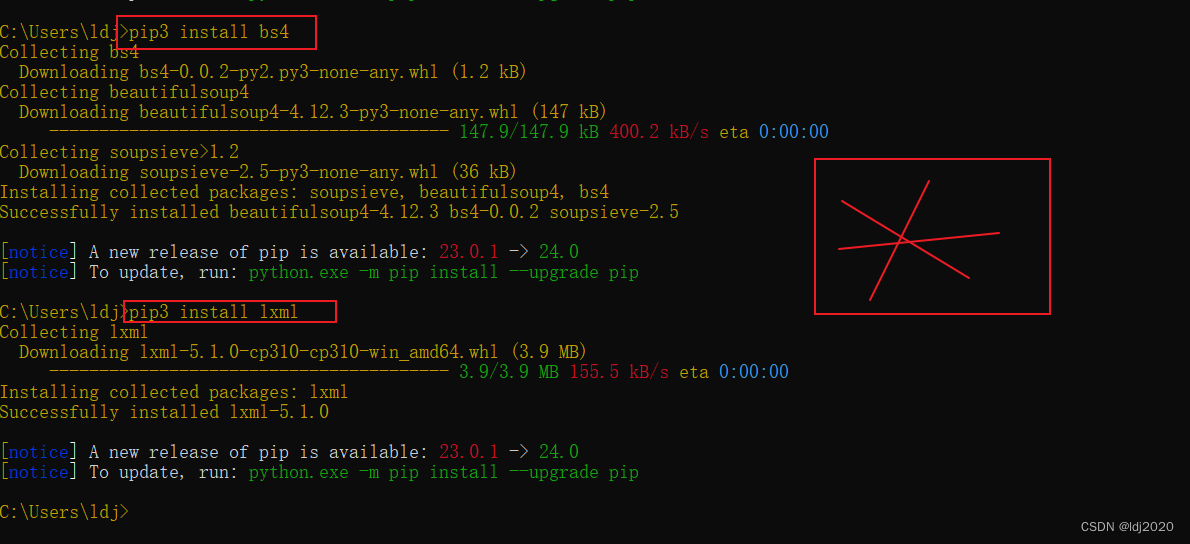

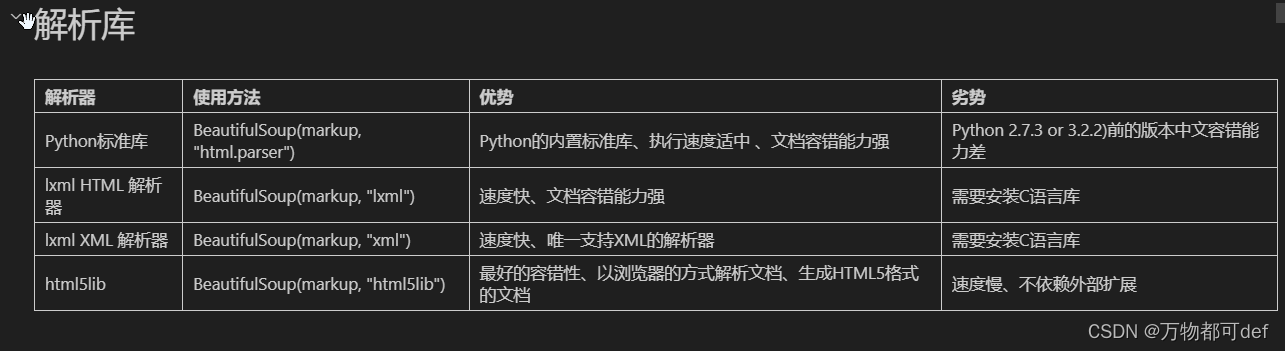

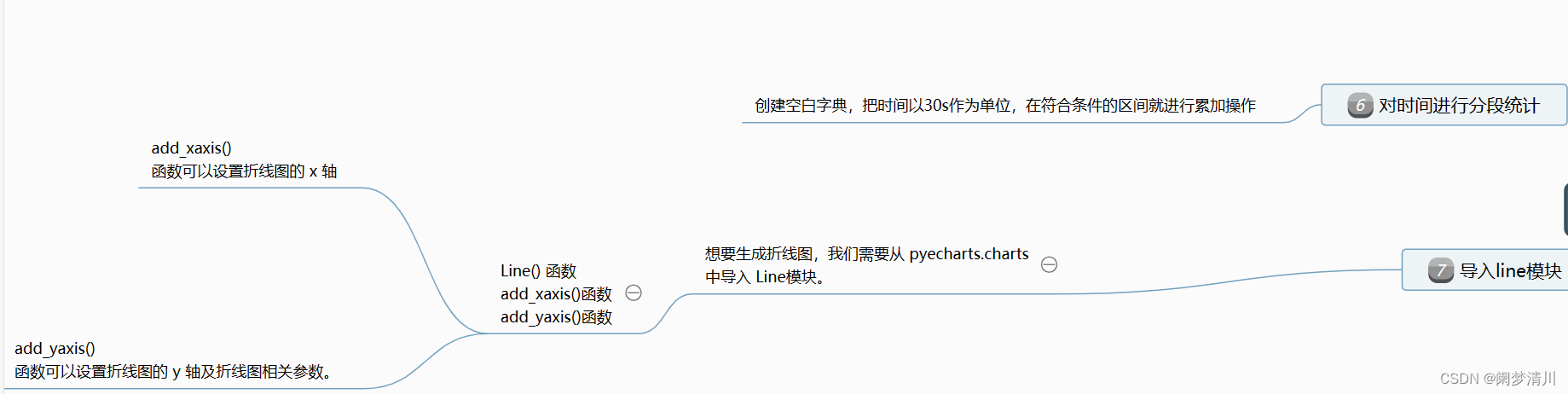

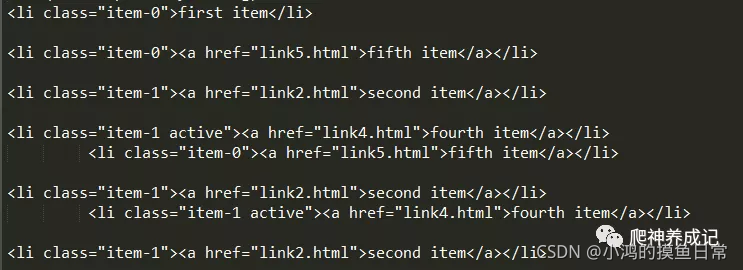

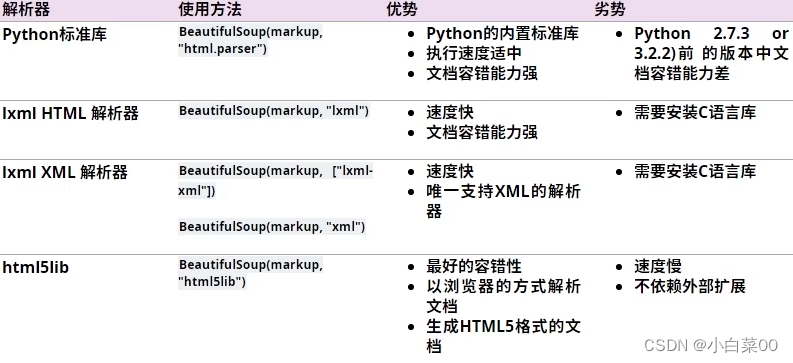

爬虫基础(7)网页解析之Beautiful Soup库

文章目录一. Beautiful Soup库简介二. 安装beautifulsoup库三. Beautiful Soup库的四个对象类1. Tag2. NavigableString3. BeautifulSoup4. Comment四. Beautiful Soup库详析(一)解析器(二)创建Beautiful Soup对象(三&…

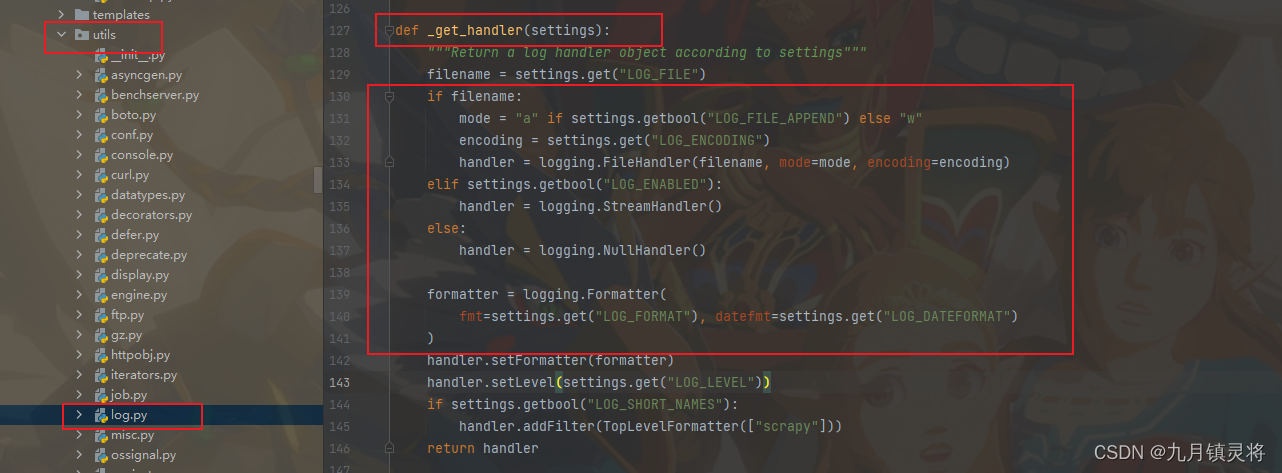

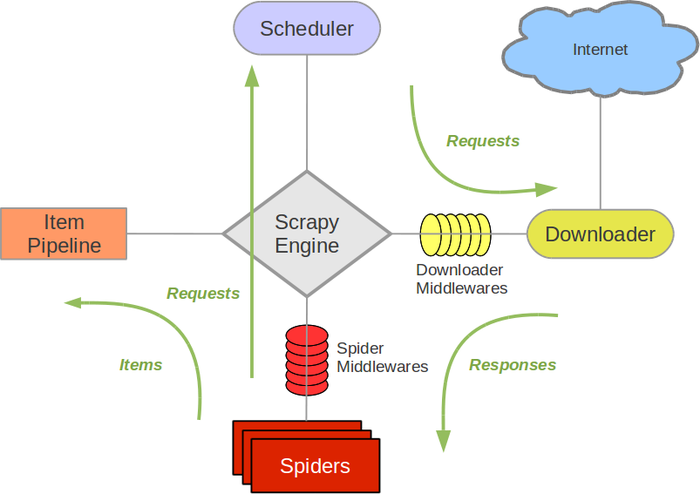

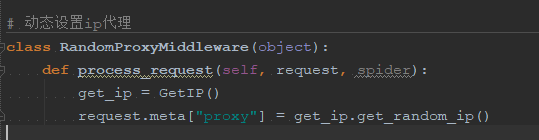

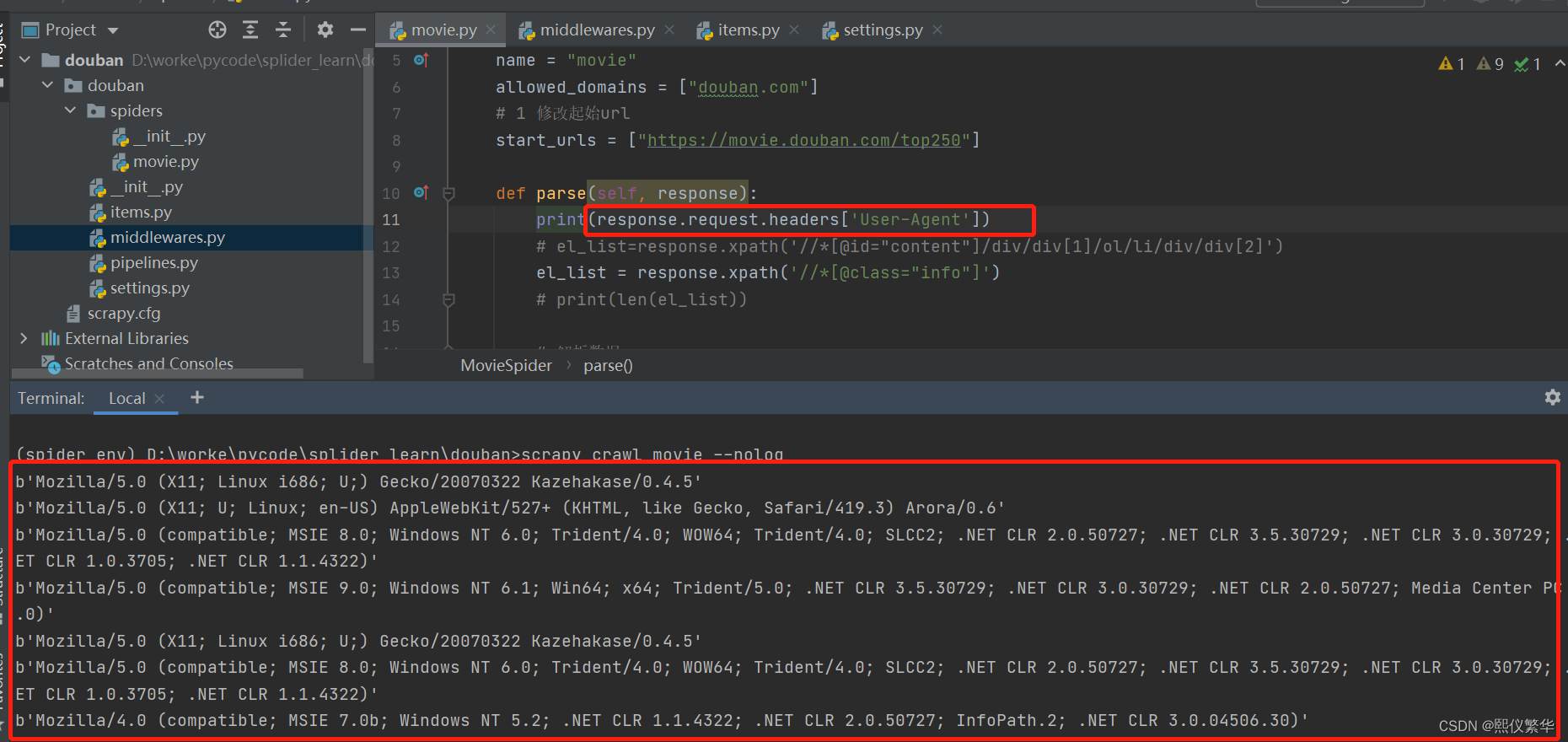

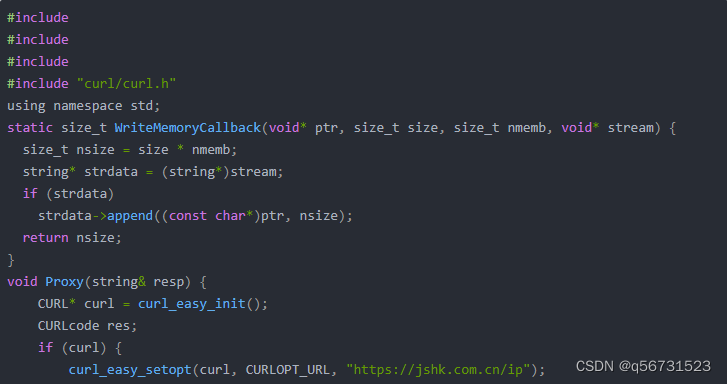

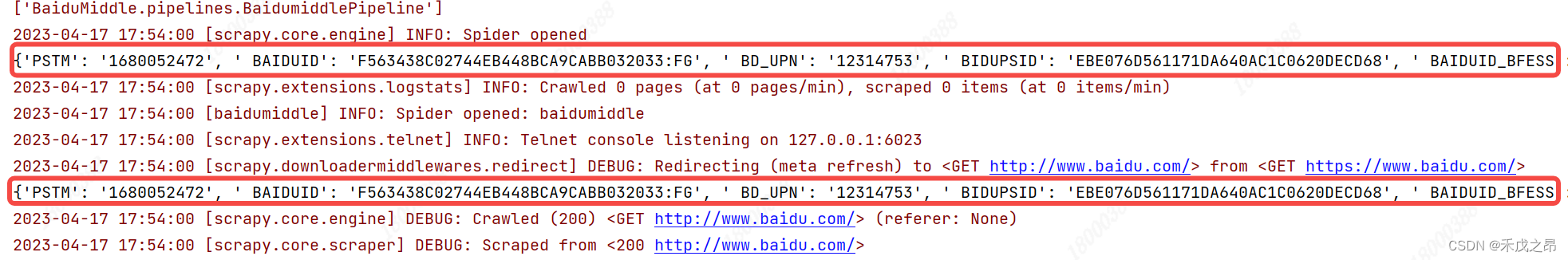

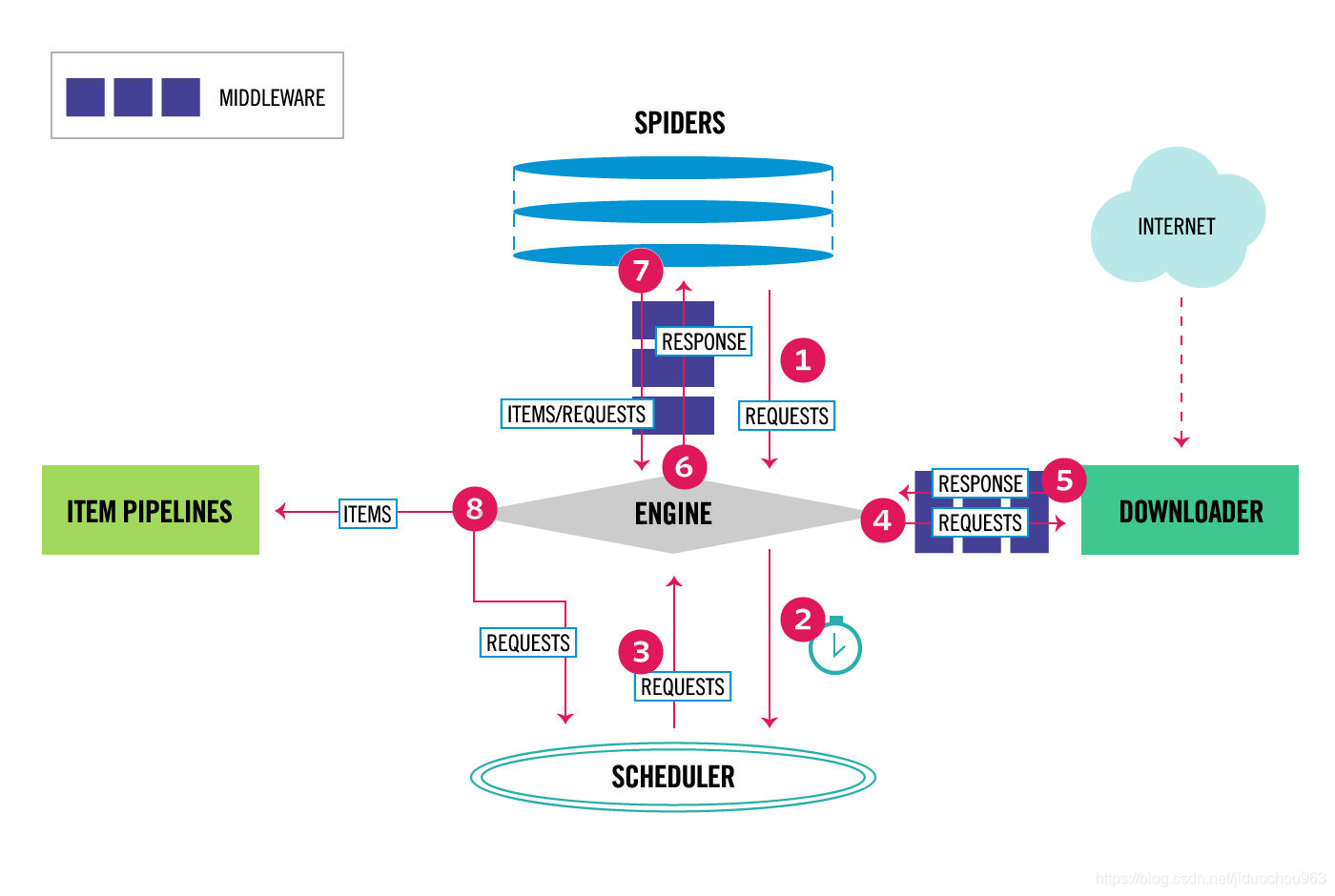

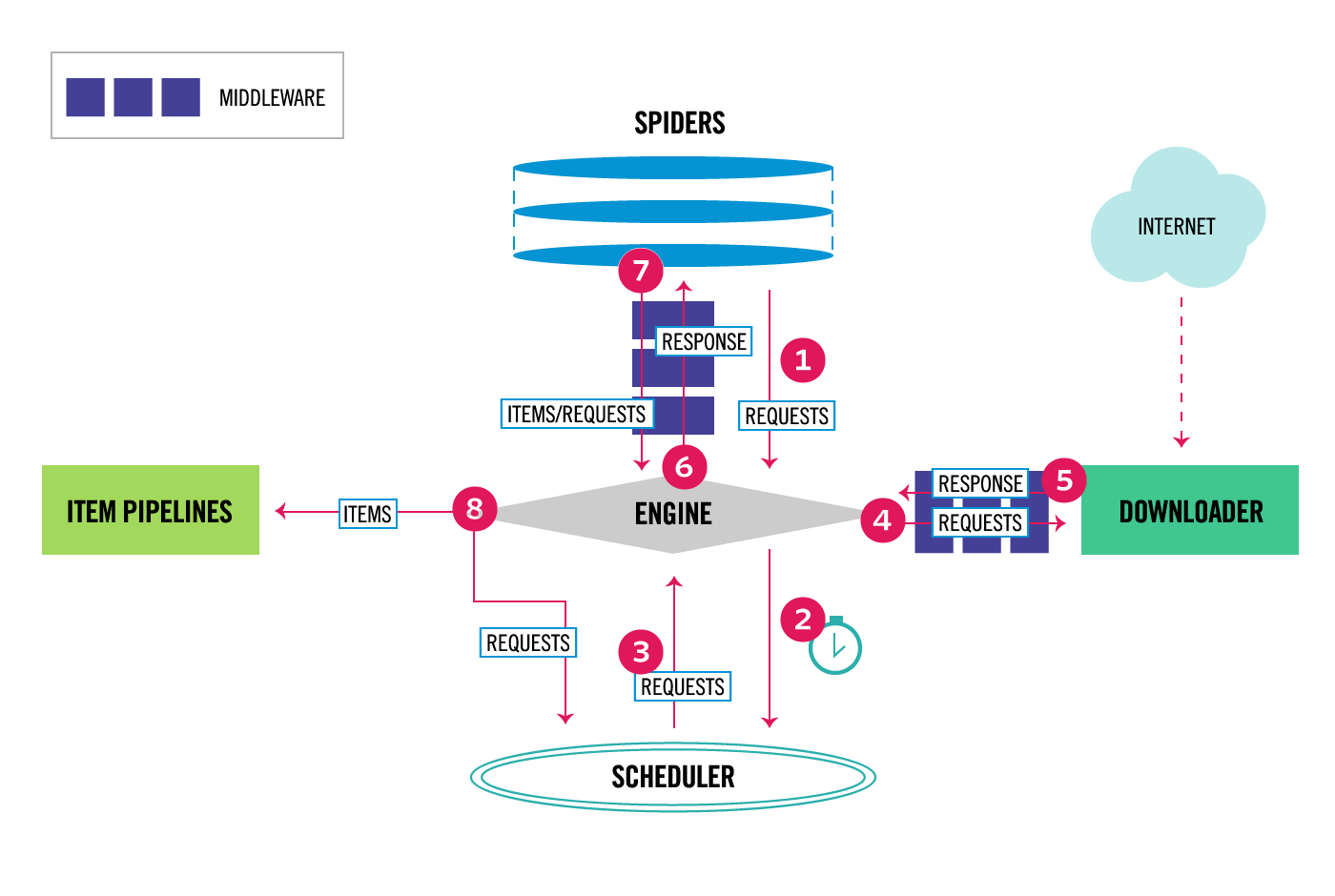

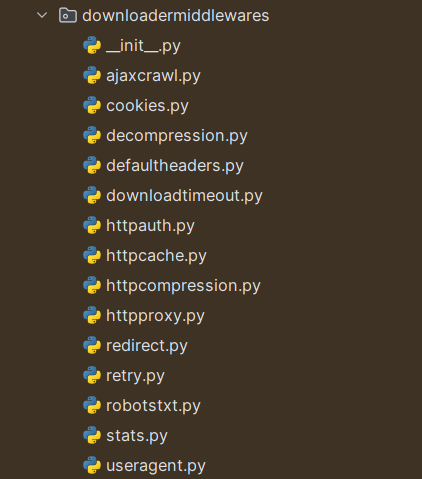

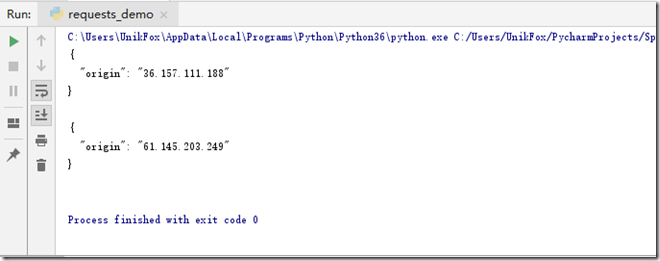

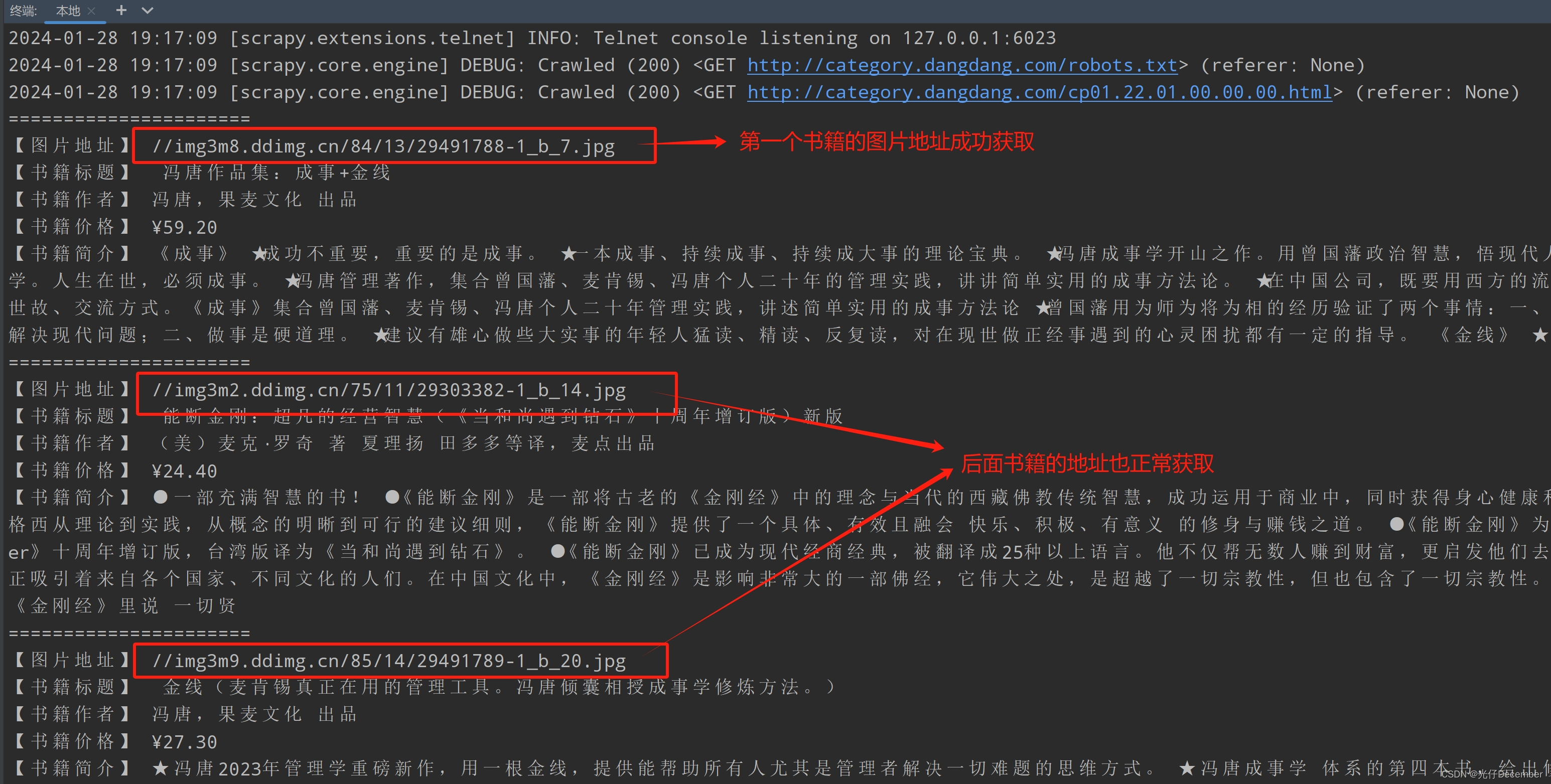

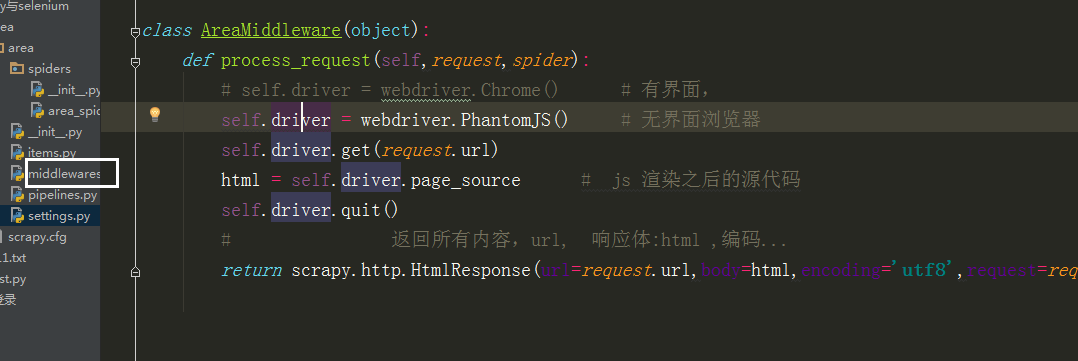

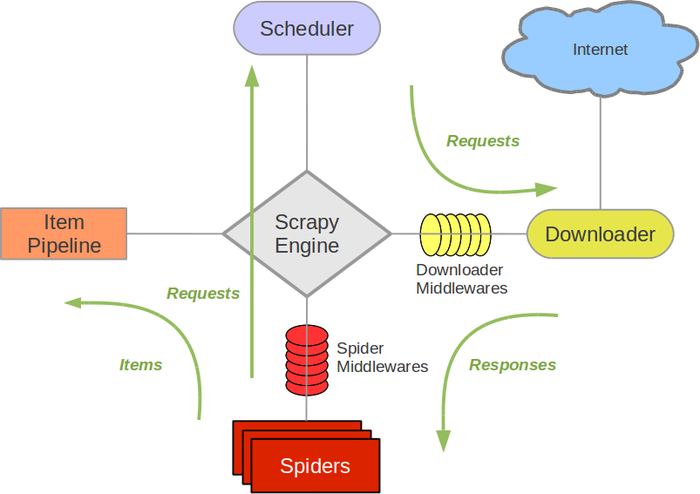

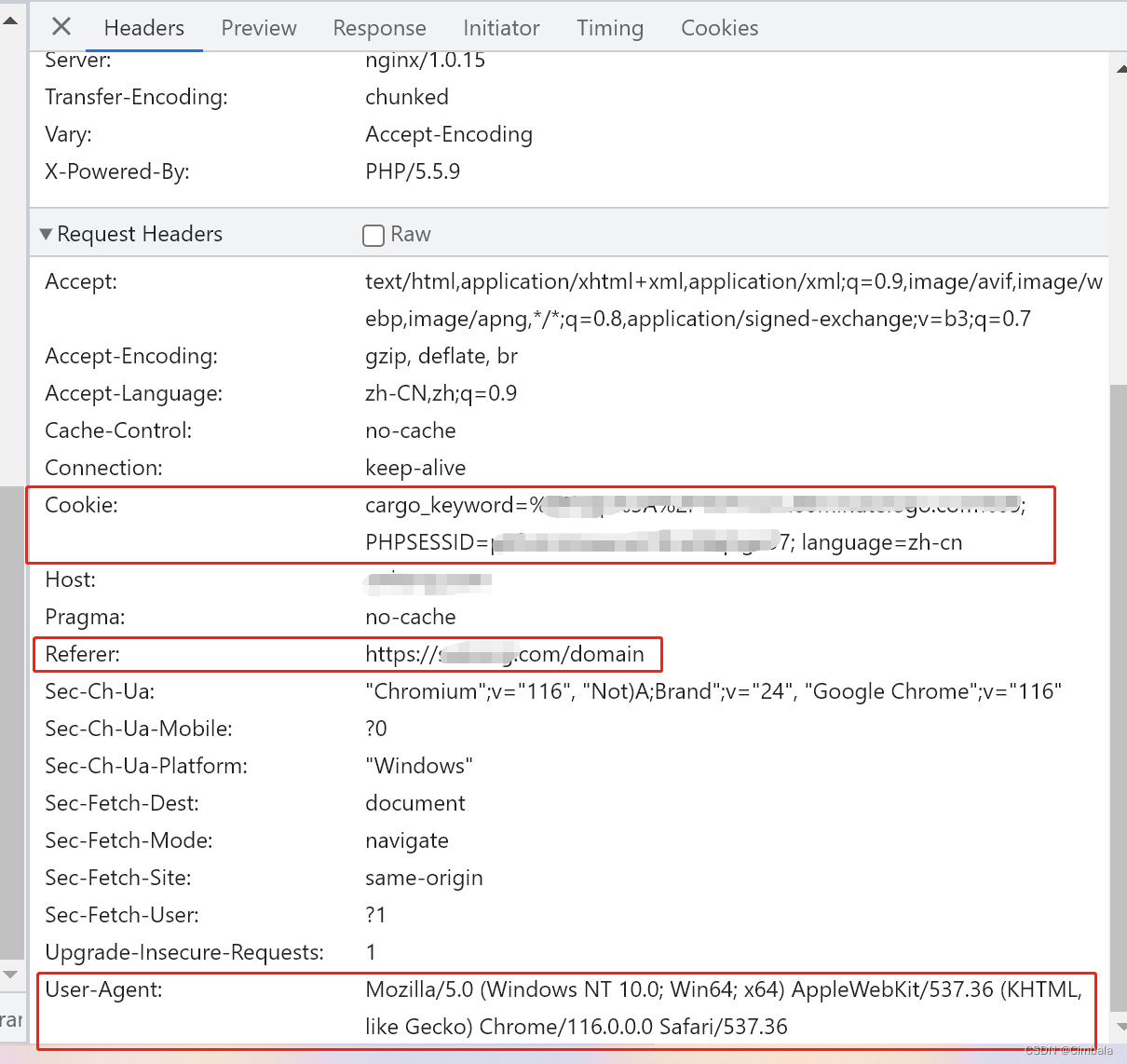

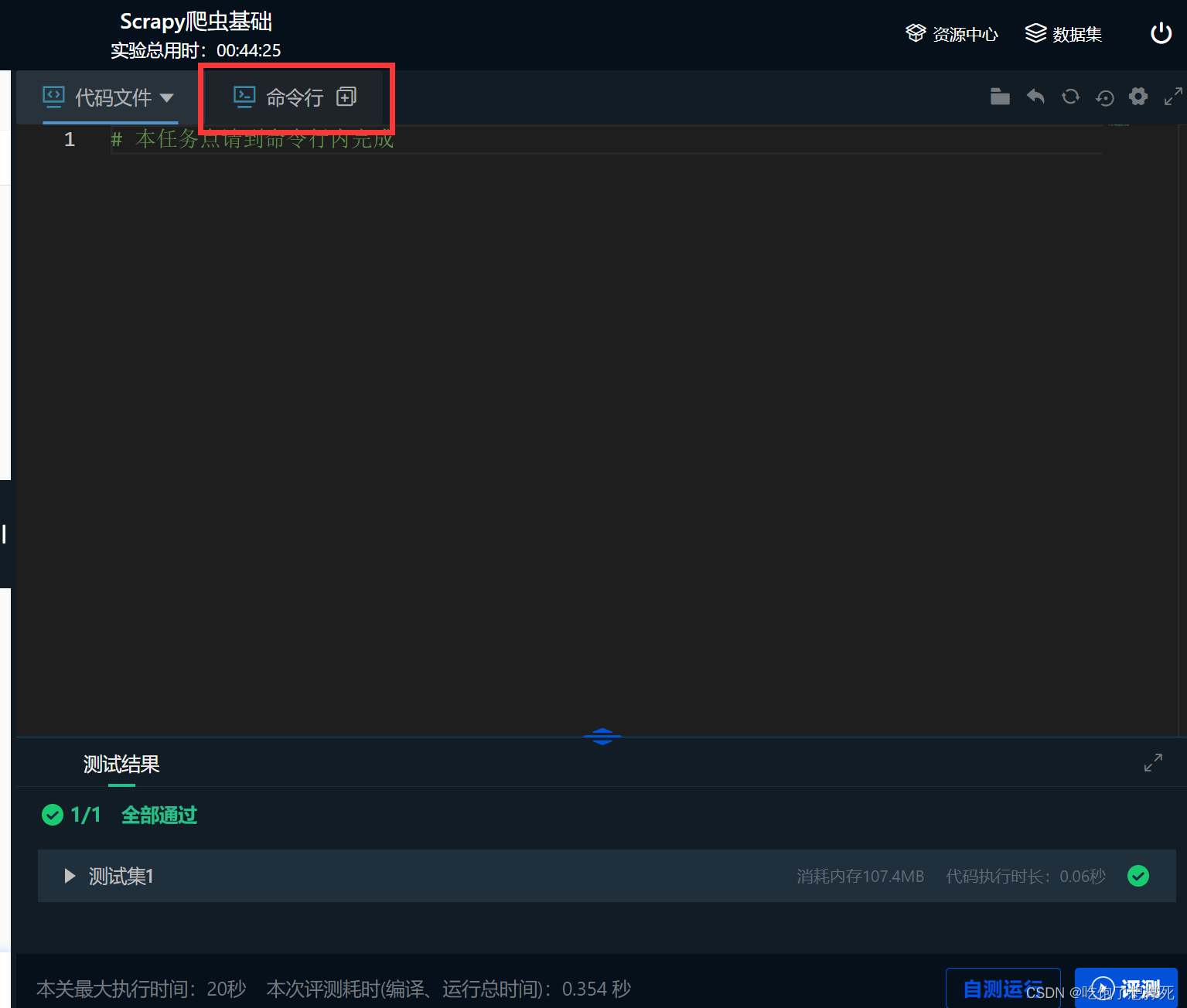

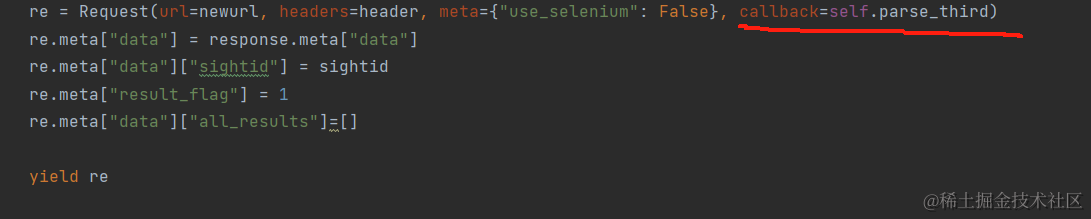

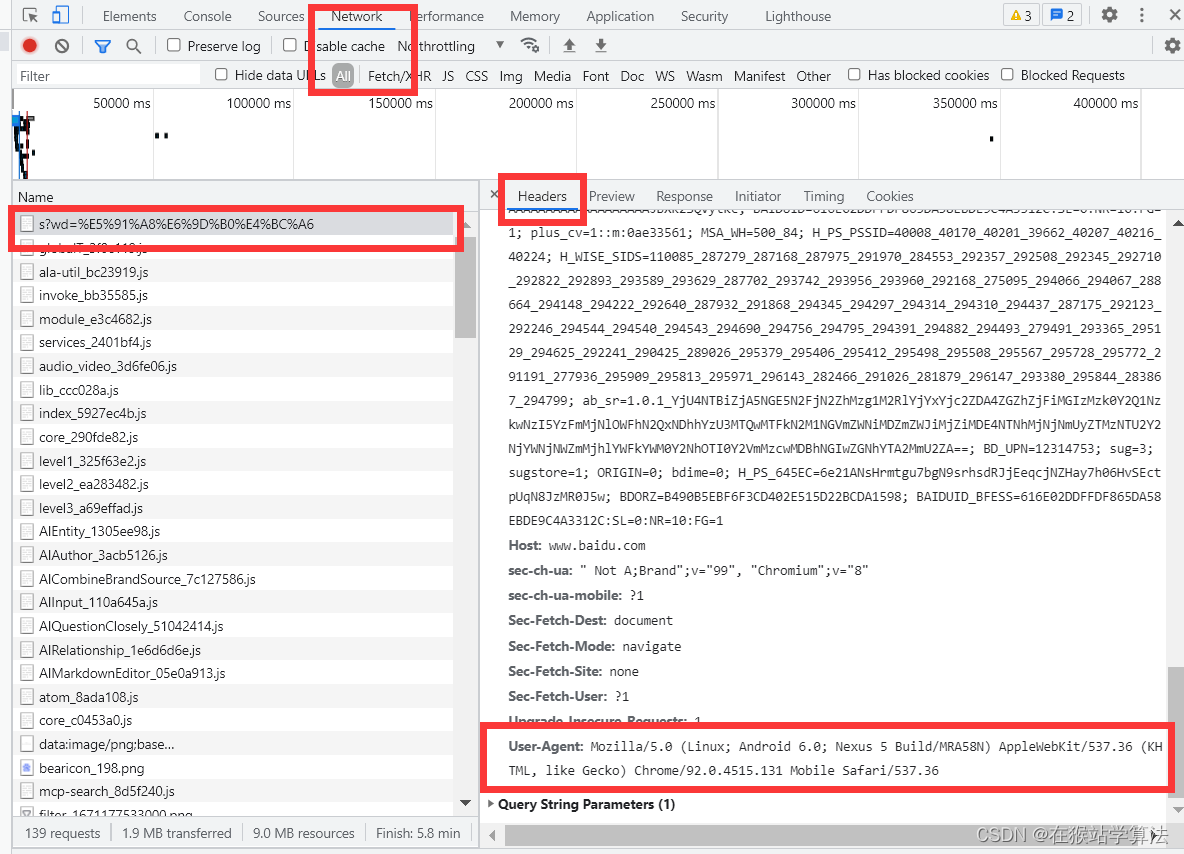

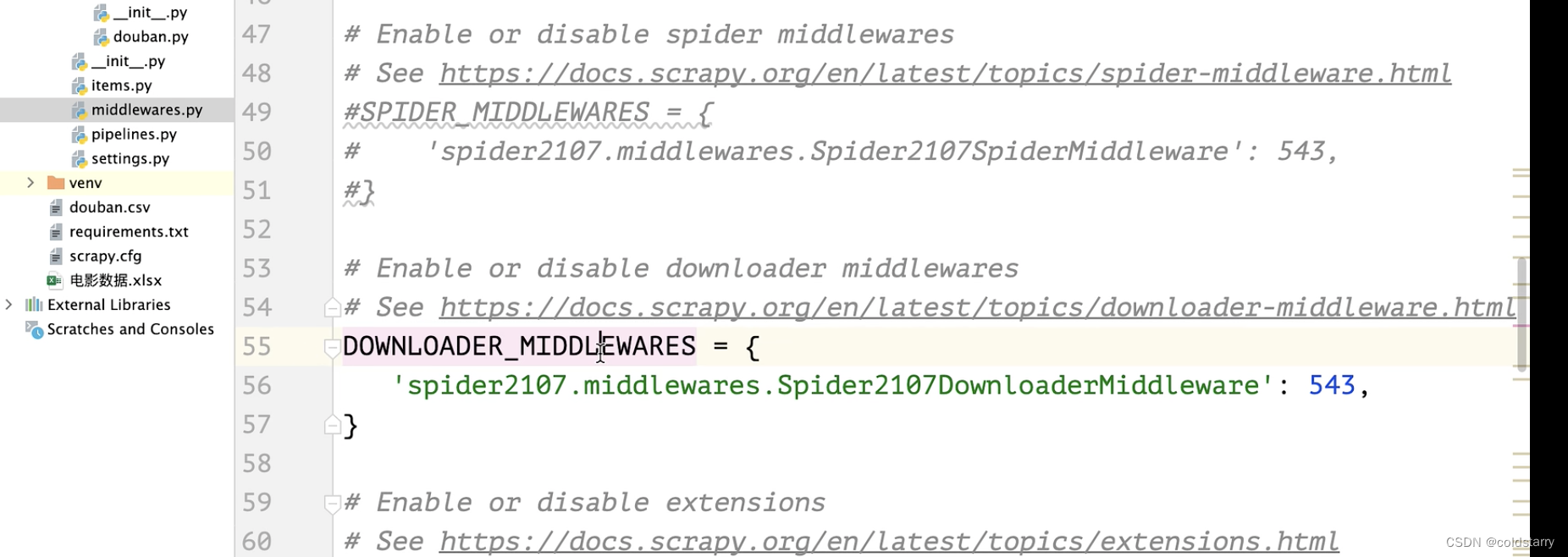

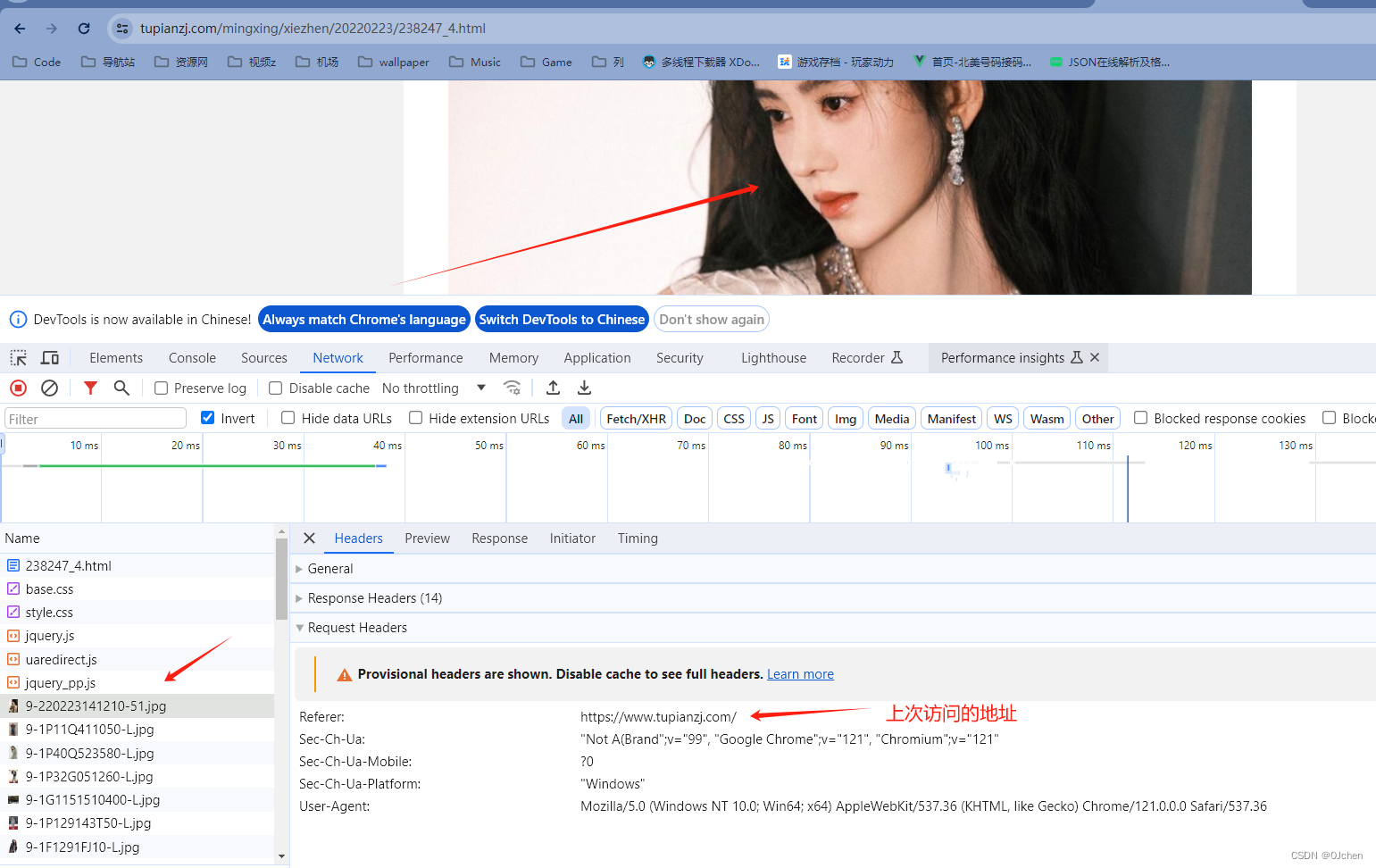

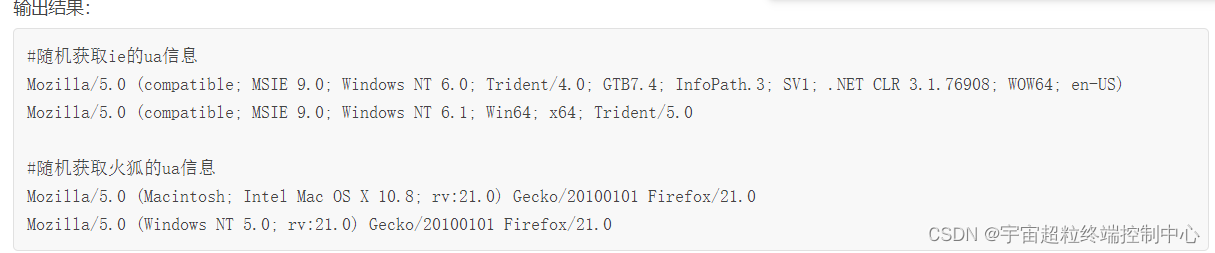

爬虫框架Scrapy(5)DownLoader Middleware 的用法

文章目录四. DownLoader Middleware 的用法1. 使用说明2. 核心方法3. 项目实战四. DownLoader Middleware 的用法

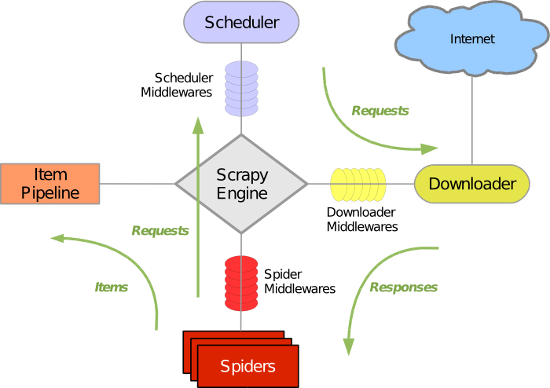

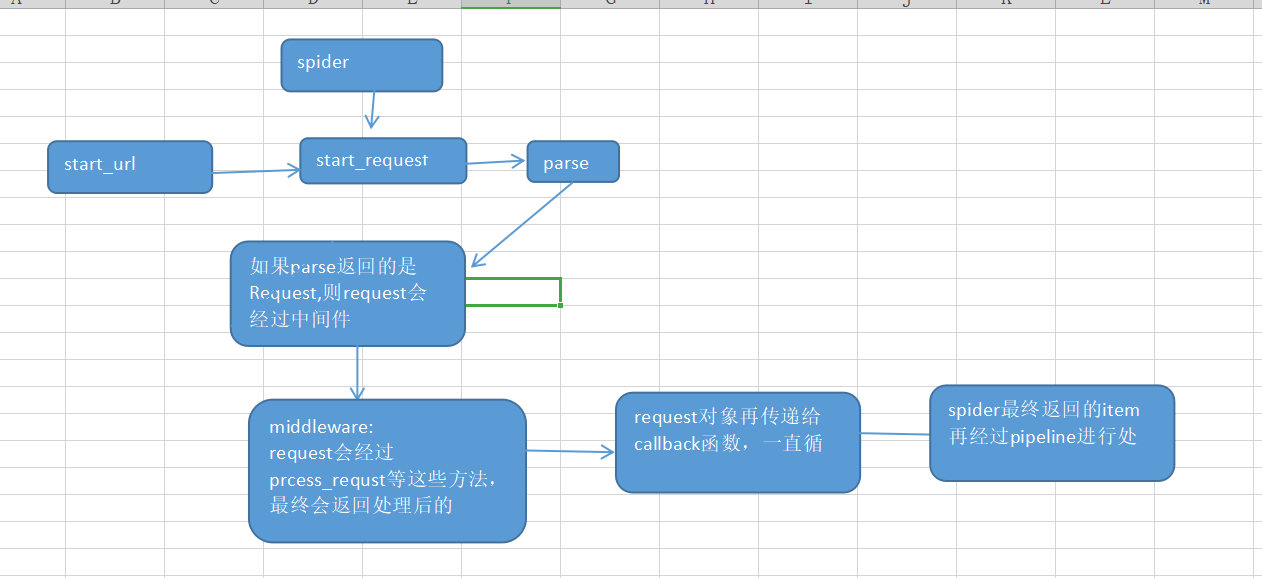

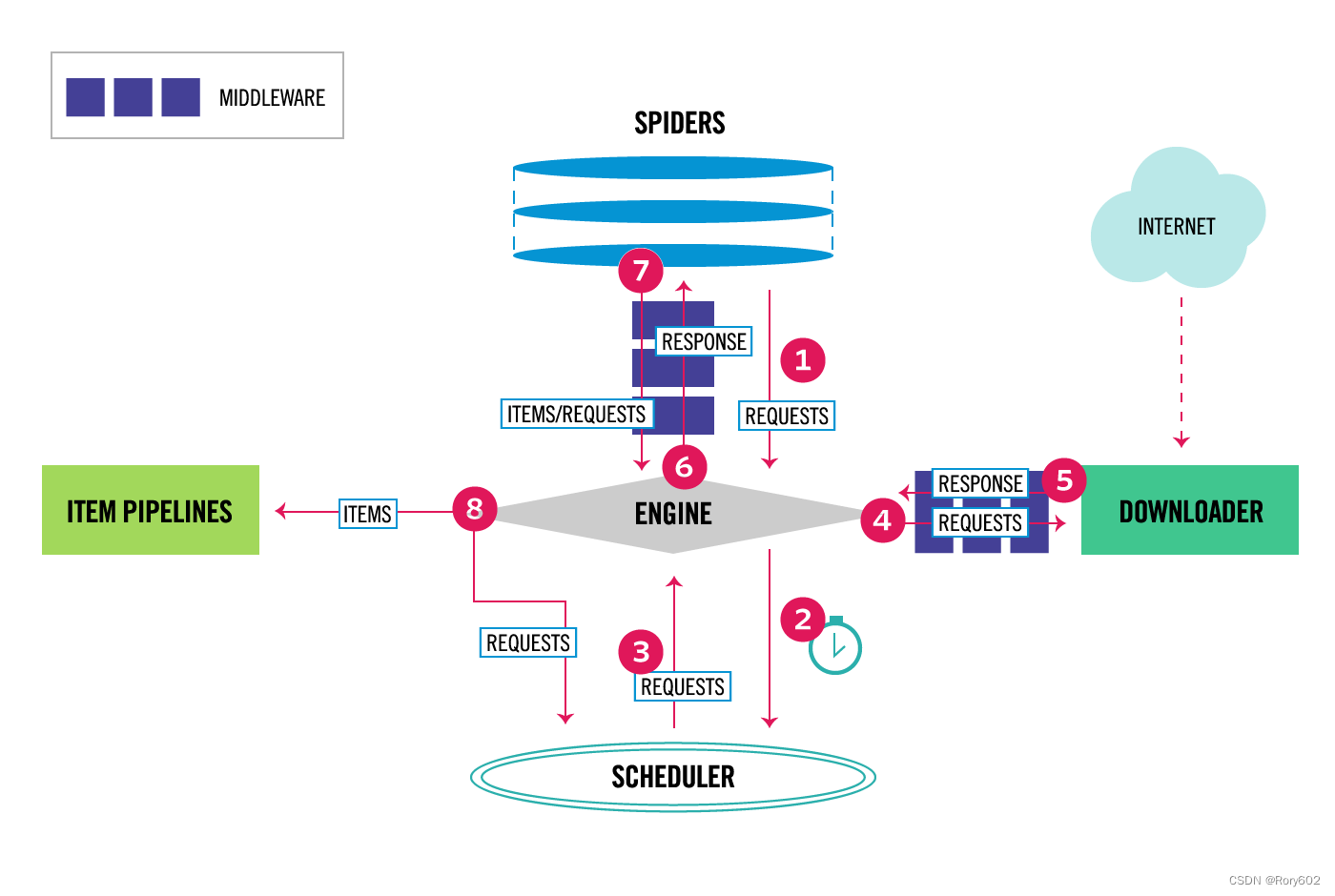

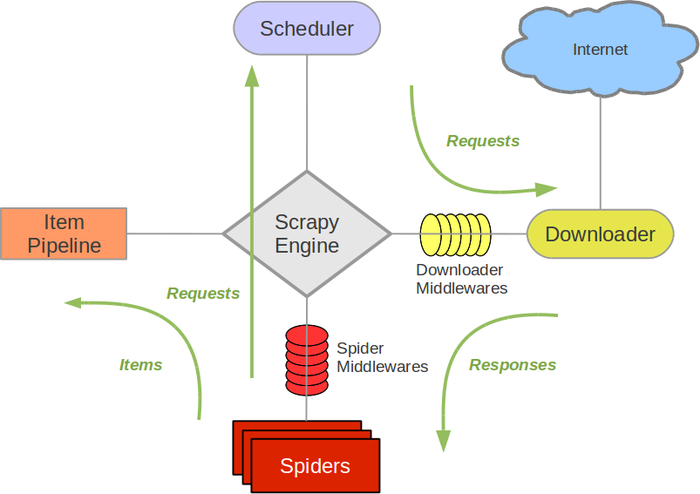

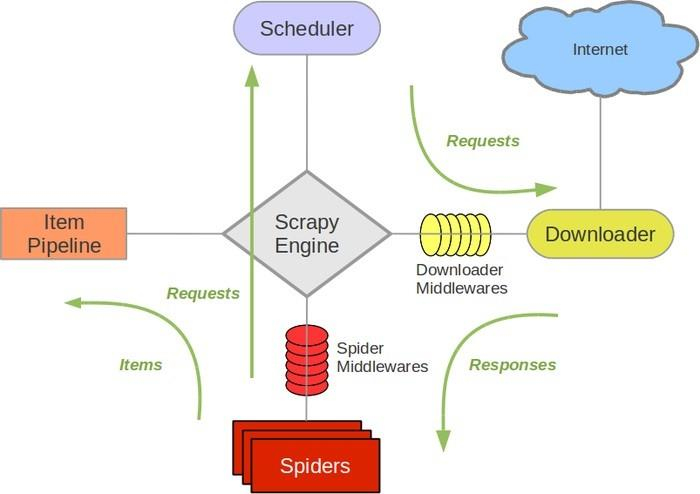

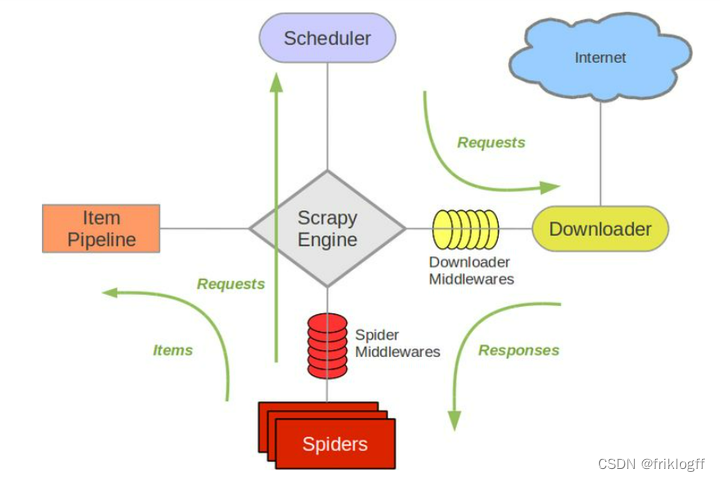

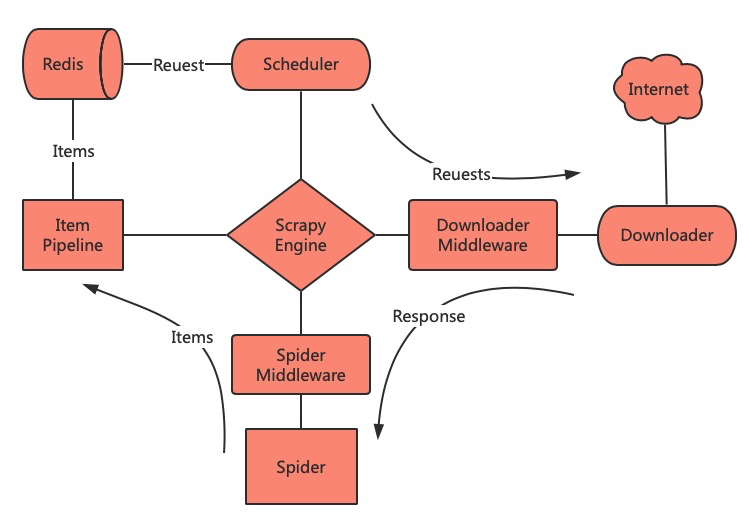

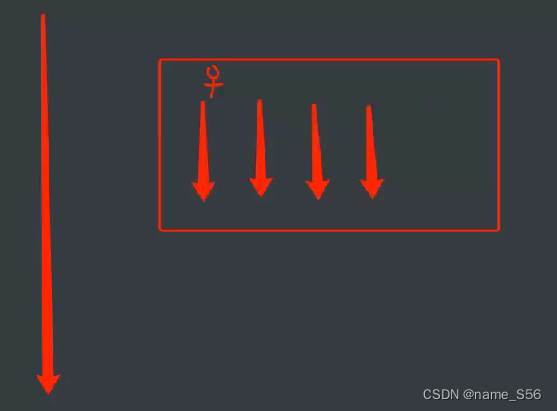

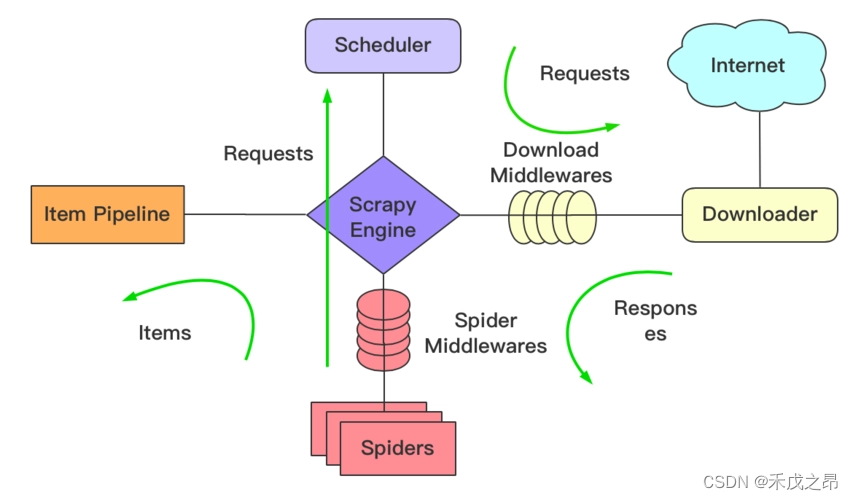

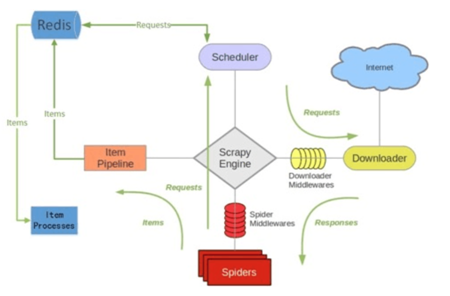

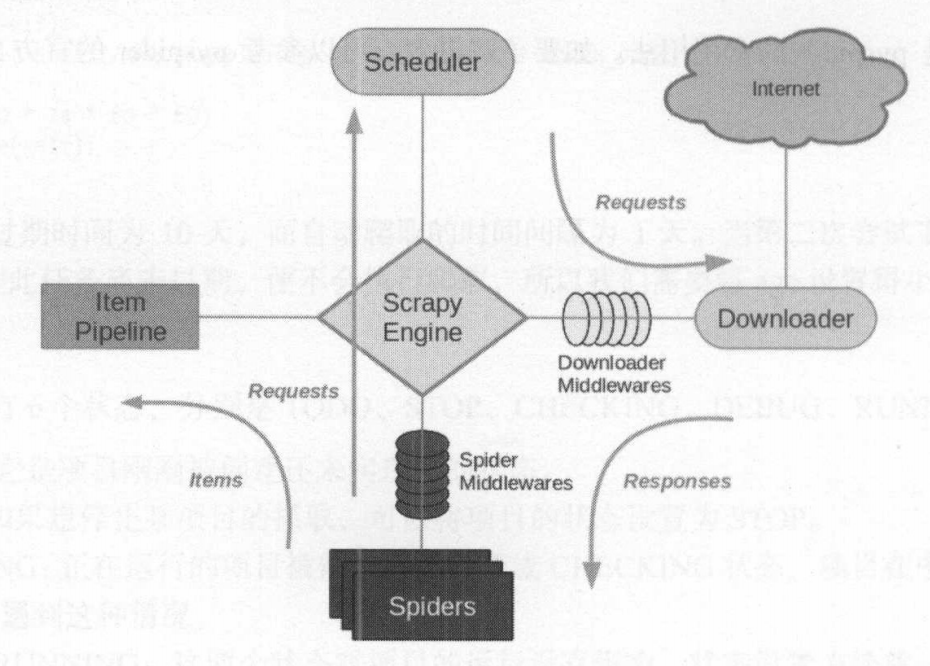

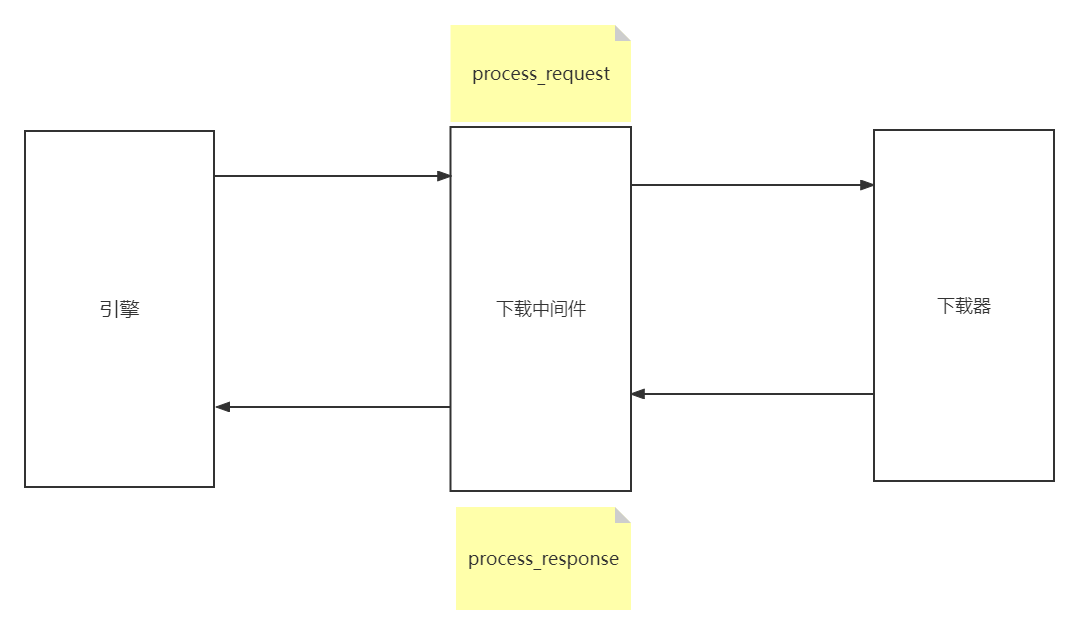

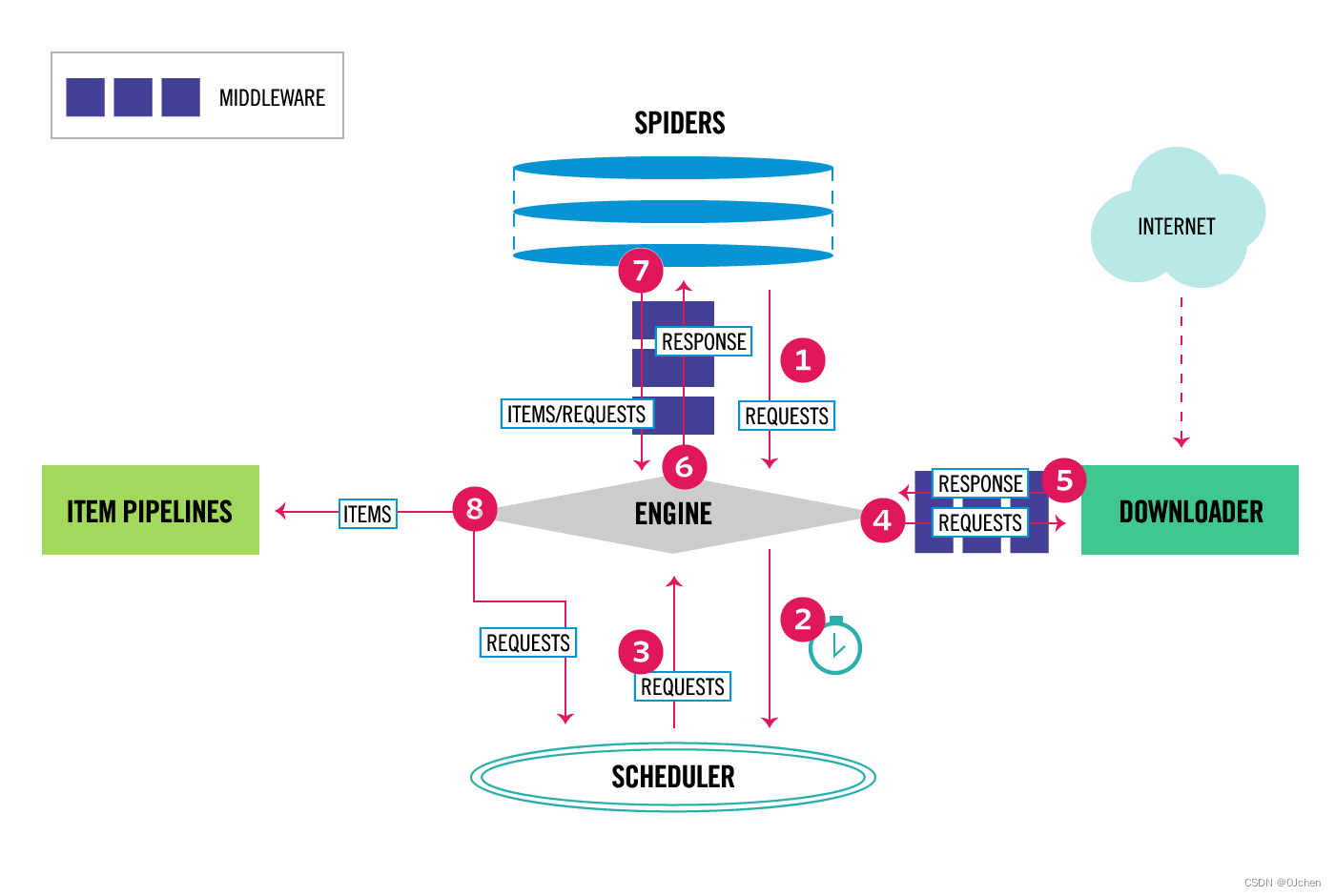

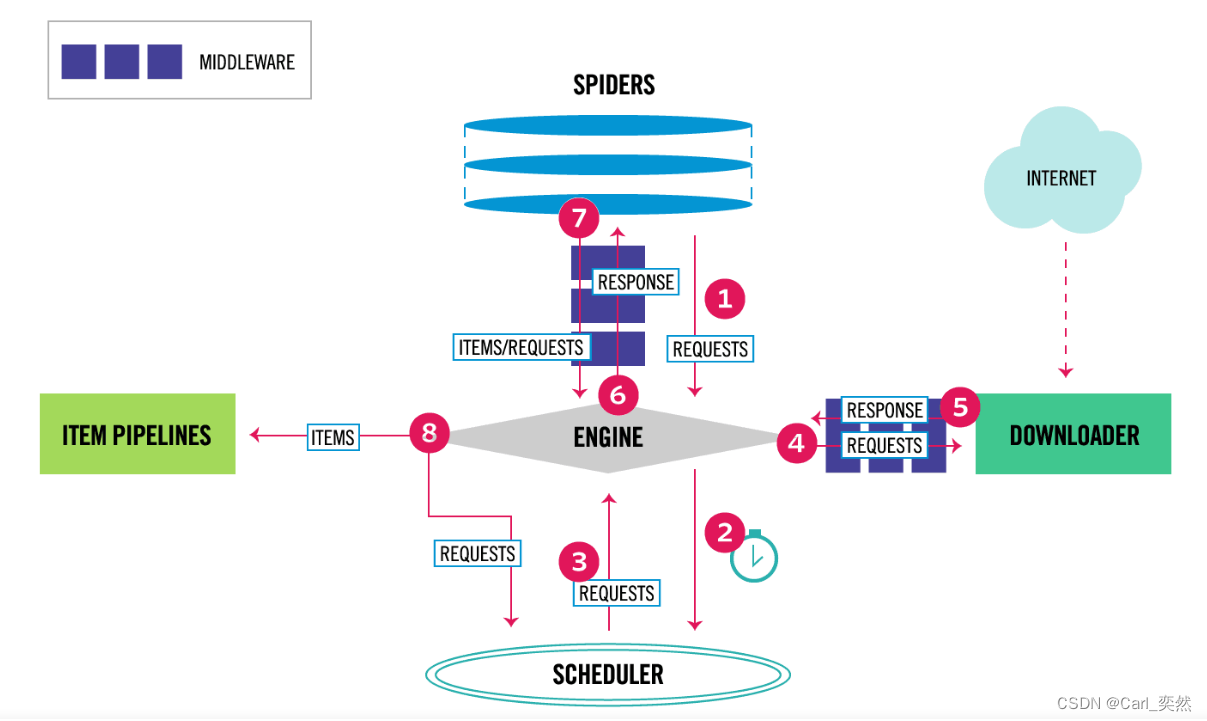

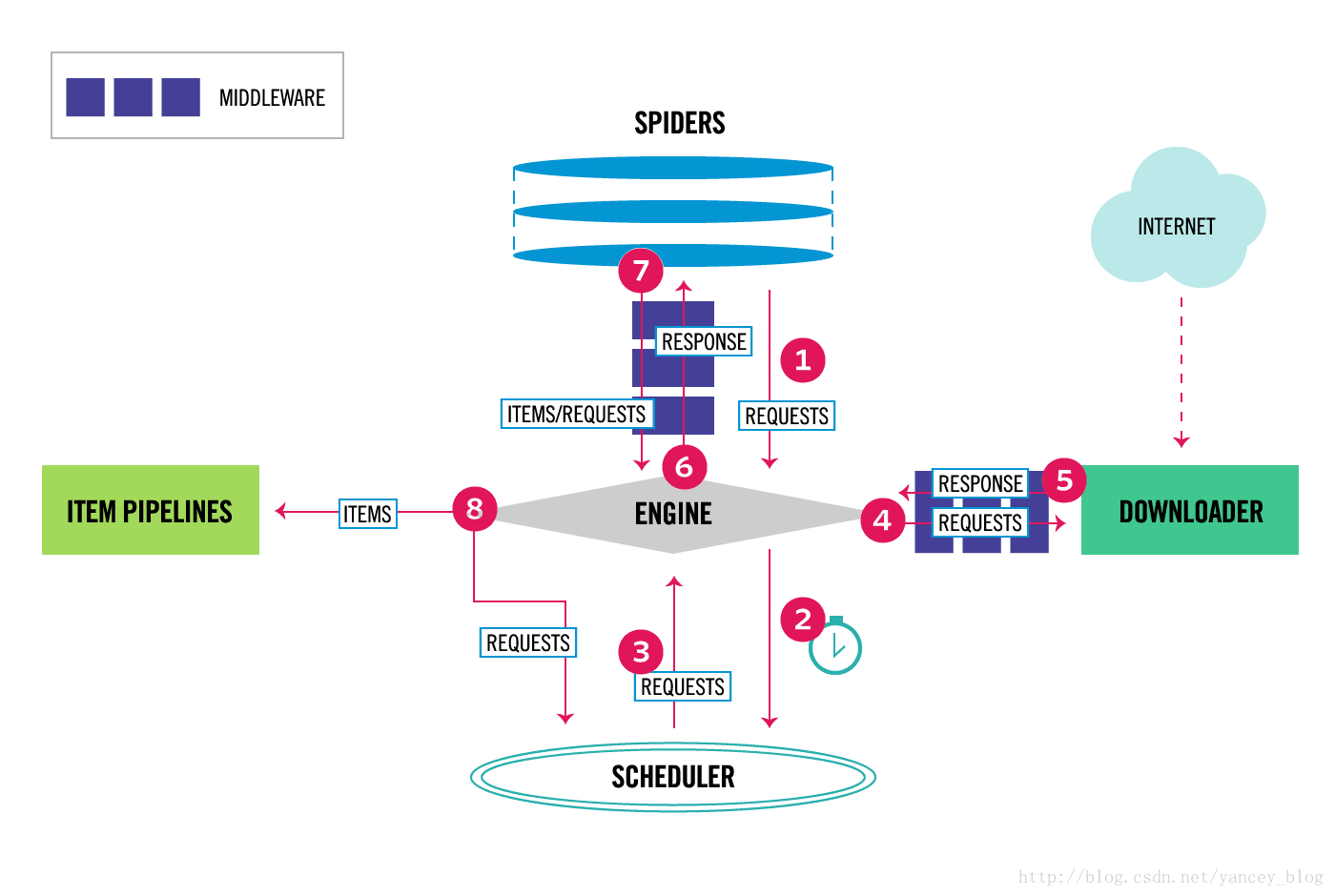

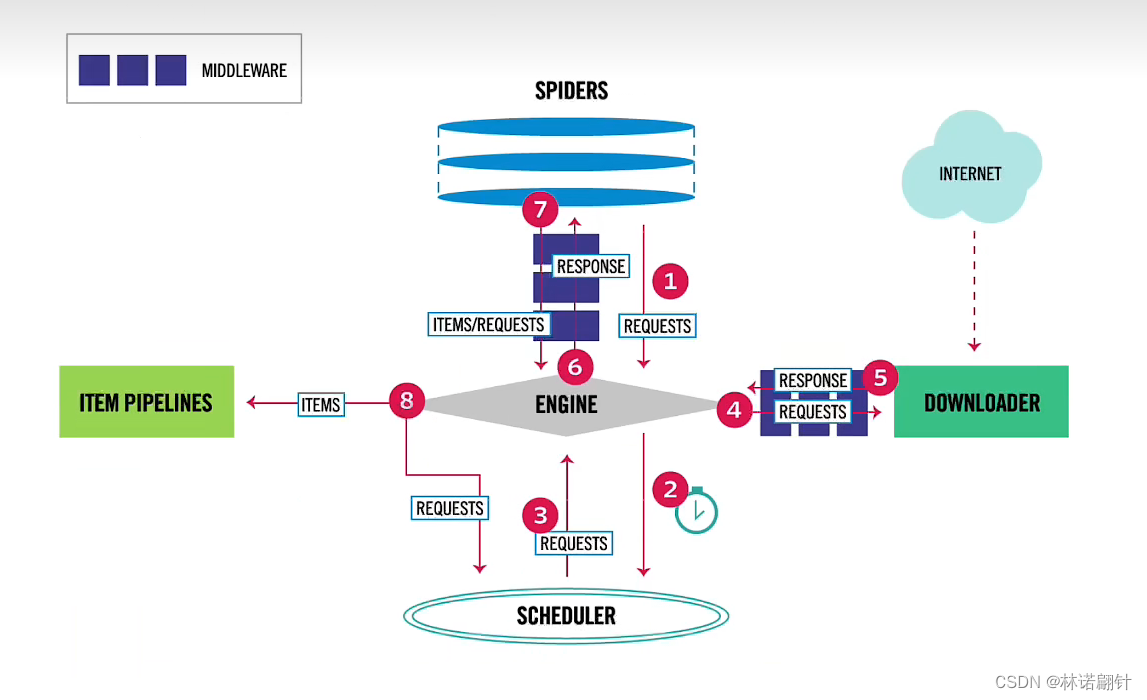

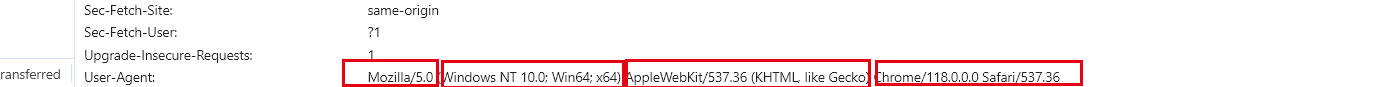

Downloader Middleware 即下载中间件,它是处于 Scrapy 的 Request 和 Response 之间的处理模块。Scheduler 从队列中拿出一个 Request 发送给 Downlo…

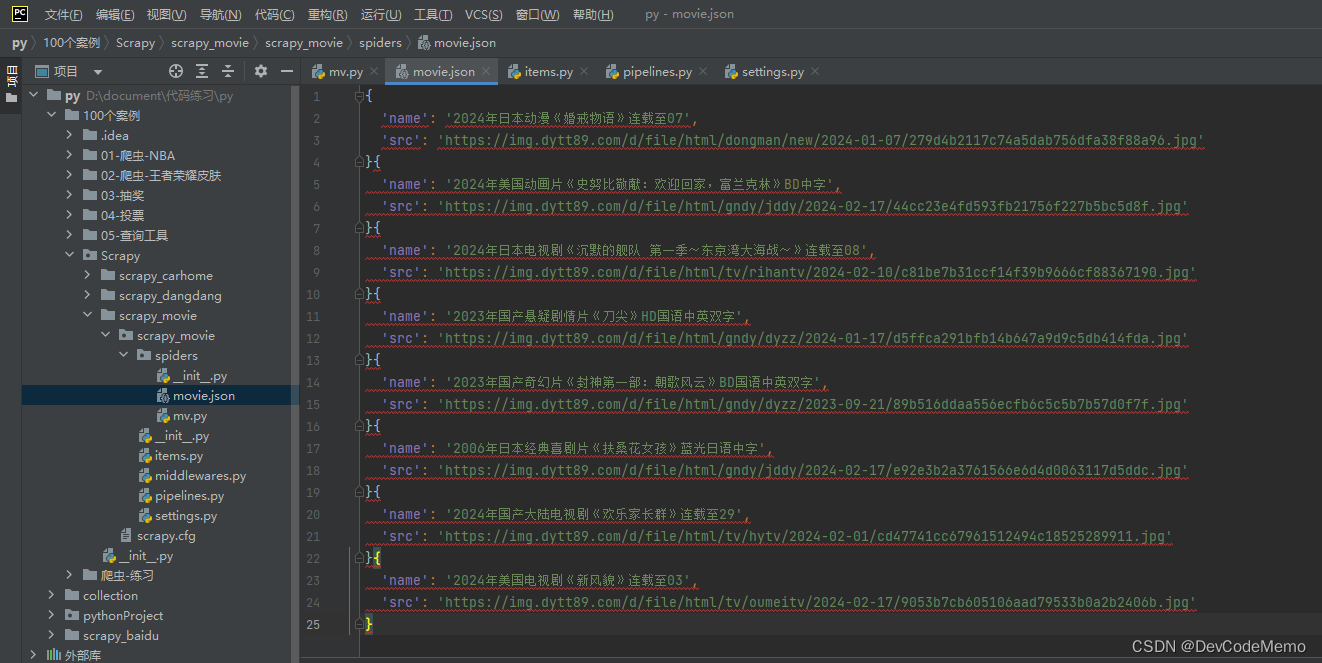

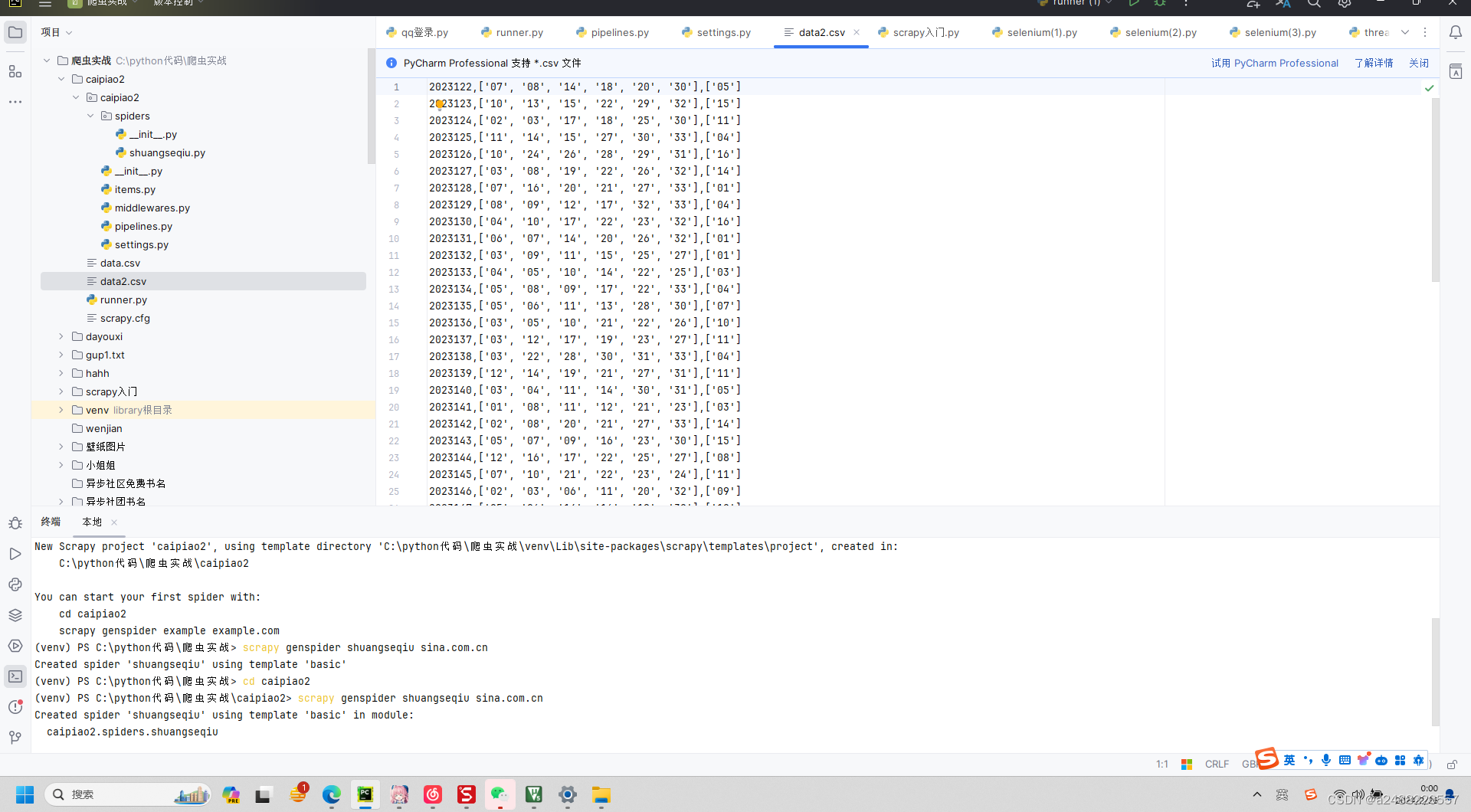

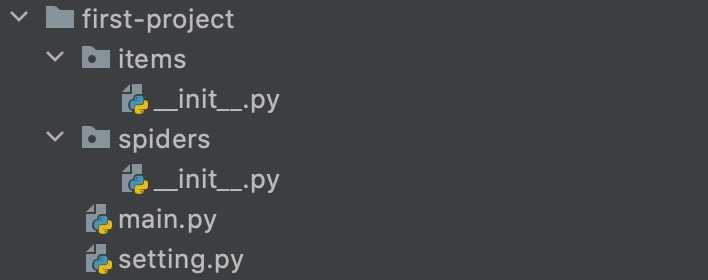

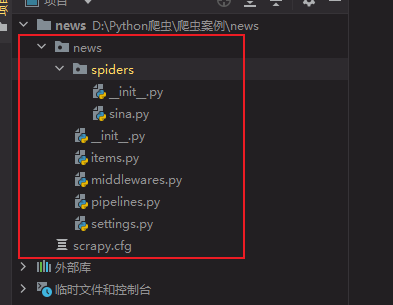

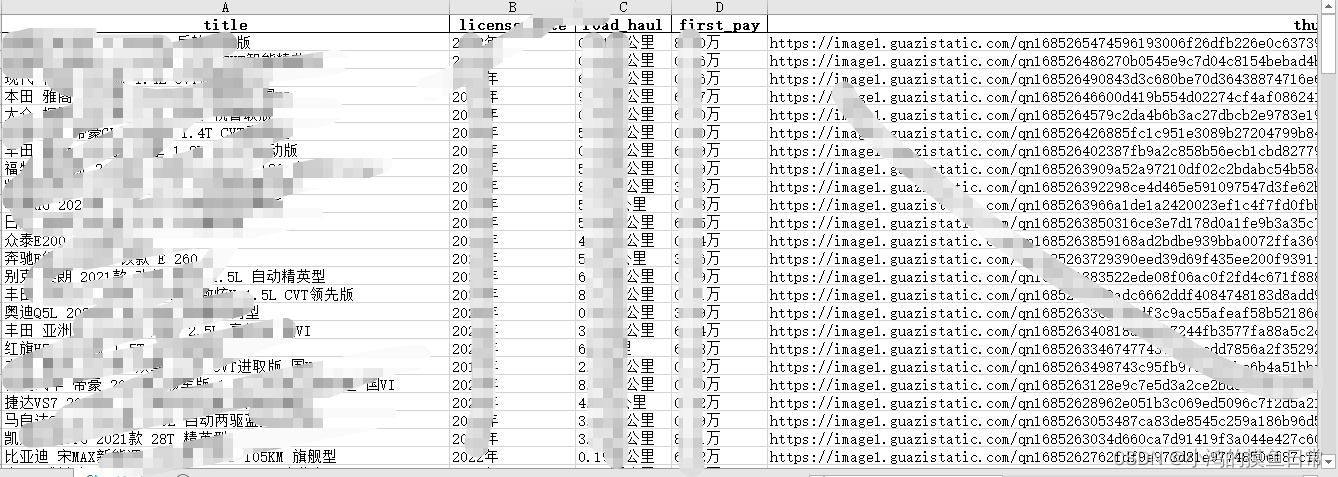

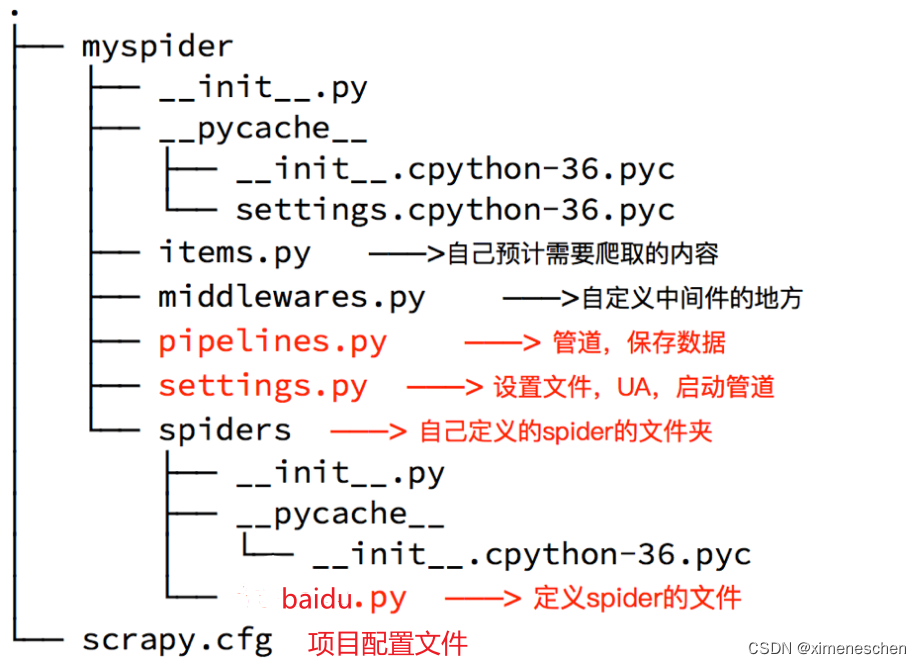

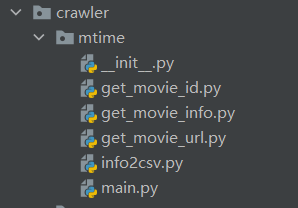

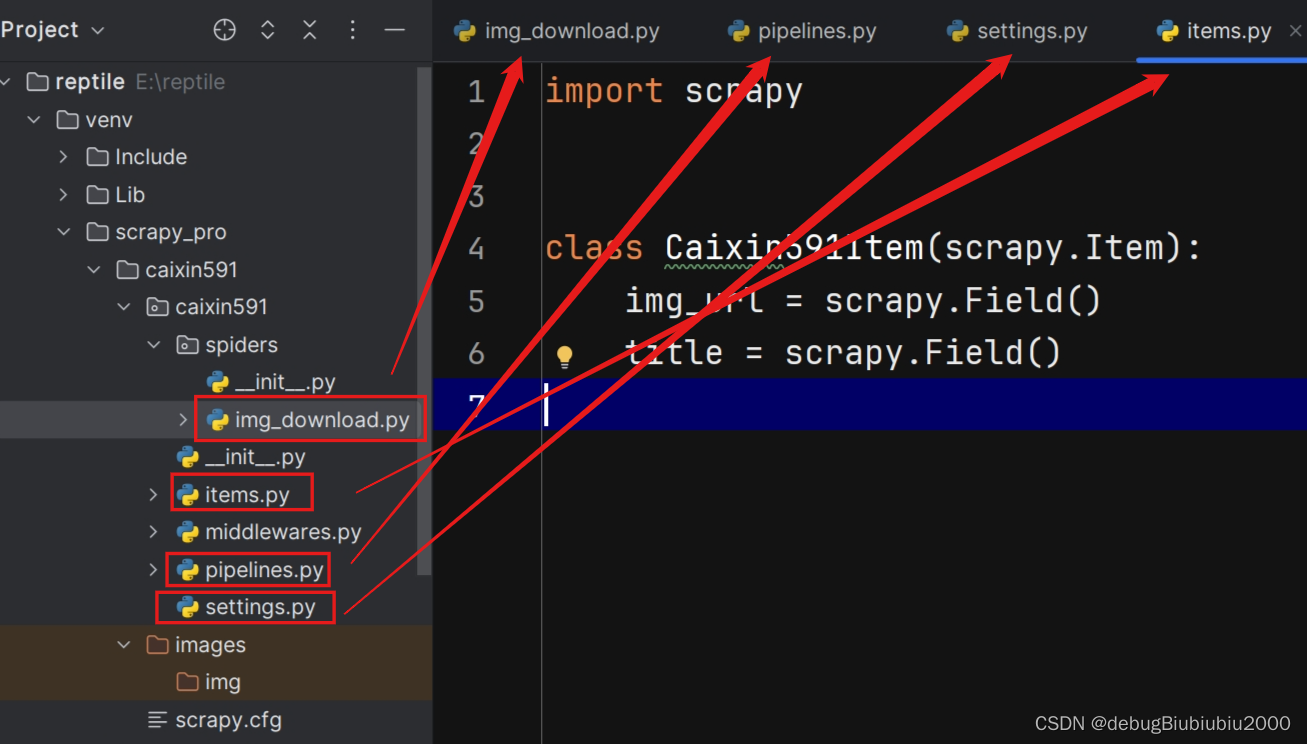

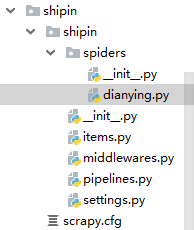

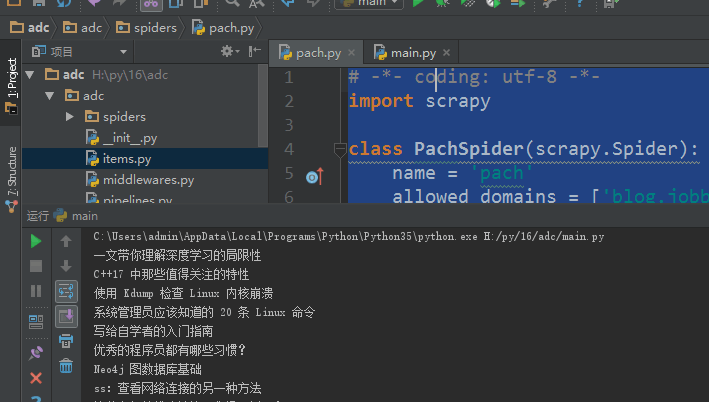

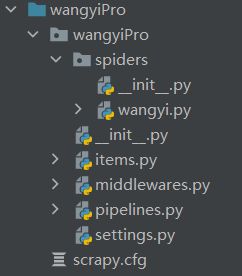

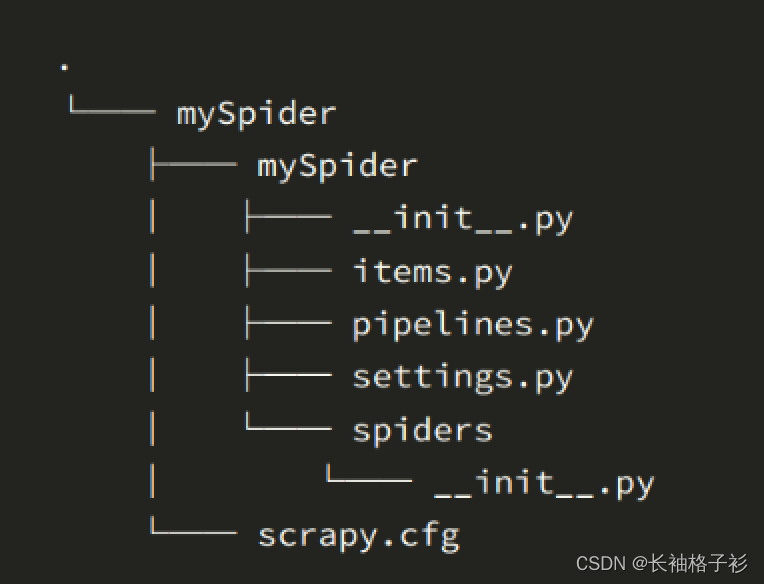

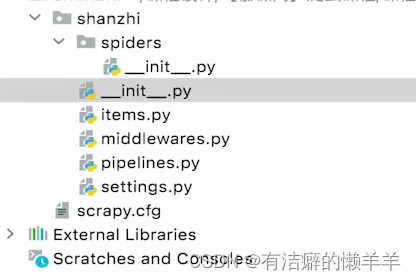

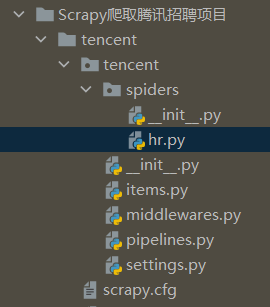

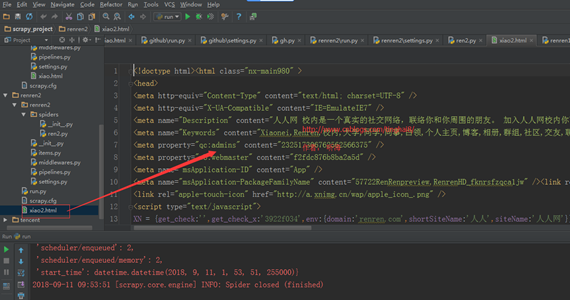

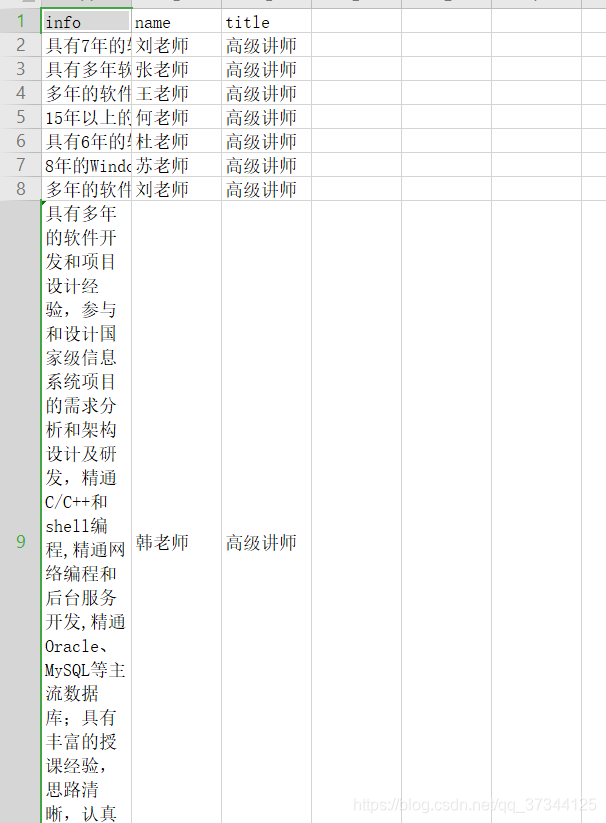

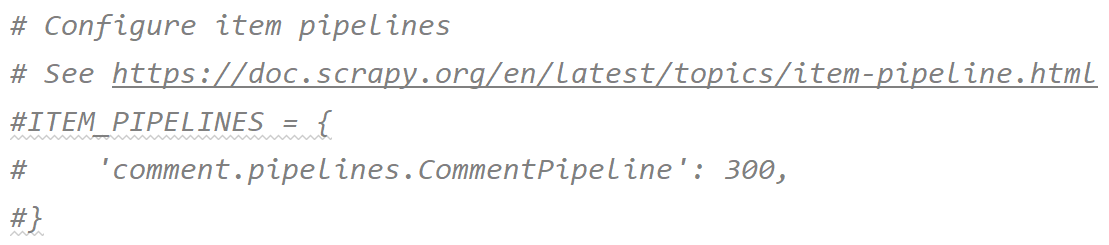

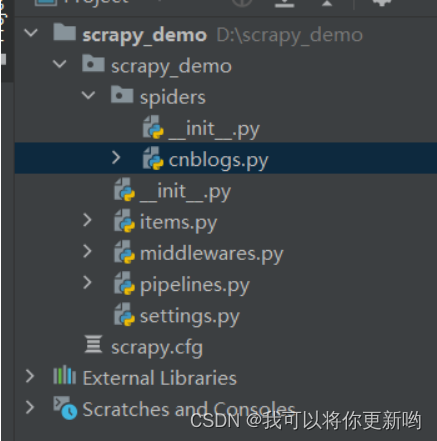

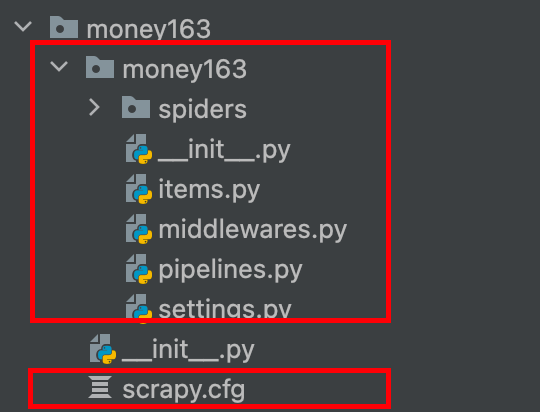

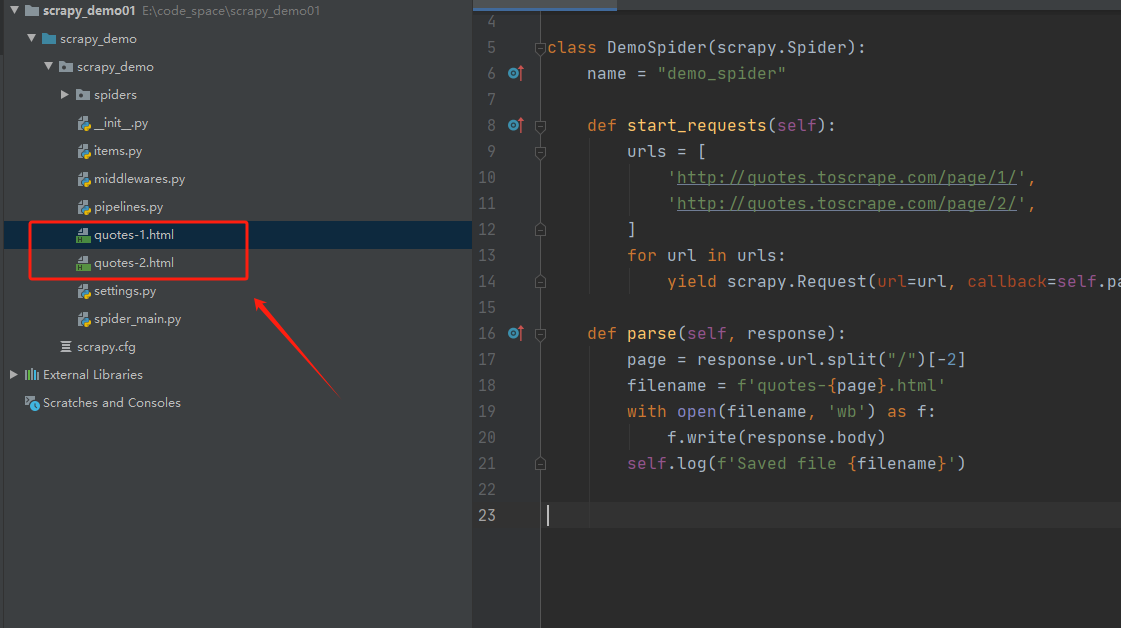

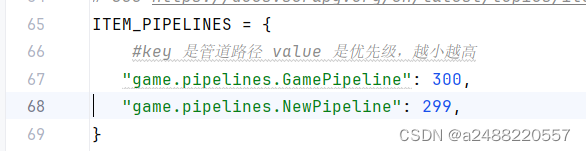

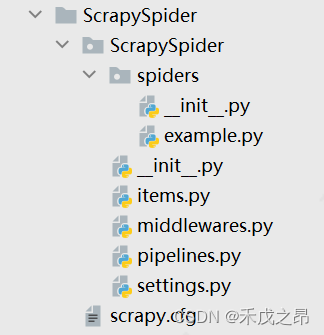

爬虫框架Scrapy(3)使用Item封装数据

文章目录使用 Item 封装数据(一)Item 基类1. 自定义 Item2. 拓展 Item(二)Field 元数据(三)在多个爬虫里使用 Item使用 Item 封装数据

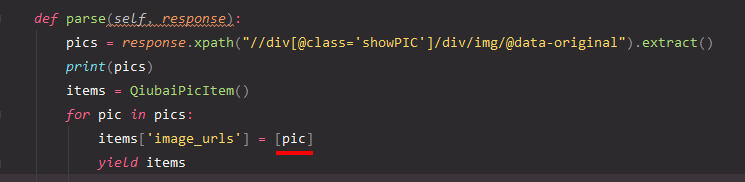

我们首先来看上一篇文章在最后所写的那个实例中的 spider.py &#x…

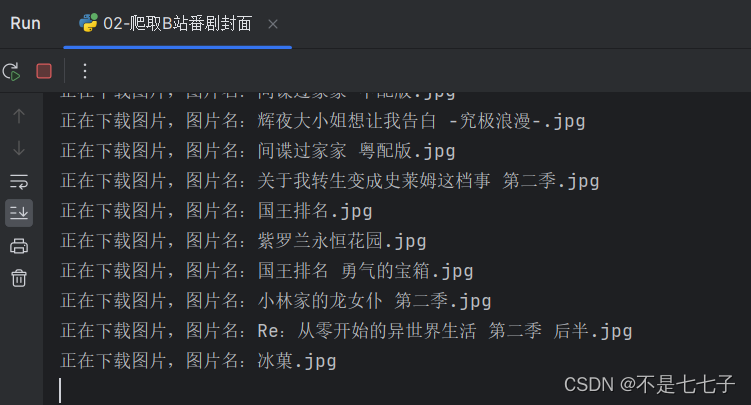

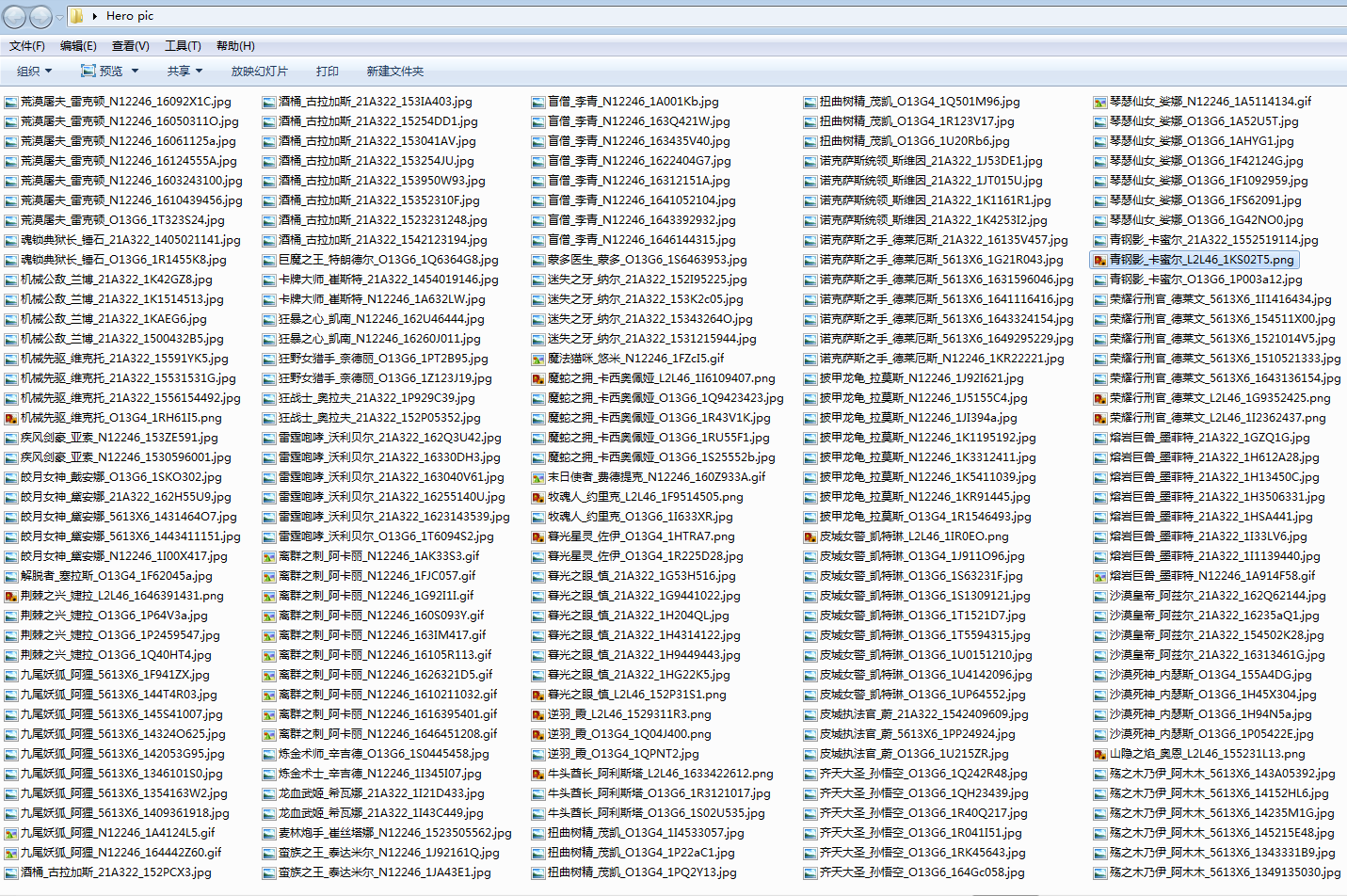

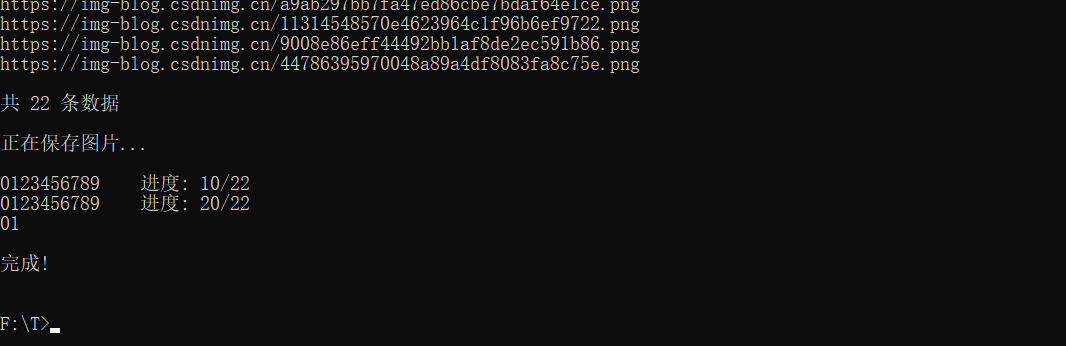

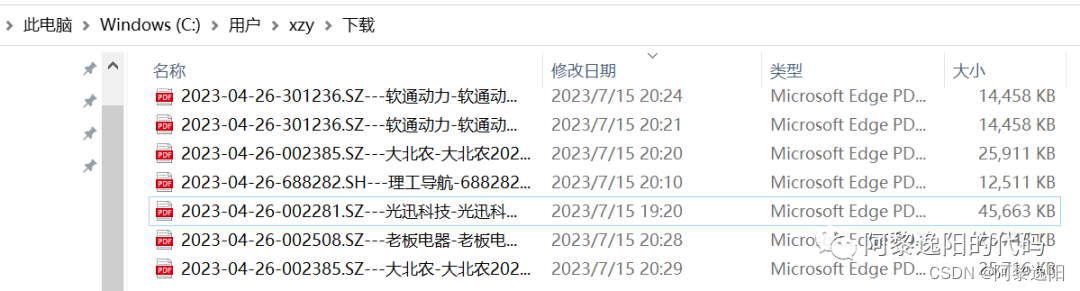

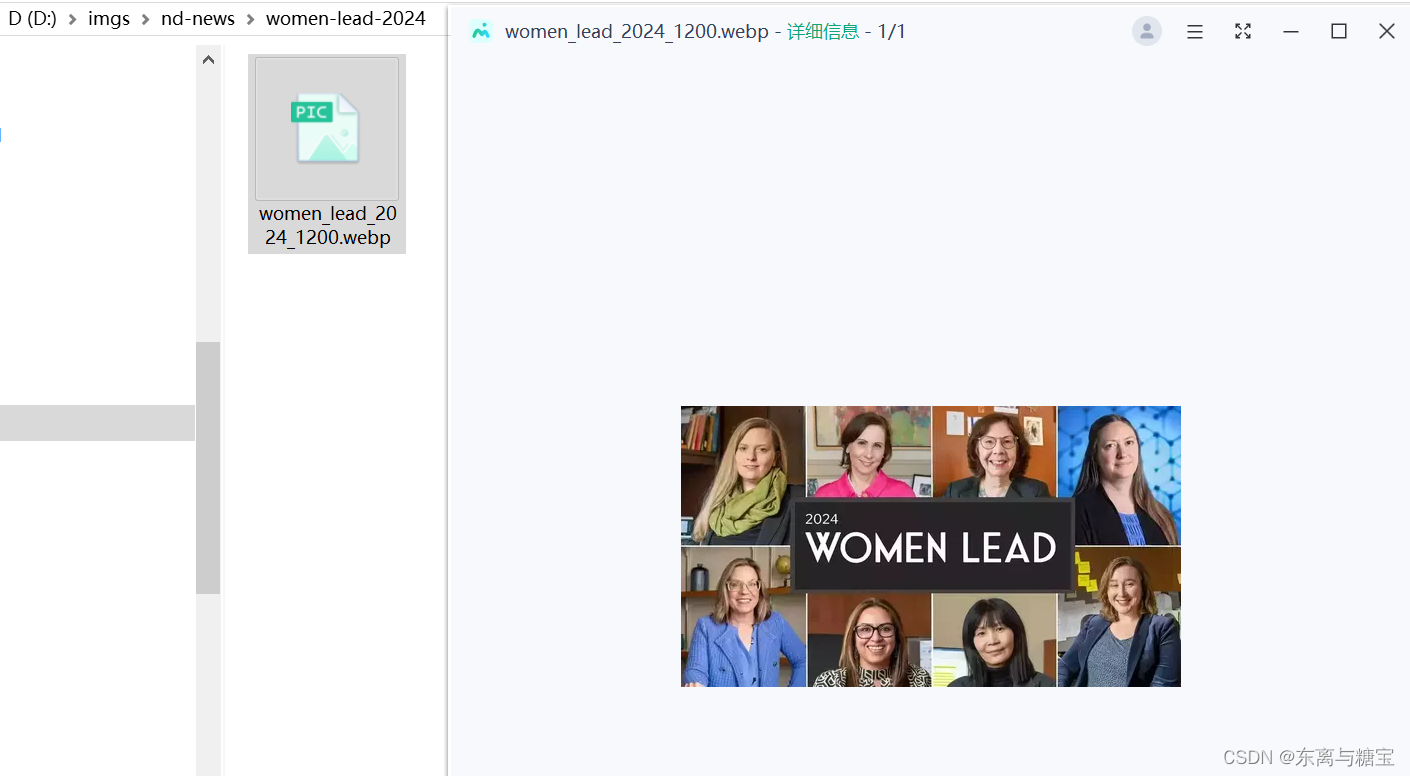

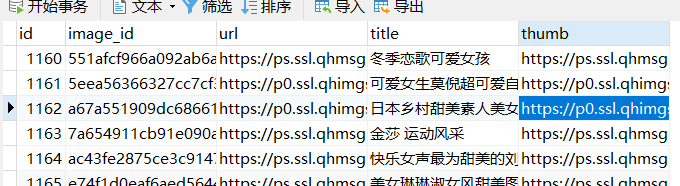

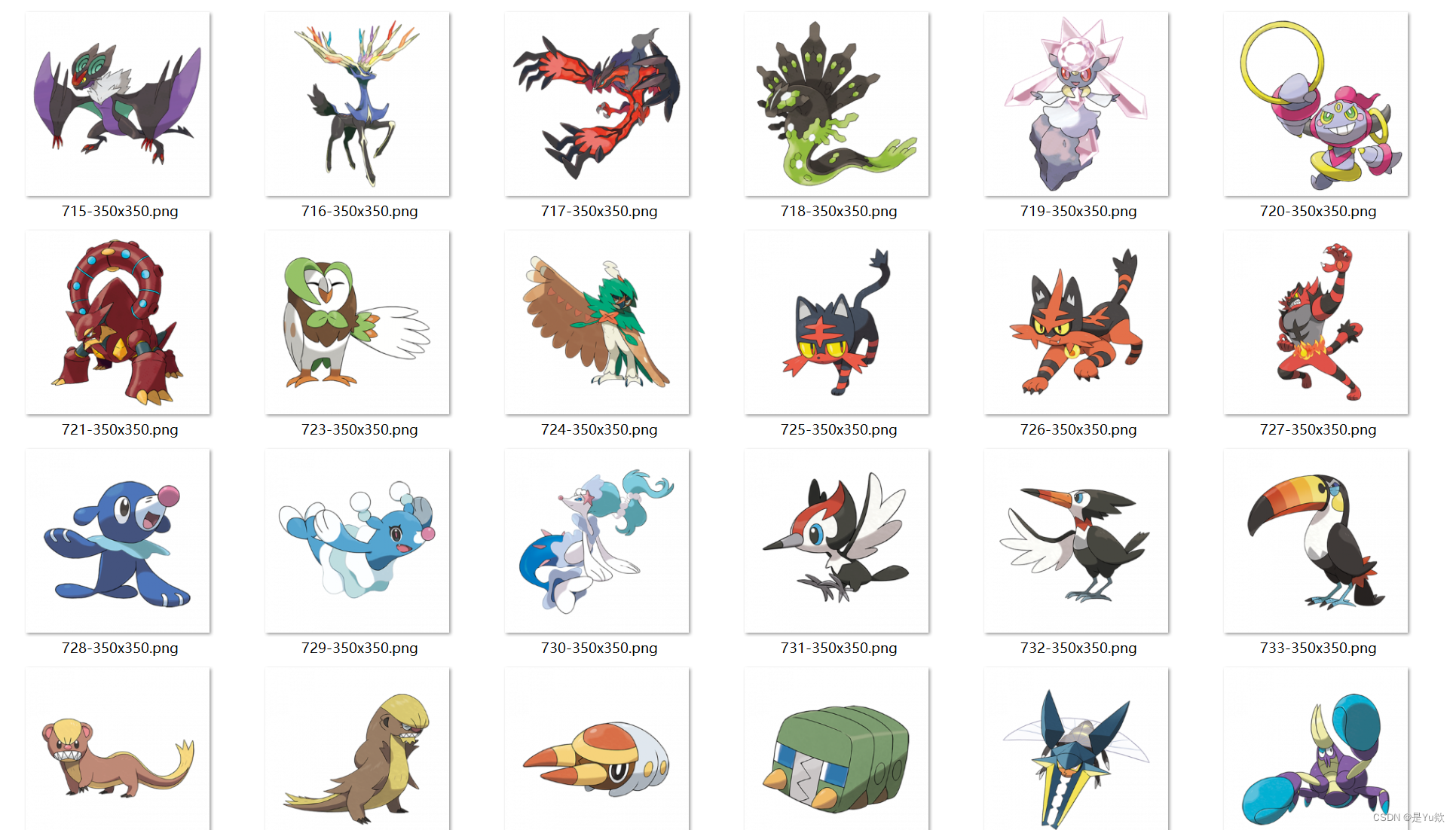

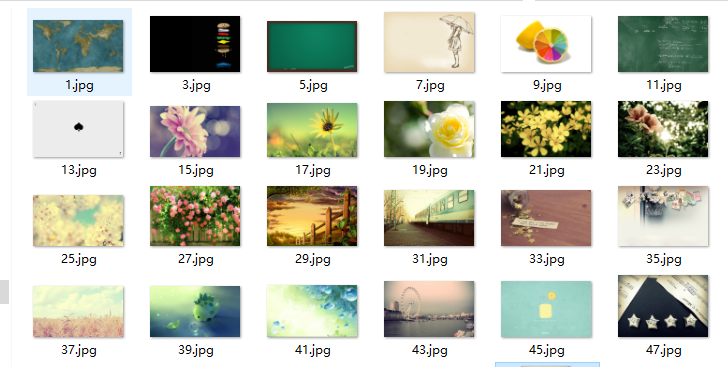

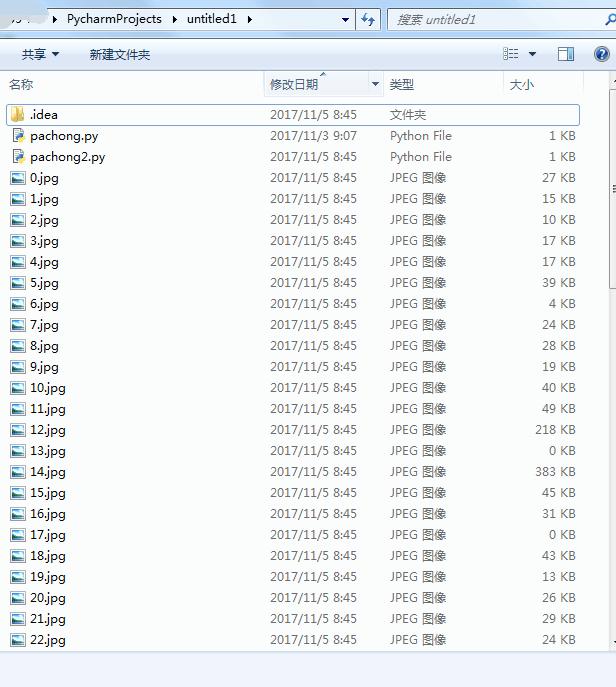

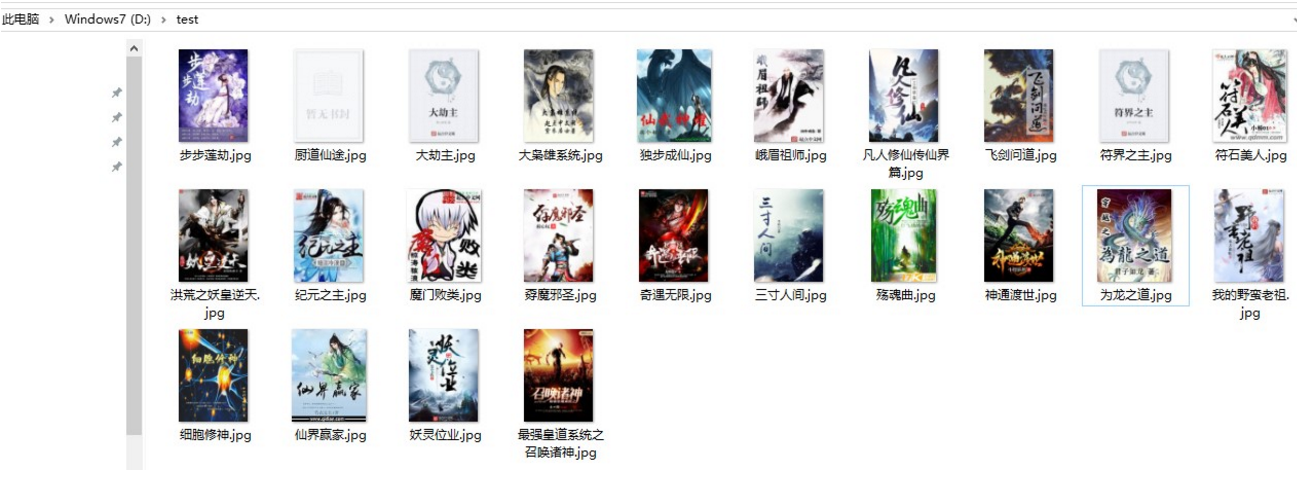

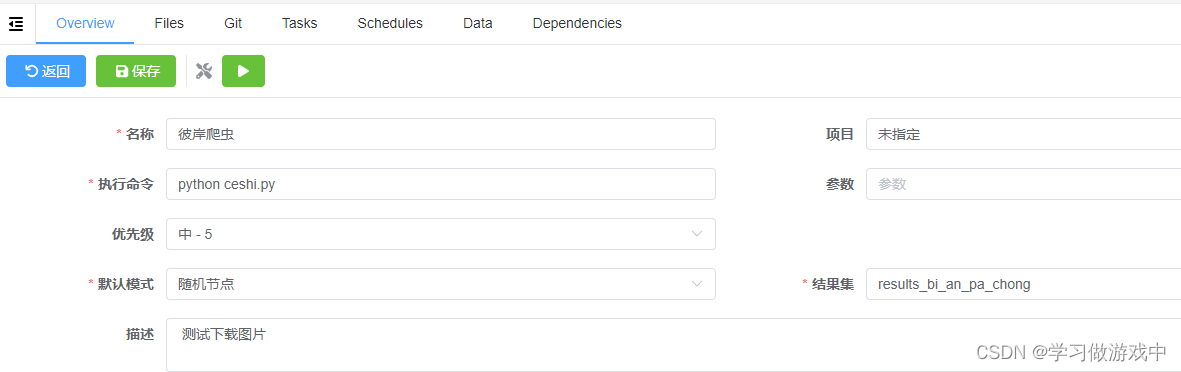

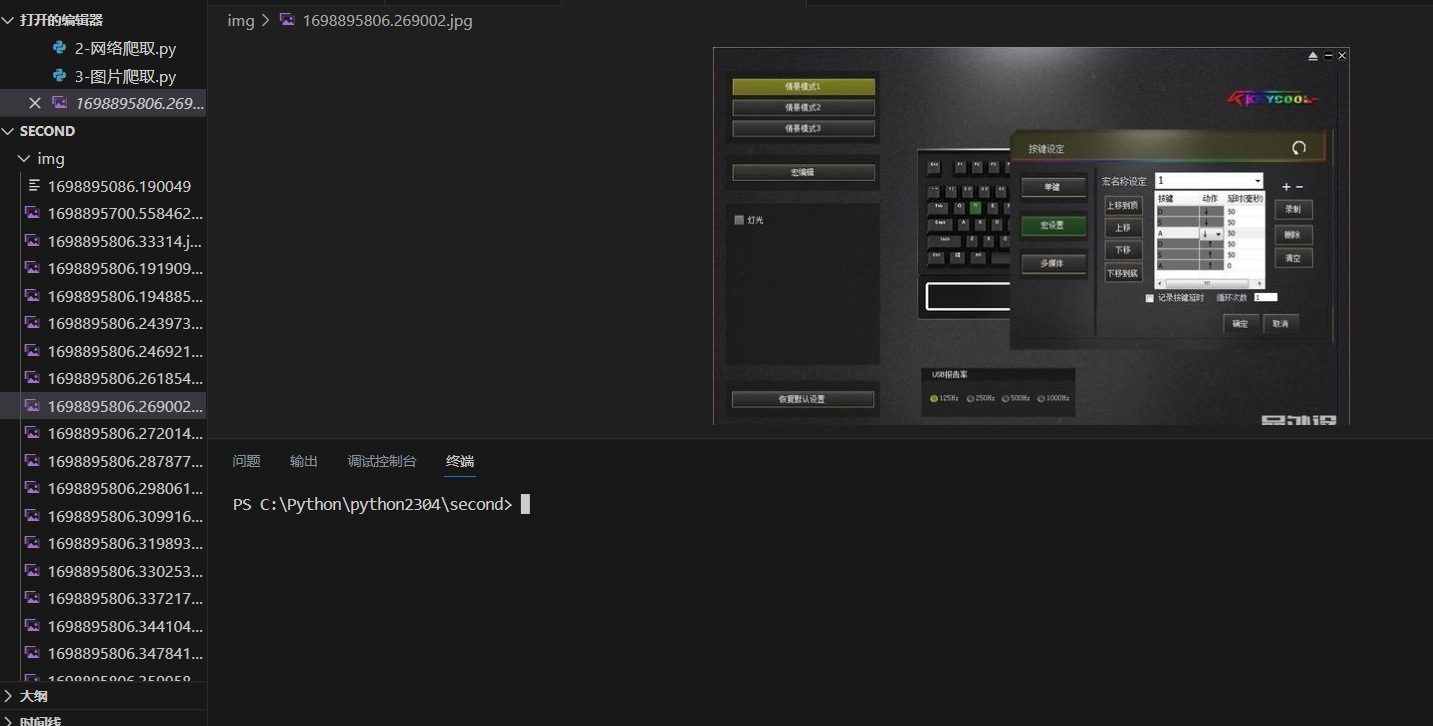

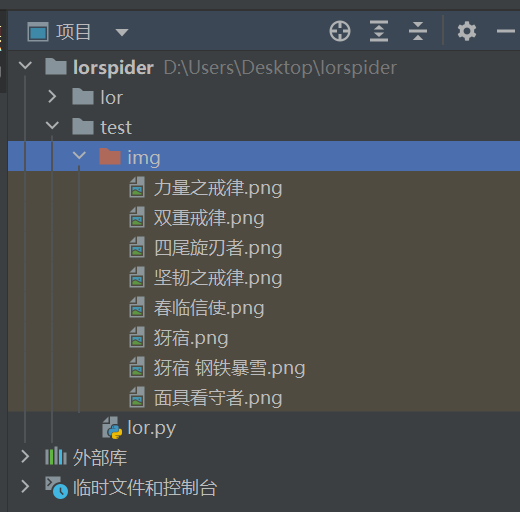

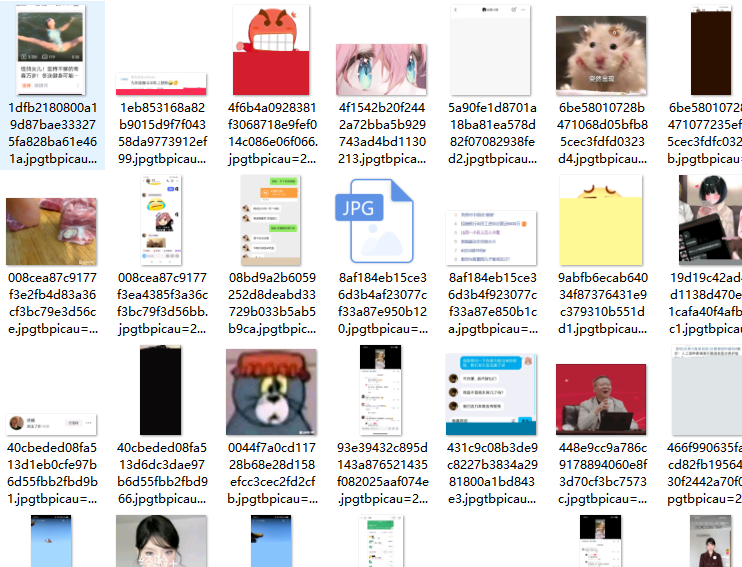

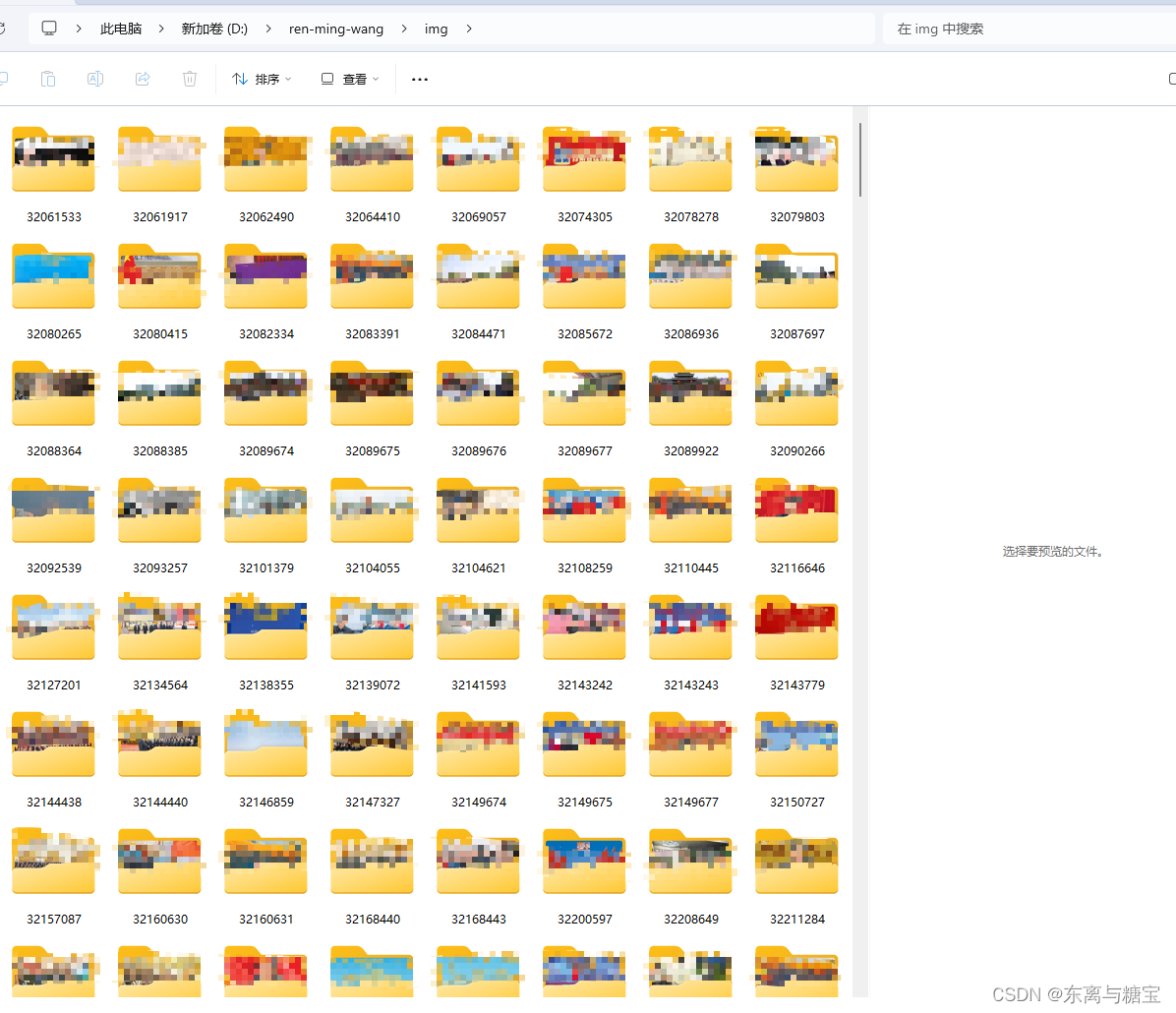

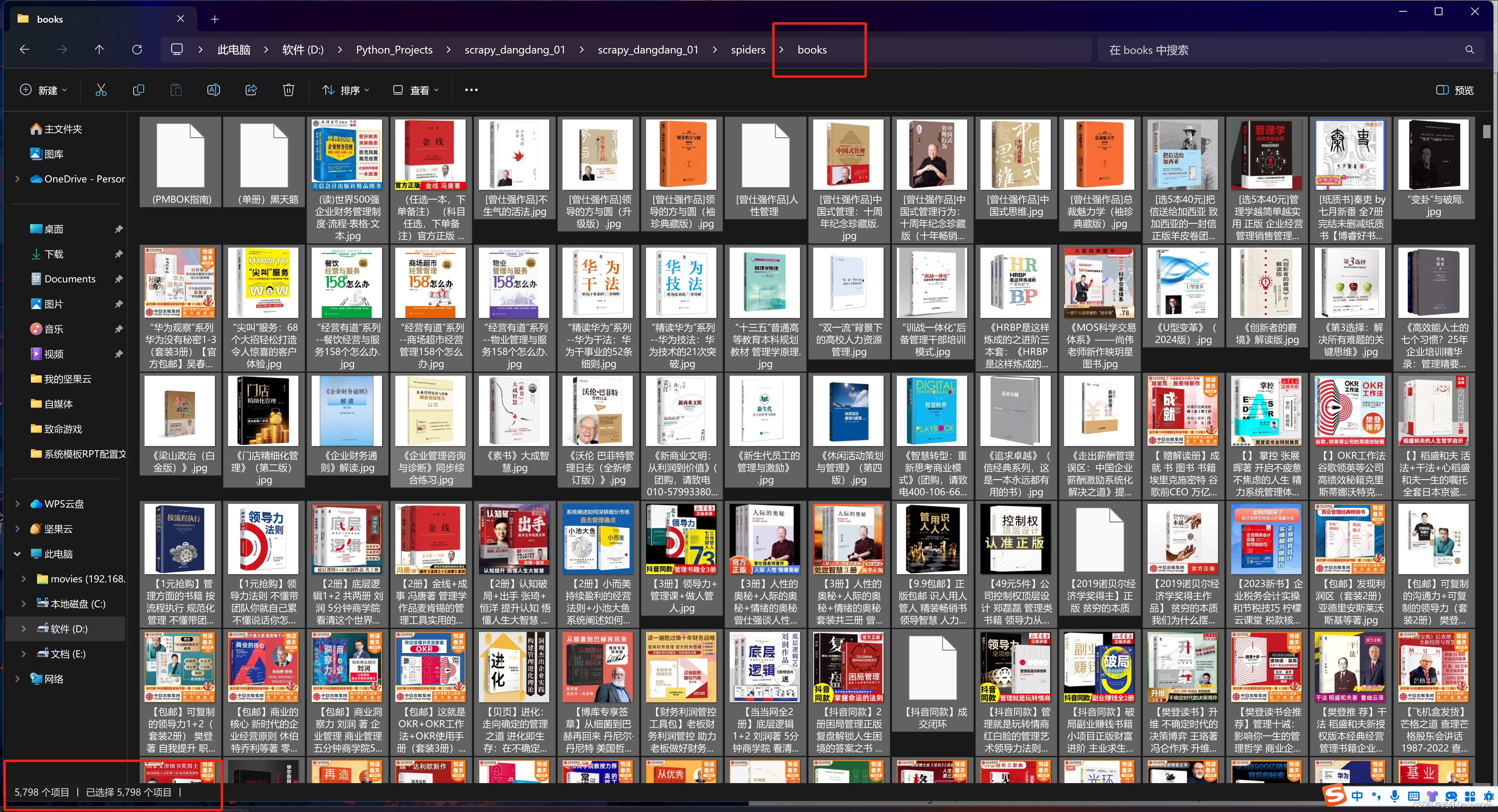

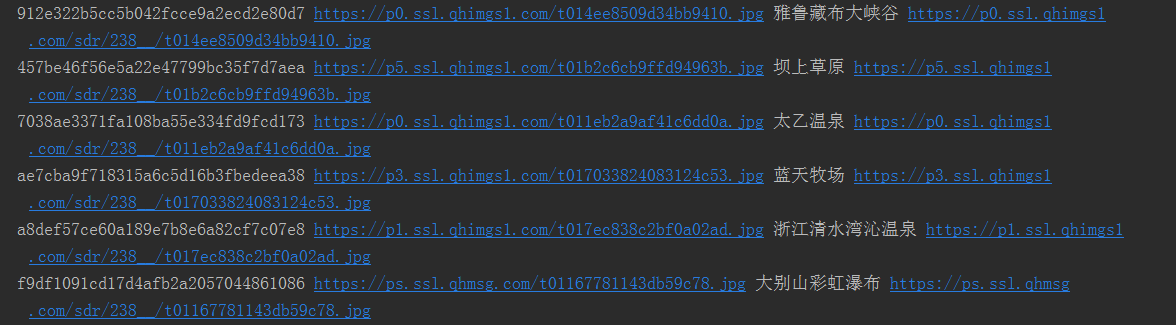

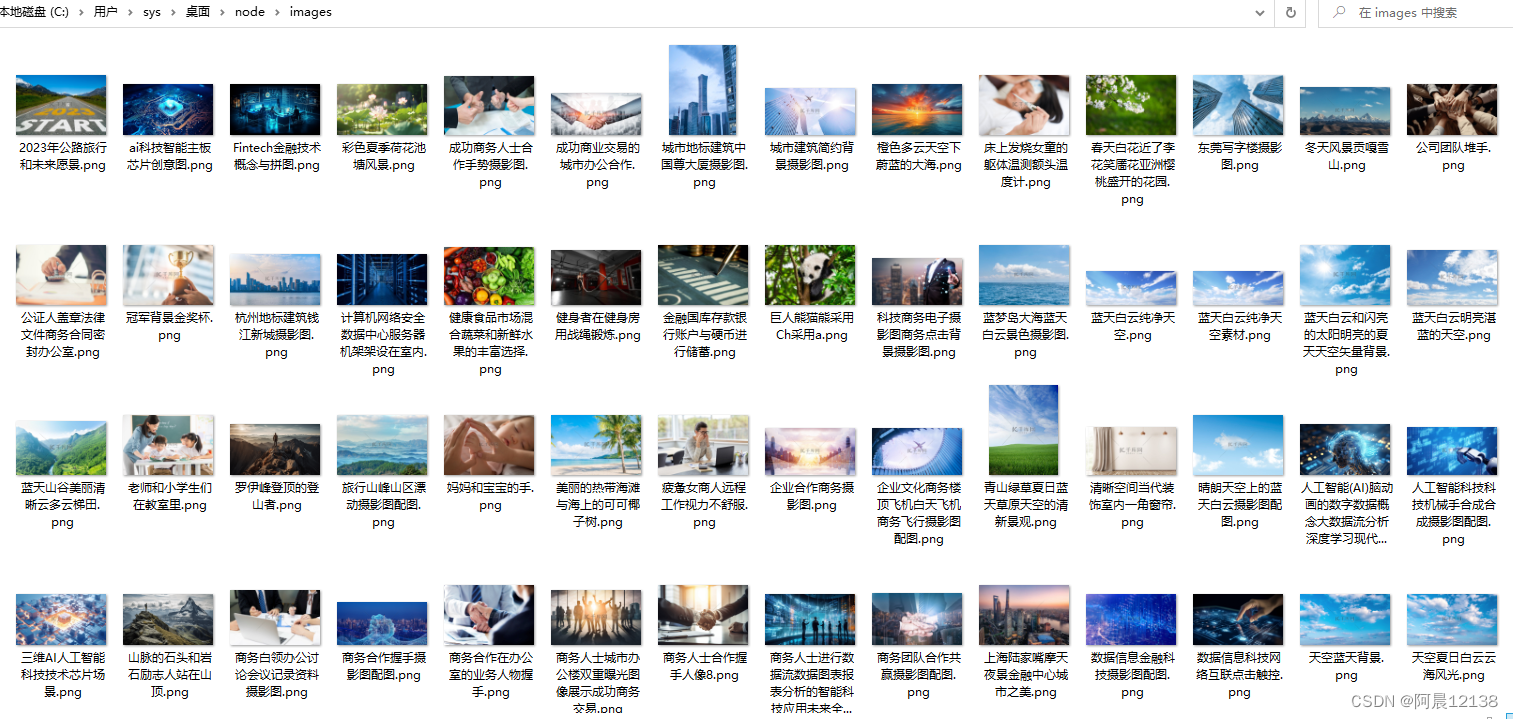

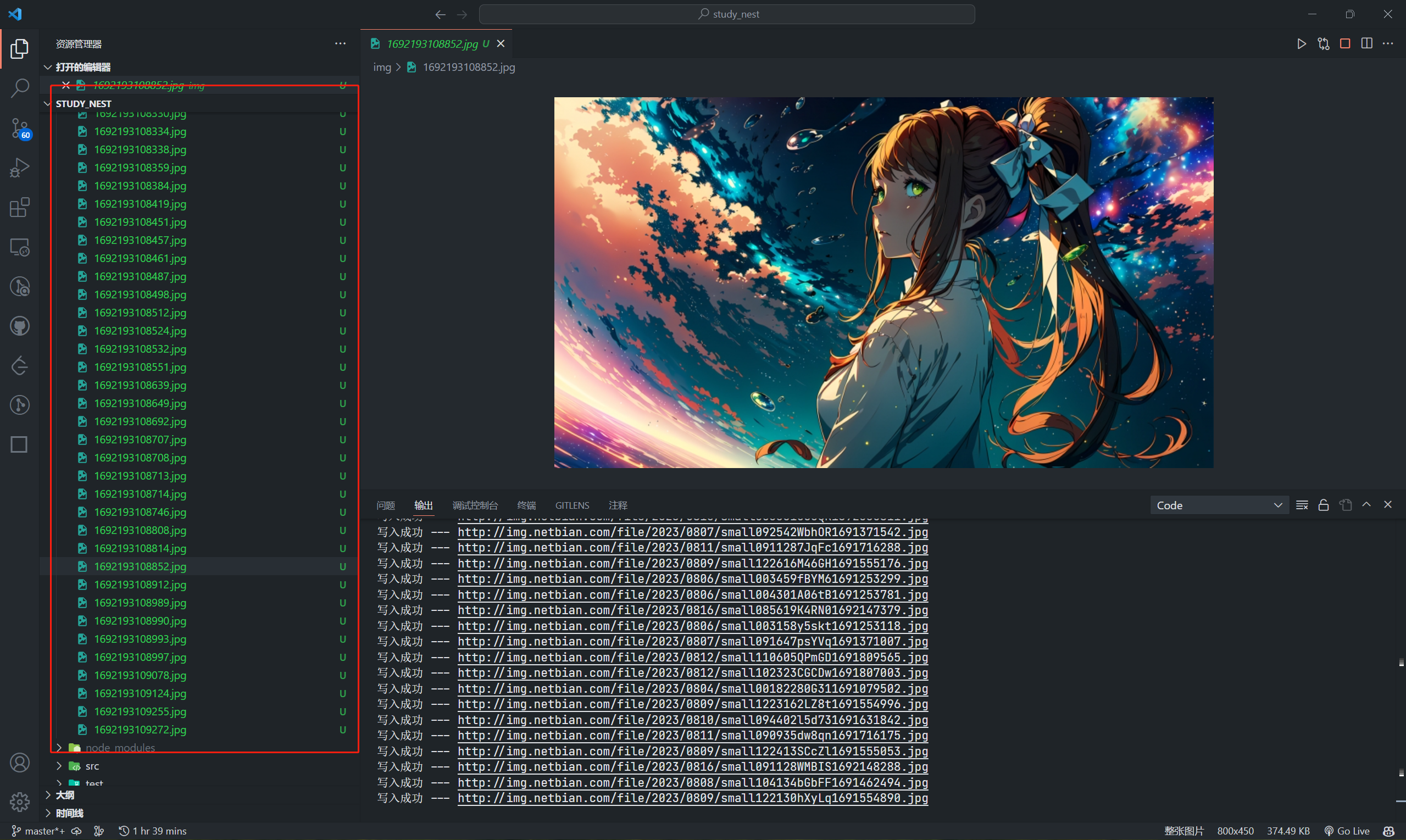

爬虫框架Scrapy(10)下载文件与图片

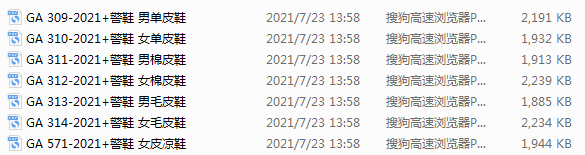

文章目录下载文件与图片(一)FilesPipeline 和 ImagesPipeline1. FilesPipeline 使用说明2. ImagesPipeline 使用说明(二)项目实例:下载 matplotlib 例子源码文件1. 页面分析2. 编码实现(1)创建项…

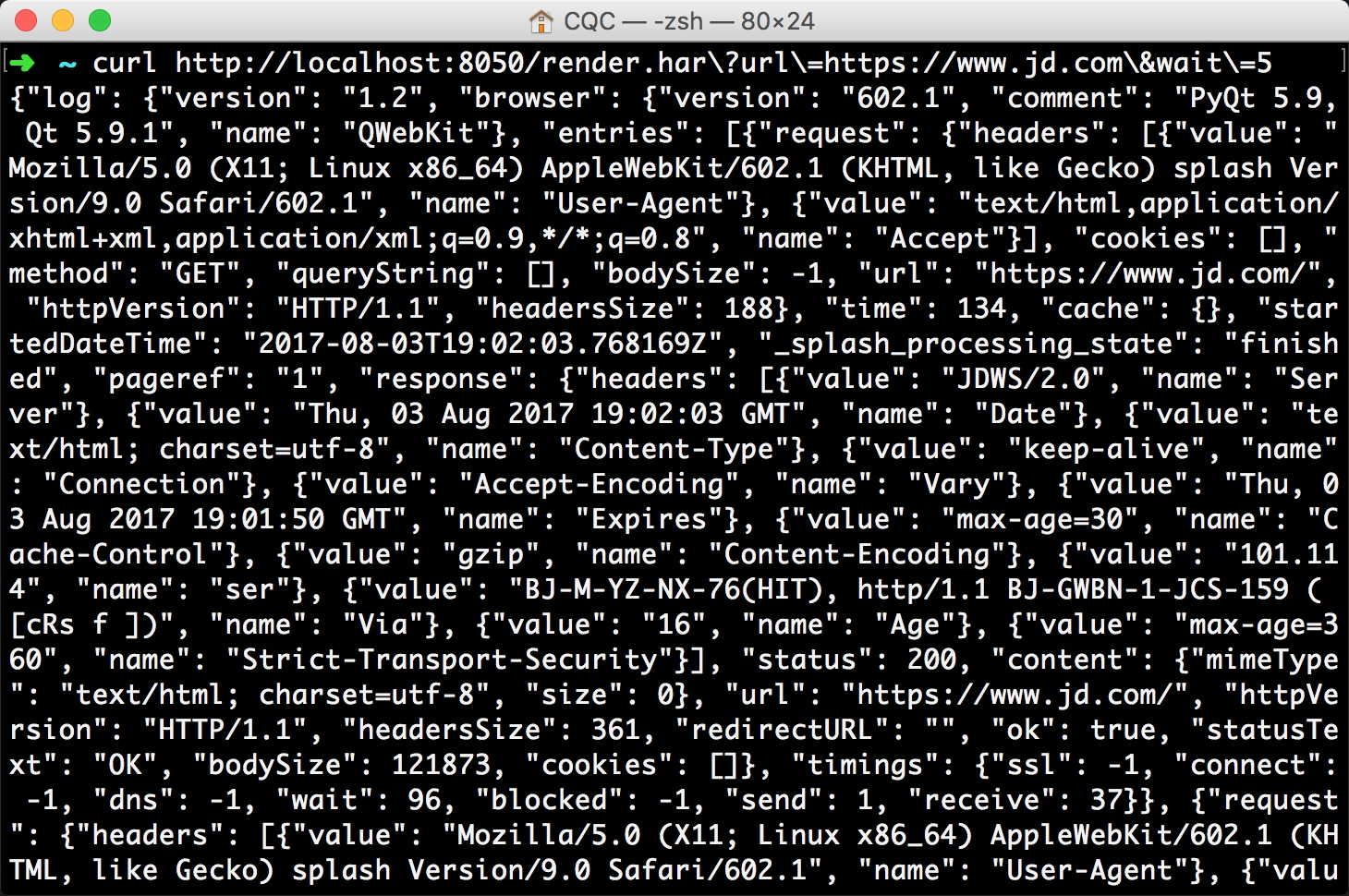

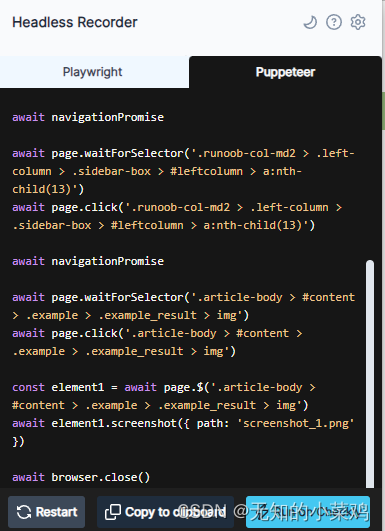

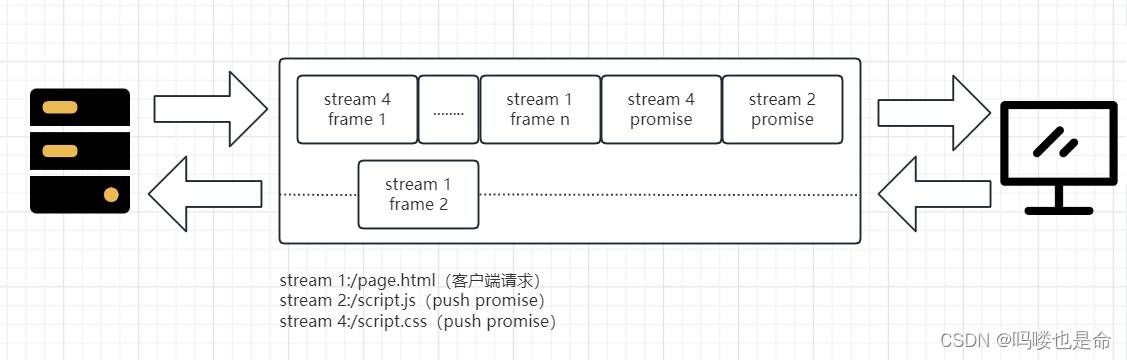

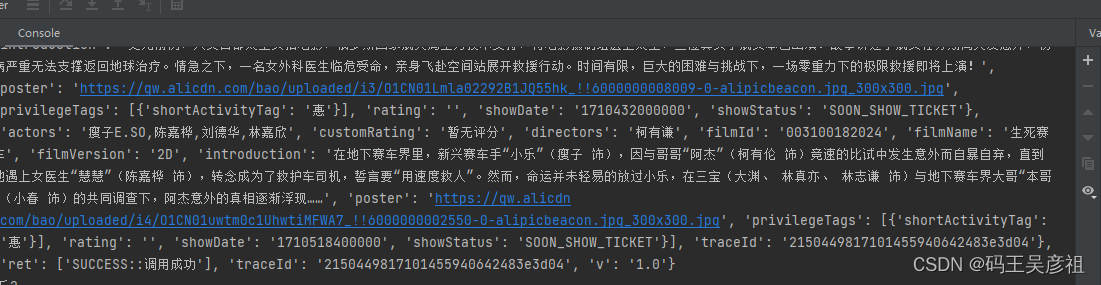

爬虫框架Scrapy(12)爬取动态页面

文章目录爬取动态页面(一)Splash 渲染引擎1. render.html 端点2. execute 端点3. 常用属性与方法(1)Splash 对象的属性(2)Splash 对象的方法(二)安装 Scrapy-Scrapy1. 安装 splash 服…

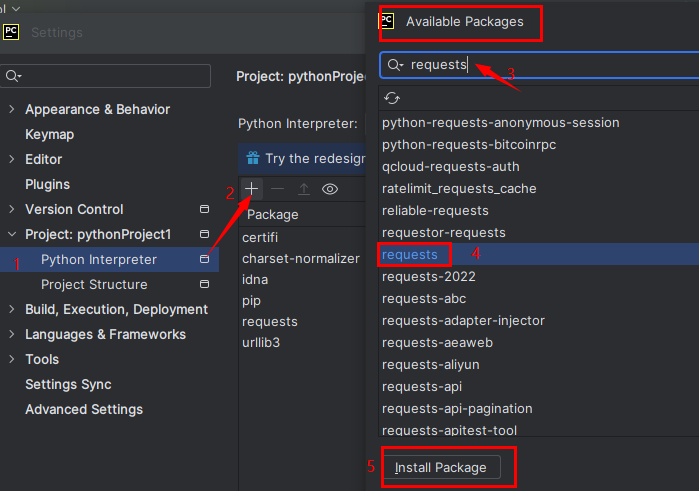

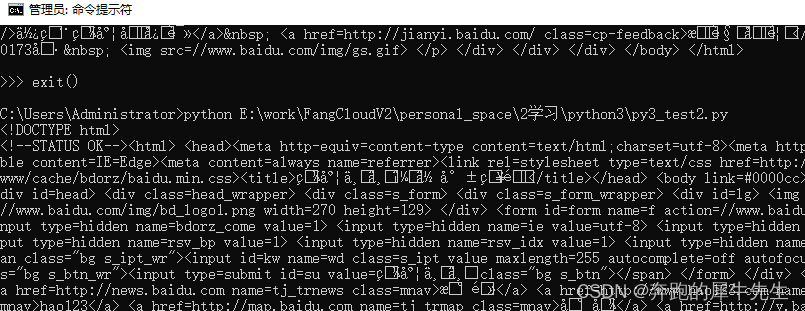

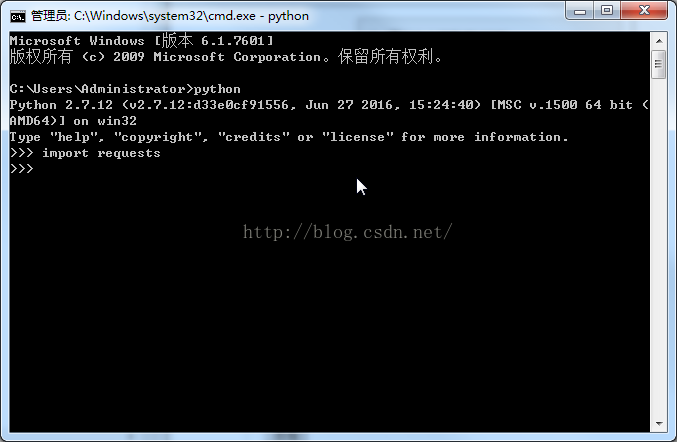

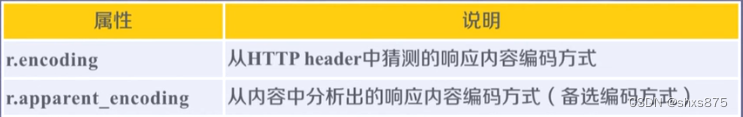

[转][实战演练]python3使用requests模块爬取页面内容

本文摘要:

1.安装pip

2.安装requests模块

3.安装beautifulsoup4

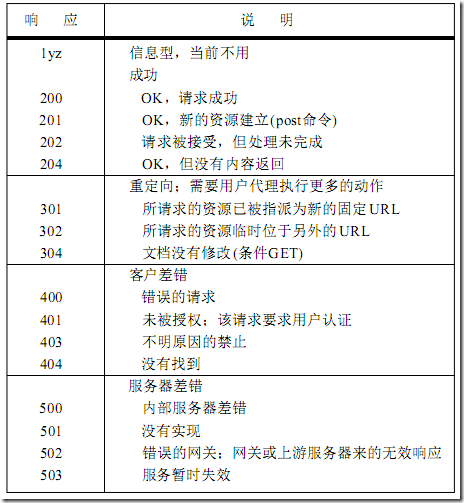

4.requests模块浅析 发送请求 传递URL参数 响应内容 获取网页编码 获取响应状态码

5.案例演示

后记 1.安装pip 我的个人桌面系统用的linuxmint,系统默认没有安装pip,考虑到后面…

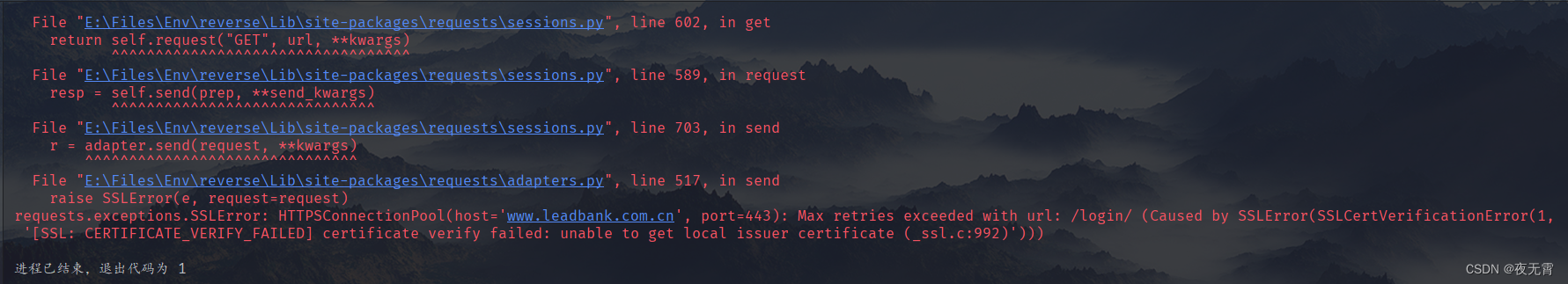

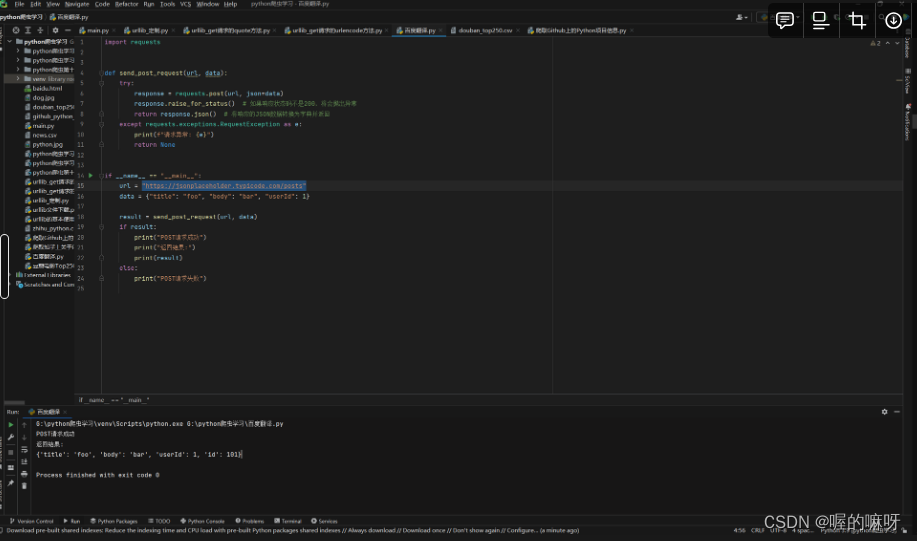

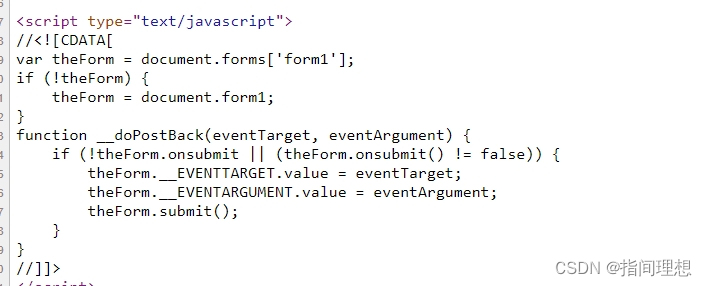

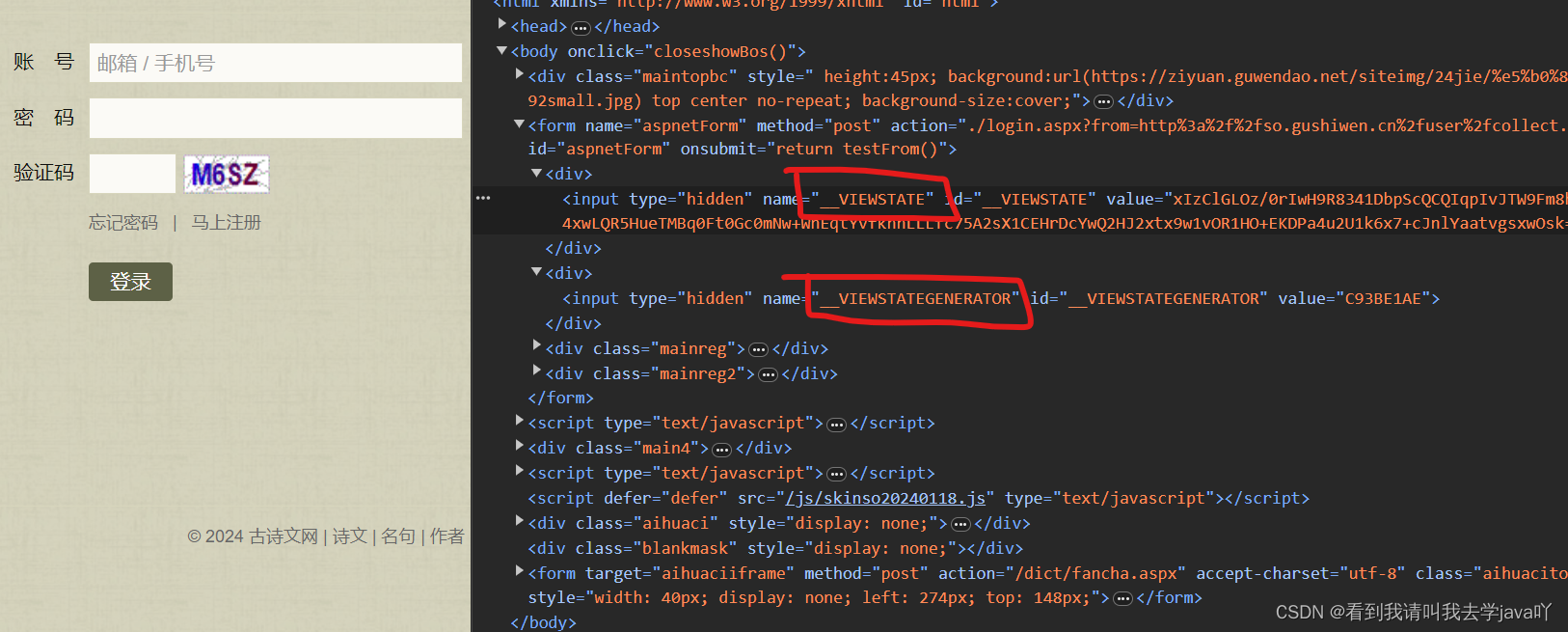

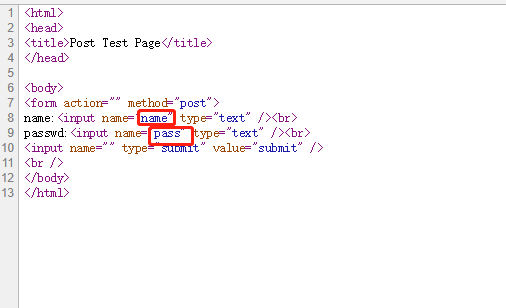

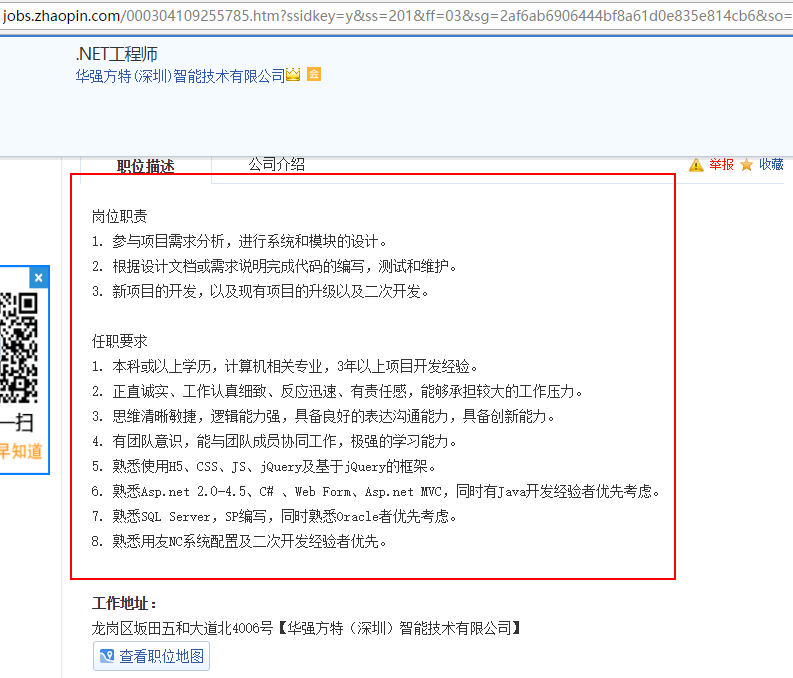

Python3.x实现网页登录表单提交功能

最近失业,在网上投了很多简历,据说刷新后,简历可以排在前面!于是就想起来做一个刷新简历的小程序,碰巧在学习Python,也懒得打开慢慢的vs了。 简历刷新呀,亲,比模拟登录163࿰…

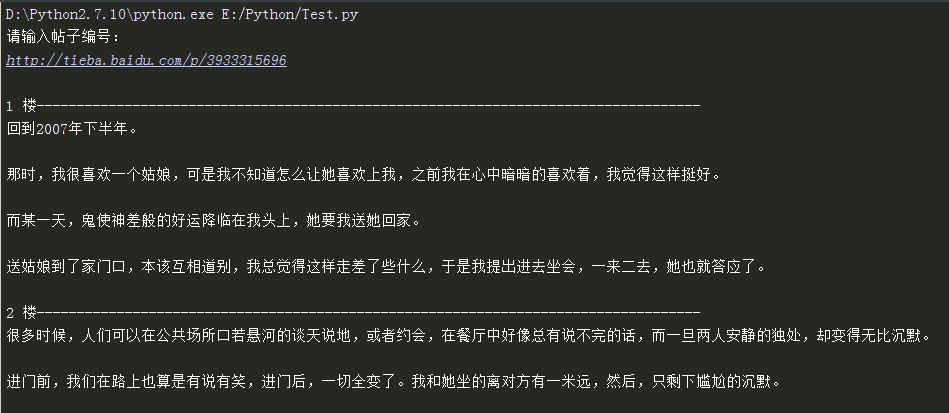

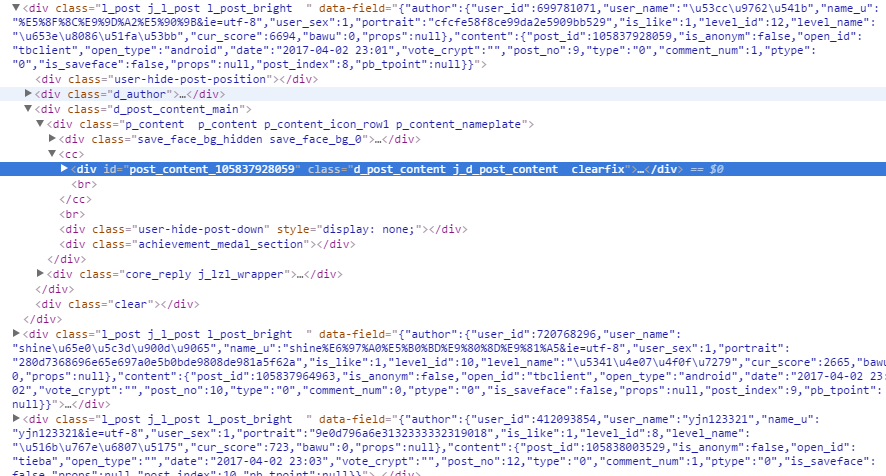

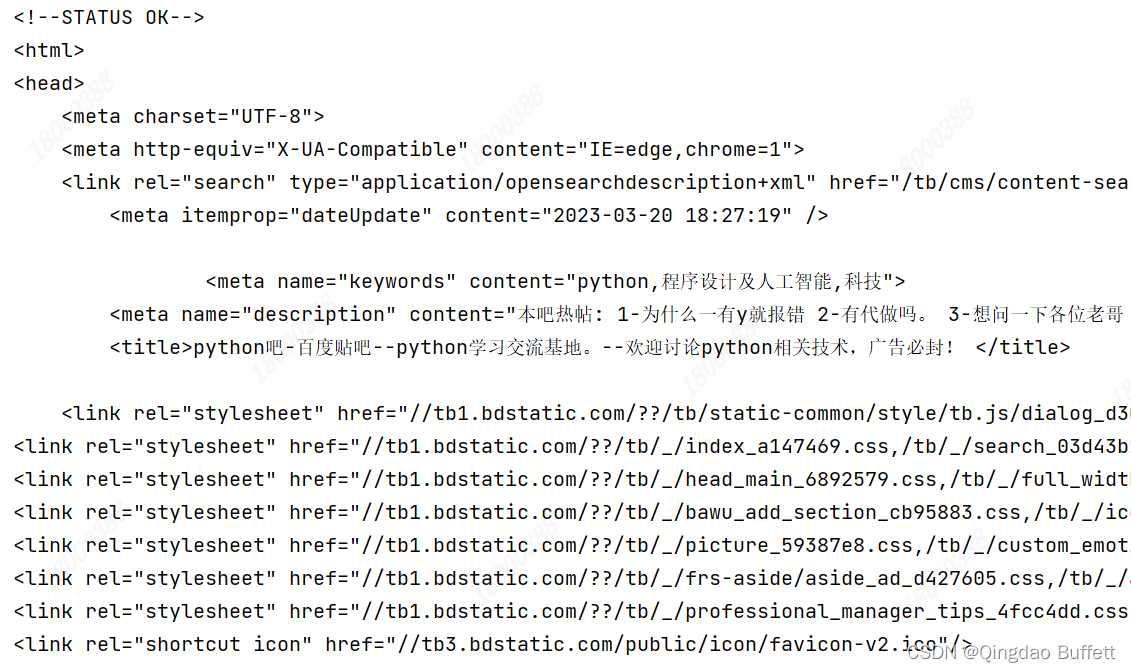

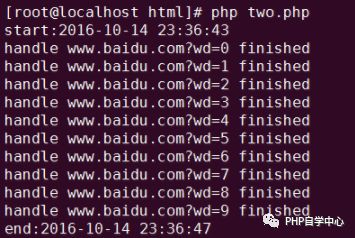

Python爬虫爬取百度贴吧多线程版

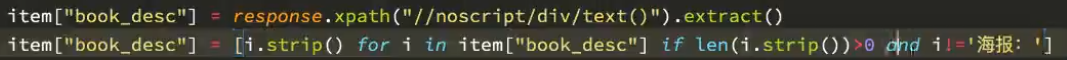

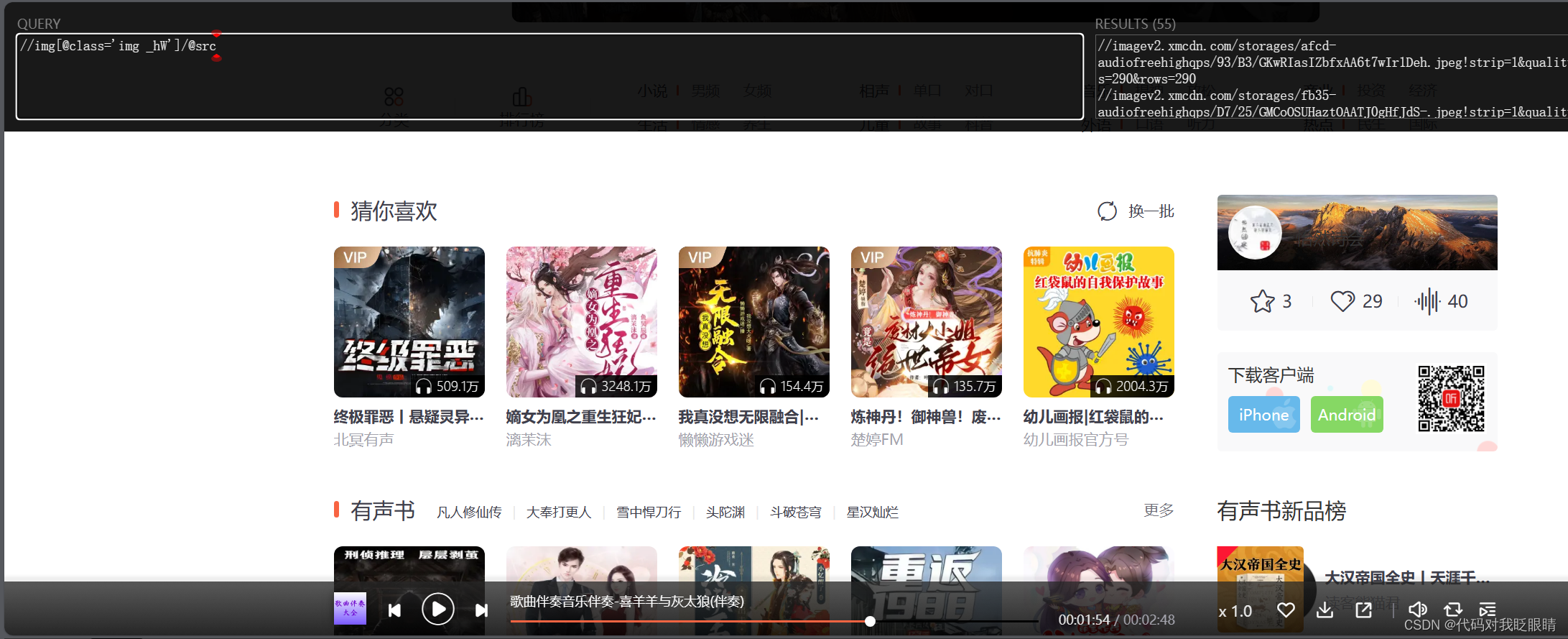

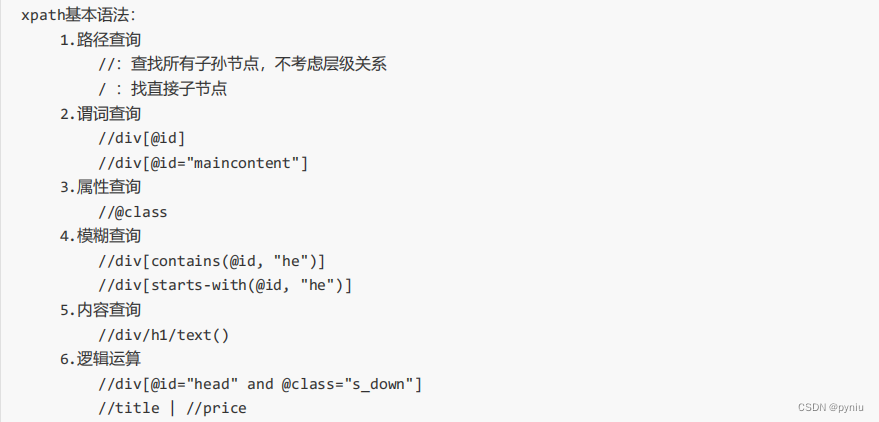

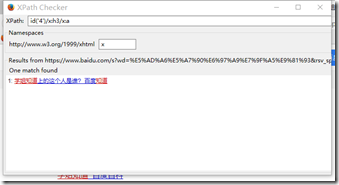

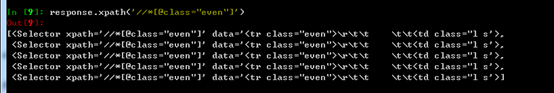

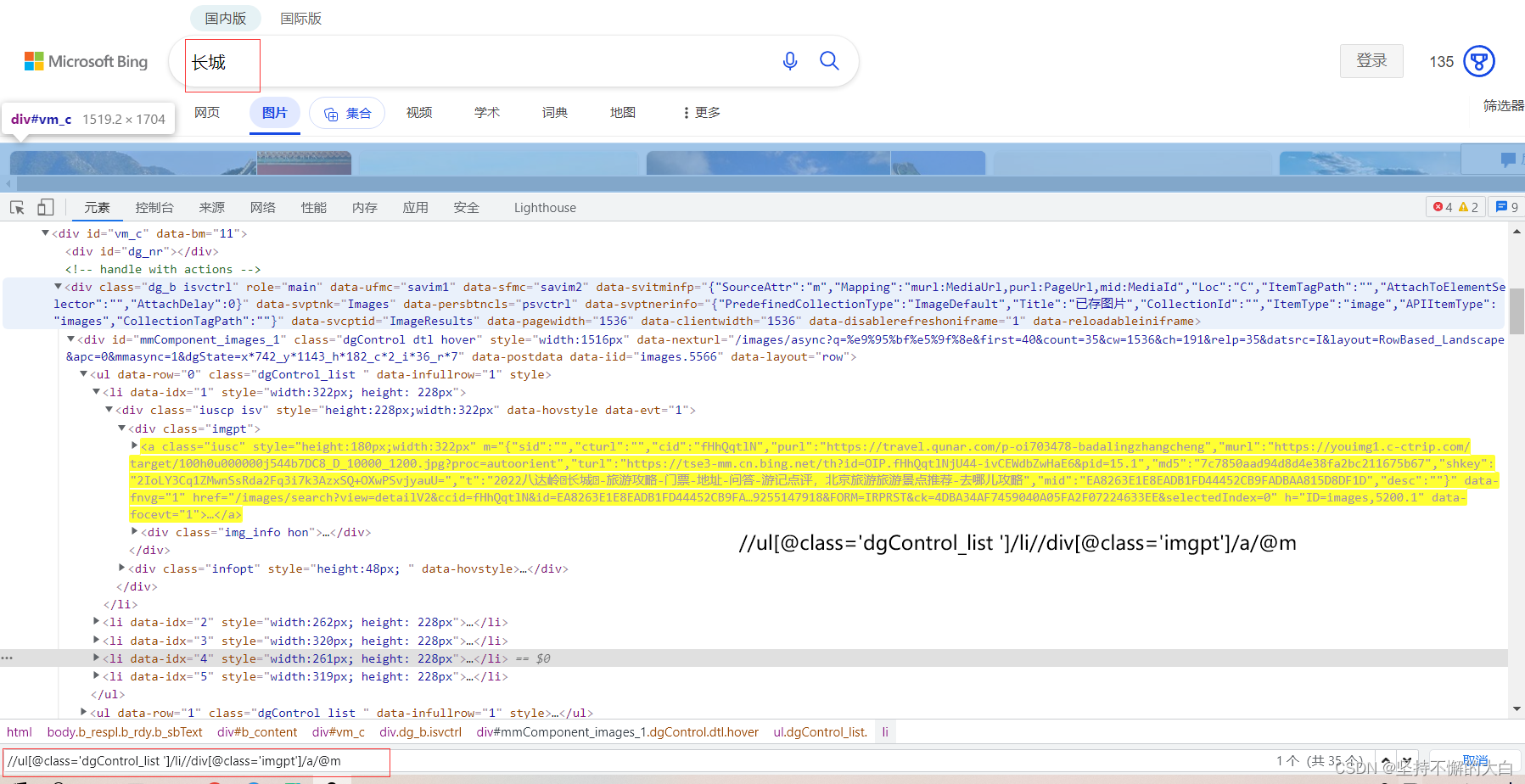

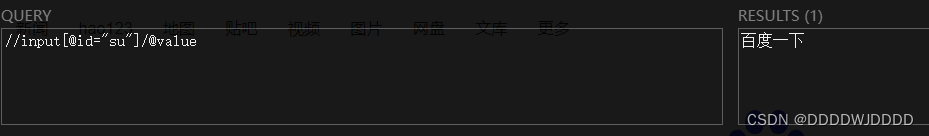

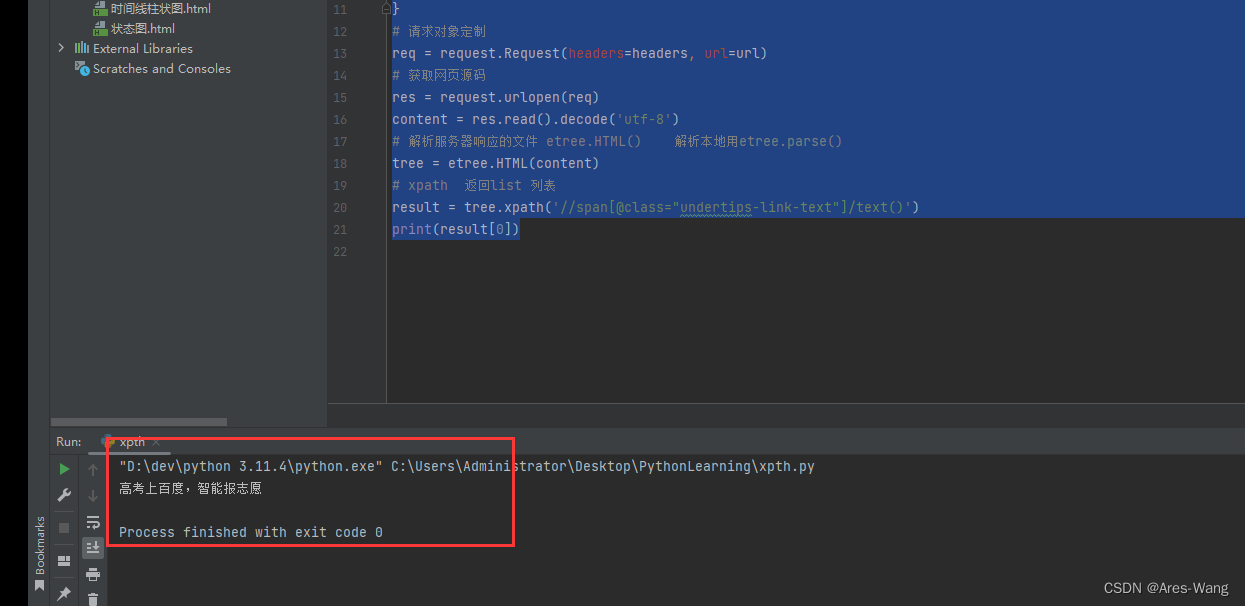

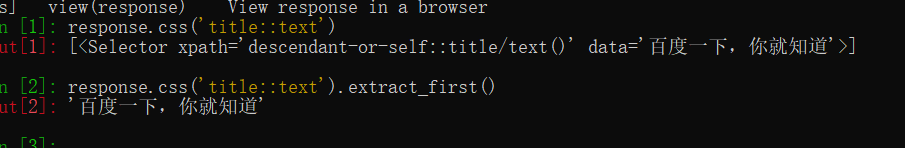

XPath提取内容//定位根节点/ 往下层寻找提取文本内容:/text()提取属性内容 : /XXXX常规匹配#-*-coding:utf8-*-

from lxml import etree

html

<!DOCTYPE html>

<html>

<head lang"en"><meta charset"UTF-8"><titl…

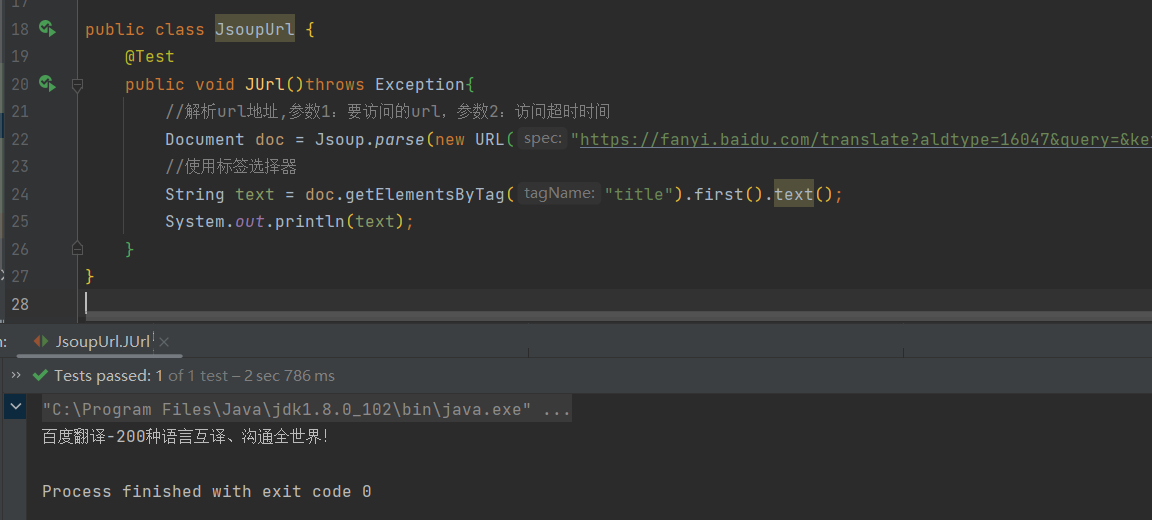

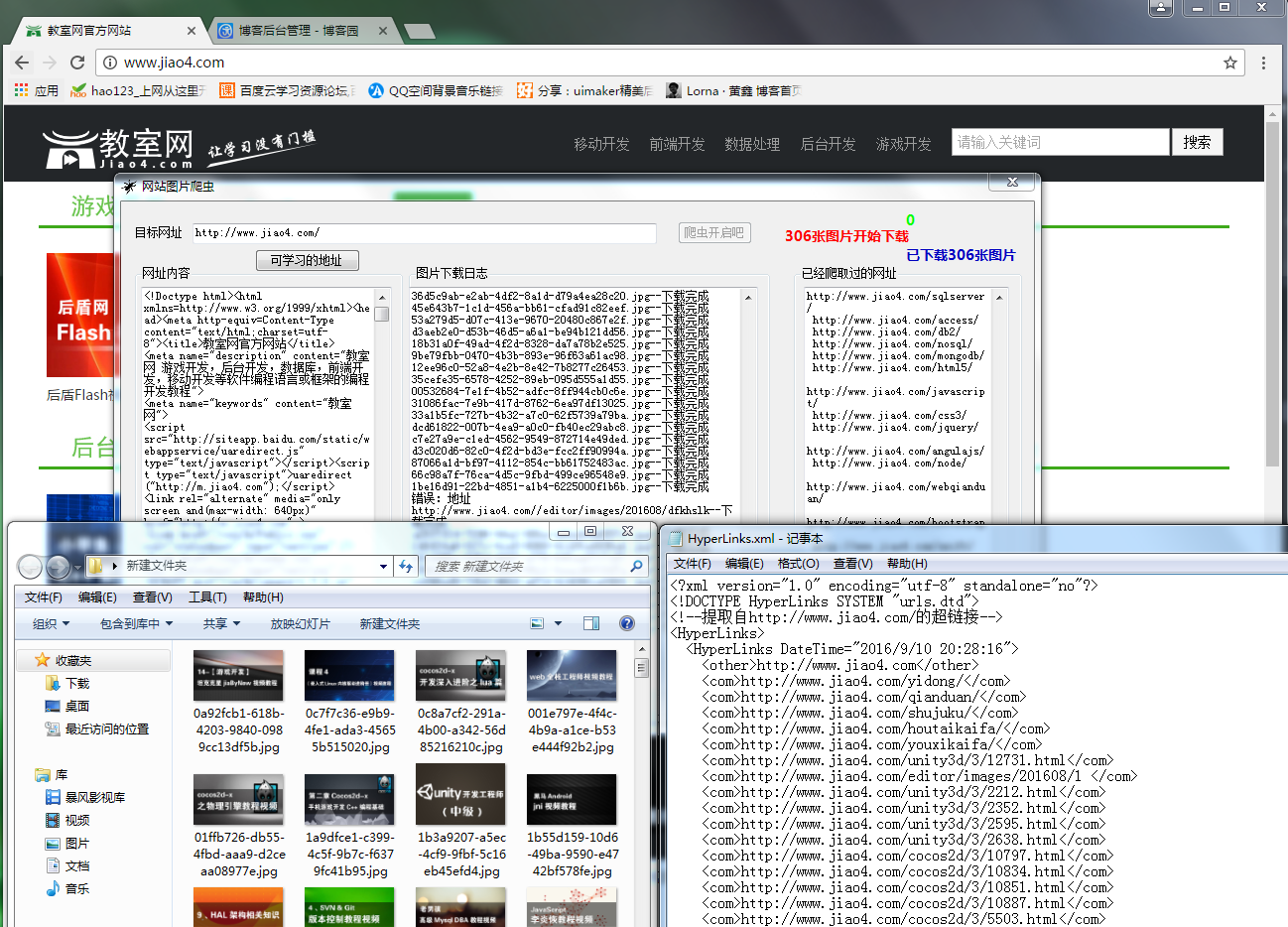

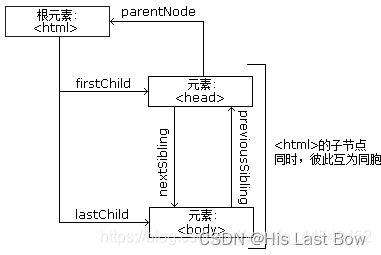

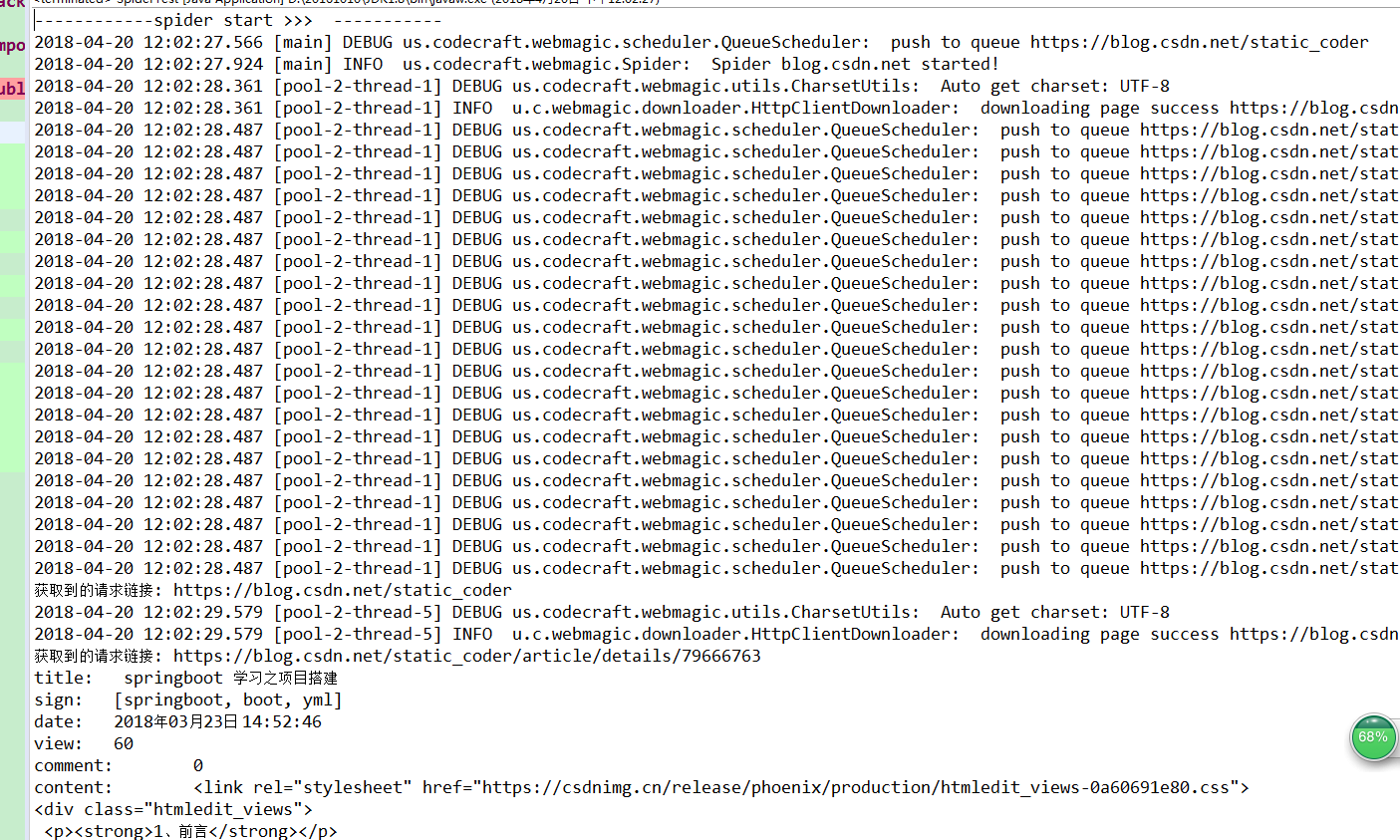

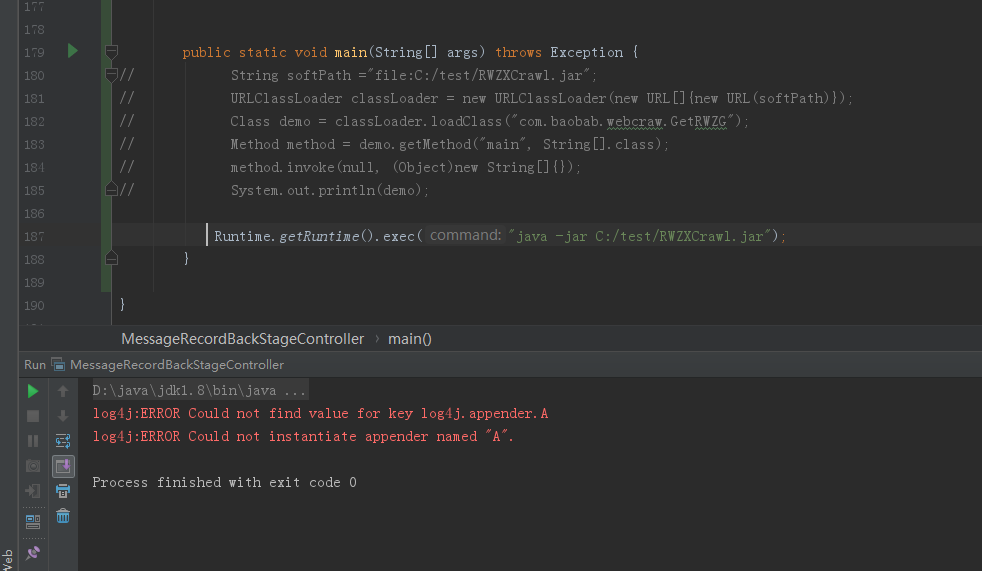

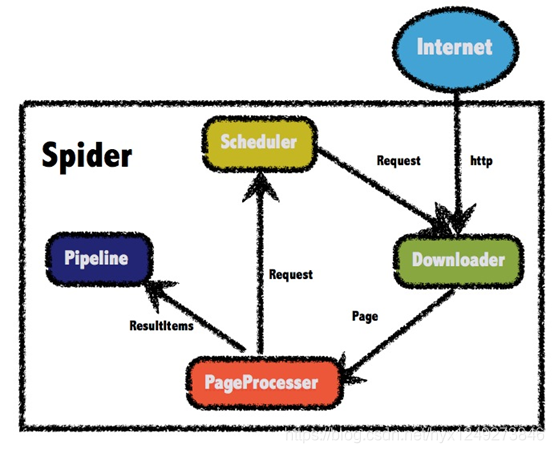

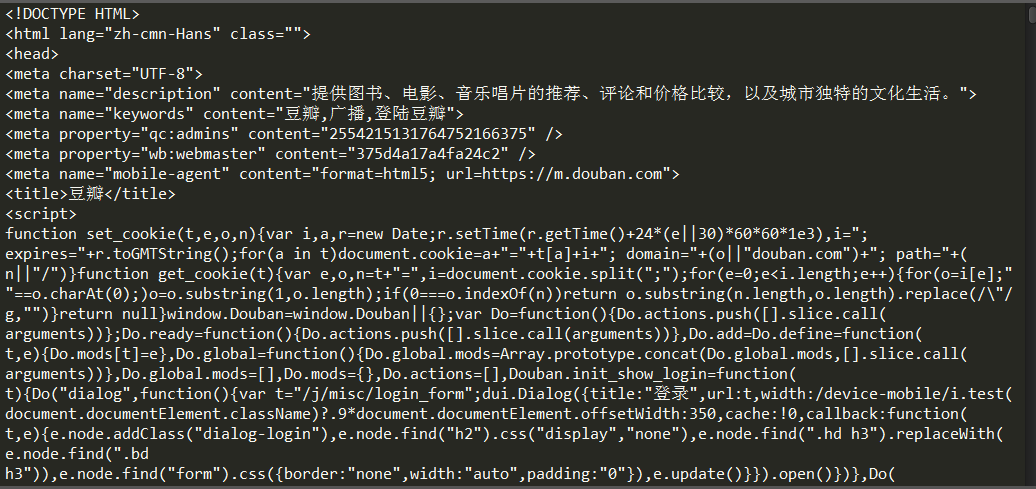

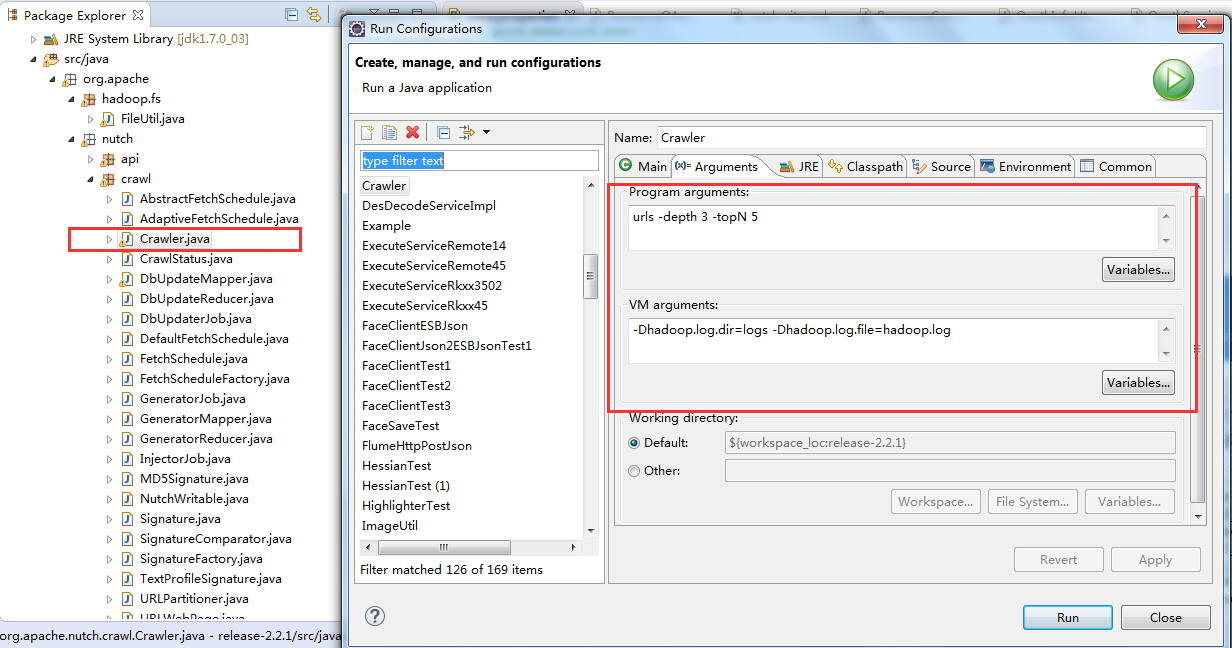

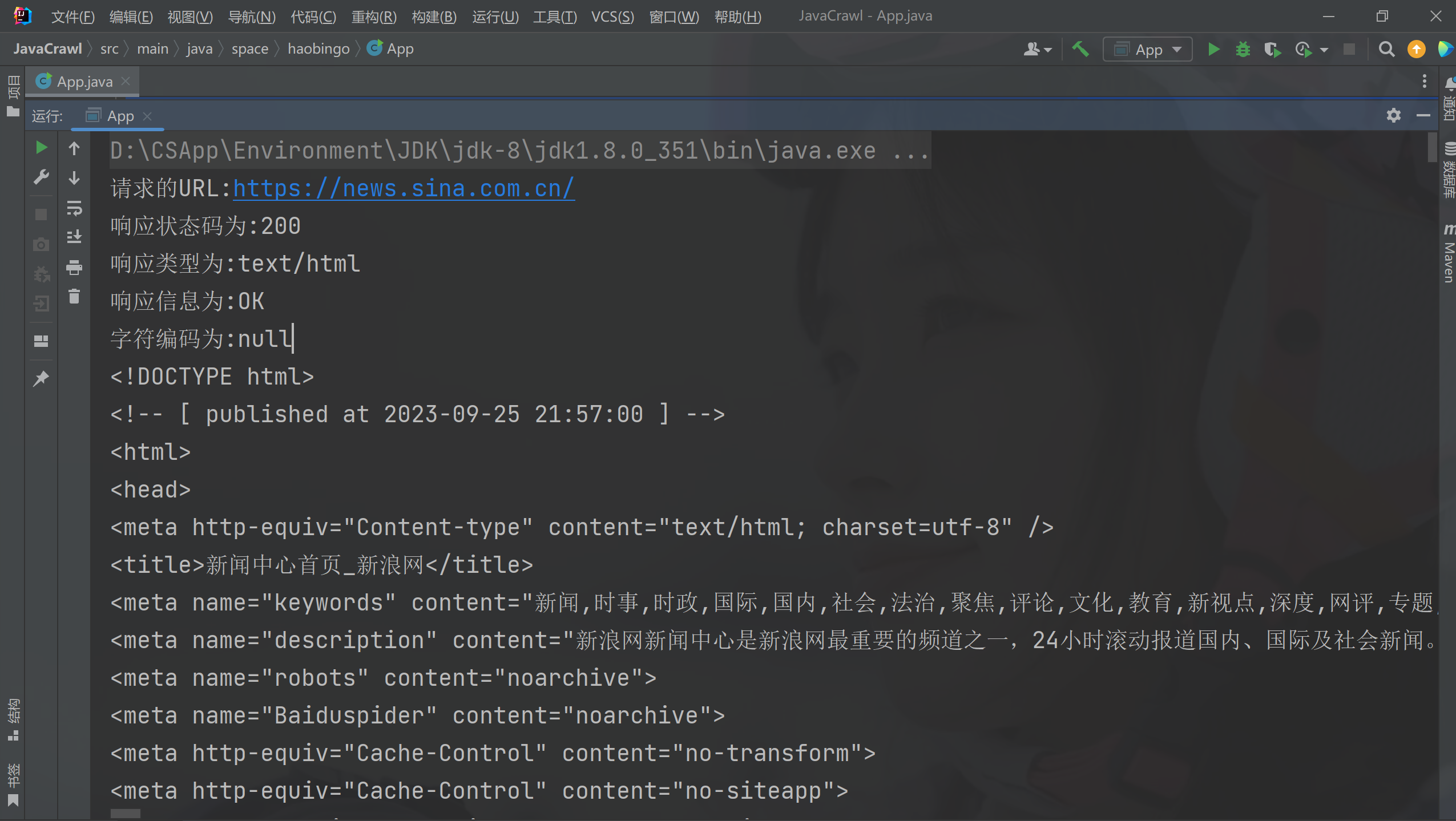

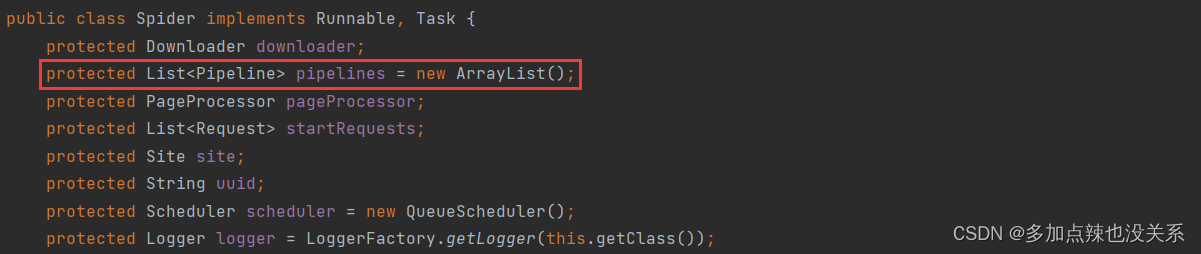

Java版网络爬虫基础

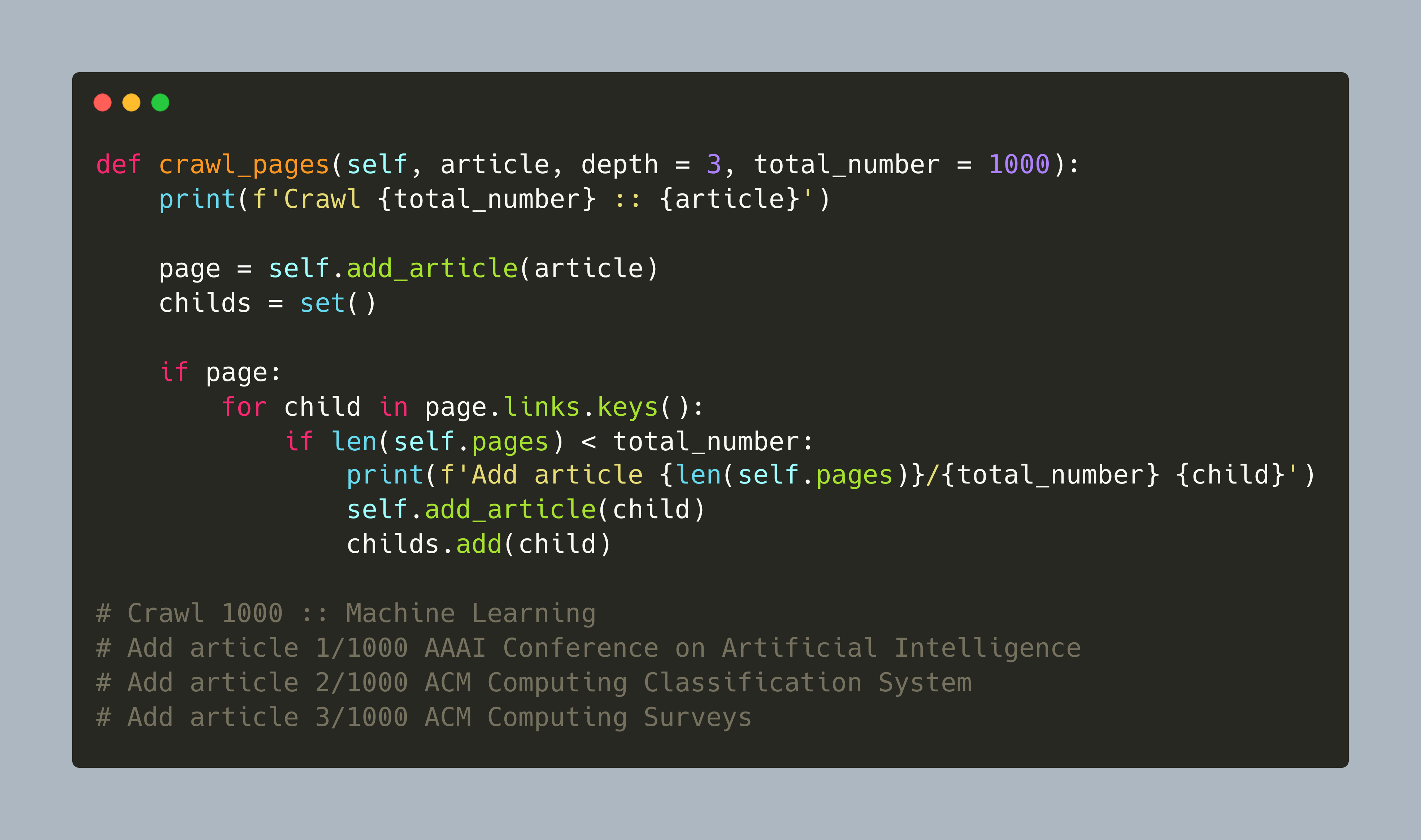

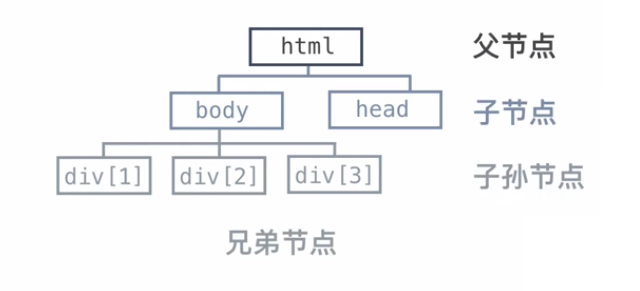

网络爬虫不仅仅可以爬取网站的网页,图片,甚至可以实现抢票功能,网上抢购,机票查询等。这几天看了点基础,记录下来。 网页的关系可以看做是一张很大的图,图的遍历可以分为深度优先和广度优先。网络爬虫采取的…

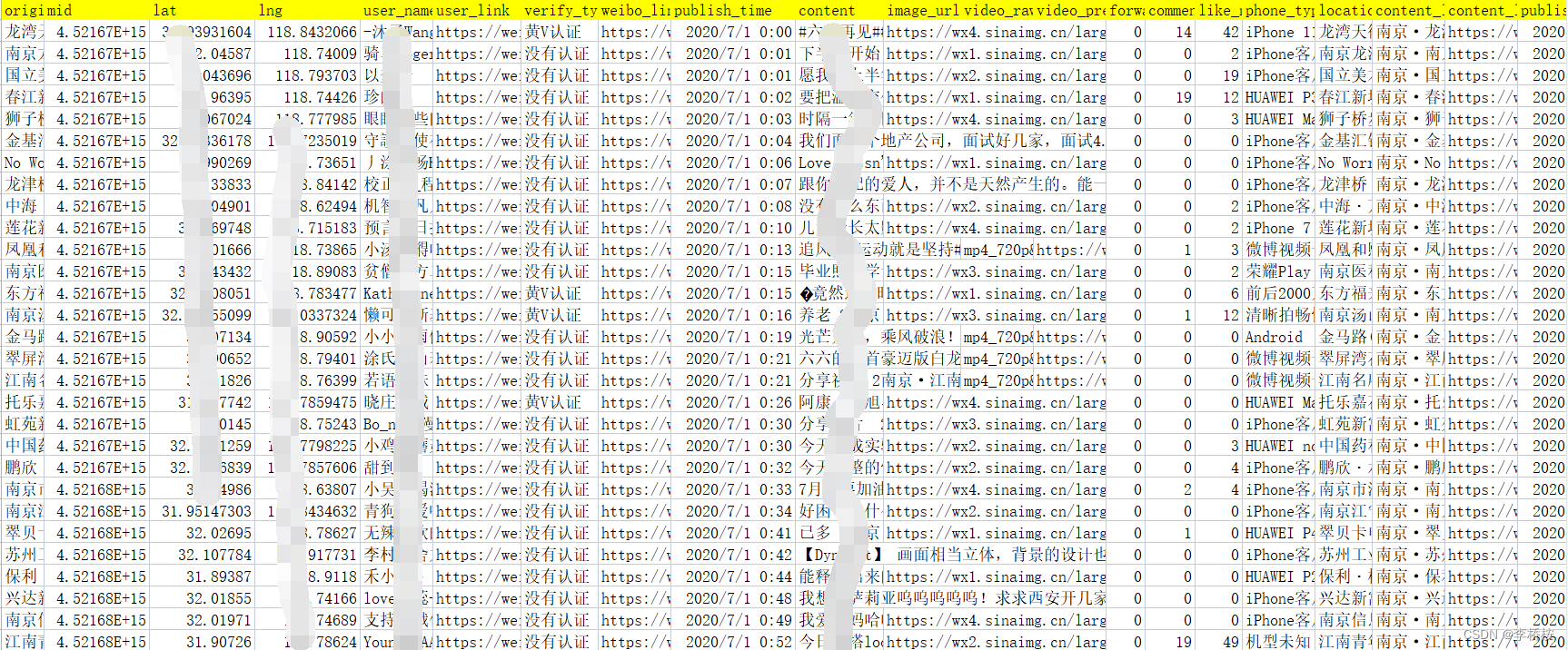

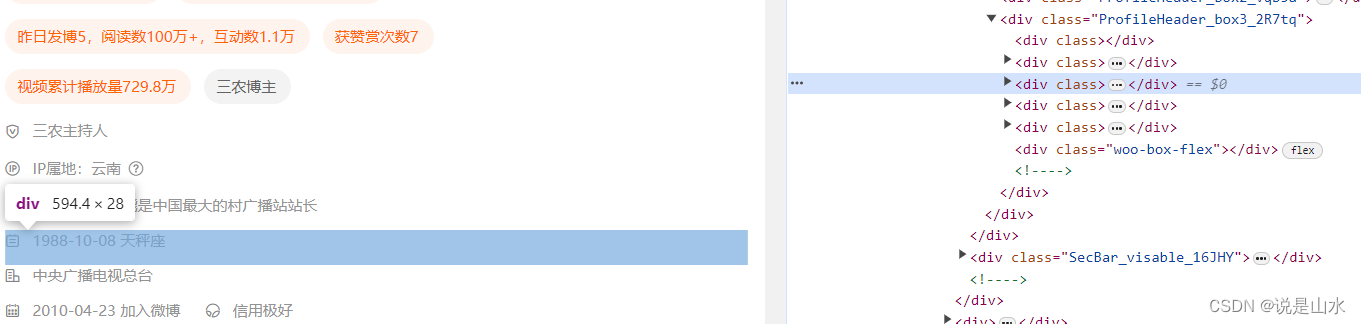

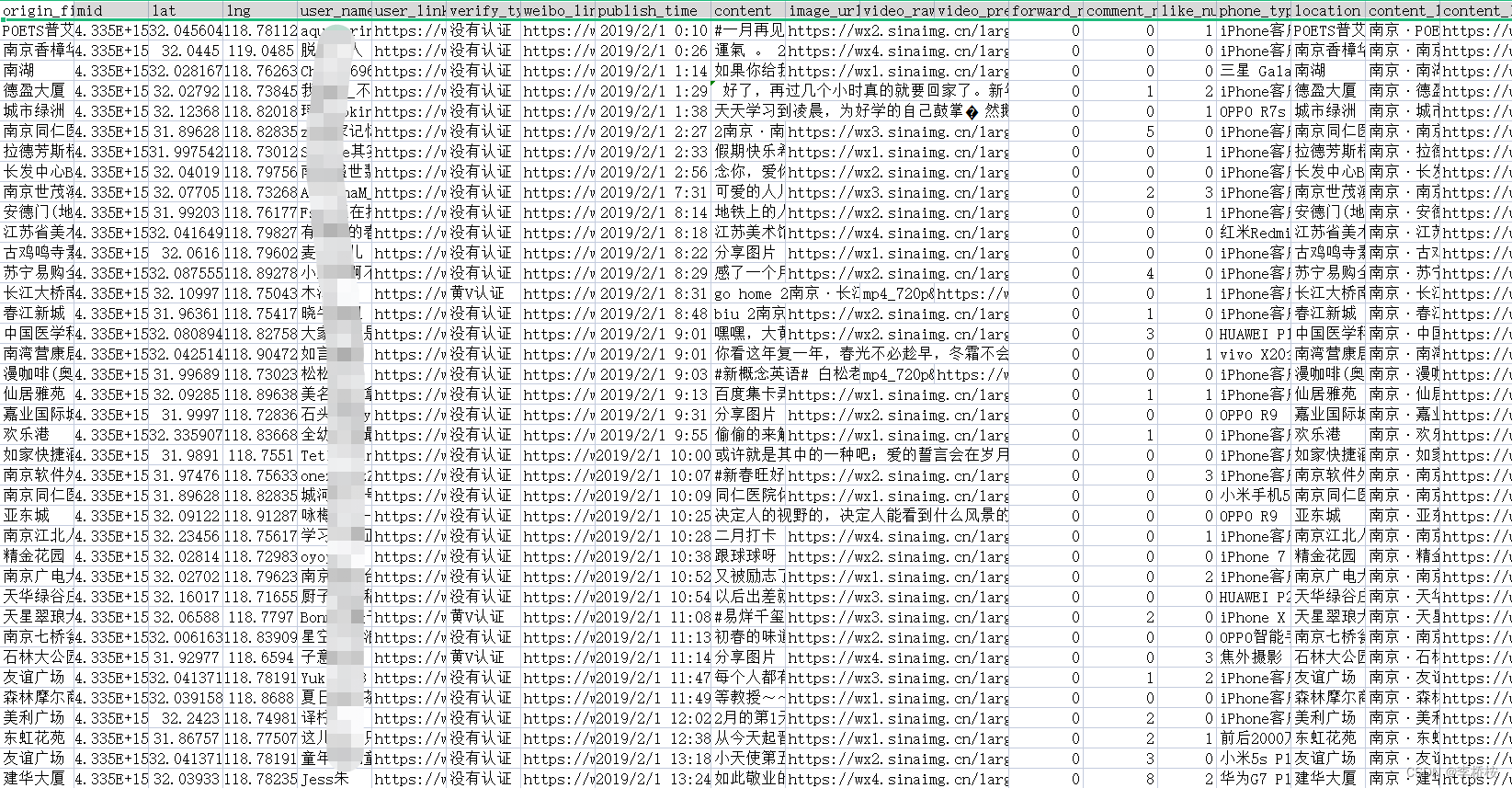

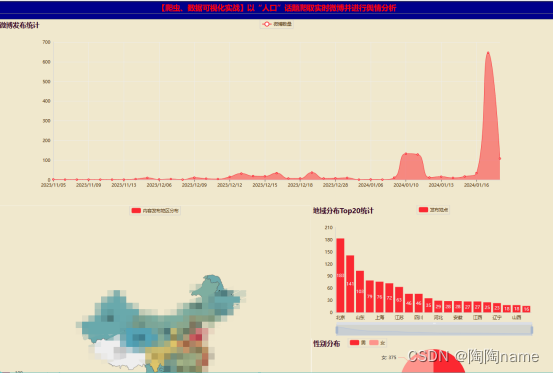

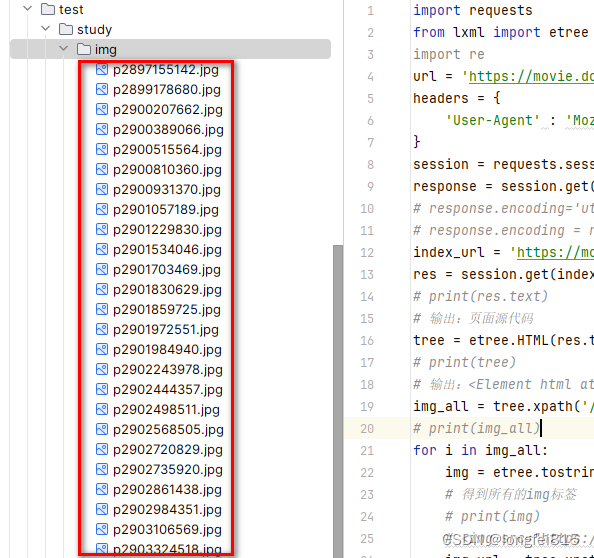

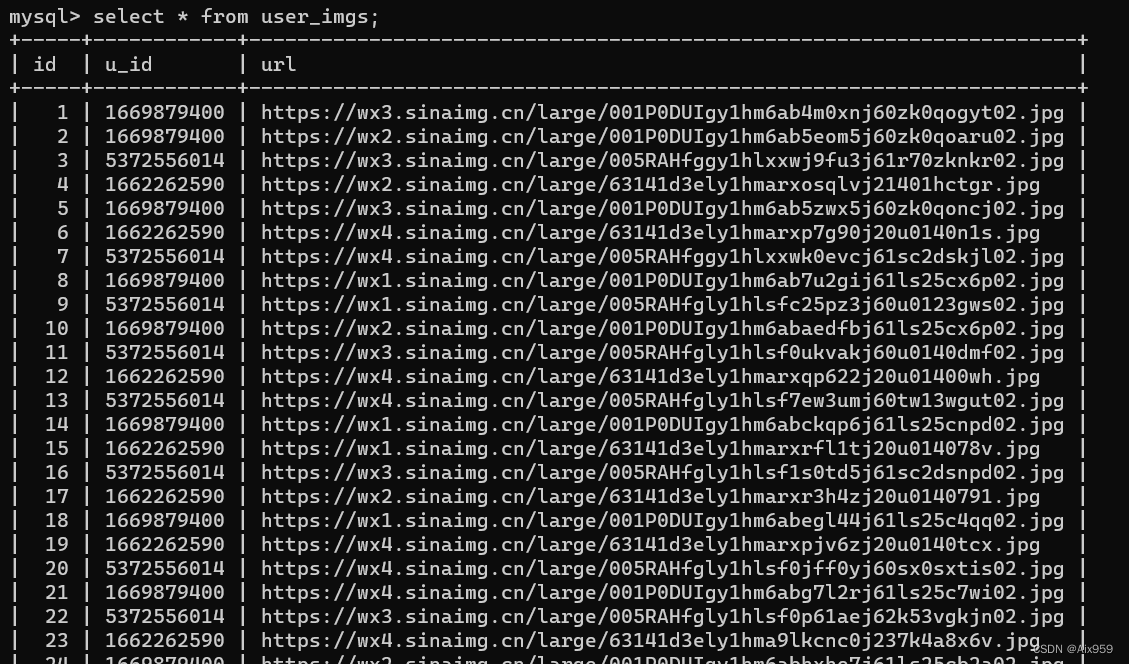

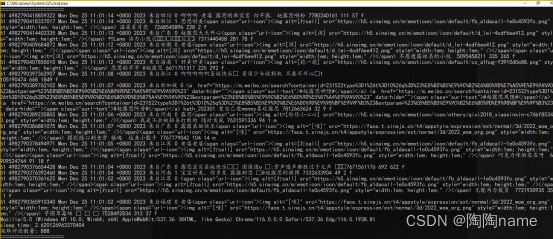

[Python爬虫] 之八:Selenium +phantomjs抓取微博数据

基本思路:在登录状态下,打开首页,利用高级搜索框输入需要查询的条件,点击搜索链接进行搜索。如果数据有多页,每页数据是20条件,读取页数 然后循环页数,对每页数据进行抓取数据。 在实践过程中发…

C#实现通过Gzip来对数据进行压缩和解压

C#实现通过Gzip来对数据进行压缩和解压 internal static byte[] Compress(byte[] data)

{using (var compressedStream new MemoryStream()){using (var zipStream new GZipStream(compressedStream, CompressionMode.Compress)){zipStream.Write(data, 0, data.Length);retu…

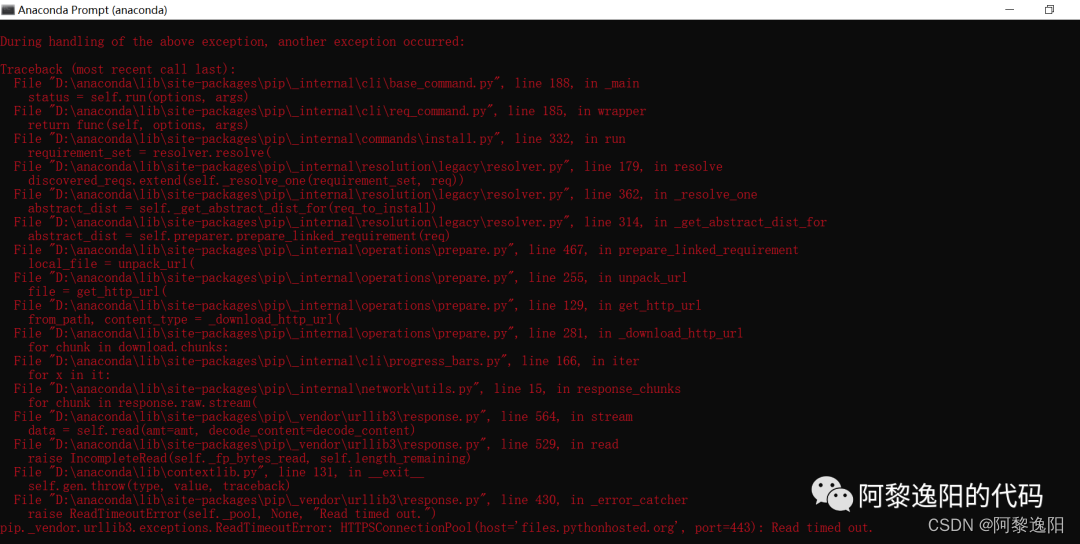

pip install scrapy报错:error: Unable to find vcvarsall.bat解决方法(python scrapy安装windows下)...

2019独角兽企业重金招聘Python工程师标准>>> 使用python的爬虫框架scrapy,在windows上搭建环境时候,使用pip install scrapy 命令安装Scrapy爬虫框架时,出现了很让人头疼的错误,错误截图如下: 在网上查找解…

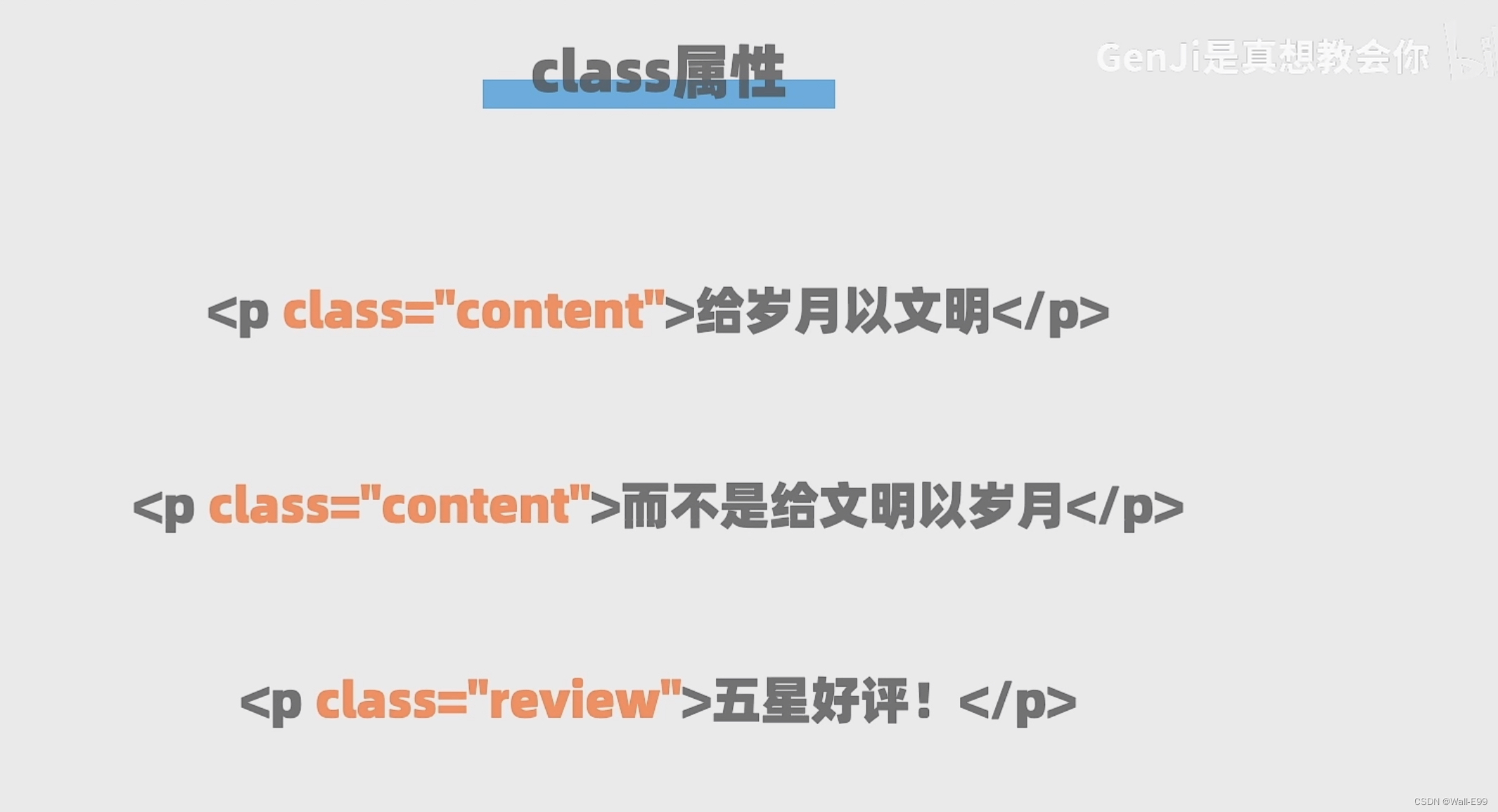

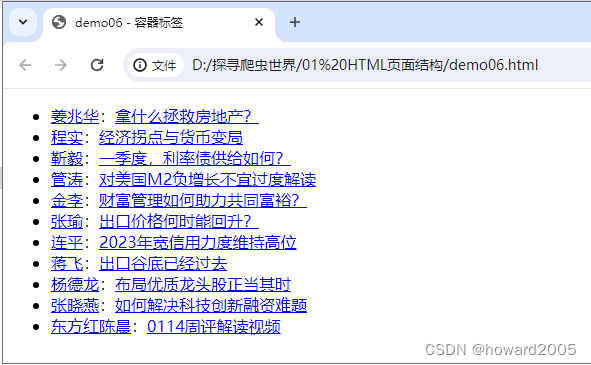

_2_head_中标签

创:20_3_2017修:5_4_2017 什么是title标签? --title 页面名(双) -- 整个html的页面名字,相当于一本书的书名 <title>北门吹雪</title> <!--给我的html页面取一个名字&a…

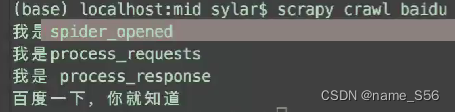

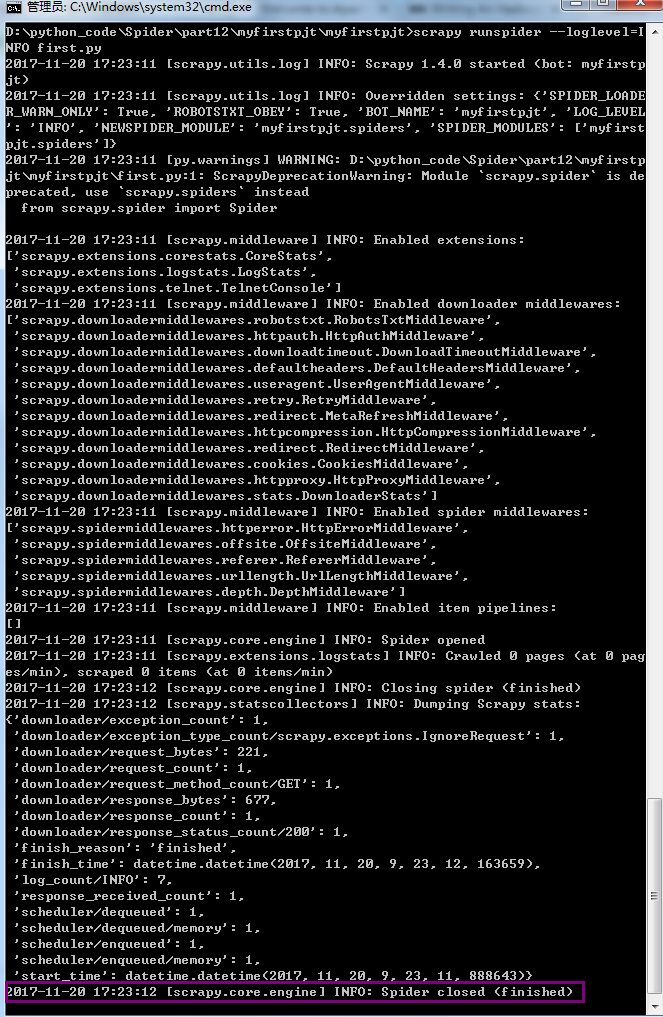

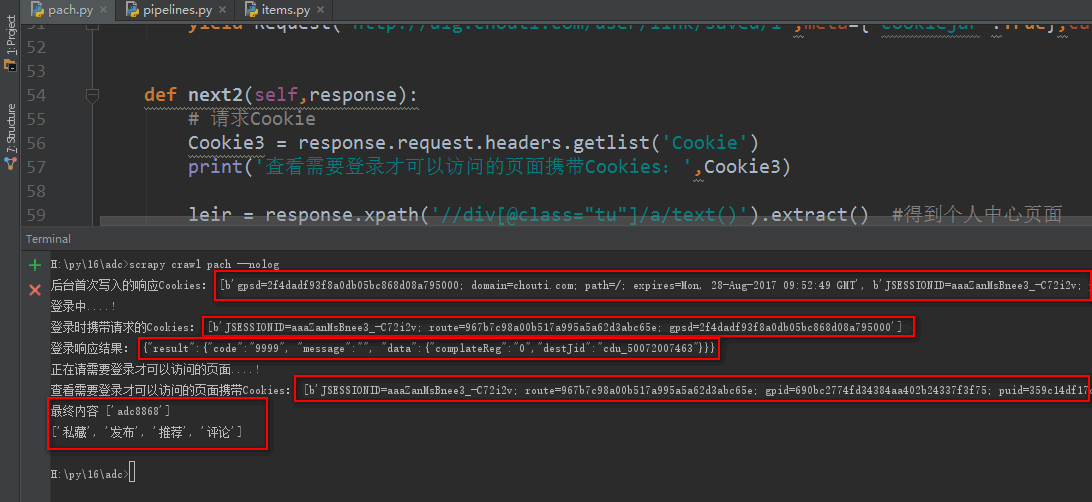

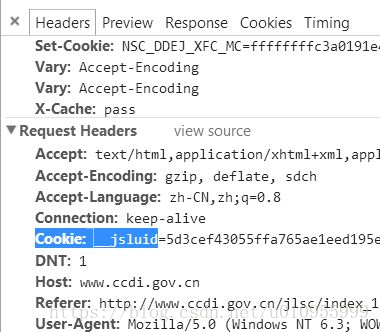

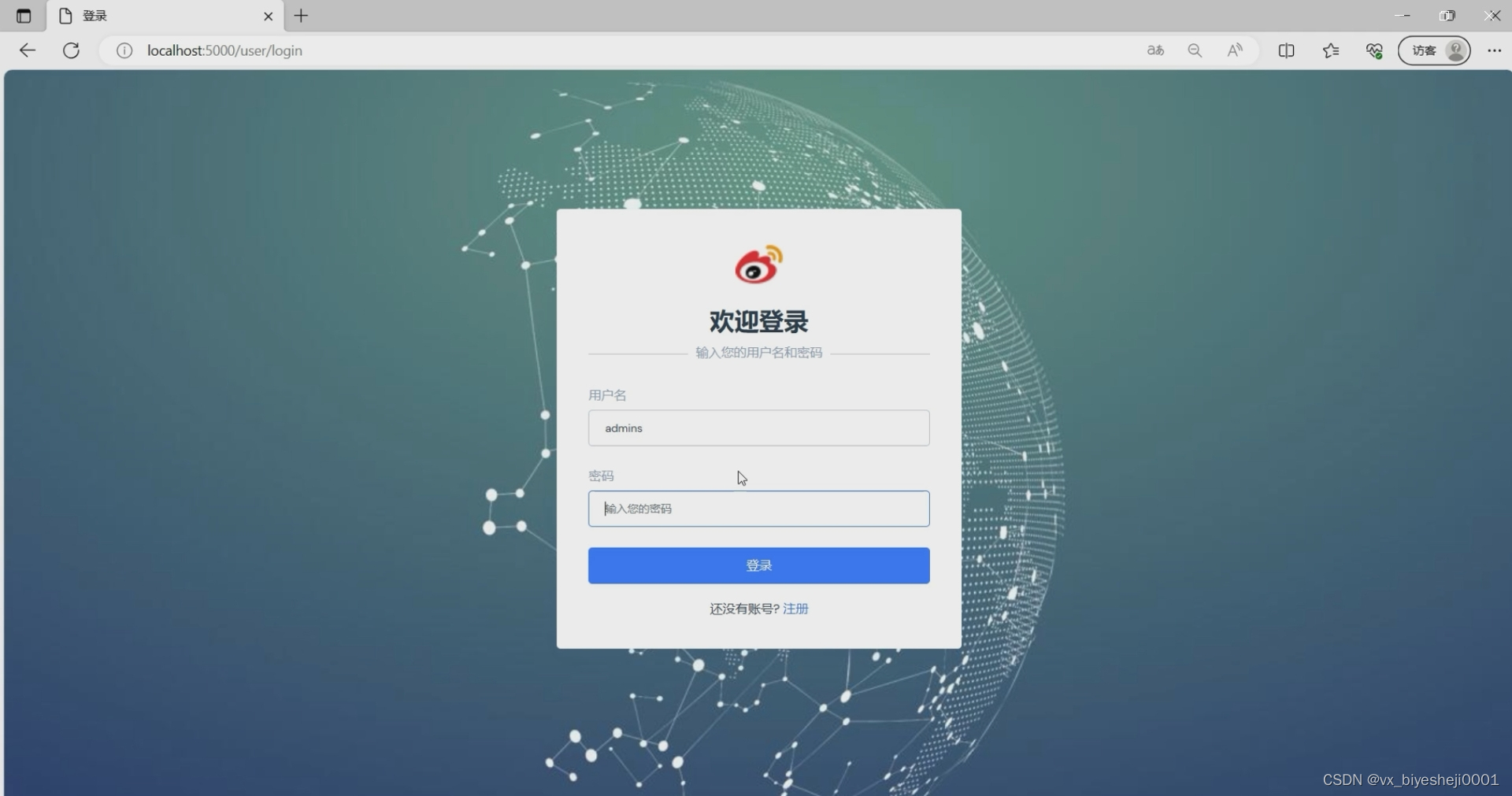

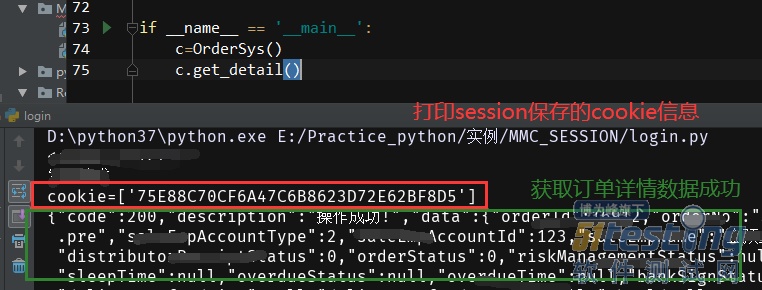

十二 web爬虫讲解2—Scrapy框架爬虫—Scrapy模拟浏览器登录—获取Scrapy框架Cookies...

模拟浏览器登录 start_requests()方法,可以返回一个请求给爬虫的起始网站,这个返回的请求相当于start_urls,start_requests()返回的请求会替代start_urls里的请求 Request()get请求,可以设置,url、cookie、回调函数 Fo…

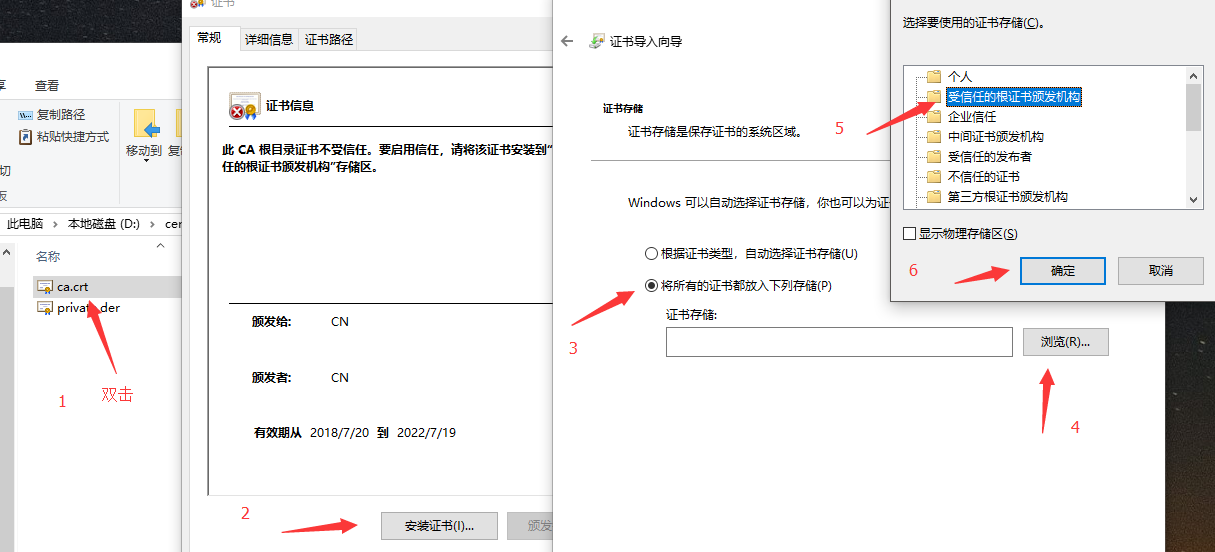

让我们加密吧Let's encrypt

前言 如今的互联网越来越不安全,我们每个人的信息以及隐私不断被暴露,地下黑产盛行,经常收到垃圾短信,经常被陌生人的电话骚扰。我们的个人信息是怎么泄漏的呢?各种爬虫无时无刻不在互联网爬取着信息,各种嗅…

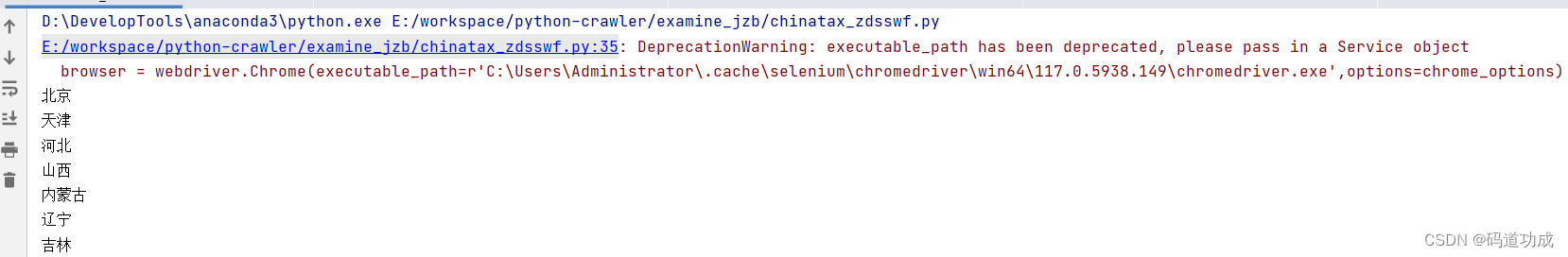

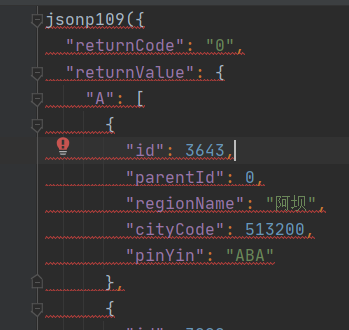

Python爬虫案例-获取最新的中国行政区域划分

源网页:中国统计局标准 http://www.stats.gov.cn/tjsj/tjbz/tjyqhdmhcxhfdm/2016/ 打开网页后可以分析出行政区域划分共分为5层 根据传入参数,生成网页地址时需要1-3层的只传本身以及 4层及以后的增加当前省份的前缀。 #生成实际需要解析的页面地址

def …

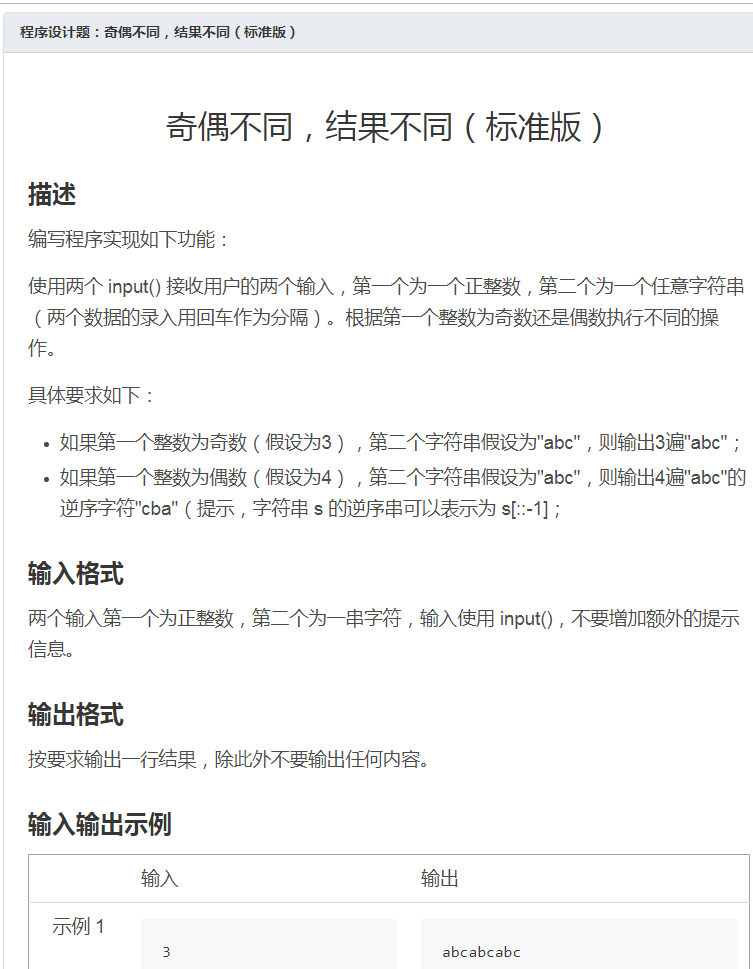

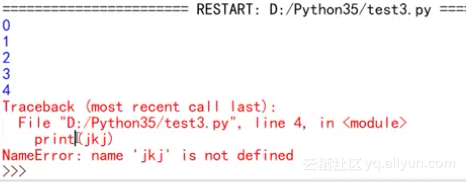

python无法使用input功能

网上参考的教程 1、Ctrl shift P ,在弹出的输入框中输入install package control; 2、Ctrl shift p, 输入 Package Control: Install Package,在弹出的框中输入SublimeREPL 3、点击Preferences,Key Buildings,输入以…

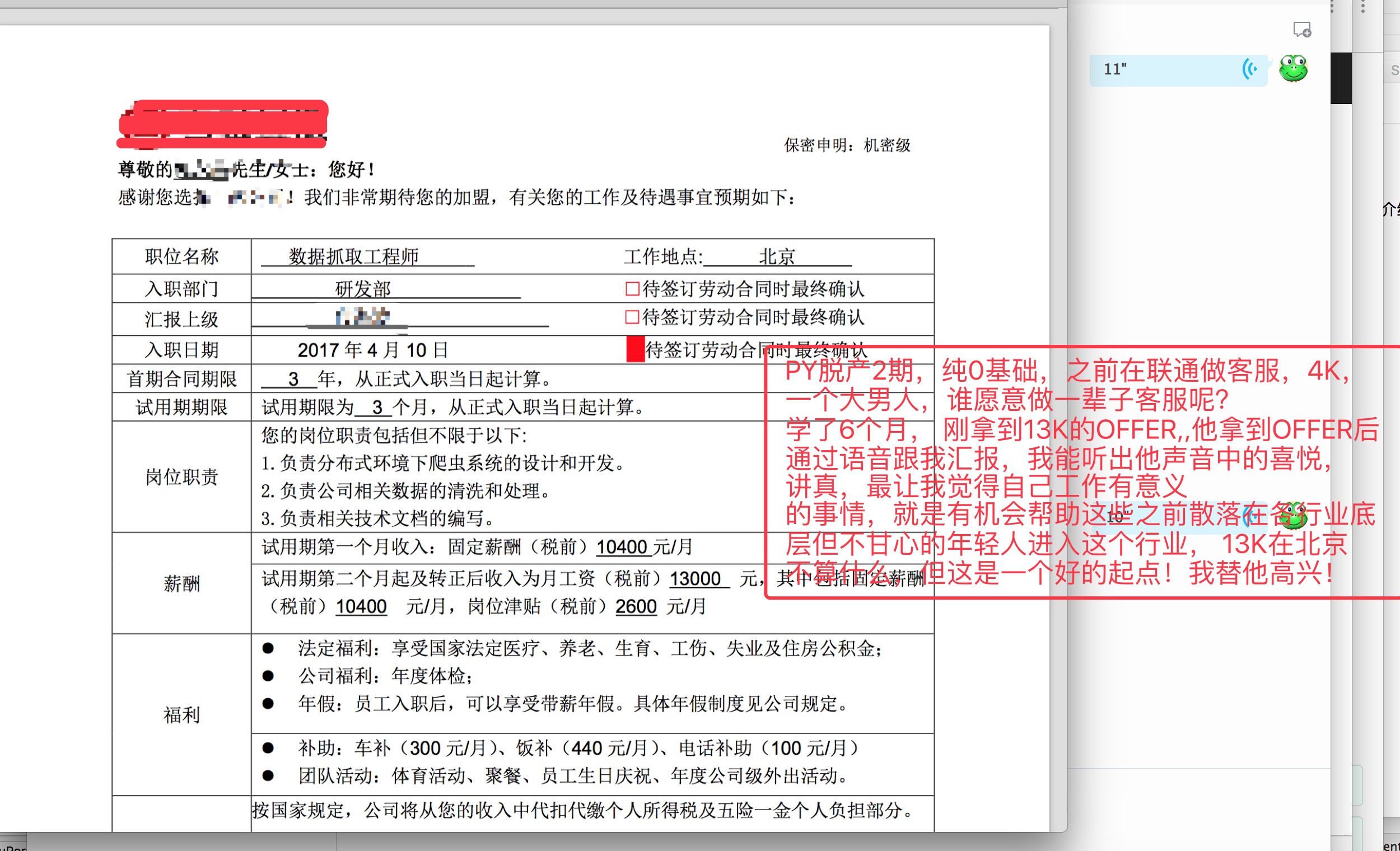

程序员如何实现财富自由

程序员如何实现财富自由?今天我想和大家聊聊这个事情。

财富自由应该是所有人的终极目标,但实现财富自由似乎是一件不太可能的事情,即使程序员的平均工资已经非常高了。

我个人经常在想,当我财富自由的时候,可以不用…

28岁程序员期权过亿从字节退休,当事人:同级的张天一比我财富自由多了

近日,知乎一篇“如何看待年仅28岁的郭宇宣布从字节跳动退休?”引发网友热议。6月16日,当事人前字节跳动程序员郭宇对此回应称,“我其实不太希望有人谈论我,人生的路还很长,希望我们每个人能尽量往前看。” …

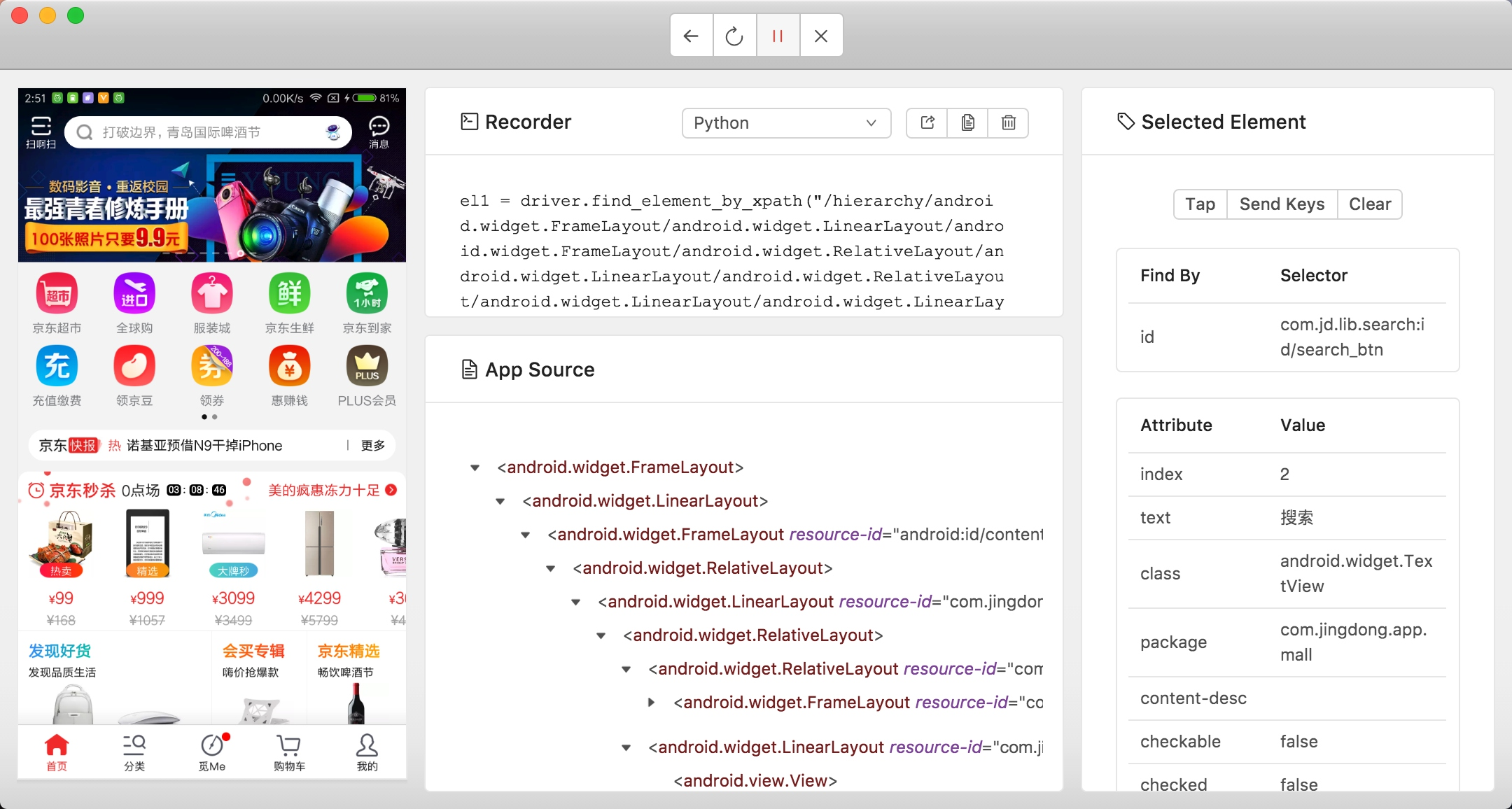

10分钟学会python写游戏脚本!Python其实很简单

前言

最近在玩儿公主连结,之前也玩儿过阴阳师这样的游戏,这样的游戏都会有个初始号这样的东西,或者说是可以肝的东西。

当然,作为一名程序员,肝这种东西完全可以用写代码的方式帮我们自动完成。游戏脚本其实并不高深…

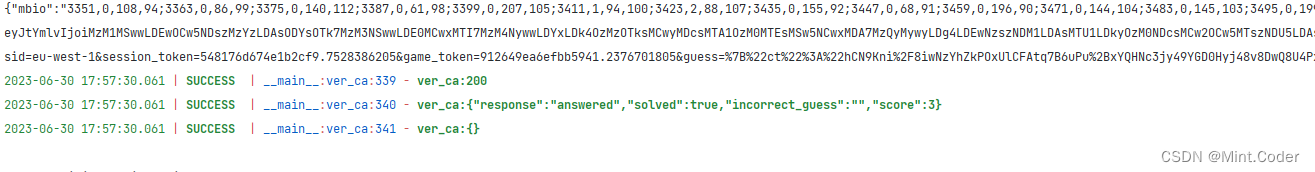

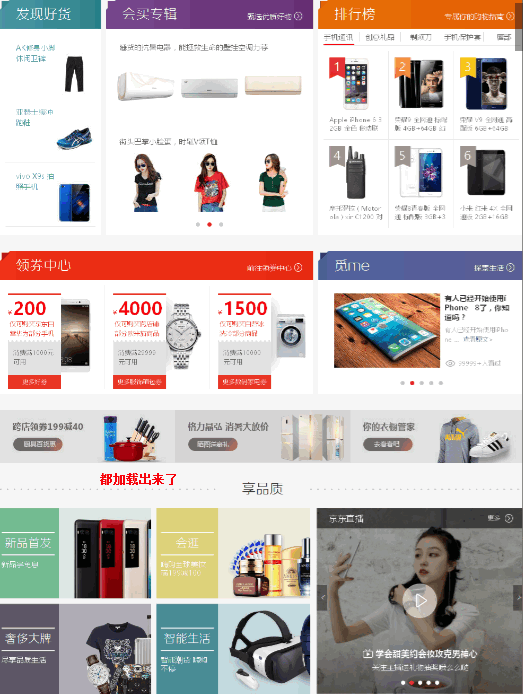

Python大神80行代码实现“头脑王者”,运营窍诀躺着教你赚钱!

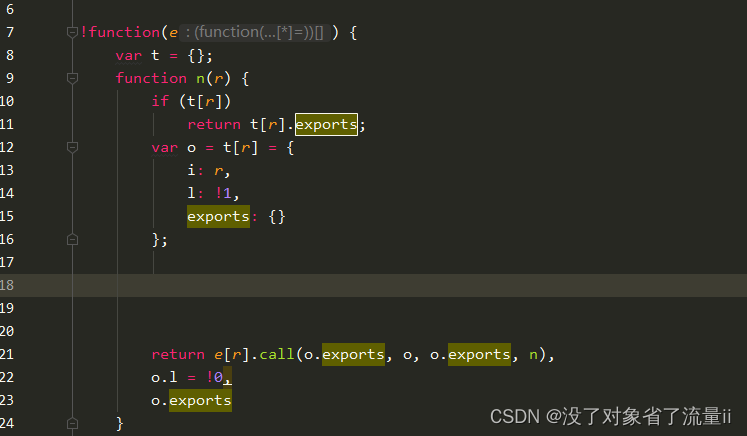

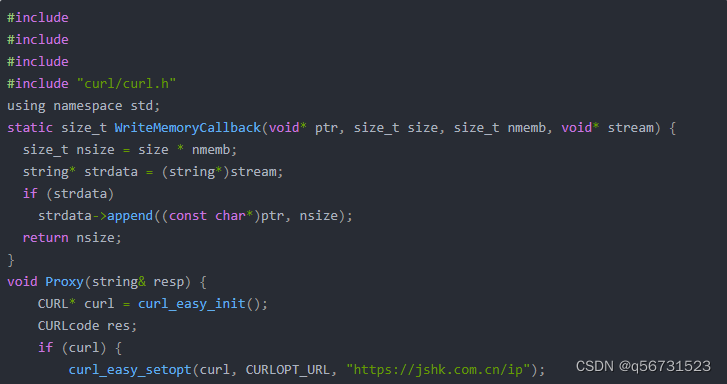

最近感觉微信小程序比较火、头脑王者,周围很多人在玩“跳一跳”和“头脑王者”之类的小游戏。

我对小程序也产生了浓厚的兴趣。一开始看到官方的小程序的介绍,也看了小程序的部分开发文档,本能以为微信小程序不过是一个浏览器框架࿰…

分享快速提高网站收录的五点技巧

1、404页面 404页面主要是为了防止网站的死链接出现,当一个文章页面不存在,但又出现在搜索引擎索引库的时候,那么搜索引擎爬虫就会抓取到死链接,如果出现大量死链接的话,那么对于日后网站的收录是非常有影响的…

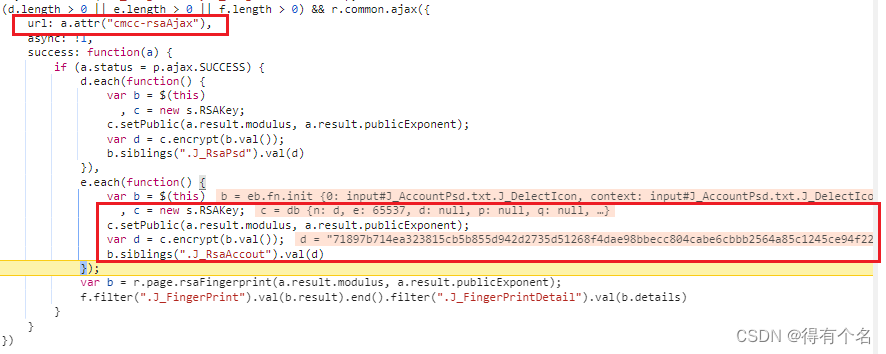

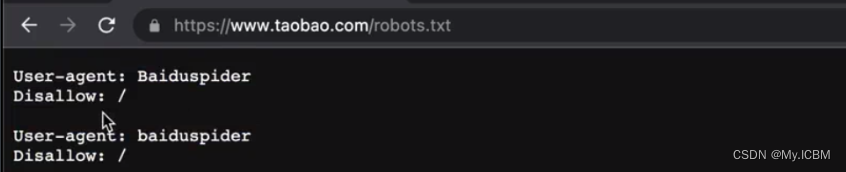

Python爬虫实战五之模拟登录淘宝并获取所有订单

经过多次尝试,模拟登录淘宝终于成功了,实在是不容易,淘宝的登录加密和验证太复杂了,煞费苦心,在此写出来和大家一起分享,希望大家支持。 温馨提示 更新时间,2016-02-01,现在淘宝换成…

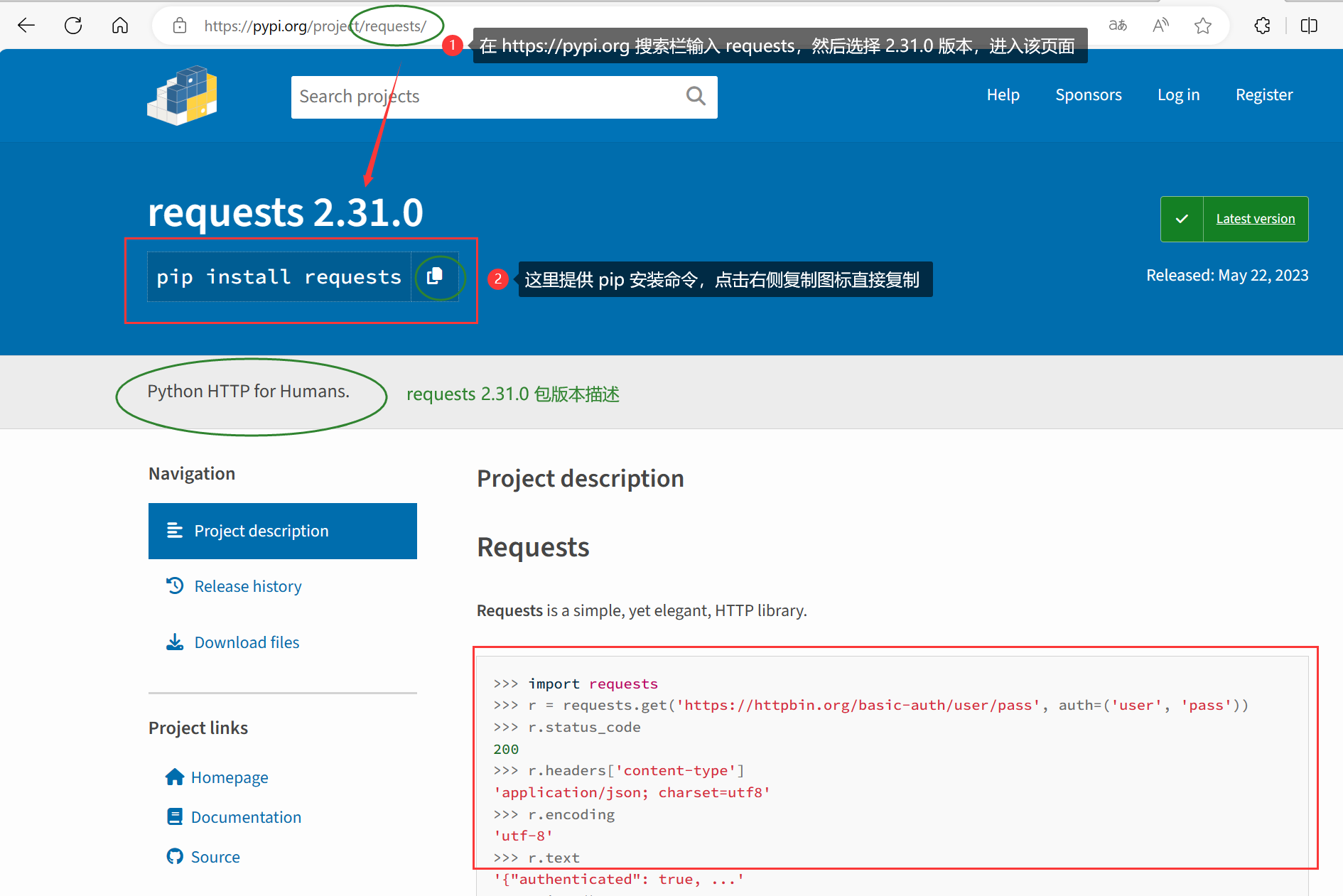

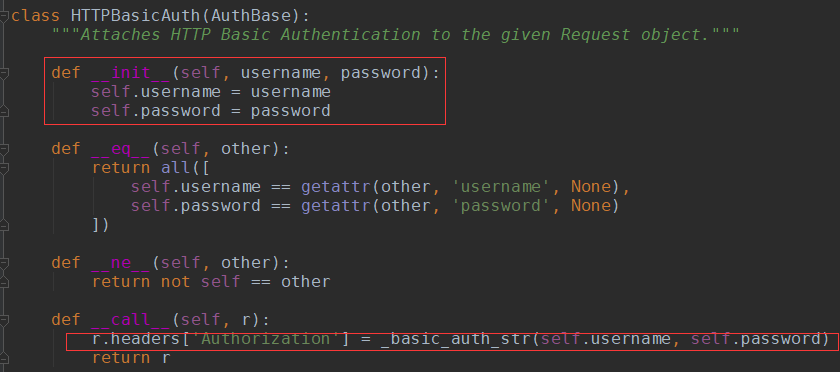

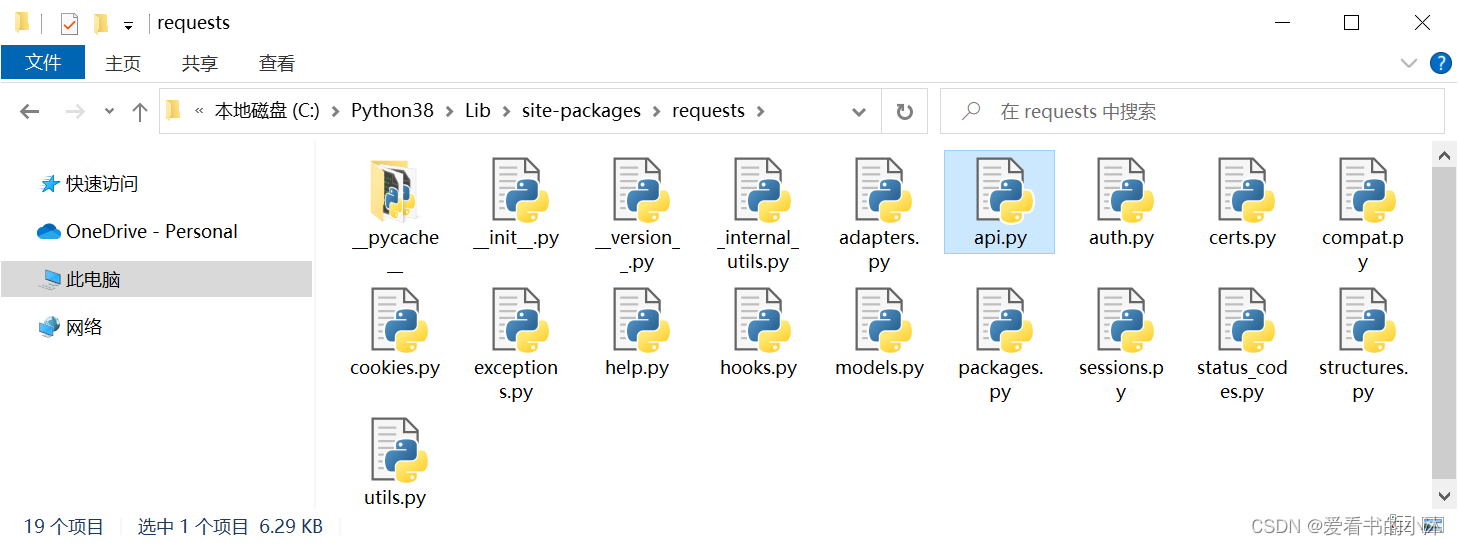

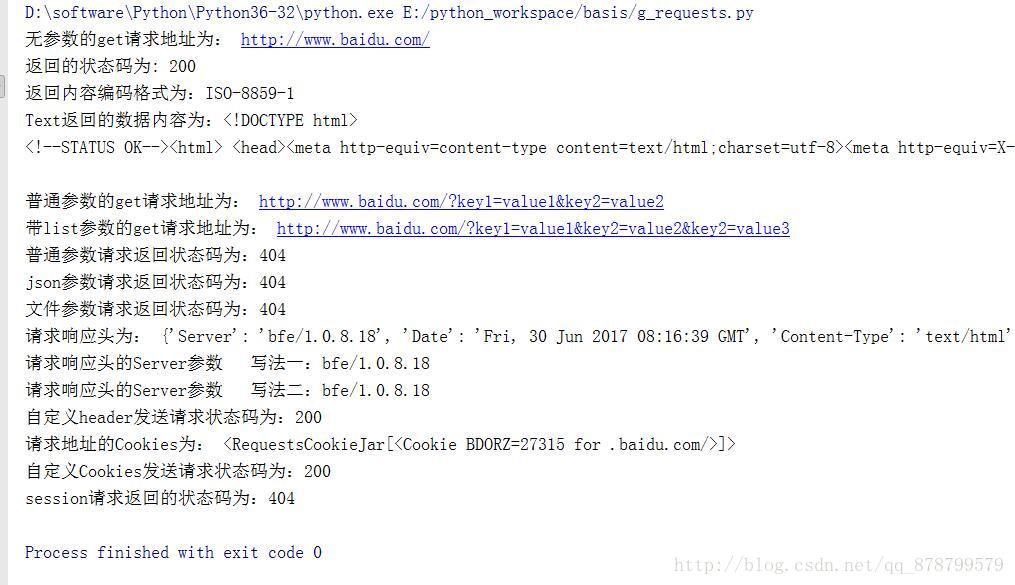

爬虫入门系列(二):优雅的HTTP库requests

在系列文章的第一篇中介绍了 HTTP 协议,Python 提供了很多模块来基于 HTTP 协议的网络编程,urllib、urllib2、urllib3、httplib、httplib2,都是和 HTTP 相关的模块,看名字觉得很反人类,更糟糕的是这些模块在 Python2 与…

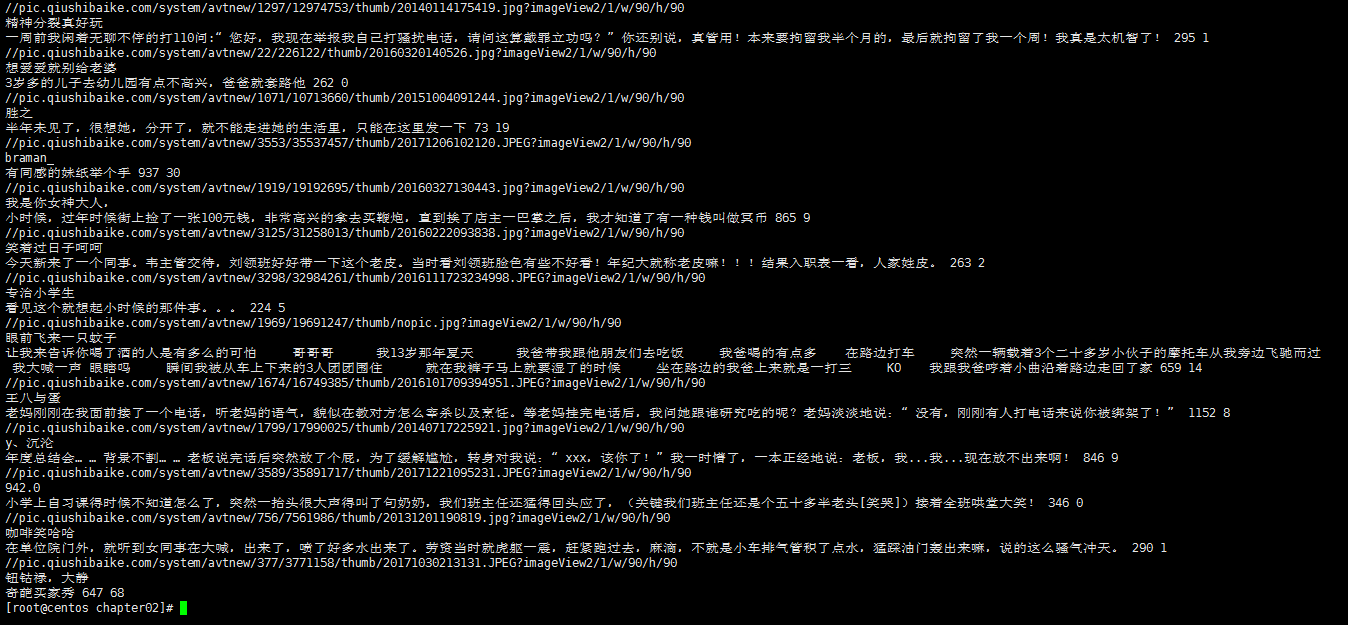

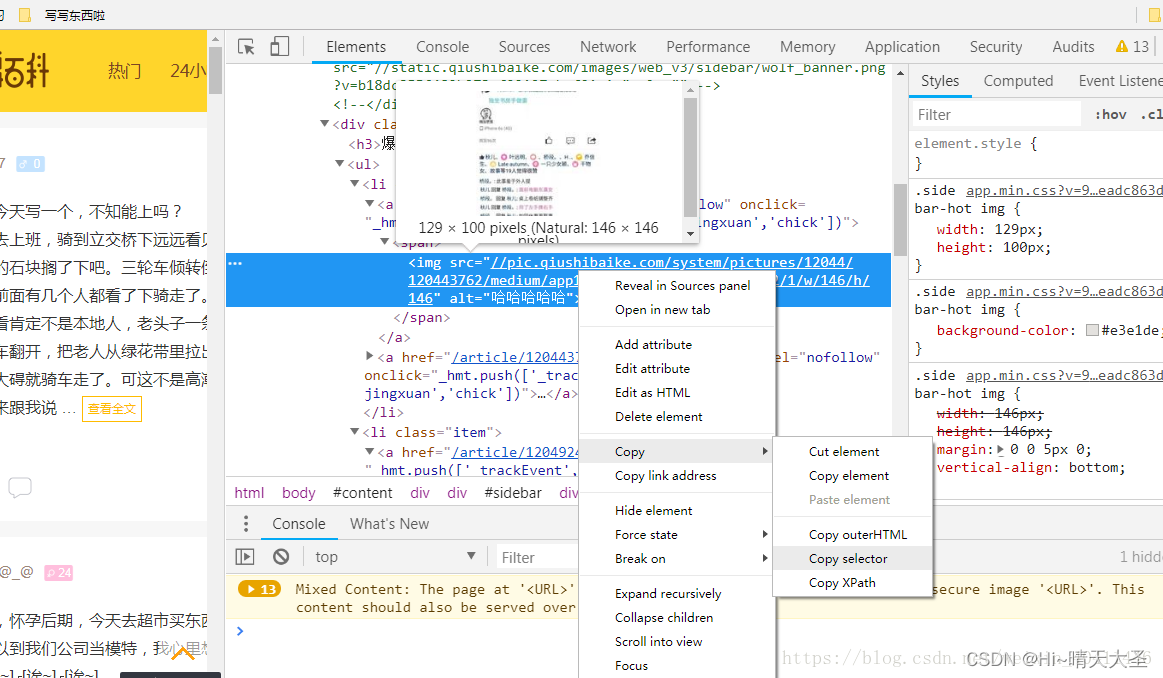

爬虫二:爬取糗事百科段子

这一次我们利用BeautifulSoup进行网页的解析,方法其实跟前一次的差不多,只是这里我们爬取的是糗事百科,糗事百科有反爬机制,我们需要模拟用户来访问糗事百科网站,也就是加上头部信息headers,其实整体思路与上一篇所写爬…

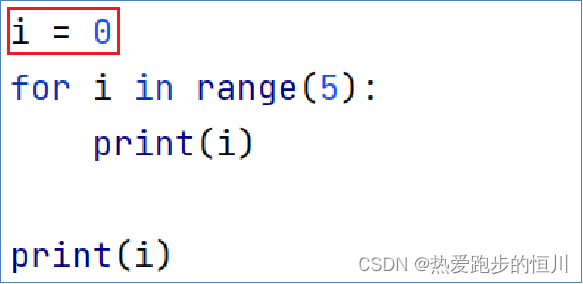

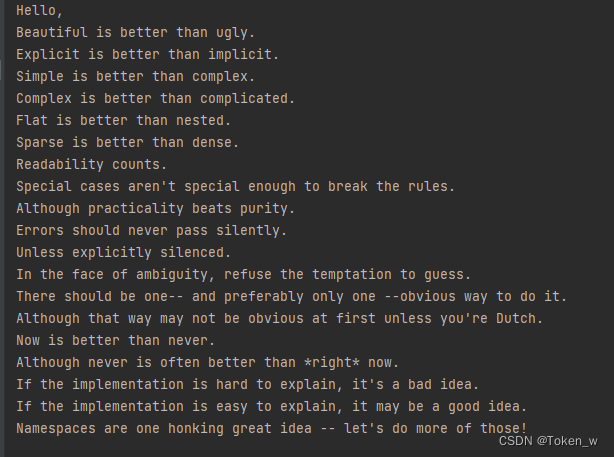

代码这样写更优雅(1)

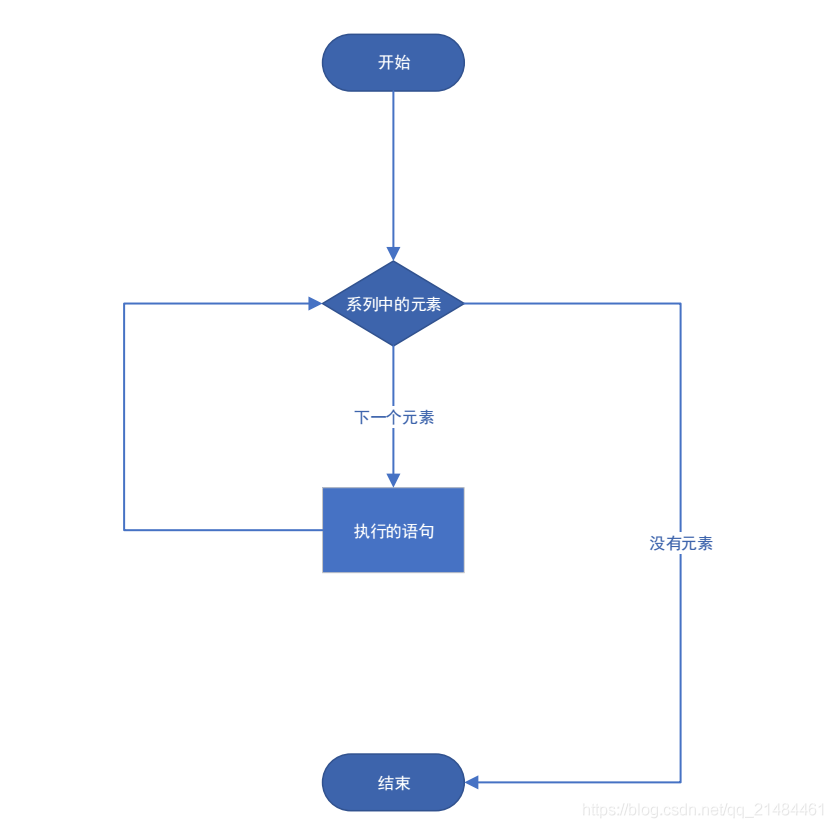

这个文章是转载的,通过优雅的代码,可以提现python的优美和我们的能力,后续不定期的更新: 1)变量交换: a,bb,a 2)循环遍历: 一般人都写:for i in range(6):,实…

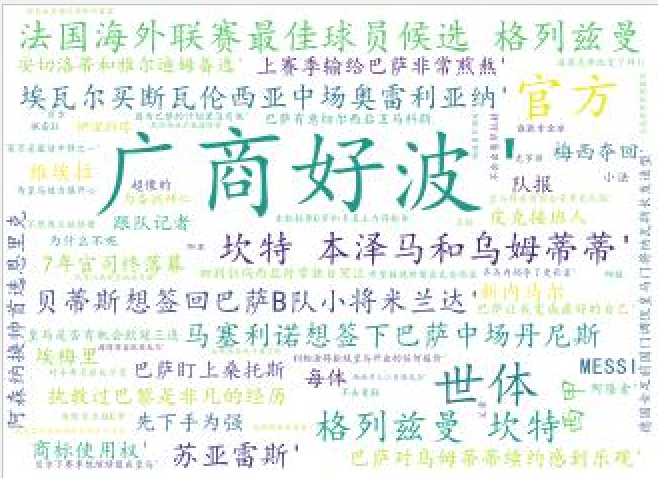

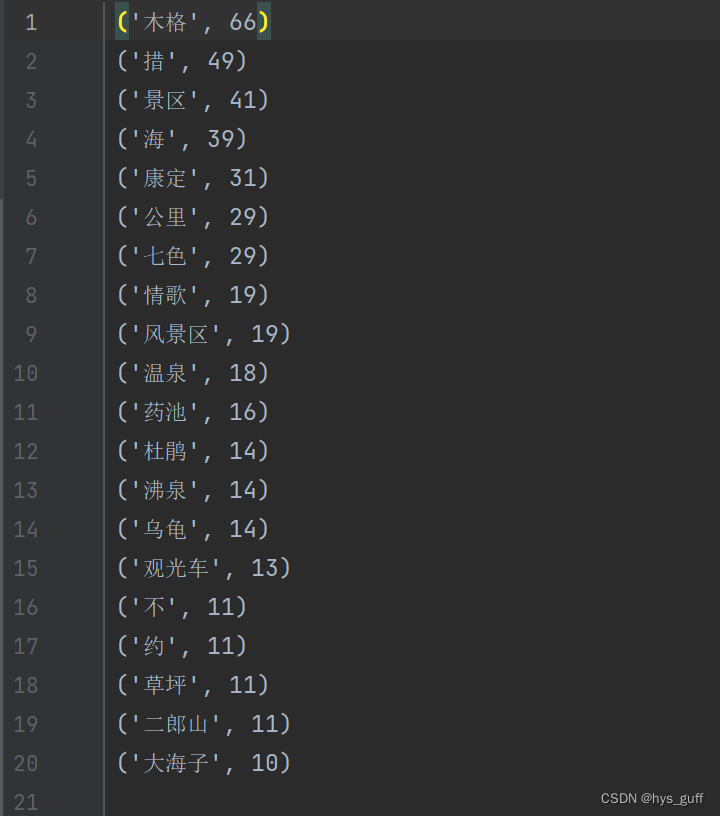

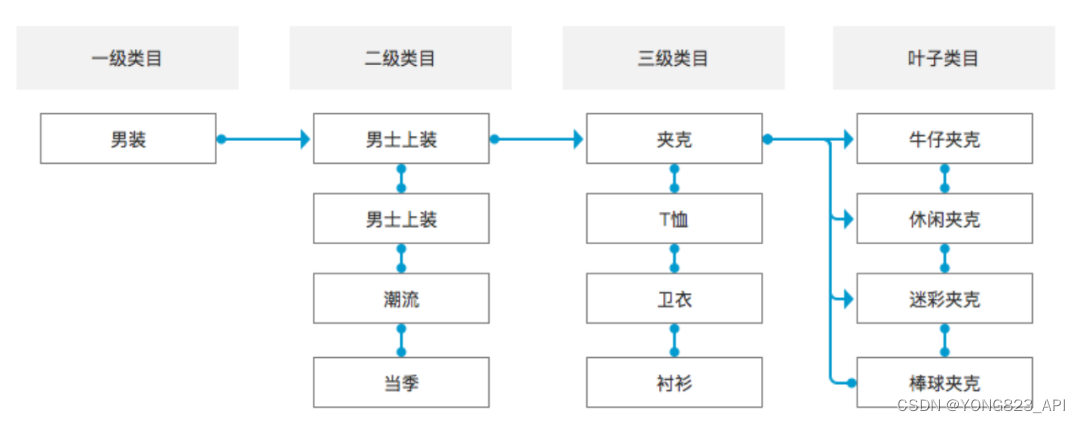

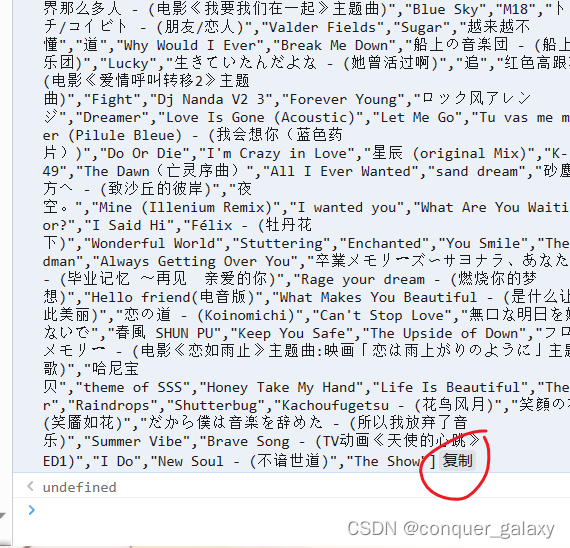

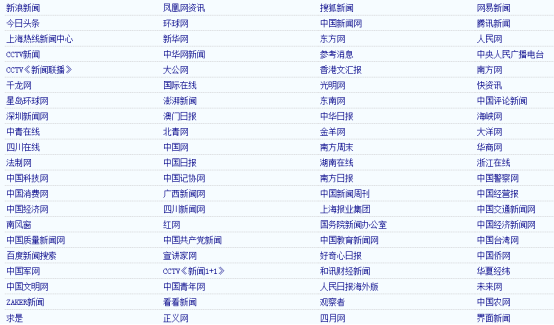

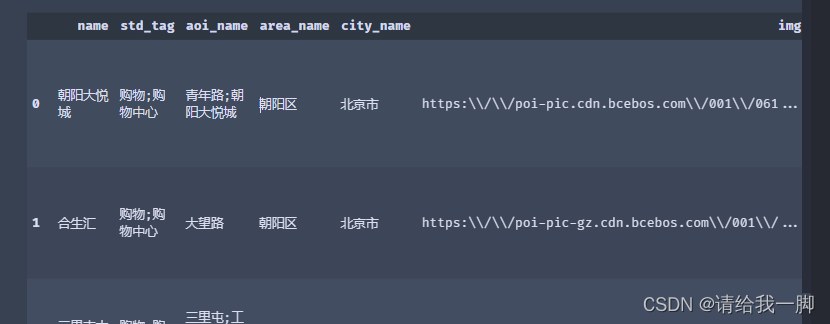

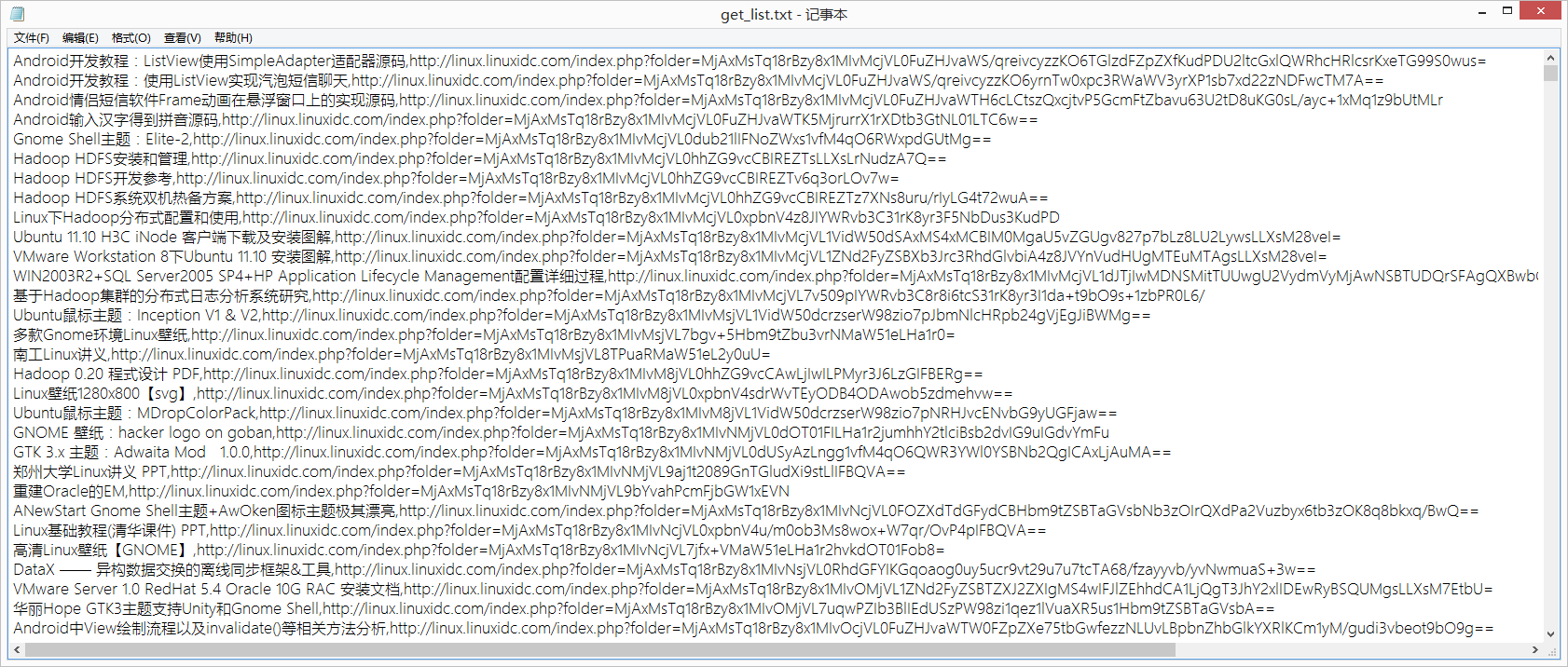

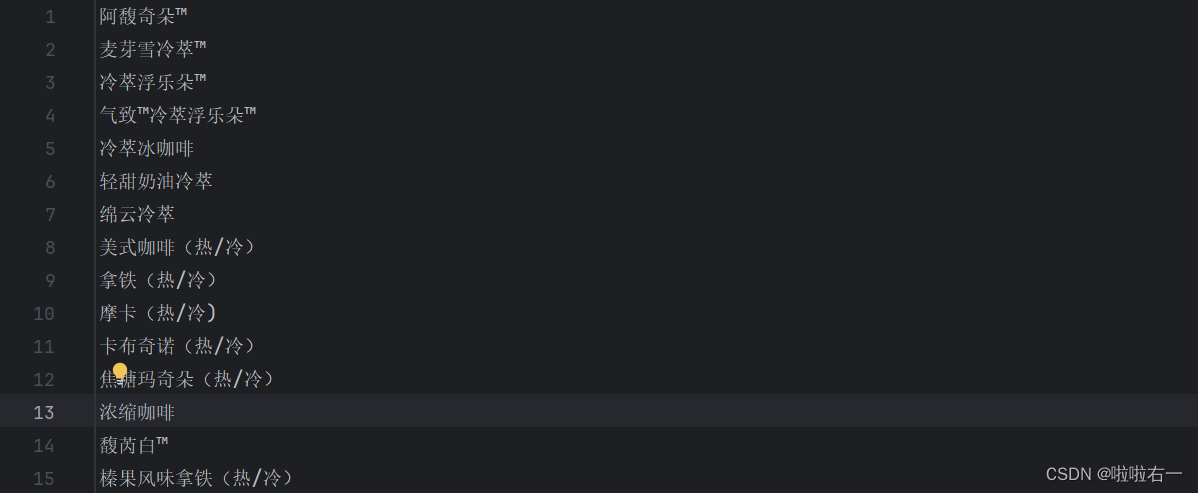

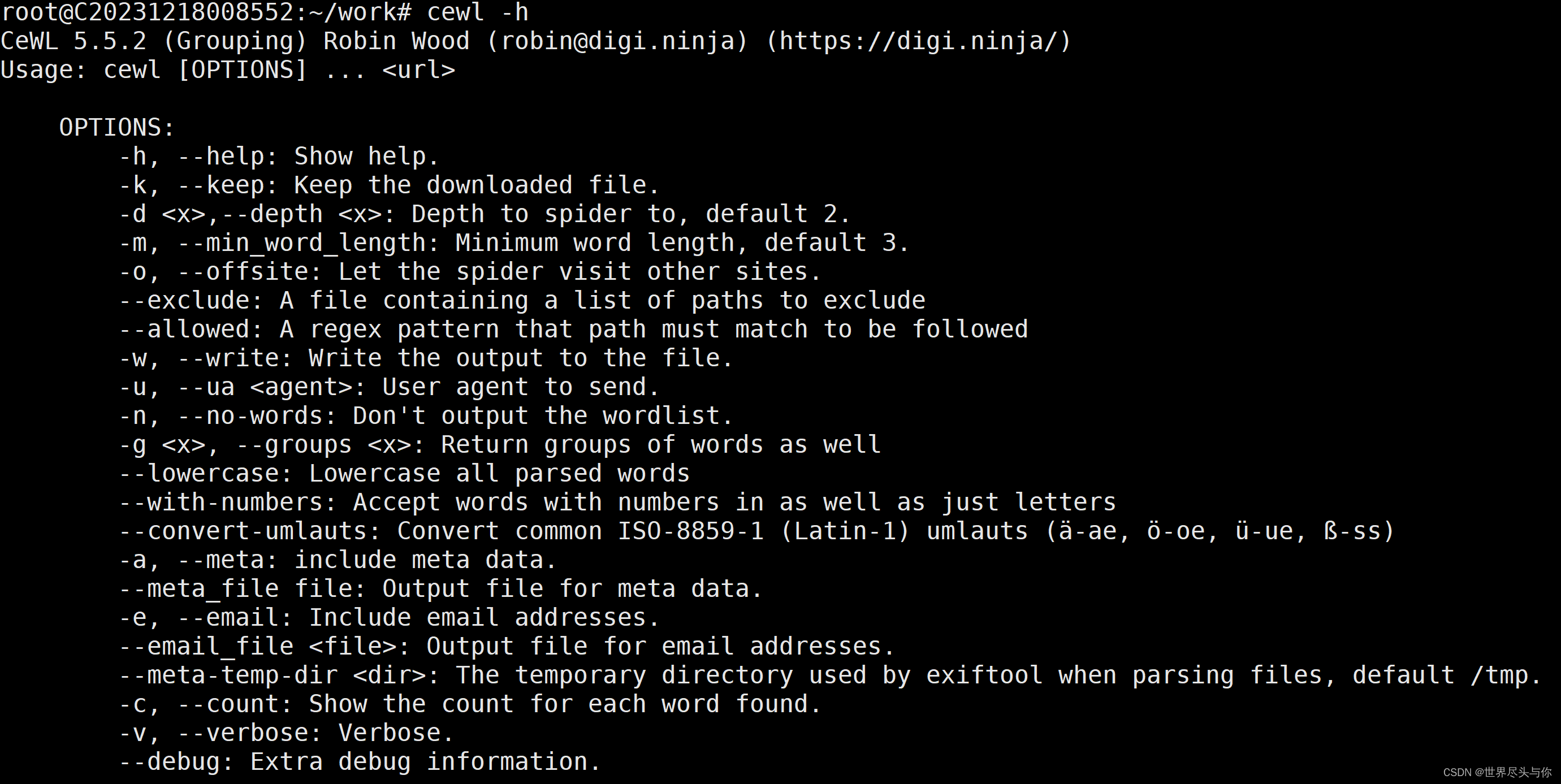

获取百度地图POI数据二(准备搜索关键词)

上篇讲到 想要获取尽可能多的POI数据 需要准备尽可能多的搜索关键字 那么这些关键字如何得来呢? 本人使用的方法是通过一些网站来获取这些关键词 http://poi.mapbar.com/这个网站有全国各地的POI数据 对各个城市的POI数据都有归类 我便是从这个网站上面获取…

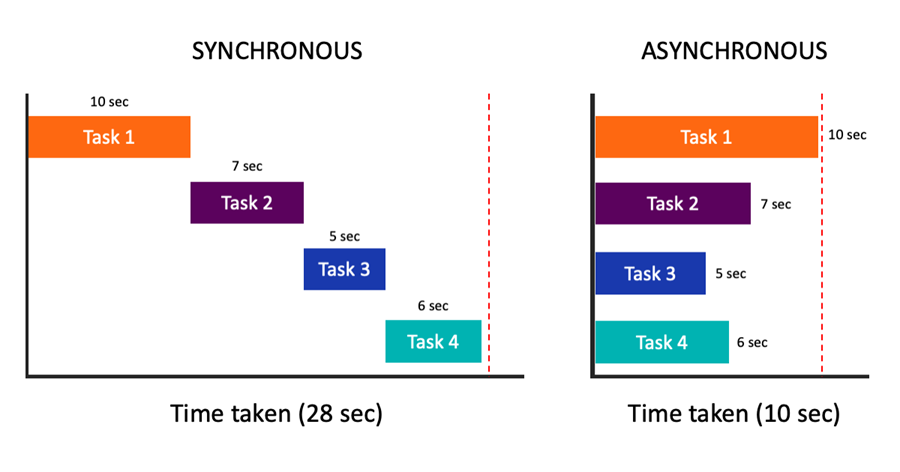

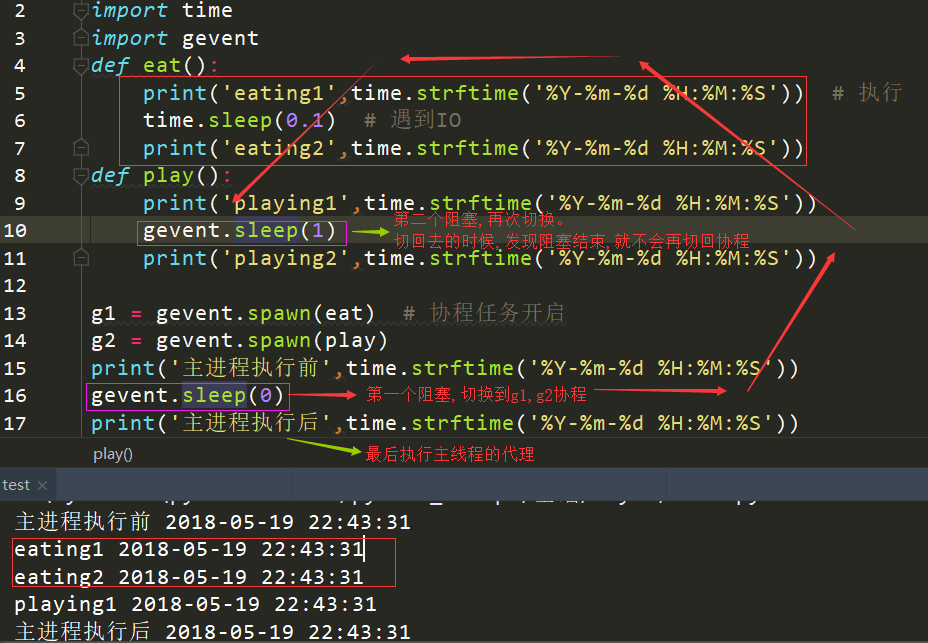

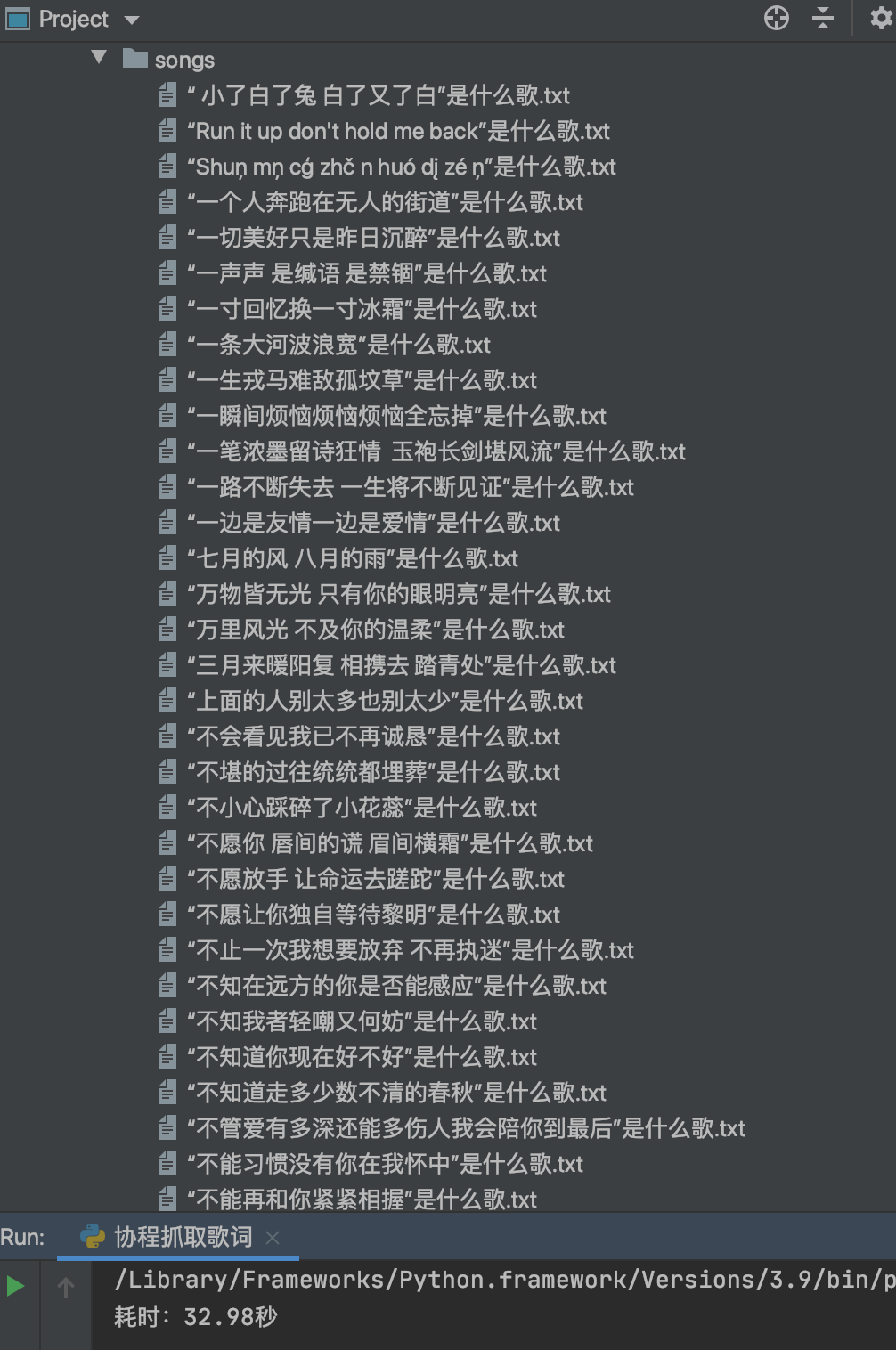

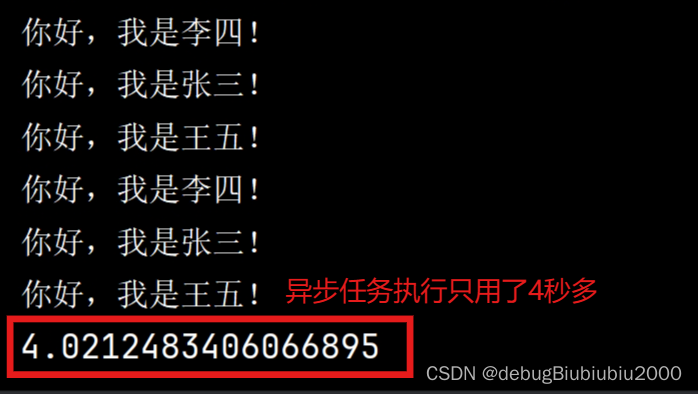

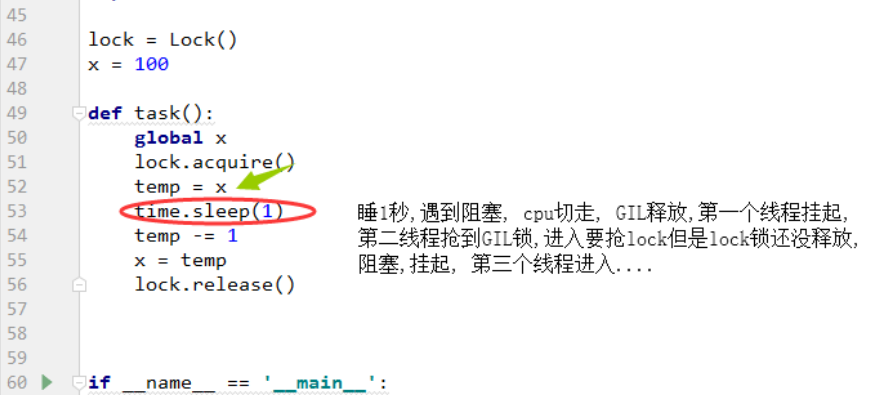

Python协程讲解

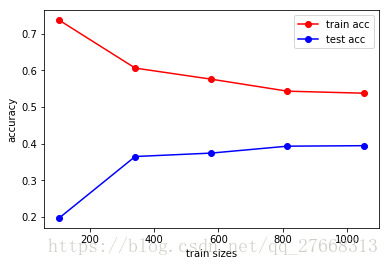

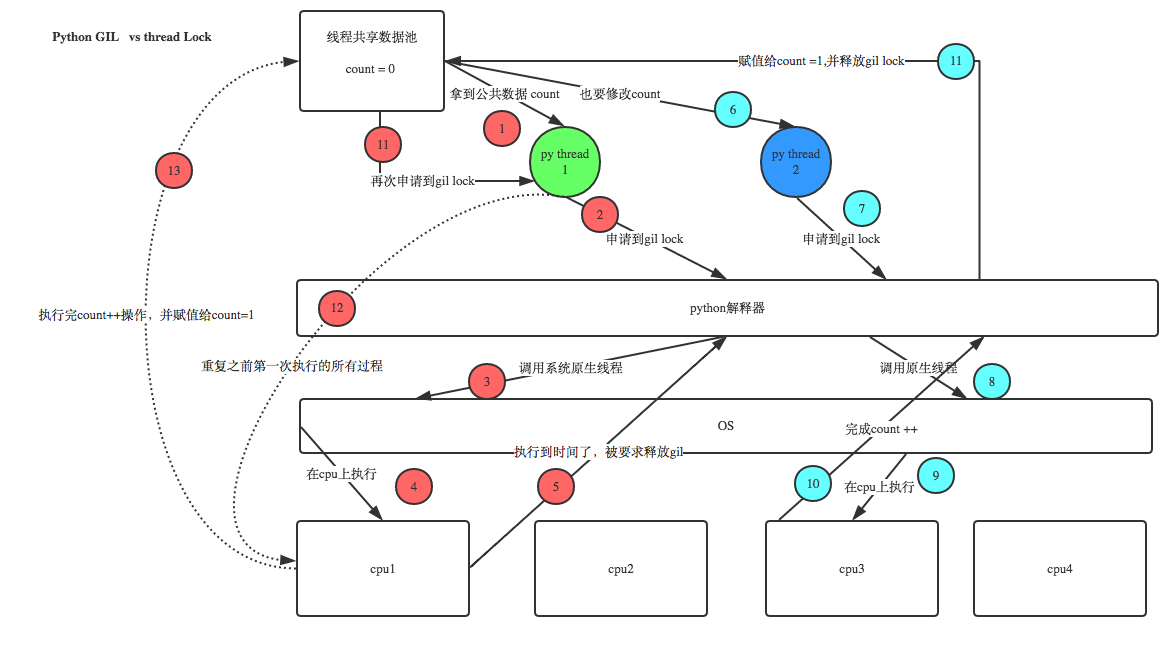

上篇文章我们说过由于GIL锁的限制,导致Python不能充分利用多线程来实现高并发,在某些情况下使用多线程可能比单线程效率更低,所以Python中出现了协程。协程(coroutine) 又称微线程,是一中轻量级的线程&…

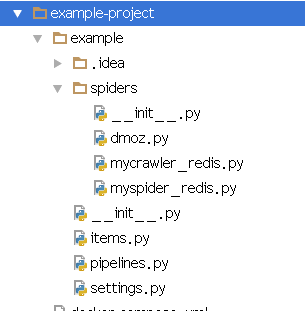

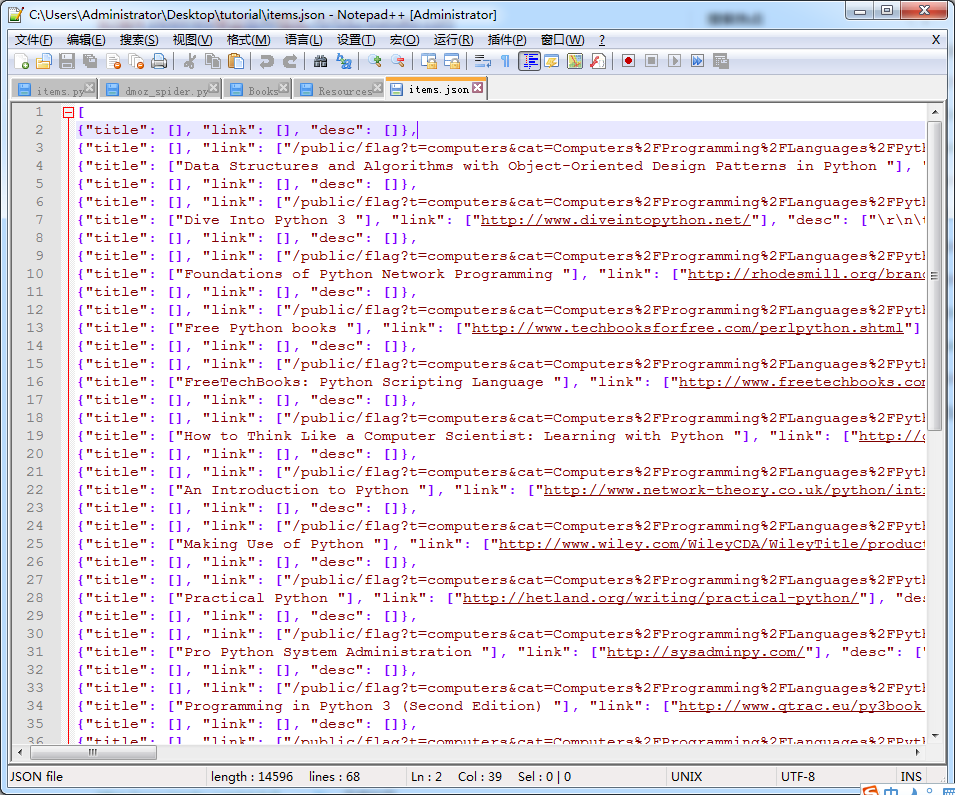

scrapy 的三个入门应用场景

说明: 本文参照了官网的 dmoz 爬虫例子。 不过这个例子有些年头了,而 dmoz.org 的网页结构已经不同以前。所以我对xpath也相应地进行了修改。 概要: 本文提出了scrapy 的三个入门应用场景 爬取单页根据目录页面,爬取所有指向的页面…

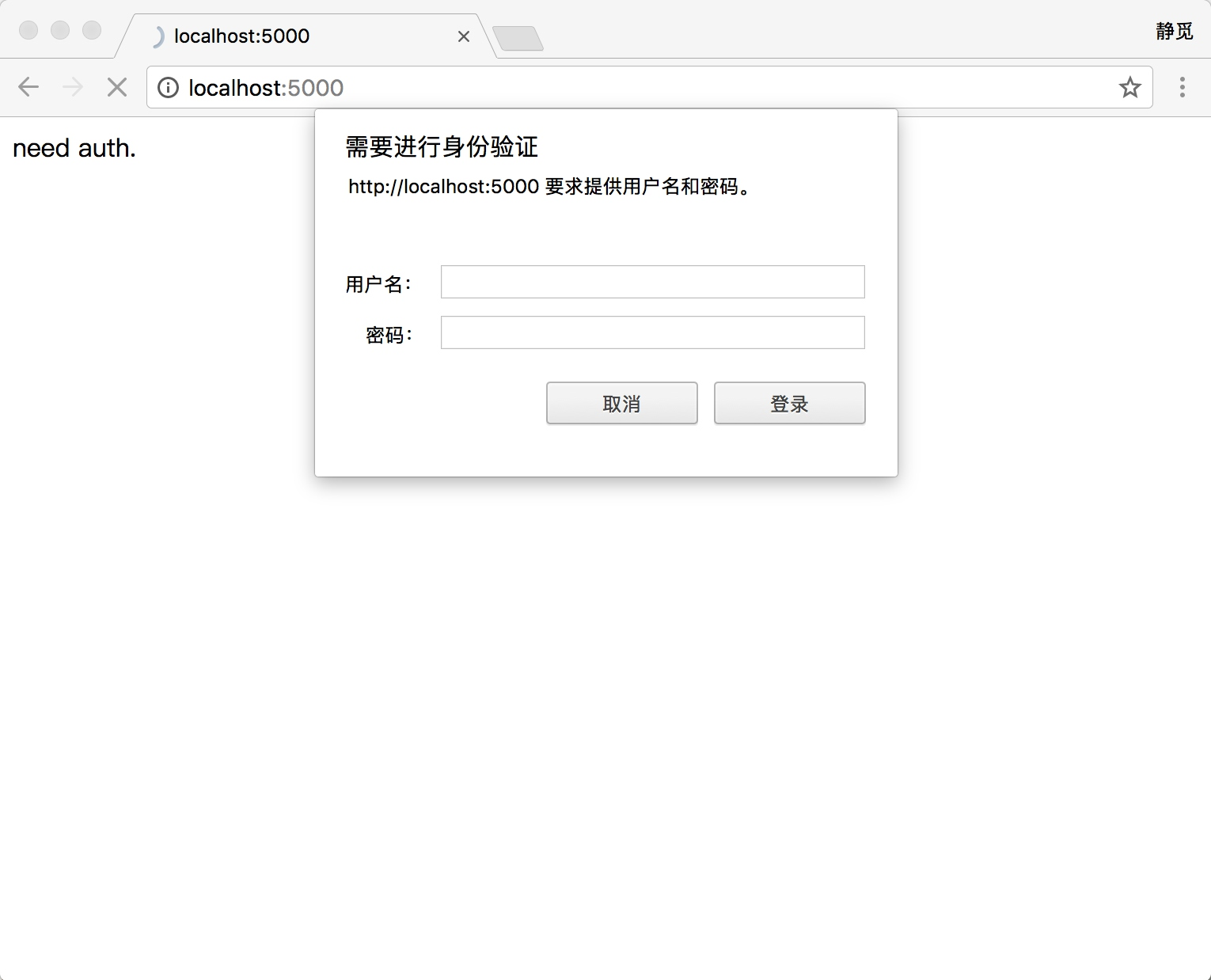

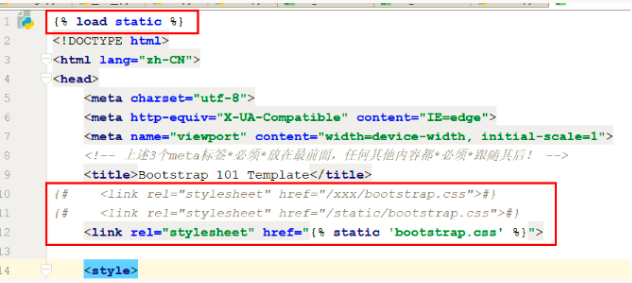

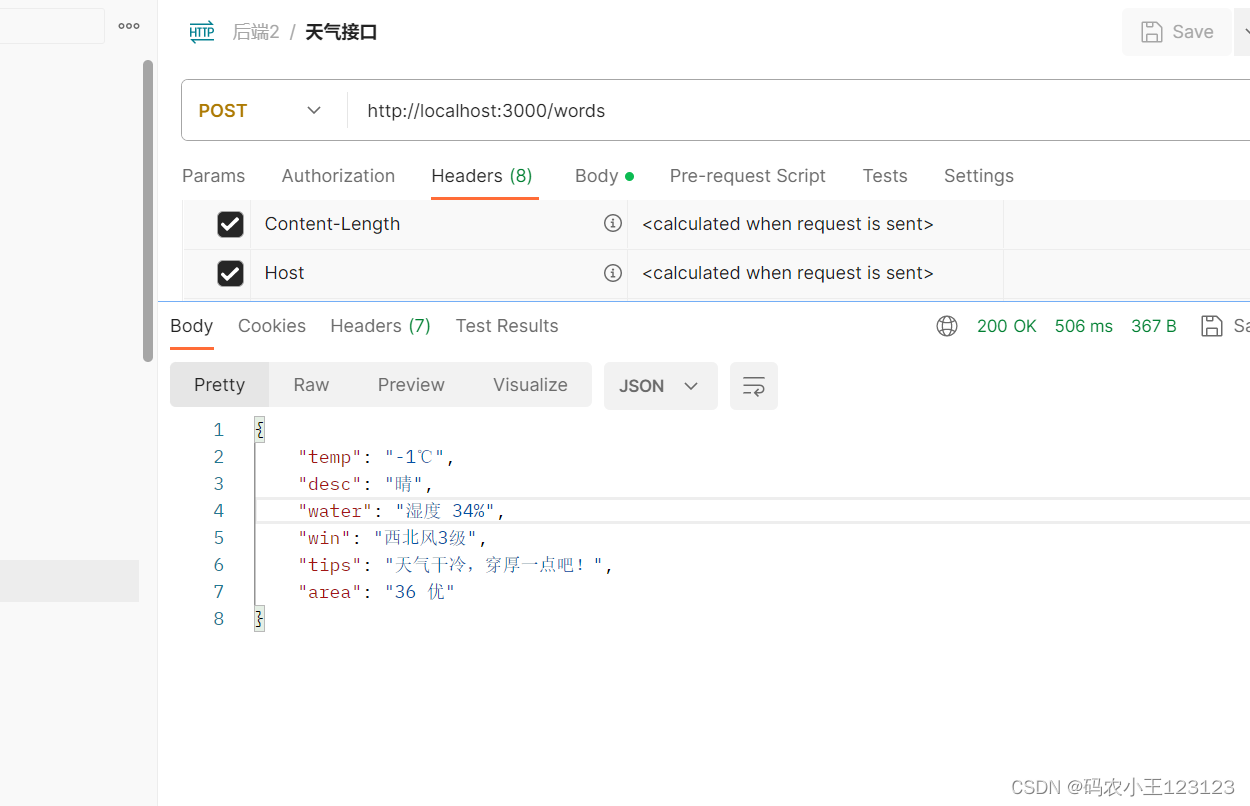

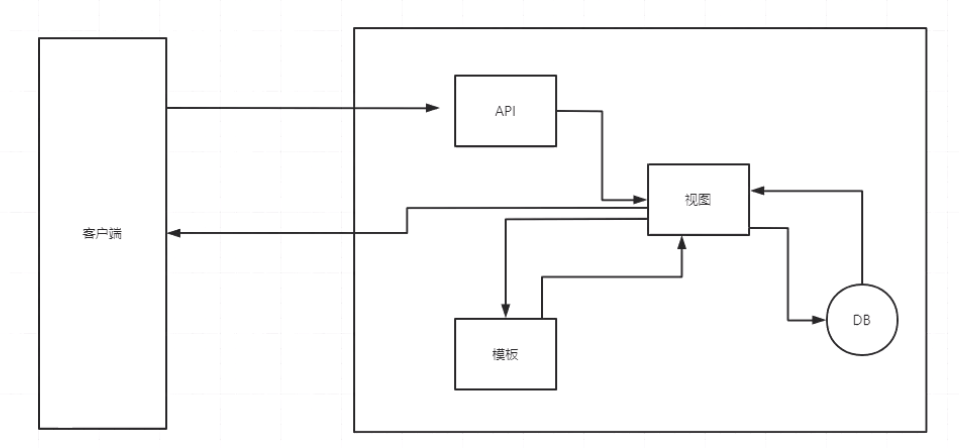

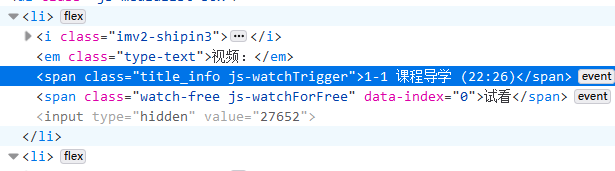

慕课网Flask高级编程实战-3.蓝图、模型与CodeFirst

3.1 应用、蓝图与视图函数 1.Flask的层级关系 Flask最上层是app核心对象在这个核心对象上可以插入很多蓝图,这个蓝图是不能单独存在的,必须将app作为插板插入app在每一个蓝图上,可以注册很多静态文件,视图函数,模板一个…

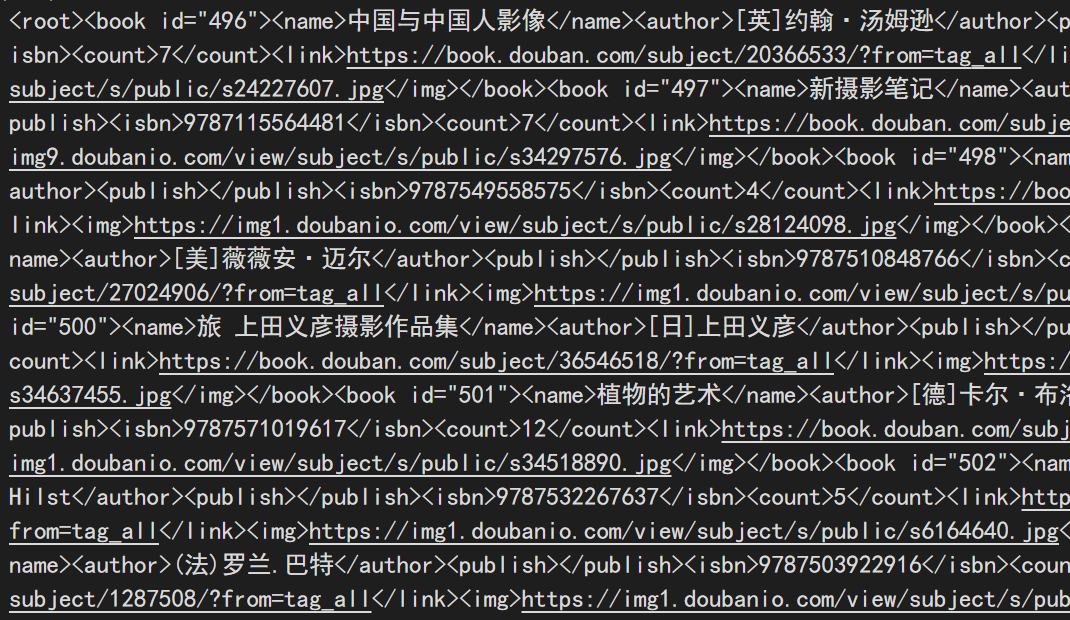

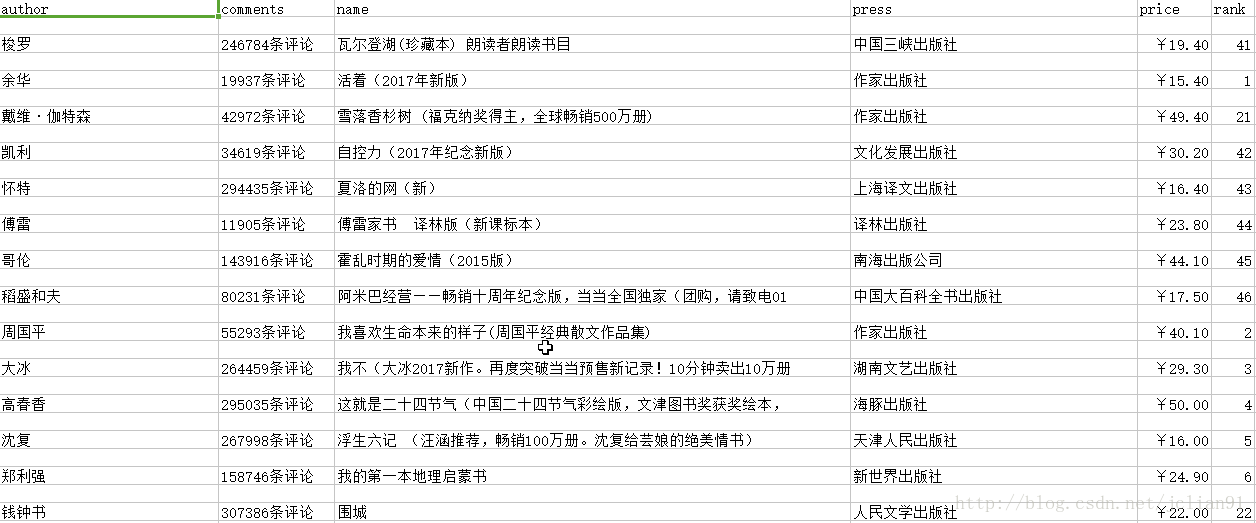

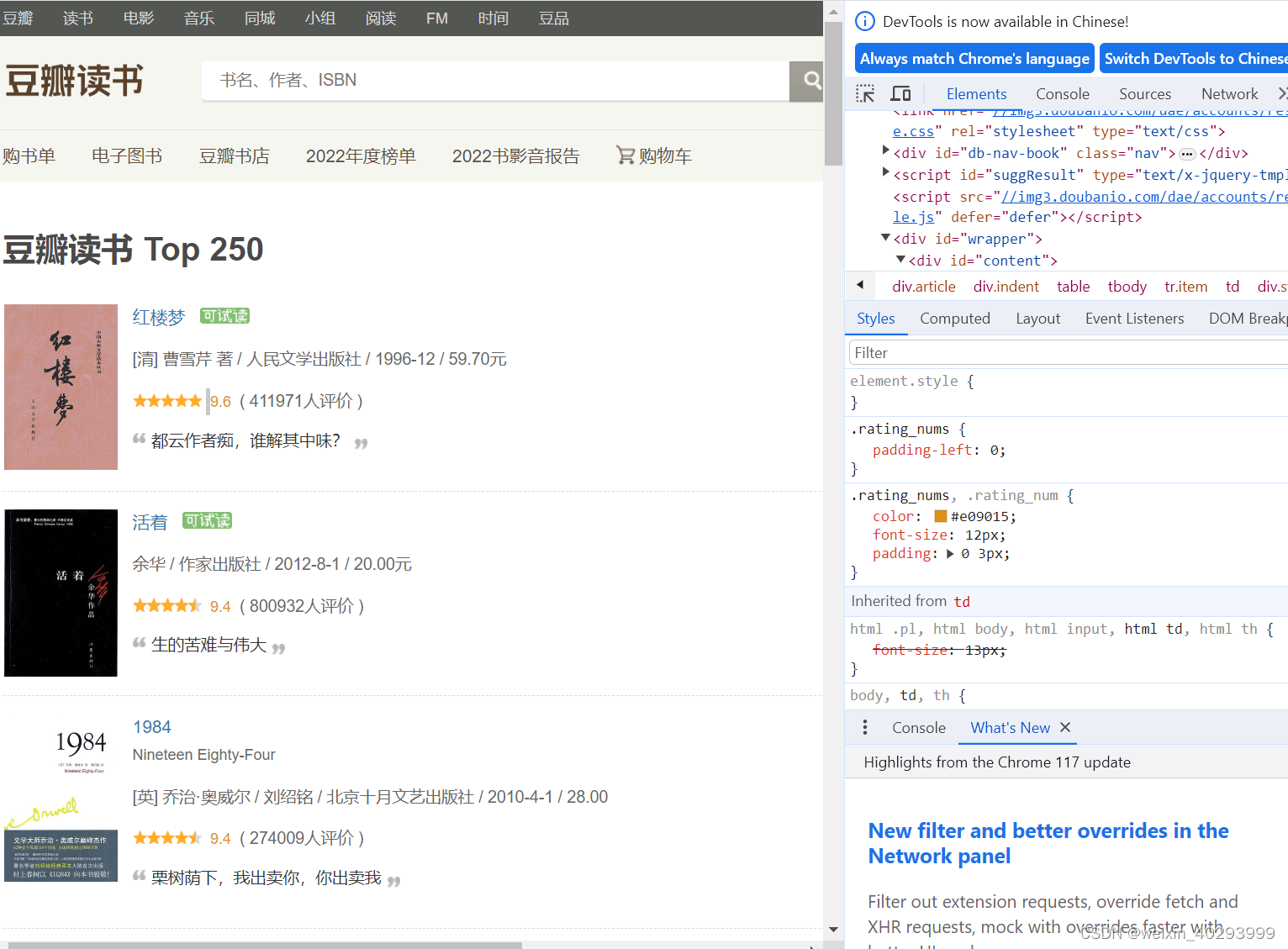

利用正则表达式爬取豆瓣读书top250书籍信息 附有详细分析

import csv

from lxml import etree

import requestsfpopen(C:\\Users\我的电脑\Desktop\doubanbook.csv,wt,newline,encodingutf-8)

writercsv.writer(fp) #创建csv

writer.writerow((name,url,author,publisher,date,price,rate,comment)) #在csv文件中写下这一行ur…

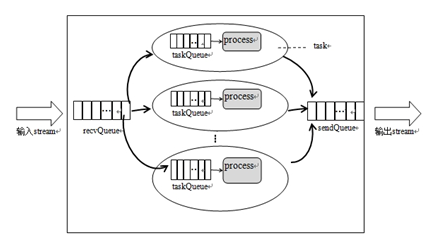

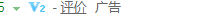

通用网络信息采集器(爬虫)设计方案

一、引言 Heritrix3.X与1.X版本变化比较大,基于此带来的Extractor定向扩展方法也受到影响,自定义扩展方面因为接口的变化受阻,从而萌生了通用网络信息采集器设计的想法。一直没有一个好的网络信息采集器,必须能够适应下载对象的多…

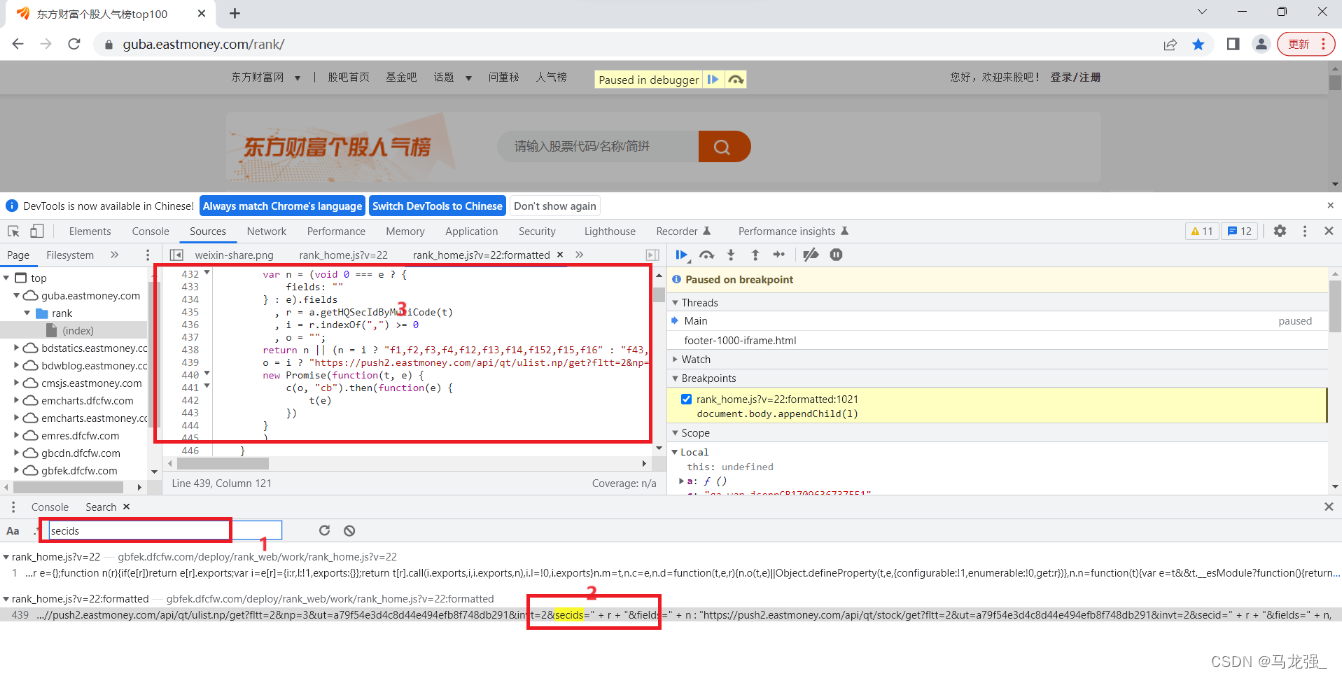

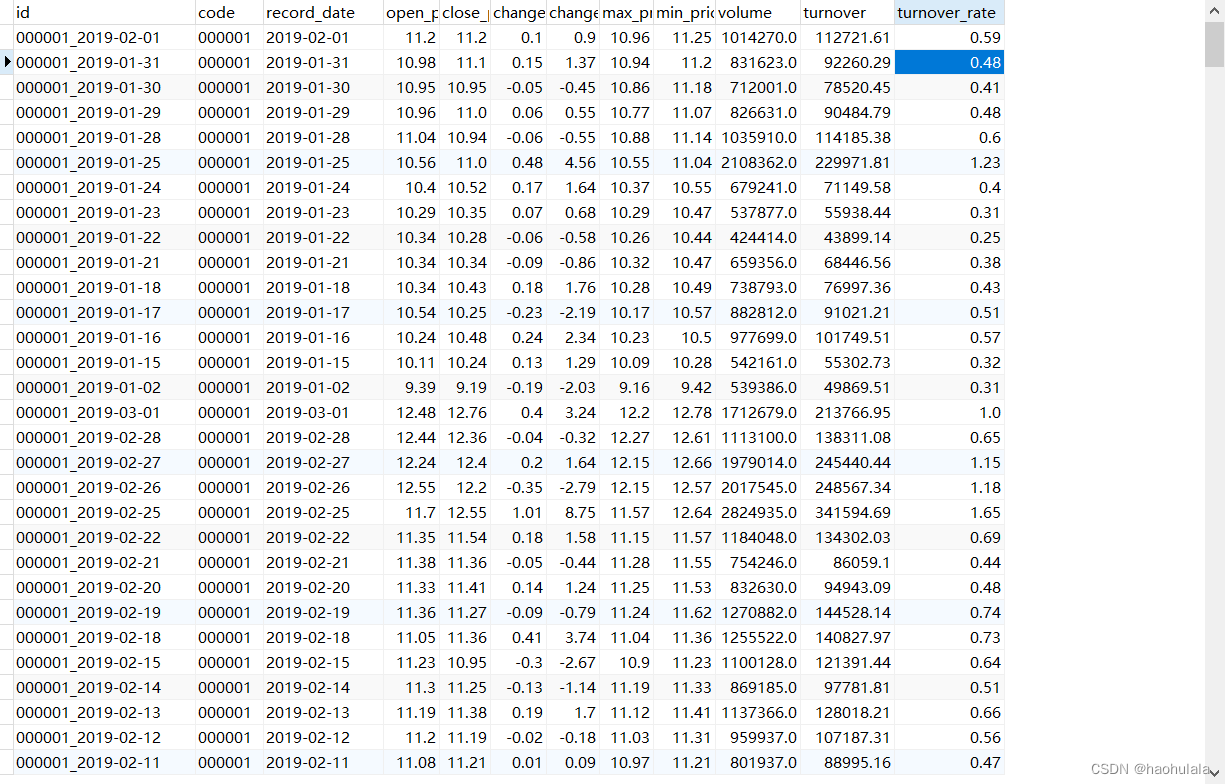

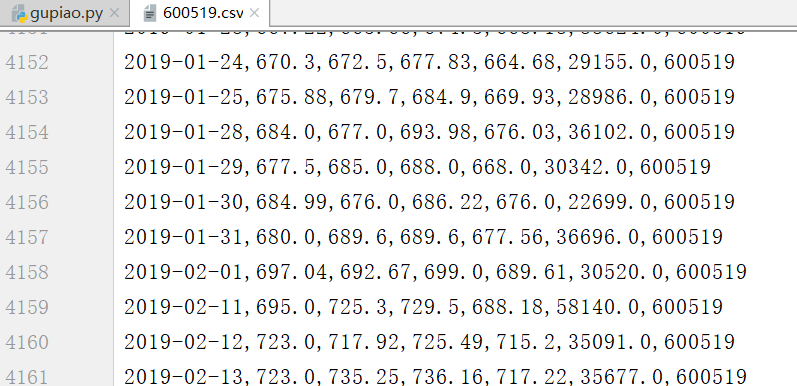

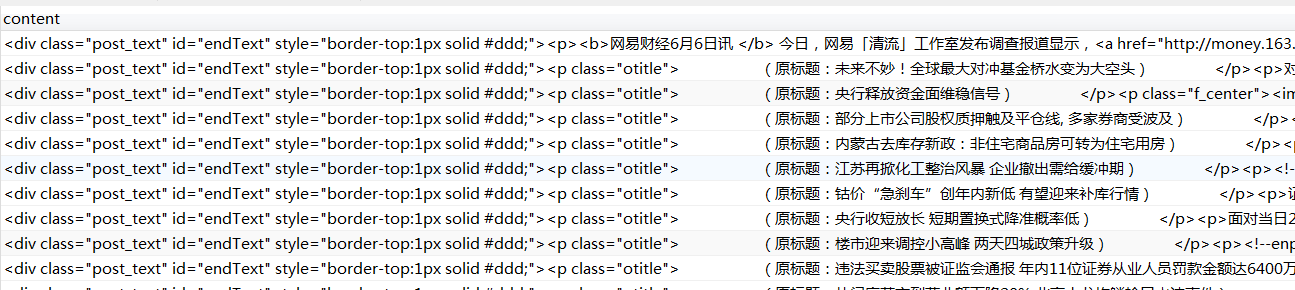

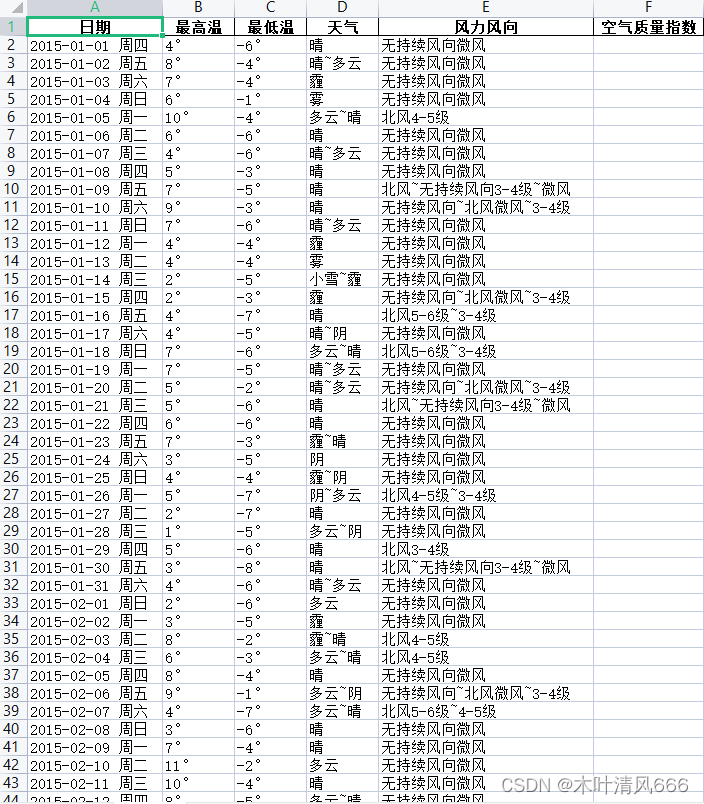

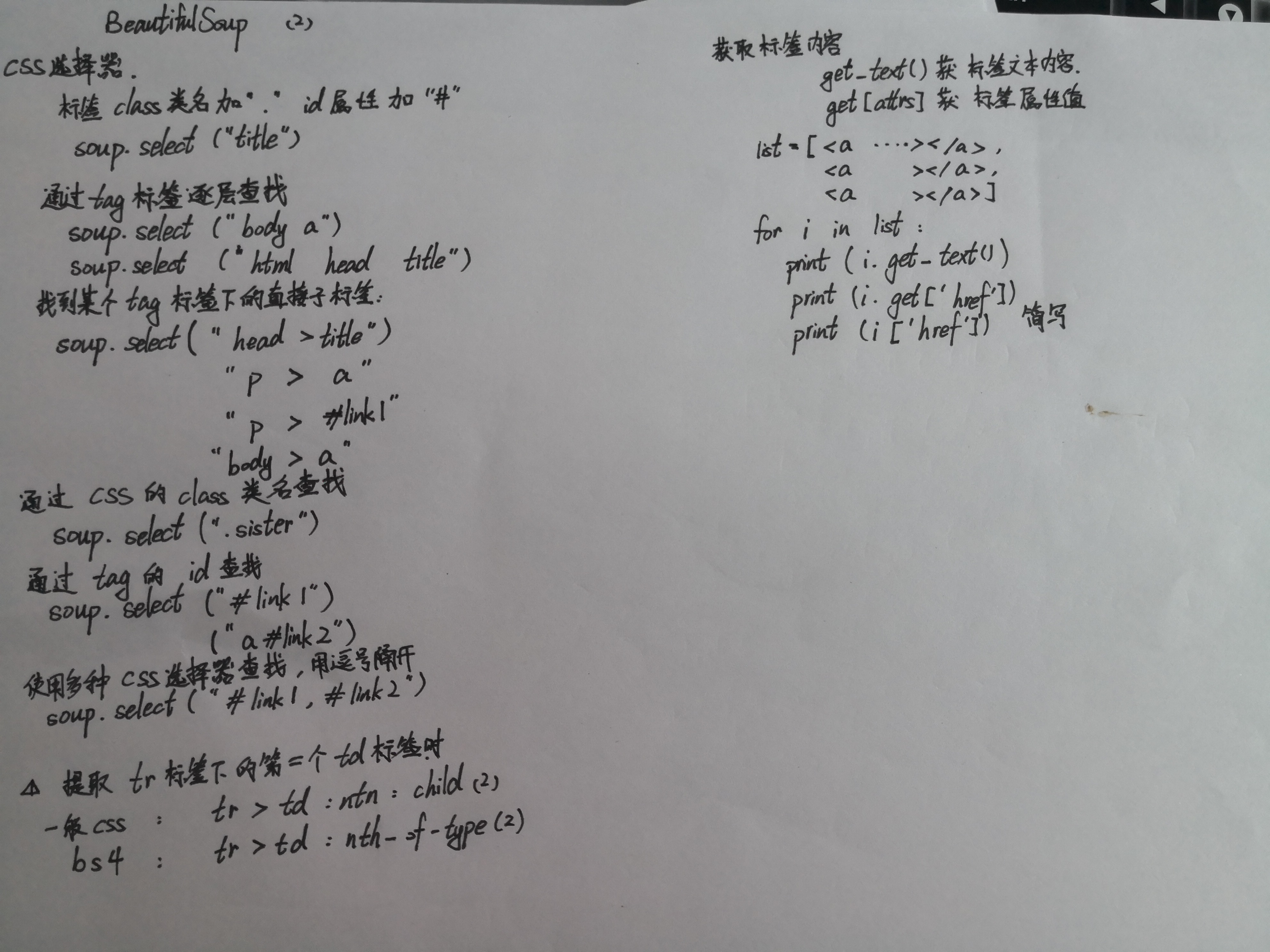

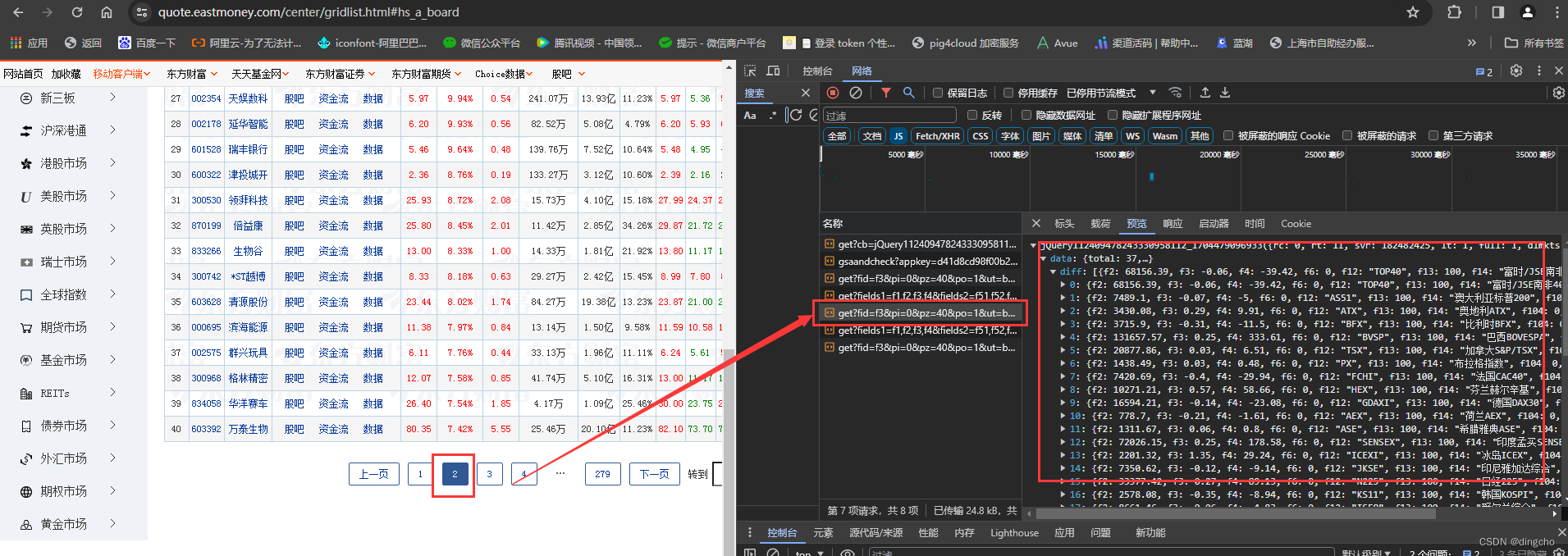

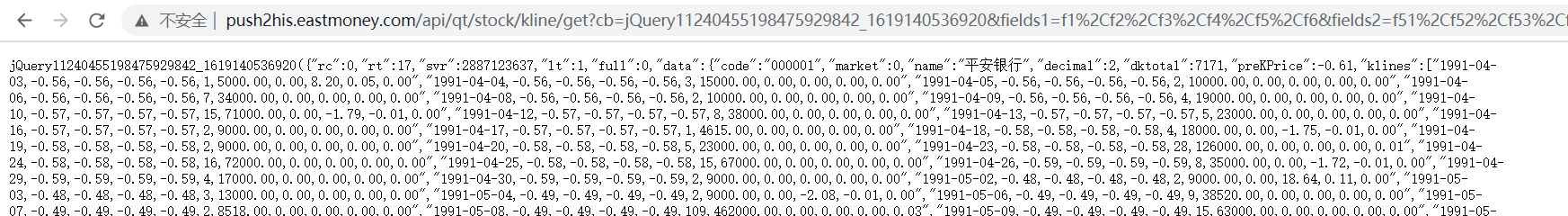

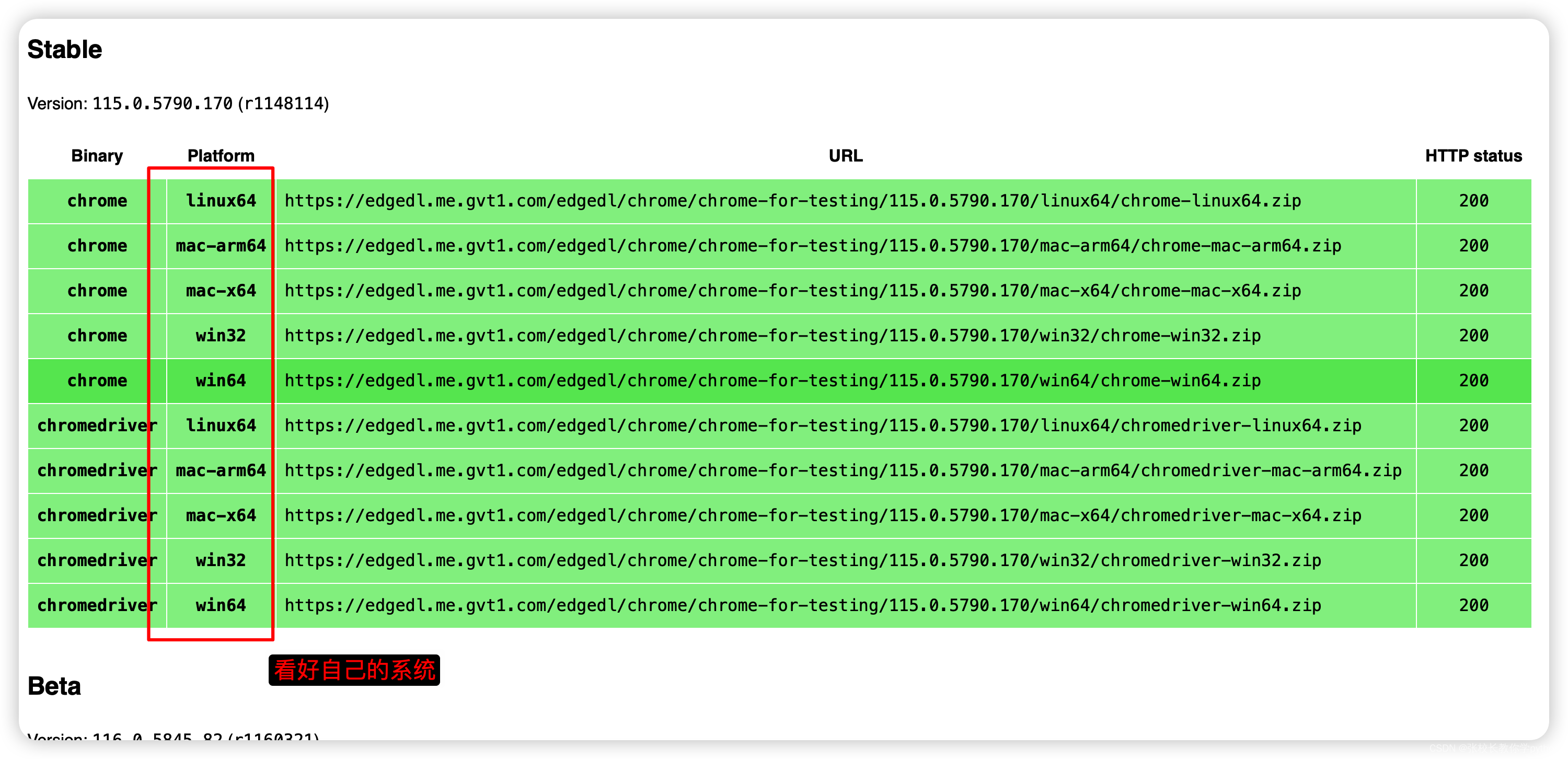

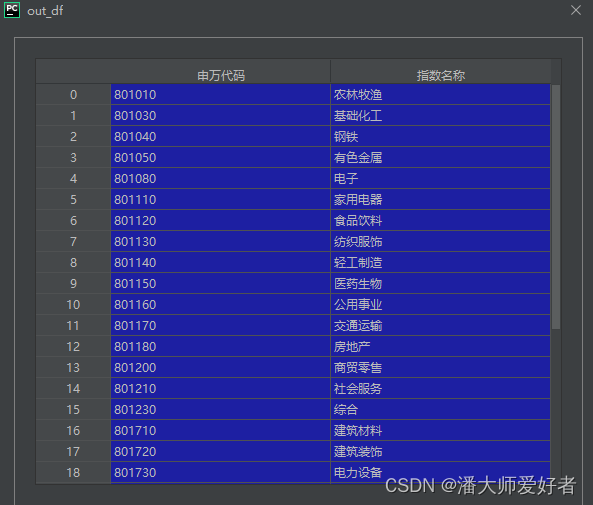

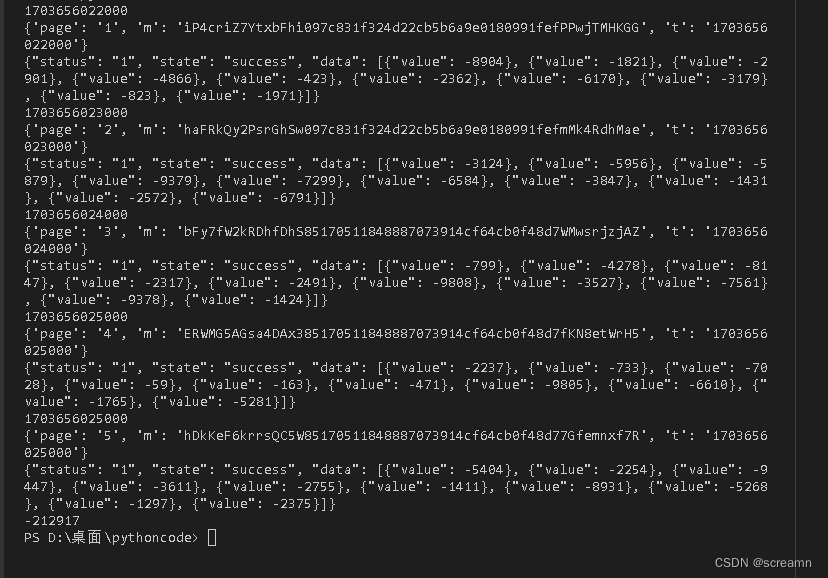

python爬取东方财富网资金流向数据(在本地生成csv文件)

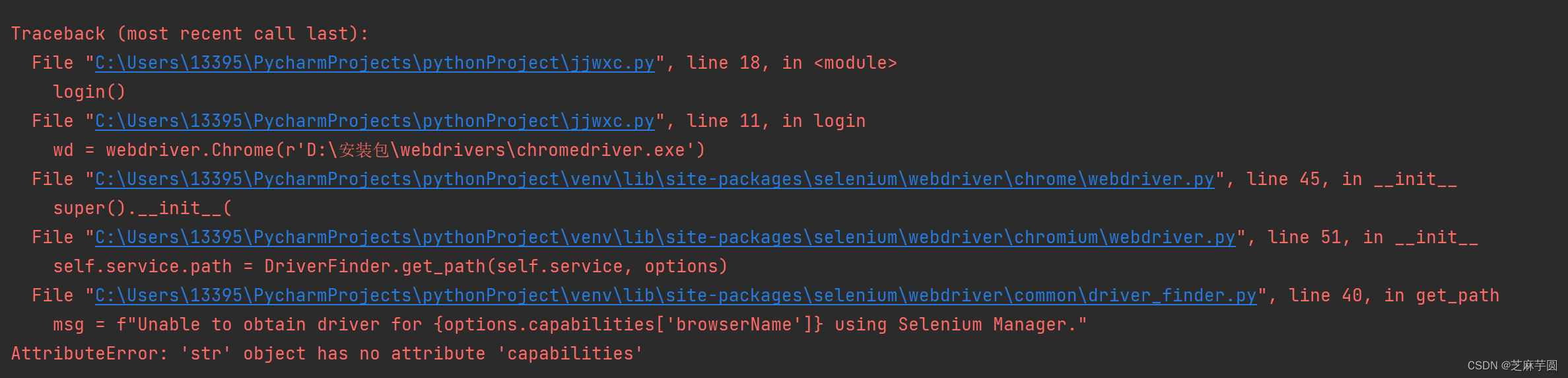

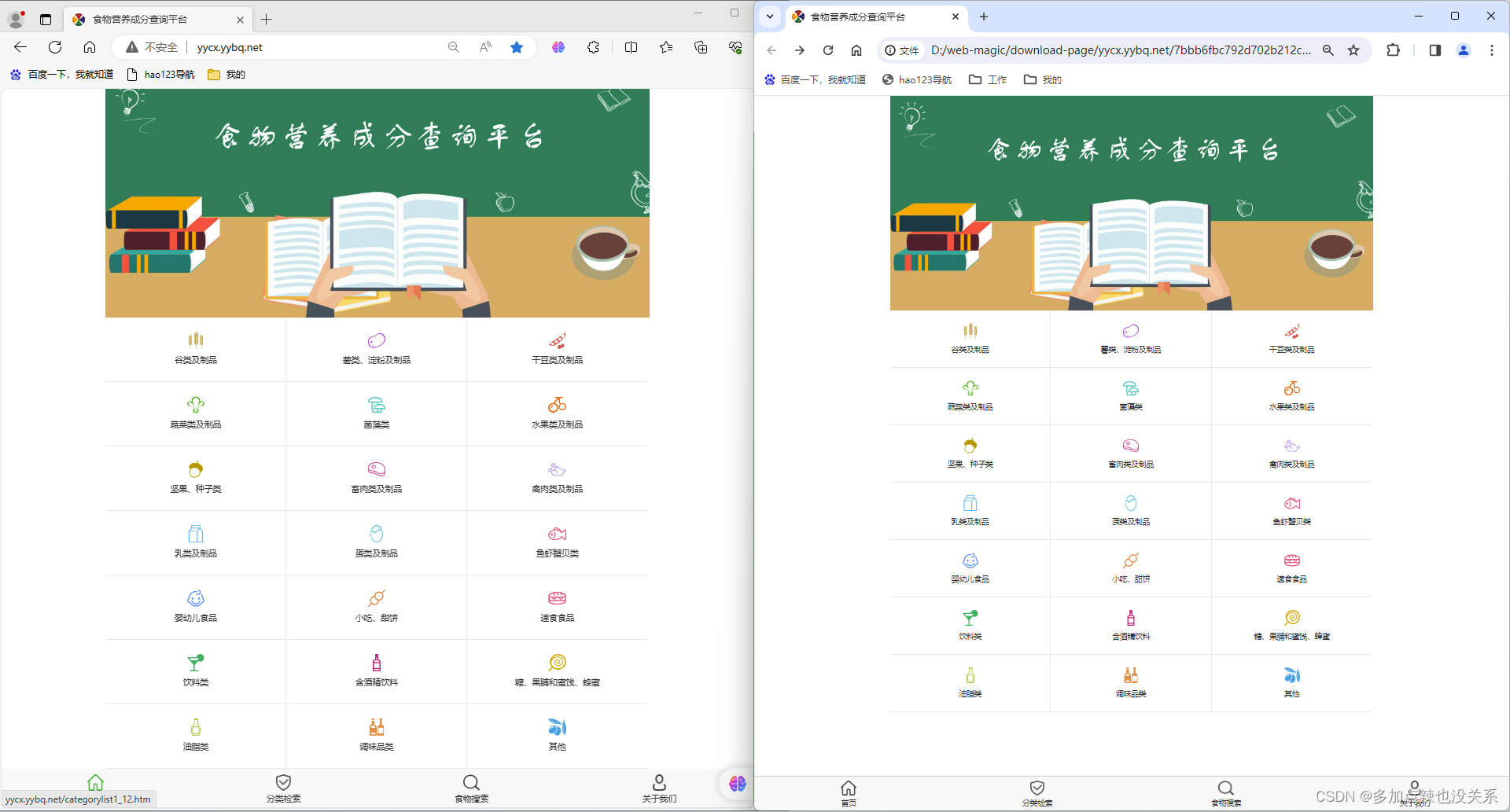

今天我们来试着用python爬取东方财富网资金流向的表格数据。

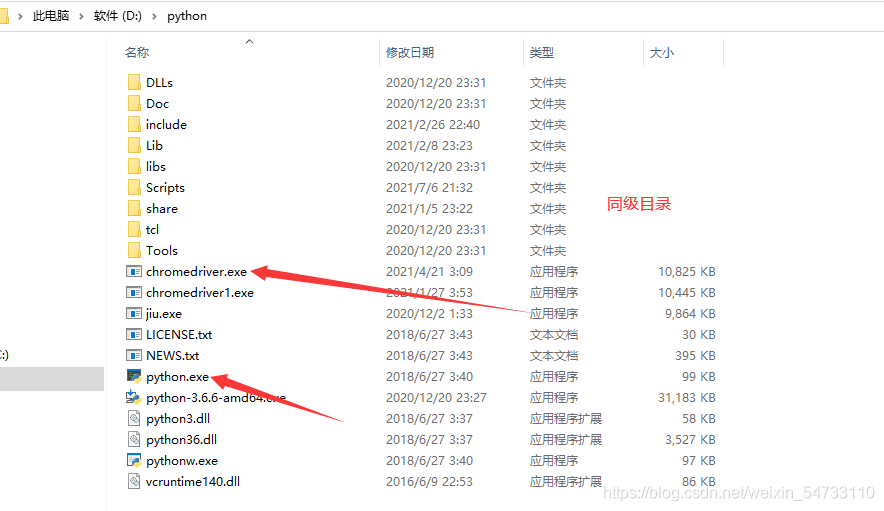

第一步:程序及应用的准备

首先我们需要安装selenium库,使用命令pip install selenium;然后我们需要下载对应的chromedriver,安装网址:http://chromedriver.storage.g…

IIS 网站日志分析

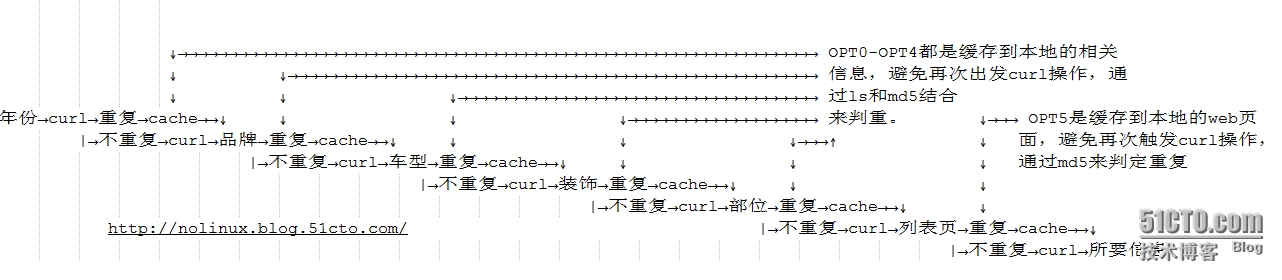

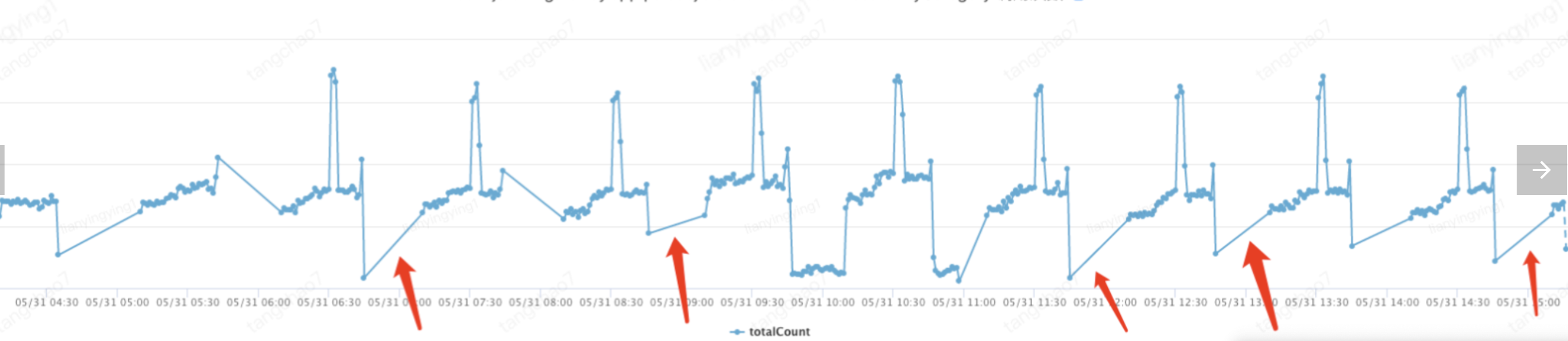

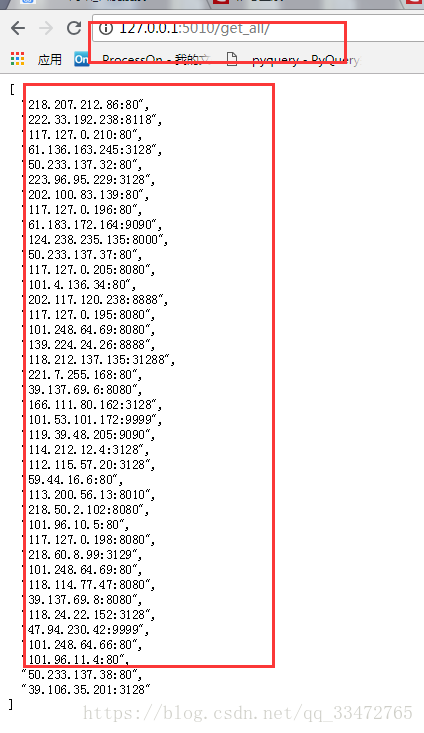

最近由于ADSL代理总出问题,导致爬虫服务器总被目标网站封,由于请求内容总是空,前端APP获取不到想要的内容就一直刷新,导致爬虫服务器请求更加繁忙。 爬虫服务器每执行完一个流程,都会给统计服务器Post一条数据…

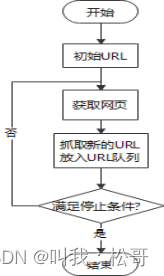

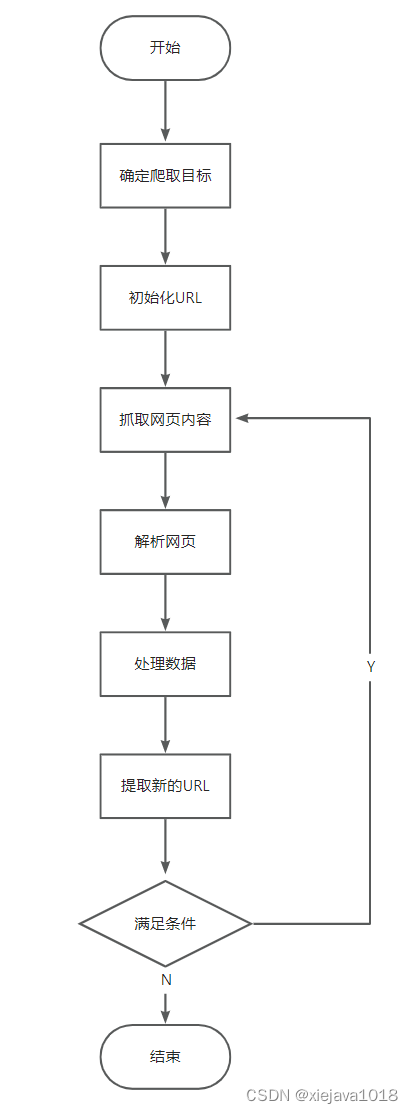

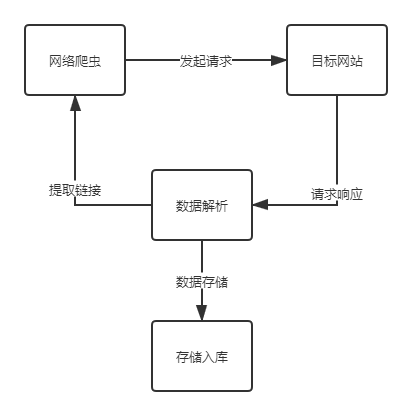

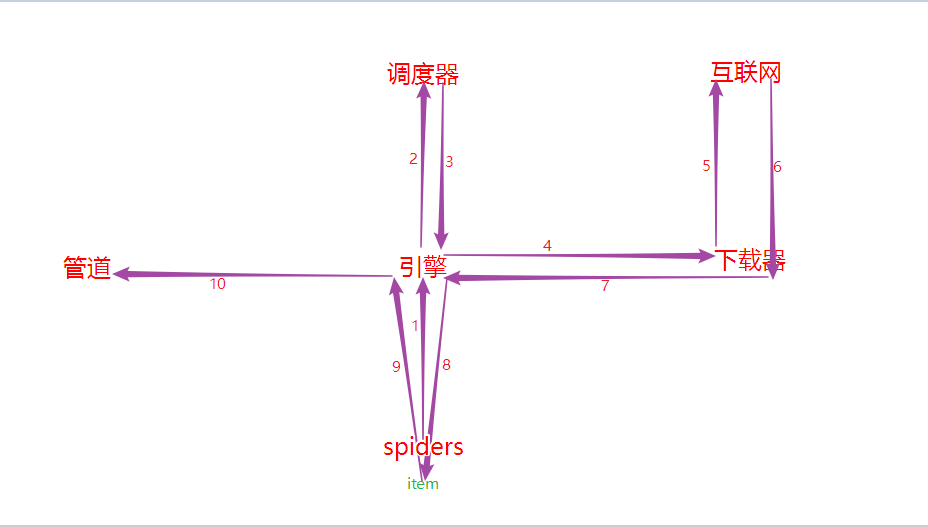

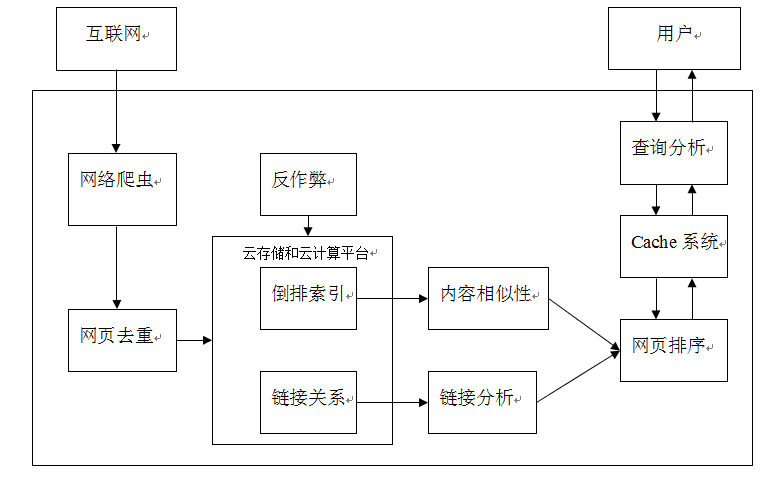

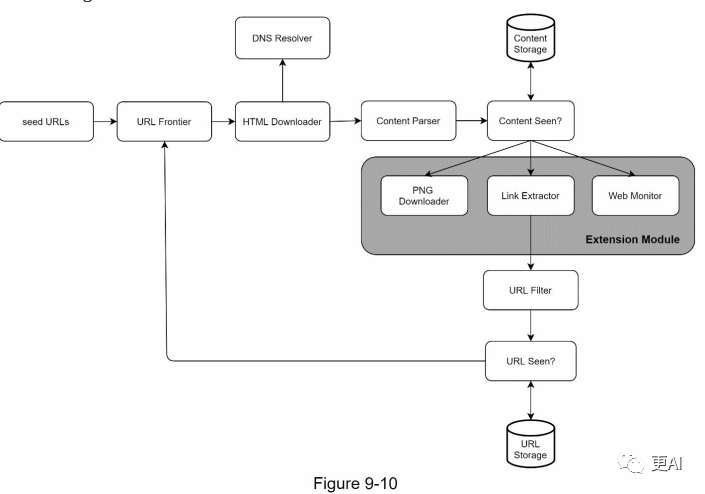

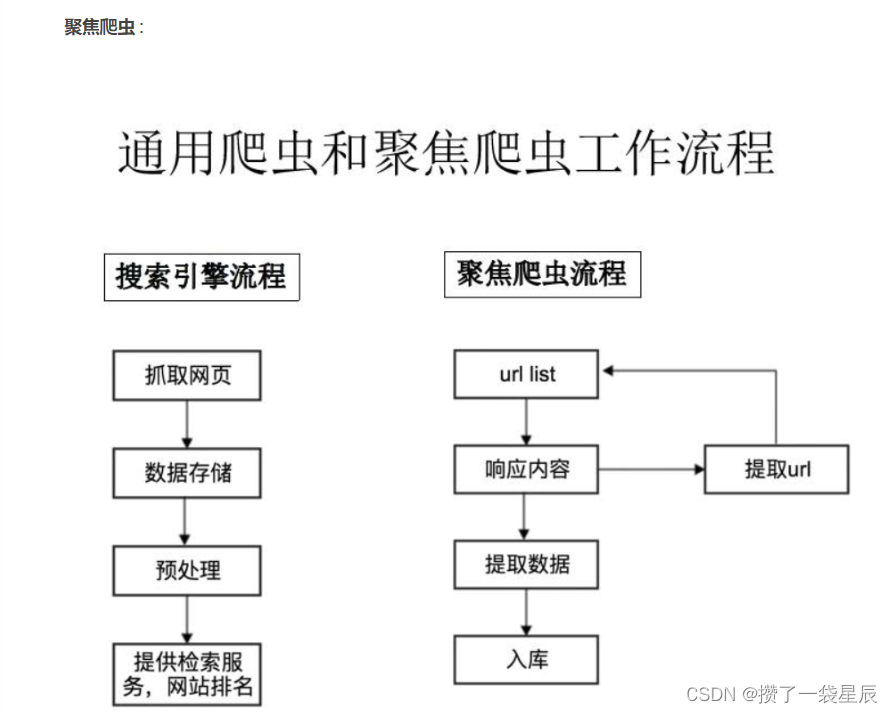

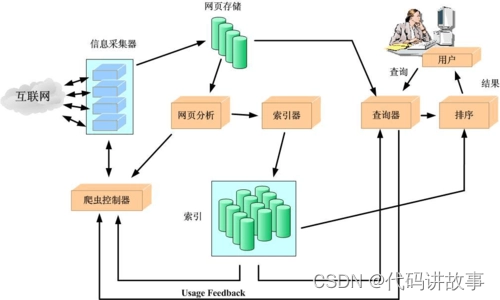

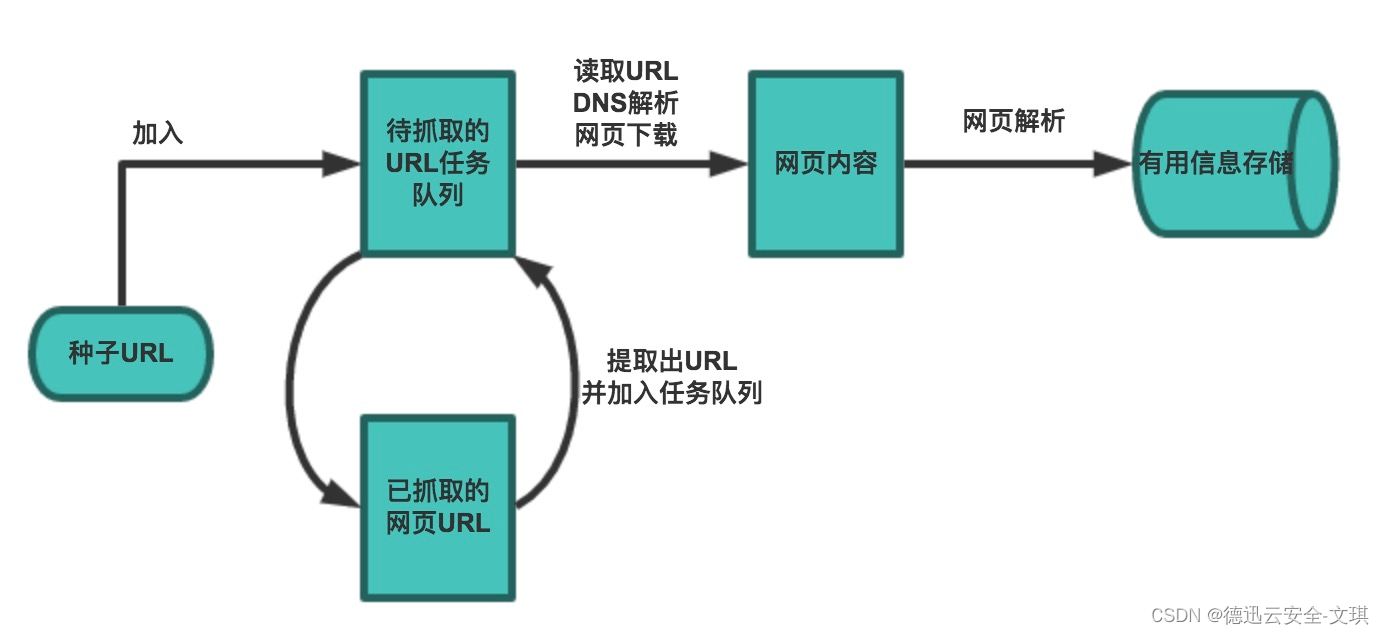

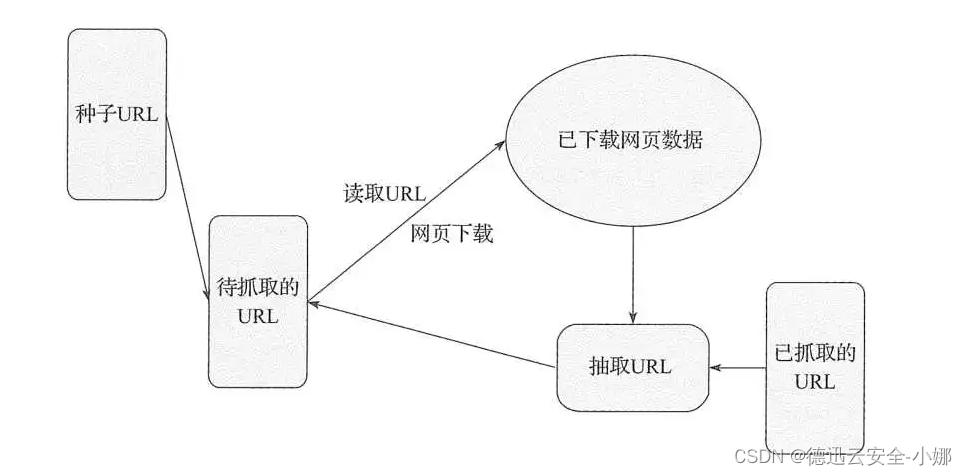

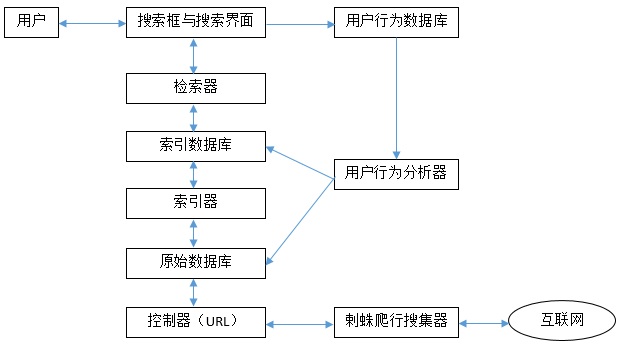

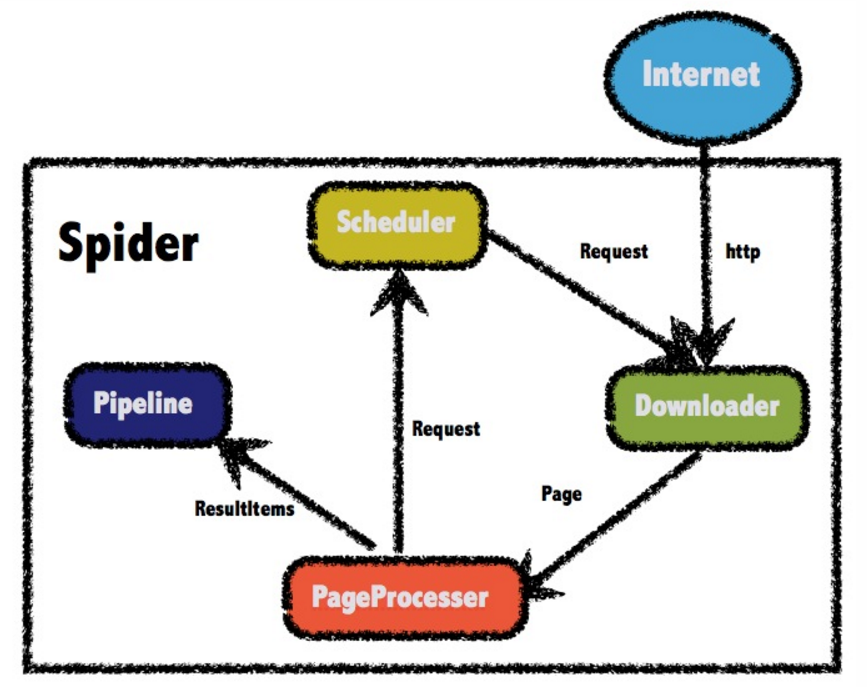

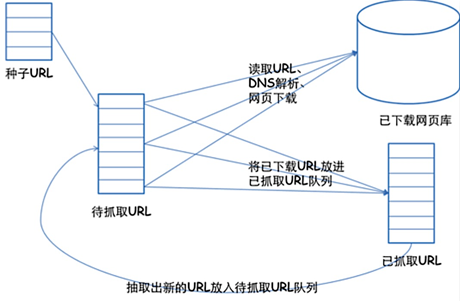

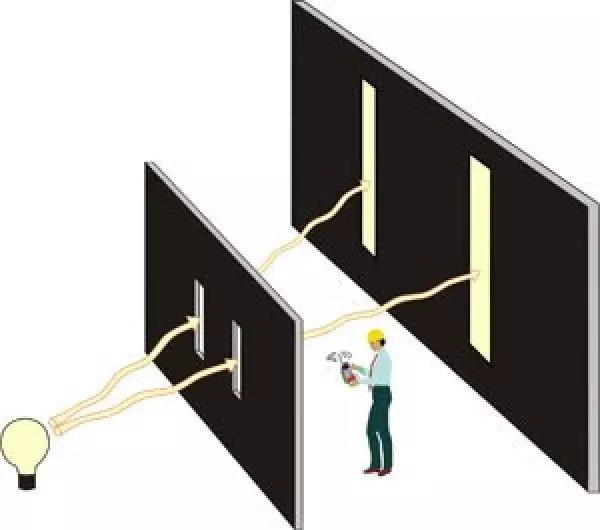

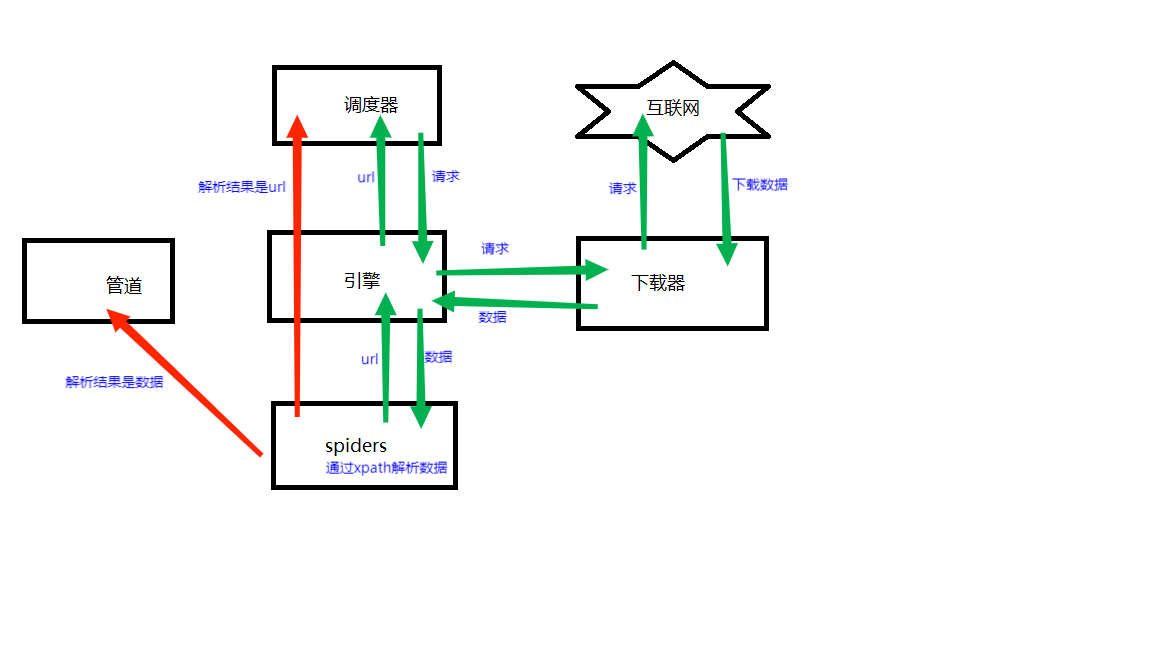

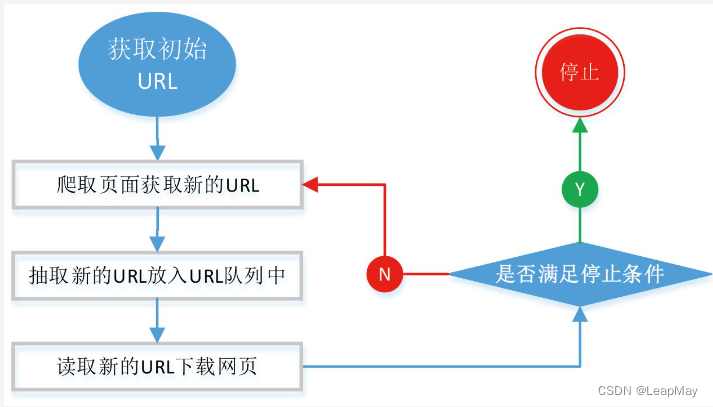

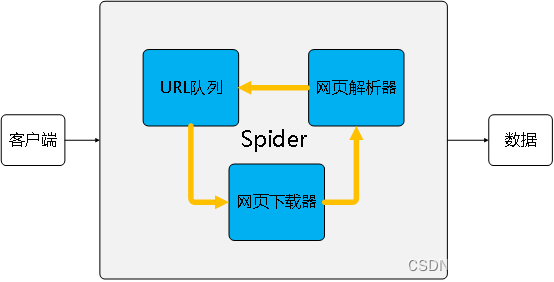

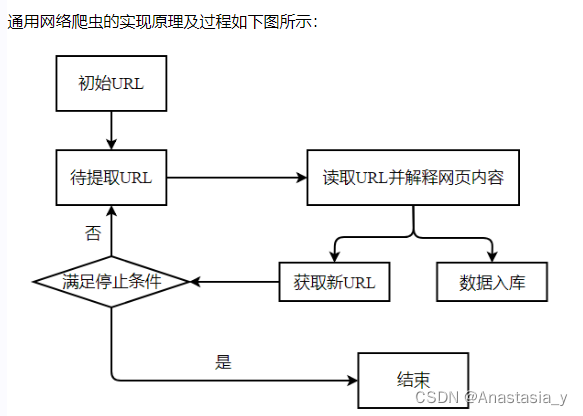

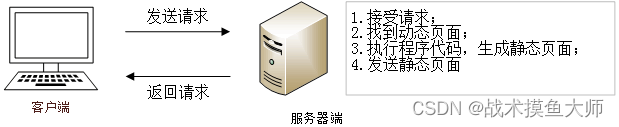

20161121 Spider 之 爬虫 基本工作原理

网络爬虫是捜索引擎抓取系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地形成一个或联网内容的镜像备份。这篇博客主要对爬虫以及抓取系统进行一个简单的概述。一、网络爬虫的基本结构及工作流程一个通用的网络爬虫的框架如图所示:网络爬虫的基本工…

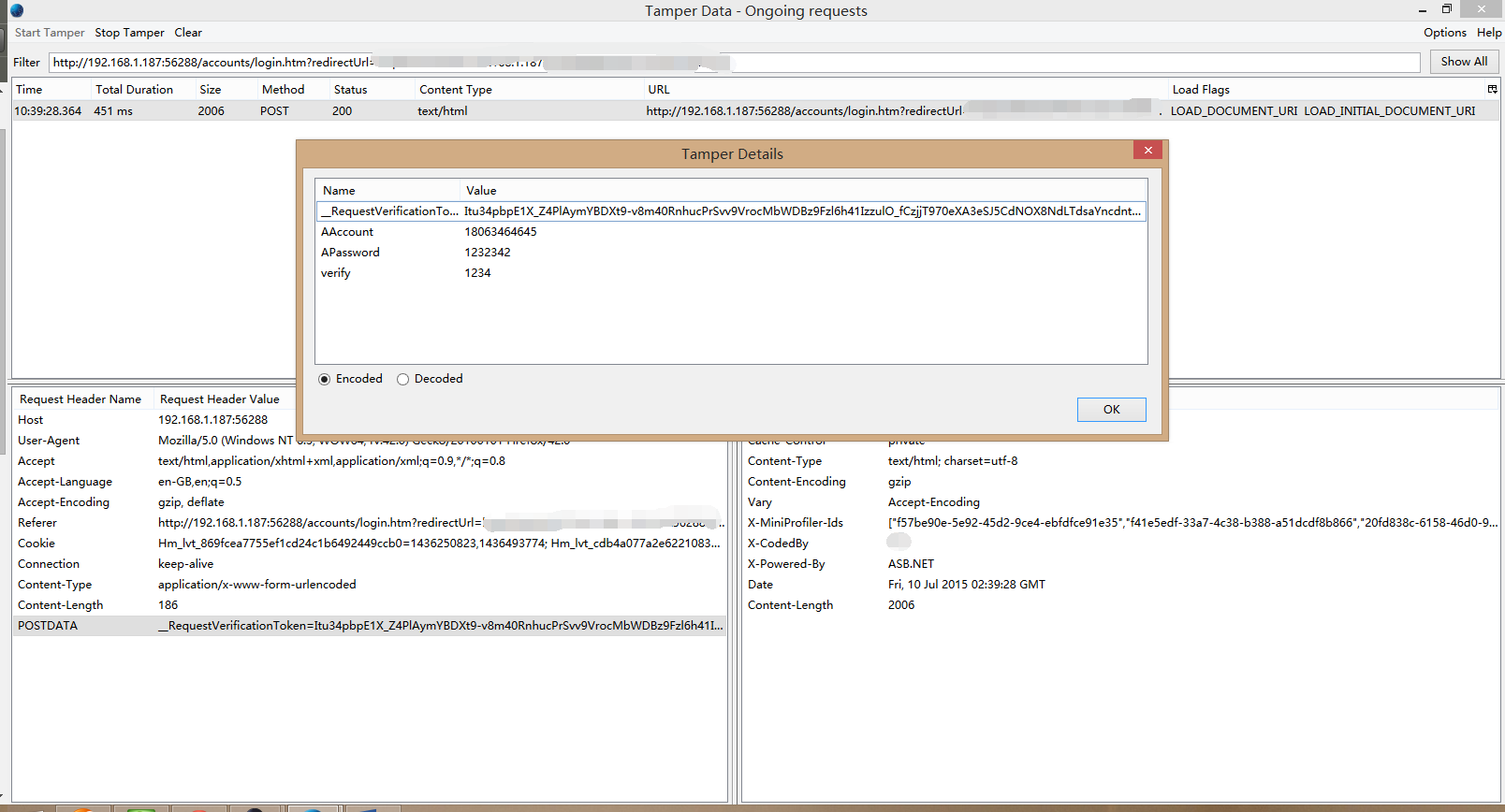

Chrome常见黑客插件及用法

目录 0x00 Web Developer(网页开发者) 0x01 Firebug Lite for Google Chrome (Firebug精简版) 0x02 d3coder (decoder,解码器)0x03 Site Spider(网站爬虫)0x04 Form Fuz…

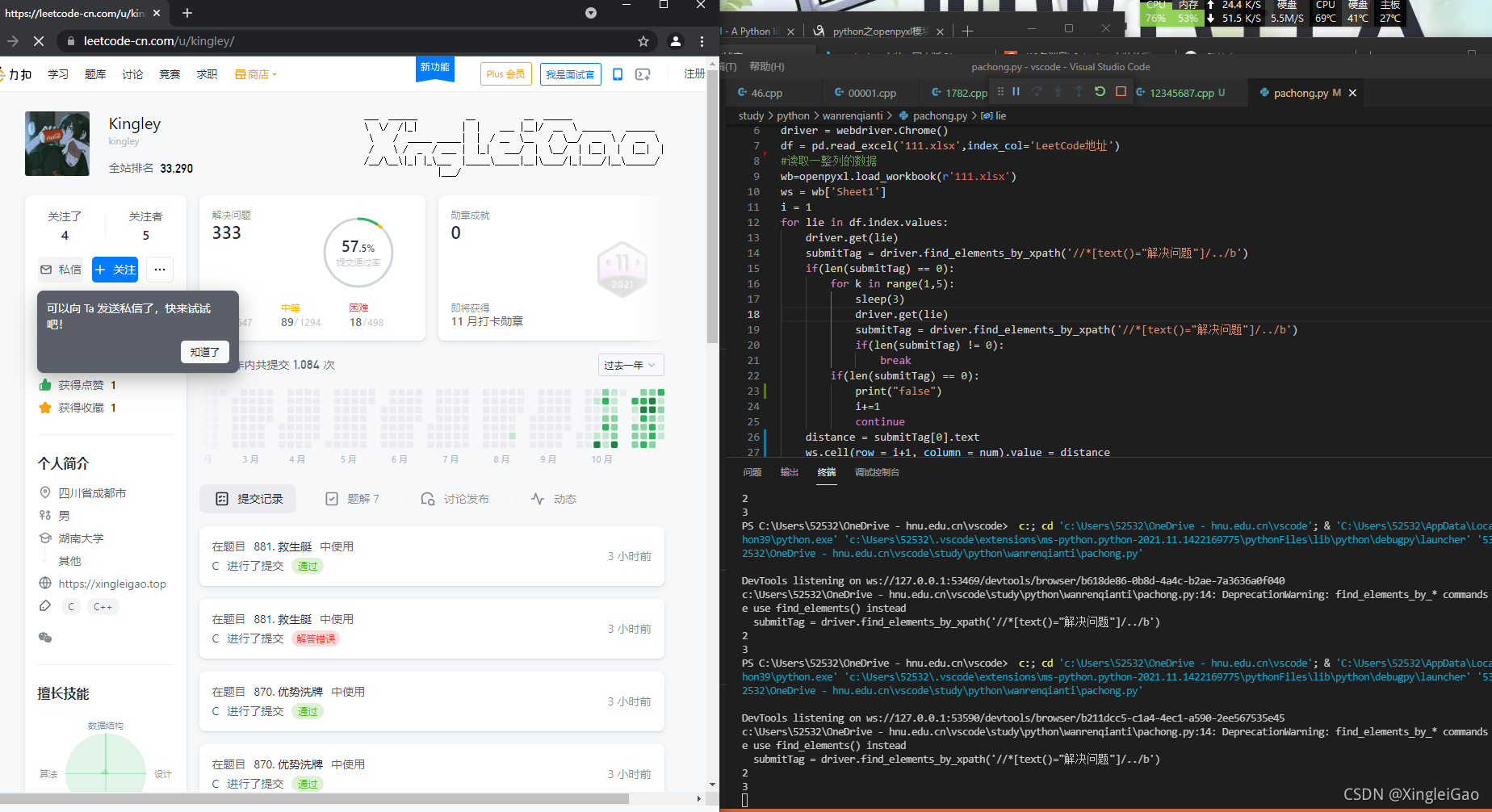

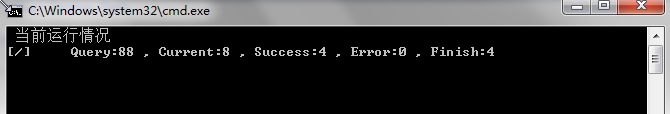

【从零开始的python生活①】手撕爬虫扒一扒力扣的用户刷题数据

☘前言☘

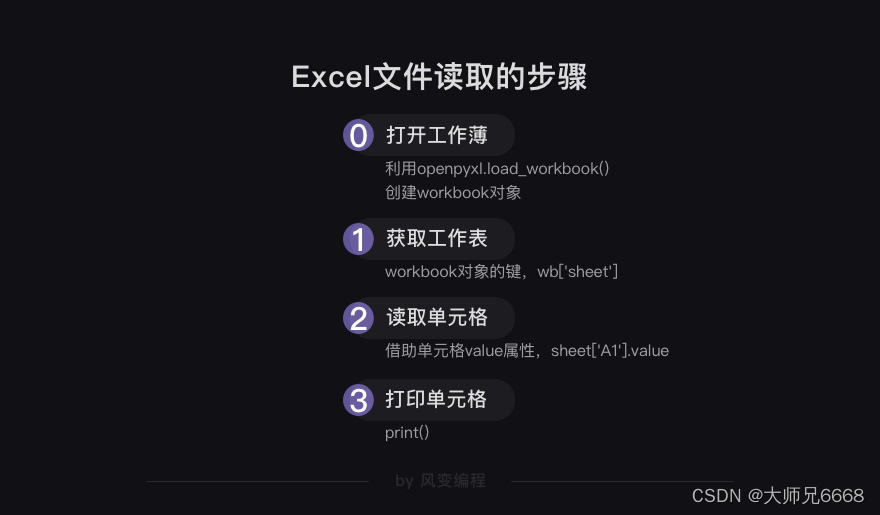

读完这篇博客,你可以学到什么? python的基础语法(适合c转python) excel的读取和写入方式 基本的爬虫定位方法 python的安装(这个很容易的) 基本的环境配置(这个基本上不用配置) 这篇博客里,我将带领大家手撕第一个python的爬虫小程…

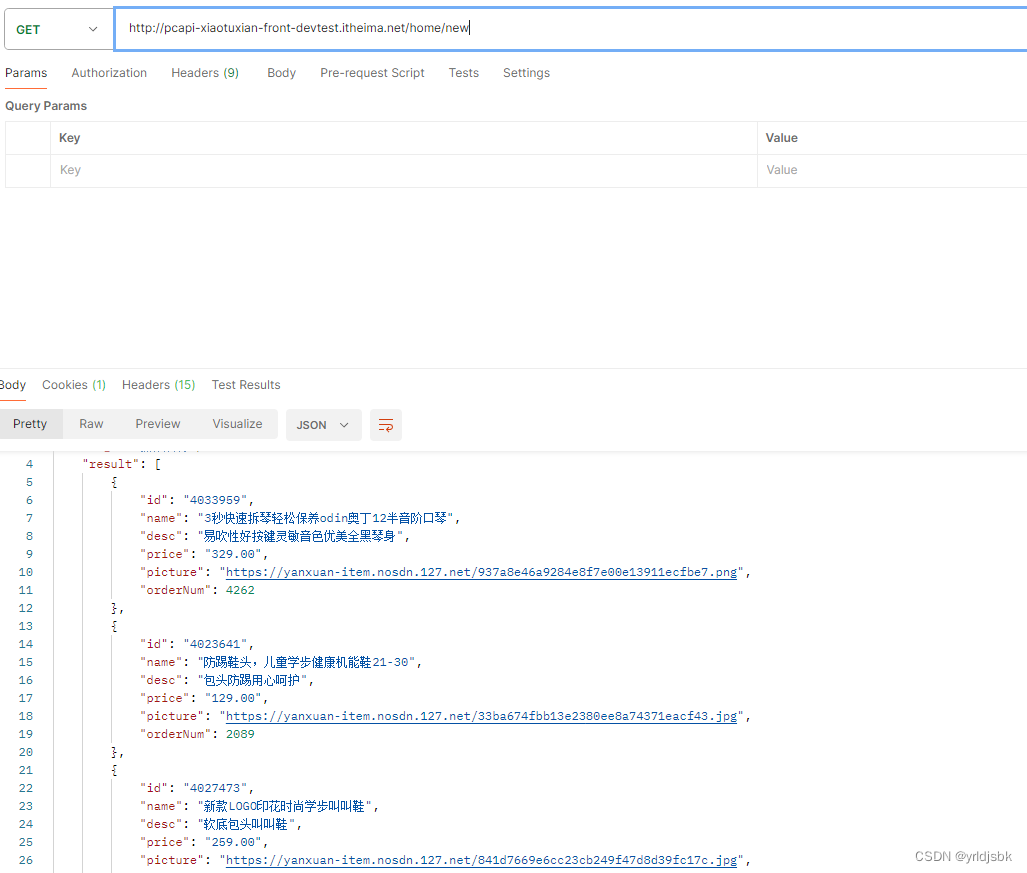

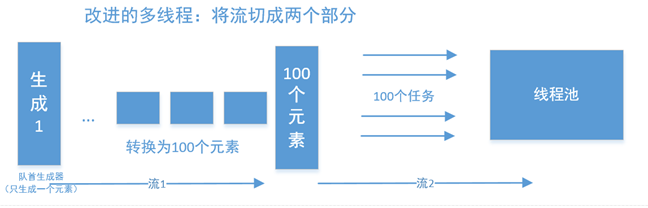

【从零开始的python生活②】力扣爬虫改进方法

☘前言☘

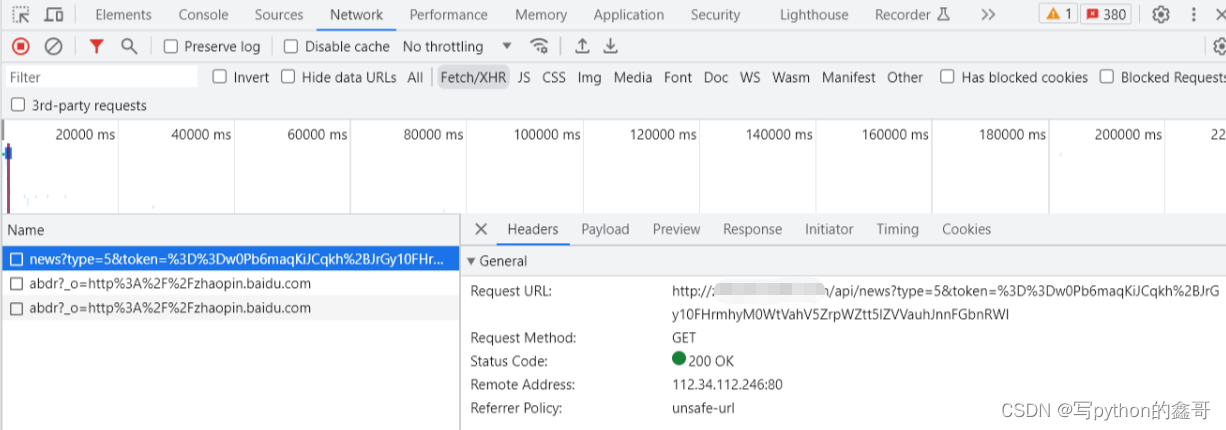

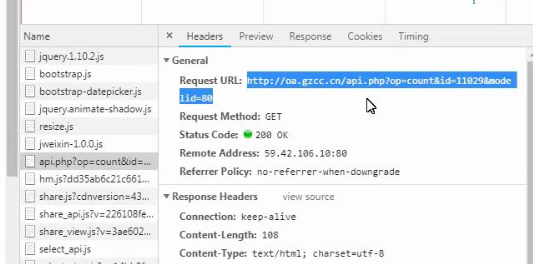

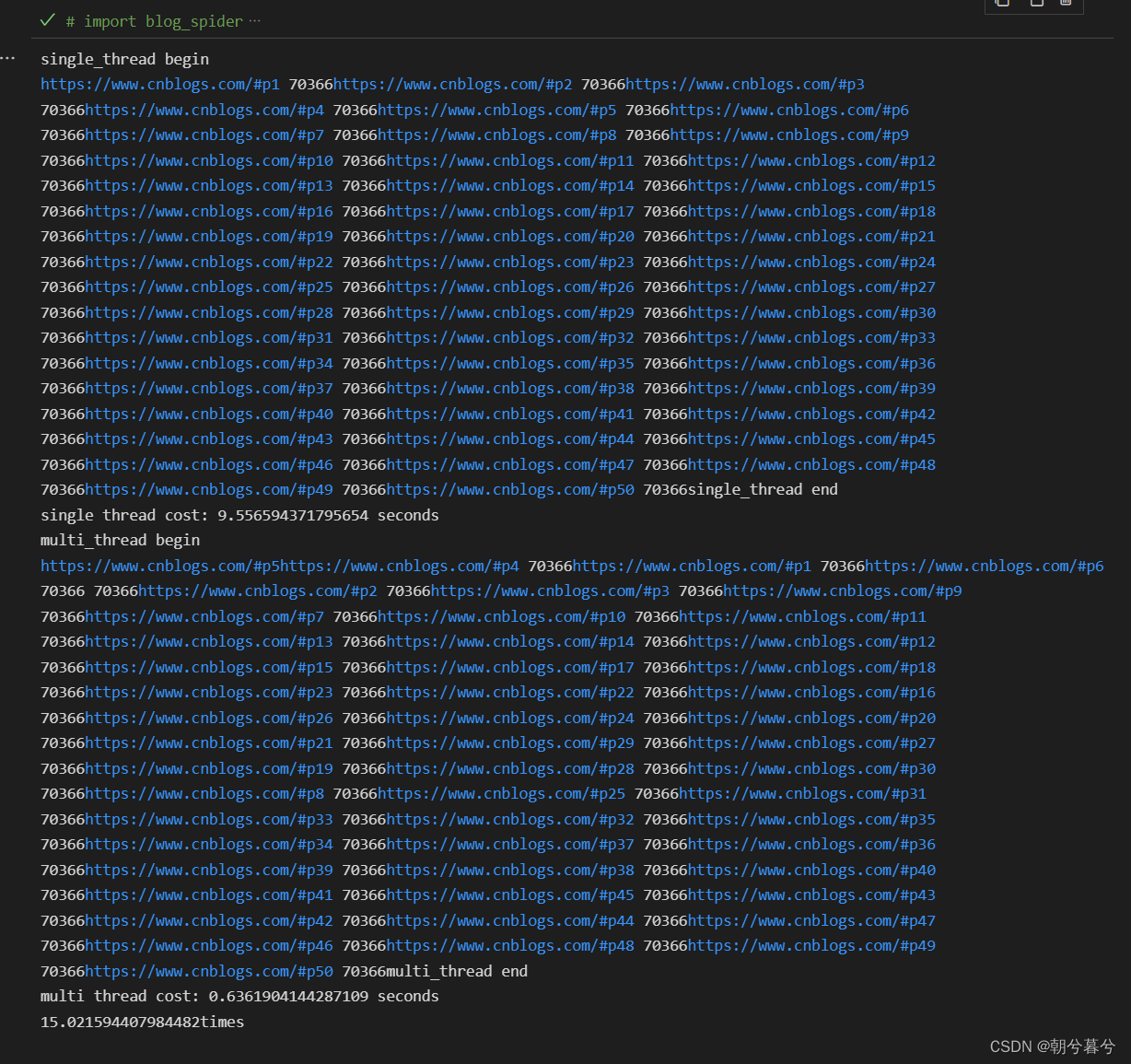

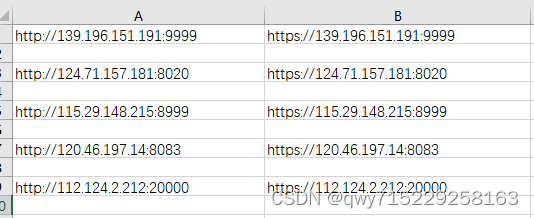

读完这篇博客,你可以学到什么? excel的读取和写入方式 获取接口的方式 多线程提高爬虫效率 云端服务器部署web服务实时更新 这篇博客里,我将在上一篇文章的基础上进一步来发掘网站接口api提高访问速度,进一步多线程发掘…

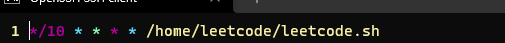

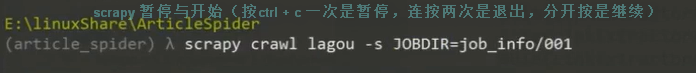

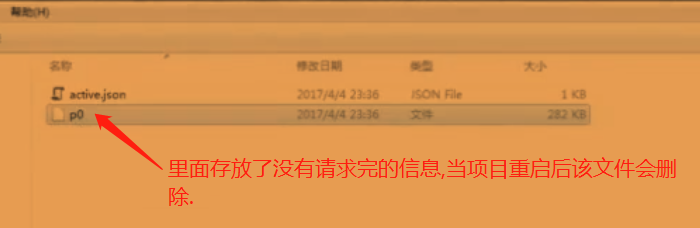

scrapy 如何暂停与重启

在project文件夹下新建一个文件夹:job_info/001目的是保存暂停之前还没处理完的文件内容,这只这个参数按ctrl c 可以实现爬虫的暂停,如果连按两次ctrl c 就是强制退出了

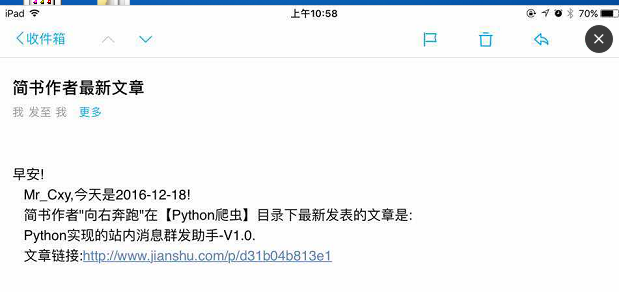

Python定时任务!这个项目我说能挣五千,你信吗?

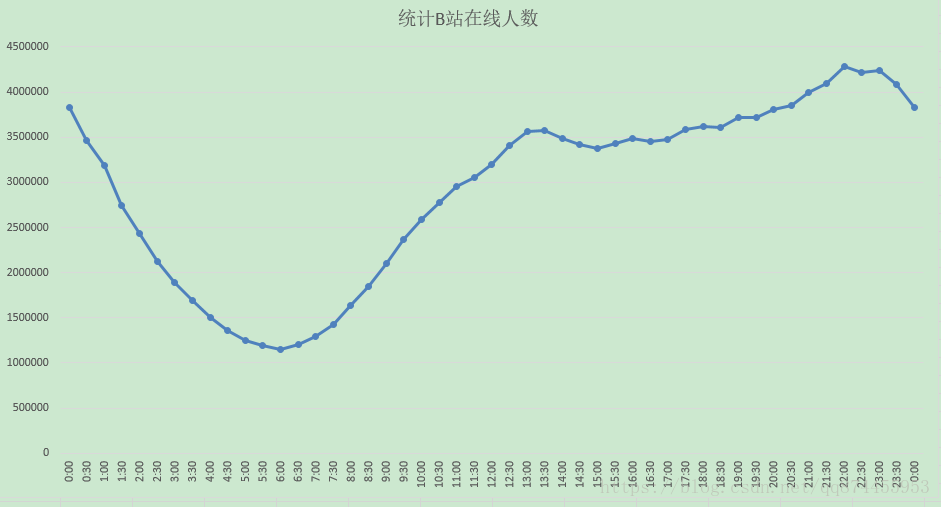

一个简单的需求,即定时启动python脚本,这种需求很常见,比如定时启动一段程序对服务器状态进行收集,写到文件中,方便运维后期审计,查看服务器占用高峰时间段,从而判断出公司产品在该时间段较多人…

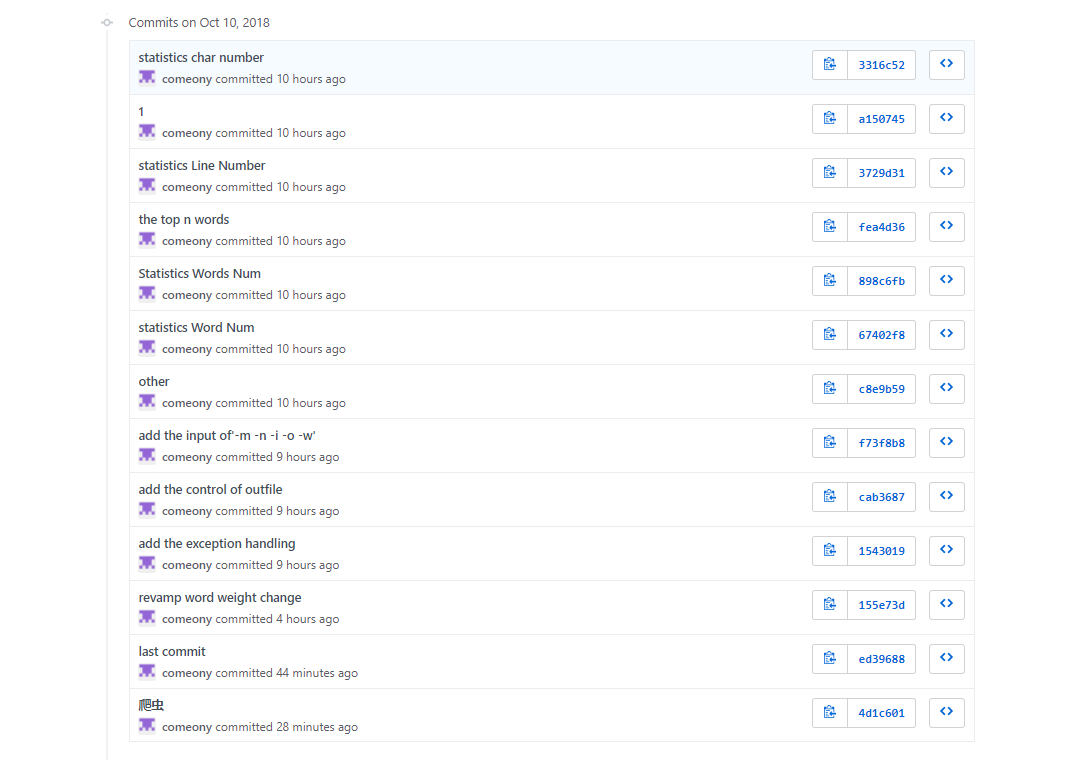

软工1816 · 第五次作业 - 结对作业2

软工1816 第五次作业 - 结对作业2 优秀的结对队友:蔡子阳 他的博客戳这里他这次博客作业戳这里Github链接分工明细 分工如下 蔡子阳:完成全部爬虫实现及附加题全部内容乐忠豪:使用C实现其余需求功能PSP表格 PSP2.1Personal Software Process…

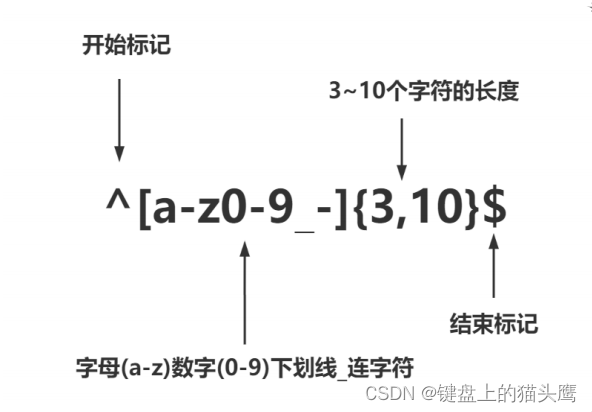

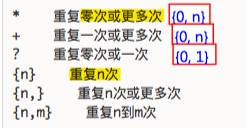

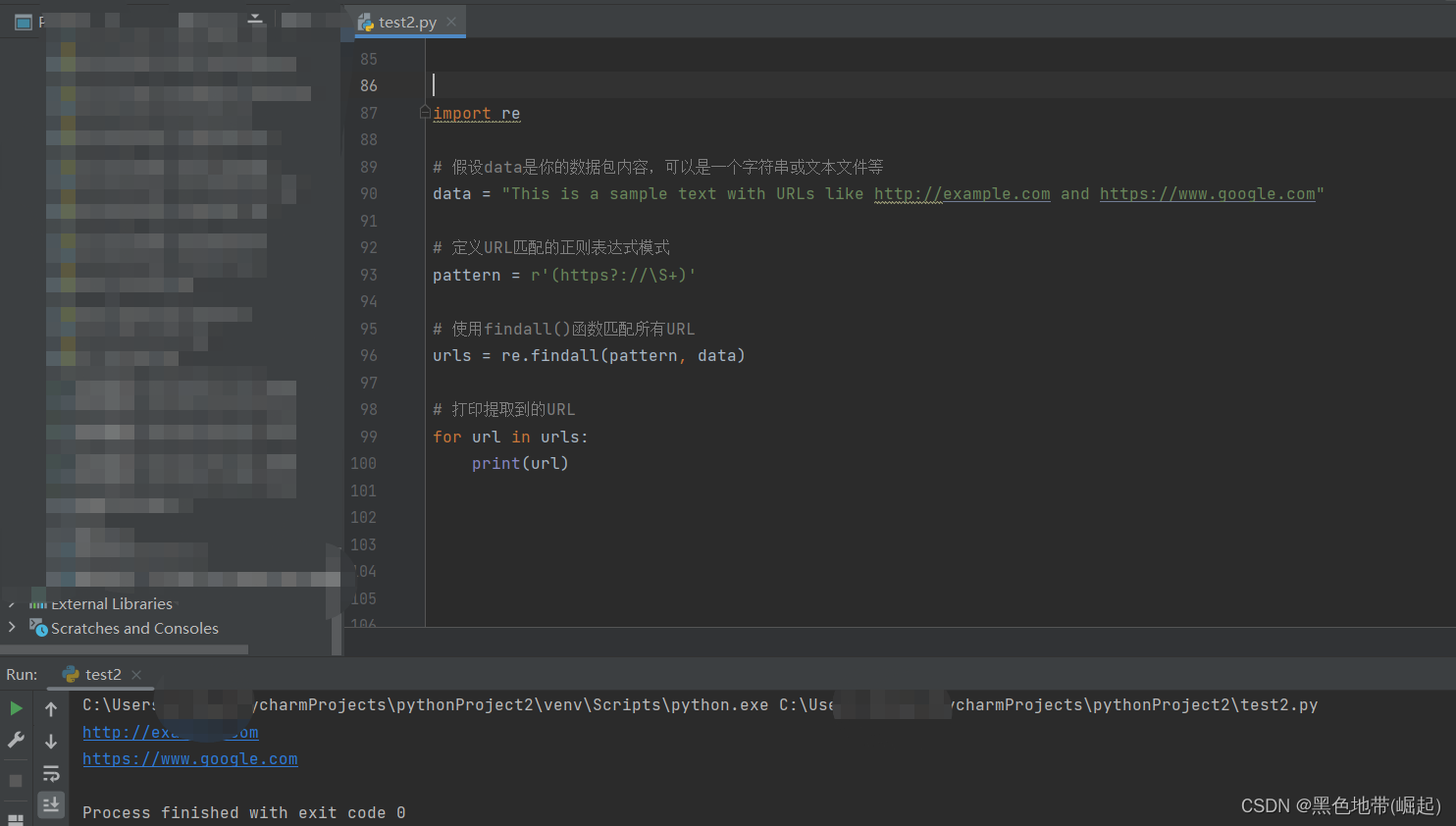

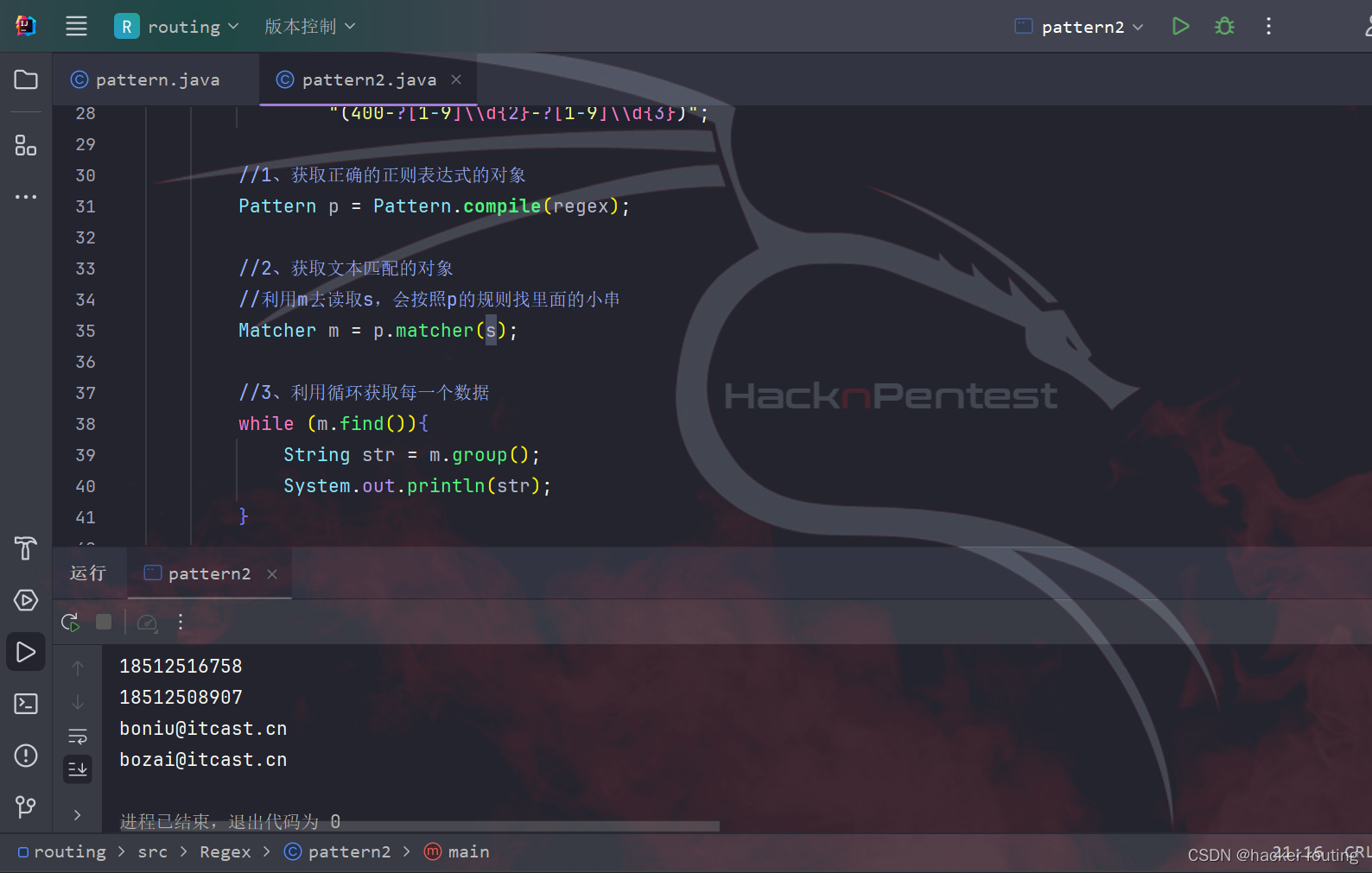

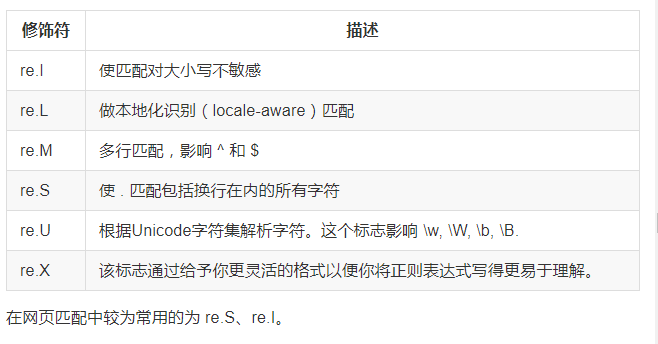

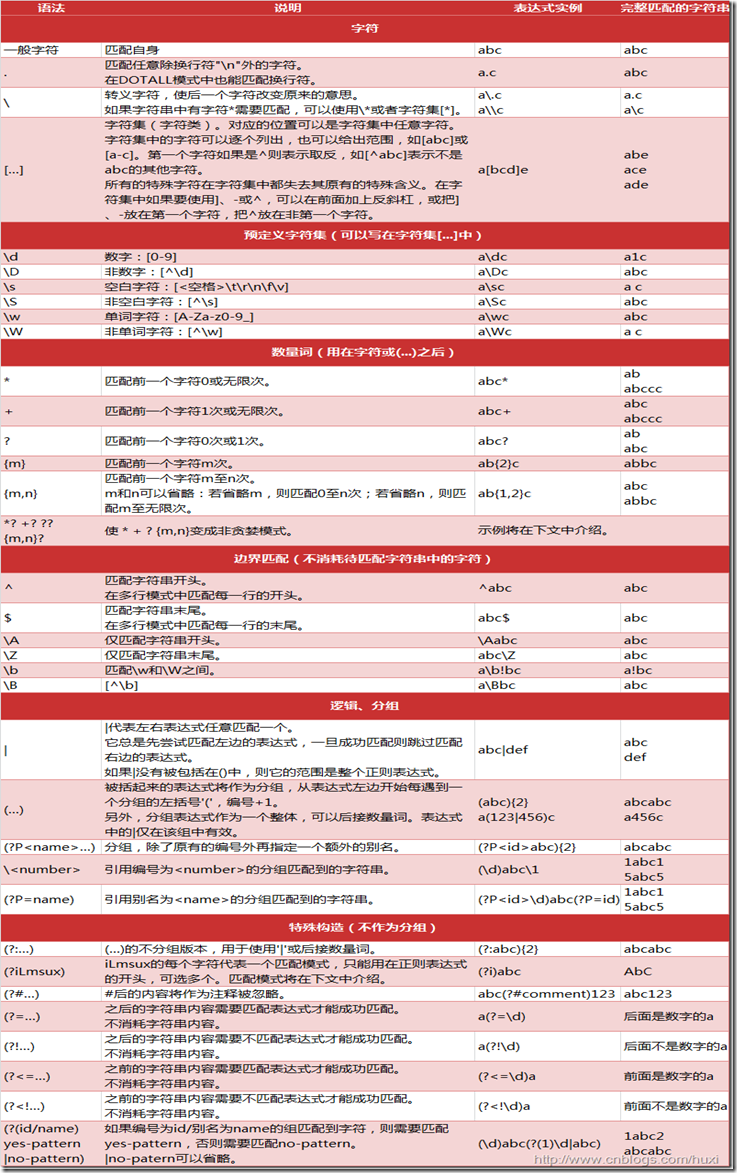

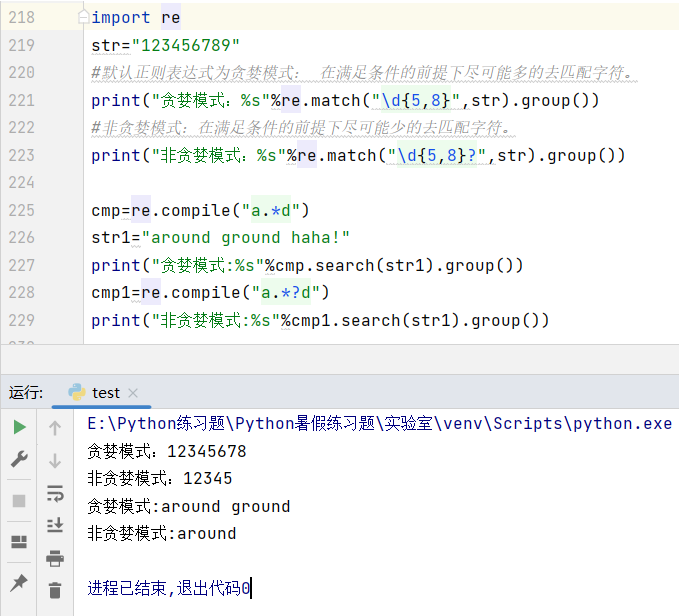

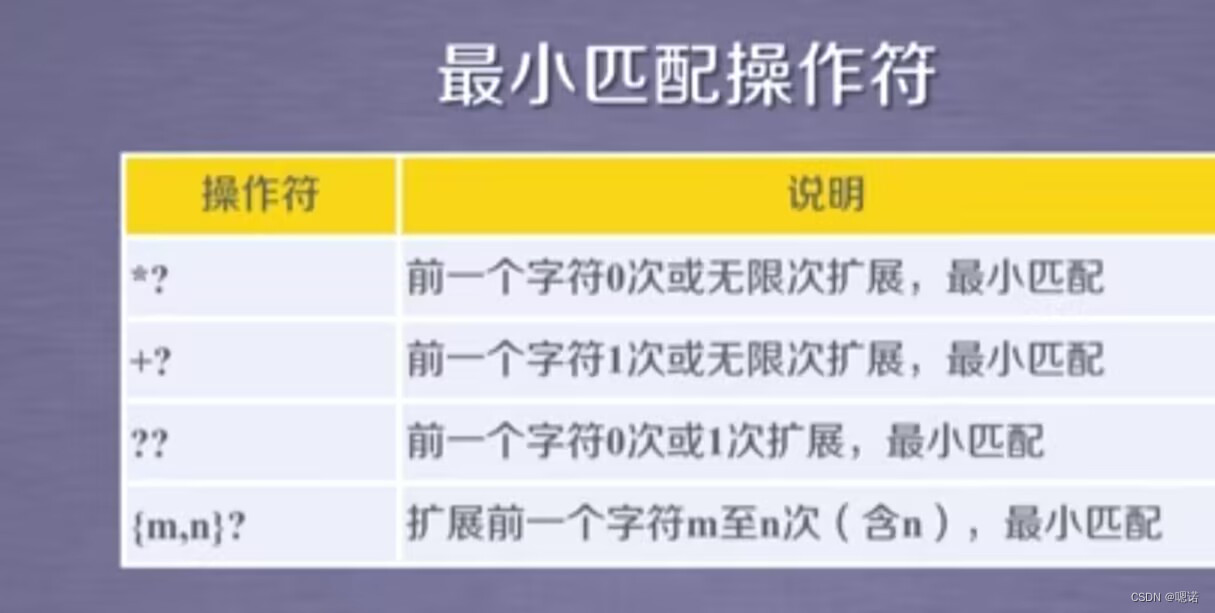

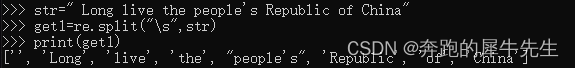

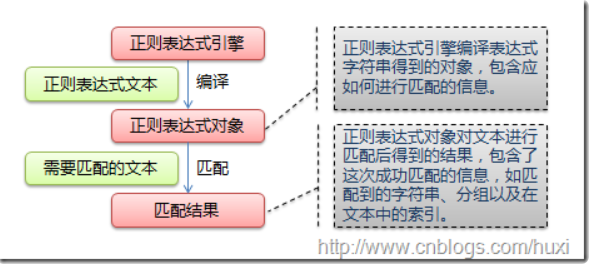

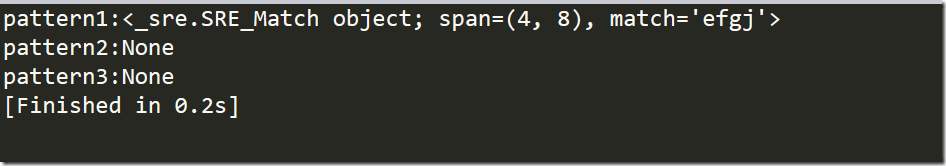

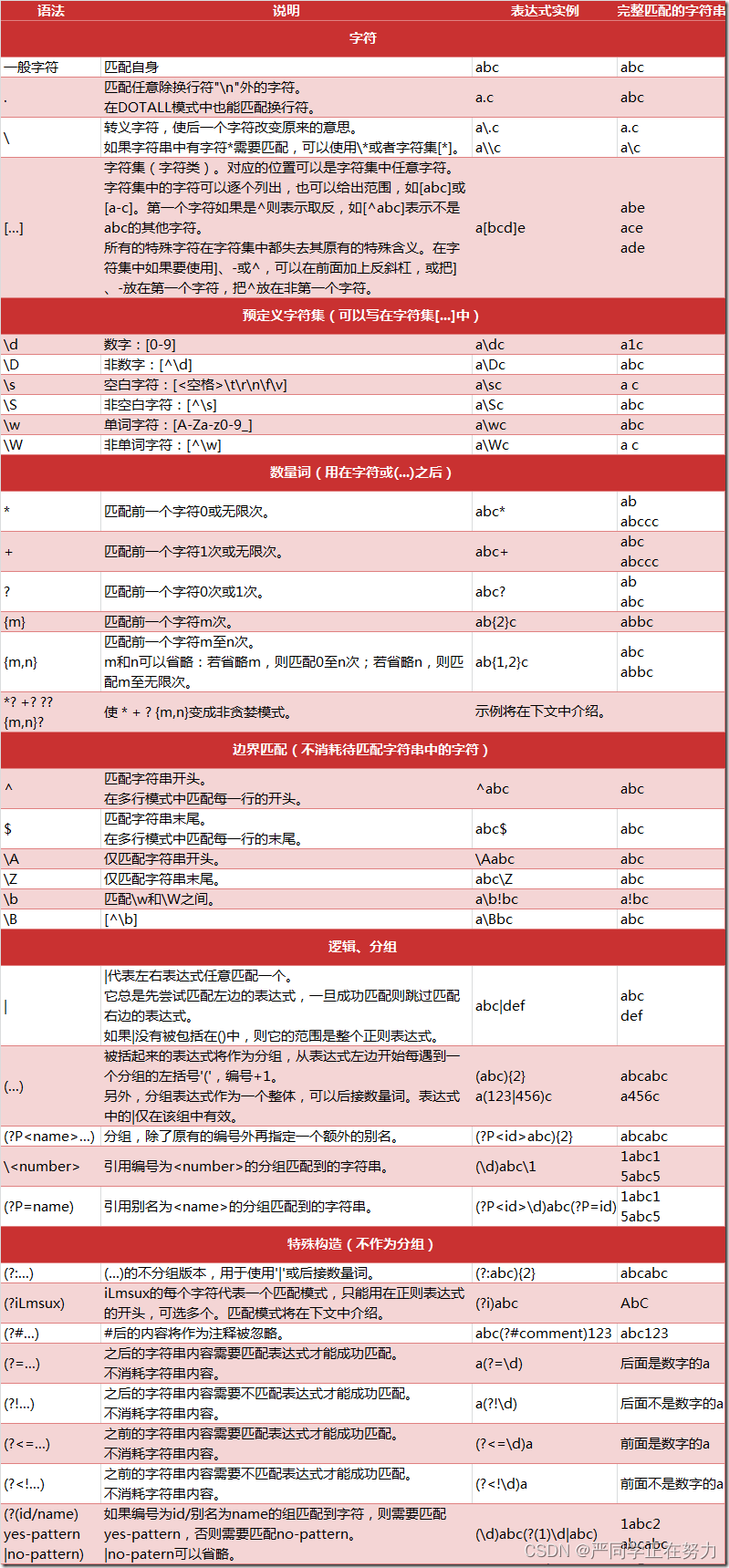

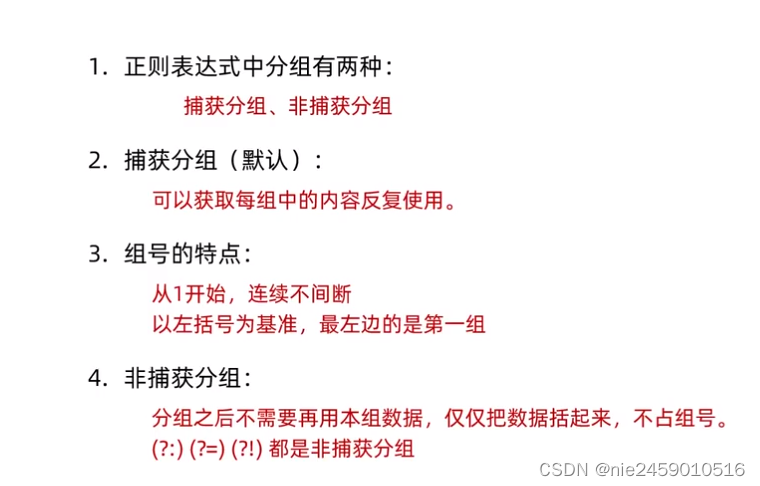

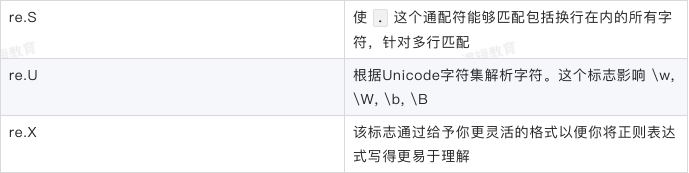

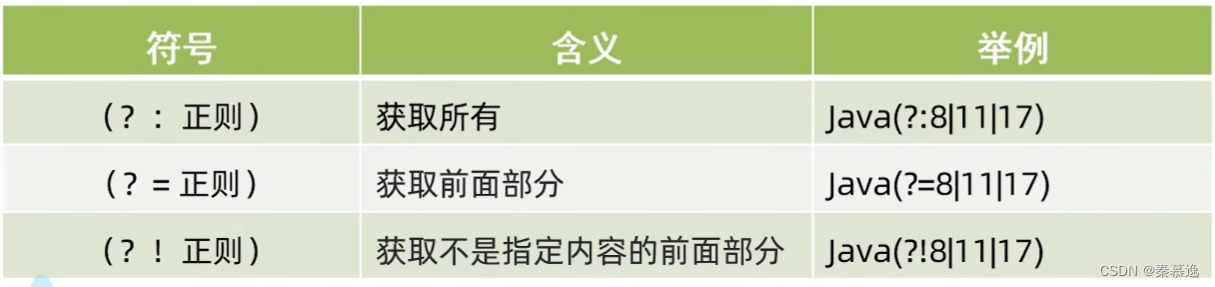

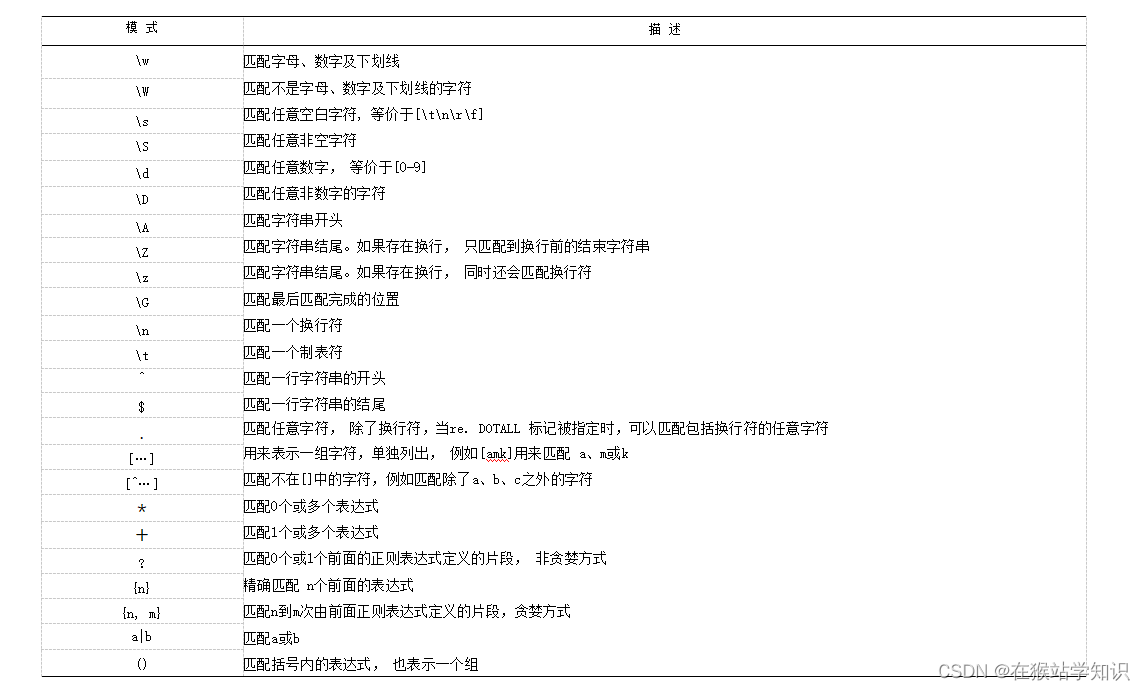

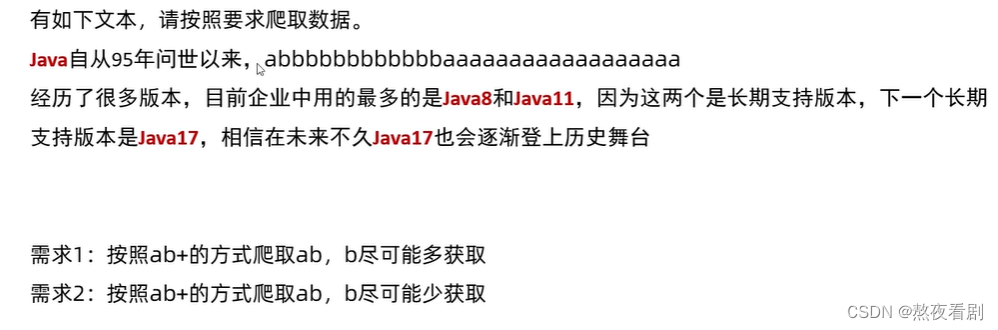

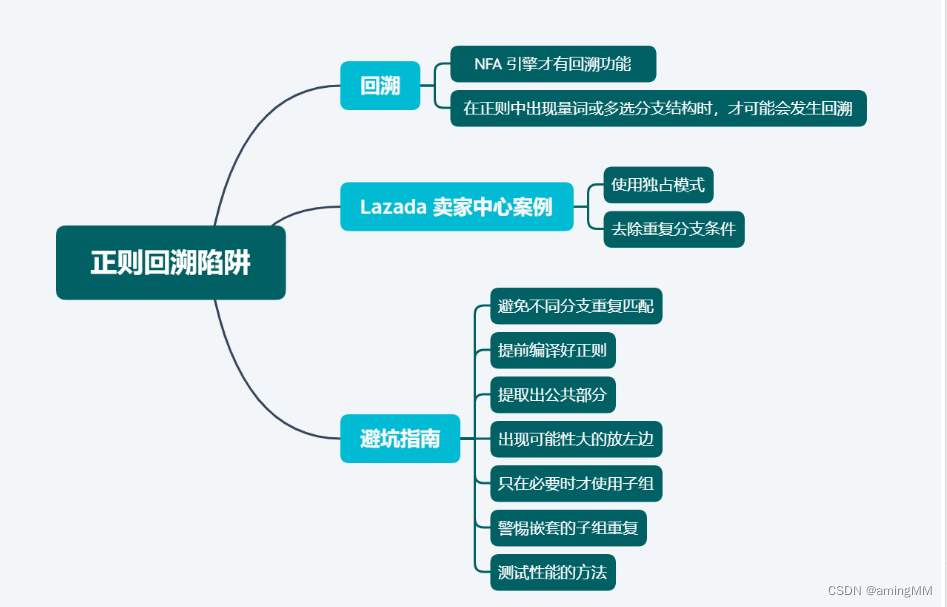

day23 re模块

1. 正则表达式, Regular Expression 是对字符串操作的一种逻辑公式 优点: 灵活, 功能性强, 逻辑性强. 缺点: 上⼿难. ⼀旦上⼿, 会爱上这个东⻄ 1. 元字符: [] 的内容会被匹配 例如:[abc] 匹配a或b或c 思考: [a-zA-Z0-9]匹配的是什么? 按照编码的顺序填写 2. 简单元字符 (单…

CSRF verification failed. Request aborted. 解决方法

按着网上教程部署一个blog 项目,写到登录界面,怎么登录都是显示 试了好多方法,最后发现,在view.py 的render_to_response后加上 context_instance RequestContext(request),此时没有引用RequestContext,需…

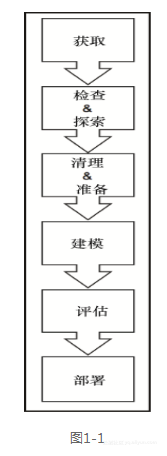

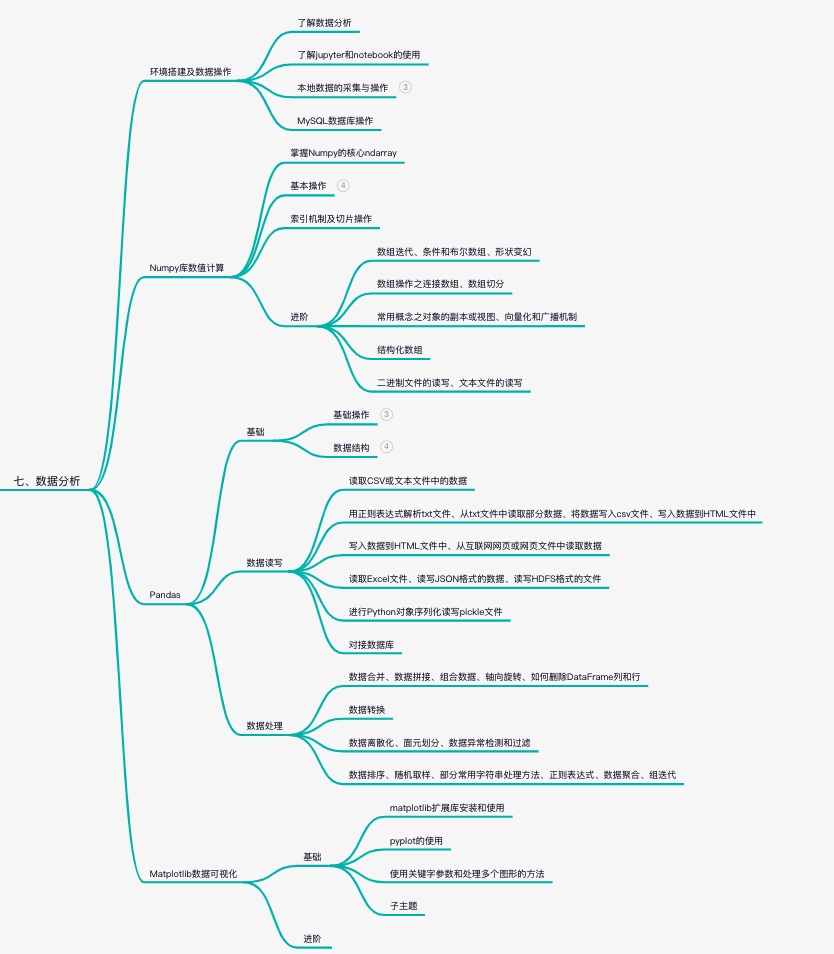

Python 数据分析学习路线

Python 数据分析学习路线 相关资料 概述 数据分析: 数据分析是指用适当利用统计分析方法对收集来的大量数据进行分析,提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。 分析数据,得到结果 学习路线 基础部分: 数学知…

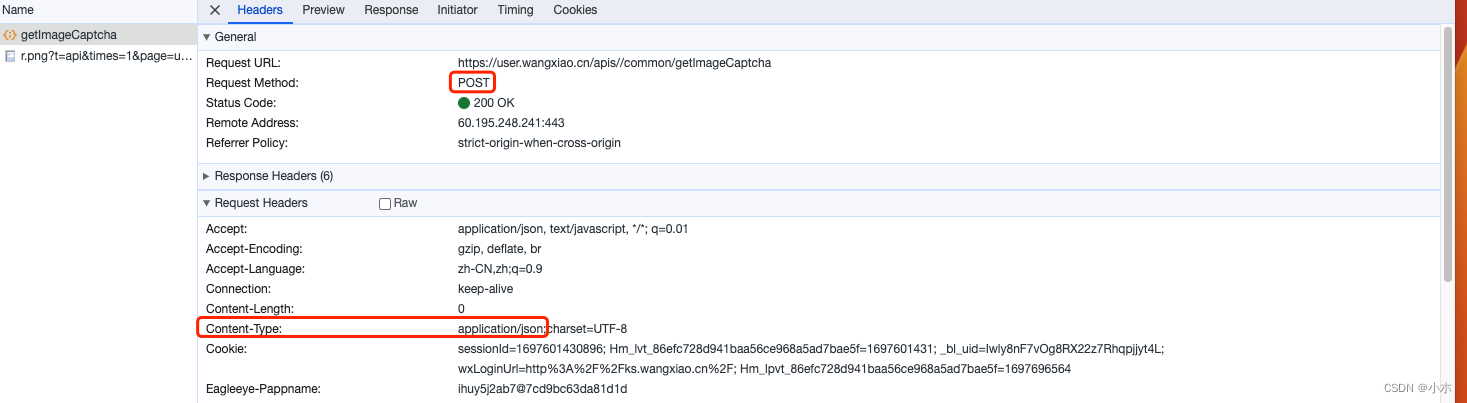

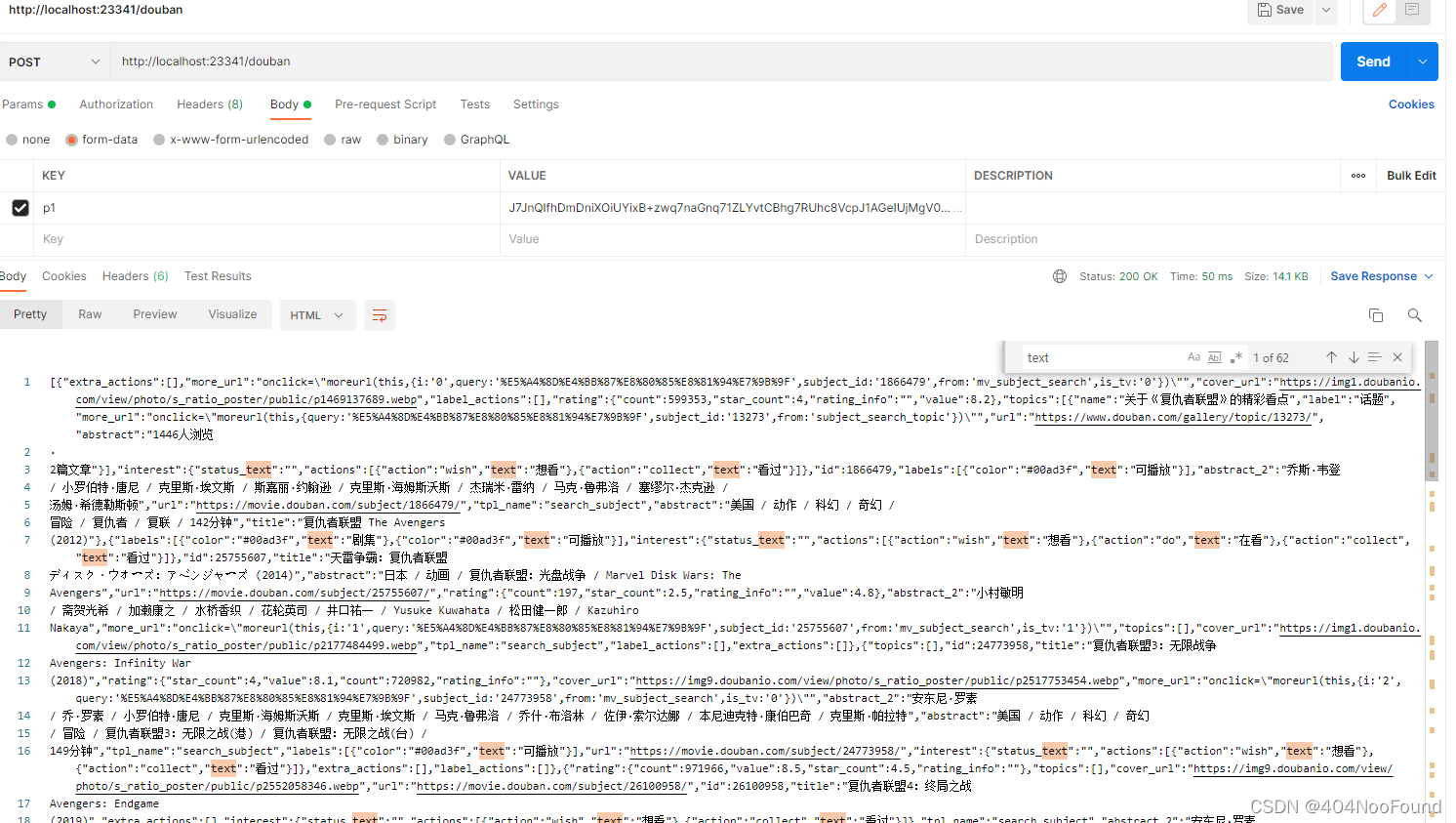

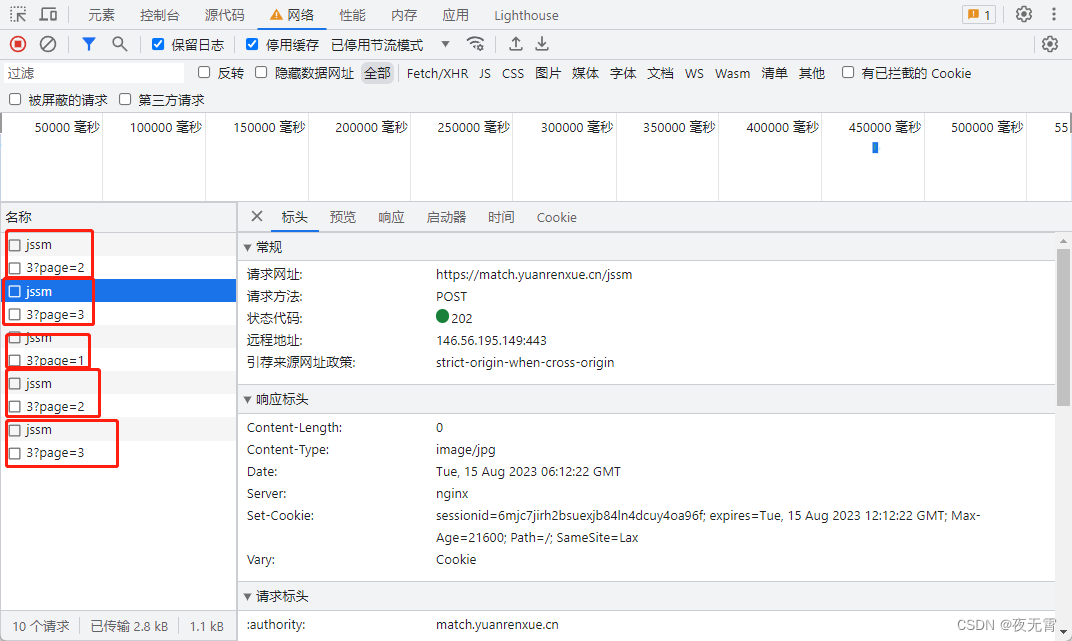

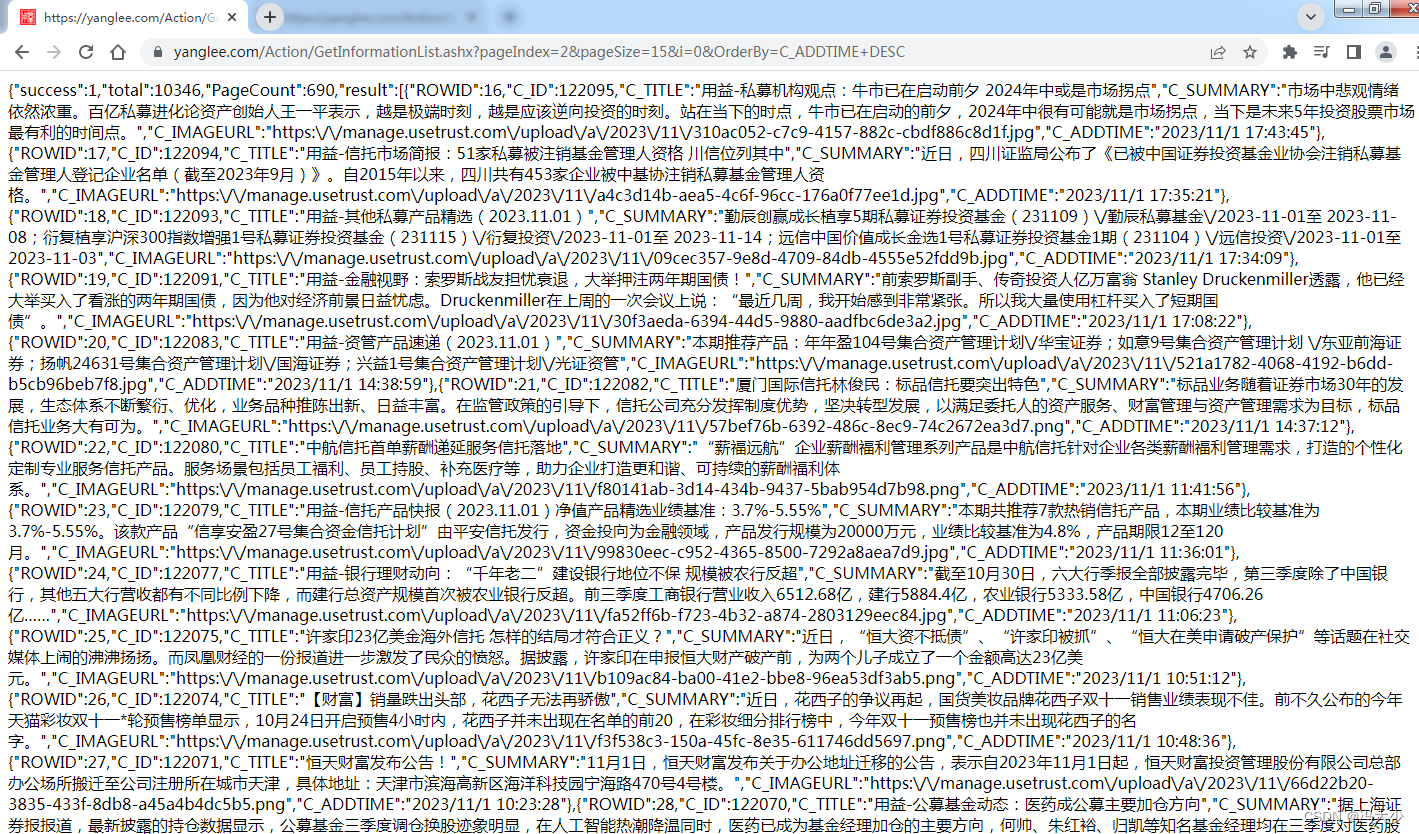

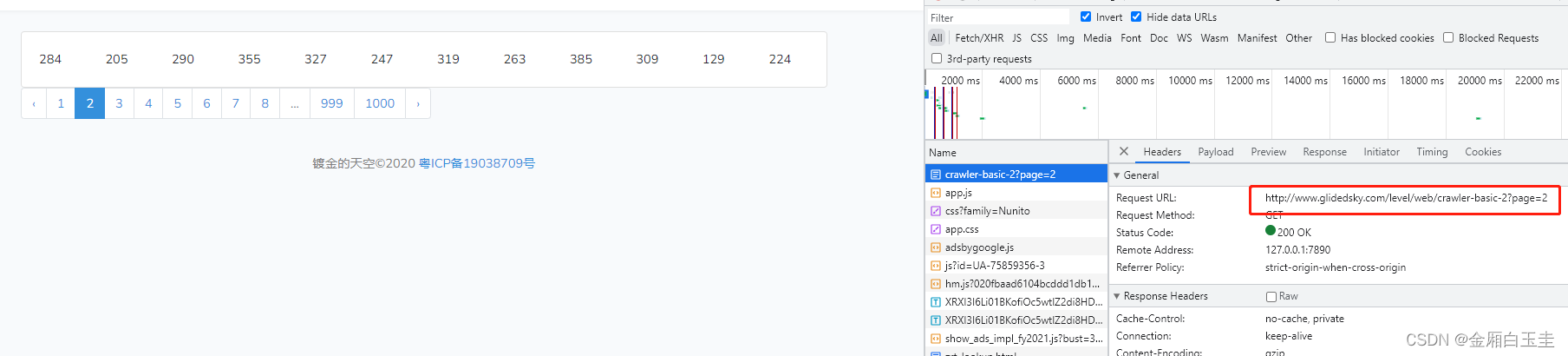

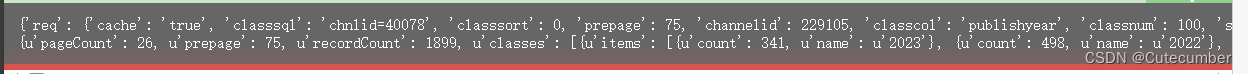

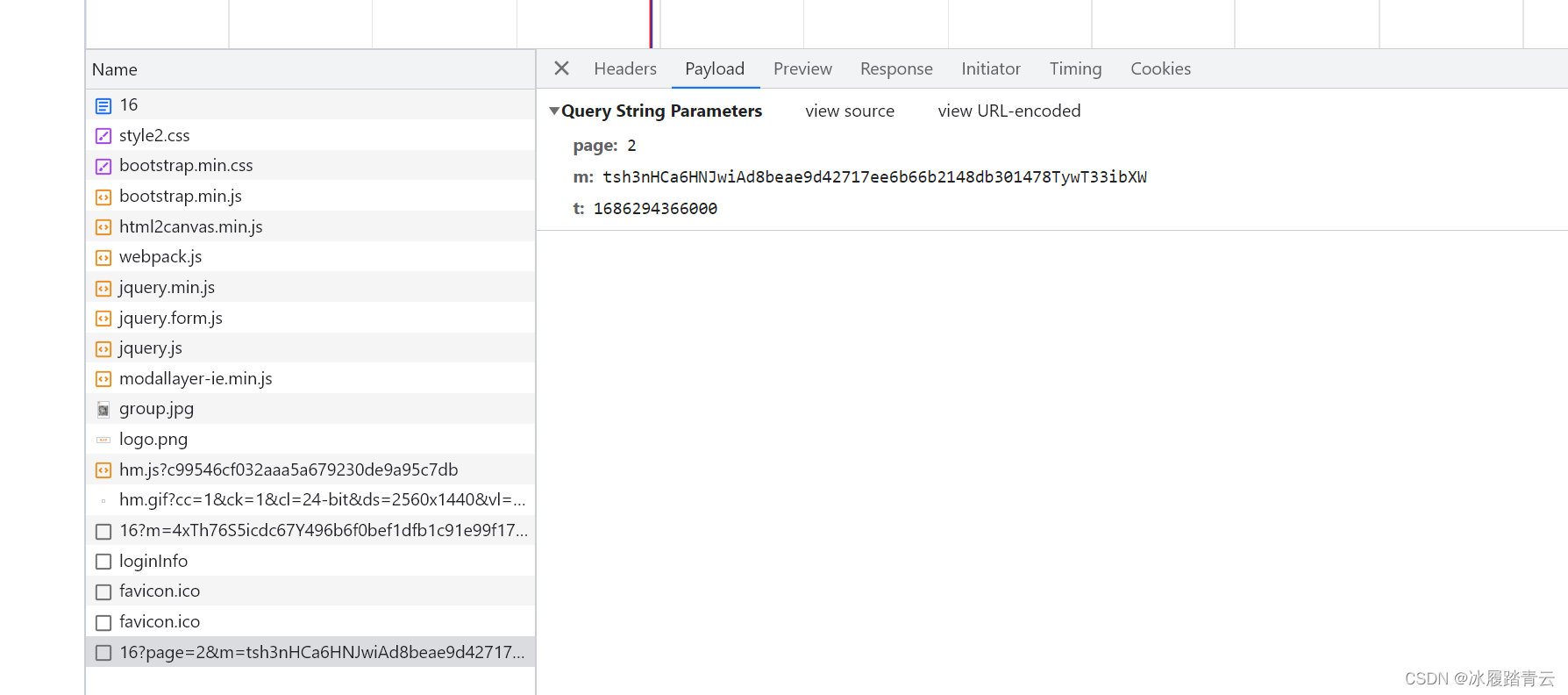

python 面对post分页爬虫

分享一则对于网抓中面对post请求访问的页面或者在分页过程中需要post请求才可以访问的内容! 面的post请求的网址是不可以零参访问网址的,所以我们在网抓的过程中需要给请求传表单数据,下面看一下网页中post请求的网址: post请求状…

python网络爬虫学习资料

第一:Python爬虫学习系列教程(来源于某博主:http://cuiqingcai.com/1052.html) Python版本:2.7 整体目录: 一、爬虫入门 1. Python爬虫入门一之综述 2. Python爬虫入门二之爬虫基础了解 3. Python爬虫入门三…

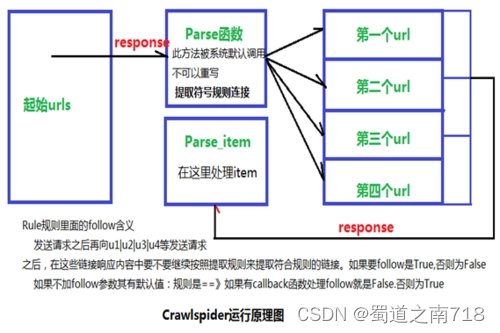

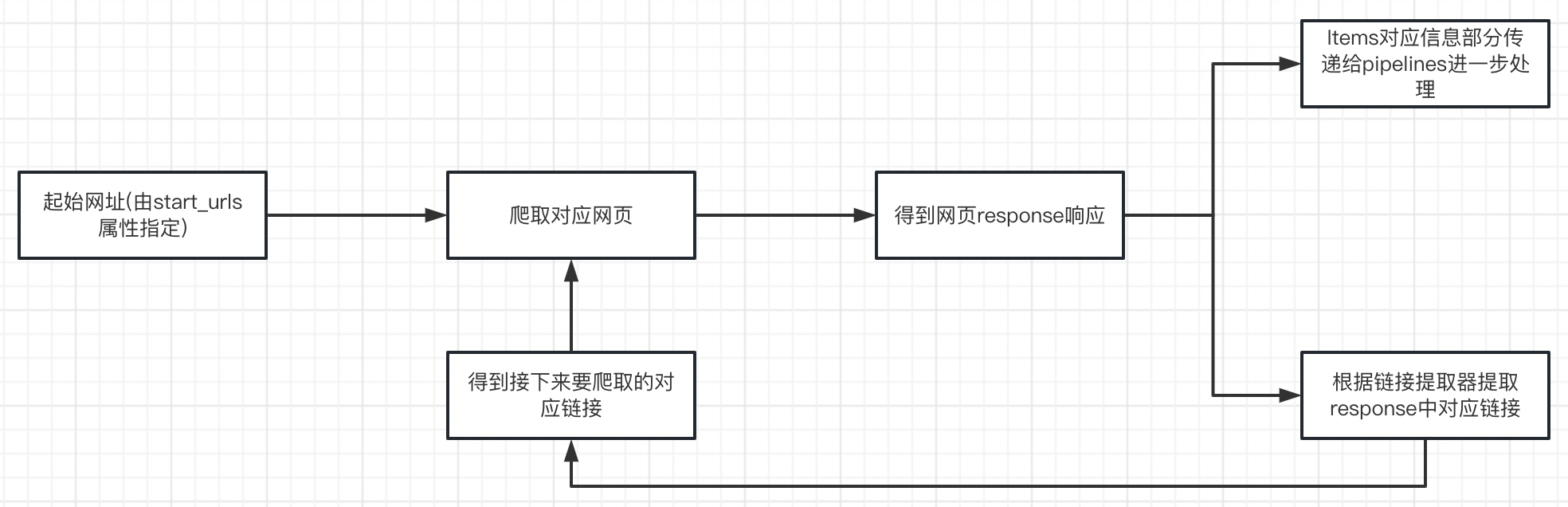

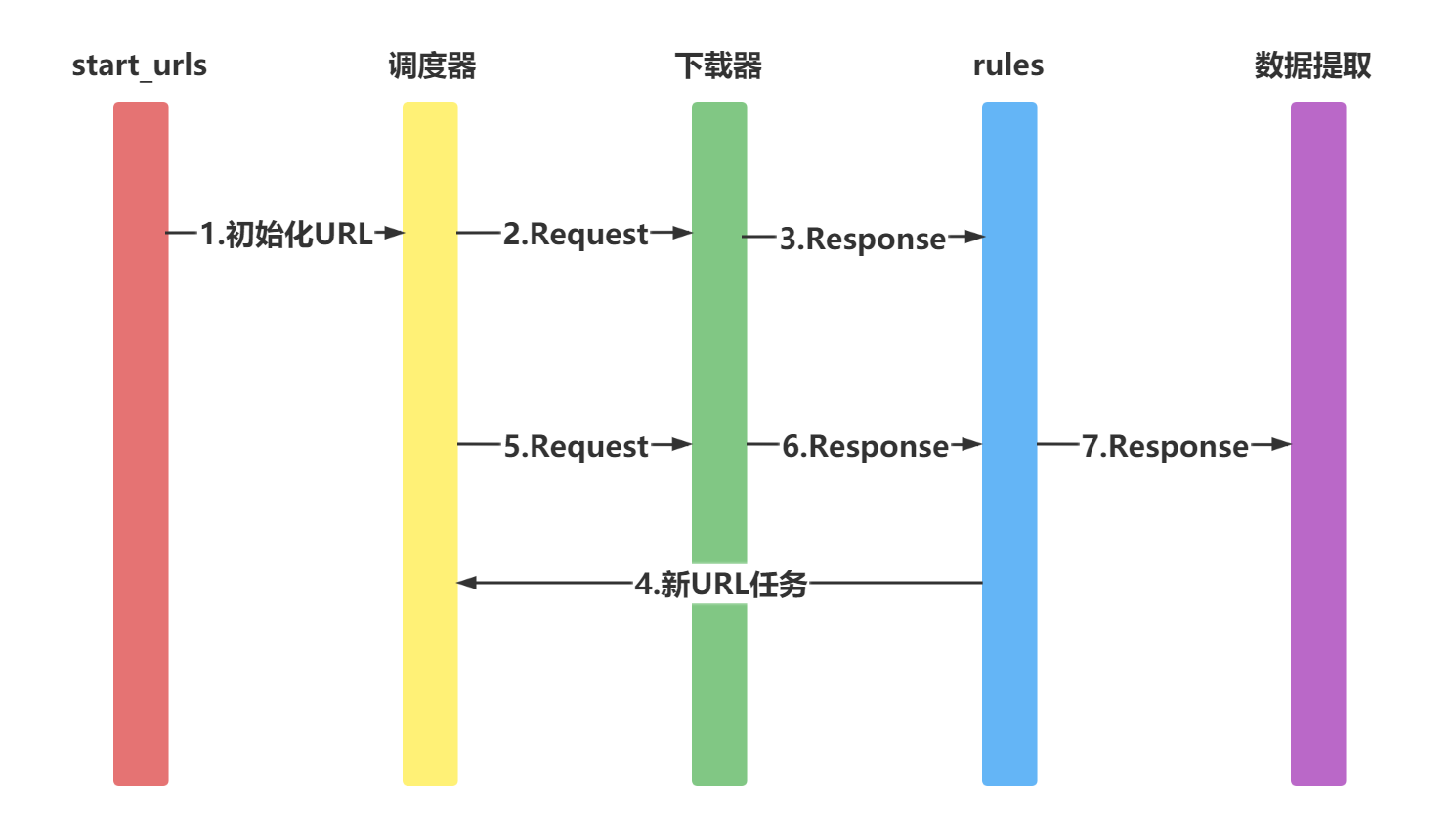

scrapy CrawlSpider解析

CrawlSpider继承自Spider, CrawlSpider主要用于有规则的url进行爬取。 先来说说它们的设计区别: SpiderSpider 类的设计原则是只爬取 start_urls 中的url,而 CrawlSpider 类定义了一些规则 rules 来提供跟进链接 link 的方便机制,从爬取的网页…

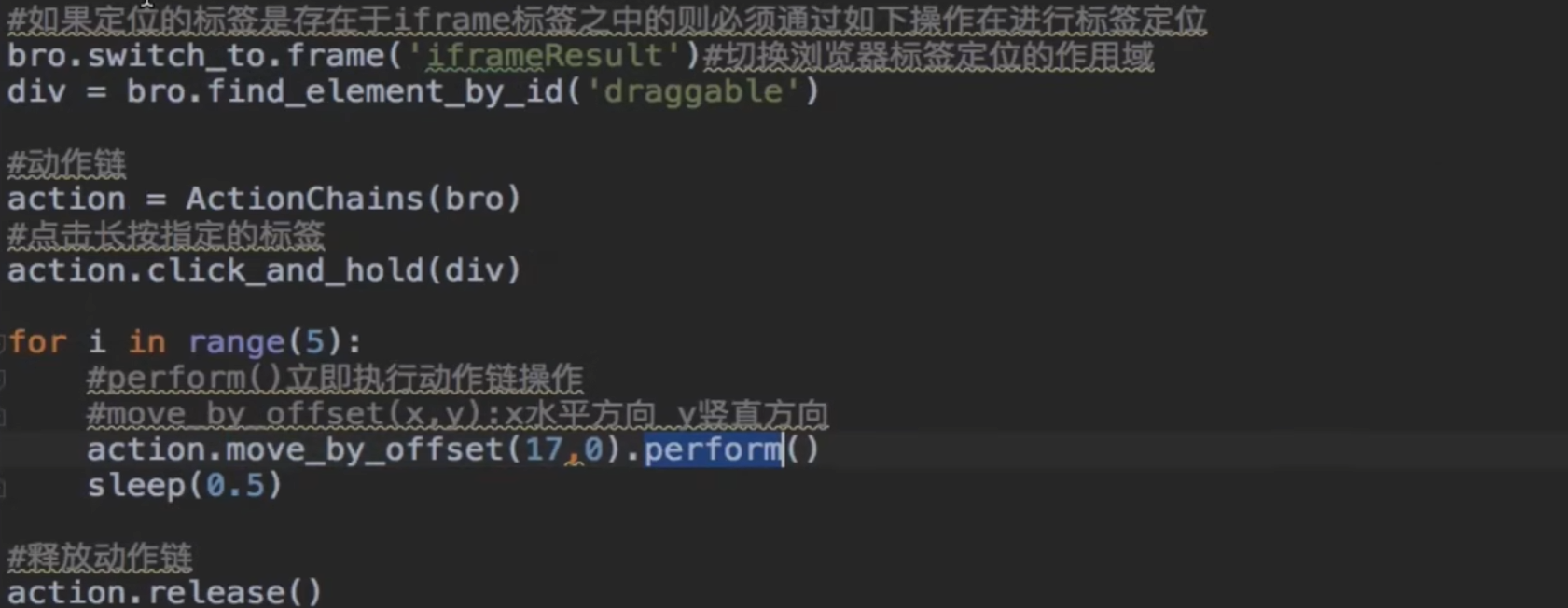

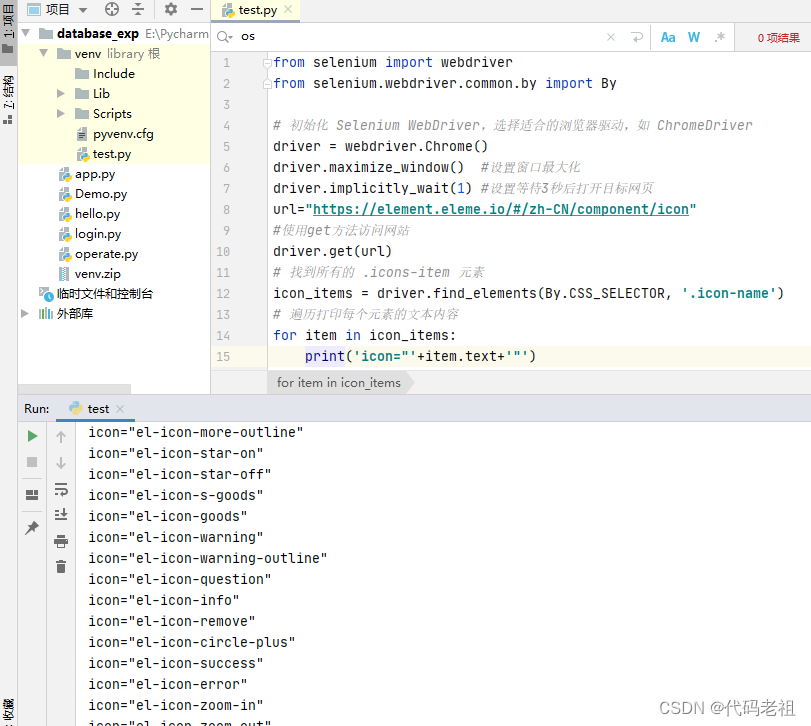

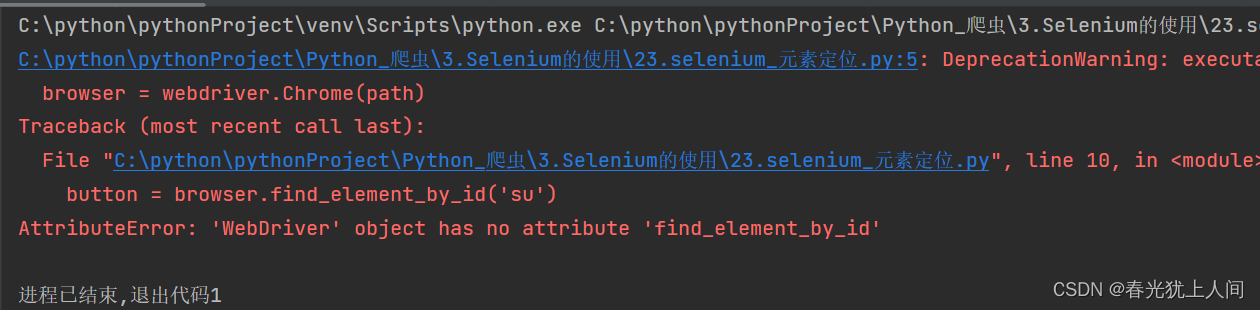

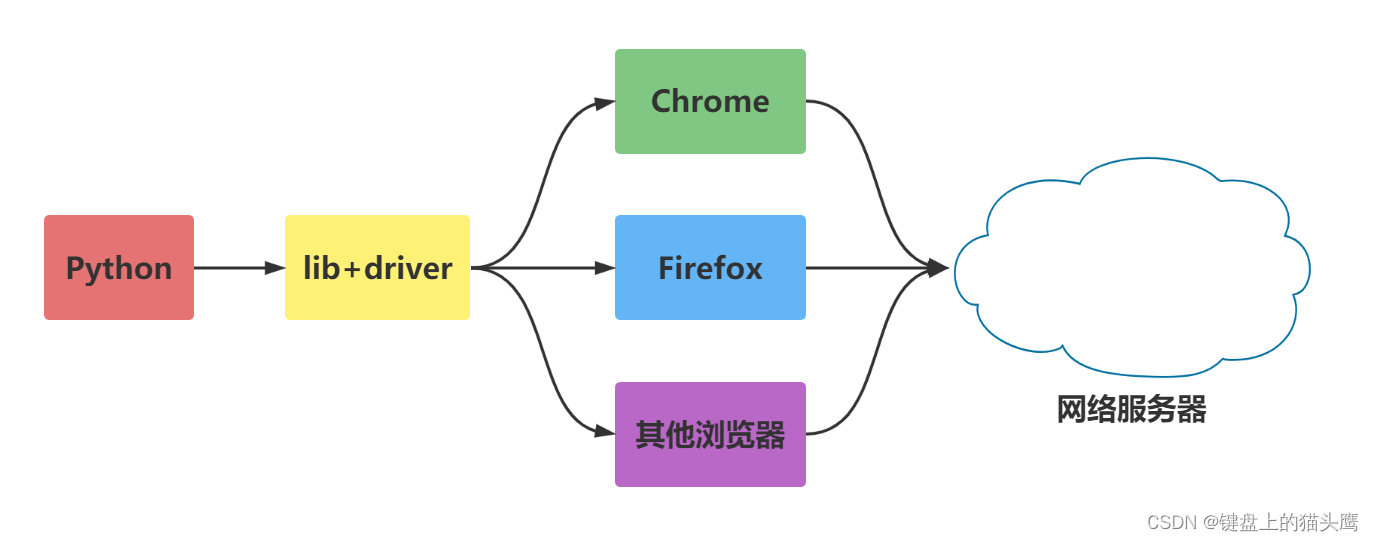

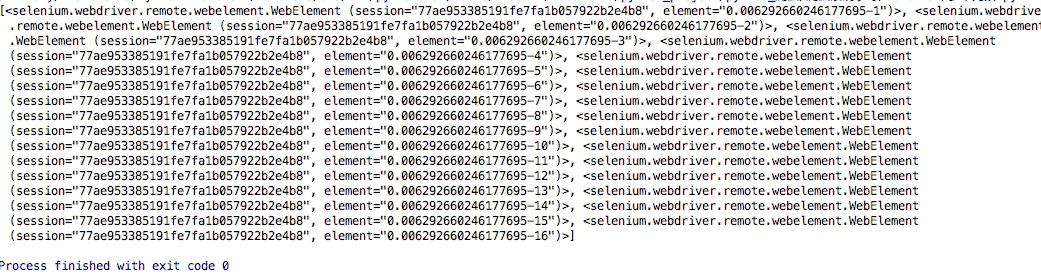

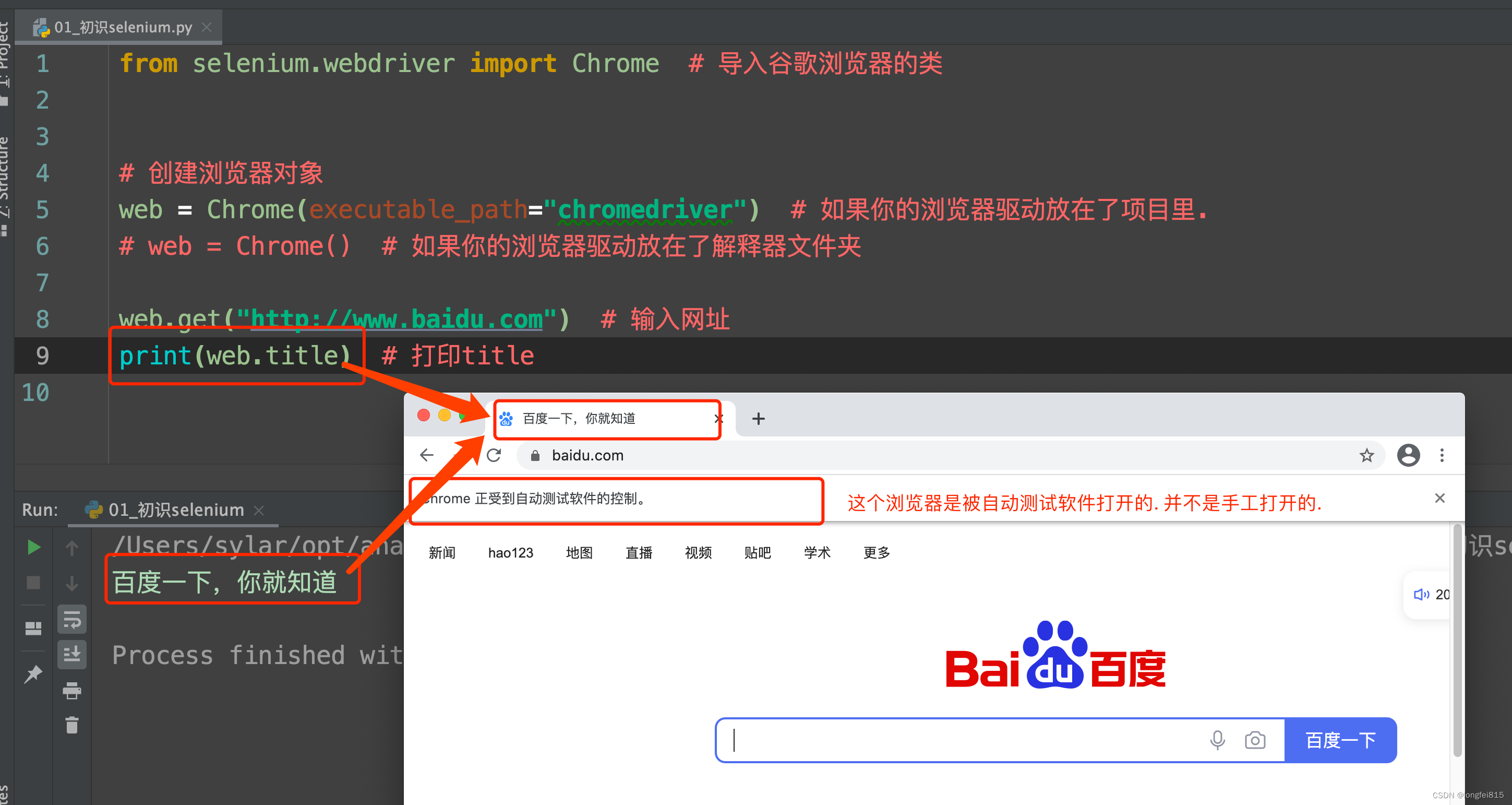

爬虫(selenium)

selenium BeautifulSoup:处理速度快,同时可以连续查找,主要用于静态 Selenium:主要用于动态网页,查找速度慢 一、声明浏览器对象 from selenium import webdriverbrowser webdriver.Chrome()

browser webdriver.Firefox()

browser webdriver.Edge()

browser webdriver.Ph…

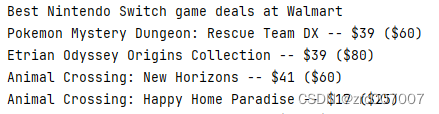

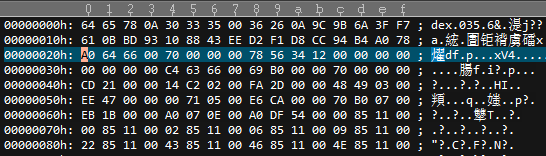

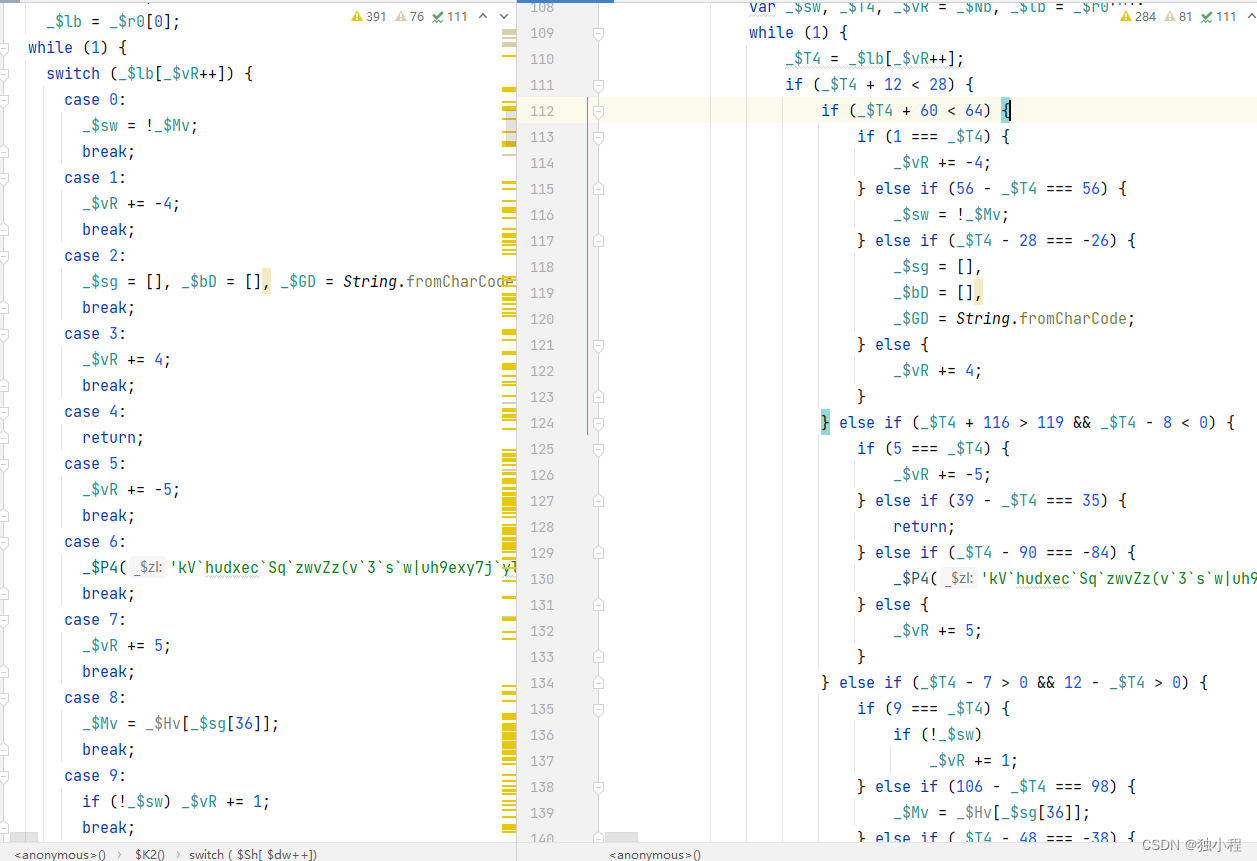

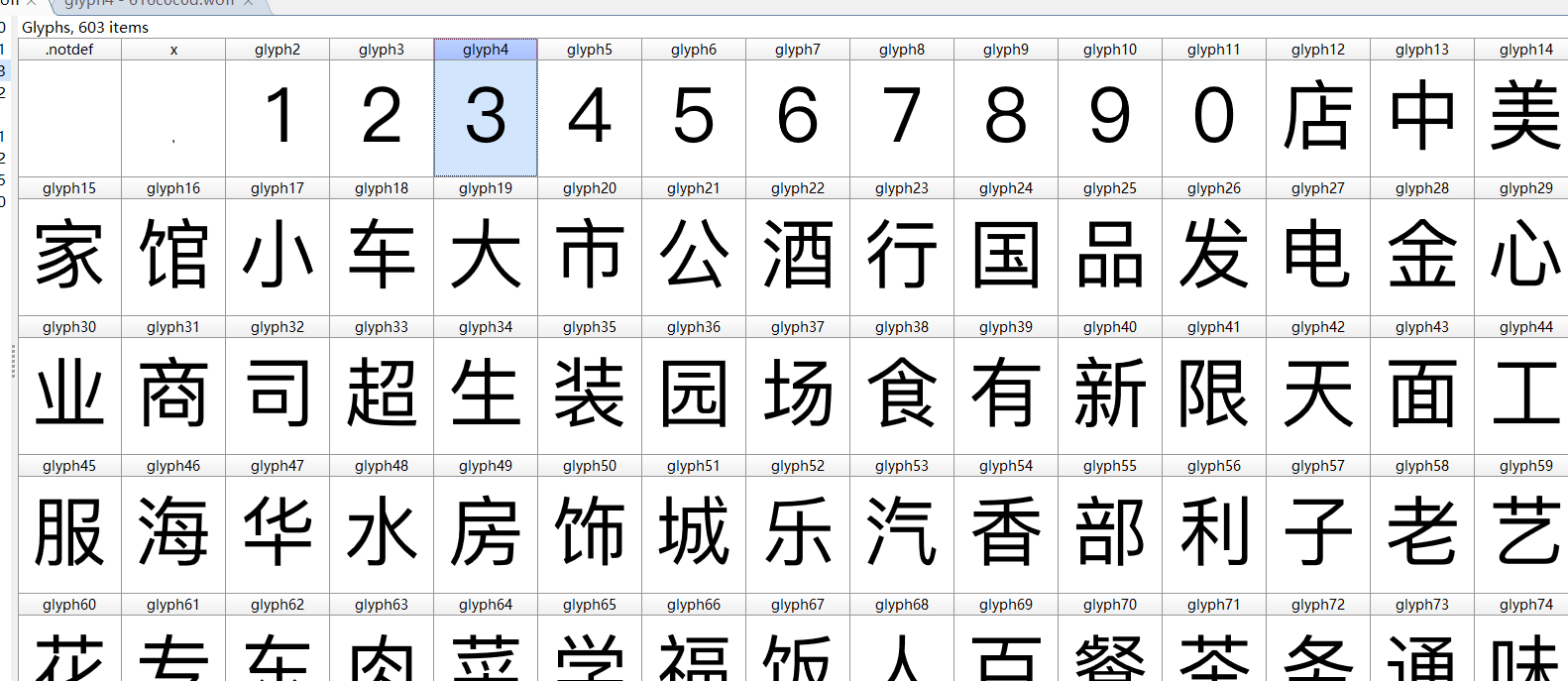

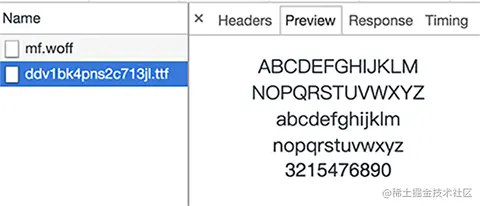

C#爬虫与反爬虫--字体加密篇

爬虫和反爬虫是一条很长的路,遇到过js加密,flash加密、重点信息生成图片、css图片定位、请求头.....等手段;今天我们来聊一聊字体; 那是一个偶然我遇到了这个网站,把价格信息全加密了;浏览器展示࿱…

【转】android开源项目和框架

特效: http://www.androidviews.net/ http://www.theultimateandroidlibrary.com/ 常用效果: 1. https://github.com/novoda/ImageLoader 异步加载图片,缓存,生成缩略图, 基本上每个应用都会需要这个lib。 android…

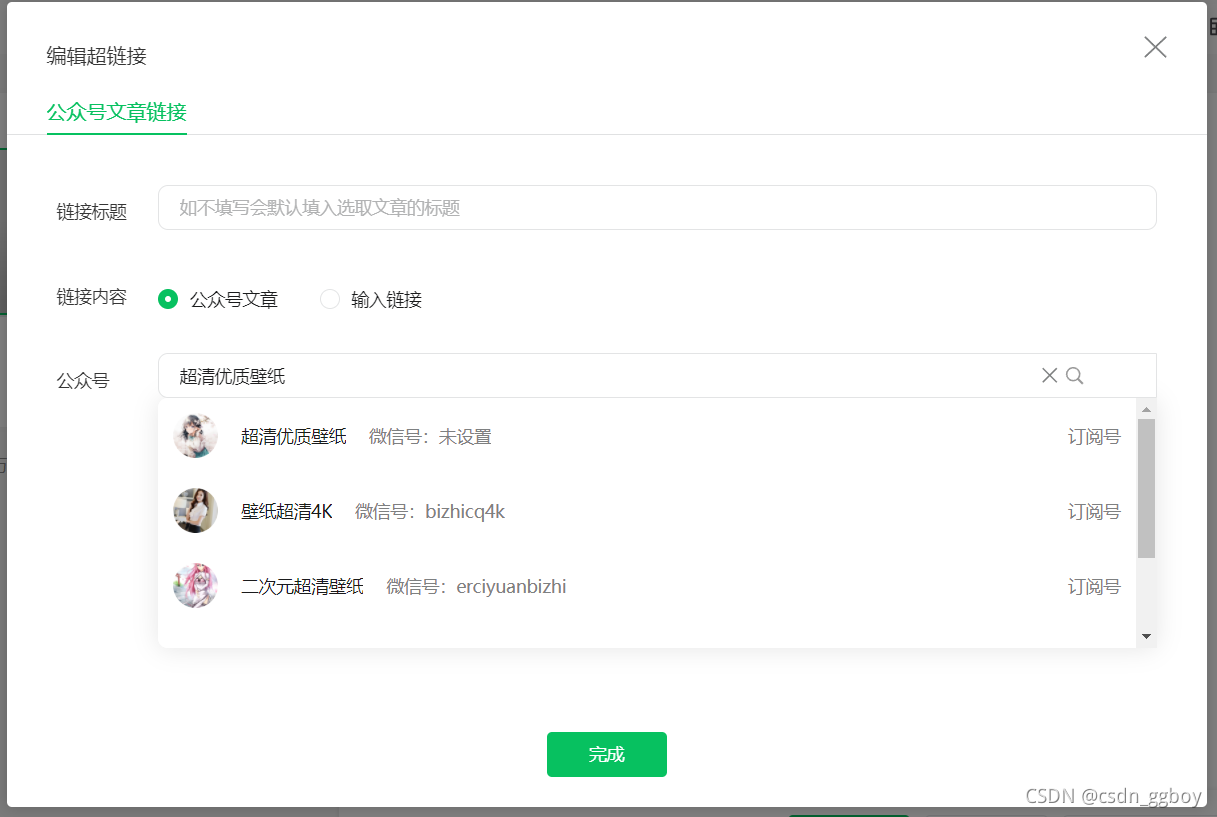

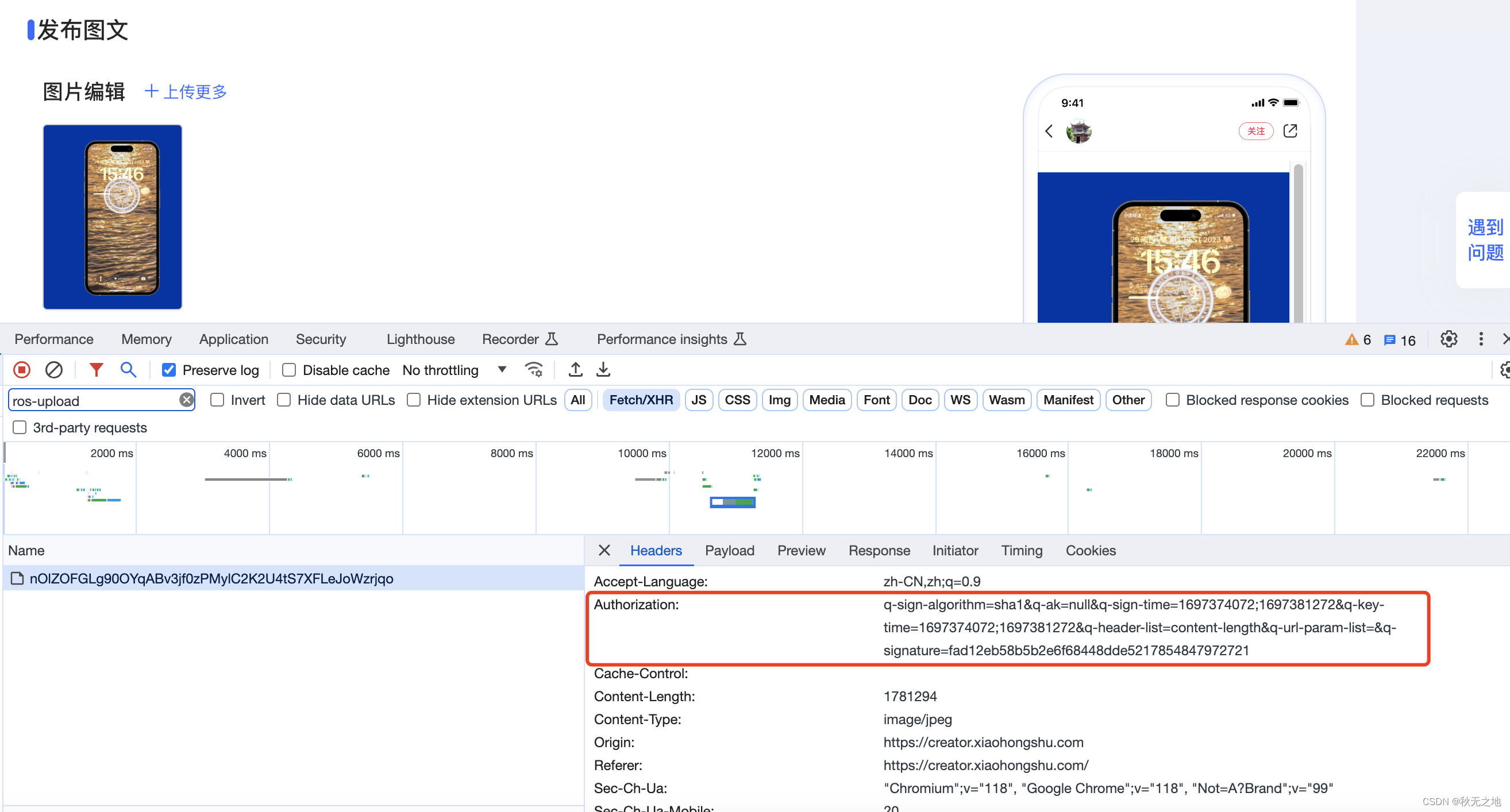

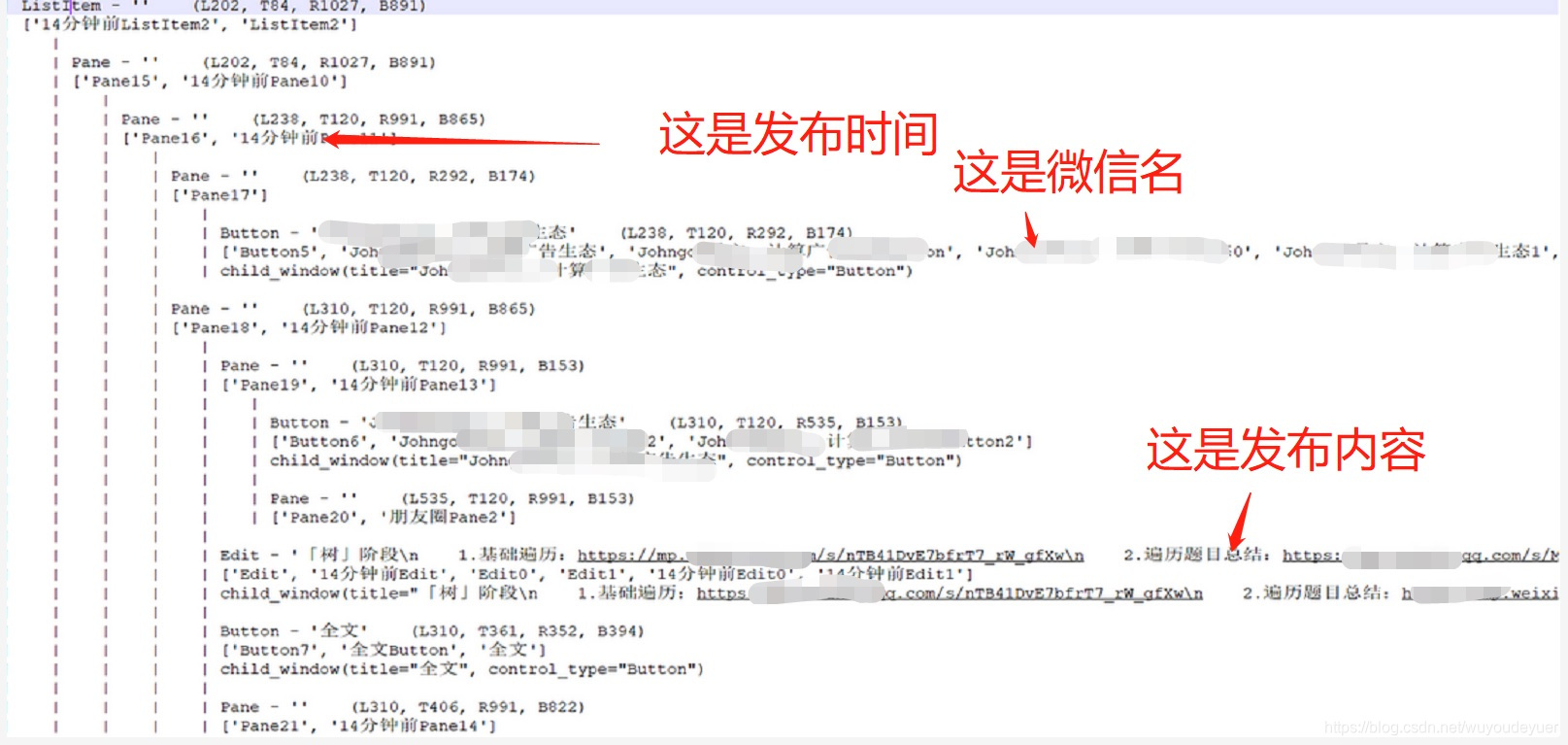

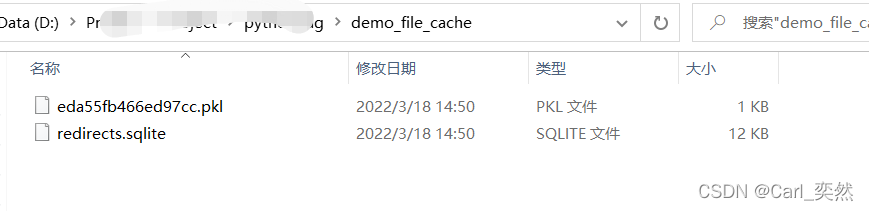

python爬虫——爬取微信公众号的文章及图片

参考

爬取公众号所有文章

想要爬取微信公众号的所有文章,微信只有文章是有地址的,如何找到这个公众号的所有文章呢?

找到该公众号的链接

打开公众号平台,找到创作图文消息 这样就找到了微信号

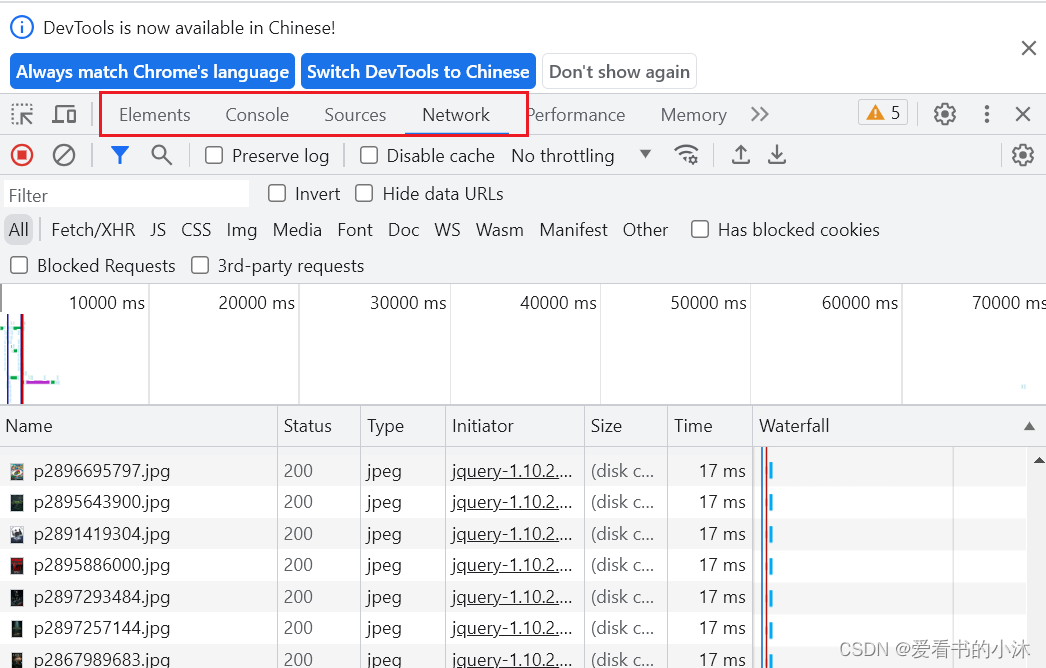

打开检查模式,选择…

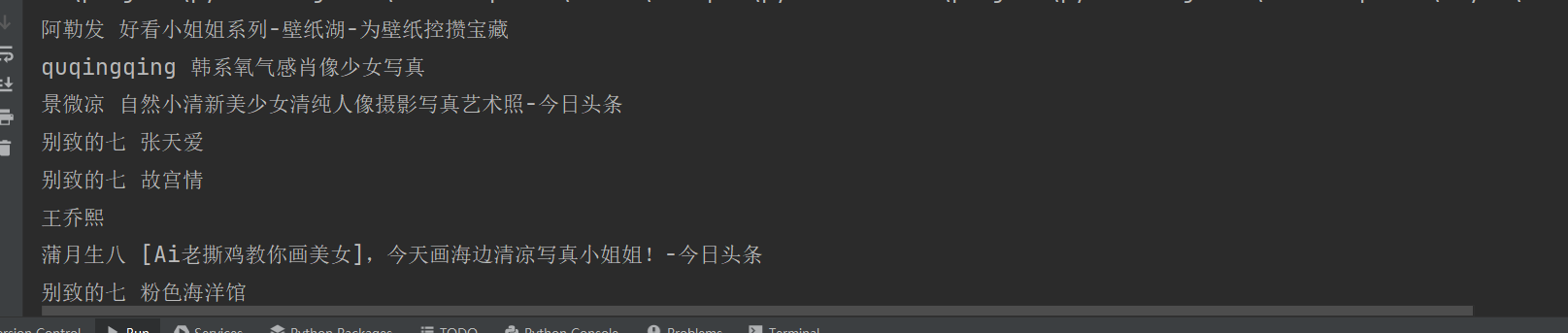

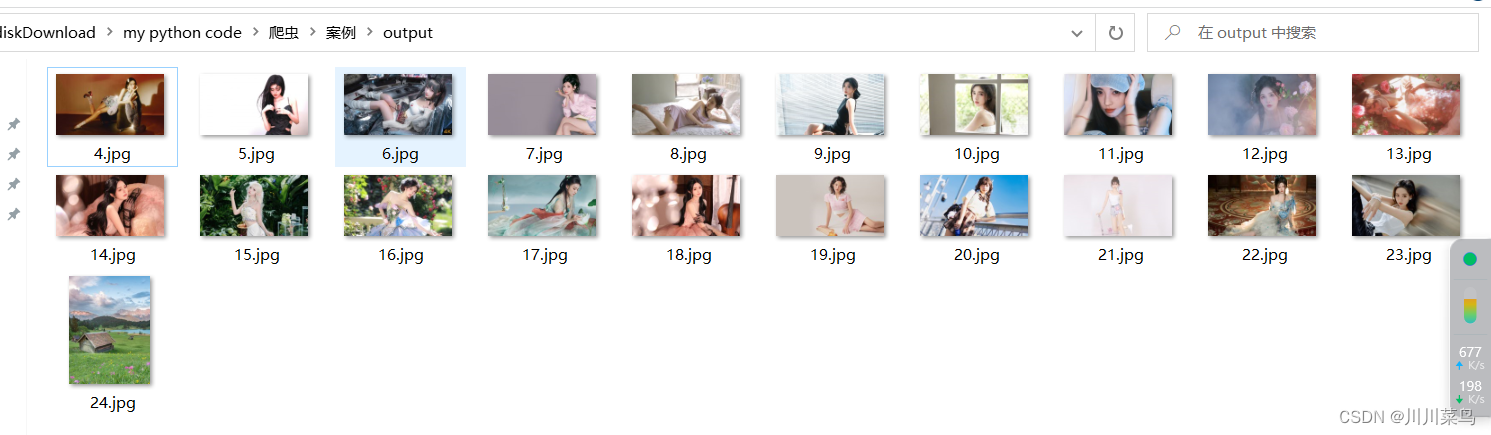

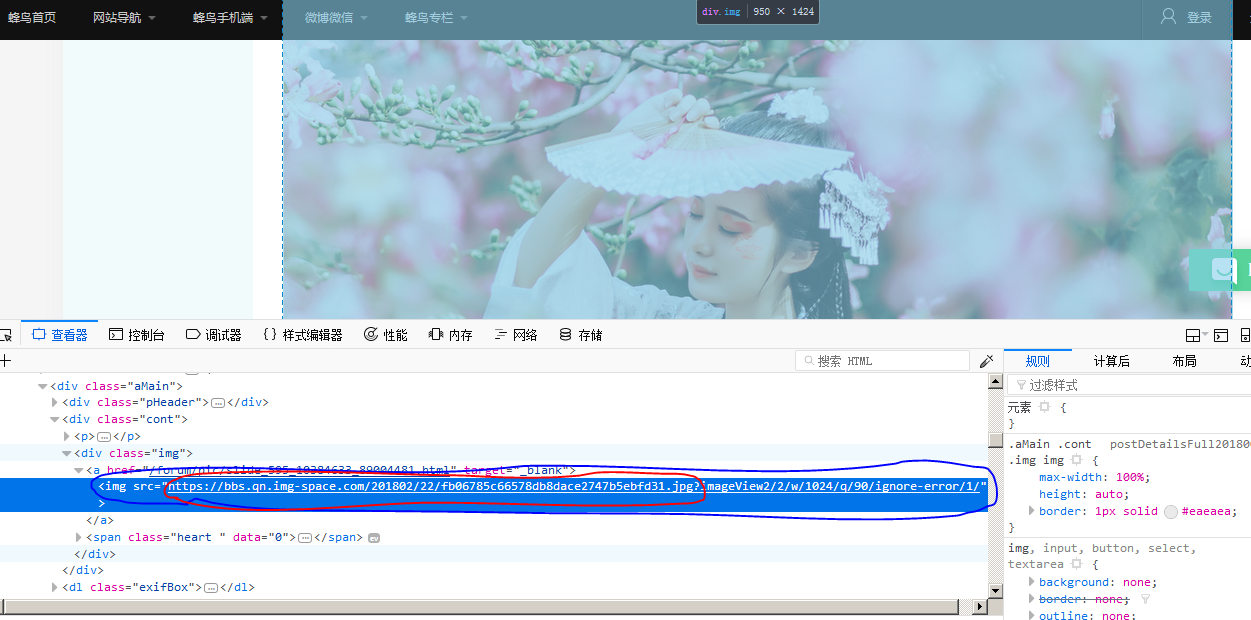

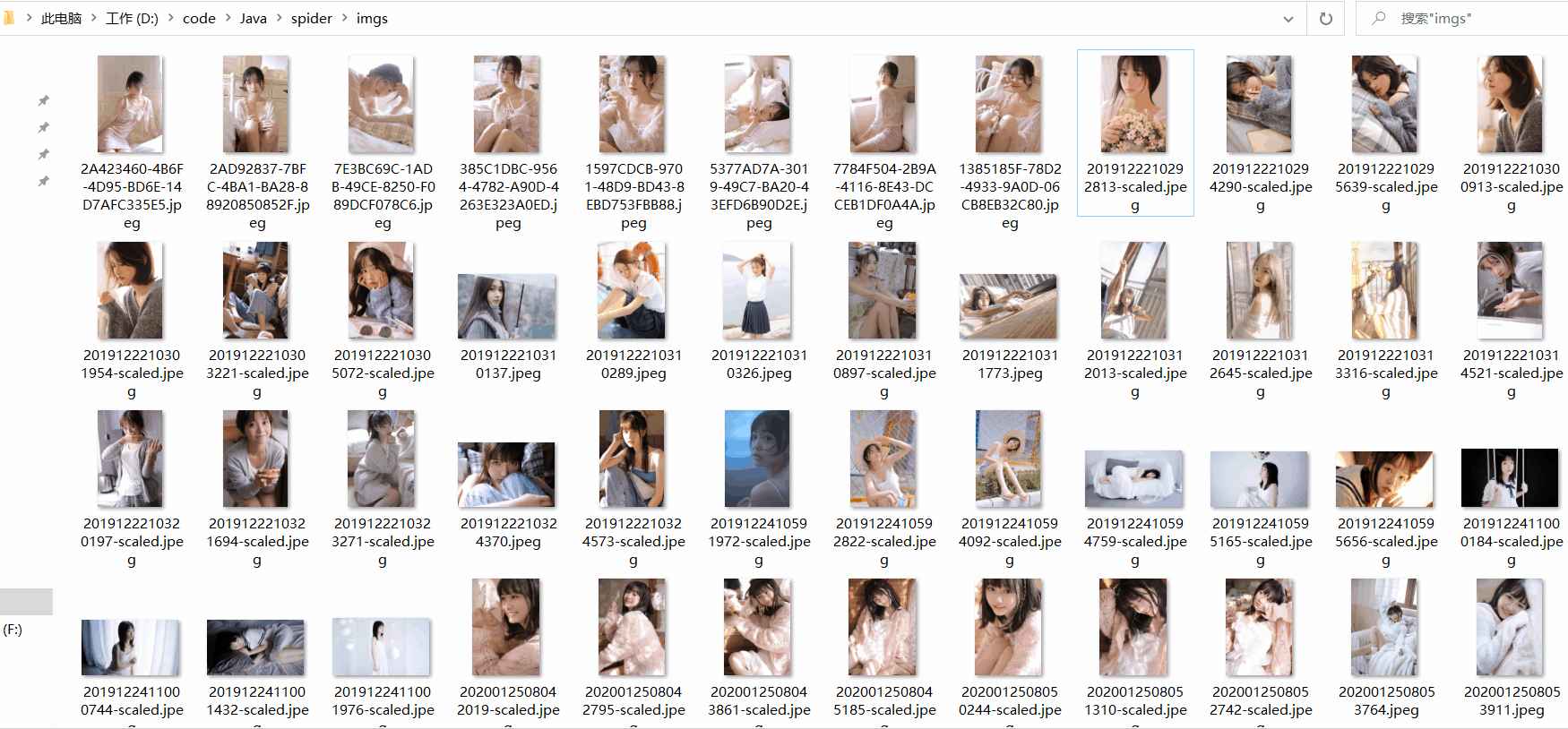

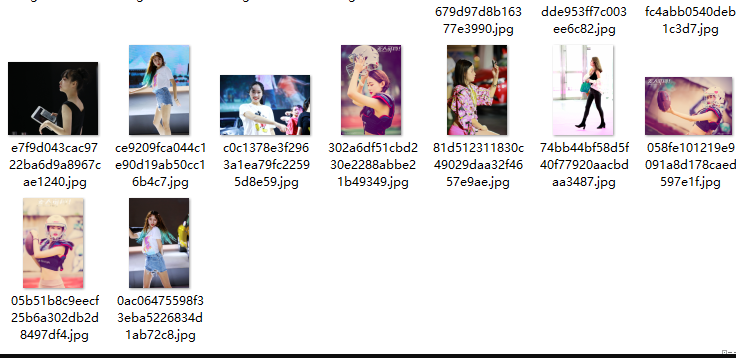

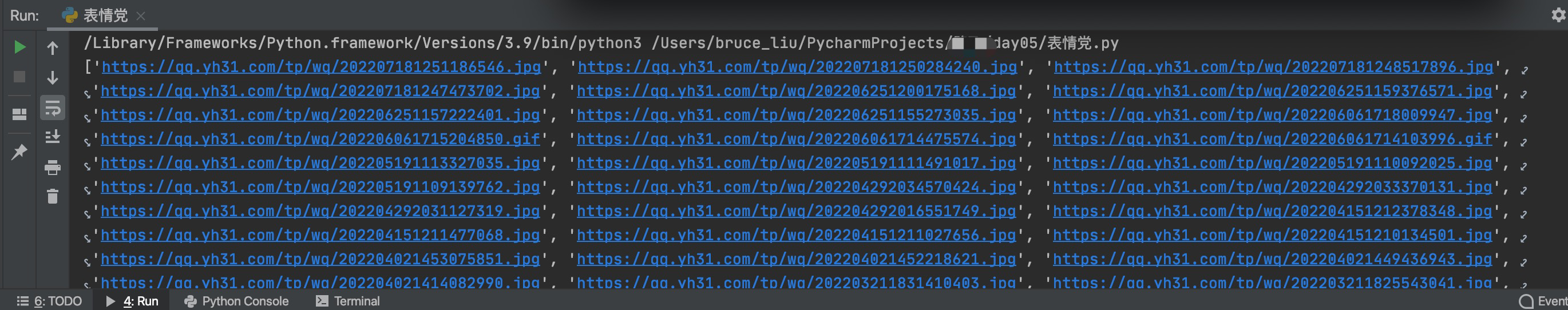

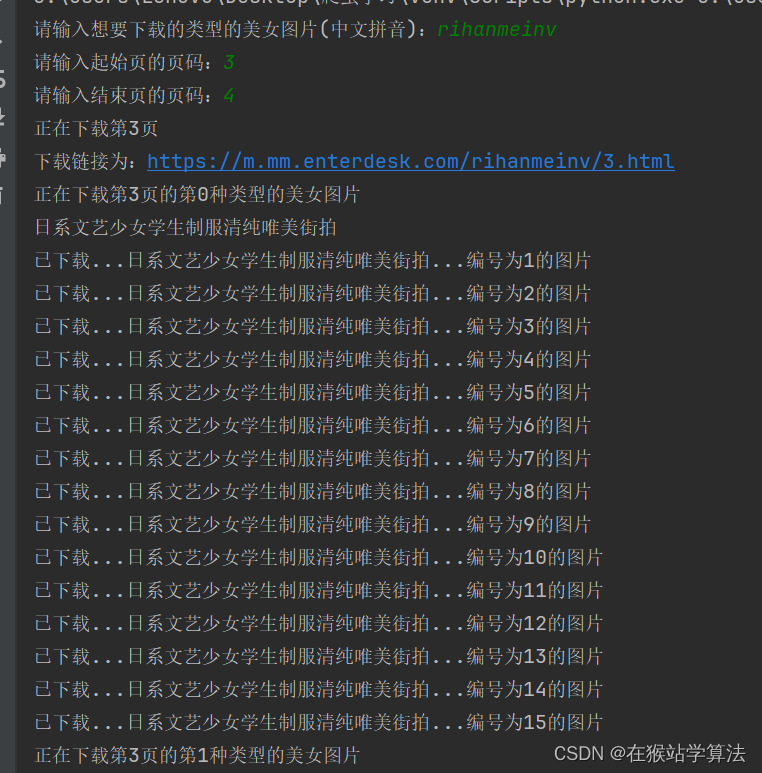

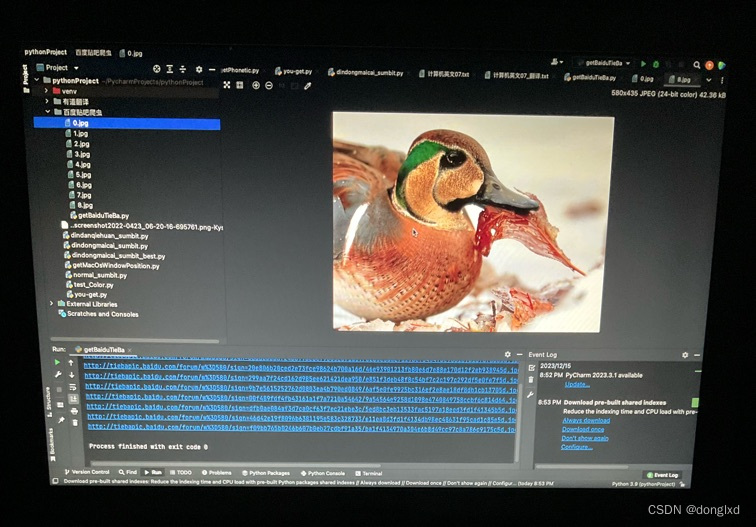

python爬虫爬取妹子图

爬取网页 req urllib.request.Request(url)req.add_header(user-agent,Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36)response urllib.request.urlopen(req)html response.read()res requests.get(im…

Acwing基础课刷题

第一讲 基础算法

快速排序88

(AcWing) (785). 快速排序

(AcWing) (786). 第(k)个数

归并排序

(AcWing) (787). 归并排序

(AcWing) (788). 逆序对的数量

二分

(AcWing) (789). 数的范围

(AcWing) (790). 数的三次方根

高精度

(AcWing) (791). 高精度加法

(AcWing) (…

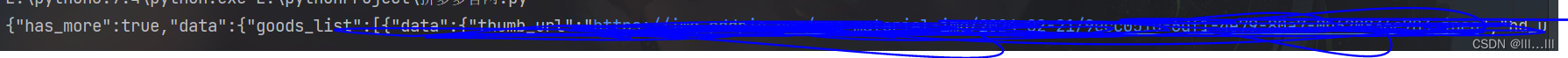

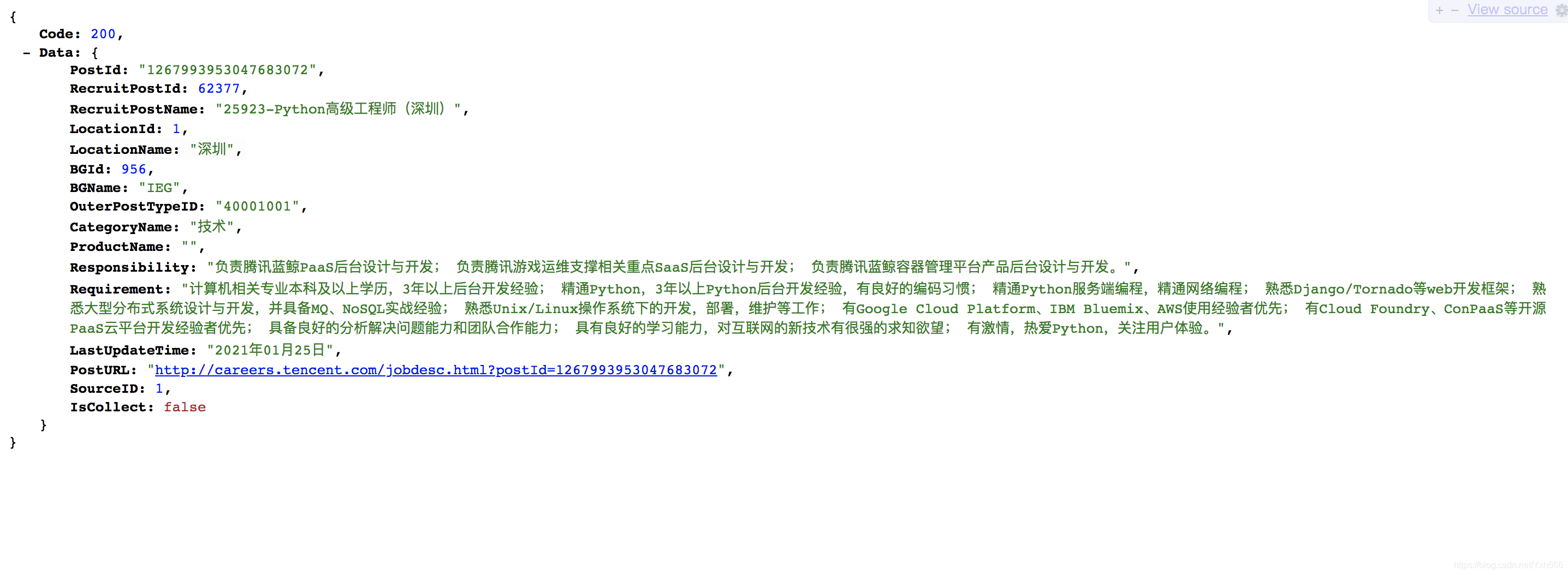

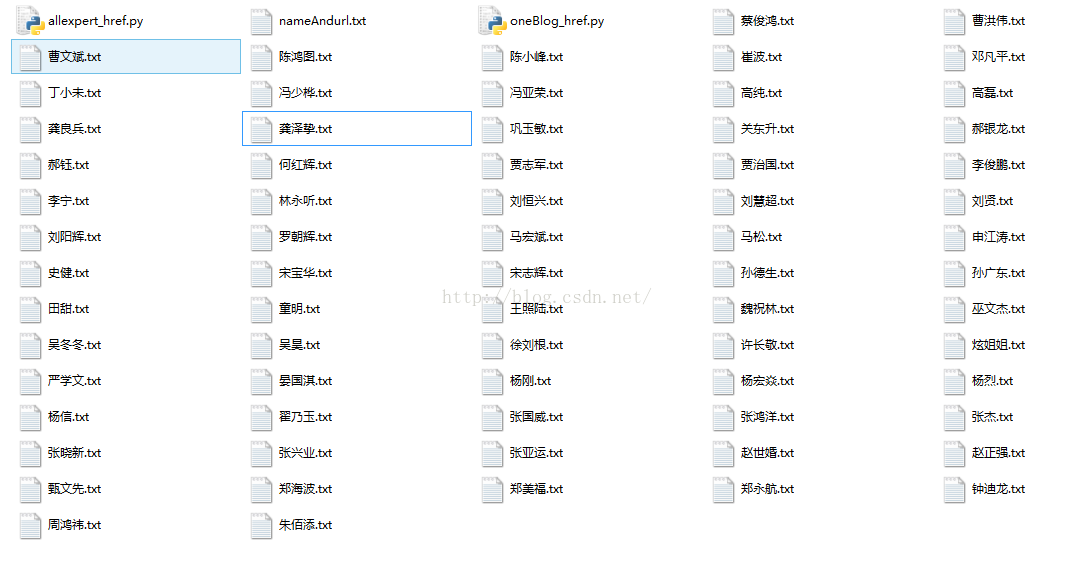

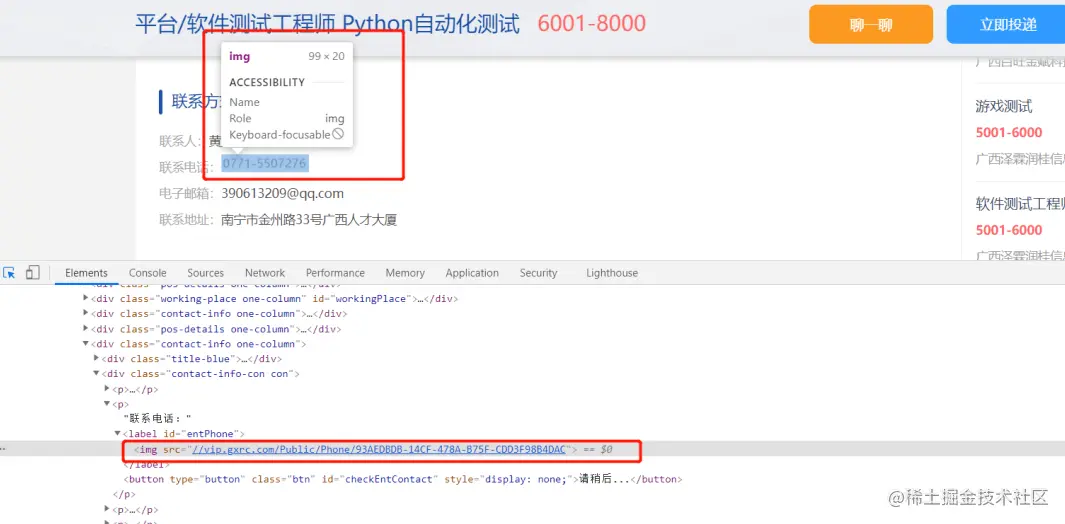

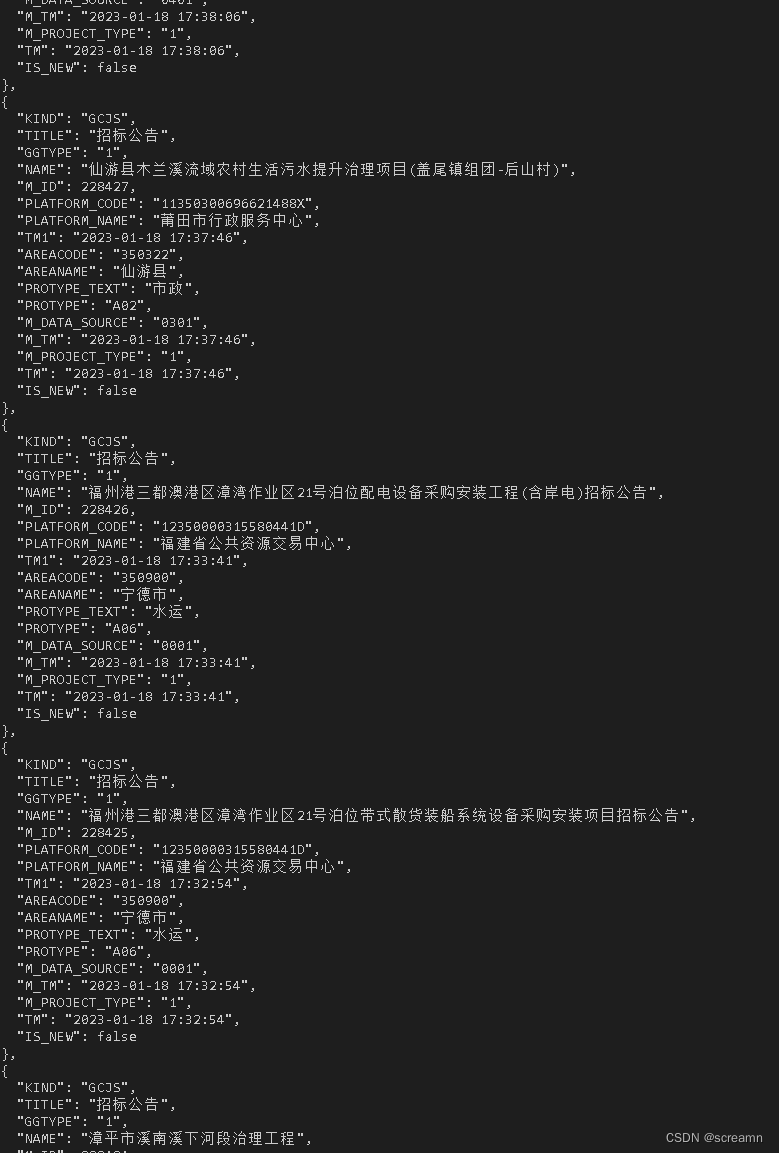

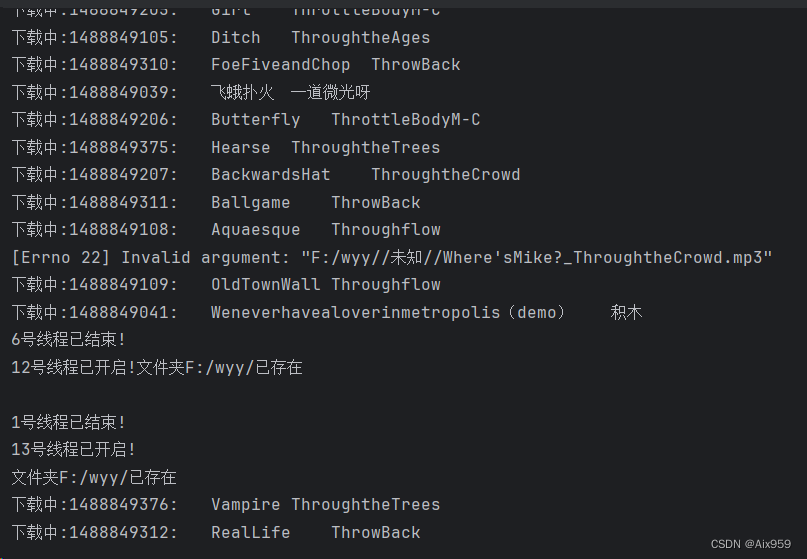

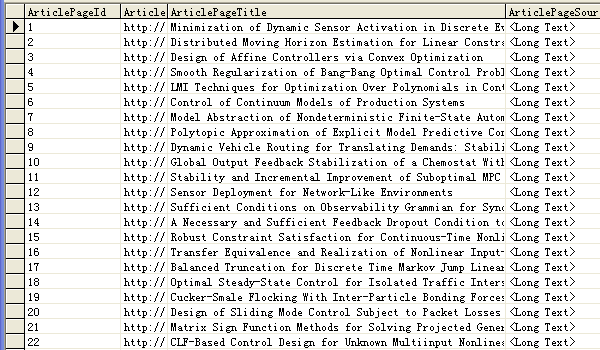

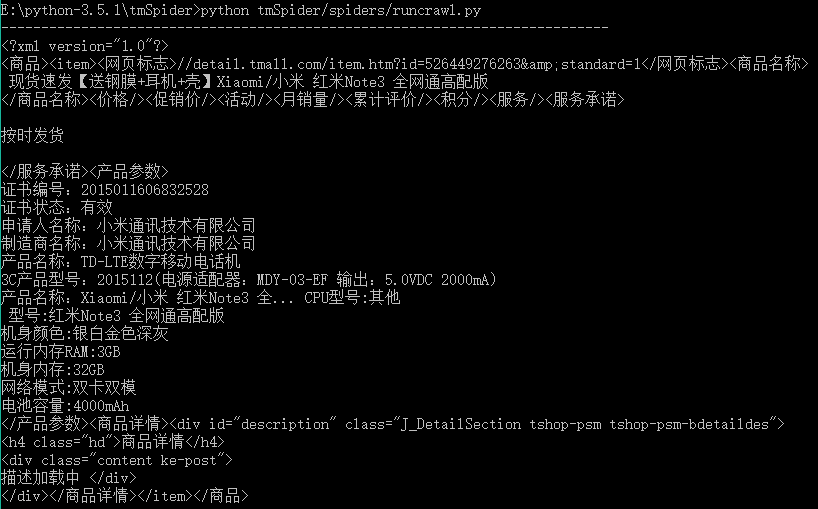

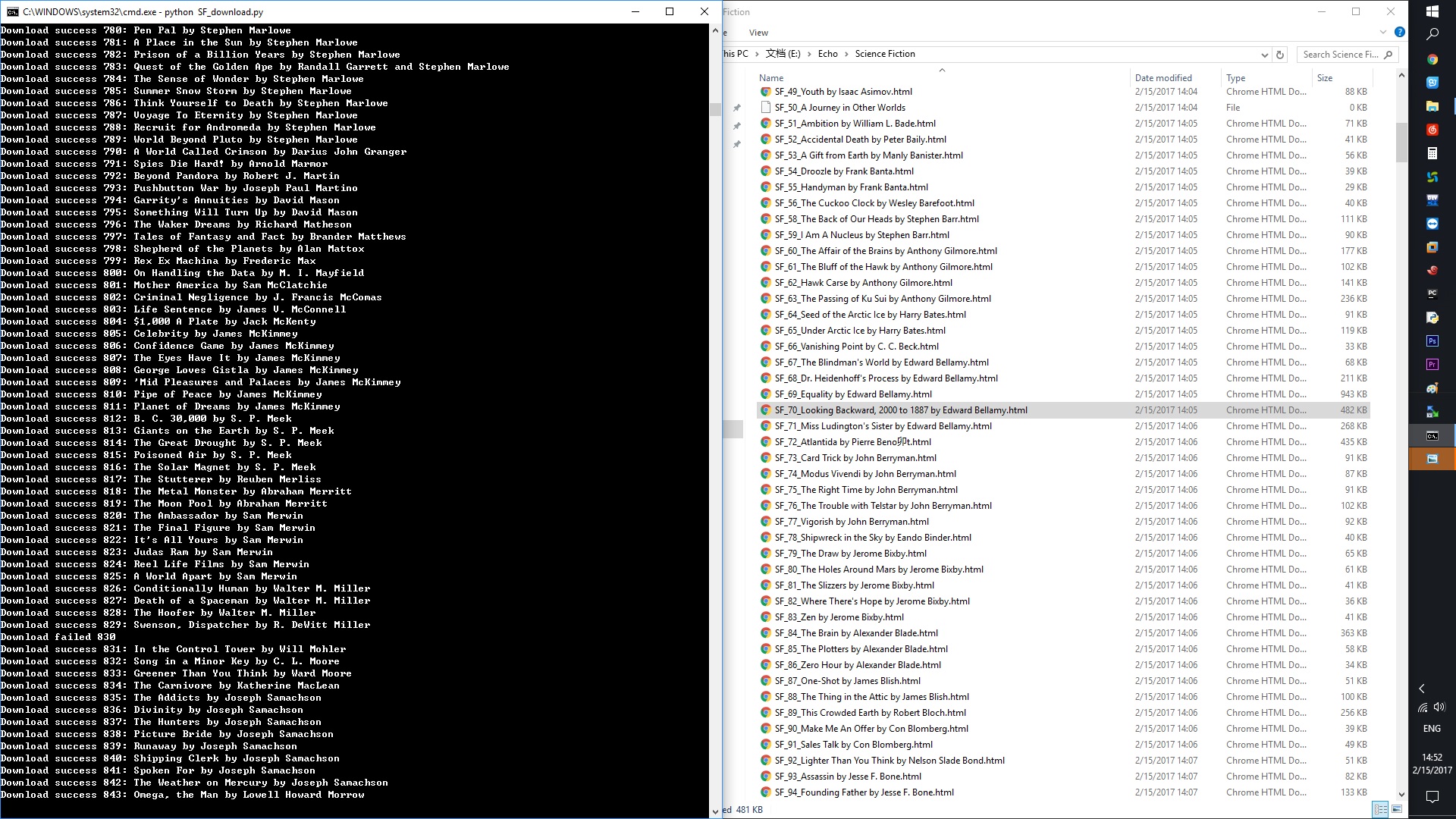

企业数据爬虫项目(二)

企业数据爬虫项目(艳辉VIP项目)第一天:下载解析网站页面第二天:多线程定时启动爬虫第一天:下载解析网站页面

第二天:多线程定时启动爬虫

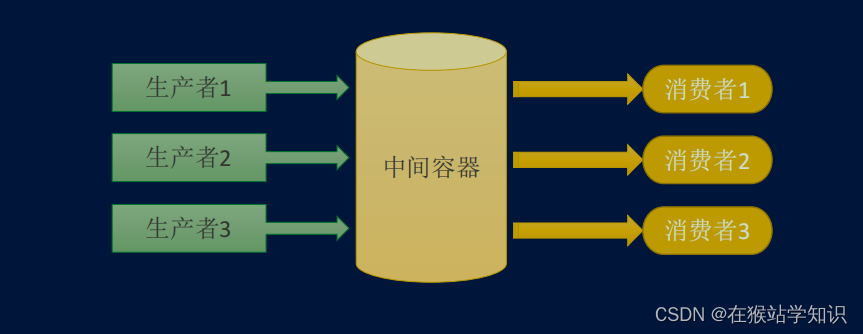

一个爬虫项目,会涉及到数据存储,Queue队列…

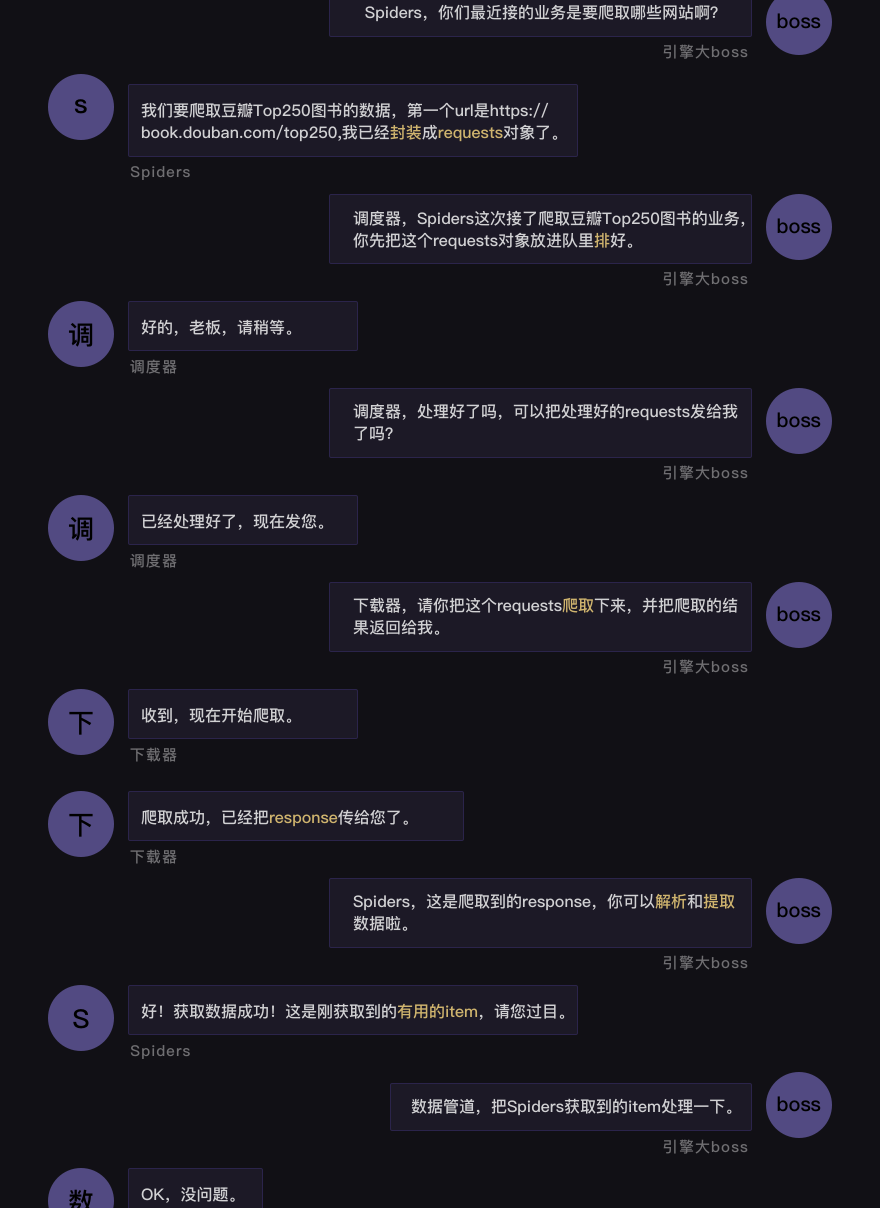

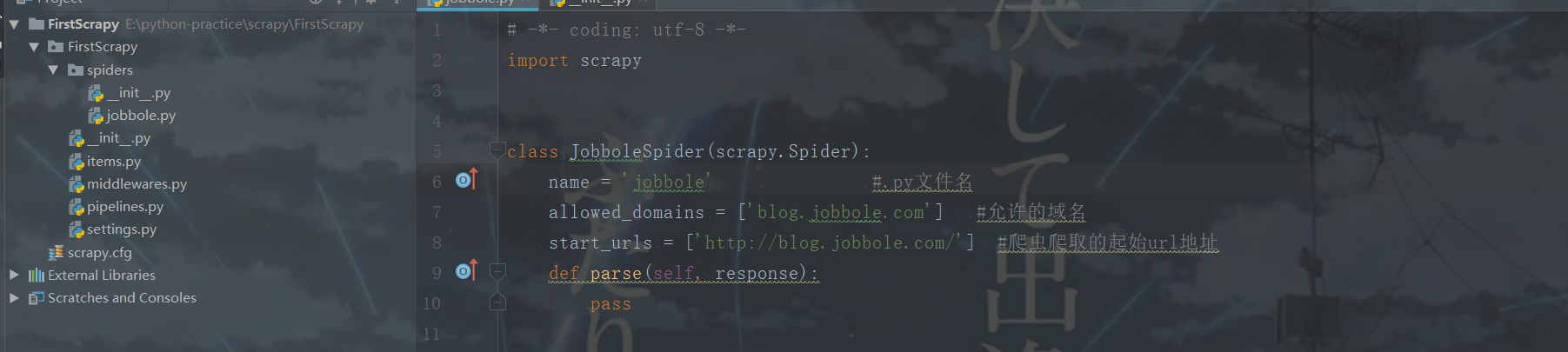

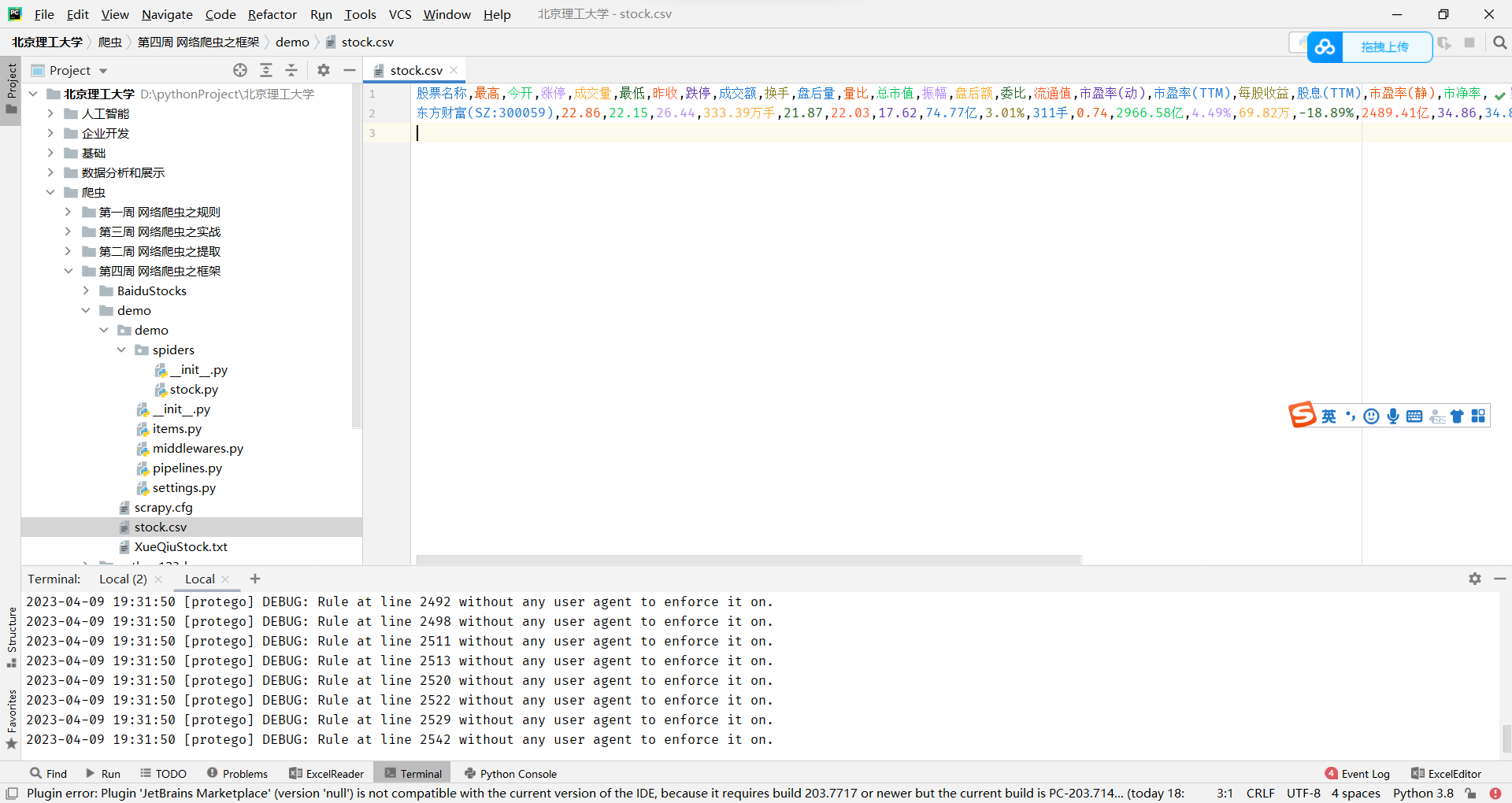

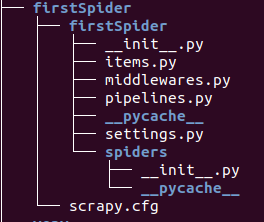

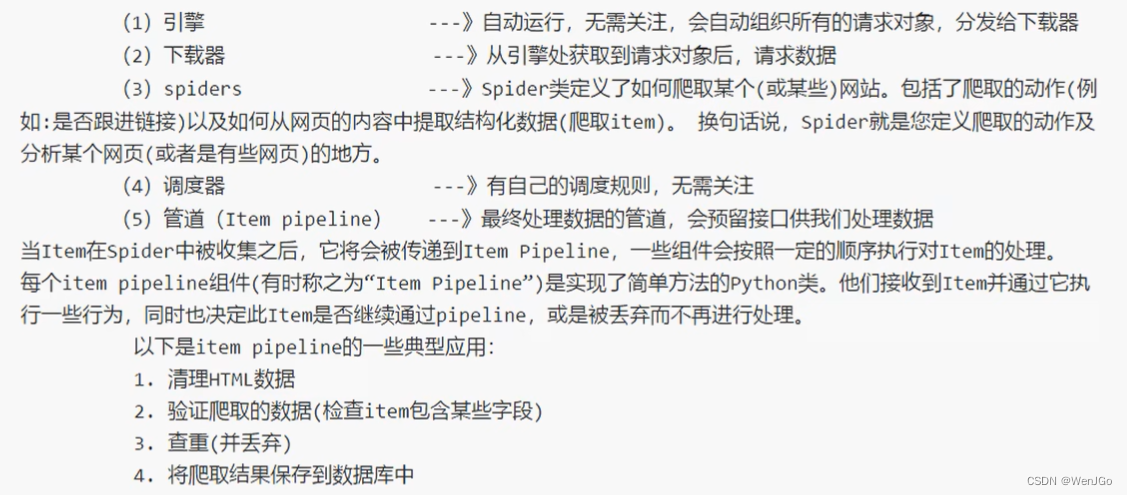

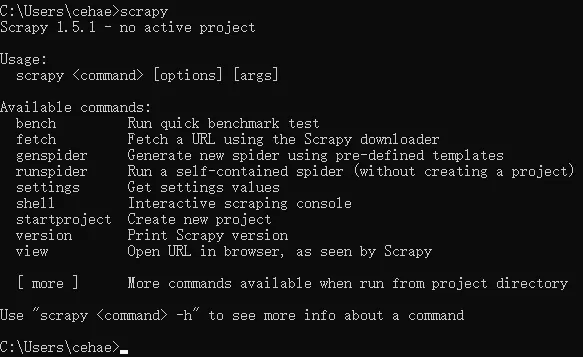

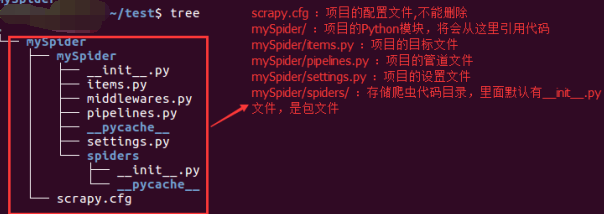

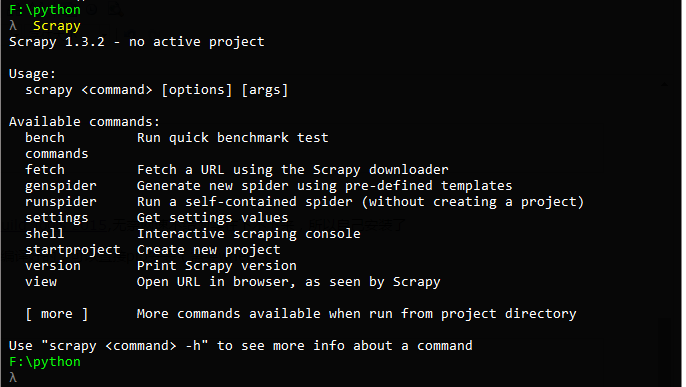

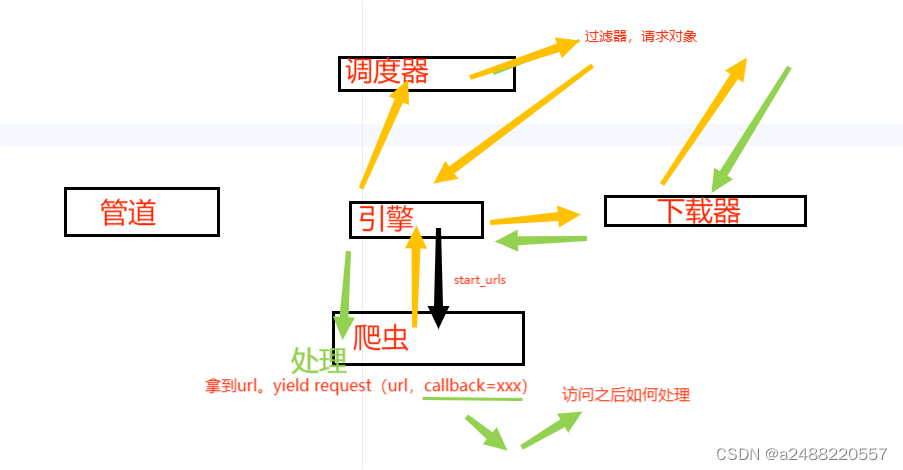

scrapy框架系列 (1) 初识scrapy

Scrapy 框架 Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛。 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各种图片,非常之方便。 Scra…

爬虫_房多多(设置随机数反爬)

本来想正面刚一下这个验证码的,但是一直post不上去,只好设置随机延迟,防止反爬 fangdd.py 1 import requests2 from lxml import etree3 import re4 from check_code import * #验证码处理模块5 from get_pinyin import * #汉子转拼音模…

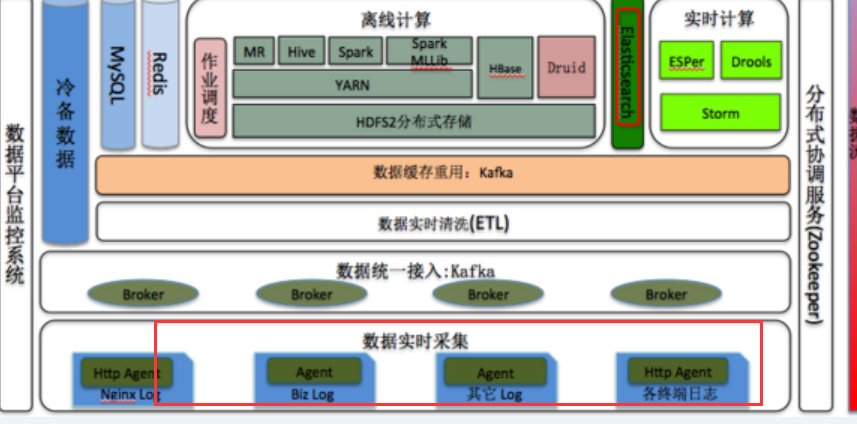

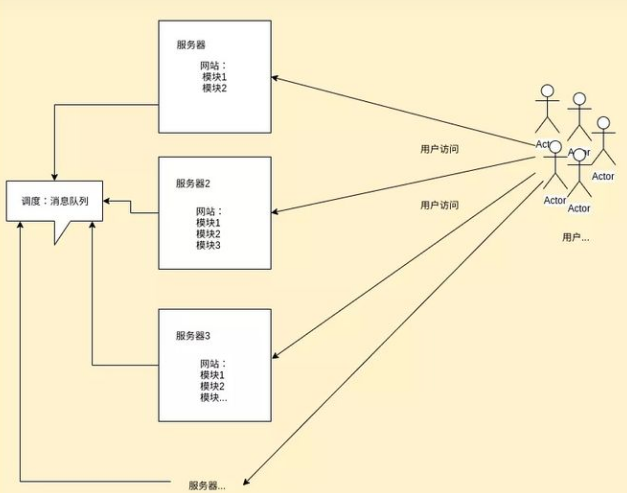

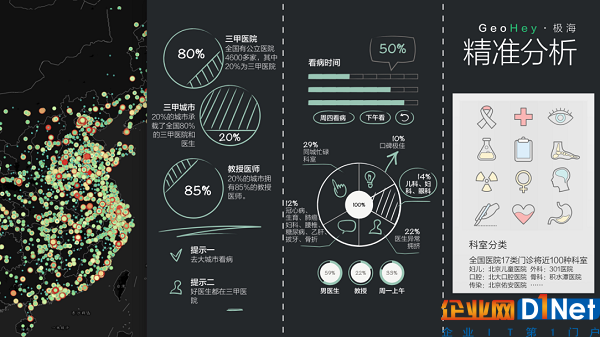

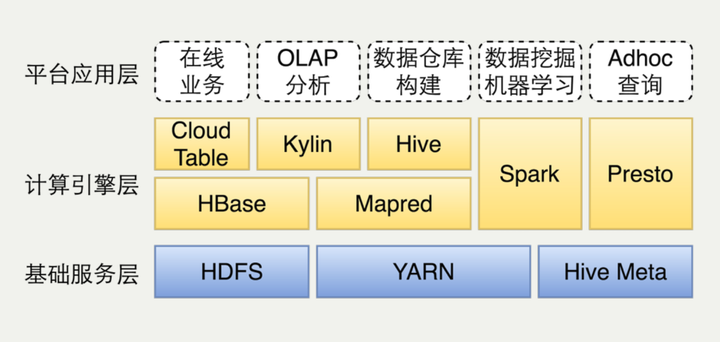

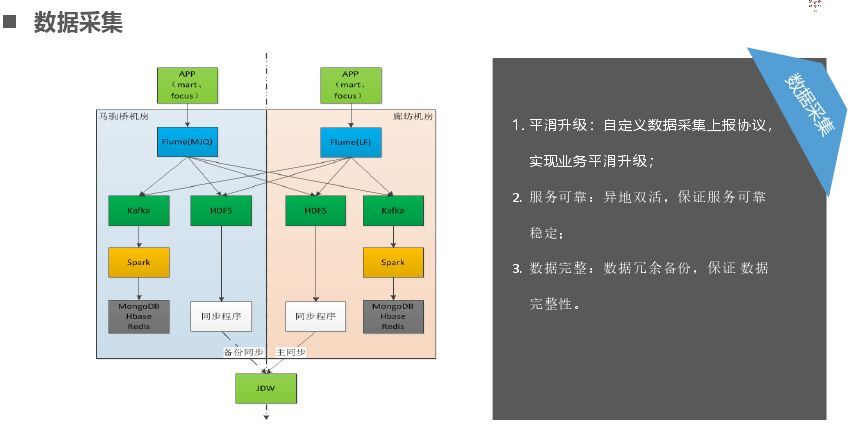

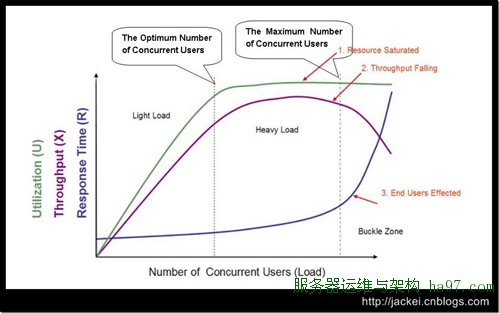

“互联网+”下的数据化运营和技术架构

数据是企业的重要投资,如何利用数据是每个企业必须面临的课题。大数据的浪潮已经席卷全球,企业已经普遍地意识到,粗放式管理必死,数据化才能永恒。这在互联网电商领域更是尤为凸显。 对于走在大数据浪端的互联网企业,关…

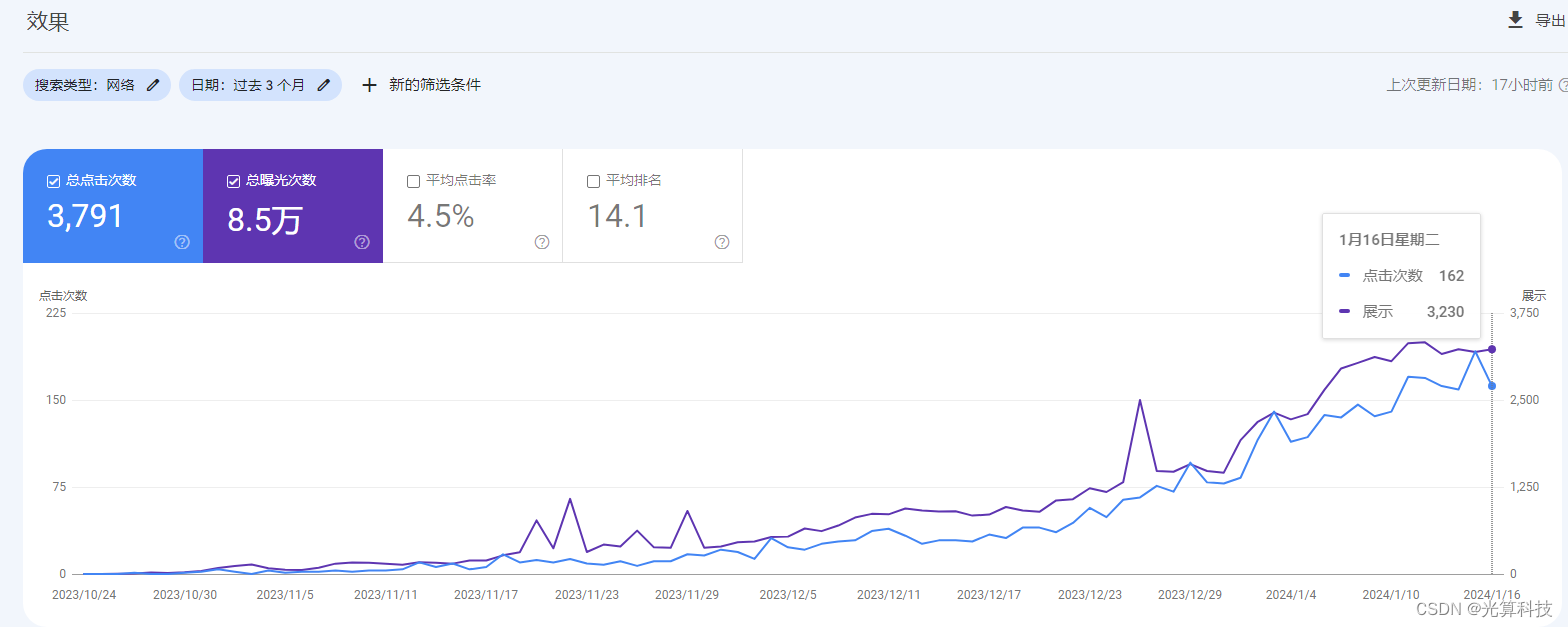

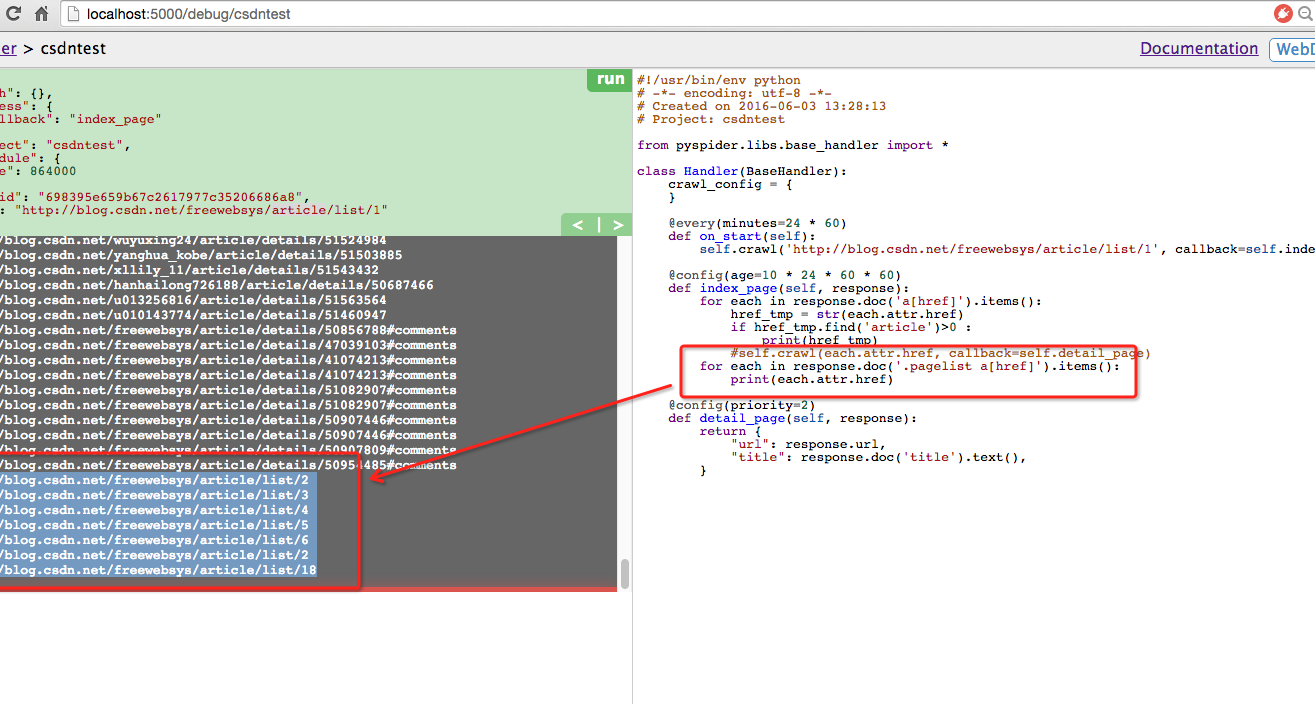

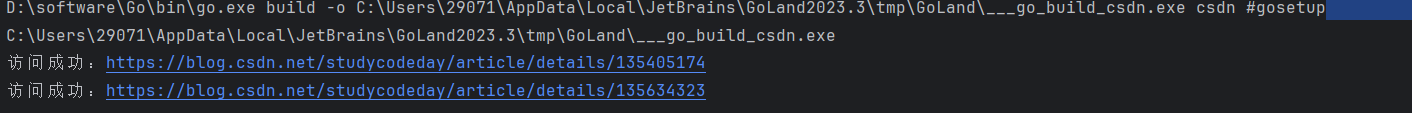

利用爬虫刷CSDN博客访问量

利用爬虫刷CSDN博客访问量

据我观察,CSDN博客并没有反爬虫的机制,因此,我们可以利用爬虫来增加自己的博文阅读量,但是需要让我们的爬虫“友好”一些,因为CSDN还是有设置两次访问的最短时间间隔的,因此&…

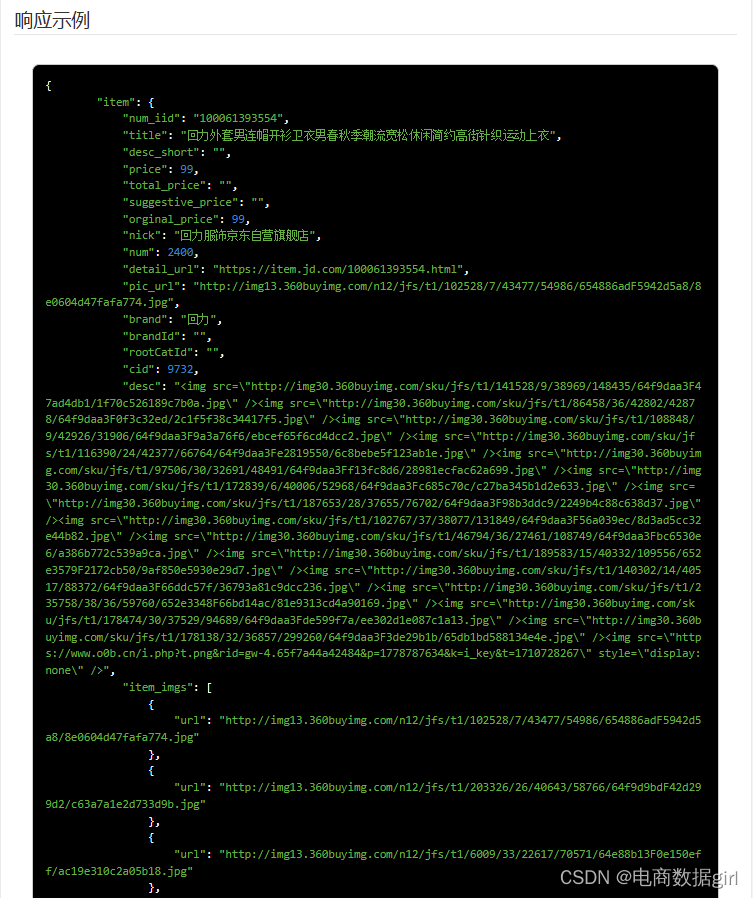

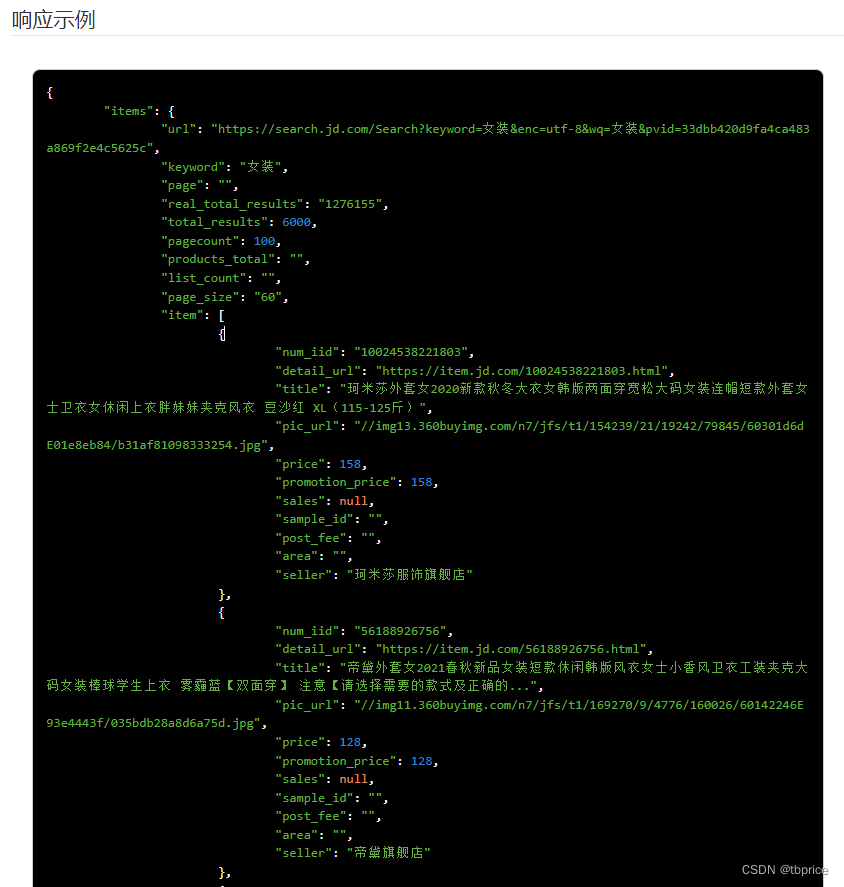

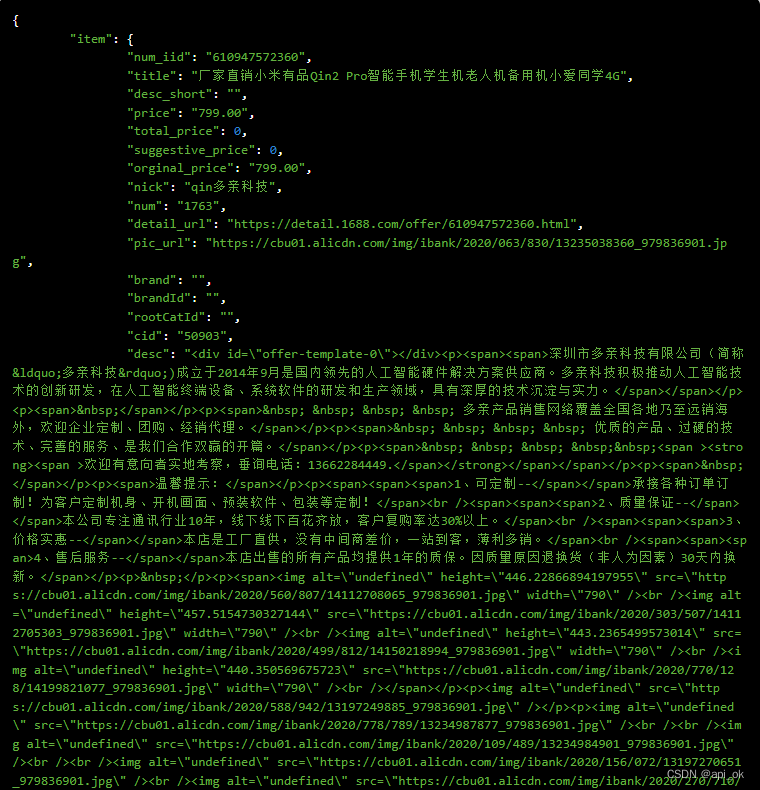

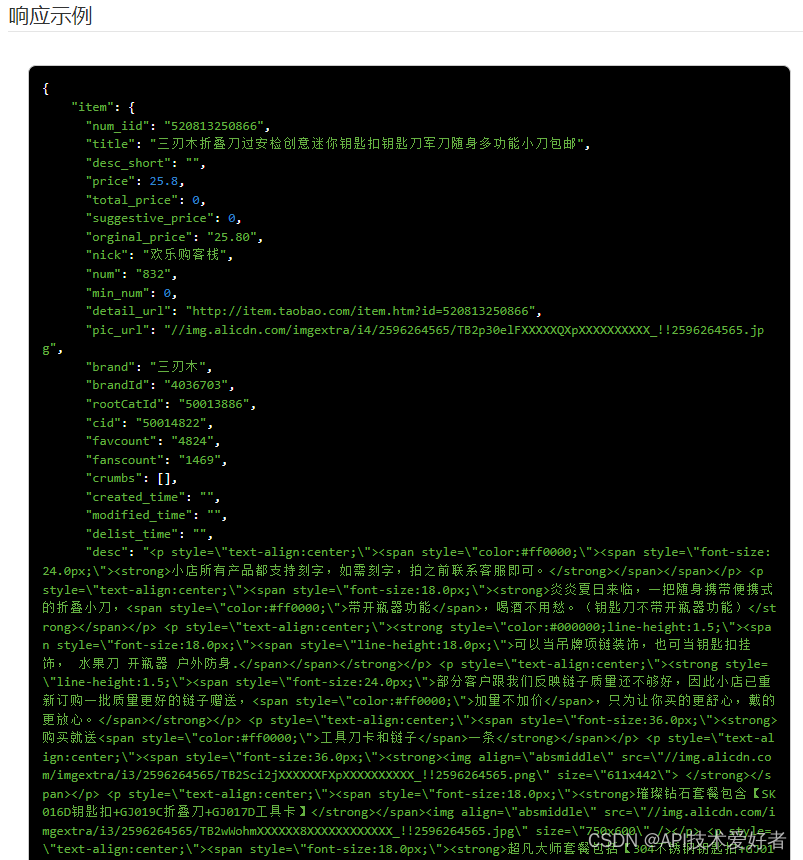

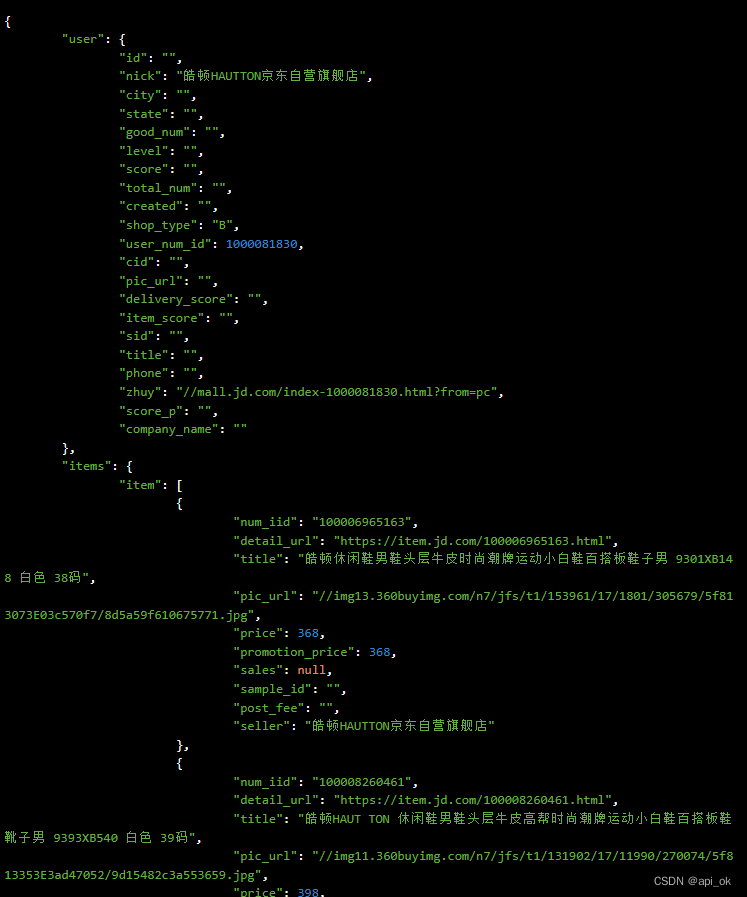

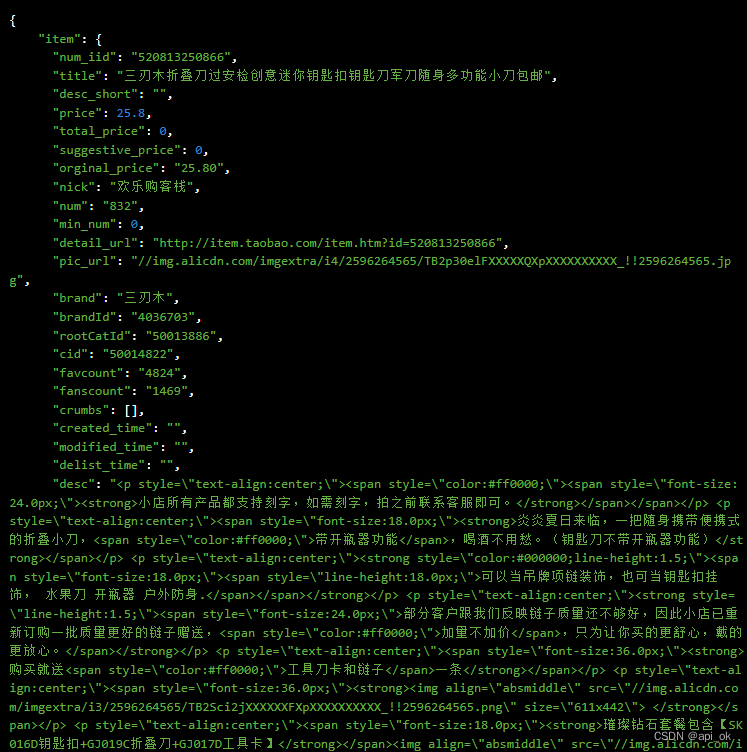

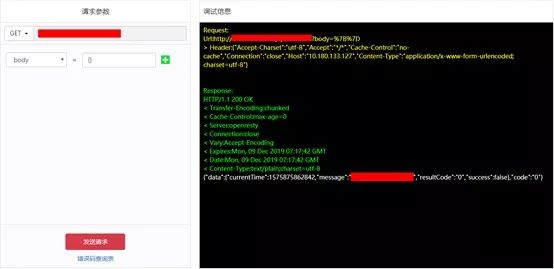

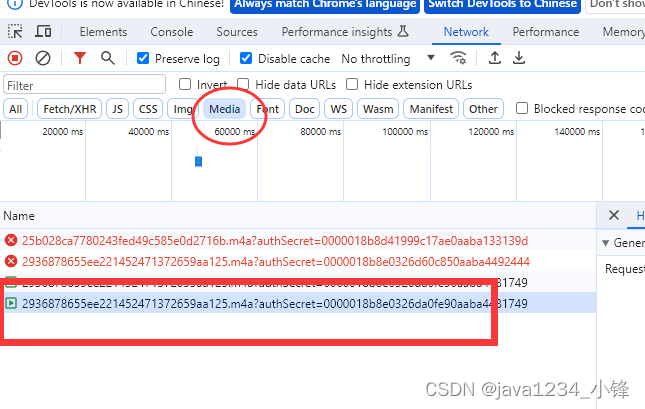

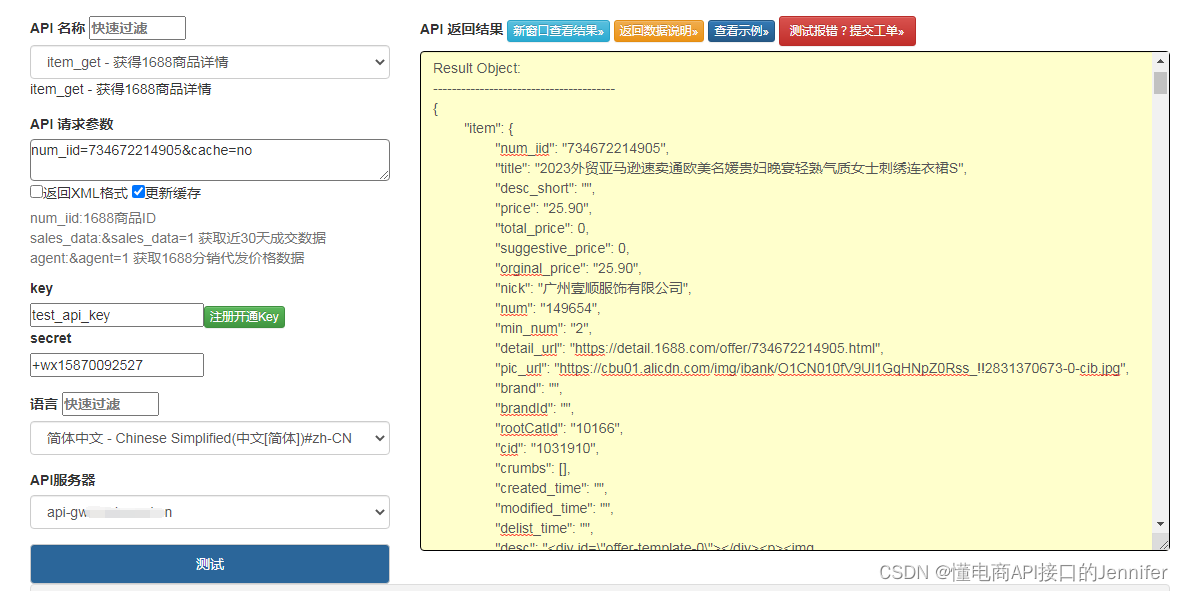

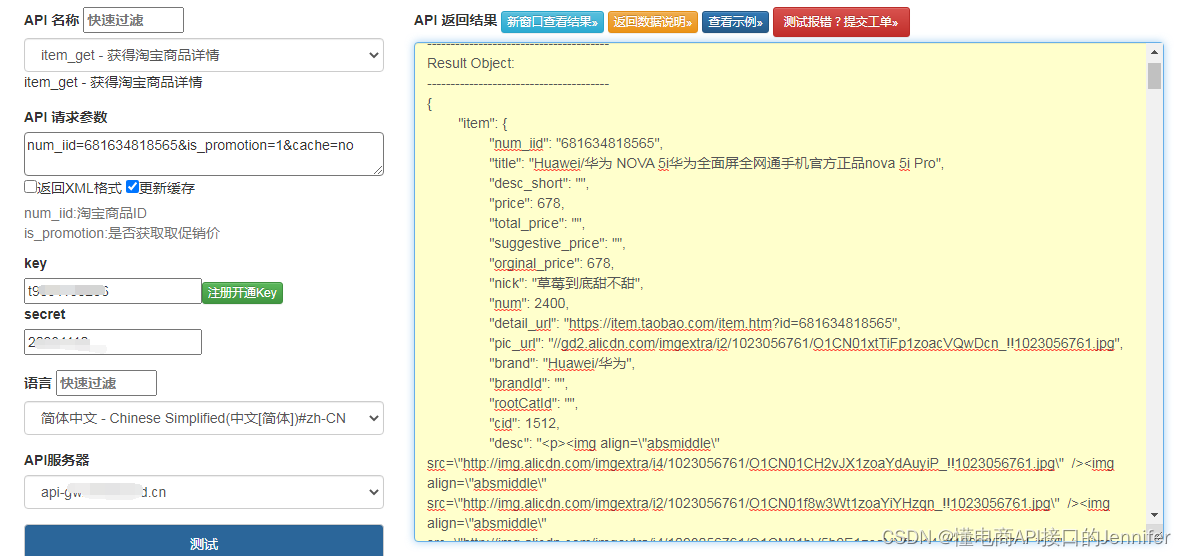

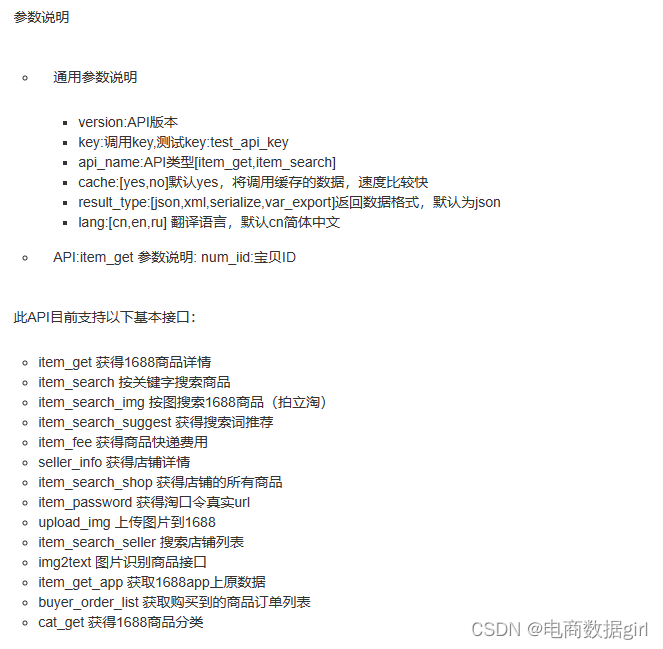

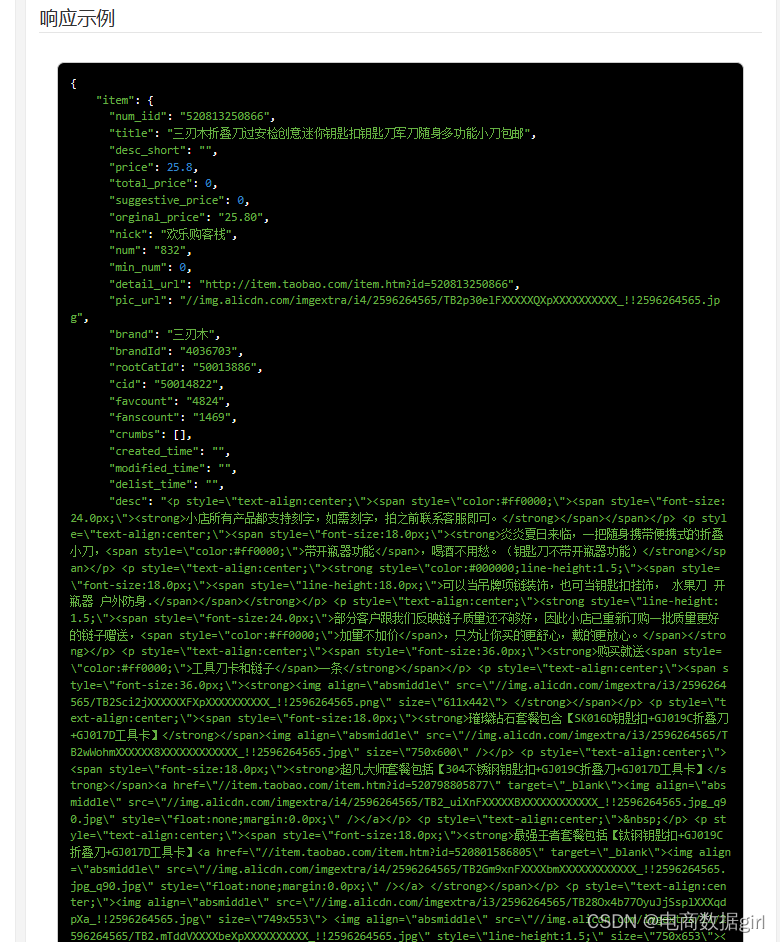

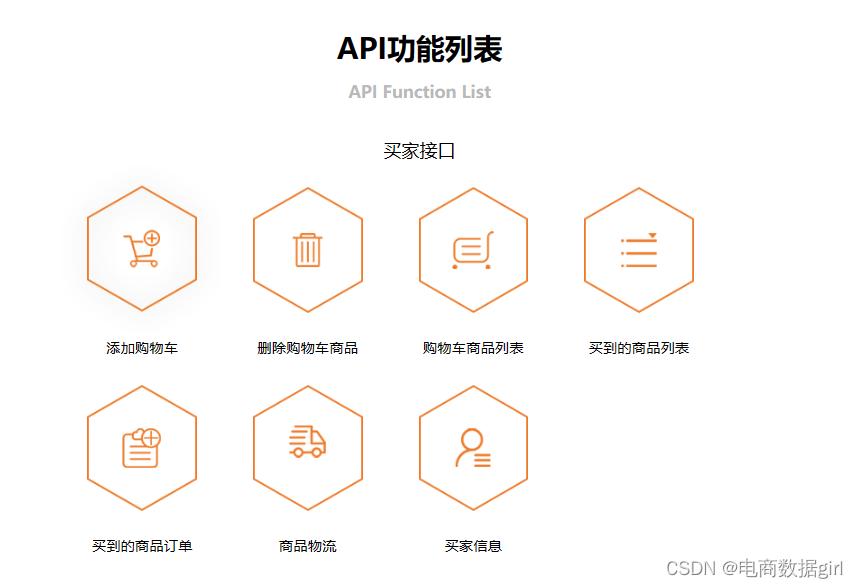

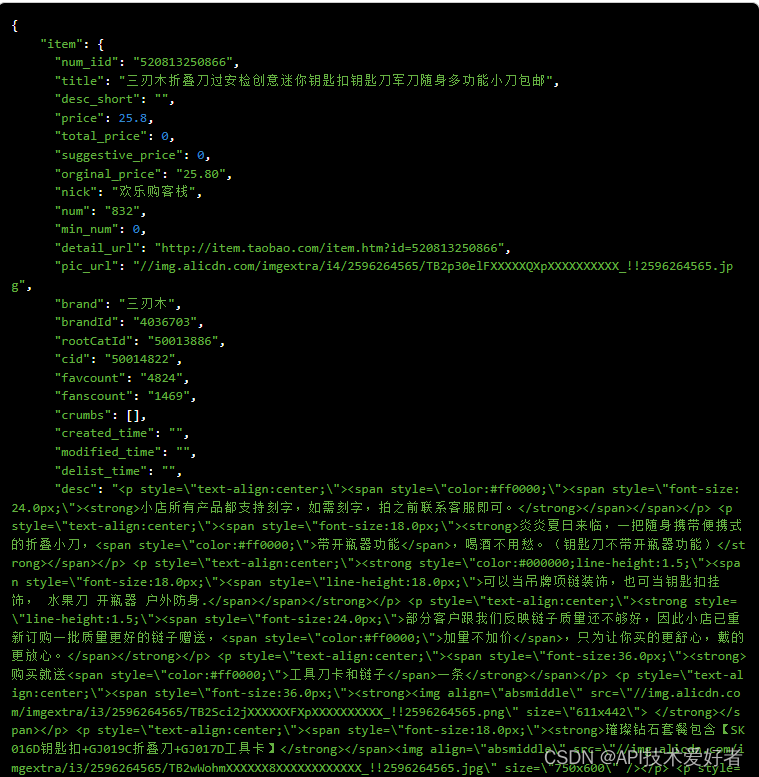

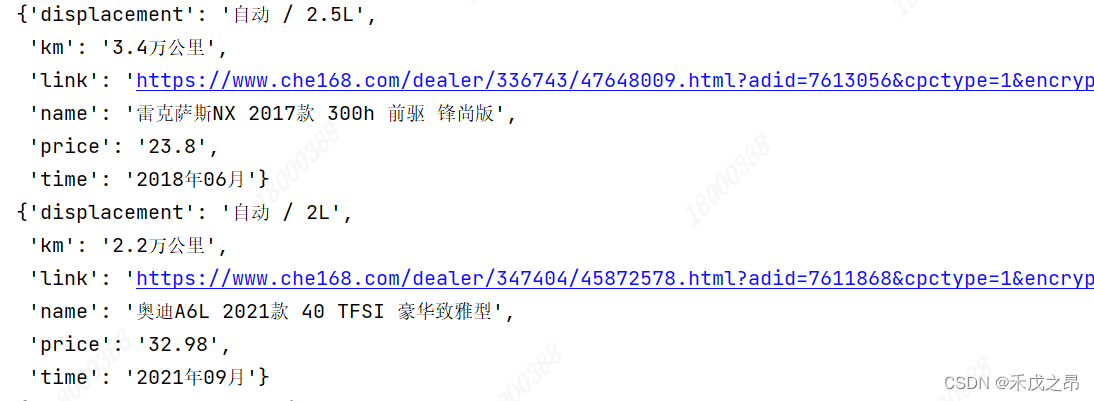

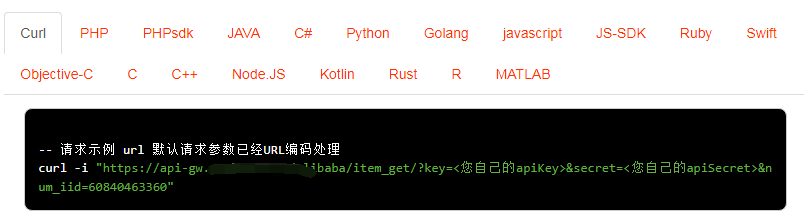

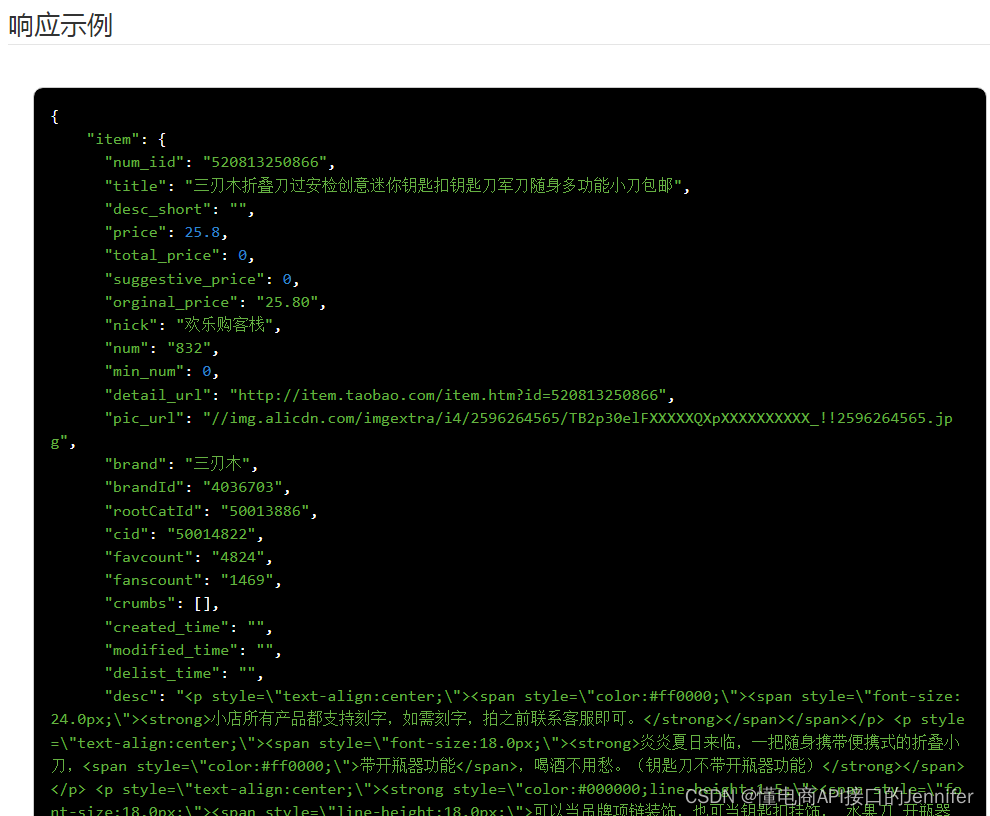

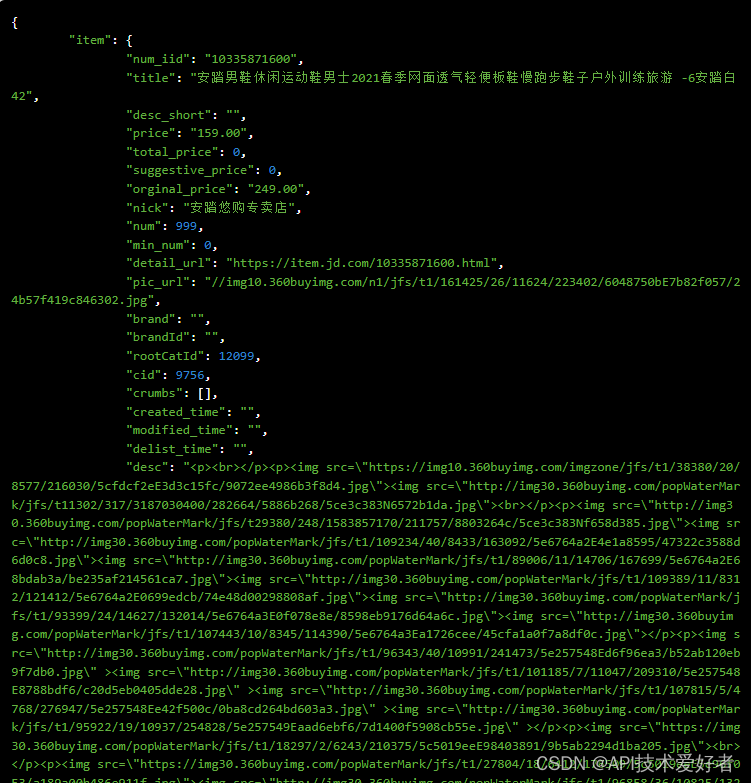

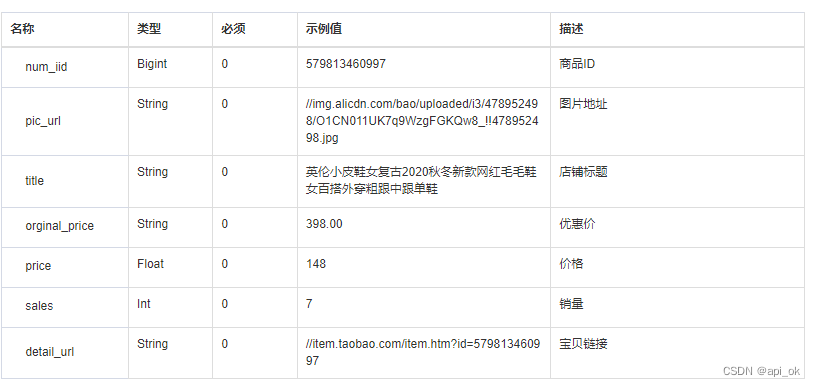

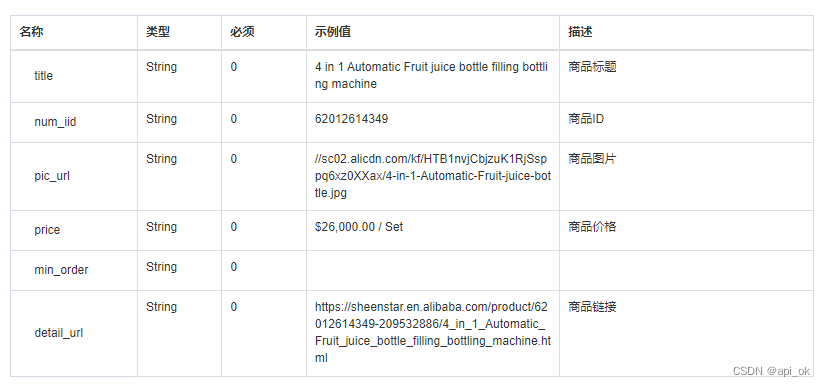

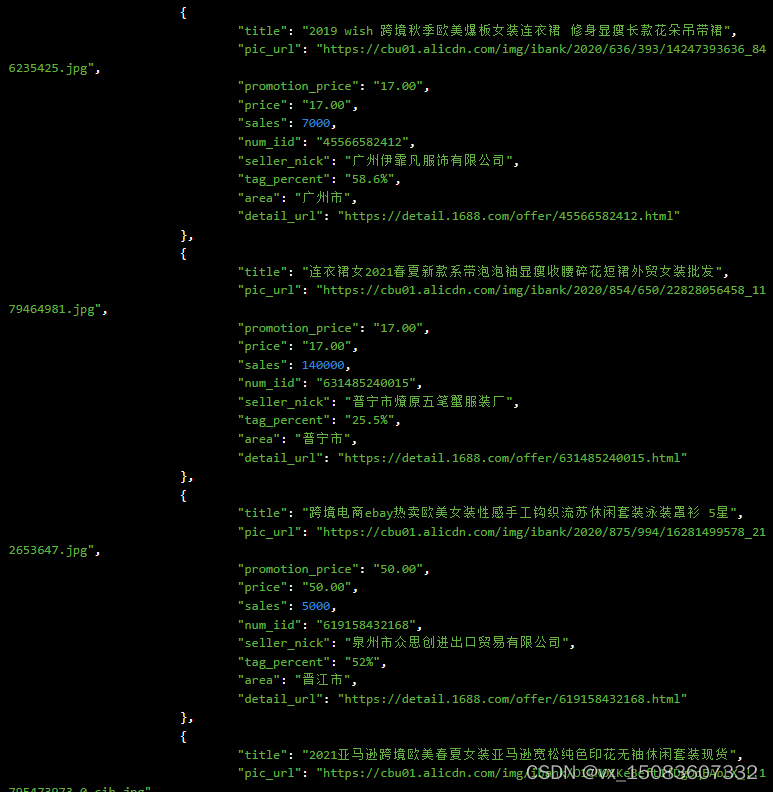

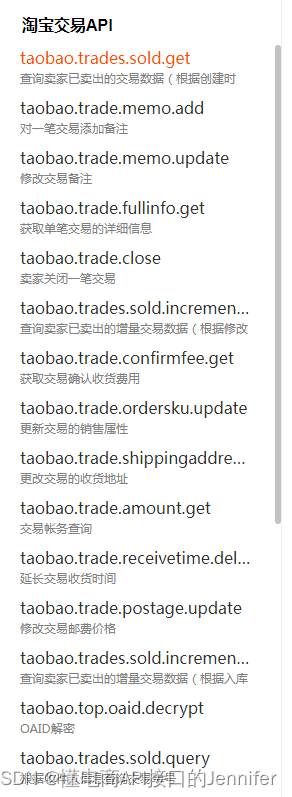

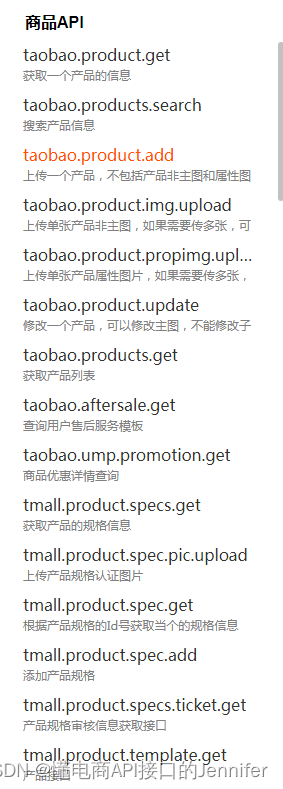

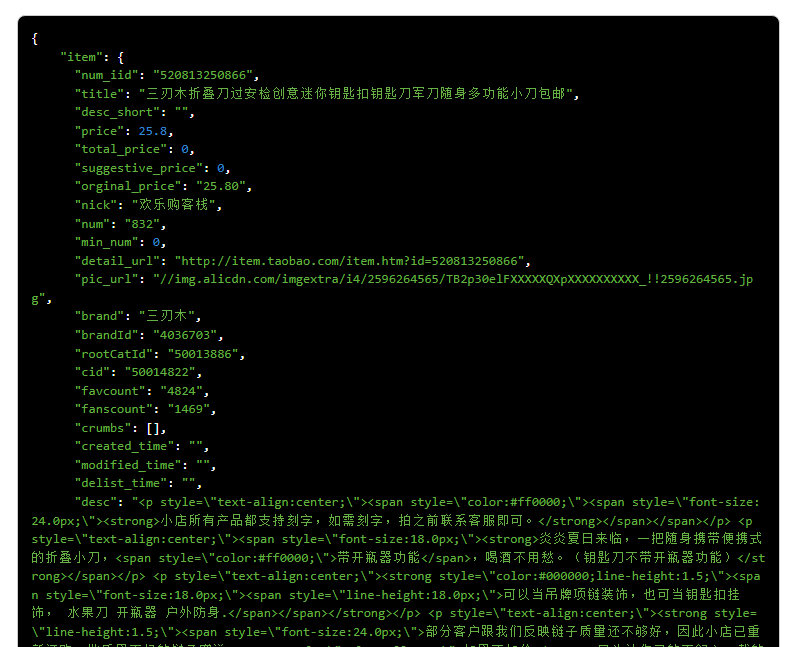

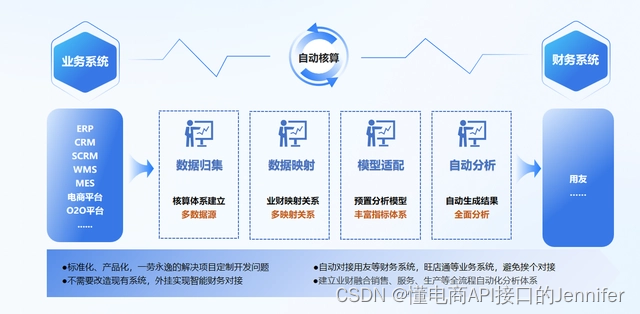

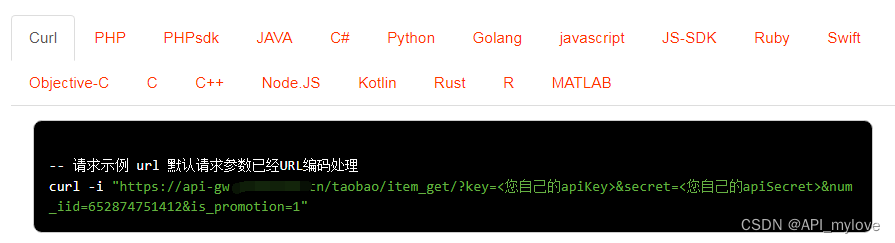

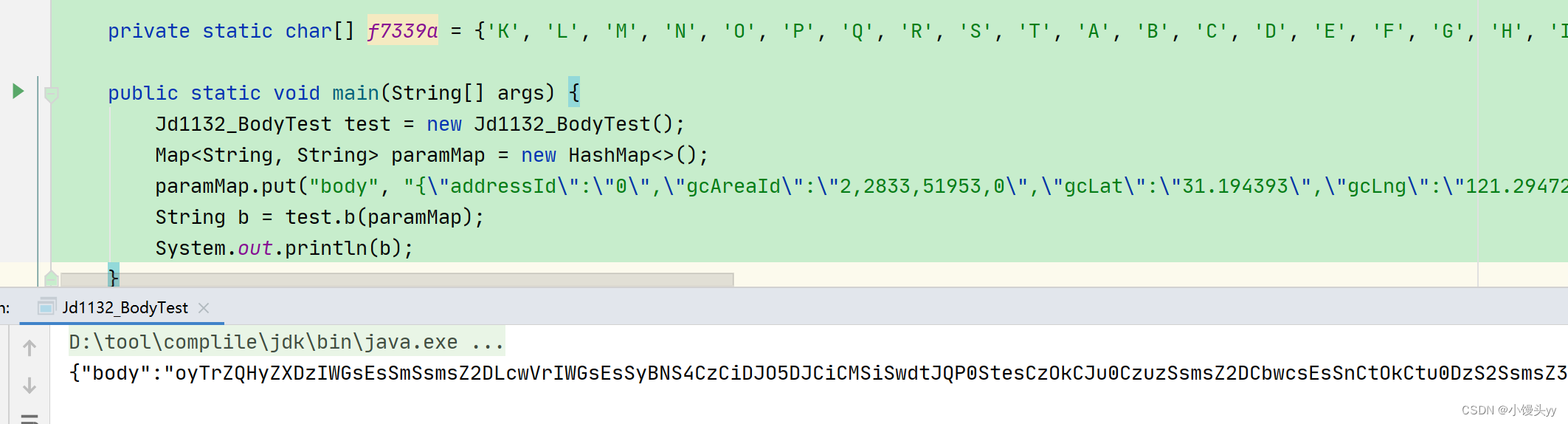

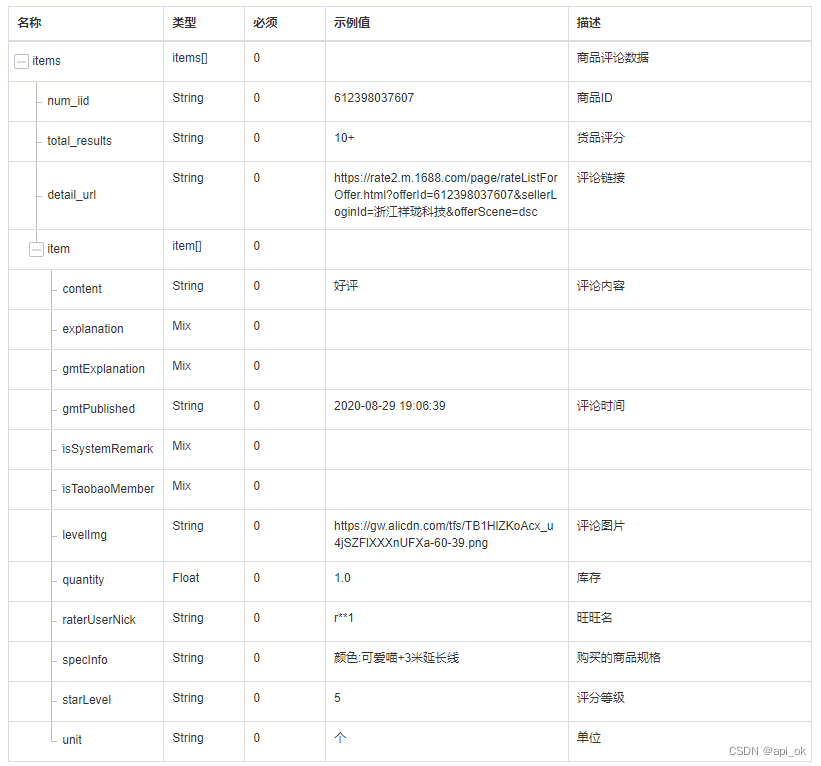

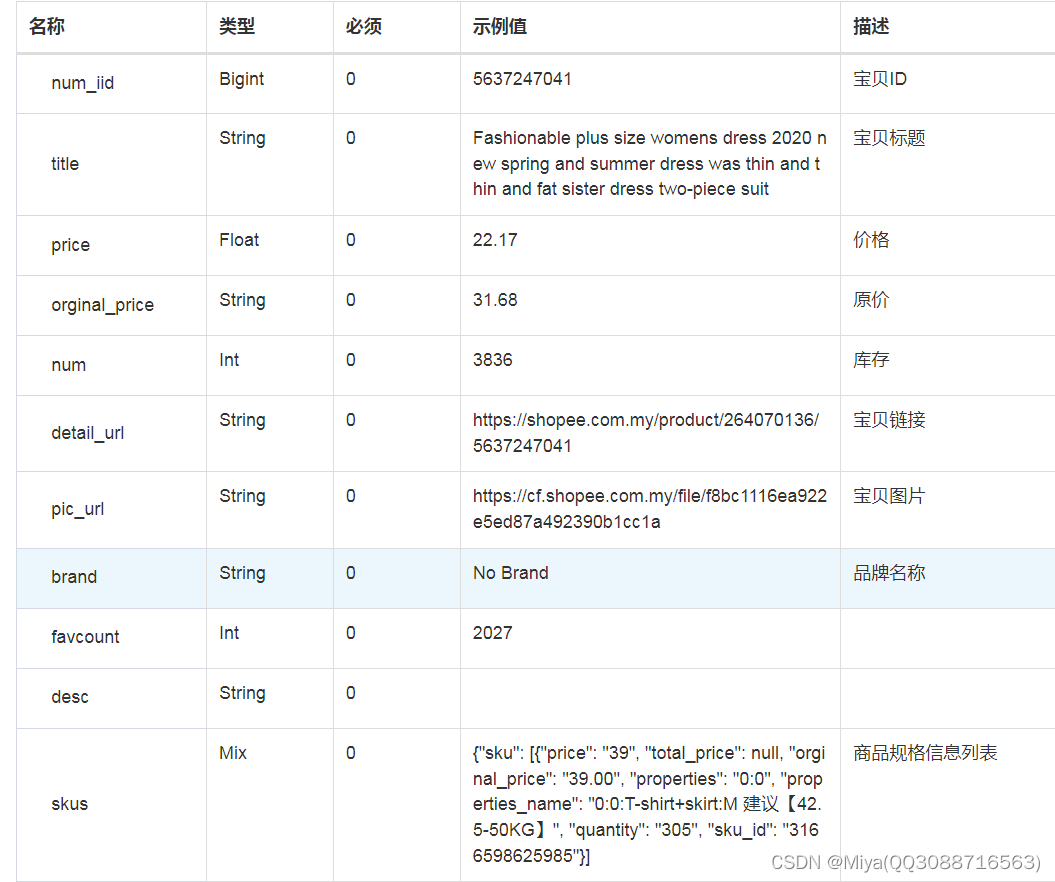

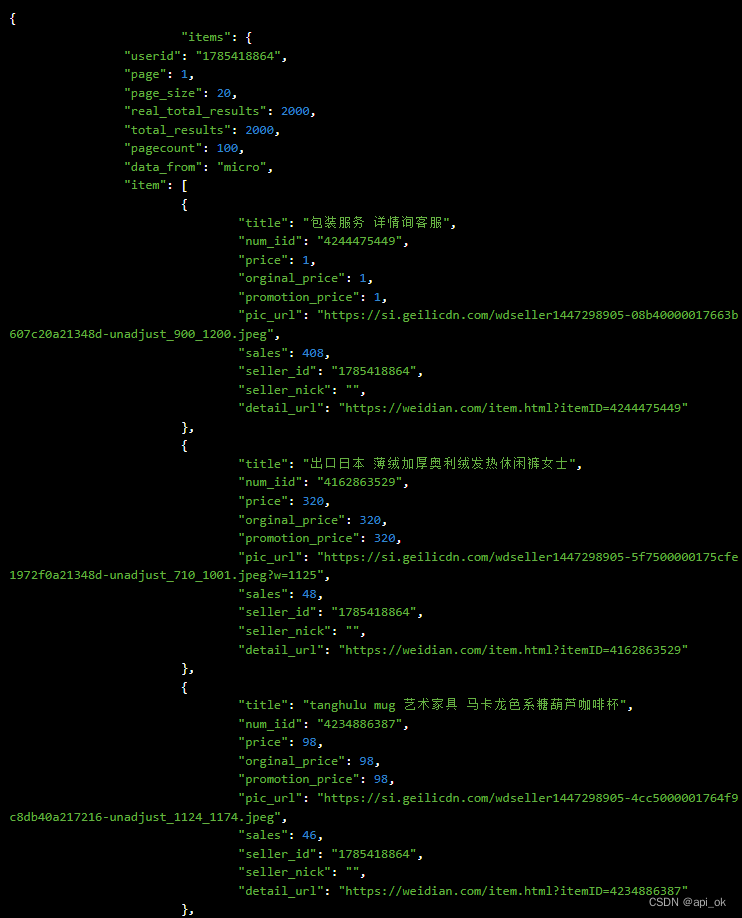

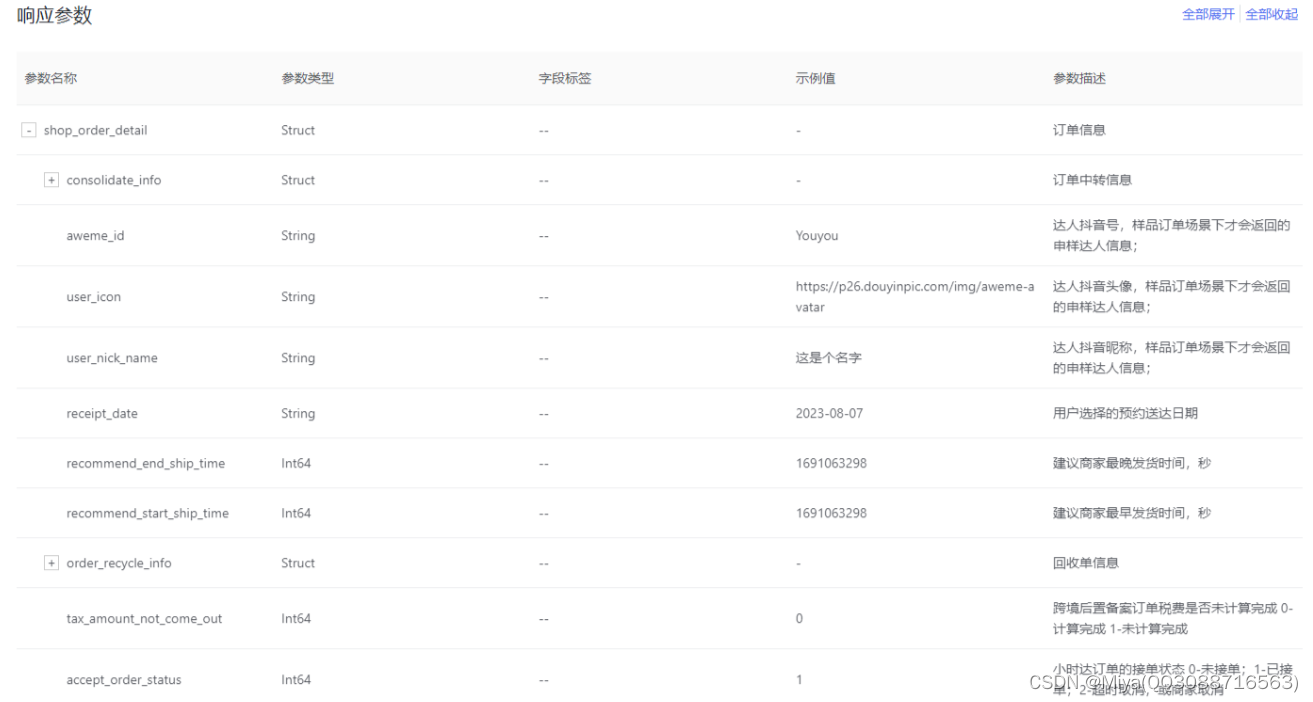

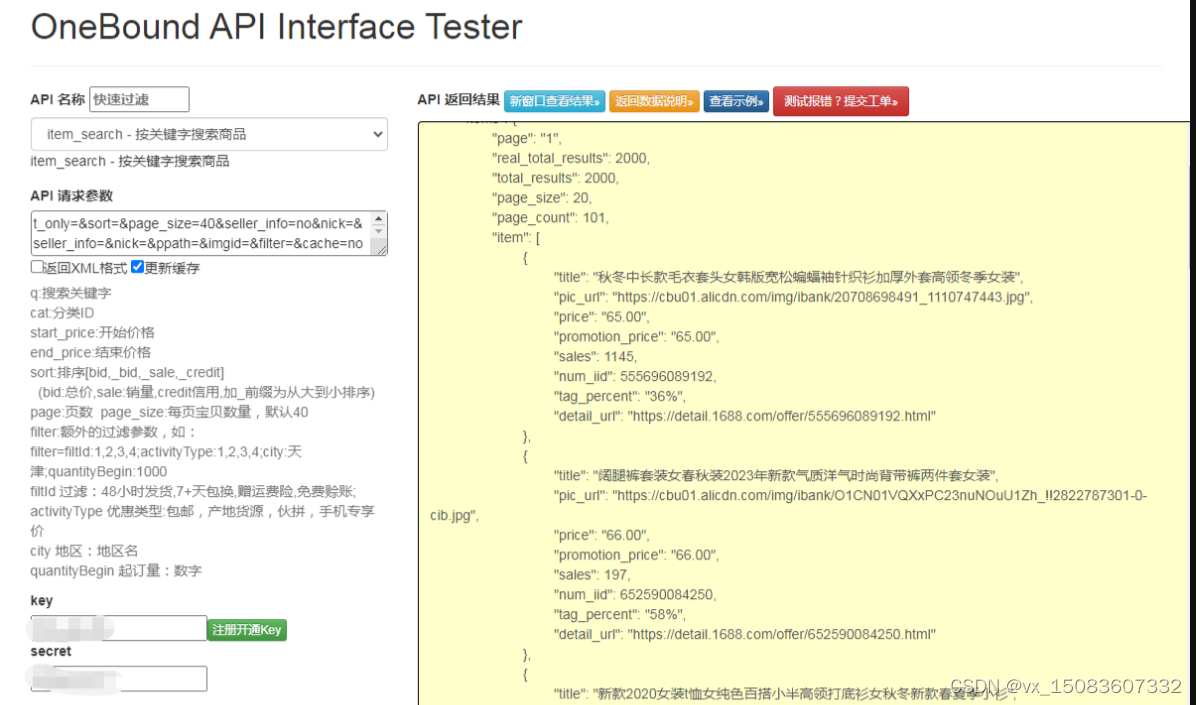

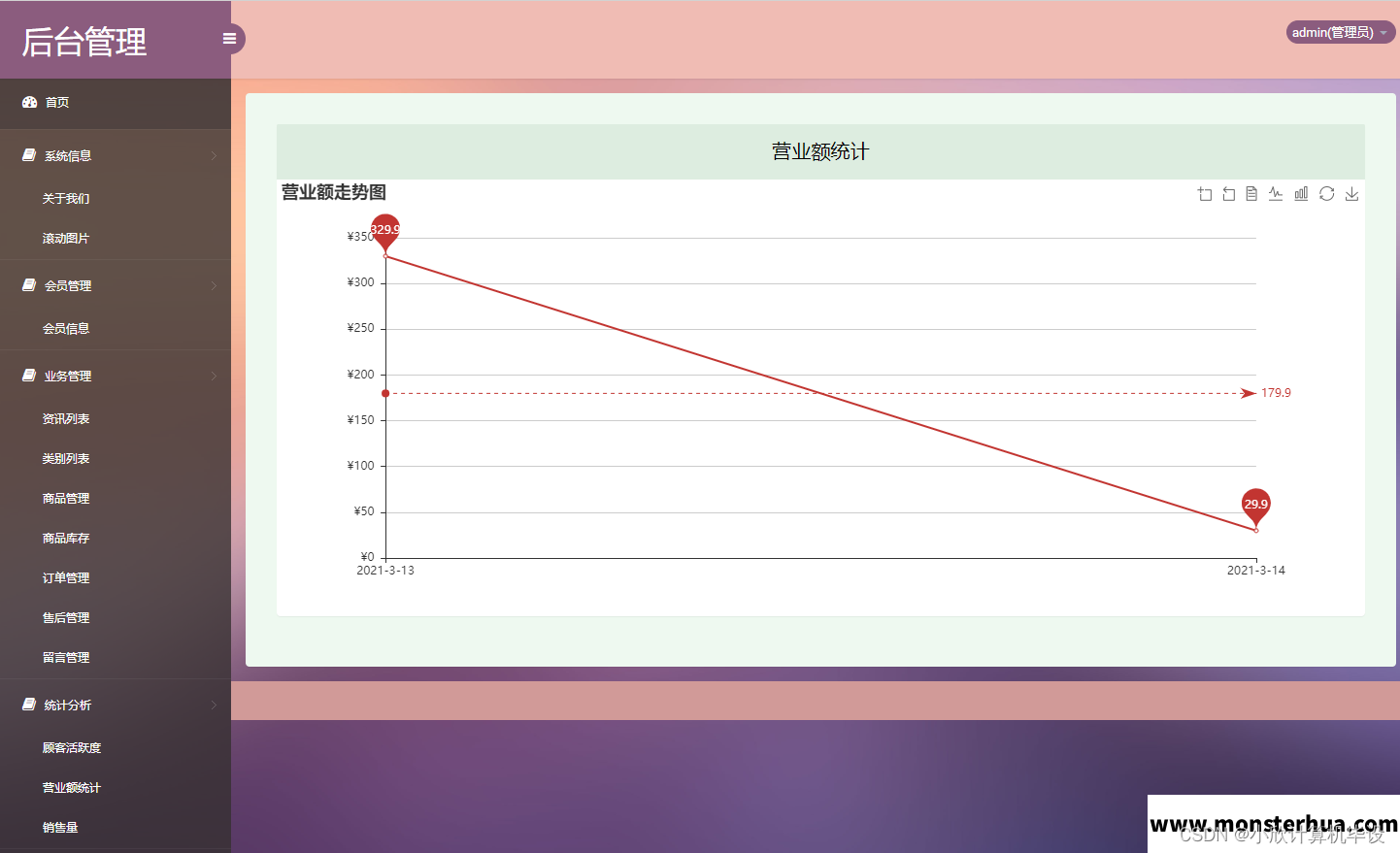

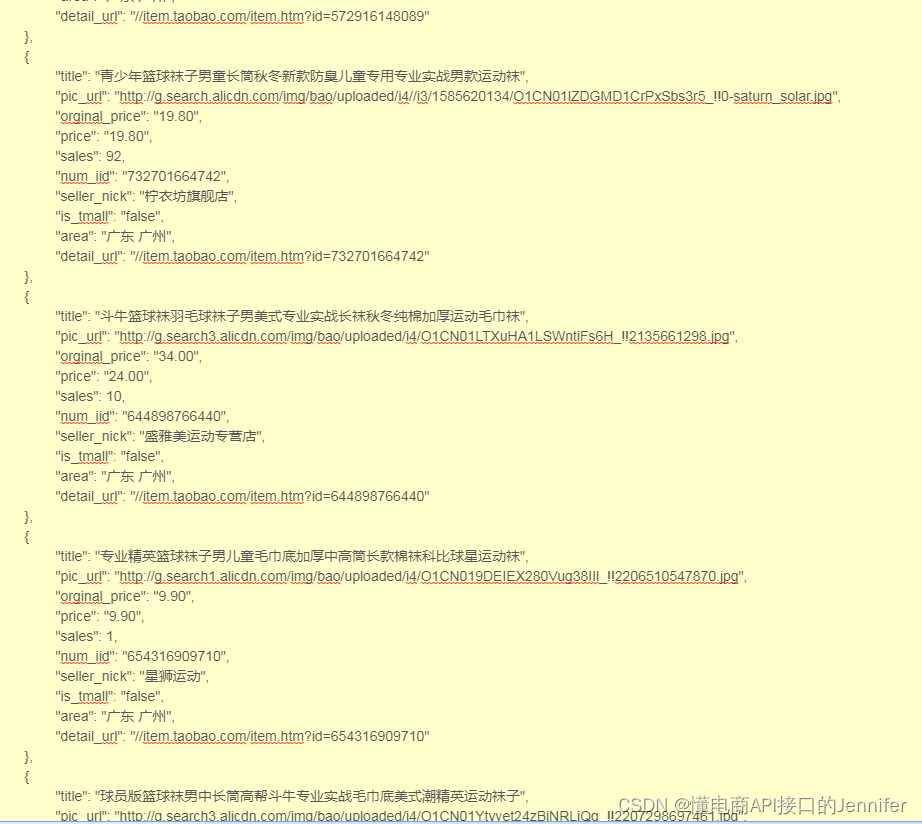

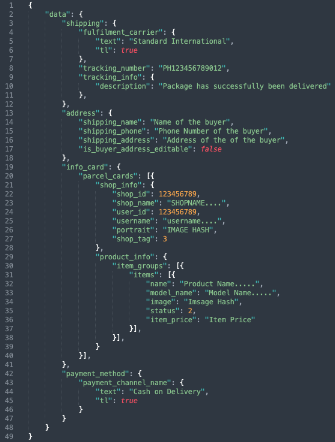

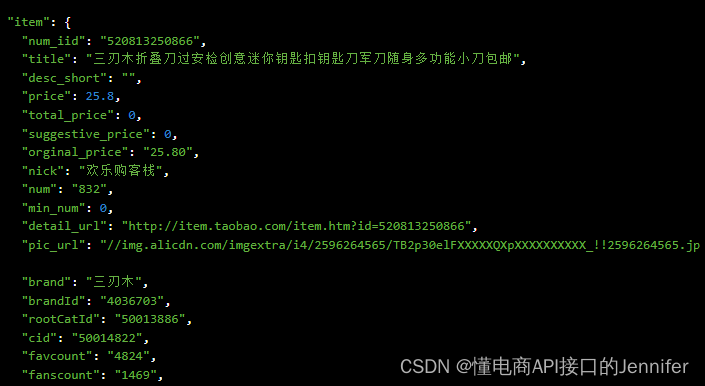

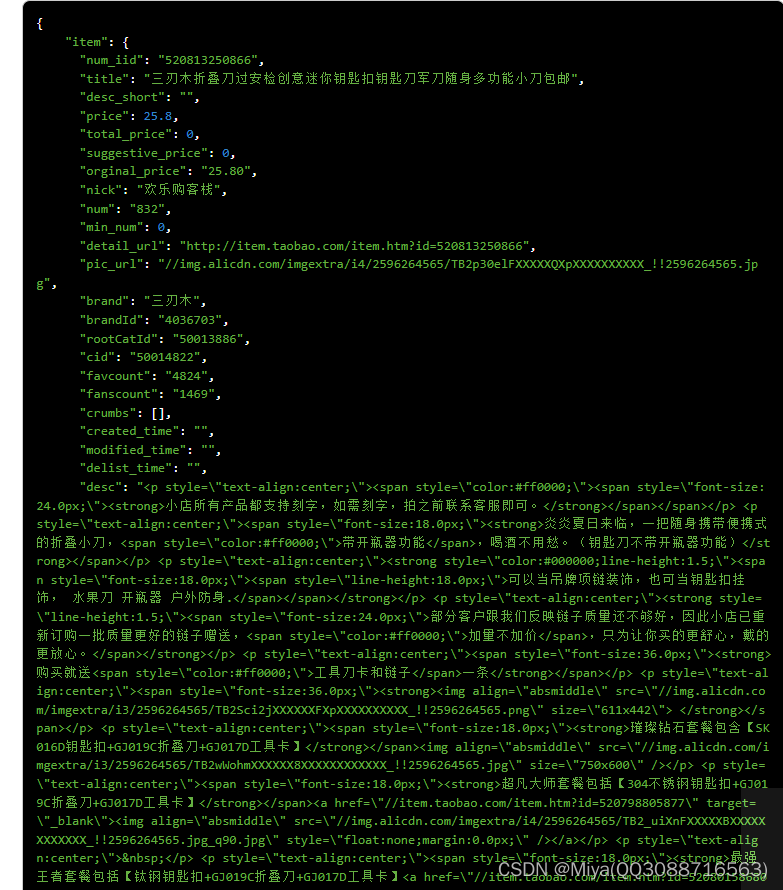

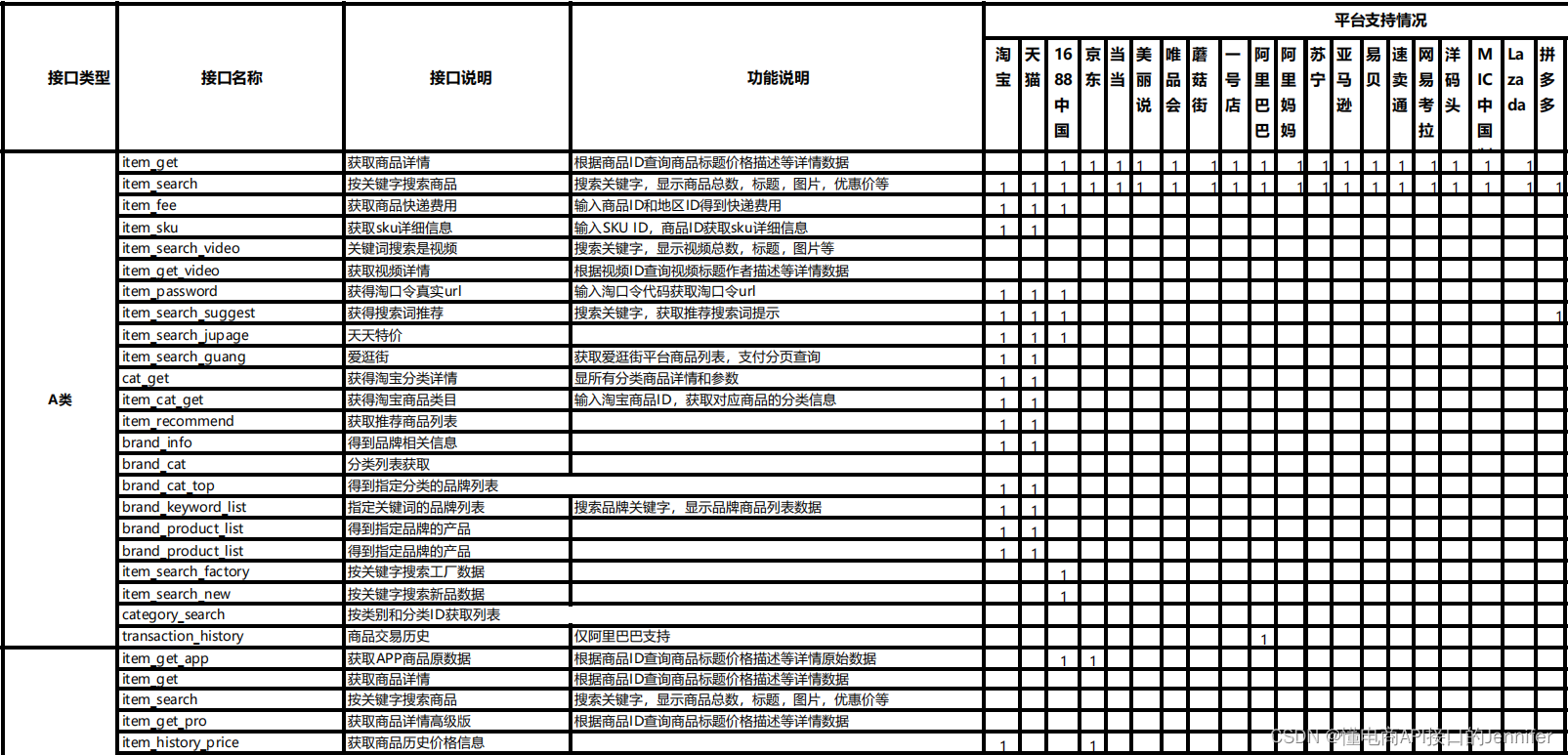

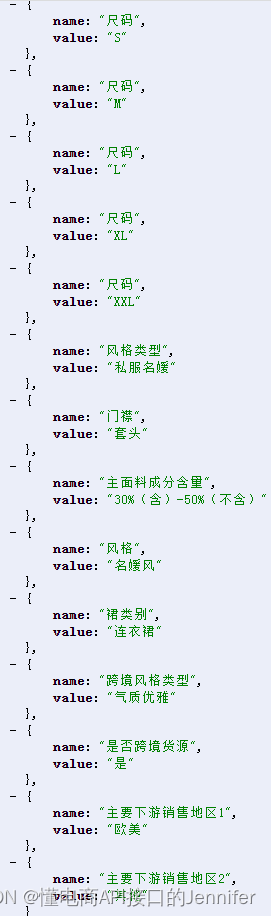

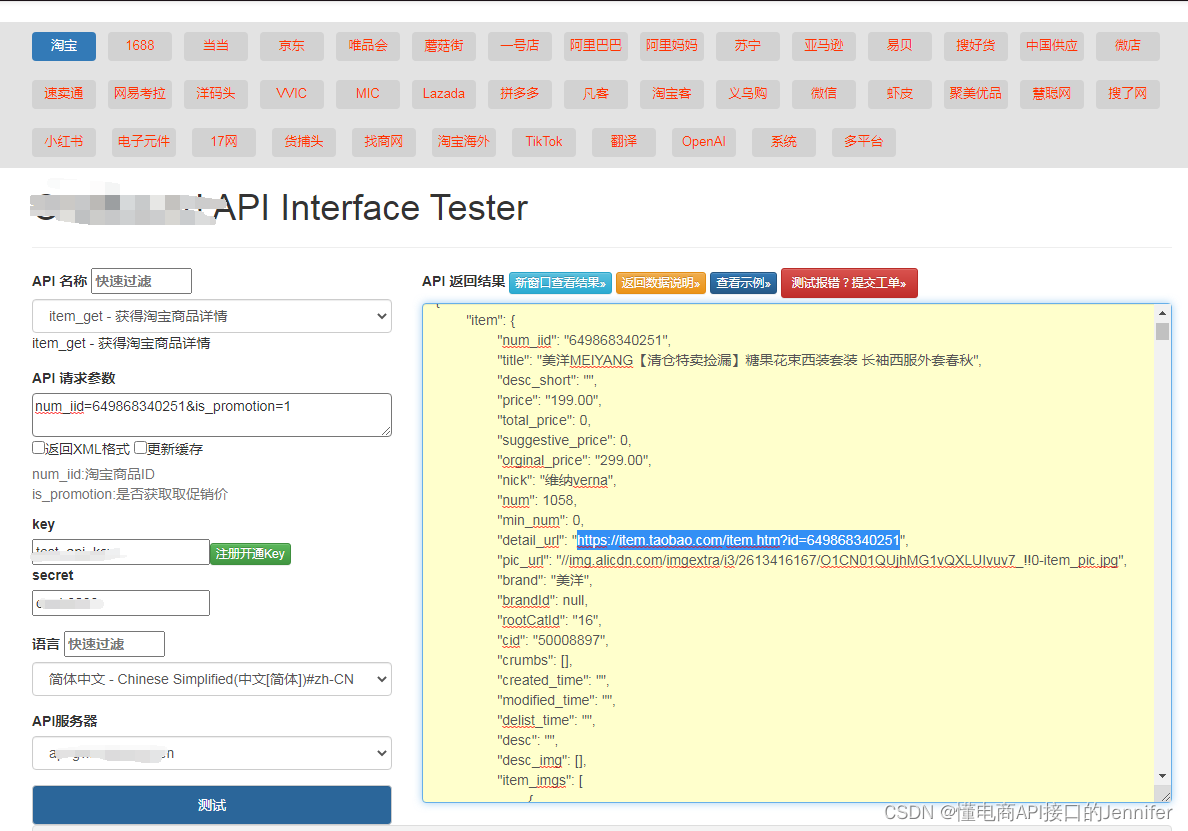

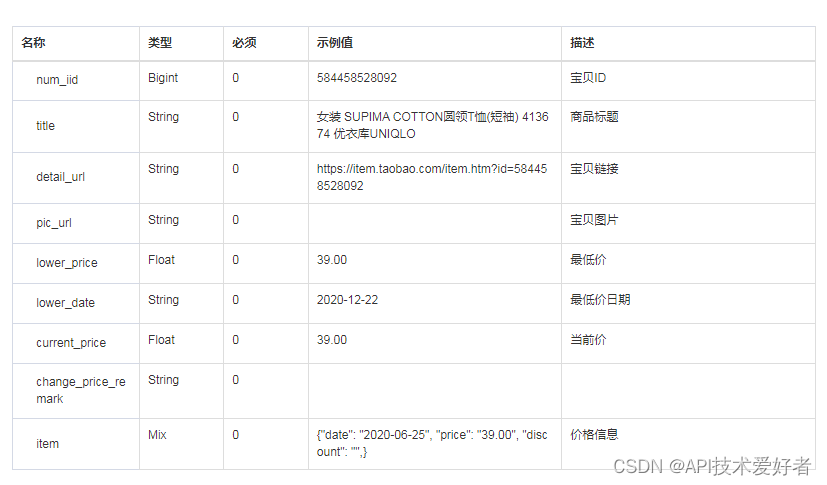

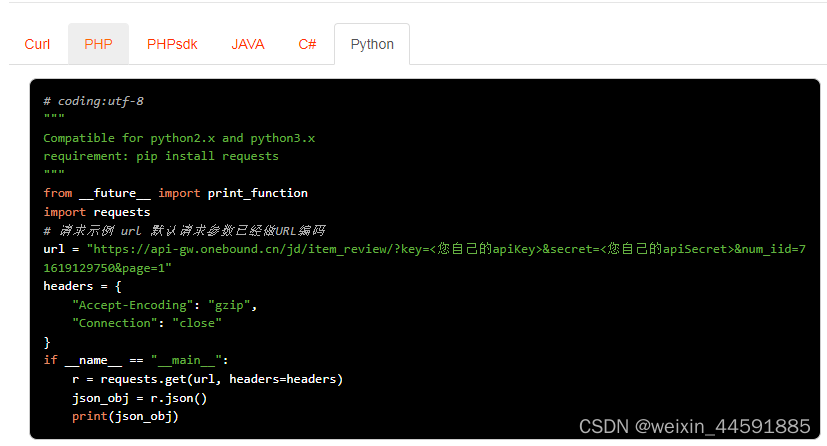

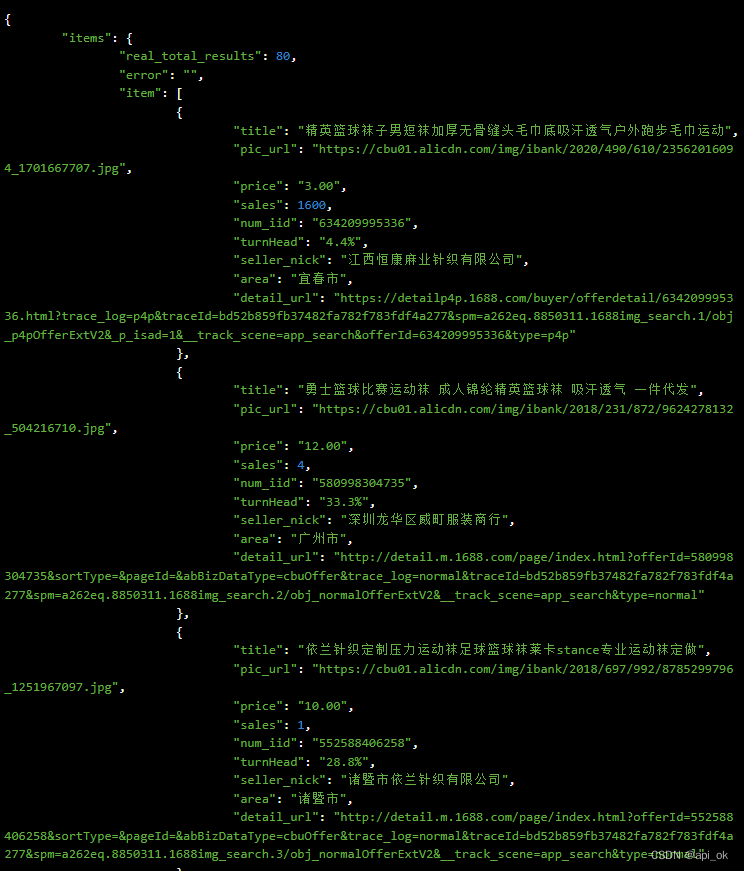

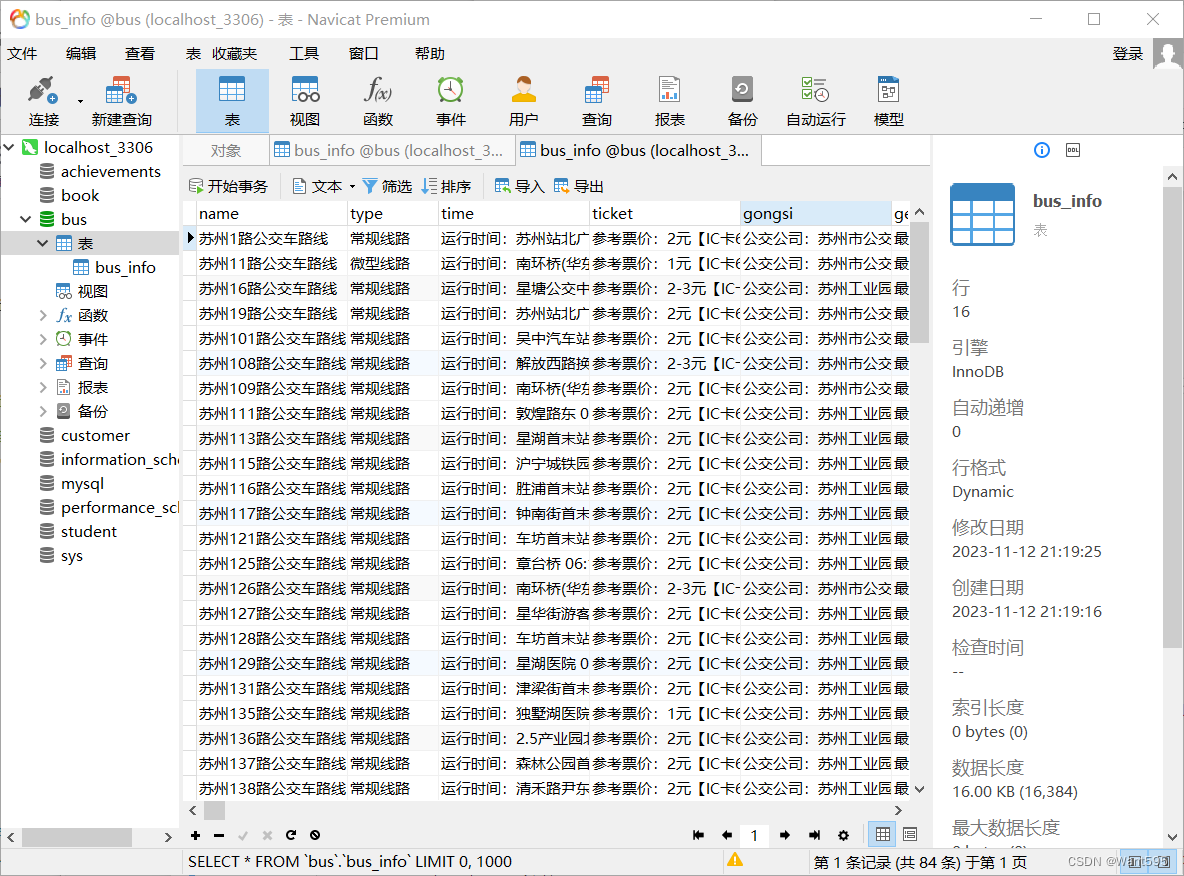

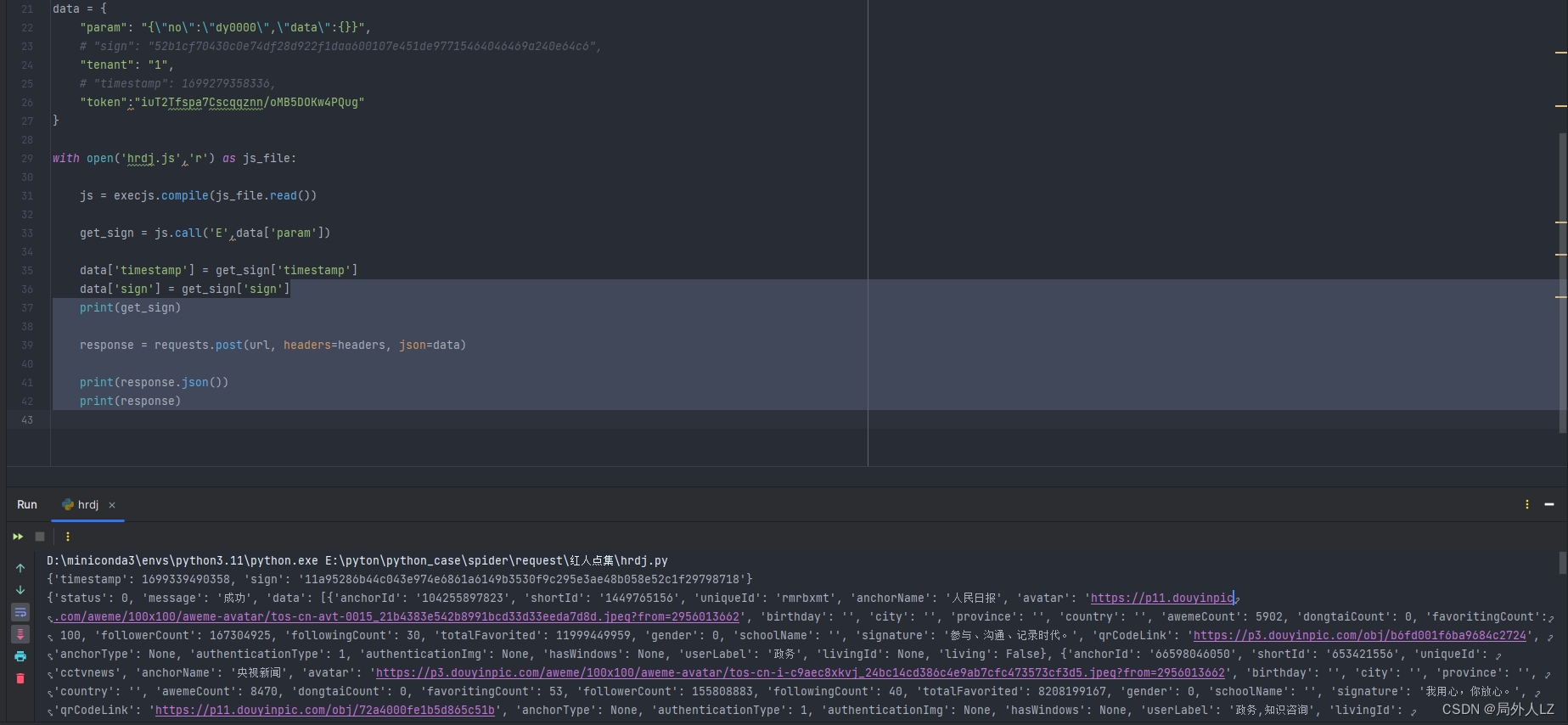

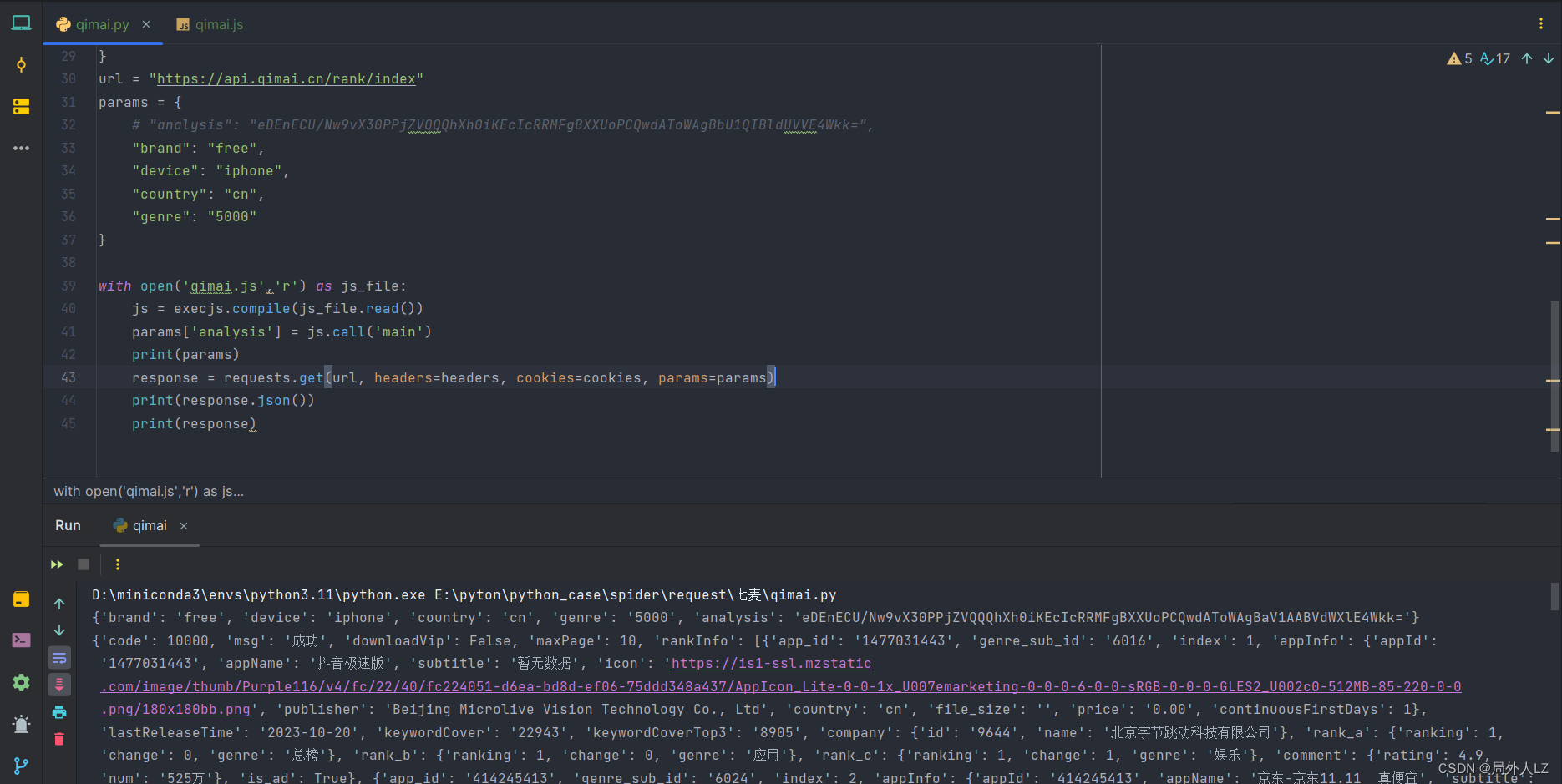

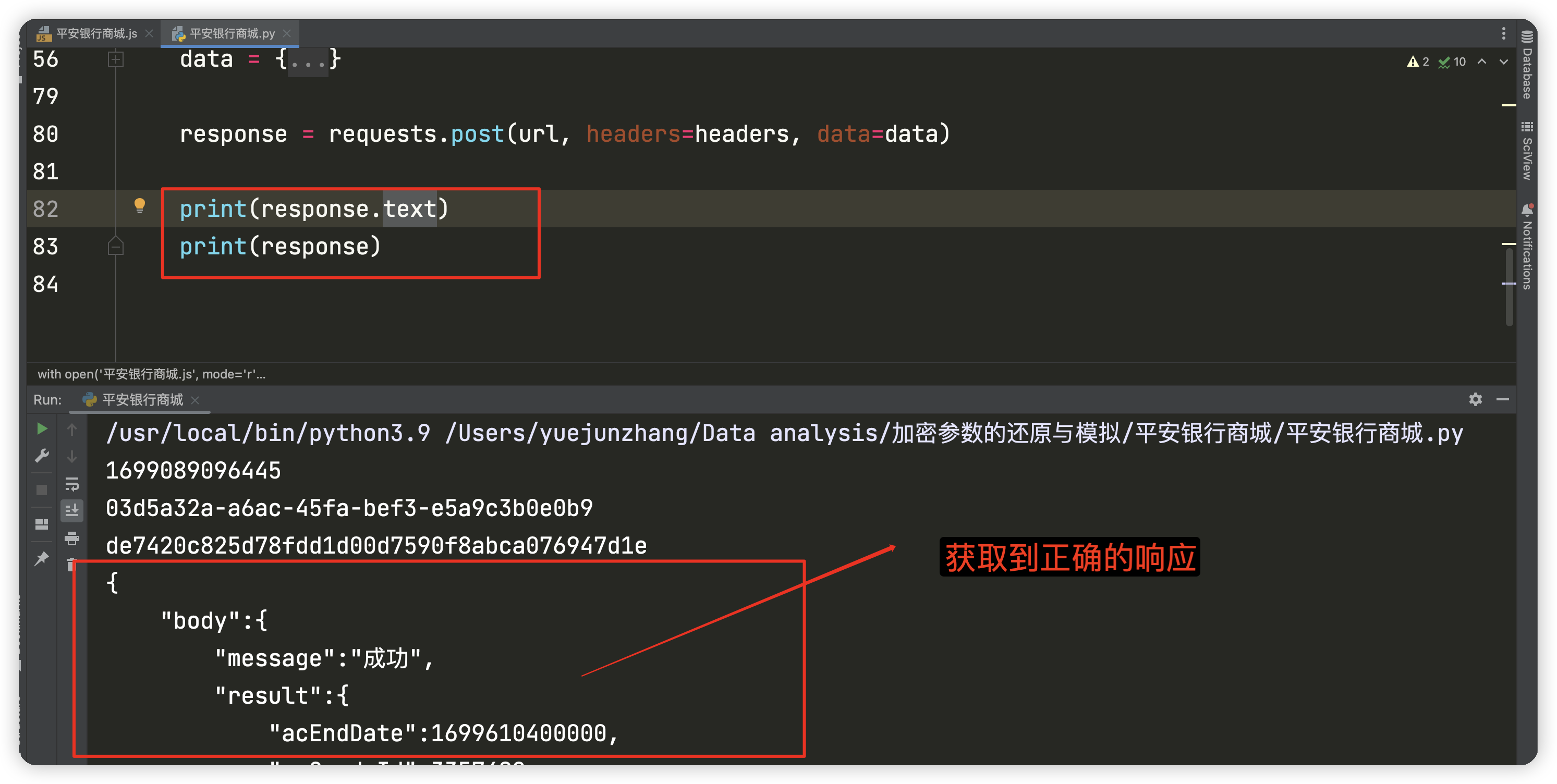

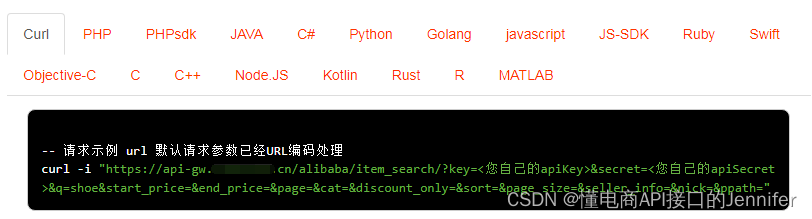

电商API接口-电商OMS不可或缺的一块 调用代码展示

电商后台管理系统关键的一环就是实现电商平台数据的抓取,以及上下架商品、订单修改等功能的调用。这里就需要调用电商API接口。接入电商API接口后再根据自我的需求进行功能再开发,实现业务上的数字化管理。其中订单管理模板上需要用到如下API:seller_ord…

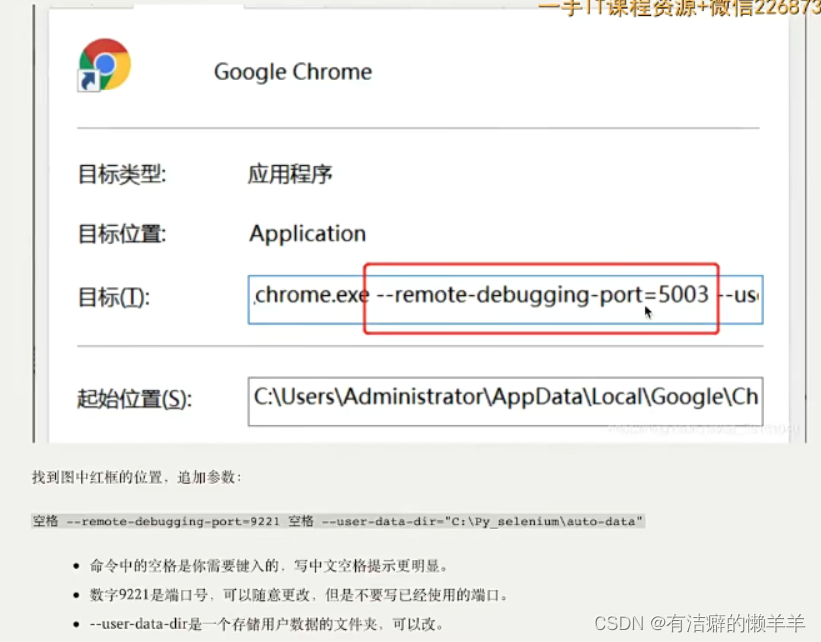

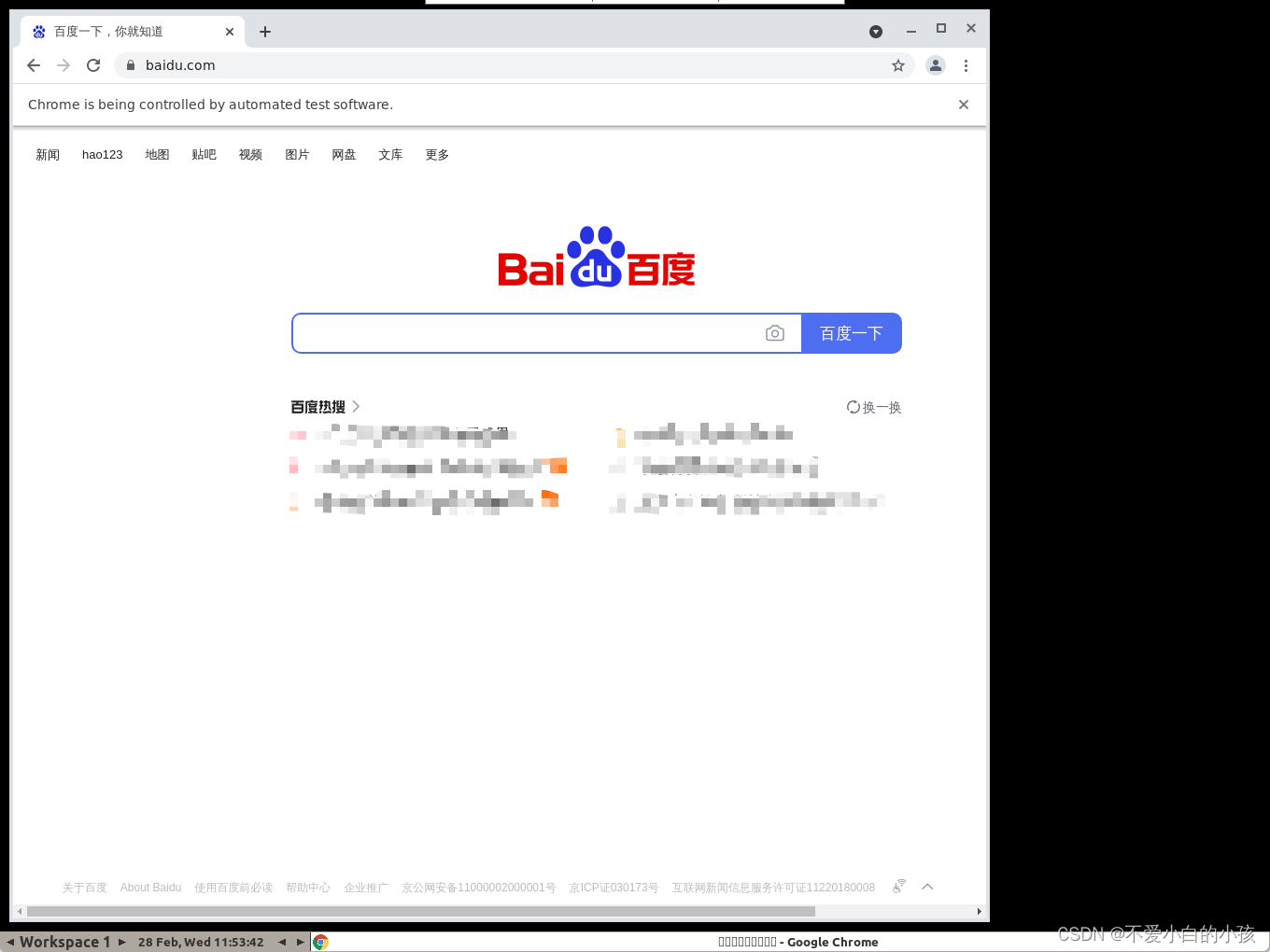

如何用 Python 做自动化测试

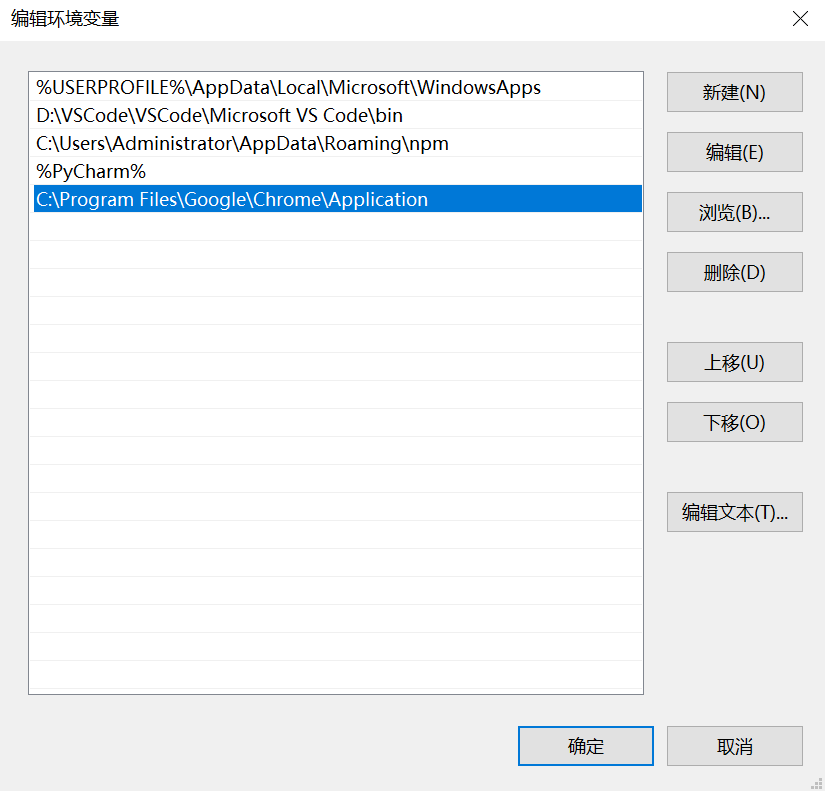

一、Selenium 环境部署

1. window 环境部署

1.1 当前环境

Win10 64 位系统;Python3.6.2(官方已经更新到了 3.6.4) 官方下载地址: https://www.python.org/downloads Selenium 3.4.3;谷歌 59。

1.2 Python3 安装部署…

40+岁老测试员的生涯回顾,Python自动化从业十年是种什么体验?

1、测试工程师“黄金”职业?

看到许多媒体都在争相炒作测试工程师—这一"黄金"职业,我有些不同的看法。以下的内容是从网站上摘录的一段信息:

随着国内IT企业对软件测试的重要性的日益了解,软件测试人才岗位的薪资待遇…

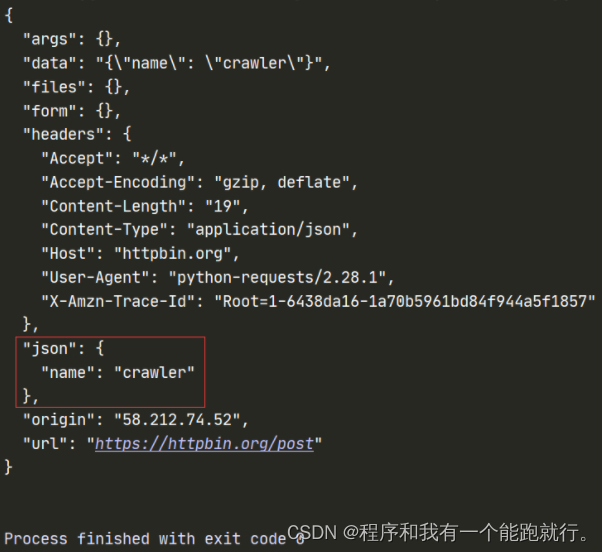

爬虫3 requests之json 把json数据转化为字典

#json 将json数据转化为字典,方便操作数据

res requests.get(http://httpbin.org/get)

print(res.json()) #res.json()返回的是字典

print(type(res.json())) 转载于:https://www.cnblogs.com/cxhzy/p/10268646.html

如何构造一个C#语言的爬虫程序

C#特别适合于构造蜘蛛程序,这是因为它已经内置了HTTP访问和多线程的能力,而这两种能力对于蜘蛛程序来说都是非常关键的。下面是构造一个蜘蛛程序要解决的关键问题: ⑴ HTML分析:需要某种HTML解析器来分析蜘蛛程序遇到的每一个…

机器人robot元标签

可以通过聪明的机器人元标签,来与机器人爬虫交互,告知它怎么爬你的网站,用法如下: <meta name”robots” content”noindex, nofollow, noodp, noydir, nosnippet”> 可以放到content中的关键字有以下几个:

“noindex”– …

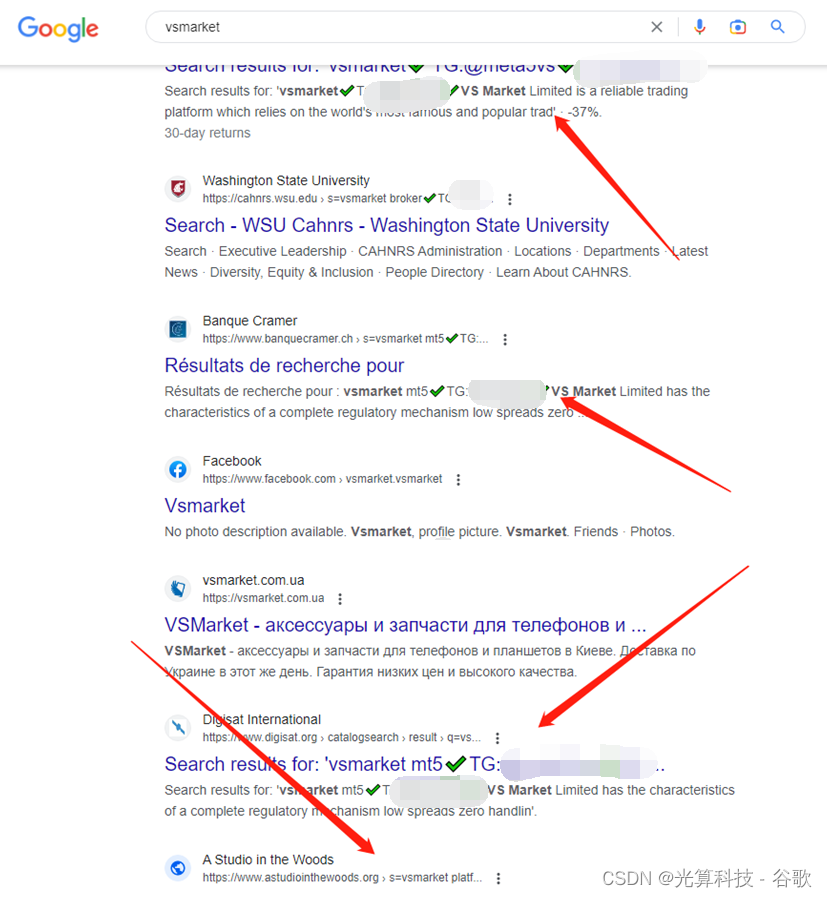

如何让自己的文章被百度等搜索引擎爬到

CSDN 写完博客将链接提交给百度站长:

https://ziyuan.baidu.com/linksubmit/url

这样有助于百度爬虫爬取文章 要想快速被搜索引擎抓你就得稍稍了解一下搜索引擎的原理,搜索引擎它是顺着一个站,将网站中的url全部提取出来,然后再…

你真的了解白帽、黑帽、灰帽 吗?看看这个你就懂了

萌新, 白帽、黑帽、灰帽 选哪个好?

1) 什么是白帽?

【定义】白帽就是通过正常手段对网站内部就行优化,包括标题、关键字、网站结构、网站代码等,是搜索引擎提倡的网站优化方法。 【特征】利用公平、正当方法…

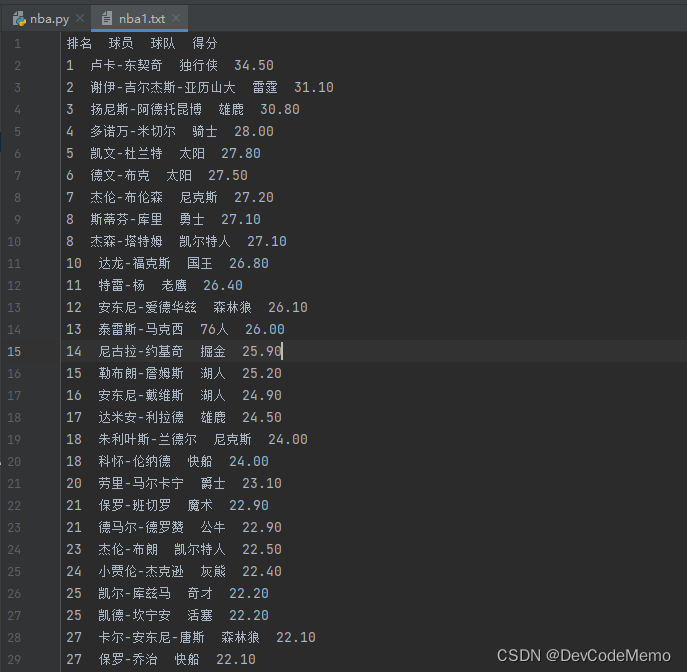

python 爬虫 beautifulsoup 和 requests 的使用

python 爬虫 beautifulsoup 和 requests 的使用

安装bs4 和 requests

pip install requests bs4导入bs4 和 requests

import requests

from bs4 import BeautifulSoup

例子:

爬取NBA球员的信息

# 新建“exerc3”Python文件完成作业:NBA球员数据网…

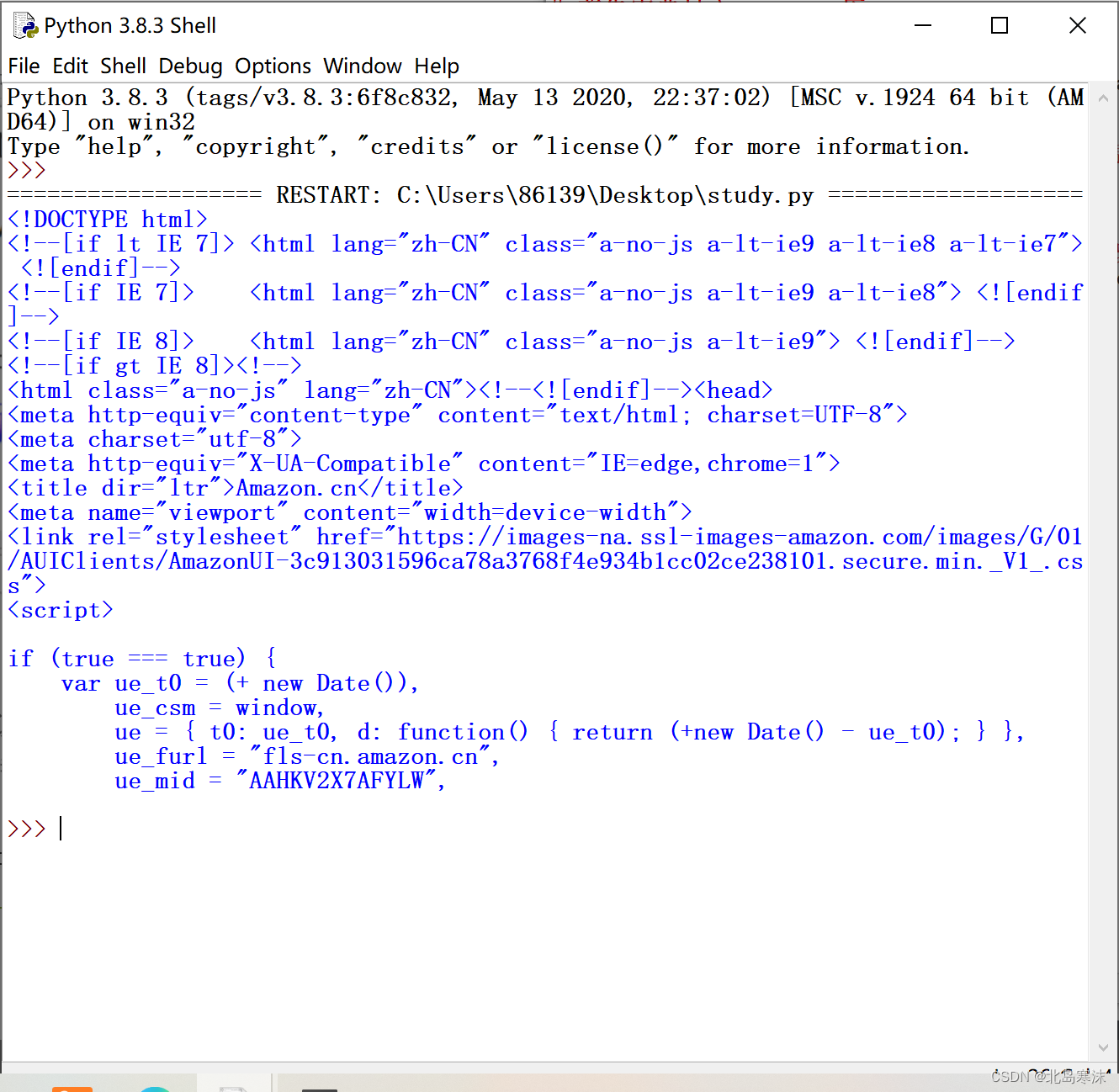

python爬虫系列--小练爬取花田首页源码

import requests#step1 指定url

urlhttps://love.163.com/ #step2 发送GET请求

responserequests.get(urlurl)#step3 获取响应数据,text:字符串格式

page_coderesponse.text

with open(youtian.html,w,encodingutf-8) as fp:fp.write(page_code)

print(爬取源码…

九. 并发编程 (进程池)

一 .进程池(multiprocess.Pool) 1.进程池概念 为什么要有进程池?进程池的概念。在程序实际处理问题过程中,忙时会有成千上万的任务需要被执行,闲时可能只有零星任务。那么在成千上万个任务需要被执行的时候,我们就需要去创建成千上万个进程么…

Scrapy爬虫中遇到的两个问题

1."Filtered offsite request" 参考一份示例代码运行的时候发生该错误,一般来说原因应该是request的地址和allow_domain的地址相冲突,会被过滤掉,所以解决方法是修改代码: yield Request(url, callbackself.parse_item, dont_filte…

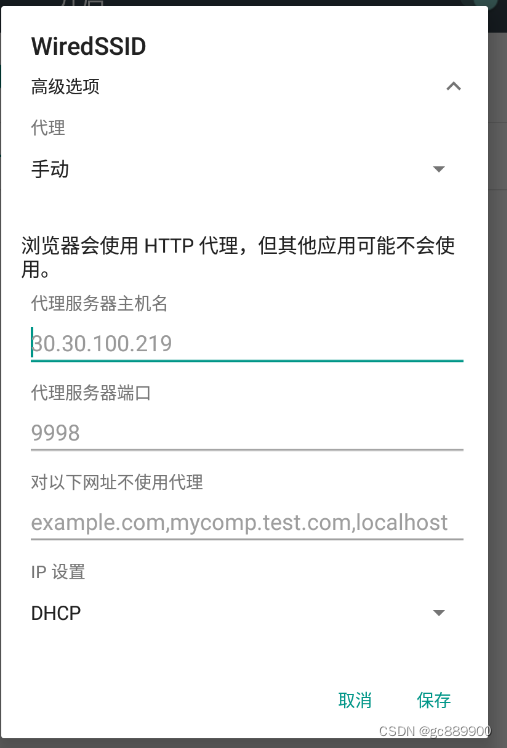

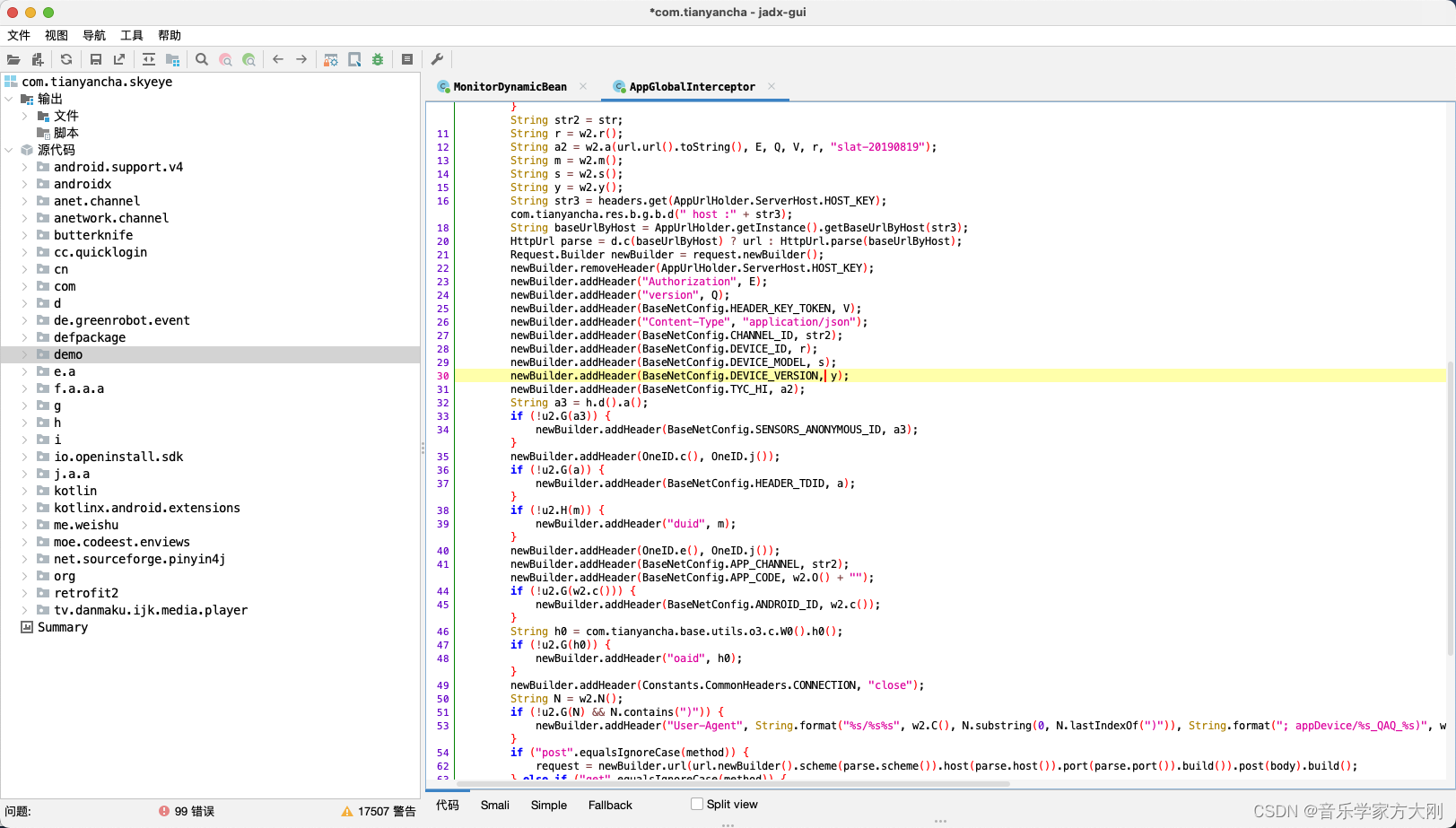

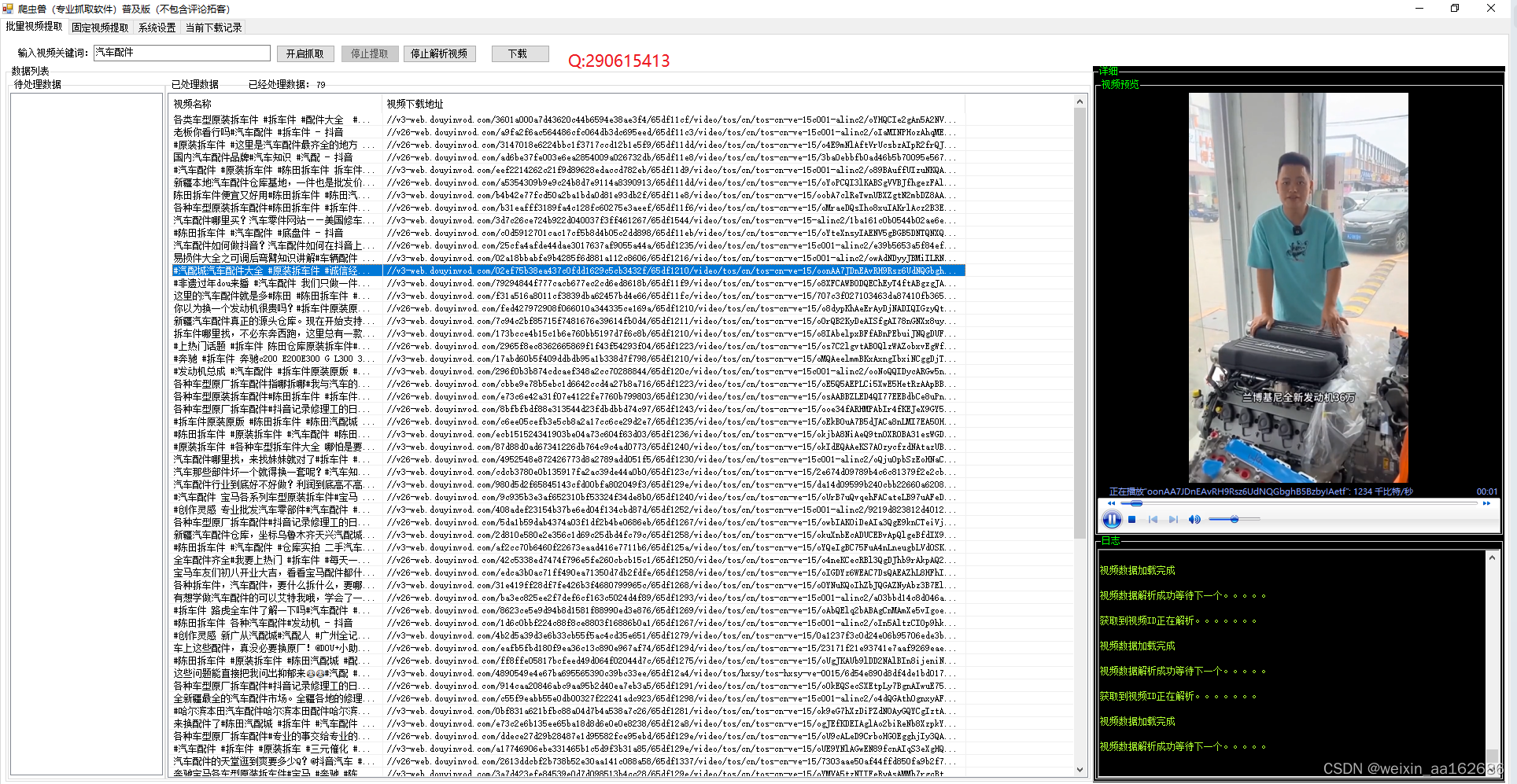

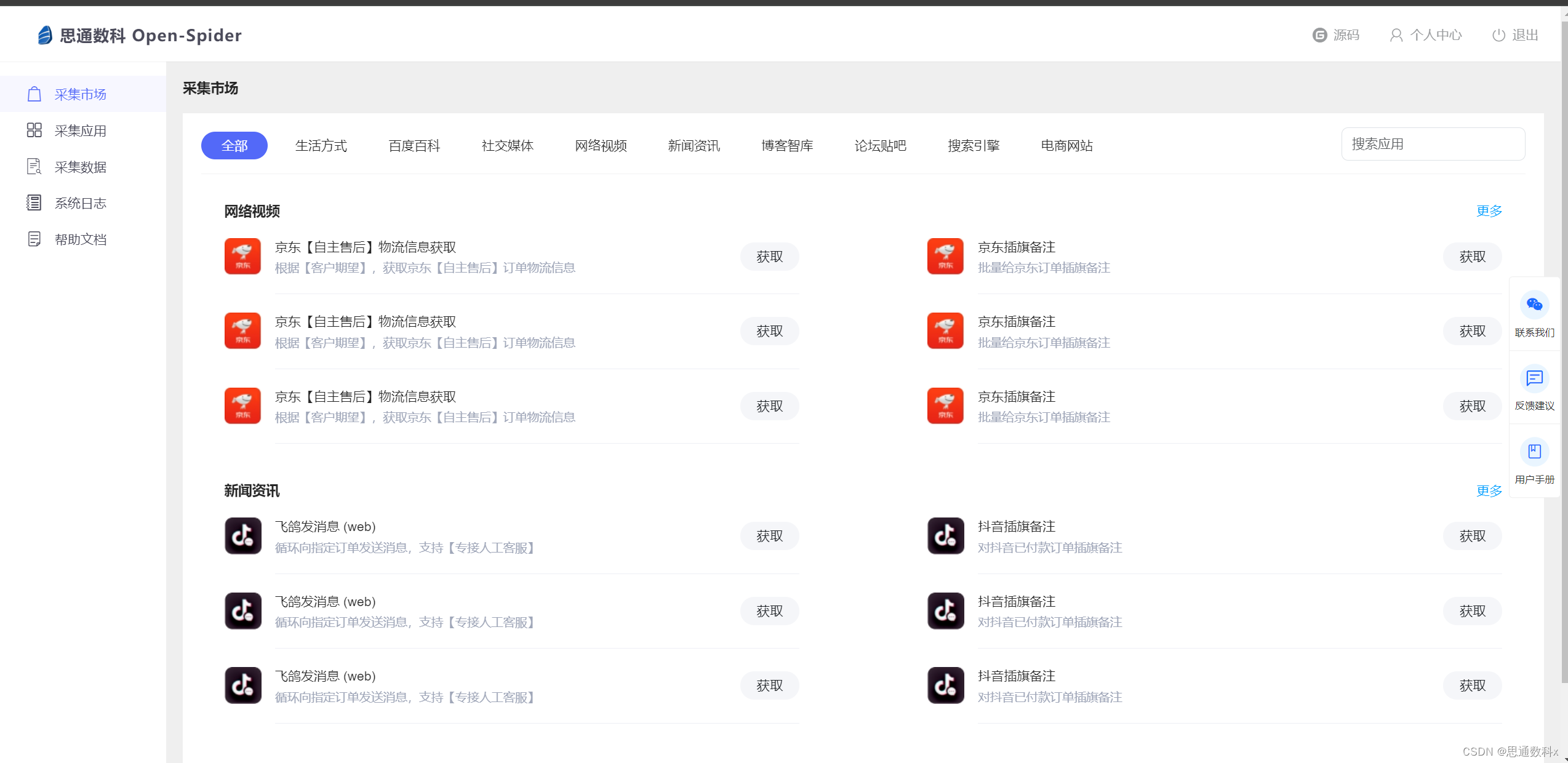

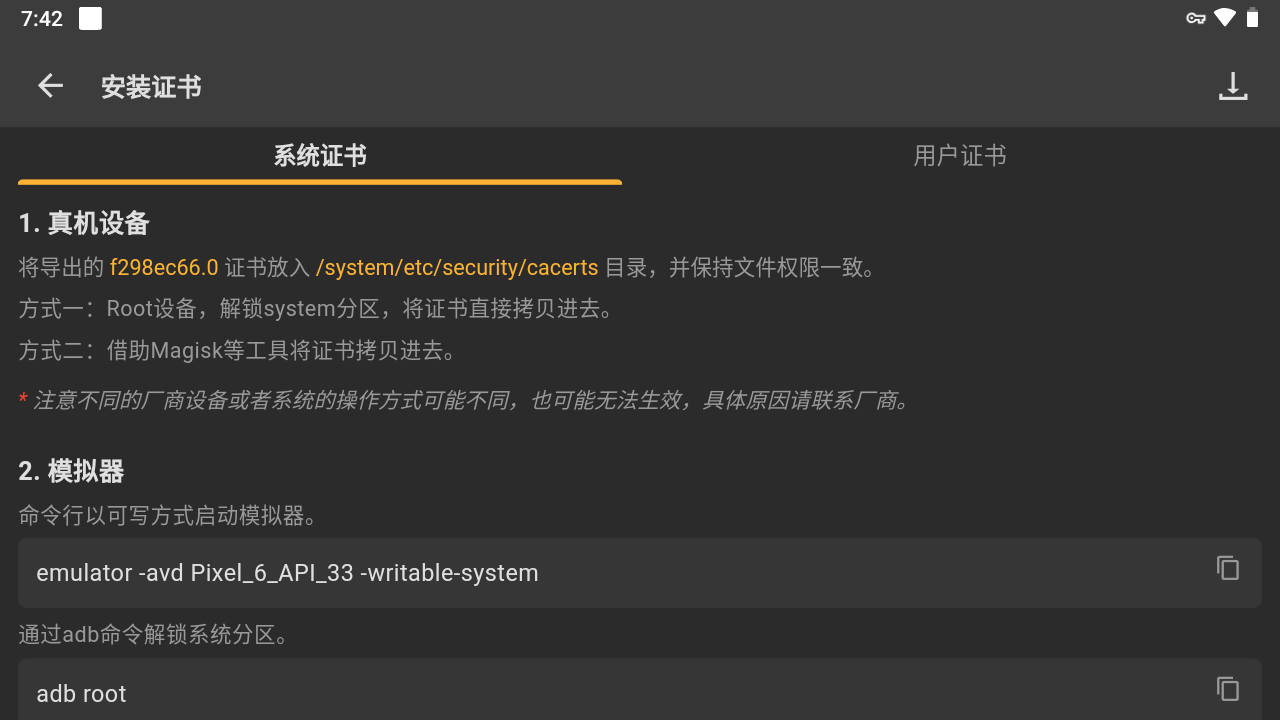

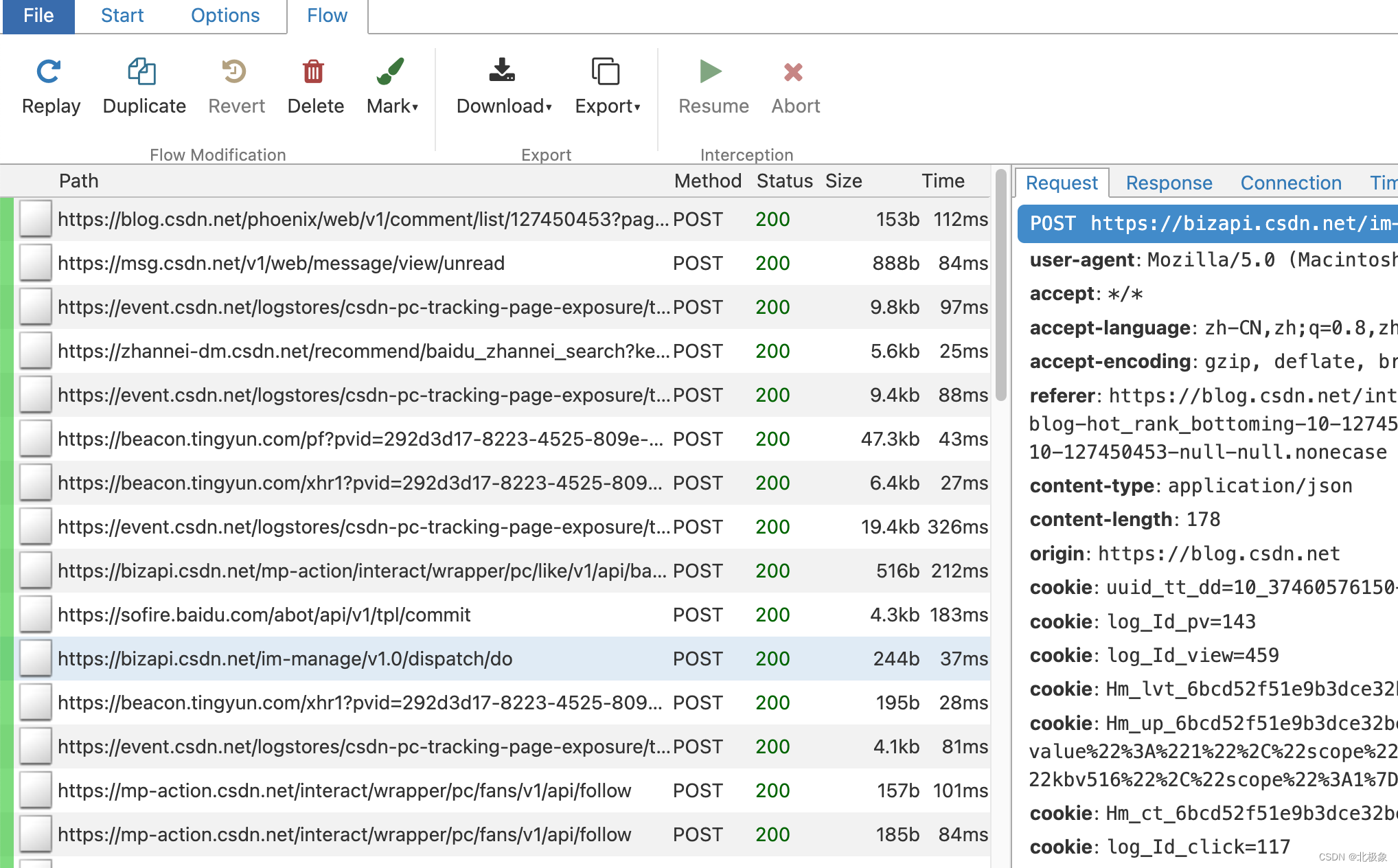

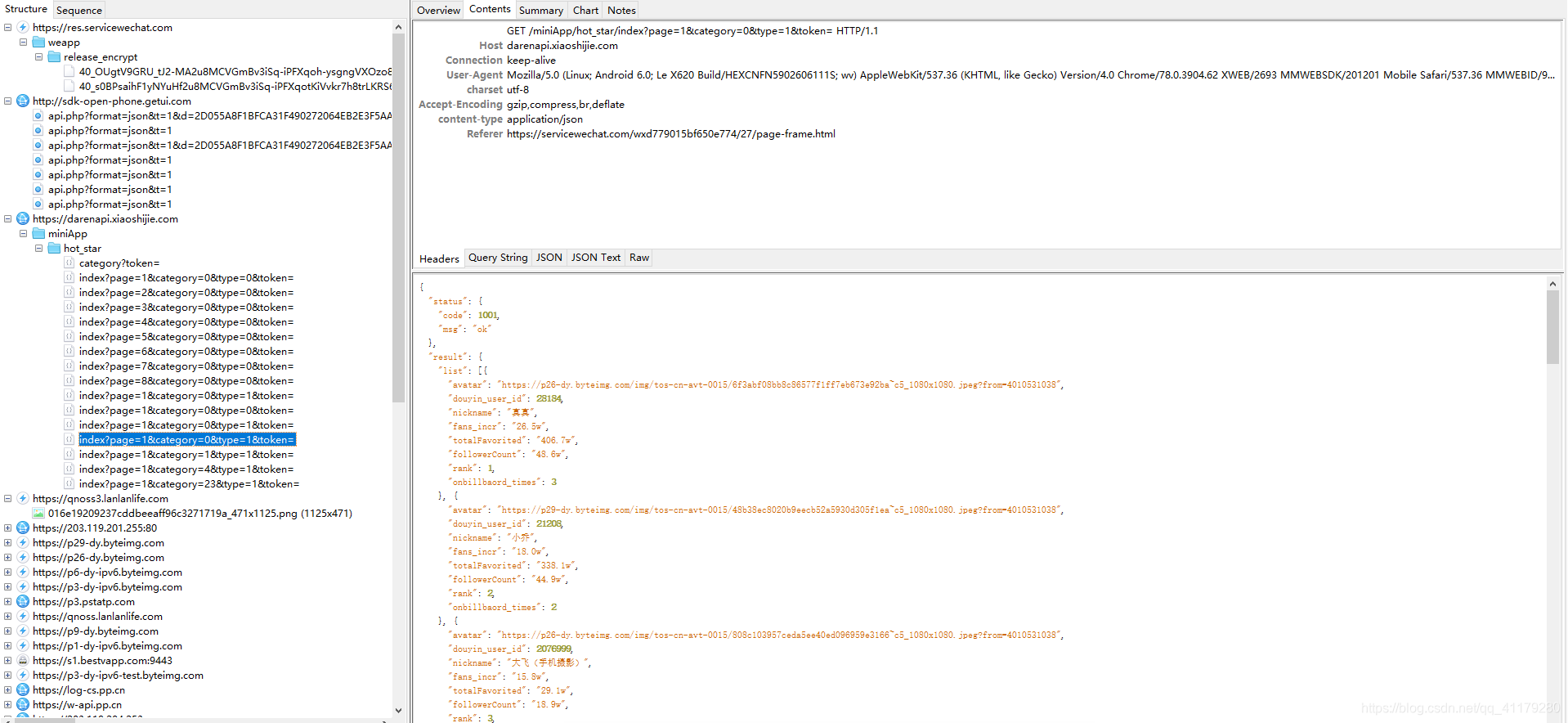

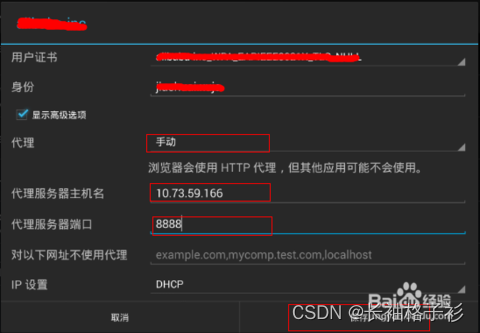

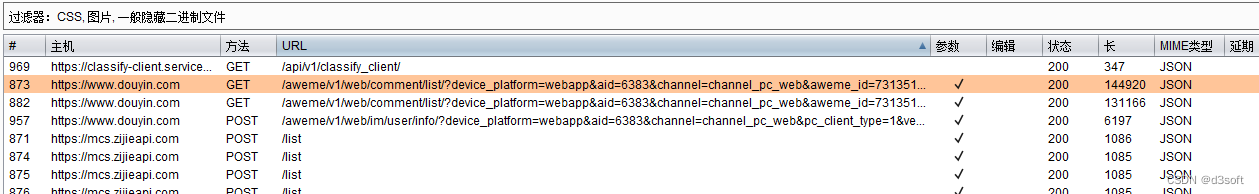

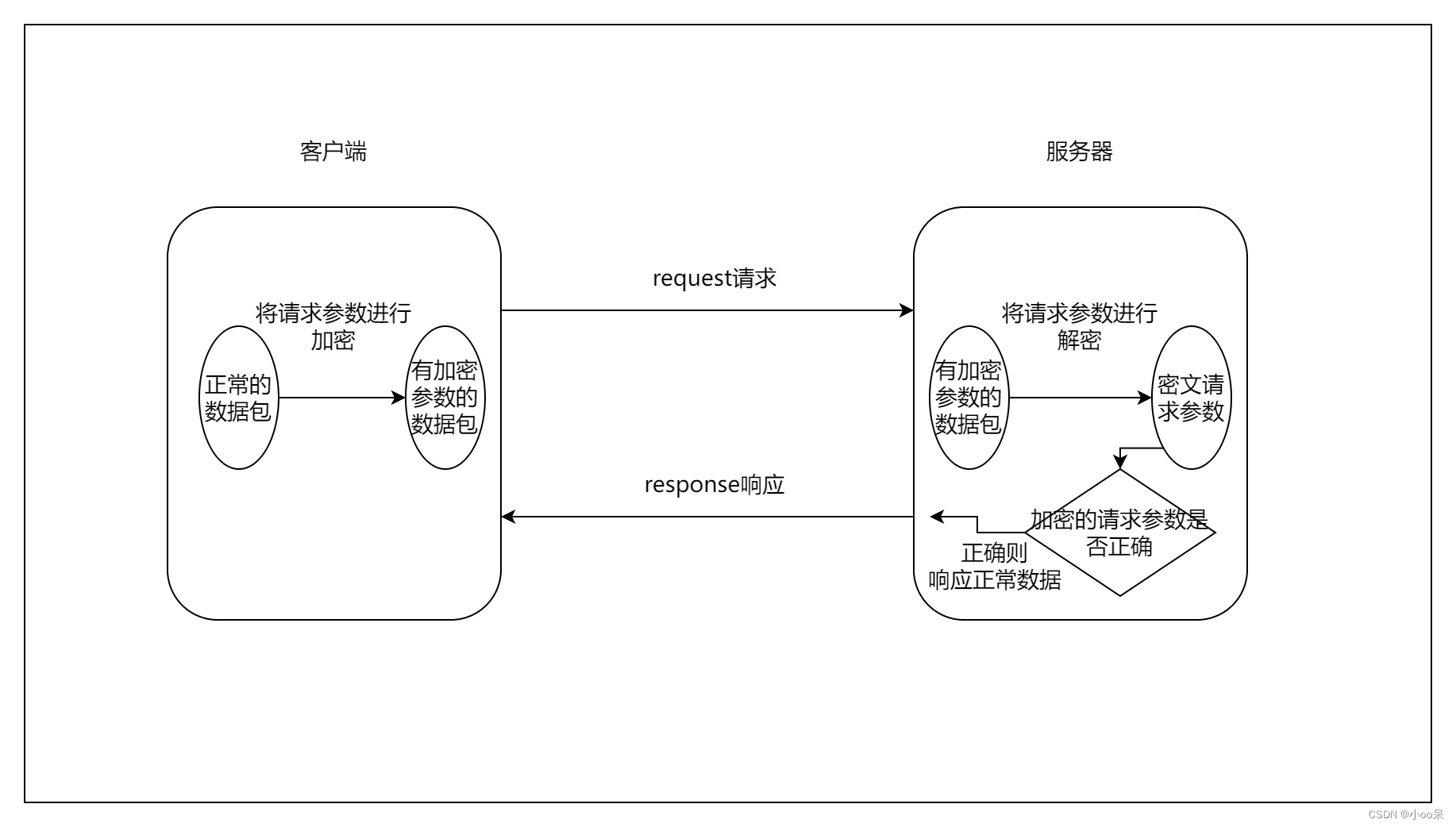

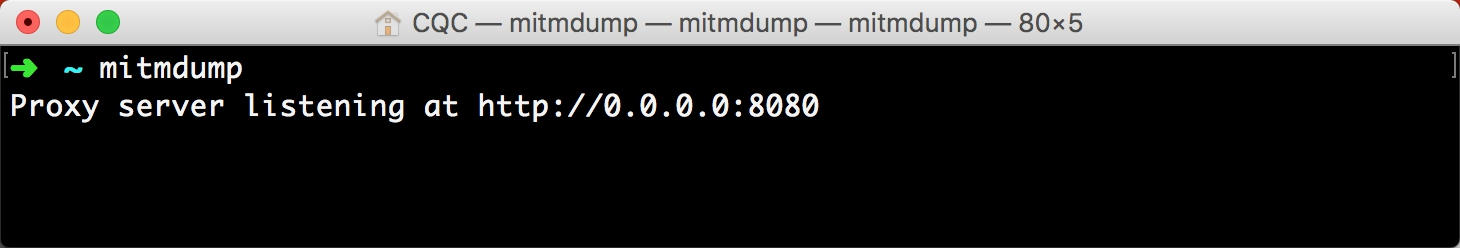

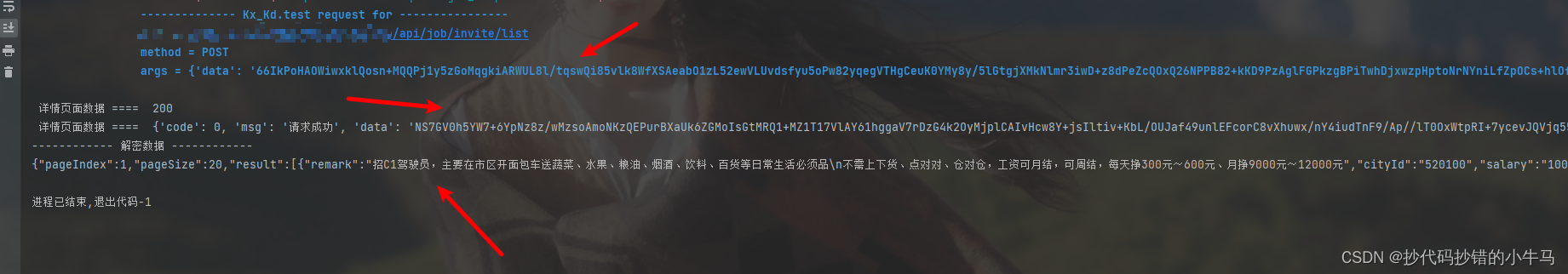

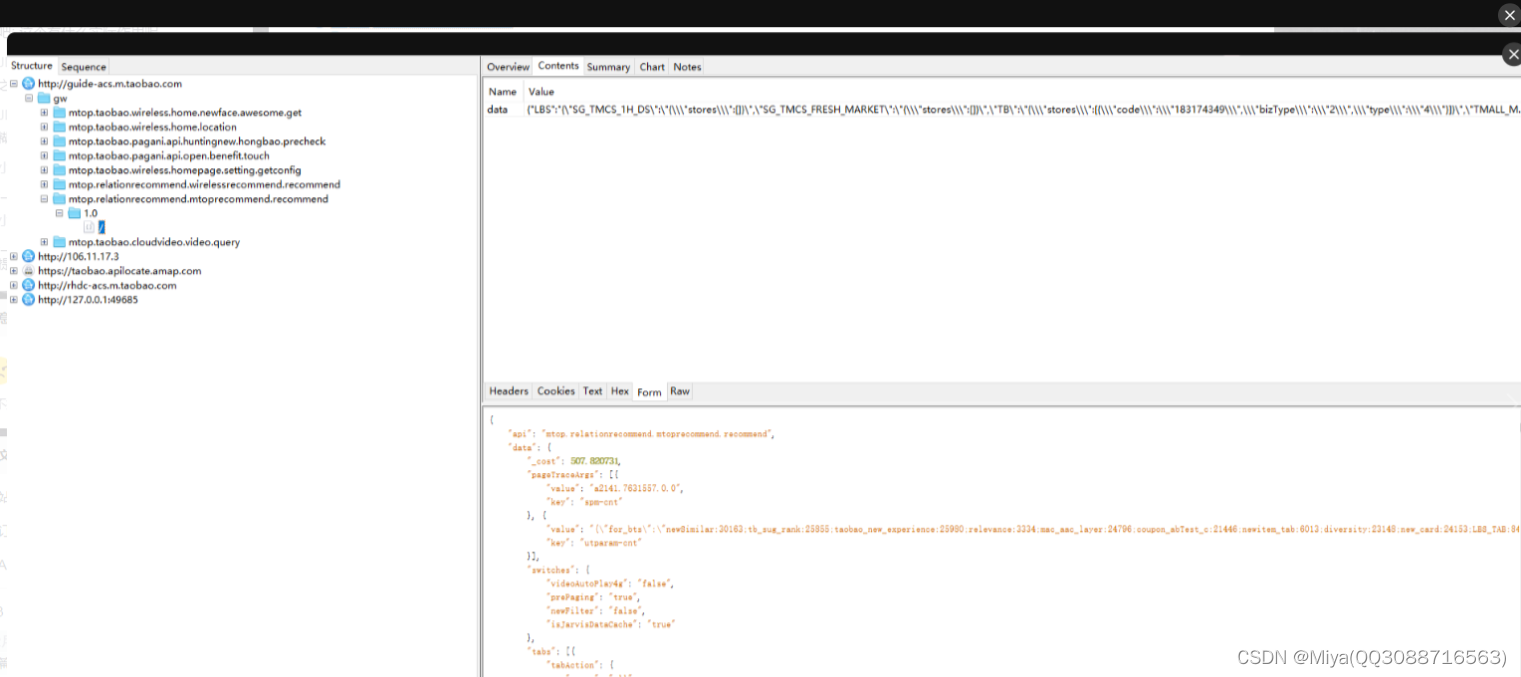

使用python抓取App数据

App接口爬取数据过程使用抓包工具手机使用代理,app所有请求通过抓包工具获得接口,分析接口反编译apk获取key突破反爬限制需要的工具:夜神模拟器FiddlerPycharm实现过程首先下载夜神模拟器模拟手机也可以用真机,然后下载Fiddler抓取…

oncontextmenu 事件

用户点击鼠标右键时触发并打开上下文菜单 禁用: document.oncontextmenu function() { return false;} 编辑自定义右键打开菜单 document.oncontextmenu function() { return false; } document.body.addEventListener(mousedown,function(e){ switch…

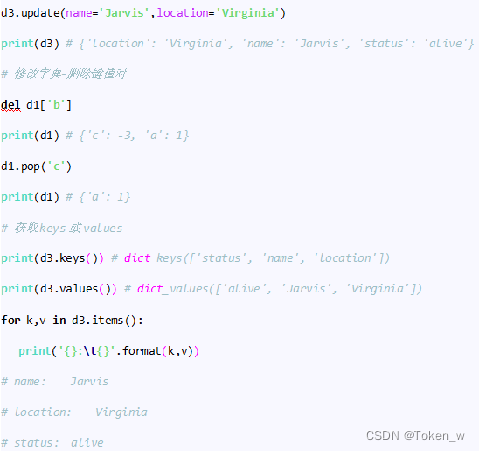

Python基础知识之2——字典

字典是什么? 字典是另外一个可变的数据结构,且可存储任意类型对象,比如字符串、数字、列表等。字典是由关键字和值两部分组成,也就是 key 和 value,中间用冒号分隔。这种结构类似于新华字典,字典中每一个字…

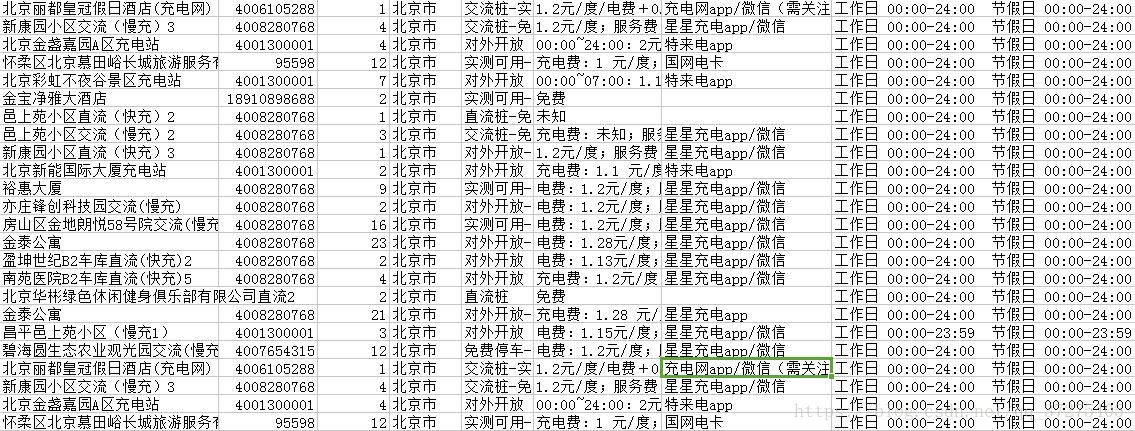

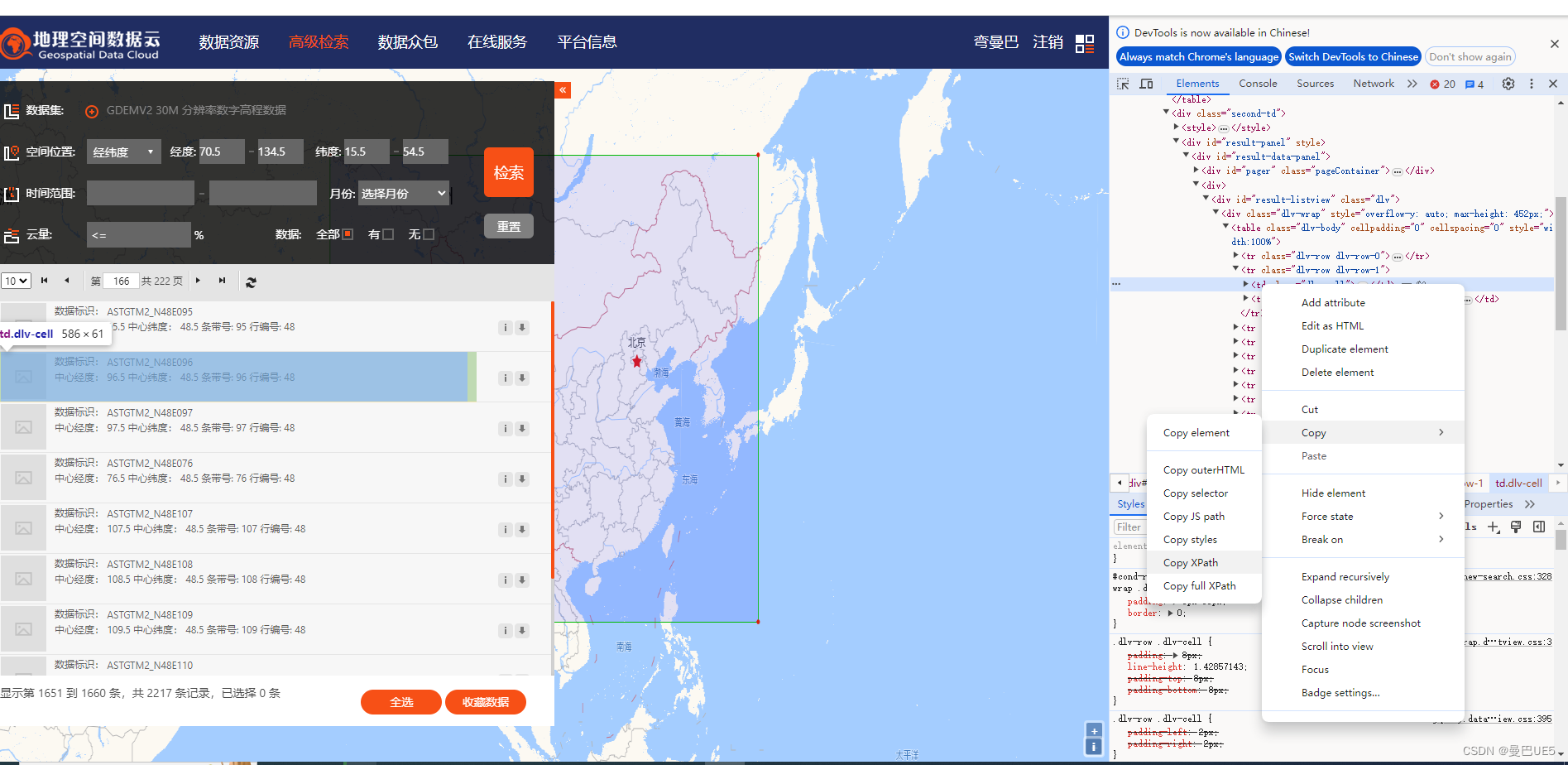

Landsat元数据批量下载工具

目录 前言landsat数据情况简介下载元数据总结一、前言 最近由于工作需要,需要下载部分landsat数据的元数据,老板大手一挥,给了十几年的landsat的path、row以及日期等,就算交待完了。于是我就开始准备吭哧吭哧到USGS官网上去一个个…

word类型考题带选项答案批量存入mysql数据库中

由于工作需要批量将word文档考题导入mysql中 题目如下(简单列举下PHP试题): 1.mysql_connect( )与mysql_connect( )的区别是 A mysql_connect( )不会忽略错误,将错误显示到客户端 B mysql_connect( )不会忽略错误,将错误显示…

爬虫3 requests基础2 代理 证书 重定向 响应时间

import requests

# 代理

# proxy {

# http:http://182.61.29.114.6868

# }

# res requests.get(http://httpbin.org/ip,proxies proxy)

# print(res.text)

#################

#取消重定向

# res requests.get(http://github.com,allow_redirects False)

# print(res.u…

Python 开发面试总结

网络基础 如何确定发送过来的数据的完整性(有无中间人攻击)? 散列值校验(MD5、SHA-1)、数字签名(PGP),需要用户亲自校验,若是散列值或数字签名本身被篡改,用户…

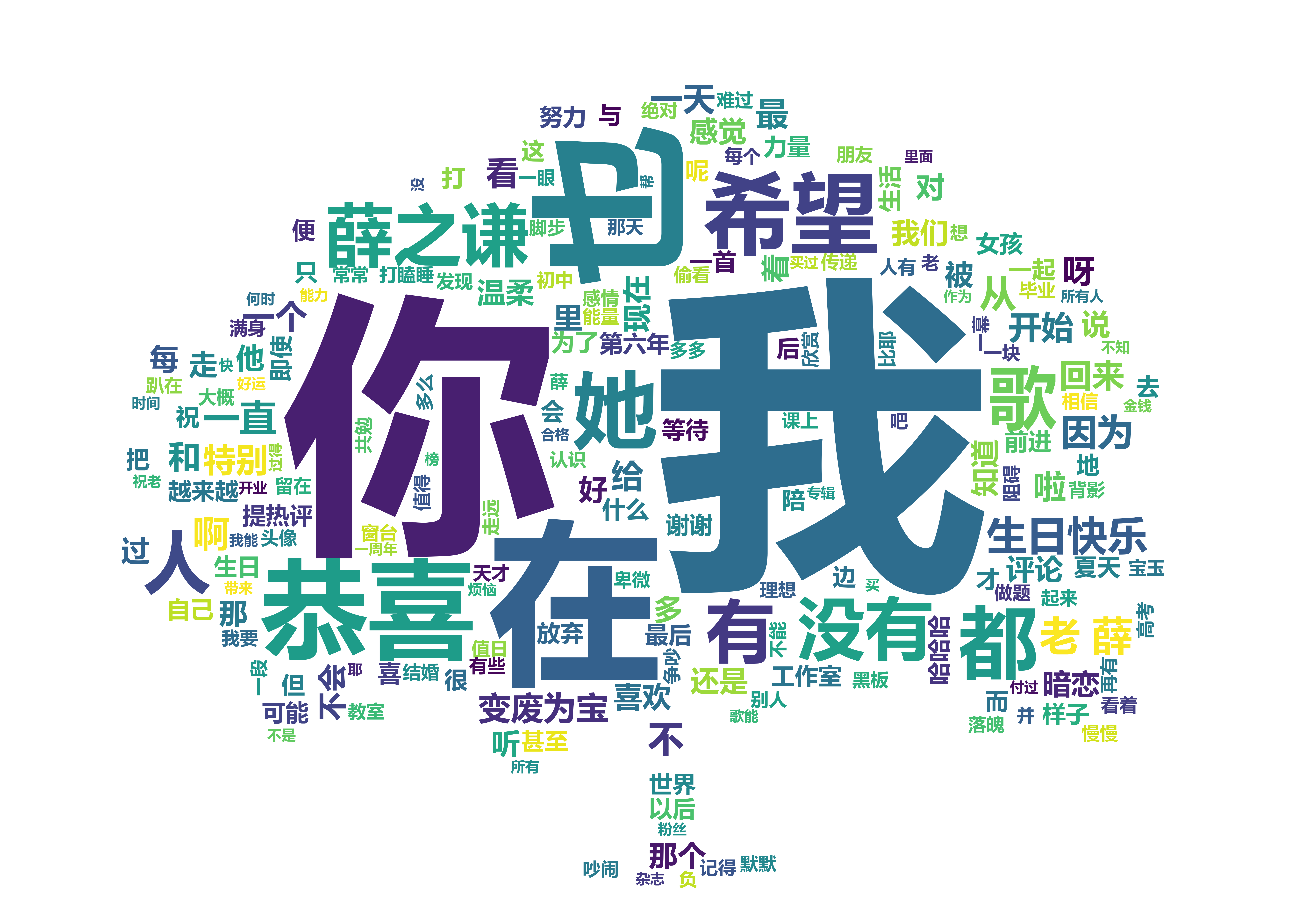

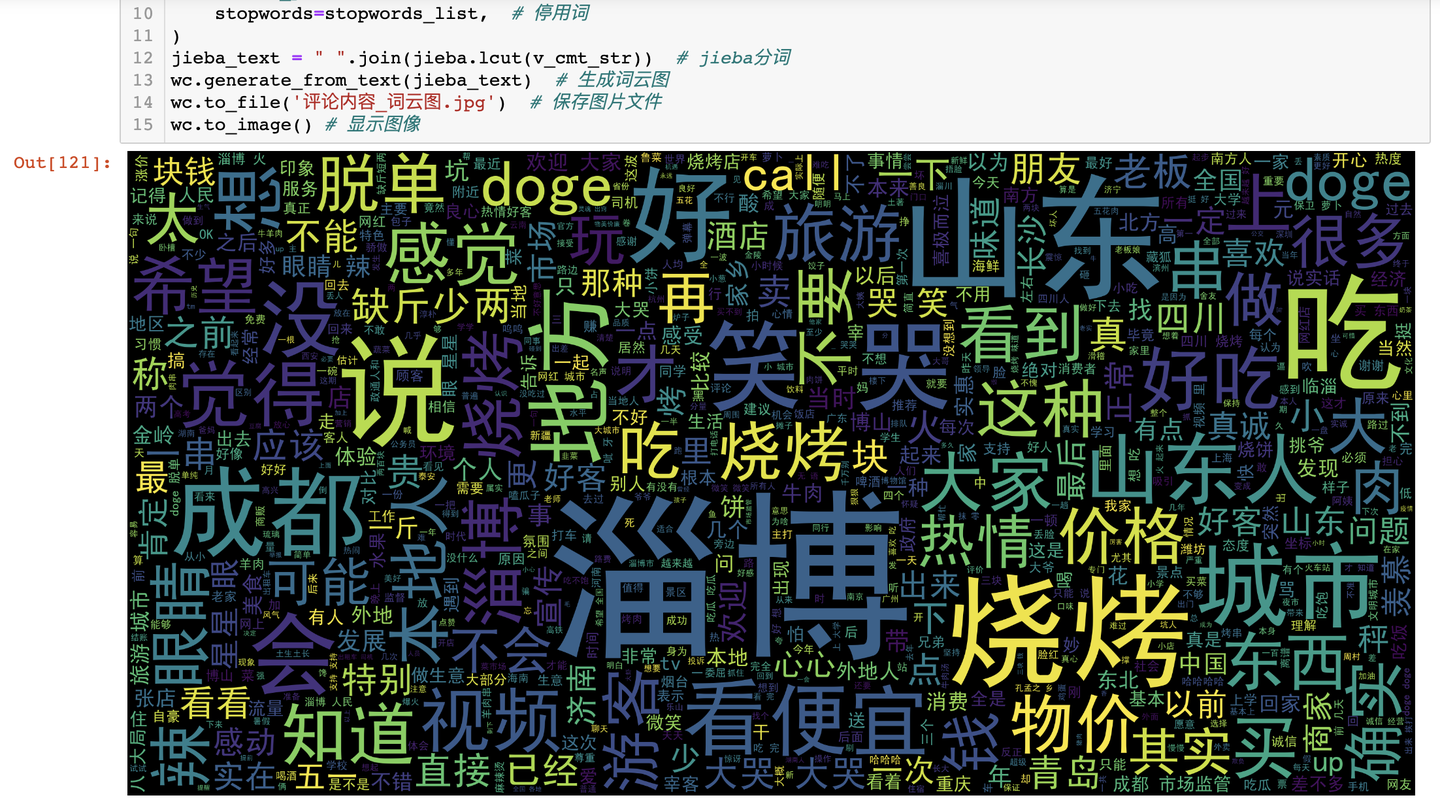

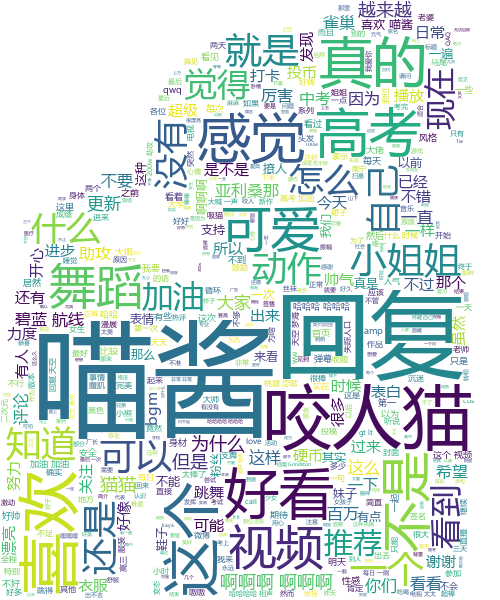

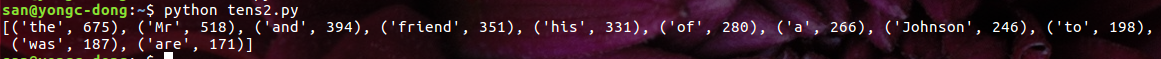

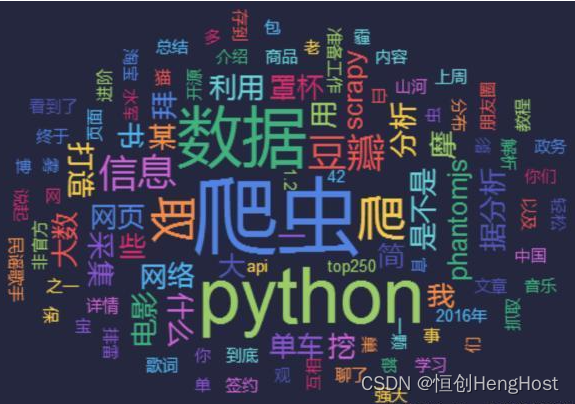

python 生成18年写过的博客词云

文章链接:https://mp.weixin.qq.com/s/NmJjTEADV6zKdT--2DXq9Q 回看18年,最有成就的就是有了自己的 博客网站,坚持记录,写文章,累计写了36篇了,从一开始的难以下手,到现在成为一种习惯ÿ…

python模块 - 常用模块推荐

python常用模块 #取行数import linecachecount linecache.getlines(mv)[1]print(count) 压缩字符 当谈起压缩时我们通常想到文件,比如ZIP结构。在Python中可以压缩长字符,不涉及任何档案文件。import zlibstring """ Lorem ipsum do…

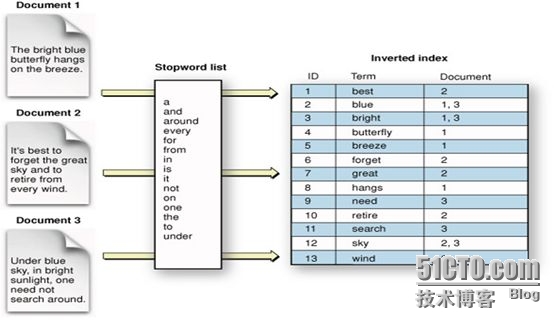

Lucene7.2.1系列(一)快速入门

系列文章: Lucene系列(一)快速入门 Lucene系列(二)luke使用及索引文档的基本操作 Lucene系列(三)查询及高亮 Lucene是什么? Lucene在维基百科的定义 Lucene是一套用于全文检索和搜索…

Python学习干货,如何用Python进行数据分析?

1.为什么选择Python进行数据分析?

Python是一门动态的、面向对象的脚本语言,同时也是一门简约,通俗易懂的编程语言。Python入门简单,代码可读性强,一段好的Python代码,阅读起来像是在读一篇外语文章。Pyth…

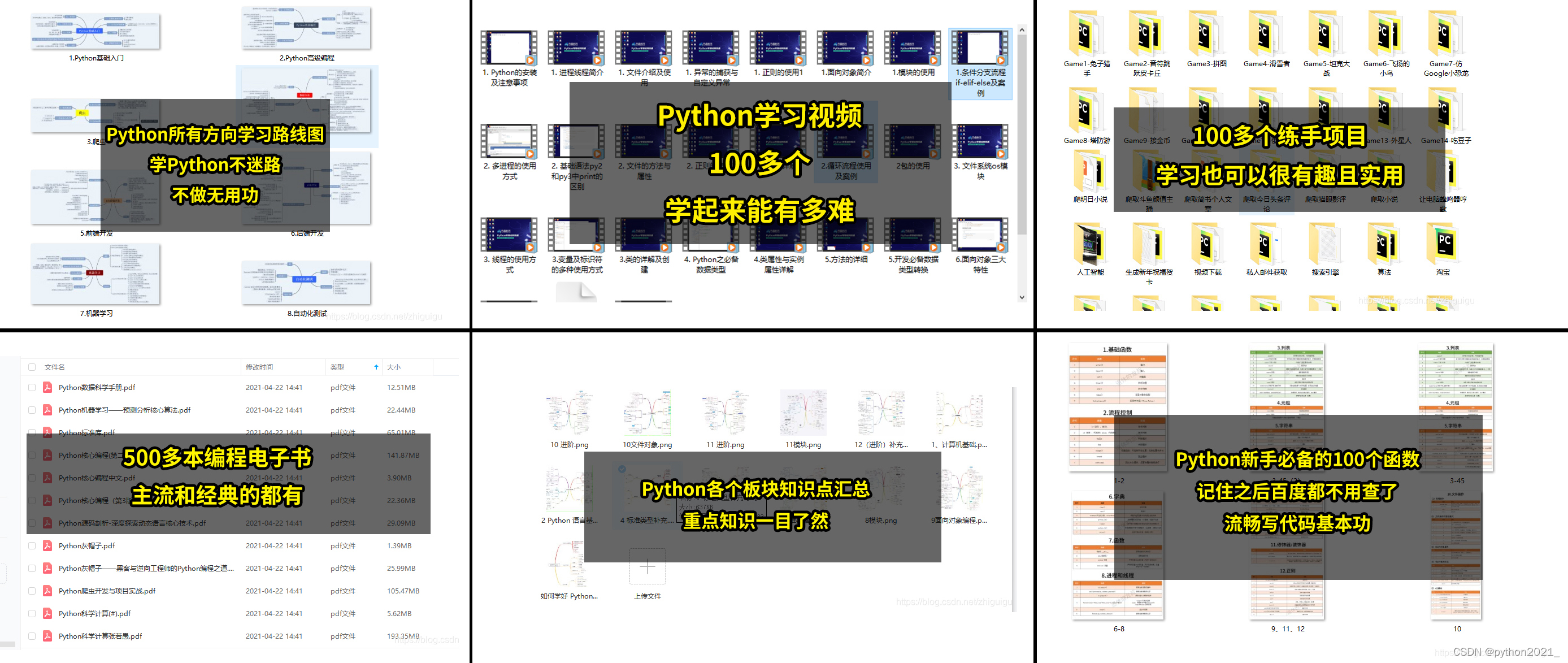

华为程序员大牛推出的一份Python学习清单,这一定是你最需要的

站在风口上,猪都能飞起来。人工智能风口,让Pyhon这门胶水语言转变成非常火的网红语言。

编程功力深厚的程序员花一两个星期就能上手Python,而一些新手程序员花几个月就可以上手。

学编程,用Python确实是一个相当不错的选择。 不…

四十岁入门 python pandas 处理 Excel 报表

都说 python 很强大,又容易学,有的省份已经将 python 纳入小学课程,于是我也想看看 python 有多容易学,断断续续看了差不多多半年的时间,有一种相见恨晚的感觉,为了不让更多的人错过这个强大又简单的编程工…

三月接Python私活,超爽

二月已近尾声,即将进入Python兼职接单的高潮期,行业里对爬虫类和数分类服务的需求量,可能会在短时间内暴增。估计圈子里的朋友都不会闲着,趁着旺季接单赚一笔。

最近,咨询技术变现、兼职接单问题的朋友也越来越多。 最…

一行Python代码实现文件共享

有时候,我们想要在局域网内共享一些文件,一般的实现方式是配置共享目录或者搭建一个文件服务器。但是无论哪种方式都是挺麻烦的。

但是现在不用担心了,今天教你一个快捷简便的方法。只要你电脑装了 python,就可以轻松实现。

共享…

女友乱用Git,差点把我代码删了。。。

想必大家平时都用 Git 管理代码,通过女朋友误删代码这事,我发现大家平时都或多或少有因为 Git 用得不熟耽误时间的,比如说:

1.怎么又报 detached HEAD 了?

2.push 不上去了,提示 non fast-forwards&#…

在银行存500万,能辞职靠利息舒服的活下去吗?NO

知乎上有这么一个热门问题: 在银行存500万,能辞职靠利息活下去吗? 这个问题有两百万多次的浏览,看来知乎上真的是人均年薪百万。

行得通吗?我说No

如果说活下去,那肯定是可以的。

但有500万的人…

千万别再瞎学Python了,过来人的一些学习经验,能让你少走弯路

我当初选择学习Python,其实自己也是盲目的,毕竟是转行过来,之前对编程领域根本不了解。这还得多亏我的那位亲戚指点,才少走了很多弯路。他当时告诉我要我学习Python主要有以下几点原因:

1、Python的优势 相比较其他语…

35岁的中年叔叔,转行学习python,还有钱途吗?

我计算机专业毕业,毕业后在一家大型台资企业上班,一转眼就干了9年了,月月拿着5000的工资,做着没啥技术含量的工作,本以为自己会心安理得的干到退休,可是随着娶妻生子,逐渐感觉到钱的重要性了&am…

大学生们颤抖吧,中学生已经开始学Python了

高中生学Python?这是开玩笑的吧?高中生能学会吗?高中生学Python干啥用?高中生应该怎样学Python?高中学了Python的话大学还要再学吗?

本文我来回答一下大家可以的几个疑问:

1、高中生爲何要学P…

Python黑客使用Python 3天爬取8亿数据据在暗网上售卖

昨天,一则“陌陌 3000 数据暗网禁售 200 元”的消息在网上不胫而走。

陌陌回应暗网售卖数据:匹配度低

据微博用户 lxghost 透露,陌陌有约 3000 万条数据在暗网出售——这批数据是 2015 年 7 月 17 日被写入的,总条数 3161 万条&…

Python快速入门指南,没基础没关系,看完这篇你就懂了

随着人工智能大火,我们身边几乎处处充满着AL的气息,就连停车,都是机器人值班了。

可是很多人都不知道人工智能是由什么开发的,各种相关联的框架都是以Python作为主要语言开发出来的。

Python本身很普通,是所有编程语…

用Python怎么多赚钱?6种办法用上 让你过上挣钱的好日子

编程语言Python特别火,火到几乎所有的程序开发公司都要求自己的员工掌握它,可以说,不懂Python的码农们在整个IT行业是无法想象的。不仅如此,Python除了在编程方面应用广泛,而且还能在业余时间变现,让拥有这…

Python易学易用,却是黑客最佳选择

首先让我们来了解一下什么是Python。 Python 是一个高层次的结合了解释性、编译性、互动性和面向对象的脚本语言。

重点是,Python 是一种对初学者非常友好的语言,从应用程序开发到文字处理、web甚至是游戏能提供支持,不少人也会将Python作为…

为什么Python适合初学者,学Python大概要多久

为什么Python适合初学者?学Python大概要多久?很多人都觉得,Python是一门很好学的语言,非常适合入门。但更多人都是不清楚具体原因的。那么,我们不如一起来看看Python为何更适合初学者,为何更适合学习吧。另…

完啦,上班三个月,变秃了

程序员很容易变“秃”吗?

真实现状

我身边的同事、和一些同行程序员发型都挺正常的。

集体活动的时候并不像光头帮那样,清一色锃光瓦亮。 我甚至觉得程序员这个团体的发型比我在学生时期所见的显得更佳多样性。

板寸、平头、背头、长发(男…

中年危机,关于未来的一些思考

今年是毕业的第10个年头,已经没了刚毕业时候那种激情冲动,但是却多了对未来的几分笃定。

目前从事互联网软件行业,专业并不是计算机,而是化学专业,毕业一年后,半路转行这个行业的。

概括起来,…

不会Python迟早失业?Python何以成为找工作必备技能

大数据时代,没听说过Python的人可能很少。

未来和data与AI紧密连接的当下,金融公司纷纷改成Fintech(financial technology),投行热衷于向科技公司砸钱,就连卖汉堡的金拱门都不甘落后,一连收购了…

零基础教你如何快速入门Python

Python是一种高层次,解释型,交互式和面向对象的脚本语言。

Python是解释型的Python是交互式的Python是面向对象的Python是初学者的语言

Python的突出特点包括:

易学易阅读易维护拥有广泛的标准库交互模式可移植可扩展数据库GUI 程序可伸缩…

使用Python进行爬虫的初学者指南

前言

爬虫是一种从网站上抓取大量数据的自动化方法。即使是复制和粘贴你喜欢的网站上的引用或行,也是一种web抓取的形式。大多数网站不允许你保存他们网站上的数据供你使用。因此,唯一的选择是手动复制数据,这将消耗大量时间,甚至…

计算机专业准大一新生,该提前学习数学知识还是Python编程

首先,对于计算机相关专业的大一新生来说,如果想在入学前或者大一期间自学一些内容,可以重点关注一下编程知识,一方面编程知识的难度相对比较低,自学往往也能够顺利入门,另一方面在学习编程知识的过程中&…

我的天,小学生都已经开始学Python了,十年后你还有工作么?

大家听到小学生学Python?这是在开玩笑的吧?小学生学Python干啥用? 实际上,山东省最新出版的小学信息技术六年级教材已经加入了Python内容!真是教育从娃娃抓起啊,以后出去都不敢说自己不会Python了….

除去…

用python找出谁拉黑了我的QQ空间

前景提要

最近发现有人QQ空间对我展开了屏蔽,咱们也不知道怎么惹到人家了,一气之下写了一个小爬虫看看到底谁把我屏蔽了。写小本本记下来!!!

代码在最尾部,需要请自取。

准备工作

python环境࿱…

零基础转行Python怎么学?

现在很多人在问,零基础学Python编程开发难度大吗?从哪学起?如果自己转行学习Python,能找得到工作吗?今天呢就给大家说说这个问题。

一、学习Python难吗?

Python语言相对于初学者来说,是比较简…

王心凌火了,Python 从入门到精通:一个月就够了

毫无疑问,Python 是当下最火的编程语言之一。对于许多未曾涉足计算机编程的领域「小白」来说,深入地掌握 Python 看似是一件十分困难的事。其实,只要掌握了科学的学习方法并制定了合理的学习计划,Python 从 入门到精通只需要一个月…

一位程序员的迷茫:每天5:30准时下班,月薪10000+

“月入过万”在过去一直是人们的梦想,随着时代的不断进步,对于各个方面的人才需求在不断的增长,能够实现月入过万梦想的岗位在现在也越来越多,就比如程序员这个大家耳熟能详职业,就能够月入过万。 当然,程序…

作为一名程序员,如何开展自己的副业?月赚三万的真实故事

作为一名程序员,除了敲代码之外还应该有一些副业。

我们都是程序员,大多数都是普通人,都在替别人打工,虽然收入在别人眼中挺高,但是连个首付都付不起。

这时,首先得要发展副业,与其拿着死工资…

四册200多页Pandas教程+Python3.x最新版(5059页),比官网还牛逼

如果我说:Pandas是Python中最好的数据处理库,应该没有人反驳吧?

但是很多人就是学不会,因为官网看起来太费劲了! 这次废了九牛二虎之力,为大家找到了4个Pandas中文文档,一共200多页,…

浙江大学内部Python入门教程(包含PPT课件、源码,系统学习Python),现已开源下载

python程序设计是浙江大学python课慕课配套教材。 这套资源包含Python程序设计教材PDF版、PPT课件、题目集源代码。强调问题解决、设计和编程,作为计算机科学的核心技能。 有需要的小伙伴,可以再文末获取! 教材目录: PPT包含内容&…

Python已可在浏览器端运行,或将成为前后端通吃语言?

知名 Python 发行版 Anaconda 开发商近日宣布了可在浏览器端运行的 Python —— PyScript。 根据官方的介绍,PyScript 是一个开发框架,为开发者提供了在标准 HTML 中嵌入编写 Python 代码的能力、使用 Python 调用 JavaScript 函数库,以及创建…

30 段极简 Python 代码,拿来即用

学 Python 怎样才最快,当然是实战各种小项目,只有自己去想与写,才记得住规则。今天给大家分享的是 30 个极简任务,初学者可以尝试着自己实现;本文同样也是 30 段代码,Python 开发者也可以看看是不是有没想到…

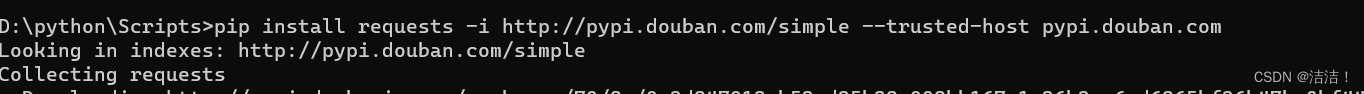

python安装模块速度太慢了,教你一招提升百倍安装速度

在python开发中,经常需要使用到各种各样的库。pip又是我们常用的安装工具。但是国外的源下载速度实在太慢,经常导致超时。

对于这种情况我们可以修改pip的下载源为国内源。这样就可以大幅度提升下载速度。

如何修改源?

1、临时更换镜像源 …

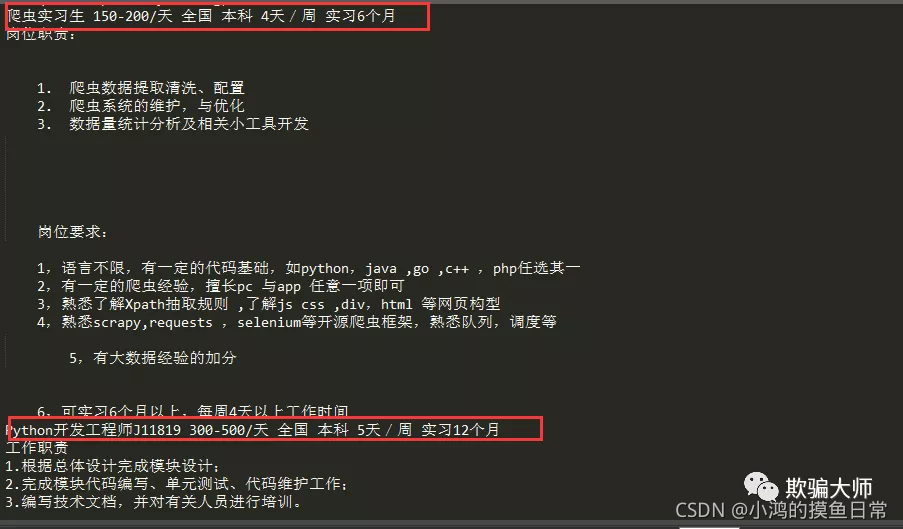

0基础学python爬虫兼职,可以月入过万吗?

废话少说,直接上图

本朝九晚六的社畜靠着下班、周末时间接单帮别人写代码,上个月就赚了1W 说实话,我虽然住在一线城市,但是工资交完合租的房租就剩小半了,每个月就剩一两千生活费,平时同事叫一起出去吃顿饭…

python从零开始学的话大概多长时间才能达到自主完成项目的水平?

Python是目前非常受青睐的编程语言,也是一门非常高级的语言,从学习难度上来说,Python要比其他语言更加简单且容易入门,因此现在学习Python的人越来越多了,这里为大家简单的介绍一下从零开始学Python需要多久才能自主完…

Python3行代码翻译70种语言,这个OCR神器牛逼了

今天给大家介绍一个超级简单且强大的OCR文本识别工具:easyocr.

这个模块支持70多种语言的即用型OCR,包括中文,日文,韩文和泰文等。

下面是这个模块的实战教程。 1.准备

请选择以下任一种方式输入命令安装依赖:

1. …

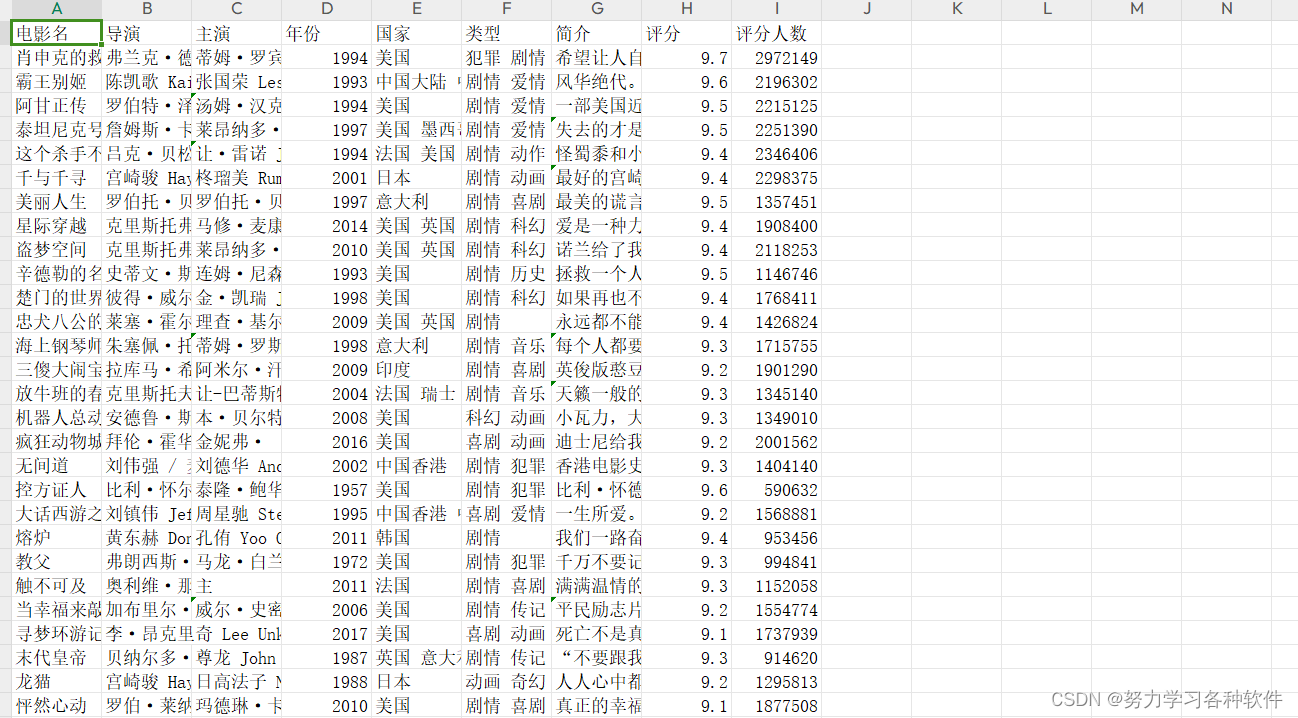

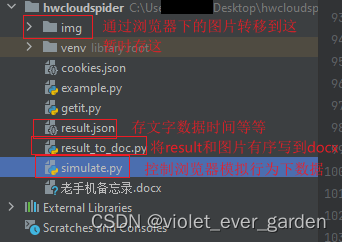

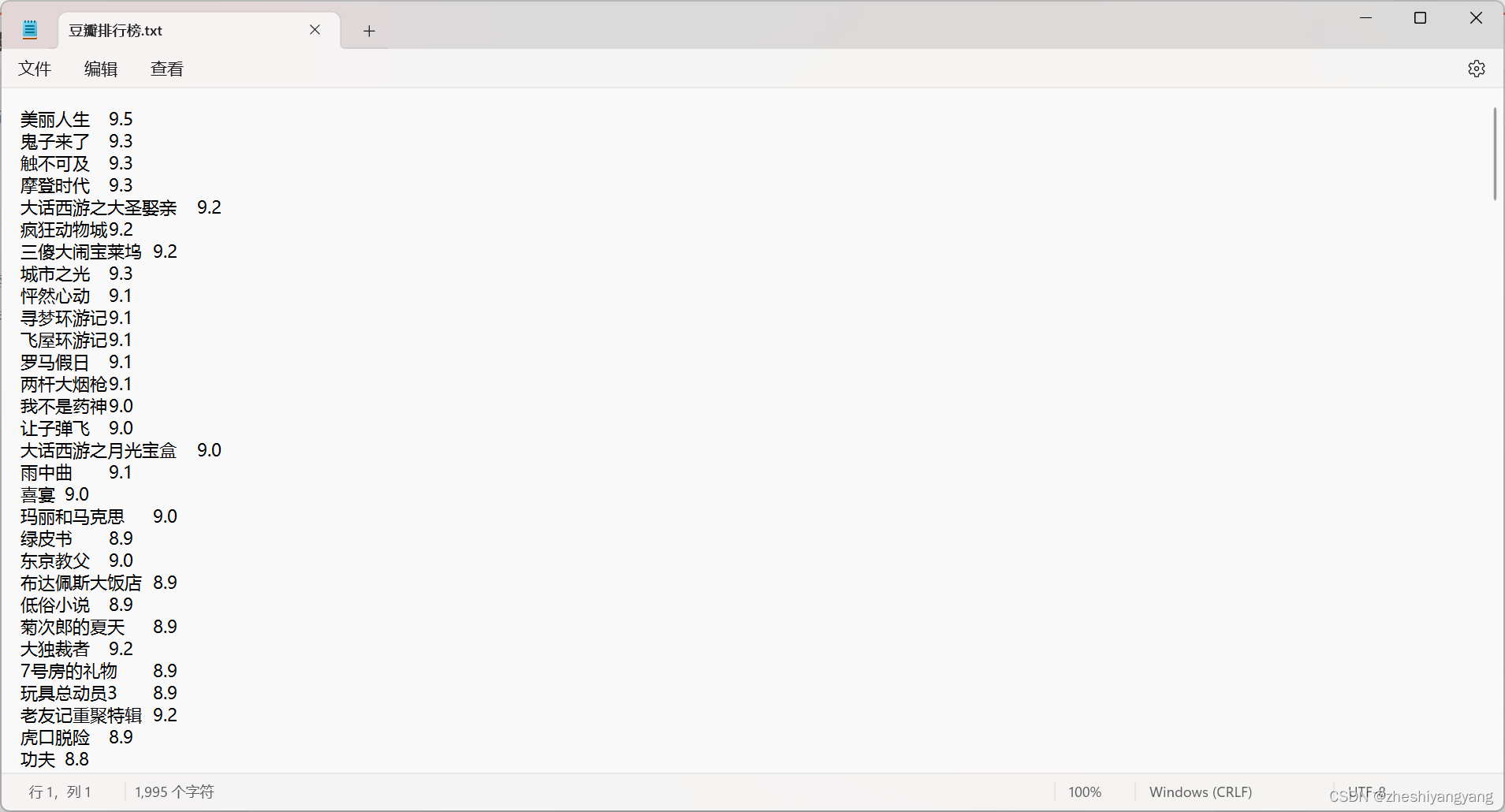

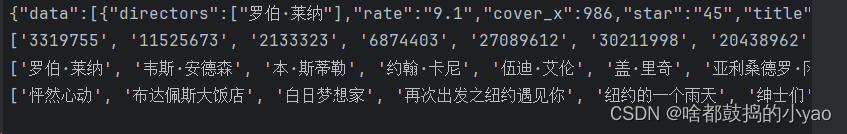

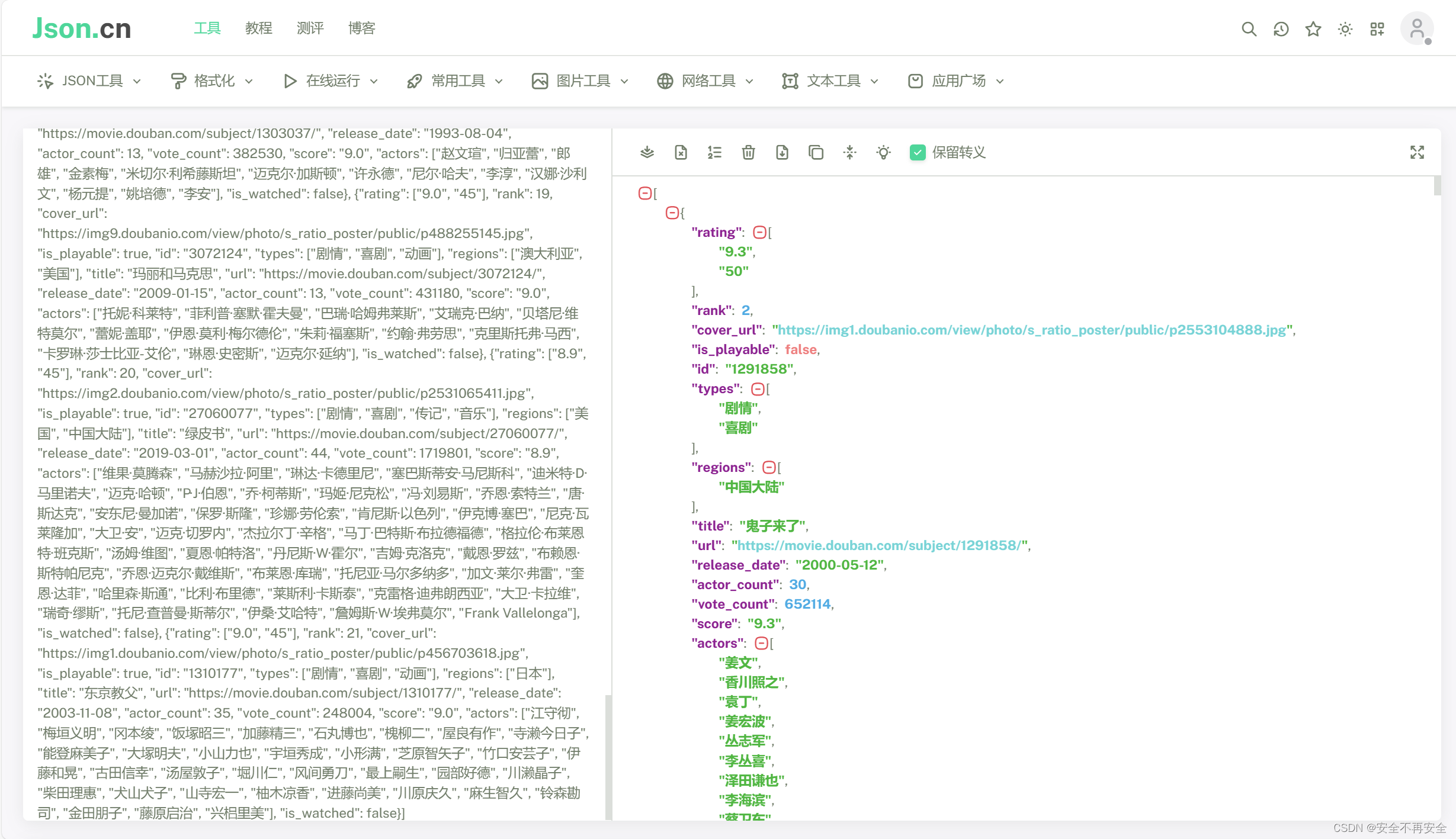

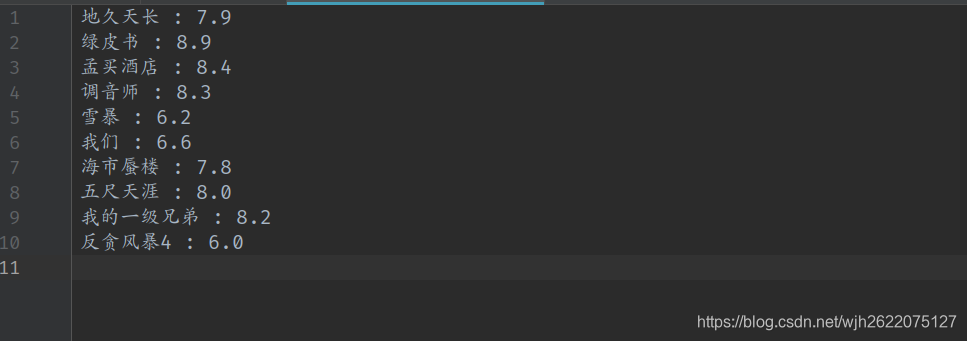

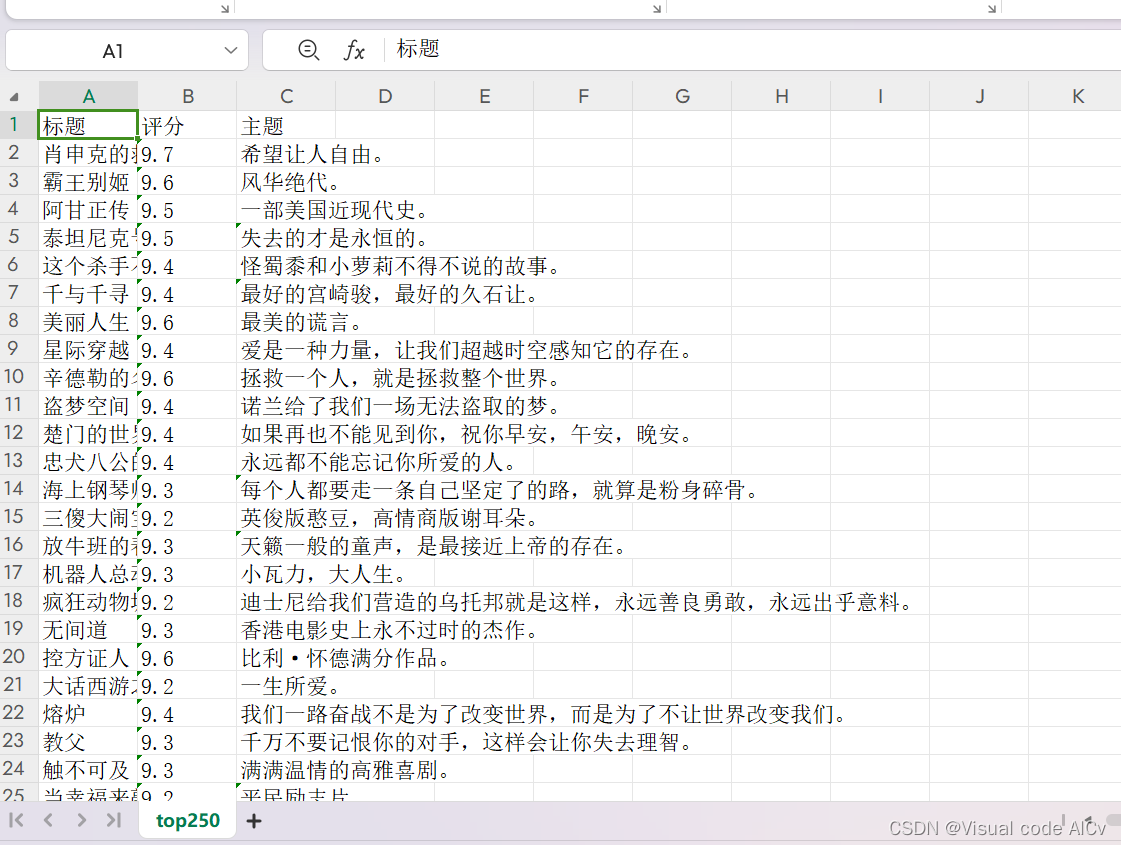

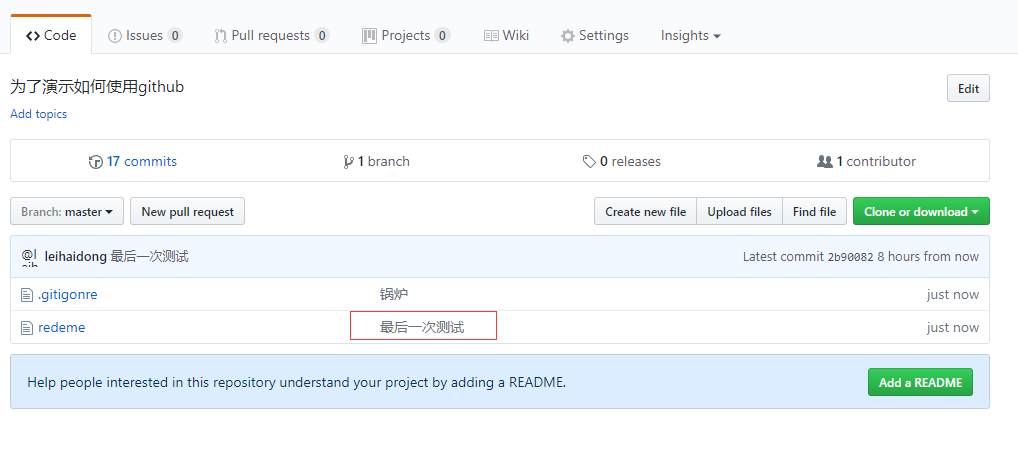

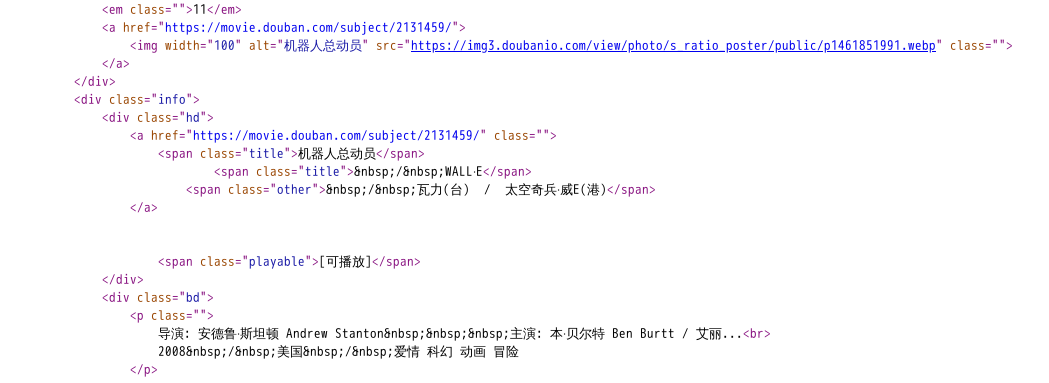

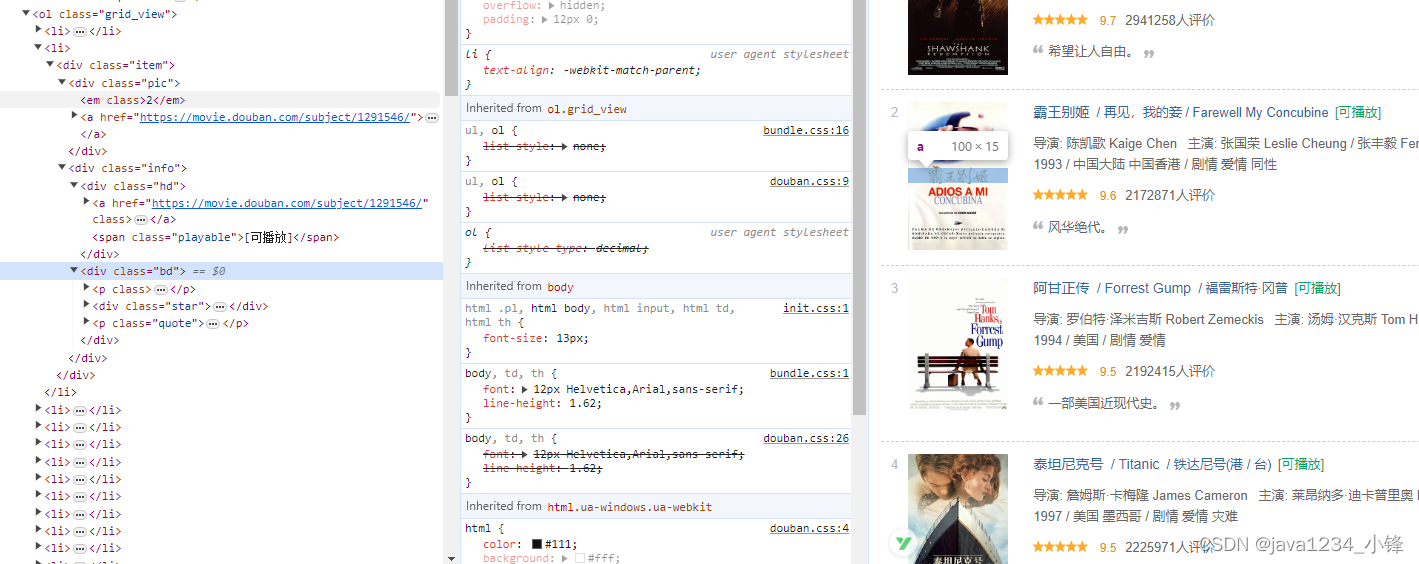

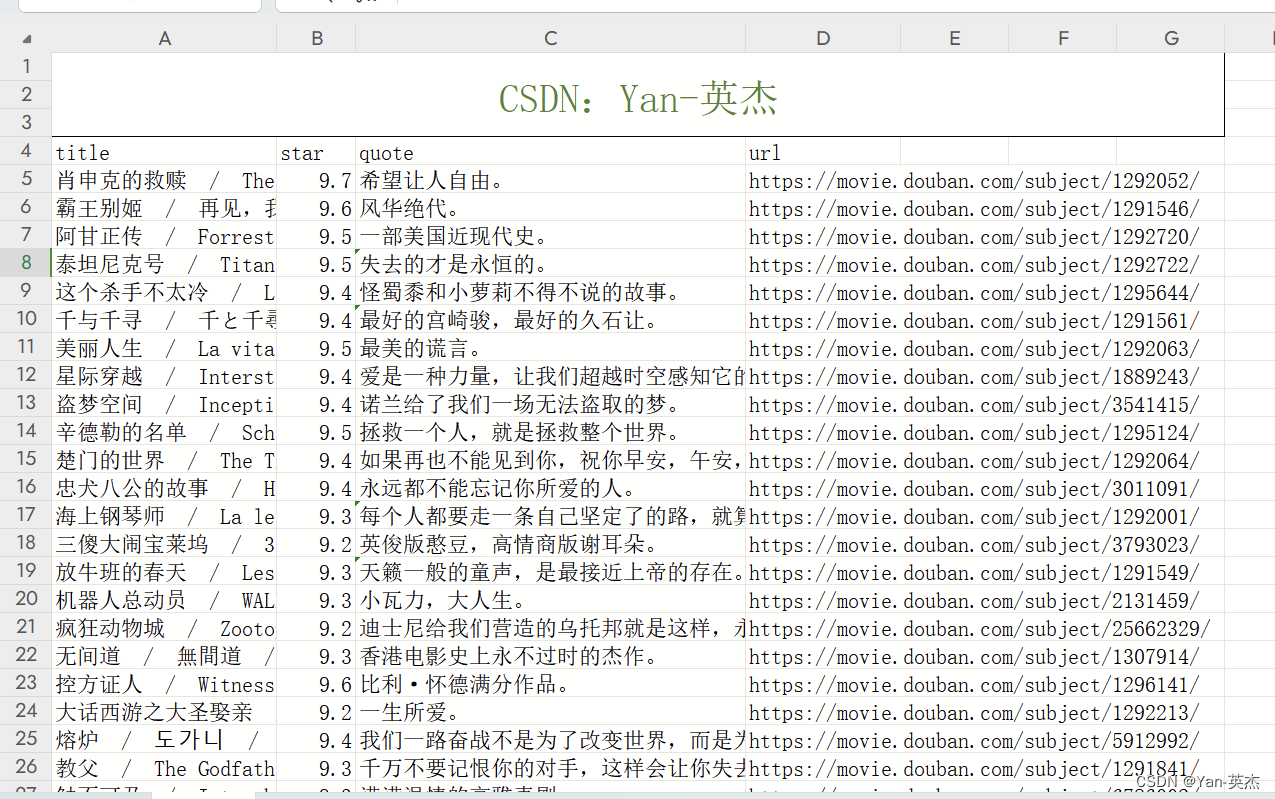

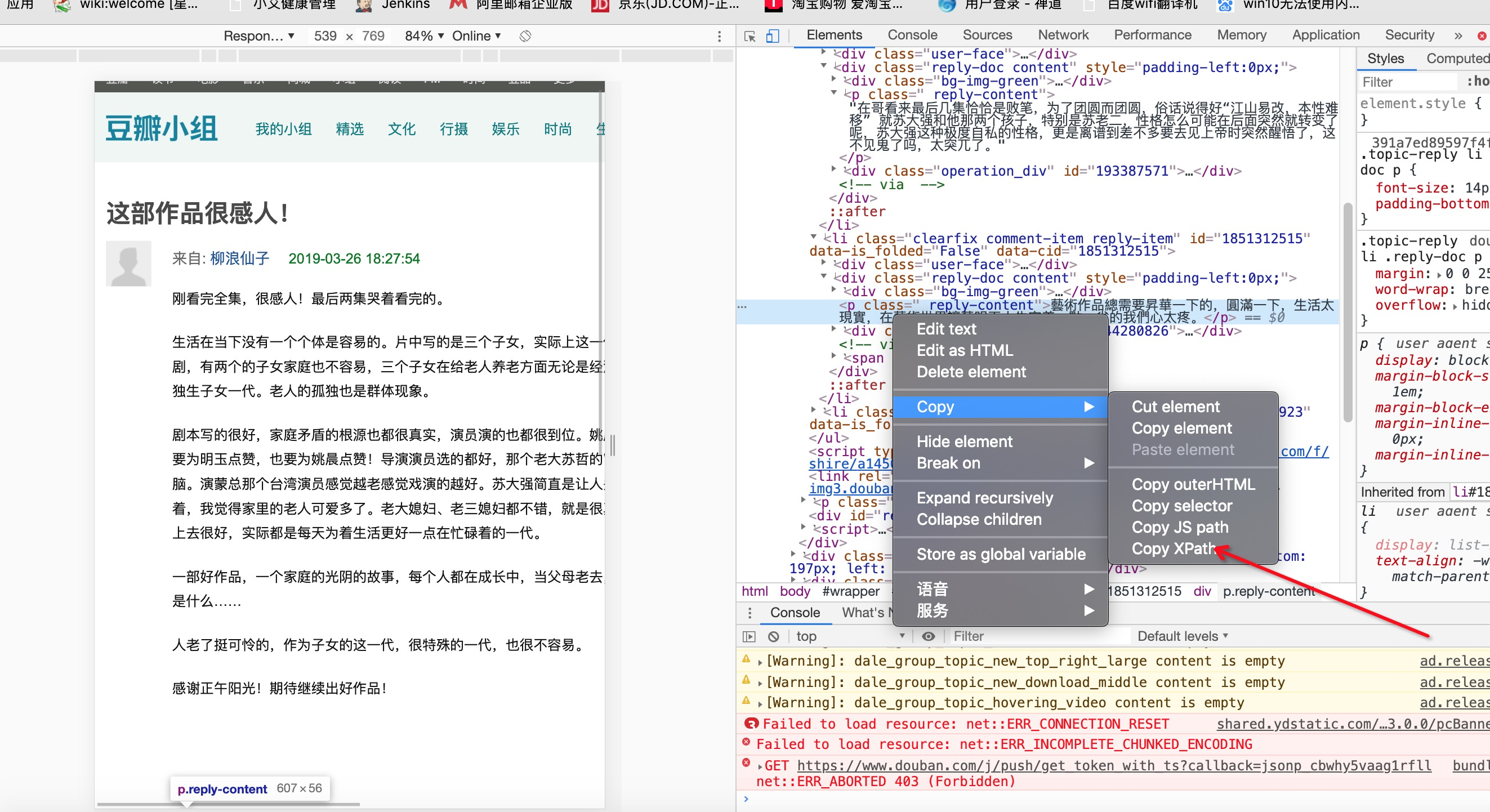

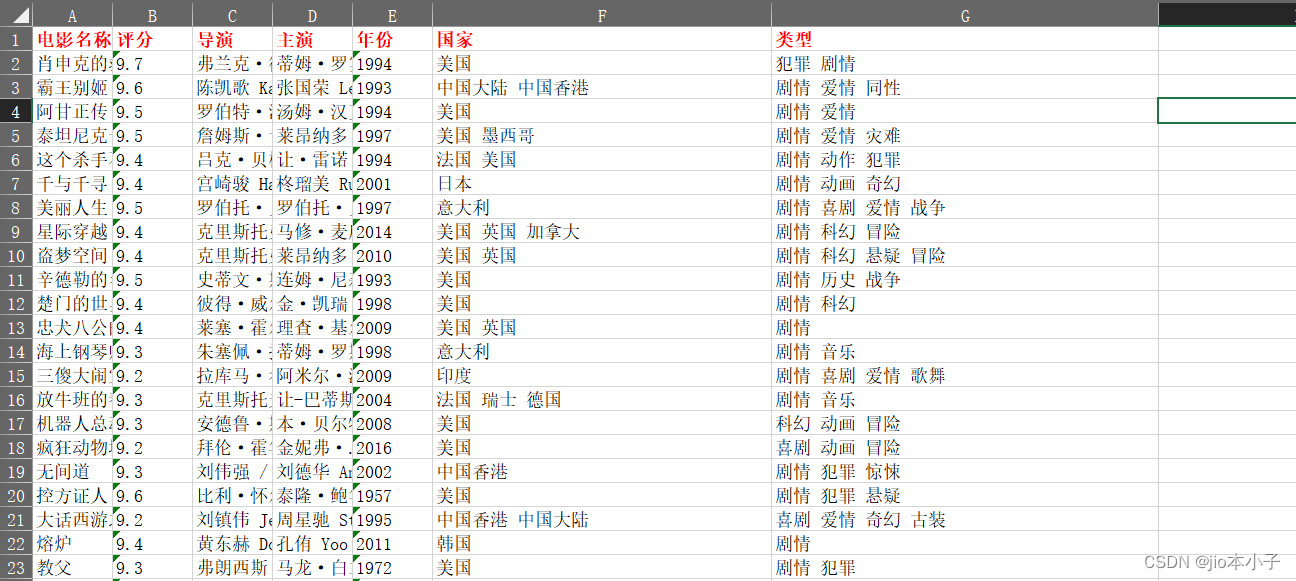

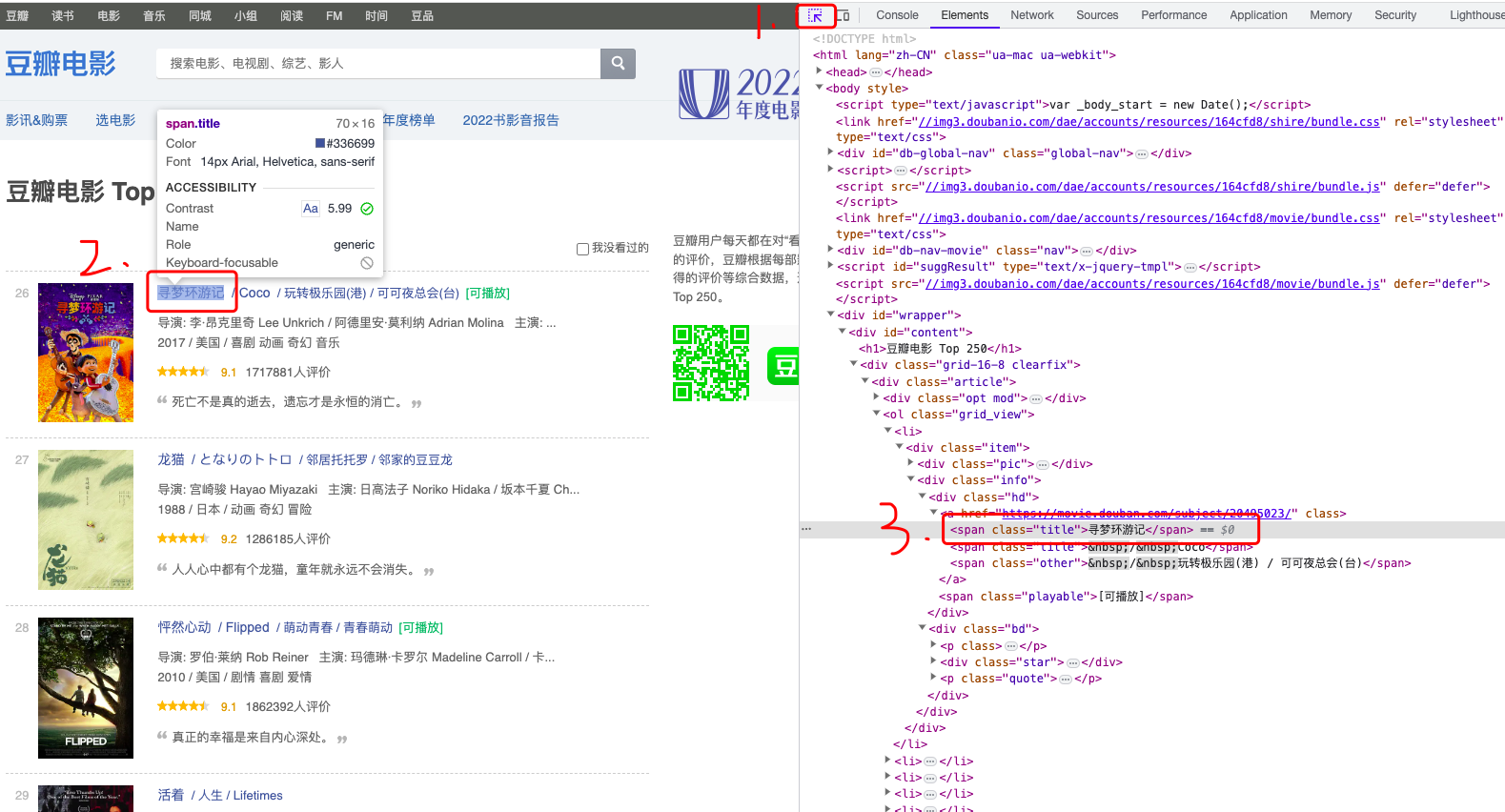

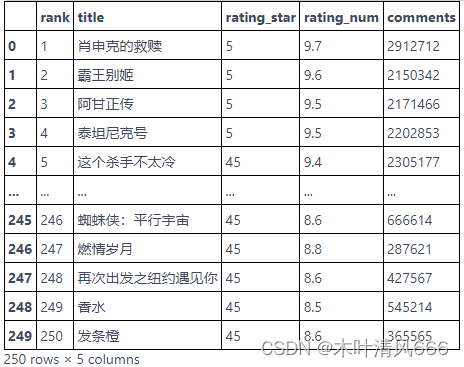

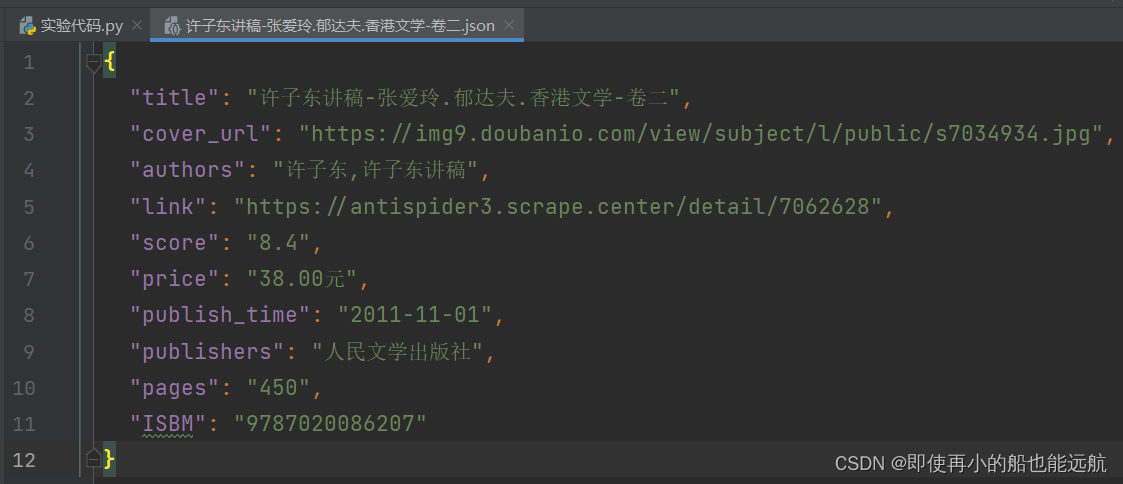

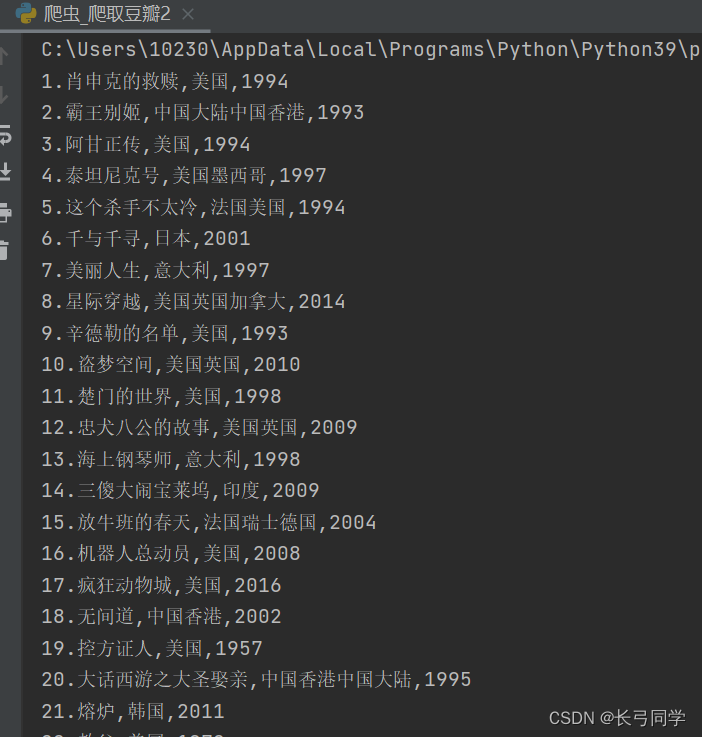

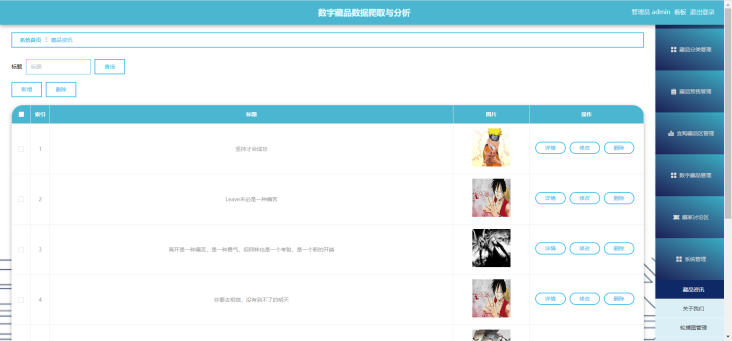

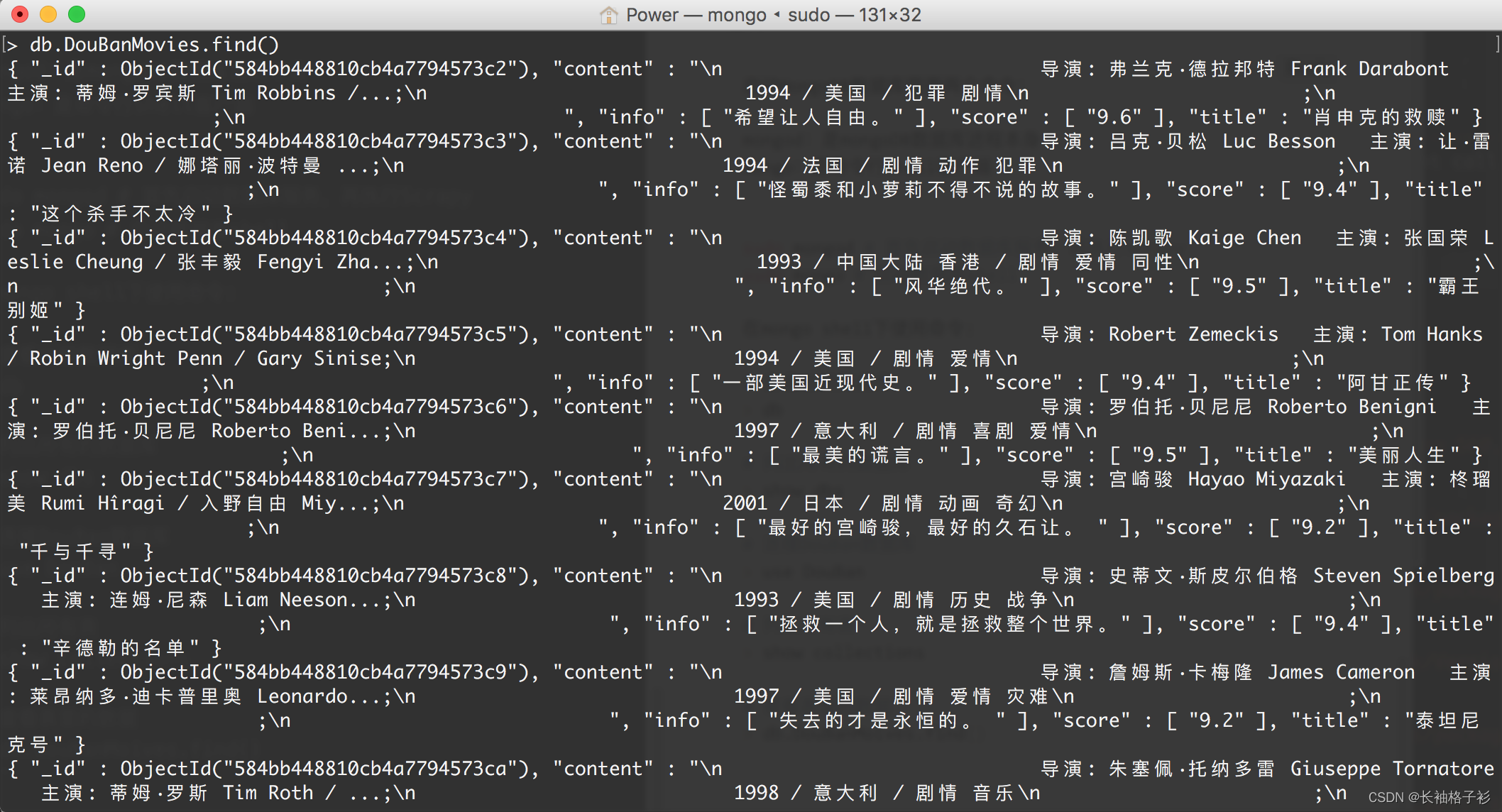

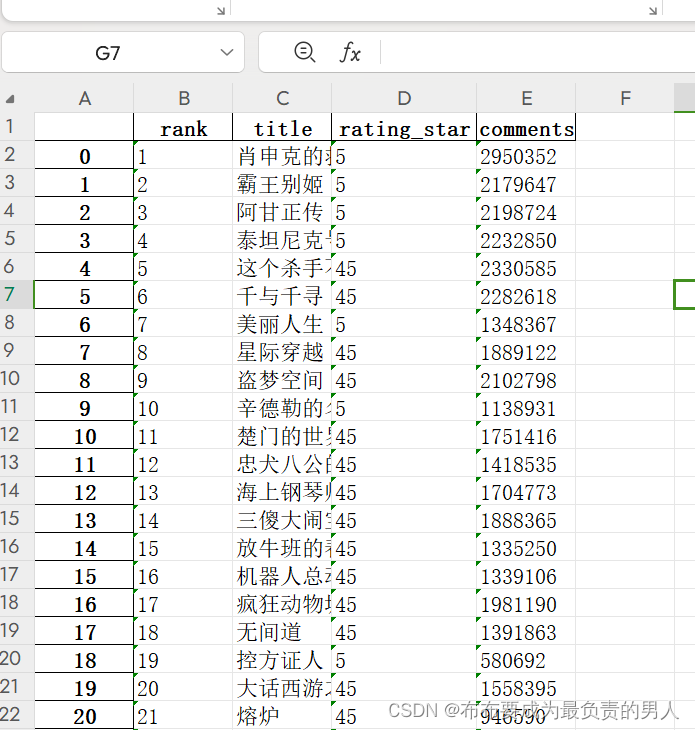

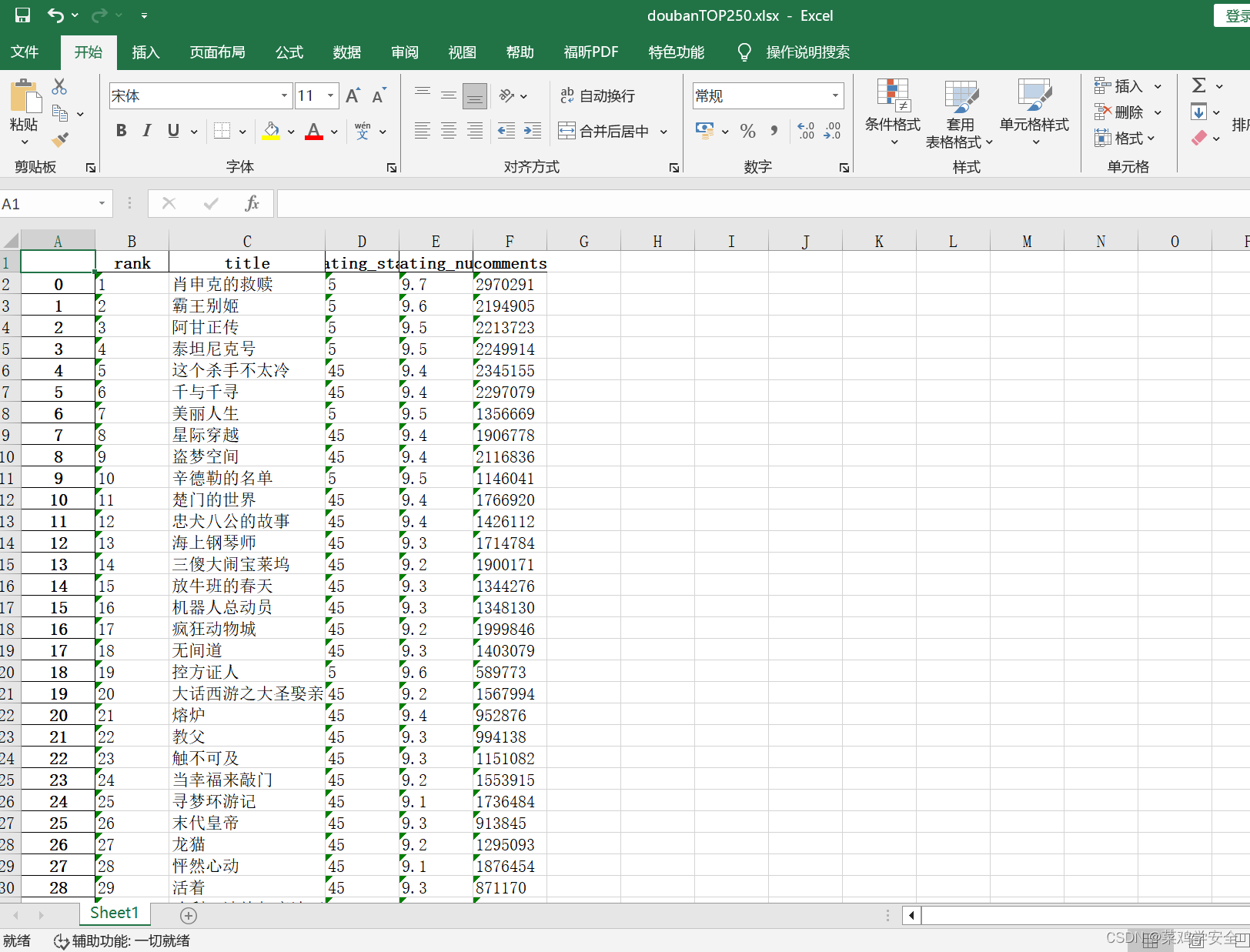

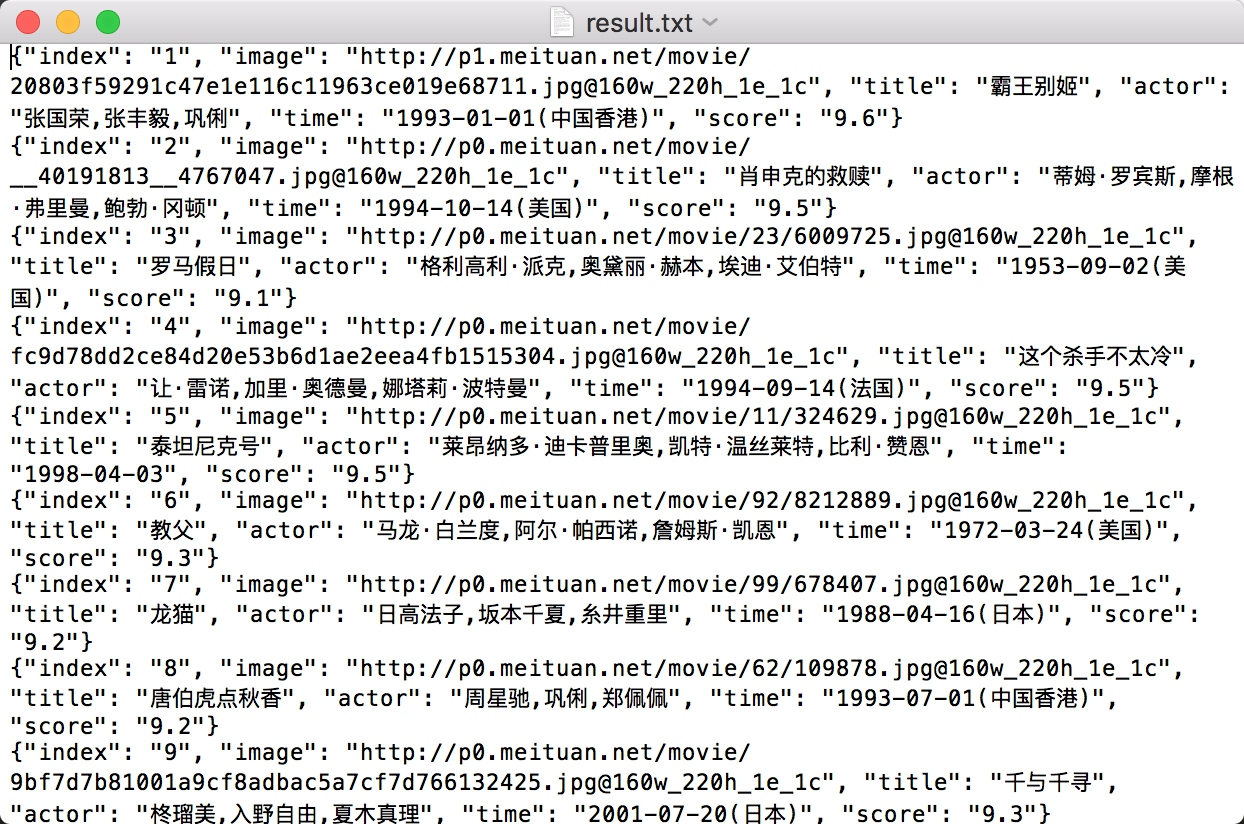

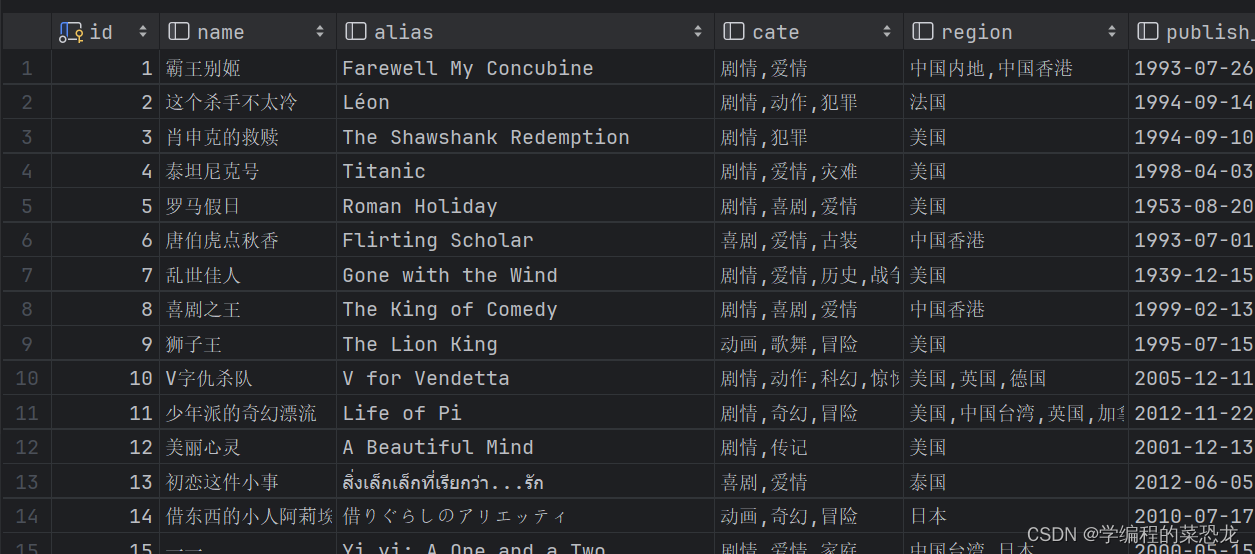

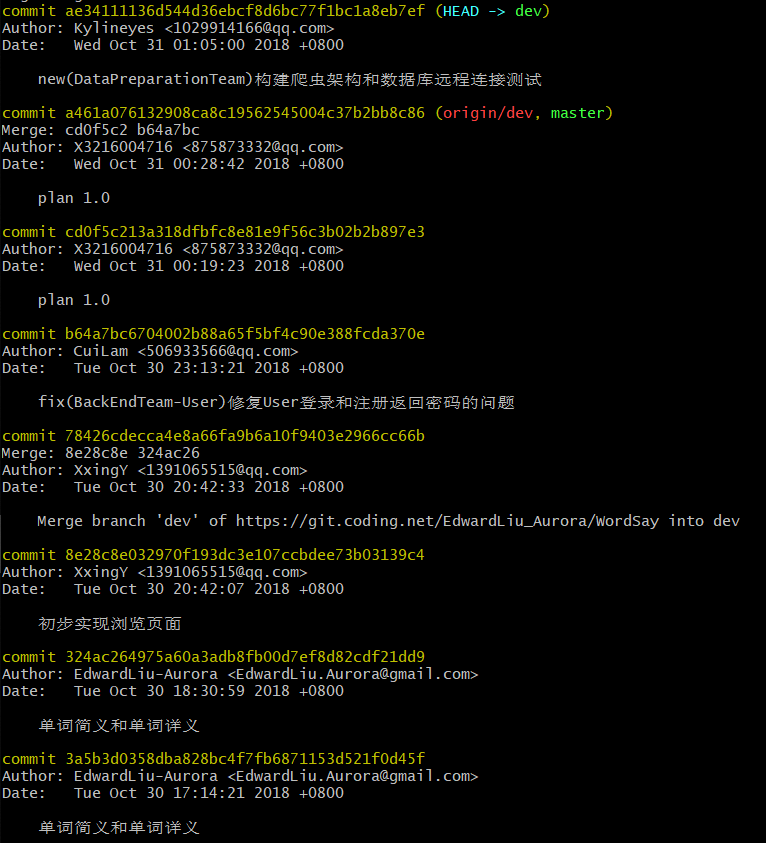

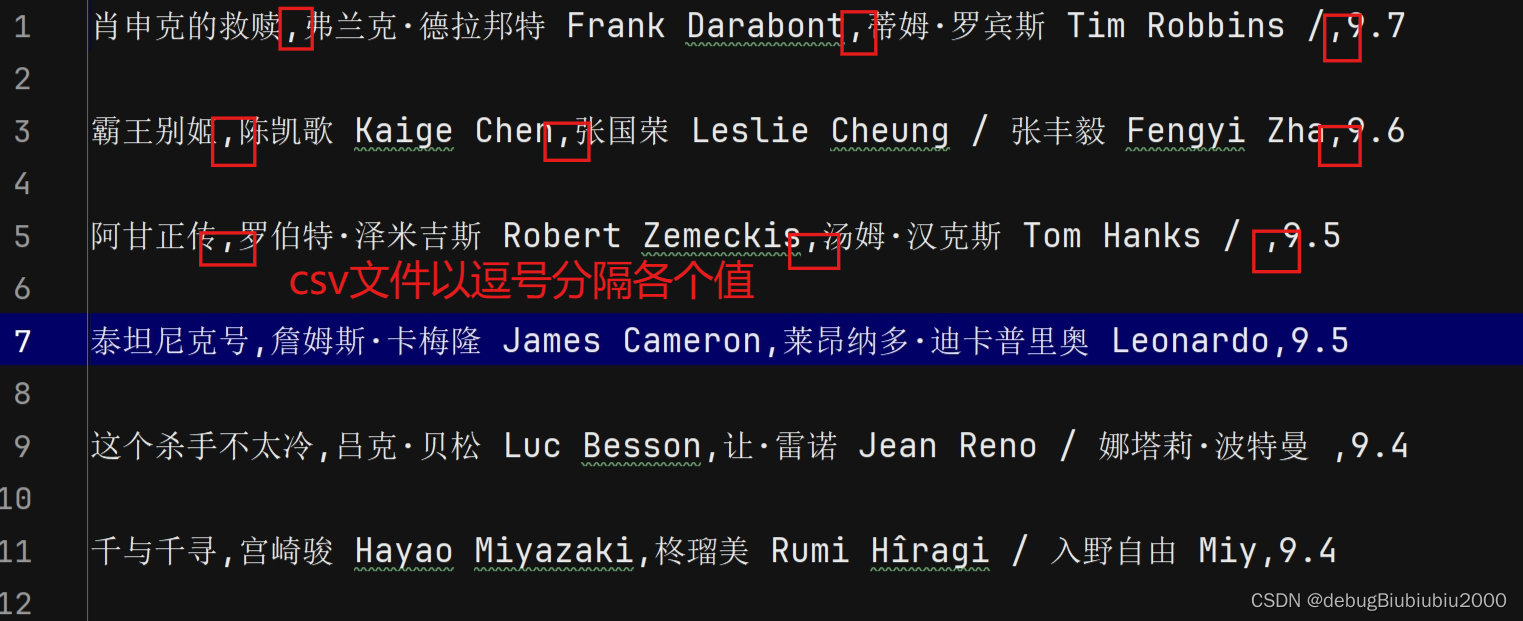

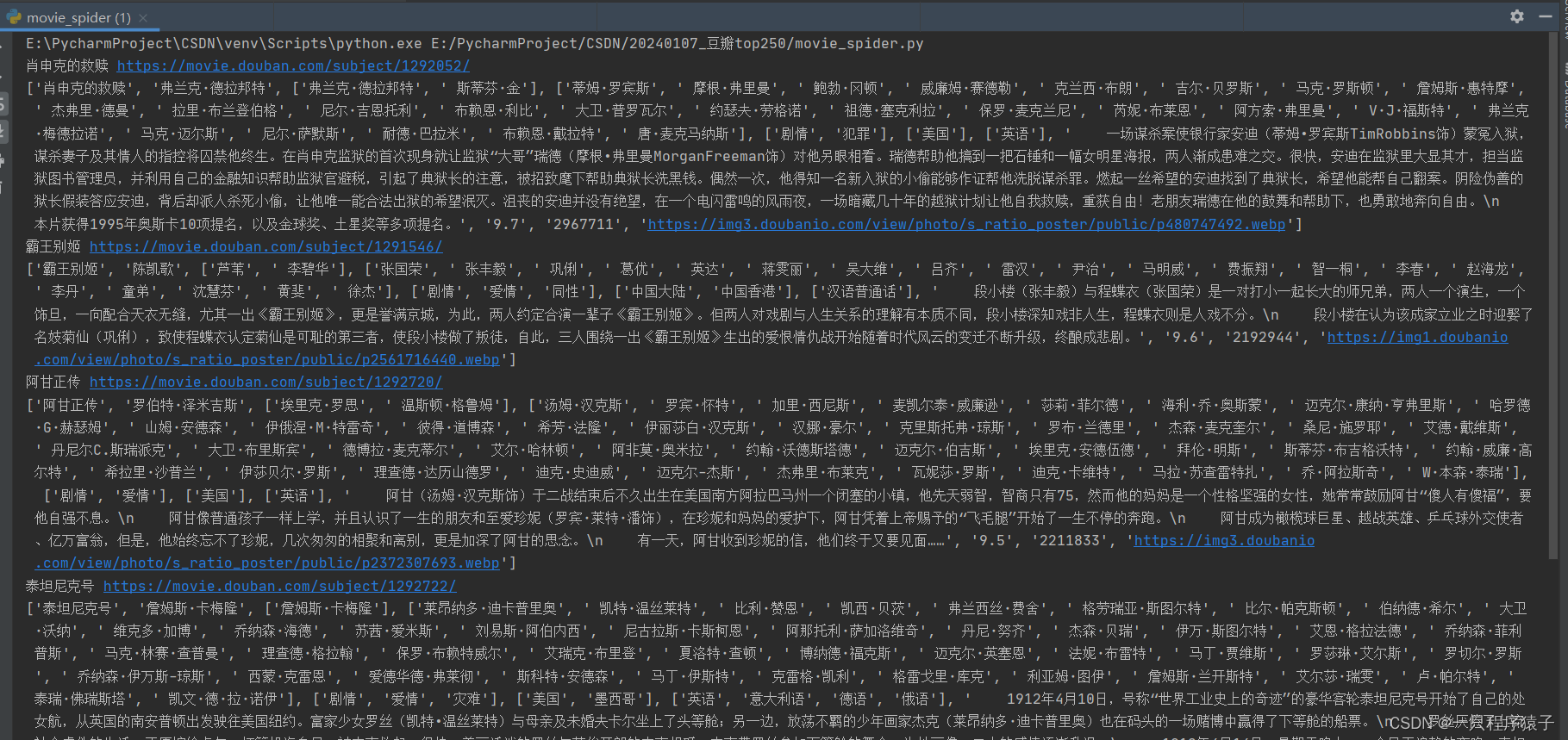

Forward团队-爬虫豆瓣top250项目-模块开发过程

项目托管平台地址:https://github.com/xyhcq/top250 我负责将爬取到的信息写入到文件中。 首先,先打开一个文件 # 打开文件

fopen("top250.txt","w") 然后在别的队员写的能够爬取出信息的代码上,加入将信息写入文件的的代码 def ge…

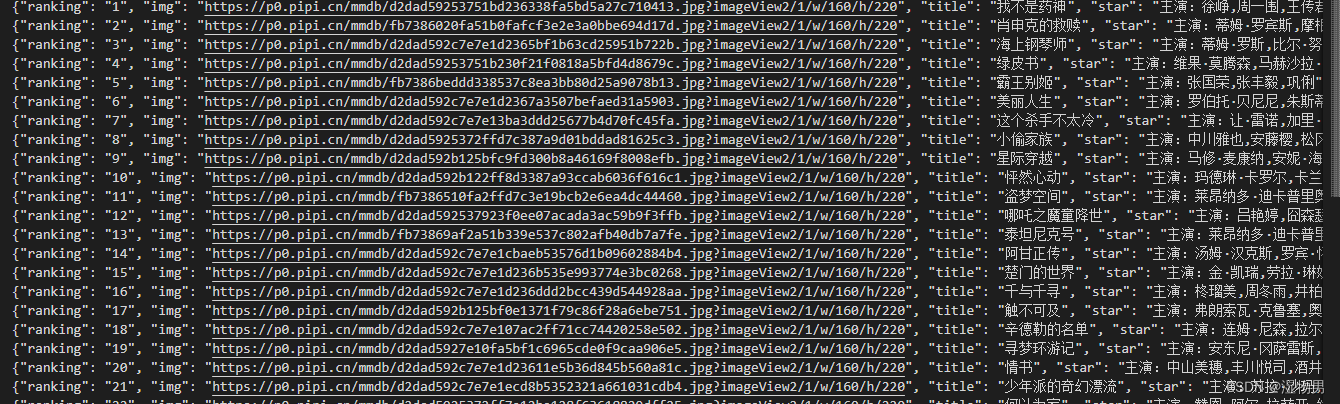

python爬虫拿出json数据

我说的是拿到的json数据: 将字符串转为字典的形式: json_str json.loads(name1) #变为字典类型之后按照字典的匹配方式,一层一层进去匹配 time_data json_str[result] 这是根据字典的额键值对来进行匹配的!转载于:https://ww…

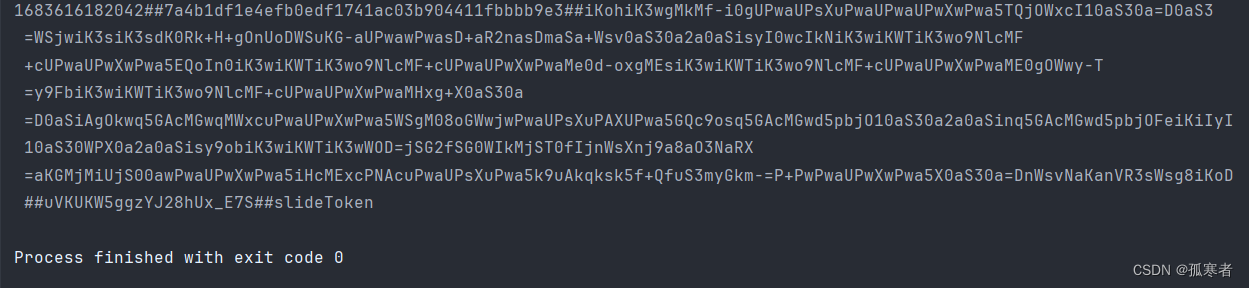

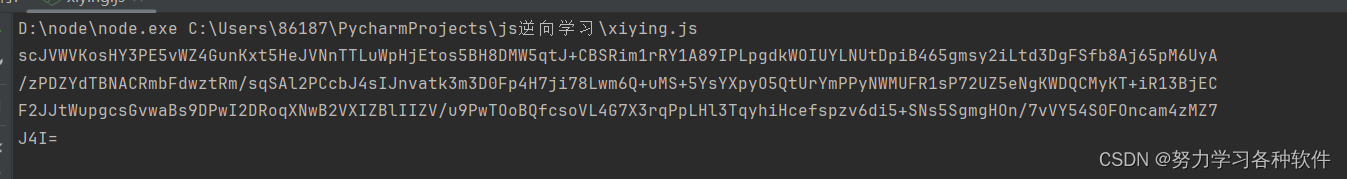

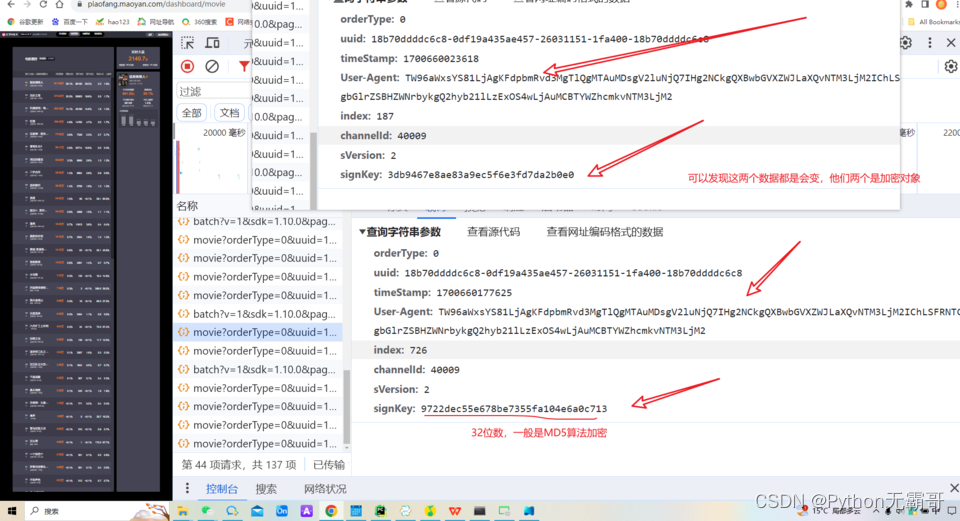

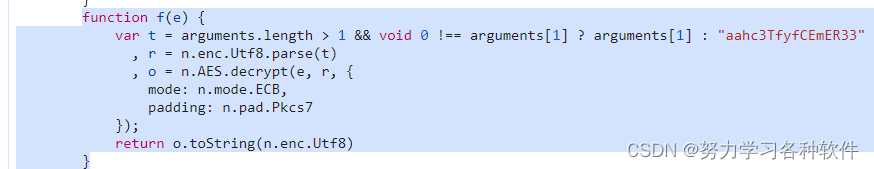

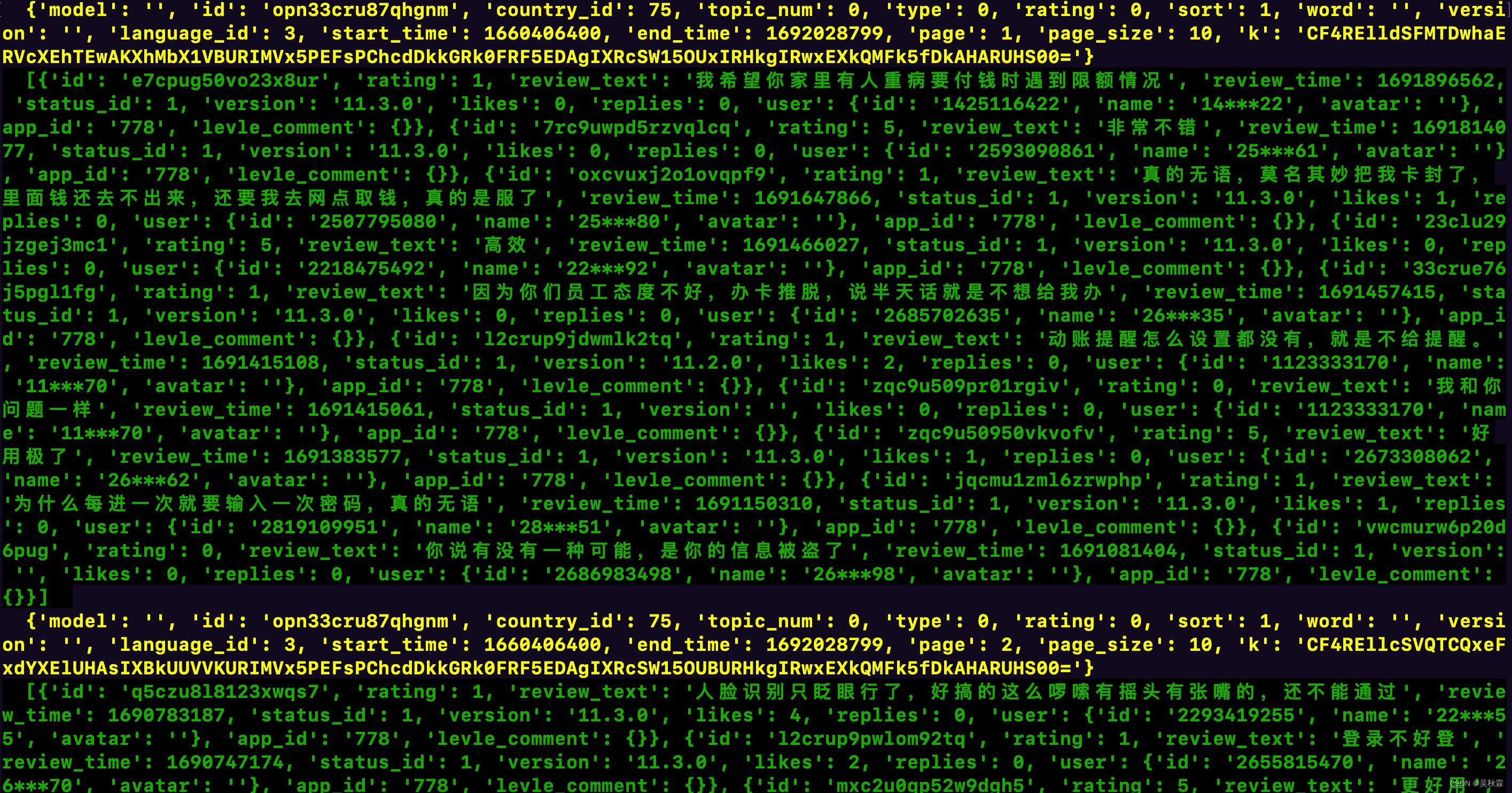

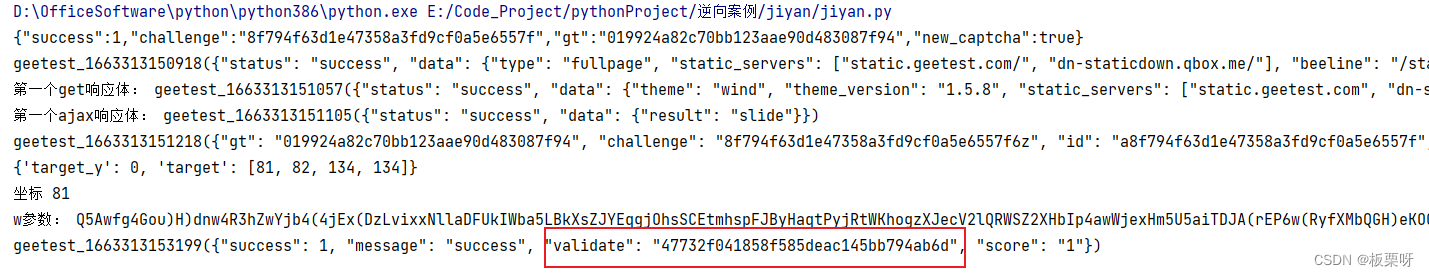

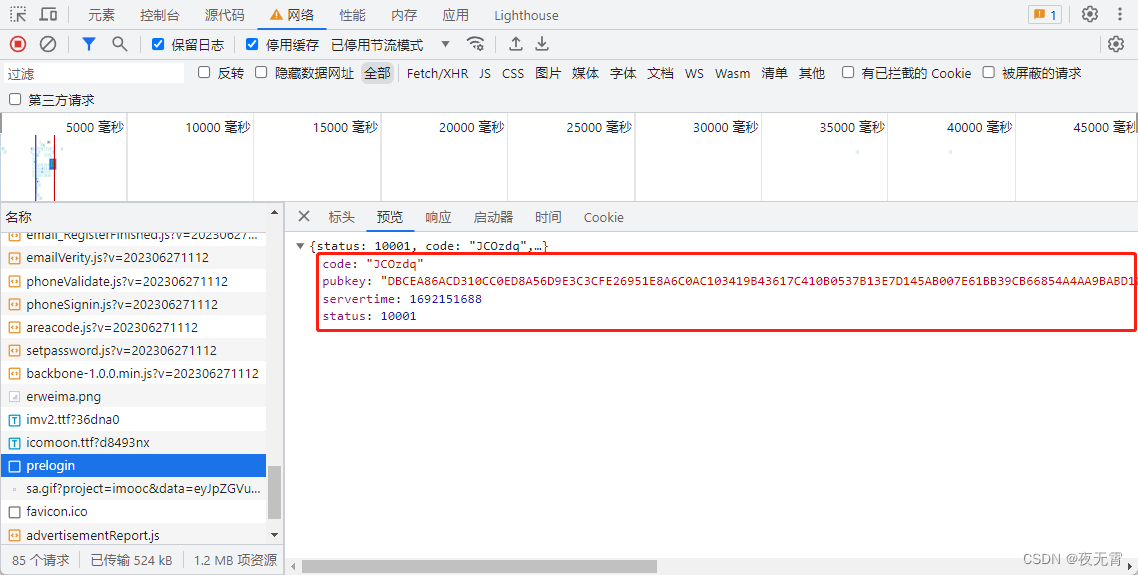

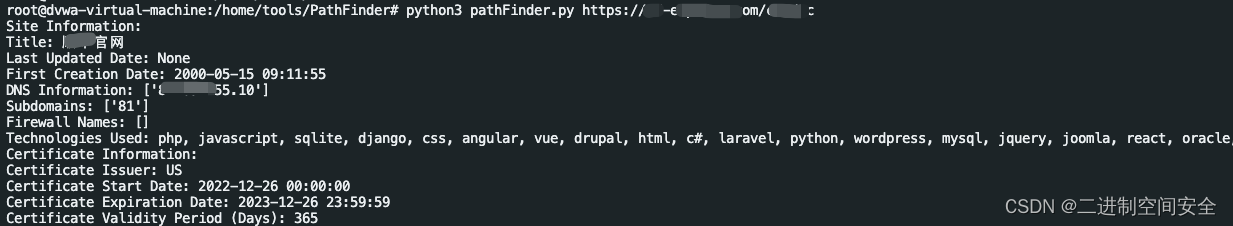

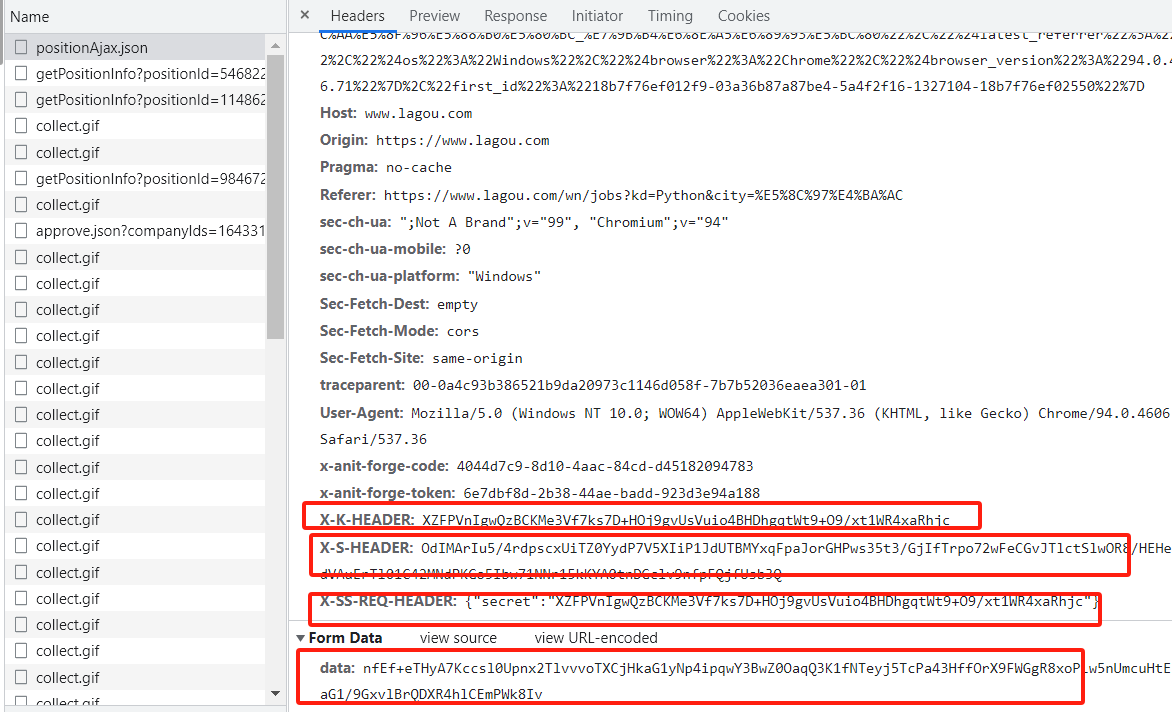

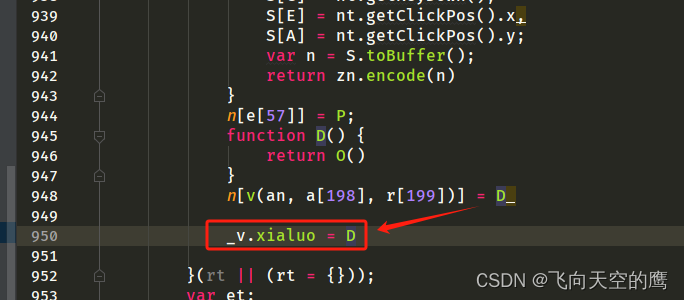

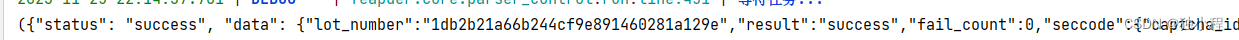

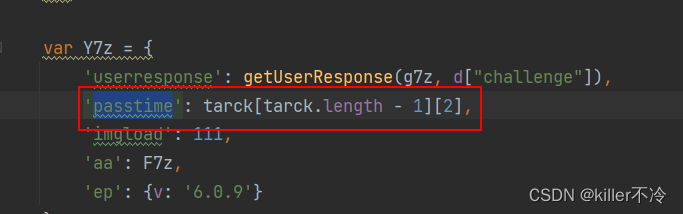

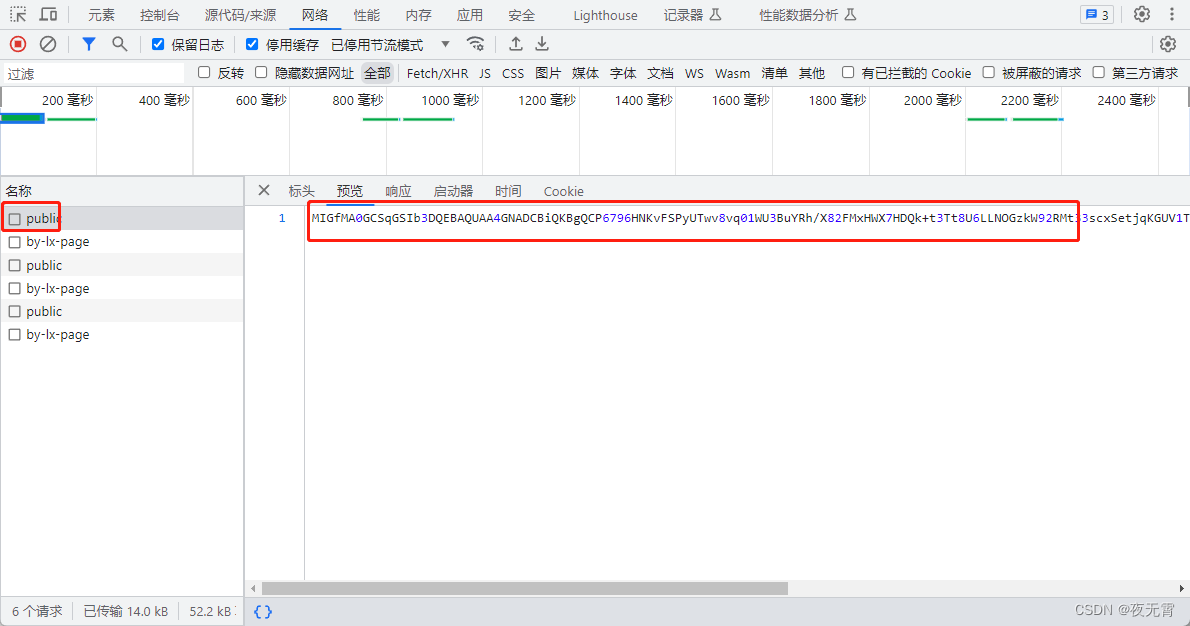

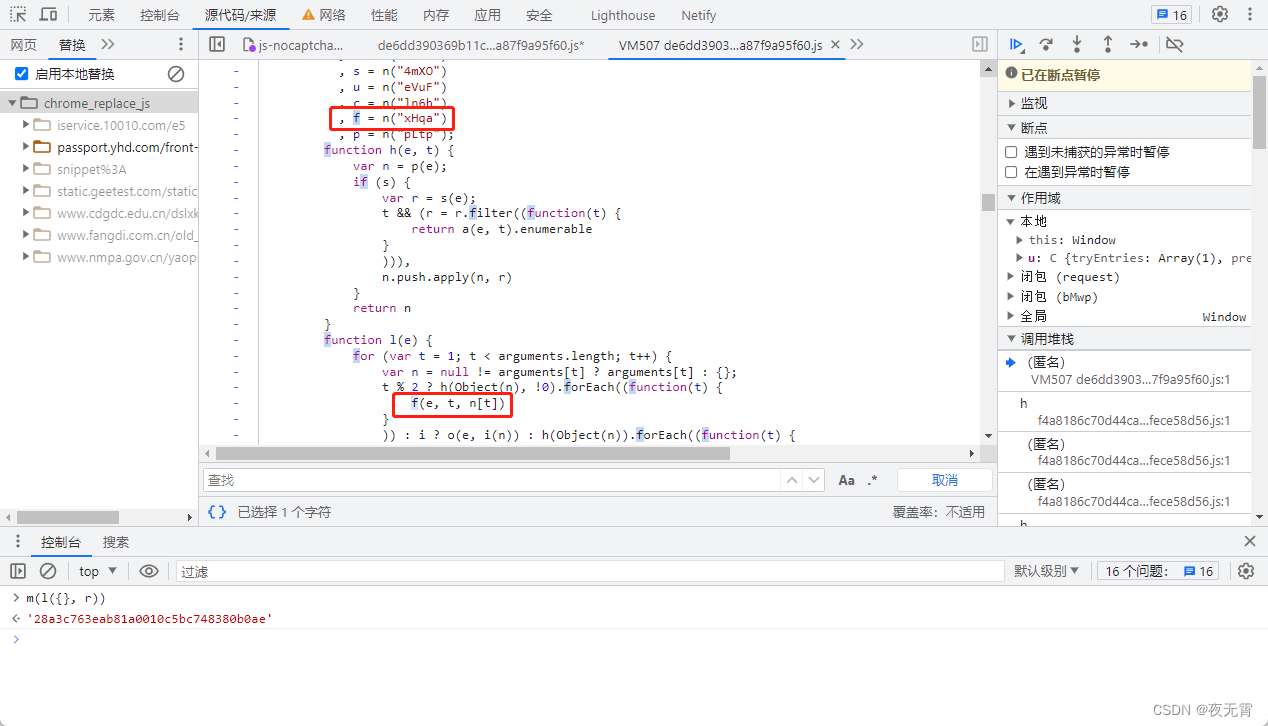

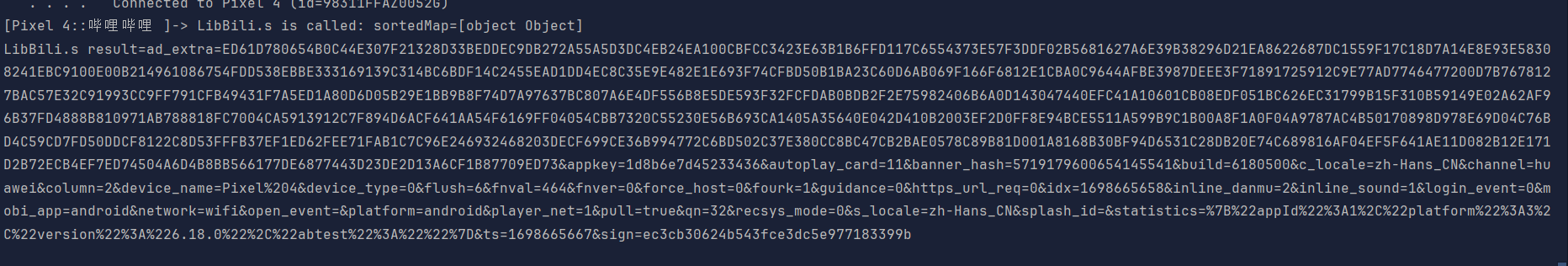

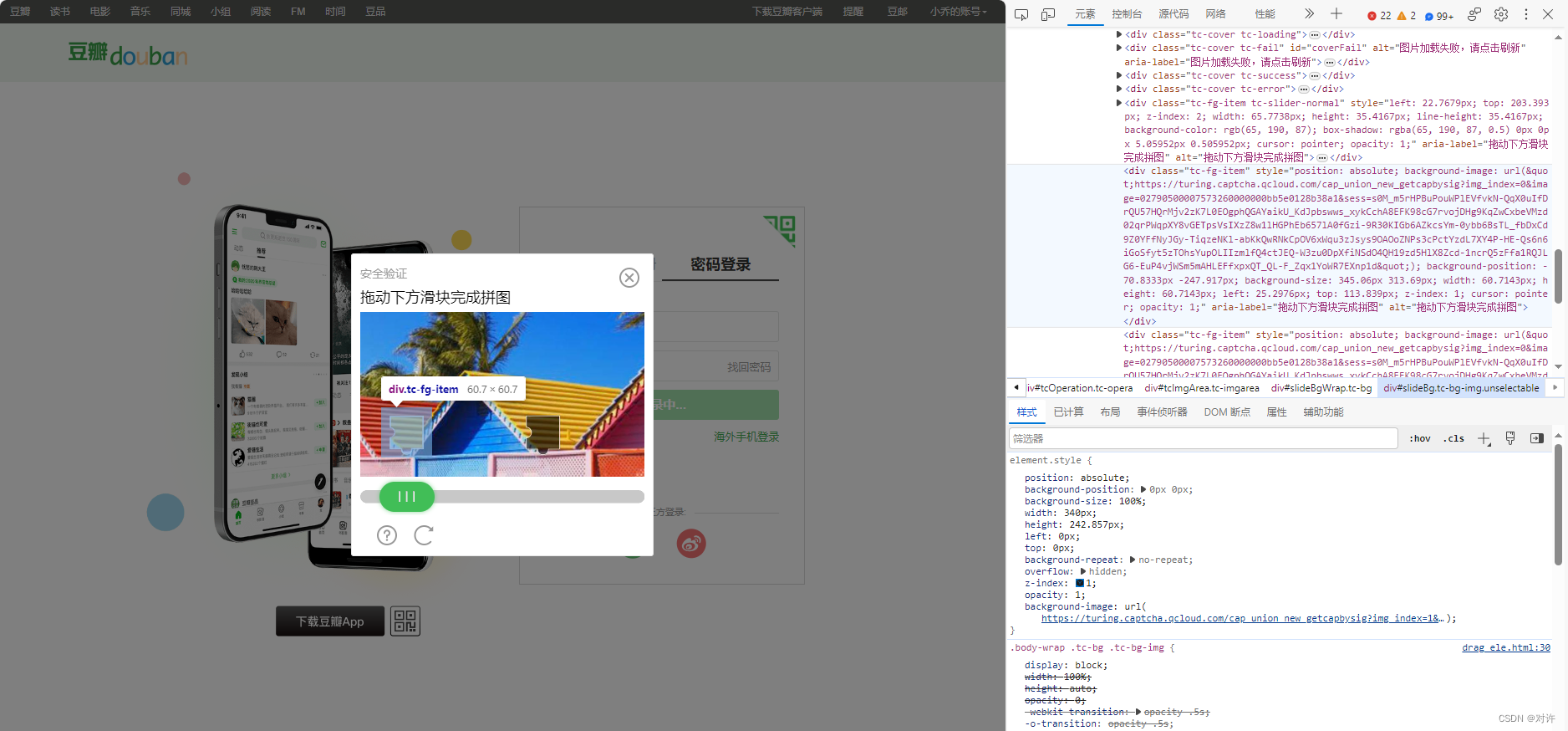

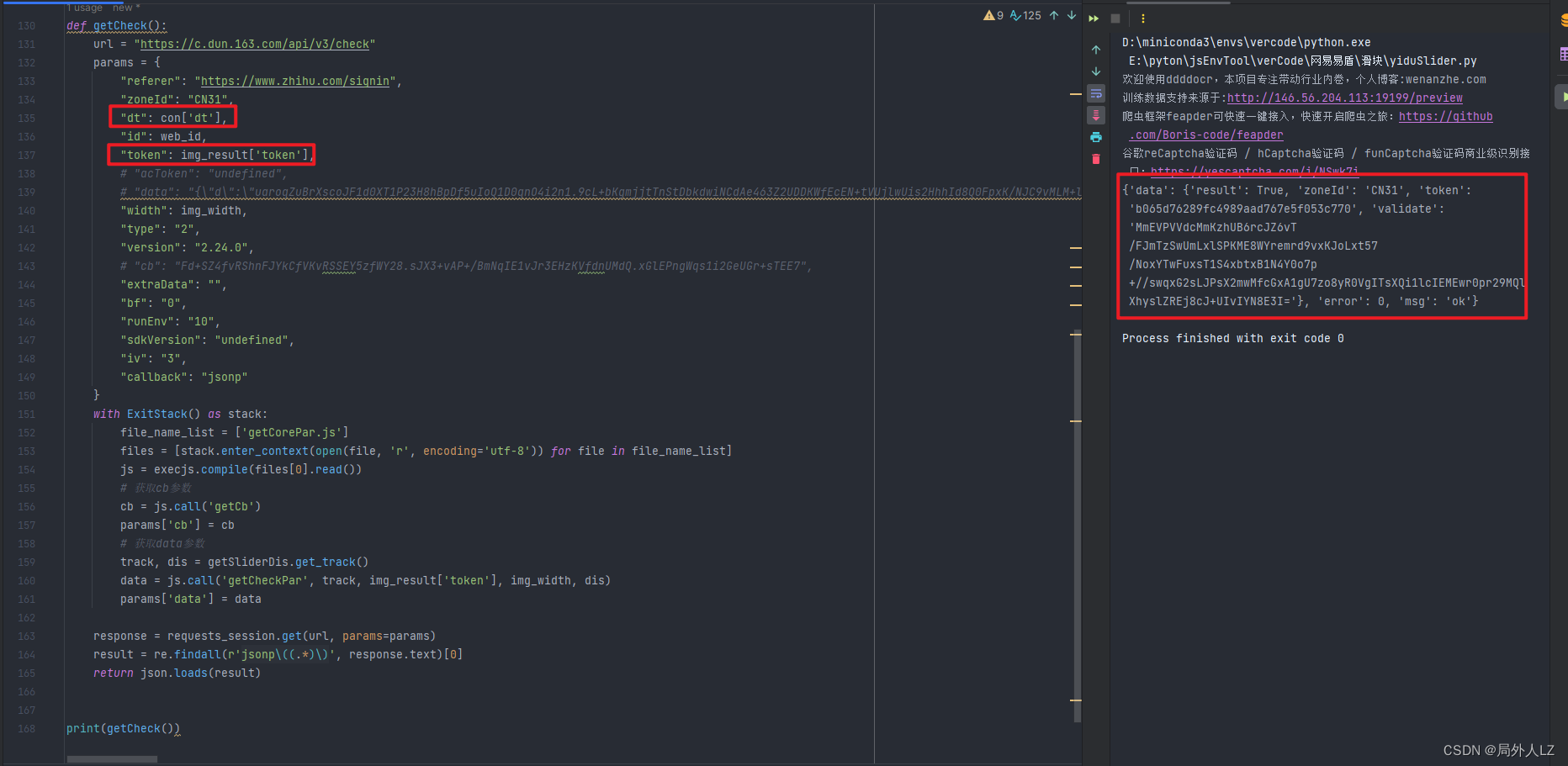

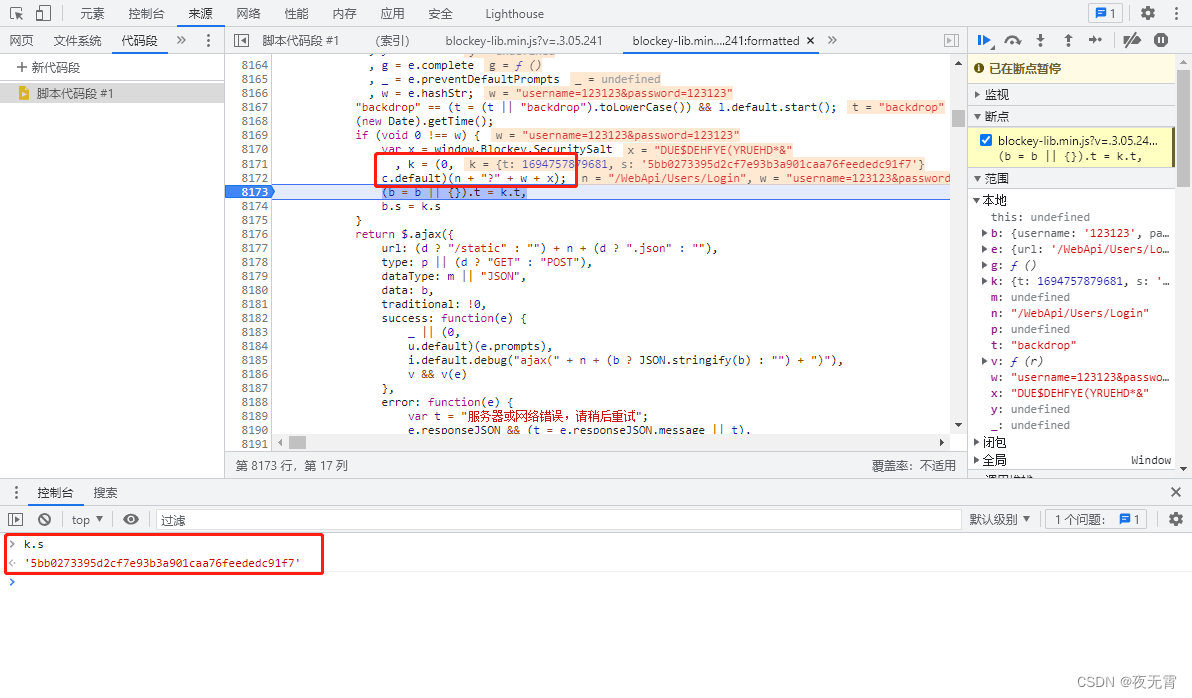

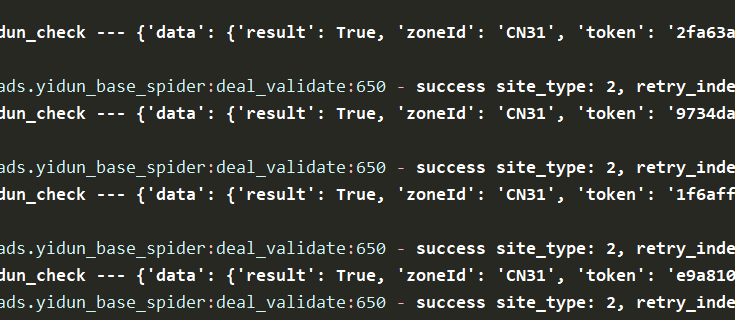

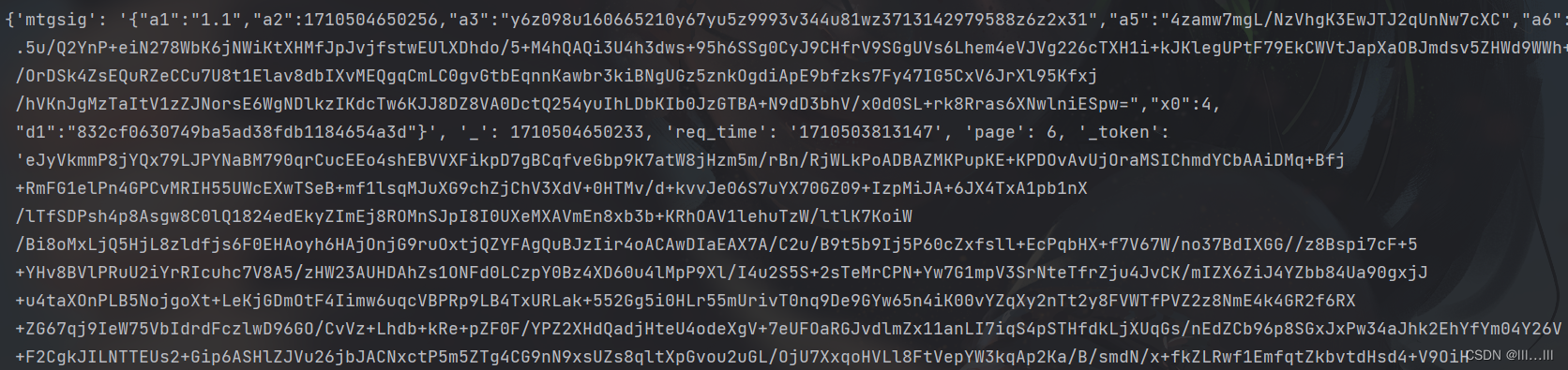

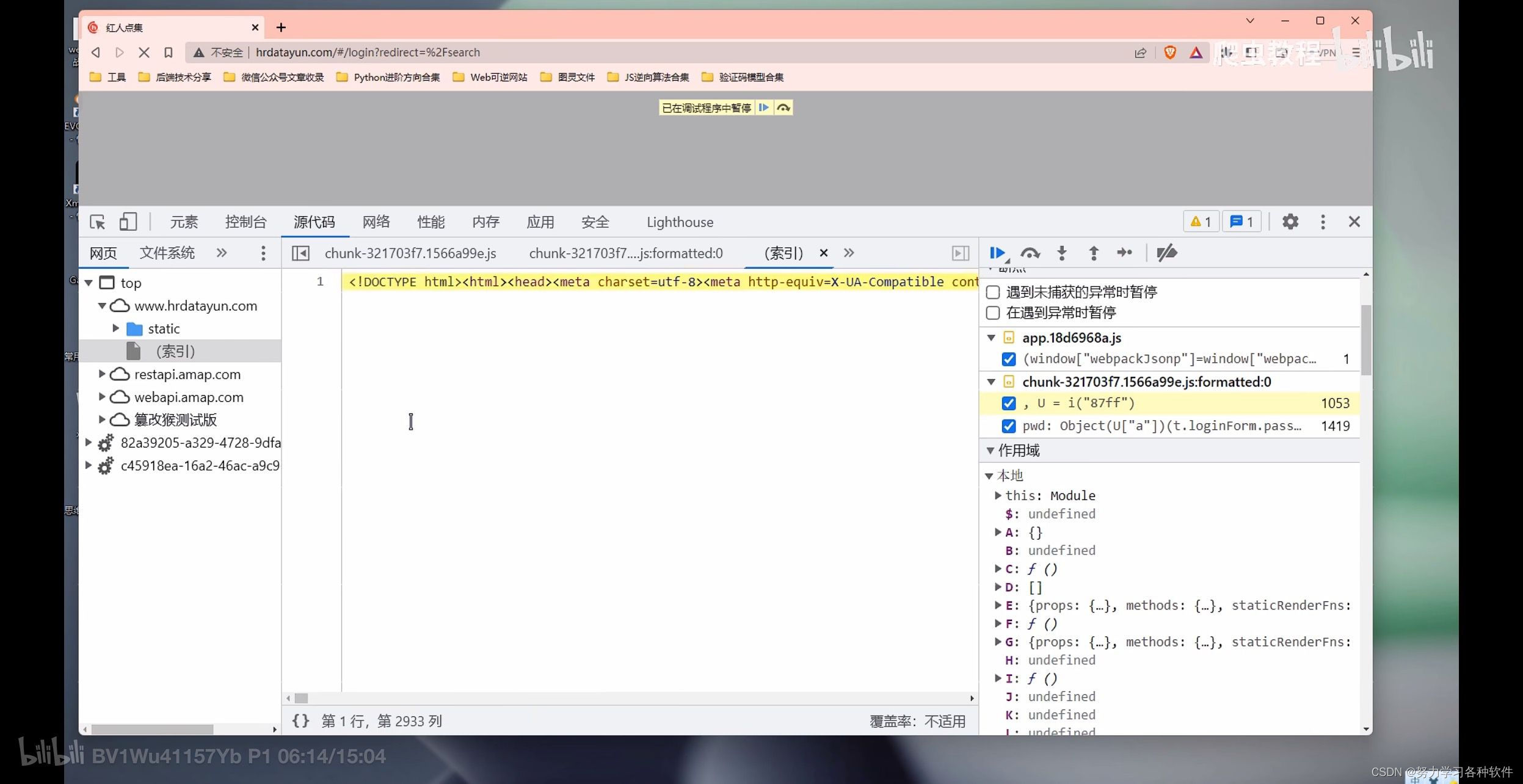

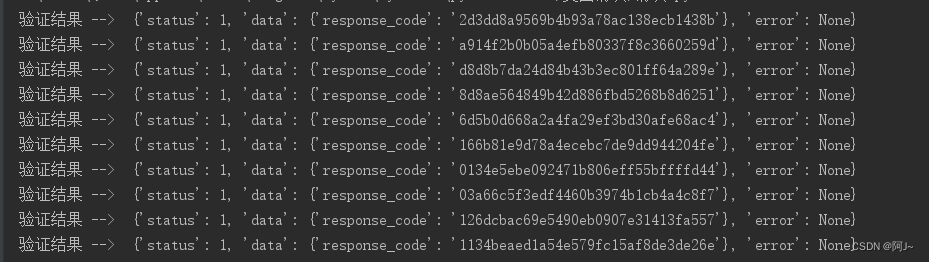

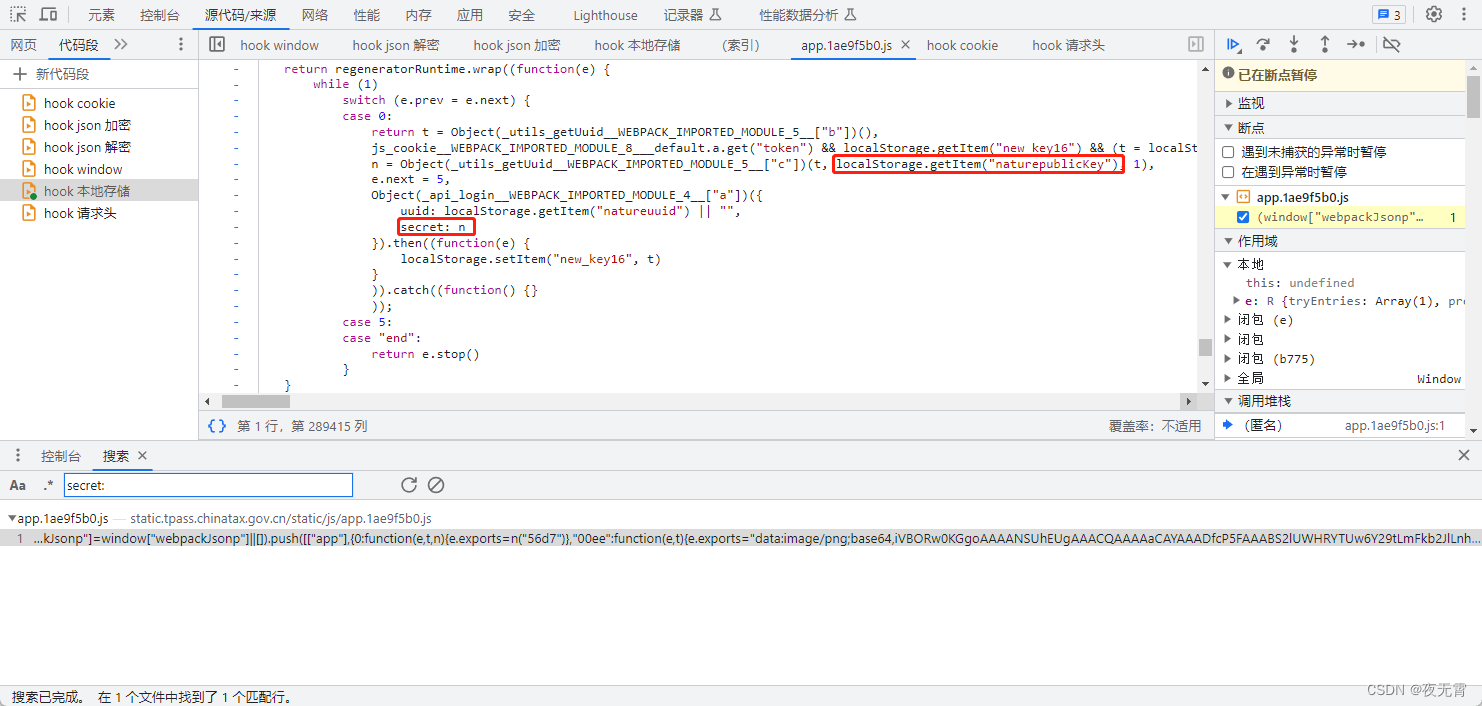

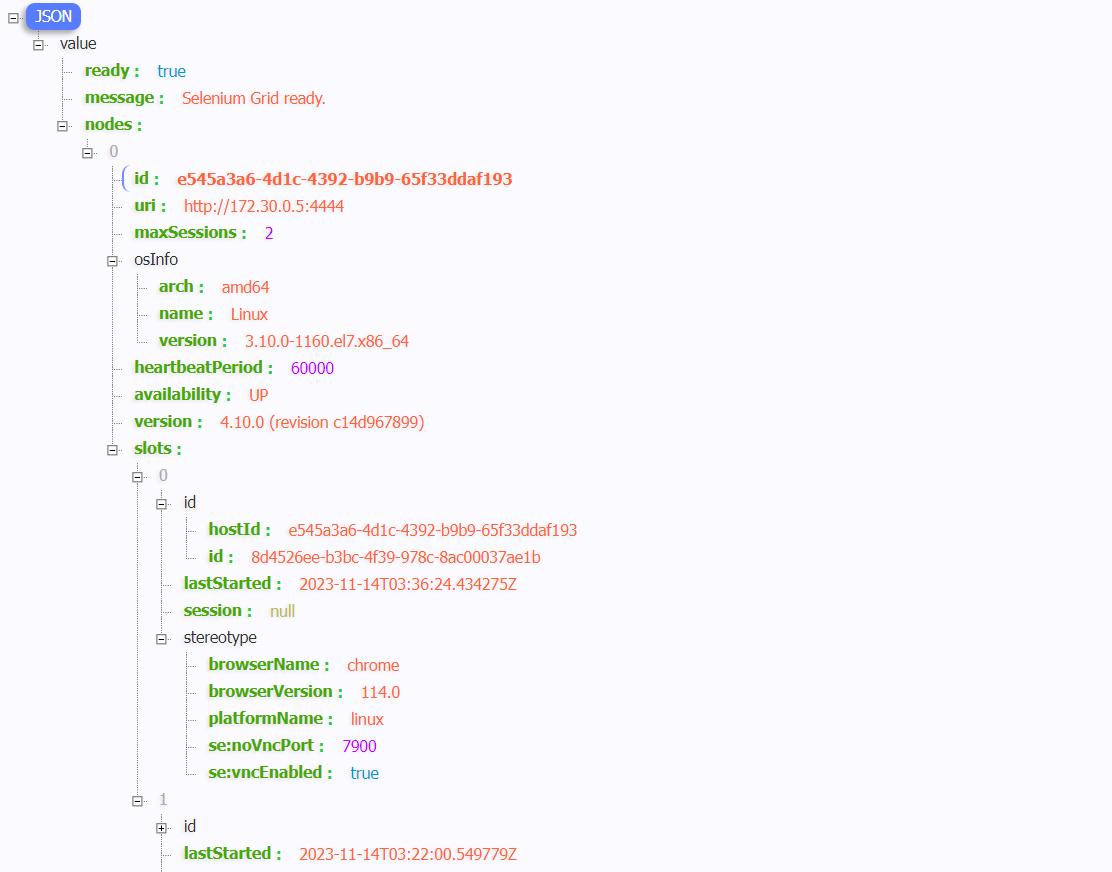

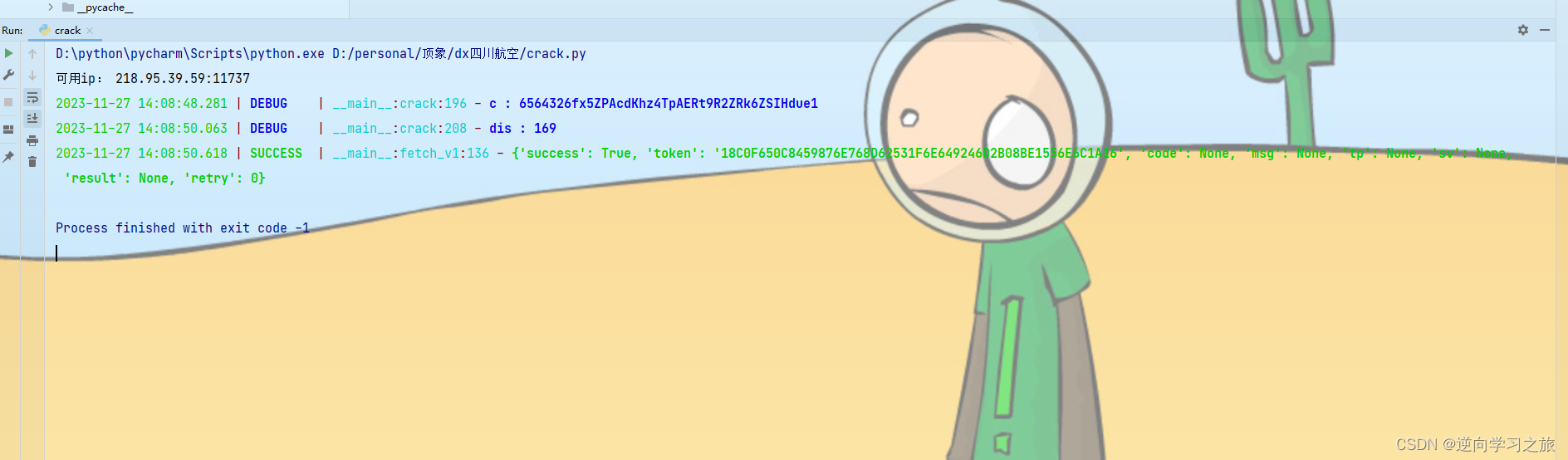

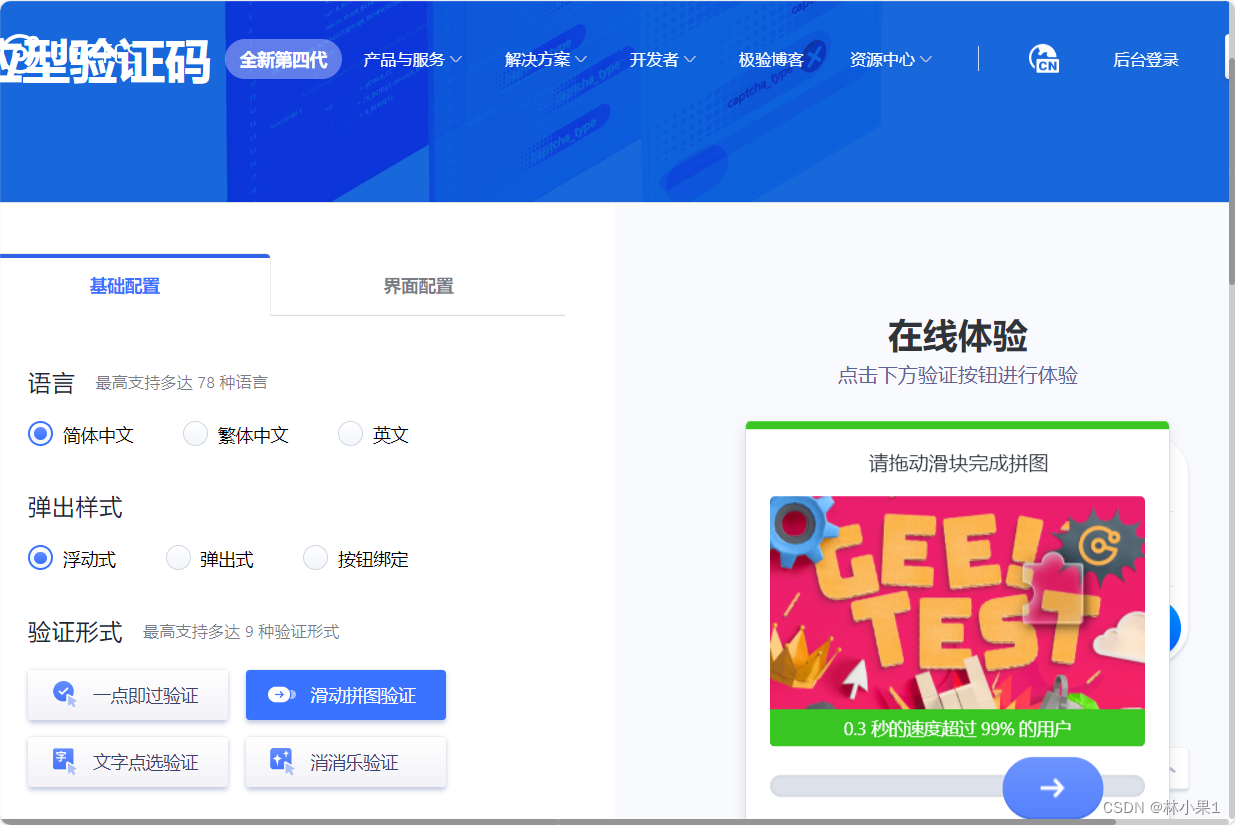

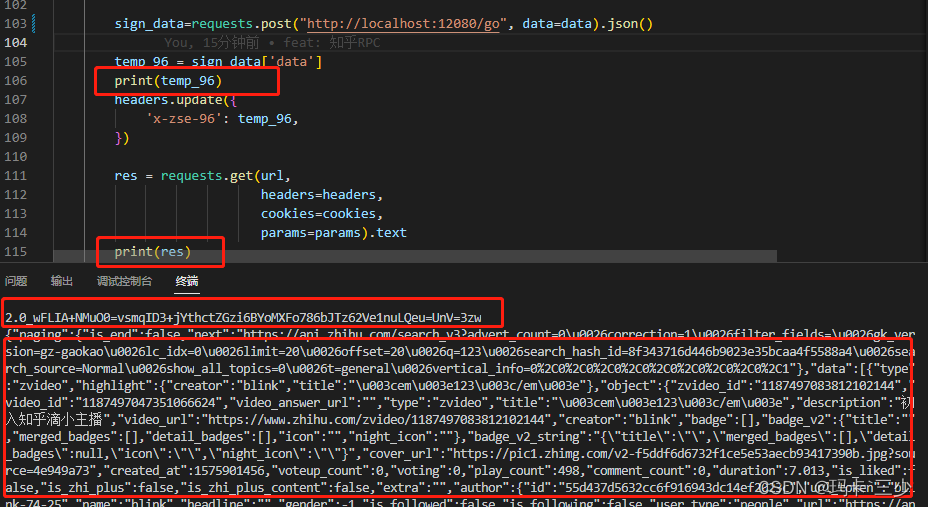

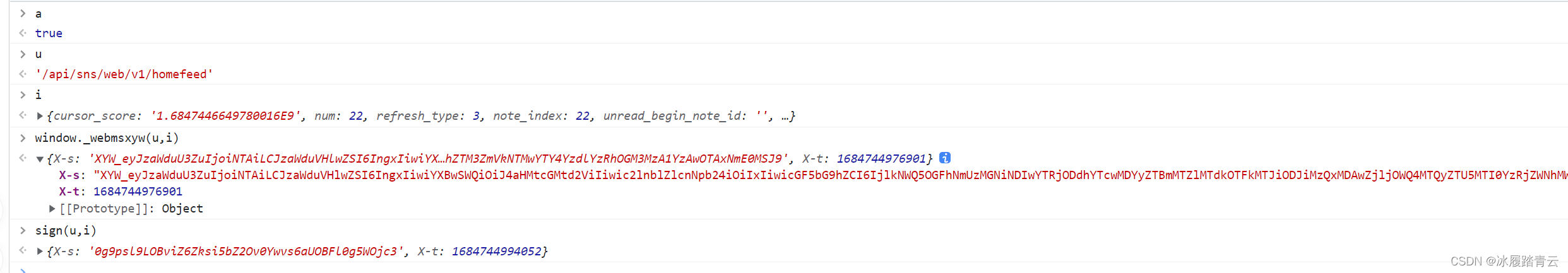

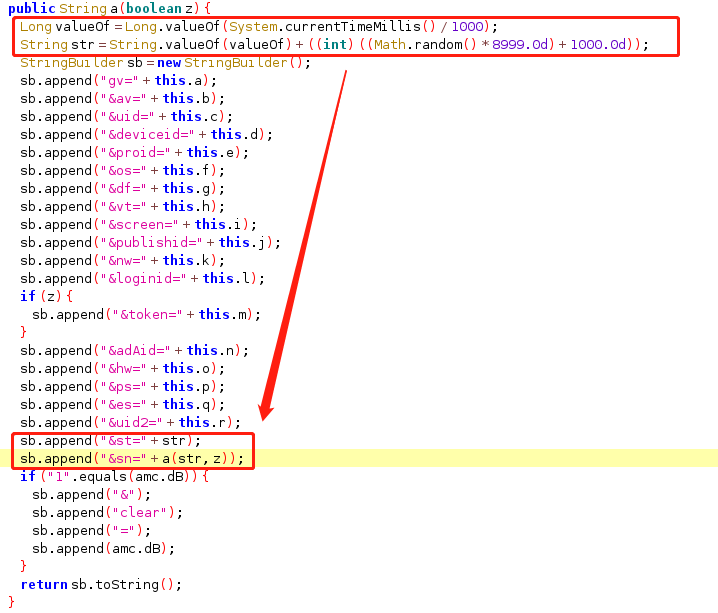

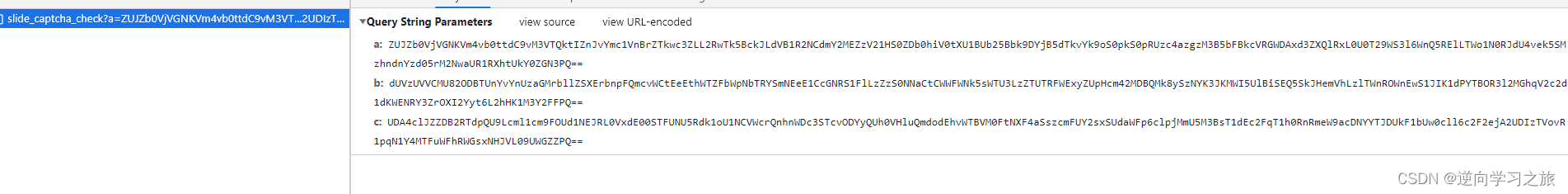

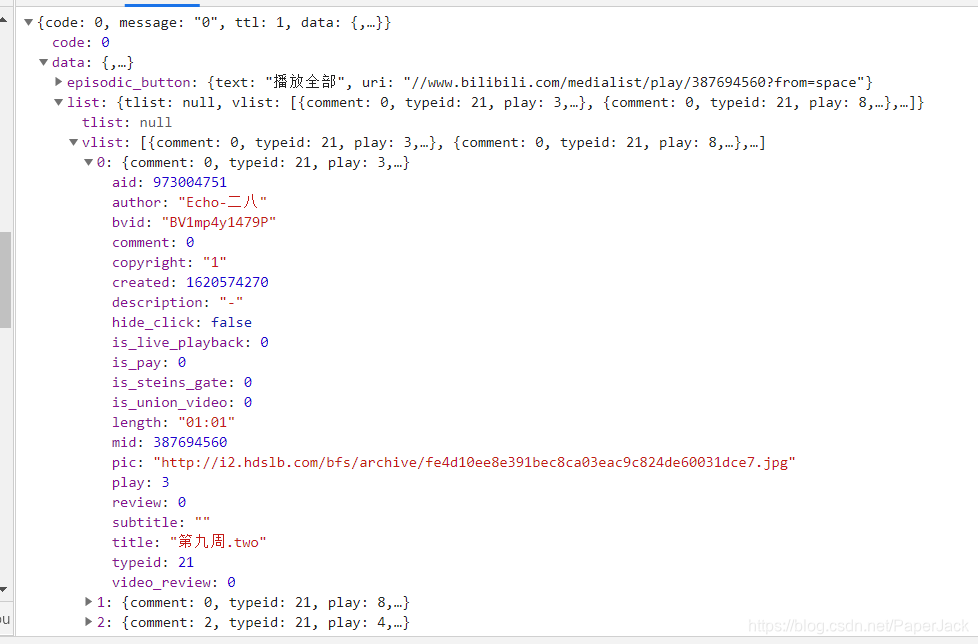

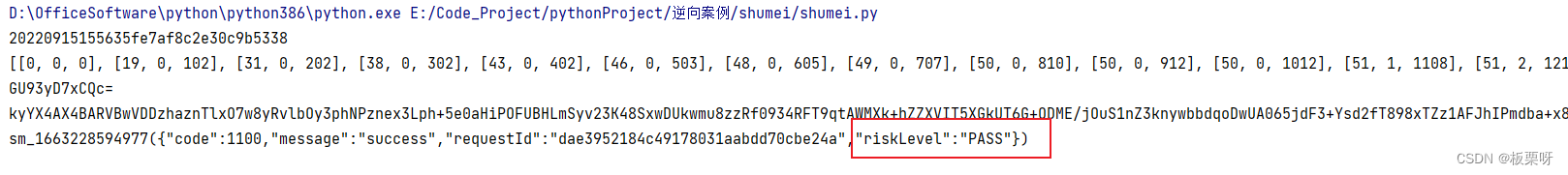

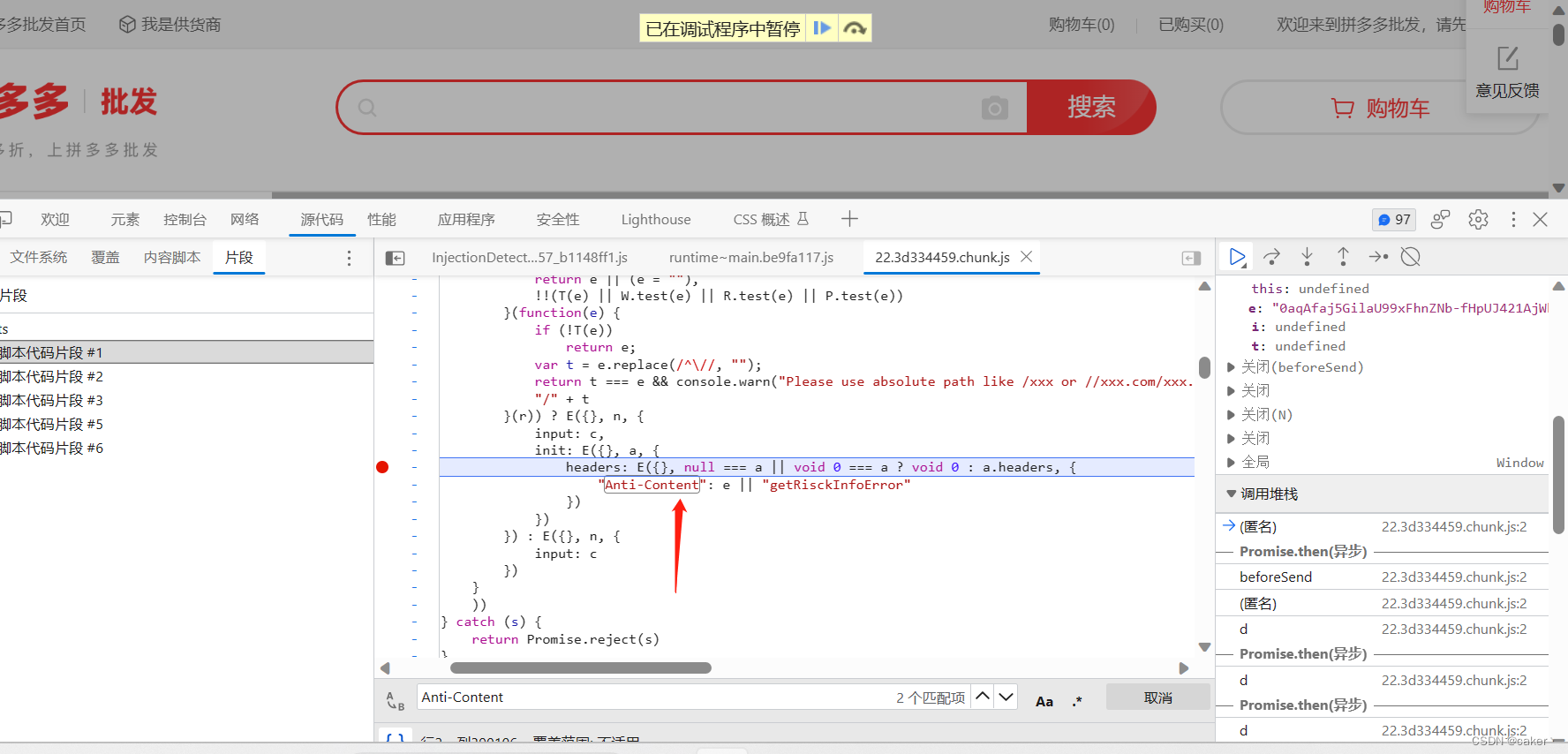

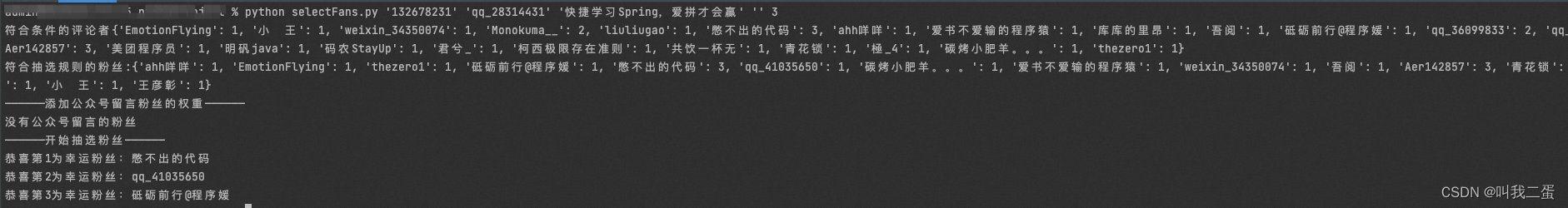

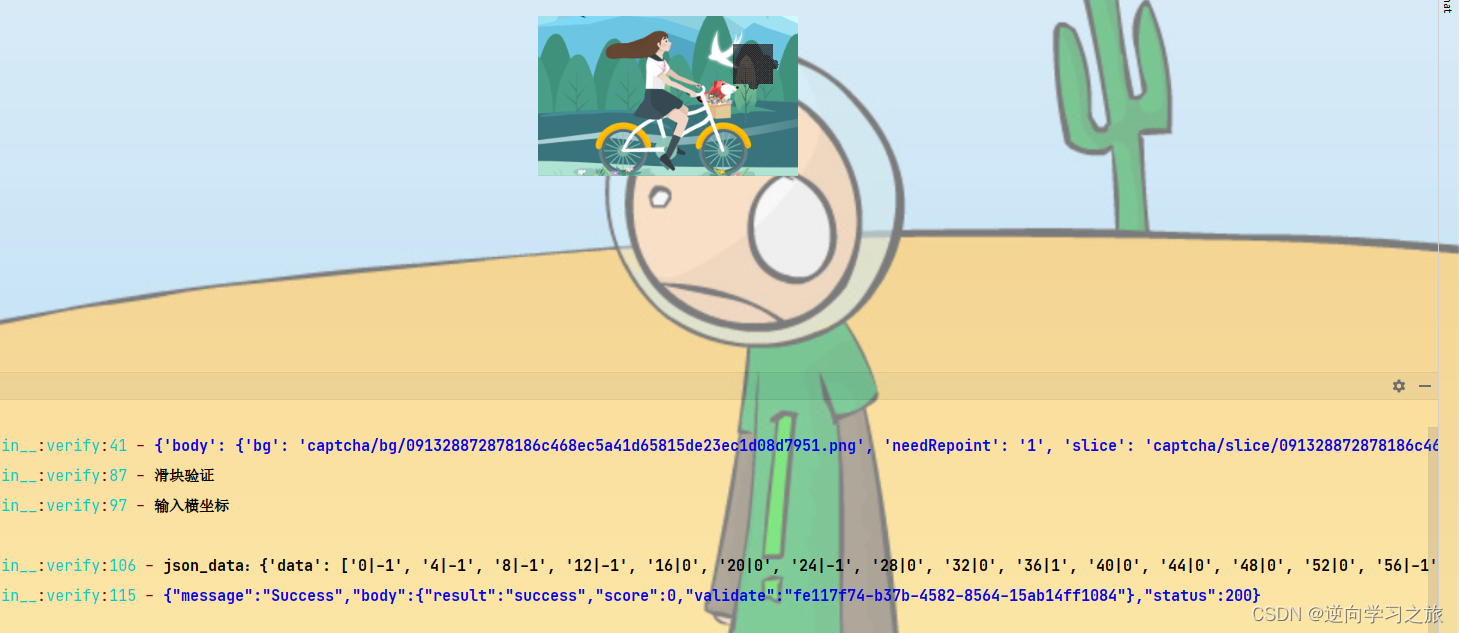

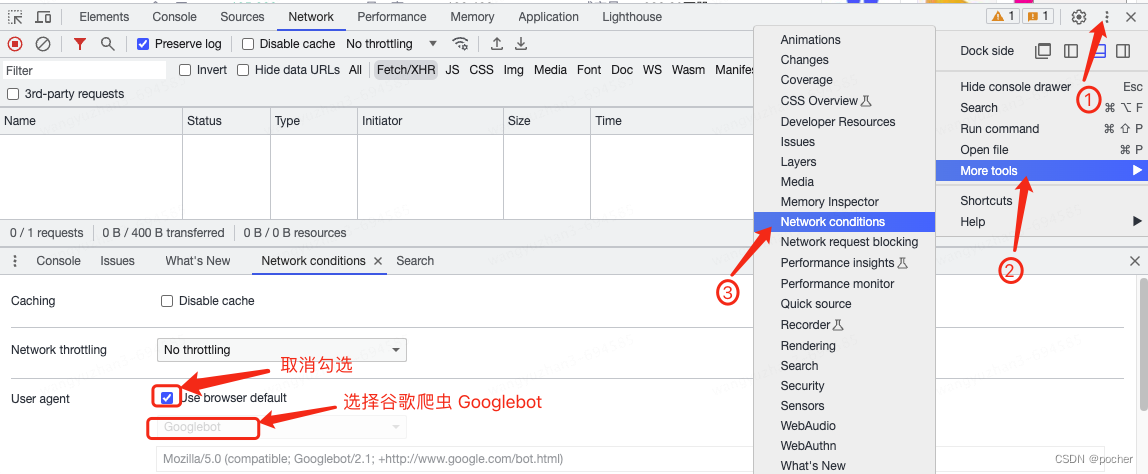

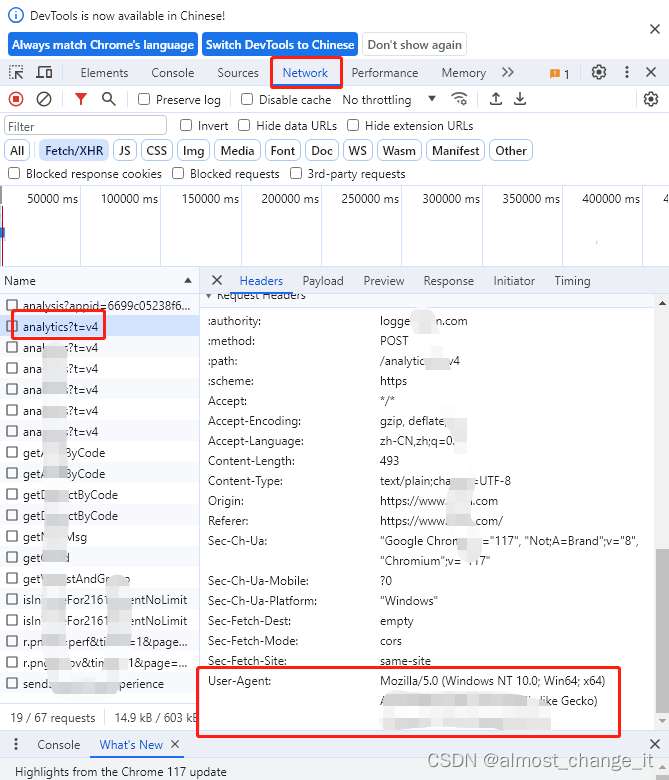

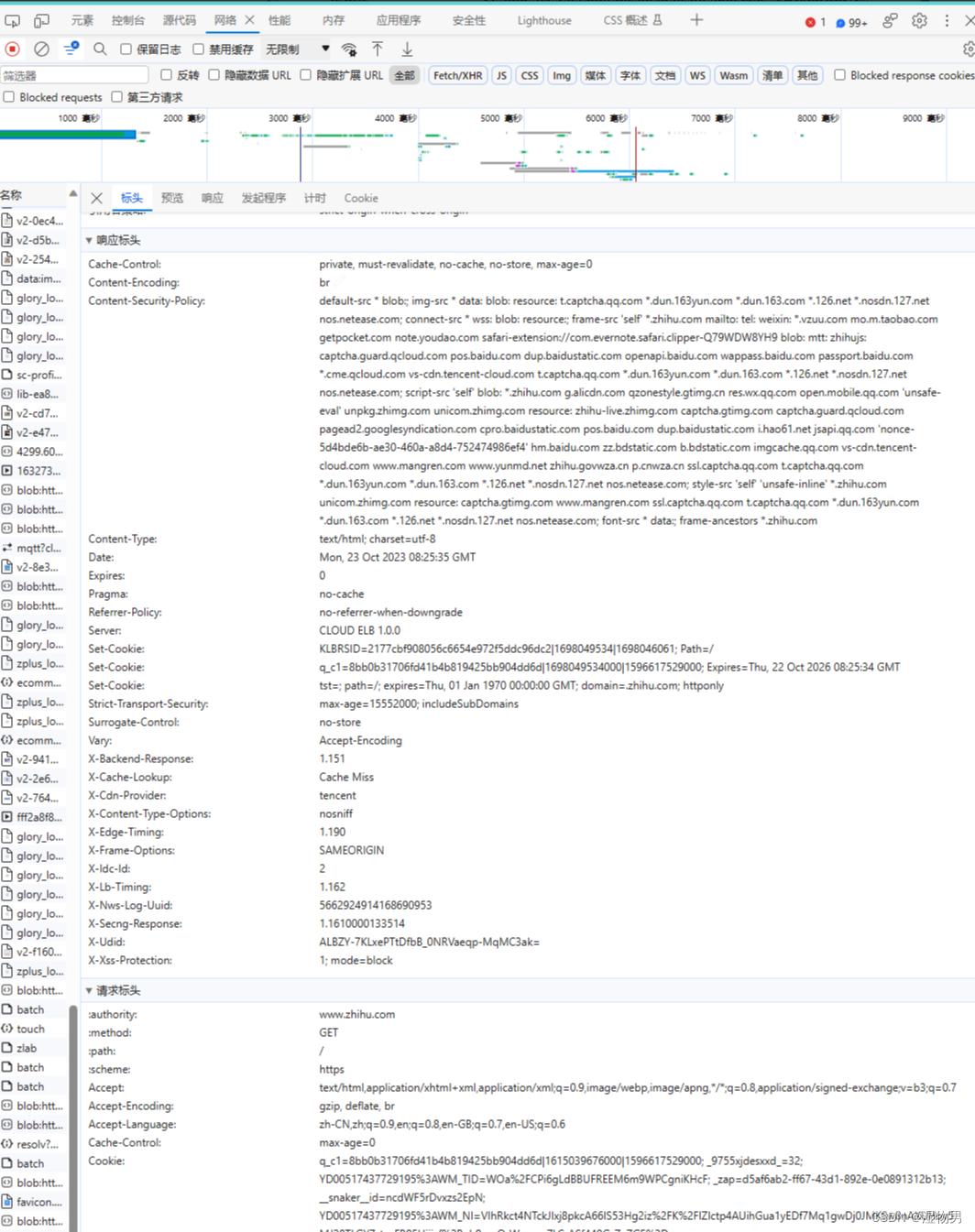

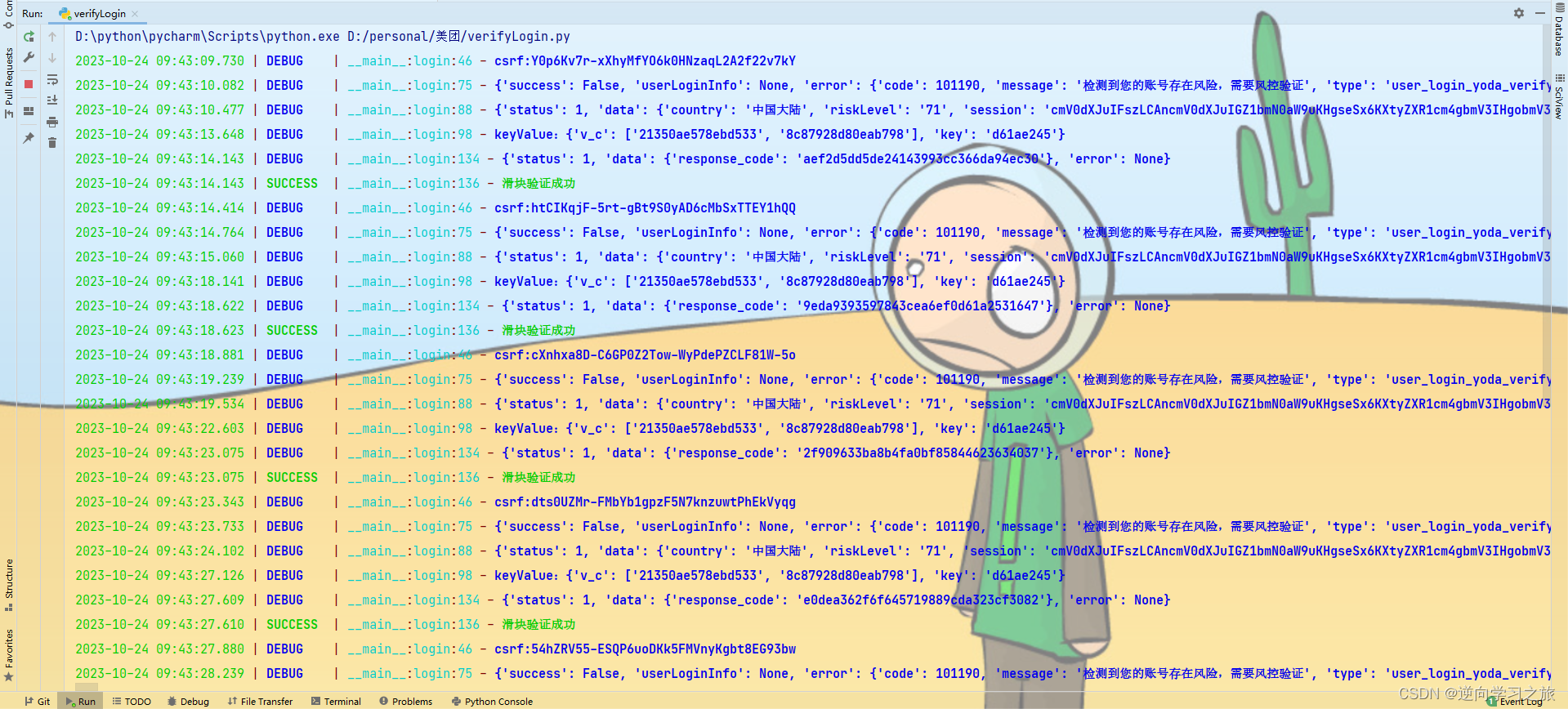

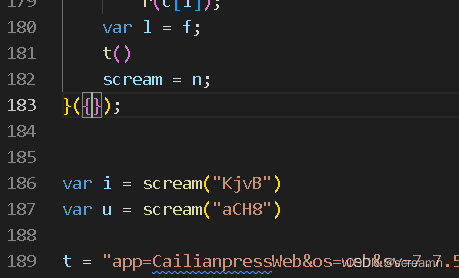

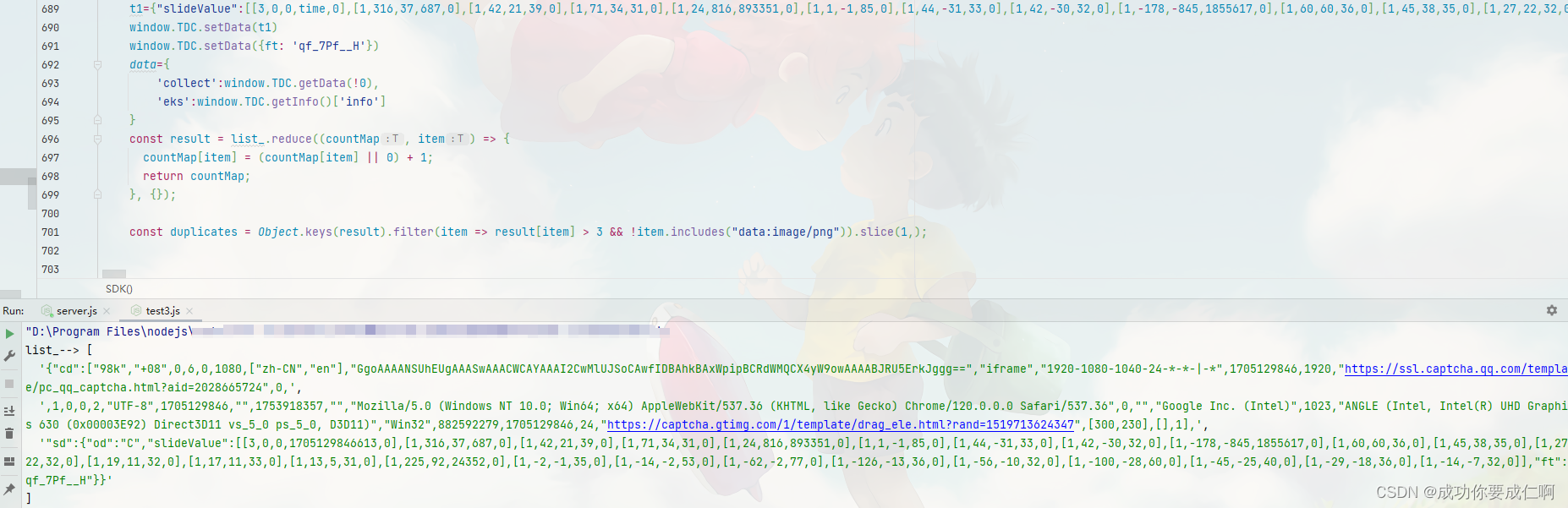

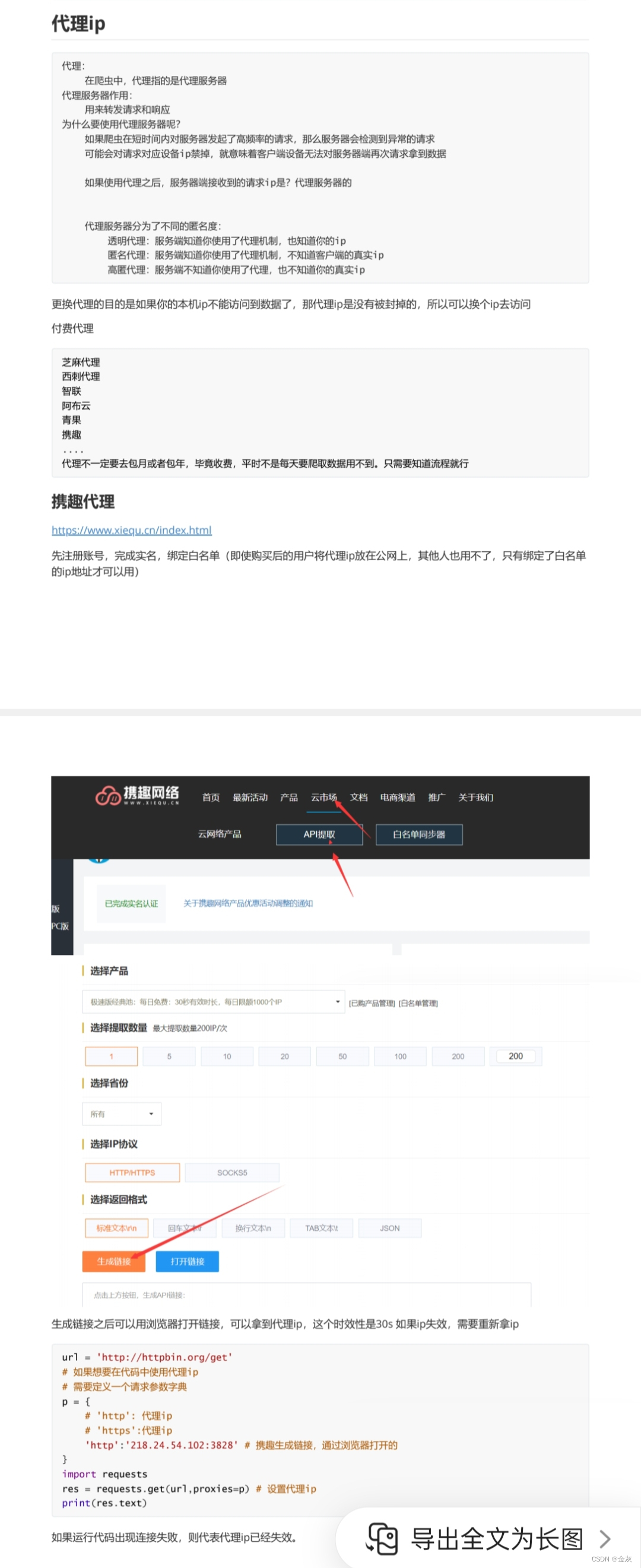

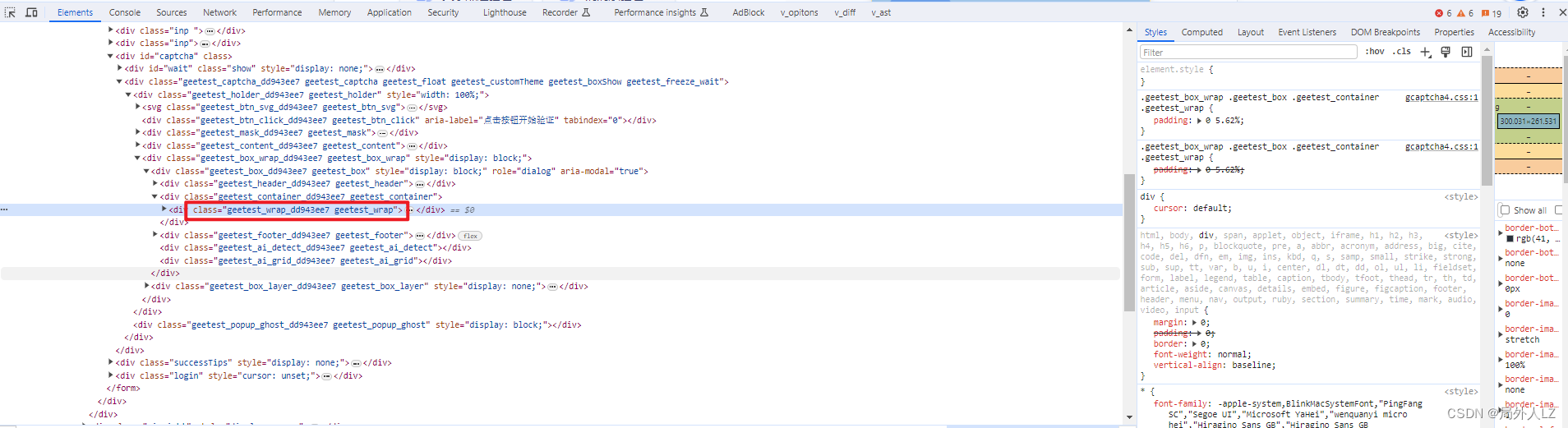

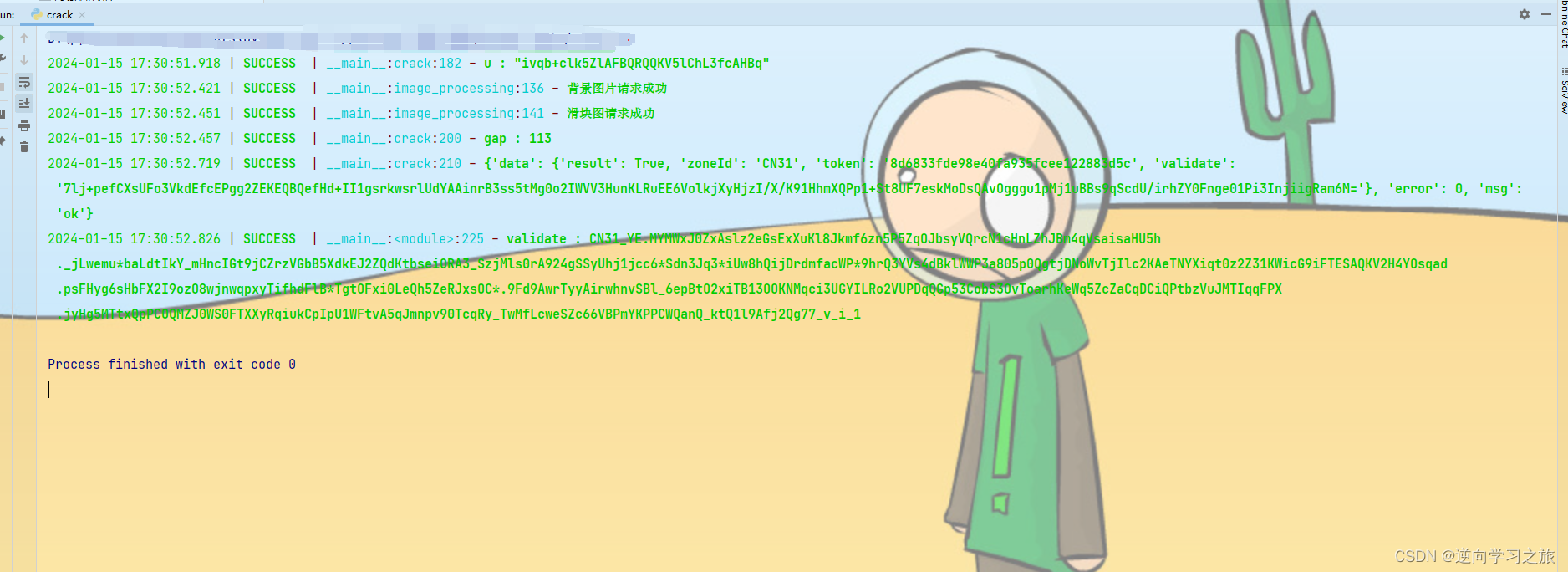

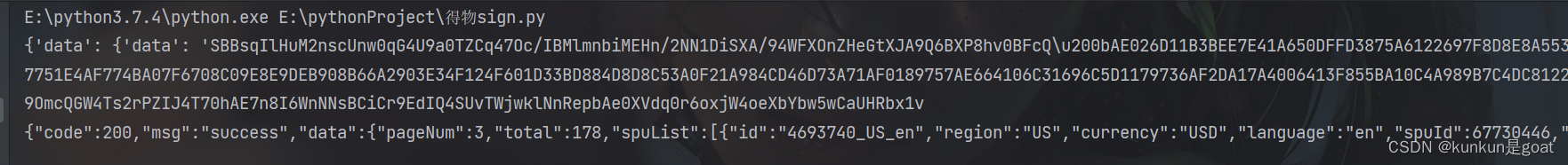

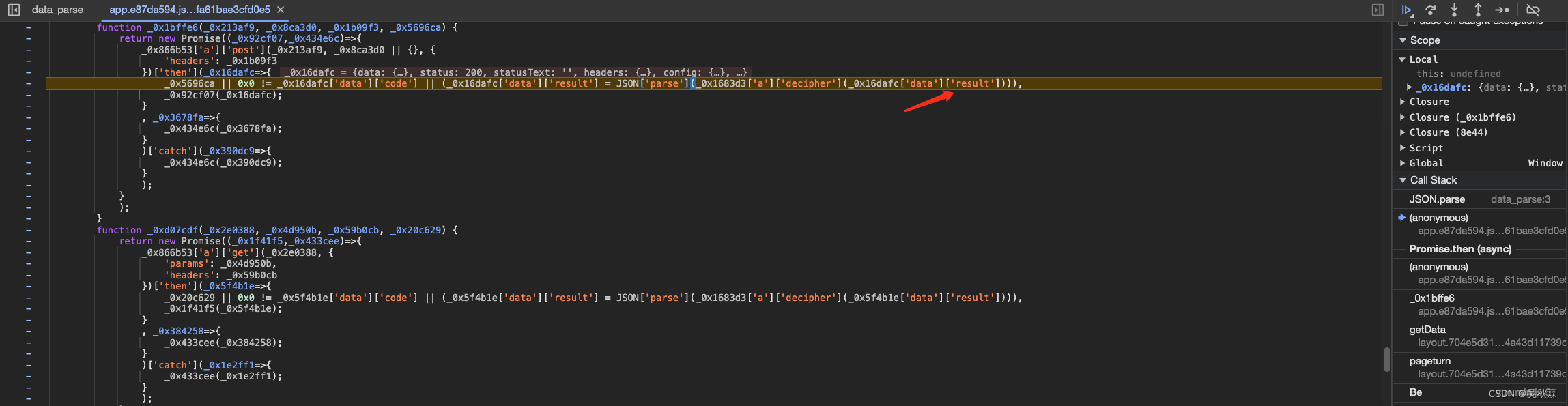

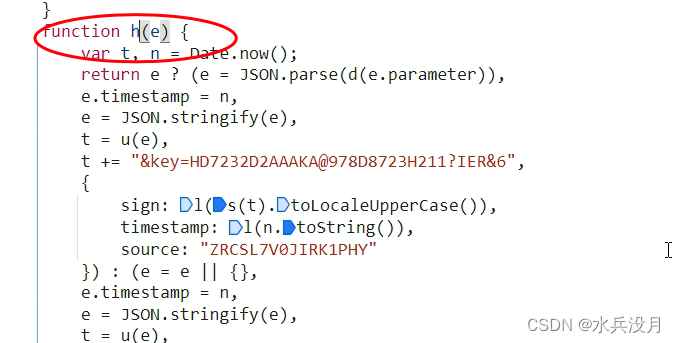

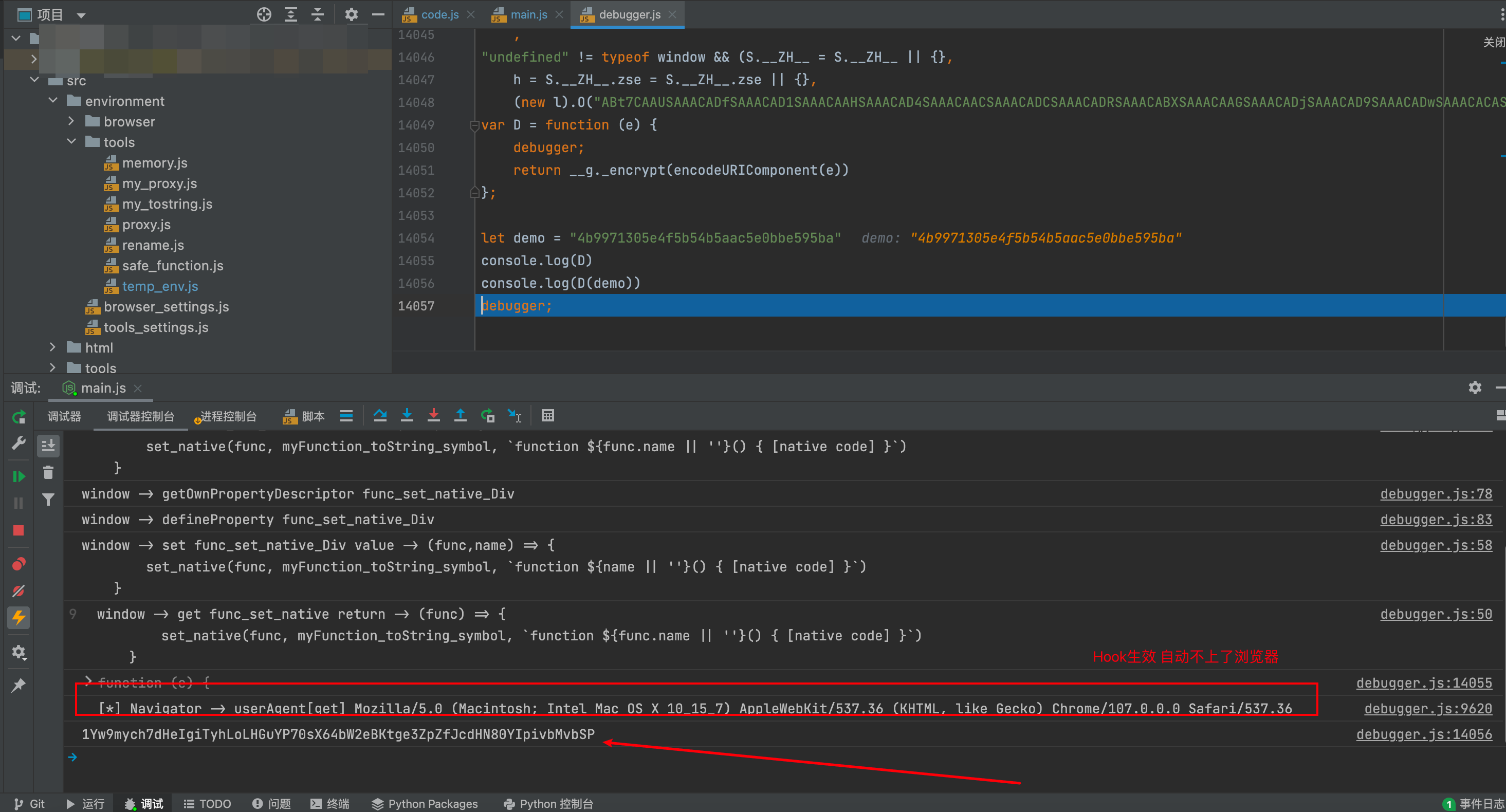

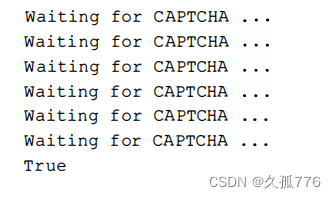

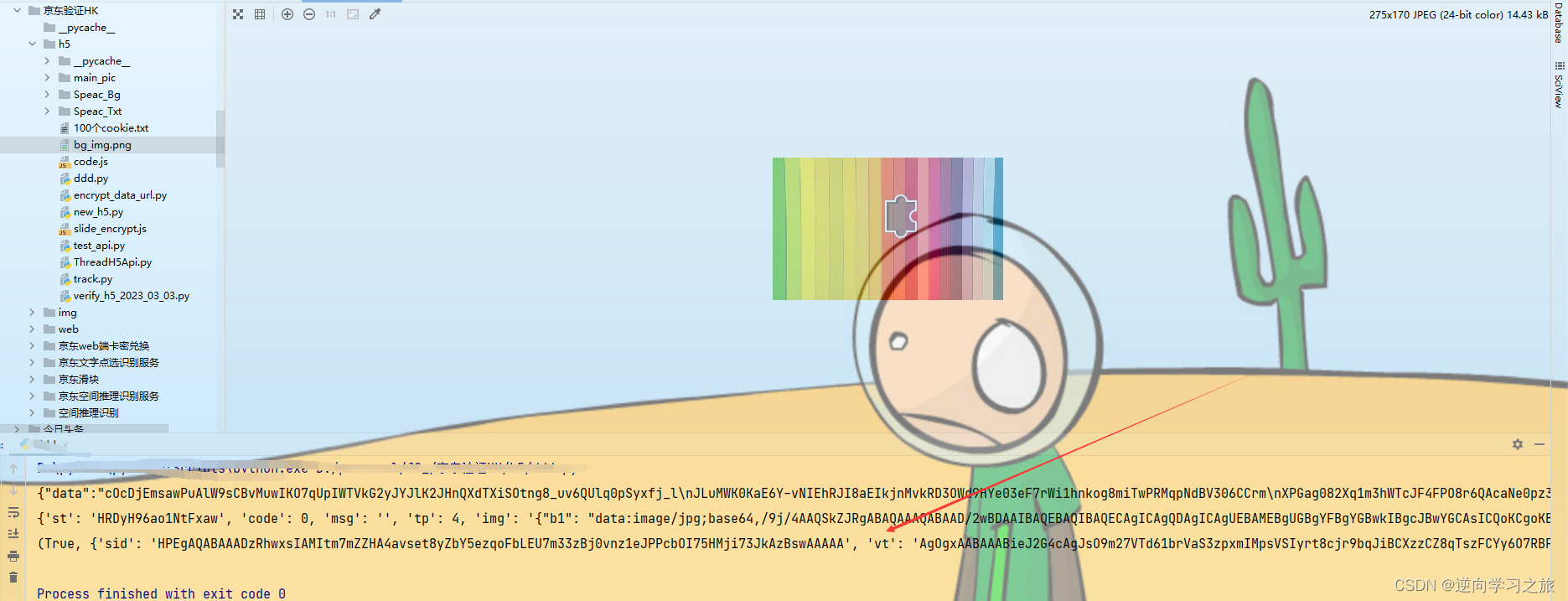

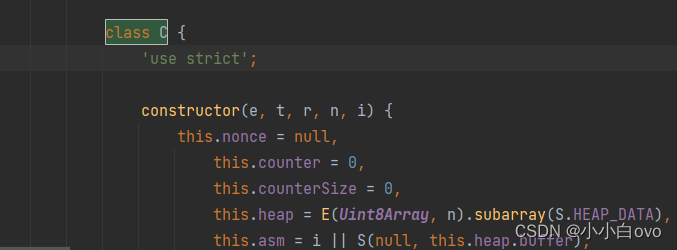

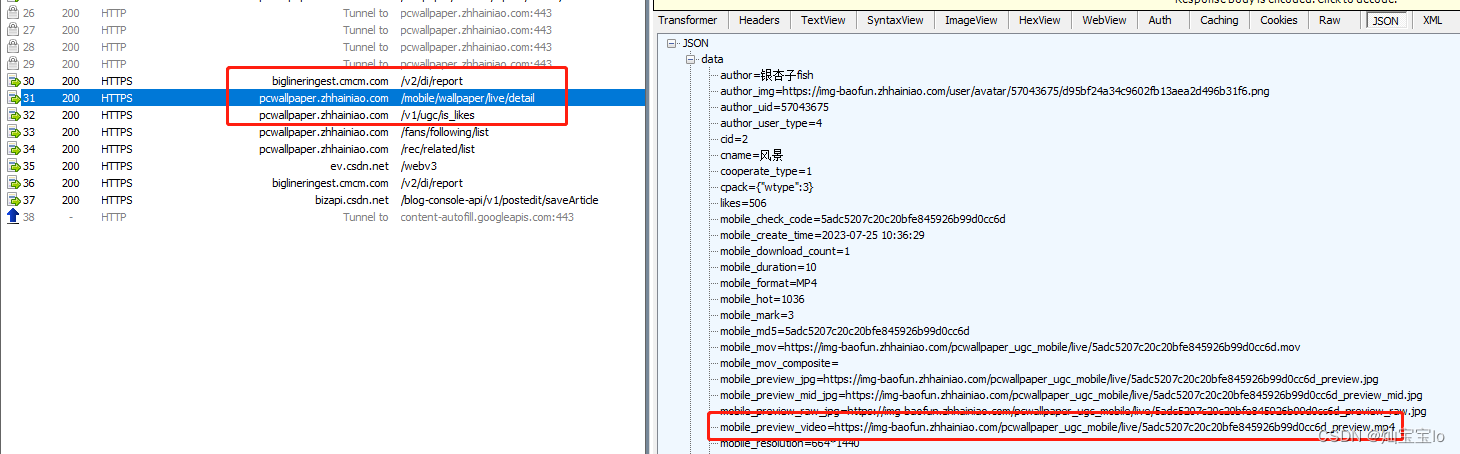

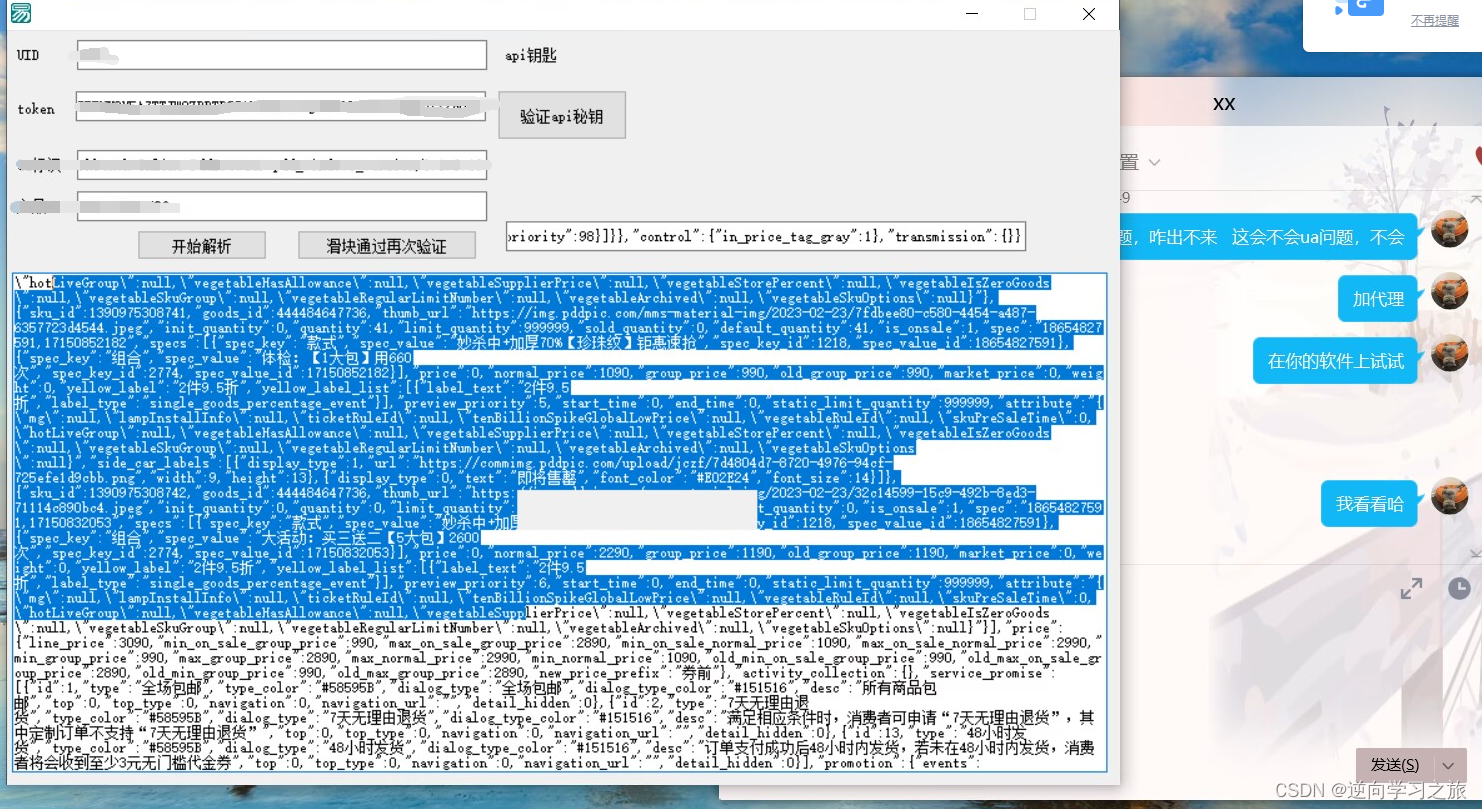

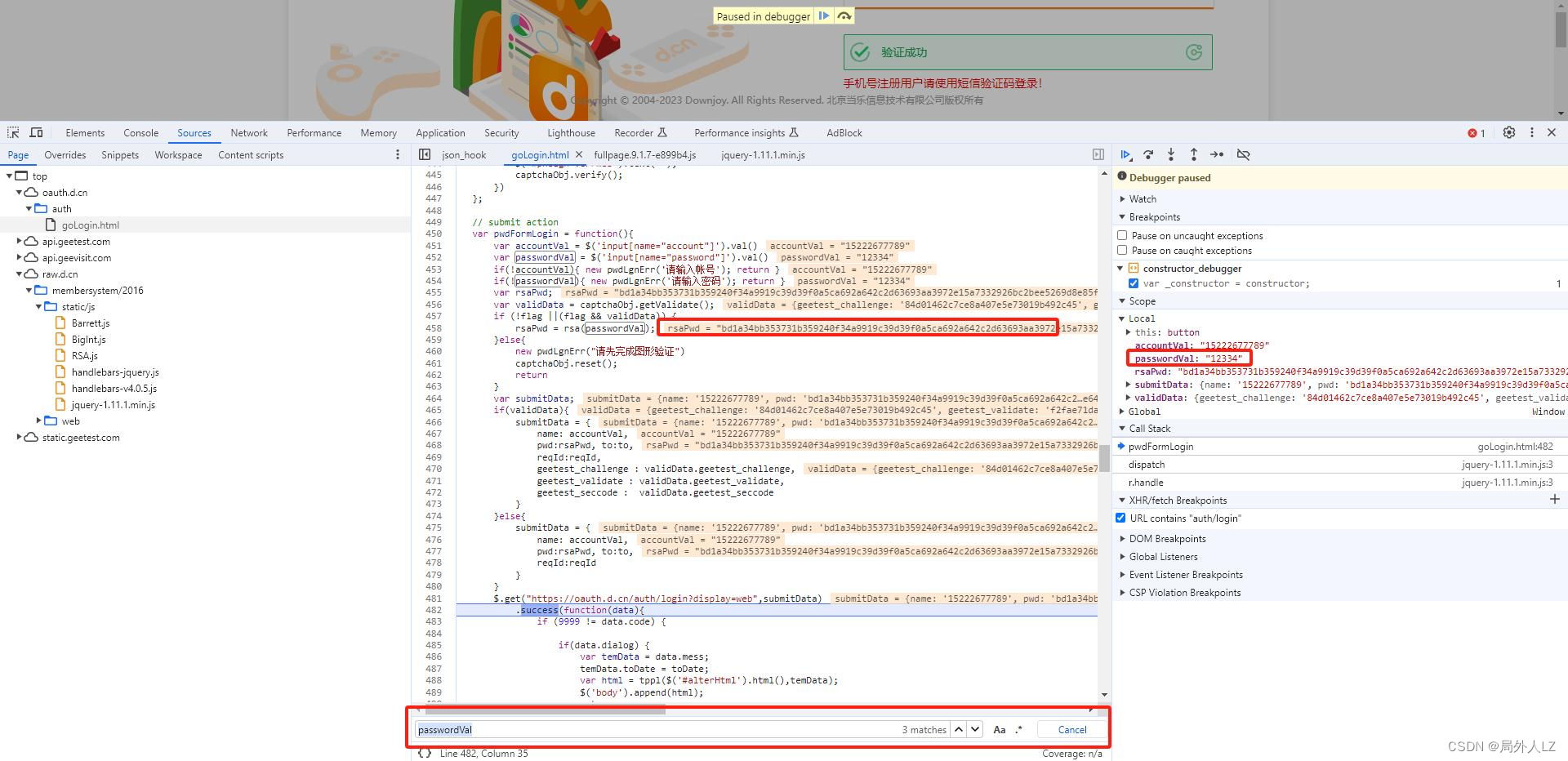

某验滑块验证码逆向分析

本文章中内容仅供项目展示使用,不用于其他任何目的,逆向项目不提供完整代码,抓包内容、敏感网址、数据接口等均已做脱敏处理,严禁用于商业用途和非法用途,否则由此产生的一切后果均与作者无关! 本文章未经许…

python 爬取世纪佳缘,经过js渲染过的网页的爬取

#!/usr/bin/python

#-*- coding:utf-8 -*-#爬取世纪佳缘

#这个网站是真的烦,刚开始的时候用scrapy框架写,但是因为刚接触框架,碰到js渲染的页面之后就没办法了,所以就采用一般的爬虫了

#js渲染过的数据,可能在网页源码里面没有数据,需要js异步…

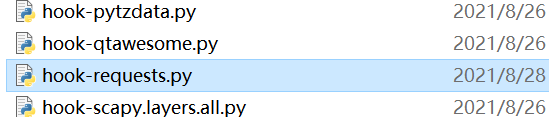

Python 爬虫-feapder 框架简介

feapder 框架 学习目标 掌握便捷式框架操作流程 掌握请求钩子结构使用 掌握框架项目搭建流程 掌握数据入库与去重 1 简介 国内文档:https://boris-code.gitee.io/feapder feapder 是一款上手简单,功能强大的Python爬虫框架,使用方式类似s…

Python BeautifulSoup简介

1.BeautifulSoup简介 BeautifulSoup是一个可以从HTML或XML文件中提取数据的python库;它能够通过转换器实现惯用的文档导航、查找、修改文档的方式。 BeautifulSoup是一个基于re开发的解析库,可以提供一些强大的解析功能;使用BeautifulSoup能够…

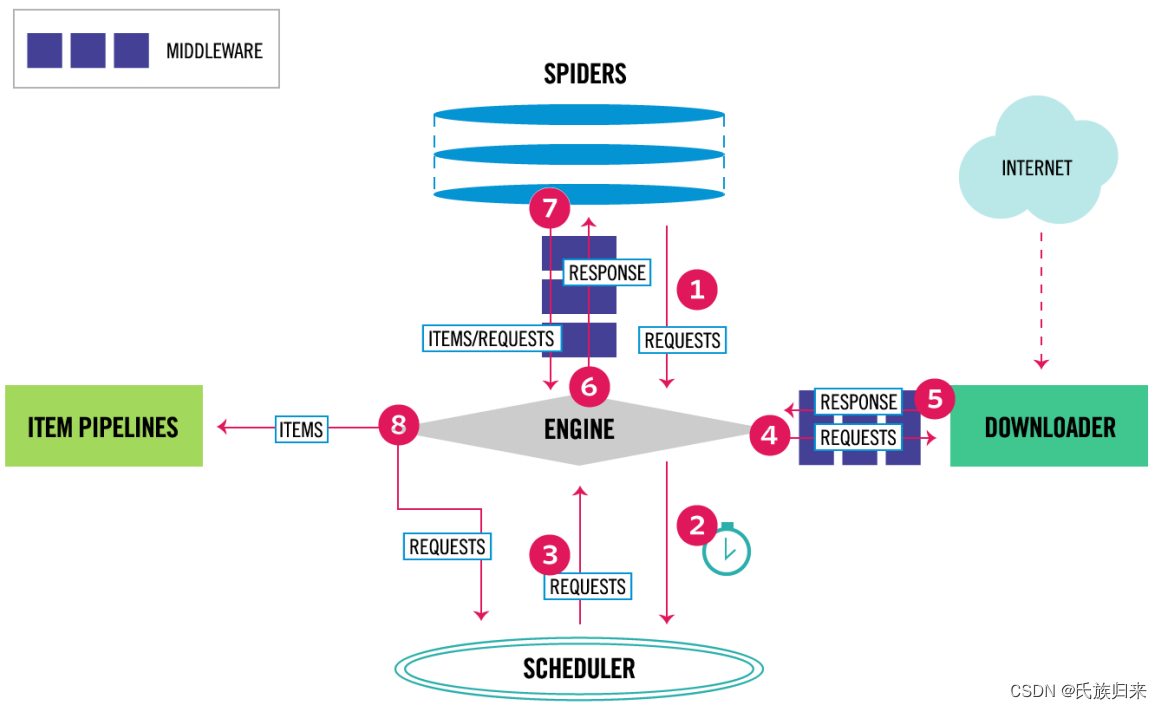

爬虫技术-Scrapy框架介绍

Scrapy采集框架 1 学习目标 1、框架流程和结构设计原理 2、框架爬虫程序编写 3、框架日志模块使用 4、框架请求发送流程 2 scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛,用户只需要定制开发…

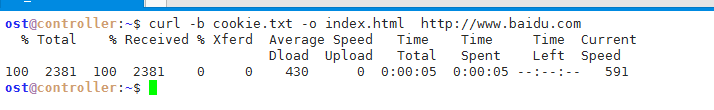

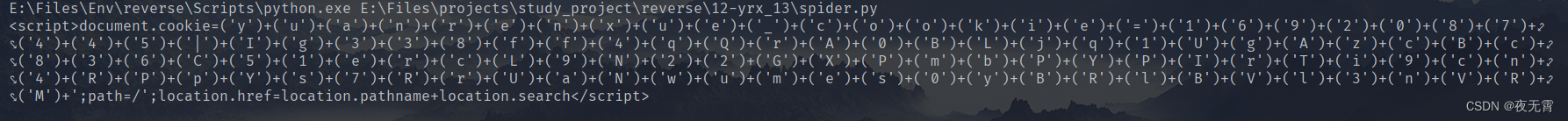

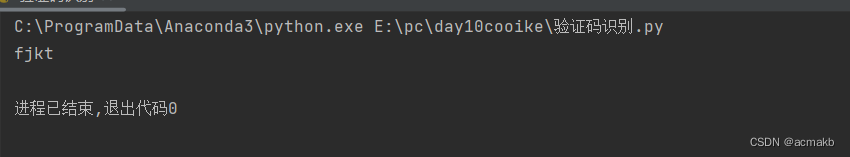

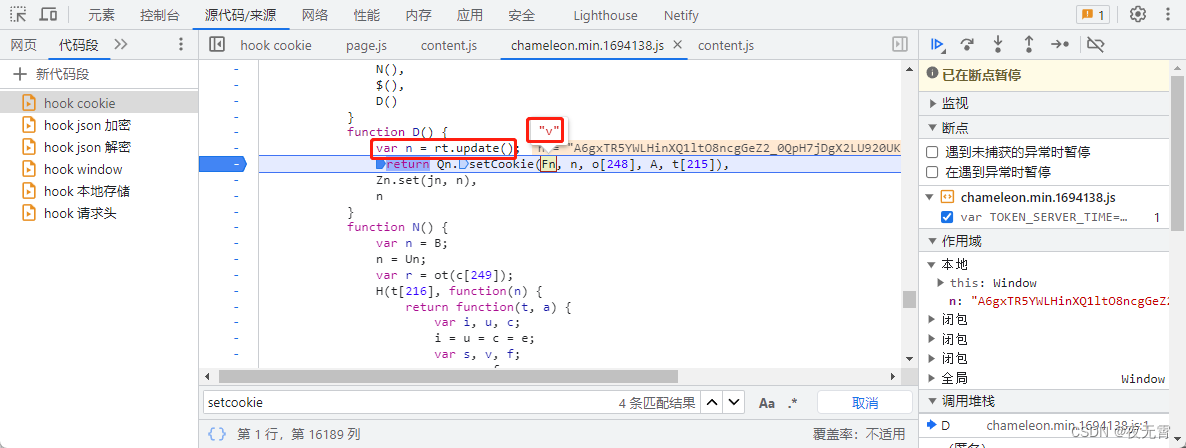

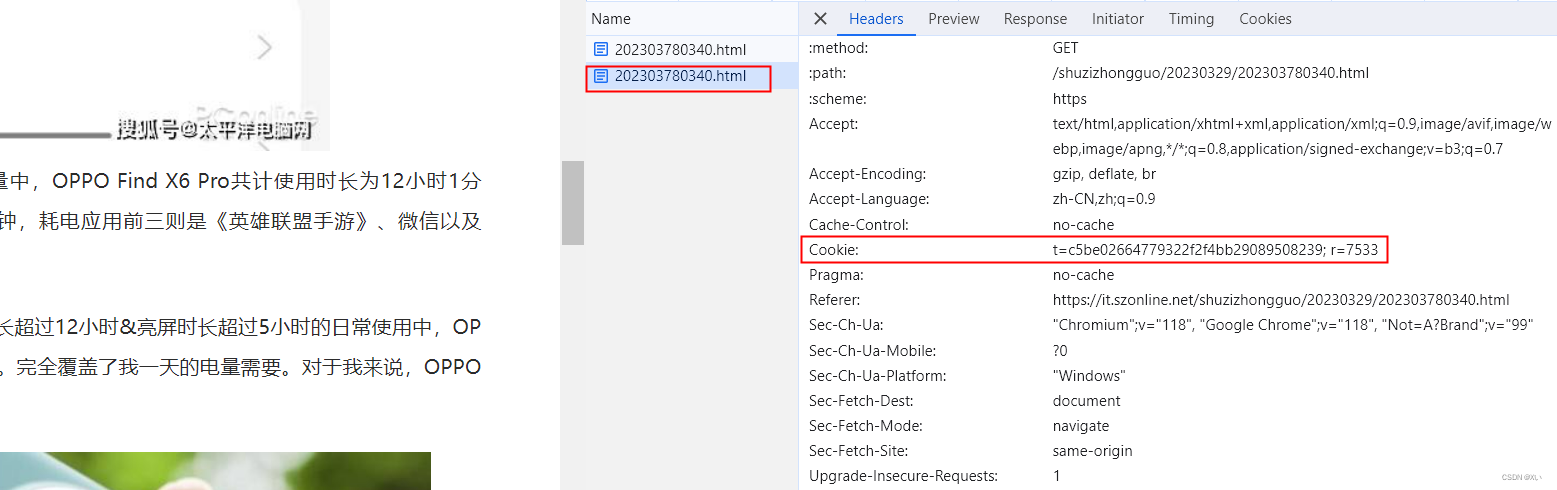

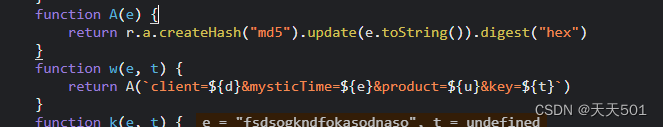

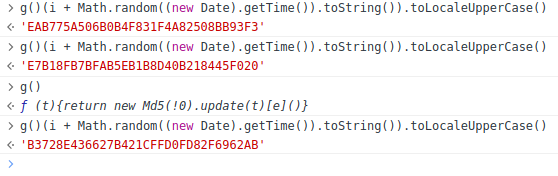

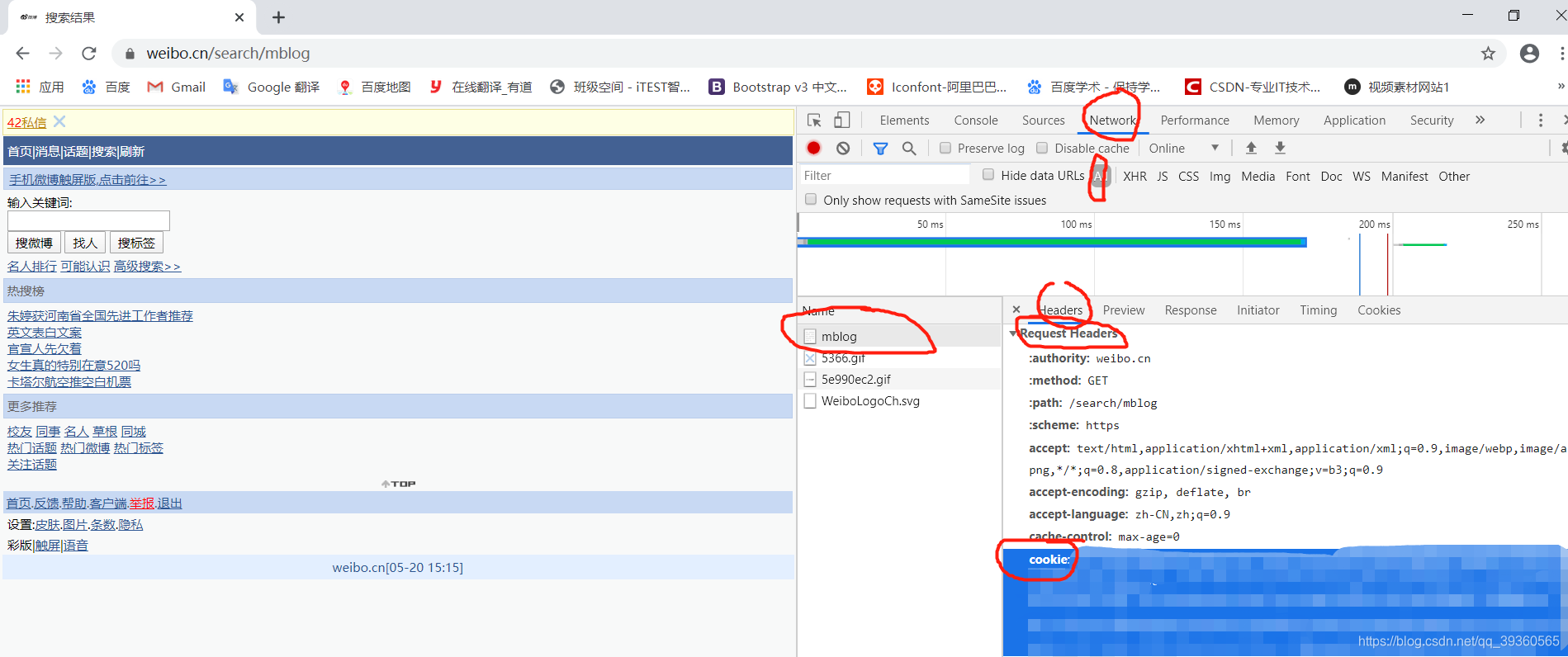

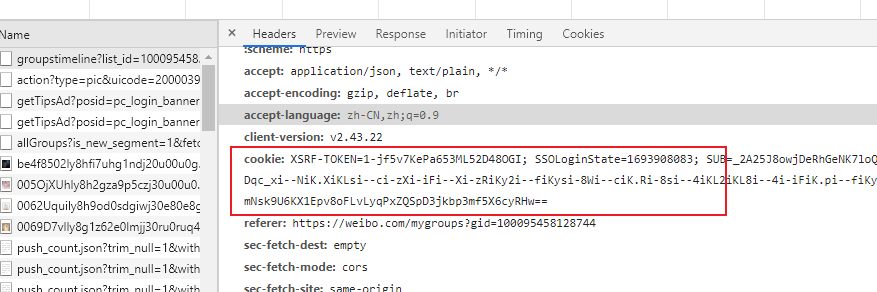

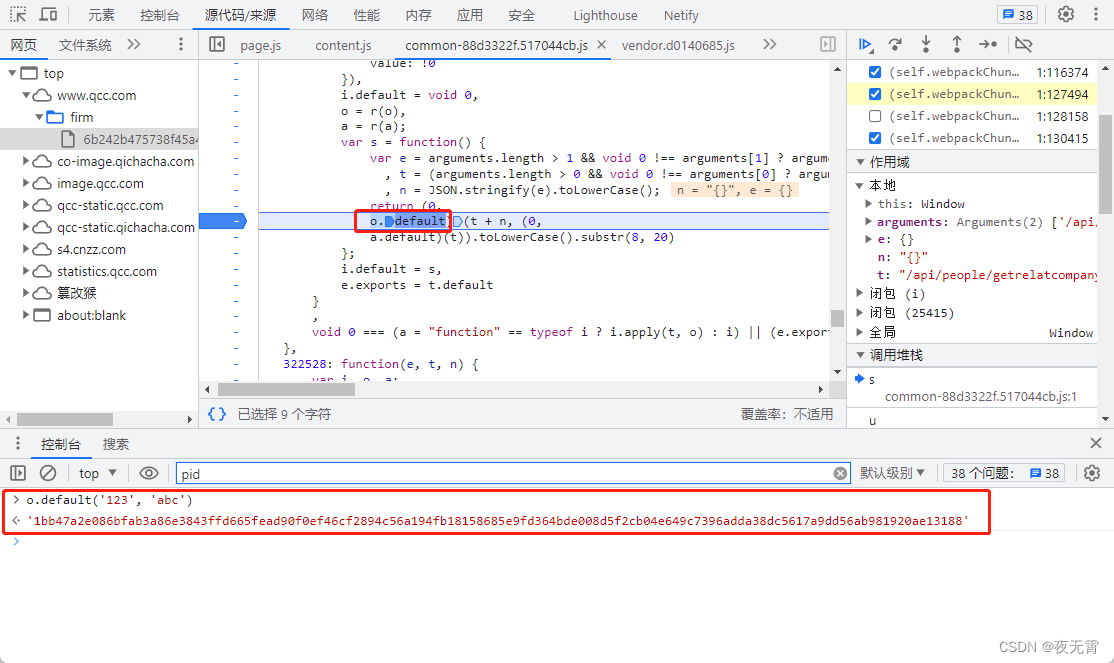

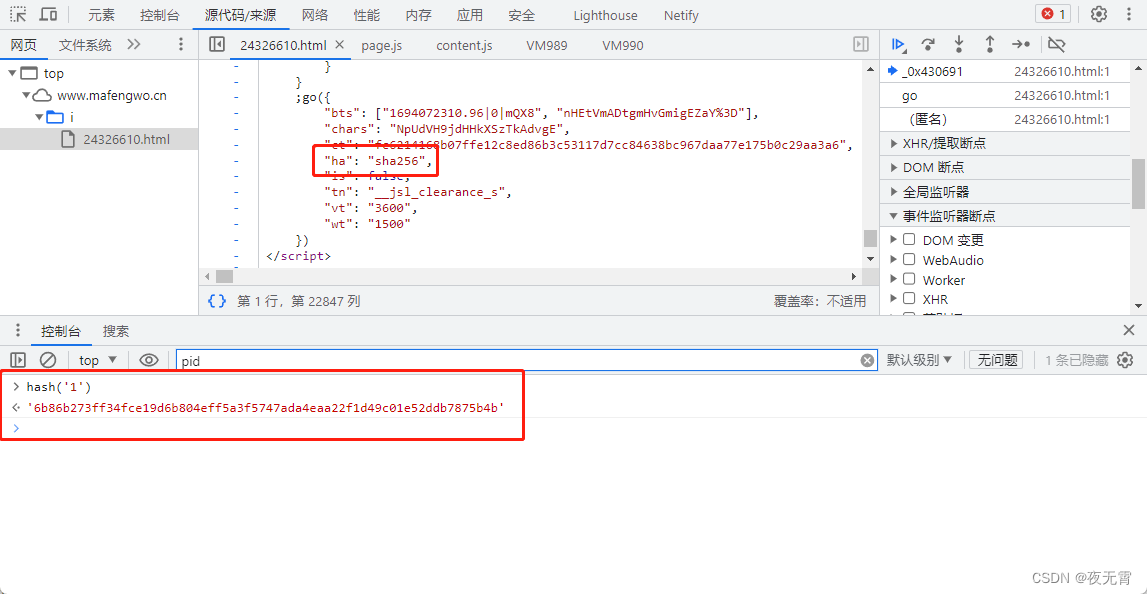

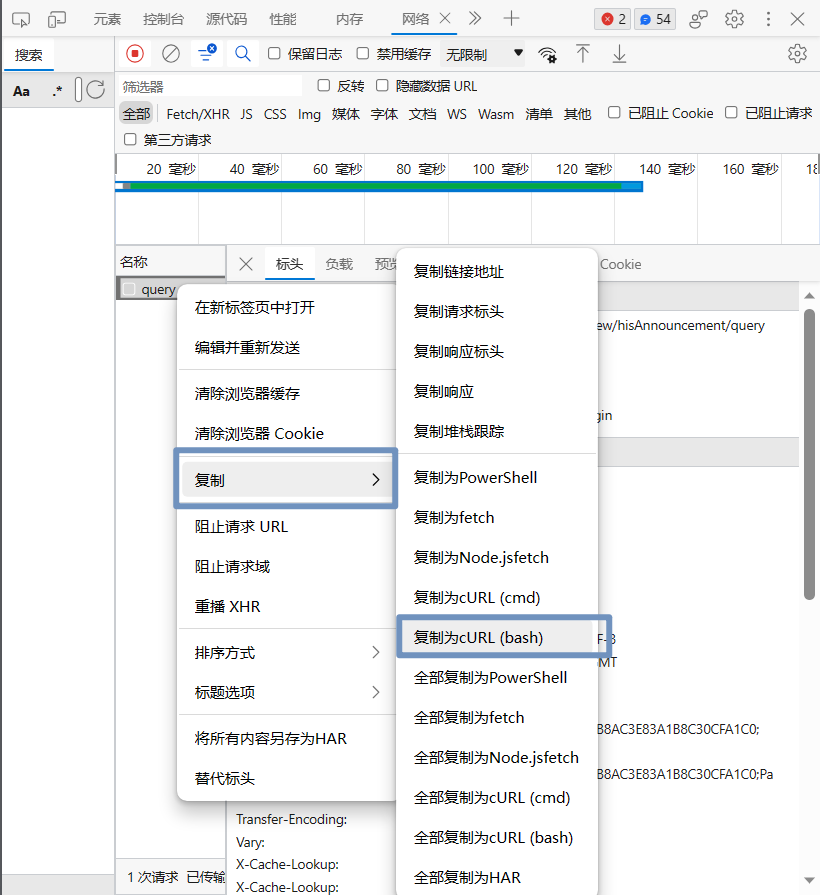

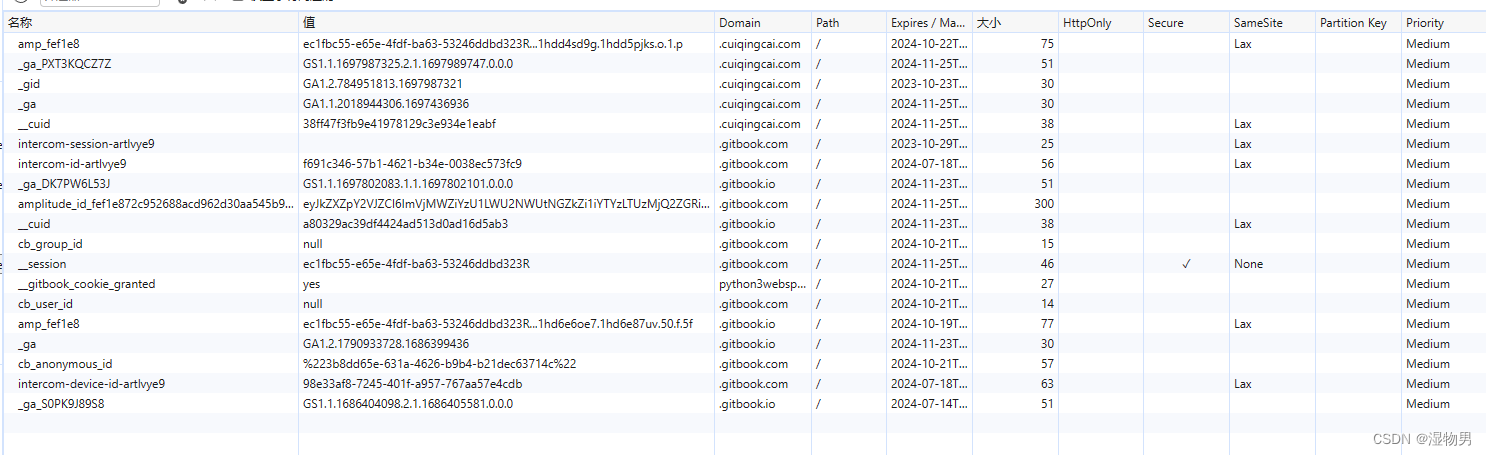

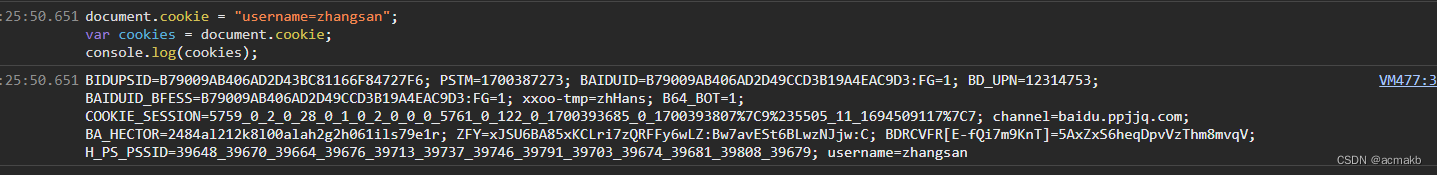

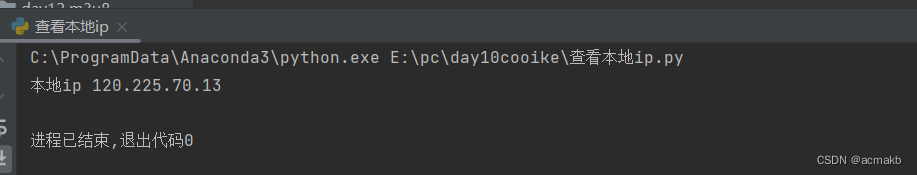

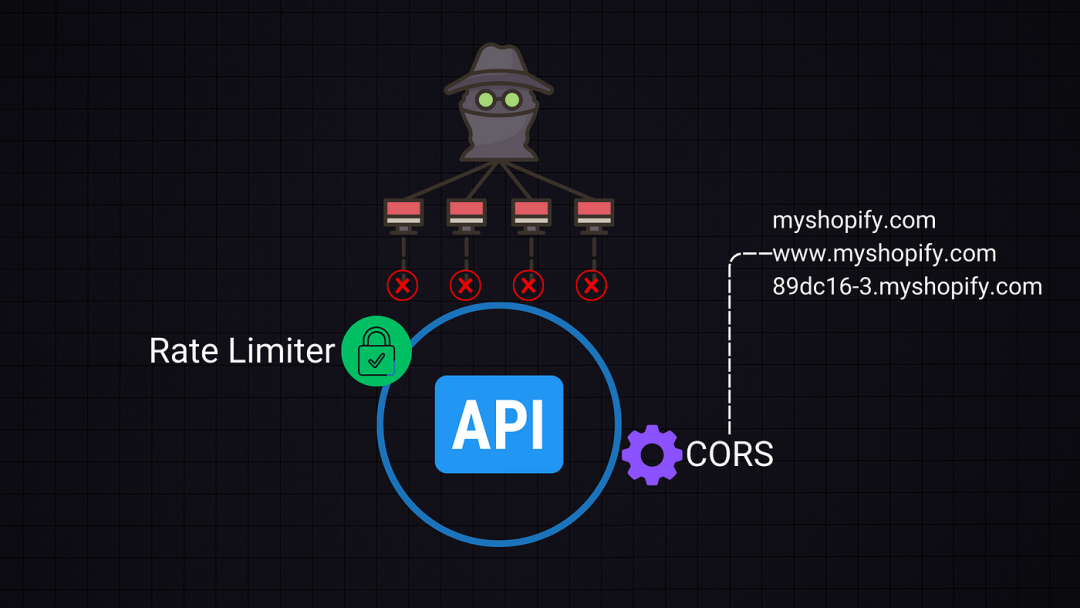

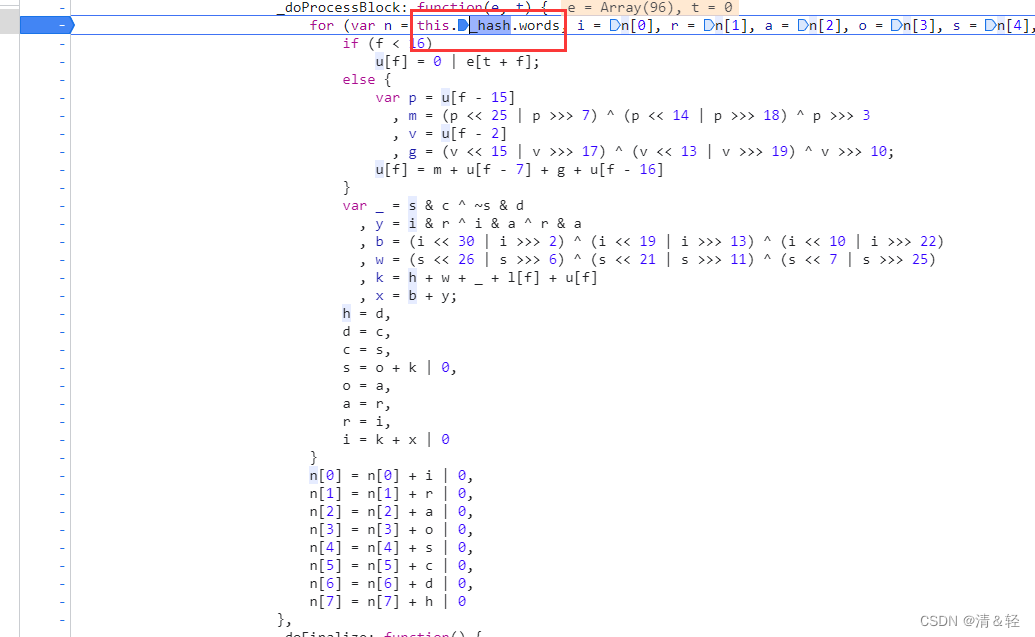

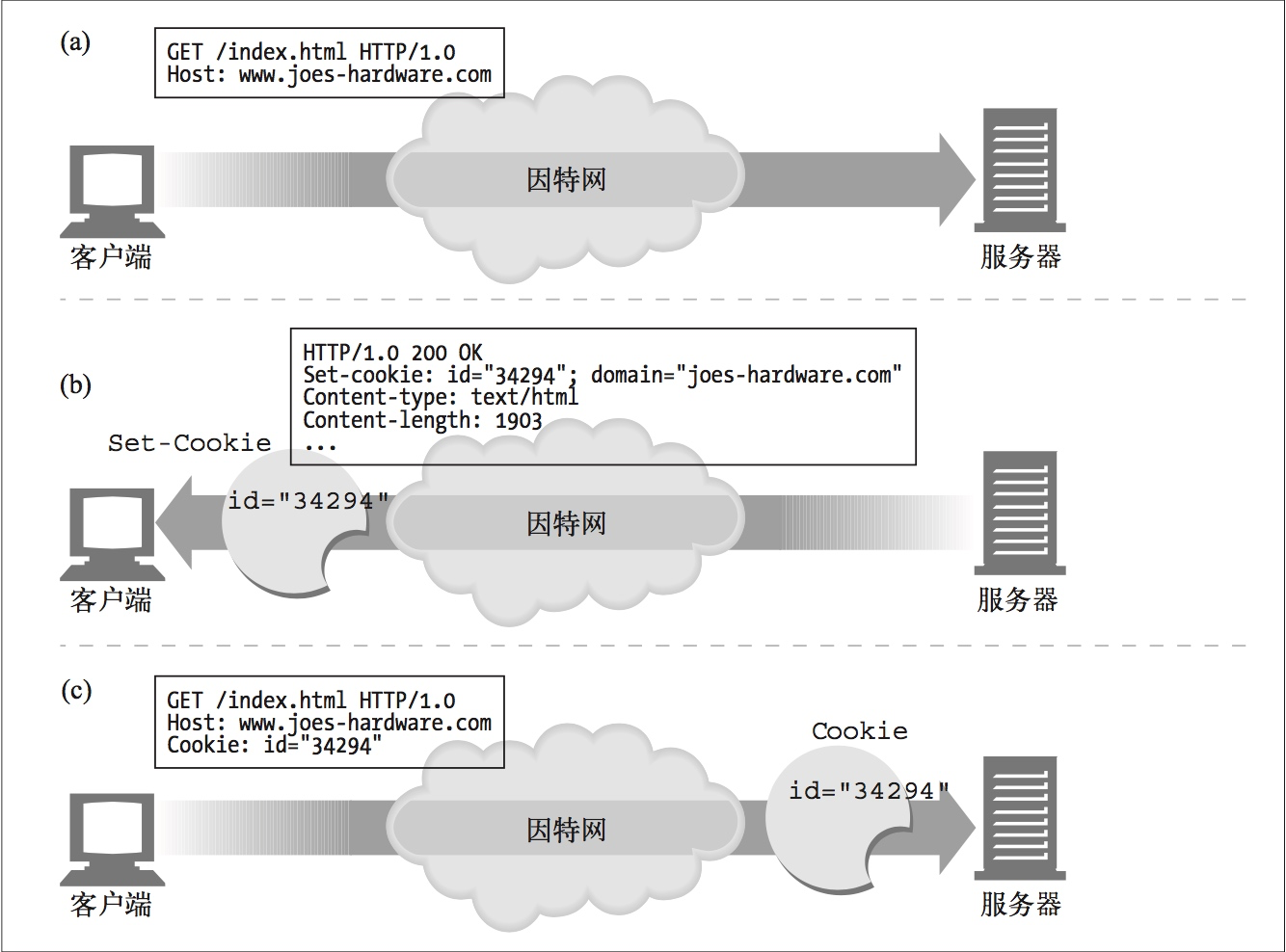

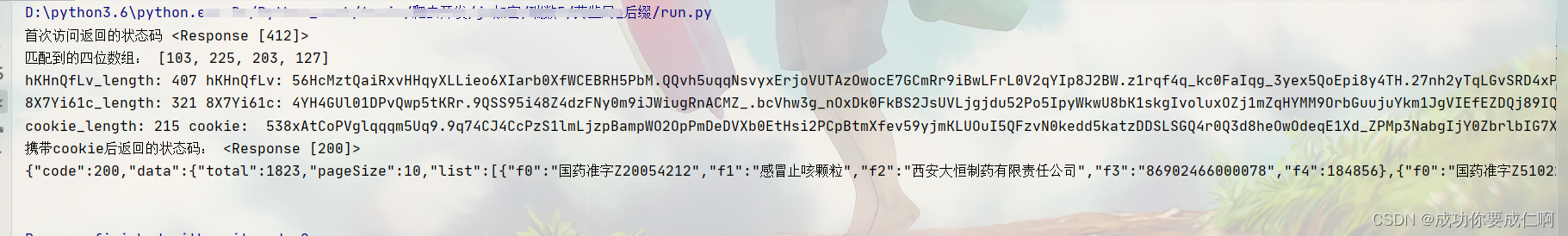

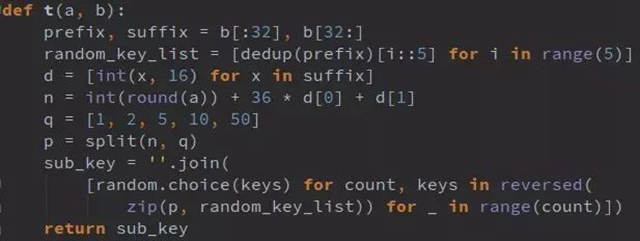

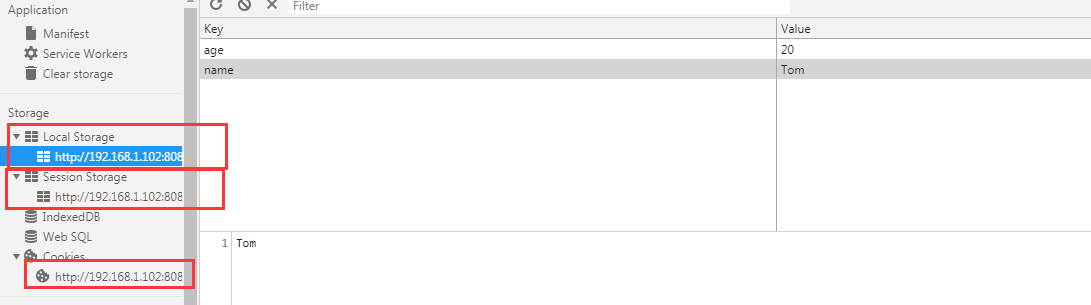

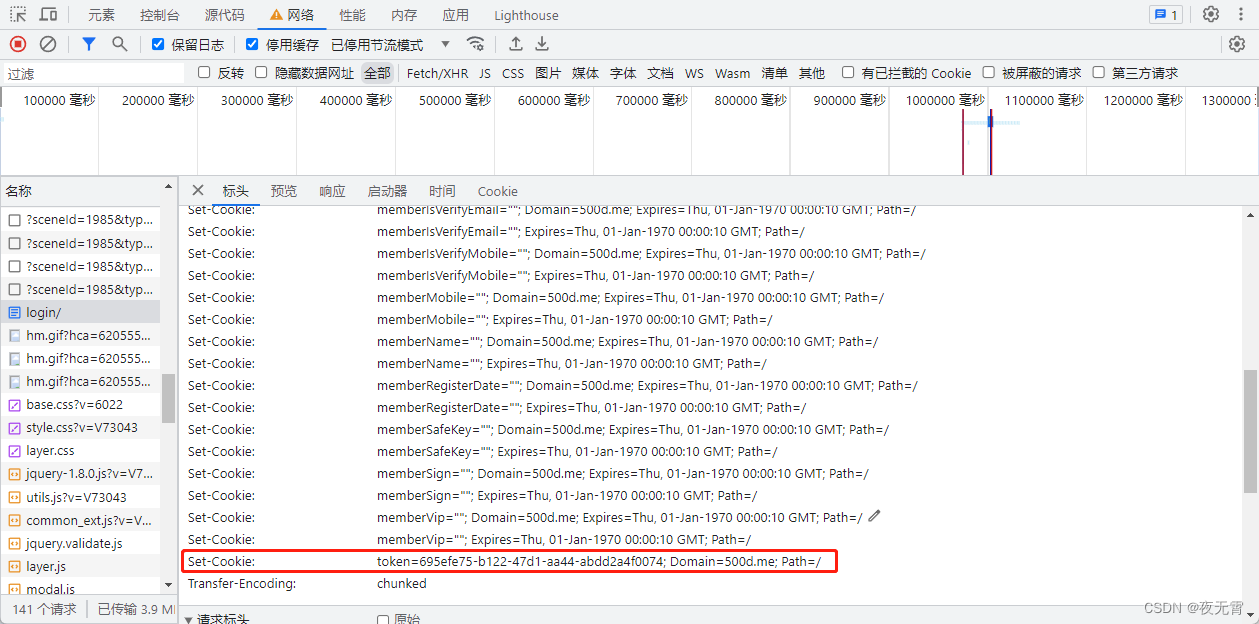

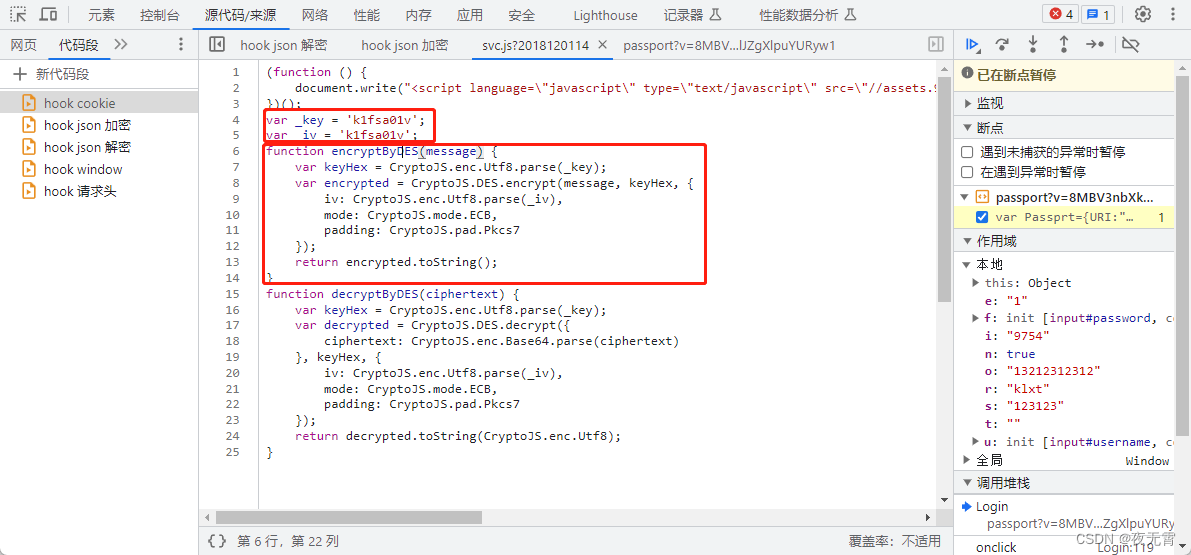

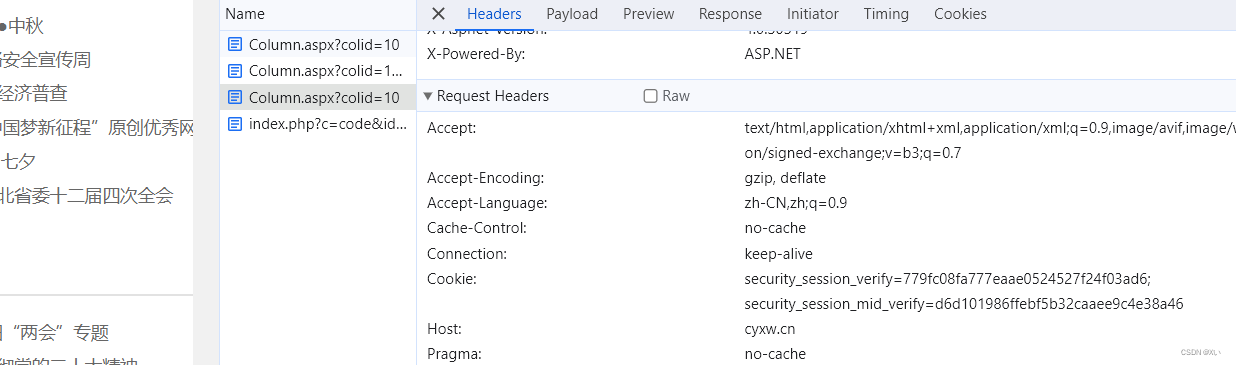

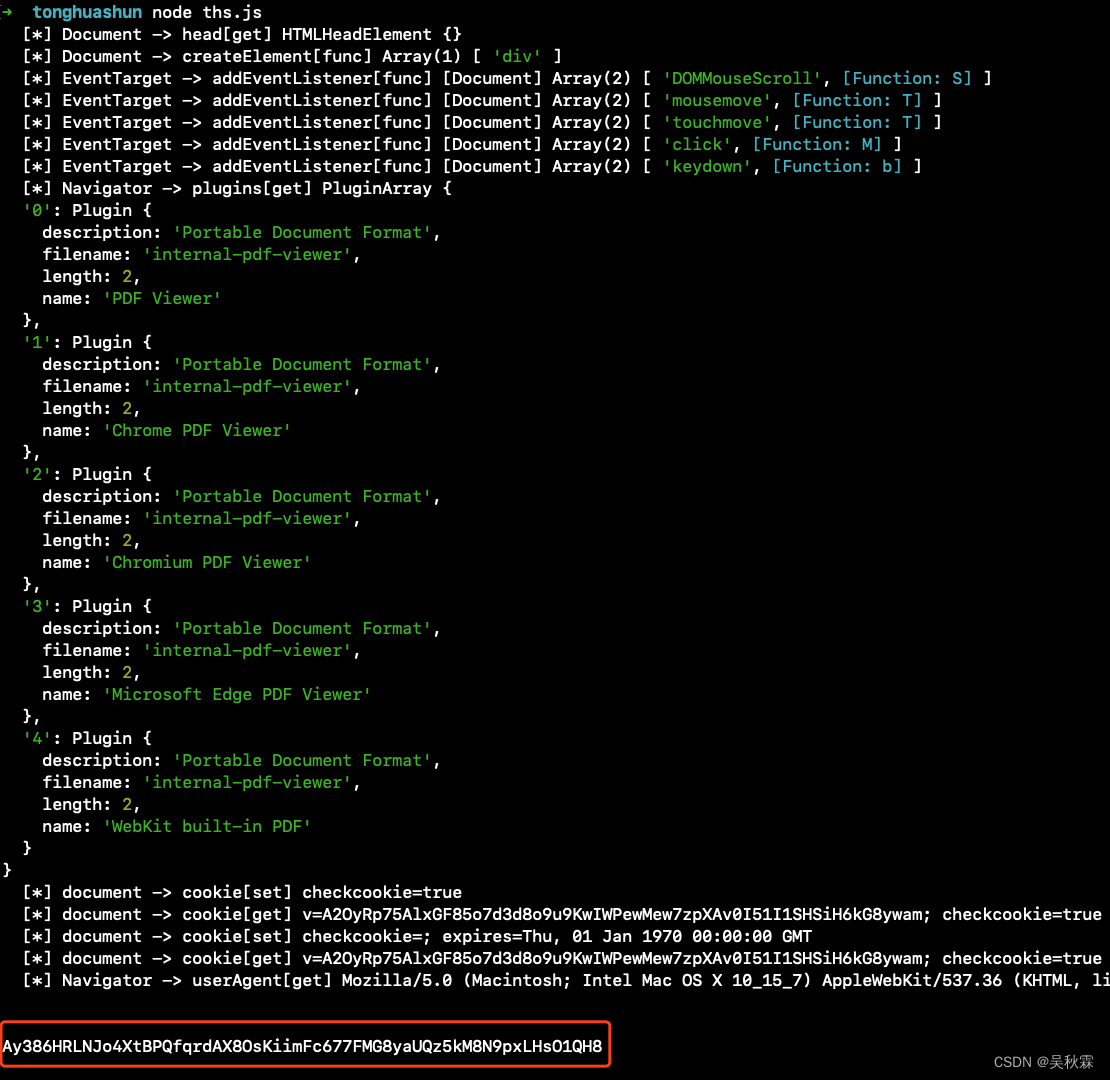

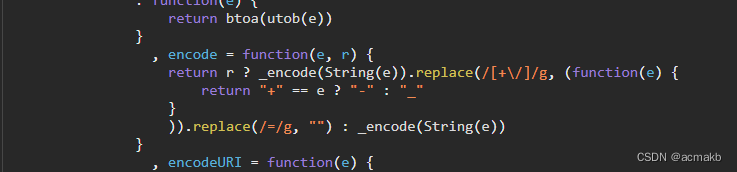

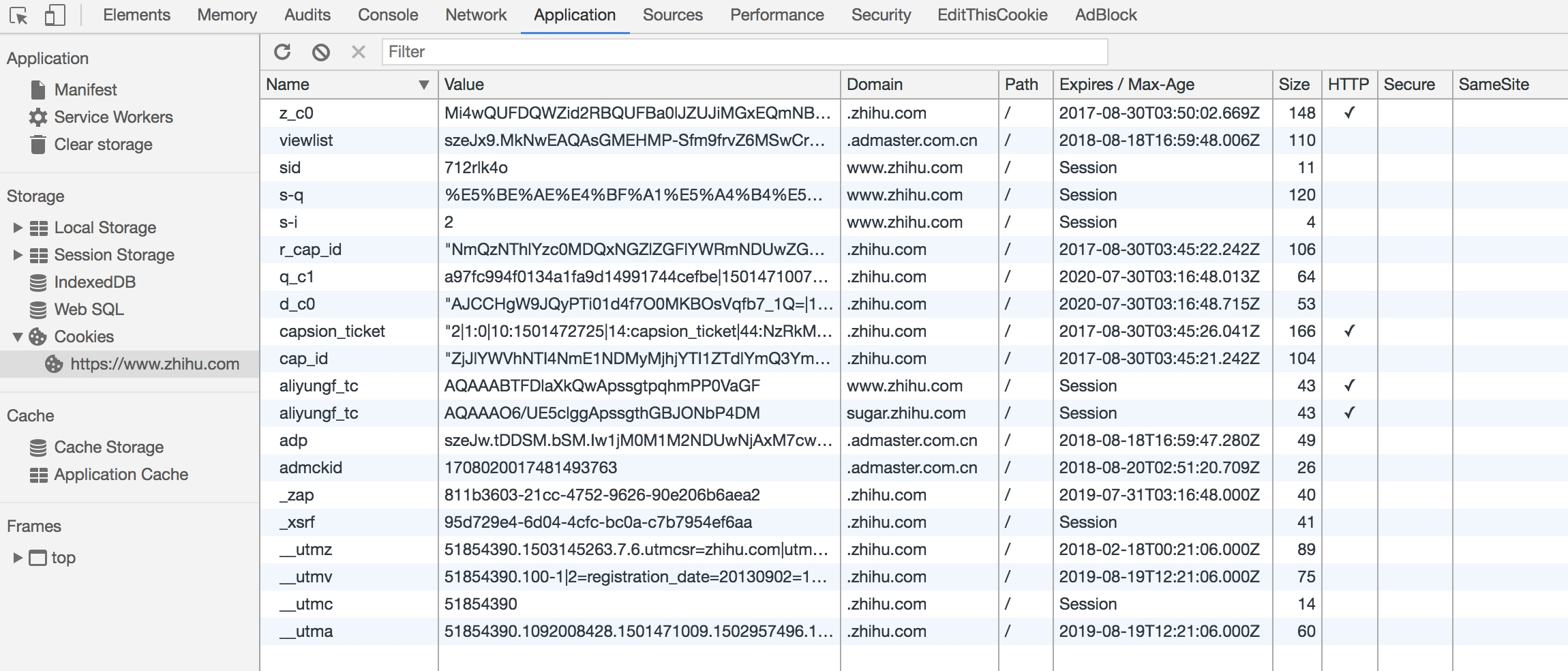

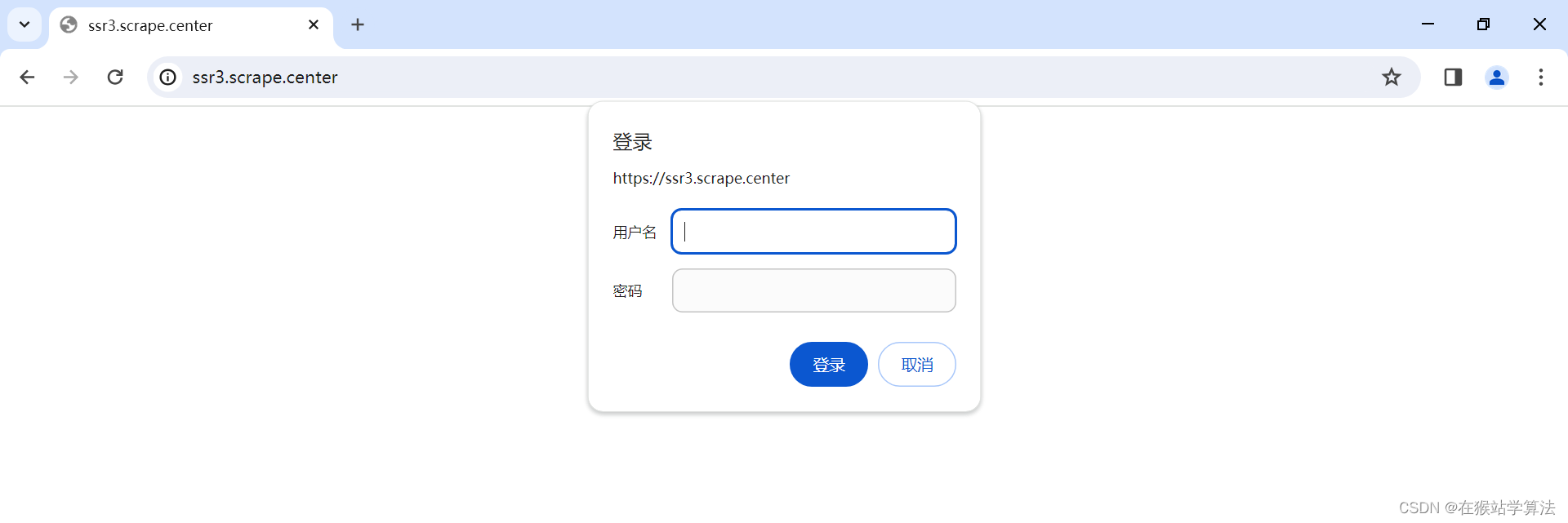

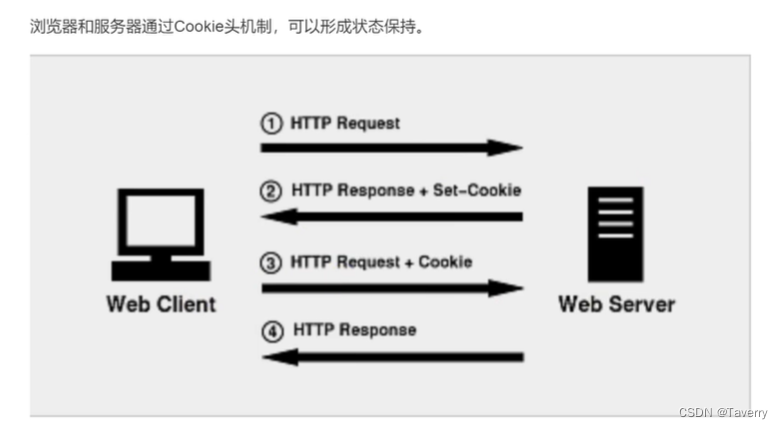

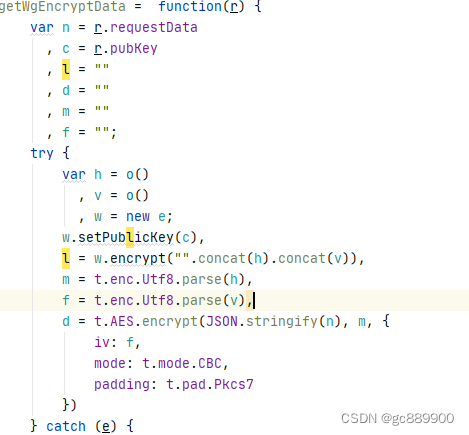

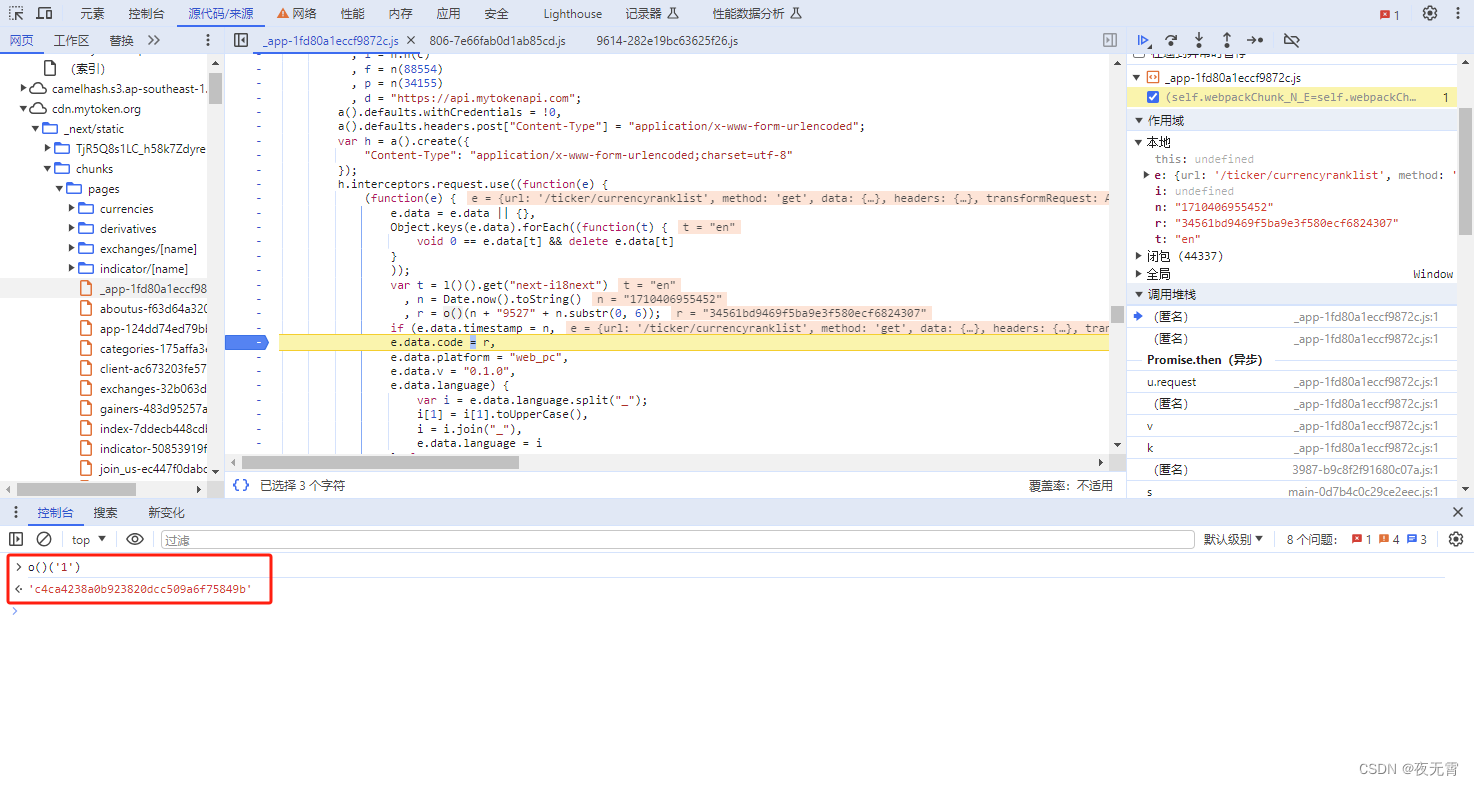

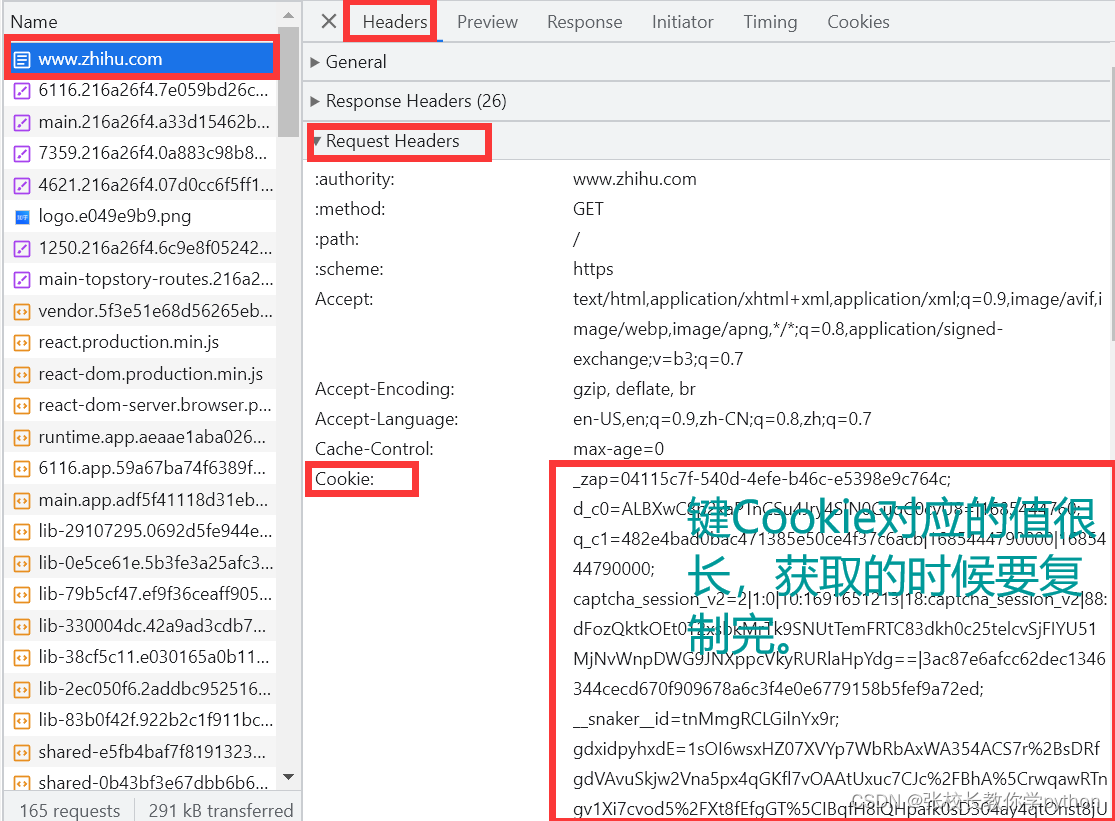

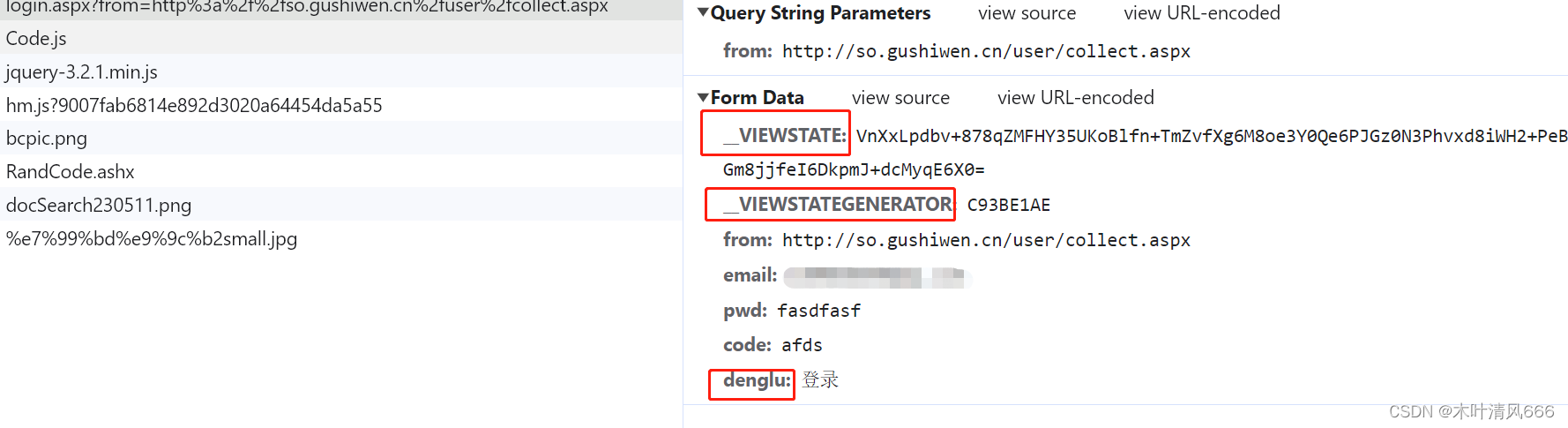

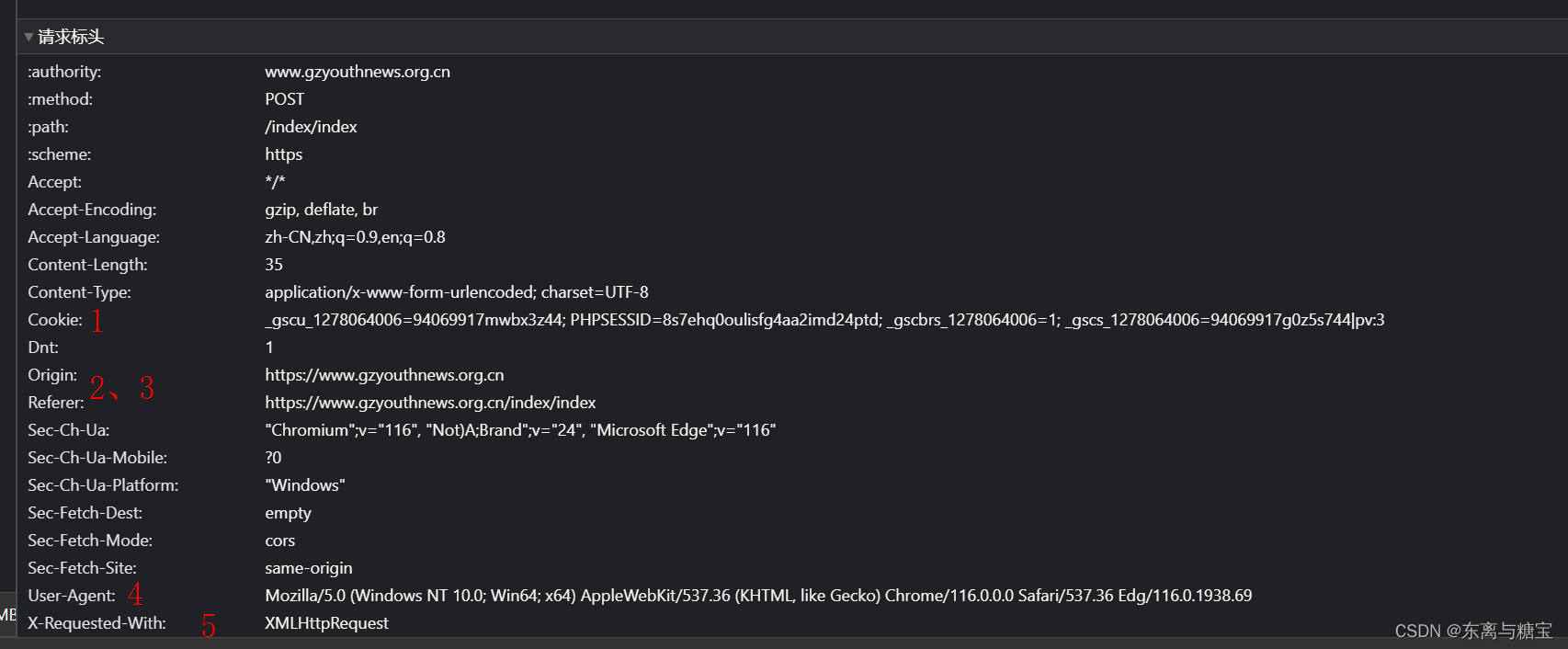

爬虫技术-cookie反爬讲解

COOkIE反爬虫 1 cookie反爬简介 Cookie 反爬虫指的是服务器端通过校验请求头中的 Cookie 值来区分正常用户和爬虫程序的手段,这种手段被广泛应用在 Web 应用中。 1.1 cookie加密原理 2 cookie逆向实践 2.1 逆向目标 地址:http://www.zjmazhang.gov.cn/hd…

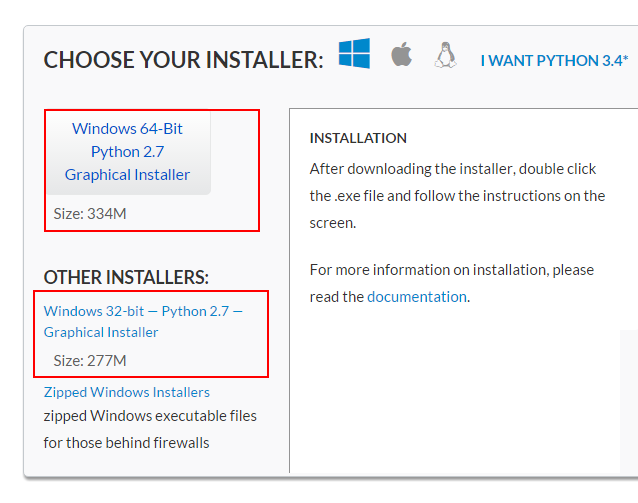

windows7 64位下环境搭建scrapy爬虫框架

适用于python 2.7 64位安装 一、操作系统:WIN7 64位 二、python版本:2.7 64位(scrapy目前不支持3.x) 不确定位数的,看图 三、安装以下软件包: 如果配置环境的时候是直接pip install scrapy安装的࿰…

基于python的爬虫方法总结(一)

爬取的方法很多,,但是不管用什么方法总结起来就3大步

确定要爬取的URL地址向网站发请求获取相应的HTML页面提取HTML页面中有用的数据 文章目录一,获取静态页面数据方法urllib方法requests方法selenium方法BeautifulSoup方法Scrapy框架方法二…

Apache Tika:通用的内容分析工具

项目介绍 Tika是一个内容分析工具,自带全面的parser工具类,能解析基本所有常见格式的文件,得到文件的metadata,content等内容,返回格式化信息。总的来说可以作为一个通用的解析工具。特别对于搜索引擎的数据抓去和处理…

Charles ——抓包工具安装与(Charles与浏览器)配置(Python爬虫必备神器)

Charles安装

1.下载

还是先介绍一下:Charles是在 Mac 下常用的网络封包截取工具,在做 移动开发时,我们为了调试与服务器端的网络通讯协议,常常需要截取网络封包来分析。Charles 通过将自己设置成系统的网络访问代理服务器…

写Python需要养成的9个编程好习惯

以写Python代码为例,有以下9个编程好习惯,整理供大家参考。

1. 提前设计

写代码和写作文一样,需要有大纲,不然很容易变成"屎山"。

思考业务逻辑和代码流程,是动手前的准备工作,这上面可以花一…

面了一个5年经验的Python程序员,对象只会最基础的,面向对象进阶之dataclass

你真的需要创建类吗?

Python中一切都是对象,所以面向对象是Python的重中之重。

但我们不一定需要创建自己的对象,有时候直接使用Python内置的列表,字典等就够了。

就算是需要创建类,也有一些不同的选择。先来看看这…

3种Python恶搞脚本,医院的WiFi实在太快了

Python 无限恶搞朋友电脑,别提有多爽了,哈哈,打造自己的壁纸修改器,电脑无限锁屏, 无线弹窗,都在这里!!!

修改电脑桌面壁纸

工具使用

开发环境:python3.7&…

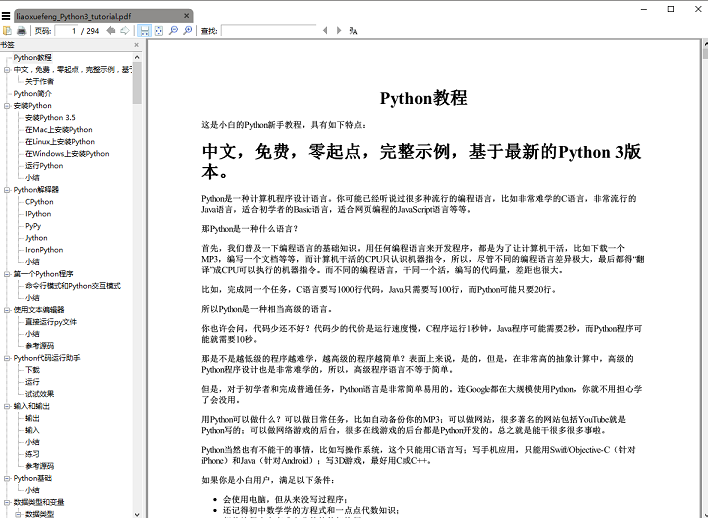

5059页,Python3.x最新版「官方中文教程」已经发布,内含教程、标准库、语言参考,及新版本特性

总有人问我:大数据人应该学习哪些技术栈?

结合许多大佬的看法,为大家总结了三条! 1. 掌握Python编程语言

只会Python不一定可以找到工作,但我可以说,你如果会其它数据分析软件,那么掌握Python…

一年阿里算法工程师的工作总结

看到一篇阿里算法工程师分享的一年工作总结,看完想起来当年的自己,很有借鉴意义,分享给大家~

20年5月到现在入职阿里已经快一年了,一年之中也做了几个项目,期间趟过了不少坑,以往的年度总结都是闭门造车&a…

用Python找到了隔壁蹭网妹子的QQ号

最近发现晚上有人老是在蹭网,而且严重怀疑是我的美女单身邻居,这可是千载难逢的好机会。于是我用Python轻松找到了它的QQ号,开始了我的桃花之旅…下面给大家介绍一下我是怎么做到的。 1-登入路由器进行分析

蹭网的信息全部都在路由器上&…

100道Python常见面试题

Python现在已经成为最热门的编程语言之一,IEEE Spectrum统计数据显示,Python无论从普及度和生态规模都已位居编程语言第一,而且相关职位也越来越多,无论数据岗、测试岗亦或开发岗都对Python技能有着高度的需求。 从求职来看&#…

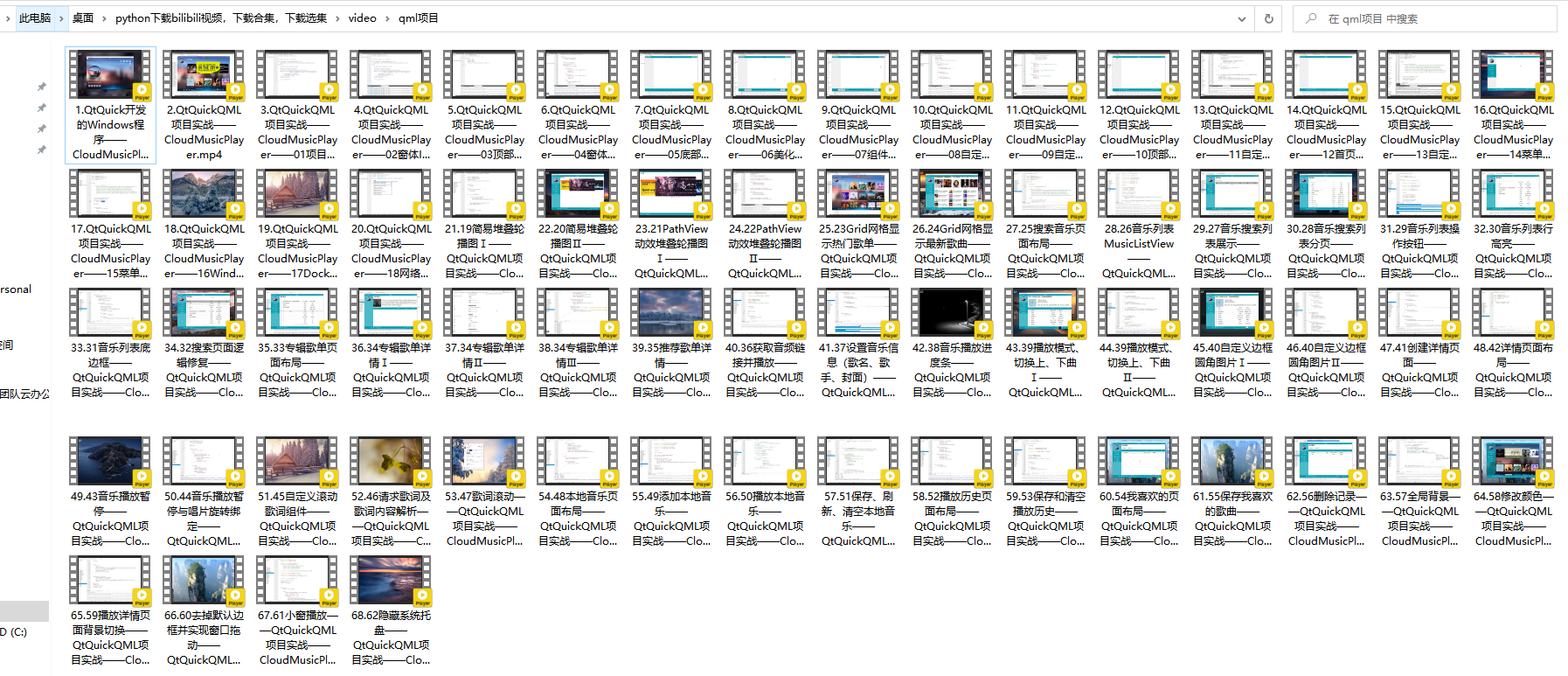

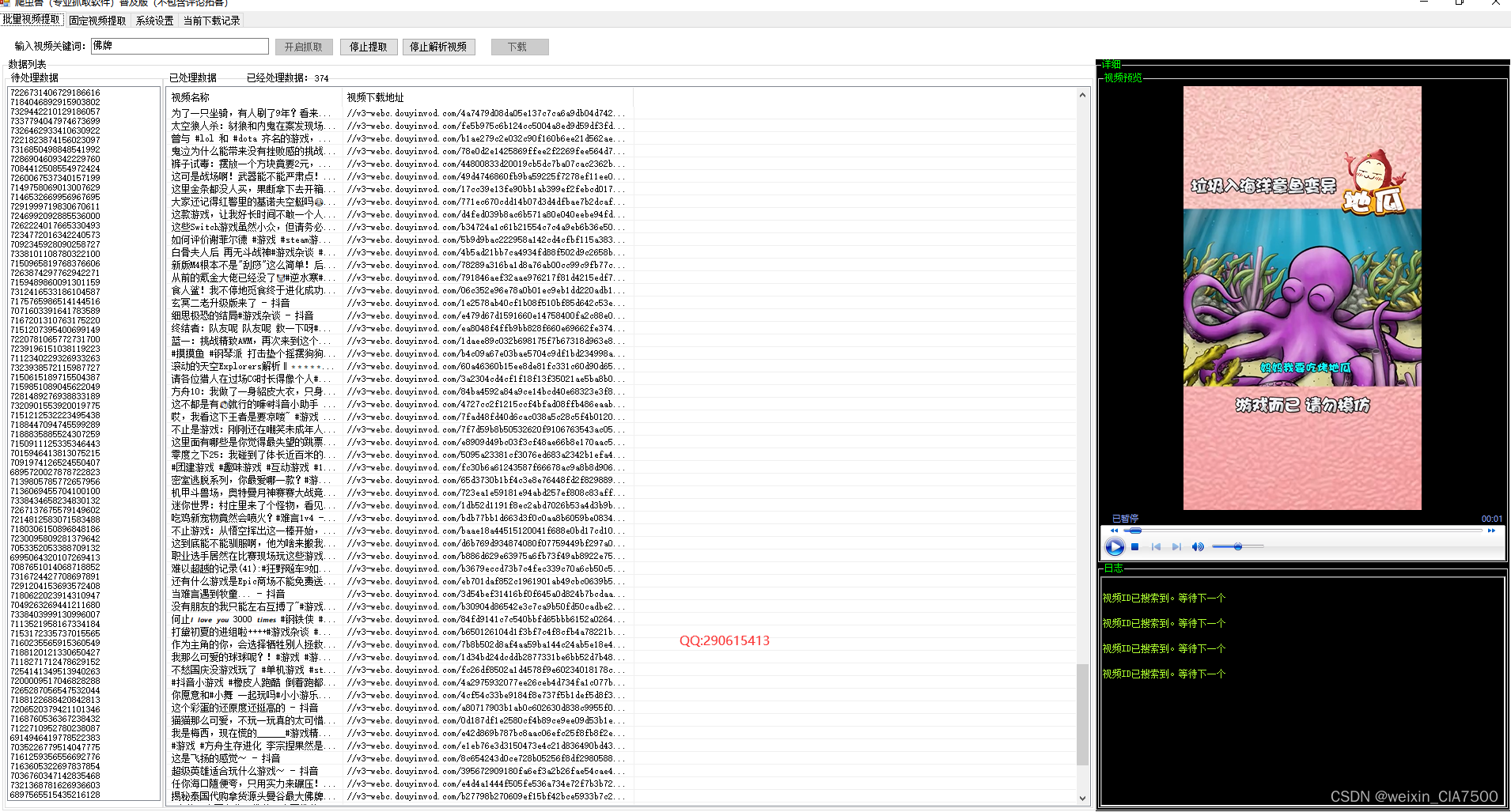

用python批量把这些好看的视频下载到本地

话说人生苦短,我用Python。

如果学python不是为了爬视频,那将毫无意义! 啊呸,老色批 咳咳,我们开始正题。

一、事前前奏

首先没装Python、pycharm的铁子先自己安装一下,我就不写安装了。

安装教程和软件…

终于,Python 标准库要做“瘦身手术”了

Python 社区有一个比较独特的概念是“内置电池”(Batteries Included),指的是 Python 自带丰富多样的标准库,开箱即用,动力十足。根据官方文档显示,Python 内置了 200 多个标准库,它们对于 Pyth…

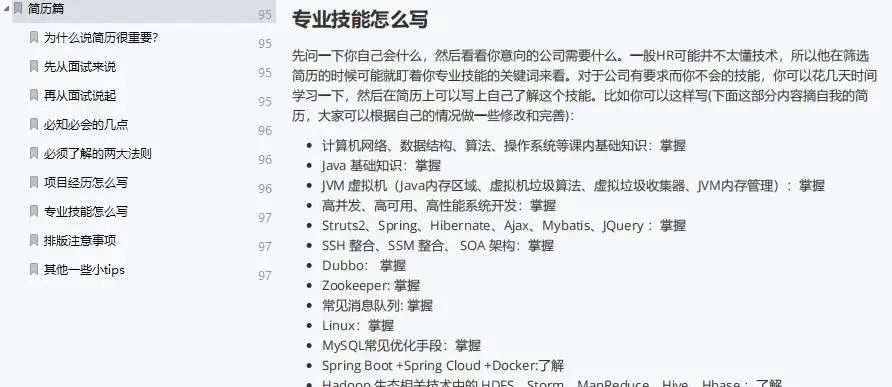

应届生求职分享:拿到数据分析offer,我做对了什么

大家好,我在9月份就紧锣密鼓的开始投简历和面试。

今天给大家的分享主要分为三个部分。

第一、面试前要做哪些准备。

第二、我的面试经历。

第三、投身到工作中后,我们需要从哪些方面继续努力。

01、面试前的准备

关于面试前的准备,就是…

30岁,放弃国企稳定的工作,转行数据分析

30岁,放弃国企稳定的工作,选择转行数据分析!

很多人问我会不会后悔?

说实话,决定要转行那会我也犹豫过、迷茫过,但是现在我很庆幸自己当初的抉择。

在决定转行之前,很多亲朋好友听说之后&…

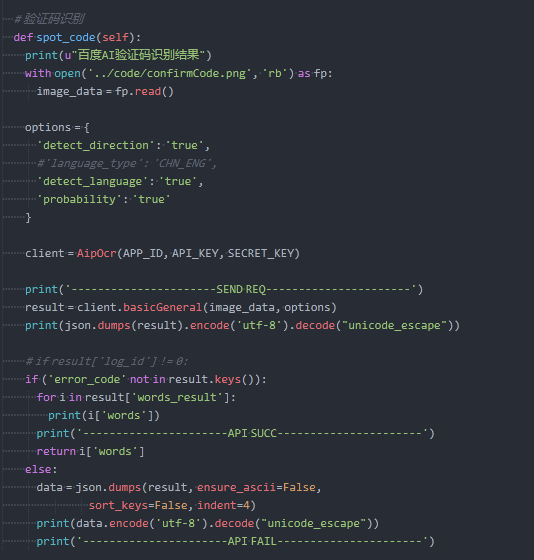

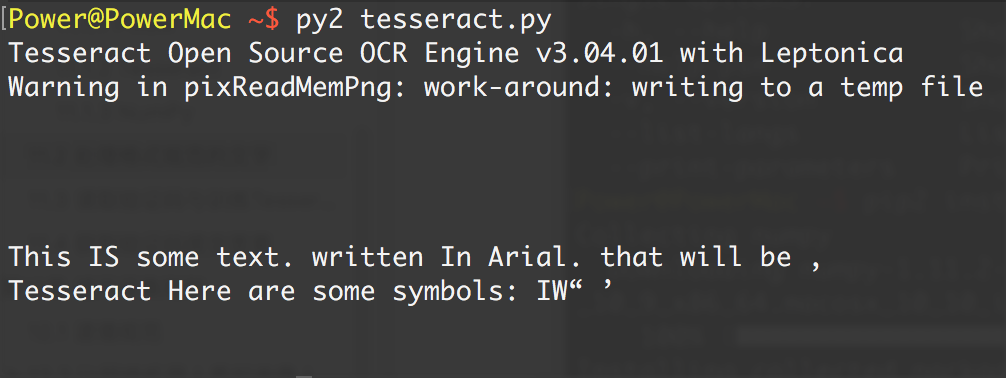

用python帮别人写了个文字识别程序

前言

就在前几天一个大一学妹打破了我繁忙的生活,我纳闷了,直接问她啥事啊(老直男了) 原来是找我帮个忙,作为好学长那肯定得助人为乐啊… 话不多说,进入正题

一.需求分析

根据学妹的描述来看,就只是想要一个能识别图…

selenium不加载图片+下拉滚动条

从豆瓣的源安装 selenium

pip install -i https://pypi.douban.com/simple/ selenium配置浏览器不加载图片

from selenium import webdriveropt webdriver.ChromeOptions()

prefs {profile.managed_default_content_settings.images:2}

opt.add_experimental_option(prefs…

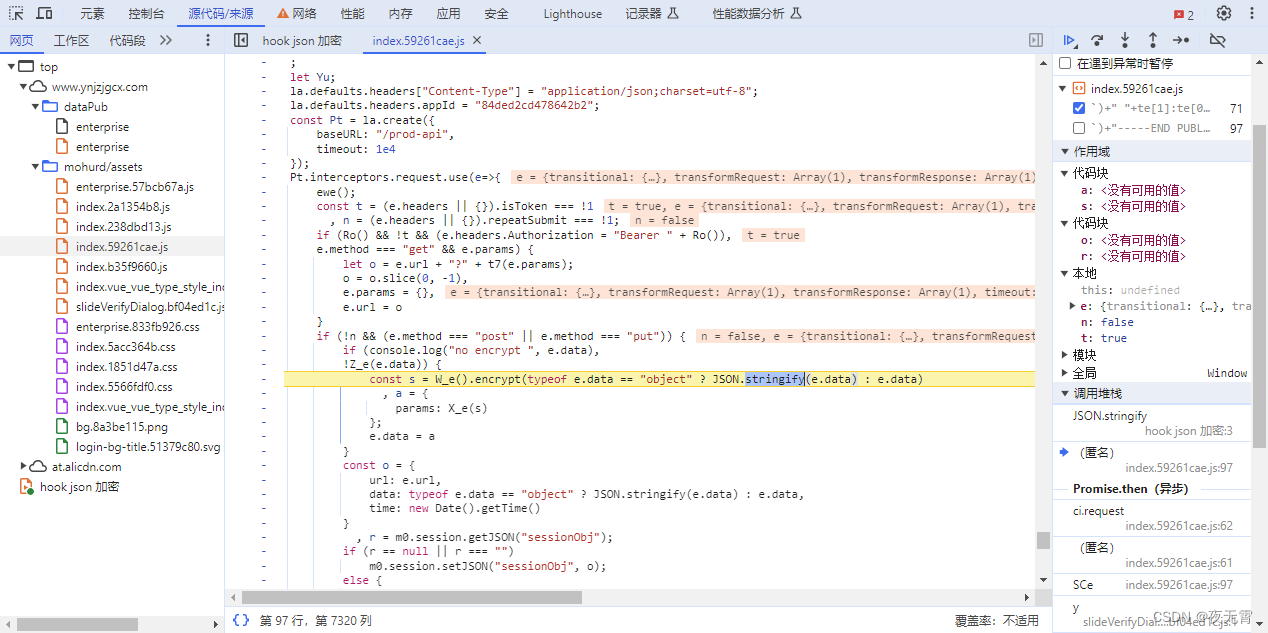

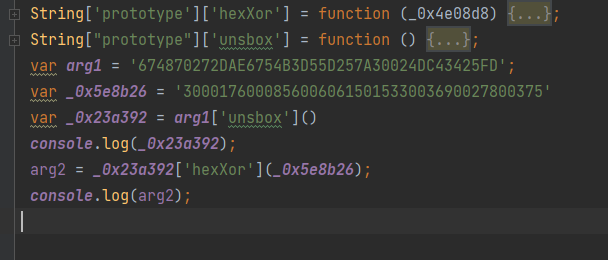

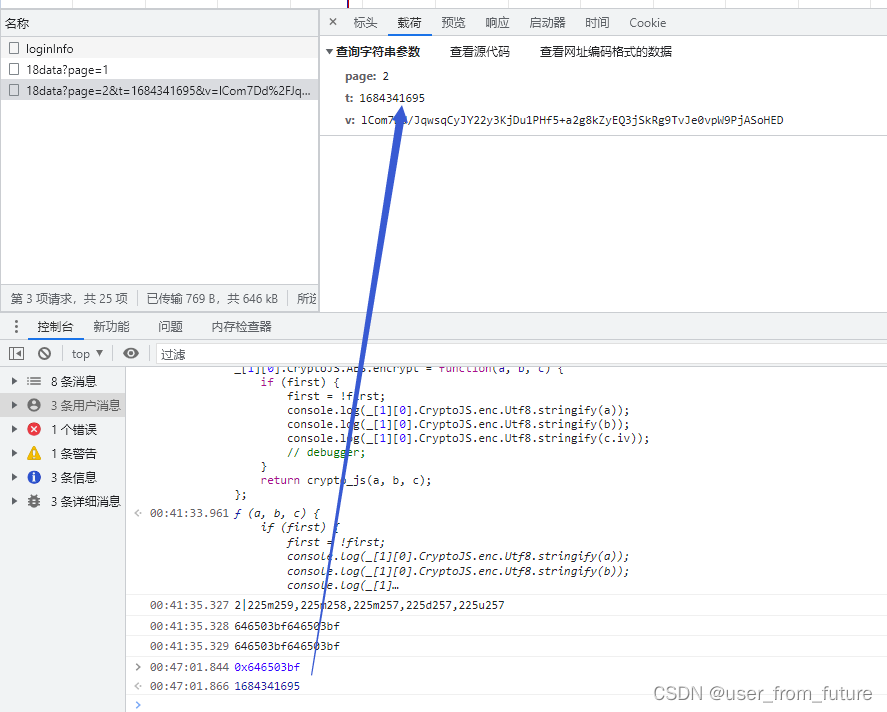

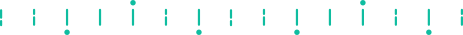

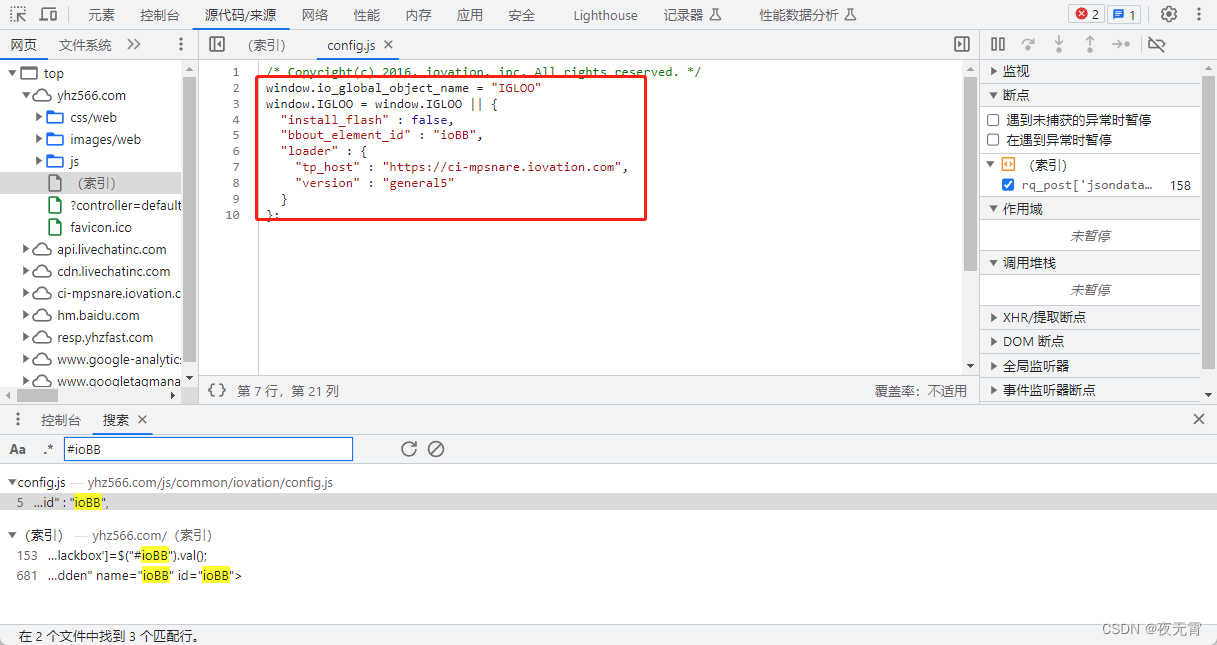

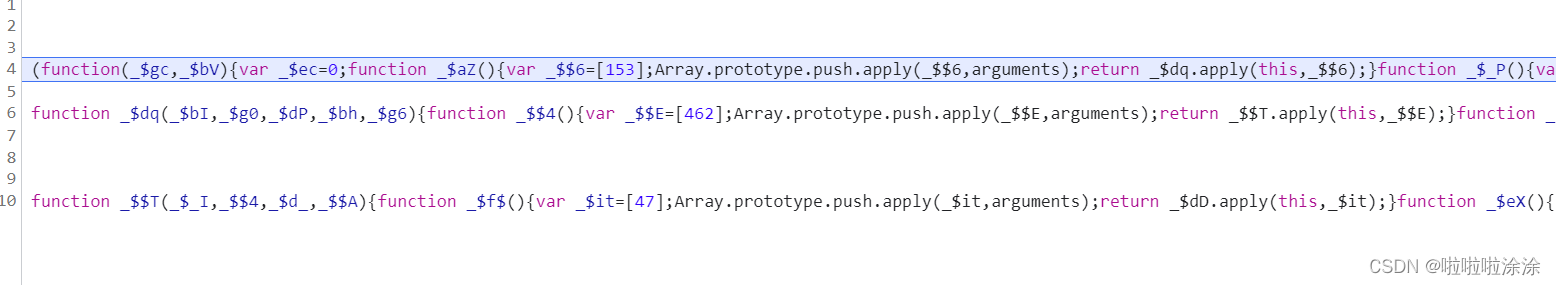

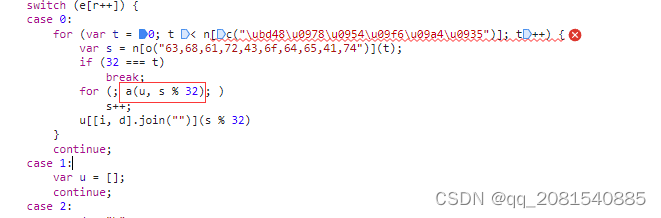

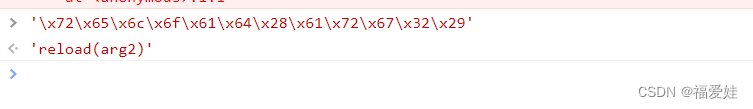

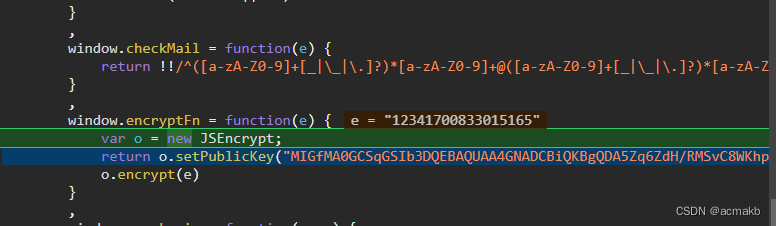

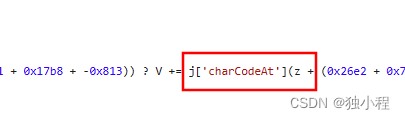

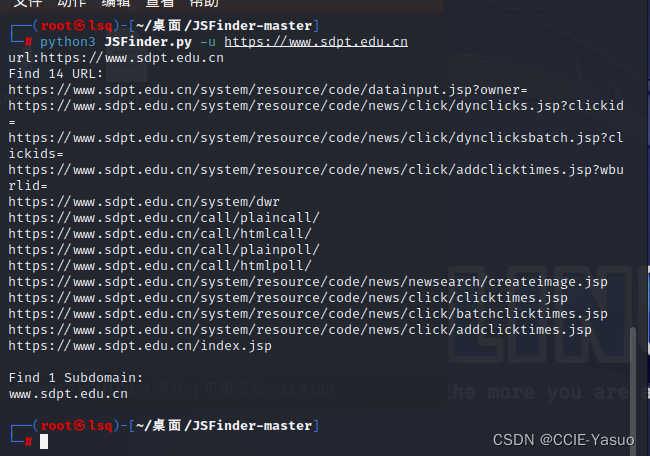

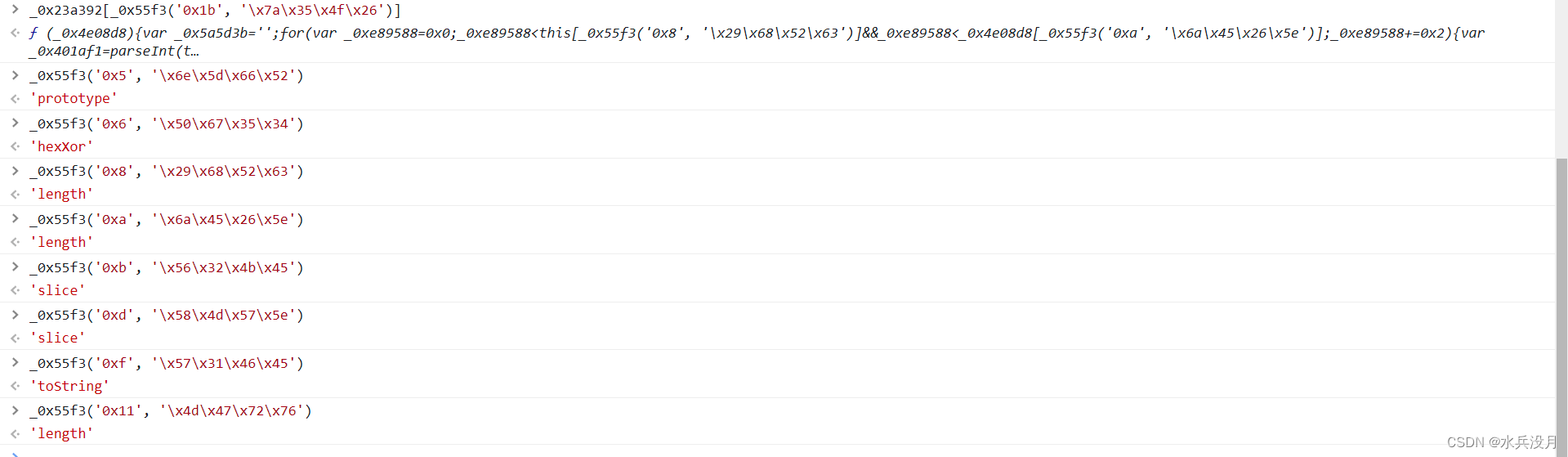

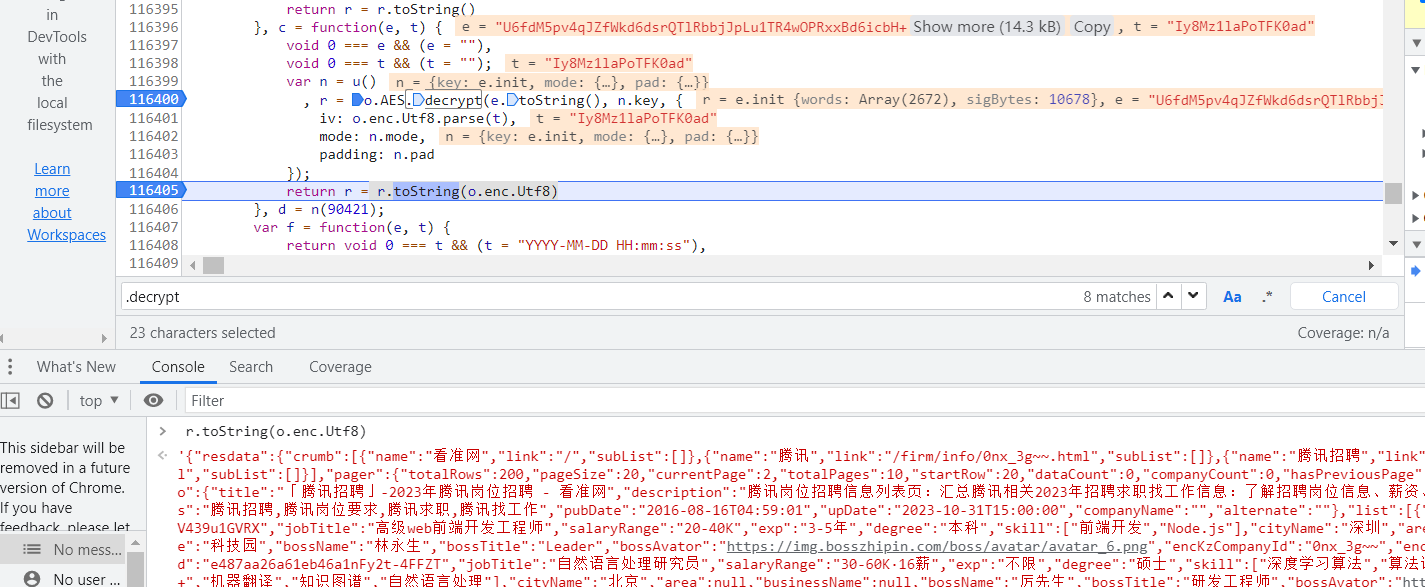

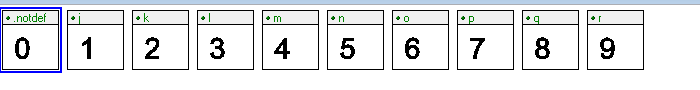

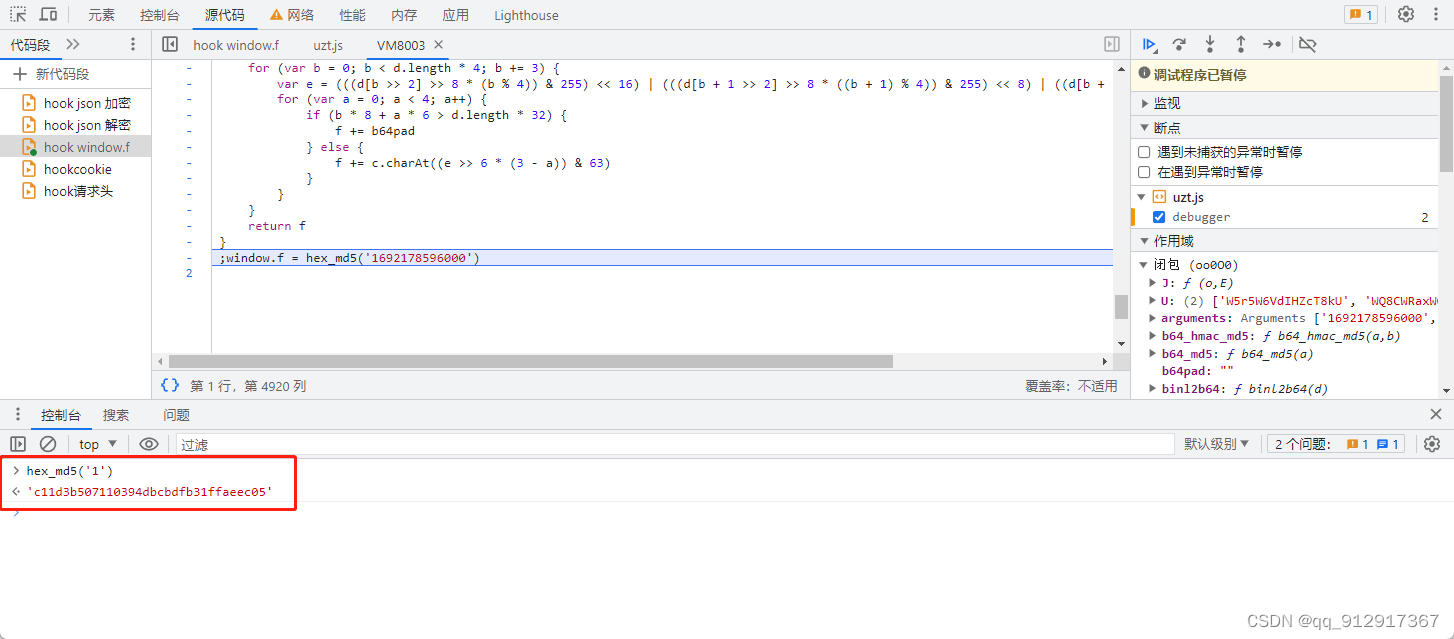

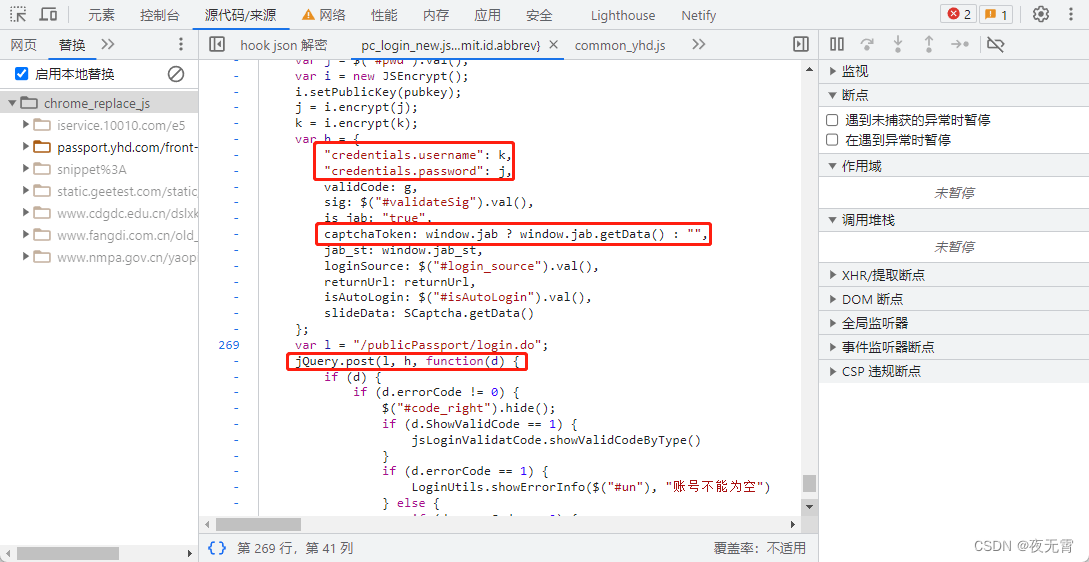

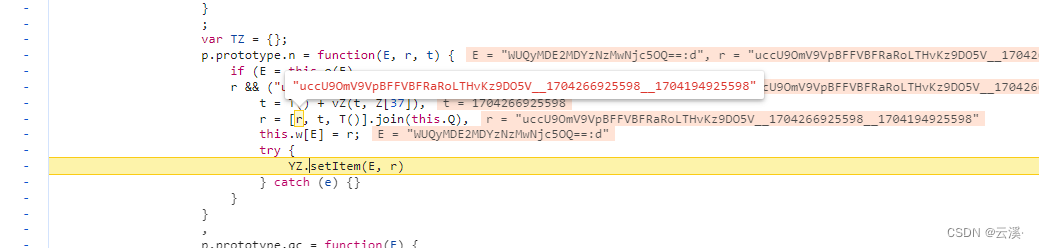

无忧代理免费ip爬取(端口js加密)

起因 为了训练爬虫技能(其实主要还是js技能…),翻了可能有反爬的网站挨个摧残,现在轮到这个网站了:http://www.data5u.com/free/index.shtml 解密过程 打开网站,在免费ip的列表页查看元素选一个端口&#…

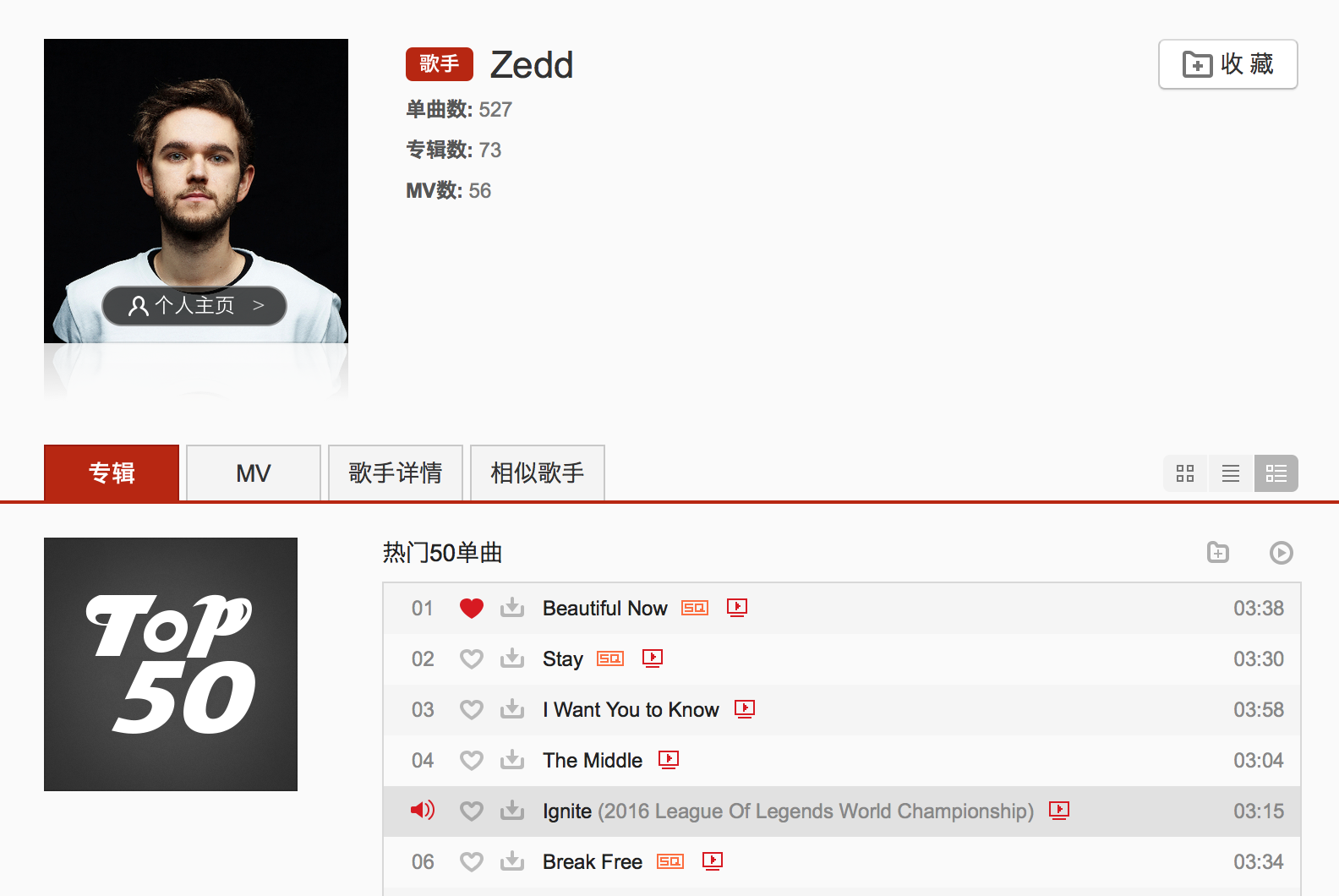

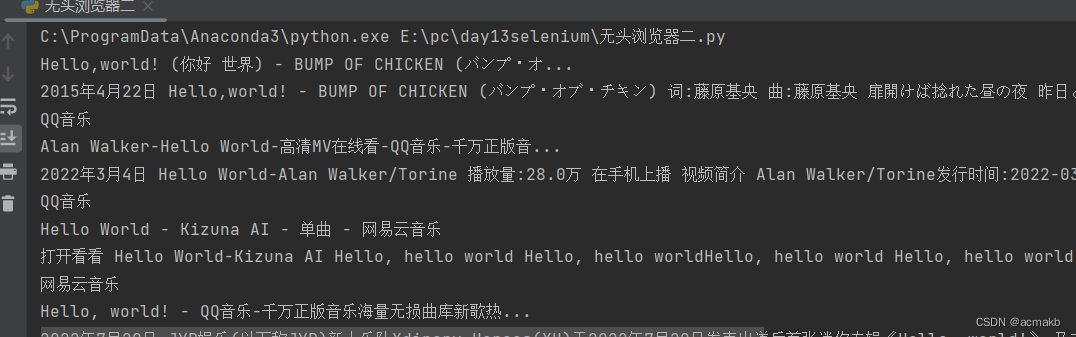

Selenium模拟浏览器获取爬取QQ音乐歌词、评论等。

目录说明Code说明

请使用爬虫Selenium模拟浏览器获取爬取QQ音乐中你喜欢的某位歌手(可以是任意歌手)最受欢迎的前5首歌曲的歌词、流派、歌曲发行时间、评论条数、评论时间、评论点赞次数、评论内容具体(每一首歌的评论>500条)。

如下图所示…

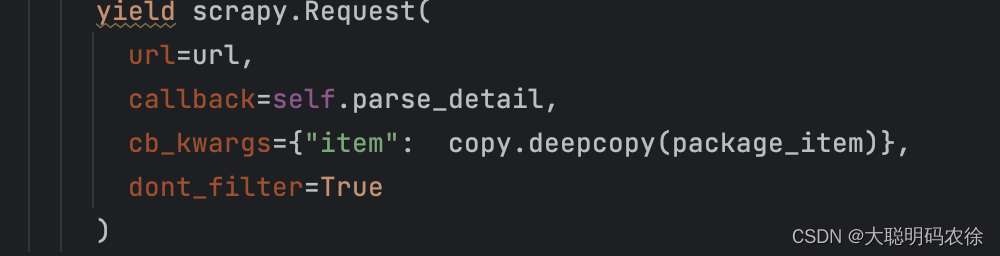

爬虫_09_请求传参中间件大文件下载CrawlSpider

09_请求传参&中间件&大文件下载&CrawlSpider

五大核心组件

目的

大概了解scrapy的运行机制为分布式铺垫 请求传参实现的深度爬取

深度爬取:爬取的数据没有在同一张页面中(例如首页数据详情页数据)

在scrapy中如果没有请求传…

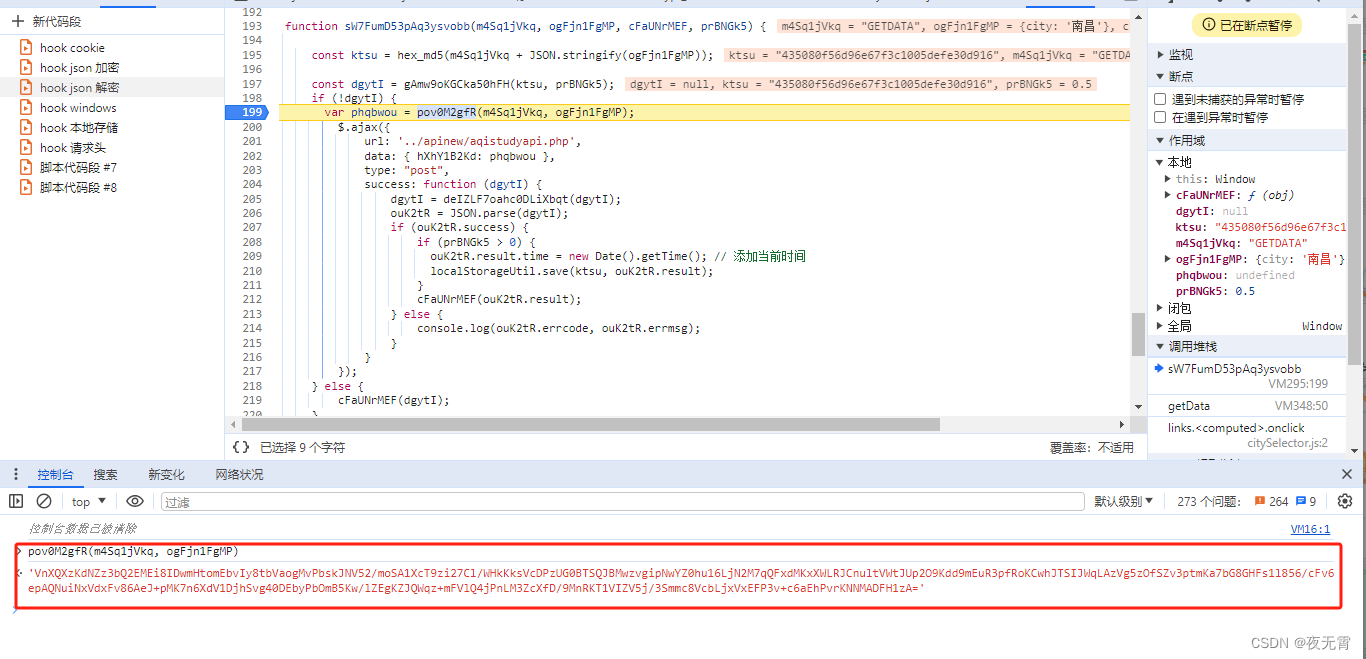

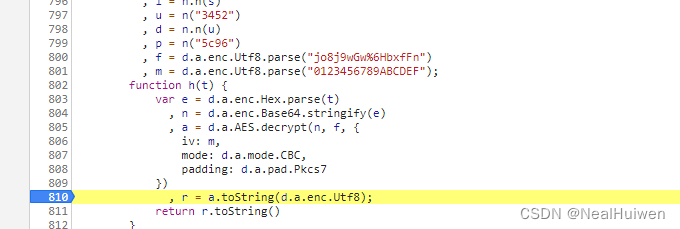

爬虫_06_余票检测js解加密

06_余票检测&js解加密&12306模拟登录

余票检测1️⃣

JS解密混淆破解

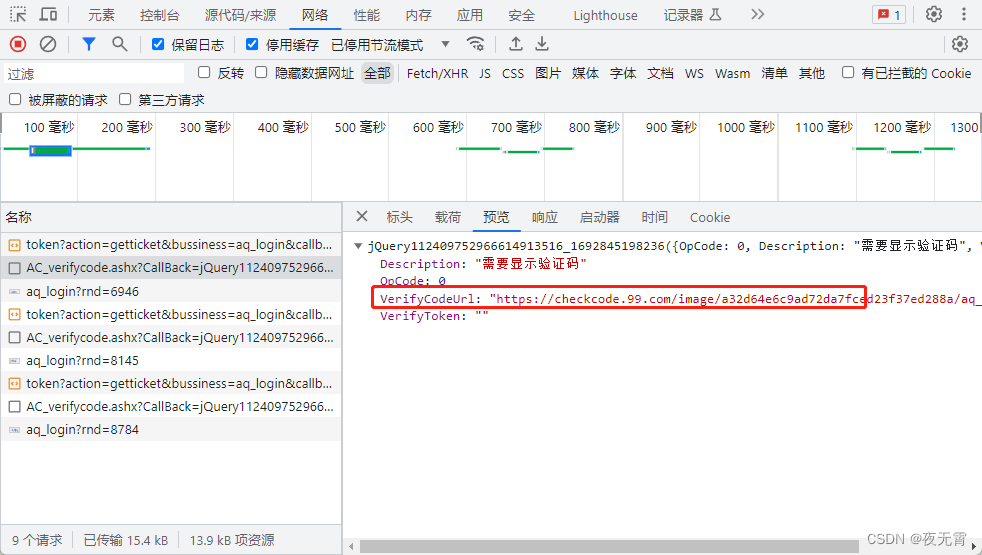

博客地址:https://www.cnblogs.com/bobo-zhang/p/11243138.html爬取的网站:https://www.aqistudy.cn/html/city_detail.html

分析 修改查询条件(城市的名称时间…

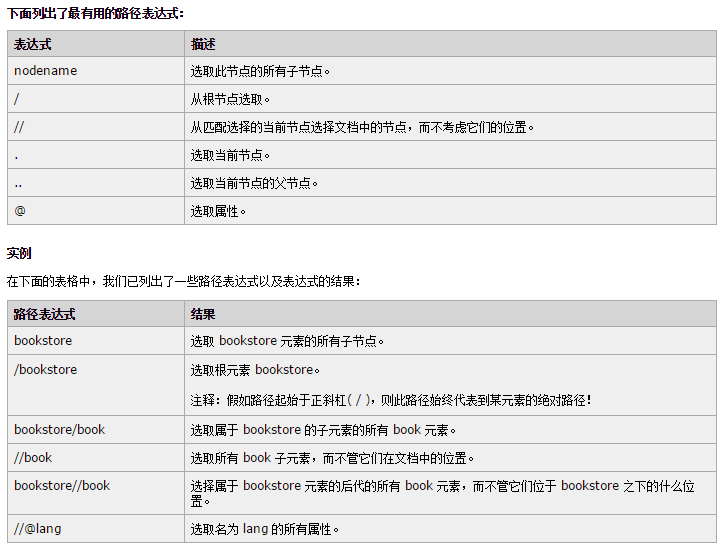

Python爬虫基础学习,从一个小案例来学习xpath匹配方法

学习目的是为了实践,而实践又可以加深我们的学习效率,今天给大家带来了lxml库的xpath匹配方法的实例!教程大家网上搜索有很多,我们只看实用功能,当然,如果您已经很熟练了,可以跳过不看的&#x…

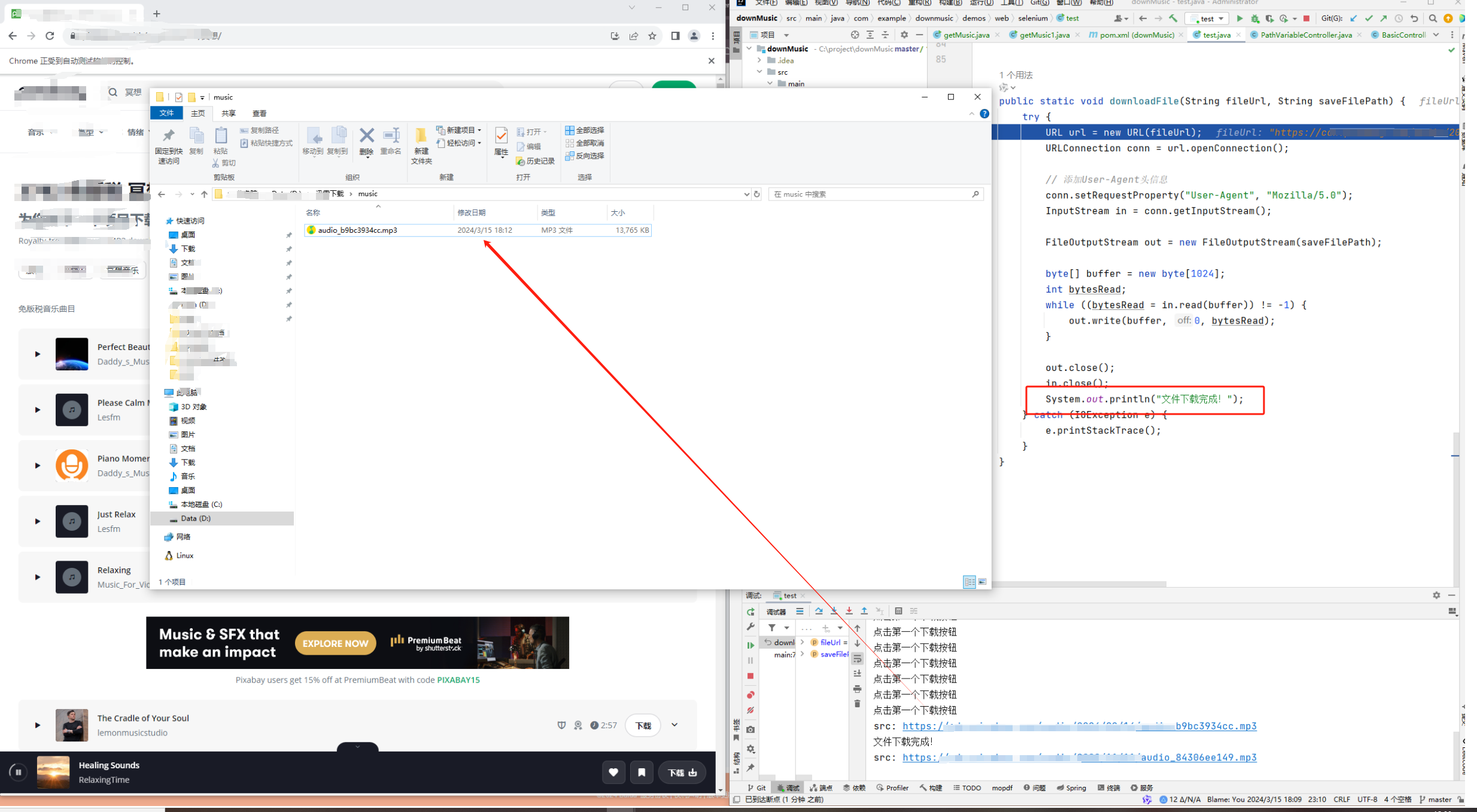

简易Java爬虫制作

一、文章来由 本来最近任务挺多,但是今天想放松一下,正巧Bill喜欢玩英语配音,而配音都是在配音软件的云上,我想把那些都拿到,于是就写一了一个爬虫,接着就有了这篇爬虫教程~~ 二、爬虫!…

magento性能优化:禁用访问日志记录

2019独角兽企业重金招聘Python工程师标准>>> 系统记录所有访问数据到数据库里面,包括访客及机器的访问(例如搜索引擎爬虫),机器访问通常会占大部分,记录大量数据,这样会生产不小的额外服务器性能…

为什么说python挣钱快?本来还不信,结果7天小赚1k

当今收入低于5000的人至少占到40%,完全不够养活一家人,而且很多小伙伴其实空余时间比较多,特别是大学生,零花钱又不够花,都想靠业余时间找点轻松的活增加收入,但是却没门路,现在的社会中&#x…

看到室友用Python制作贪吃蛇小游戏,我直接偷偷学会

最近有很多的同学问,能不能用Python做出一个小游戏来,而且最好要讲清楚每一段干嘛是用来干嘛的

那行,今天将来讲解一下用Python pygame做一个贪吃蛇的小游戏 据说是贪吃蛇游戏是1976年,Gremlin公司推出的经典街机游戏,…

用Python写的一个2048小游戏,这可能就是程序员的乐趣吧

原理介绍

“使用方向键移动方块,两个数字相同的方块撞在一起后,将会合并为一个数字是原来两倍的新方块。游戏的时候尽可能多地合并这些数字方块就行了。” 大概了解了游戏规则之后,我们就可以开始写这个游戏啦~首先,进行一下游戏…

如何在 Python 中隐藏和加密密码?

有多种 Python 模块用于隐藏用户输入的密码,其中一个是**maskpass()模块。在 Python 中,借助maskpass()模块和base64()**模块,我们可以在输入时使用星号(*) 隐藏用户的密码,然后借助 base64() 模块可以对其进行加密。

maskpass()…

python零基础不用怕,程序媛轻松教你入门,连安装步骤都给你准备啦

python零基础不用怕,程序媛轻松教你入门,连安装步骤都给你准备啦你还有什么理由不学习!! 大家好,今天带领大家进行Python从入门到提高的学习路程。首先我们先对Python有个基本的了解和清晰的概念,然后再一步…

为什么网上Python爬虫教程这么多,但是做爬虫的却很少呢?别再被忽悠啦

网上教程多,是因为入门简单,容易获得成就感,容易忽悠小白

爬虫就是因为太有技术含量,所以会的人少,可能看起来做的人就少了

爬虫远比我们想的复杂

大多数人会的,只是造一颗螺丝钉,而整个爬虫…

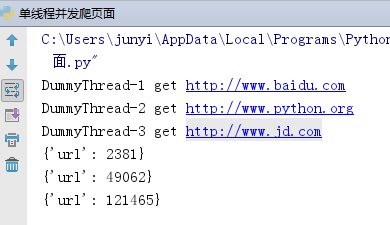

谁有粉?就爬谁!他粉多,就爬他!Python 多线程采集 260000+ 粉丝数据

今天你想爬谁的粉呢? 谁粉多,就爬谁。 那谁有粉? 沉默王二有粉。

今天咱们继续学习 Python 爬虫,从本篇博客开始进行短暂的(15 篇)多线程爬虫学习。

第一篇就要采集 大佬沉默王二 的粉丝,坐拥…

[antd-design-pro] mock 数据(post,request不一致)Sorry, we need js to run correctly!

Sorry, we need js to run correctly! 可能问题: mock数据 api 和 request api 不一致 POST /api/banners/leftexport async function querySideBanner(params) {return request(/api/left/banners, {method: POST,body: params,});}转载于:https://www.cnblogs.…

编写爬虫的几个注意点

写入文件时: 一: 由于windows系统默认打开编码格式为gbk, 此时需将打开方式设置为 utf-8 1 with open(text2.txt, w, encodingutf-8) as f: # 改变默认编码格式

2 for j, k in zip(movie_list, director_list[1:]): # 多变量循环方法

3 f.write(j …

Python爬虫相关基础概念

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程。 哪些语言可以实现爬虫 1.php:可以实现爬虫.但是php在实现爬虫中支持多线程和多进程方面做的不好。 2.java:可以实现爬虫。java可以非常好的处理和实现爬虫…

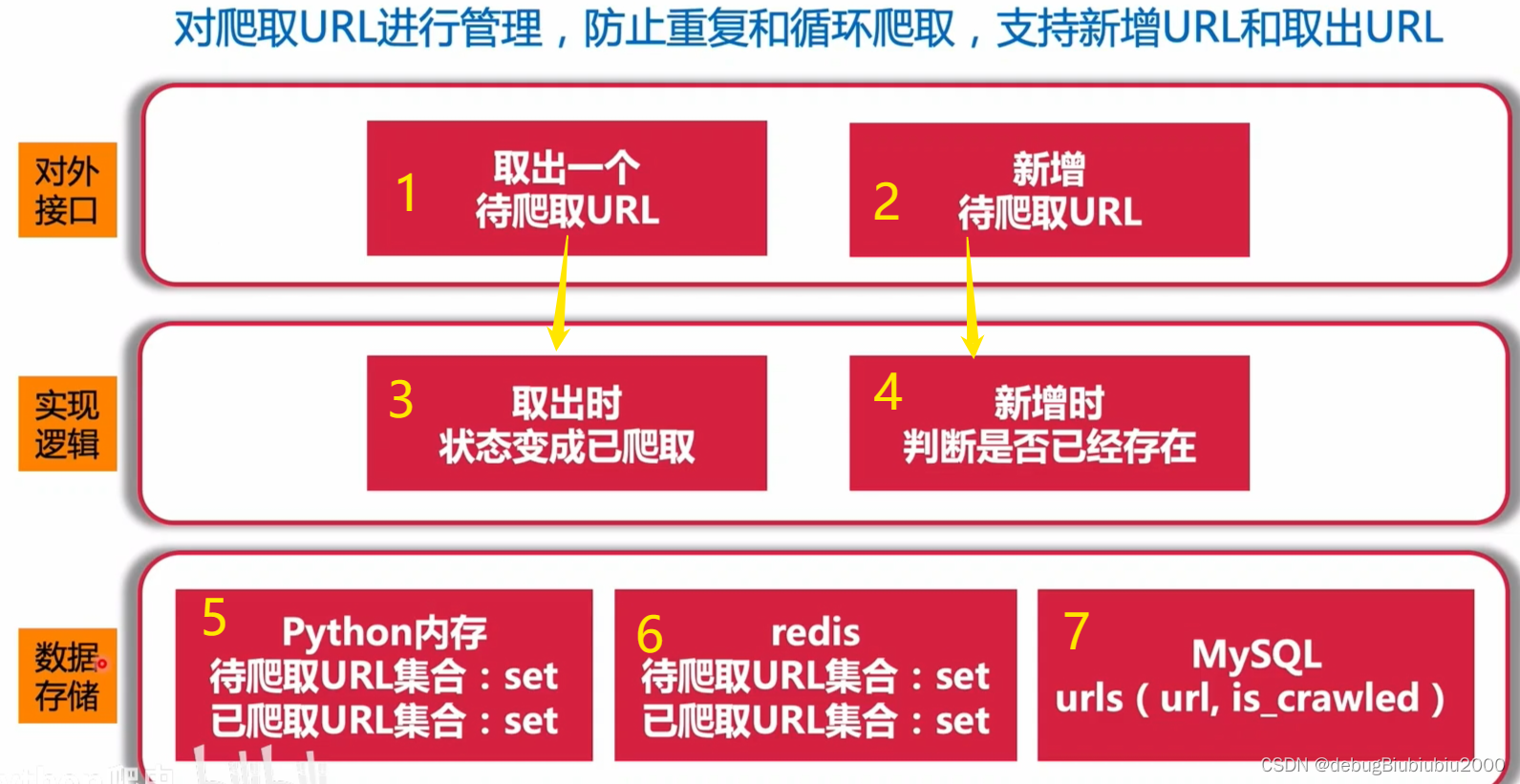

【python爬虫】—URL管理器的实现

python爬虫-url管理器 url管理器的作用python实现 url管理器的作用 在Python爬虫中,URL管理器(URL Manager)是一个重要的组件,用于有效管理爬取过程中所涉及的URL。它主要负责以下几个方面的任务: URL去重(…

《用Python写网络爬虫》——导读

前 言 互联网包含了迄今为止最有用的数据集,并且大部分可以免费公开访问。但是,这些数据难以复用。它们被嵌入在网站的结构和样式当中,需要抽取出来才能使用。从网页中抽取数据的过程又被称为网络爬虫。随着越来越多的信息被发布到网络上&…

反爬虫策略及破解方法

反爬虫策略及破解方法 作者出蜘蛛网了 反爬虫策略及破解方法爬虫和反爬的对抗一直在进行着…为了帮助更好的进行爬虫行为以及反爬,今天就来介绍一下网页开发者常用的反爬手段。1. BAN IP:网页的运维人员通过分析日志发现最近某一个IP访问量特别特别大&am…

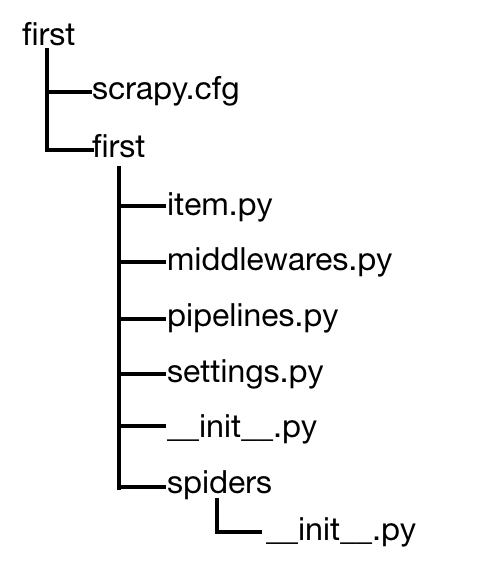

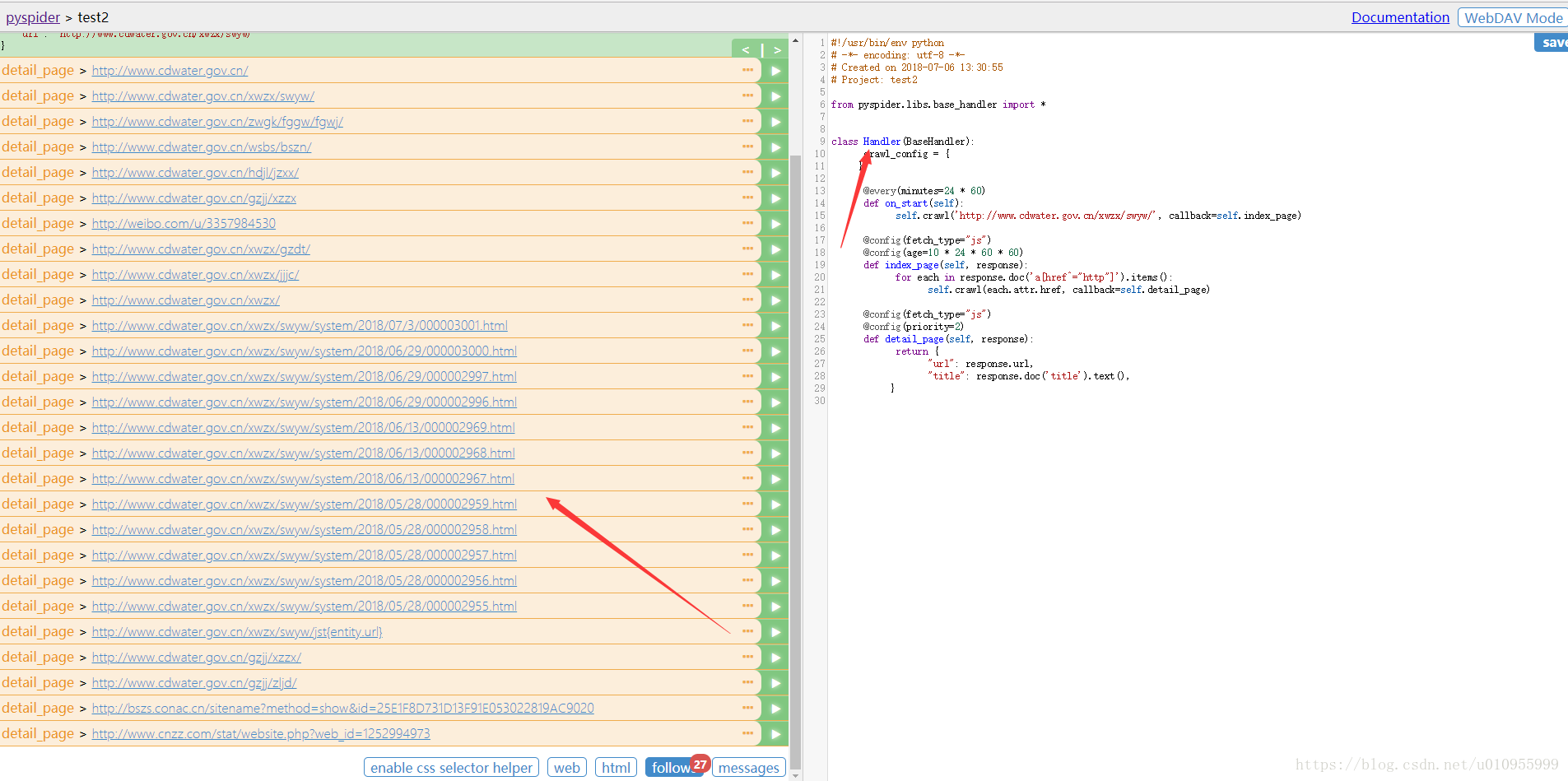

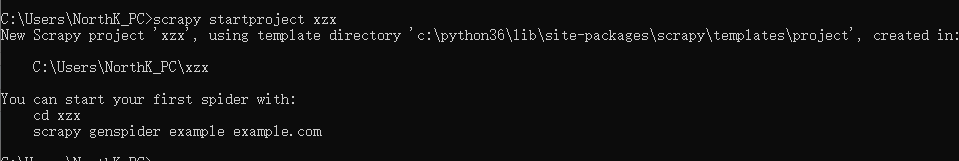

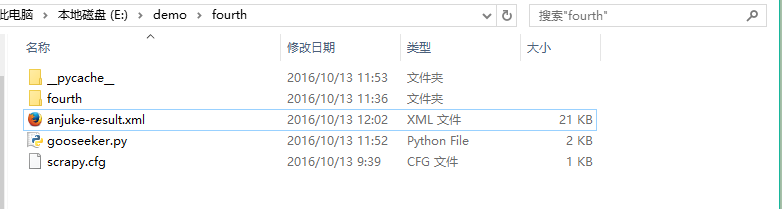

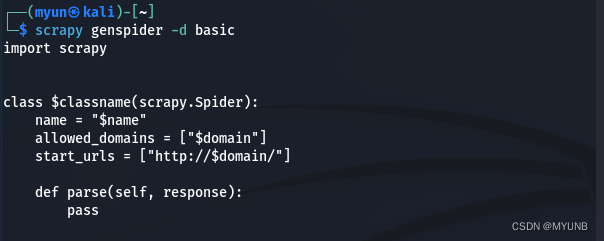

爬虫例子及知识点(scrapy知识点)

爬虫例子及知识点(scrapy知识点) 新知识: 新建一个scrapy项目:scrapy startproject xxx(项目名称)运行一个scrapy项目:scrapy crawl xxx(项目名称) 项目文件说明: 文件说…

爬虫:Scrapy14 - Telnet 终端(Telnet Console)

Scrapy 提供了内置的 Telnet 终端,以供检查,控制 Scrapy 运行的进程。Telnet 仅仅是一个运行在 Scrapy 进程中的普通 Python 终端。因此你可以在其中做任何是。 Telnet 终端是一个自带的 Scrapy 扩展。该扩展默认为启用,不过你也可以关闭。 如…

python urllib.error.URLError: <urlopen error [WinError 10060] 由于连接方在一段时间后没有正确答复或连接的主机没有反应,连接尝 试失败。

按照网上的代码学习的时候 报错信息出现了

urllib.error.URLError: <urlopen error [WinError 10060] 由于连接方在一段时间后没有正确答复或连接的主机没有反应,连接尝

试失败。>解决办法:

# 创建请求对象

req urllib.request.Request(r"http://www.…

TypeError: POST data should be bytes, an iterable of bytes, or a file object. It cannot be of type s

我在是 学习的时候,代码中是python2.x 的版本用的是urllib2 库 我是改为urllib.requst

运行是提示

TypeError: POST data should be bytes, an iterable of bytes, or a file object. It cannot be of type str解决办法。在 # 编码 data urllib.parse.urlencode(…

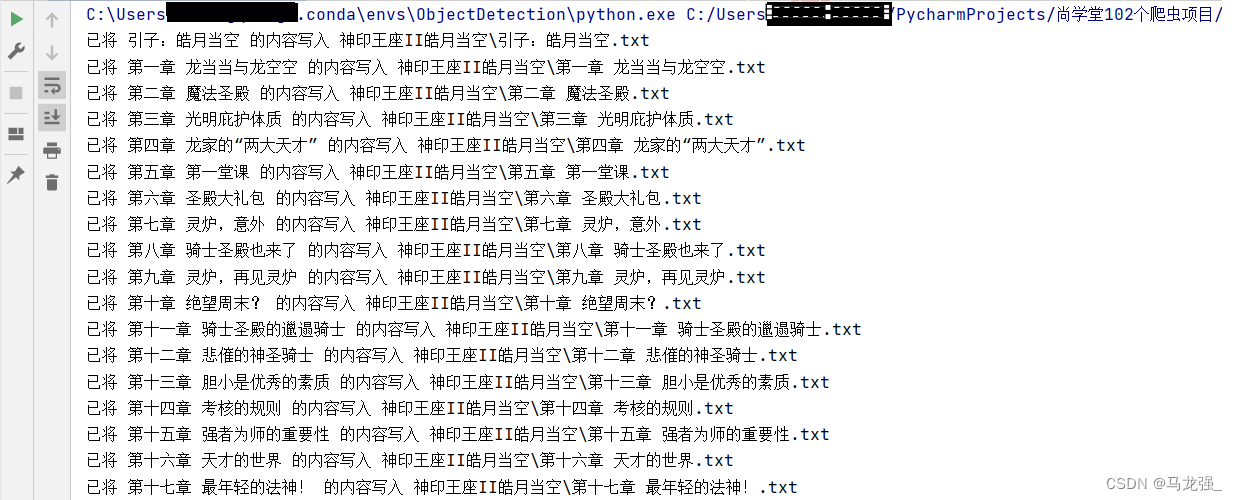

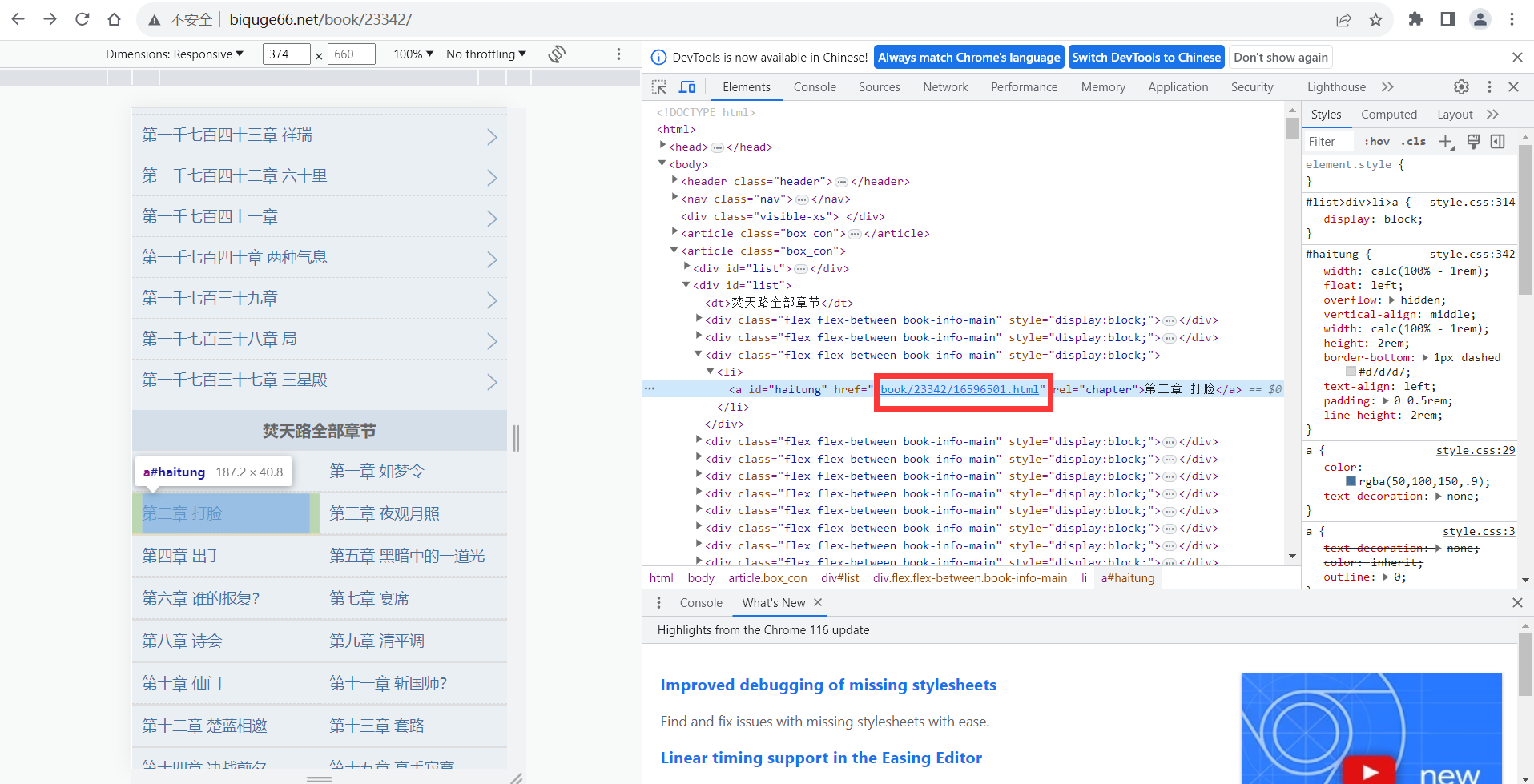

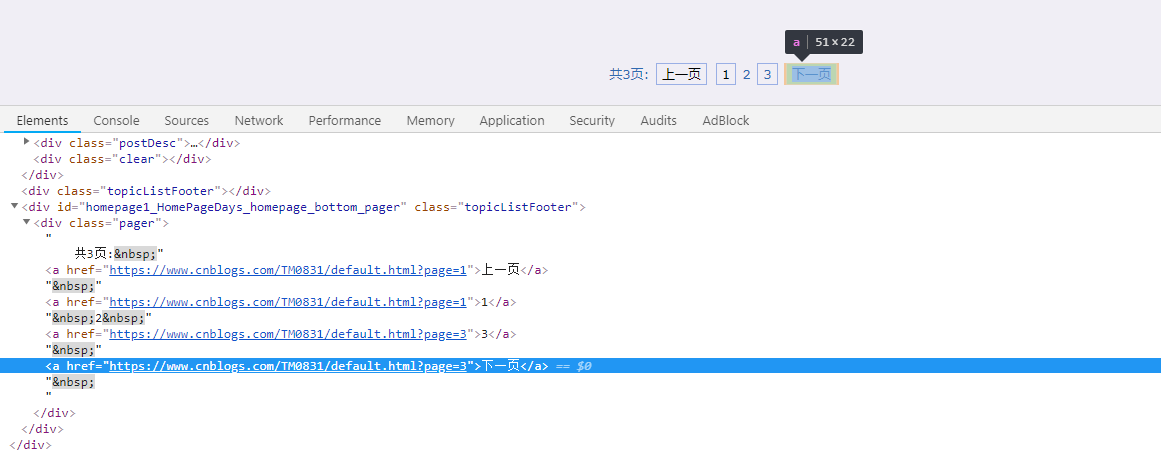

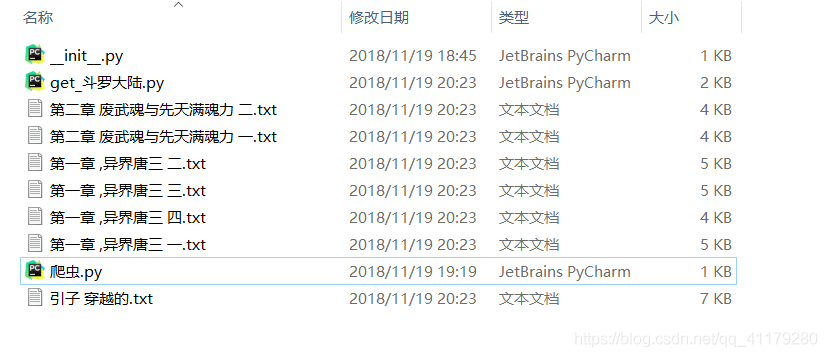

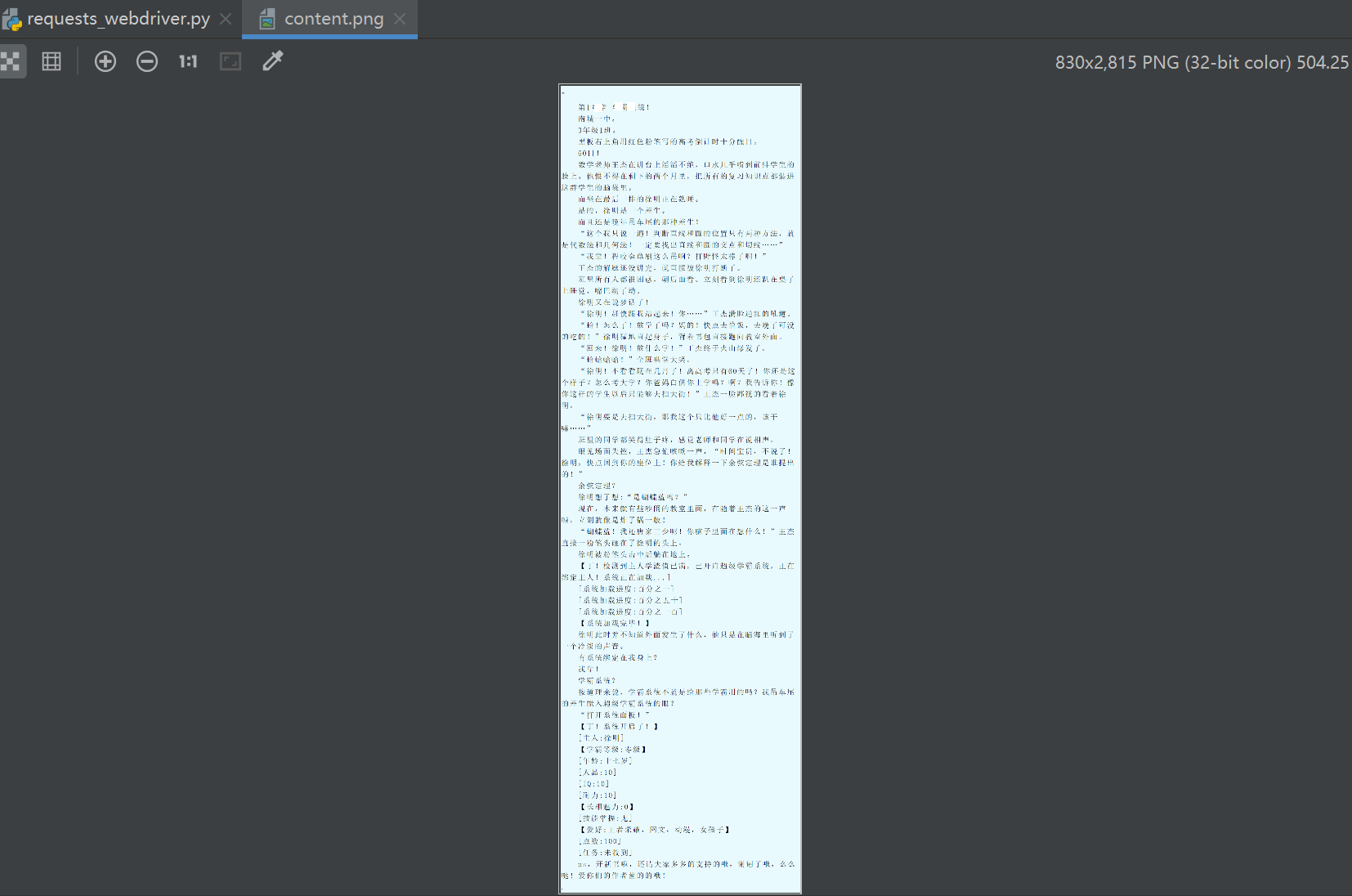

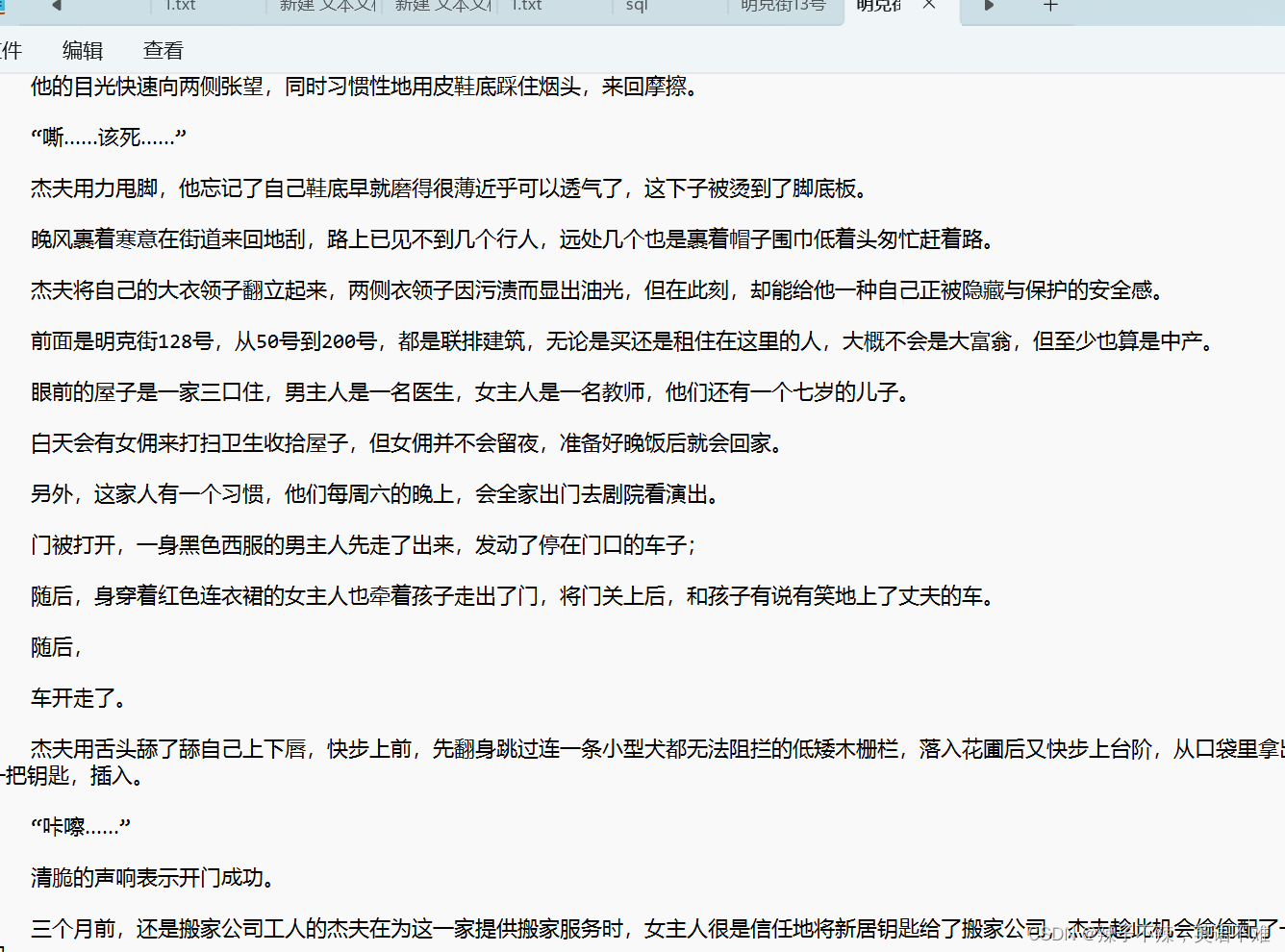

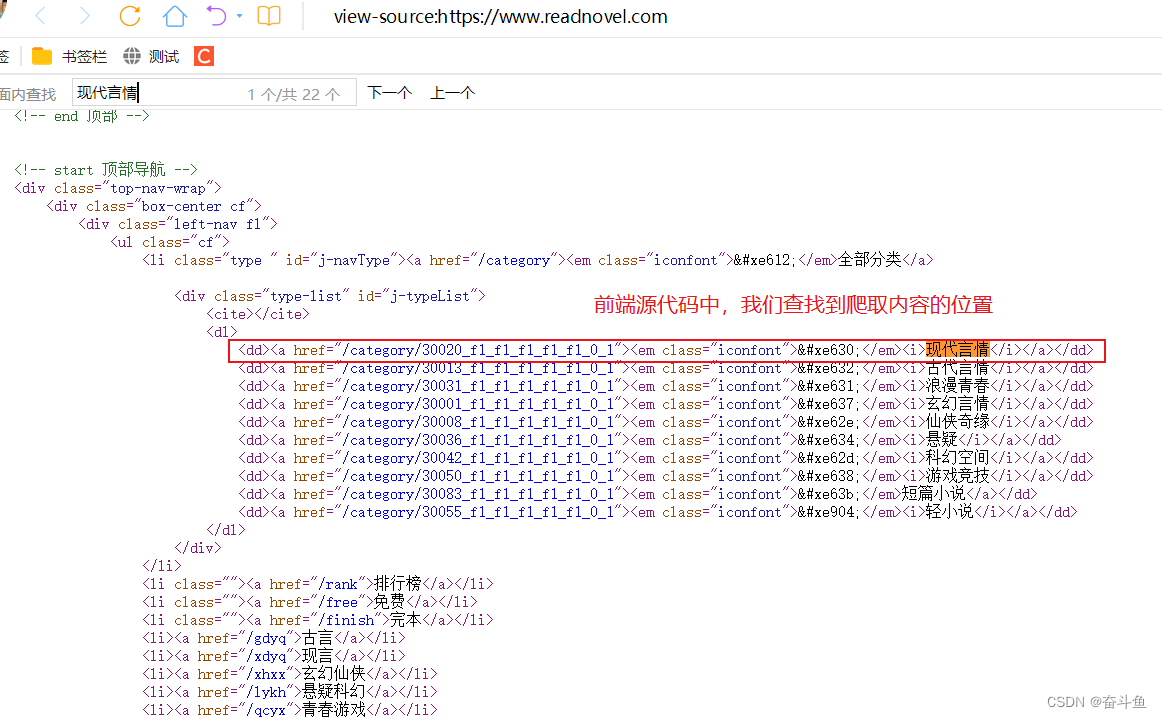

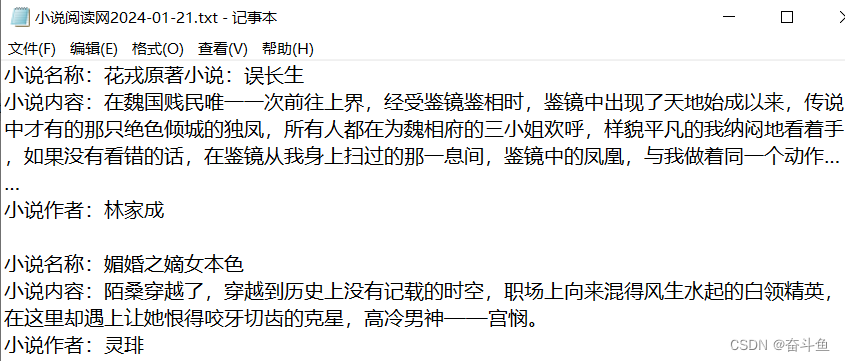

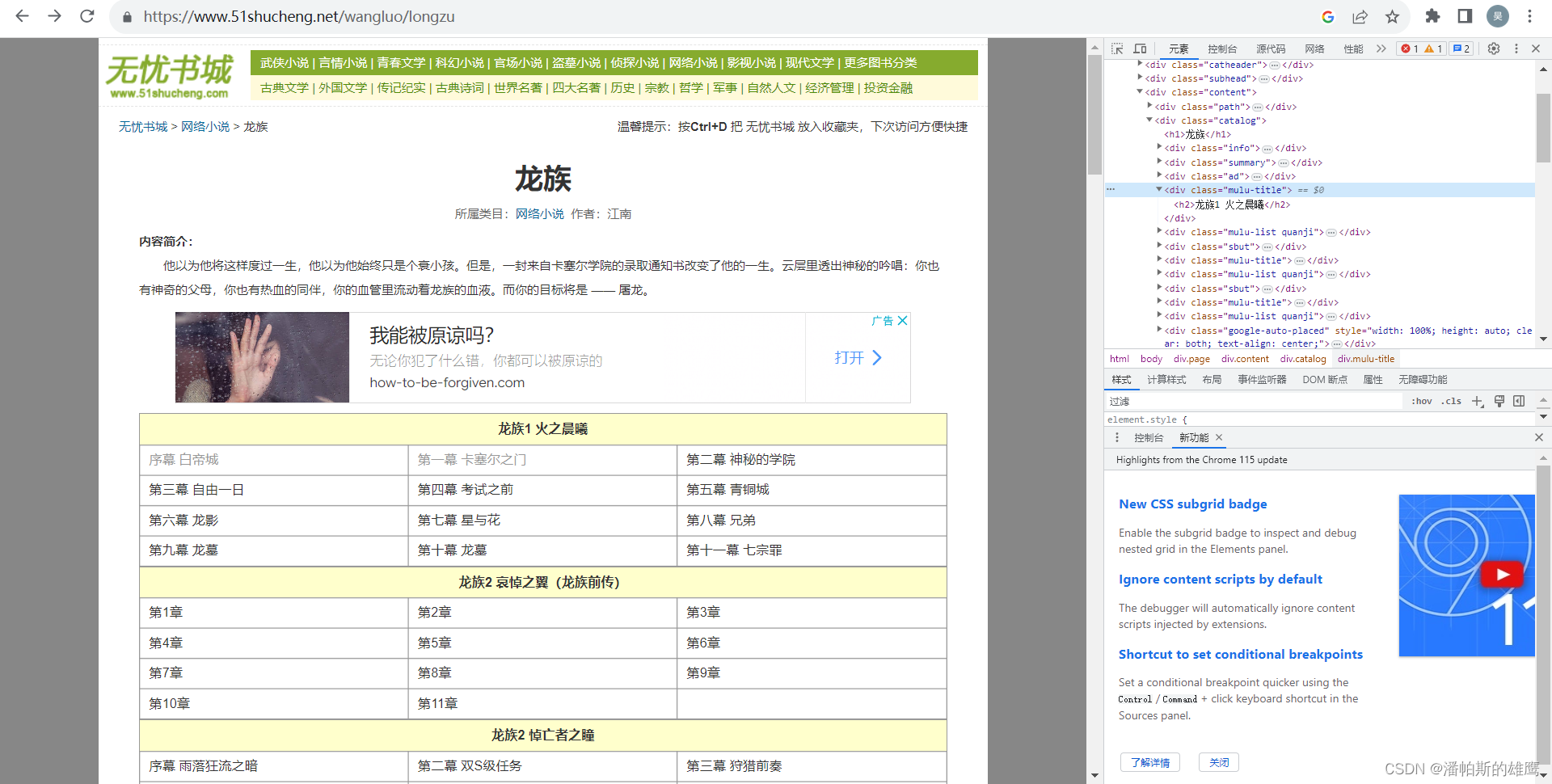

使用webdriver扒取网站小说(二)-----进阶篇(分层数据驱动)

1.思路构想

上一节主要通过webdriver写了一个demo来写了拔取小说的功能,虽然功能实现了,但是每次拔取不同的小说都要改很多数据,更改起来有很多不方便的地方,所以我们来吧数据层单独放在一起,并加入了日志等功能&…

爬虫常用的三种通用模板小结

确实有一段时间没怎么写爬虫了,最近又安排了写爬虫的任务,其实很多东西写过一份,之后再做大部分是复制粘贴代码,然后修改一下。所以这里总结一下通用的地方,之后编写爬虫的时候就可以直接拿来用了。 一、使用urllib2库…

Python爬虫:常用的浏览器请求头User-Agent(转)

原文地址:https://blog.csdn.net/mouday/article/details/80182397 user_agent [ "Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50", "Mozilla/5.0 (Windows; U; Wi…

怎么抠图最简单?教你一行Python代码去除照片背景

今天来教大家如何使用Python去除照片背景,说到去除照片背景的方法,我首先想到的是第三方接口(如:百度AI,或者说什么设计里面的一键抠图。),但本文重点在于免费使用,不花钱的那种&…

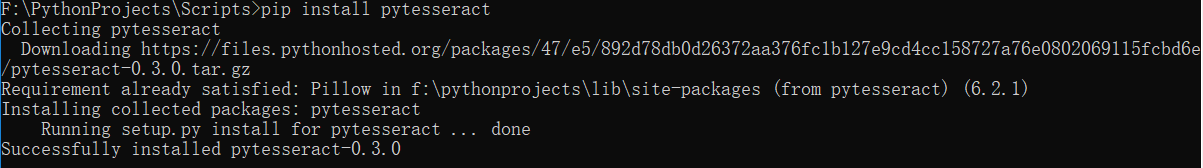

python+selenium+pytesseract识别图片验证码

一、selenium截取验证码

import json

from io import BytesIOimport time

from test.testBefore.testDriver import driver

from test.util.test_pytesseract import recognize

from PIL import Image

import allure

import unittest/处理验证码# 要截图的元素element driver…

讲人话科普,Python究竟是个什么,为啥大家都在学呢?

说实话,现在网上一搜“学Python能做些什么?”弹出来的无一例外是一堆看都看不懂的专业名词

什么web开发、linux系统运维、自动化测试都给我去一边的吧,尽管这些名词听起来相当的牛掰,但如果是外行人根本看不懂,搜索完…

一篇了解爬虫技术方方面面

原理传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关…

使用node抓取微信素材并处理多余js标签

使用node抓取微信素材

首先下载脚本文件,下载地址: 链接:https://pan.baidu.com/s/1xDq6tlfbUqcfASrMau58hg 提取码:fkzf

目录结构如下,可以下载gz压缩包,在本地使用git命令行禁止解压处理:ta…

subprocess.call(cmd, shell=True)

1.使用方法 subprocess.call()

执行由参数提供的命令.

我们可以用数组作为参数运行命令,也可以用字符串作为参数运行命令(通过设置参数shellTrue)

注意,参数shell默认为False

我们用subprocess.call()来做一个统计磁盘的例子:subprocess.call([df, -h])

下面的例子把shell设置为…

Python 从爬虫到数据分析(一)定义

为什么80%的码农都做不了架构师?>>> 1.什么是爬虫? 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,…

爬虫的基本操作 requests / BeautifulSoup 的使用

爬虫的基本操作 爬虫基础知识 什么是爬虫? 在最开始,还没有诞生Google和百度等一系列搜索引擎的公司的时候,人们进入一些公司的网站只能通过在浏览器地址栏输入网址的方式访问,如同在很早之前前手机不流行的时候,我们会…

python正则表达式 1

re模块提供了一个郑则表达式的引擎接口,可以让你的Re string变异成对象并用它来进行匹配,这样效率比较高。附上例子让我们一块体验一下吧。以下是我写的类似与爬虫的小脚本,供大家参考#!/usr/bin/python

# codingutf-8

import urllib

import …

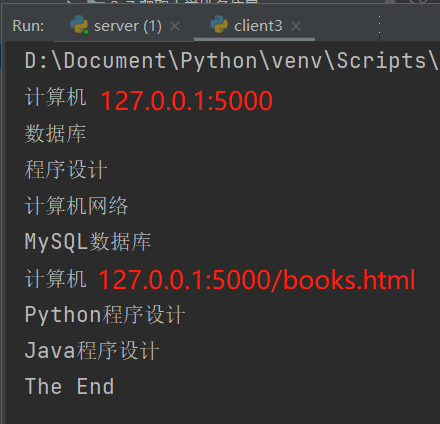

201621123042《java程序设计》第十三次作业

1. 本周学习总结 以你喜欢的方式(思维导图、OneNote或其他)归纳总结多网络相关内容。 2. 为你的系统增加网络功能(购物车、图书馆管理、斗地主等)-分组完成 为了让你的系统可以被多个用户通过网络同时使用,需要为你的系统增加网络功能。 2.1 …

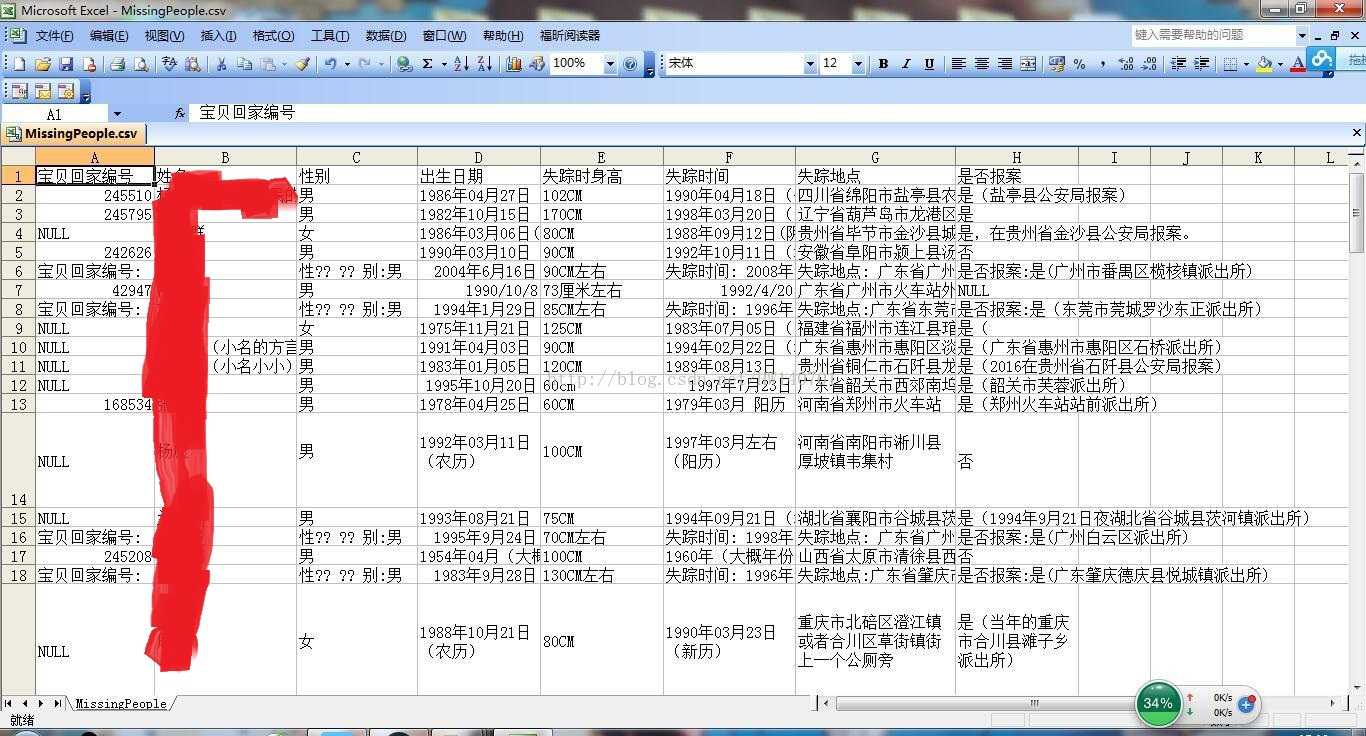

Python爬虫小实践:寻找失踪人口,爬取失踪儿童信息并写成csv文件,方便存入数据库...

前两天有人私信我,让我爬这个网站,http://bbs.baobeihuijia.com/forum-191-1.html上的失踪儿童信息,准备根据失踪儿童的失踪时的地理位置来更好的寻找失踪儿童,这种事情本就应该义不容辞,如果对网站服务器造成负荷,还请…

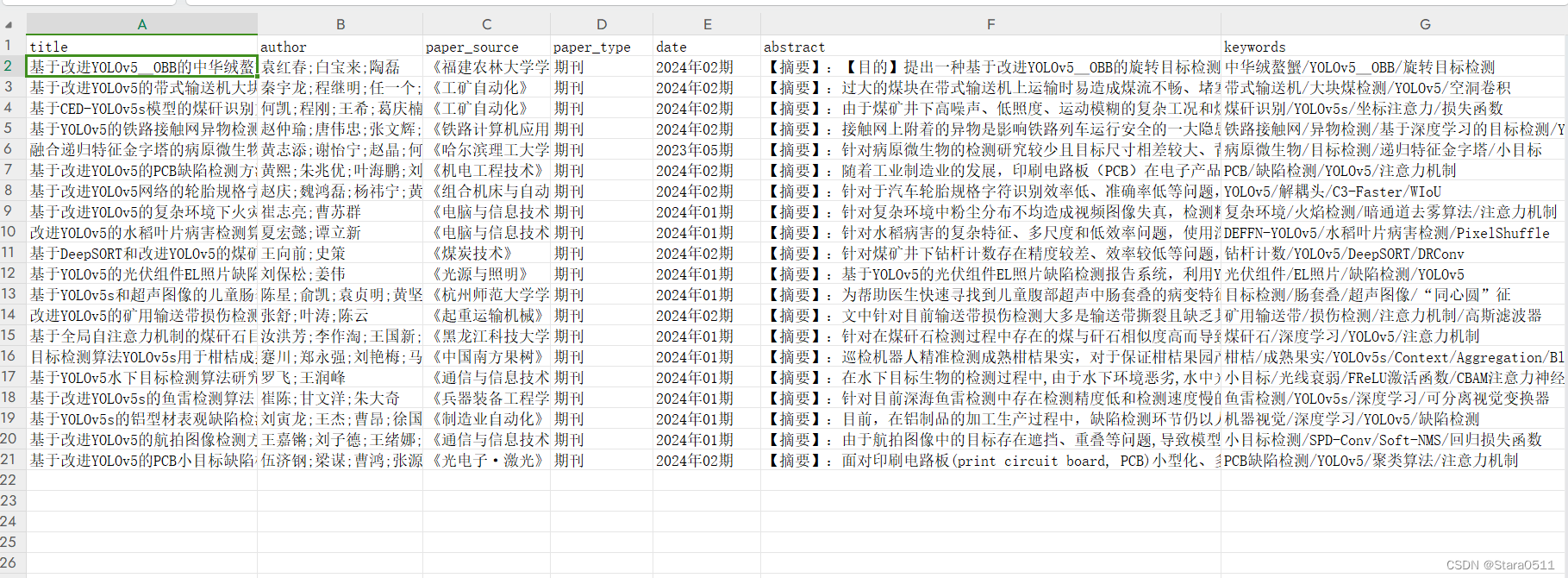

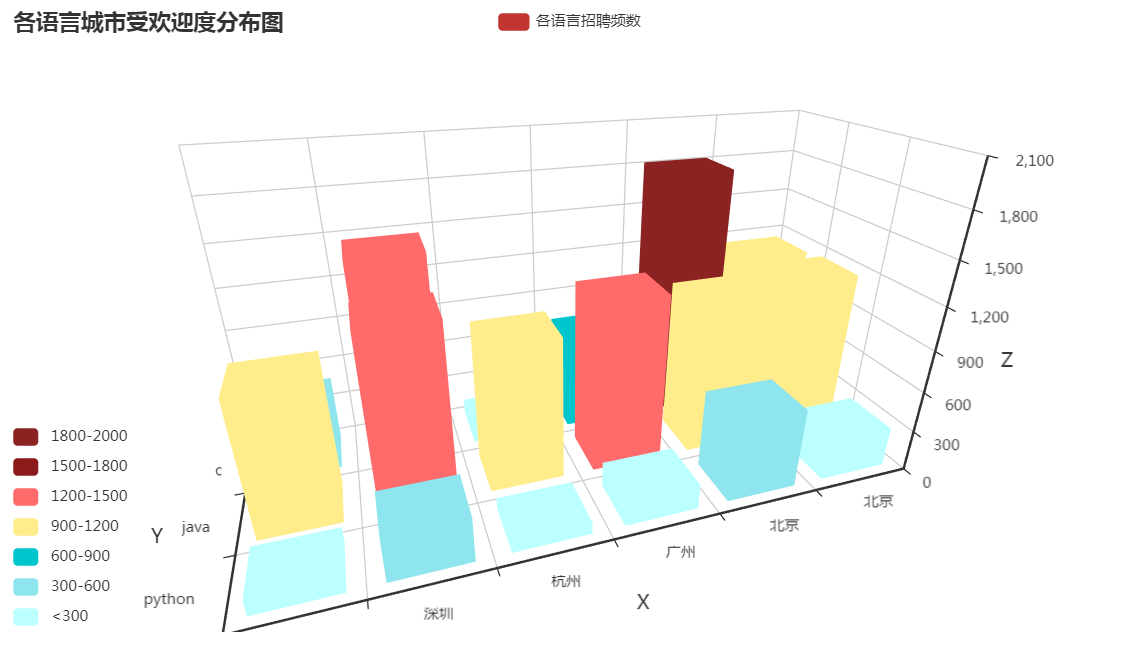

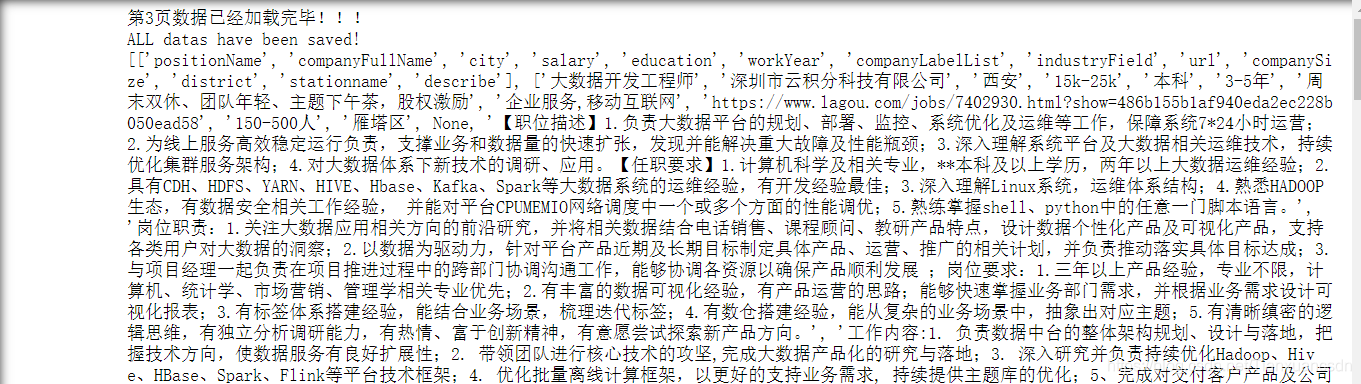

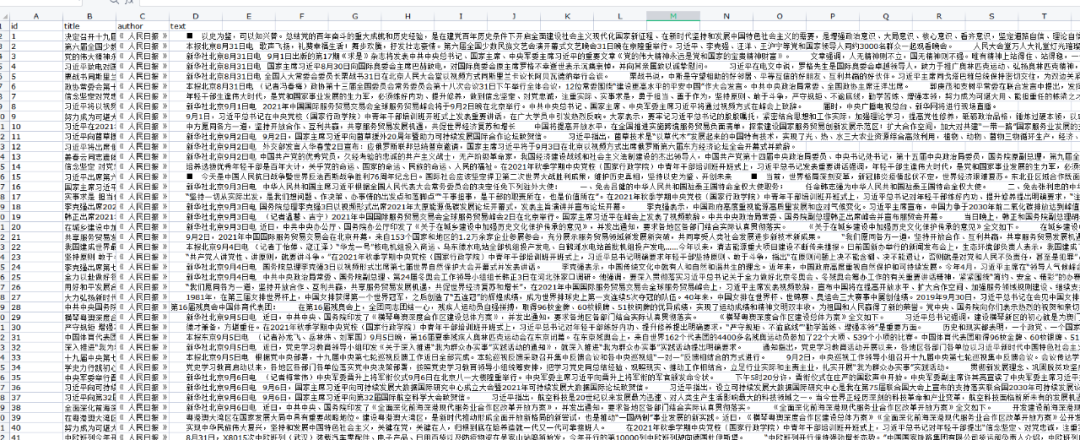

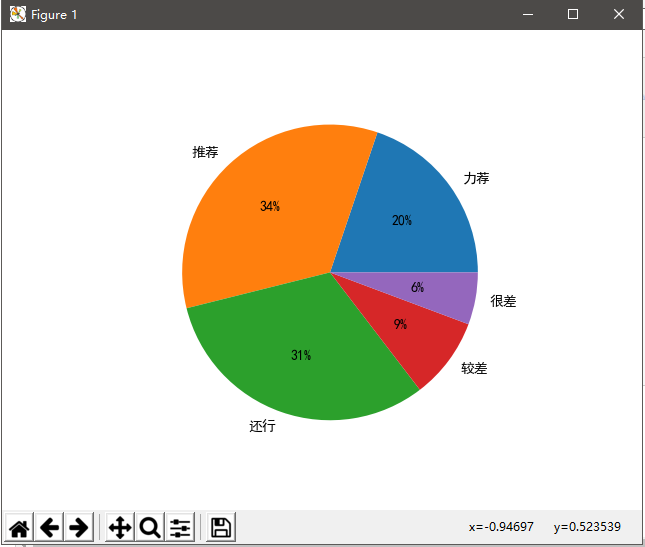

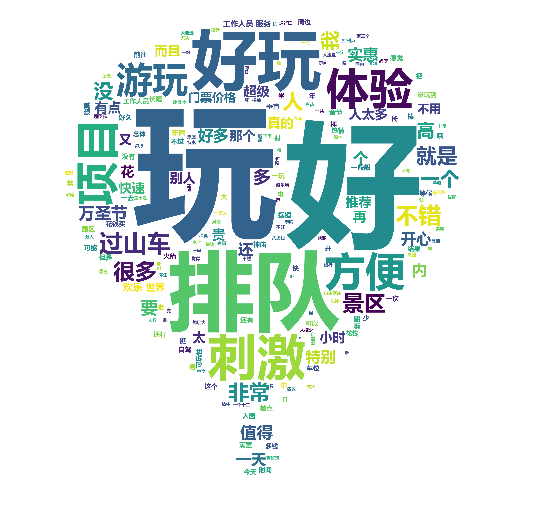

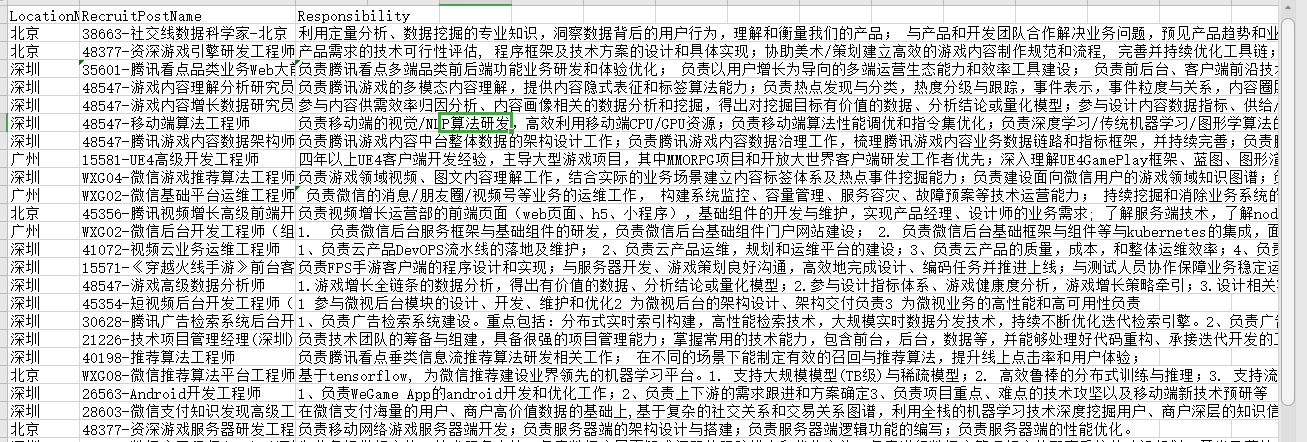

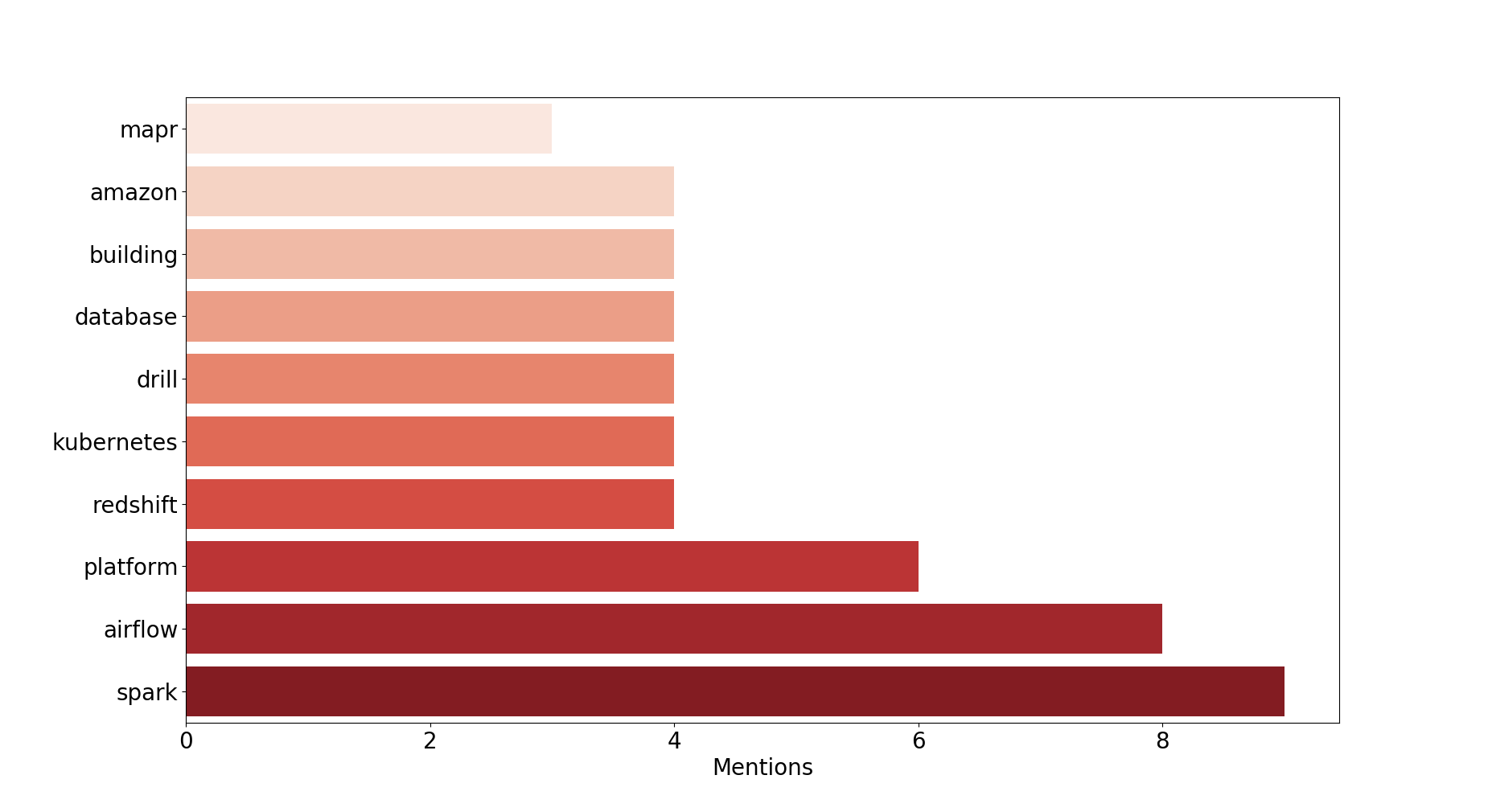

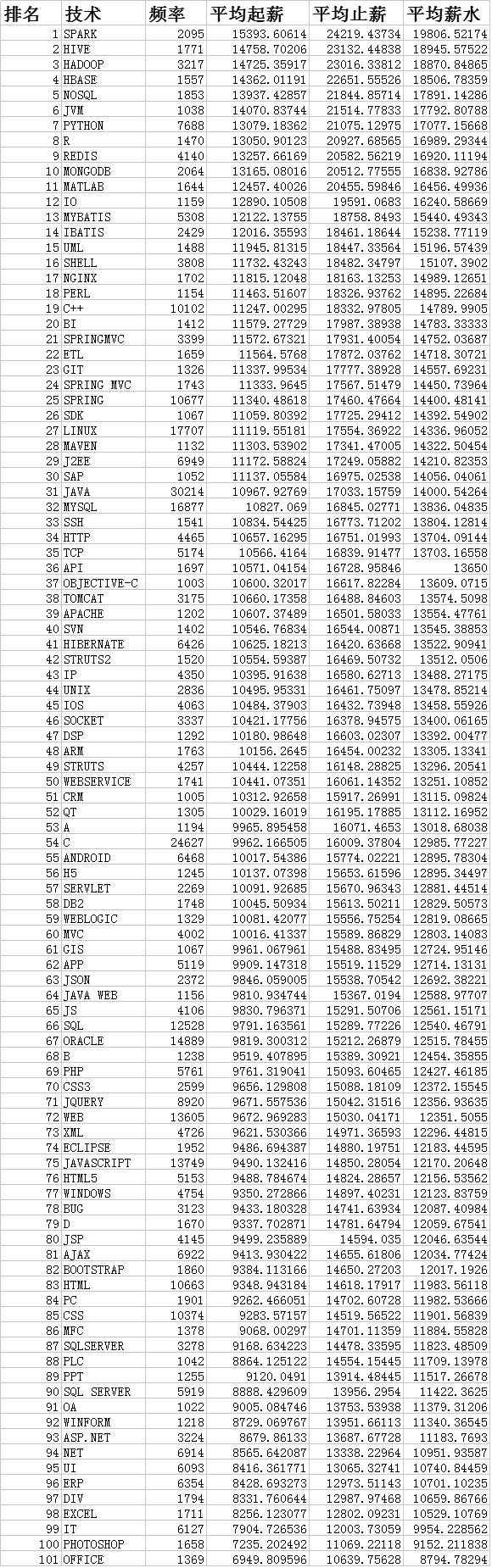

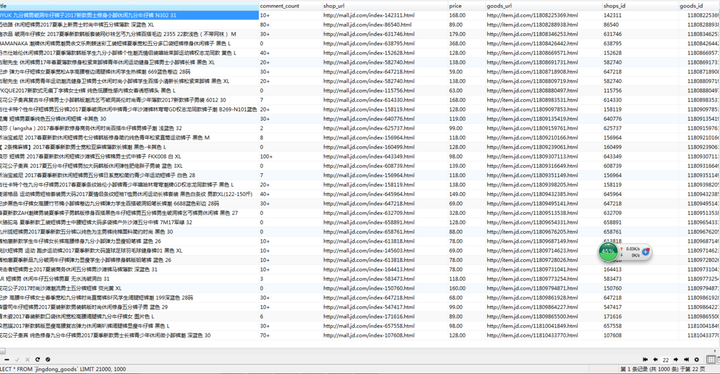

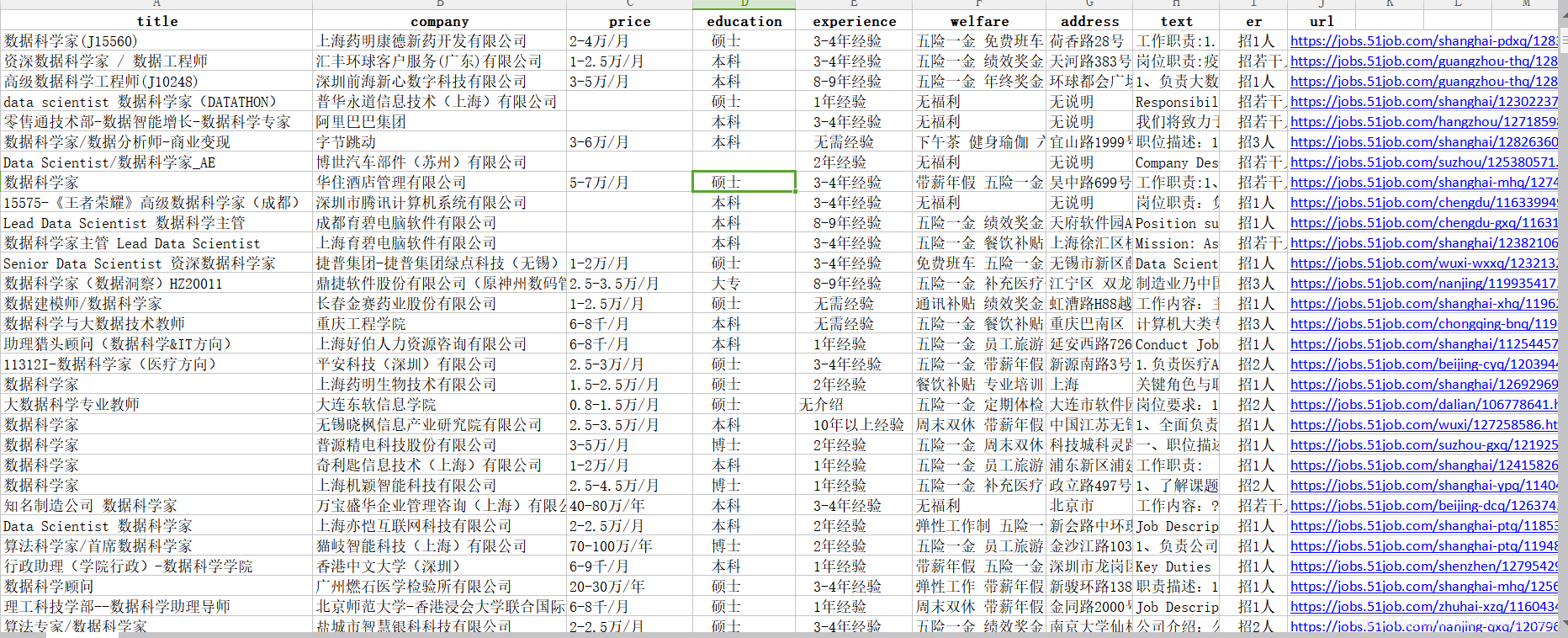

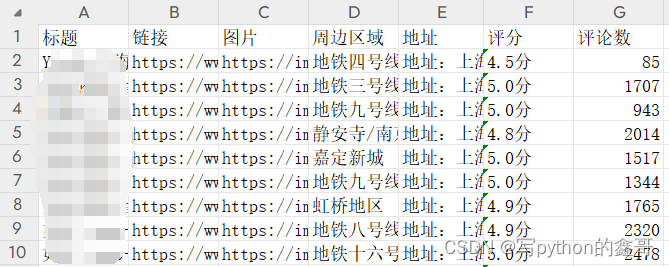

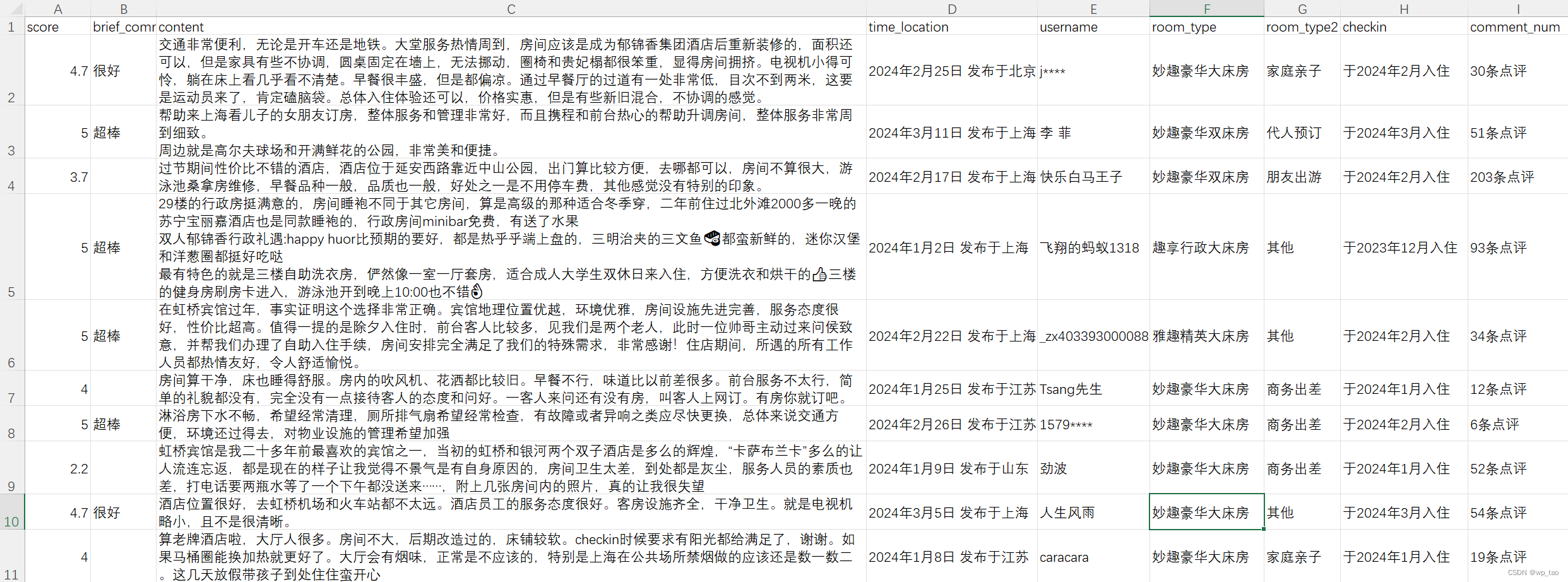

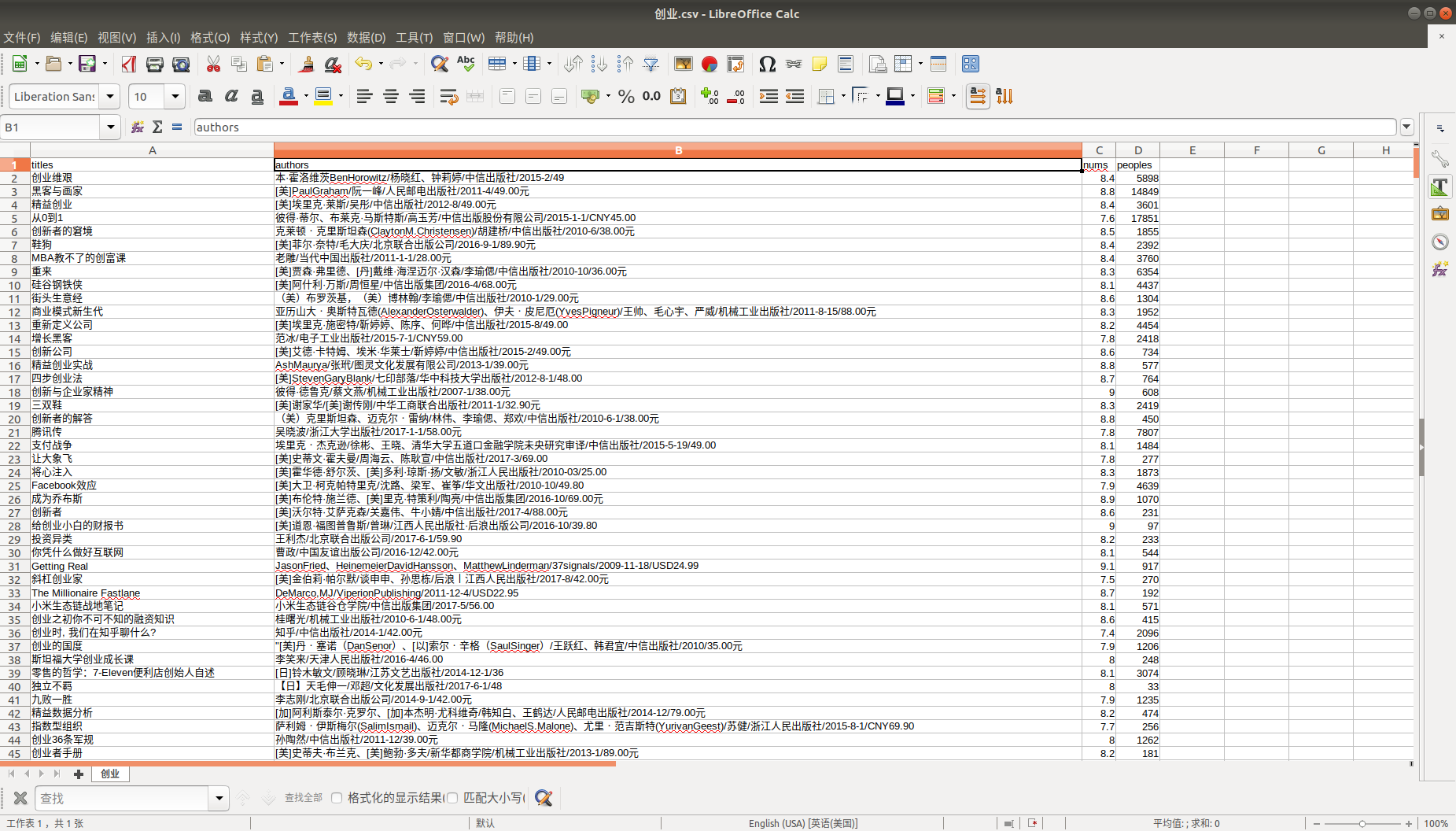

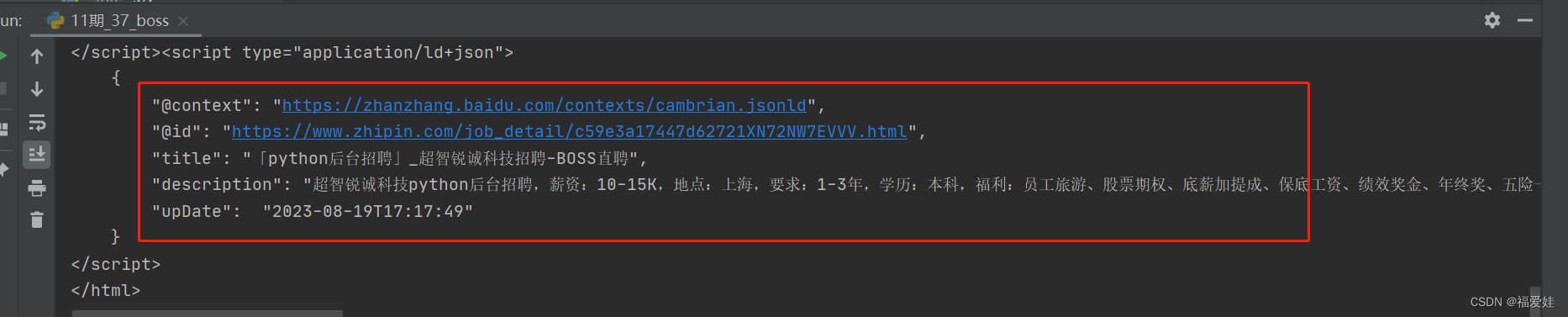

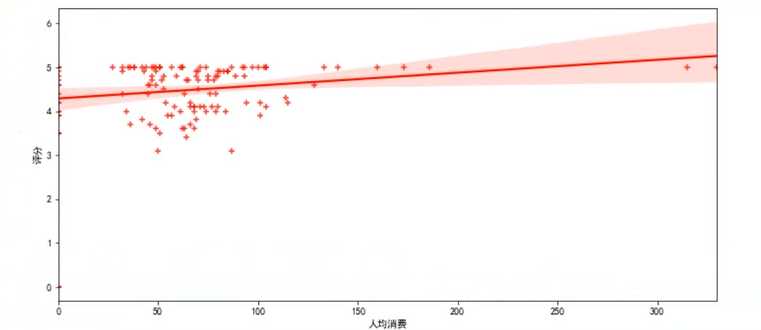

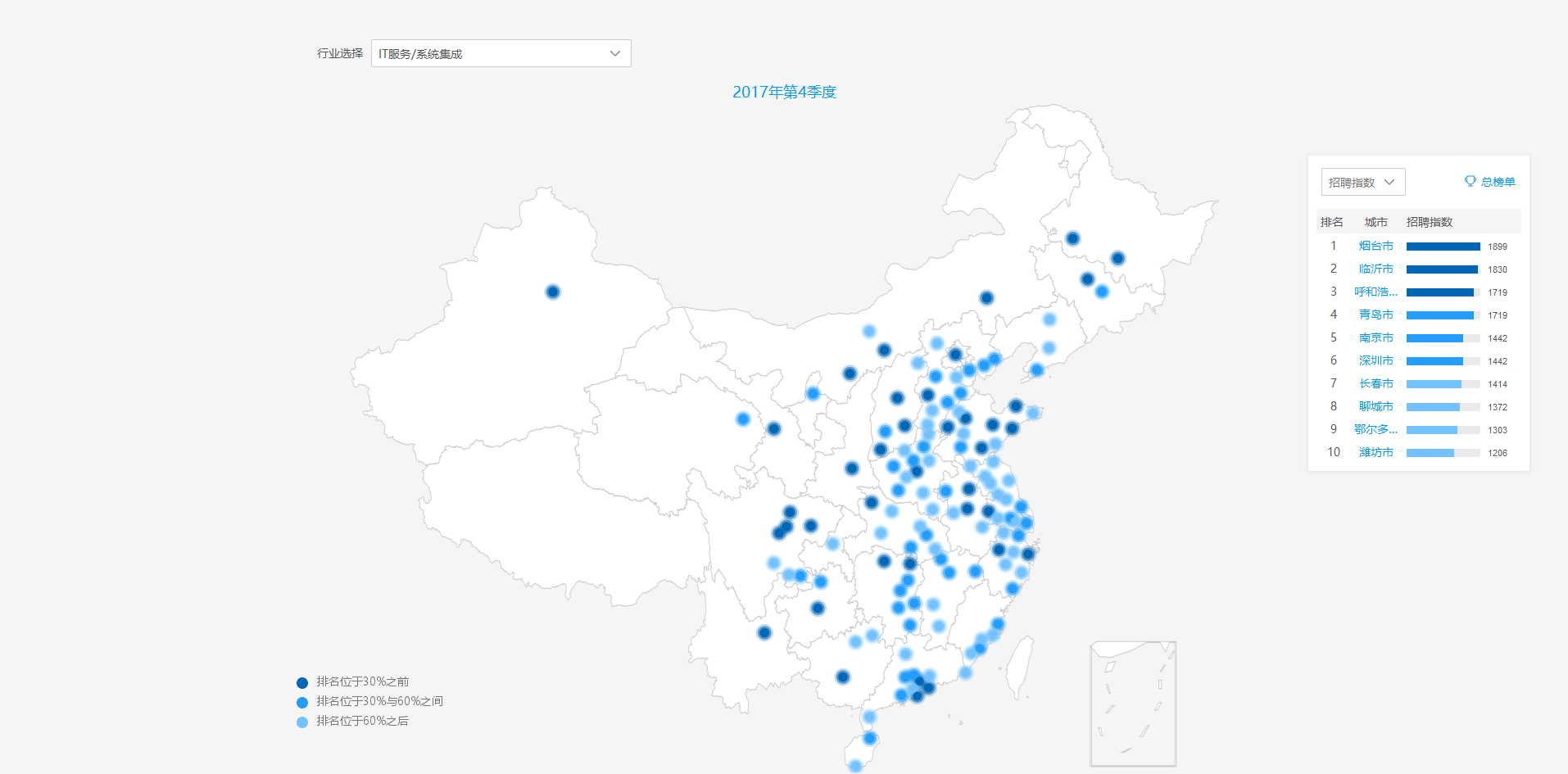

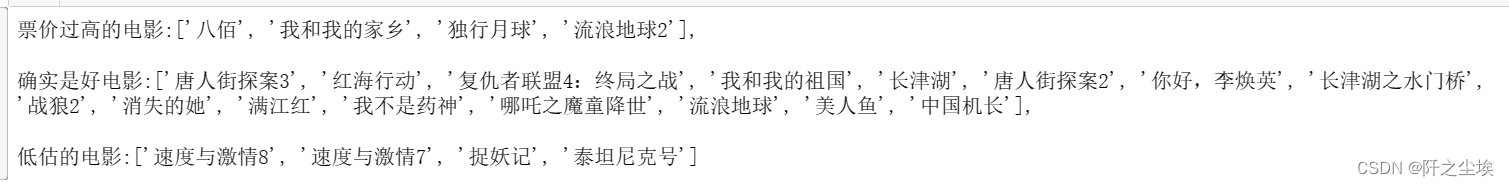

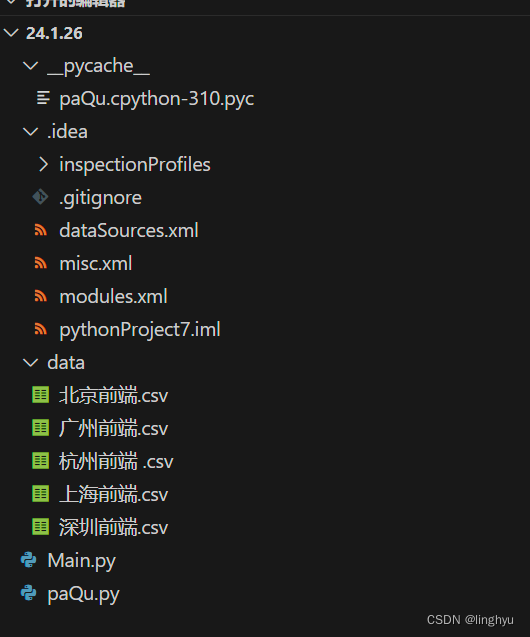

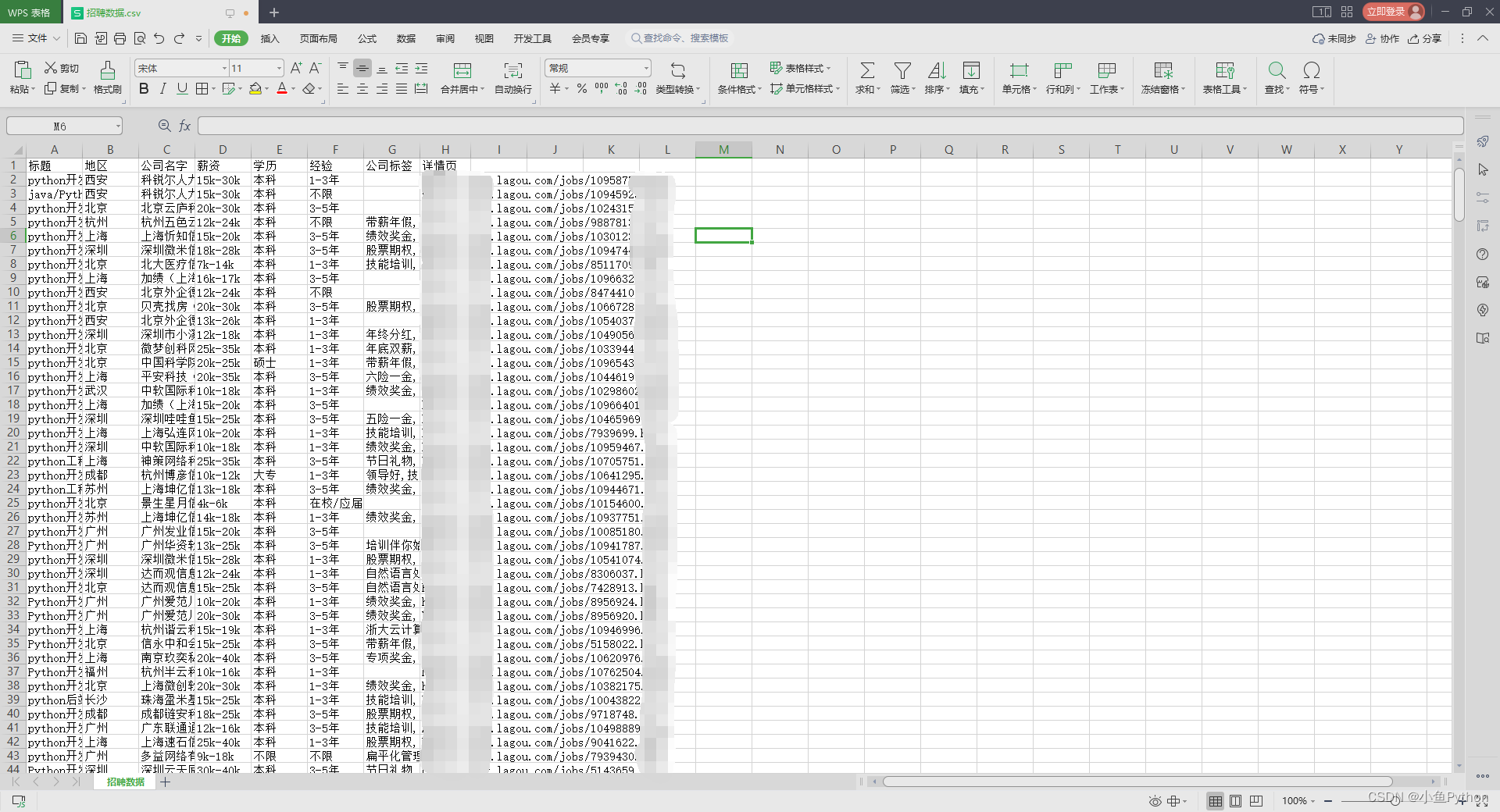

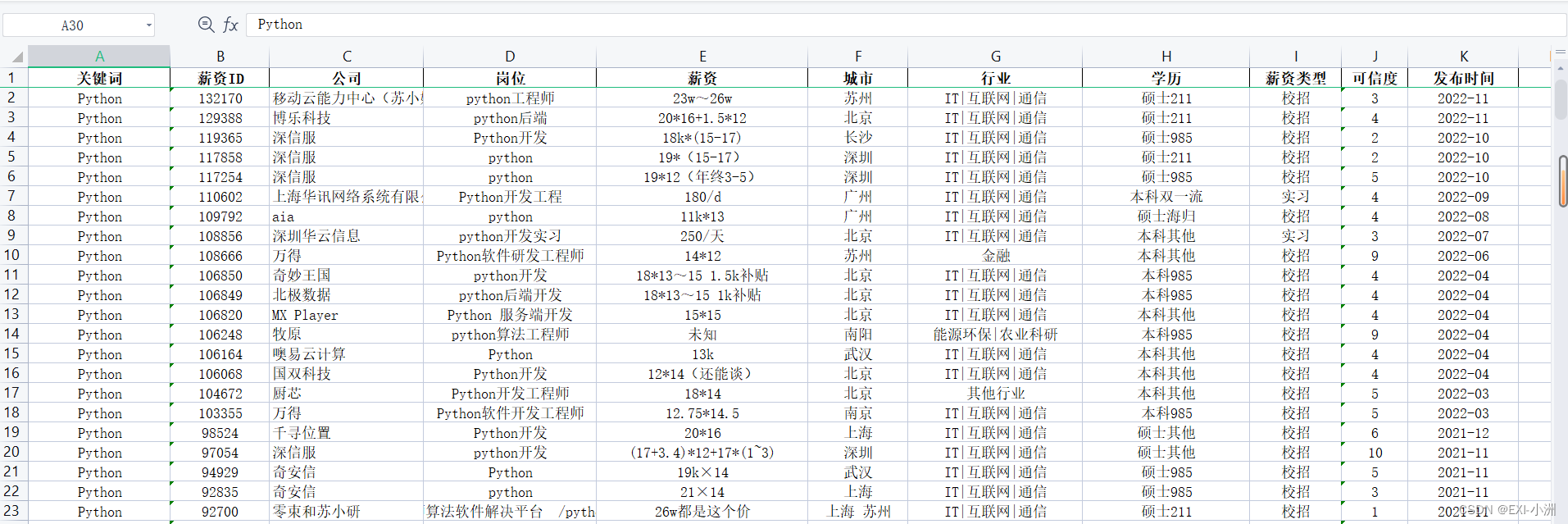

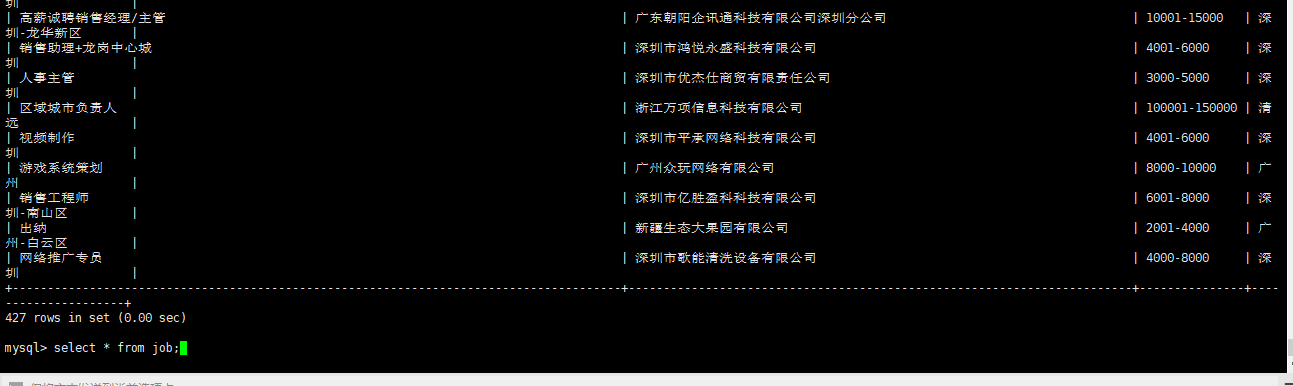

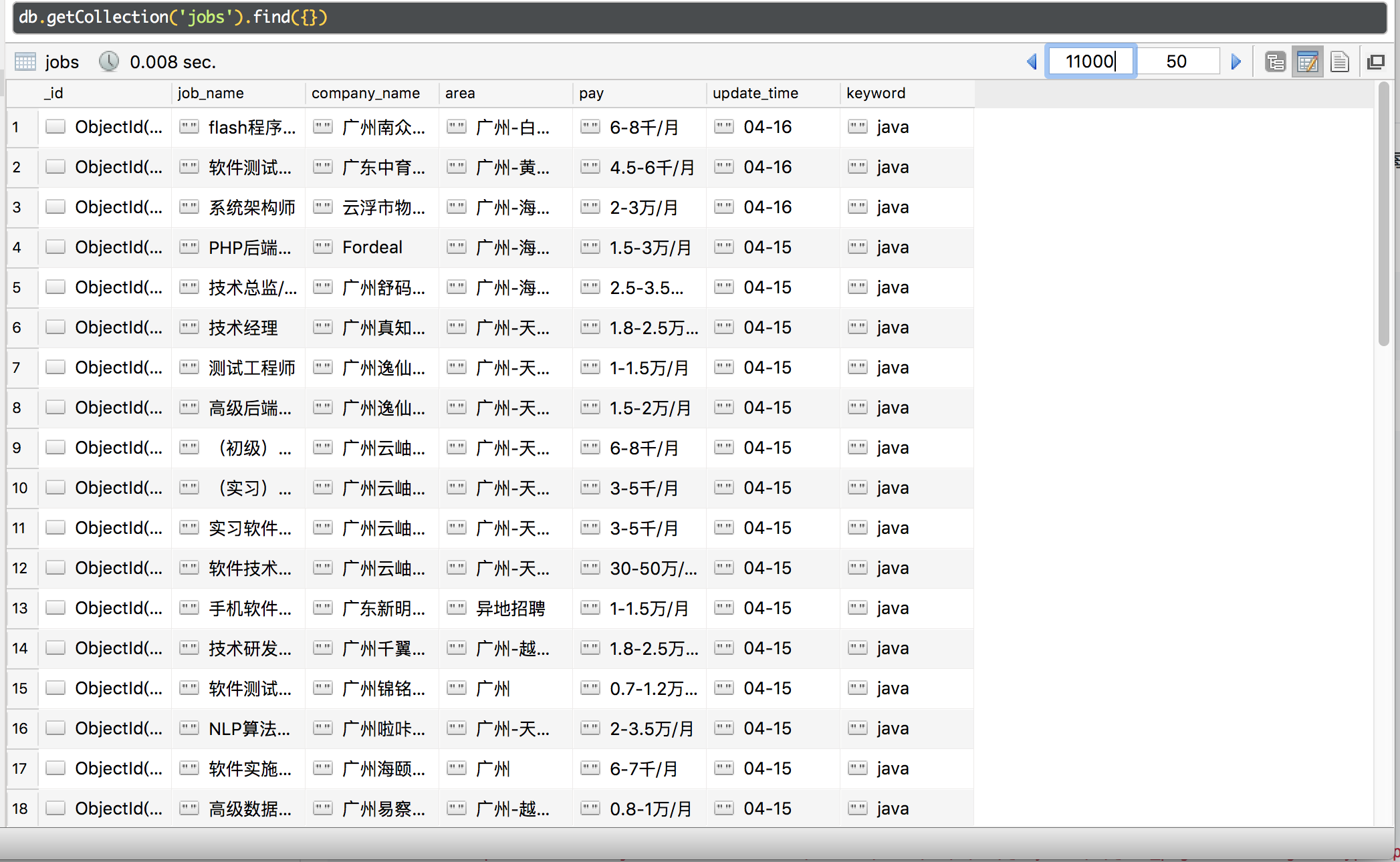

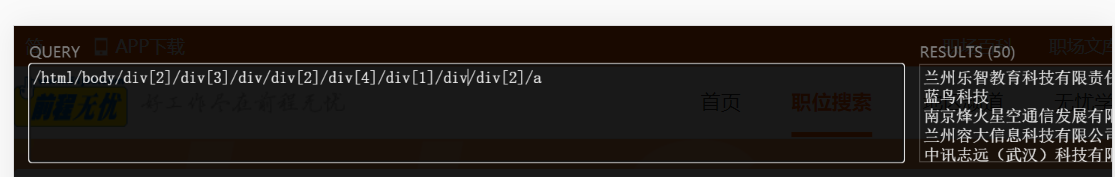

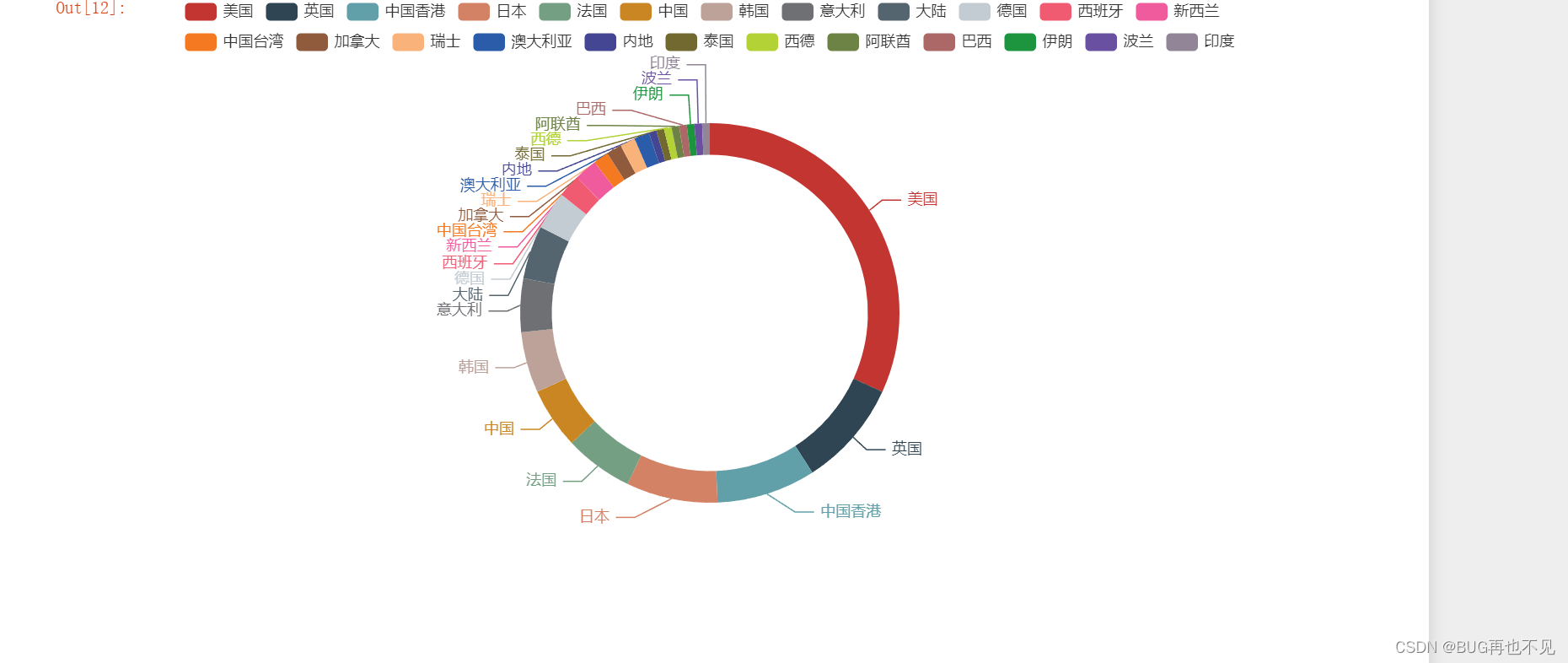

python岗位数据分析报告

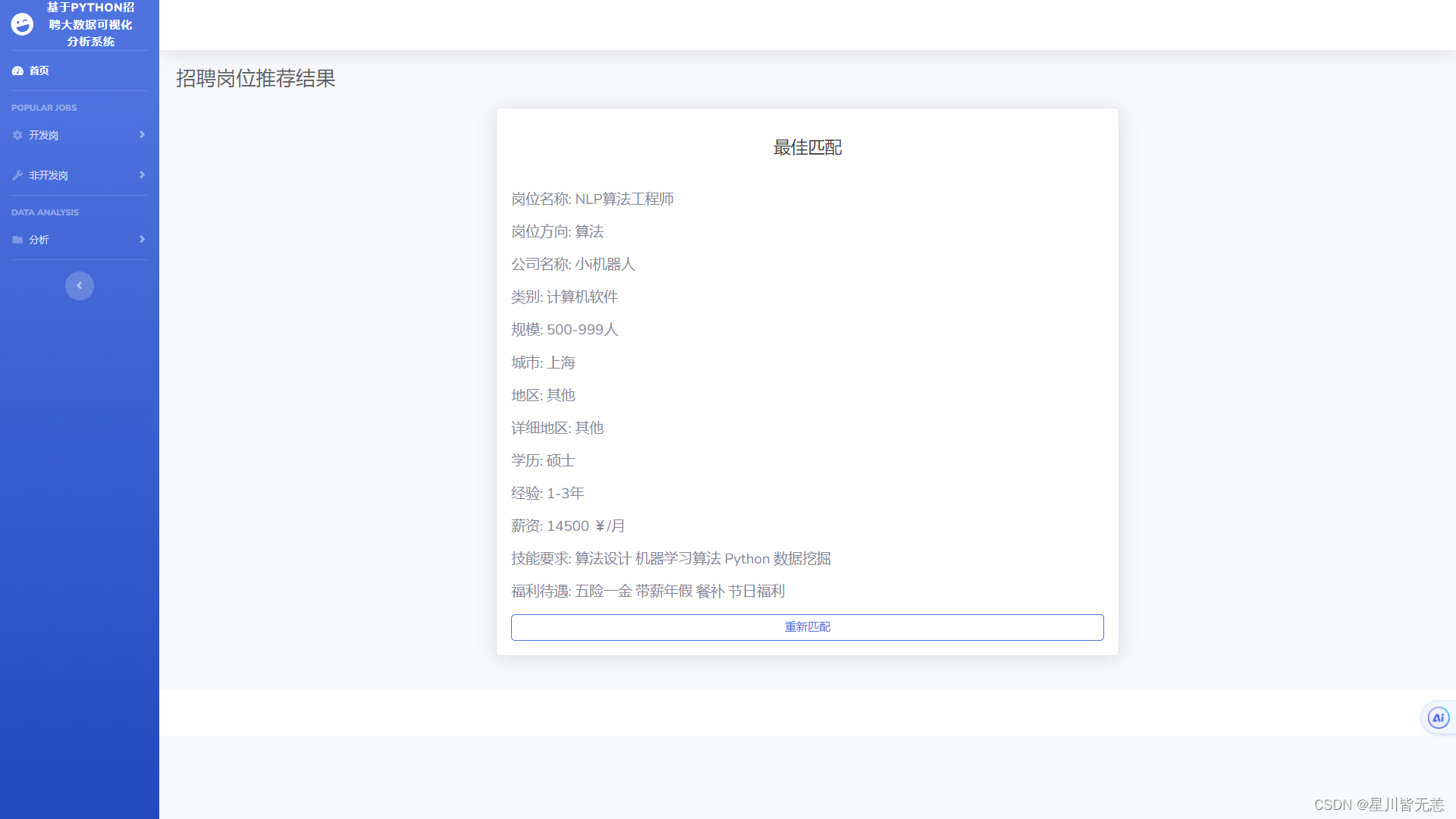

python岗位数据分析报告

数据集为针对智联,boss,拉勾三个招聘网站的爬取,

爬取关键字段:语言为python,java,c;城市为 北上广深郑杭;

数据分类保存在 ‘’python招聘数据.xlsx‘’…

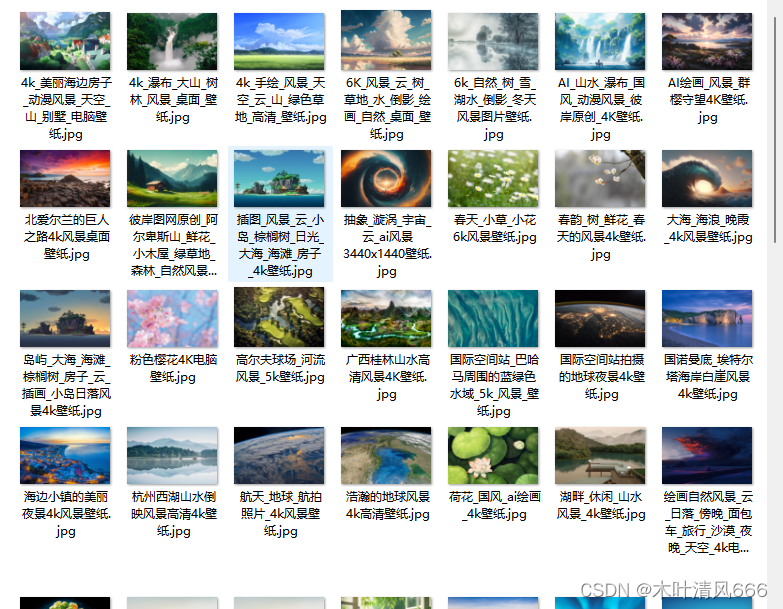

设计师们的福音,二十行代码破解pexels反爬,轻松get高质量图片(全自动化操作,高清大图,且免费使用)

先来上成果:

正常画质效果 百分之百的效果: (发现了神马???画质简直逆天而且免费!!!!!) 源码如下:

爬取简书ajxs动态化数据并存储到ecxel中!

爬取简书ajxs动态化数据并存储到ecxel中! # -*- coding: utf-8 -*-

"""

Created on Tue Nov 17 10:30:23 2020author: Yuka

"""网址为https://www.jianshu.com/u/9104ebf5e177,爬取内容为简书用户的最新评论中的评论题目、…

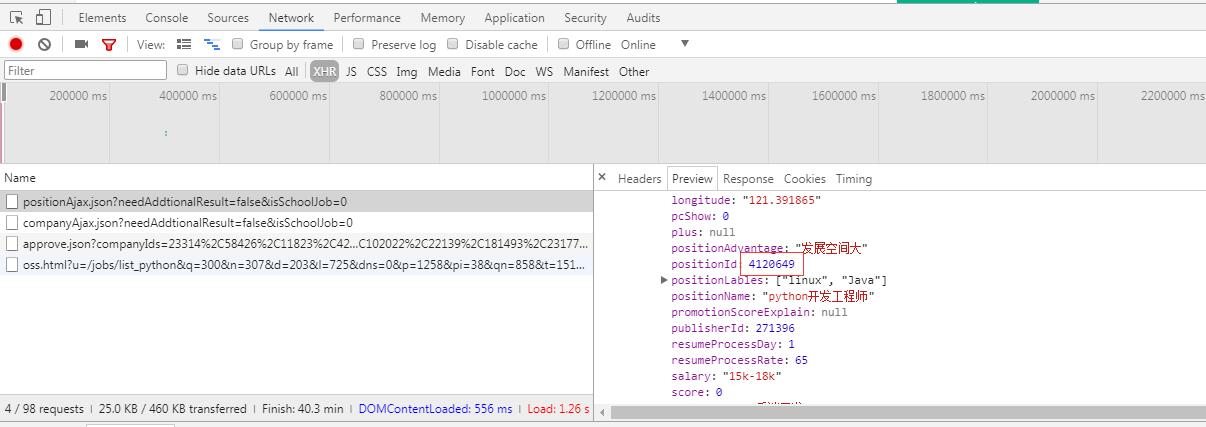

获取拉勾网30页所有信息的常规方法 VS selenium

笔者有话说:大家也都知道拉勾网此类的电商网站反爬一向恶心,笔者通过半天时间的研究试用了两种方法之后,得出了两个结论(包括一个貌似可行的cokie秘密) 首先是常规方法 import requests

from lxml import etree

import random

from multiprocessing.dummy

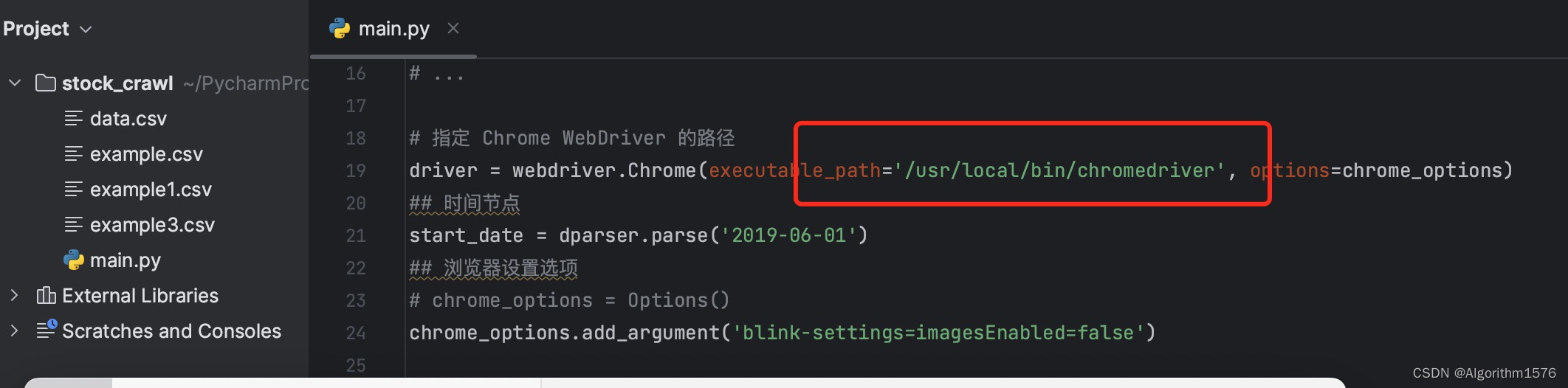

Linux系统中提示Message: ‘chromedriver‘ executable needs to be in PATH

项目场景:

在ubuntu系统中运行爬虫文件

问题描述:

Linux系统中提示Message: ‘chromedriver’ executable needs to be in PATH

原因分析:

没有设置环境变量

解决方案:

#1.修改环境变量

cd /etc

sudo vim profile#2. 在末尾…

Python爬虫从编码到部署(这么一篇就够了!!!)

Python爬虫从编码到部署(这么一篇就够了!!!) 文章目录Python爬虫从编码到部署(这么一篇就够了!!!)一、导论二、http协议三、request模块四、数据解析一、bs4进…

HTML5 web存储之LocalStorage和sessionStorage

什么是localstorage 前几天在老项目中发现有对cookie的操作觉得很奇怪,咨询下来是要缓存一些信息,以避免在URL上面传递参数,但没有考虑过cookie会带来什么问题: ① cookie大小限制在4k左右,不适合存业务数据

② cookie…

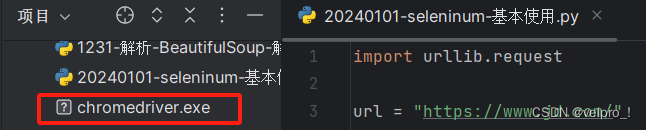

python爬虫---selenium库的用法

selenium是一个自动化测试工具,支持Firefox,Chrome等众多浏览器 在爬虫中的应用主要是用来解决JS渲染的问题。 1.使用前需要安装这个第三方库,CMD下: pip install selenium 2.为你的测试浏览器下载驱动,我用的是Chrome…

爱qiyi滑块(2-23,js逆向)

网址:aHR0cHM6Ly93d3cuaXFpeWkuY29tLw一、整体流程分析 爱qiyi整个登录滑块流程主要分五步:

1、访问dfp_pcw/sign拿到dfp参数

2、访问login.action拿到token参数

3、访问sbox_init_key拿到sig,sid,sr参数

4、访问verifycenter/initpage拿到滑块相关数据…

Python 爬虫入门实战01

1、什么是爬虫?

网络爬虫又称网络蜘蛛、网络机器人,它是一种按照一定的规则自动浏览、检索网页信息的程序或者脚本。网络爬虫能够自动请求网页,并将所需要的数据抓取下来。通过对抓取的数据进行处理,从而提取出有价值的信息。

2…

EasyPR--开发详解(2)车牌定位

转自https://www.cnblogs.com/subconscious/p/4013591.html EasyPR的项目地址在这:GitHub。要想运行EasyPR的程序,首先必须配置好openCV,具体可以参照这篇文章。 在前两篇文章中,我们已经初步了解了EasyPR的大概内容,在…

世界上最伟大的推销员

2019独角兽企业重金招聘Python工程师标准>>> 世界上最伟大的推销员 很好的励志书籍,短小精干。现在励志书籍太过泛滥,看得太多反而会让人有一种麻木的感觉:感觉知道了明白了,就不去再行动了。事实上,只要不…

主打python-2021年度总结-展望2022年

主打python-2021年度总结-展望2022年

我是2021年1月19日加入csdn这个大家庭的,属于小菜鸟,我是因为代码上有问题,在csdn上找答案,这才加入csdn的 5月份的时候,有幸看到csdn新星计划第一季的比赛 我决定参加这次的比…

[Python爬虫] 之九:Selenium +phantomjs抓取活动行中会议活动(单线程抓取)

思路是这样的,给一系列关键字:互联网电视;智能电视;数字;影音;家庭娱乐;节目;视听;版权;数据等。在活动行网站搜索页(http://www.huodongxing.com…

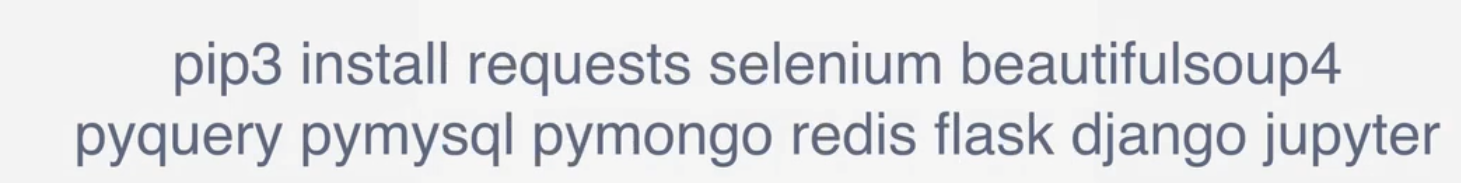

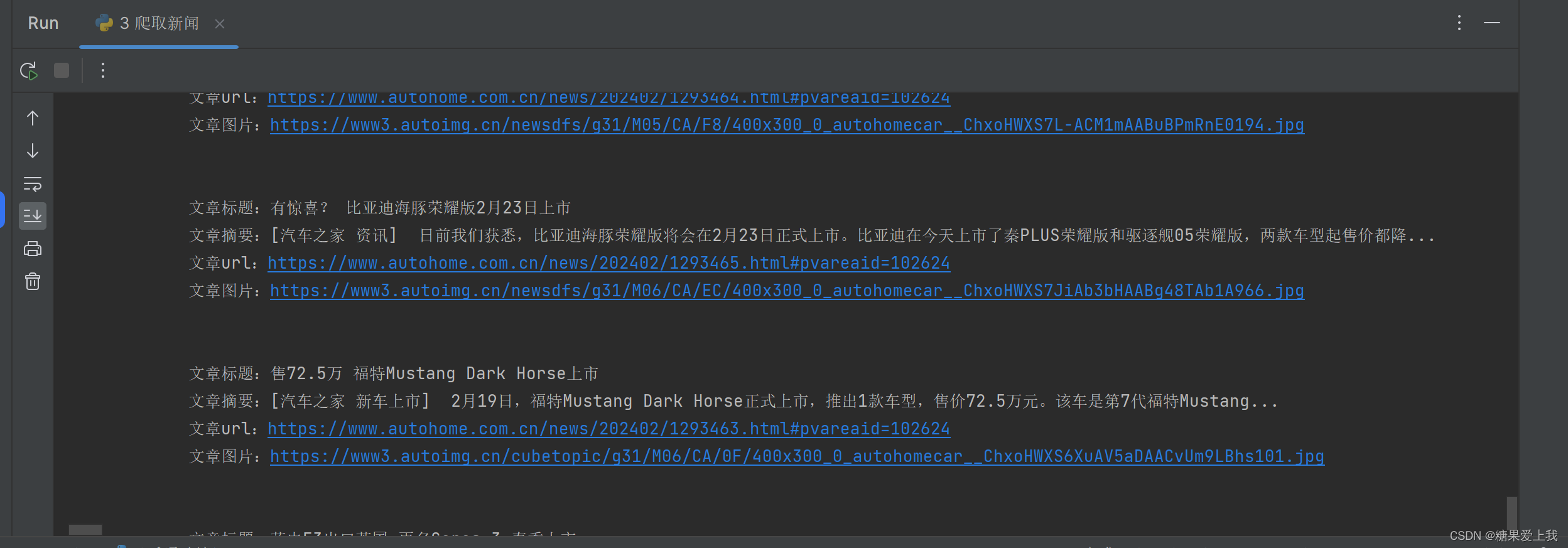

python爬虫基础_requests和bs4

些都是笔记,还缺少详细整理,后续会更新。 下面这种方式,属于入门阶段,手动成分比较多. 首先安装必要组件: pip3 install requests pip3 install beautifulsoup4 一、爬汽车之家 #!/usr/bin/env python

# coding:utf-8import requests

from bs4 import Be…

.NetCore实践爬虫系统(一)解析网页内容

爬虫系统的意义 爬虫的意义在于采集大批量数据,然后基于此进行加工/分析,做更有意义的事情。谷歌,百度,今日头条,天眼查都离不开爬虫。 今日目标 今天我们来实践一个最简单的爬虫系统。根据Url来识别网页内容。 网页内…

菜鸟也想玩搜索引擎——爬虫部分技术要点浅析(补充)

时隔这么久,继续开写。本文系上一篇的补充:爬虫部分技术要点浅析。 本次将主要讨论上次提出的后两个问题:如何处理抽取出来的Url。 3、如何处理抽取出来的Url(爬取策略)? 所谓爬取策略,就是网络…

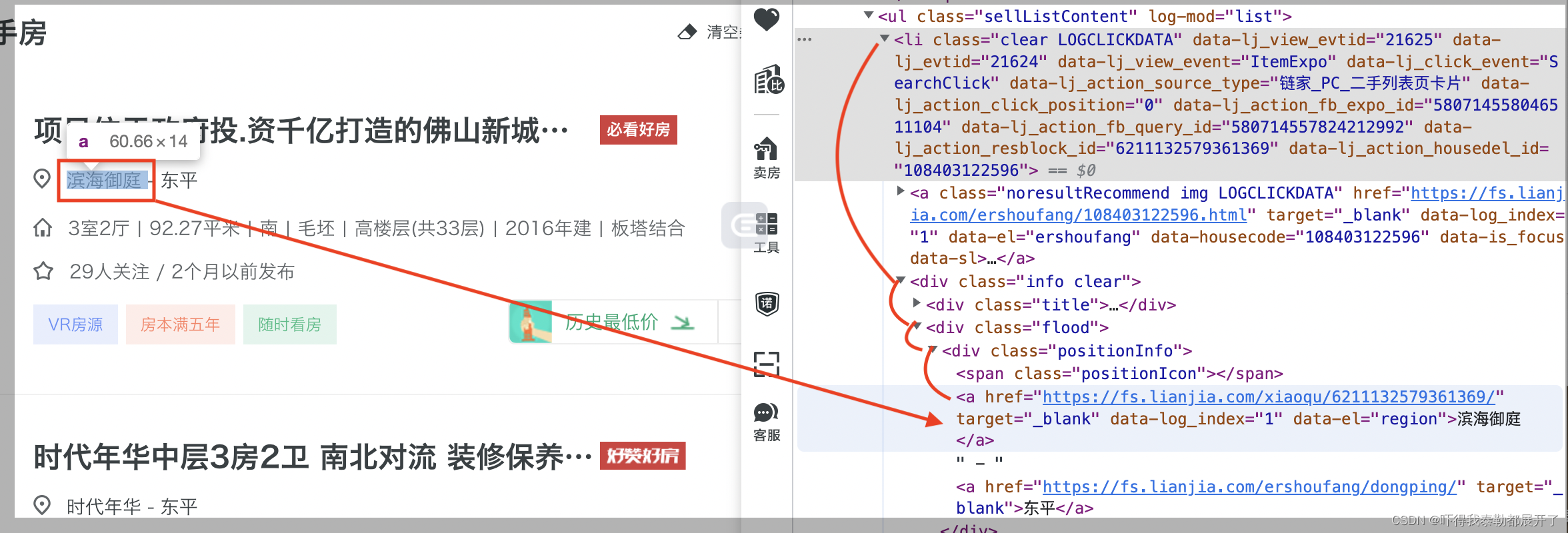

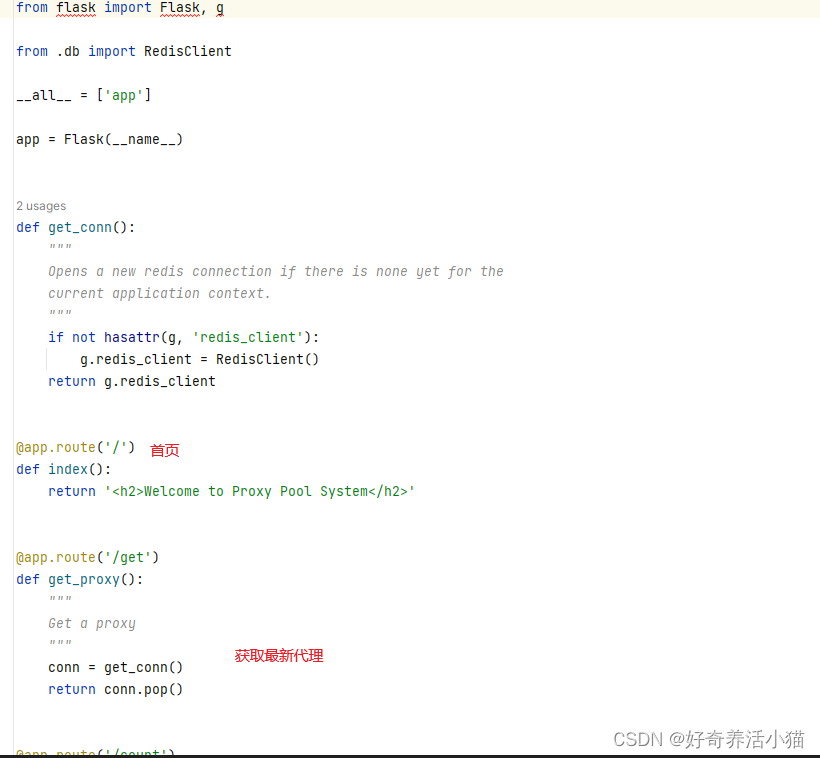

如何维护一个1000 IP的免费代理池

楔子

好友李博士要买房了, 前几天应邀帮他抓链家的数据分析下房价, 爬到一半遇到了验证码.

李博士的想法是每天把链家在售的二手房数据都抓一遍, 然后按照时间序列分析. 链家线上在交易的二手房数据大概有30000余套, 而一天只有86400秒, 也就是最慢3s也要访问一个页面. 测试按照…

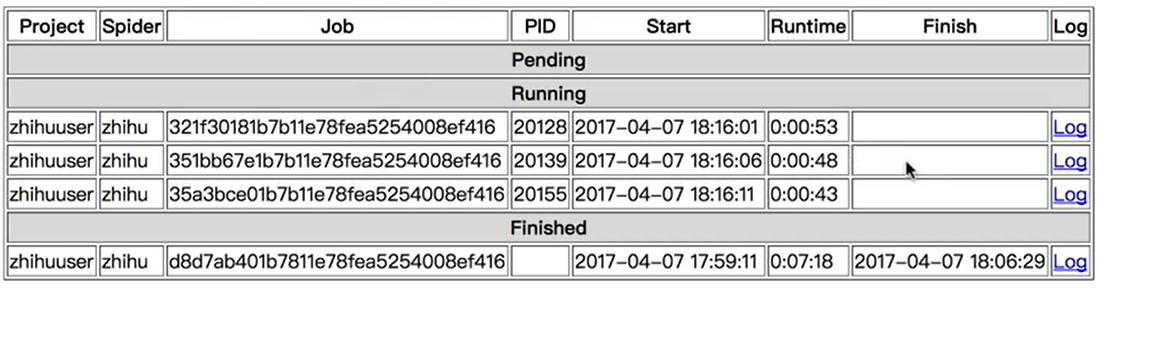

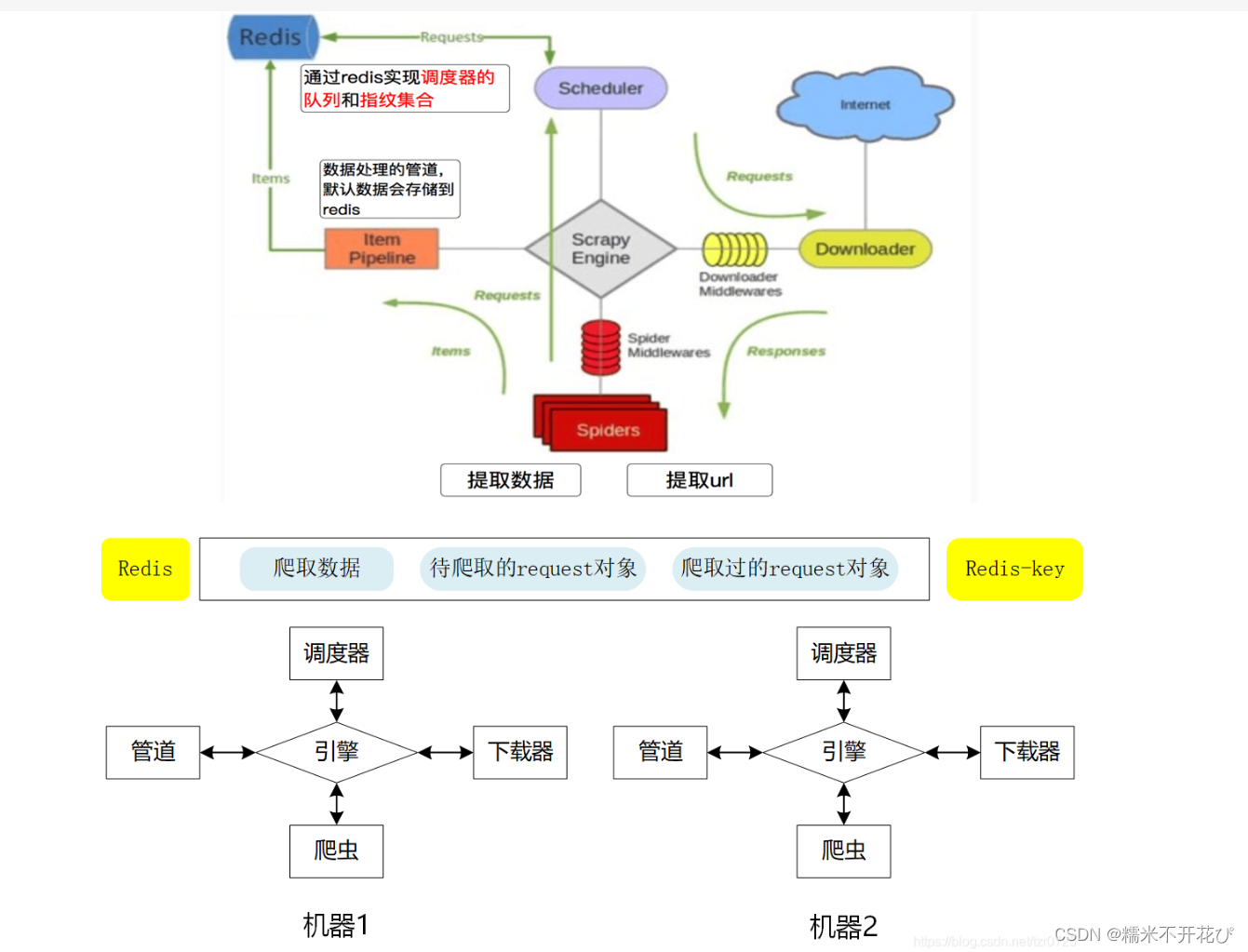

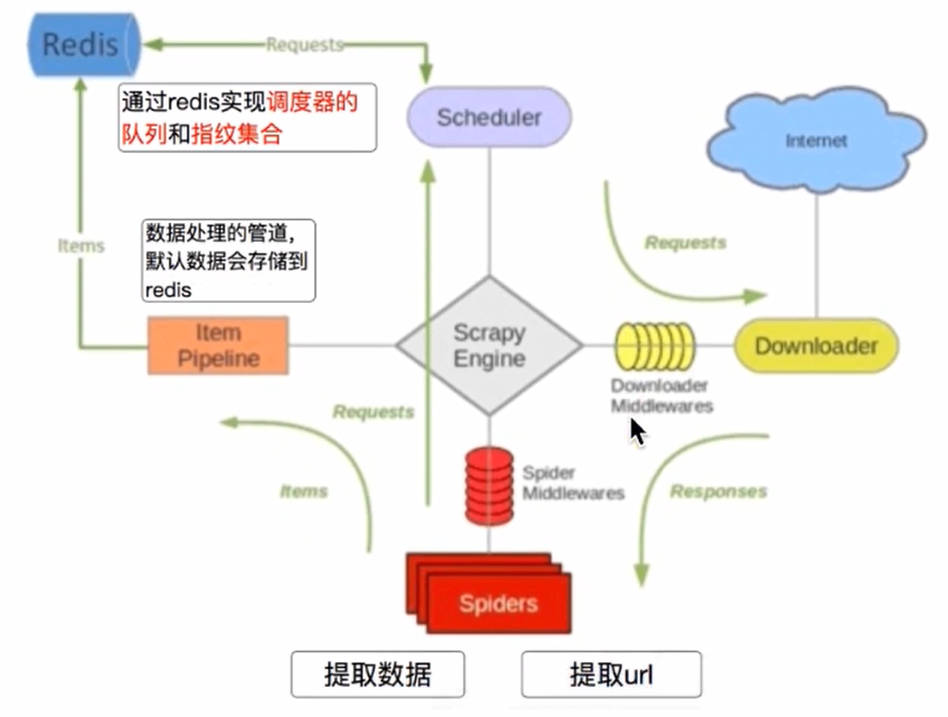

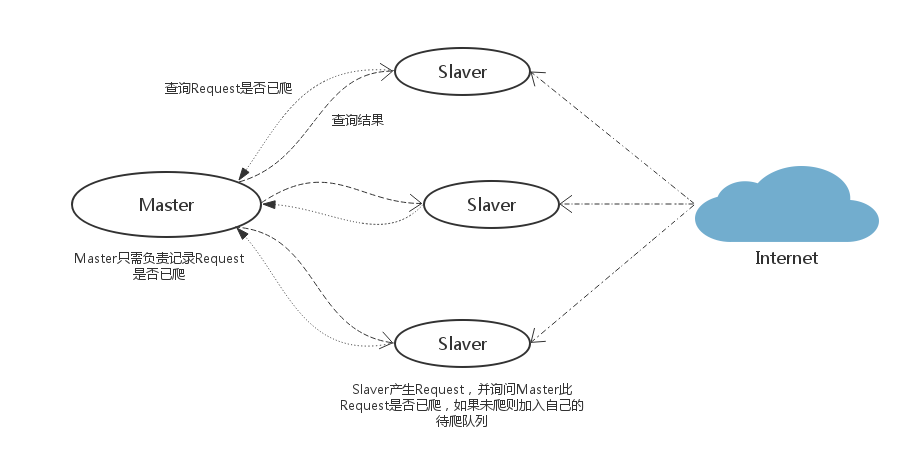

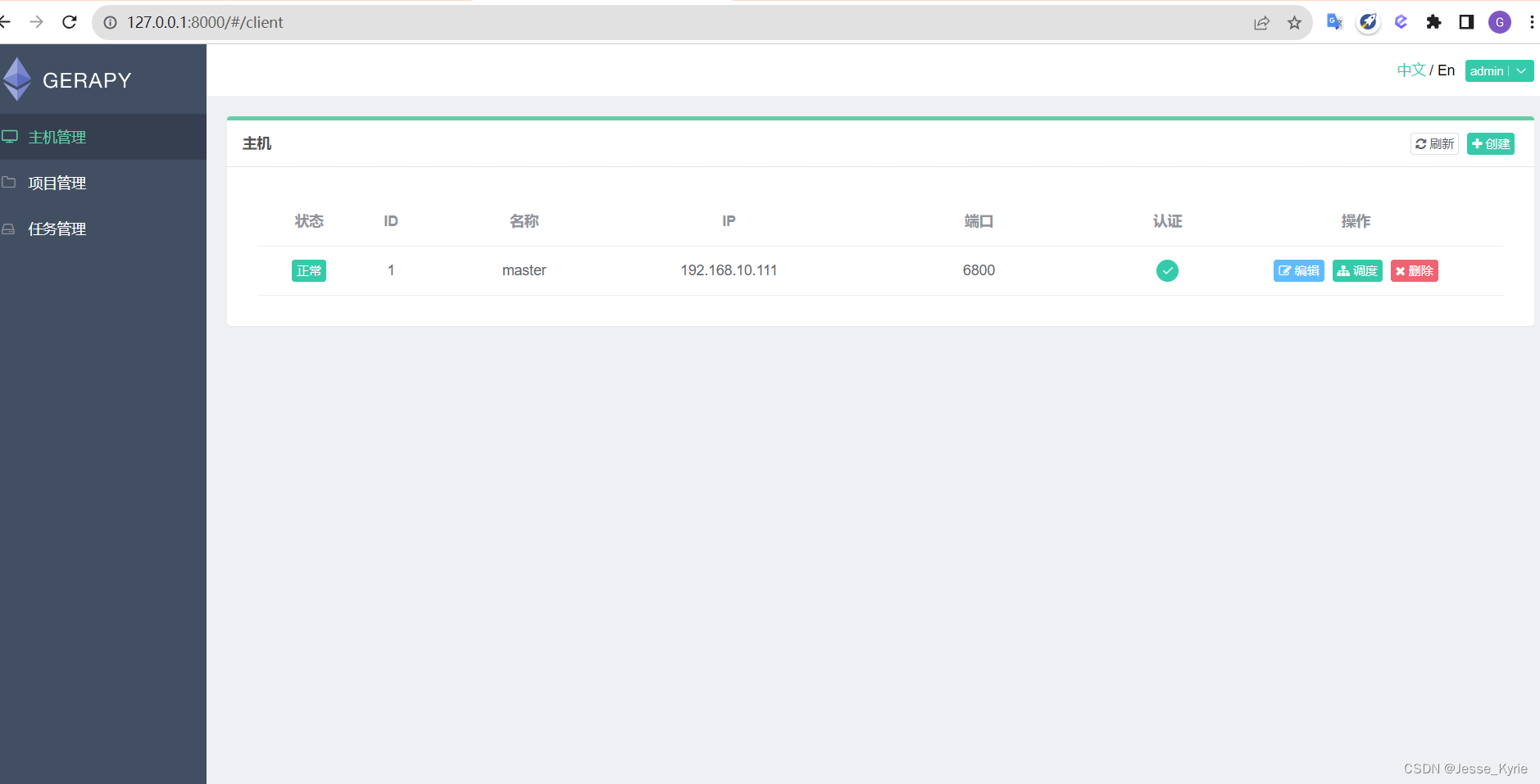

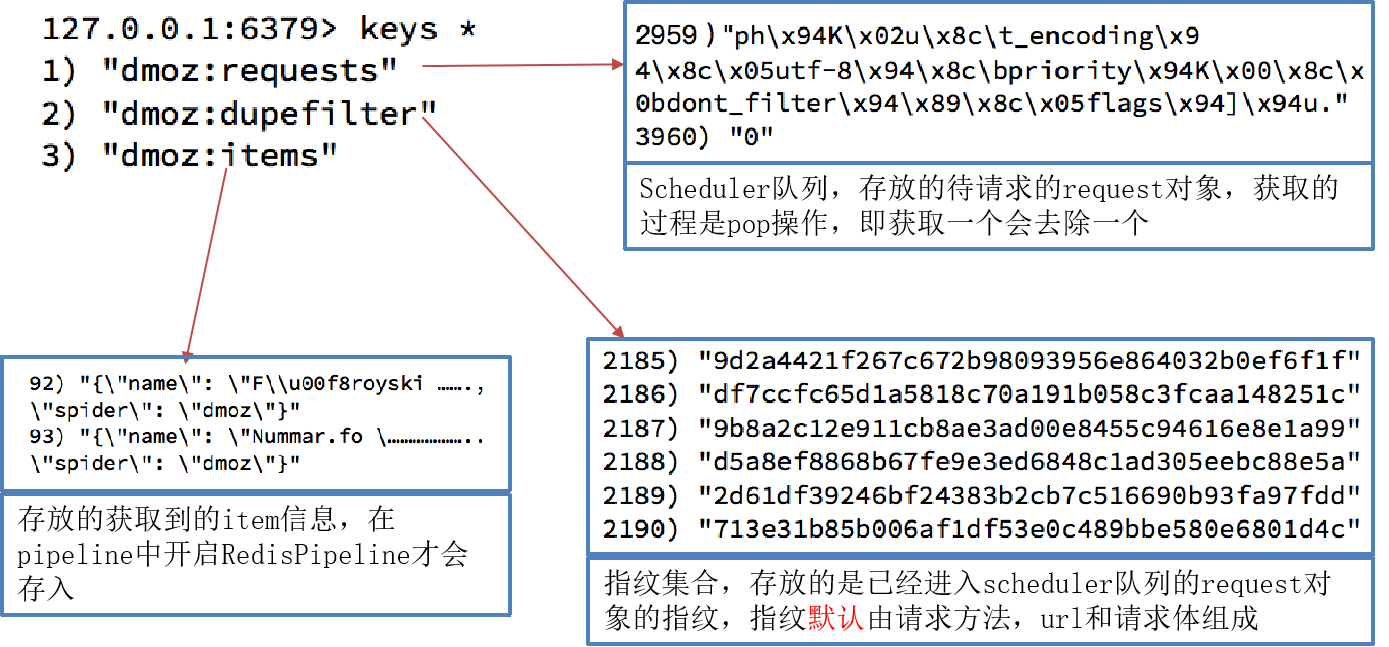

16 Scrapy之分布式爬虫

redis分布式部署 1.scrapy框架是否可以自己实现分布式? - 不可以。原因有二。 其一:因为多台机器上部署的scrapy会各自拥有各自的调度器,这样就使得多台机器无法分配start_urls列表中的url。(多台机器无法共享同一个调度器&#x…

爬虫 - 动态分页抓取 游民星空 的资讯 - bs4

# codingutf-8

# !/usr/bin/env python

author: dangxushengdesc : 动态分页抓取 游民星空 的资讯date : 2018-08-29

import requests

from bs4 import BeautifulSoup

import json

import timeurl "https://www.gamersky.com/news/"

headers {"User-Agent&…

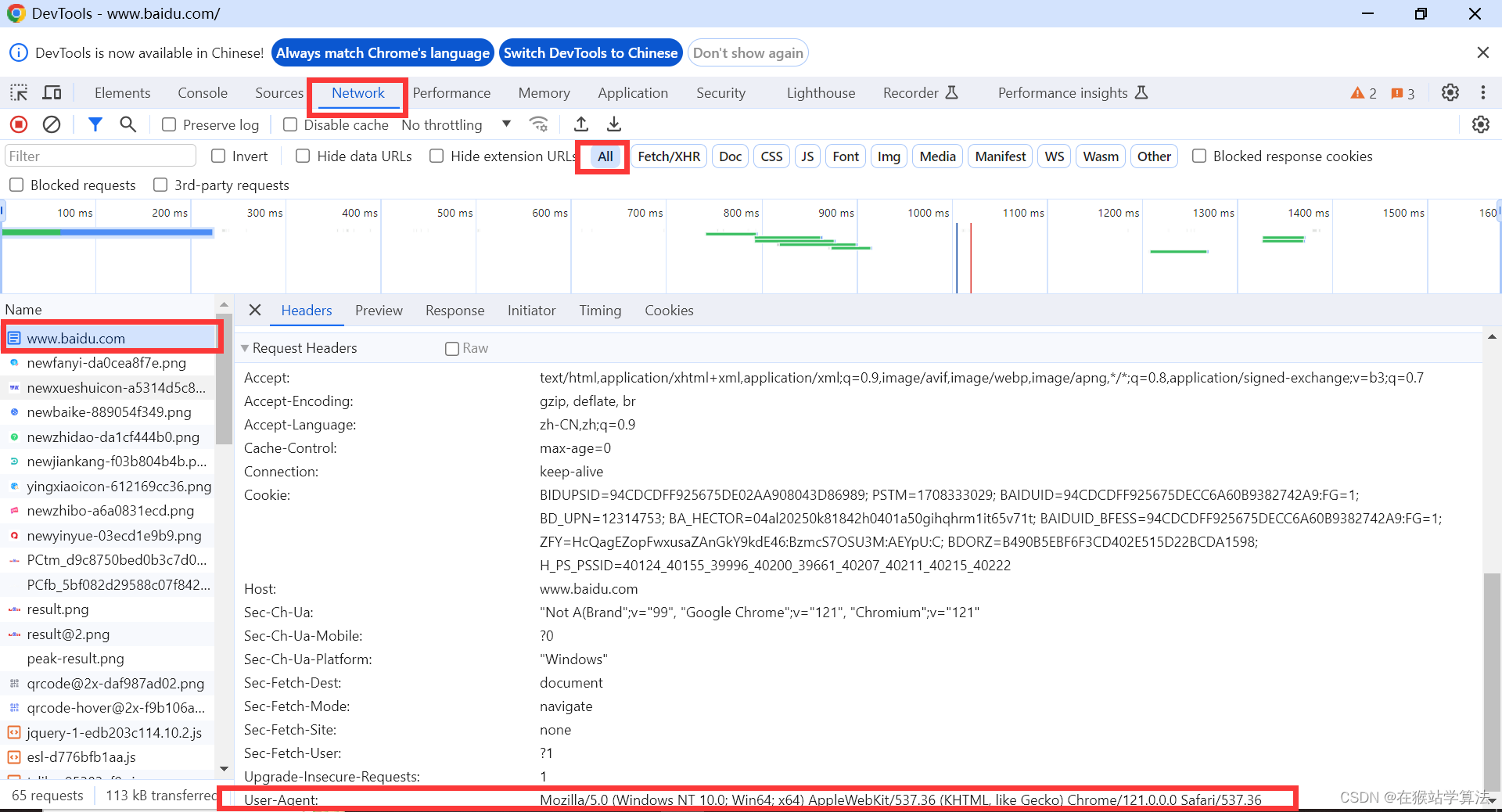

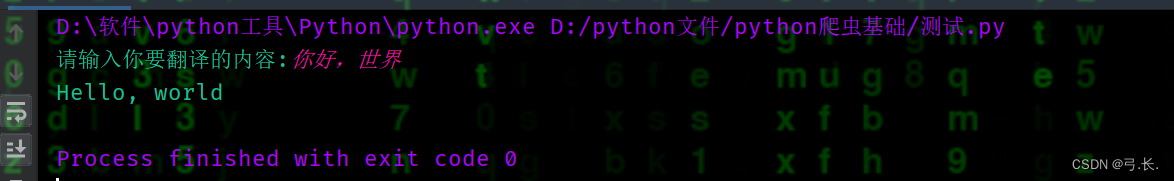

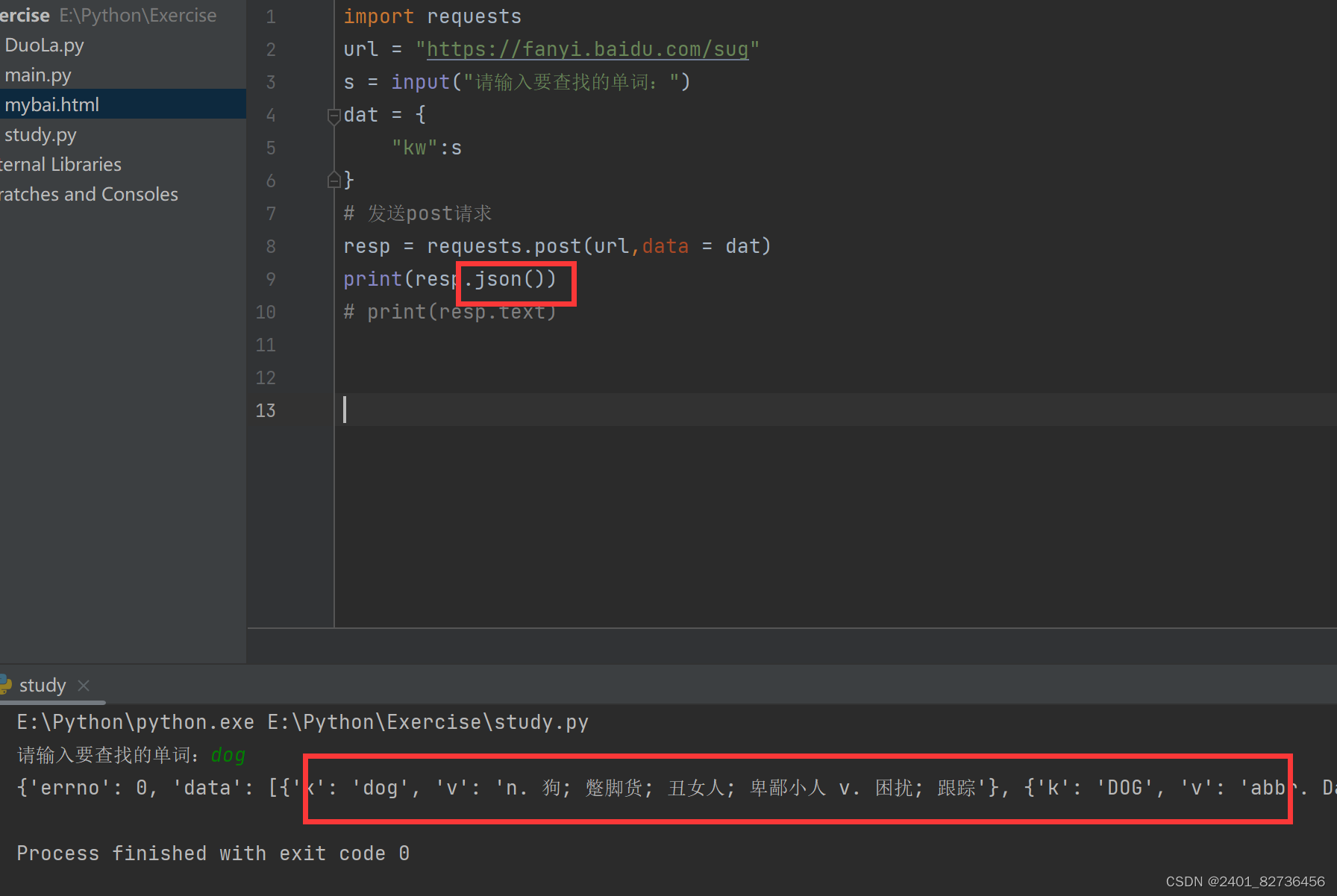

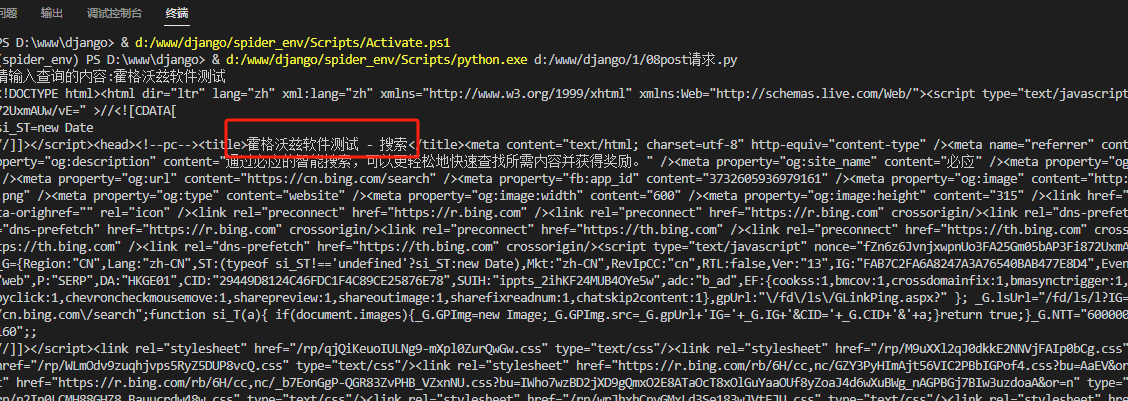

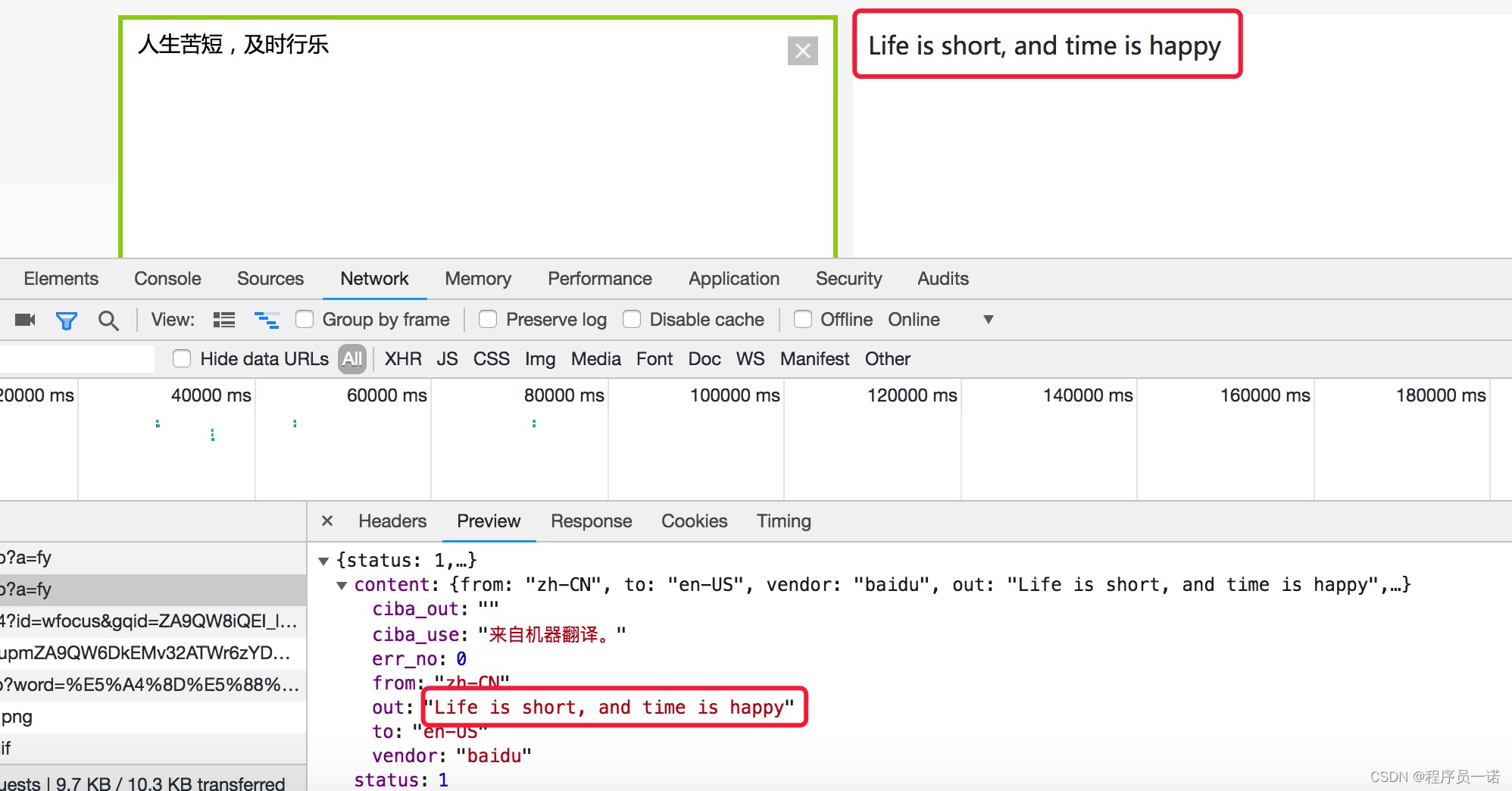

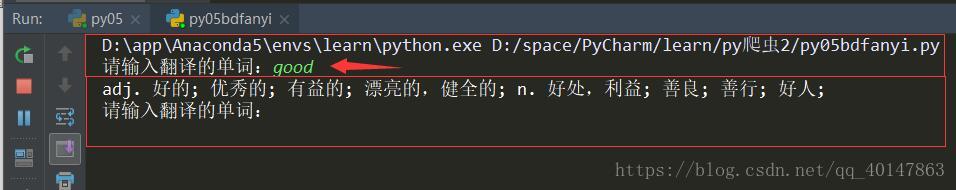

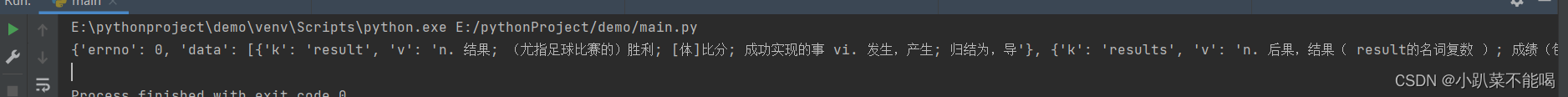

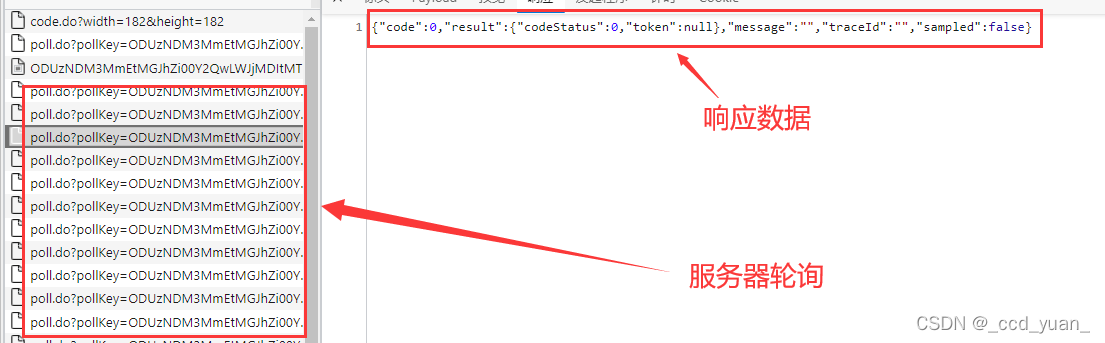

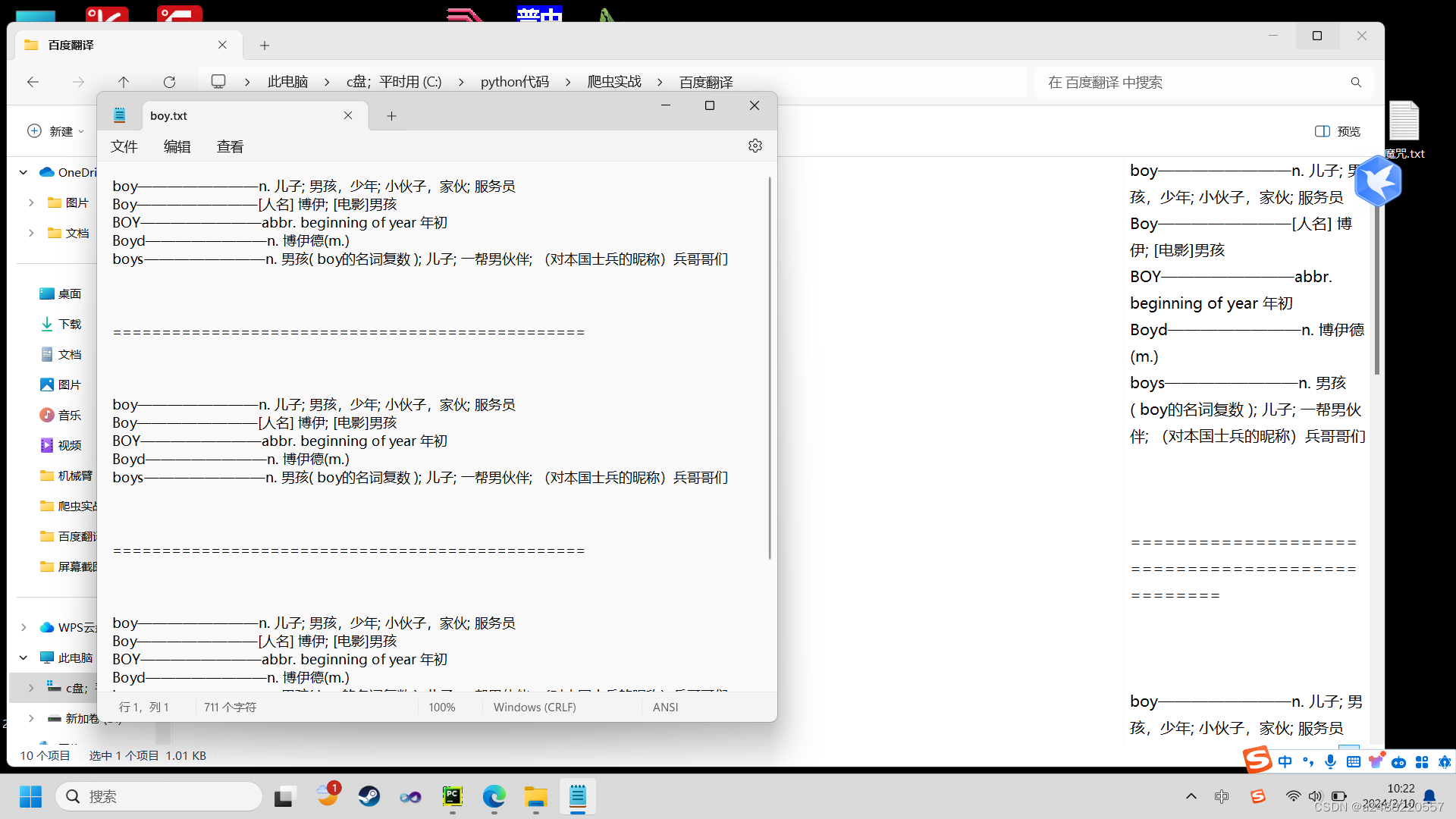

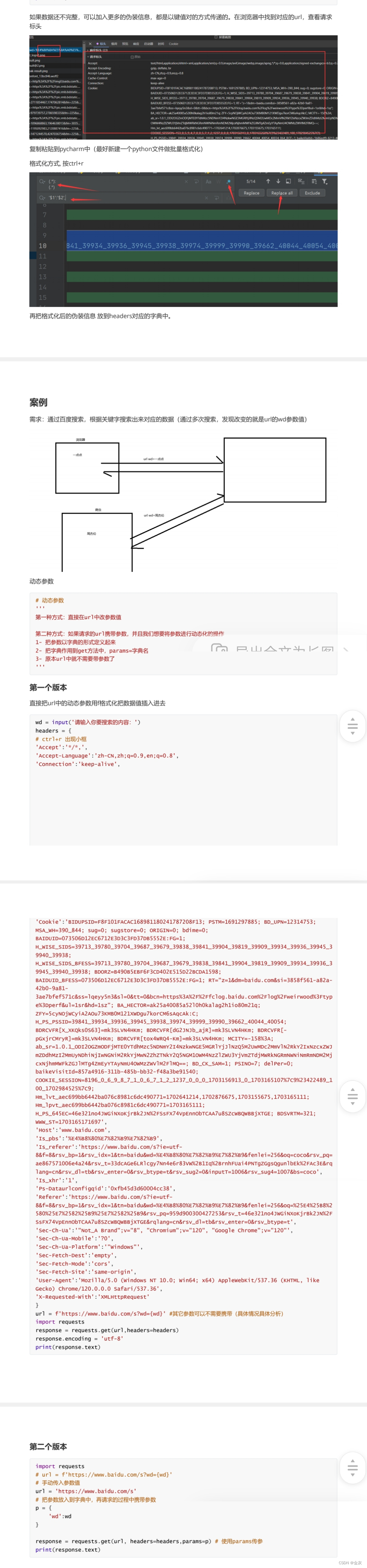

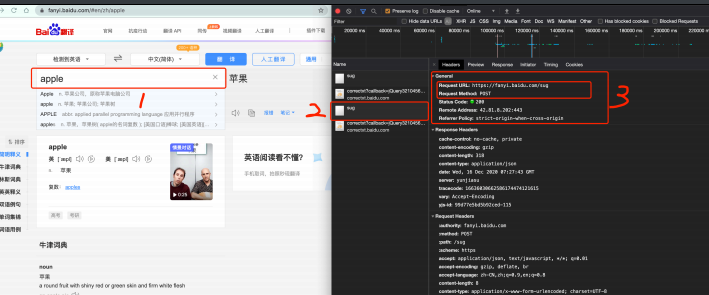

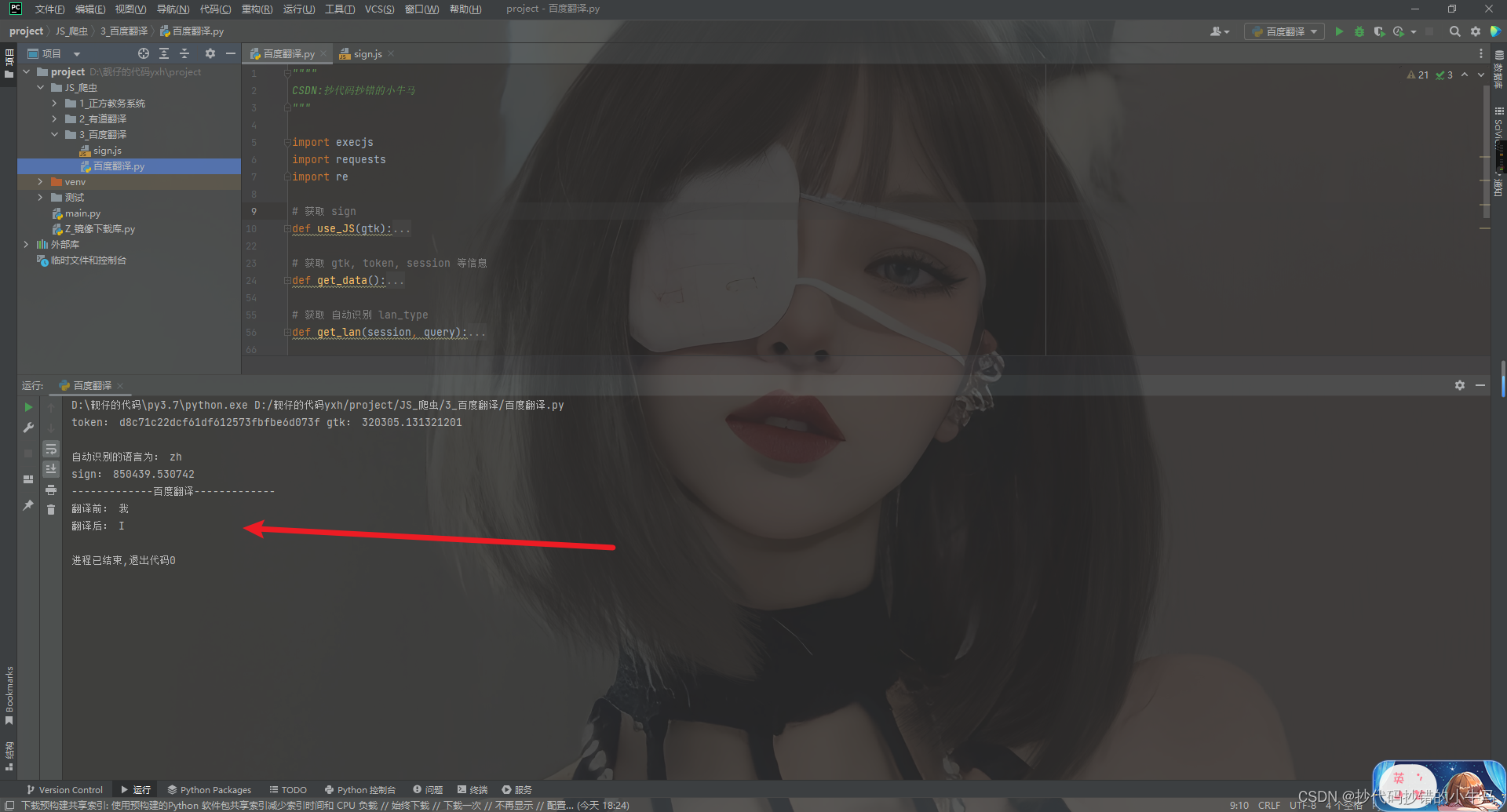

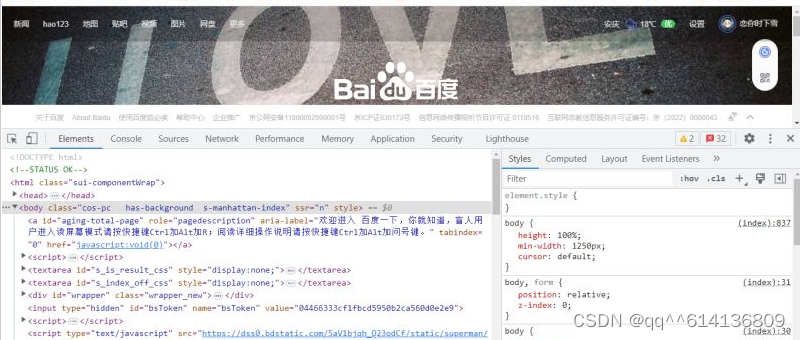

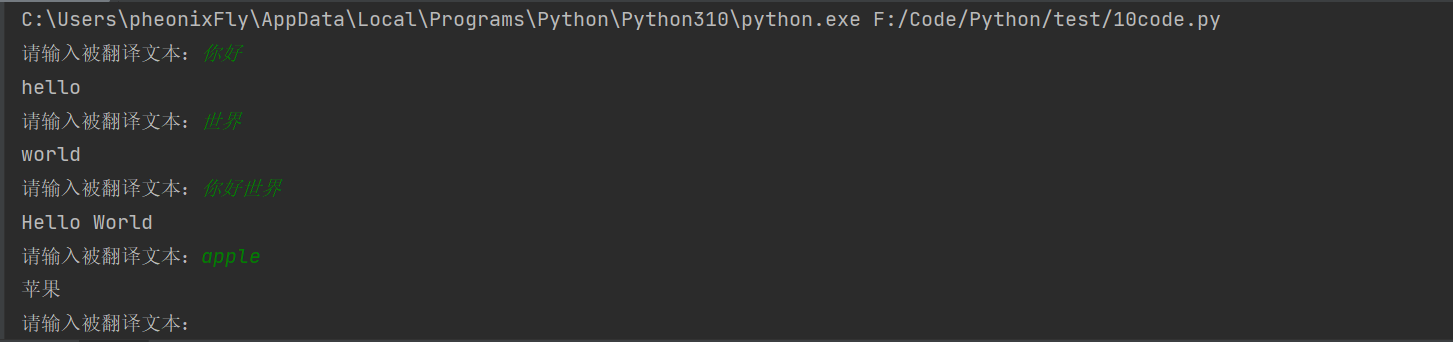

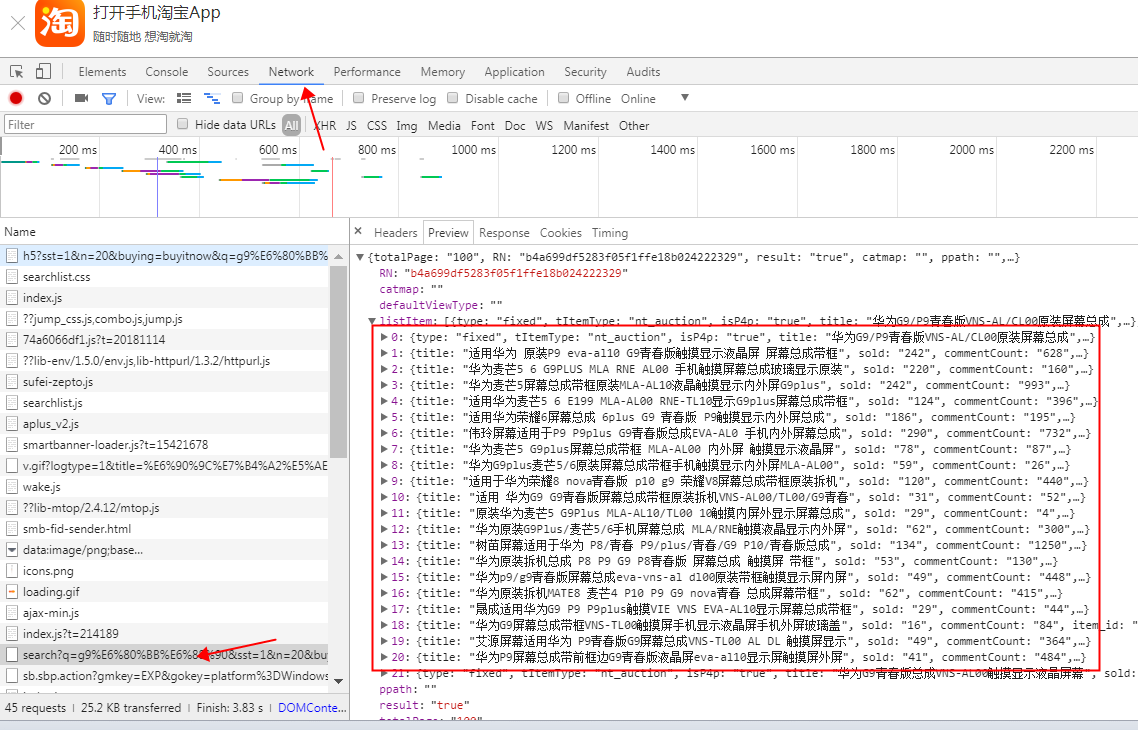

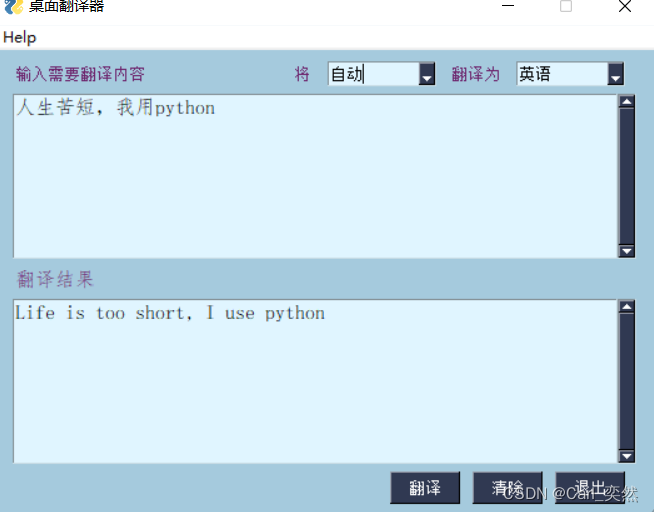

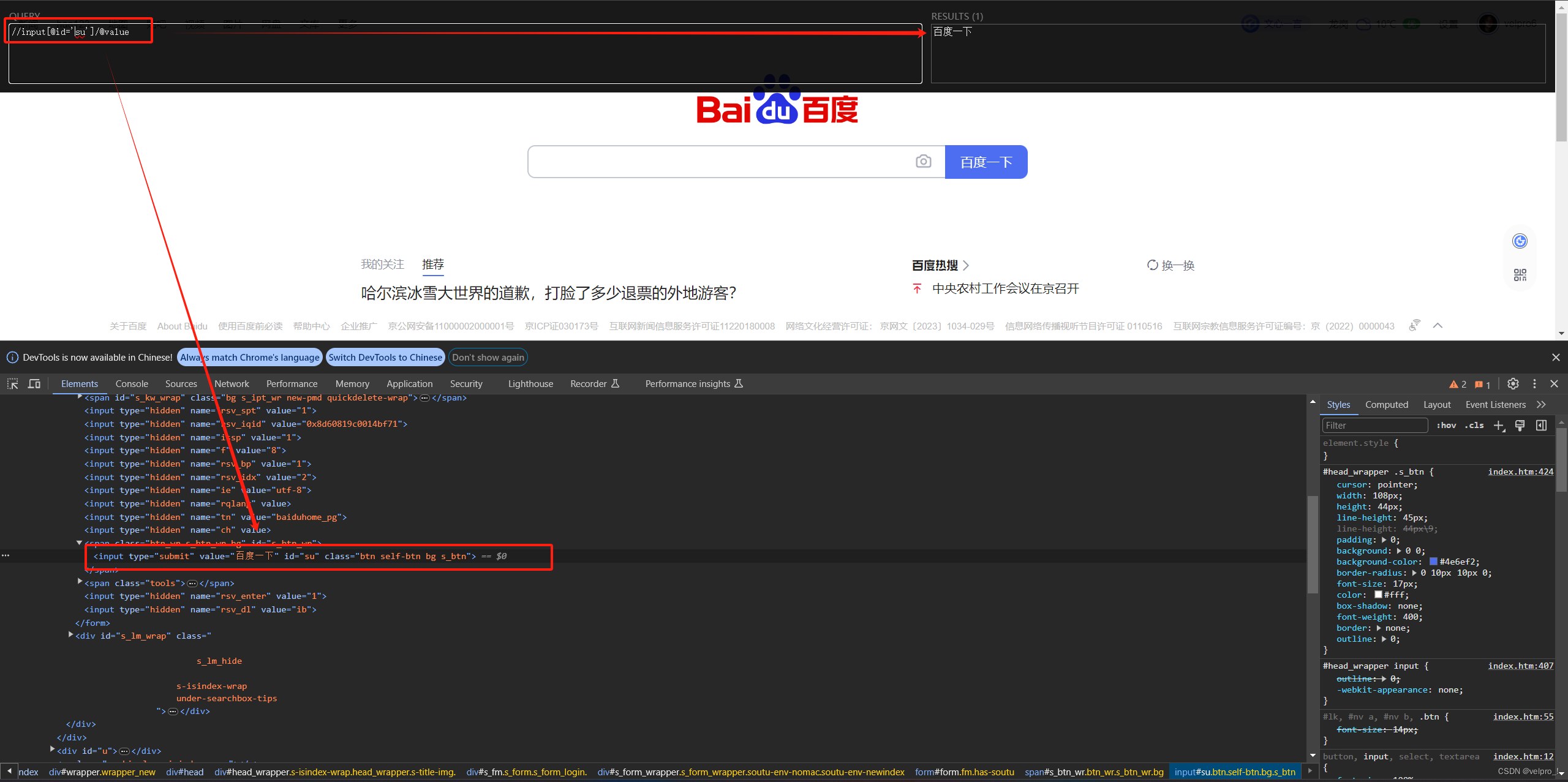

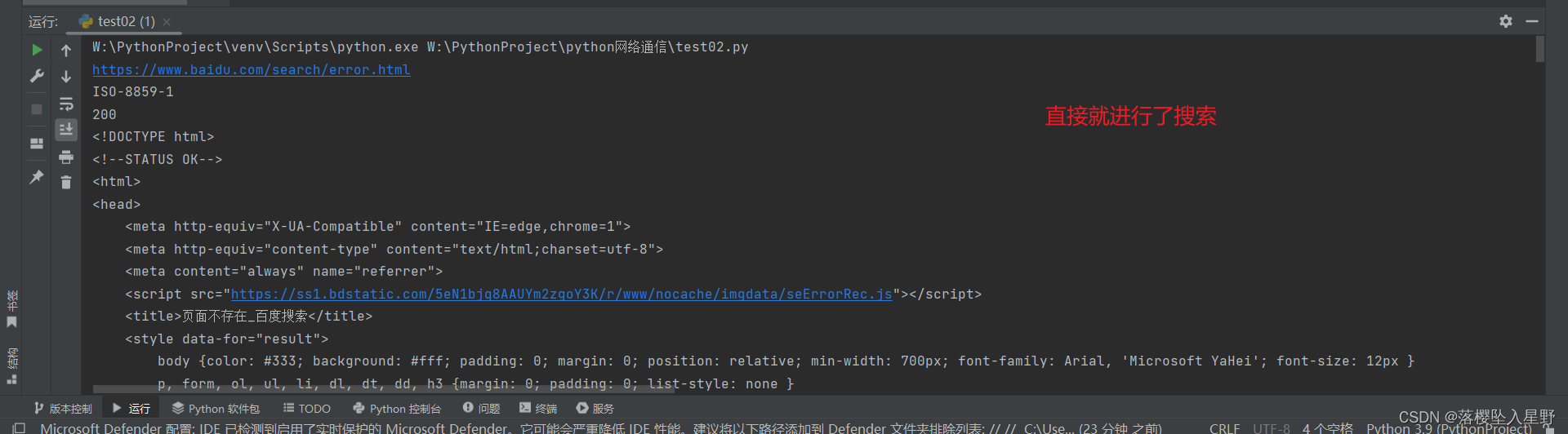

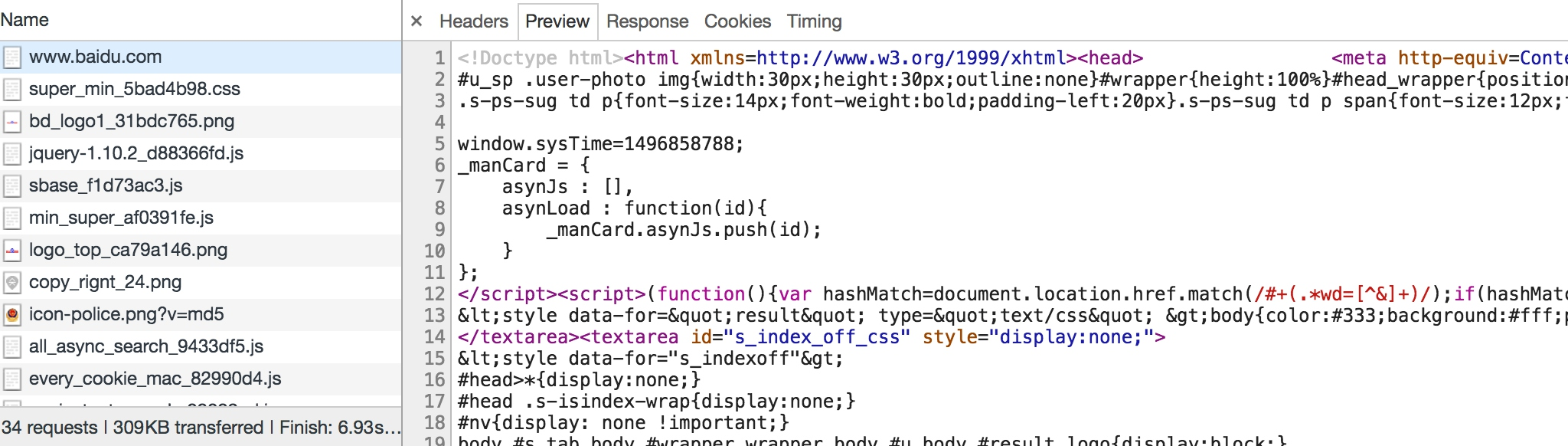

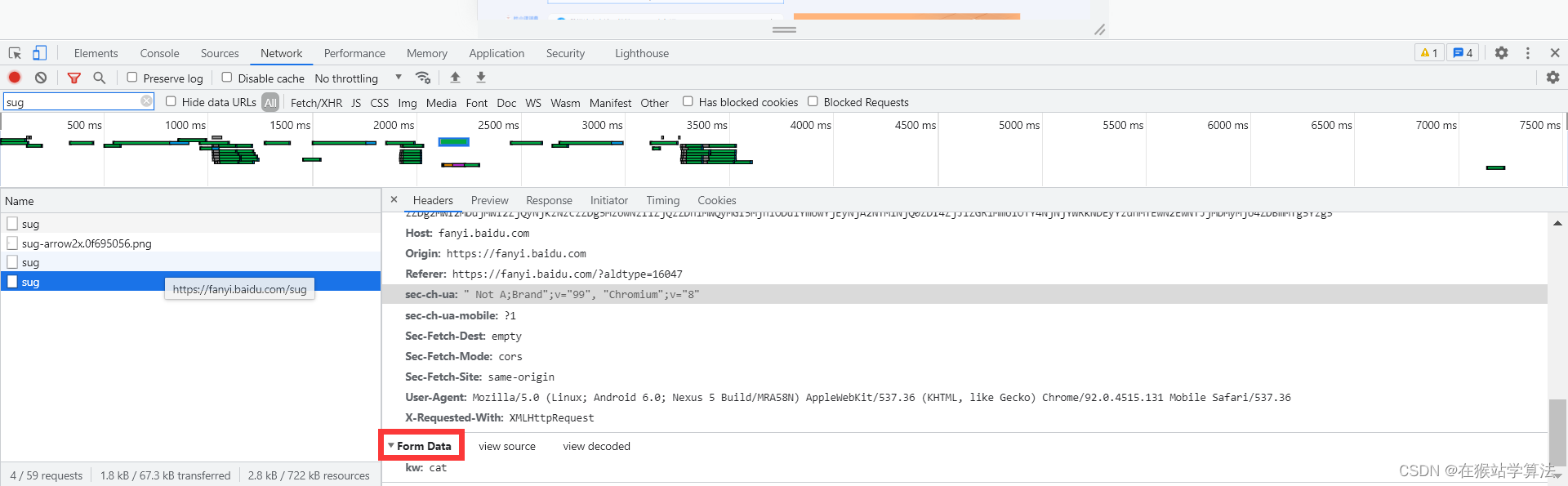

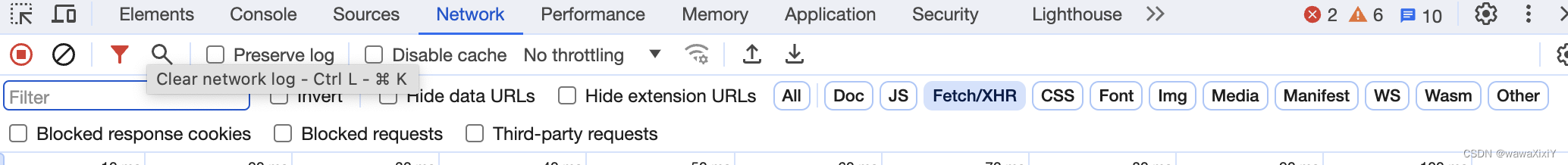

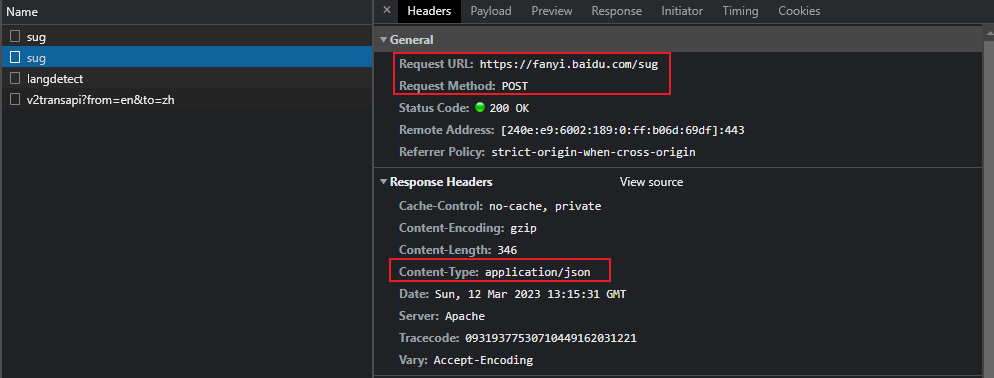

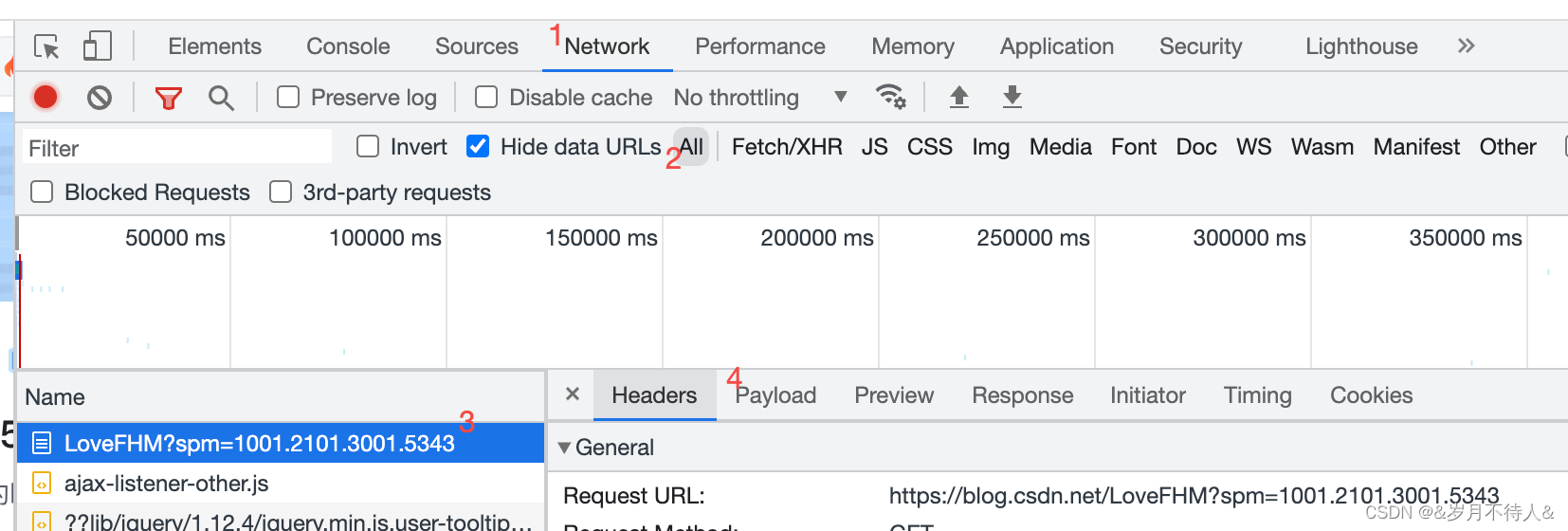

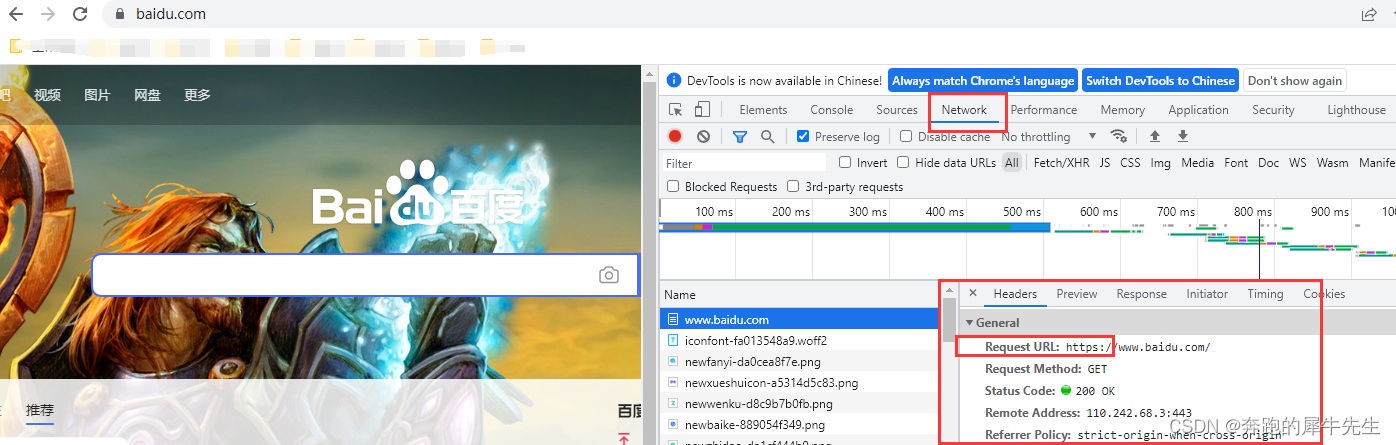

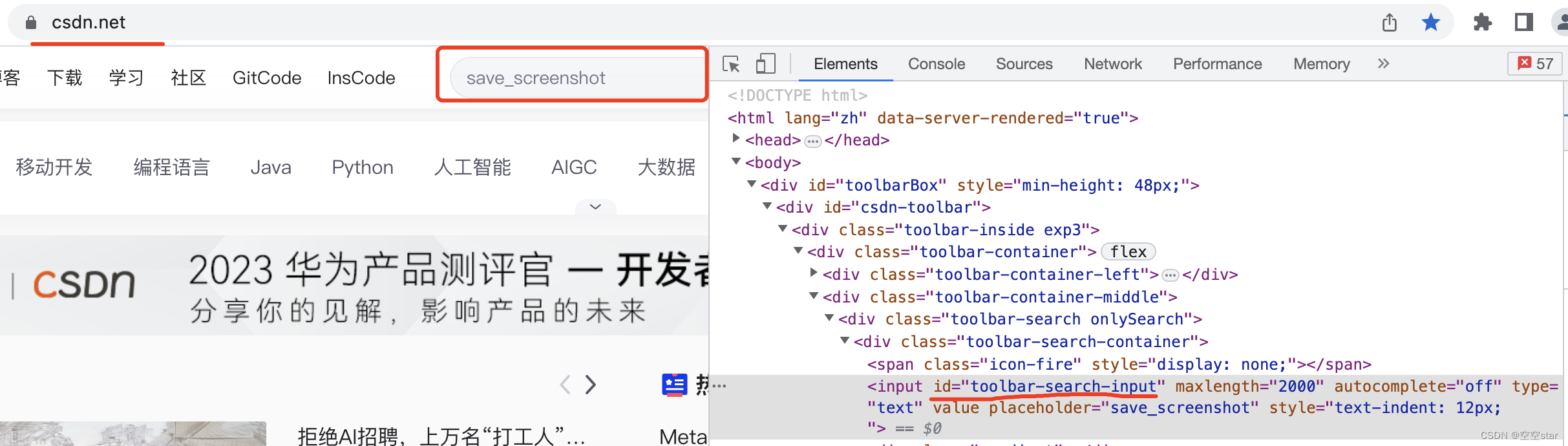

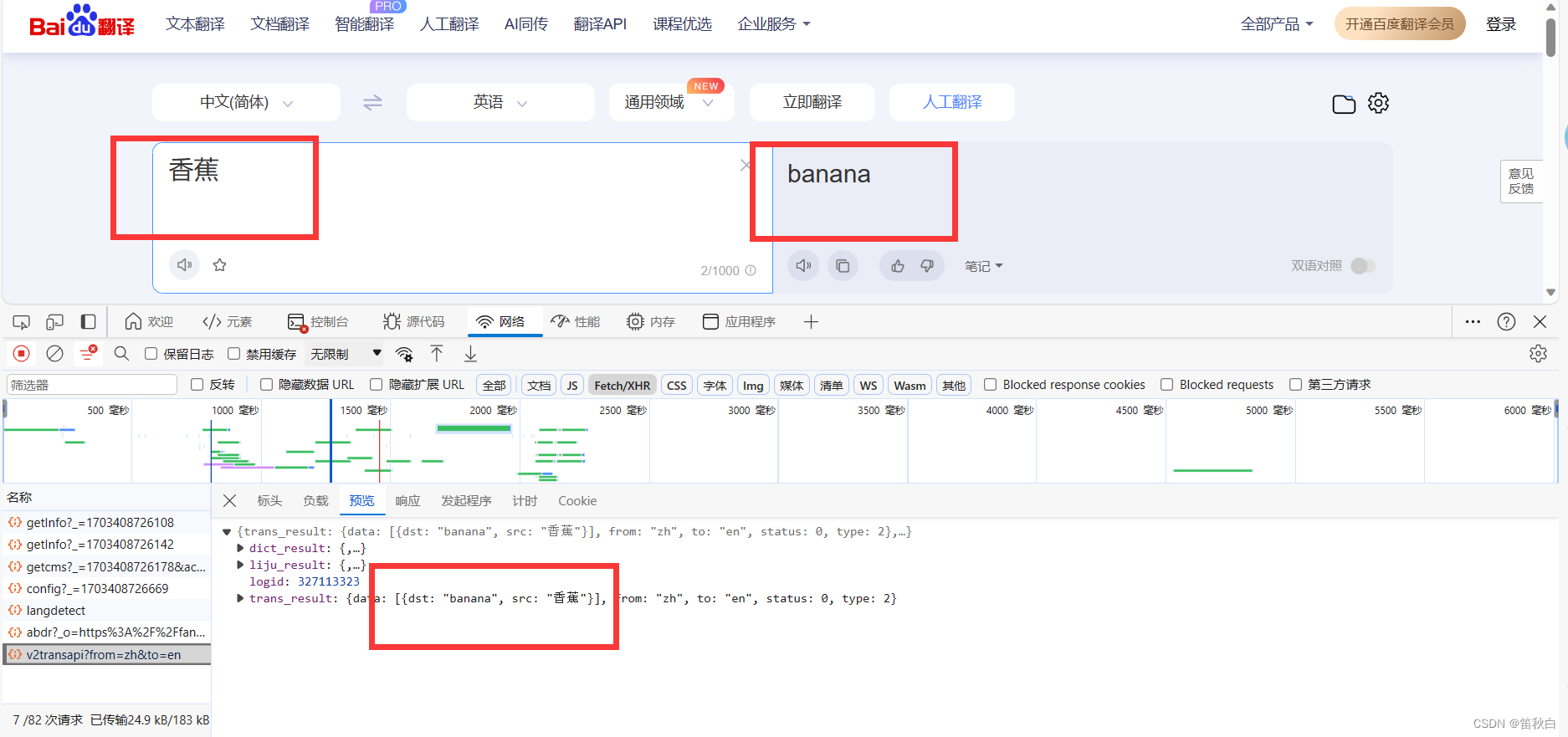

Python爬虫教程-05-python爬虫实现百度翻译

使用python爬虫实现百度翻译功能 python爬虫实现百度翻译: python解释器【模拟浏览器】,发送【post请求】,传入待【翻译的内容】作为参数,获取【百度翻译的结果】 通过开发者工具,获取发送请求的地址 提示:…

Go圣经-学习笔记之并发的字典遍历

2019独角兽企业重金招聘Python工程师标准>>> 上一篇 Go圣经-学习笔记之select多路复用 面试题:输入目录或者文件,求目录或者文件的磁盘占用大小,类似du命令? 编程实现 // 实现思路:

// 1. 获取当前所有目录…

使用teleport ultra爬取网站源码

有时候看到好看的网站总想爬取下来玩一玩,模仿一下,这里介绍一个好用的工具teleport ultra 下载链接:teleport ultral

下载之后,安装,注意安装的时候把默认勾选的推广软件取消了!

爬取步骤:

…

利用Fiddler抓取APP

之前一直都是做网页爬虫,这两天接了新项目,我负责37个APP的抓取工作,所以趁热写一下APP爬虫的步骤,这里是采用fiddler抓取数据包: 1.fiddler安装 去官网https://www.telerik.com/fiddler下载安装就可以了,比…

网站url改版必须要注意的几点

懂点seo的人都知道,网站url地址的美观程度会影响搜索引擎的排名,搜索引擎更喜欢语义化的url地址,比如http://www.xx.com/archives/35 要远远好过 http://www.xx.com/index.php?mcontent&cindex&ashow&catid21&id1060&#x…

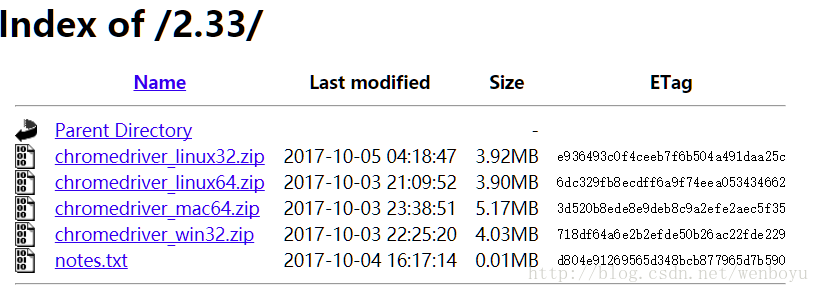

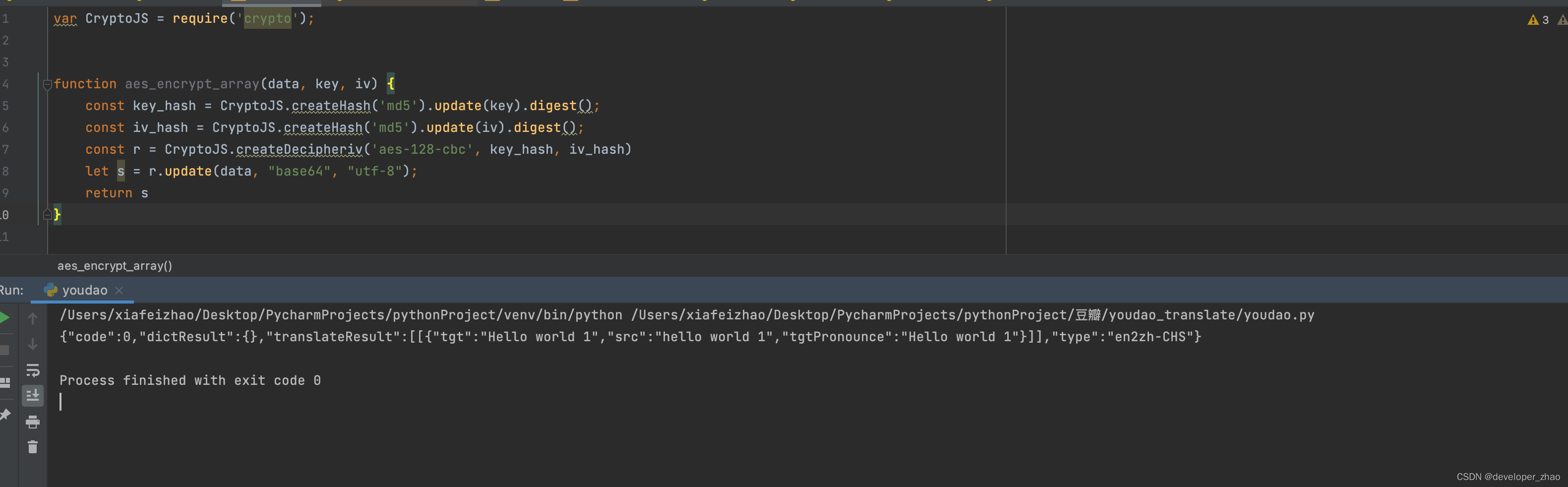

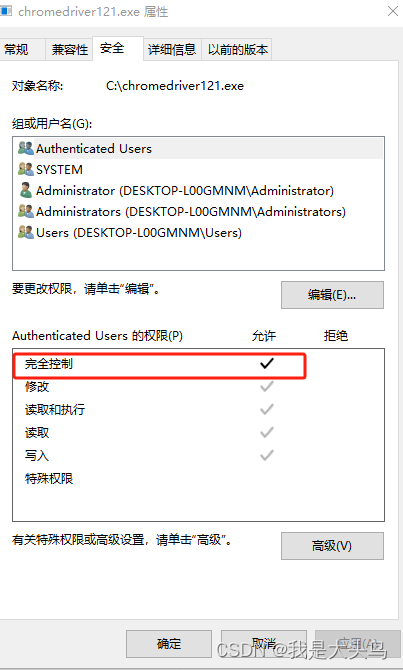

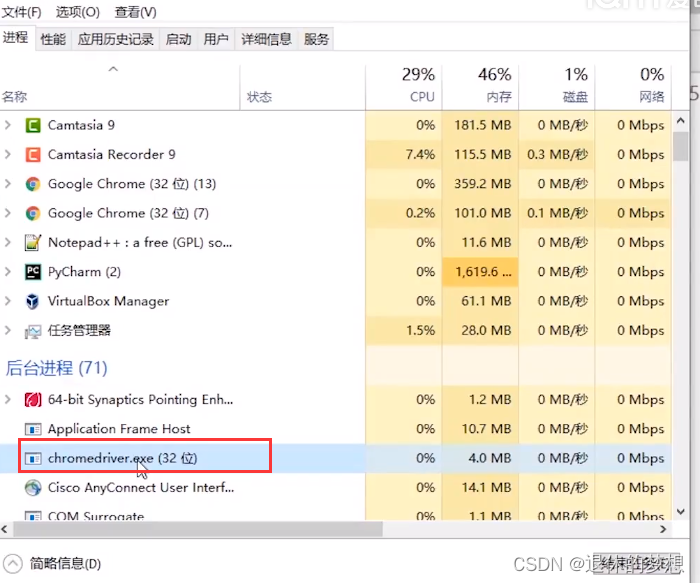

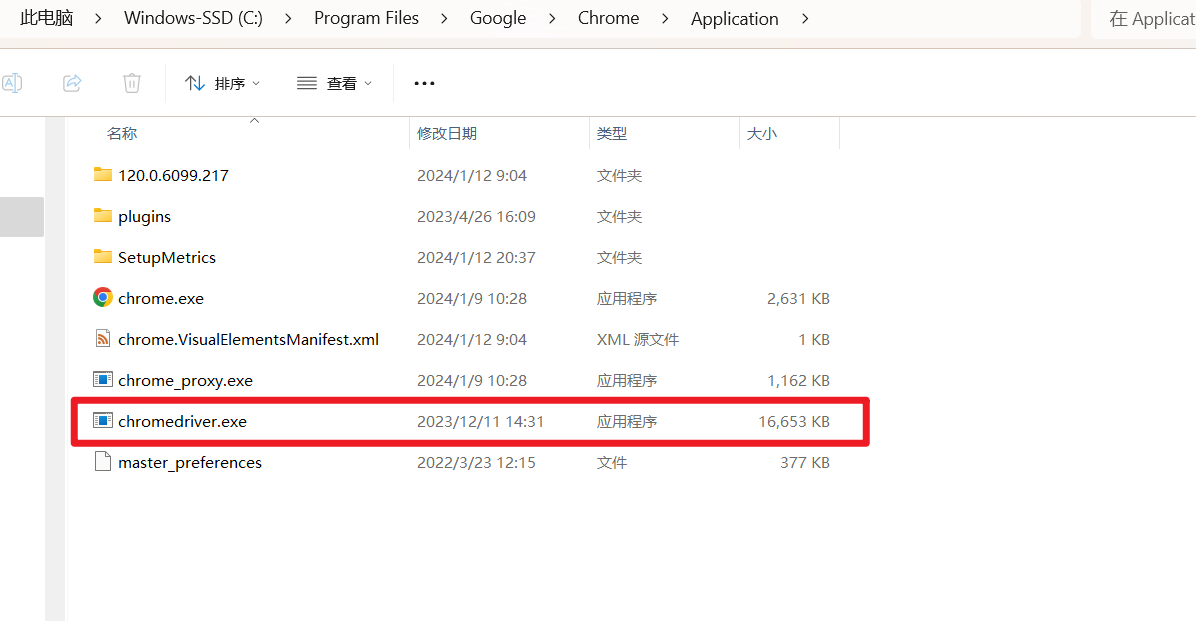

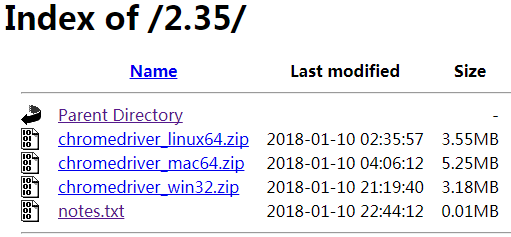

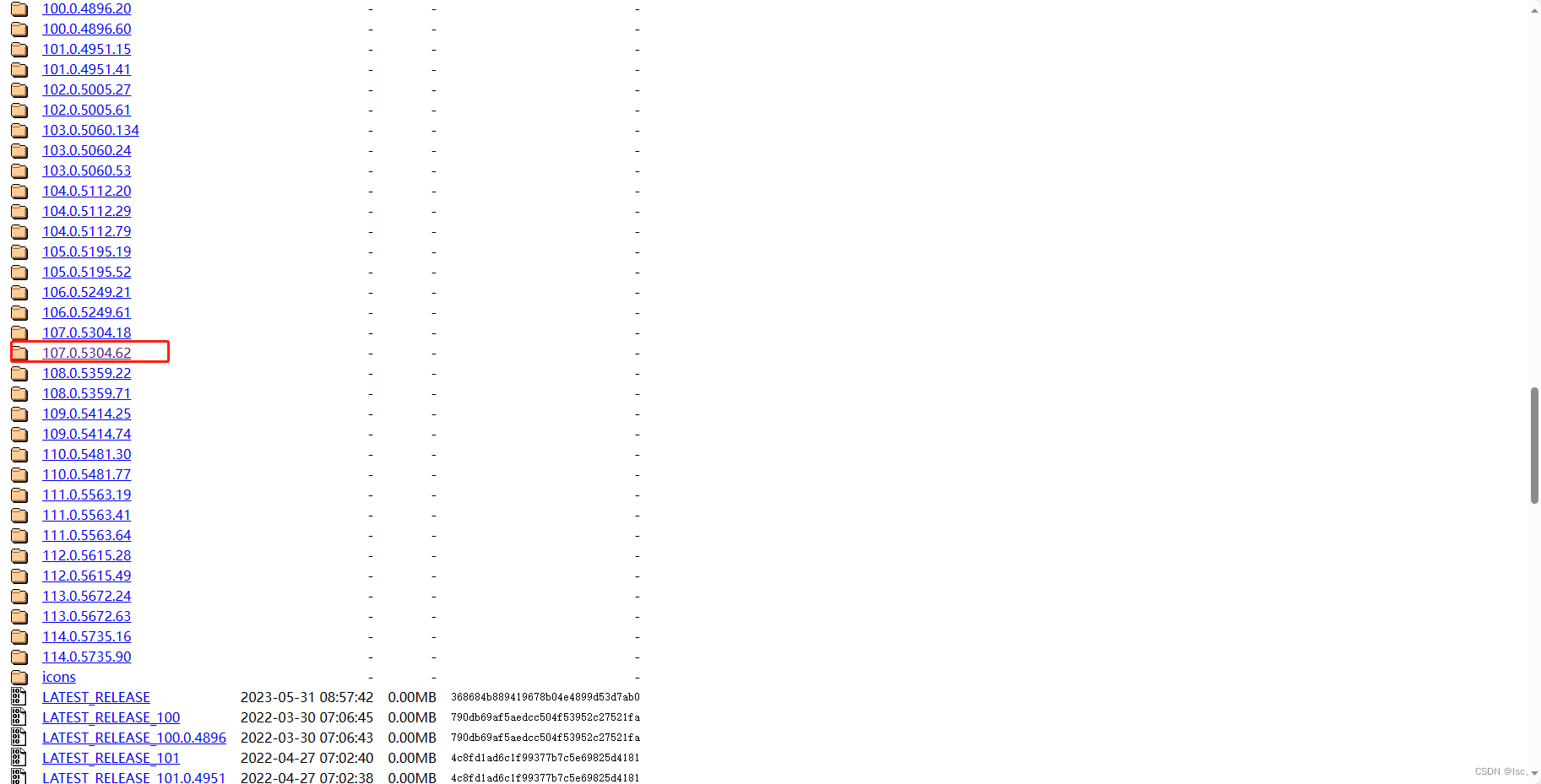

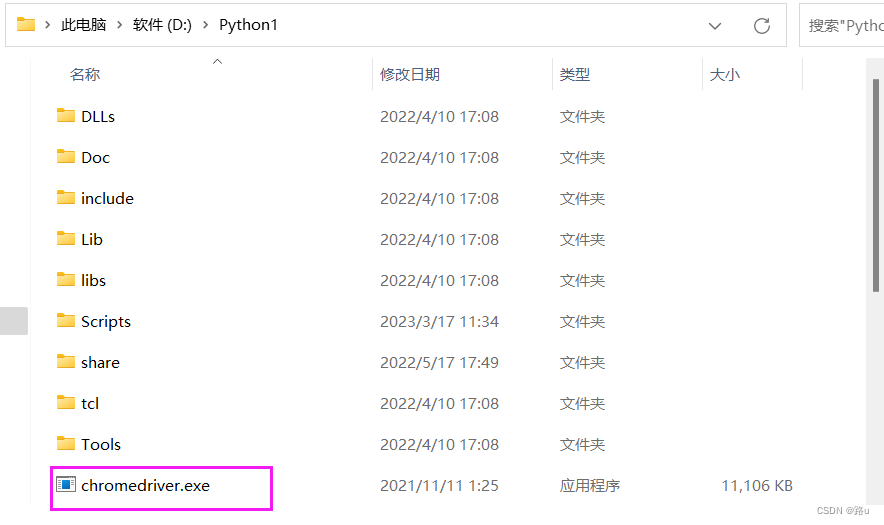

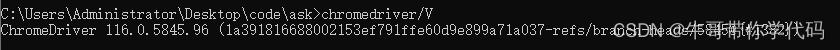

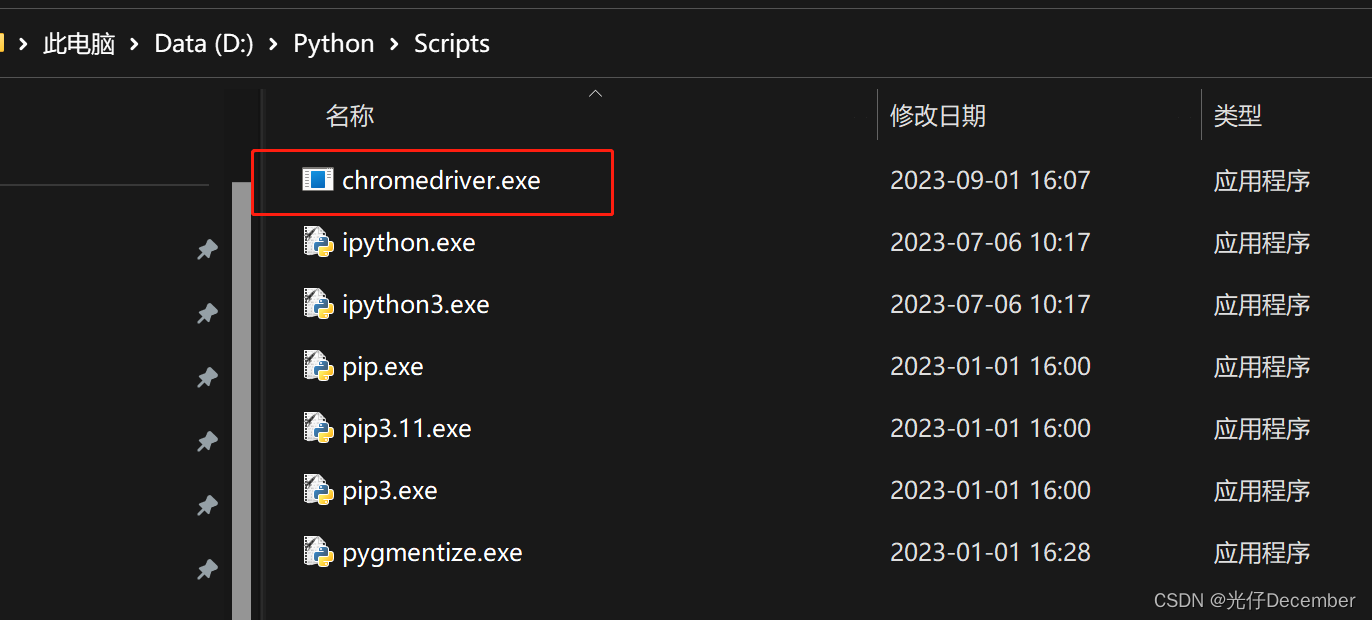

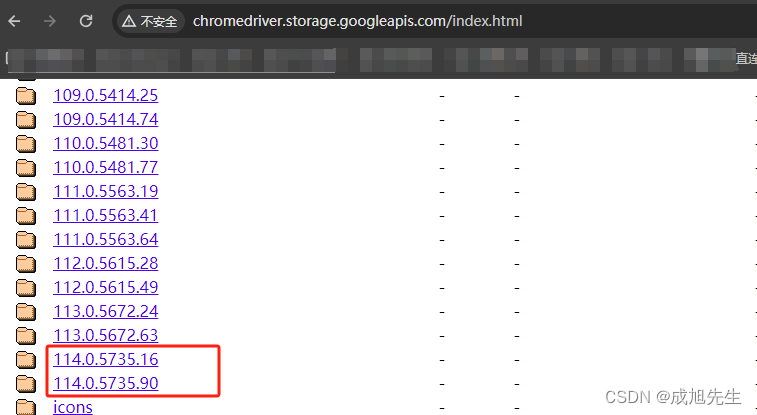

爬虫_使用chromedriver.exe下载网页

window10,pycharm

1. 查看电脑上Chrome浏览器版本

1.1 在Chrome浏览器地址栏中输入 chrome://version/ 2. 下载 chromedriver.exe

2.1 下载地址 http://chromedriver.storage.googleapis.com/index.html

2.2 找到和自己安装的chrome对应的版本 下载后解压&…

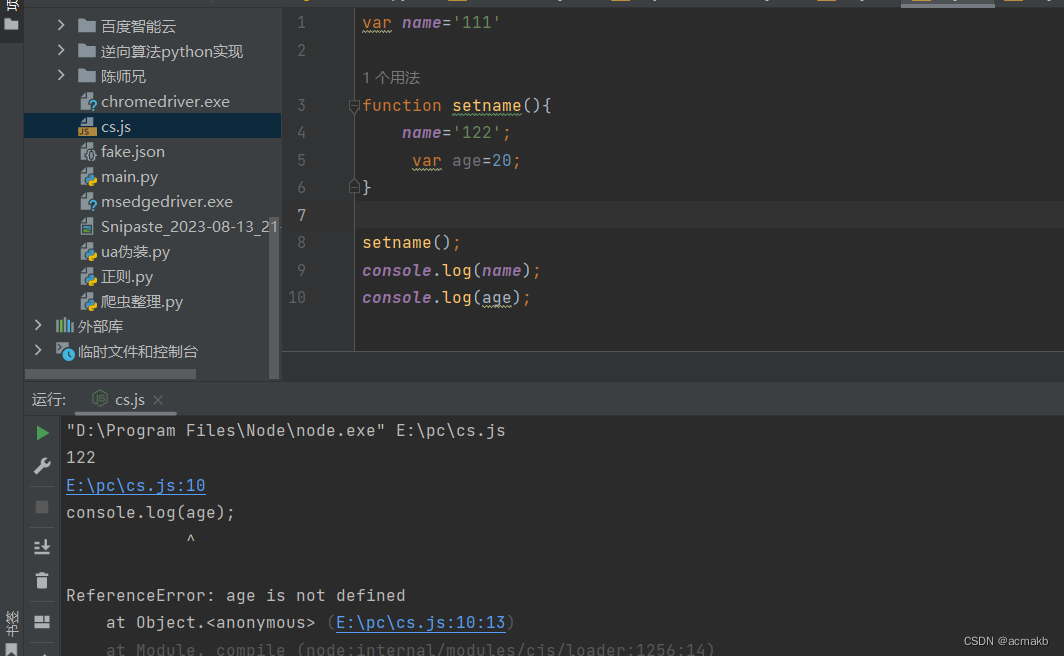

Python学习之路——函数对象作用域名称空间

一、函数对象 # 函数名就是存放了函数的内存地址,存放了内存地址的变量都是对象,即 函数名 就是 函数对象# 函数对象的应用

# 1 可以直接被引用 fn cp_fn

# 2 可以当作函数参数传递 computed(cp_fn, 100, 20)

# 3 可以作为函数的返回值 get_cp_fn(cmd…

初学爬虫(二):爬取静态网页之(1)安装requests库

1、什么是静态网页?

静态网页一般指的是纯粹HTML的网页。 静态网页的所有数据都呈现在网页的HTML代码中,所以静态网页的数据是比较容易获取的。

2、为什么要安装requests库?

requests库是一个功能十分强大且完善的库,它能帮助我…

ASP.NET MVC内置的Filter实现介绍

有时候你想在调用action方法之前或者action方法之后处理一些逻辑,为了支持这个,ASP.NET MVC允许你创建action过滤器。Action过滤器是自定义的Attributes,用来标记添加Action方法之前或者Action方法之后的行为到控制器类中的Action方法中。 一…

关键词的选择是搜索的最关键的技巧(转)

搜索引擎我已经讲过了,google,百度等是精品,也许大家都不难选择,但同一个引擎,不同人会搜索出不同结果,而且甚至差别很大。尤其体现在那些具有专业性质的东西中,其中的奥秘是什么? 关…

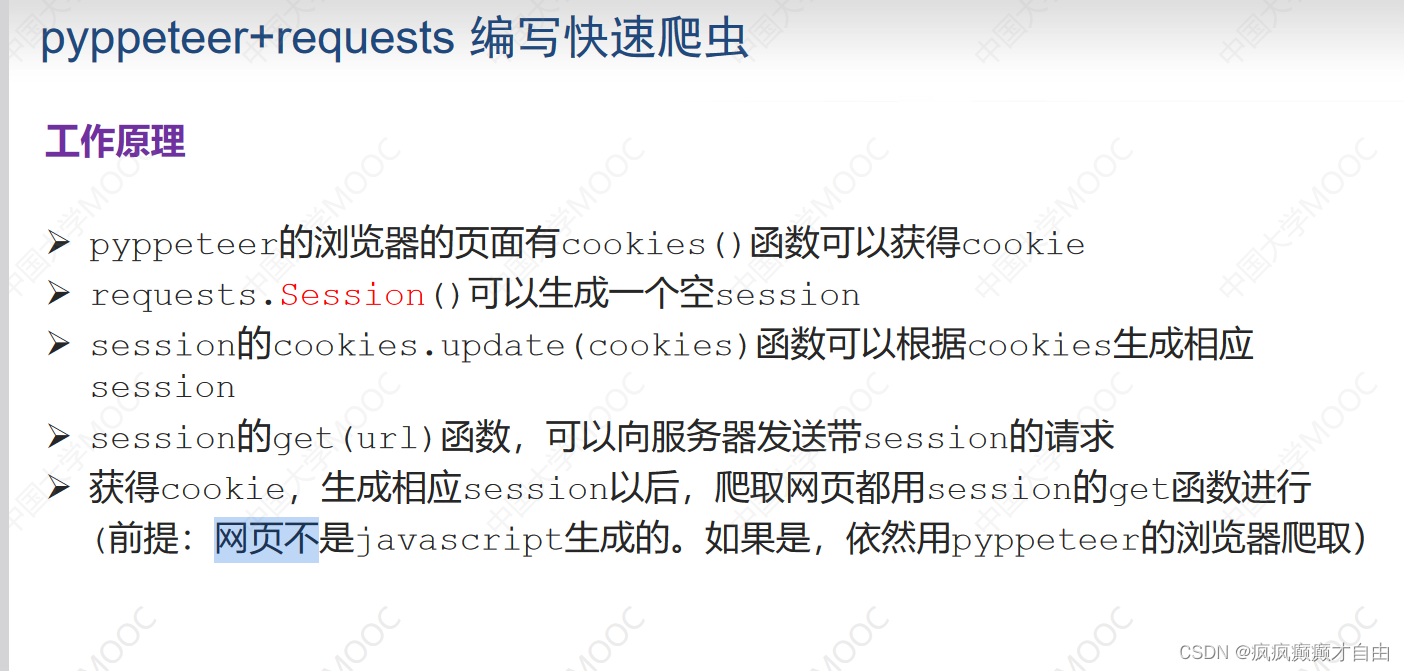

pypepeteer的使用代替selenium(防止反爬)

# pypepeteer同样可以操作浏览器,和selenium具有同样的功能,但是很多反爬虫网站能检测到selenium,所以同样拿不到数据,那我们就得pypepeteer 以下是官方说明: Installation Pyppeteer requires python 3.6. (experimen…

request爬虫入门

🌸request爬虫入门 从网页的基本结构开始讲述, 慢慢使用一些简单的工具, 做一些简单的爬虫. 还会有一些小练习, 让你爬爬真正的互联网. 下载美图, 逛逛百度百科, 全网爬取等等. 当你懂得了爬虫的概念, 我们在深入一些, 谈谈如何加速你那和蠕虫(爬的慢)一样的爬虫, 把…

Ubuntu中使用RoboMongo实现MongoDB的可视化

2019独角兽企业重金招聘Python工程师标准>>> 在运行爬虫的过程中,考虑到将数据存储到数据库会更加方便查看和测试,所以使用了mongodb存储爬虫结果。在Ubuntu中,对MongoDB的操作都是在命令窗口中进行的,无法以图标的形式…

手机最强 Python 编程神器,在手机上运行 Python 不再是梦

手机编程软件有很多,大部分都很难使用,操作不灵活,甚至不能安装第三方库。 尝试安装了很多Python移动编程软件,发现了很多问题,不是编码效率低就是各种bug。今天,来自一位python编程小哥指导,向…

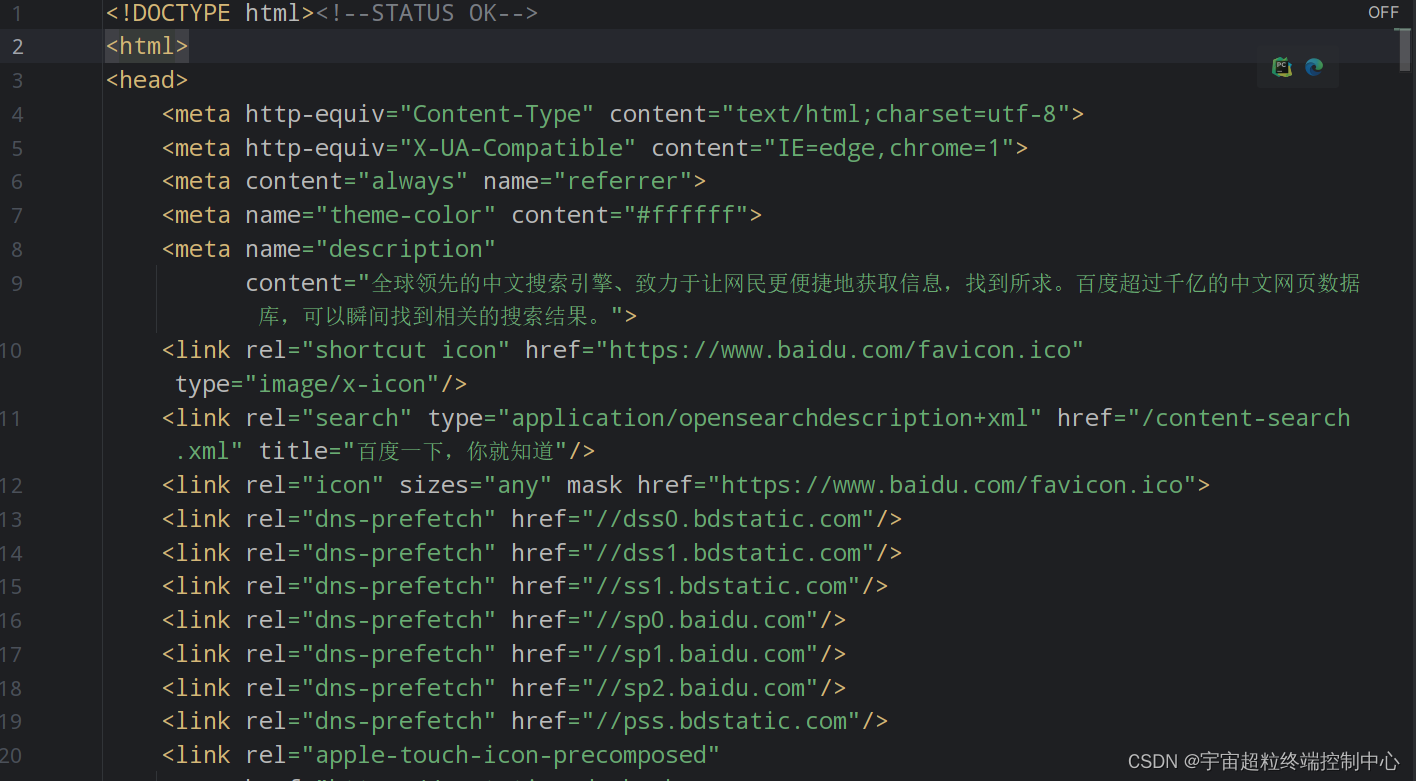

Python爬虫之Urllib库的基本使用

# get请求

import urllib.request

response urllib.request.urlopen("http://www.baidu.com")

print(response.read().decode(utf-8))# post请求

import urllib.parse

import urllib.request

data bytes(urllib.parse.urlencode({"word":"hello&quo…

爬虫之BSXpath

BeautifulSoup 一 简介 简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。

它是一个工具箱,通过解析…

python爬虫Urllib实战

Urllib基础 urllib.request.urlretrieve(url,filenname) 直接将网页下载到本地 import urllib.request

>>> urllib.request.urlretrieve("http://www.hellobi.com",filename"D:\/1.html")

(D:\\/1.html, <http.client.HTTPMessage object at 0…

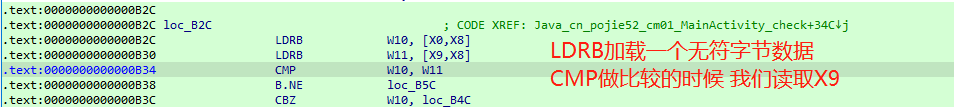

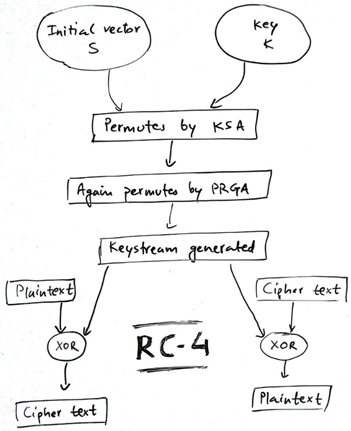

密码学 | RC4算法Native层分析

一、Java层分析 二、Native层分析

1、Java_cn_pojie52_cm01_MainActivity_check

首先分析入参出参和大体流程。

2、sub_B90

接下来看下sub_B90。 其中主要部分进行了两次循环,第一个大循环到256次,第二个里面有异或运算,这两个特征一出…

【K哥爬虫普法】字节前高管,离职后入侵今日头条数据库,是阴谋、还是利诱?

案情介绍 2016年至2017年间,张洪禹、宋某、侯明强作为被告单位上海晟品网络科技有限公司主管人员,在上海市共谋采用技术手段抓取北京字节跳动网络技术有限公司(办公地点位于本市海淀区北三环西路43号中航广场)服务器中存储的视频数…

Python与爬虫有什么关系?

爬虫一般是指网络资源的获取,因为python的脚本特征,Python易于配置,对字符的处理也非常灵活,加上python有丰富的网络抓取模块,所以两者经常联系在一起。

接下来我们可以详情了解python到底有什么作用。 首先Python翻译…

快速傅里叶变换及Python代码实现

一、前言 我想认真写好快速傅里叶变换(Fast Fourier Transform,FFT),所以这篇文章会由浅到细,由窄到宽的讲解,但是傅里叶变换对于寻常人并不是很容易理解的,所以对于基础不牢的人我会通过前言普…

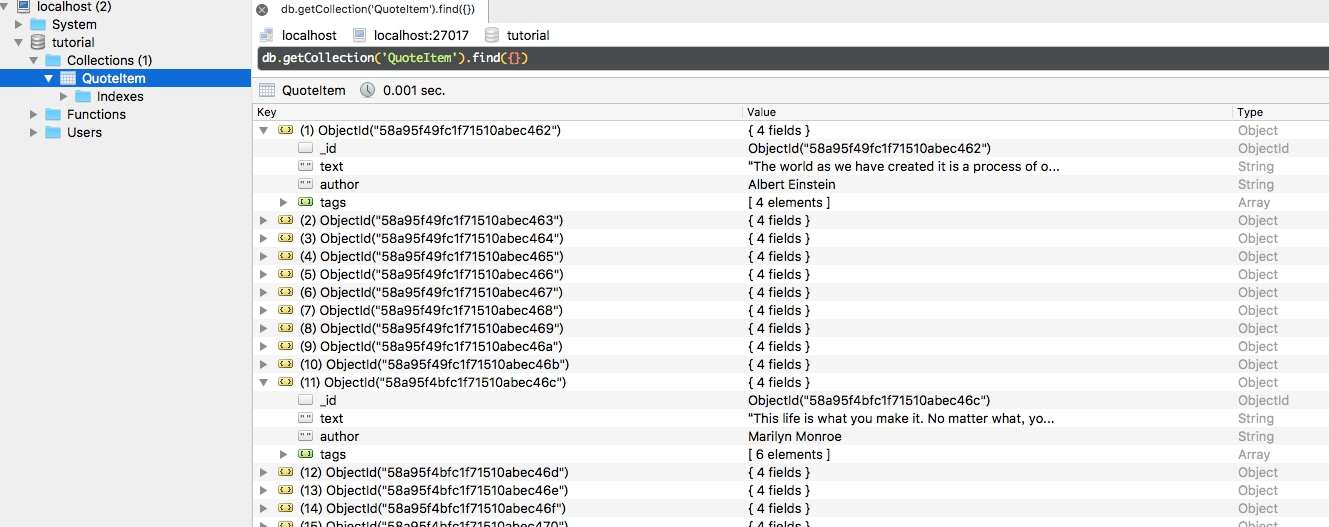

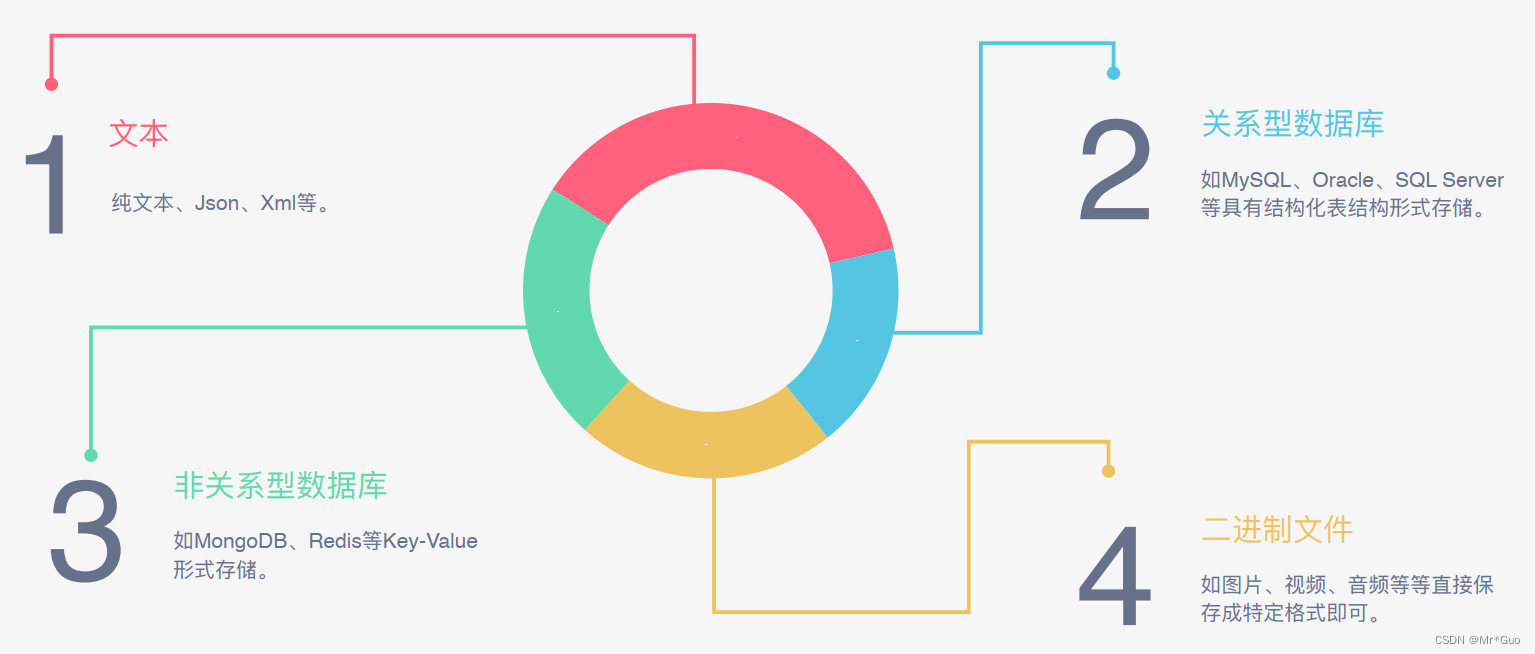

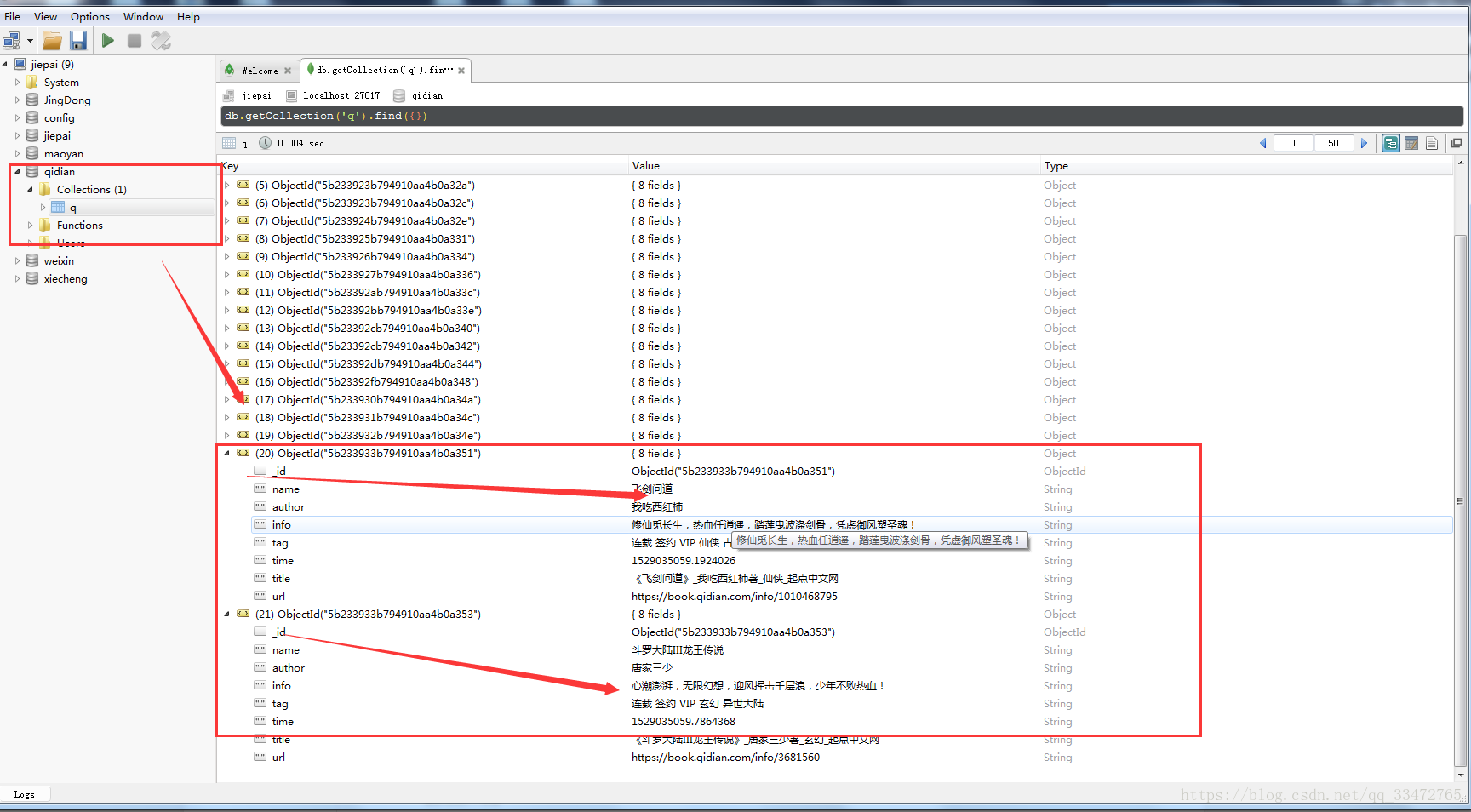

一步一步学爬虫(4)数据存储之MongoDB文档存储

一步一步学爬虫(4)数据存储之MongoDB文档存储4.5.1. 准备工作4.5.2. 连接 MongoDB4.5.3. 指定数据库4.5.4. 指定集合4.5.5. 插入数据4.5.6. 查询4.5.7. 计数4.5.8. 排序4.5.9. 偏移4.5.10. 更新4.5.11. 删除4.5.12. 其他操作4.5.13. 总结NoSQL࿰…

爬虫快速入门教程:利用urllib实现网络请求(上)

urllib库是Python内置的非常基础的HTTP请求库,在它的助力下,我们可以通过短短的几行代码就完成一次从网页请求到处理响应结果的过程。而且urllib库是Python的内置库,也就是说我们无需进行额外的安装。

urllib中包含四个基础模块: request:它是urllib中最核心的模块,可以…

python列表相关

Python 集合(数组) Python 编程语言中有四种集合数据类型:

列表(List)是一种有序和可更改的集合。允许重复的成员。 元组(Tuple)是一种有序且不可更改的集合。允许重复的成员。 集合࿰…

Python多进程详解

文章目录1. 多进程2. 创建进程2.1 直接创建2.2 继承创建3. 守护进程和join()方法4. 进程锁5. 进程通信5.1 Queue5.2 Pipe6. 进程数据共享6.1 Value6.2 Array7. 进程池参考文章前面的多线程文章已经讲过了,Python中的多线程实际上是一种虚假的多线程,在大…

小白必看、手把手教你利用爬虫爬网页

接下来从网络爬虫的概念、用处与价值和结构等三个方面,让大家对网络爬虫有一个基本的了解。

网络爬虫及其应用

随着网络的迅速发展,万维网成为大量信息的载体,如何有效地提取并利用这些信息成为一个巨大的挑战,网络爬虫应运而生…

2. 中间件 随机请求头

第一步:在settings中添加UA的列表

USER_AGENTS_LIST [ "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Win64; x64; Trident/5.0; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 2.0.50727; Media Center PC 6.0)", "Mozilla/…

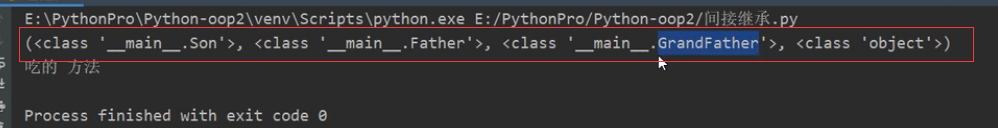

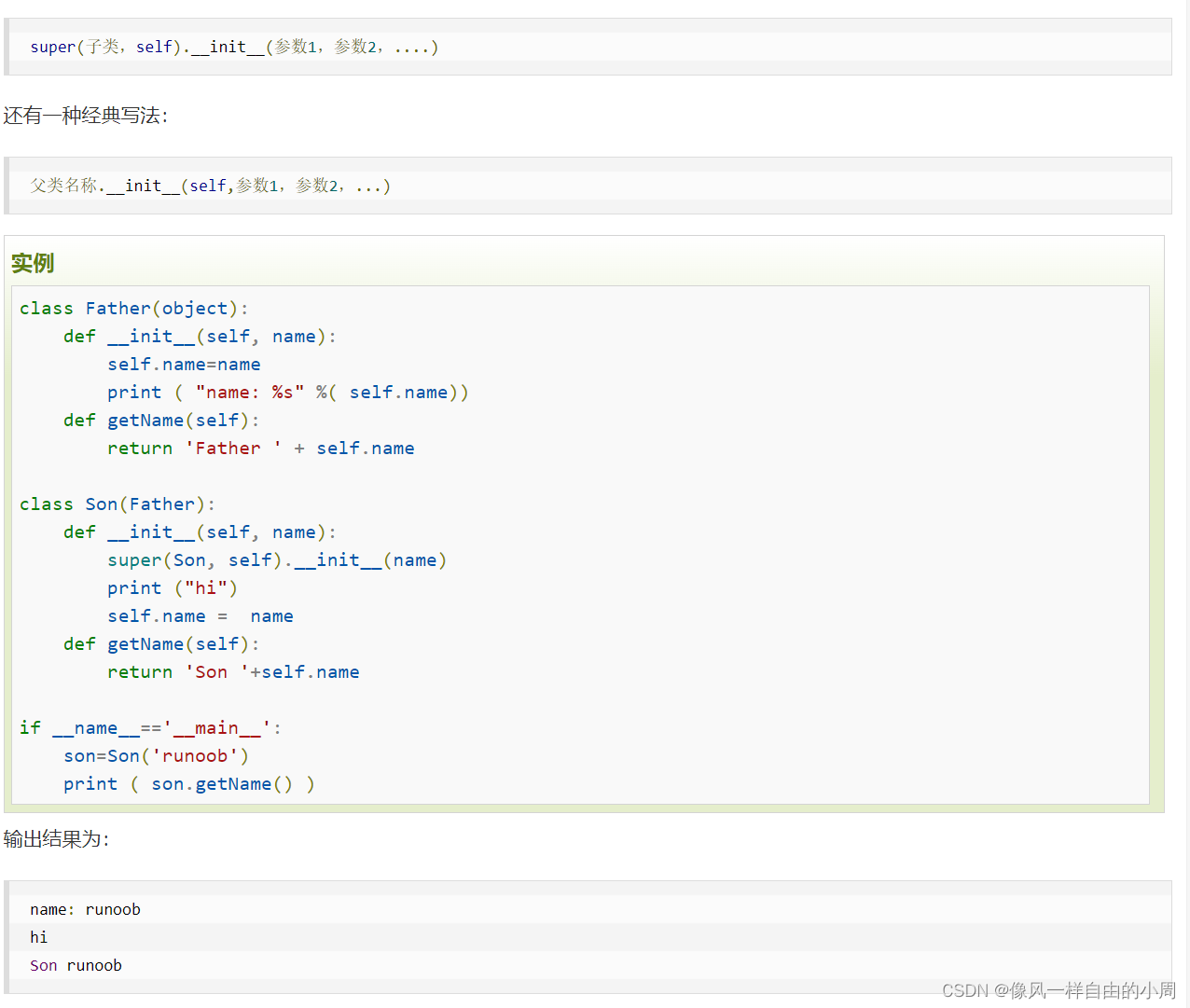

Python类的继承

一、类的继承

众所周知,Python是面向对象编程。而面向对象编程主要好处之一便是代码的重用。Python实现代码重用的方法之一是通过继承。

继承是类和类之间的一种关系,是一种子类和父类的关系。如子类继承父类,而Python类中重要的两个东西便…

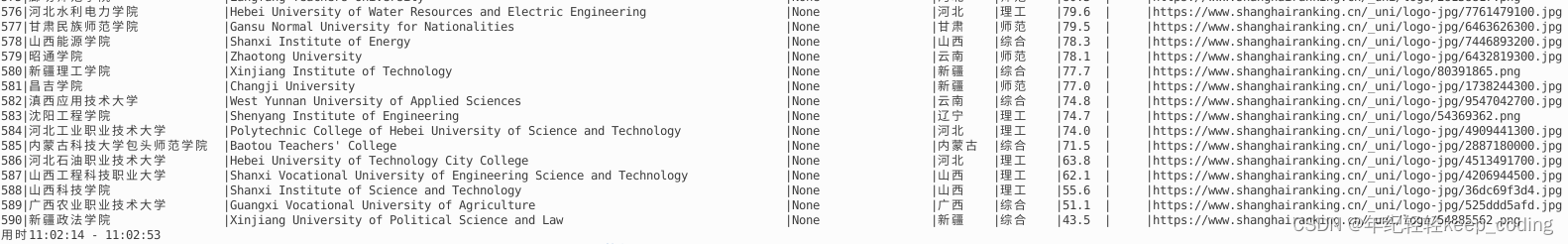

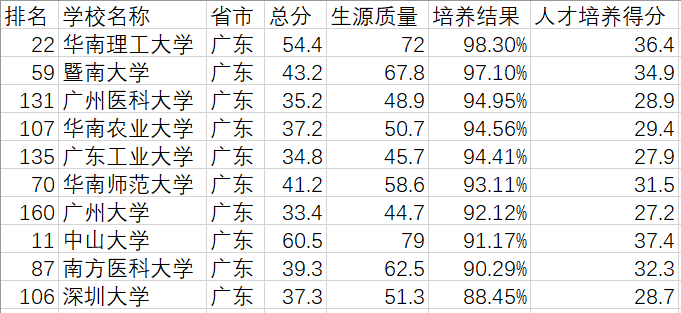

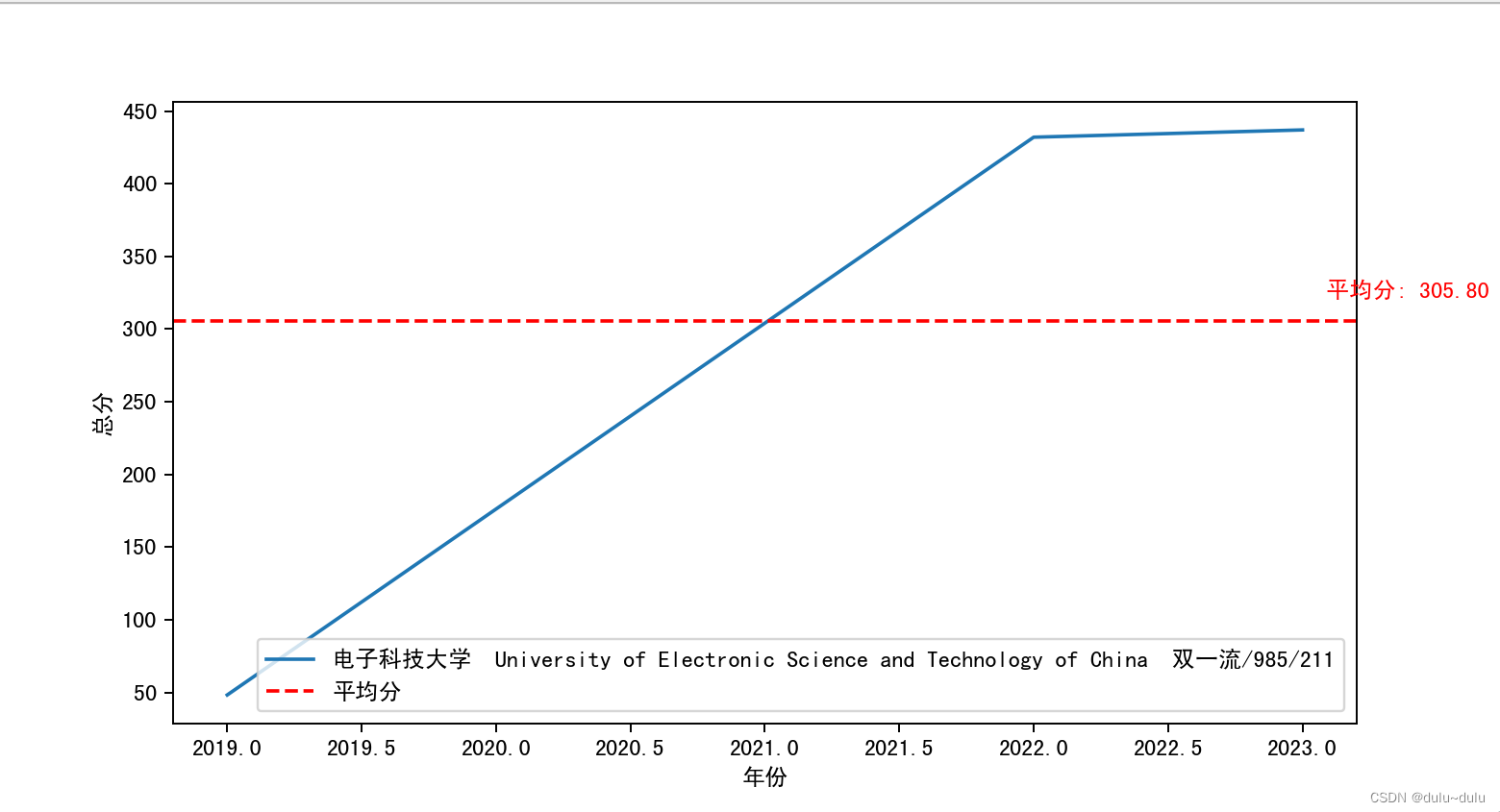

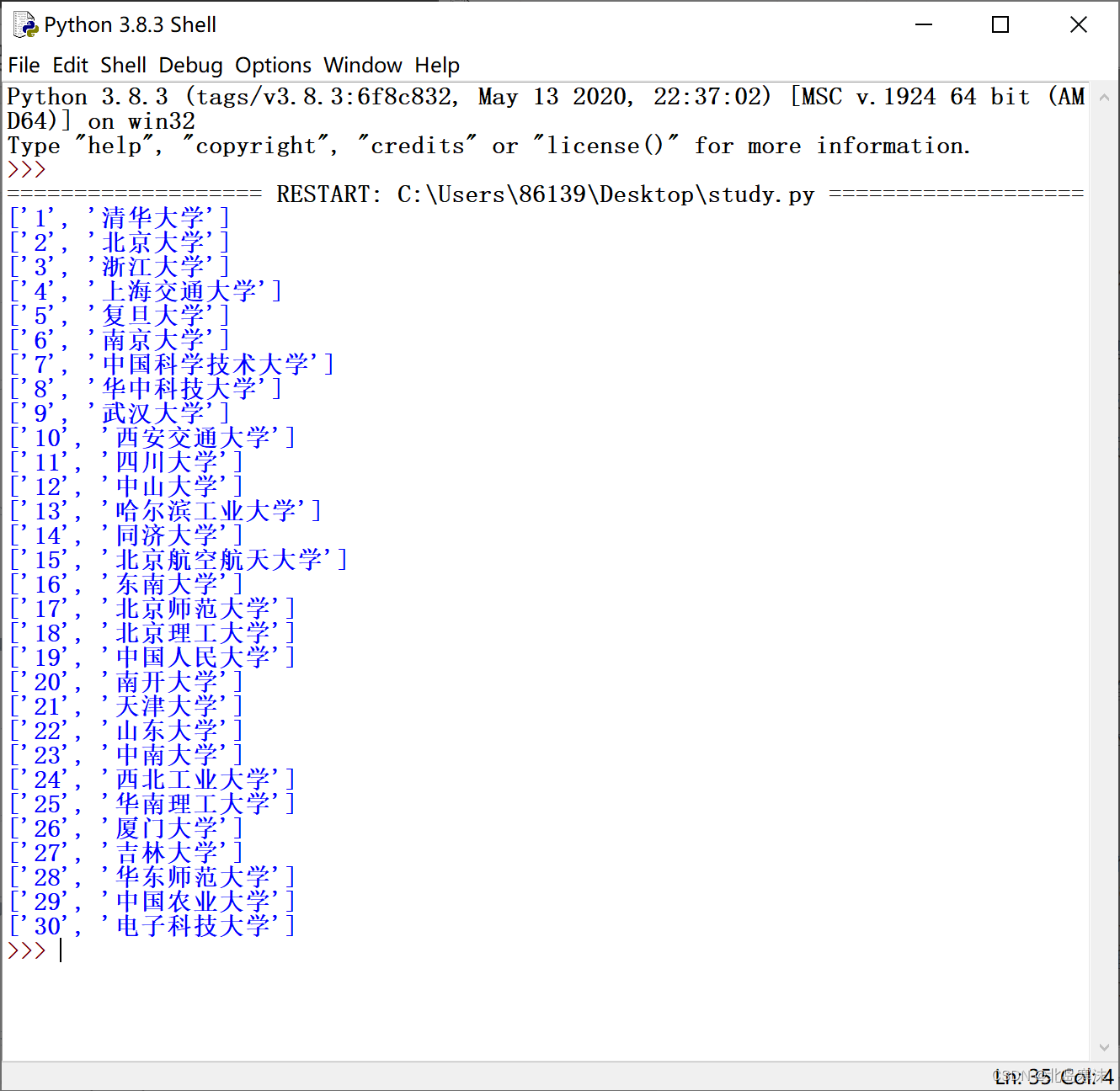

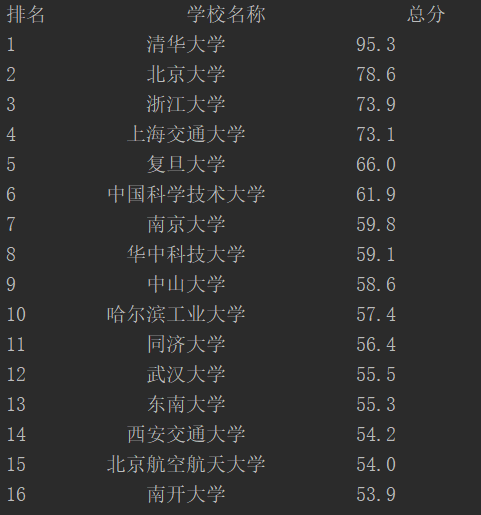

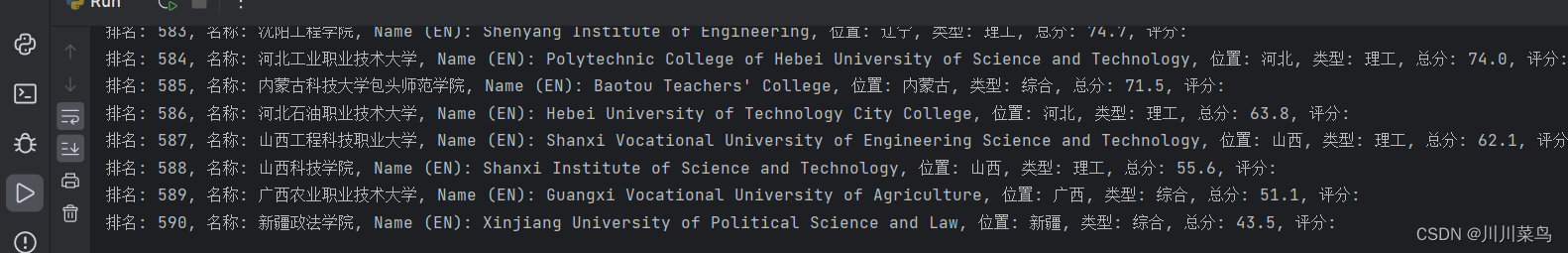

中国大学哪家强?Python爬取排名榜,太棒啦(31)

小朋友们好,大朋友们好!

我是猫妹,一名爱上Python编程的小学生。

欢迎和猫妹一起,趣味学Python。

今日主题

如何用Python,抓取并分析2023中国大学排名数据。

用到的Python库有requests、bs4。

requests库

reque…

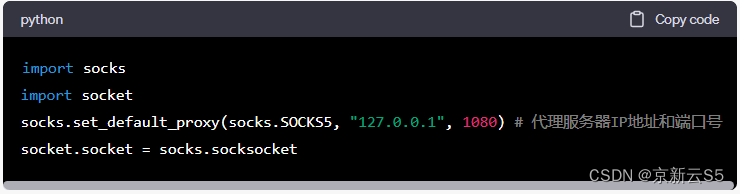

Socks5代理与HTTP代理:基本概念、工作原理和在网络应用中的应用

在互联网上,代理服务器是一种非常重要的技术手段,可以实现许多网络应用的高效和安全运行。Socks5代理和HTTP代理是两种常见的代理服务器类型,它们在网络应用中都有着重要的作用。本文将介绍Socks5代理和HTTP代理的基本概念、工作原理以及在网…

说PHP不适合做爬虫的人,看这里

文章目录 一、关于PHP爬虫框架—Goutte1.1 什么是Goutte1.2 Goutte的优点1.3 Goutte的安装 二、Goutte的使用2.1 基本用法2.2 获取页面内容2.3 表单提交2.4 AJAX请求2.5 登录并抓取数据 三、15个Goutte爬虫示例3.1 简单示例3.2 获取表格内容3.3 登录并获取数据3.4 处理JavaScri…

【RPA开发】Beautiful Soup 使用详解

爬虫时通过 requests.get 方法获得 html 源代码后,通常需要从源代码中提取关键信息,这有多种方式,比如使用正则表达式匹配,也可通过 python 的第三方库 Beautiful Soup 实现定位提取关键信息,类似的库还有 lxml 第三方…

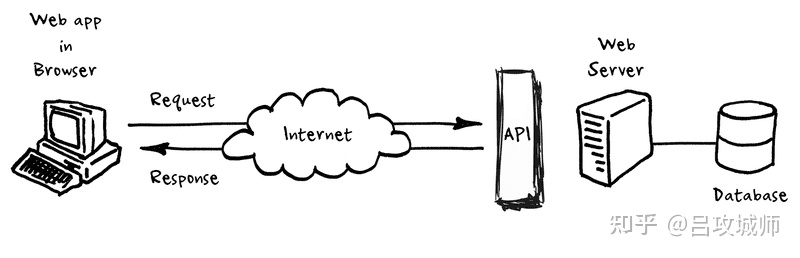

【河南省第二届技能大赛-物联网技术】C模块Python开发讲解

文章目录 前言题目如下什么是云平台APIAPI调用的基本流程Python实例介绍依赖库介绍API调用的基本参数请求返回值requests库PyQt5库总结源码链接 前言

这是基于样题进行讲解的文章,因为正式赛题尚未公布和样题类型相似。文章结尾提供了源码和环境链接,读…

如何通过筛选高质量爬虫IP提升爬虫效率?

前言

对于做数据抓取的技术员来说,如何稳定高效的爬取数据ip库池起到决定性作用,对于爬虫ip池的维护,可以从以下几个方面入手: 目录 一、验证爬虫ip的可用性二、更新爬虫ip池三、维护爬虫ip的质量四、监控爬虫ip的使用情况 一、验…

零基础应该选择学习爬虫

1、数据分析 可能几年之前,说到数据分析,你并不会想到Python,但不知从什么时候开始,数据分析师的简历上,Python已经成了最亮眼的加分项。各种数据分析框架的出现,让Python这种本就极其简单的语言更加方便易…

深入理解 python 虚拟机:魔术方法之数学计算

深入理解 python 虚拟机:魔术方法之数学计算

在本篇文章当中主要给大家介绍在 python 当中一些常见的魔术方法,本篇文章主要是关于与数学计算相关的一些魔术方法,在很多科学计算的包当中都使用到了这些魔术方法。

大小比较

当我们在Python…

毕设源码分享 计算机毕业设计之Python+Spark疫情大屏可视化 疫情爬虫可视化 疫情数据分析 大数据毕业设计

开发技术

前端:vue.js echarts websocket

后端API:springbootsparkmybatis

数据库:mysql

爬虫:python chrome_driver

创新点

Spark大屏 Python爬虫 websocket

运行截图

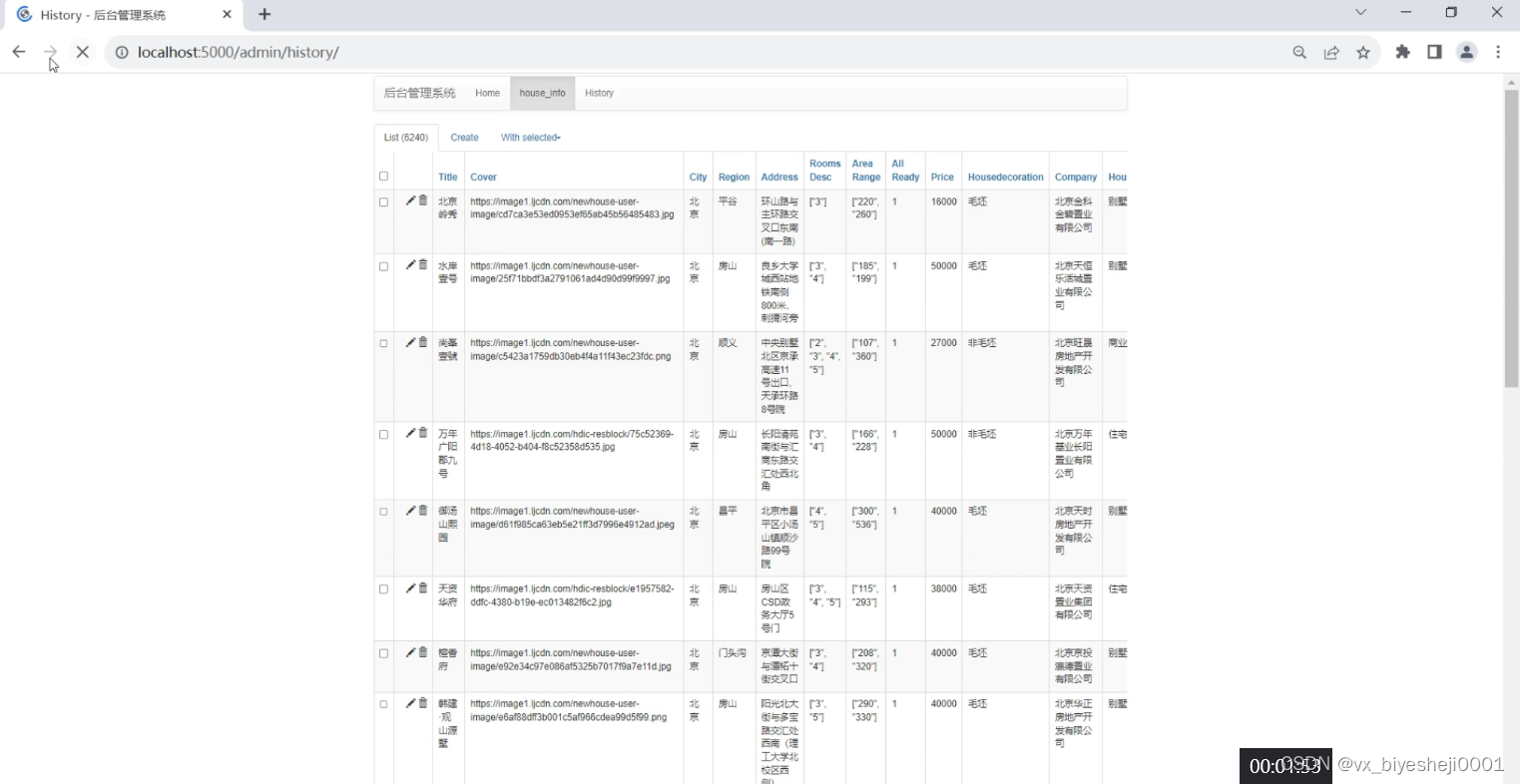

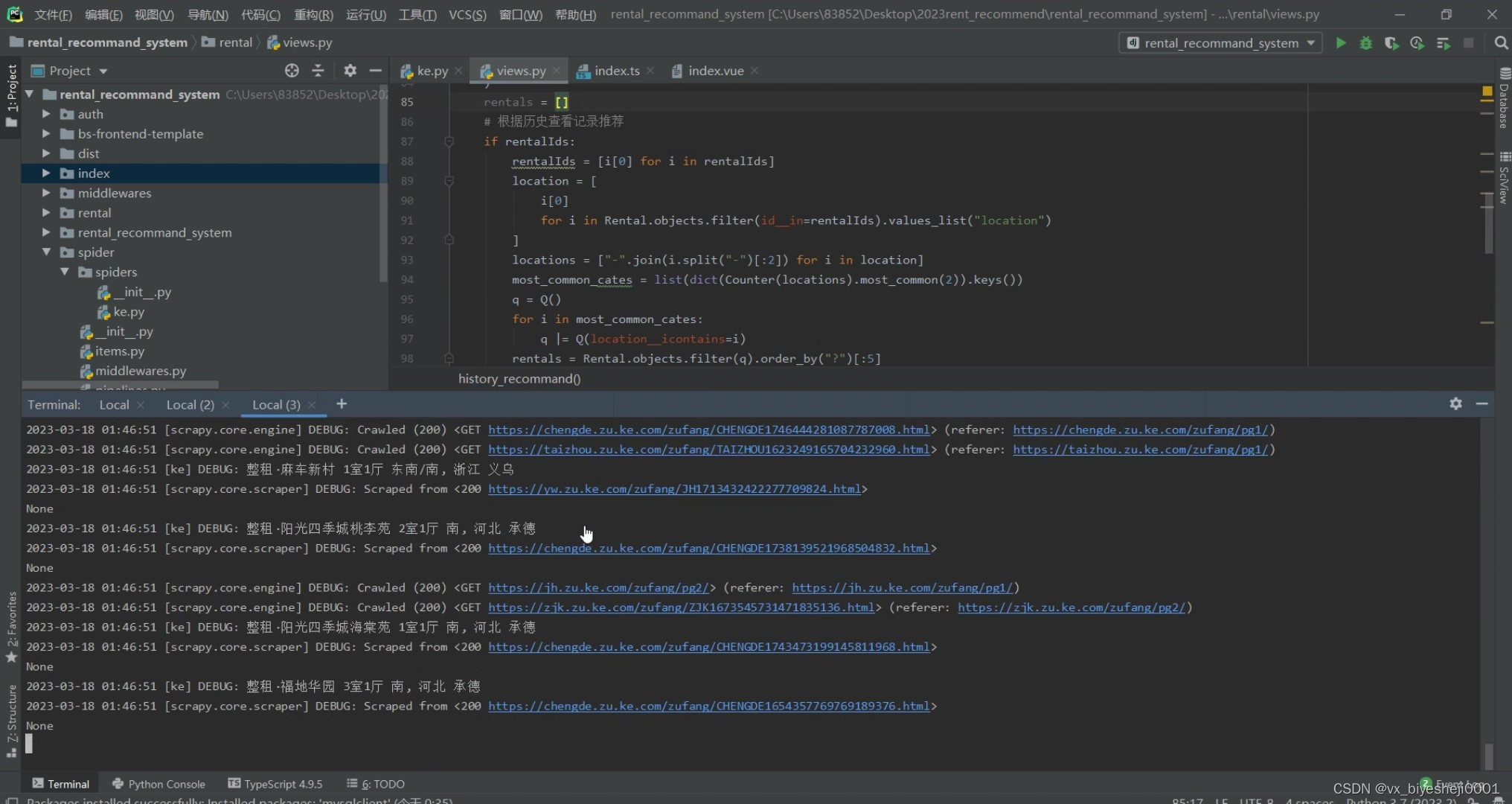

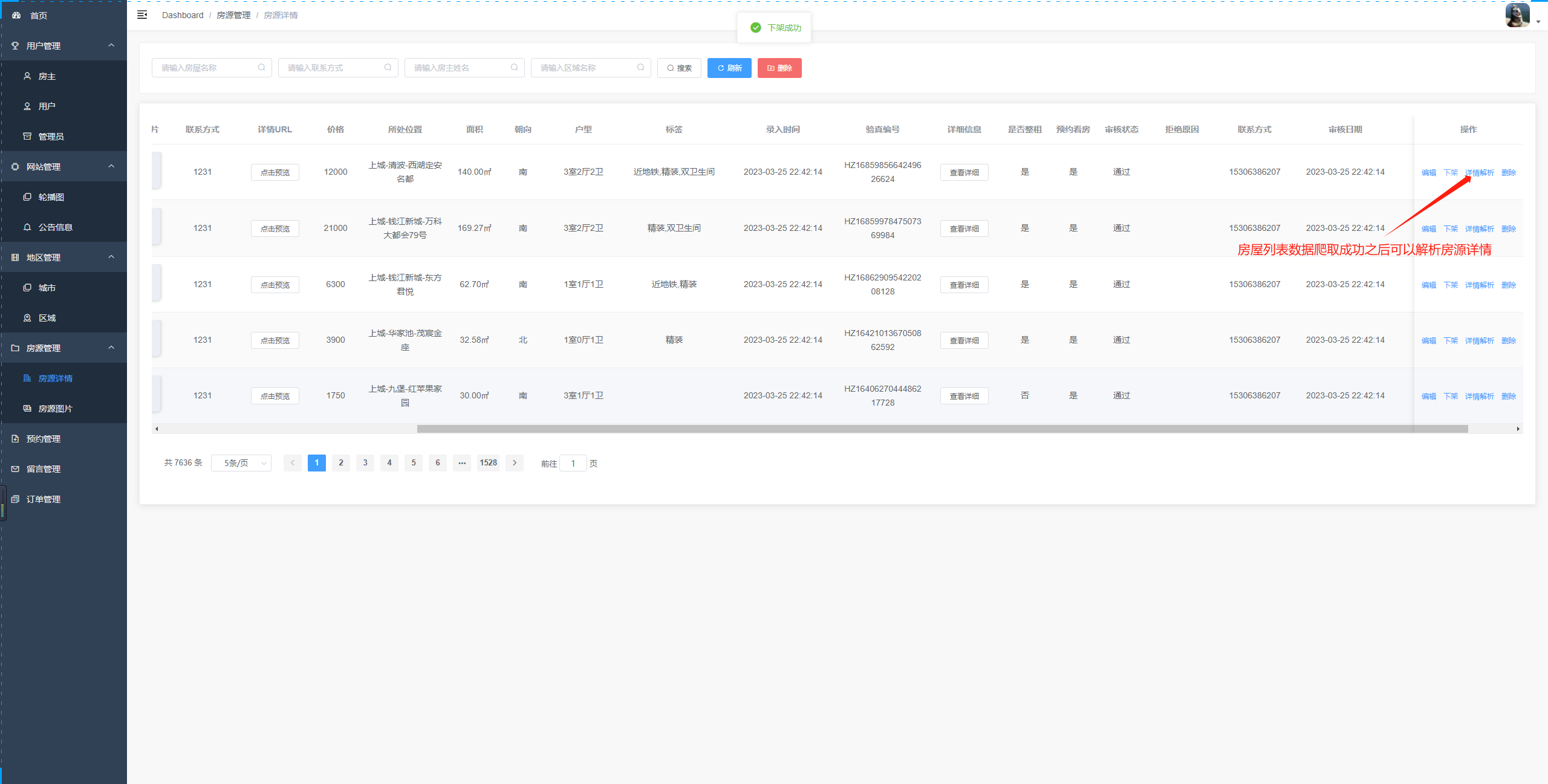

计算机毕业设计之全网独家Spark租房爬虫数据分析与推荐系统 租房大数据 租房app 租房数据分析 租房爬虫 房源推荐系统 房源数据分析 房源可视化

一、网站

登录与注册、注销

短信验证码修改密码

我的信息:身份证实名认证

租房业务流程 (预约看房支付完成评价)、进度步骤条展示

支付宝沙箱支付

房屋浏览、中介信息查看

房屋推荐(基于mahout协同过滤算法…

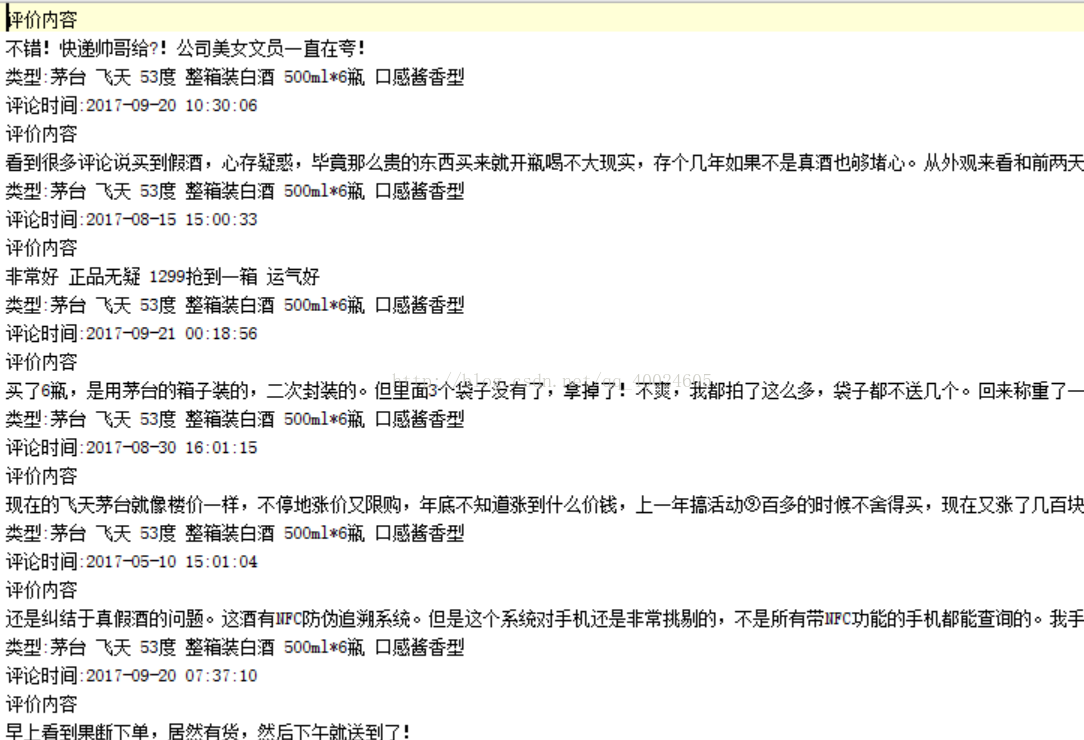

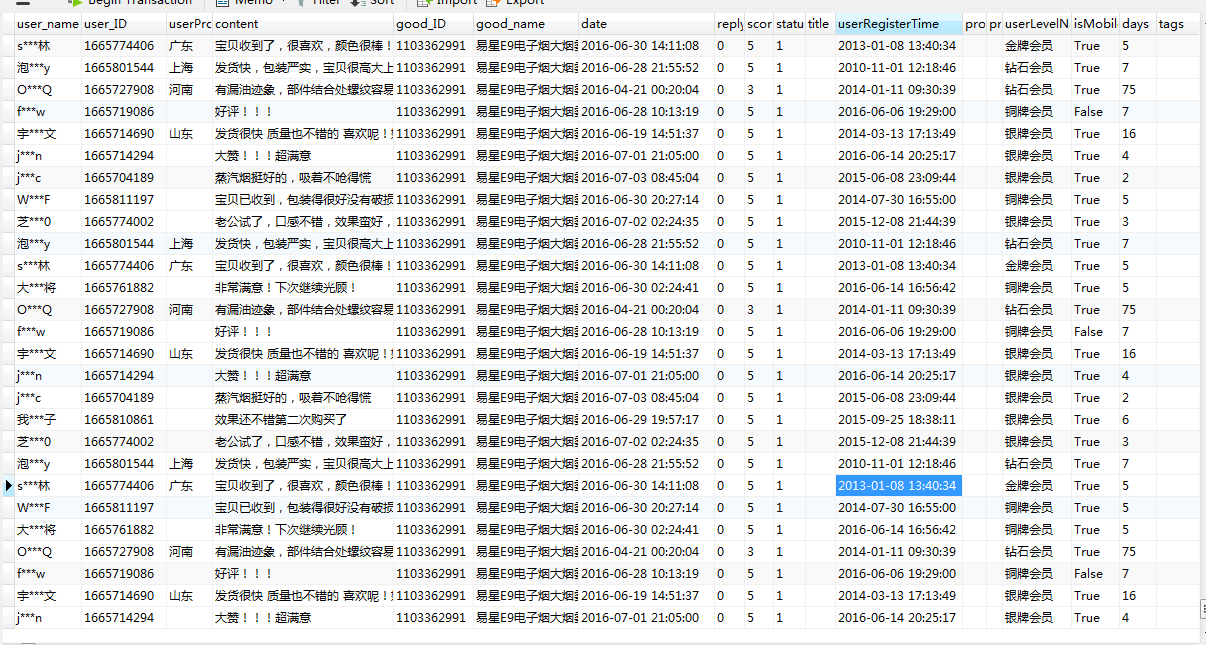

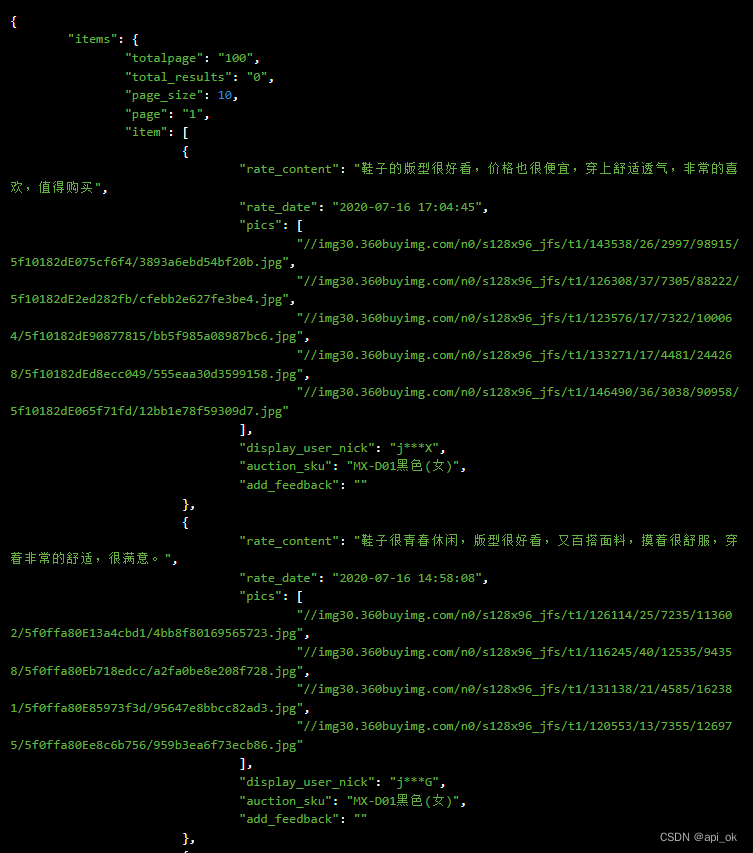

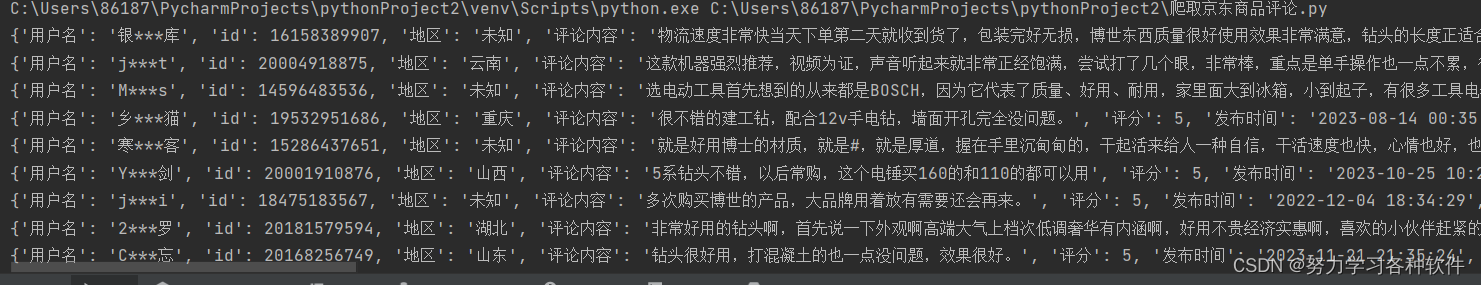

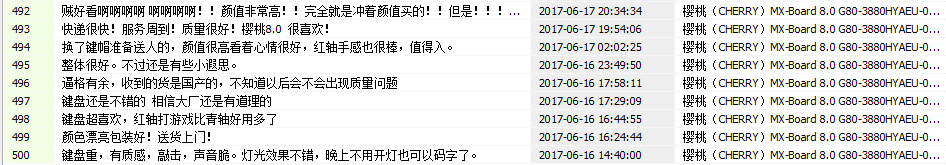

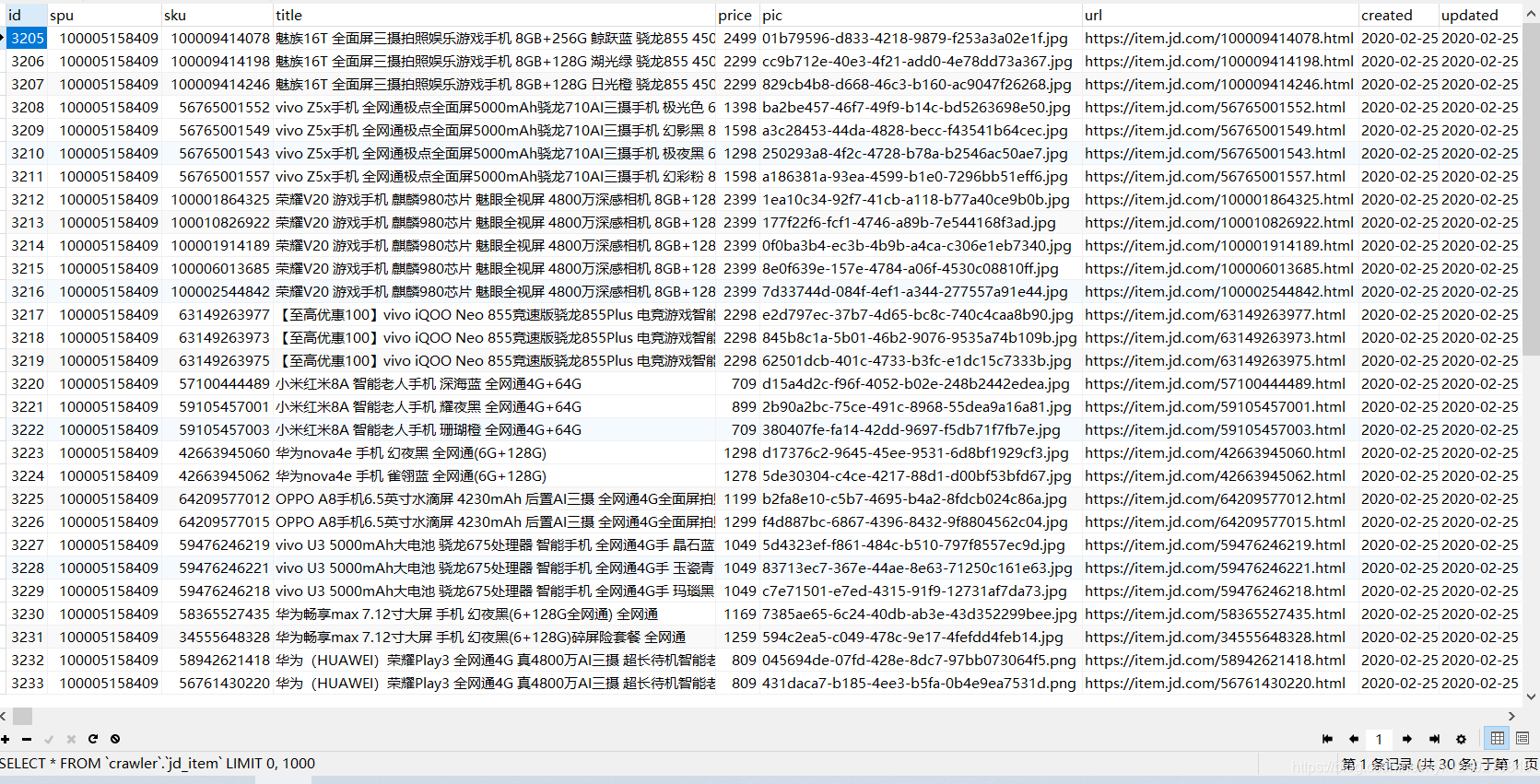

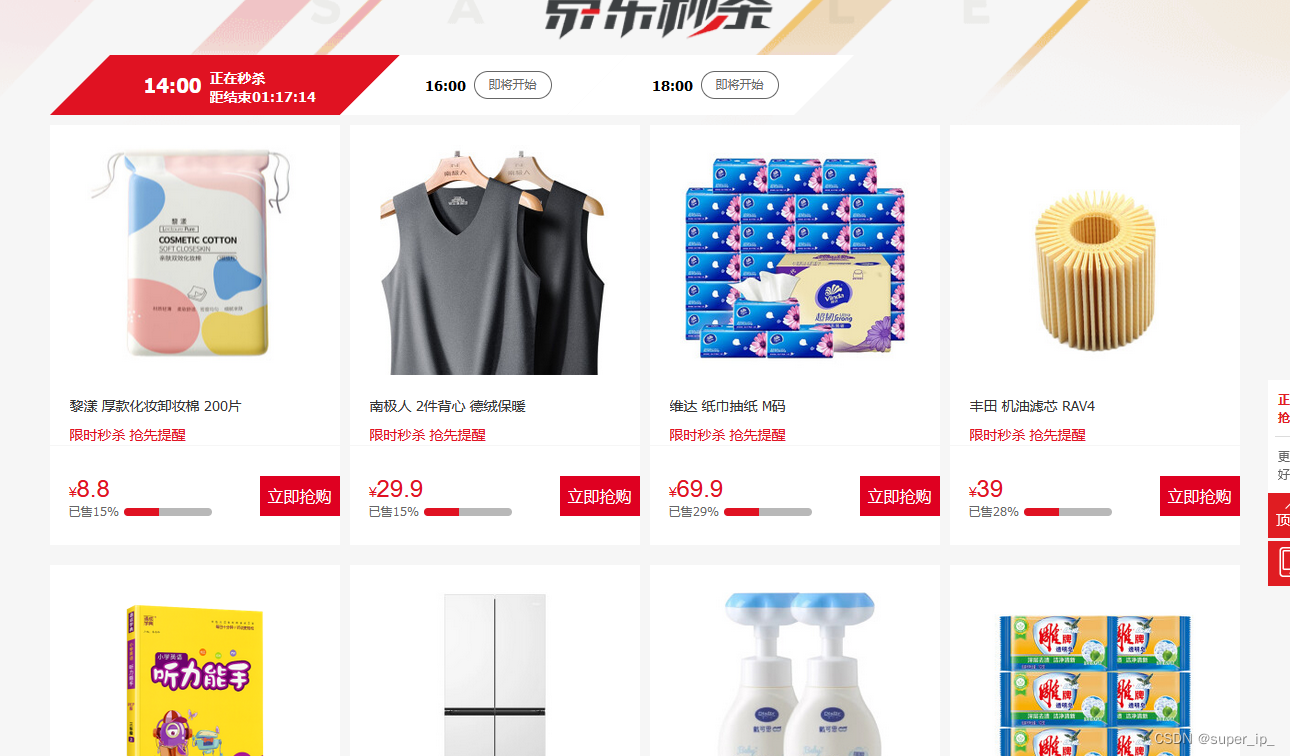

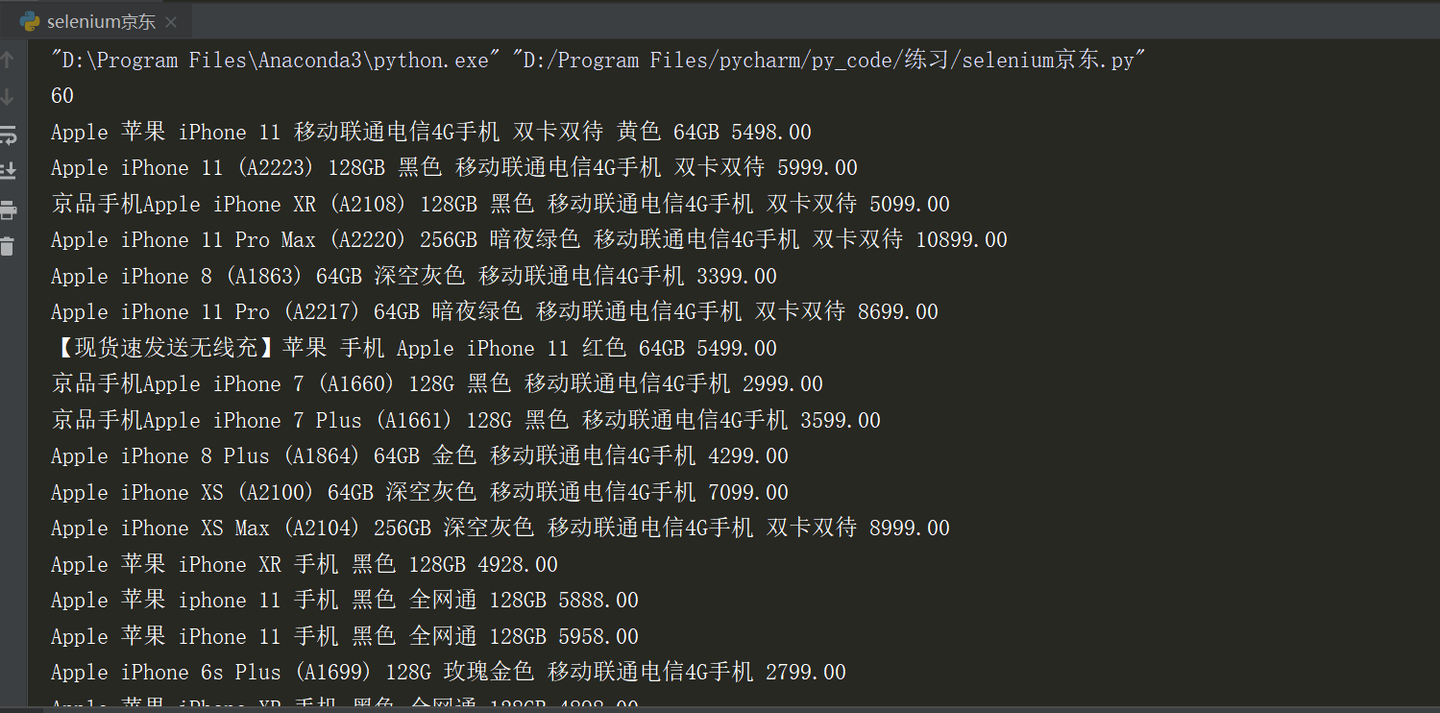

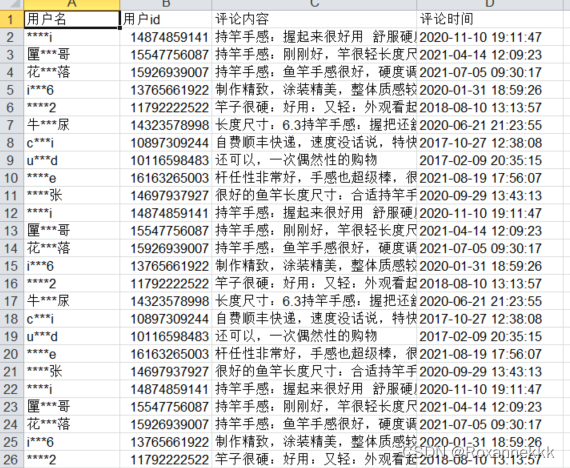

爬虫项目(四)之京东评论

爬虫项目(四)之京东评论 最近,出了小米9,听说可以拍月亮,好像挺酷的。就来JD看看网友们是怎么评论的。

经过爬取信息总结得到,小米还是挺不错的。

方法就是通过一个url链接获取评论信息字符串,…

爬虫项目(三)之java文章

爬虫项目(三)之java文章

private void setList(ModelAndView mav, String mavObject, String filePath) {List<String> list _fileUtils.getFiles2(filePath);Collections.sort(list);List<LoveqVO> loveqVOList new ArrayList<>()…

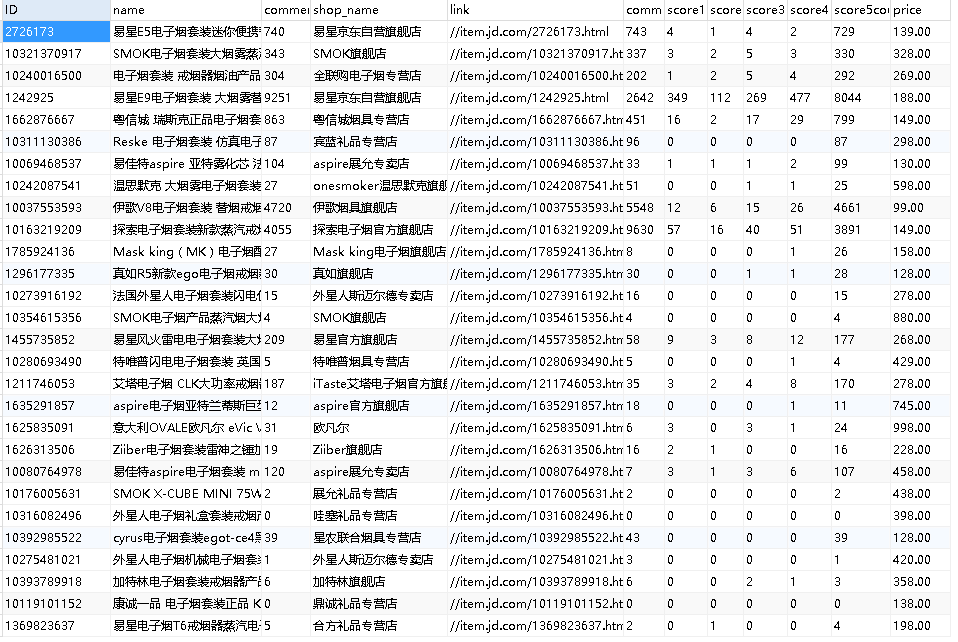

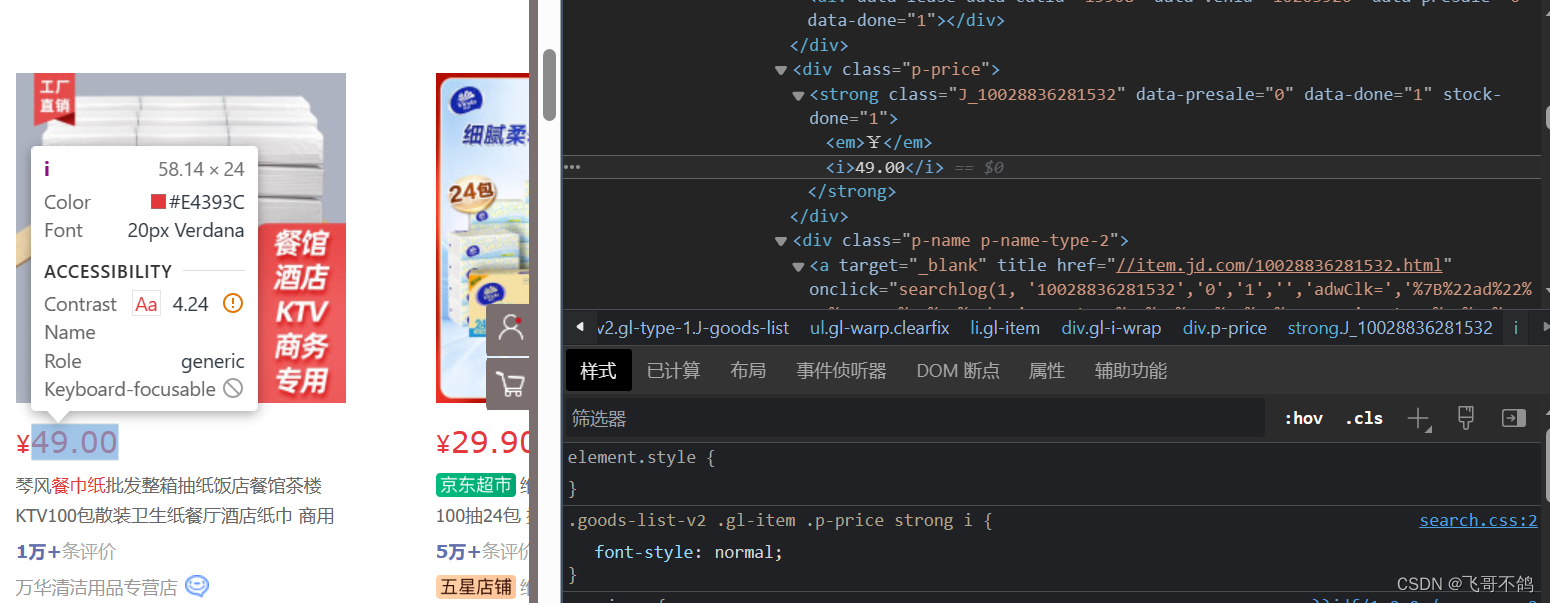

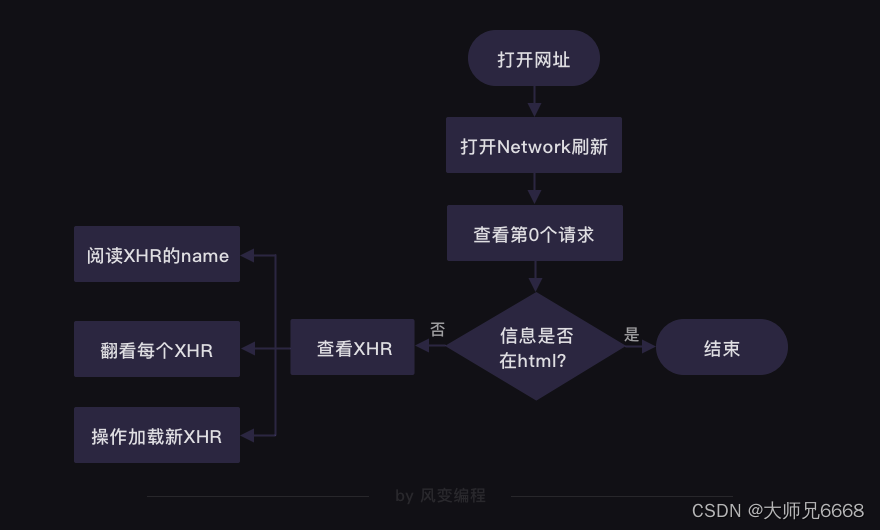

八个commit让你学会爬取京东商品信息

我发现现在不用标题党的套路还真不好吸引人,最近在做相关的事情,从而稍微总结出了一些文字。我一贯的想法吧,虽然才疏学浅,但是还是希望能帮助需要的人。博客园实在不适合这种章回体的文章。这里,我贴出正文的前两个部…

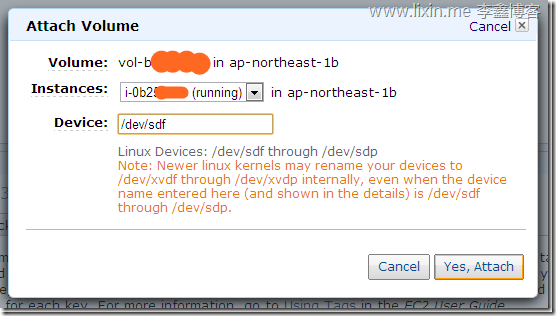

给Amazon ec2 增加卷(Volume)并挂载到系统

前言 导师让师弟把实验的网站挂到亚马逊的EC2云服务器上。师弟对linux不太熟悉。就跑过来问我。于是花了一个小时搞定。问题主要是将EC2的另外一个volumn挂到实例当中。 EC2的一个实例至少存在一个volumn。因为免费的是8G,显然不够空间。现在网站包括爬虫ÿ…

CentOS 7 安装python3.7.1的方法及注意事项

安装wget yum -y install wget 创建一个download目录用于下载各种安装包 mkdir download 切换到刚创建的download目录中 cd download 下载python3.7.1 wget https://www.python.org/ftp/python/3.7.1/Python-3.7.1.tgz 解压 tar -zxvf Python-3.7.1.tgz 切换到刚刚解压得到得文…

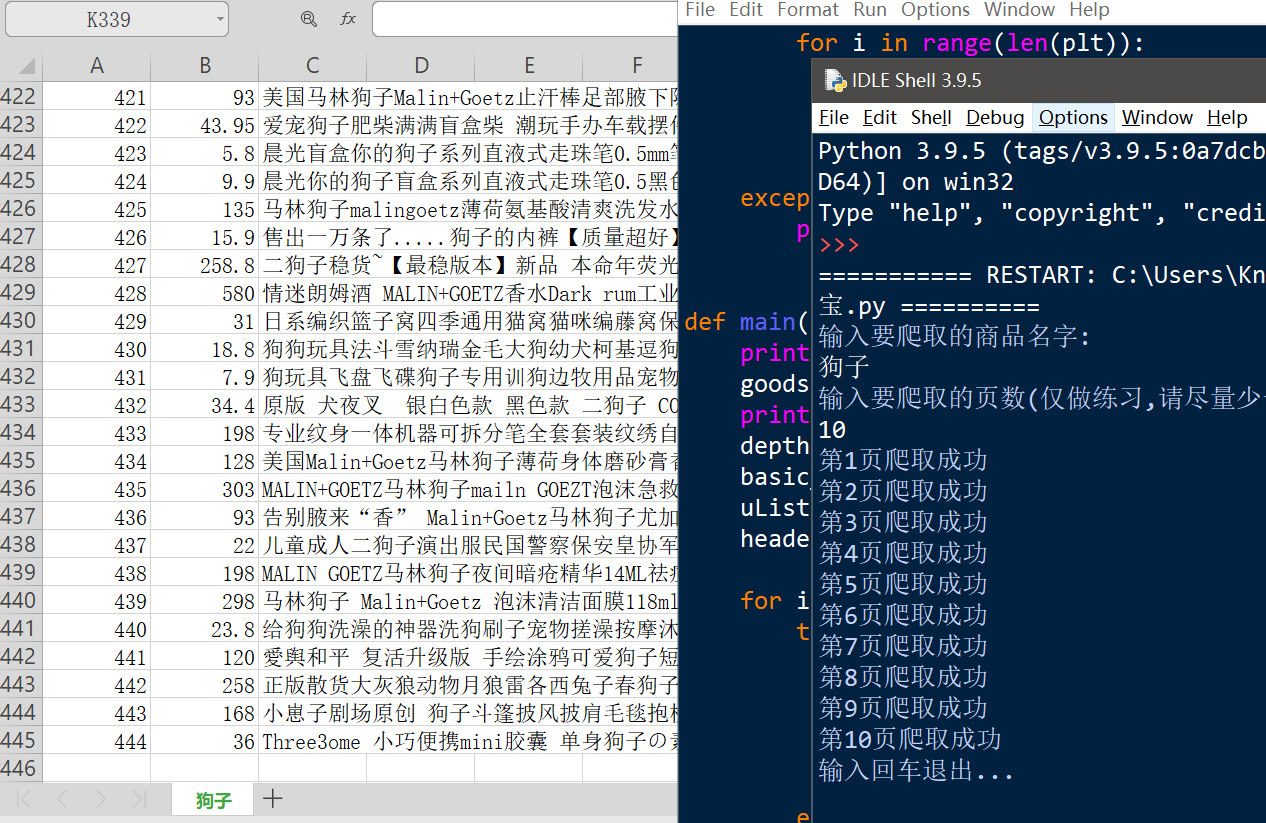

爬取指定页数淘宝商品的价格名称等并存入csv文件

......纪第一个Python爬虫,

首发于本人同名博客园...... """

Created on Thu Jun 10 21:42:17 2021author: 泥烟本爬虫可实现指定商品,指定页数的信息爬取,仅用来学习

具有时效性(cookie会过期,用的时候手动改一下即可)

"""import requests

imp…

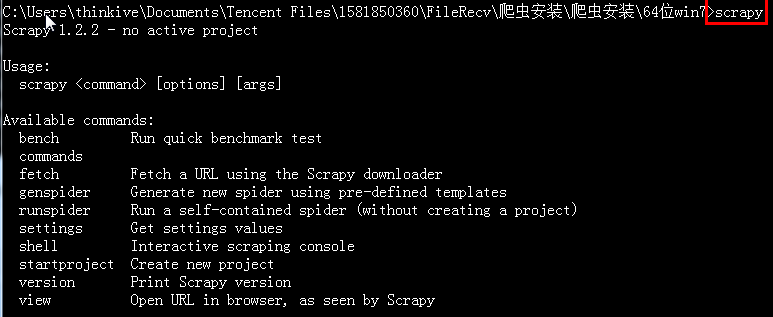

Scrapy框架——安装以及新建scrapy文件

一.安装 conda install Scrapy :之后在按y 表示允许安装相关的依赖库(下载速度慢的话也可以借助镜像源),安装的前提是安装了anaconda作为python , 测试scrapy是否安装成功,在窗口输入scrapy回车 注意:我…

Python爬虫1-----urllib模块

1、加载urllib模块的request from urllib import request 2、相关函数: (1)urlopen函数:读取网页 webpagerequest.urlopen(url,timeout1) 【读取网页,参数timeout表示1秒之后为超时,遇到无效网页时可以跳…

Python爬虫之BeautifulSoup详解

Beautiful Soup(以下简称BS)是Python中最为流行的HTML和XML解析库之一。它的主要目的是从HTML或XML中提取数据。相比于Python内置的HTML解析库,BS提供了更加简单易用的API,使得编写爬虫或者数据清洗的工作更加高效、简单。

1.安装…

【Python爬虫】urllib模块:强大的网络爬虫利器,让你轻松获取万千信息!

前言: Python爬虫是一种获取互联网信息的技术,它可以自动化地从网站上抓取数据并进行处理。Python爬虫的优点在于它可以快速地获取大量数据,并且可以自动化地进行数据处理和分析。在Python爬虫中,urllib模块是一个非常重要的模块&…

于Python的分布式多主题网络爬虫的研究与设计

本文旨在研究和设计一种基于Python的分布式多主题网络爬虫,以实现高效、快速、准确地获取互联网上的信息资源。

一、研究背景

随着互联网的快速发展,信息资源的数量和种类不断增加,如何高效地获取和利用这些信息资源成为了一个重要的问题。…

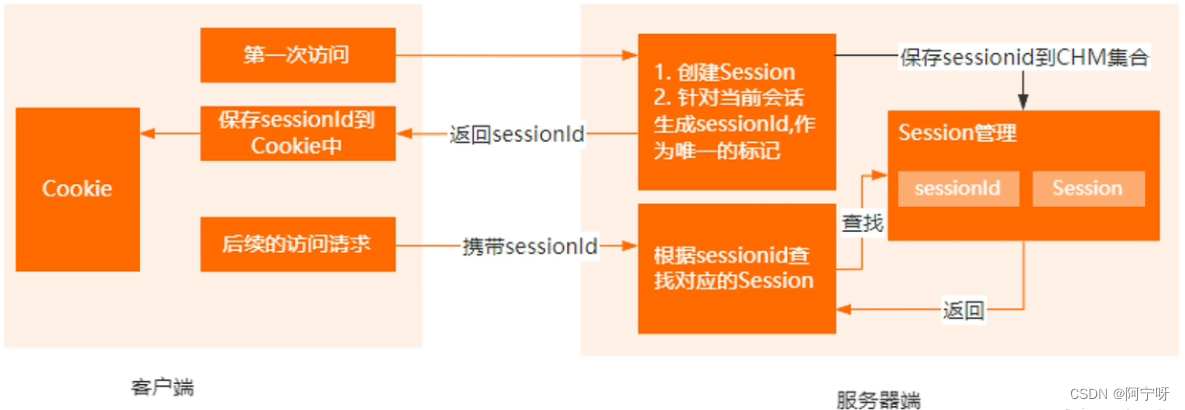

HTTP请求常见字段cookie、session、token鉴权

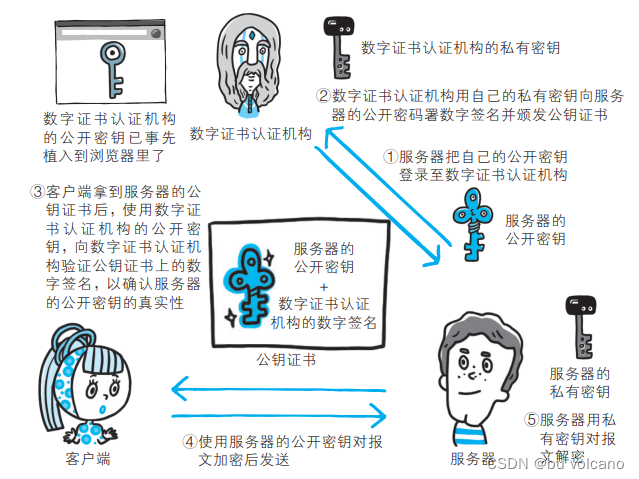

上次介绍了HTTP的原理以及HTTPS的加密过程,本章将围绕HTTP请求常见的字段cookie、session、token进行详解!

HTTP引入cookie和session的原因

我们知道,HTTP是一种无状态协议,一旦数据进行交易后,连接就会断开…

python from entry to abandon3

第十章的内容是解决问题————编写一个Python脚本。在我的电脑上因为Zip命令不能正常工作所以无法给出演示。该章给出了很有意义的编程思路,对以后学习和工作都有不错的参考意义,这部分有兴趣的同学还是自己去看原版教程吧。 这篇博客是来个给薄薄的…

爬虫入门指南:如何使用正则表达式进行数据提取和处理

文章目录 正则表达式正则表达式中常用的元字符和特殊序列案例 使用正则表达式提取数据案例存储数据到文件或数据库使用SQLite数据库存储数据的示例代码SQLite基本语法创建表格:插入数据:查询数据:更新数据:删除数据:条…

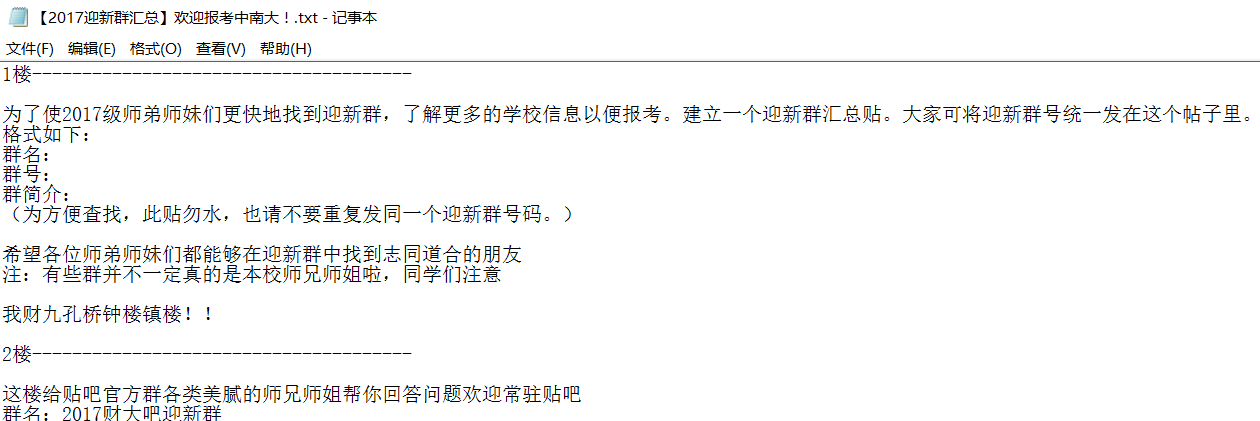

Python爬虫爬取贴吧的帖子内容

最近在看一个大神的博客,从他那里学会了很多关于python爬虫的知识,其实python如果想用在实际应用中,你需要了解许多,比如正则表达式、引入库、过滤字段等等,下面不多说,我下面的程序是爬取Ubuntu吧的一个帖…

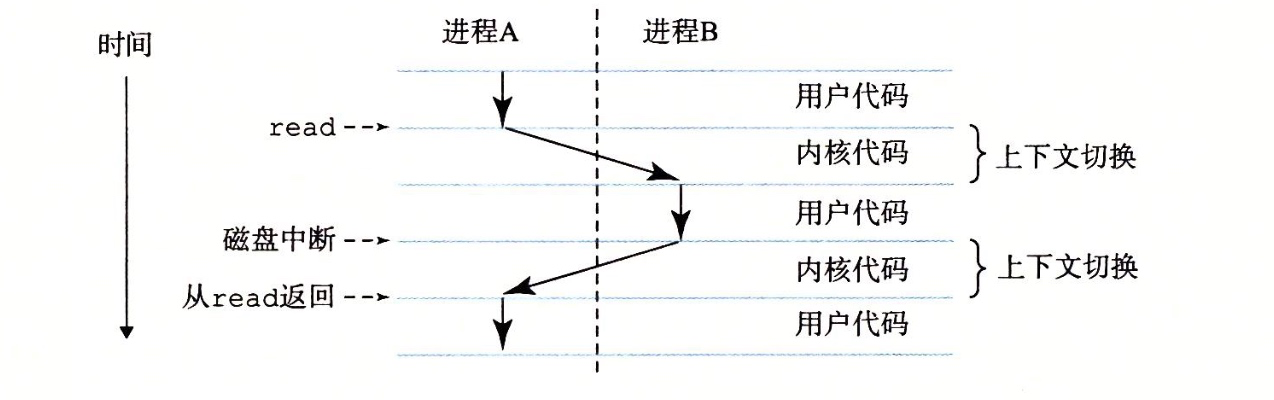

异步爬虫:协程的基本原理

基础概念

阻塞:(阻塞状态指程序未得到所需计算资源时被挂起的状态)程序在等待某个操作完成期间,自身无法继续干别的事情非阻塞:程序在等待某个操作的过程中,自身不被阻塞,可以继续干别的事情&a…

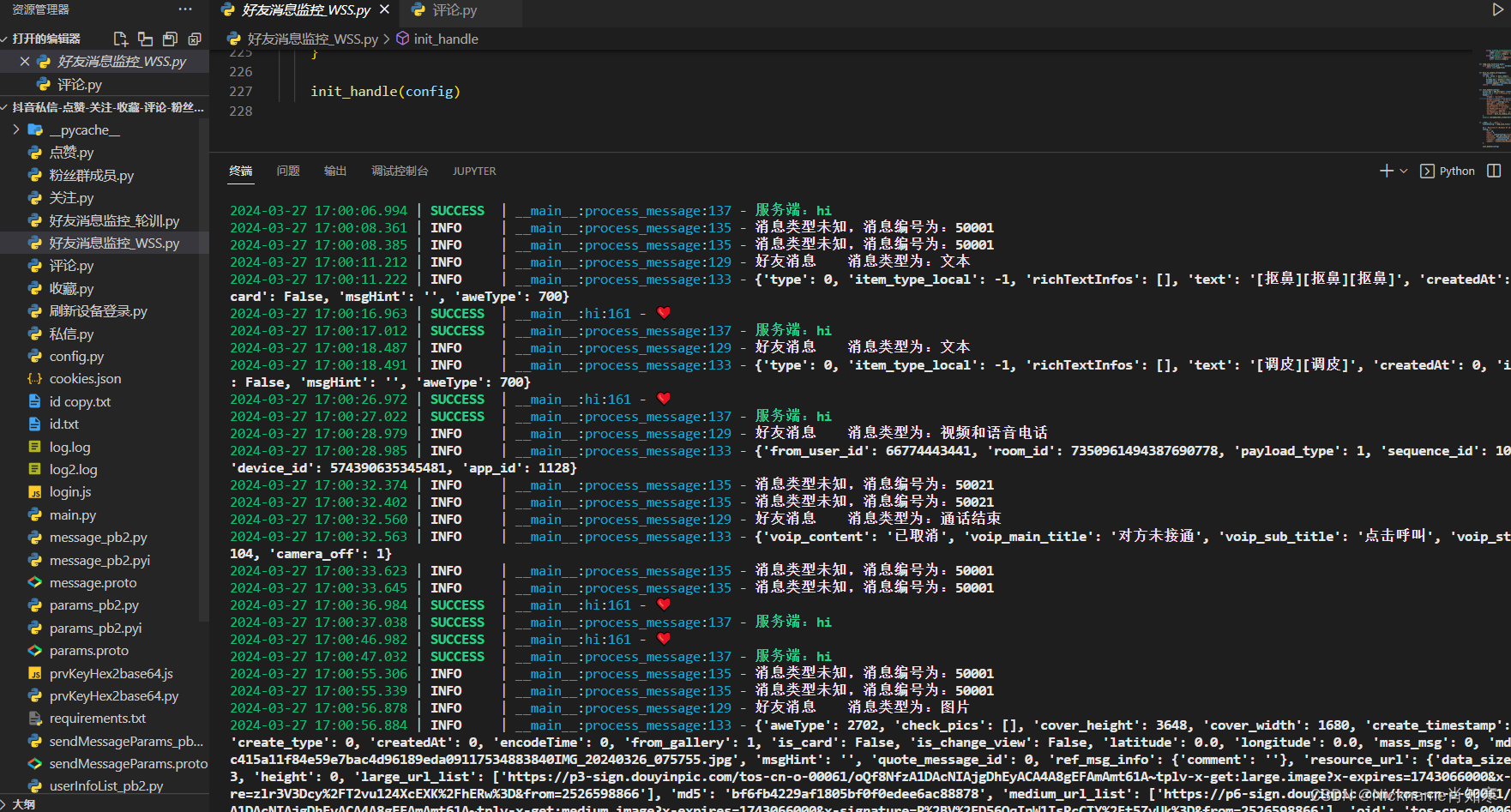

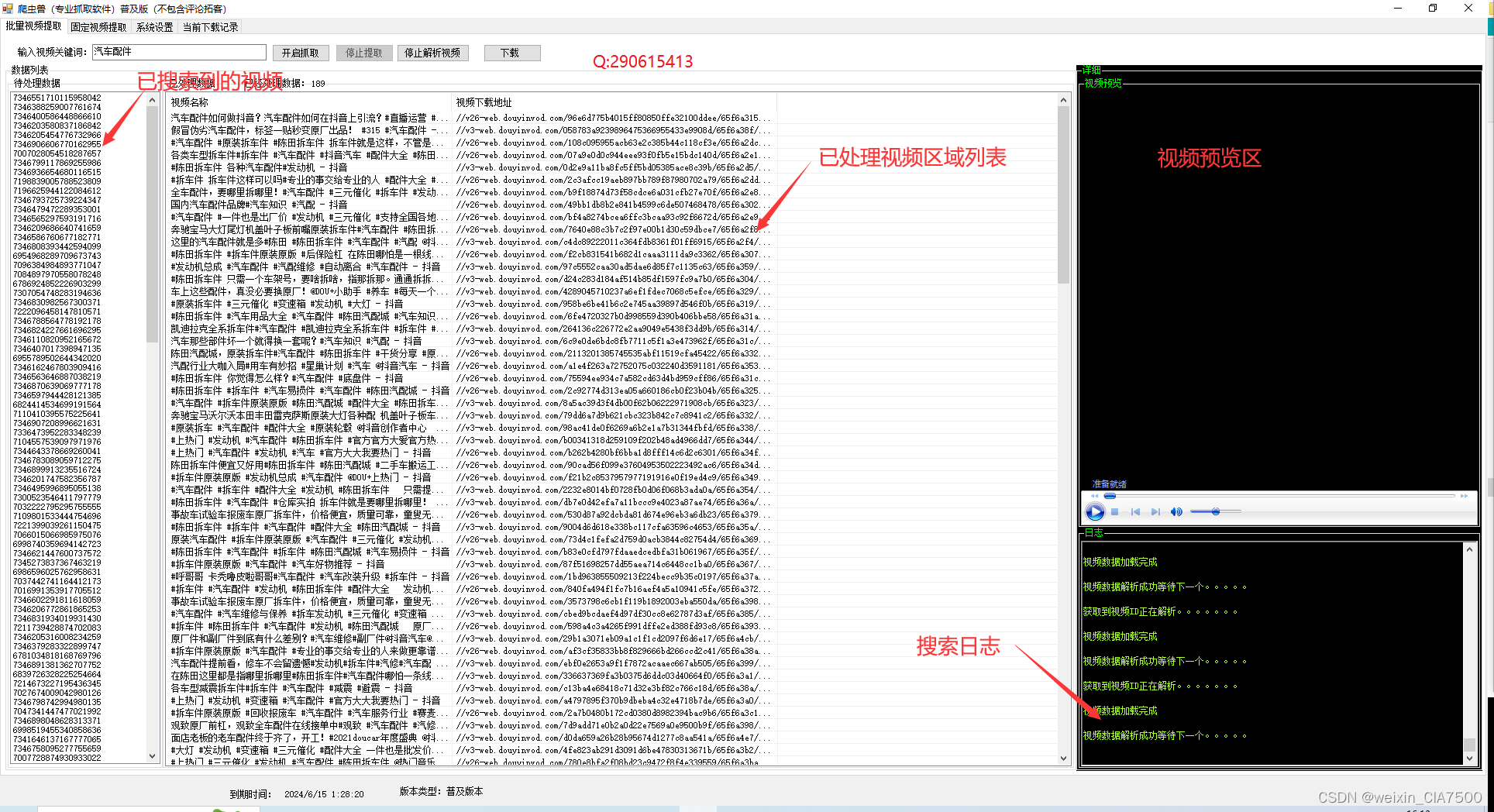

抖音 x-gorgon 03 免费生成接口 抖音6.3.0版本

接口已经更新,请参考文章 https://blog.csdn.net/wql2014302721/article/details/113737772 相关文章: 抖音爬虫从0到1-第一弹:环境配置 抖音 x-gorgon 03 免费生成接口 抖音6.3.0版本

最近老板让爬取一下抖音数据,最新版本的总是抓不到包&a…

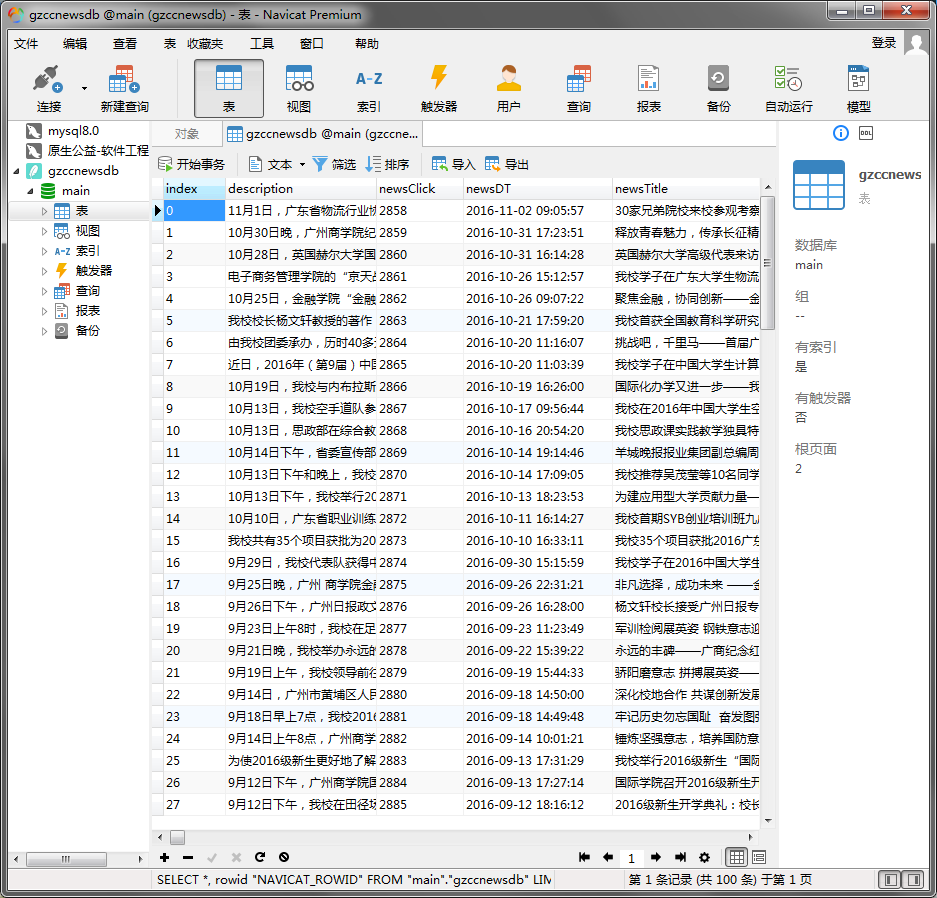

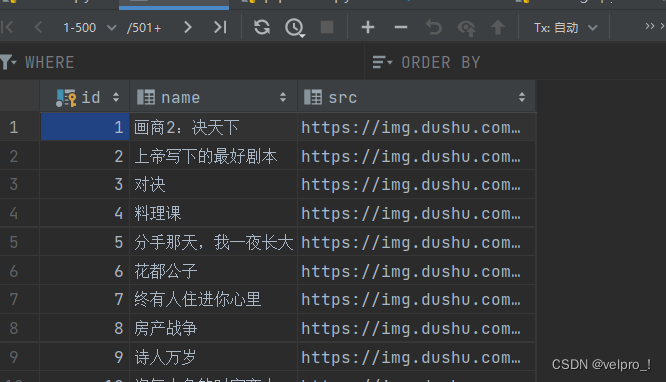

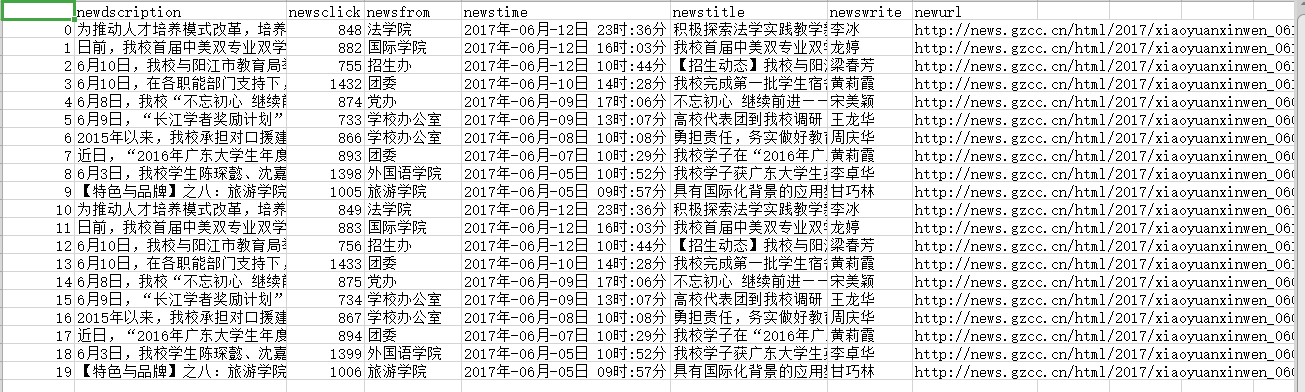

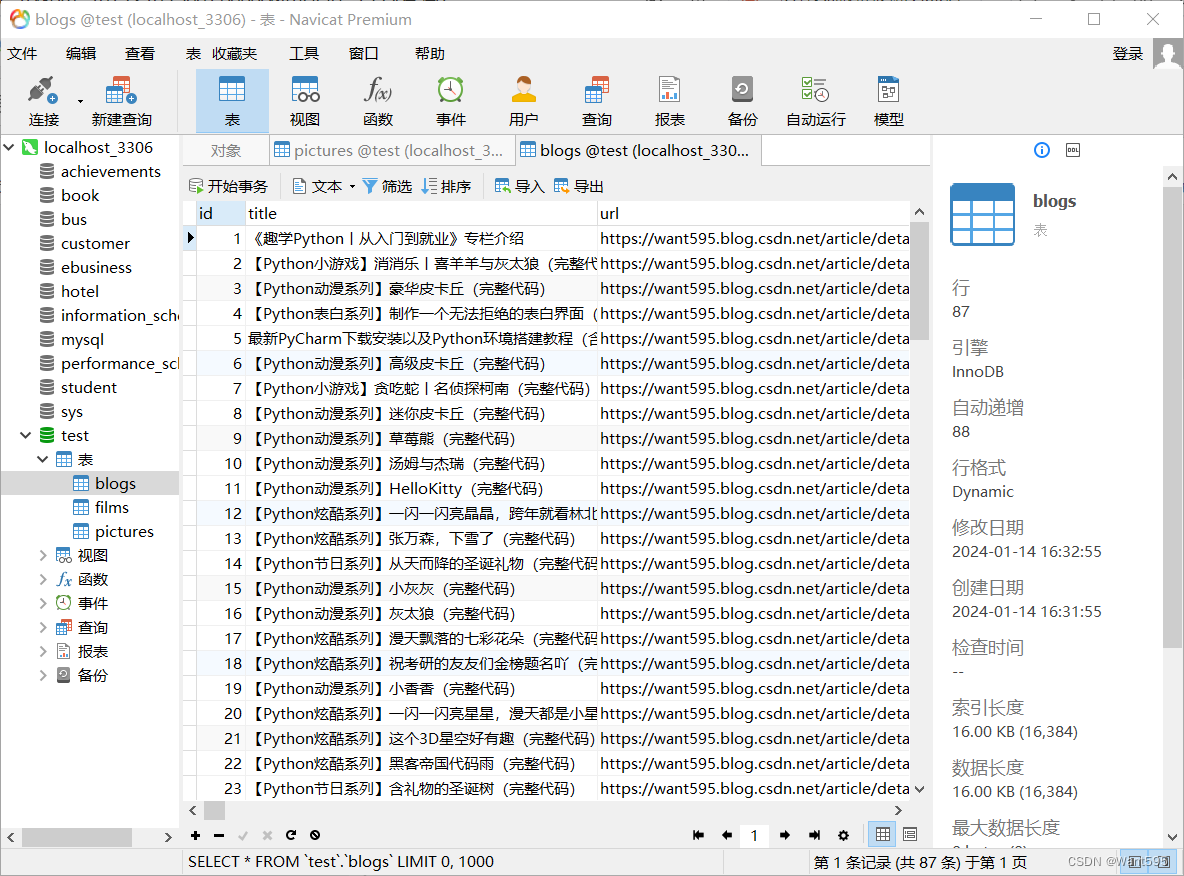

将爬取内容导入数据库

任务:将爬去的内容导入数据库

实现:1、安装mysql 可以在网上百度到安装包及安装教程,有很多大佬的经验

推荐https://jingyan.baidu.com/album/eae07827b2acad1fec54852d.html?picindex1

然后再安装Navicat Premium(可以找这http:…

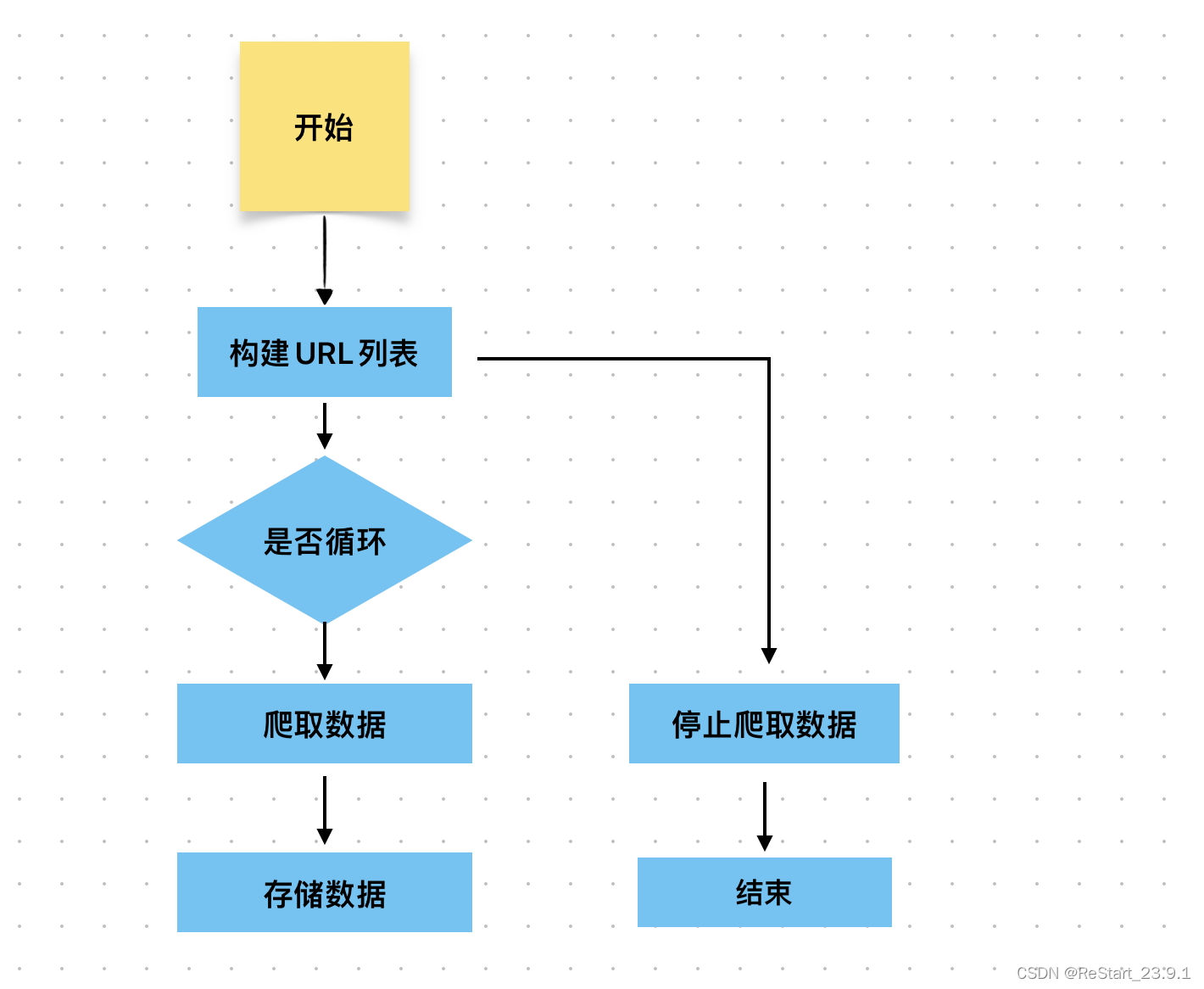

Python开发简单爬虫(一)

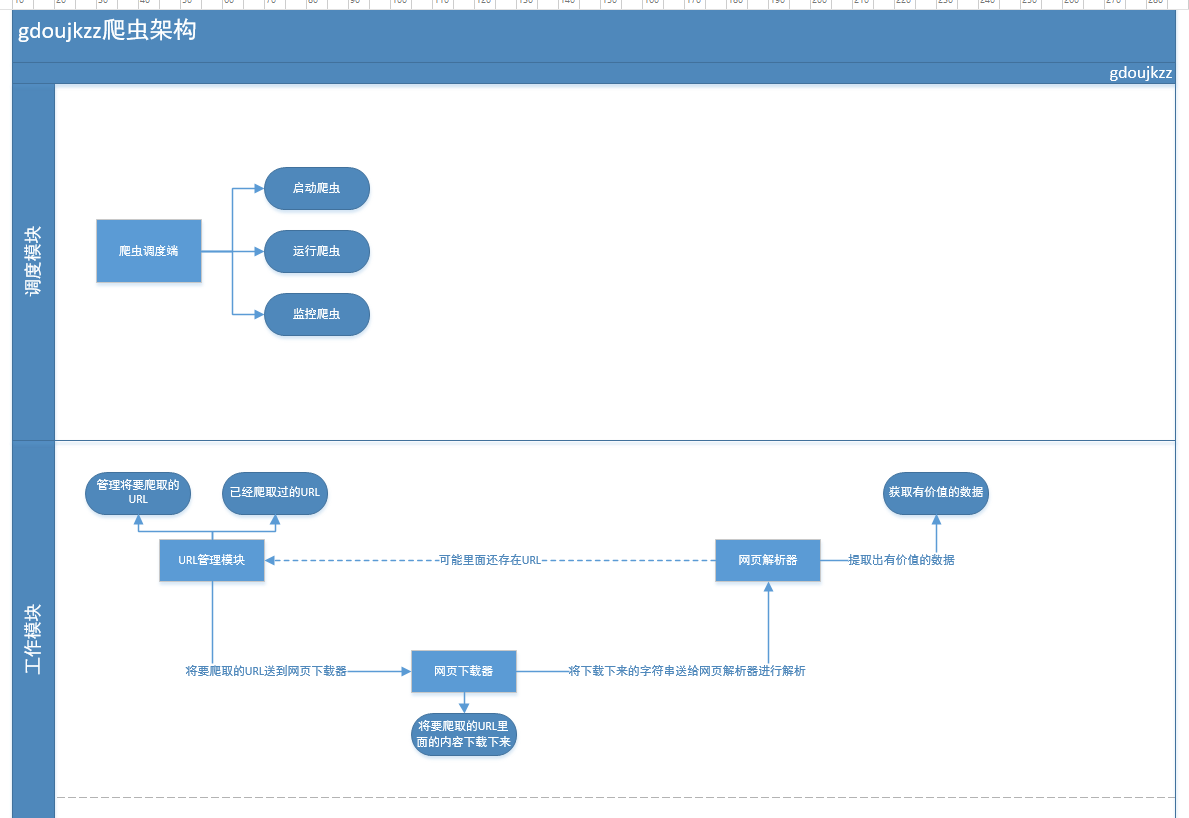

一 、简单爬虫架构: 爬虫调度端:启动爬虫,停止爬虫,监视爬虫运行情况 URL管理器:对将要爬取的和已经爬取过的URL进行管理;可取出带爬取的URL,将其传送给“网页下载器” 网页下载器:将…

【python】-- 元组、字典

元组 元组其实跟列表差不多,也是存一组数,只不是它一旦创建,便不能再修改,所以又叫只读列表 用途:一般情况下用于自己写的程序能存下数据,但是又希望这些数据不会被改变,比如:数据库…

Python爬虫:自动化下载海报

Python爬虫:如何自动化下载海报?

上一讲中我给你讲了如何使用八爪鱼采集数据,对于数据采集刚刚入门的人来说,像八爪鱼这种可视化的采集是一种非常好的方式。它最大的优点就是上手速度快,当然也存在一些问题࿰…

java学习笔记(3):网络编程

基本原理 客户端要发起通信,首先得知道运行服务器程序主机的IP地址,然后由网络的基础结构利用目标地址,将发送的信息传递到正确的主机上。地址可以是数字型(IPv4或者IPv6),也可以是字符串(必须先被解析&…

Day Five (beta)

站立式会议 站立式会议内容总结 331 今天:爬虫抓取豆瓣数据; 明天:数据展示在话题详情页,话题页修改442 今天:了解聊天模块 遇到的问题:无 明天:编写聊天模块439 今天:学习 遇到困难 无 明天:修改话题详情界面142 今天…

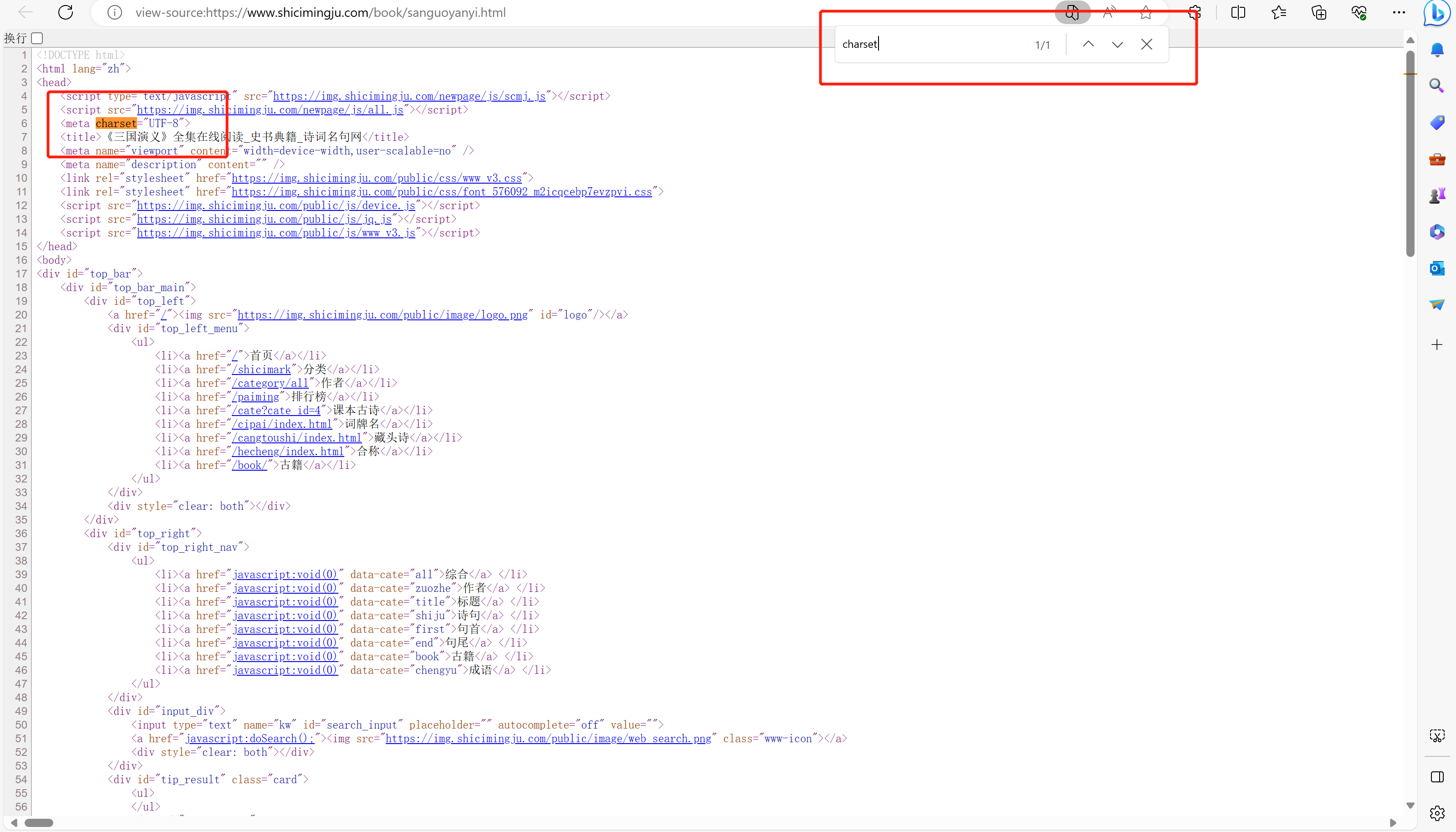

BeautifulSoup /bs4 爬虫实例

需求:使用bs4实现将诗词名句网站中三国演义小说的每一章的内容爬去到本地磁盘进行存储 http://www.shicimingju.com/book/sanguoyanyi.html 1 from bs4 import BeautifulSoup2 import requests3 4 url http://www.shicimingju.com/book/sanguoyanyi.html5 headers…

高防IP如何防止爬虫和Web攻击?

高防IP如何防止爬虫和Web攻击?随着互联网的发展,各种类型的网络攻击和爬虫行为也越来越多。为了保护网站的安全和稳定性,许多网站都采用了高防IP来防止爬虫和Web攻击。那么高防IP是如何防止爬虫和Web攻击的呢?下面我们来详细了解一…

【网络安全带你练爬虫-100练】第17练:分割字符串

目录

一、目标1:使用函数分割

二、目标2:使用函数模块

三、目标3:使用正则匹配 一、目标1:使用函数分割 目标:x.x.x.x[中国北京 xx云] 方法:split函数replace函数 1、分割:使用split()方法将…

代理IP和Socks5代理:跨界电商与爬虫的智能引擎

跨界电商,作为全球市场的一部分,对数据的需求越来越大。同时,随着互联网的发展,爬虫技术也在不断演进,成为了跨界电商的关键工具之一。然而,随之而来的是网站的反爬虫机制和网络安全风险。在这种情况下&…

爬虫学习-selenium模块

与爬虫的关联可以便携的获取网站中动态加载的数据便携实现模拟登录基于游览器自动化的一个模块(按键精灵脚本)使用流程环境安装pip install selenium下载一个游览器的驱动程序:谷歌浏览器驱动安装 - 琳达的博客 - 博客园 (cnblogs.com)from s…

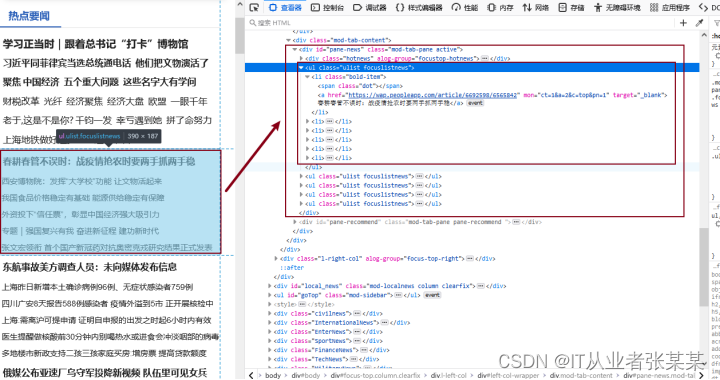

(十二)python网络爬虫(理论+实战)——实战:使用BeautfulSoup解析baidu热搜新闻数据

系列文章: python网络爬虫专栏 目录

序言

本节学习目标

特别申明

4.7 使用BeautfulSoup解析h

手机有什么爬虫App工具?

随着智能手机的普及和应用的繁盛,越来越多的人开始对手机App进行数据爬取和分析。那么,在进行手机App爬虫的过程中,我们可以借助哪些工具呢?让我们一起来了解一下吧! 1、Fiddler

Fiddler是一款功能强大的网络调试工具…

python基础程序(全代码)

一、下面是一个简单的Python Flask服务示例,它可以接受用户输入,并根据输入生成一个随机数字: from flask import Flask, render_template

import randomapp = Flask(__name__)@app.route(/)

def index():return render_template(index.html)@app.route(/random-number, method…

python 爬虫爬取新东方考研真题

女朋友要考研,想看看各个院校的真题,网上找了下,发现新东方真题库里面的考研真题还挺齐全的,网址:http://new.bj.xdf.cn/zhentiku/daxue/kaoyan/kyzyk/list_381_1.html

于是随手写了个爬虫爬取所有 新闻学 的考研题&a…

周末了,八一八推荐博客的排名

作者:Vamei 出处:http://www.cnblogs.com/vamei 欢迎转载,也请保留这段声明。谢谢! 最近挖煤君上了博客园推荐博客的排行榜,甚是高兴。看着自己名次上升,是件很开心的事情。 看着推荐榜上的诸位大神&#x…

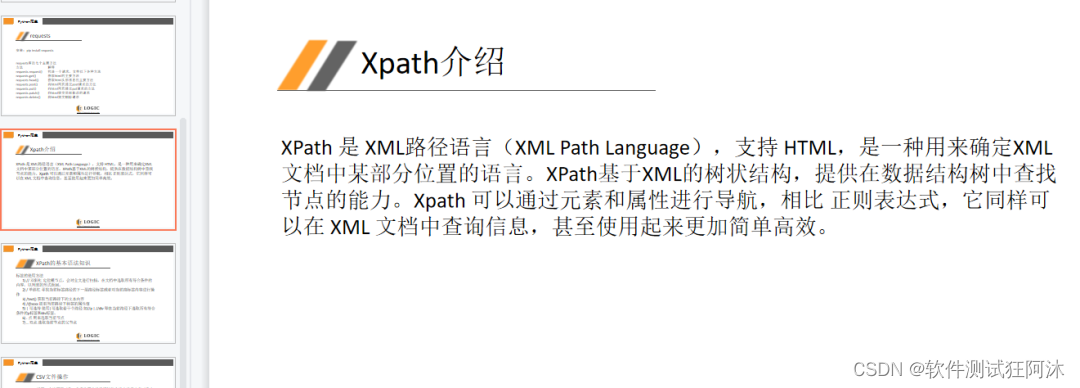

Python爬虫解析工具之xpath使用详解

文章目录 一、数据解析方式二、xpath介绍三、环境安装1. 插件安装2. 依赖库安装 四、xpath语法五、xpath语法在Python代码中的使用 一、数据解析方式

爬虫抓取到整个页面数据之后,我们需要从中提取出有价值的数据,无用的过滤掉。这个过程称为数据解析&a…

python数据处理相关的一些知识点(学习点)

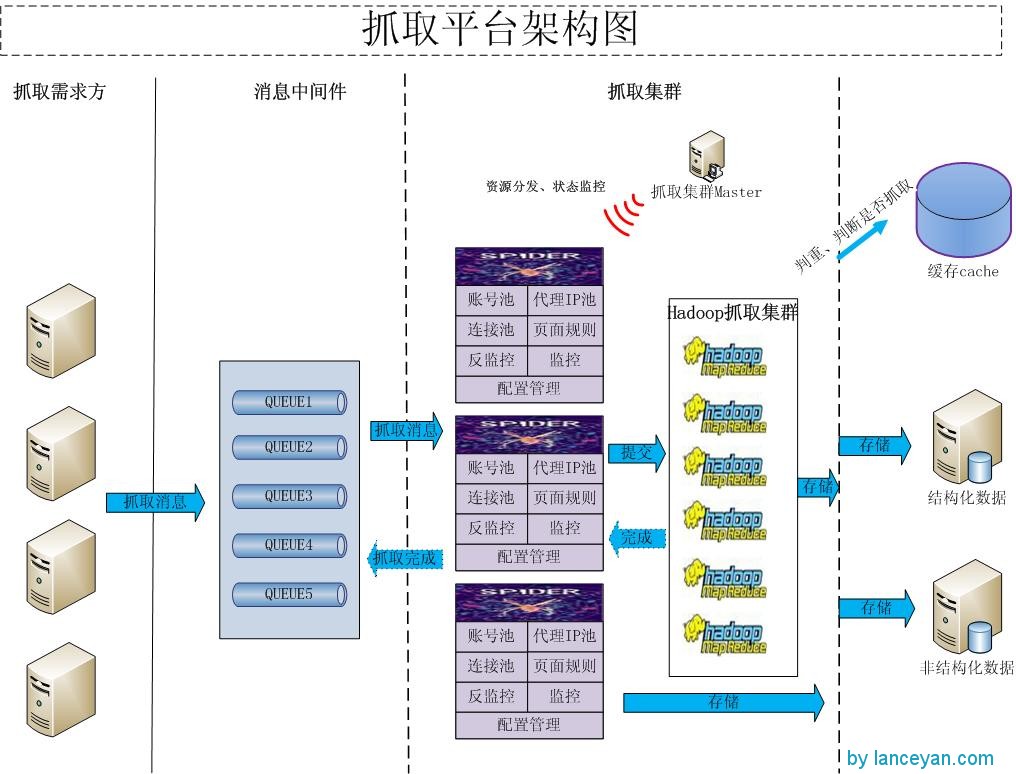

自己总结了一下就是存储,消息处理(异步,阻塞,队列,消息中间件) 参考岗位需求 数据爬虫工程师的岗位职责:1、分布式网络爬虫研发:不断完善现有抓取系统,通过对抓取、解析、…

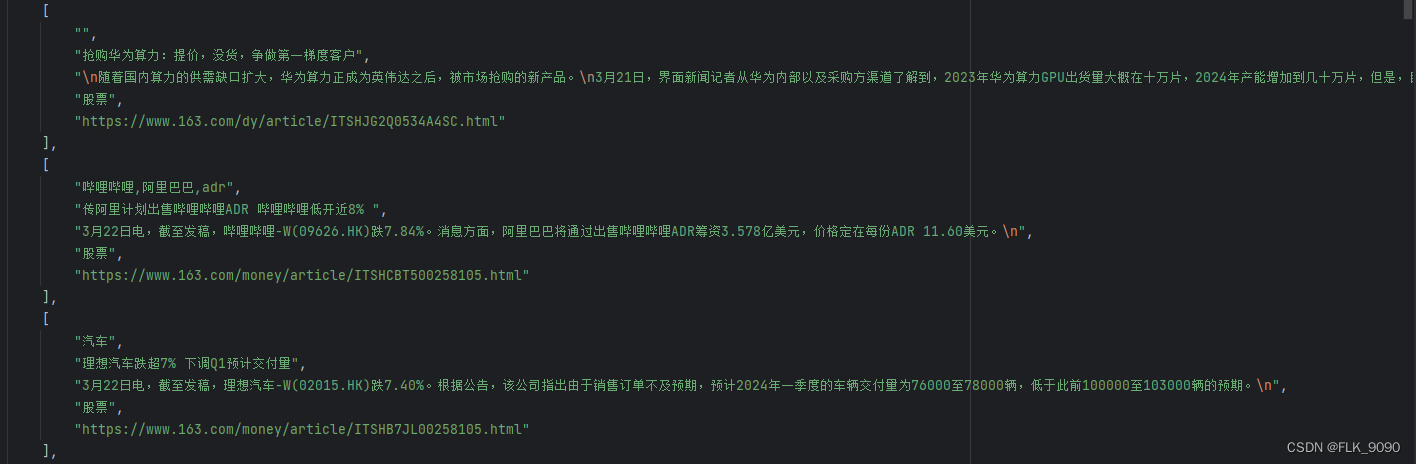

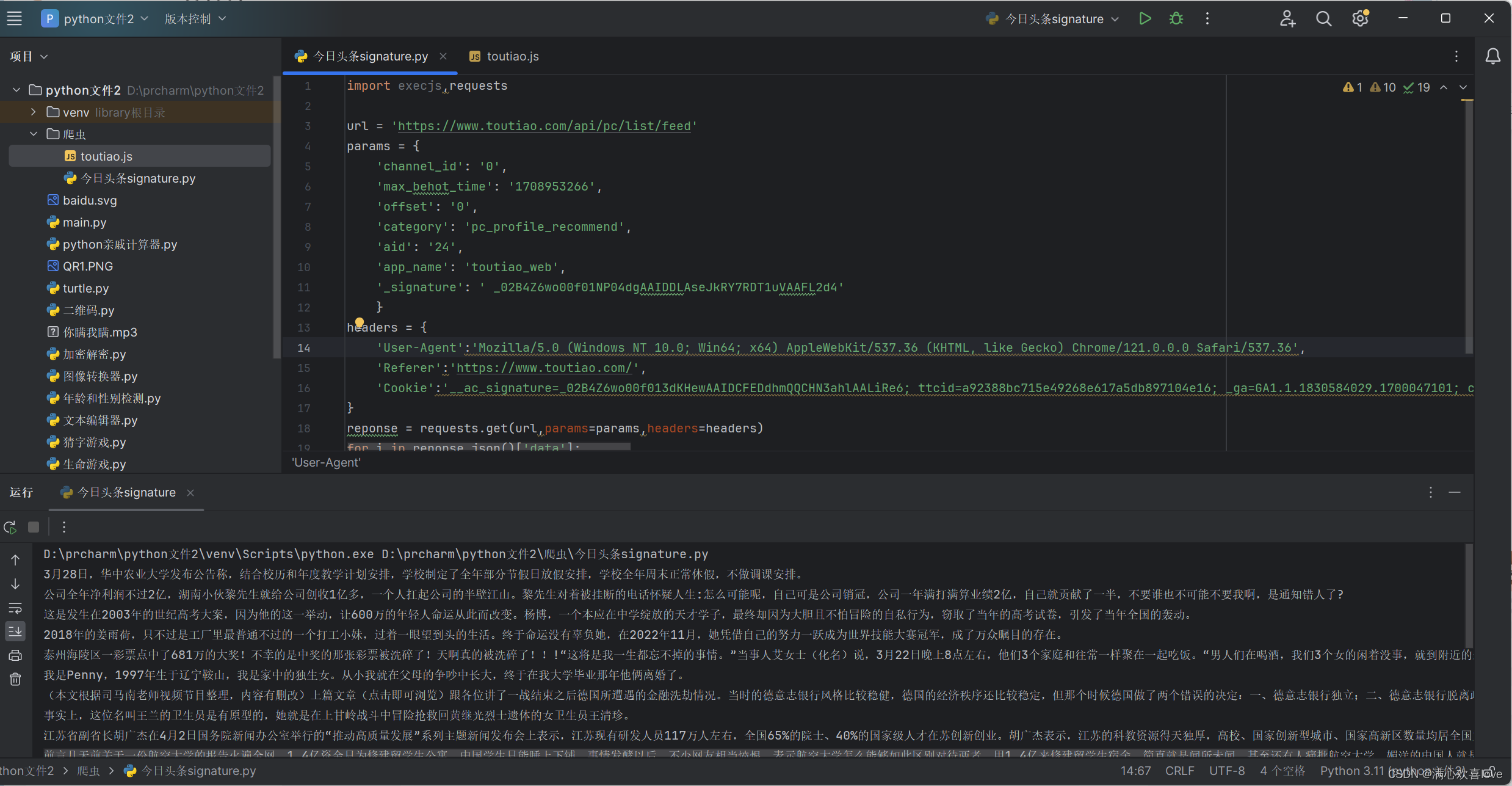

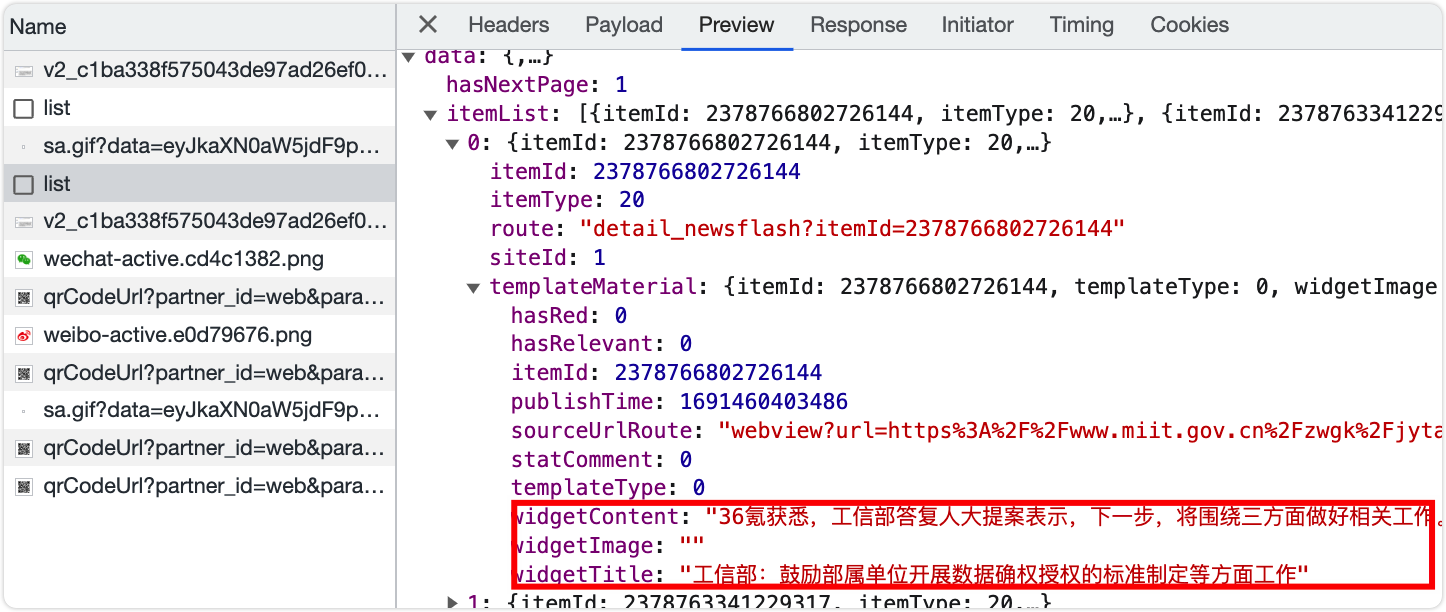

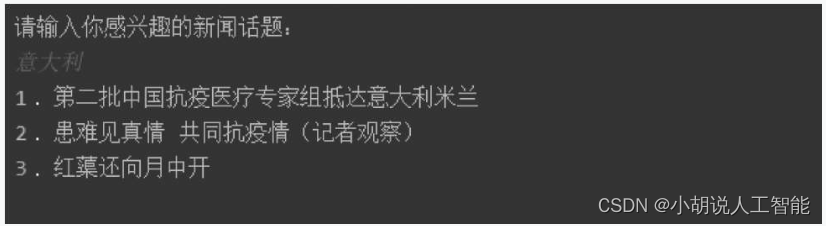

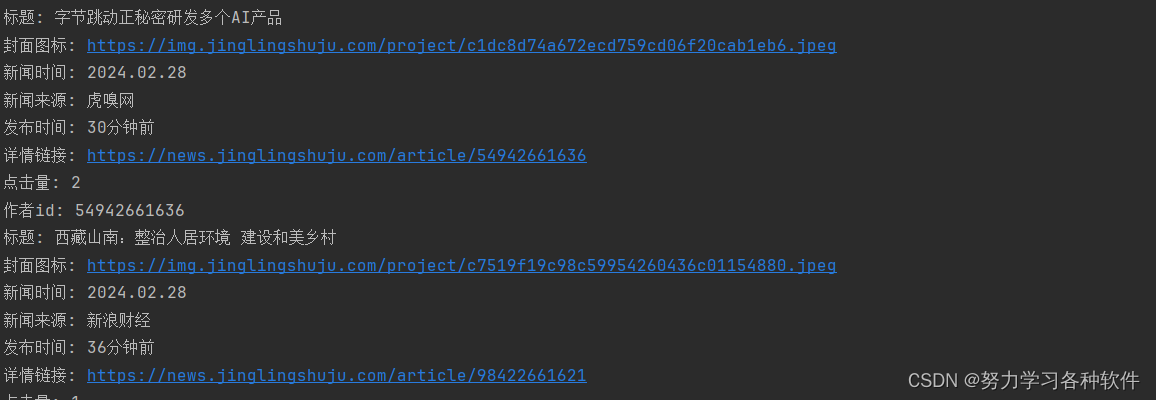

python爬虫实战——今日头条新闻数据获取

大家早好、午好、晚好吖 ❤ ~欢迎光临本文章 如果有什么疑惑/资料需要的可以点击文章末尾名片领取源码

第三方库:

requests >>> pip install requests

第三方模块安装:

win R 输入cmd 输入安装命令 pip install 模块名

(如果你觉得安装速度比较慢, 你…

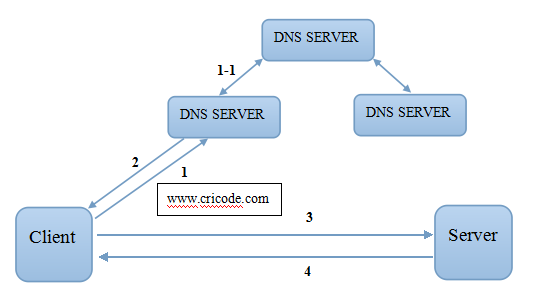

[爬虫学习笔记]C#基于ARSoft.Tools.Net的DNS解析模块(半成品)

最近在做爬虫的作业,今天学习的内容是关于DNS解析模块的制作的。使用的库为ARSoft.Tools.Net,它是一个非常强大的开源DNS控件库,包含.Net SPF validation, SenderID validation以及DNS Client、DNS Server接口。使用该接口可轻松实现DNS客户请…

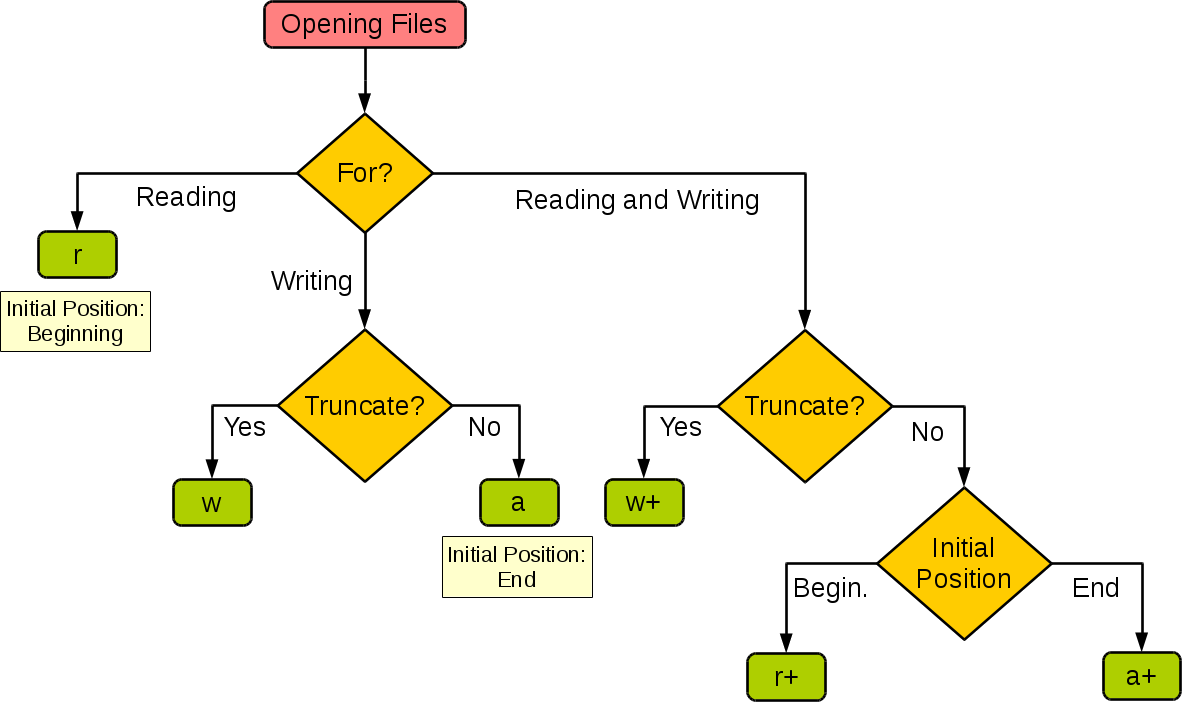

Python基础学习11——文件

我们可以利用python对本电脑文件夹里的文件进行处理,python中提供了一系列相关的方法和函数供我们使用。

读取文件

我们现在在本python文件中有一个txt文件名为Lego,那么我们就可以利用python打开该文件

with open(Lego.txt) as file_text:contents …

Flutter中好用的Widget-CupertinoPicker

Flutter中好用的Widget-CupertinoPicker

CupertinoPicker是Flutter框架中的一个非常实用且美观的Widget,它可以让用户从一个预设的列表中选择一个或多个值。在iOS设计风格的应用程序中,CupertinoPicker非常常见。

使用方法

CupertinoPicker组件需要通…

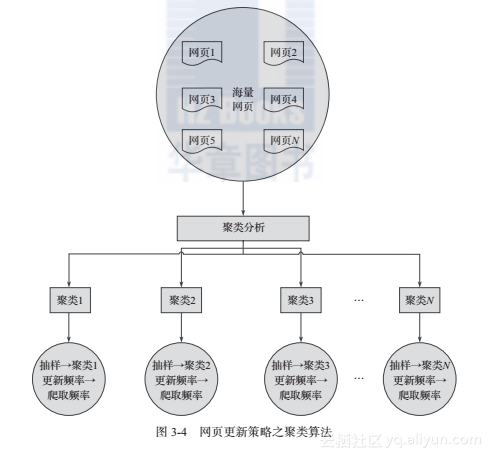

网络爬虫基本原理(二)

本文转载至 http://www.cnblogs.com/wawlian/archive/2012/06/18/2554072.html四、更新策略互联网是实时变化的,具有很强的动态性。网页更新策略主要是决定何时更新之前已经下载过的页面。常见的更新策略又以下三种:1.历史参考策略顾名思义,根…

最易上手的爬虫请求库:Requests核心功能速览(上)

前边三个章节我们学习了Python内置的爬虫请求库urllib的使用。说起urllib,它也算是挺强大了,可定制程度很高。

但是它有一个最大的问题,那就是使用起来还是不够方便,在处理一些复杂的功能比如会话、验证等时会比较复杂,甚至为了给URL添加一些请求参数,我们还得专门将这些…

scrapy进阶开发(四):spiderMiddleware

SpiderMiddleWare的定义 spiderMiddleware 是一个Scrapy的spider处理机制的钩子框架,你可以插入自定义的功能用来处理engine发往spider的response和spider发往engine的request和item 激活SpiderMiddleware 想要激活SpiderMiddleware,需要在settings里配置…

爬虫 selenium语法 (八)

目录

一、为什么使用selenium

二、selenium语法——元素定位

1.根据 id 找到对象

2.根据标签属性的属性值找到对象

3.根据Xpath语句获取对象

4.根据标签名获取对象

5.使用bs语法获取对象

6.通过链接文本获取对象

三、selenium语法——访问元素信息

1.获取属性的属性值…

Scrapy爬虫提高效率

如何提高scrapy的爬取效率 增加并发:默认scrapy开启的并发线程为32个,可以适当进行增加。在settings配置文件中修改CONCURRENT_REQUESTS 100值为100,并发设置成了为100。降低日志级别:在运行scrapy时,会有大量日志信息的输出&…

HTML的作用和新标签

语义化标签的含义: 根据内容的结构化(内容语义化),选择合适的标签(代码语义化)便于开发者阅读和写出更优雅的代码同时让浏览器的爬虫和机器很好地解析。可以在没有CSS的情况下,页面也能呈现出好…

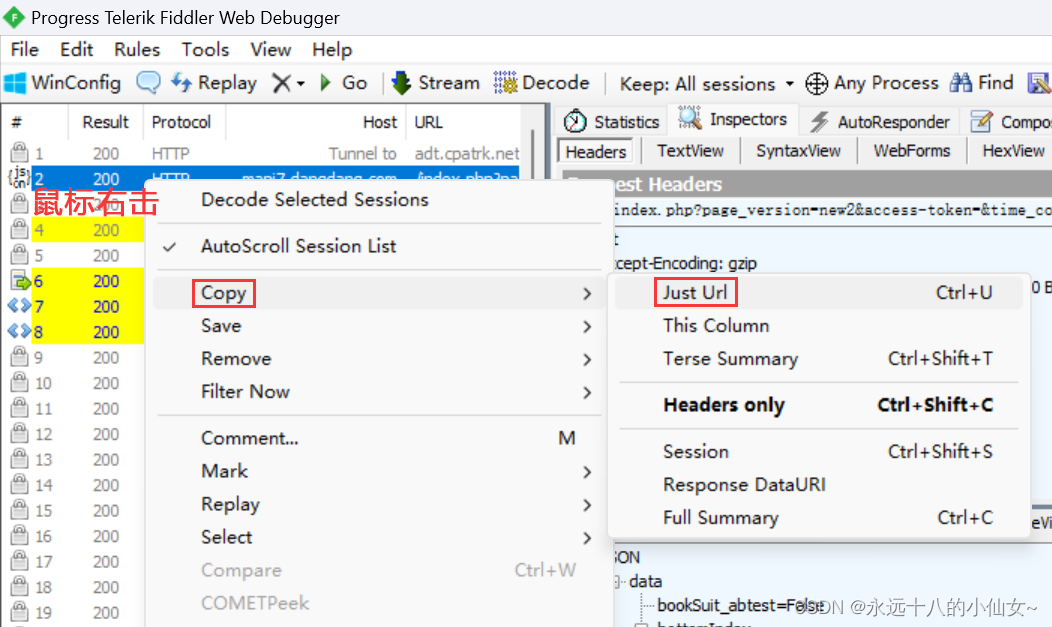

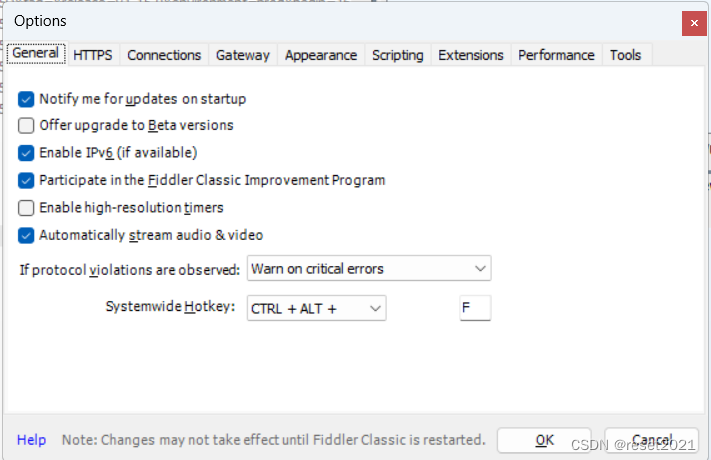

python爬虫入门 之 移动端数据的爬取

第七章 移动端数据的爬取 基于某一款抓包工具 : fiddler ,青花瓷 ,miteproxy 7.1 fiddler 基本配置 7.1.1fiddler简介和安装 什么是Fiddler? Fiddler是位于客户端和服务器端的HTTP代理,也是目前最常用的http抓包工具之一 。 它能够记录客户端和服务器之间的所有 H…

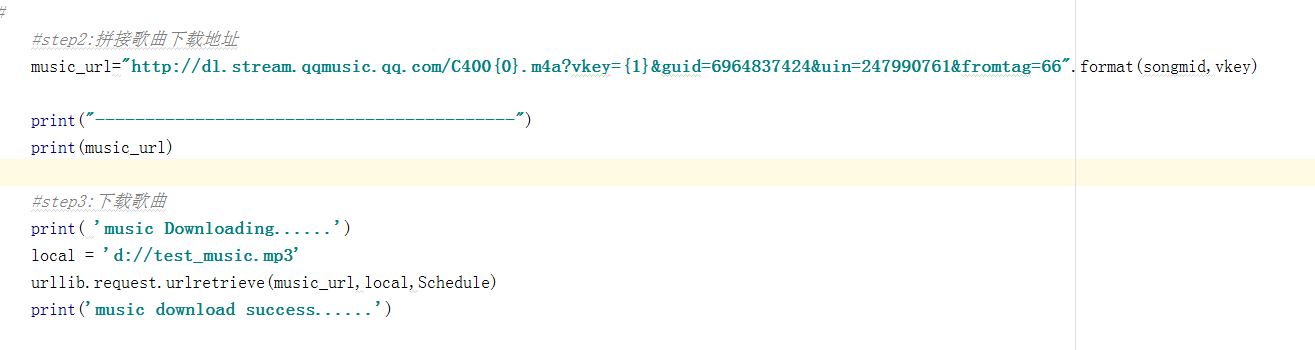

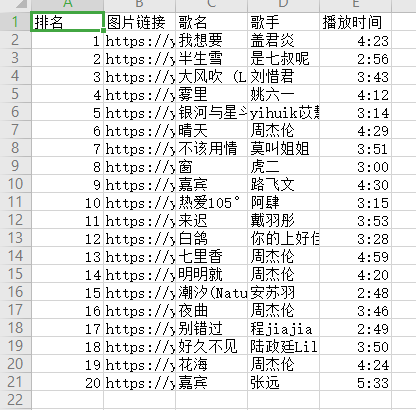

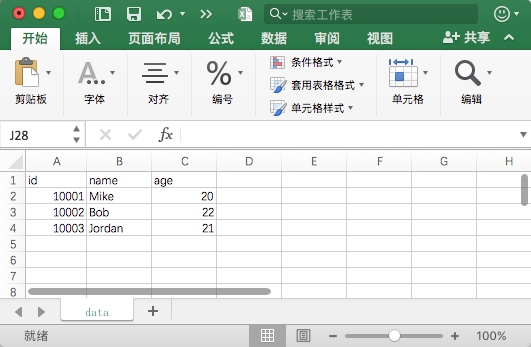

【python爬虫】7.爬到的数据存到哪里?

文章目录 前言存储数据的方式存储数据的基础知识基础知识:Excel写入与读取基础知识:csv写入与读取项目:存储周杰伦的歌曲信息 复习 前言

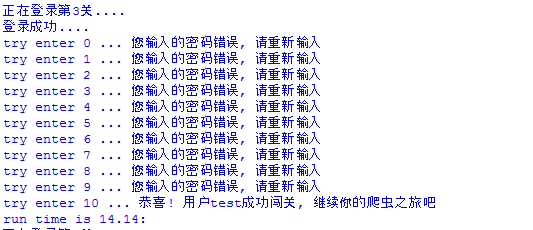

上一关我们以QQ音乐为例,主要学习了如何带参数地请求数据(get请求)…

【python】f.write()写入中文出错解决办法

一个出错的例子 #coding:utf-8

s u中文

f open("test.txt","w")

f.write(s)

f.close() 原因是编码方式错误,应该改为utf-8编码 解决方案一: #coding:utf-8

s u中文

f open("test.txt","w")

f.write(s.encod…

Python爬虫基础之Scrapy框架详解

目录 1. 简介2. Scrapy的安装3. Scrapy的架构4. Scrapy的数据流程5. Scrapy开发流程5.1 创建项目5.2 创建Spider5.3 创建Item5.4 编写Spider5.5 运行Spider 参考文献 原文地址:https://program-park.top/2023/12/01/reptile_5/ 本文章中所有内容仅供学习交流使用&am…

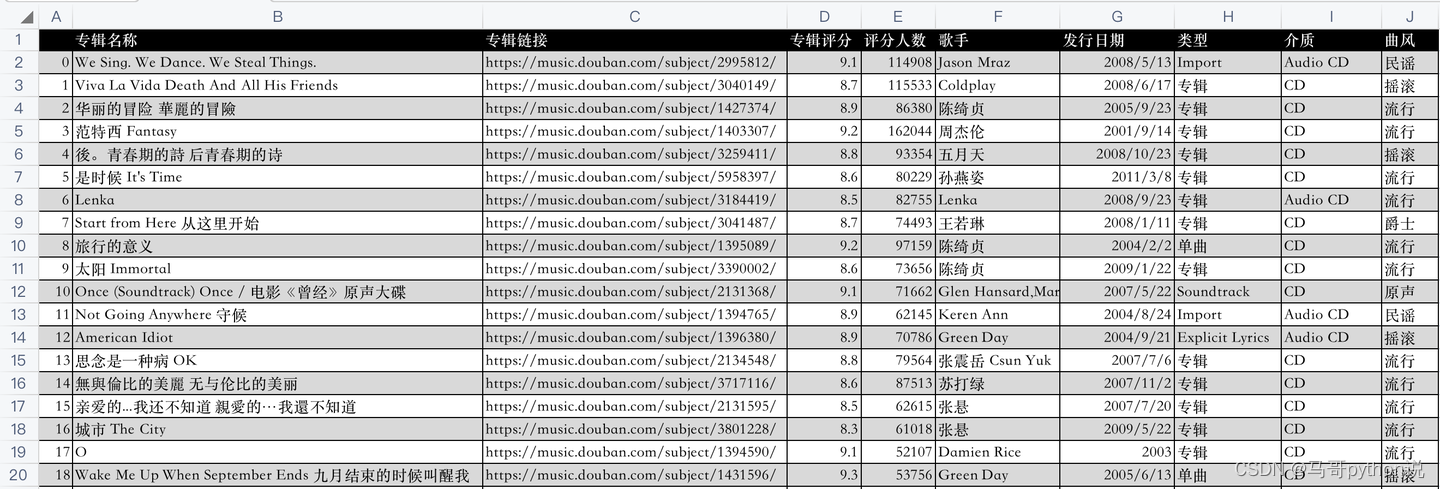

Python爬虫实战之豆瓣音乐、微打赏、阳光电影(附代码)

一、豆瓣音乐 今天爬的是豆瓣音乐top250,比较简单,主要是练练手。 1、加了请求头,本来没加,调试几次突然没数据了,加了请求头开始也没好,后来又好了,可能是网络原因; 2、这次是进入信…

Python:爬虫异常处理URLError HTTPError

爬虫异常处理

URLError

HTTPError:是URLError的子类,

所以如果URLError和HTTPError同时出现的话,要将HTTPError写在前面,URLError写在后面

import urllib.request

import urllib.errorURLError错误req urllib.request.Request(http://www.12…

深入了解Socks5代理技术

代理服务器的安全性,防范潜在的攻击。

三、Socks5代理的应用场景:

Socks5代理由于其灵活性和高度定制化的特性,在多种场景下得到了广泛应用: 匿名浏览: 用户可以通过Socks5代理实现匿名浏览,隐藏真实IP地…

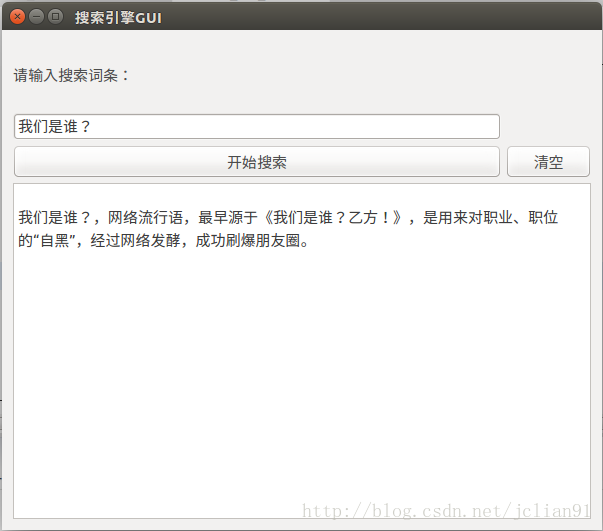

Python爬虫——自制简单搜索引擎GUI版

在上一篇分享中,笔者已经介绍了如何利用Python爬虫来制作一个简单的搜索引擎。我们将继续这个工作,来建立一个该搜索引擎的GUI版本,来获得更好地搜索体验。 主要程序还是上一篇分享中的搜索程序,在此基础上加入UI设计&#x…

Python爬虫之读取数据库中的数据

之前几篇我们一直在研究如何从网站上快速、方便的获取数据,并将获取到的数据存储在数据库中。但是将数据存储在数据中并不是我们的目的,获取和存储数据的目的是为了更好的利用这些数据,利用这些数据的前提首先需要从数据库按一定的格式来读取…

python爬取糗百第一页的笑话

自学python网络爬虫,发现request比urllib还是要好用一些,因此利用request和BeautifulSoup来实现糗百的首页笑话的抓取。BeautifulSoup通过find和findAll以及利用正则表达式实现HTML对应模块的抓取,当然select也是一个不错的选择。下面是临时的…

Python爬虫——使用requests和beautifulsoup4库来爬取指定网页的信息

以下是一个简单的Python代码,使用requests和beautifulsoup4库来爬取指定网页的信息:

import requests

from bs4 import BeautifulSoupurl "https://example.com"# 发送GET请求,获取网页内容

response requests.get(url)# 将网页内…

【Python网络爬虫入门教程1】成为“Spider Man”的第一课:HTML、Request库、Beautiful Soup库

Python 网络爬虫入门:Spider man的第一课 写在最前面背景知识介绍蛛丝发射器——Request库智能眼镜——Beautiful Soup库 第一课总结 写在最前面

有位粉丝希望学习网络爬虫的实战技巧,想尝试搭建自己的爬虫环境,从网上抓取数据。

前面有写一…

python和php语言编写大型爬虫那个更适用 ?

以我多年从事爬虫行业的经验来说,其实python和php两种语言都可以用于编写大型爬虫项目,但是因为Python语言简洁方便,第三方库相比有很多,数据处理能力也很强,所以受到大多数程序员的追捧。

Python和PHP都可以用于编写…

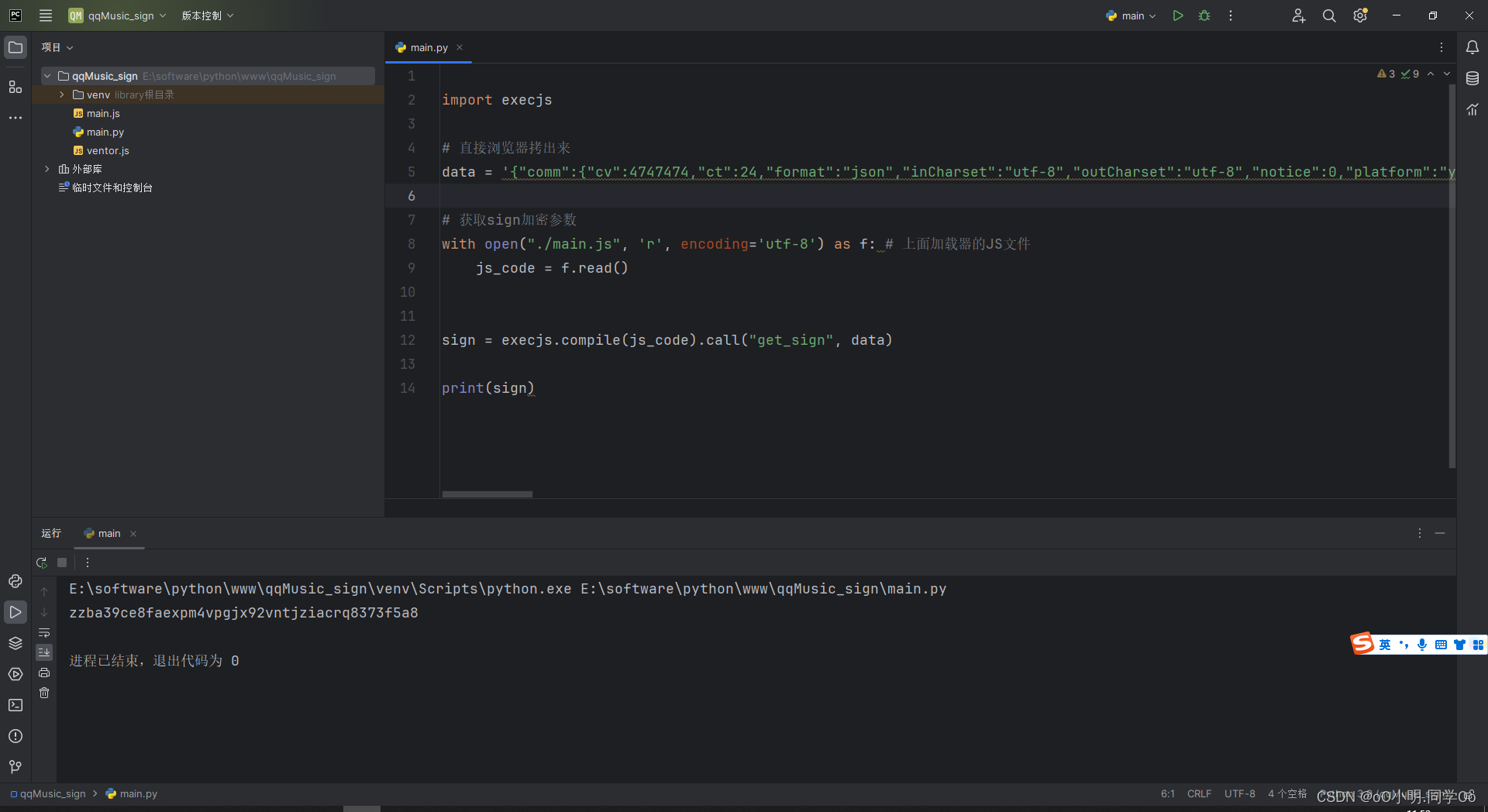

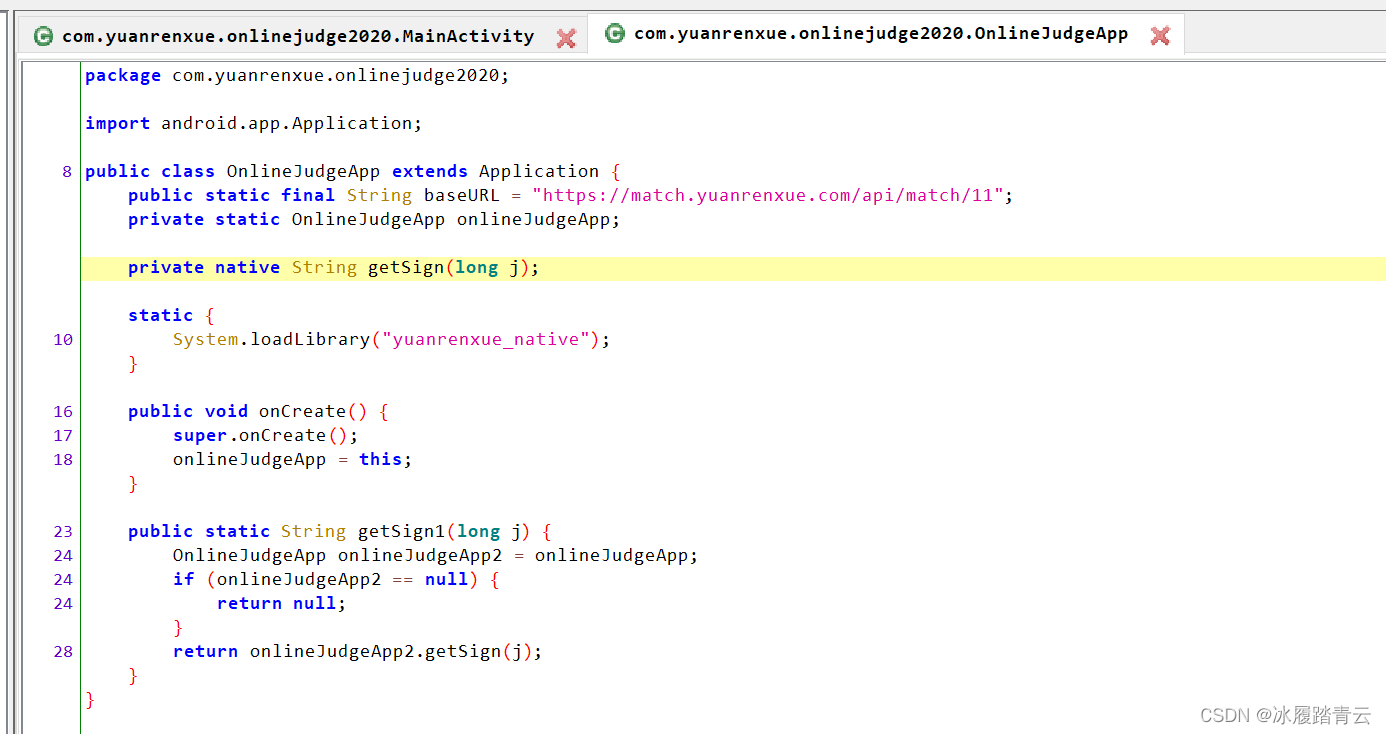

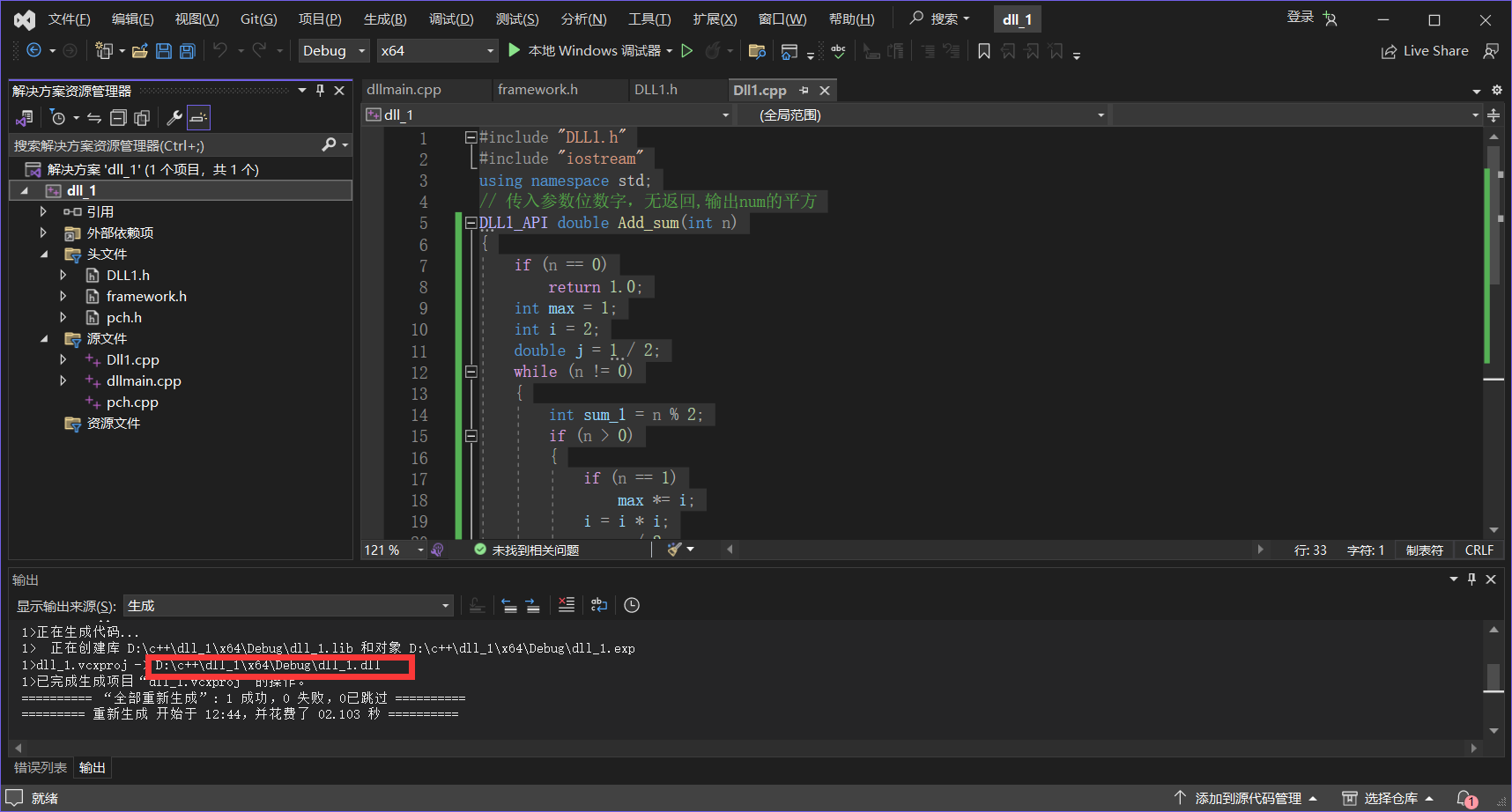

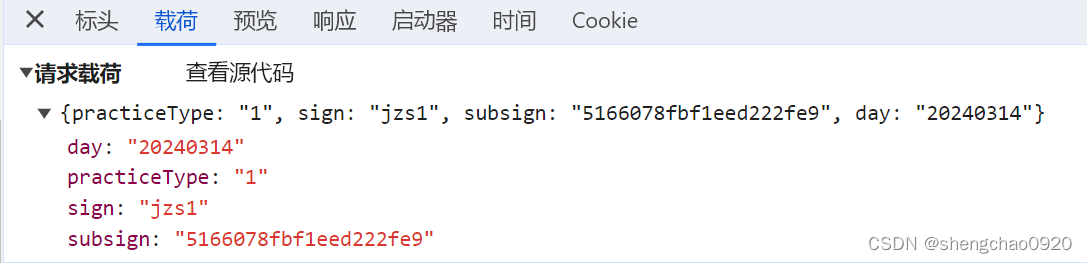

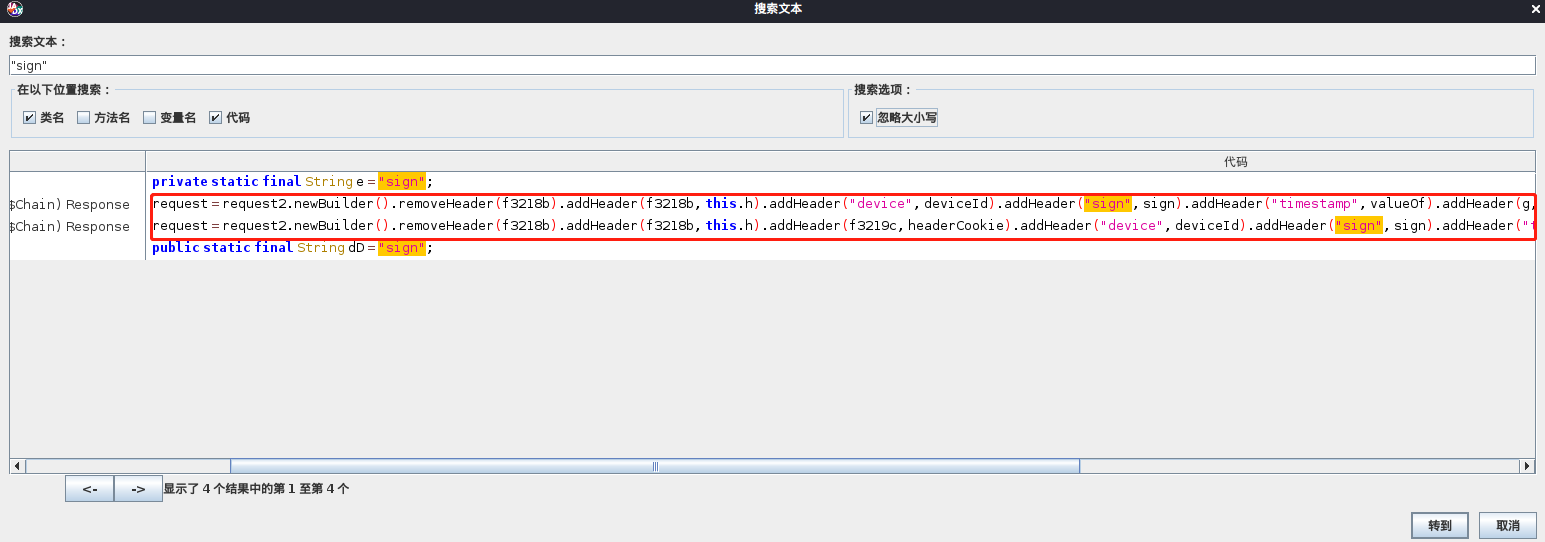

【微信小程序调试工具试用】

【微信小程序调试工具试用】 试用大佬开发的dll拿到某物小程序sign签名 (过于简单 大佬勿喷)本次工具分享到此结束 什么是爬虫逆向? 试用大佬开发的dll拿到某物小程序sign签名 (过于简单 大佬勿喷)

1 如图 下面小程序…

Python实现内网穿透和端口转发代理

对于大型的爬虫项目,肯定需要有良好的反爬机制,还应该配合代理iP使用,只有这两种结合才能让你的爬虫更高效准确。今天我就借用我一点空闲时间,来谈一谈有关python爬虫网络方面的解决方案,这里提供内网穿透和端口转发两…

python网络数据获取

文章目录1网络爬虫2网络爬虫的类型2.1通用网络爬虫2.1.12.1.22.2聚焦网络爬虫2.2.1 基于内容评价的爬行策略2.2.2 基于链接结构的爬行策略2.2.3基于增强学习的爬行策略2.2.4基于语境图的爬行策略2.3增量式网络爬虫深层网页爬虫3网络爬虫基本架构3.1URL管理模块3.2网页下载模块3…

Python的Scrapy框架入门教程

前言:

Scrapy是一个基于Python的Web爬虫框架,可以快速方便地从互联网上获取数据并进行处理。它的设计思想是基于Twisted异步网络框架,可以同时处理多个请求,并且可以使用多种处理数据的方式,如提取数据、存储数据等。…

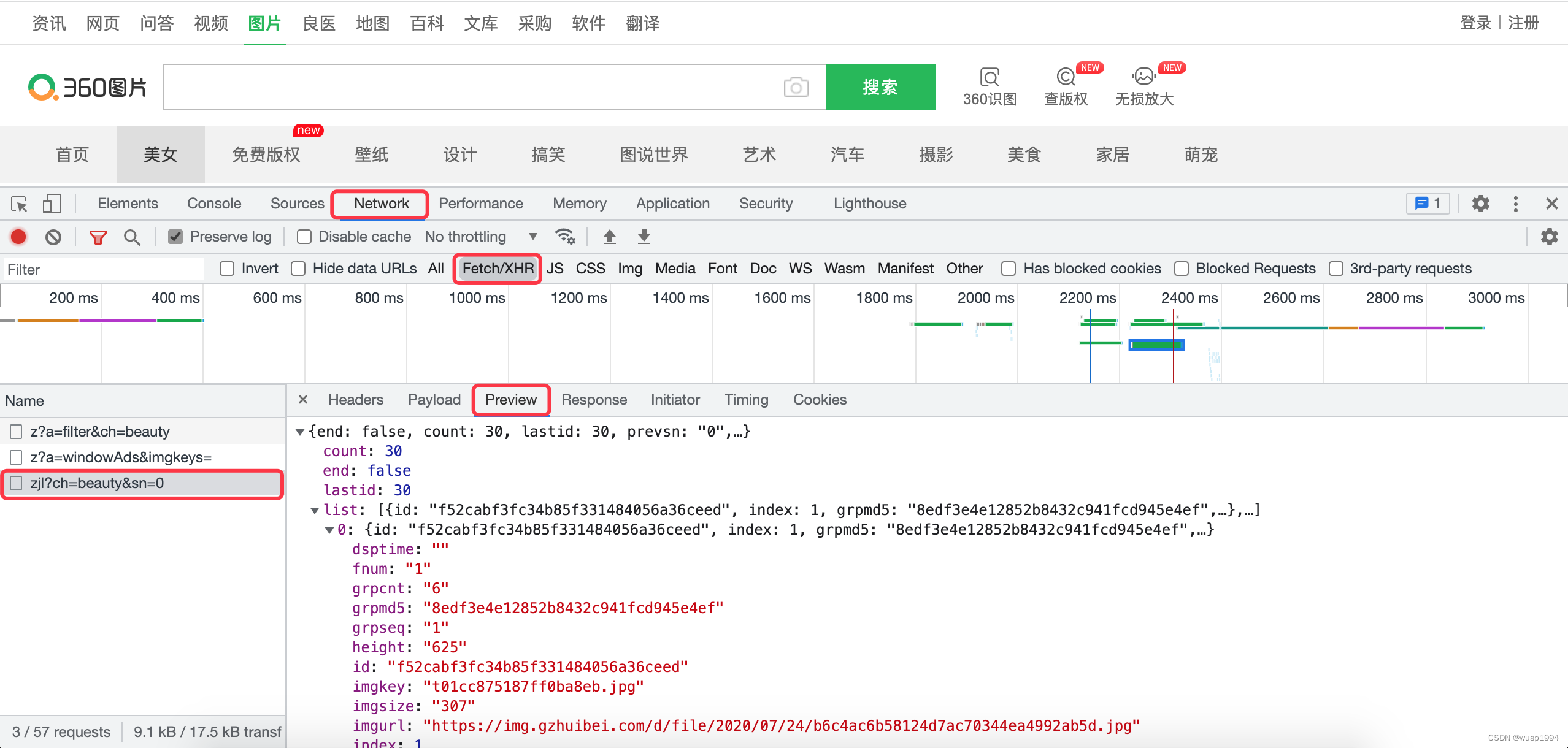

【爬虫】案例01:爬取某搜索网站搜索结果数据

古人云:“问君能有几多愁,恰似一群爬虫在爬网。” 但现在的我们可以说:“学爬虫,就像打怪升级一样,一步一步,勤学多练才能变得更强!下面就开始爬虫的第一个案例练习吧,获取搜索结果要…

分享Python7个爬虫小案例(附源码)

本次的7个python爬虫小案例涉及到了re正则、xpath、beautiful soup、selenium等知识点,非常适合刚入门python爬虫的小伙伴参考学习。注:若涉及到版权或隐私问题,请及时联系我删除即可。

1.使用正则表达式和文件操作爬取并保存“某吧”某帖子…

Python 爬虫采集知识,JavaScript 压缩,混淆和加密技术详解

文章目录JavaScript 压缩,混淆和加密技术详解介绍JavaScript 的重要性为什么需要压缩、混淆和加密?JavaScript 压缩JavaScript 压缩的定义JavaScript 压缩的原理常见的 JavaScript 压缩工具JavaScript 压缩的优缺点JavaScript 压缩案例JavaScript 混淆Ja…

〖Python网络爬虫实战③〗- 爬虫的基本原理

订阅:新手可以订阅我的其他专栏。免费阶段订阅量1000python项目实战 Python编程基础教程系列(零基础小白搬砖逆袭) 说明:本专栏持续更新中,目前专栏免费订阅,在转为付费专栏前订阅本专栏的,可以免费订阅付费…

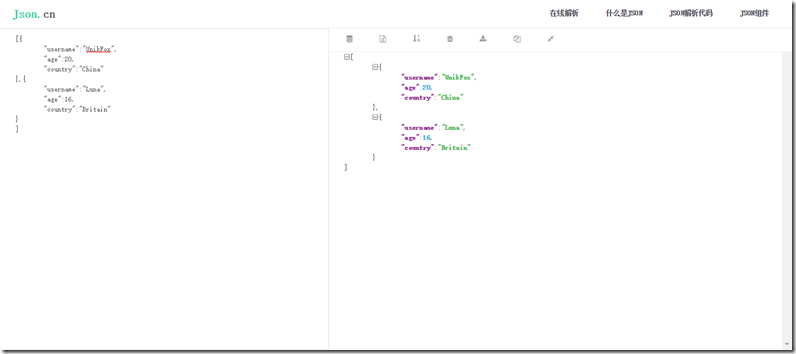

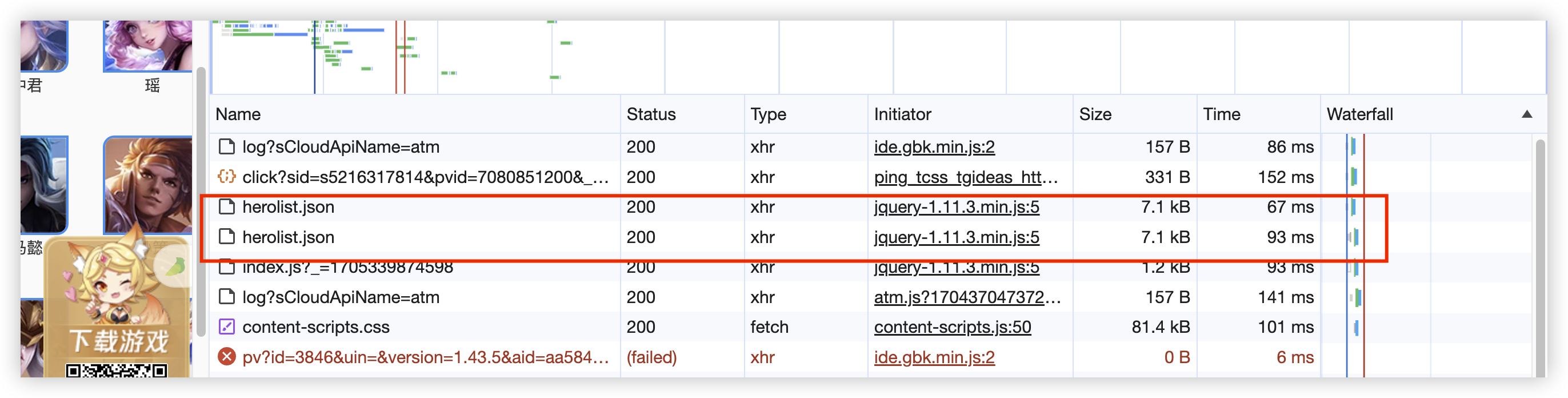

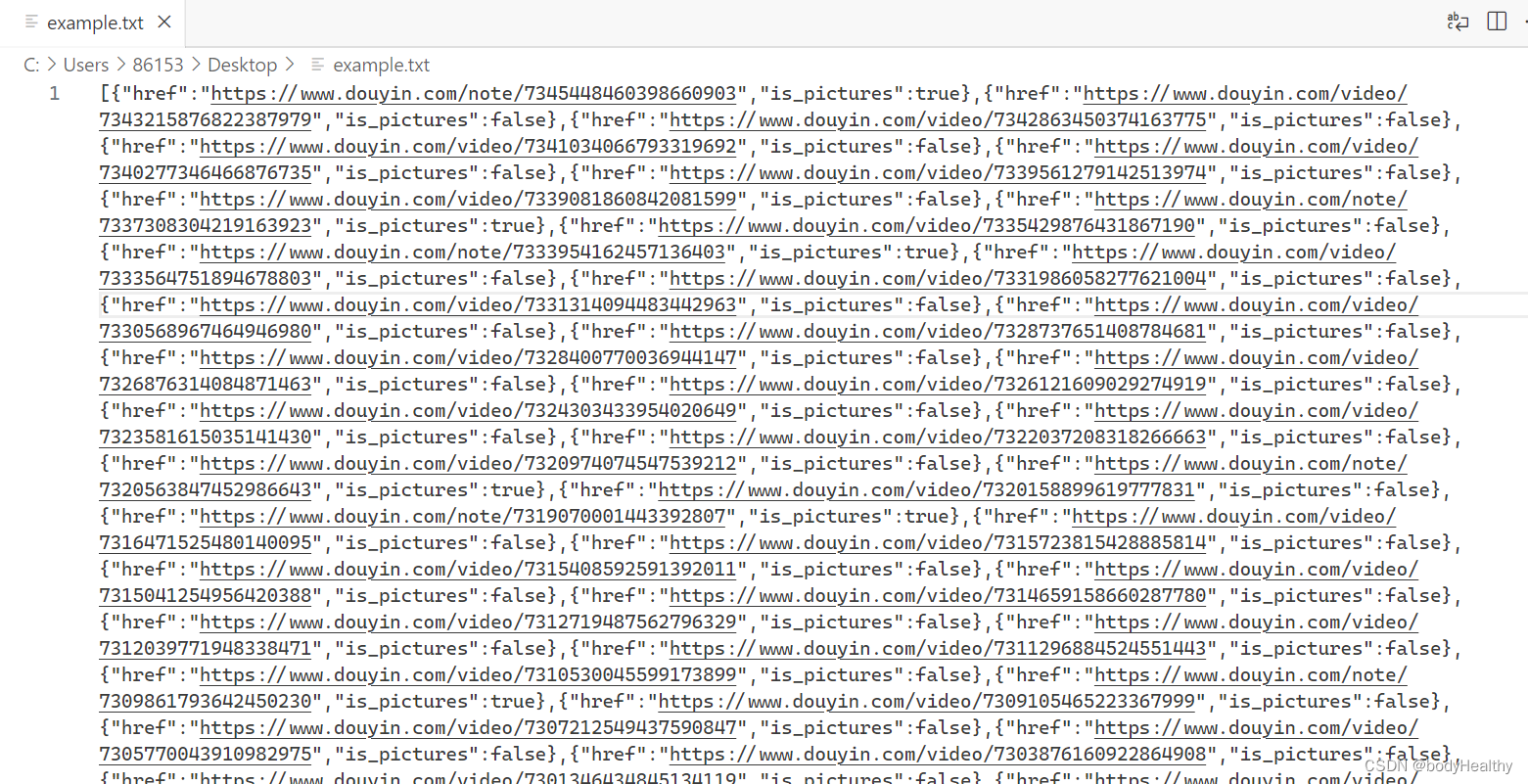

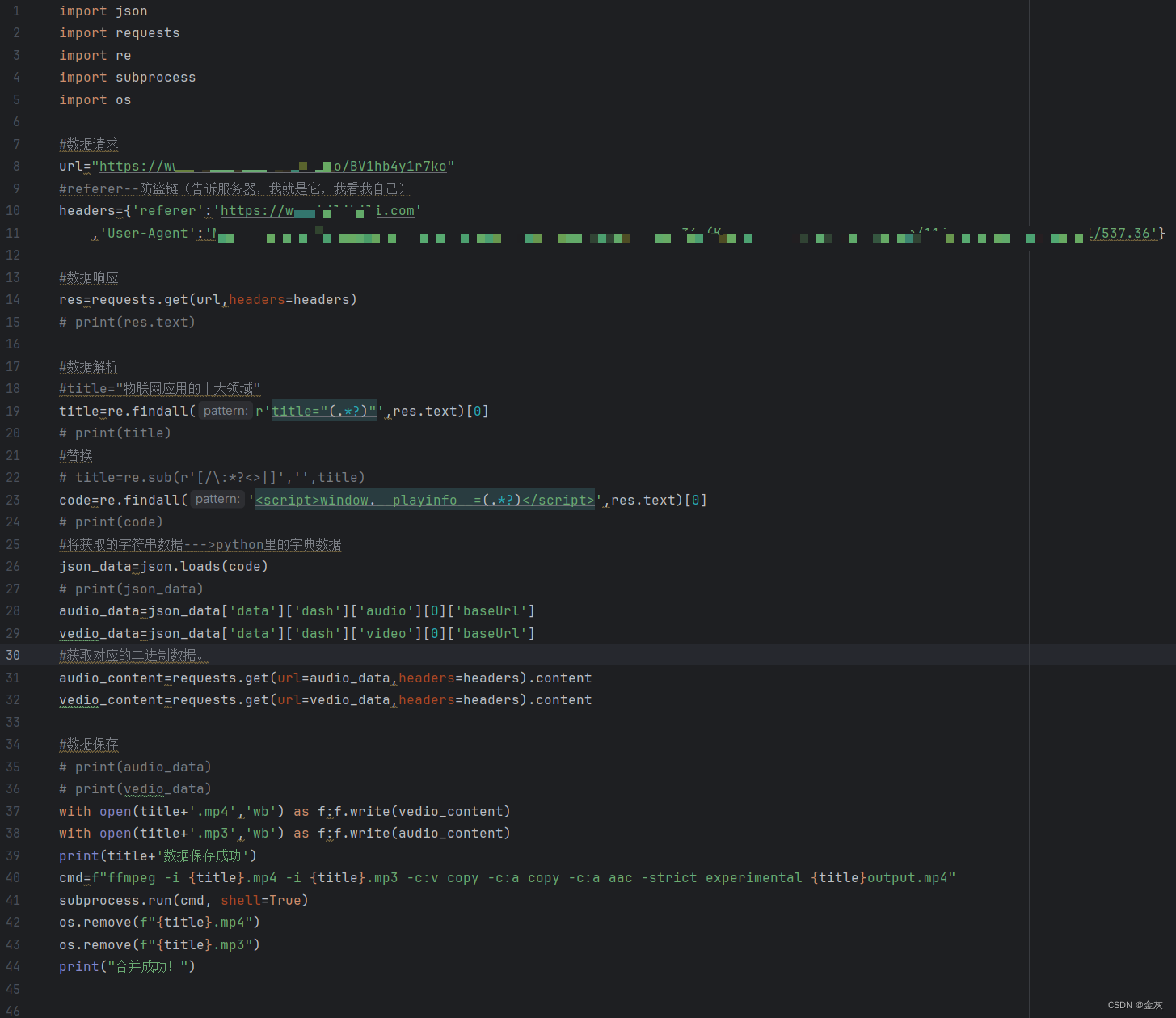

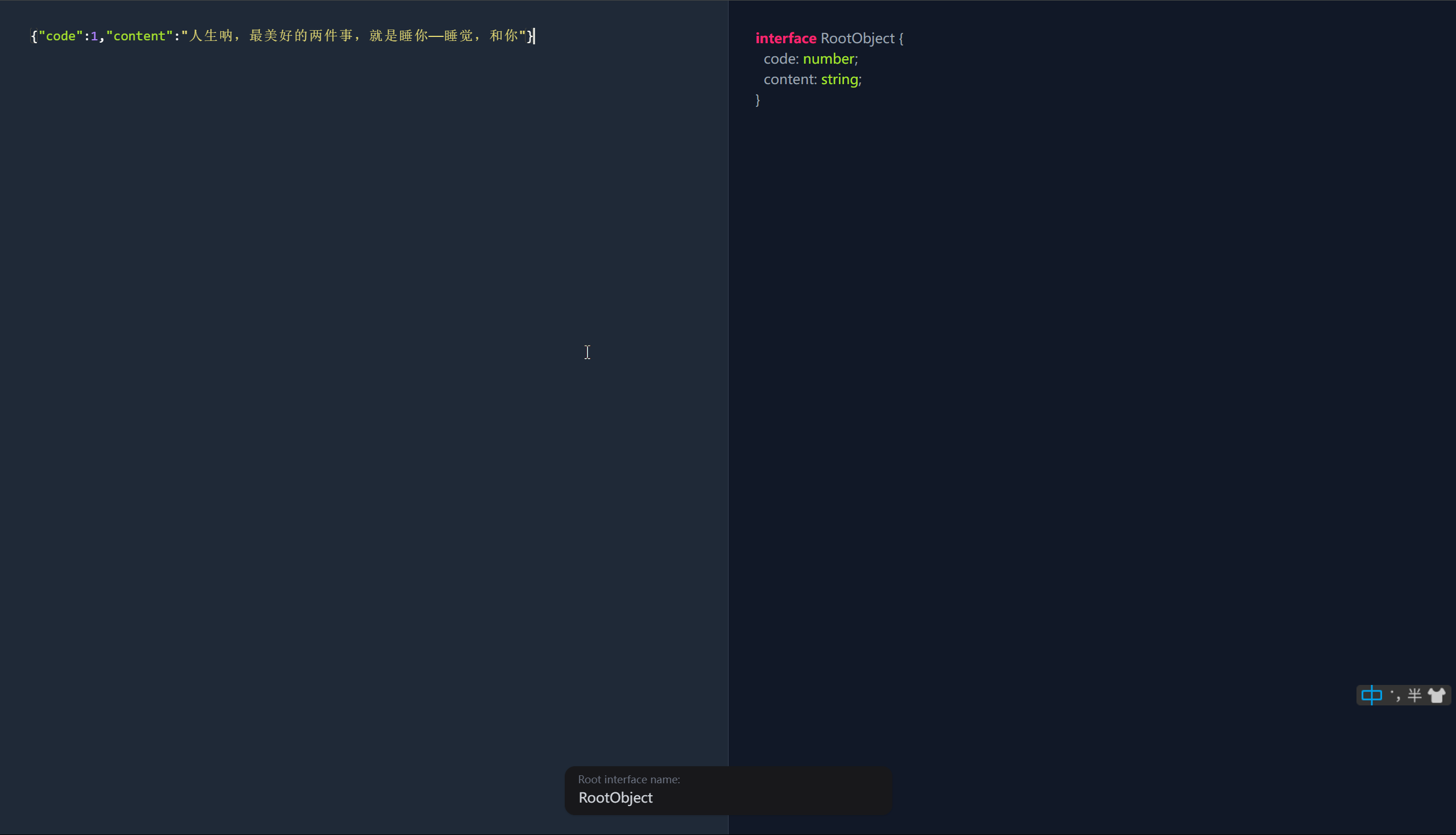

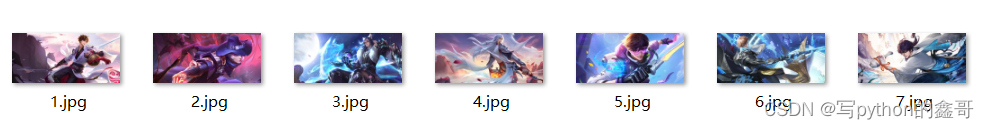

【Python】json数据解析

目录

json文件数据解析

爬虫获取王者荣耀英雄信息json数据包并解析

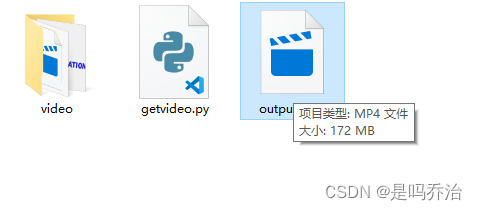

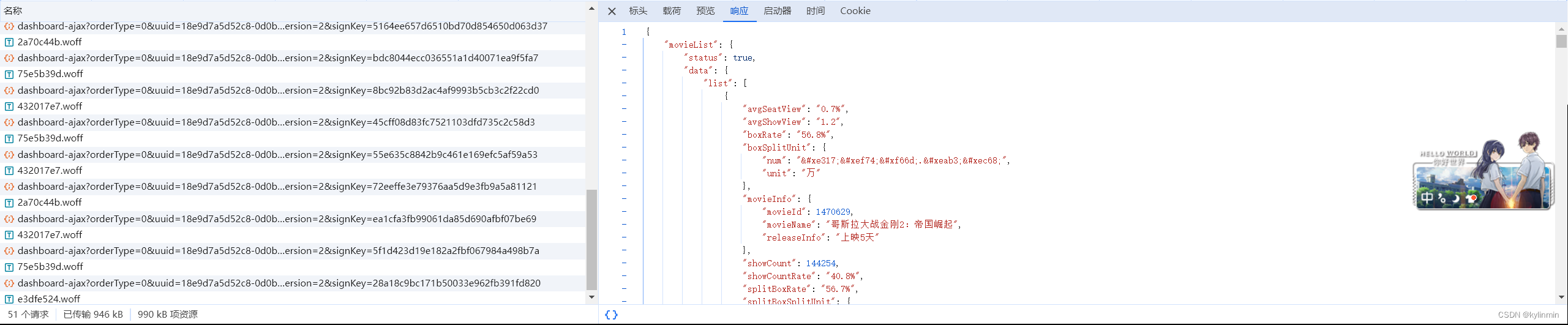

爬虫获取抖音视频json数据包并解析 json文件数据解析 json字符串:通常类似python数据类型中的列表和字典的结合,也可能是单独的列表或者字典格式,通常可以通过json模块的…

【Python】【进阶篇】十九、Python爬虫的json模块

目录十九、Python爬虫的json模块19.1 jons.loads()19.1 json.dump()19.1 json.load()19.1 json.dumps()十九、Python爬虫的json模块

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,遵循欧洲计算机协会制定的 JavaScript 规范…

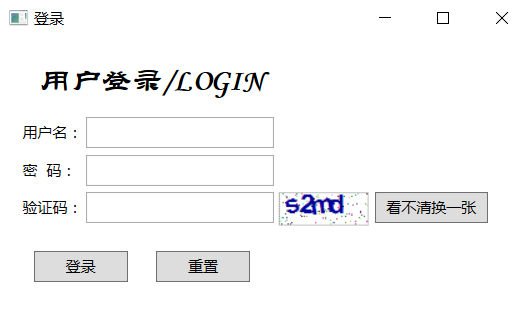

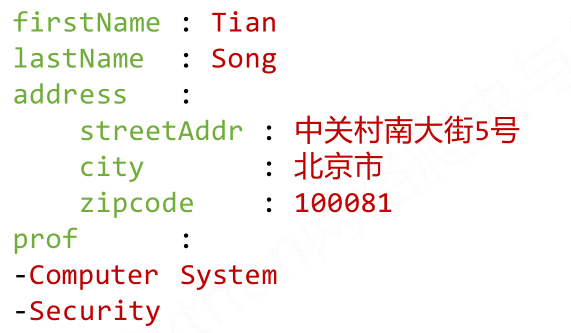

团队项目——工大助手界面(登录部分)

工大助手 基本内容 工大助手(桌面版)实现登陆、查成绩、计算加权平均分等功能团队人员 13070002 张雨帆13070003 张帆13070004 崔巍13070006 王奈13070045 汪天米13070046 孙宇辰界面设计(登录部分) 使用VS2013 C# WPF制作界面。 …

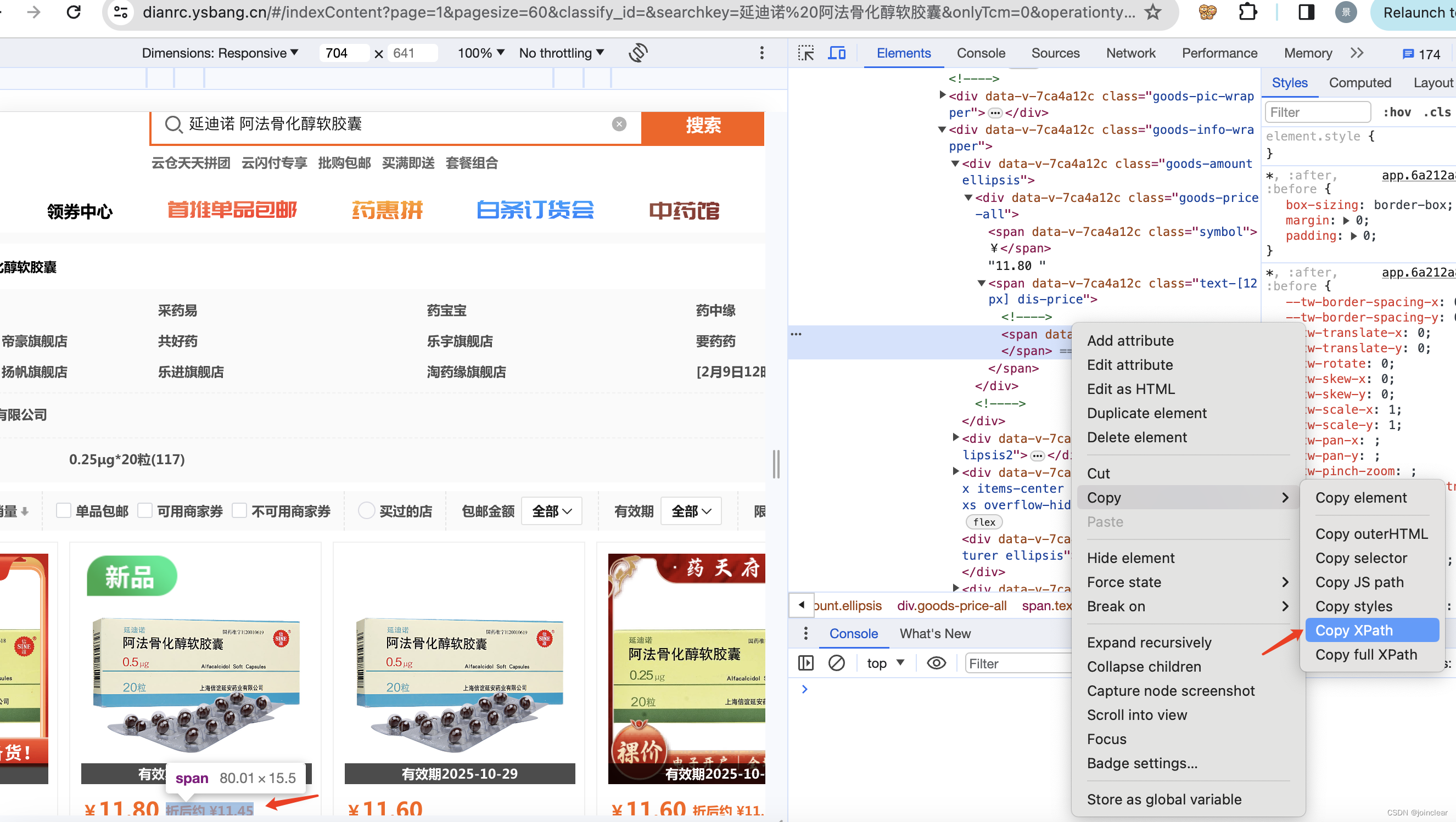

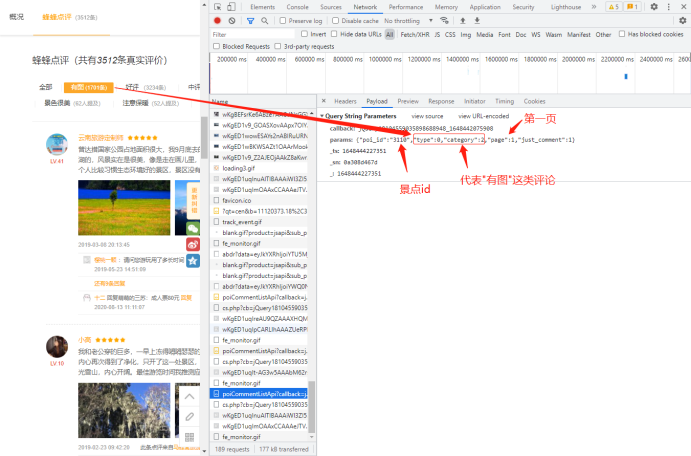

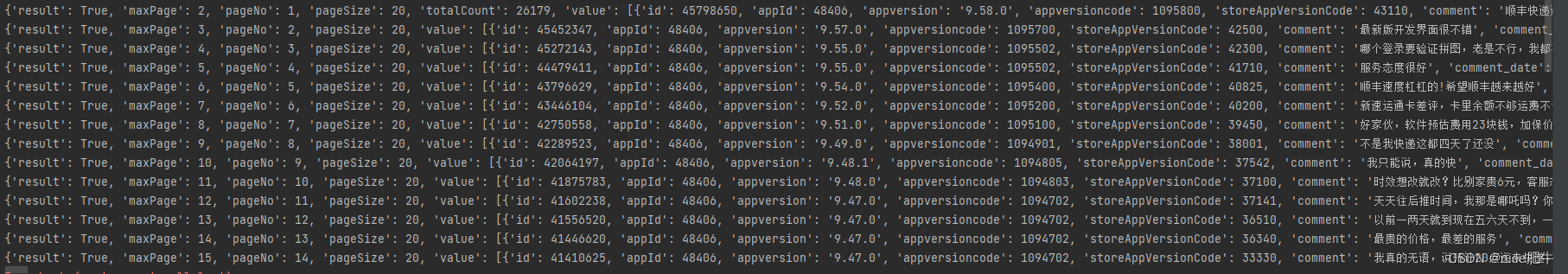

python json 爬京东商品评论

目标:爬京东任意商品评论

一、首先打开京东任意商品的评论1、我用的是QQ浏览器,右击检查,在Network下选择JS,在搜索框里输入productPageComments(如果出不来记得F5刷新一下)

如图:

2、双击productPageComments会得到以…

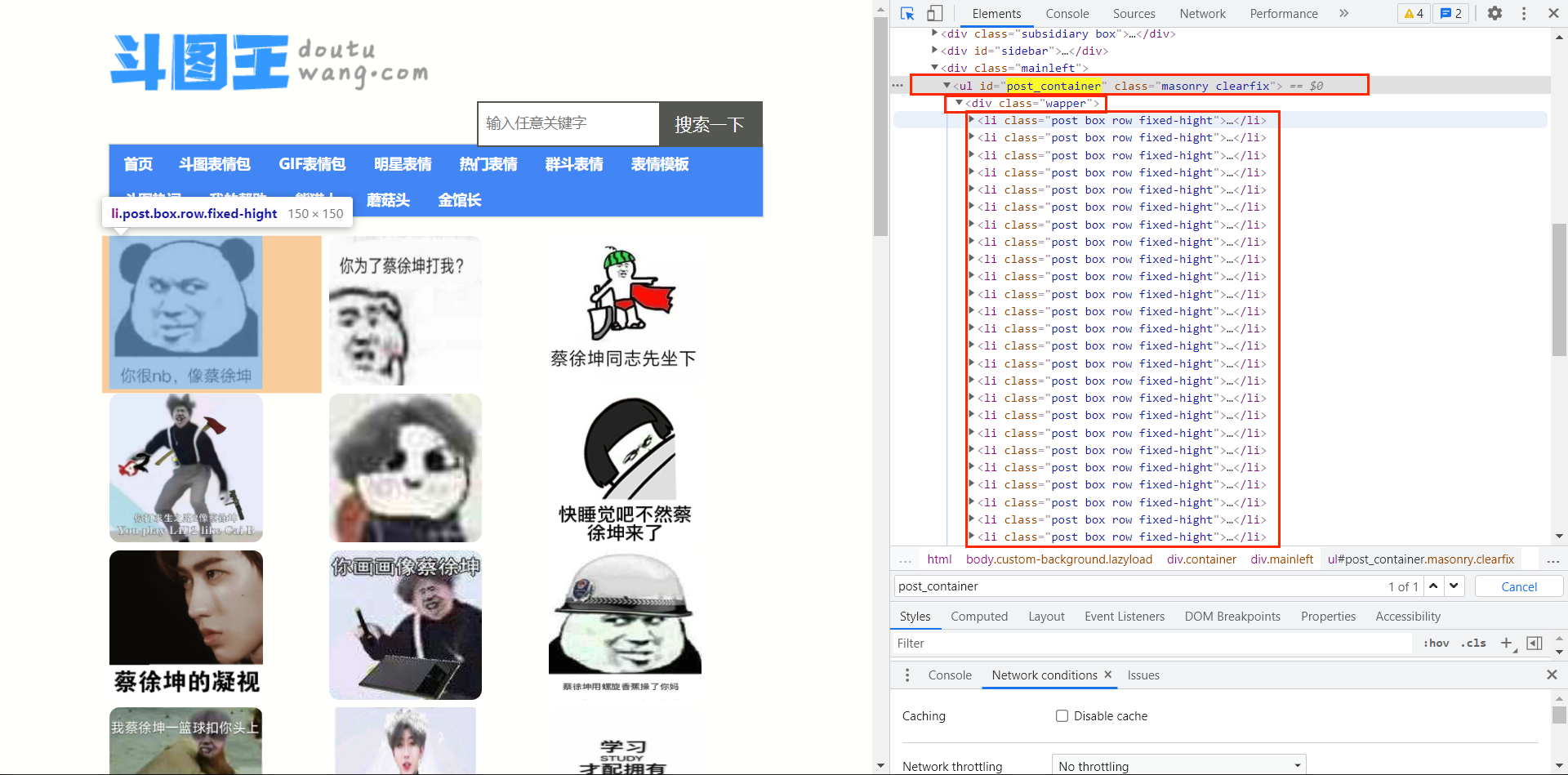

python能做的100件事03 - 爬虫

文章目录1. scrapy介绍2 新建爬虫项目3 新建蜘蛛文件4 运行爬虫5 爬取内容5.1分析网页结构5.2 关于Xpath解析5.3 接着解析电影数据5.4 下载缩略图5.5 完整代码6 最后说明7 2023.01.23更新7.1 关于分页7.1.1 第一种是类似烂番茄网这样底部只有一个load more按钮的。每次单击这个…

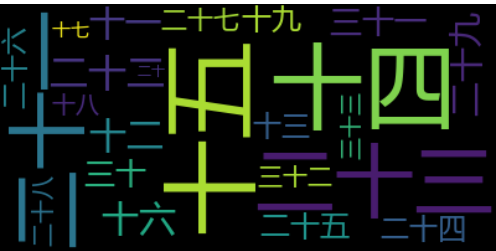

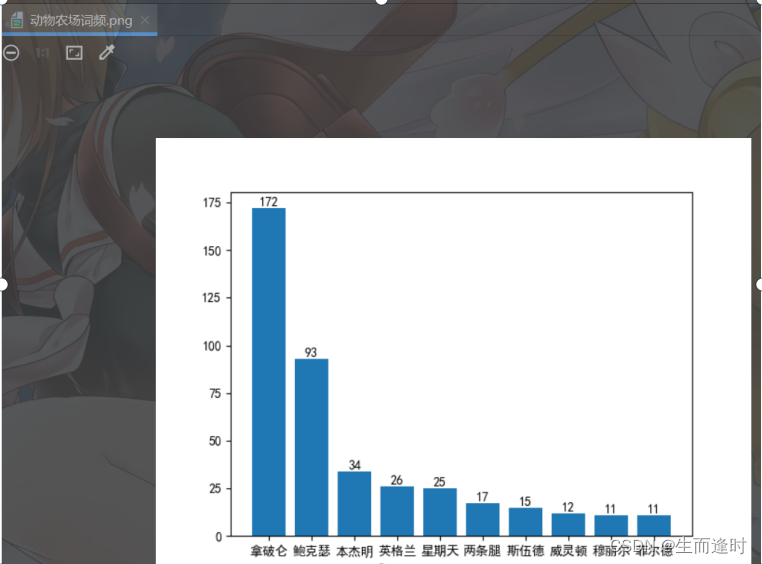

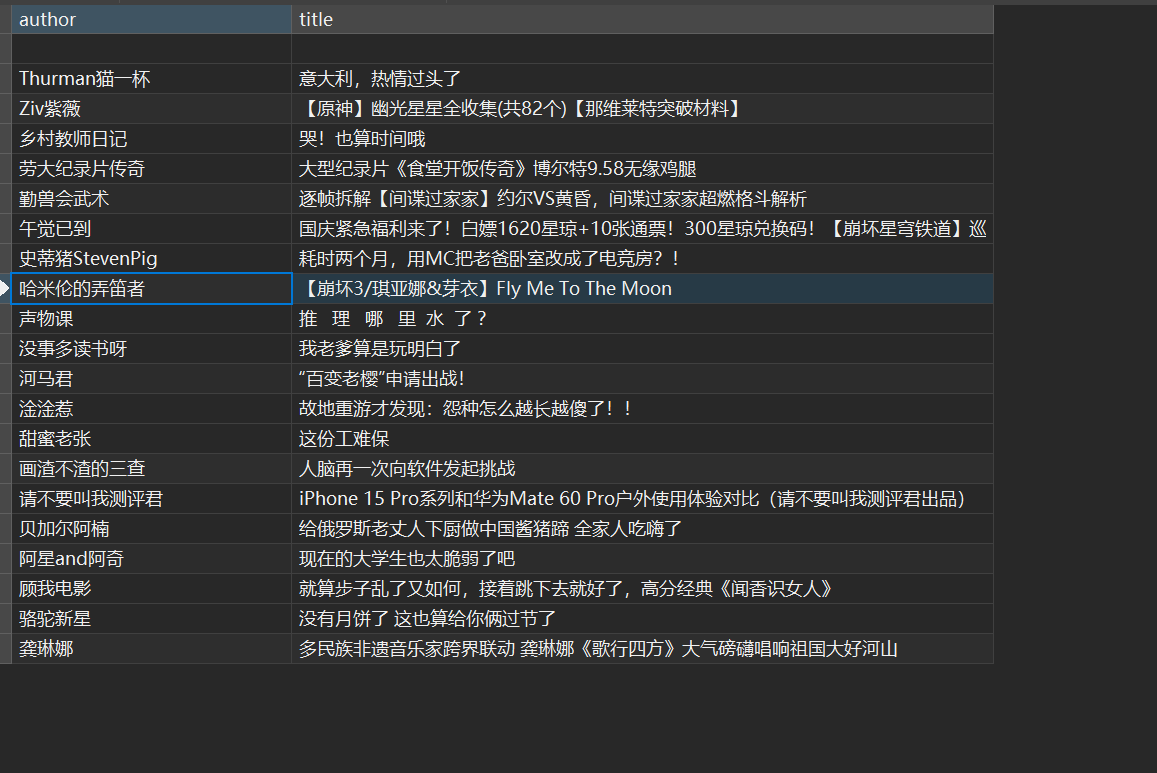

写给我无聊看的,python爬取CSDN博客标题和摘要出现的最多字,我都不知道我想干什么

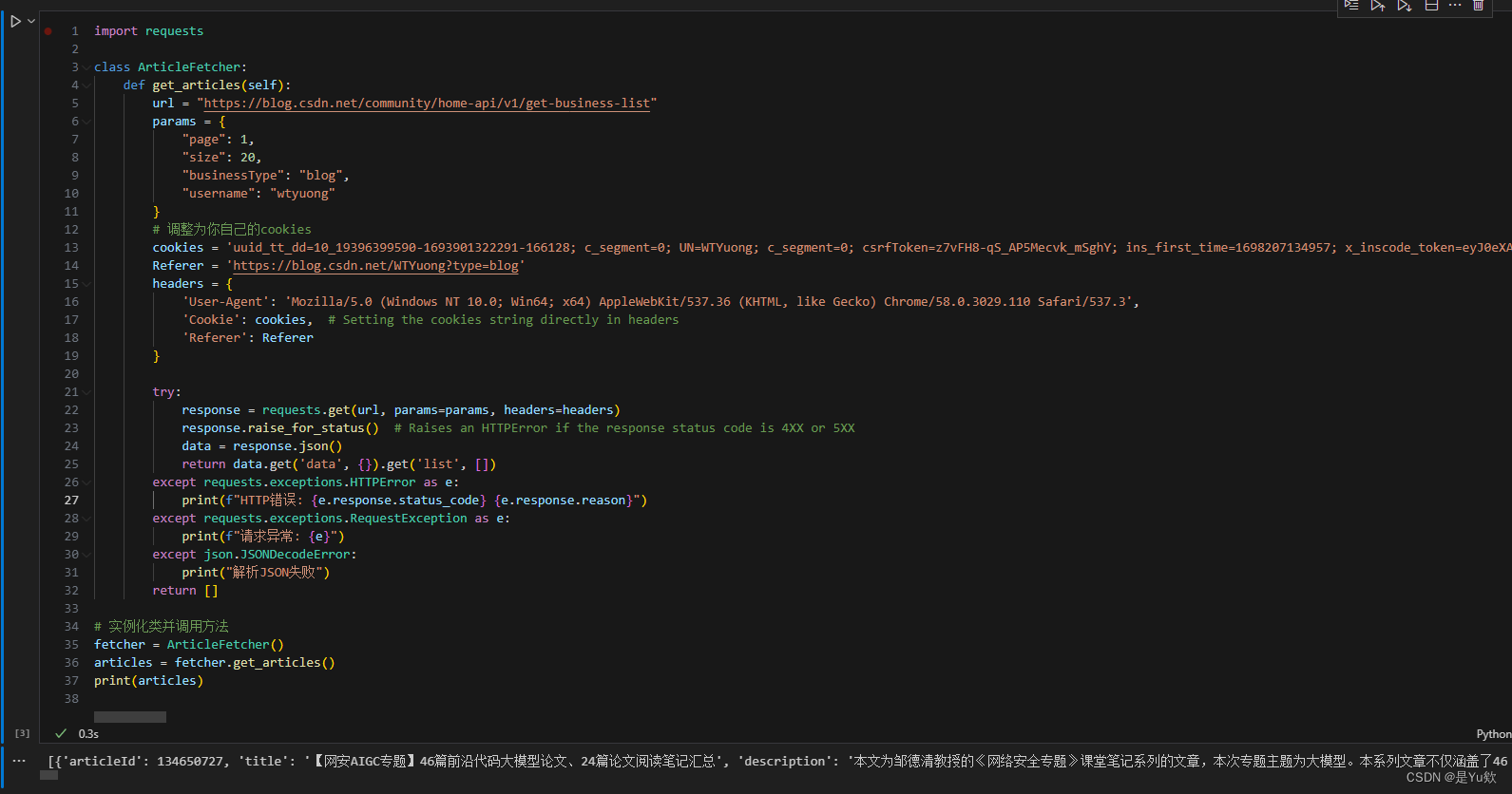

一、分析网页

这个网站是动态加载的数据,我们不墨迹,直接抓包 https://blog.csdn.net/community/home-api/v1/get-business-list?page1&size20&businessTypelately&noMorefalse&usernameYxh666https://blog.csdn.net/community/home-a…

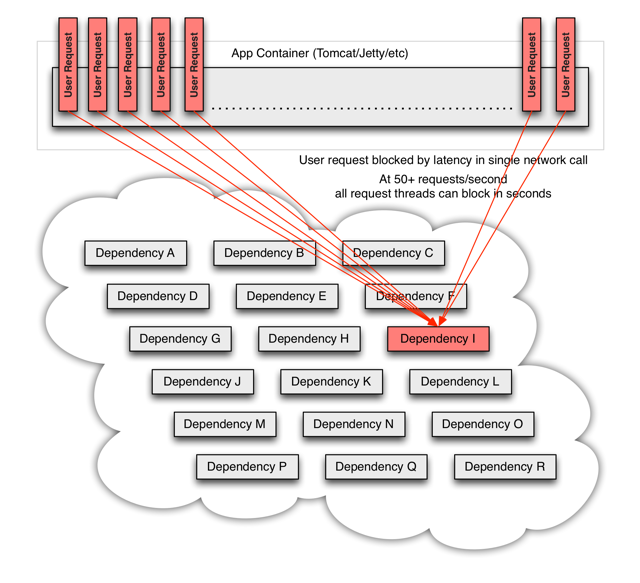

架构设计之防止或缓解雪崩效应

熔断 当某个服务调用慢或者有大量超时现象(过载),系统停止后续针对该服务的调用而直接返回,直至情况好转才恢复调用。这通常是为防止造成整个系统故障而采取的一种保护措施,也称过载保护。很多时候刚开始,可能只是出现了局部小规模…

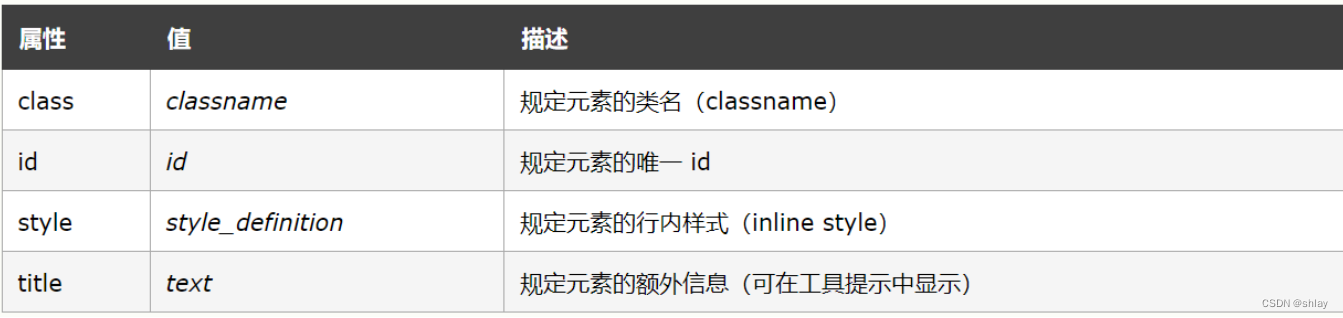

html meta标签使用及属性介绍

自学前端开始,我对meta标签接触不多,主要把精力都集中在能显示出来的标签上,比如span、button、h1等等。有时候去查看一些知名网站的源码,发现head标签里有一大摞的meta。 今天就来学习一下meta的用处,看看有些啥属性。…

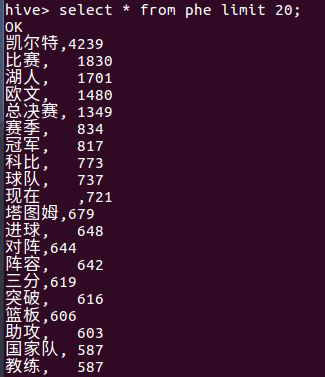

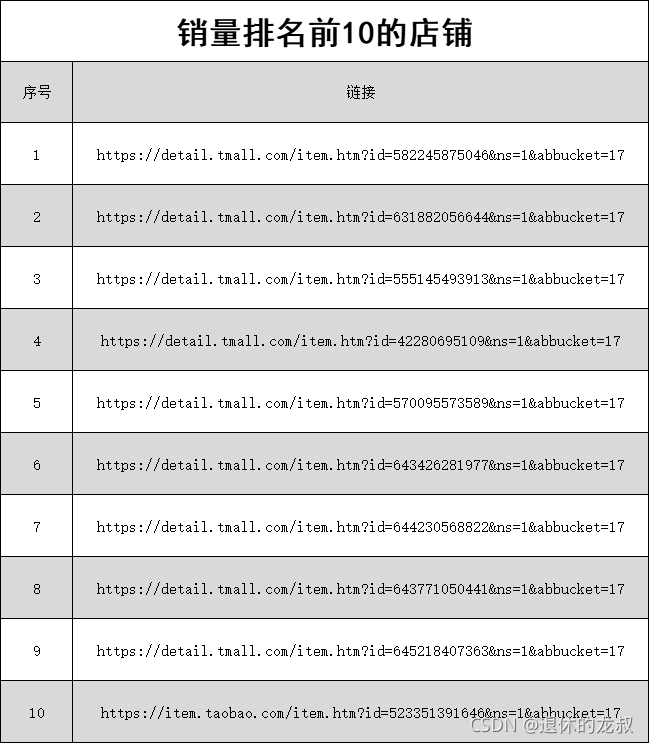

王者荣耀KPL秋季赛总决赛预测(AG VS DYG)

原文连接:https://zhuanlan.zhihu.com/p/337468137 这个一个很Nice的公众号,推荐给大家:Datawhale

用到的知识:爬虫数据分析

自己在在学了一段时间的爬虫和python数据分析之后,尝试了网上很多一些开源的项目&#x…

爬虫框架Scrapy(6)Spider Middleware 的用法

文章目录五. Spider Middleware 的用法1. 使用说明2. 核心方法五. Spider Middleware 的用法

Spider Middleware 是介入到 Scrapy 的 Spider 处理机制的钩子框架。当 Downloader 生成 Response 之后,Response 会被发送给 Spider,在发送给 Spider 之前&a…

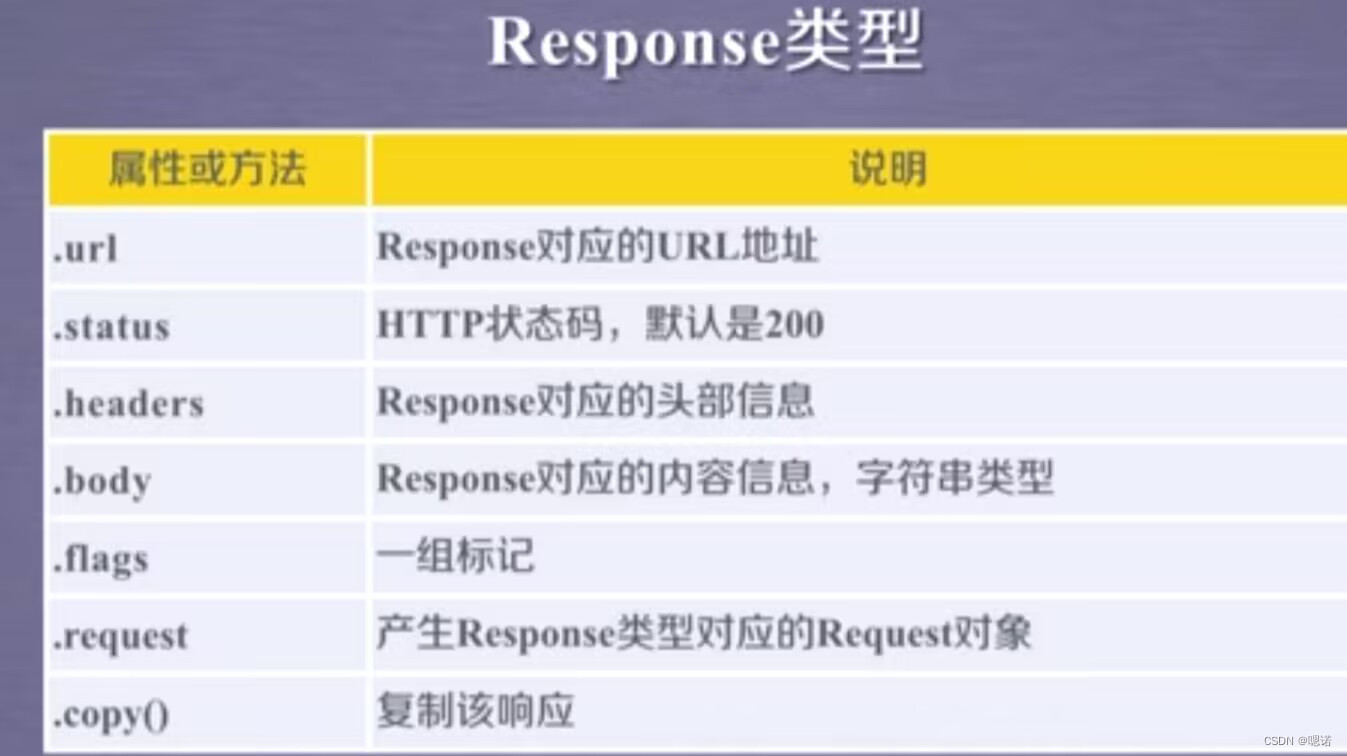

爬虫框架Scrapy(4)Spider的用法

文章目录一. Spider 的用法1. Spider 运行流程2. Spider 类分析二. 请求与响应1. Request 对象2. Response 对象一. Spider 的用法

在 Scrapy 中,要抓取网站的链接配置、抓取逻辑、解析逻辑里其实都是在 Spider 中配置的。本节我们就专门了解一下 Spider 的基本用法…

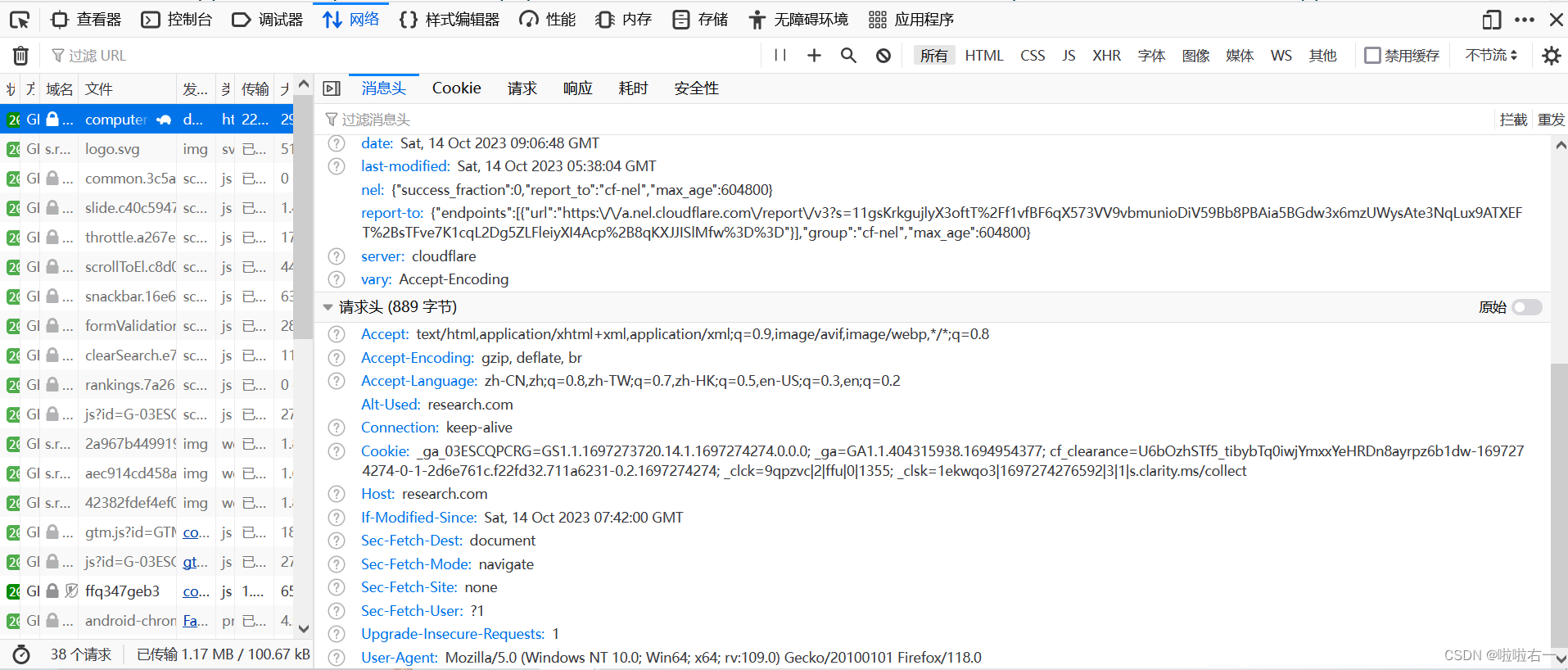

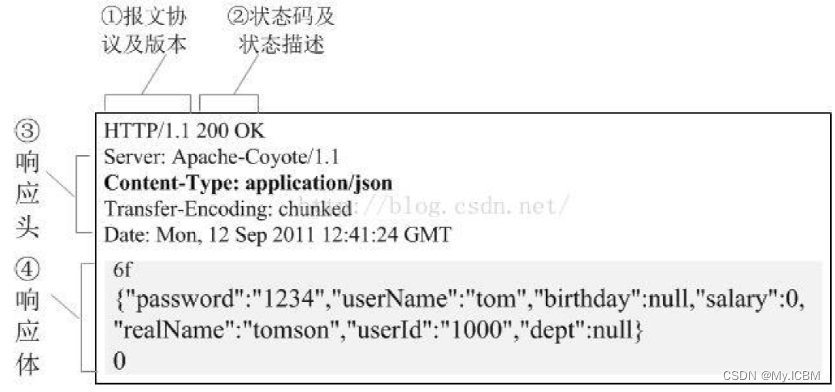

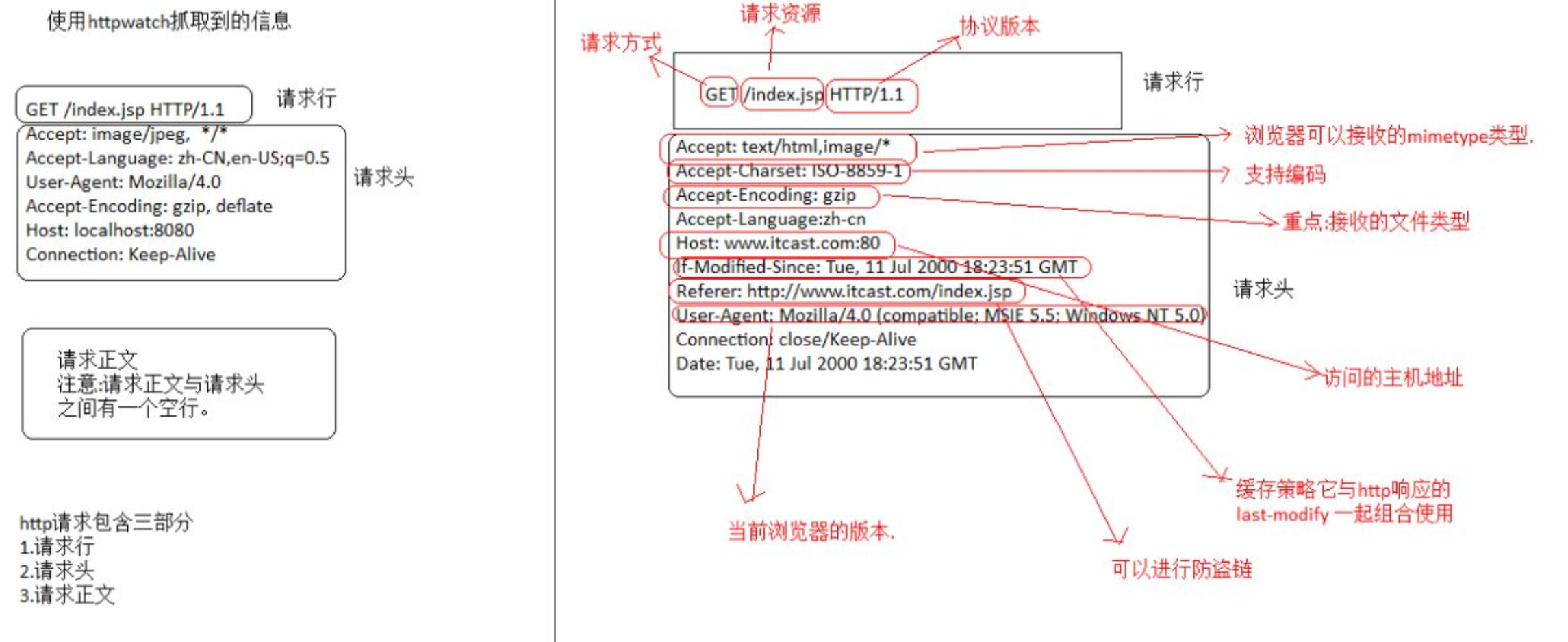

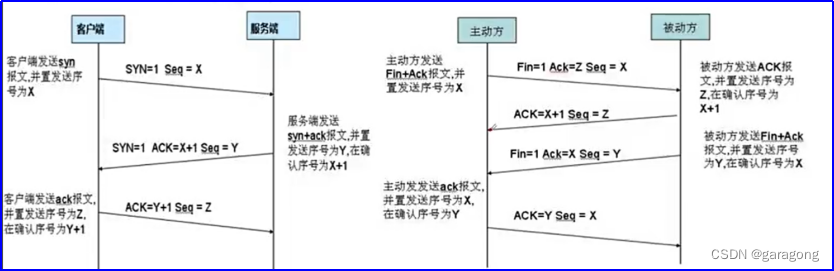

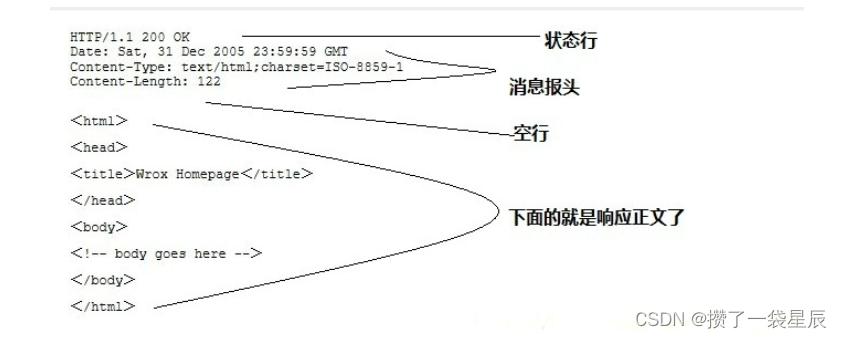

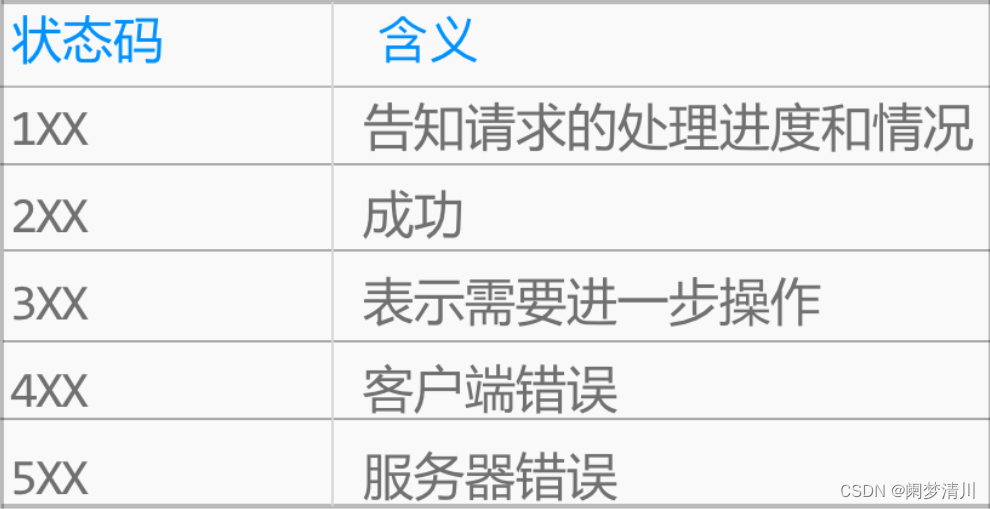

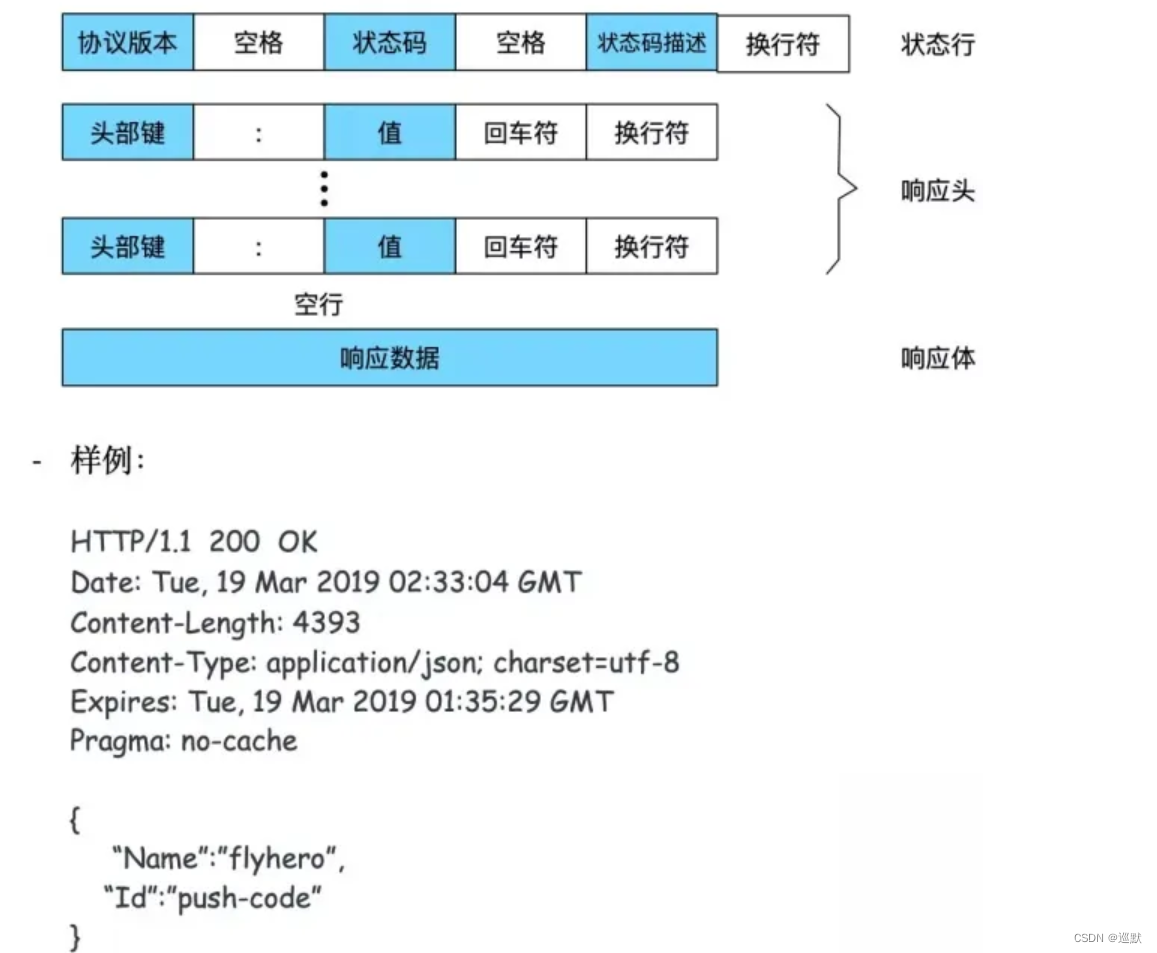

爬虫基础(2)网络爬虫的实现原理与技术

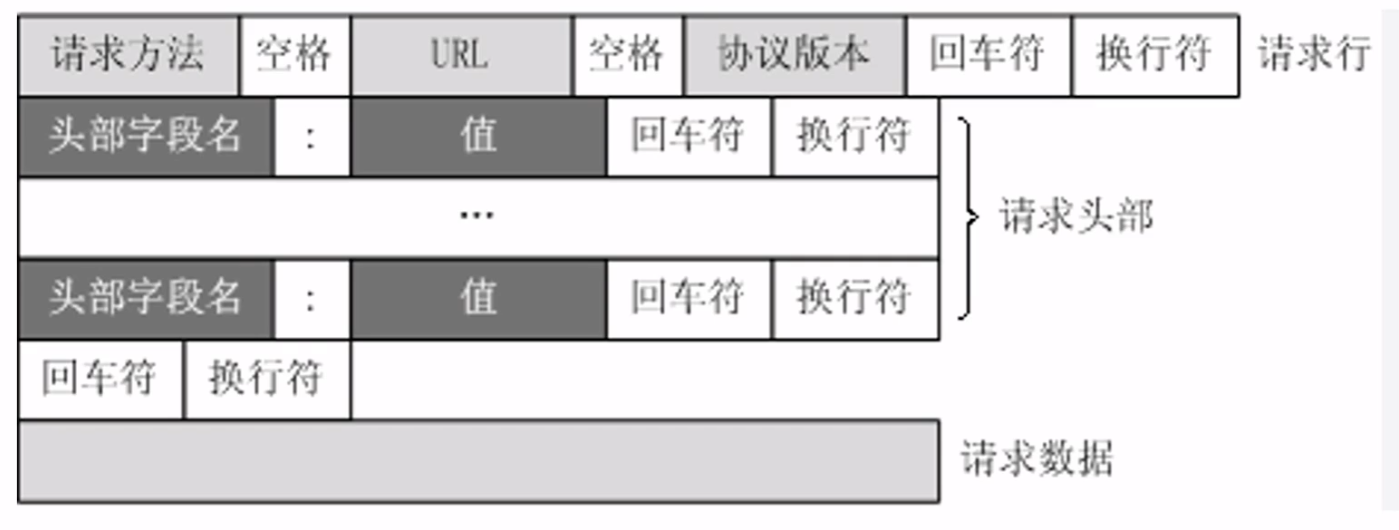

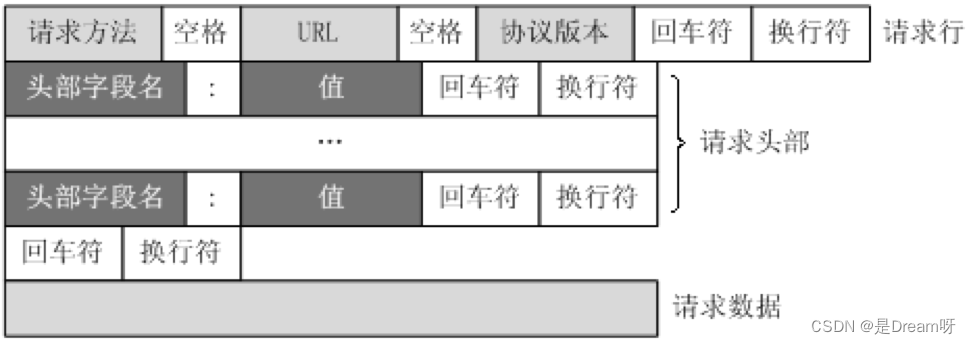

文章目录一. 爬虫技术实现原理二. 发送请求1. 请求行2. 请求头3. 空行4. 请求体三. 获取响应内容1. 响应行2. 响应头3. 空行4. 响应体四. 解析网页内容1. 提取链接2. 提取资源一. 爬虫技术实现原理

Web网络爬虫系统的功能是下载网页数据,为搜索引擎系统提供数据来源…

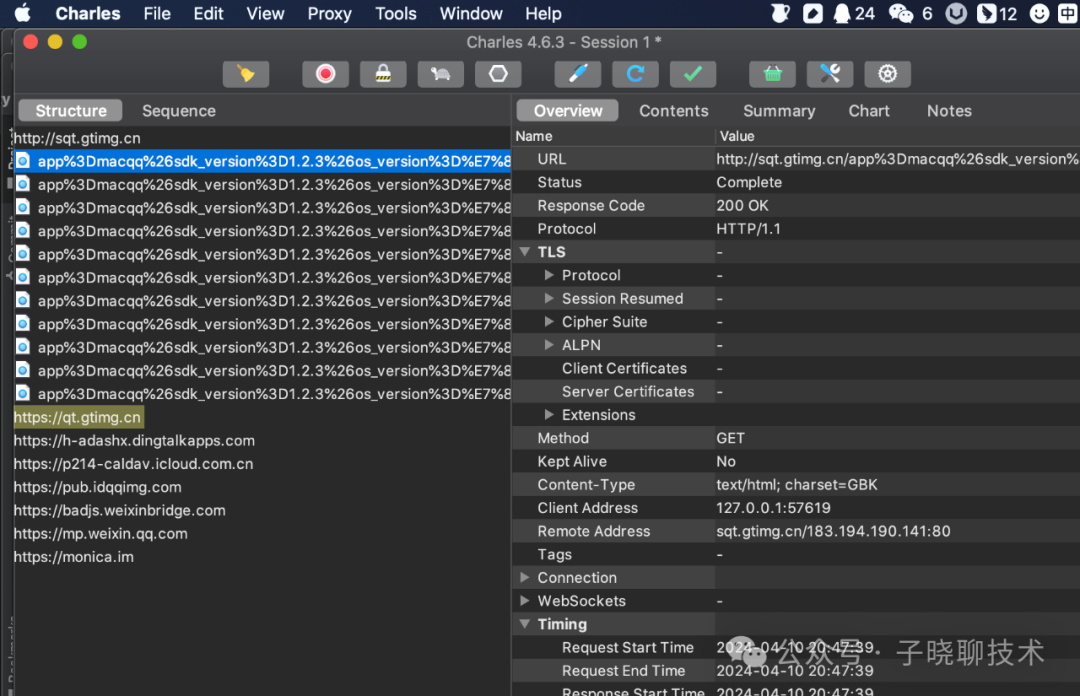

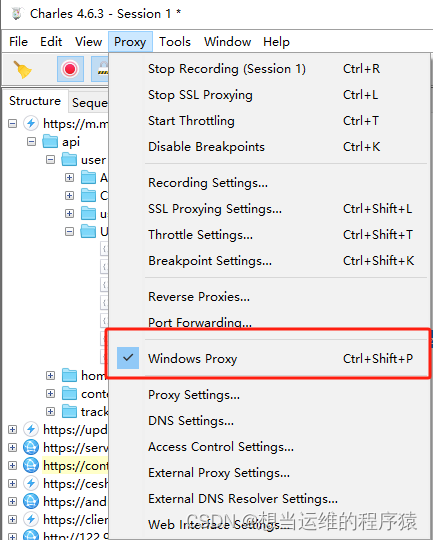

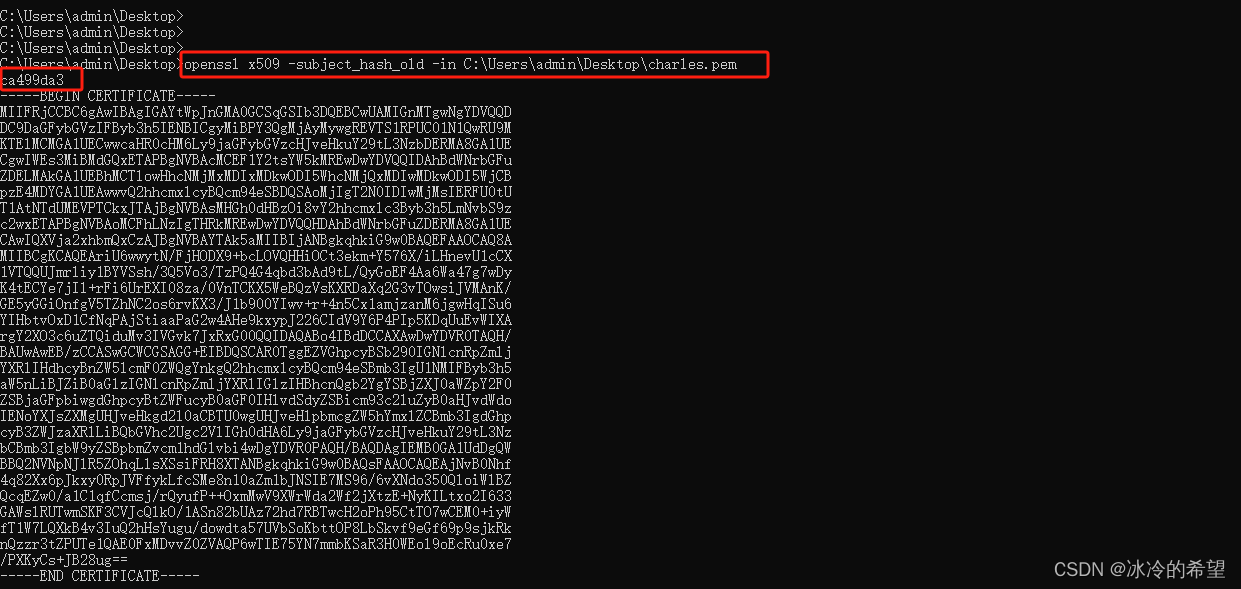

使用Python爬取公号文章(上)

阅读文本大概需要 10 分钟。01 抓取目标场景:有时候我们想爬取某个大 V 的发布的全部的文章进行学习或者分析。这个爬虫任务我们需要借助「 Charles 」这个抓包工具,设置好手机代理 IP 去请求某个页面,通过分析,模拟请求ÿ…

java爬虫简单实现

以下为源码 package WebSpider;import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.MalformedURLException;

import java.net.URL;

import java.nio.charset.Charset;

import java.util.regex.Matcher;

import ja…

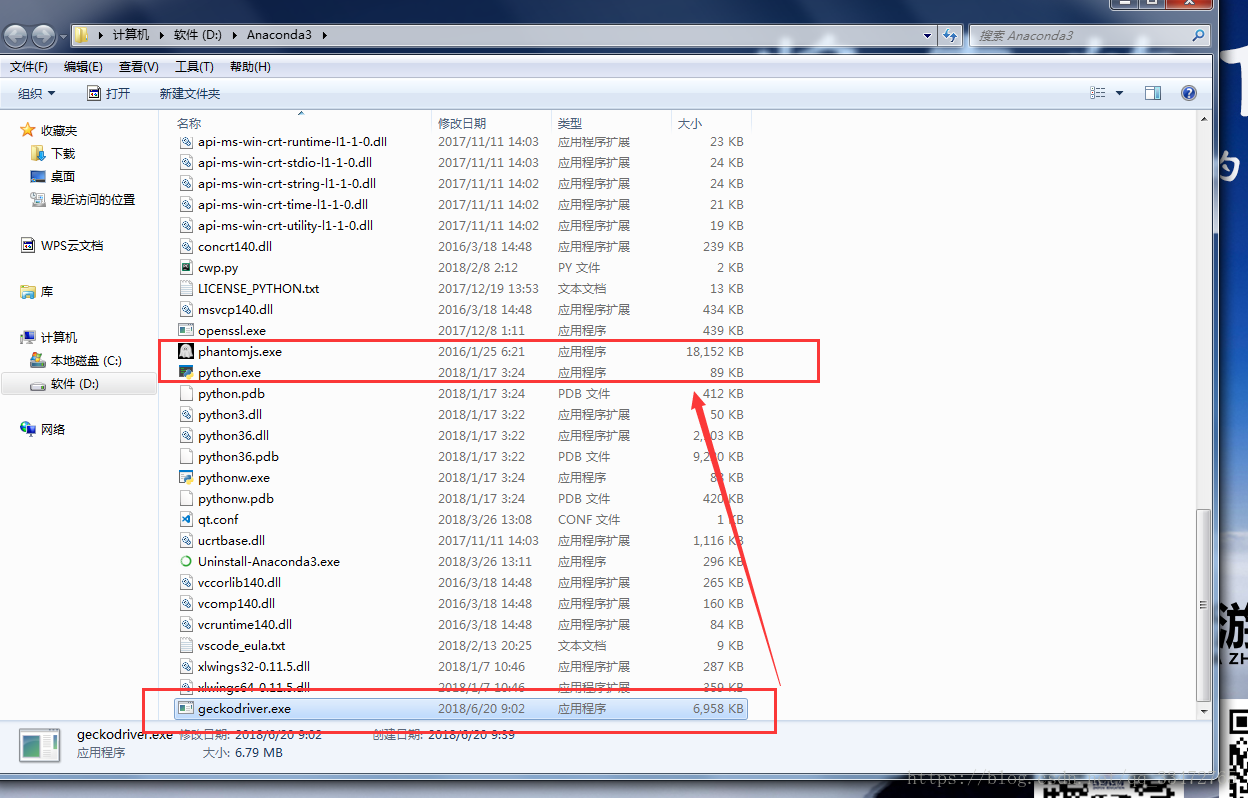

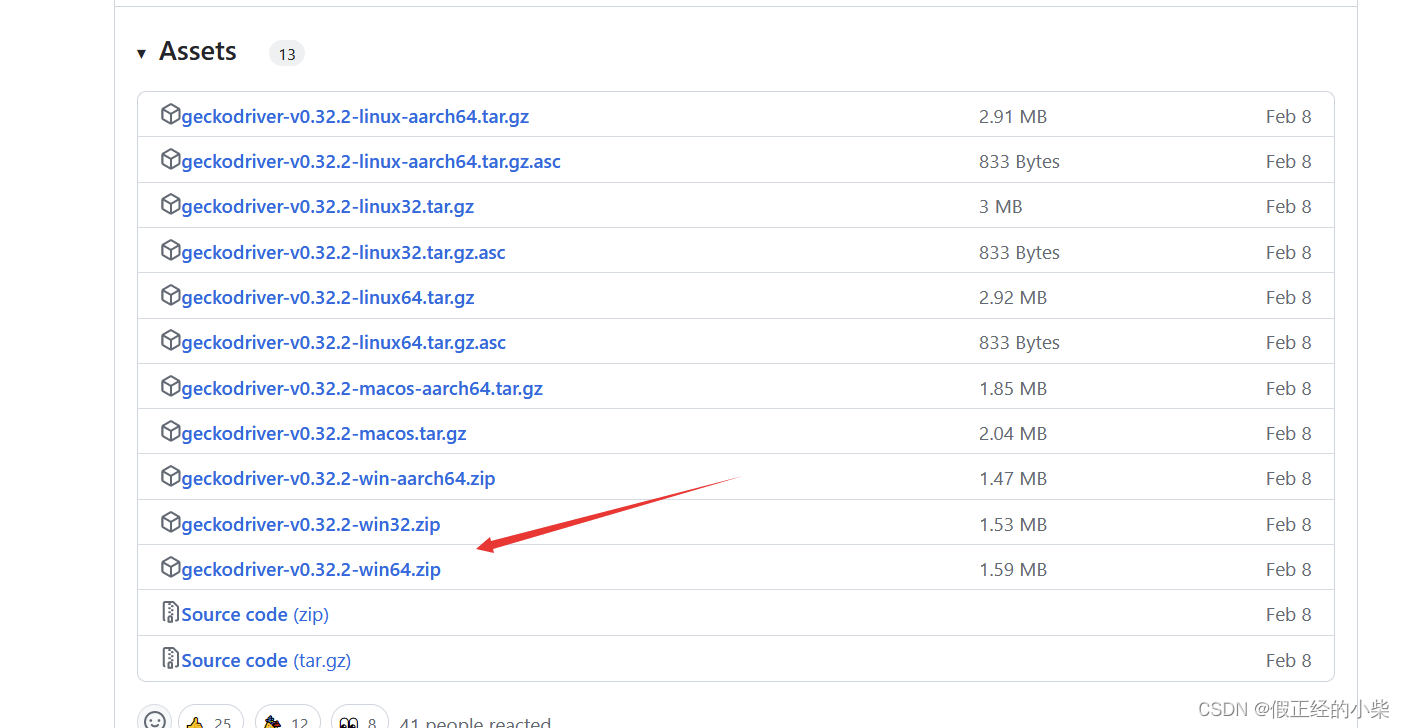

geckodriver的下载、安装与配置

1、下载geckodriver压缩包

链接:https://pan.baidu.com/s/1u8_lFbCWSc3Bux2Win0v-Q 提取码:2677

下载好后的geckodriver压缩包:

2、解压geckodriver

将1中下载好的geckodriver压缩包解压得到exe文件:

3、将2中得到的exe文件…

Python学习教程_Python学习路线_Python学习视频:爬虫的概念和工作原理

Python学习教程_Python学习路线_Python学习视频:爬虫的概念和工作原理众所周知,随着计算机、互联网、物联网、云计算等网络技术的风起云涌,网络上的信息呈爆炸式增长。毋庸置疑,互联网上的信息几乎囊括了社会、文化、政治、经济、…

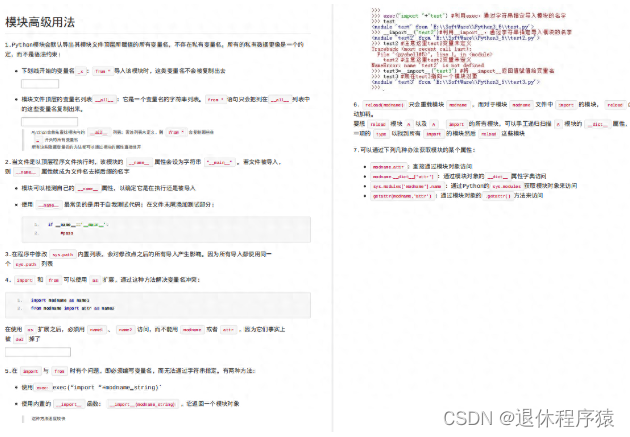

Python基础04-模块

什么是模块 模块的导入 自定义模块 什么是模块 Python模块:函数的升级版,多个函数组合在一起,按照统一类别的函数放到一块,成为,模块! 例如:爬虫相关的函数可以组成一个模块 Python 系统自带的模…

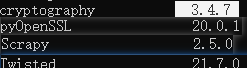

scrapy爬虫错误记录

相关包的版本

twisted.internet.error.TCPTimedOutError: TCP connection timed out: 10060: 由于连接方在一段时间后没有正确答复或连接的主机没有反应,连接尝试失败

原因:被检测到为爬虫 解决:爬虫时间设置为白天

[<twisted.python.…

Java --Serializable序列化

前阵子不知道做的哪家的笔试题,选择题有这个序列化的问题,当时一脸懵逼,似乎平时都没有用到过。现在有空,就把这个知识补一补吧。 序列化,是让我们有可能在程序不运行的时候,存在并保存对象的信息。等到下一…

读书笔记--精通CSS高级Web标准解决方案(五)---链接样式

这部分和上一节的内容类似,都是提供一些常用的CSS实践。 一、对链接应用样式 1、对于链接简单的处理方式,一般是应用CSS伪类来让链接在各种状态下表现,用到的伪类基本如下: a:link:未被访问到; a:visited&a…

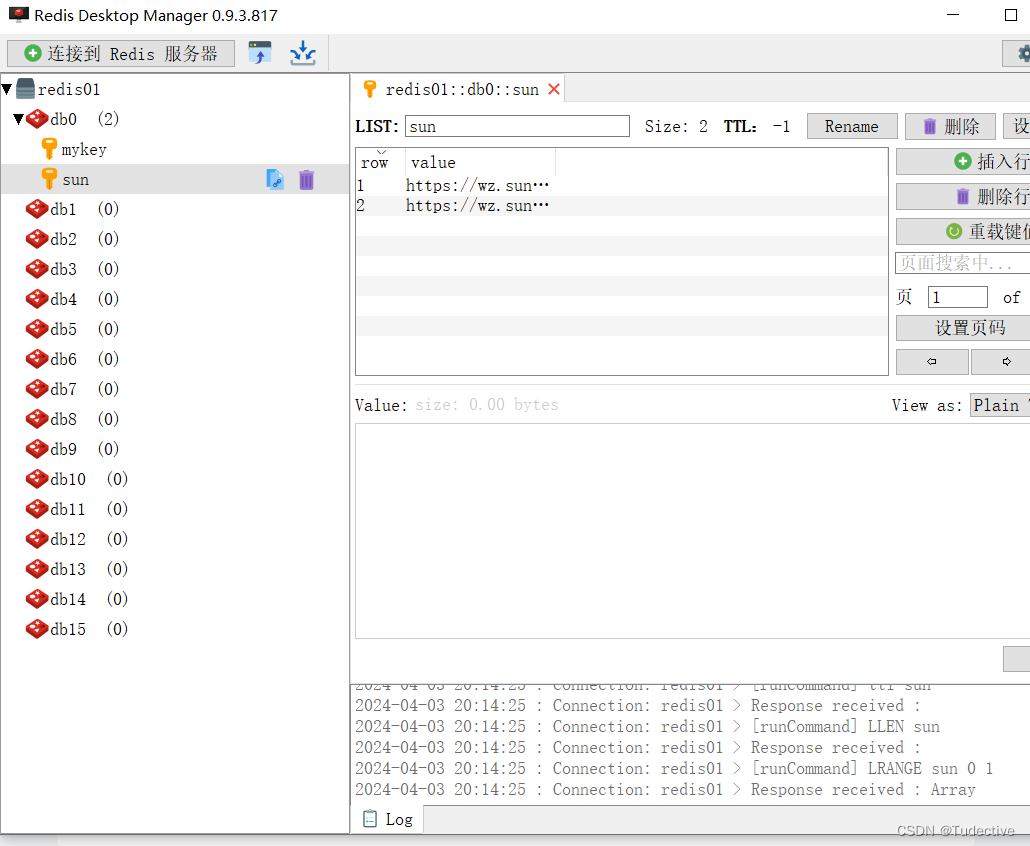

爬虫mysql,redis重新连接和关闭连接

报错 pymysql.err.InterfaceError: (0, ) 在python 的多线程里 同时使用一个MySQL链接导致的----要把mysql数据库连接放入函数中! #使用多线程等,切忌全局变量 conn"127.0.0.1", user"root",password"123", database"…

文字太多?控件太小?试试 TextView 的新特性 Autosizing 吧!

Hi,大家好,我是承香墨影! Android 8.0 已经发布了有一阵子了,如果你有在关注它,你应该会知道它新增了一个对于 TextView 字体大小变动的新特性:Autosizing。 本身这个新特性,如果只是在 Android…

OWASP A2 XSS跨站脚本

OWASP A2 XSS跨站脚本

一.什么叫xss

XSS叫做跨站脚本攻击,网站页面对于用户输入的内容过滤不严格,导致恶意代码被植入网站,也属于注入攻击,常见危害盗取用户cookie,session劫持攻击,钓鱼攻击等。

二.XSS…

【Java爬虫】学爬虫从简单的开始,无门槛小白都能学会,带你爬取豆瓣电影Top250

闲扯几句

大家好,本期我准备了一篇爬虫的教程,也是从最基础的网页爬虫开始,给大家讲讲网页爬虫的小技巧。

看到网上很多的爬虫代码都是基于python的,那作为一名Java工程师的我就有点不服气了,Java难道不能做爬虫吗&a…

记一次scrapy无法下载图片,提示 [scrapy.middleware] WARNING:XXXX ImagesPipeline requires

今天在测试scrapy爬取糗事百科的图片,检查了几遍代码啥的都没问题,但是一直无法进行图片下载,后面查看打印的信息,发现提示: [scrapy.middleware] WARNING: Disabled QiubaiPicPipeline: ImagesPipeline requires installing Pill…

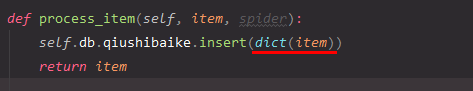

解决scrapy爬虫报错 pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection

scrapy爬虫报错内容 pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }, full error: {‘index’: 0, ‘code’: 11000, ‘keyPattern’: {’_id’: 1}…

Python3 selenium获取起点收藏榜单Top100并解析字体加密

1、爬虫简介 使用selenium模块获取起点中文作品书架作品排行,并打印相关的排行信息。 2、站点分析

需要爬取的内容

VIP收藏榜共5页,每一页展示的有20条排名数据,爬取完每一页的数据之后,自动点…

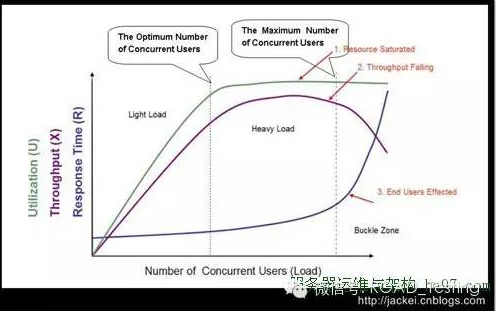

linux的dns缓存,NSCD服务

linux的dns缓存,NSCD服务这两天做压力测试的时候发现,用webbench压域名要比压ip地址慢好几倍,而且压域名的时候nginx并发量也很低.反复测试了好多遍,怀疑时间是花在dns解析上.在/etc/hosts中做手动解析:1echo "211.157.145.103 m.app518.com" >> /etc/hosts之后…

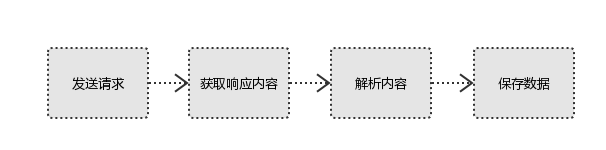

python网络爬虫之requests模块

什么是requests模块: requests模块是python中原生的基于网路请求的模块,其主要作用是用来模拟浏览器发送请求,功能强大,用法简洁高效,在爬虫的领域占半壁江山 如何使用requests模块: 安装:pip install requests 使用流程: 1.指定url 2.发送请求 3.获取数据 4.持久化存储 转载于…

Golang爬虫学习

2023年将会持续于B站、CSDN等各大平台更新,可加入粉丝群与博主交流:838681355,为了老板大G共同努力。 【商务合作请私信或进群联系群主】

一、golang-net/http包(正则)

1.1 简介和示例

导包:

import("fmt""io/ioutil"…

java代码编辑器 pdf文件预览 主流SSM 代码生成器 shrio redis websocket即时通讯

获取【下载地址】QQ: 313596790官网 http://www.fhadmin.org/A代码编辑器,在线模版编辑,仿开发工具编辑器,pdf在线预览,文件转换编码B 集成代码生成器[正反双向](单表、主表、明细表、树形表,快速开发利器)快速表单构建…

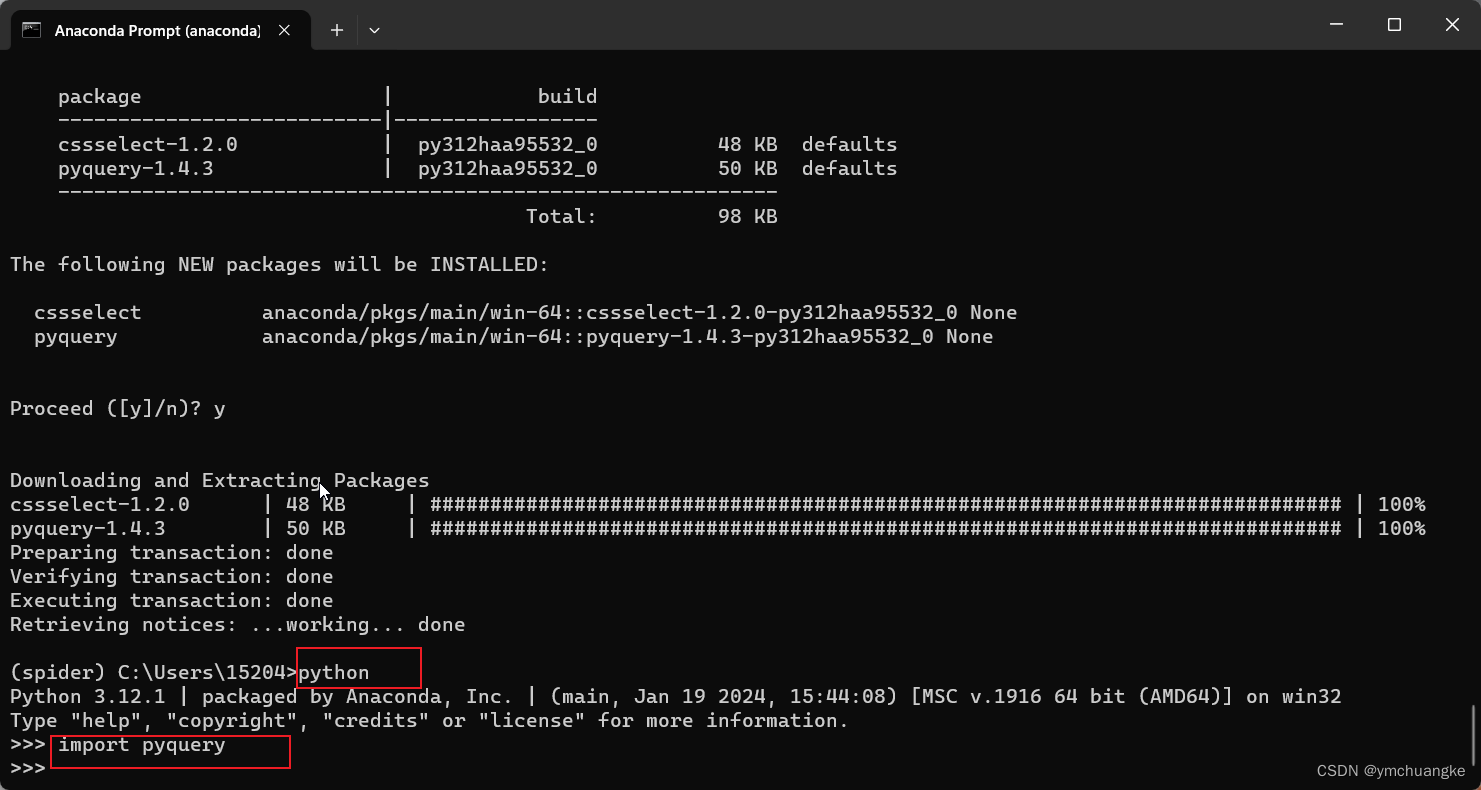

运维学python之爬虫工具篇(六)Pyquery的用法

1 简介 今天介绍的工具是Pyquery,没错,就是jquery的表哥,是用于python的jquery类库。pyquery允许您在xml文档上进行jquery查询。API类似于jquery。pyquery使用lxml进行快速xml和html操作。Pyquery官方文档jQuery中文在线手册 2 安装 pip安装 …

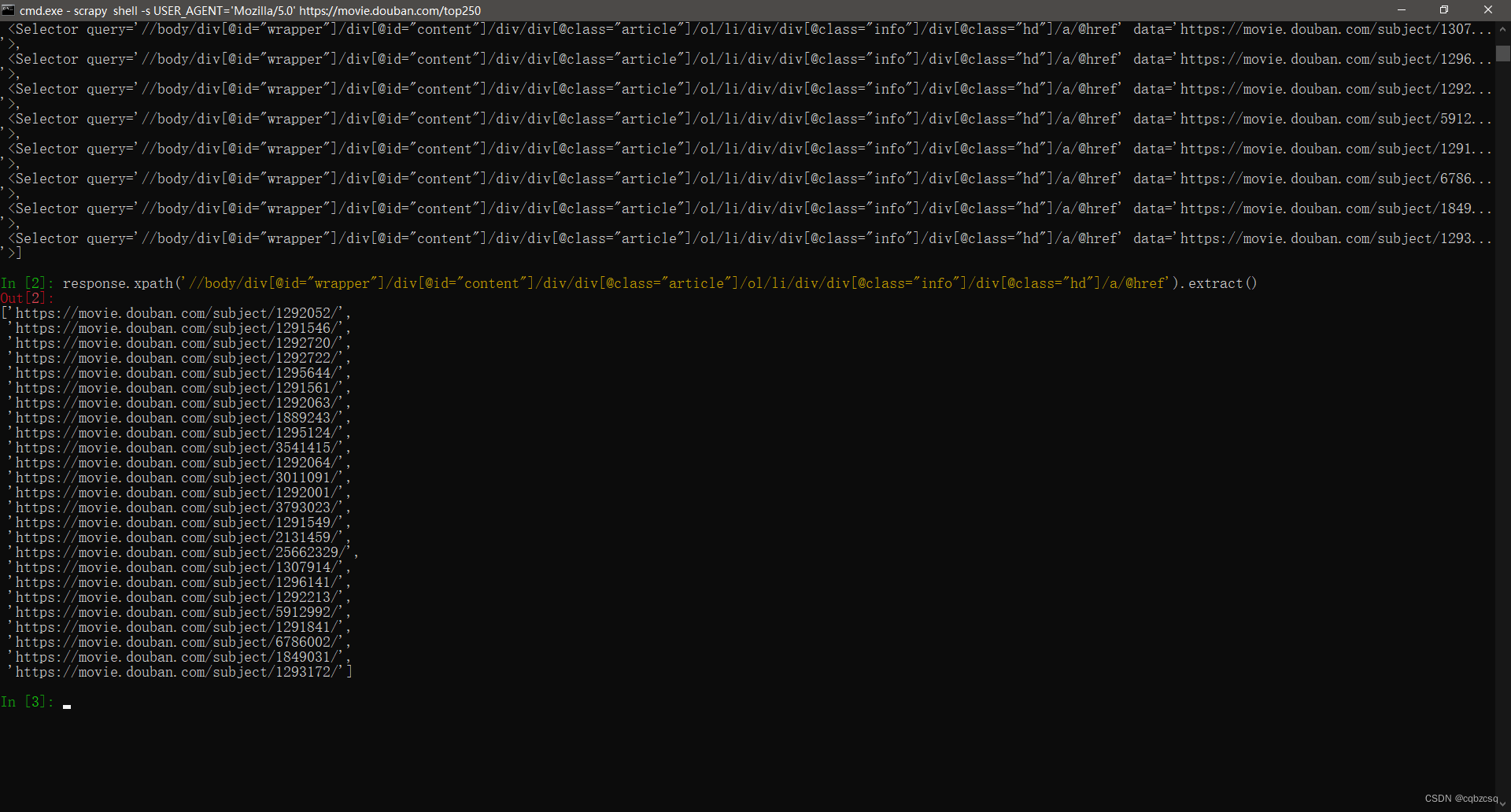

Scrapy中用xpath/css爬取豆瓣电影Top250:解决403HTTP status code is not handled or not allowed...

好吧,我又开始折腾豆瓣电影top250了,只是想试试各种方法,看看哪一种的方法效率是最好的,一直进行到这一步才知道 scrapy的强大,尤其是和selector结合之后,速度飞起。。。。 下面我就采用scrapy爬取豆瓣电影…

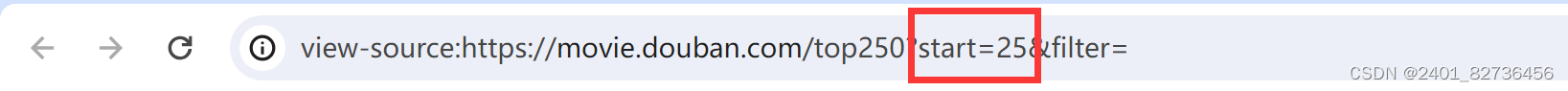

python爬虫获取豆瓣网前250部电影的详细信息

网址 https://movie.douban.com/top250 一共250部电影,有分页,获取每一部的详细信息 不采用框架,使用 urilib读取网页,re进行正则表达式匹配,lxml进行xpath查找 1 from film import *2 from urllib import request3 im…

Apache服务器的htaccess文件配置 rewrite/防盗链/屏蔽爬虫蜘蛛

Apache服务器的htaccess文件配置 rewrite/防盗链/屏蔽爬虫蜘蛛 htaccess是Apache服务器的一个配置文件,具有强大的功能,本文介绍如何编辑该文件,让网站实现封锁某国家IP网段、防止图片、文件盗链、保护主机下的目录与文件、创建自定义的出错页…

伪静态技术(SEO) 摘自:http://bbs.admin5.com/thread-8522290-1-1.html

参考:http://bbs.admin5.com/thread-8522290-1-1.html http://www.microsoft.com/web/spotlight/urlrewriter/ 伪静态技术1、静态网页与动态比较: 1)静态网页: 优势:A、 对搜索引擎友好,被收录的质量高…

网站建设与关键词http://www.360seo.cn/

http://www.360seo.cn/网站建设的整个过程中,从网站的规划到网站优化最终的设计都应考虑到seo的问题,不能到了推广的时候才关注SEO知识,有些SEO知识在网站策划的时候就应该考虑到的,那么网页设计就应该把相关的优化建议作为网站开…

遇到的反爬虫策略以及解决方法?

通过headers反爬虫:自定义headers,添加网页中的headers数据。基于用户行为的反爬虫(封IP):可以使用多个代理IP爬取或者将爬取的频率降低。动态网页反爬虫(JS或者Ajax请求数据):动态网页可以使用 selenium phantomjs 抓取。对部分…

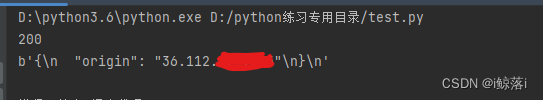

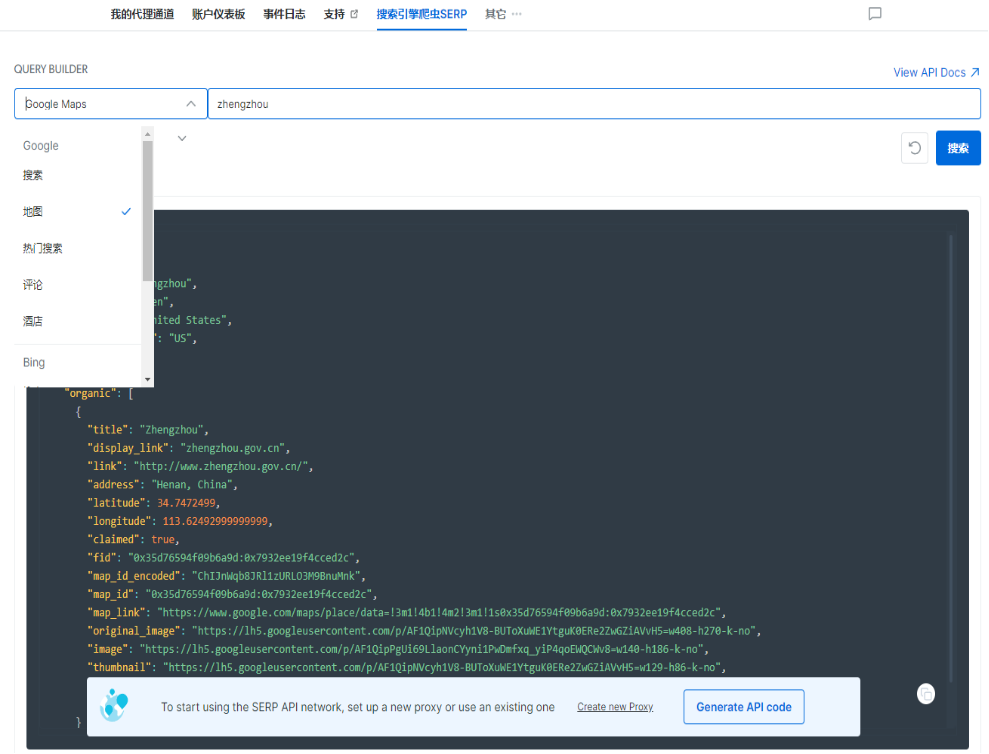

python获取地图坐标数据并存入数据库

需求: 需要爬取到浙江省各个县区的边界的geo数据,用于后续前端绘制地图使用。

解决方案: 1、找到浙江省各个县区的边界数据,这里从阿里云数据(阿里云地图数据可视化)中获取;2、编写爬虫脚本获取…

ChatGPT 和爬虫有什么区别?

ChatGPT是一种基于人工智能的对话模型,它通过训练大量的文本数据来生成自然语言回复。它可以用于实现智能对话系统,能够理解用户的输入并生成相应的回复。ChatGPT的目标是模拟人类对话,使得对话更加流畅和自然。

而爬虫是一种用于自动化地从…

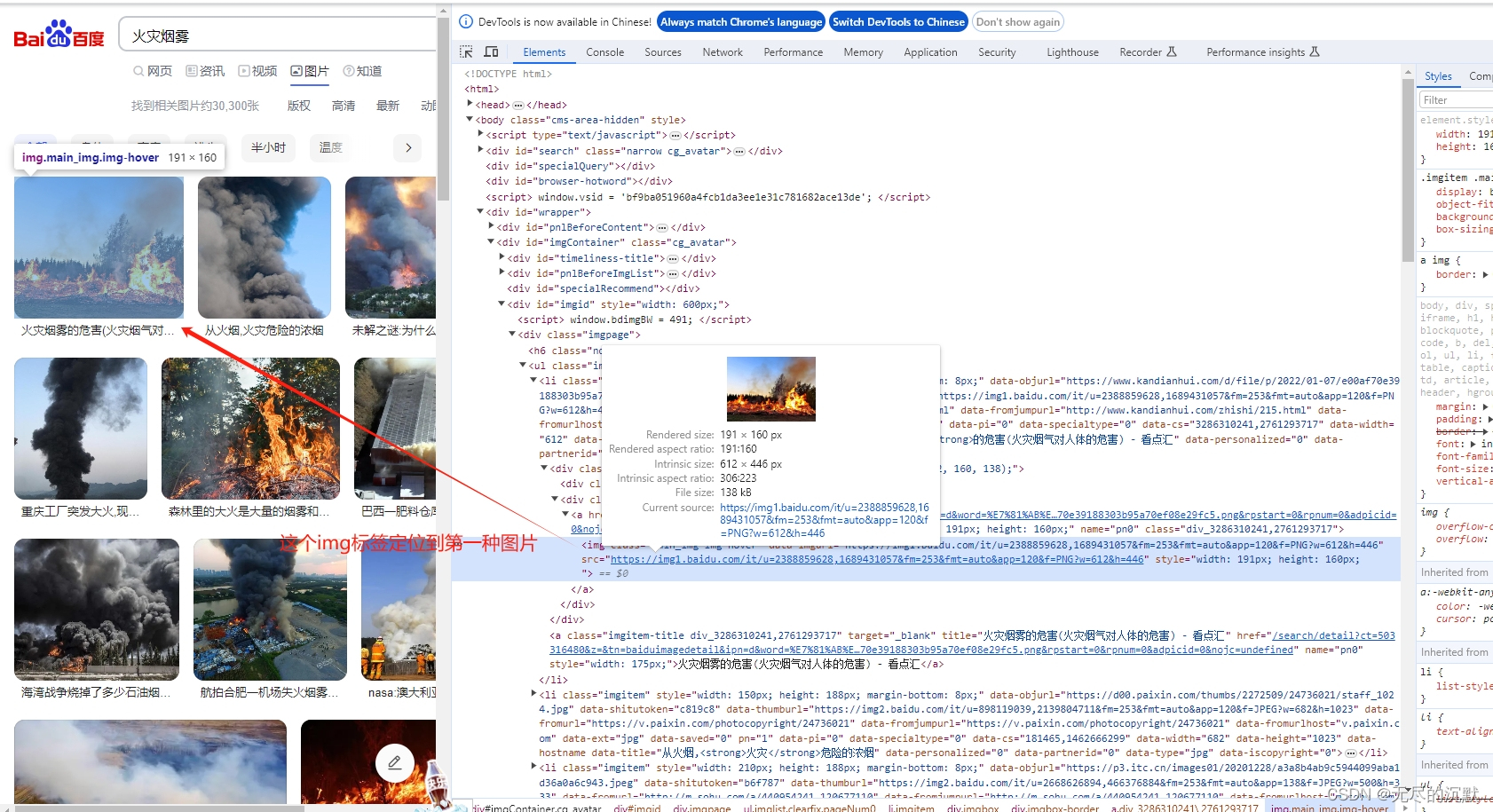

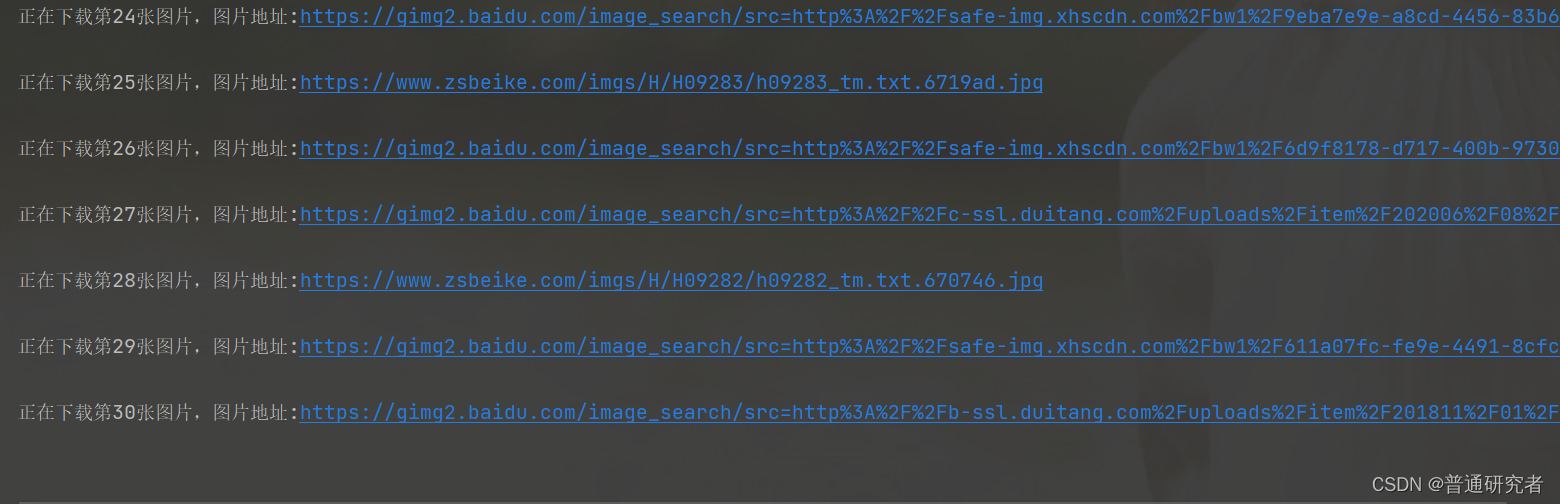

python爬虫爬取百度图片并保持到本地

python爬虫爬取百度图片并保持到本地

from selenium import webdriver

from selenium.webdriver.common.by import By

import time

from bs4 import BeautifulSoup# 配置ChromeDriver路径

#driver_path = ChromeDriver路径

driver=webdriver.Chrome()

# 创建Chrome浏览器实例

…

【java爬虫】使用selenium爬取优惠券

本文将介绍使用selenium爬取某宝优惠券的方法,之所以使用selenium是因为我不会js逆向,如果你已经参透了淘宝联盟的js逆向方法,那么直接使用接口调数据就行了。

使用selenium接管chrome浏览器

由于淘宝联盟需要先登录,为了避免每…

爬了个爬(一)爬虫入门

一、爬虫定义 网络爬虫:(又被称为网页蜘蛛,网络机器人,在FOFA社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动的抓取万维网信息的程序或者脚本。 URI(Uniform Reso…

HTTP Header 入门详解

为什么80%的码农都做不了架构师?>>> HTTP Header 入门详解(转真的不错) 什么是HTTP Headers HTTP是“Hypertext Transfer Protocol”的所写,整个www都在使用这种协定,几乎你在流览器里看到的大部分内容都是通过http协定来传输的…

Python爬虫——抓取糗百段子

在别人博客里学习的 抓取糗百段子,由于糗百不断的更新,代码需要改正。 抓取网页:http://www.qiushibaike.com/hot/page/1 修改后的代码如下: # -*- coding:utf-8 -*-import urllib

import urllib2

import re

import thread

import…

爬取奇迹秀工具箱里面的文本和软件网盘链接

1.爬取的网址:http://www.qijishow.com/down/index.html 2.完整代码展示

from selenium import webdriver

import timeurl http://www.qijishow.com/down/index.html

opt webdriver.ChromeOptions()

opt.add_argument("--headless")

driver webdrive…

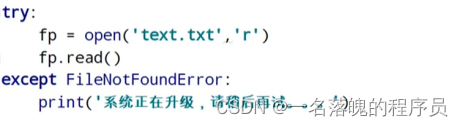

Python学习笔记--异常、模块与包

......待更新

(一) 了解异常 1. 异常 程序运行的过程中出现了错误 2. bug bug就是指异常的意思,因为历史是因为小虫子导致计算机失灵的案例,所以延续至今,bug就代表软件出现错误 (二) 异常的捕…

网络爬虫的原理是什么?

随着互联网的兴起,网络上的公开数据大多数都是以http(或加密的http即https)协议传输的。因此,我们将通过对爬虫技术的介绍并基于http(https)协议编写的爬虫教程供大家参考。

在Python的模块海洋里…

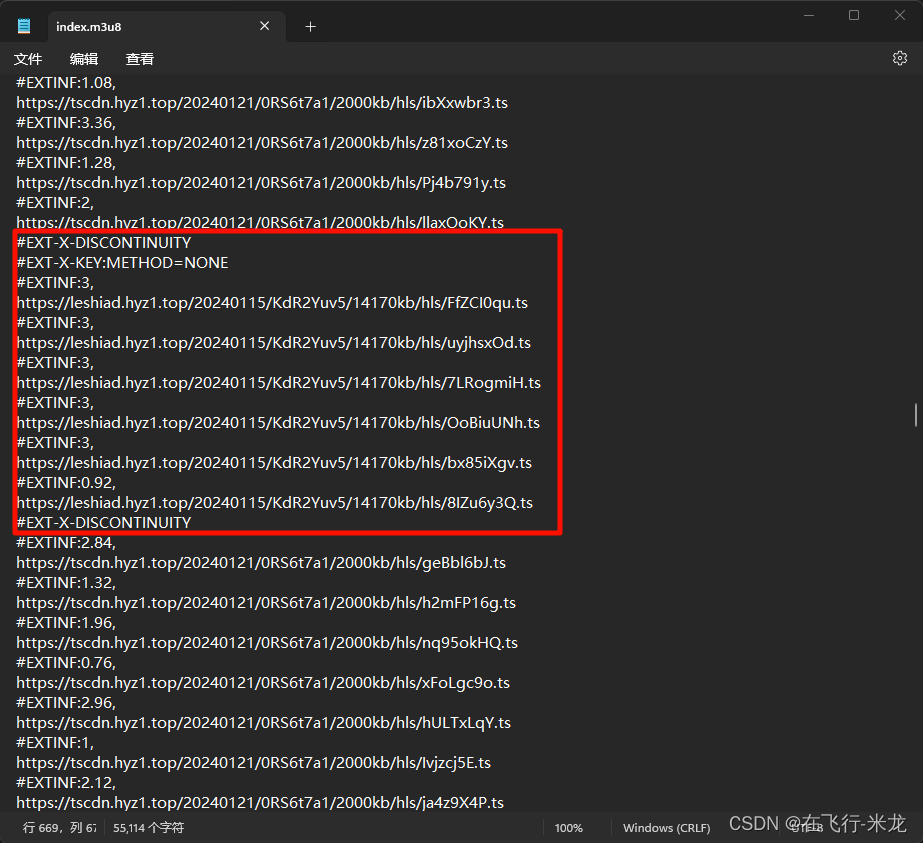

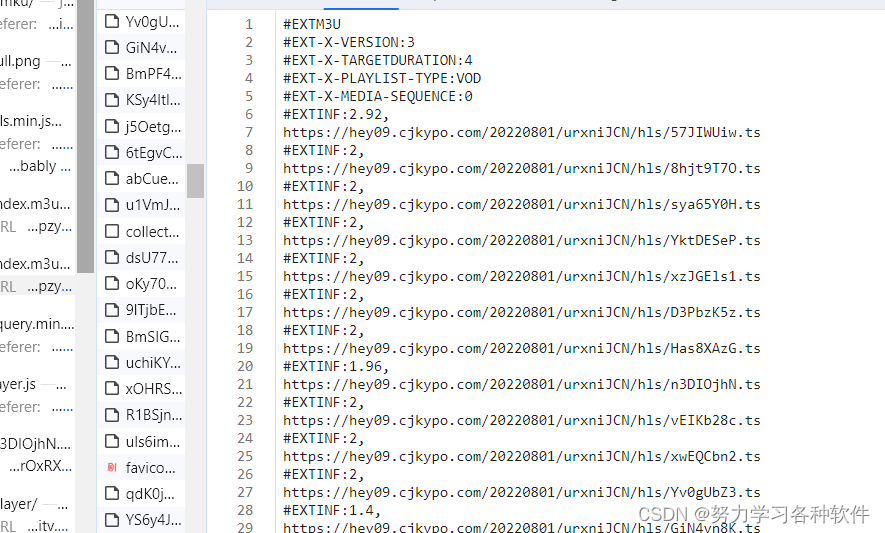

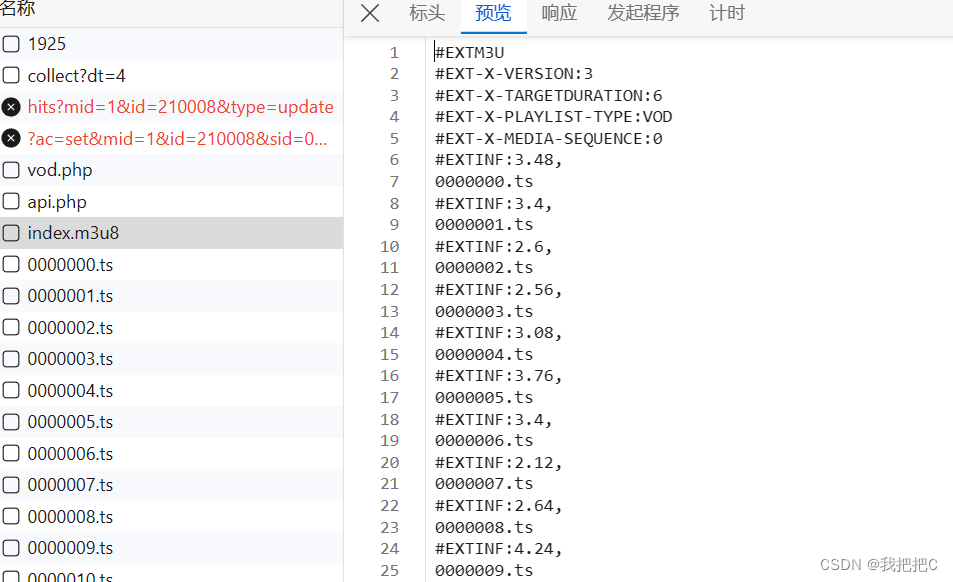

m3u8转mp4下载,有URL,IV

1、背景

在线m3u8现在是主流加密方式的视频。

2、下载m3u8视频难点

首先需要连接m3u8文件格式,这个自行百度,其次加密方式确定和key以及iv。如果没有加密直接找一个在线的m3u8转mp4就可以,但是问题就是很多带加密,而且key不是m3m8中key URL返回的数据,市面上软件无法直…

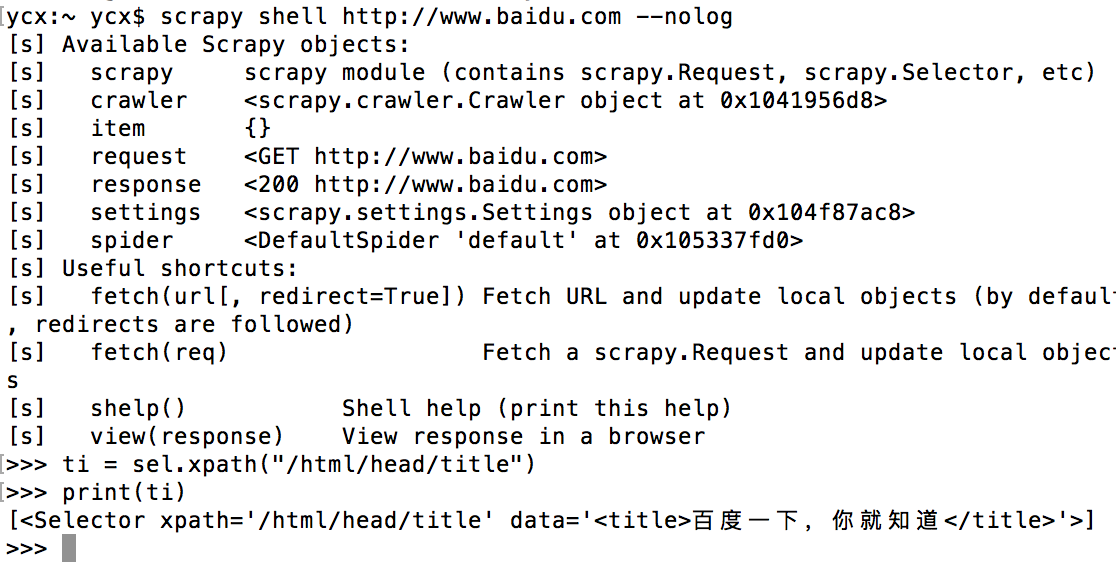

18.网络爬虫—Scrapy实战演示

网络爬虫—Scrapy实战演示 Scrapy Shell简介进入shell调试网站启动Scrapy Shell 查看目标网站获取网站源代码常用方法调试xpath提取数据Scrapy请求子页面请求及返回处理创建项目创建爬虫 数据解析写入csv文件后记 前言: 🏘️🏘️个人简介&…

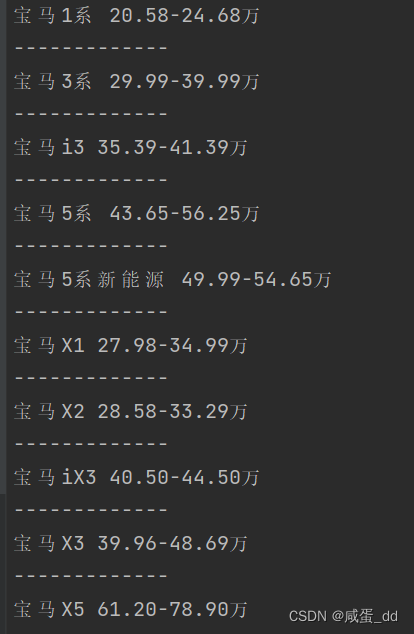

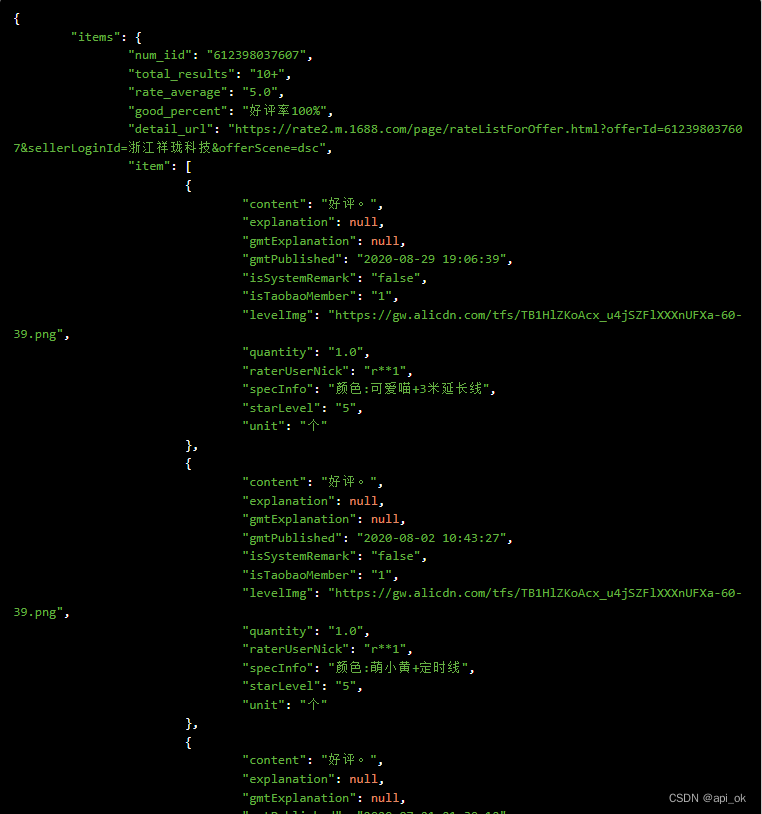

Python爬虫-D车网近半年(六个月)汽车销量排行榜

前言 本文是该专栏的第46篇,后面会持续分享python爬虫干货知识,记得关注。

在本专栏前面,笔者有单独详细介绍过该平台当前月更新的最新汽车销量排行榜数据。感兴趣的同学,可往前翻阅查看(Python爬虫-某懂车平台之汽车销量排行榜)。

而本文,笔者将详细来介绍该平台近半年…

Python爬虫利器之PhantomJS

PhantomJS是一个基于WebKit的无头浏览器,它没有图形界面,但是它可以像传统的浏览器一样访问web页面,并返回已呈现的内容。PhantomJS是一种命令行工具,可以用它来测试和爬取Web页面。

在PhantomJS中,我们需要使用JavaS…

Ceph对象存储的基本概念、使用以及优点(基于nautilus版本)

Ceph对象存储的基本概念、使用以及优点(基于nautilus版本)

Ceph是一个分布式对象存储系统,能够提供高性能、高可靠性和可扩展性。在Ceph中,数据被存储为对象,每个对象都有一个唯一的标识符,称为对象ID。对…

电商平台商品数据爬虫分析(test阶段可对接测试)

1.简单说明

京东,淘宝,天猫,,淘特,拼多多,阿里巴巴,1688,抖音,苏宁,亚马逊中国 ,lazada,速卖通等全球50多个知名平台抓取数据&#x…

C# Http请求接口数据的两种方式Get and Post

面向接口编程是一种设计思想,无论用什么语言都少不了面向接口开发思想,在软件开发过程中,常常要调用接口,接下来就是介绍C#调用其它开发商提供的接口进行获取数据,http接口方式获取接口数据。 Get请求数据:…

nodejs--实现跨域抓取数据

最近公司安排给我一个任务,抓取页面数据;http://survey.finance.sina.com.cn/static/20205/20131120.html?pid20205&dpc1,身为一个前端,还没搞过后台的东西,硬着头皮接下之后,就到网上各种找方法了。最…

爬取百度贴吧图片的小爬虫

#本来想要爬取百度图片的图片,但是发现那些图片都是js加载的,具体怎么爬取现在还不能搞清。。。。,所以就选择了百度贴吧里面的图片 #!/usr/bin/python

#coding: utf-8#

# name: download images from baiduTieba

#

#author: Hacker_MJW

#

#…

使用scrapy crawl name启动一个爬虫时出现的问题

使用scrapy crawl name启动一个爬虫时出现的问题,我的项目名字叫做 “spider_city_58”,代码如下: from scrapy import cmdline

cmdline.execute("scrapy crawl spider_city_58".split()) 来启动一个爬虫,却出现了如下错…

Python requests模块:发送HTTP请求和处理响应

目录 前言一、requests模块二、requests携带参数的方式三、get请求URL解码编码四、post请求携带数据编码格式五、get请求携带请求头六、post请求携带参数七、requests.session的使用(可以不用带cookie)八、requests模块其他参数九、response对象十、最后 前言

爬虫是什么&…

2018-2019-2 20189212 《网络攻防技术》第十一周作业

Burp Suite专项研究 简介:Brup Suite是用于攻击web应用程序的集成平台。它包含了许多工具,并为这些工具设计了许多接口,以促进加快攻击应用程序的过程。所有的工具都共享一个能处理并显示HTTP消息,持久性,认证…

并发编程:同步异步、队列、协程与实现方式

一、进程池回顾 二、同步异步 三、利用回调完成生产者消费者 四、利用回调完成生产者消费者 五、线程队列 六、协程实现 七、greenlet使用 八、gevent使用 一、进程池回顾 from concurrent.futures import ProcessPoolExecutor,ThreadPoolExecutorimport os,time# 默认按照cpu的…

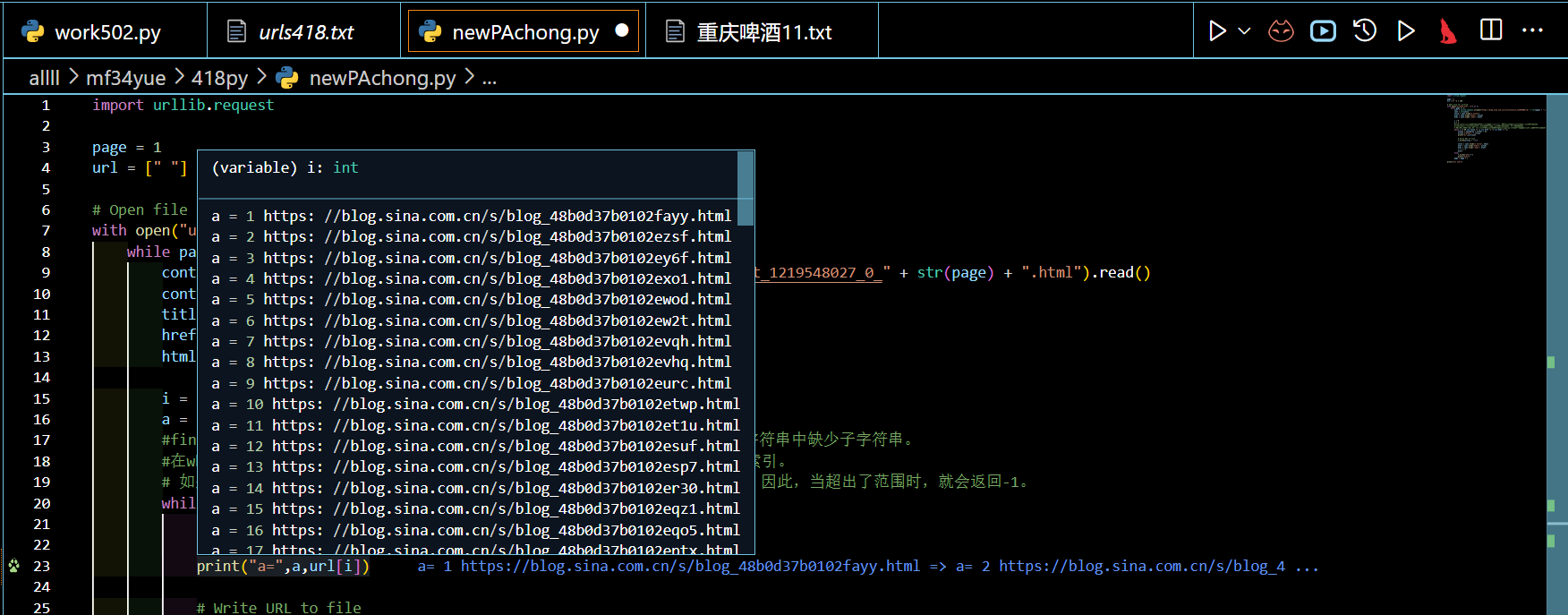

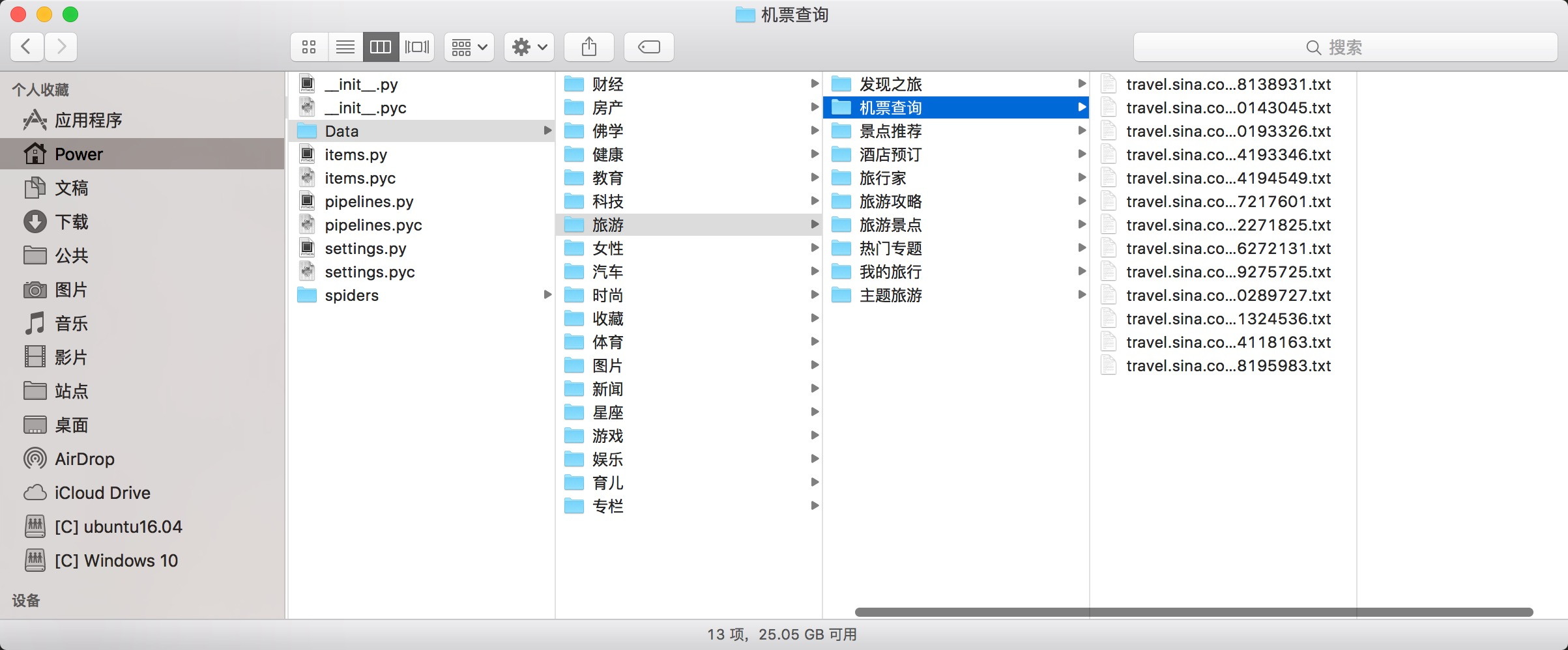

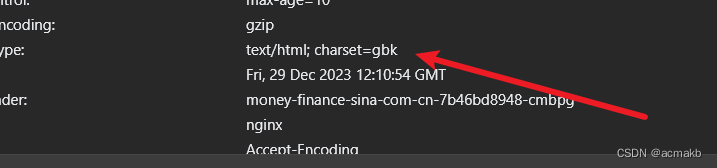

python爬虫:抓取新浪新闻内容(从当前时间到之前某个时间段),并用jieba分词,用于训练自己的分词模型...

新浪新闻内容采用的是ajax动态显示内容,通过抓包,发现如下规律: 每次请求下一页,js那一栏都会出现新的url: "http://api.roll.news.sina.com.cn/zt_list?channelnews&cat_1gnxw&cat_2gdxw1" &q…

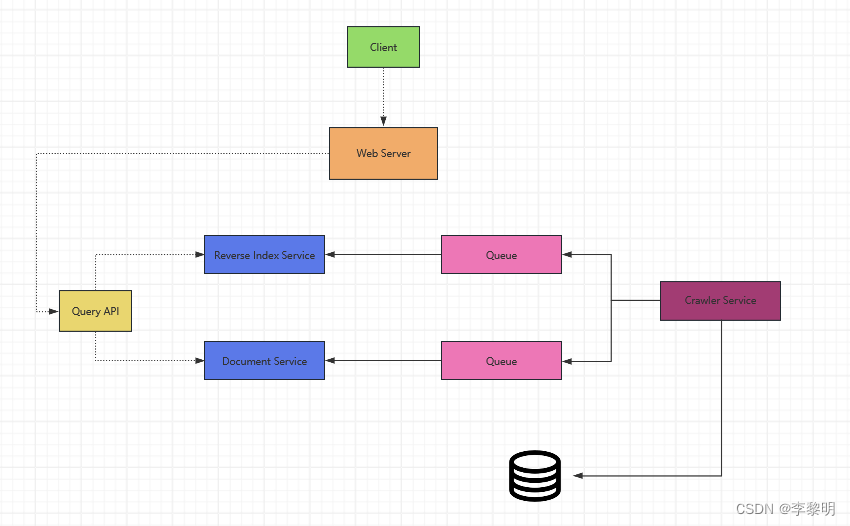

从零实现基于Scrapy-redis和ElasticSearch的搜索引擎(附代码及构建过程)

Project Introduction 项目整体分为scrapy-redis分布式爬虫爬取数据、基于ElasticSearch数据检索和前端界面展示三大模块。做此项目是为了熟悉scrapy-redis的基本流程,以及其背后的原理,同时熟悉ElasticSearch的使用。本项目可以作为一个基于ES存储的简单…

css之颜色值、单位

颜色值 英文命令颜色:p{color:red;} RGB颜色:p{color:rgb(133,45,200);}每一项的值可以是 0~255 之间的整数,也可以是 0%~100% 的百分数。如:p{color:rgb(20%,33%,25%);} 十六进制颜色:p{color:#00ffff;} 优美颜色大…

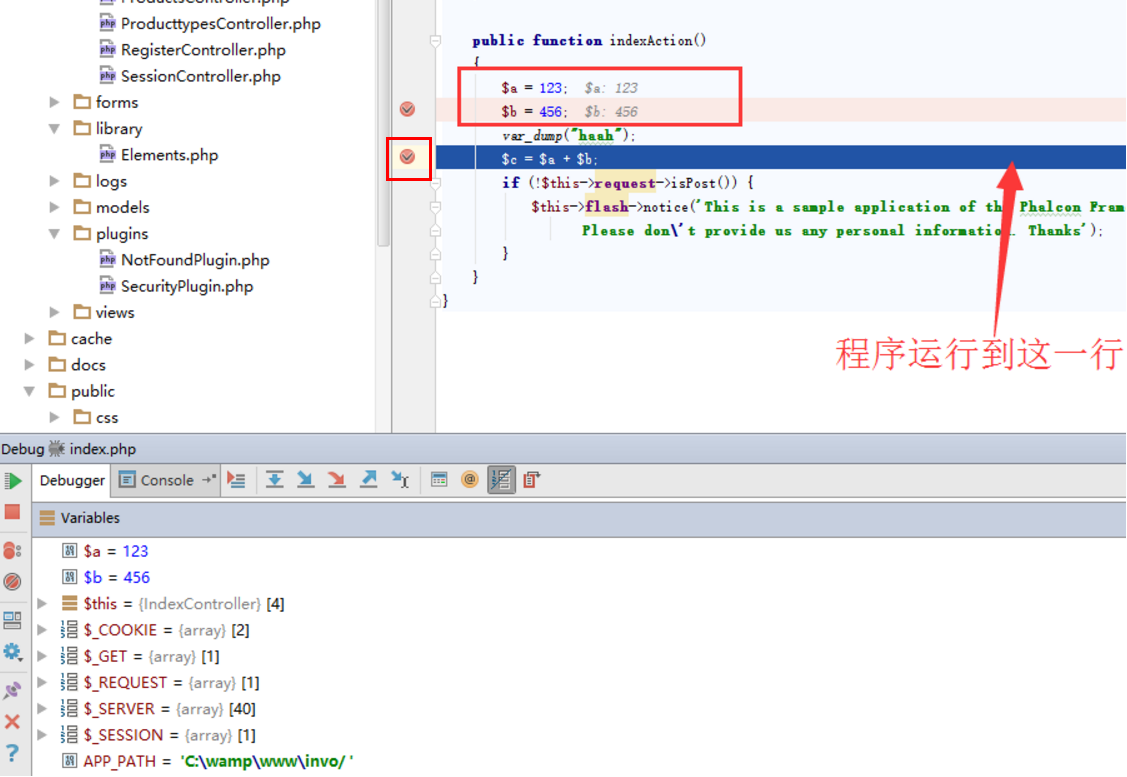

Python基础合集 练习24 (程序调试)

assert expression[,arguments]

expression条件表达式语句,如果表达式的值为真,则程序会继续执行下去,如果值为假则程序抛出Assertionerror错误,并输出指定的参数内容

arguments可选参数

if not expression:

raise AssertionError(argument)

def num_ca(): book int(inpu…

自动核对名单详细教程〖Python版〗

前言 大家好,今天我们来给大家分享一个很实用的东西。最近,有粉丝私信我,能不能做一个大学习自动核对名单的程序,我这个粉丝呢,她作为班级团支书,每次核对大学习的名单感到特别的头疼。那我接下来就来写一个…

Python爬虫入门之爬虫解析提取数据的四种方法

本文主要介绍了Python爬虫入门之爬虫解析提取数据的四种方法,通过具体的内容向大家展现,希望对大家Python爬虫的学习有所帮助。

基础爬虫的固定模式

笔者这里所谈的基础爬虫,指的是不需要处理像异步加载、验证码、代理等高阶爬虫技术的爬虫…

做网络爬虫需要掌握哪些技术?

网络爬虫是指通过代码自动化地访问网页并收集数据的程序,要开发一个成功的爬虫,需要掌握以下技术:

1. HTTP 协议:了解 HTTP 请求和响应的基本内容,以及如何使用 HTTP 请求头和响应头来优化爬虫性能。

2. HTML/CSS/Ja…

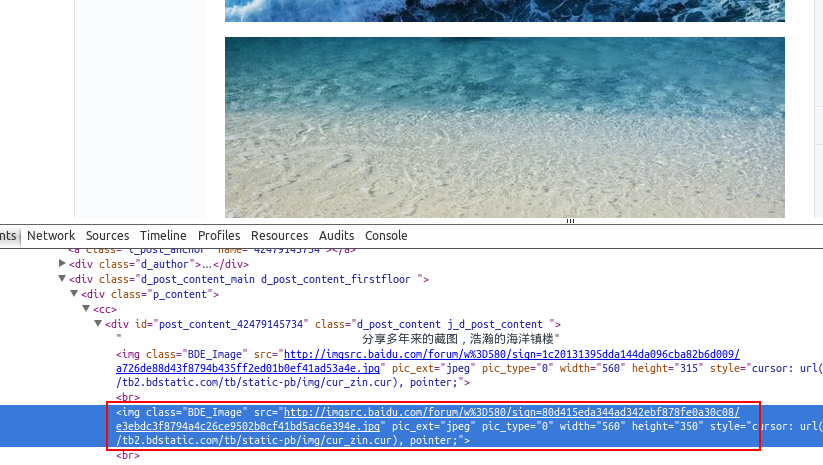

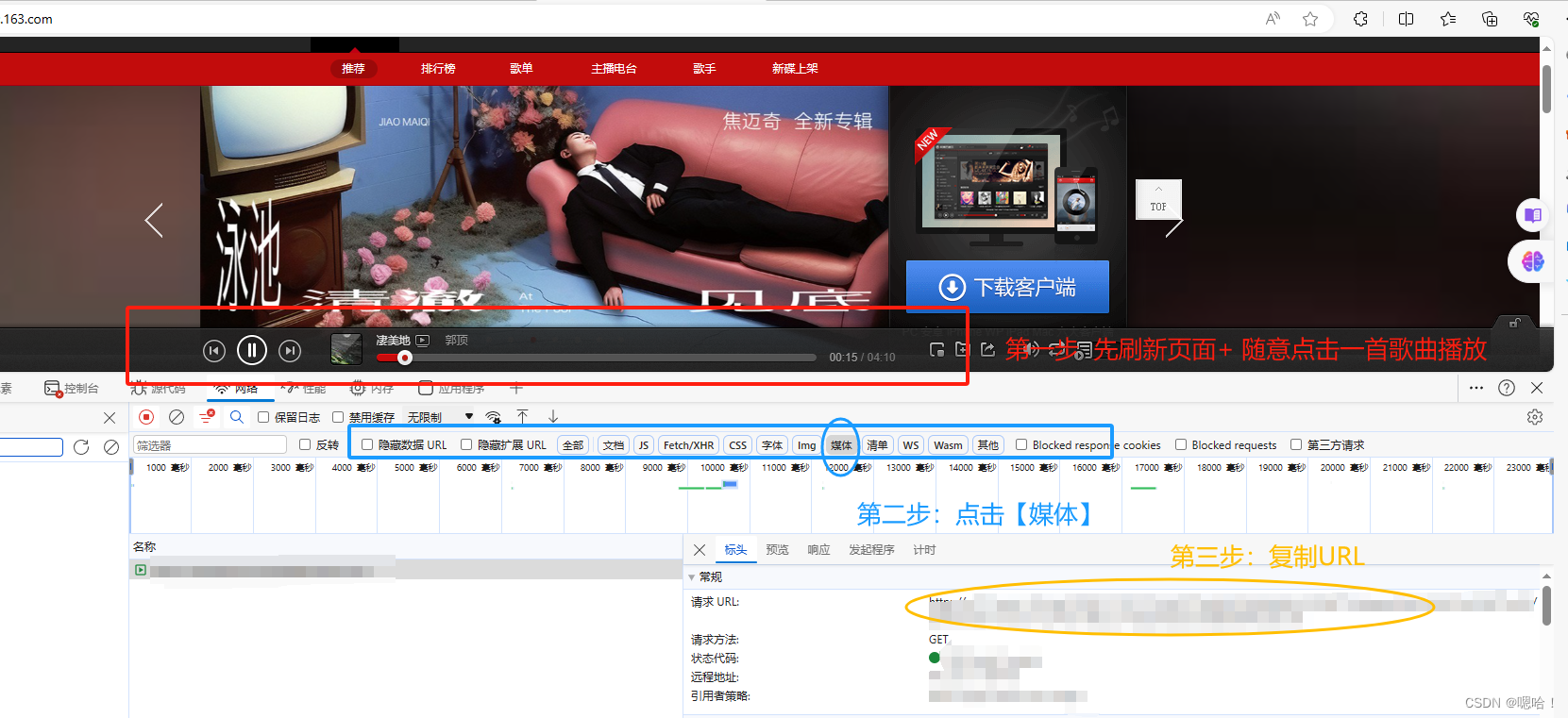

python网络爬虫笔记20:批量下载图片并将其转换为pdf文档

对于有些网页,你可以预览所有的页面内容,并且也可以通过F12获取到页面的URL,但是面对动辄几十页的图片,手动下载显然是不可行的。

在这里我们给出一个人机交互的通用解决策略。

第一步:使用F12获取页面所有感兴趣图片的URL

这一步看似简单,其实也暗藏玄机。因为有些网…

初学爬虫(二):爬取静态网页之(3)自定义requests——设置传递URL(网络地址)参数and自定义请求头(怎么找+怎么做)

在初学爬虫(二):爬取静态网页之(2)获取网页响应内容——requests.get()函数中讲解了如何使用requests函数获取网页响应内容。 但是,有些网页不能如上直接被获取,而是需要对requests中的参数进行…

使用Python和Scrapy实现抓取网站数据

Scrapy是一个功能强大的网络爬虫框架,允许开发者轻松地抓取和解析网站内容,这篇文章主要为大家介绍了如何使用Python的Scrapy库进行网站数据抓取,需要的可以参考一下

在本文中,我们将介绍如何使用Python的Scrapy库进行网站数据抓…

如何编写一个好用的app爬虫,采集各种app的数据

编写一个用于采集各种App数据的爬虫相比于编写一般的网络爬虫要复杂一些,这是因为许多App数据可能通过API进行传输,而且这些API的访问可能需要特定的授权令牌,或者使用了其他形式的安全性保护。另外,一些数据可能是通过HTTPS加密的…

Python爬虫入门案例6:scrapy的基本语法+使用scrapy进行网站数据爬取

几天前在本地终端使用pip下载scrapy遇到了很多麻烦,总是报错,花了很长时间都没有解决,最后发现pycharm里面自带终端!(狂喜),于是直接在pycharm终端里面写scrapy了 这样的好处就是每次不用切换路…

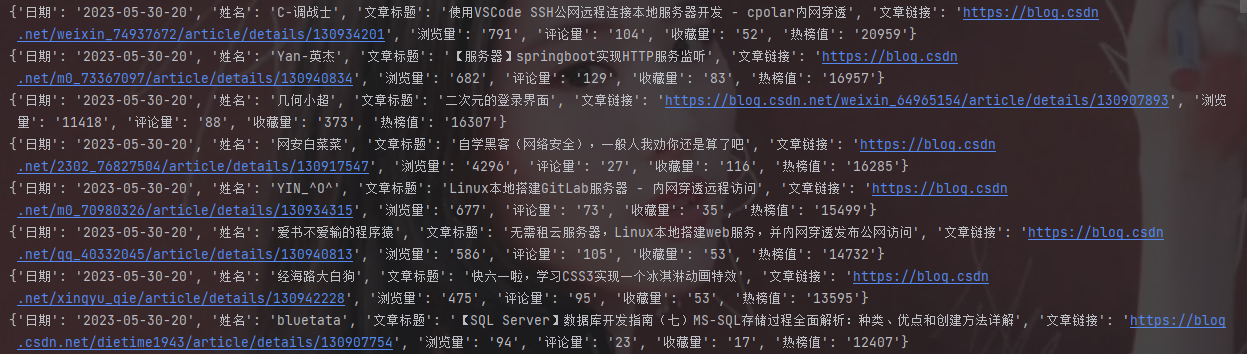

【Python实战】Python采集C站热榜数据

前言 大家好,我们今天来爬取c站的热搜榜,把其文章名称,链接和作者获取下来,我们保存到本地,我们通过测试,发现其实很简单,我们只要简单获取数据就可以。没有加密的东西。 效果如下:

环境使用 python 3.9pycharm模块使用 requests模块介绍 requests requests是…

【爬虫第三章】 Python基础

预计更新一、 爬虫技术概述 1.1 什么是爬虫技术 1.2 爬虫技术的应用领域 1.3 爬虫技术的工作原理

二、 网络协议和HTTP协议 2.1 网络协议概述 2.2 HTTP协议介绍 2.3 HTTP请求和响应

三、 Python基础 3.1 Python语言概述 3.2 Python的基本数据类型 3.3 Python的流程控制语句 3…

学好Java爬虫需要什么技巧

Java爬虫是一种利用Java编程语言编写的网络爬虫程序,它可以自动化地浏览和抓取互联网上的数据,并将数据进行处理和保存。Java爬虫通常使用HTTP协议模拟浏览器请求来获取网页内容,并通过解析HTML网页标签和属性等信息来提取有用的数据。Java爬…

爬虫框架和库有多重要?

爬虫框架和库在网络数据提取和分析中非常重它们为开发人员提供了工具和功能,使他们能够更轻松地从互联网上抓取数据。爬虫框架和库通常提供了高效的网络请求、数据解析和存储机制,简化了爬取过程。 使用爬虫框架库有以下几个重要优势:

快速开…

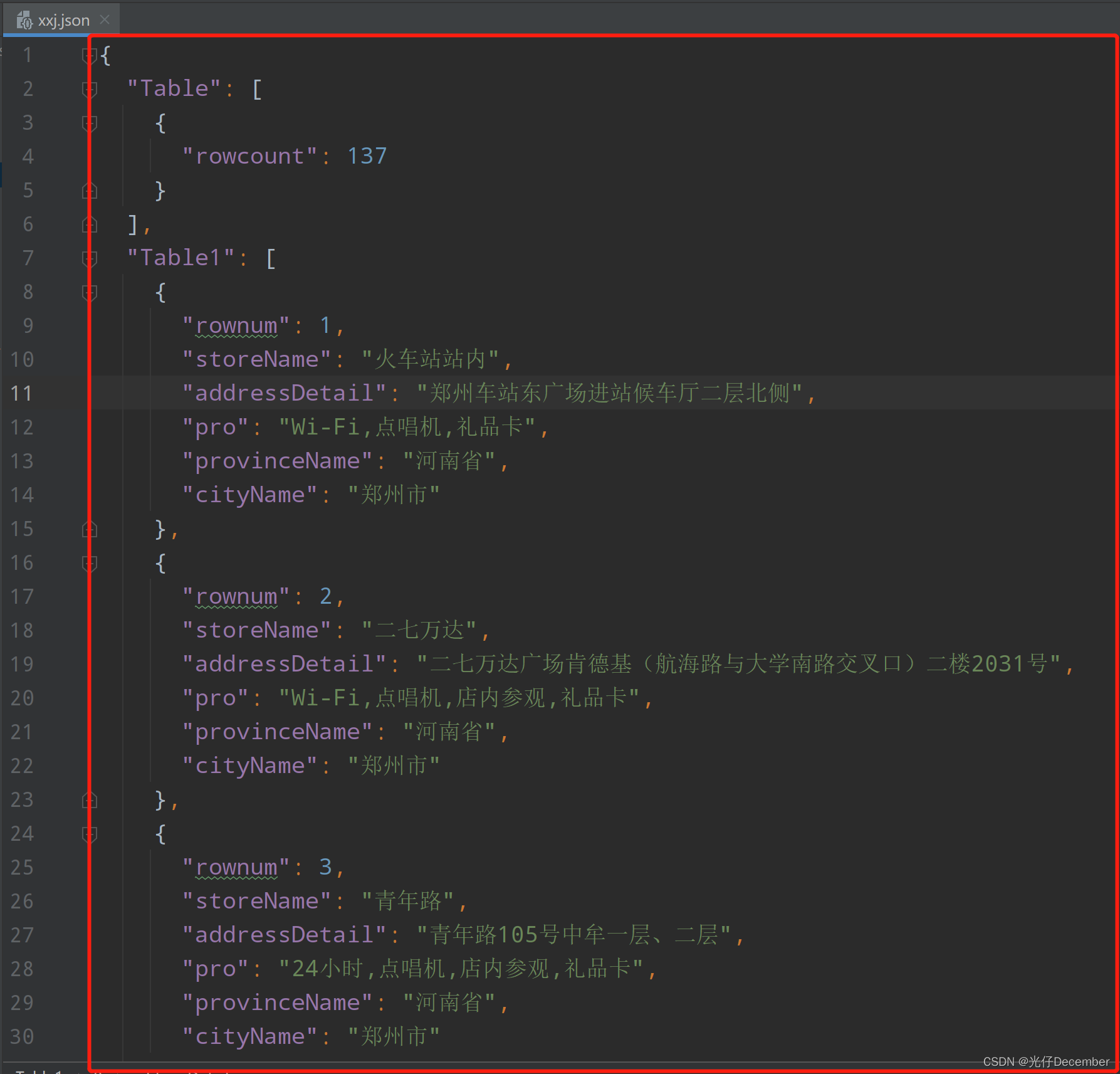

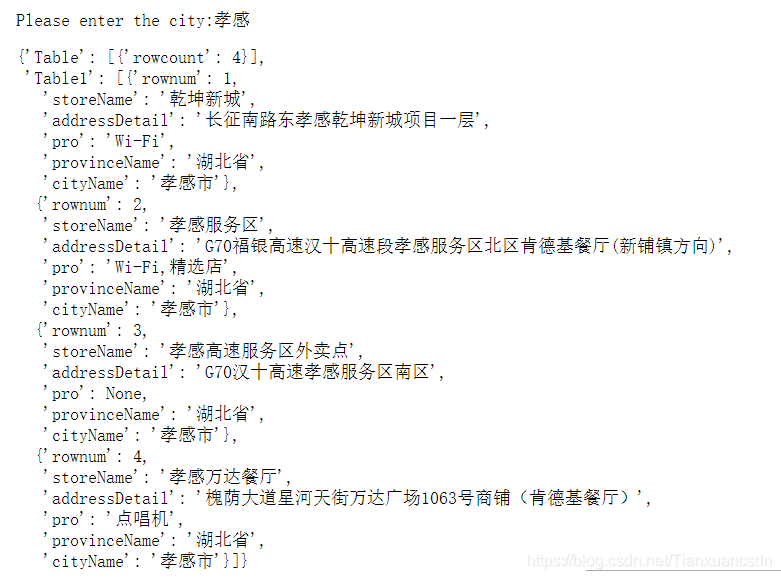

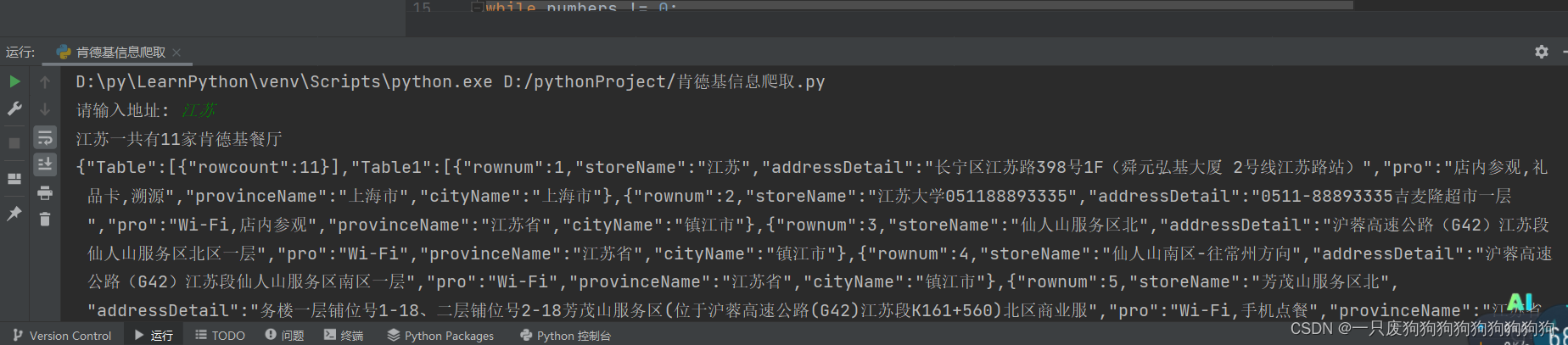

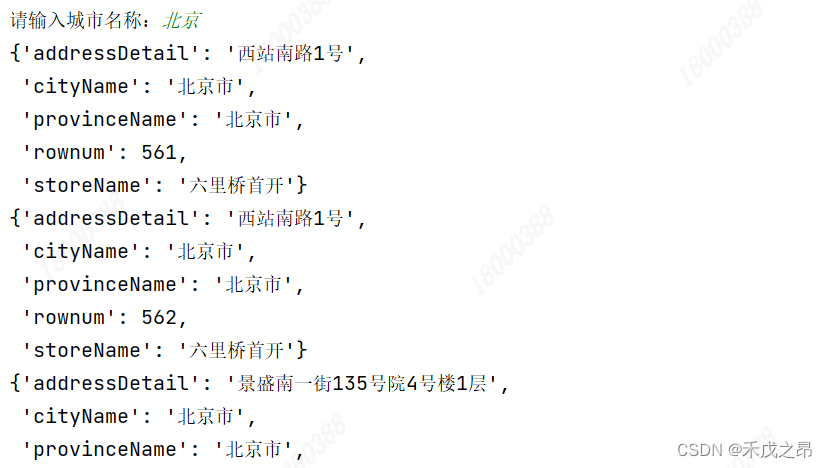

【Python从入门到进阶】25、urllib获取快餐网站店铺数据

接上篇《24、urllib获取网站电影排行》 上一篇我们讲解了如何使用urllib的get请求抓取某某电影排行榜信息。本篇我们来讲解如何使用urllib的post请求抓取某某快餐网站店铺数据。

一、某某快餐网站介绍

1、某某快餐网站

某某快餐店网址为:http://www.kfc.com.cn/k…

我用Python爬虫挣钱的那点事

在下写了10年Python,期间写了各种奇葩爬虫,挣各种奇葩的钱,写这篇文章总结下几种爬虫挣钱的方式。 1.最典型的就是找爬虫外包活儿。这个真是体力活,最早是在国外各个freelancer网站上找适合个人做的小项目,看见了就赶紧…

Python简易爬虫爬取百度贴吧图片

通过python 来实现这样一个简单的爬虫功能,把我们想要的图片爬取到本地。(Python版本为3.6.0) 一.获取整个页面数据 def getHtml(url):pageurllib.request.urlopen(url)htmlpage.read()return html 说明: 向getHtml()函数传递一个网址,就可以把整个页面…

python 爬虫 处理超级课程表传输的数据

借鉴的别人的思路 http://www.oschina.net/code/snippet_2463131_53711 抓取超级课程表传输的数据 他的传输数据居然是明文的…… 现在已经把自己的课表都抓出来了 不过这个也是抓取手机APP数据的思路? 还是值得学习一番的。 //很蠢…… //我干嘛不直接爬学校的教务…

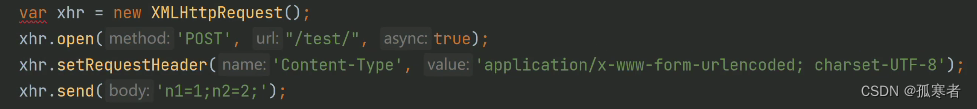

http协议学习 —— post请求方法提交application/x-www-form-urlencoded类型的数据格式

先推荐一篇很不错的文章:https://imququ.com/post/four-ways-to-post-data-in-http.html 说一下,如果是自己编写底层,那么要注意了,不能只有提交数据的类型,还必须要有数据内容的长度,大体这样写即可&#…

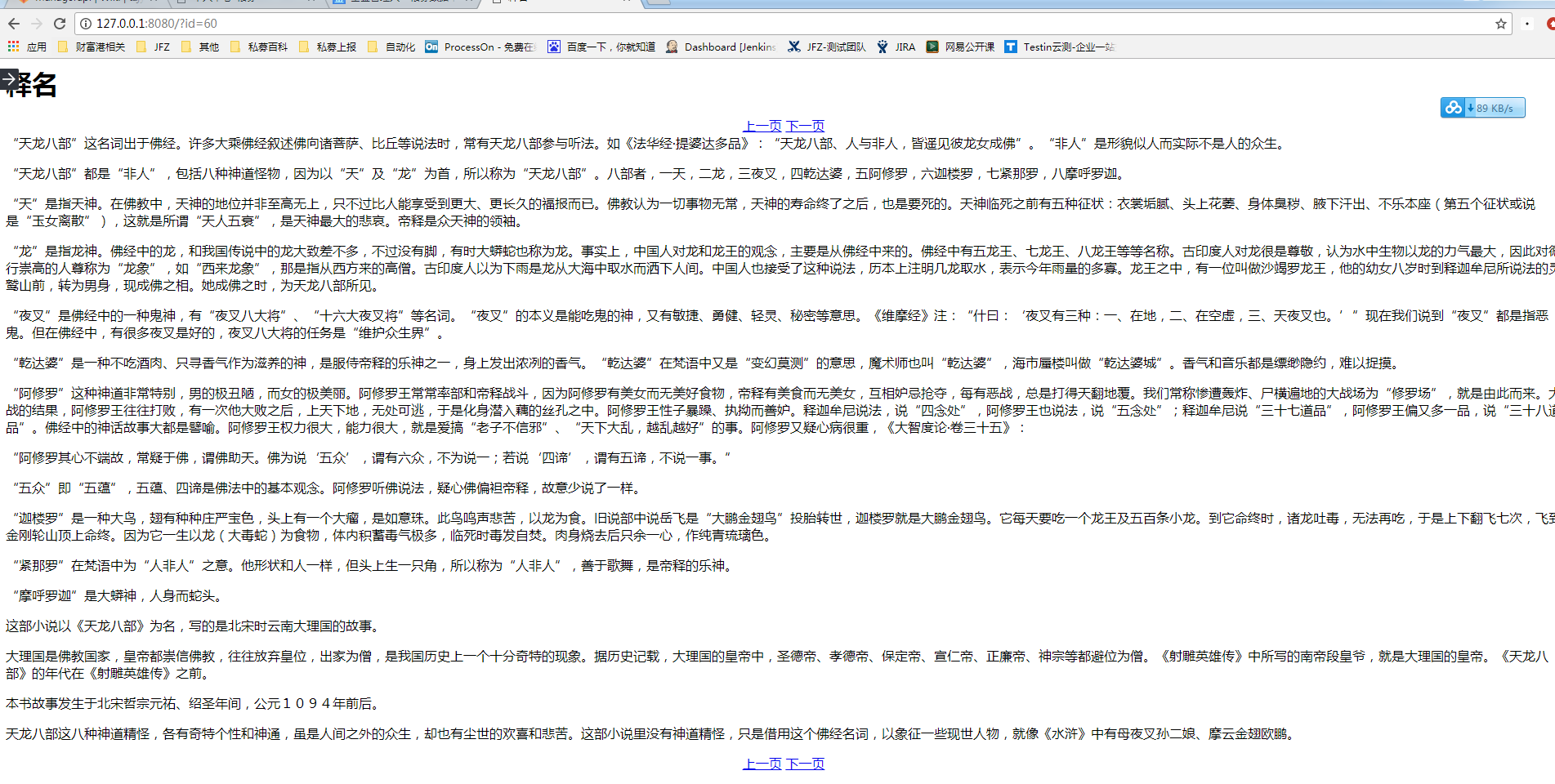

python 爬小说

初学python爬虫,爬了笔趣阁的全部小说,倒是能爬下来,可是运行速度贼慢,怀疑有Bug,各位大佬可以帮忙看看 # -*- coding:utf-8 -*-

import urllib

import re

from bs4 import BeautifulSoup

import sys

reload(sys)

sys.setdefaulte…

Anaconda完全入门指南

2019独角兽企业重金招聘Python工程师标准>>> Anaconda完全入门指南 AC手环 关注 2018.03.16 09:22 字数 2791 阅读 37732评论 4喜欢 49 Anaconda 使用指南 参考文章: 致Python初学者:Anaconda入门使用指南Anaconda使用总结概述 很多学习python的初学者甚…

批量爬取链家房源信息

Python 爬虫get请求

http get请求:明文向服务器发起资源获取的请求 post:向服务器传递信息 get:向服务器获取信息 get请求常见使用方法: urllib get requests get

在爬虫方向 除了模拟登陆之外,大部分的请求是get 1…

深入理解 Python 异步编程(上)

https://mp.weixin.qq.com/s?__bizMzIxMjY5NTE0MA&mid2247483720&idx1&snf016c06ddd17765fd50b705fed64429c http://python.jobbole.com/88291/ 前言 很多朋友对异步编程都处于“听说很强大”的认知状态。鲜有在生产项目中使用它。而使用它的同学,则大…

Grafana = 可视化分析 + 监控告警

Grafana是一个完美地分析和监控的开发平台 可以把Grafana理解为一个可视化面板(Dashboard),其实Kibana也是一个分析和可视化平台,只不过在大家的日常使用中Kibana是跟着Logstash、ElasticSearch等组件一起使用做日志展示、索引、分…

Node.js之网络小爬虫

使用JavaScript在前端访问跨域页面常常用到Ajax,后端Node.js抓取网页信息就容易得多。 下面是一个最简单的例子,抓取我的博客主页信息,显示首页博客标题。 1 var http require(http)2 var cheerio require(cheerio)3 4 var url http://www…

python3爬虫例子02(获取个人博客园的文章信息)

#!/usr/bin/env python# -*- coding:UTF-8 -*-import requestsfrom bs4 import BeautifulSoupresrequests.get("https://www.cnblogs.com/NiceTime/")# cres.contentcres.text# print(c)#获取文章日期soupBeautifulSoup(c,"html.parser")postdaysoup.find_…

2018年6月12日笔记

爬虫概念网络爬虫(又被称为网页蜘蛛,网页追踪者),是一种按照一定的规则,自动抓取网络信息的程序或脚本。 GET & POSTHTTP与服务器交互的4个基本方法: GET:会向数据库发索取数据的请求&#…

Alpha 冲刺 (10/10)

团队信息 队名:爸爸饿了组长博客:here作业博客:here组员情况 组员1(组长):王彬 过去两天完成了哪些任务 协助完成前端各个页面的整合协助解决前端操作逻辑存在的问题完成前端的美化,使UI风格靠近原型设计接…

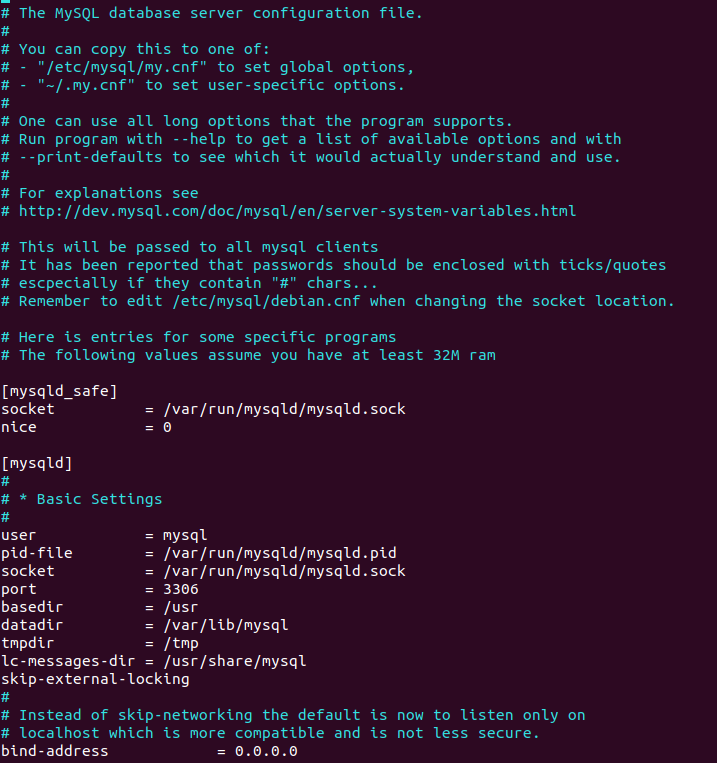

在Linux用Python写爬虫(三)

Mysql远程访问,找不到配置文件的错误。 参考书籍:《Python3 网络爬虫开发实战》2018年4月第一版 1.4.1 系统: Ubuntu 18.04.2 LTS 背景:已经安装好mySQL,进入Linux命令行 命令: 由于 Linux 一般会作为服务器…

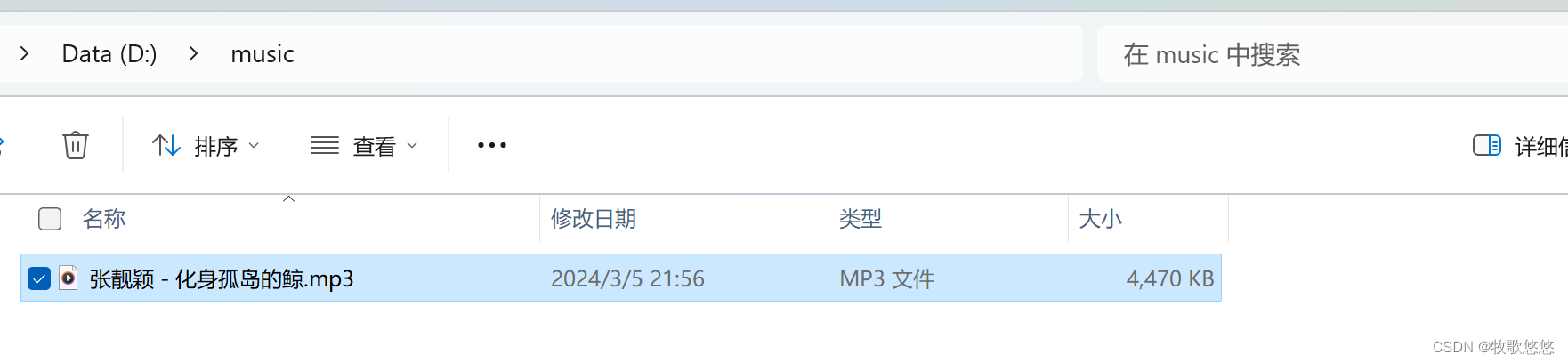

Python爬虫——selenium爬取网易云评论并做词云

大家好!我是霖hero到点了上号网易云,很多人喜欢到夜深人静的时候,在网易云听音乐发表评论,正所谓:自古评论出人才,千古绝句随口来,奈何本人没文化,一句卧槽行天下!评论区…

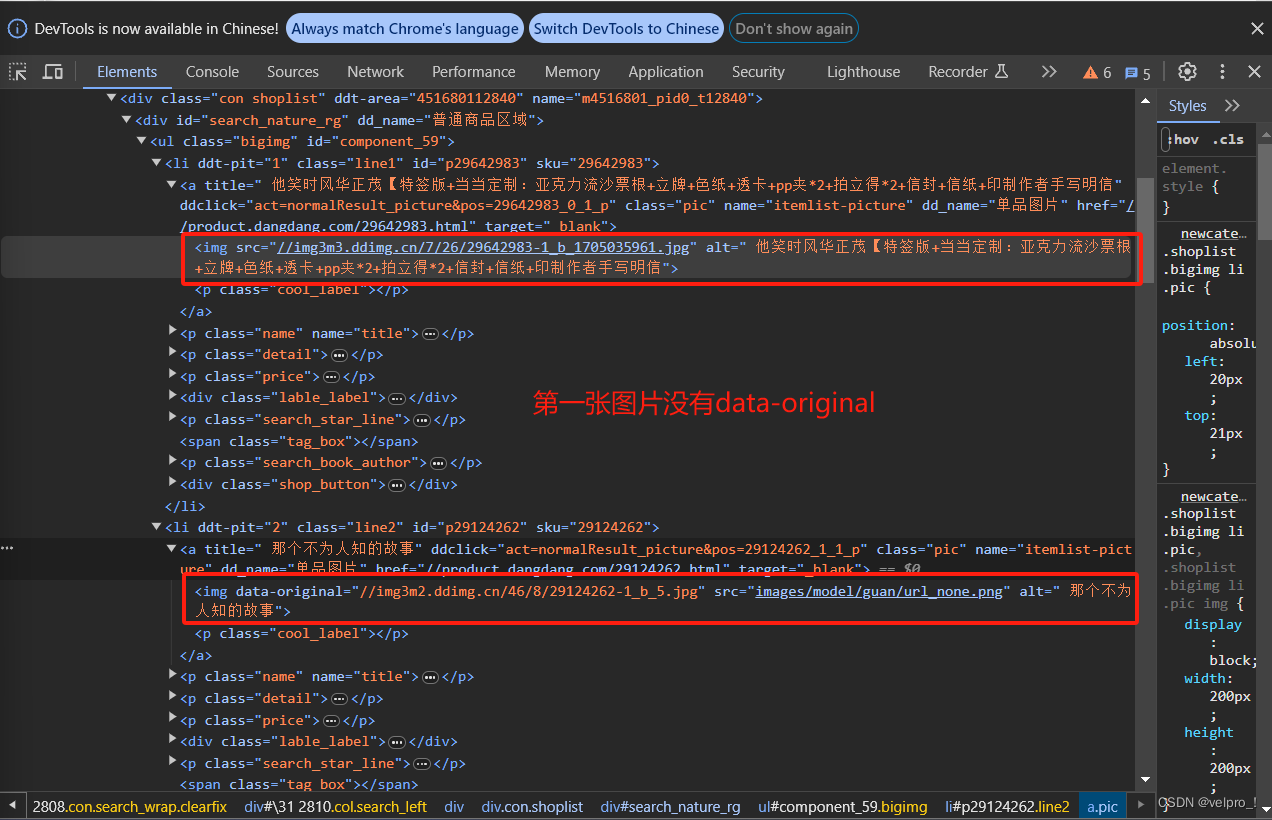

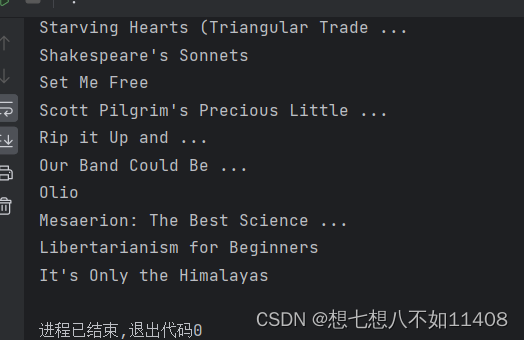

Python爬虫——selenium爬取当当畅销图书排行

前言

上上篇文章我们爬取了今日头条街拍美图,好了,心情愉悦完了,这篇文章我们使用Selenium来爬取当当网的畅销图书排行。正所谓书中自有黄金屋,书中自有颜如玉,我们通过读书学习来提高自身的才华,自然能有…

Python爬虫——教你使用XPath爬取免费代理IP

目录

前言

XPath

什么是 XPath?

XPath作用是什么?

XPath——常用规则

XPath Helper的添加与使用

XPath Helper的添加

XPath Helper的使用

实战演练

爬取首页

XPath规则提取内容

循环遍历

结果展示 前言

可能有人说,初学者Python爬虫爬数据…

结合Java实现的一个腾讯空间备份器谈谈MVC思想在Swing桌面项目中的应用

HTTP 协议可能是现在 Internet 上使用得最多、最重要的协议了,越来越多的 Java 应用程序需要直接通过 HTTP 协议来访问网络资源。虽然在 JDK 的 java net包中已经提供了访问 HTTP 协议的基本功能,但是对于大部分应用程序来说,JDK 库本身提供的…

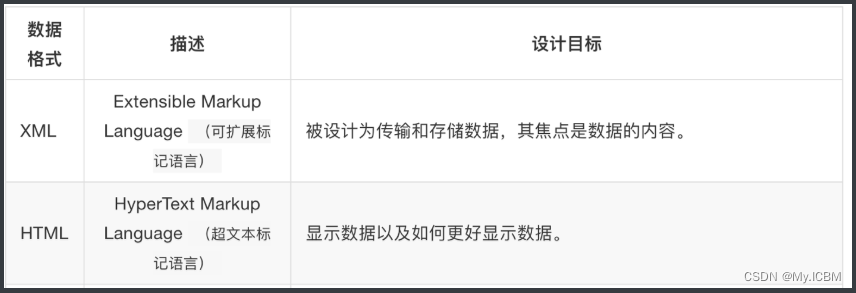

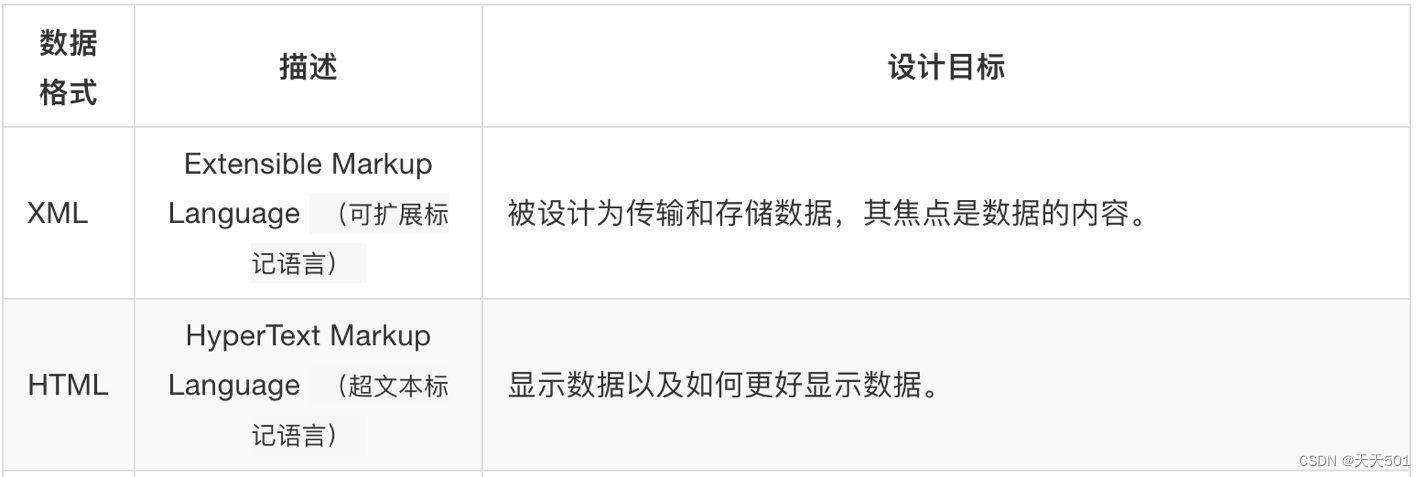

Python 爬虫-信息的标记xml,json,yaml

2017-07-26 23:53:03 信息标记的作用有: 标记后的信息可形成信息组织结构,增加了信息维度标记的结构与信息一样具有重要价值标记后的信息可用于通信、存储或展示标记后的信息更利于程序理解和运用信息标记的三种形式: XMLJSONYAML一、XML xm…

9.爬虫与数据库—MongoDB

MongoDB 是由C++语言编写的,是一个基于分布式文件存储的开源数据库系统。

MongoDB 将数据存储为一个文档,数据结构由键值(key=>value)对组成,是一种典型的非关系型数据库。

一、MongoDB的安装与使用

1.在mac中安装MongoDB

(1)创建mongodb数据源库 brew tap mongodb/b…

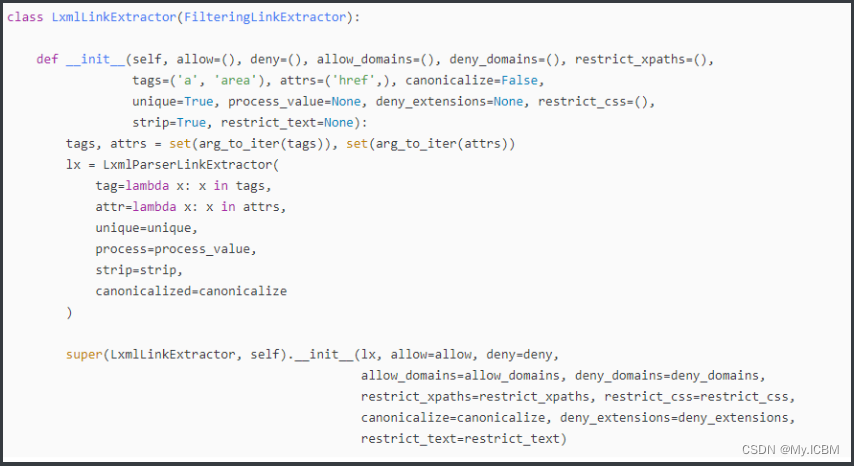

爬虫框架Scrapy(8)使用 LinkExtractor 提取链接

文章目录使用 LinkExtractor 提取链接1. 提取链接的方法(1)使用Selector(2)使用LinkExtractor2. LinkExtractor 提取链接的规则(1)allow(2)deny(3)allow_doma…

java抓取动态生成的网页--吐槽

2019独角兽企业重金招聘Python工程师标准>>> 最近在做项目的时候有一个需求:从网页面抓取数据,要求是首先抓取整个网页的html源码(后期更新要使用到)。刚开始一看这个简单,然后就稀里哗啦的敲起了代码&…

HTML meta标签使用介绍

简介 在查阅w3school中,第一句话中的“元数据”就让我开始了Google之旅。然后很顺利的在英文版的w3school找到了想要的结果。(中文w3school说的是元信息,Google和百度都没有相关的词条。但元数据在Google就有详细解释。所以这儿采用英文版W3s…

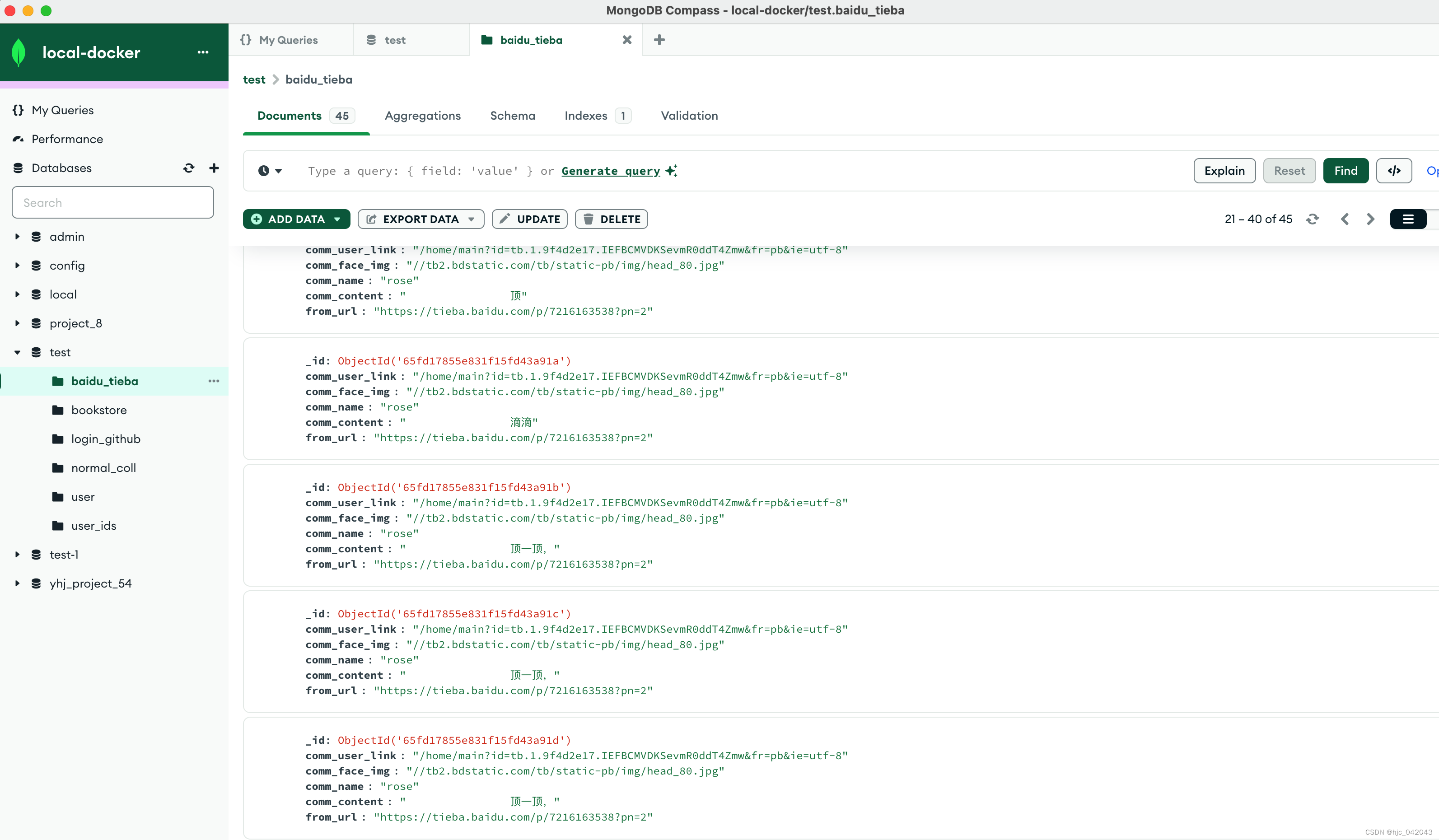

百度贴吧爬虫node+vue

baidu_tieba_crawler 演示地址 http://www.femirror.com/index 服务器很慢,请原谅 项目地址 https://github.com/tyaqing/baidu_tieba_crawler 喜欢的给个star 使用说明书 !!!爬虫类的东东还是友善使用 程序运行不起来就要检查下…

java SSM框架 代码生成器 websocket即时通讯 shiro redis 后台框架源码

A代码编辑器,在线模版编辑,仿开发工具编辑器,pdf在线预览,文件转换编码B 集成代码生成器 [正反双向](单表、主表、明细表、树形表,快速开发利器)快速表单构建器 freemaker模版技术 ,0个代码不用写ÿ…

Python如何入门?从零基础到进阶,非常详细的Python速成之路!

之前从未接触过Python,想学Python如何开始学?

不管你是否有编程经验,如果要学习Python这个编程语言,你都得有一个指南针,否则会走很多学习上的弯路。

我就是那个走了很多弯路的人,刚开始学习Python的时候…

爬虫使用xpath解析时返回为空,获取不到相应的元素的原因和解决办法

在写爬虫的时候解析网页,使用最多的解析方式就是xpath解析,但是在使用在使用xpath解析的时候,明明自己写的xpath语句正确,但是返回值还是为空 原因通常是前端做的一些反爬措施,在编写网页的时候通常省略一层标签&#…

python网络爬虫实践一

1、网络蜘蛛 webSpider, 第一步查从百度首页爬取源码 2、查看自己浏览器的cookie BAIDU_SSP_lcrhttps://www.baidu.com/link?urlWHikIXPAqSR3zgfbyzzki6u1Q4biCKXH4N9hJhskEC9-U_kOcWHBDUxFdIdUeSfoEc_9K_l1KSWfDM1m18druQOg6jMHECldh6T0xCl9pFK&wd&eqide5…

Git 分布式版本控制 -- (2、远程仓库)

为什么80%的码农都做不了架构师?>>> 上周断断续续好几个爬虫出问题,今天统计了以下十多个爬虫停止工作了。这下有事情做了。今天看了Prada的官网,改版好严重,连价格取值都成get https json了。好在排版什么的还是挺不…

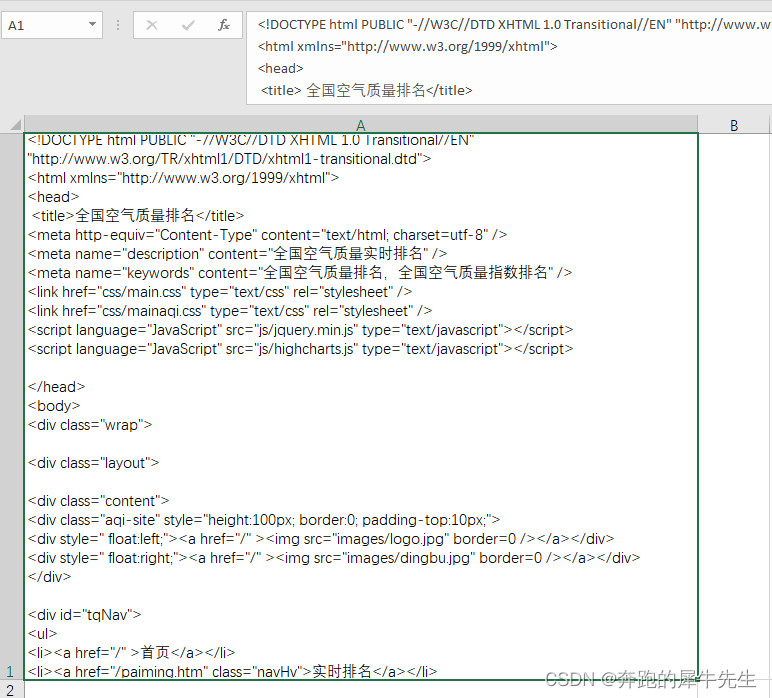

python网页爬虫+简单的数据分析

python网页爬虫简单的数据分析 文章目录python网页爬虫简单的数据分析一、数据爬取二、数据分析1.我们今天爬取的目标网站是:http://pm25.in/2.需要爬取的目标数据是:该网站所有城市的空气质量数据(主要包括AQI、PM2.5/1h、PM10/1h、CO/1h、N…

Python multiprocessing模块的Pool类来代表进程池对象

#-*-coding:utf-8-*-

multiprocessing模块提供了一个Pool类来代表进程池对象1、Pool可以提供指定数量的进程供用户调用,默认大小是CPU的核心数;2、当有新的请求提交到Pool中,如果池还没有满,name就会创建一个新的进程用来执行改请…

REST风格的应用程序实现

莫笑我老土,因为我确实是最近才听说REST风格的,以前就是觉得 /category/product/pid 这样的地址非常的漂亮,但是那只是表象罢了,了解深入以后,发现必须有一个客户端的Ajax Engine和Server端的服务配合,才能…

SEO教程-网站优化404页面怎么制作

SEO教程-网站优化404页面怎么制作

网站优化404页面怎么制作

一个404页主要是引导用户在一个不能打开的链接上访问站点的其它内容,而不是让用户直接关闭窗口,这有助于增加页面浏览,但是对爬虫有好处,使页面不会因页面错误而受到阻…

爬虫中的selenium简单学习及案例

selenium 什么是selenium 一款基于浏览器自动化的模块和爬虫的关联: 模拟登录便捷的获取动态加载的数据缺点: 爬取数据的效率底环境部署繁琐模块下载: pip install seleniumselenium如何获取动态加载的数据 环境安装:pip install selenium基本的使用流程 结合着某一款浏览器驱动…

一名爬虫工程师的运维入门之路:dnspython学习笔记

你们是否跟我一样,不知道什么是DNS,在这里,首先普及一下什么是DNS DNS(Domain Name System,域名系统),万维网上作为域名和IP地址相互映射的一个分布式数据库,能够使用户更方便的访问…

用selenium获取动态简书加载的(阿贾克斯)信息,一键自动化操作......(香~)

用selenium获取简书动态加载的(阿贾克斯)信息,一键自动化操作…(香~)

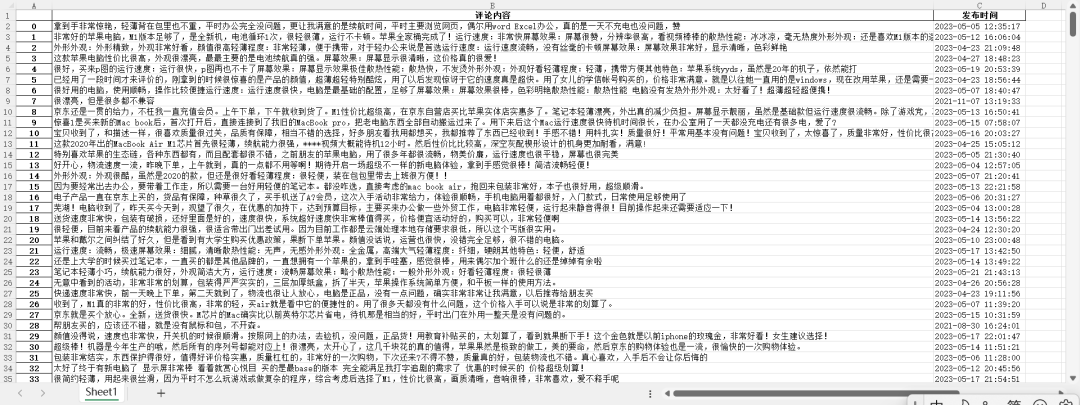

爬取目标:网址为https://www.jianshu.com/u/9104ebf5e177,爬取内容为简书用户的最新评论中的评论题目、评论内容及评论时间,爬取5页,用selenium爬取,将这些评论存入Excel文件中,文件后缀为.xls。将…

用Selenium动态抓取淘宝网商品详情并存储到Mysql数据中去.............

对于本次目标抓取: 温馨提示:能不要用自己的淘宝账号就别用自己的淘宝账号了。。。至于为什么。。。。呵呵 你试试就知道了 (短信登录可还行???真尼玛恶心)最后,请容许笔者在这里祈个福,六级一定要(高分)过啊啊啊啊啊啊啊啊… # -*- coding: utf-8 -*-

""&q…

一键抓取拉勾网跟boss直聘的招聘信息(常规操作,未借用Selenium这些)

笔者有话说:针对大多数电商类的望着那而言,其信息偷明度与时效性不言而喻,同样,他的反爬机制也相当到位,这里遇到的常见的反爬手段无非就是cookie跟refer字段,cookie动态加载的信息尤其的恶心,在不用selenium进行破解的时候,那过程简直了。。。(某直聘网站还定点封ip大…

爬取安居客房租信息并存储到mysql数据库中

本次抓取主要是数据库存储之一块需要进行命令操作,python操作mysql还是比较香的。

conn = pymysql.connect(host=localhost, user=root, passwd=123456, db=hyj, port=3306, charset=

10.15 wget:命令行下载工具

wget命令 用于从网络上下载某些资料,该命令对于能够连接到互联网的Linux系统的作用非常大,可以直接从网络上下载自己所需要的文件。wget的特点如下:支持断点下载功能。支持FTP和HTTP下载方式。支持代理服务器。非常稳定,它在带宽很…

touch.js 手机端的操作手势

使用原生的touchstart总是单击、长按有冒泡冲突事件,发现百度在几年开源的touch.js库,放在现在来解决手机端的操作手势,仍然很好用。

BeautifulSoup 爬虫入门Ⅰ

BeautifulSoup4安装

pycharm 直接在setting 里面找到 Beautifulsoup4 install就好 注意:

interpreter 要知道是下在了哪一个编译时记得查看 edit configuration 的interpreter 是否对应

用 BeautifulSoup 简单爬一个对象

from urllib.request import urlopen

fr…

scrapy-redis+selenium+webdriver解决动态代理ip和user-agent的问题(全网唯一完整代码解决方案)...

问题描述:在爬取一些反爬机制做的比较好的网站时,经常会遇见一个问题就网站代码是通过js写的,这种就无法直接使用一般的爬虫工具爬取,这种情况一般有两种解决方案 第一种:把js代码转为html代码,然后再使用h…

Python 爬虫的代理 IP 设置方法汇总

本文转载自:Python 爬虫的代理 IP 设置方法汇总 https://www.makcyun.top/web_scraping_withpython15.html 需要学习的地方:如何在爬虫中使用代理IP Requests 和 Scrapy 中的代理 IP 设置。 摘要:对于采取了比较强的反爬措施网站来说,要想顺利爬取网站数…

爬取网页时出现了中文编码乱码的问题的解决方案

在网站看到编码是utf-8的,但是出现了乱码,感觉肯定不是使用了utf-8的中文编码形式 import requests r requests.get(http://www.baidu.com/) print (type(r)) # <class requests.models.Response> print (r.encoding) # ISO-8859-1 print…

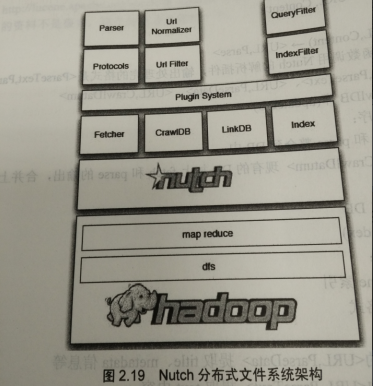

开发网络爬虫应该如何选择爬虫框架?

有些人问,开发网络爬虫应该选择Nutch、Crawler4j、WebMagic、scrapy、WebCollector还是其它的?这里依照我的经验随便扯淡一下: 上面说的爬虫,基本能够分3类: 1.分布式爬虫:Nutch 2.JAVA单机爬虫:…

Scrapy爬虫流程

参考:Scrapy框架实战(一):Scrapy基础知识_Amo Xiang的博客-CSDN博客_scrapy框架

1. 主要流程

1. 创建项目

scrapy project xxx

2. 制作spider

scrapy genspider xxx "http://www.xxx.com"

3. 编写Item.py 明确需…

网络爬虫——基于JAVA的宽度优先遍历互联网结点

整个的宽度优先爬虫过程就是从一系列的种子节点开始,把这些网页中(种子结点网页)的“子节点” (也就是超链接)提取出来,放入队列中依次进行抓取。被处理过的链接需要放入一张表(通常称 为 Visited 表)中。每次新处理一个链接之前&…

爬虫抓取新浪足球文字直播

# 全部代码

import jieba

import jieba.posseg as psg

import re

import pandas as pd

import requests

from bs4 import BeautifulSoup

import bs4id2188200

while id <2188250:header{User-Agent:Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, l…

python爬虫之scrapy(基本介绍)

scrapy框架 一、engine模块 1、控制所有模块的数据流 2、根据条件触发事件 3、不需要用户修改

二、download 1、根据请求下载模块 2、不需要用户修改

三、scheduler 1、对所有请求进行调度管理 2、不需要用户修改 四、spider 1、解析download返回的response(响应…

python爬虫基础14-selenium大全8/8-常见问题

Selenium笔记(8)常见的坑 本文集链接:https://www.jianshu.com/nb/25338984 用Xpath查找数据时无法直接获取节点属性 通常在我们使用xpath时,可以使用class的方式直接获取节点的属性,如下所示: page.xpath(…

[转载]爬虫的自我解剖(抓取网页HtmlUnit)

网络爬虫第一个要面临的问题,就是如何抓取网页,抓取其实很容易,没你想的那么复杂,一个开源HtmlUnit包,4行代码就OK啦,例子如下: 1234final WebClient webClientnew WebClient();final HtmlPage …

HtmlAgilityPack组件

HtmlAgilityPack组件用于解析Html字符串,一个典型的应用场景是用于网页爬虫。 示例程序 using Common.Tools;

using Datebase.Entity;

using HtmlAgilityPack;

using Http.Extension;

using ServiceStack.Orm.Extension.Imples;

using ServiceStack.Orm.Extension.I…

Python 爬虫监控女神的QQ空间新的说说,实现秒赞,并发送说说内容到你的邮箱